5.1 设信源?

?????=?

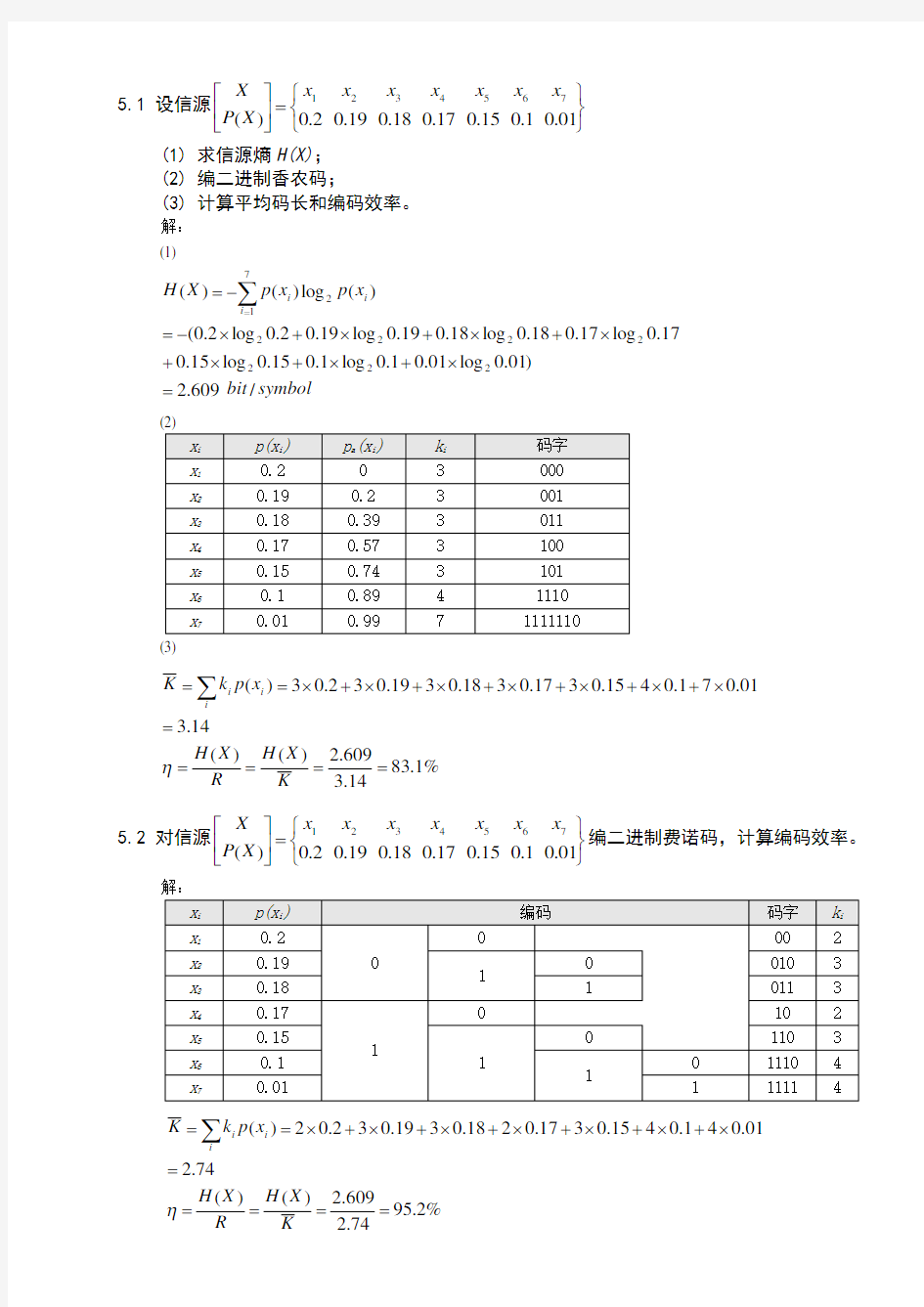

?????01.01.015.017.018.019.02.0)(765432

1x x x x x x x X P X (1) 求信源熵H(X); (2) 编二进制香农码;

(3) 计算平均码长和编码效率。

解: (1)

sym bol

bit x p x p X H i i i /609.2)01.0log 01.01.0log 1.015.0log 15.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0()

(log )()(22222227

1

2=?+?+?+?+?+?+?-=-=∑=

%

1.8314.3609.2)()(14

.301

.071.0415.0317.0318.0319.032.03)(=====?+?+?+?+?+?+?==∑K

X H R X H x p k K i

i i η

5.2 对信源?

?????=??????01.01.015.017.018.019.02.0)(765432

1x x x x x x x X P X 编二进制费诺码,计算编码效率。

%

2.9574.2609.2)()(74

.201

.041.0415.0317.0218.0319.032.02)(=====?+?+?+?+?+?+?==∑K

X H R X H x p k K i

i i η

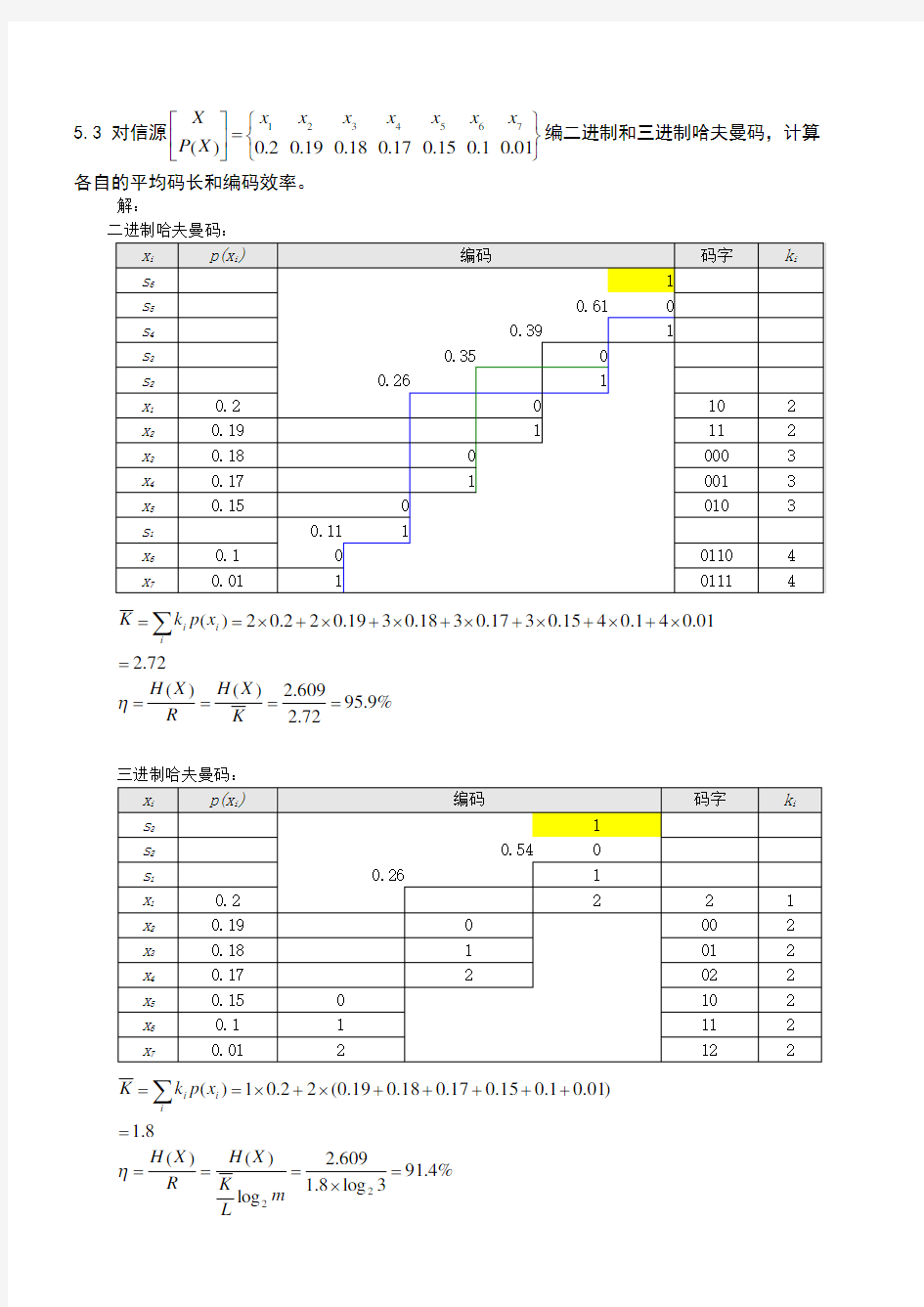

5.3 对信源??????=?

?????01.01.015.017.018.019.02.0)(765432

1x x x x x x x X P X 编二进制和三进制哈夫曼码,计算各自的平均码长和编码效率。

解:

%

9.9572.2609.2)()(72

.201

.041.0415.0317.0318.0319.022.02)(=====?+?+?+?+?+?+?==∑K

X H R X H x p k K i

i i η

%

4.913log 8.1609.2log )()(8

.1)

01.01.015.017.018.019.0(22.01)(2

2=?====+++++?+?==∑m L

K X H R X H x p k i

i i η

5.4 设信源??

????????=?

?????12811281641321161814121)(87654321x x x x x x x x X P X (1) 求信源熵H(X);

(2) 编二进制香农码和二进制费诺码;

(3) 计算二进制香农码和二进制费诺码的平均码长和编码效率; (4) 编三进制费诺码;

(5) 计算三进制费诺码的平均码长和编码效率;

解: (1)

symbol

bit x p x p X H i i i /984.1128log 1281128log 128164log 64132log 32116log 1618log 814log 412log 21)

(log )()(222222228

1

2=?+?+?+?+?+?+?+?=-=∑=

=127/64 bit/symbol (2)

二进制费诺码:

香农编码效率:

%100984.1984.1)()(64

/127984.17128

171281664153214161381241121)(====

==?+?+?+?+?+?+?+?=

=∑K

X H R X H x p k K i

i i η

费诺编码效率:

%100984.1984

.1)()(984

.17

128171281664153214161381241121)(====

=?+?+?+?+?+?+?+?==∑K

X H R X H x p k K i

i i η

(5)

%

3.943log 328.198

4.1log )()(328

.14

1281

41281364133212161281141121)(2

2=?=?===?+?+?+?+?+?+?+?==∑m K X H R X H x p k K i

i i η

5.5 设无记忆二进制信源?

?????=??????1.09.010

)(X P X

先把信源序列编成数字0,1,2,……,8,再替换成二进制变长码字,如下表所示。

(1) 验证码字的可分离性;

(2) 求对应于一个数字的信源序列的平均长度1K ; (3) 求对应于一个码字的信源序列的平均长度2K ; (4) 计算

1

2

K K ,并计算编码效率; (5) 若用4位信源符号合起来编成二进制哈夫曼码,求它的平均码长K ,并计算编码效率。

解:(1)满足Kcraft 不等式:

12282

149

1

=+?=--=-∑i K i

;由码树图可见,没有一个码字是其它码字的前

缀,码字均在树的终结点。所以码字可分离。

数字符号信源符号/.69359

11==∑=i i i L p K

(3) 数字符号

/.b i t L p K i i

i

708629

1

2='=

∑= (4)

信源符号/.bit K K 475601

2

=, 此值表示无记忆二元信源采用游程长度编码后每个二元信源需要的平均码长。

信源符号/.)(log )()(bit x p x p X H i i 46902

1i 2==∑=,%./)

(6981

2==

K K X H η

(5)4位信源符号的联合概率、Huffman 编码及码长如下表:(码字可以不同,但码长一样) 80

123456701

11111110

000

00

%.)

(/./,

/.)(295492604497021416

1

4==

====∑=K

X H Sym

bit K K Sym bit L s p K i i i η

5.6 有二元平稳马氏链,已知p (0/0) = 0.8,p (1/1) = 0.7,求它的符号熵。用三个符号合成一个来编写二进制哈夫曼码,求新符号的平均码字长度和编码效率。 解:平稳时马尔科夫状态的概率:

???=+-+=1

7018010100)()()().()(.)(S P S P S P S P S p 解得:??

?==525

310/)(/)(S P S p 一阶马氏信源的熵:

sym bit S S P S S

p S p H j i j i j

i

i /.log log log )

|(log )|()(7860725

7

3253525142221

21

11=--+-

=-=∑∑

==+7

01130102001800052153023121321.)|(,.)|(,.)|(,.)|(,

/)(,/)()|()|()()(=================S S p S S p S S p S S p S p S p S S p S S p S p S S S p

%

.//.)()()()(1490336162125327

125

325095250212502112512425049125123125481119

1

====

+?+++?++?+?

==+=∑K H

sym bit L s p K i i i η

1

101

0101100111000011110006/250

9/25021/25021/25024/25024/25049/250

96/25015/250

36/250

45/250

60/250

94/250

154/250

00000

01

1

1

1

1

1

5.7 对题5.6的信源进行游程编码。若“0”游程长度的截止值为16,“1”游程长度的截止值为8,求编码效率。

解:一阶马氏信源的熵同上题,sym bit H /.786011=+ 二元平稳一阶记忆序列“0”游程的长度概率:

∑∞

=-=>=?????=100

015

00

1100000

11515

321i i l i

i i l i l

p l l p p p l p )(,...,,)(///

二元平稳一阶记忆序列“1”游程的长度概率:

∑∞

=-=>=???

??=1

1

1

171

11

0111111

17

7

321i i l i i i l i l p l l p p p l p )(,...,,)(/// “1”游程长度的熵:

信源符号/.2),()(log )(log )(log log )

(log log )(log )(log log )(log log )(log log )(log log ][log ][][log ][][/////////////////////////////////////////////bit p p H p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p

l p p p p p p p

p p

p p l p l p l p l p l H i i i i i i i i i i i l l l l l i

l l l l l i i i l i i 6961111111711111101

17111121

17

111110271171

127111121

17111111271

110271

171

127117

1

1

111111************

1

71

127111127

1

1011

11102101

117

171

127111011

12101

1

17

1

71

1271112111

2111

1111111111=--=-----=----+--=-????---=----=--=--=-=∑∑∑∑∑∑=-==--=--=∞=

同理,“0”游程长度的熵:

信源符号/.),()(][////bit p p H p p l H i 48331101000

015

000=--= 分别对“0”和“1”游程序列进行Huffman 编码,并分别计算出它们的编码效率。

数字符号

信源符号/.)())(()())(()

()()()()(5113517654312517654312171651514132150

01301906030200011150013011001701401012001013

012001001150

2

0070120040120001116

1

2=+++++++++=+++++++++=+++++++++++++++==∑=p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p p L p L i i i %.././][199951134833200===L l H i η

“1”游程序列的长度、对应得概率、Huffman 编码的二元码长及码字:

数字符号

二元码字/.)())((////////'7324143217

1

12

11114

11102

1111108

1

2=++++++==∑=p p p p p p p p K p K i i i

%.../][759873

2696

2211==

=K l H i η %....][][/][/][][][11

1

01997325113696

2483322000=++=++=++=∴K L l H l H l H l H l H l H i i i i i i ηηη 可见满足10ηηη>>,这里的“0”游程编码效率高,因为游程长度长,而“1”游程编码效率受游程的长度限制显得比“0”游程编码效率略低一些,因此整体的编码效率介于两者之间。

5.8 选择帧长N = 63

(1) 对00100000,00000000,00000000,00000000,01000000,00000000,00000000,0000000编L-D 码; (2) 对10000100,00101100,00000001,00100001,01001000,00000111,00000100,0000001编L-D 码 再译码;

(3) 对0000000000000000000000000000000000000000000000000000000000000000编L-D 码; (4) 对10100011010111000110001110100110000111101100101000110101011010010编L-D 码; (5) 对上述结果进行讨论。

解:(1)本帧内信息位数Q=2;各信息位位置值n 1=3,n 2=34;帧长N=63。

53052822

13411311=+=+==--=-∑C C C T Q

j j n j

Q 位和T 位需要的二进制自然码位数分别是:

??????

11195319536

64122

6322=====+log ,log )(log C C N Q N 所以,L-D 编码结果:000010,010********

解码:已知N=63,故前6位为Q 的自然码表示,所以Q=2;后11位为T 的自然码表示,得T=530 寻找某一值K ,使

,5,221130++<≤<≤K K Q K Q K C C C T C 即:得:K=33

再令,25285305302

3321

=-=-=-=C C T T K

再次寻找某一值L ,使

,,11111112+-+-<≤<≤L L Q L Q L C C C T C 即:得:L=2

所以解码出信息位的位置值是n 1=3,n 2=34

(2) 对10000100,00101100,00000001,00100001,01001000,00000111,00000100,00000010编L-D 码

本帧内信息位数Q=15;各信息位位置值n 1=1,n 2=6,n 3=11,n 4=13,n 5=14,n 6=24,n 7=27,n 8=32,n 9=34,

n 10=37,n 11=46,n 12=47,n 13=48,n 14=54,n 15=63;帧长N=63。

9470

95646769289920930527499120024039799044514067684845389106176501015059591254186856385671007888725657800100947128749512010015

1

63141541314812147111461013791348

1

32712761245114411331112161111

1=++++++++++++++=++++++++++++++==---------------=-∑C C C C C C C C C C C C C C C C T Q

j j n j Q 位和T 位需要的二进制自然码位数分别是:

??????47

98952213173426989522131734266

641215

6322=====+1log ,

1log )(log C C N Q N

所以,L-D 编码结果:001111,1010110,11111101,01111111,10110101,00011000,11111110

解码:已知N=63,故前7位为Q 的自然码表示,所以Q=15;后47位为T 的自然码表示,得 T= 95646769289470 (a) 寻找某一值K ,使

,,15151194709564676928++<≤<≤K K Q K Q K C C C T C 即:得:K=62

(b)令,

550

25940193699920

9305274991=-=-=-=94709564676928947095646769281562C C T T Q K

Q=Q-1

重复步骤(a )(b )每次寻找出一个K 值,得:

解出的各信息位位置值:

n 1=1,n 2=6,n 3=11,n 4=13,n 5=14,n 6=24,n 7=27,n 8=32,n 9=34,n 10=37,n 11=46,n 12=47,n 13=48,n 14=54,n 15=63;

(3) 本帧内信息位数Q=0;帧长N=64

Q 位和T 位需要的二进制自然码位数分别是:

??????0

765120

6422=====+1log ,1log )(log C C N Q N 所以,L-D 编码结果:0000000

解码:已知N=64,故前7位为Q 的自然码表示,所以Q=0。表示64位全零。 (4)“0”、“1”数几乎相等,用一般的能表示15位十进制整数的数学软件已无法表示其T 值,可以肯定的是,其编出的码要比64bit 二进制还要长。

(5)L-D 编码的结论是,全0、全1、或少量的0、1可以编出短码,当冗余位和信息为相当时,反而使其码长增加,此时不宜使用L-D 编码。

第一章信息论与基础 1.1信息与消息的概念有何区别? 信息存在于任何事物之中,有物质的地方就有信息,信息本身是看不见、摸不着的,它必须依附于一定的物质形式。一切物质都有可能成为信息的载体,信息充满着整个物质世界。信息是物质和能量在空间和时间中分布的不均匀程度。信息是表征事物的状态和运动形式。 在通信系统中其传输的形式是消息。但消息传递过程的一个最基本、最普遍却又十分引人注意的特点是:收信者在收到消息以前是不知道具体内容的;在收到消息之前,收信者无法判断发送者将发来描述何种事物运动状态的具体消息;再者,即使收到消息,由于信道干扰的存在,也不能断定得到的消息是否正确和可靠。 在通信系统中形式上传输的是消息,但实质上传输的是信息。消息只是表达信息的工具,载荷信息的载体。显然在通信中被利用的(亦即携带信息的)实际客体是不重要的,而重要的是信息。 信息载荷在消息之中,同一信息可以由不同形式的消息来载荷;同一个消息可能包含非常丰富的信息,也可能只包含很少的信息。可见,信息与消息既有区别又有联系的。 1.2 简述信息传输系统五个组成部分的作用。 信源:产生消息和消息序列的源。消息是随机发生的,也就是说在未收到这些消息之前不可能确切地知道它们的内容。信源研究主要内容是消息的统计特性和信源产生信息的速率。 信宿:信息传送过程中的接受者,亦即接受消息的人和物。 编码器:将信源发出的消息变换成适于信道传送的信号的设备。它包含下述三个部分:(1)信源编码器:在一定的准则下,信源编码器对信源输出的消息进行适当的变换和处理,其目的在于提高信息传输的效率。(2)纠错编码器:纠错编码器是对信源编码器的输出进行变换,用以提高对于信道干扰的抗击能力,也就是说提高信息传输的可靠性。(3)调制器:调制器是将纠错编码器的输出变换适合于信道传输要求的信号形式。纠错编码器和调制器的组合又称为信道编码器。 信道:把载荷消息的信号从发射端传到接受端的媒质或通道,包括收发设备在内的物理设施。信道除了传送信号外,还存储信号的作用。 译码器:编码的逆变换。它要从受干扰的信号中最大限度地提取出有关信源输出消息的信息,并尽可能地复现信源的输出。 1.3 同时掷一对骰子,要得知面朝上点数之和,描述这一信源的数学 模型。 解:设该信源符号集合为X

一、(11’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是 0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 (6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码。(7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。 (8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小。(9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关 三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (2分) 故 p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (2分) I(A|B)=-log0.375=1.42bit (1分) 四、(5')证明:平均互信息量同信息熵之间满足 I(X;Y)=H(X)+H(Y)-H(XY) 证明:

《信息论基础》试卷第1页 《信息论基础》试卷答案 一、填空题(共25分,每空1分) 1、连续信源的绝对熵为 无穷大。(或()()lg lim lg p x p x dx +∞-∞ ?→∞ --?? ) 2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 3、无记忆信源是指 信源先后发生的符号彼此统计独立 。 4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。根据信源符号的统计特性,对概率大的符号用 短 码,对概率小的符号用 长 码,这样平均码长就可以降低,从而提高 有效性(传输速率或编码效率) 。 5、为了提高系统的有效性可以采用 信源编码 ,为了提高系统的可靠性可以采用 信道编码 。 6、八进制信源的最小熵为 0 ,最大熵为 3bit/符号 。 7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为 高斯分布(或()0,1x N 2 2 x - )时,信源具有最大熵,其值为 0.6155hart(或 1.625bit 或 1lg 22 e π)。 8、即时码是指 任一码字都不是其它码字的前缀 。 9、无失真信源编码定理指出平均码长的理论极限值为 信源熵(或H r (S)或()lg H s r ),此 时编码效率为 1 ,编码后的信息传输率为 lg r bit/码元 。 10、一个事件发生的概率为0.125,则自信息量为 3bit/符号 。 11、信源的剩余度主要来自两个方面,一是 信源符号间的相关性 ,二是 信源符号概率分布的不均匀性 。 12、m 阶马尔可夫信源的记忆长度为 m+1 ,信源可以有 q m 个不同的状态。 13、同时扔出一对均匀的骰子,当得知“两骰子面朝上点数之和为2”所获得的信息量为 lg36=5.17 比特,当得知“面朝上点数之和为8”所获得的信息量为 lg36/5=2.85 比特。 14.在下面空格中选择填入的数学符号“=,≥,≤,>”或“<” H(XY) = H(Y)+H(X ∣Y) ≤ H(Y)+H(X)

一、概念简答题(每题5分,共40分) 1.什么是平均自信息量与平均互信息,比较一下这两个概念的异同? 答:平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2.简述最大离散熵定理。对于一个有m个符号的离散信源,其最大熵是多少? 答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 最大熵值为。 3.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系? 答:信息传输率R指信道中平均每个符号所能传送的信息量。信道容量是一个信道所能达到的最大信息传输率。信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。 平均互信息是信源概率分布的∩型凸函数,是信道传递概率的U型凸函数。 4.对于一个一般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。 答:通信系统模型如下:

数据处理定理为:串联信道的输入输出X、Y、Z组成一个马尔可夫链,且有, 。说明经数据处理后,一般只会增加信息的损失。 5.写出香农公式,并说明其物理意义。当信道带宽为5000Hz,信噪比为30dB时求信道容量。 .答:香农公式为,它是高斯加性白噪声信道在单位时间内的信道容量,其值取决于信噪比和带宽。 由得,则 6.解释无失真变长信源编码定理。 .答:只要,当N足够长时,一定存在一种无失真编码。 7.解释有噪信道编码定理。 答:当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8.什么是保真度准则?对二元信源,其失真矩阵,求a>0时率失真函数的和? 答:1)保真度准则为:平均失真度不大于允许的失真度。 2)因为失真矩阵中每行都有一个0,所以有,而。 二、综合题(每题10分,共60分) 1.黑白气象传真图的消息只有黑色和白色两种,求:

《信息论基础》答案 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X ,其概率分布为1 23x x x X 1 11P 244?? ?? ? =?? ????? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则每十个符号的平均信息量是 15bit 。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log (b-a )bit/自由度;若放大器的最高频率为F ,则单位时间内输出的最大信息量是 2Flog (b-a )bit/s. 5. 若某一 信源X ,其平均功率受限为16w ,其概率密度函数是高斯分布时,差熵的最大值为 1 log32e 2 π;与其熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。 8、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,,=≥≤?”或“?” (1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)。 (2)假设信道输入用X 表示,信道输出用Y 表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 2009-2010学年第二学期末考试试题 信息论与编码理论 一、(共10分) 简述最大熵原理与最小鉴别信息原理,并说明两者之间的关系。 二、(共12分) 某一无记忆信源的符号集为{0, 1},已知P(0) = 1/4,P(1) = 3/4。 1) 求符号的平均熵; 2) 有100个符号构成的序列,求某一特定序列(例如有m个“0”和(100 - m)个“1”)的自信息量的表达式; 3) 计算2)中序列的熵。 三、(共12分) 一阶马尔可夫信源的状态图如下图所示。信源X 的符号集为{0, 1, 2}。 1) 求平稳后信源的概率分布; 2) 求)(X H ; 3) 求上述一阶马尔可夫信源的冗余度。 P P 四、(共10分) 设离散型随机变量XYZ 的联合概率满足xyz ?)()()()(y z p x y p x p xyz p =。 求证:);();(Z Y X I Y X I ≥ 五、(共12分) 设有一离散无记忆信道,输入信号为321,,x x x ,输出为321,,y y y ,其信道转移矩阵为???? ??????=214141412141414121Q ,61)(,32)(21==x P x P 。 试分别按理想译码准则与最大似然译码准则确定译码规则,并计算相应的平均译码差错概率。 六、(共14分) 设有一离散信道,输入X ,输出Y ,其信道转移矩阵为?? ????7.01.02.02.01.07.0, 求:1)信道的信道容量及达到信道容量时的输入分布? 2)当输入X 分布为7.0)(1=x P 3.0)(2=x P 时,求平均互信息);(Y X I 及信道疑义度)(X Y H 。 重庆邮电大学2007/2008学年2学期 《信息论基础》试卷(期末)(A卷)(半开卷) 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X,其概率分布为 123 x x x X 111 P 244 ?? ?? ? = ?? ? ?? ?? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则 每十个符号的平均信息量是 15bit。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b,最小瞬时电压为a。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log(b-a)bit/自由度;若放大器的最高频率为F,则单位时间内输出的最大信息量是 2Flog(b-a)bit/s. 5. 若某一信源X,其平均功率受限为16w,其概率密度函数是高斯分布时,差熵的最大值为1 log32e 2 π;与其 熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r(S))。 8、当R=C或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,, =≥≤?”或“?” (1)当X和Y相互独立时,H(XY)=H(X)+H(X/Y)。 (2)假设信道输入用X表示,信道输出用Y表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) (一) 一、判断题共 10 小题,满分 20 分. 1. 当随机变量X 和Y 相互独立时,条件熵)|(Y X H 等于信源熵)(X H . ( ) 2. 由于构成同一空间的基底不是唯一的,所以不同的基 底或生成矩阵有可能生成同一码集. ( ) 3.一般情况下,用变长编码得到的平均码长比定长编码 大得多. ( ) 4. 只要信息传输率大于信道容量,总存在一种信道编译码,可以以所要求的任意小的误差概率实现可靠的通信. ( ) 5. 各码字的长度符合克拉夫特不等式,是唯一可译码存在的充分和必要条件. ( ) 6. 连续信源和离散信源的熵都具有非负性. ( ) 7. 信源的消息通过信道传输后的误差或失真越大,信宿收到消息后对信源存在的不确 定性就越小,获得的信息量就越小. 8. 汉明码是一种线性分组码. ( ) 9. 率失真函数的最小值是0.( ) 10.必然事件和不可能事件的自信息量都是0. ( ) 二、填空题共 6 小题,满分 20 分. 1 、 码 的 检 、 纠 错 能 力 取 决 于 . 2、信源编码的目的是 ;信道编码的目的是 . 3、把信息组原封不动地搬到码字前k 位的),(k n 码就叫 做 . 4、香农信息论中的三大极限定理 是 、 、 . 5、设信道的输入与输出随机序列分别为X 和Y ,则 ),(),(Y X NI Y X I N N =成立的 条件 . 6、对于香农-费诺编码、原始香农-费诺编码和哈夫曼编码, 编码方法惟一的是 . 7、某二元信源0 1()1/21/2X P X ????=??? ????? ,其失真矩阵 00a D a ?? =???? ,则该信源的max D = . 三、本题共 4 小题,满分 50 分. 1、某信源发送端有2种符号i x )2,1(=i ,a x p =)(1;接收端有3种符号i y )3,2,1(=j ,转移概 率 矩 阵 为 1/21/201/21/41/4P ?? =????. (1) 计算接收端的平均不确定度()H Y ; (2) 计算由于噪声产生的不确定度(|)H Y X ; (3) 计算信道容量以及最佳入口分布. 2、一阶马尔可夫信源的状态转移图如右图所示, 信源X 的符号集为}2,1,0{. 图2-13 信息论与编码期中试题答案 一、(10’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 二、(10?)判断题 (1)信息就是一种消息。(? ) (2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。(? ) (3)概率大的事件自信息量大。(? ) (4)互信息量可正、可负亦可为零。(? ) (5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。 (? ) (6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。(? ) (7)非奇异码一定是唯一可译码,唯一可译码不一定是非奇异码。(? ) (8)信源变长编码的核心问题是寻找紧致码(或最佳码)。 (? ) (9)信息率失真函数R(D)是关于平均失真度D的上凸函数. ( ? ) 三、(10?)居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (5分) 故p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (4分) I(A|B)=-log0.375=1.42bit (1分) 《信息论基础》模拟试卷 一、填空题(共15分,每空1分) 1、信源编码的主要目的是 ,信道编码的主要目的是 。 2、信源的剩余度主要来自两个方面,一是 ,二是 。 3、三进制信源的最小熵为 ,最大熵为 。 4、无失真信源编码的平均码长最小理论极限制为 。 5、当 时,信源与信道达到匹配。 6、根据信道特性是否随时间变化,信道可以分为 和 。 7、根据是否允许失真,信源编码可分为 和 。 8、若连续信源输出信号的平均功率为2σ,则输出信号幅度的概率密度是 时,信源具有最大熵,其值为值 。 9、在下面空格中选择填入数学符号“,,,=≥≤?”或“?” (1)当X 和Y 相互独立时,H (XY ) H(X)+H(X/Y) H(Y)+H(X)。 (2)()() 1222 H X X H X = ()()12333H X X X H X = (3)假设信道输入用X 表示,信道输出用Y 表示。在无噪有损信道中,H(X/Y) 0, H(Y/X) 0,I(X;Y) H(X)。 二、(6分)若连续信源输出的幅度被限定在【2,6】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少。 三、(16分)已知信源 1234560.20.20.20.20.10.1S s s s s s s P ????=???????? (1)用霍夫曼编码法编成二进制变长码;(6分) (2)计算平均码长L ;(4分) (3)计算编码信息率R ';(2分) (4)计算编码后信息传输率R ;(2分) (5)计算编码效率η。(2分) 四、(10分)某信源输出A 、B 、C 、D 、E 五种符号,每一个符号独立出现,出现概率分别为1/8、1/8、1/8、1/2、1/8。如果符号的码元宽度为0.5s μ。计算: (1)信息传输速率t R 。(5分) (2)将这些数据通过一个带宽为B=2000kHz 的加性白高斯噪声信道传输,噪声的单边功率谱密度为 6010W n Hz -=。试计算正确传输这些数据最少需要的发送功率P 。(5分) 安徽大学2011—2012学年第1学期 《信息论》考试试卷(AB 合卷) 院/系 年级 专业 姓名 学号 一、填空题 1、接收端收到y 后,获得关于发送的符号是x 的信息量是 。 2、香农信息的定义 。 3、在已知事件z Z ∈的条件下,接收到y 后获得关于事件x 的条件互信息(;|)I x y z 的表达式为 。 4、通信系统模型主要分成五个部分分别为: 。 5、研究信息传输系统的目的就是要找到信息传输过程的共同规律,以提高信息传输的可靠性、有效性、 和 ,使信息传输系统达到最优化。 6、某信源S 共有32个信源符号,其实际熵H ∞=1.4比特/符号,则该信源剩余度为 。 7、信道固定的情况下,平均互信息(;)I X Y 是输入信源概率分布()P x 的 型凸函数。 信源固定的情况下,平均互信息(;)I X Y 是信道传递概率(|)P y x 的 型凸函数。 8、当信源与信道连接时,若信息传输率达到了信道容量,则称此信源与信道达到匹配。信道剩余度定义为 。 9、已知信源X 的熵H (X )=0.92比特/符号,则该信源的五次无记忆扩展信源X 5的信息熵 5()H X = 。 10、将∞H ,6H ,0H ,4H ,1H 从大到小排列为 。 11、根据香农第一定理,对于离散无记忆信源S ,用含r 个字母的码符号集对N 长信源符号序列进行变长编码,总能找到一种无失真的唯一可译码,使每个信源符号所需平均码长满足: 。 12、多项式剩余类环[]())q F x f x 是域的充要条件为 。 13、多项式剩余类环[](1)n q F x x -的任一理想的生成元()g x 与1n x -关系为 。 14、有限域12 2F 的全部子域为 。 15、国际标准书号(ISBN )由十位数字12345678910a a a a a a a a a a 组成(诸i a ∈11F ,满足: 10 1 0(mod11)i i ia =≡∑) ,其中前九位均为0-9,末位0-10,当末位为10时用X 表示。《Handbook of Applied Cryptography 》的书号为ISBN :7-121-01339- ,《Coding and Information Theory 》的书号为ISBN :7-5062-3392- 。 二、判断题 1、互信息(;)I x y 与平均互信息(;)I X Y 都具有非负性质。 ( ) 2、离散信源的信息熵是信源无失真数据压缩的极限值。 ( ) 3、对于无噪无损信道,其输入和输出有确定的一一对应关系。 ( ) 4、对于有噪无损信道,其输入和输出有确定的一一对应关系。 ( ) 5、设有噪信道的信道容量为C ,若信息传输率R C >,只要码长n 足够长,必存在一种信道编码和相应的译码规则,使译码平均错误概率E P 为任意小。反之,若R C <则不存在以R 传输信息而E P 为任意小的码。 ( ) 6、在任何信息传输系统中,最后获得的信息至多是信源所提供的信息。如果一旦在某一 设信源1 234567()0.20.190.180.170.150.10.01X a a a a a a a p X ????=???? ???? (1) 求信源熵H(X); (2) 编二进制香农码; (3) 计算平均码长和编码效率. 解: (1) 7 21222222()()log () 0.2log 0.20.19log 0.19 0.18log 0.180.17log 0.170.15log 0.150.1log 0.10.01log 0.012.609/i i i H X p a p a bit symbol ==-=-?-?-?-?-?-?-?=∑ (2) (3) 7 1 ()0.230.1930.1830.1730.153 0.140.0173.141 ()()/ 2.609 3.14183.1% i i i K k p x H X H X K R η===?+?+?+?+?+?+?====÷=∑ 对习题的信源编二进制费诺码,计算编码效率. 解: a i p(a i )编码码字k i a1 0002 a2 1 00103 a310113 a4 1 0102 a5 1 01103 a6 1 011104 a7111114 对信源编二进制和三进制哈夫 曼码,计算各自的平均码长和编码效率. 解: 二进制哈夫曼码: x i p(x i)编码码字k i s61 s50 s41 s30 s21 x10102 x21112 x300003 x410013 x500103 s11 x6001104 x7101114 三进制哈夫曼码: x i p(x i)编码码字k i s31 s20 s11 x1221 x20002 x31012 x42022 x50102 x61112 x72122 一填空题(本题20分,每小题2分) 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 3、最大熵值为。 4、通信系统模型如下: 5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。 6、只要,当N足够长时,一定存在一种无失真编码。 7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。 9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。 按照信息的地位,可以把信息分成客观信息和主观信息。 人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。 信息的可度量性是建立信息论的基础。 统计度量是信息度量最常用的方法。 熵是香农信息论最基本最重要的概念。 事物的不确定度是用时间统计发生概率的对数来描述的。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。 12、自信息量的单位一般有比特、奈特和哈特。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是∞。 15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。 17、离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 18、离散平稳有记忆信源的极限熵,。 19、对于n元m阶马尔可夫信源,其状态空间共有 nm 个不同的状态。 20、一维连续随即变量X在[a,b]区间内均匀分布时,其信源熵为 log2(b-a)。 2004信息论基础试题 xx年香农在贝尔杂志上发表了两篇有关的“通信的数学理论”文章,该文用 2 对信源的不确定性的度量,是衡量信息量大小的一个尺度;用 3 来度量两事件的依赖程度,表现在通信领域就是输入和输出两事件的相互的信息量,若把它取最大值,就是通信线路的 4 ,若把它取最小值,就是 5 ;无失真压缩的理论依据: 6 ,限失真压缩理论依据: 7 ;香农第一定理又称 8 编码定理,编码后的码符号信源尽可能为 11 ,使每个码符号平均所含的信息量达到 9 ,要做到无失真编码,变换每个信源符号平均所需最少的r元码元数就是信源的 10 。 二简答题 1.简述最大离散熵定理。对于一个有m个符号的离散信源,其最大熵是多少? 2.连续信源的绝对熵多大,你想到了什么? 3.用一个实例说明你对信号、消息、信息的理解。 4.写出香农公式,并说明其物理意义。当信道带宽为5000Hz,信噪比为30dB时求信道容量。 5.解释下图阴影部分含义。 R(D)1R'(D)(实际)R(D) 1/2D 6.比较信息熵和互信息两个概念的异同之处及相互关 系。 7.解释等长信源编码定理和无失真变长信源编码定理,说明对于等长码和变长码,最佳码的每符号平均码长最小为多少?编码效率最高可达多少? 8.分别说明信源的概率分布和信道转移概率对平均互信息的影响,说明平均互信息与信道容量的关系。 9.二元无记忆信源,有求: 某一信源序列100个二元符号组成,其中有m个“1”,求其自信息量?求100个符号构成的信源序列的熵。 10.求一一对应确定信道P1的信道容量:三计算题 1.黑白气象传真图的消息只有黑色和白色两种,求: 1)黑色出现的概率为,白色出现的概率为。给出这个只有两个符号的信源X的数学模型。假设图上黑白消息出现前后没有关联,求熵 ; 2)假设黑白消息出现前后有关联,其依赖关系为:, ,求其熵H∞; ,, 3)比较H(X)和H∞的大小,并说明其物理含义。 2.二元对称信道如图。 1)若,,求和; 设信源? ?????=? ?????01.01.015.017.018.019.02.0)(765432 1x x x x x x x X P X (1) 求信源熵H(X); (2) 编二进制香农码; (3) 计算平均码长和编码效率。 解: (1) symbol bit x p x p X H i i i /609.2)01.0log 01.01.0log 1.015.0log 15.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0() (log )()(22222227 1 2=?+?+?+?+?+?+?-=-=∑= (2) (3) %1. 8314.3609 .2)()(14 .301 .071.0415.0317.0318.0319.032.03)(==== =?+?+?+?+?+?+?==∑K X H R X H x p k K i i i η 对信源? ?????=? ?????01.01.015.017.018.019.02.0)(765432 1x x x x x x x X P X 编二进制费诺码,计算编码效率。 解: %2.9574.2609 .2)()(74 .201 .041.0415.0317.0218.0319.032.02)(==== =?+?+?+?+?+?+?==∑K X H R X H x p k K i i i η 对信源??????=? ?????01.01.015.017.018.019.02.0)(765432 1x x x x x x x X P X 编二进制和三进制哈夫曼码,计算各自的平均码长和编码效率。 解: 二进制哈夫曼码: 《信息论与编码(第二版)》曹雪虹答案 第二章 2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =? ? ?=?? 2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2, (1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。画出 状态图,并计算各状态的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 重庆理工大学硕士研究生招生考试试题专用纸 第1页 重庆理工大学2019年攻读硕士学位研究生入学考试试题 学院名称:电气与电子工程学院 学科、专业名称:信息与通信工程 考试科目(代码):信息论基础(813)(A 卷) (试题共 3 页) 一、填空题(30分,每题3分) 1、根据计算自信息量的对数底的不同选择,自信息量的单位有三种,当对数底为2时对应的单位为 。 2、 是指包含信息的语言、文字和图像等,例如我们每天从报纸、电视节目和互联网中获得的各种新闻等。 3、有记忆信源是指信源发出的前后符号之间是具有 性。 4、信道上所能传输的最大信息量称之为 。 5、为了定量地描述信号传输的差错,定义收发码之“差”为 。 6、码字110111010和码字010101011的码间距离为 。 7、已知某线性分组码的码间最小距离为6,其最多能独立纠正的码元位数为 。 8、具有6.5MHz 带宽的某高斯信道,若信道中信号功率与噪声功率之比255,则该信道上所能传输的最高信息速率为 M bit/s 。 9、克劳夫特(Kraft)不等式可以用来判断满足某种码长的唯一可译码是否存在。假设进行2进制编码,共有N 个不同的码字,第i 个码字对应的码长为i K ,其克劳夫特不等式为 。 10、无失真的信源定长编码定理说明,当码字长度L 足够大时,只要码字所携带的信息量 信源序列输出的信息量,则可以使传输几乎无失真。 二、简述题(60分,每题15分) 1、试从信息论与编码角度简述数字通信系统的基本模型。画出模型框图,并阐述模型中各部分的主要作用。 2、请给出至少3条熵的性质,并进行简单阐述。 3、什么是信源的冗余度?产生冗余度的两个主要原因是什么? 北方民族大学试卷 课程代码: 01100622 课程:信息理论及编码 B 卷答案 : 号学 说明:此卷为《信息理论及编码》 B 卷答案 一、概念简答题(每小题6分,共30分) 1、比较平均自信息(信源熵)与平均互信息的异同。 。题试试 考 末期期学季 秋 年学 - —80 名姓班级业专程工息信院学 程工息信气电 线 - q - 答:平均自信息为 H X - -7 p q log p q ,表示信源的平均不确定度, 也表示平 - i 4 - 均每个信源消息所提供的信息量。 ........................... (3分) 平均互信息I X;Y P xy log X,Y 。表示从Y 获得的关于每个 X 的平均信息量, 也表示发X 前后Y 的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 (3分) 2、简述香农第一定理。 - 答:对于离散信源 S 进行r 元编码,只要其满足 L N _匕^, ..................................... (3分) - N log r - 当N 足够长,总可以实现无失真编码。 ............................. (3分) 密 3、简述唯一可译变长码的判断方法? - 答:将码C 中所有可能的尾随后缀组成一个集合 F ,当且仅当集合 F 中没有包含任一码字 - 时,码C 为唯一可译变长码。构成集合 F 的方法: ............. (2分) 首先,观察码C 中最短的码字是否是其他码字的前缀。若是,将其所有可能的尾随后缀排 列出。而这些尾随后缀又可能是某些码字的前缀, 再将由这些尾随后缀产生的新的尾随后 缀列出。依此下去,直至没有一个尾随后缀是码字的前缀或没有新的尾随后缀产生为 止。 .............(2分) 接着,按照上述步骤将次短的码字直至所有码字可能产生的尾随后缀全部列出, 得到尾随 后缀集合F 。 ............. (2分) 4、简述最大离散熵定理。 答:最大离散熵定理为:对于离散无记忆信源,当信源等概率分布时熵最大。…… (3分) 对于有m 个符号的离散信源,其最大熵为 log m 。 (3分) 一、填空题(每空1分,共35分) 1、1948年,美国数学家 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。信息论的基础理论是 ,它属于狭义信息论。 2、信号是 的载体,消息是 的载体。 3、某信源有五种符号}{,,,,a b c d e ,先验概率分别为5.0=a P ,25.0=b P ,125.0=c P ,0625.0==e d P P ,则符号“a ”的自信息量为 bit ,此信源的熵为 bit/符号。 4、某离散无记忆信源X ,其概率空间和重量空间分别为1 234 0.50.250.1250.125X x x x x P ????=??? ?????和1234 0.5122X x x x x w ???? =??????? ? ,则其信源熵和加权熵分别为 和 。 5、信源的剩余度主要来自两个方面,一是 ,二是 。 6、平均互信息量与信息熵、联合熵的关系是 。 7、信道的输出仅与信道当前输入有关,而与过去输入无关的信道称为 信道。 8、马尔可夫信源需要满足两个条件:一、 ; 二、 。 9、若某信道矩阵为????? ????? ??01000 1 000001 100,则该信道的信道容量C=__________。 10、根据是否允许失真,信源编码可分为 和 。 11、信源编码的概率匹配原则是:概率大的信源符号用 ,概率小的信源符号用 。(填 短码或长码) 12、在现代通信系统中,信源编码主要用于解决信息传输中的 性,信道编码主要用于解决信息传输中的 性,保密密编码主要用于解决信息传输中的安全性。 13、差错控制的基本方式大致可以分为 、 和混合纠错。 14、某线性分组码的最小汉明距dmin=4,则该码最多能检测出 个随机错,最多能纠正 个随机错。 15、码字101111101、011111101、100111001之间的最小汉明距离为 。 16、对于密码系统安全性的评价,通常分为 和 两种标准。 17、单密钥体制是指 。 18、现代数据加密体制主要分为 和 两种体制。 19、评价密码体制安全性有不同的途径,包括无条件安全性、 和 。 20、时间戳根据产生方式的不同分为两类:即 和 。 二、选择题(每小题1分,共10分) 1、下列不属于消息的是( )。 A. 文字 B. 信号 C. 图像 D. 语言 2、设有一个无记忆信源发出符号A 和B ,已知4341)(,)(==B p A p ,发出二重符号序列消息的信源, 无记忆信源熵)(2X H 为( )。 A. 0.81bit/二重符号 B. 1.62bit/二重符号 C. 0.93 bit/二重符号 D . 1.86 bit/二重符号 3、 同时扔两个正常的骰子,即各面呈现的概率都是1/6,若点数之和为12,则得到的自信息为( )。 A. -log36bit B. log36bit C. -log (11/36)bit D. log (11/36)bit 4、 二进制通信系统使用符号0和1,由于存在失真,传输时会产生误码,用符号表示下列事件,x0: 发出一个0 、 x1: 发出一个1、 y0 : 收到一个0、 y1: 收到一个1 ,则已知收到的符号,被告知发出的符号能得到的信息量是( )。 A. H(X/Y) B. H(Y/X) C. H( X, Y) D. H(XY) 5、一个随即变量x 的概率密度函数P(x)= x /2,V 20≤≤x ,则信源的相对熵为( )。 A . 0.5bit B. 0.72bit C. 1bit D. 1.44bit 6、 下面哪一项不属于熵的性质: ( ) A .非负性 B .完备性 C .对称性 D .确定性 信息论与编码 信息论与编码 试题编号: 重庆邮电大学2007/2008学年2学期 《信息论基础》试卷(期末)(A 卷)(半开卷) 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分 为 和 2.一个八进制信源的最大熵为 3.有一信源X ,其概率分布为??? ? ????=??????414121 32 1 x x x P X ,其信源剩余度为 ;若对该信源进行十次扩展,则每十个符号的平均信息量是 。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是 ;其能在每个自由度熵的最大熵是 ;若放大器的最高频率为F ,则单位时间内输出的最大信息量是 . 5. 若某一 信源X ,其平均功率受限为16w ,其概率密度函数是高斯分布时,差熵的最大值为 ;与其熵相等的非高斯分布信源的功率为 6、信源编码的主要目的是 ,信道编码的主要目的是 。 7、无失真信源编码的平均码长最小理论极限制为 . 8、当时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为和。 10、在下面空格中选择填入数学符号“,,, =≥≤?”或“?” (1)当X和Y相互独立时,H(XY) H(X)+H(X/Y)。 (2)假设信道输入用X表示,信道输出用Y表示。在无噪有损信道中,H(X/Y) 0, H(Y/X) 0,I(X;Y) H(X)。 二、(8分)掷两粒骰子,各面出现的概率都是1/6,计算信息量: 1.当点数和为3时,该消息包含的信息量是多少? 2.当点数和为7是,该消息包含的信息量是多少? 3.两个点数中没有一个是1的自信息是多少? 三、(12分)设X、Y是两个相互统计独立的二元随机变量,其取-1或1的概率相等。定义另一个二元随机变量Z,取Z=YX(一般乘积)。试计算: 1.H(Y)、H(Z); 2.H(XY)、H(YZ); 3.I(X;Y)、I(Y;Z); 四、(15分)如图所示为一个三状态马尔科夫信源的转移概率矩阵 P= 11 22 11 0 22 111 424?? ? ? ? ? ? ? ???信息论考试题

信息论基础》试卷(期末A卷

信息论与编码期末考试题(全套)

信息论与编码期中试卷及答案

信息论试卷含答案

(整理)信息论期末考试试题1.

信息论与编码第五章答案

信息论与编码试题集与答案

2004信息论基础试题

信息论第五章答案

信息论与编码(第二版)曹雪虹(最全版本)答案

重庆理工大学2019年《813信息论基础》考研专业课真题试卷

《信息论》期末考试B卷答案

信息理论与编码期末试卷A及答案

信息论基础》试卷(期末A卷