数据预处理——剔除异常值及平滑处理

测量数据在其采集与传输过程中,由于环境干扰或人为因素有可能造成个别数据不切合实际或丢失,这种数据称为异常值。为了恢复数据的客观真实性以便将来得到更好的分析结果,有必要先对原始数据剔除异常值。

另外,无论是人工观测的数据还是由数据采集系统获取的数据,都不可避免叠加上“噪声”干扰(反映在曲线图形上就是一些“毛刺和尖峰”)。为了提高数据的质量,必须对数据进行平滑处理(去噪声干扰)。

(一)剔除异常值。

注:若是有空缺值,或导入Matlab 数据显示为“NaN ”(非数),需要忽略整条空缺值数据,或者填上空缺值。

填空缺值的方法,通常有两种:A. 使用样本平均值填充;B. 使用判定树或贝叶斯分类等方法推导最可能的值填充(略)。 一、基本思想:

规定一个置信水平,确定一个置信限度,凡是超过该限度的误差,就认为它是异常值,从而予以剔除。

二、常用方法:拉依达方法、肖维勒方法、一阶差分法。

注意:这些方法都是假设数据依正态分布为前提的。 1. 拉依达方法(非等置信概率)

如果某测量值与平均值之差大于标准偏差的三倍,则予以剔除。

3x i x x S ->

其中,11

n i i x x n ==∑为样本均值,1

2

211()1n

x i i S x x n =?? ???

=--∑为样本的标准偏差。

注:适合大样本数据,建议测量次数≥50次。 代码实例(略)。

2. 肖维勒方法(等置信概率)

在 n 次测量结果中,如果某误差可能出现的次数小于半次时,就予以剔除。

这实质上是规定了置信概率为1-1/2n ,根据这一置信概率,可计算出肖维勒系数,也可从表中查出,当要求不很严格时,还可按下列近似公式计算:

10.4ln()n n ω=+

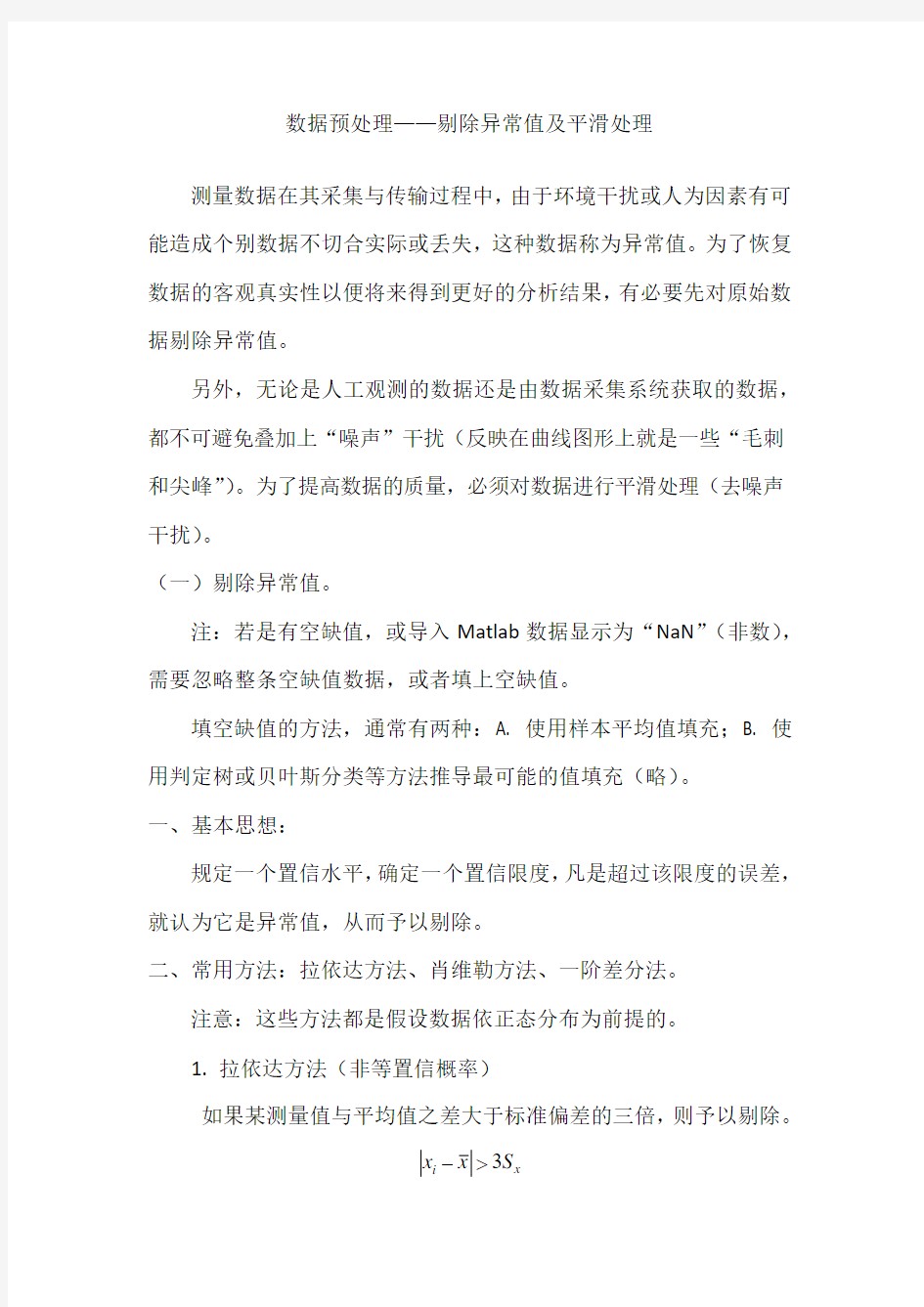

Tab1. 肖维勒系数表

如果某测量值与平均值之差的绝对值大于标准偏差与肖维勒系数之积,则该测量值被剔除。

n x i x x S ω->

例1. 利用肖维勒方法对下列数据的异常值(2.5000)进行剔除: 1.5034 1.5062 1.5034 1.5024 1.4985 2.5000 1.5007

1.5067 1.4993 1.4969

上述数据保存于文件erro.dat

代码:

x=load('error.dat');

n=length(x);

subplot(2,1,1);

plot(x,'o');

title('原始数据')

axis([0,n+1,min(x)-1,max(x)+1]);

w=1+0.4*log(n);

yichang = abs(x-mean(x)) > w*std(x);

% 若用拉依达方法,把w改成3即可,但本组数据将不能成功剔除异常值。x(yichang)=[];

save errornew.dat x -ASCII

subplot(2,1,2);

plot(x,'rs');

title('异常值剔除后数据');

axis([0,n+1,min(x)-1,max(x)+1]);

运行结果:x =

1.5034 1.5062 1.5034 1.5024 1.4985

2.5000 1.5007 1.5067 1.4993 1.4969

y =

1.5034 1.5062 1.5034 1.5024 1.4985 1.5007 1.5067 1.4993 1.4969

3. 一阶差分法(预估比较法)

用前两个测量值来预估新的测量值,然后用预估值与实际测量值比较,若大于事先给定的允许差限值,则剔除该测量值。 预估值

112()?n n n n x

x x x ---+-= 比较判别:

?n n x x

W -< 注:该方法的特点是

(1)适合于实时数据采集与处理过程;

(2)精度除了与允许误差限的大小有关外,还与前两点测量值的精确度有关;

(3)若被测物理量的变化规律不是单调递增或单调递减函数,这

一方法将在函数的拐点处产生较大的误差,严重时将无法使用。 (二)数据的平滑处理

对于一组测量数据(xi ,yi ) i=1,…,n ,不要直接就想着求出的拟合多项式的线性参数,而是要先平滑处理去掉“噪声”。平滑处理在科学研究中广泛使用,它可以减少测量中统计误差带来的影响,尤其被用于无法利用多次重复测量来得到其平均值的情况和当yi 随xi 有徒然变化的那些测量段。

1. “(2n+1点)单纯移动平均”平滑滤波

取出以yi 为中心的前后各n 个数据(yi-n, …,yi-1,yi,…yi+n )求平均值代替yi ,即

'

1121n

i i k n

y y n +=-=+∑ 优点:方法简单,计算方便。

缺点:方法产生误差会造成信号失真;前后各n 个数据无法平滑。 适用性:适用于变化缓慢的数据。 注:n 越大平滑效果越好,但失真也越大。 例2. “9点单纯移动平均”平滑滤波

代码:

% 建立“n 点单纯移动平均”的滤波函数 % 注意函数要单独保存为与函数名同名的.m 文件 function Y=smooth_data(y,n)

m=length(y); j=1;

for i=(n-1)/2+1:(m-(n-1)/2) p=i-(n-1)/2;

q=i+(n-1)/2;

Y(j)=sum(y(p:q))/n;

j=j+1;

end

end

% 主程序

clc

clear

t=-15:0.5:15;

n=length(t);

Y=5./(1+t.^2); % 原始测试数据

y=Y+(0.5-rand(1,n)); % 给测试数据加上噪声干扰y1=smooth_data(y,9); % 调用函数作9点滤波处理plot(1:n,Y,1:n,y,'-o',5:n-4,y1,'-*'); legend('无噪声','含噪声','9点平滑后');

运行结果:

2.“加权移动平均”平滑滤波

加权的基本思想:

作平均的区间内中心处数据的权值最大,愈远离中心处的数据权值越小小。这样就减小了对真实信号本身的平滑作用。

权重系数可以采用最小二乘原理,使平滑后的数据以最小均方差逼近原始数据。即令

'2min ()i k i k k

y y ++-∑

通常采用“五点二次平滑” (n=5, k=-2,-1,0,1,2)

22

012222

01222

22

0122

()0()0()0i k k i k k i k k y A A k A k y A A k A k k y A A k A k k +=-+=-+=-?---=???---=???---=??∑∑∑ 五点二次平滑权重系数表:

()'0210121

3121712335y y y y y y --=

-+++-

3.用“smooth函数”平滑滤波

调用格式:

Z = smooth(Y, span, method)

说明:

Z:平滑后的数据向量

Y:被平滑的数据向量

span:平滑点数,缺省为5点

method :平滑方法,缺省为移动平滑,其它还有

‘moving’——Moving average (default)单纯移动平均

‘lowess’——Lowess (linear fit)线性加权平滑

‘loess’——Loess (quadratic fit)二次加权平滑

'sgolay' ——Savitzky-Golay

'rlowess' ——Robust Lowess (linear fit)

'rloess' ——Robust Loess (quadratic fit)

例3.用matlab自带的平滑函数作平滑滤波实例。

代码:

t=-10:0.5:10;

n=length(t);

y=5./(1+t.^2); % 原始测试数据

y1=y+0.5*(0.5-rand(1,n)); % 给测试数据加上噪声干扰

% 调用多个滤波函数作滤波处理

y2=smooth(y1,3); y3=smooth(y1,9);

y4=smooth(y1,3,'lowess'); y5=smooth(y1,9,'lowess');

y6=smooth(y1,3,'loess'); y7=smooth(y1,9,'loess');

y8=smooth(y1,3,'rloess'); y9=smooth(y1,9,'rloess');

figure(1); % 第一张图

subplot(3,2,1);

plot(t,y); axis([-10 10 -1 6]); grid on

title('无噪声信号');

subplot(3,2,2);

plot(t,y1,'-*'); axis([-10 10 -1 6]); grid on title('含噪声信号');

subplot(3,2,3);

plot(t,y2,'-*'); axis([-10 10 -1 6]); grid on title('3点单纯移动平均');

subplot(3,2,4);

plot(t,y3,'-*'); axis([-10 10 -1 6]); grid on title('9点单纯移动平均');

subplot(3,2,5);

plot(t,y4,'-*'); axis([-10 10 -1 6]); grid on title('3点线性加权平滑');

subplot(3,2,6);

plot(t,y5,'-*'); axis([-10 10 -1 6]); grid on title('9点线性加权平滑');

figure(2); % 第二张图

subplot(3,2,1);

plot(t,y); axis([-10 10 -1 6]); grid on

title('无噪声信号');

subplot(3,2,2);

plot(t,y1,'-*'); axis([-10 10 -1 6]); grid on title('含噪声信号');

subplot(3,2,3);

plot(t,y6,'-*'); axis([-10 10 -1 6]); grid on title('3点二次加权平滑');

subplot(3,2,4);

plot(t,y7,'-*'); axis([-10 10 -1 6]); grid on title('9点二次加权平滑');

subplot(3,2,5);

plot(t,y8,'-*'); axis([-10 10 -1 6]); grid on title('3点rloess平滑');

subplot(3,2,6);

plot(t,y9,'-*'); axis([-10 10 -1 6]); grid on title('9点rloess平滑');

运行结果:

Figure 1

Figure 2

4.用“smoothts函数”(盒子法、高斯窗法、指数法)平滑滤波

调用格式:

output = smoothts(input)

output = smoothts(input, ‘b’, wsize) % 盒子法

output = smoothts(input, ‘g’, wsize, stdev) % 高斯窗方法

output = smoothts(input, ‘e’, n) % 指数法

例4.读取股市数据,对开盘价的240条数据,调用smoothts函数进行平滑处理。

代码:

x=xlsread('D:\Program

Files\MATLAB\MyWorks\gupiaoshuju01.xls'); % 读取数据文件

p0=x(1:240,1)'; % 用开盘价所在列的前240条数据

% 注意若不转置可能导致后面处理结果异常

subplot(2,2,1);

plot(p0,'k','LineWidth',1.5);

% 绘制平滑后曲线图,黑色实线,线宽1.5 xlabel('观测序号');

ylabel('股市日开盘价');

axis([0 250 1000 1400]);

p1 = smoothts(p0,'b',30); % 用盒子法平滑数据,窗宽为30 subplot(2,2,2);

plot(p0,'.'); % 绘制日开盘价散点图

plot(p0,'.','markersize',3); 可以改变点的大小

hold on

plot(p1,'k','LineWidth',1.5);

xlabel('观测序号');

ylabel('盒子法');

legend('原始散点','平滑曲线','location','northwest'); axis([0 250 1000 1400]);

p2 = smoothts(p0,'g',30);

% 高斯窗方法,窗宽为30,标准差为默认值0.65

subplot(2,2,3);

plot(p0,'.');

hold on

plot(p2,'k','LineWidth',1.5);

xlabel('观测序号'); ylabel('高斯窗方法');

legend('原始散点','平滑曲线','location','northwest'); axis([0 250 1000 1400]);

p3 = smoothts(p0,'e',30); % 用指数法平滑数据,窗宽为30 subplot(2,2,4);

plot(p0,'.');

hold on

plot(p3,'k','LineWidth',1.5);

xlabel('观测序号'); ylabel('指数方法');

legend('原始散点','平滑曲线','location','northwest');

axis([0 250 1000 1400]);grid on

title('9点rloess平滑');

运行结果:

5.用medfilt1函数(一维中值滤波)

调用格式:

y = medfilt1(x,n)

y = medfilt1(x,n,blksz)

y = medfilt1(x,n,blksz,dim)

例5.产生一列正弦波信号,加入噪声信号,然后调用medfilt1函数对加入噪声的正弦波进行滤波(平滑处理)。

代码:

t = linspace(0,4*pi,500)';

% 产生一个从0到4*pi的向量,长度为500

y = 100*sin(t); % 产生正弦波信号

noise = normrnd(0,15,500,1);

% 产生500行1列的服从N(0,152)分布的随机数,作为噪声信号

y = y + noise; % 将正弦波信号加入噪声信号

subplot(2,1,1);

plot(t,y);

xlabel('时间');

ylabel('加噪声的正弦波');

% 调用medfilt1对加噪正弦波信号y进行中值滤波,并绘制波形图

yy = medfilt1(y,30); % 指定窗宽为30,对y进行中值滤波

subplot(2,1,2);

plot(t,y,'b:'); % b:表示蓝色虚线

hold on

plot(t,yy,'k','LineWidth',2); % 绘制平滑后曲线,黑色实线,线宽2 xlabel('时间');

ylabel('中值滤波');

legend('加噪波形','平滑后波形');

运行结果:

如何对市场调研问卷的数据进行预处理 市场调研问卷数据的预处理是整个市场调研工作的重要环节,如果预处理做得不好,就会使有问题的问卷进入后面的数据分析环节,对最终结果产生严重影响。 一、信度检验 1.信度分析简介 信度,即信任度,是指问卷数据的可信任程度。信度是保证问卷质量的重要手段,严谨的问卷分析通常会采用信度分析筛选部分数据。 α值是信度分析中的一个重要指标,它代指0~1的某个数值,如果α值小于0.7,该批次问卷就应当剔除或是进行处理;如果大于0.9,则说明信度很高,可以用于数据分析;如果位于0.7~0.9,则要根据具体情况进行判定。如表1所示。 α值意义 >0.9信度非常好 >0.8信度可以接受 >0.7需要重大修订但是可以接受 <0.7放弃 2.信度分析示例 操作过程 下面介绍的是一个信度分析的案例,其操作过程为:首先打开信度分析文件,可以看到该文件的结构很简单,一共包含10个题目,问卷的份数是102份。然后进入SPSS的“分析”模块,找到“度量”下面的“可靠性分析”,将这十个题目都选进去。 在接下来的统计量中,首先看平均值、方差和协方差等,为了消除这些变量的扰动,可以选择要或者不要这些相关的量,另外ANOVA(单音数方差分析)是分析两个变量之间有无关系的重要指标,一般选择要,但在这里可以不要,其他一些生僻的量值一般不要。描述性在多数情况下需要保留,因为模型的输出结果会有一些描述,因此应当选中项、度量和描述性,然后“确定”,这时SPSS输出的结果就会比较清楚。 结果解读 案例处理汇总后,SPSS输出的结果如图1所示。

图1 信度分析结果 由图1可知,案例中调查问卷的有效数据是102,已排除数是0,说明数据都是有效的,在这里如果某个问卷有缺失值,就会被模型自动删除,然后显示出已排除的问卷数。在信度分析中,可以看到Alpha值是0.881,根据前文的判定标准,这一数值接近0.9,可以通过。在图右下方部分有均值、方差、相关性等多个项目,这主要看最后的“项已删除的Alpha值”,该项目表示的是删除相应项目后整个问卷数据信度的变动情况,可以看出题目1、题目2和题目6对应的数值高于0.881,表明删除这三个题目后整个问卷的Alpha值会上升,为了确保整个调查的严谨性,应当将这三个题目删除。 二、剔除废卷 删除废卷大致有三种方法:根据缺失值剔除、根据重复选项剔除、根据逻辑关系剔除。 1.根据缺失值剔除 缺失值的成因 在市场调查中,即使有非常严格的质量控制,在问卷回收后仍然会出现缺项、漏项,这种情况在涉及敏感性问题的调查中尤其突出,缺失值的占比甚至会达到10%以上。之所以会出现这种现象,主要有以下原因:一是受访者对于疾病、收入等隐私问题选择跳过不答,二是受访者由于粗心大意而漏掉某些题目等。 缺失值的处理 在处理缺失值时,有些人会选择在SPSS或Excel中将其所在的行直接删除。事实上,不能简单地删除缺失值所在的行,否则会影响整个问卷的质量。这是因为在该行中除了缺失的数据以外,其他数据仍旧是有效的,包含许多有用信息,将其全部删除就等于损失了这部分信息。 在实际操作中,缺失值的处理主要有以下方式,如图2所示。

数据分析一定少不了数据预处理,预处理的好坏决定了后续的模型效果,今天我们就来看看预处理有哪些方法呢? 记录实战过程中在数据预处理环节用到的方法~ 主要从以下几个方面介绍: ?常用方法 ?N umpy部分 ?P andas部分 ?S klearn 部分 ?处理文本数据 一、常用方法 1、生成随机数序列 randIndex = random.sample(range(trainSize, len(trainData_copy)), 5*tra inSize) 2、计算某个值出现的次数 titleSet = set(titleData) for i in titleSet: count = titleData.count(i)

用文本出现的次数替换非空的地方。词袋模型 Word Count titleData = allData['title'] titleSet = set(list(titleData)) title_counts = titleData.value_counts() for i in titleSet: if isNaN(i): continue count = title_counts[i] titleData.replace(i, count, axis=0, inplace=True) title = pd.DataFrame(titleData) allData['title'] = title 3、判断值是否为NaN def isNaN(num): return num != num 4、 Matplotlib在jupyter中显示图像 %matplotlib inline 5、处理日期 birth = trainData['birth_date'] birthDate = pd.to_datetime(birth) end = pd.datetime(2020, 3, 5) # 计算天数birthDay = end - birthDate birthDay.astype('timedelta64[D]') # timedelta64 转到 int64 trainData['birth_date'] = birthDay.dt.days

matlab 中归一化的几种方法及其各自的适用条件 关于神经网络(matlab)归一化的整理 关于神经网络归一化方法的整理 由于采集的各数据单位不一致,因而须对数据进行[-1,1]归一化处理,归一化方法主要有如下几种,供大家参考:(by james) 1、线性函数转换,表达式如下: y=(x-MinValue)/(MaxValue-MinValue) 说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。 2、对数函数转换,表达式如下: y=log10(x) 说明:以10为底的对数函数转换。 3、反余切函数转换,表达式如下: y=atan(x)*2/PI 归一化是为了加快训练网络的收敛性,可以不进行归一化处理 归一化的具体作用是归纳统一样本的统计分布性。归一化在0-1之间是统计的概率分布,归一化在-1--+1之间是统计的坐标分布。归一化有同一、统一和合一的意思。无论是为了建模还是为了计算,首先基本度量单位要同一,神经网络是以样本在事件中的统计分别几率来进行训练(概率计算)和预测的,归一化是同一在0-1之间的统计概率分布; 当所有样本的输入信号都为正值时,与第一隐含层神经元相连的权值只能同时增加或减小,从而导致学习速度很慢。为了避免出现这种情况,加快网络学习速度,可以对输入信号进行归一化,使得所有样本的输入信号其均值接近于0或与其均方差相比很小。 归一化是因为sigmoid函数的取值是0到1之间的,网络最后一个节点的输出也是如此,所以经常要对样本的输出归一化处理。所以这样做分类的问题时用[0.9 0.1 0.1]就要比用[1 0 0]要好。 但是归一化处理并不总是合适的,根据输出值的分布情况,标准化等其它统计变换方法有时可能更好。 关于用premnmx语句进行归一化: premnmx语句的语法格式是:[Pn,minp,maxp,Tn,mint,maxt]=premnmx(P,T) 其中P,T分别为原始输入和输出数据,minp和maxp分别为P中的最小值和最大值。mint 和maxt分别为T的最小值和最大值。 premnmx函数用于将网络的输入数据或输出数据进行归一化,归一化后的数据将分布在[-1,1]区间内。 我们在训练网络时如果所用的是经过归一化的样本数据,那么以后使用网络时所用的新数据也应该和样本数据接受相同的预处理,这就要用到tramnmx。 下面介绍tramnmx函数: [Pn]=tramnmx(P,minp,maxp) 其中P和Pn分别为变换前、后的输入数据,maxp和minp分别为premnmx函数找到的最大值和最小值。 (by terry2008) matlab中的归一化处理有三种方法 1. premnmx、postmnmx、tramnmx

数据中异常值的检测与处理方法 一、数据中的异常值 各种类型的异常值: 数据输入错误:数据收集,记录或输入过程中出现的人为错误可能导致数据异常。例如:一个客户的年收入是$ 100,000。数据输入运算符偶然会在图中增加一个零。现在收入是100万美元,是现在的10倍。显然,与其他人口相比,这将是异常值。 测量误差:这是最常见的异常值来源。这是在使用的测量仪器出现故障时引起的。例如:有10台称重机。其中9个是正确的,1个是错误的。 有问题的机器上的人测量的重量将比组中其他人的更高/更低。在错误的机器上测量的重量可能导致异常值。 实验错误:异常值的另一个原因是实验错误。举例来说:在七名跑步者的100米短跑中,一名跑步者错过了专注于“出发”的信号,导致他迟到。 因此,这导致跑步者的跑步时间比其他跑步者多。他的总运行时间可能是一个离群值。 故意的异常值:这在涉及敏感数据的自我报告的度量中通常被发现。例如:青少年通常会假报他们消耗的酒精量。只有一小部分会报告实际价值。 这里的实际值可能看起来像异常值,因为其余的青少年正在假报消费量。 数据处理错误:当我们进行数据挖掘时,我们从多个来源提取数据。某些操作或提取错误可能会导致数据集中的异常值。 抽样错误:例如,我们必须测量运动员的身高。错误地,我们在样本中包括一些篮球运动员。这个包含可能会导致数据集中的异常值。 自然异常值:当异常值不是人为的(由于错误),这是一个自然的异常值。例如:保险公司的前50名理财顾问的表现远远高于其他人。令人惊讶的是,这不是由于任何错误。因此,进行任何数据挖掘时,我们会分别处理这个细分的数据。

在以上的异常值类型中,对于房地产数据,可能出现的异常值类型主 要有:(1)数据输入错误,例如房产经纪人在发布房源信息时由于输入错误,而导致房价、面积等相关信息的异常;在数据的提取过程中也可能会出现异常值,比如在提取出售二手房单价时,遇到“1室7800元/m 2”,提取其中的数字结果为“17800”,这样就造成了该条案例的单价远远异常于同一小区的其他房源价格,如果没有去掉这个异常值,将会导致整个小区的房屋单价均值偏高,与实际不符。(2)故意的异常值,可能会存在一些人,为了吸引别人来电询问房源,故意把价格压低,比如房屋单价为1元等等;(3)自然异常值。房价中也会有一些实际就是比普通住宅价格高很多的真实价格,这个就需要根据实际请况进行判断,或在有需求时单独分析。 二、数据中异常值的检测 各种类型的异常值检测: 1、四分位数展布法 方法[1]:大于下四分位数加倍四分位距或小于上四分位数减倍。 把数据按照从小到大排序,其中25%为下四分位用FL 表示,75%处为上四分位用FU 表示。 计算展布为:L U F F F d -=,展布(间距)为上四分位数减去下四分位数。 最小估计值(下截断点):F L d F 5.1- 最大估计值(上截断点):F U d F 5.1+ 数据集中任意数用X 表示,F U F L d F X d F 5.15.1+<<-, 上面的参数不是绝对的,而是根据经验,但是效果很好。计算的是中度异常,参数等于3时,计算的是极度异常。我们把异常值定义为小于下截断点,或者大于上截断点的数据称为异常值。

遥感讲座——遥感影像预处理 据预处理是遥感应用的第一步,也是非常重要的一步。目前的技术也非常成熟,大多数的商业化软件都具备这方面的功能。预处理的大致流程在各个行业中有点差异,而且注重点也各有不同。下面是预处理中比较常见的流程。 1、数据预处理一般流程 数据预处理的过程包括几何精校正、配准、图像镶嵌与裁剪、去云及阴影处理和光谱归一化几个环节,具体流程图如图所示。 各个行业应用会有所不同,比如在精细农业方面,在大气校正方面要求会高点,因为它需要反演;在测绘方面,对几何校正的精度要求会很高。 2、数据预处理的各个流程介绍 (一)几何精校正与影像配准 引起影像几何变形一般分为两大类:系统性和非系统性。系统性一般有传感器本身引起的,有规律可循和可预测性,可以用传感器模型来校正;非系统性几何变形是不规律的,它可以是传感器平台本身的高度、姿态等不稳定,也可以是地球曲率及空气折射的变化以及地形的变化等。 在做几何校正前,先要知道几个概念: 地理编码:把图像矫正到一种统一标准的坐标系。 地理参照:借助一组控制点,对一幅图像进行地理坐标的校正。 图像配准:同一区域里一幅图像(基准图像)对另一幅图像校准

影像几何精校正,一般步骤如下, (1)GCP(地面控制点)的选取 这是几何校正中最重要的一步。可以从地形图(DRG)为参考进行控制选点,也可以野外GPS测量获得,或者从校正好的影像中获取。选取得控制点有以下特征: 1、GCP在图像上有明显的、清晰的点位标志,如道路交叉点、河流交叉点等; 2、地面控制点上的地物不随时间而变化。 GCP均匀分布在整幅影像内,且要有一定的数量保证,不同纠正模型对控制点个数的需求不相同。卫星提供的辅助数据可建立严密的物理模型,该模型只需9个控制点即可;对于有理多项式模型,一般每景要求不少于30个控制点,困难地区适当增加点位;几何多项式模型将根据地形情况确定,它要求控制点个数多于上述几种模型,通常每景要求在30-50个左右,尤其对于山区应适当增加控制点。 (2)建立几何校正模型 地面点确定之后,要在图像与图像或地图上分别读出各个控制点在图像上的像元坐标(x,y)及其参考图像或地图上的坐标(X,Y),这叫需要选择一个合理的坐标变换函数式(即数据校正模型),然后用公式计算每个地面控制点的均方根误差(RMS)根据公式计算出每个控制点几何校正的精度,计算出累积的总体均方差误差,也叫残余误差,一般控制在一个像元之内,即RMS<1。 (3)图像重采样 重新定位后的像元在原图像中分布是不均匀的,即输出图像像元点在输入图像中的行列号不是或不全是正数关系。因此需要根据输出图像上的各像元在输入图像中的位置,对原始图像按一定规则重新采样,进行亮度值的插值计算,建立新的图像矩阵。常用的内插方法包括: 1、最邻近法是将最邻近的像元值赋予新像元。该方法的优点是输出图像仍然保持原来的像元值,简单,处理速度快。但这种方法最大可产生半个像元的位置偏移,可能造成输出图像中某些地物的不连贯。 2、双线性内插法是使用邻近4个点的像元值,按照其距内插点的距离赋予不同的权重,进行线性内插。该方法具有平均化的滤波效果,边缘受到平滑作用,而产生一个比较连贯的输出图像,其缺点是破坏了原来的像元值。 3、三次卷积内插法较为复杂,它使用内插点周围的16个像元值,用三次卷积函数进行内插。这种方法对边缘有所增强,并具有均衡化和清晰化的效果,当它仍然破坏了原来的像元值,且计算量大。 一般认为最邻近法有利于保持原始图像中的灰级,但对图像中的几何结构损坏较大。后两种方法虽然对像元值有所近似,但也在很大程度上保留图像原有的几何结构,如道路网、水系、地物边界等。

数据的标准化 在数据分析之前,我们通常需要先将数据标准化(normalization),利用标准化后的数据进行数据分析。数据标准化也就是统计数据的指数化。数据标准化处理主要包括数据同趋化处理和无量纲化处理两个方面。数据同趋化处理主要解决不同性质数据问题,对不同性质指标直接加总不能正确反映不同作用力的综合结果,须先考虑改变逆指标数据性质,使所有指标对测评方案的作用力同趋化,再加总才能得出正确结果。数据无量纲化处理主要解决数据的可比性。去除数据的单位限制,将其转化为无量纲的纯数值,便于不同单位或量级的指标能够进行比较和加权。数据标准化的方法有很多种,常用的有“最小—最大标准化”、“Z-score标准化”

和“按小数定标标准化”等。经过上述标准化处理,原始数据均转换为无量纲化指标测评值,即各指标值都处于同一个数量级别上,可以进行综合测评分析。 一、Min-max 标准化 min-max标准化方法是对原始数据进行线性变换。设minA和maxA分别为属性A的最小值和最大值,将A的一个原始值x通过min-max标准化映射成在区间[0,1]中的值x',其公式为: 新数据=(原数据-极小值)/(极大值-极小值) 二、z-score 标准化 这种方法基于原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。将A的原始值x使用z-score标准化到x'。z-score标准化方法适用于属性A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。 新数据=(原数据-均值)/标准差 spss默认的标准化方法就是z-score标准化。用Excel进行z-score标准化的方法:在Excel中没有现成的函数,需要自己分步计算,其实标准化的公式很简单。步骤如下: 求出各变量(指标)的算术平均值(数学期望)xi和标准差si ; .进行标准化处理:zij=(xij-xi)/si,其中:zij为标准化后的变量值;xij为实际变量值。 将逆指标前的正负号对调。标准化后的变量值围绕0上下波动,

. 一、 一、实验/实习过程 实验题1在程序中产生一个ArithmeticException类型被0除的异常,并用catch 语句捕获这个异常。最后通过ArithmeticException类的对象e 的方法getMessage给出异常的具体类型并显示出来。 package Package1; public class除数0 { public static void main(String args[]){ try{ int a=10; int b=0; System.out.println("输出结果为:"+a/b); } catch(ArithmeticException e){ System.out.println("除数不能为0"+e.getMessage()); } } } 实验题2在一个类的静态方法methodOne()方法内使用throw 产生

ArithmeticException异常,使用throws子句抛出methodOne()的异常,在main方法中捕获处理ArithmeticException异常。 package Package1; public class抛出异常 { static void methodOne() throws ArithmeticException{ System.out.println("在methodOne中"); throw new ArithmeticException("除数为0"); } public static void main(String args[]){ try{ int a=10; int b=0; int c=1; System.out.println("输出结果为:"+a/b); } catch(ArithmeticException e){ System.out.println("除数不能为0"+e.getMessage()); } } }

数据归一化方法大全 在数据分析之前,我们通常需要先将数据标准化(normalization),利用标准化后的数据进行数据分析。数据标准化也就是统计数据的指数化。数据标准化处理主要包括数据同趋化处理和无量纲化处理两个方面。数据同趋化处理主要解决不同性质数据问题,对不同性质指标直接加总不能正确反映不同作用力的综合结果,须先考虑改变逆指标数据性质,使所有指标对测评方案的作用力同趋化,再加总才能得出正确结果。数据无量纲化处理主要解决数据的可比性。数据标准化的方法有很多种,常用的有“最小—最大标准化”、“Z-score标准化”和“按小数定标标准化”等。经过上述标准化处理,原始数据均转换为无量纲化指标测评值,即各指标值都处于同一个数量级别上,可以进行综合测评分析。 一、m ax Min标准化 - M i n标准化方法是对原始数据进行线性变换。设minA和maxA分别- m a x 为属性A的最小值和最大值,将A的一个原始值x通过m ax Min标准化映射 - 成在区间[0,1]中的值'x,其公式为: 新数据=(原数据-极小值)/(极大值-极小值) 二、z-score 标准化 这种方法基于原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。将A的原始值x使用z-score标准化到x'。 z-score标准化方法适用于属性A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。 新数据=(原数据-均值)/标准差 spss默认的标准化方法就是z-score标准化。 用Excel进行z-score标准化的方法:在Excel中没有现成的函数,需要自己分步计算,其实标准化的公式很简单。 步骤如下: 1.求出各变量(指标)的算术平均值(数学期望)xi和标准差si ; 2.进行标准化处理: zij=(xij-xi)/si 其中:zij为标准化后的变量值;xij为实际变量值。 3.将逆指标前的正负号对调。 标准化后的变量值围绕0上下波动,大于0说明高于平均水平,小于0说明低于平均水平。

1.1 归一化方法 数据的归一化的目的是将不同量纲和不同数量级大小的数据转变成可以相互进行数学运算的具有相同量纲和相同数量级的具有可比性的数据。数据归一化的方法主要有线性函数法、对数函数法、反余切函数法等 线性函数法 对于样本数据x (n ),n =1,2,……,N ,归一化后的样本数据可以采用三种表示方法,分别是最大最小值法、均值法和中间值法。最大最小值法用于将样本数据归一化到[0,1]范围内;均值法用于将数据归一化到任意范围内,但最大值与最小值的符号不可同时改变;中间值法用于将样本数据归一化到[-1,1]范围内,三种方法的公式分别如式(2-1)、式(2-2)、式(2-3)所示。 ()(()min(()))(max(())min(())),1,2,,y k x k x n x n x n k N =--= (0-1) 1 () 1(),1,2,,,()N i x k y k A k N x x i N x ====∑ (0-2) ()(),1,2,,1 (max(()))2 min(())mid x n x k x y k k N x n -= =- (0-3) max(())min((),1,2,,2 ) mid x n n n N x x += = (0-4) 其中min(x (n ))表示样本数据x (n )的最小值,max(x (n ))表示样本数据x (n )的最大值,x 表示样本数据x (n )的均值,mid x 为样本数据x (n )的中间值,A 为调节因子,是一个常数,用于根据工程实际需要来调节样本数据的范围。 对数函数法 对于样本数据x (n ),n =1,2,……,N,归一化后的样本数据y (n )用公式表示为: 10()log (()),1,2,,y k x k k N == (0-5) 对数函数法主要用于数据的数量级非常大的场合。 反余切函数法 对于样本数据x (n ),n =1,2,……,N ,归一化后的样本数据y (n )用公式表示为: 2 ()arctan(()),1,2,,y k x k k N π = = (0-6) 反余切函数法主要用于将角频率等变量转换到[-1,1]范围。

一、实验/实习过程 实验题1在程序中产生一个ArithmeticException类型被0除的异常,并用catch 语句捕获这个异常。最后通过ArithmeticException类的对象e 的方法getMessage给出异常的具体类型并显示出来。 package Package1; public class除数0 { public static void main(String args[]){ try{ int a=10; int b=0; System.out.println("输出结果为:"+a/b); } catch(ArithmeticException e){ System.out.println("除数不能为0"+e.getMessage()); } } } 实验题2在一个类的静态方法methodOne()方法内使用throw 产生ArithmeticException异常,使用throws子句抛出methodOne()的异常,

在main方法中捕获处理ArithmeticException异常。 package Package1; public class抛出异常 { static void methodOne() throws ArithmeticException{ System.out.println("在methodOne中"); throw new ArithmeticException("除数为0"); } public static void main(String args[]){ try{ int a=10; int b=0; int c=1; System.out.println("输出结果为:"+a/b); } catch(ArithmeticException e){ System.out.println("除数不能为0"+e.getMessage()); } } }

数据归一化汇总 ================================= 归一化化定义:我是这样认为的,归一化化就是要把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内。首先归一化是为了后面数据处理的方便,其次是保正程序运行时收敛加快。 在matlab里面,用于归一化的方法共有三种: (1)premnmx、postmnmx、tramnmx (2)prestd、poststd、trastd (3)是用matlab语言自己编程。 premnmx指的是归一到[-1 1],prestd归一到单位方差和零均值。(3)关于自己编程一般是归一到[0.1 0.9] 。具体用法见下面实例。 为什么要用归一化呢?首先先说一个概念,叫做奇异样本数据,所谓奇异样本数据数据指的是相对于其他输入样本特别大或特别小的样本矢量。 下面举例: m=[0.11 0.15 0.32 0.45 30; 0.13 0.24 0.27 0.25 45]; 其中的第五列数据相对于其他4列数据就可以成为奇异样本数据(下面所说的网络均值bp)。奇异样本数据存在所引起的网络训练时间增加,并可能引起网络无法收敛,所以对于训练样本存在奇异样本数据的数据集在训练之前,最好先进形归一化,若不存在奇异样本数据,则不需要事先归一化。 具体举例: close all clear echo on clc %BP建模 %原始数据归一化 m_data=[1047.92 1047.83 0.39 0.39 1.0 3500 5075; 1047.83 1047.68 0.39 0.40 1.0 3452 4912; 1047.68 1047.52 0.40 0.41 1.0 3404 4749; 1047.52 1047.27 0.41 0.42 1.0 3356 4586; 1047.27 1047.41 0.42 0.43 1.0 3308 4423; 1046.73 1046.74 1.70 1.80 0.75 2733 2465; 1046.74 1046.82 1.80 1.78 0.75 2419 2185; 1046.82 1046.73 1.78 1.75 0.75 2105 1905; 1046.73 1046.48 1.75 1.85 0.70 1791 1625; 1046.48 1046.03 1.85 1.82 0.70 1477 1345; 1046.03 1045.33 1.82 1.68 0.70 1163 1065; 1045.33 1044.95 1.68 1.71 0.70 849 785; 1044.95 1045.21 1.71 1.72 0.70 533 508; 1045.21 1045.64 1.72 1.70 0.70 567 526; 544; 601 0.70 1.69 1045.64 1045.44 1.70

数据的标准化化准数据标常我们通需要先将,在分数据析之前 数据标准,利用标准化后的数据进行数据分析。normalization)(同趋化处化也就是统计数据的指数化数据标准化处理主要包括数据。 不同性质数据数据同趋化理和无量纲化处理处理主要解决两个方面。 问题,对不同性质指标直接加总不能正确反映不同作用力的综合结使所有指标对测评方案的作用力须先考虑改变逆指标数据性质,果,数据数据无量纲化处理主要解决再加总才能得出正确结果。同趋化,的可比性。去除数据的单

位限制,将其转化为无量纲的纯数值,便于有很不同单位或量级的指标能够进行比较和加权。数据标准化的方法标准化”和“按小Z-score“、多种,常用的有“最小—最大标准化” 数定标标准化”等。经过上述标准化处理,原始数据均转换为无量纲 可以进行综合指标值都处于同一个数量级别上,即各化指标测评值, 测评分析。 一、Min-max 标准化 min-max标准化方法是对原始数据进行线性变换。设minA和maxA 分别为属性A的最小值和最大值,将A的一个原始值x通过min-max 标准化映射成在区间[0,1]中的值x',其公式为: 新数据=(原数据-极小值)/(极大值-极小值) 二、z-score 标准化这种方法基于原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。将A的原始值x使用z-score标准化到x'。z-score标准化方法适用于属性A的最大值和最小值未知的情况,或有超出取值范围的离群数据的情况。 新数据=(原数据-均值)/标准差 spss默认的标准化方法就是z-score标准化。用Excel进行z-score 标准化的方法:在Excel中没有现成的函数,需要自己分步计算,其

目录 摘要......................................................................... I 关键词...................................................................... I 1引言 (1) 2异常值的判别方法 (1) 检验(3S)准则 (1) 狄克松(Dixon)准则 (2) 格拉布斯(Grubbs)准则 (2) 指数分布时异常值检验 (3) 莱茵达准则(PanTa) (3) 肖维勒准则(Chauvenet) (4) 3 实验异常数据的处理 (4) 4 结束语 (5) 参考文献 (6)

试验数据异常值的检验及剔除方法 摘要:在实验中不可避免会存在一些异常数据,而异常数据的存在会掩盖研究对象的变化规律和对分析结果产生重要的影响,异常值的检验与正确处理是保证原始数据可靠性、平均值与标准差计算准确性的前提.本文简述判别测量值异常的几种统计学方法,并利用DPS软件检验及剔除实验数据中异常值,此方法简单、直观、快捷,适合实验者用于实验的数据处理和分析. 关键词:异常值检验;异常值剔除;DPS;测量数据

1 引言 在实验中,由于测量产生误差,从而导致个别数据出现异常,往往导致结果产生较大的误差,即出现数据的异常.而异常数据的出现会掩盖实验数据的变化规律,以致使研究对象变化规律异常,得出错误结论.因此,正确分析并剔除异常值有助于提高实验精度. 判别实验数据中异常值的步骤是先要检验和分析原始数据的记录、操作方法、实验条件等过程,找出异常值出现的原因并予以剔除. 利用计算机剔除异常值的方法许多专家做了详细的文献[1] 报告.如王鑫,吴先球,用Origin 剔除线形拟合中实验数据的异常值;严昌顺.用计算机快速剔除含粗大误差的“环值”;运用了统计学中各种判别异常值的准则,各种准则的优劣程度将体现在下文. 2 异常值的判别方法 判别异常值的准则很多,常用的有t 检验(3S )准则、狄克松(Dixon )准则、格拉布斯(Grubbs )准则等准则.下面将一一简要介绍. 2.1 检验(3S )准则 t 检验准则又称罗曼诺夫斯基准则,它是按t 分布的实际误差分布范围来判别异常值,对重复测量次数较少的情况比较合理. 基本思想:首先剔除一个可疑值,然后安t 分布来检验被剔除的值是否为异常值. 设样本数据为123,,n x x x x ,若认j x 为可疑值.计算余下1n -个数据平均值 1n x -及标准差1n s - ,即2 111,1,1n n i n i i j x x s n --=≠=-∑. 然后,按t 分布来判别被剔除的值j x 是否为异常值. 若1(,)n j x x kn a -->,则j x 为异常值,应予剔除,否则为正常值,应予以保留.其中:a 为显著水平;n 数据个数;(,)k n a 为检验系数,可通过查表得到.

为什么要归一化? 答:为了减少数据中存在的奇异样本数据存在所引起的网络训练时间增加,并可能引起网络无法收敛。其次保证程序运行时收敛加快。 ============外一篇有关mapminmax的用法详解by faruto================================== 几个要说明的函数接口: [Y,PS] = mapminmax(X) [Y,PS] = mapminmax(X,FP) Y = mapminmax('apply',X,PS) X = mapminmax('reverse',Y,PS) 用实例来讲解,测试数据x1 = [1 2 4], x2 = [5 2 3]; >> [y,ps] = mapminmax(x1) y = -1.0000 -0.3333 1.0000 ps = name: 'mapminmax' xrows: 1 xmax: 4 xmin: 1 xrange: 3 yrows: 1 ymax: 1 ymin: -1 yrange: 2 其中y是对进行某种规范化后得到的数据,这种规范化的映射记录在结构体ps中.让我们来看一下这个规范化的映射到底是怎样的? Algorithm

It is assumed that X has only finite real values, and that the elements of each row are not all equal. ?y = (ymax-ymin)*(x-xmin)/(xmax-xmin) + ymin; ?[关于此算法的一个问题.算法的假设是每一行的元素都不想相同,那如果都相同怎么办?实现的办法是,如果有一行的元素都相同比 如xt = [1 1 1],此时xmax = xmin = 1,把此时的变换变为y = ymin,matlab内部就是这么解决的.否则该除以0了,没有意义!] 也就是说对x1 = [1 2 4]采用这个映射f: 2*(x-xmin)/(xmax-xmin)+(-1),就可以得到y = [ -1.0000 -0.3333 1.0000] 我们来看一下是不是: 对于x1而言xmin = 1,xmax = 4; 则y(1) = 2*(1 - 1)/(4-1)+(-1) = -1; y(2) = 2*(2 - 1)/(4-1)+(-1) = -1/3 = -0.3333; y(3) = 2*(4-1)/(4-1)+(-1) = 1; 看来的确就是这个映射来实现的. 对于上面algorithm中的映射函数其中ymin,和ymax是参数,可以自己设定,默认为-1,1; 比如: >>[y,ps] = mapminmax(x1) >> ps.ymin = 0; >> [y,ps] = mapminmax(x1,ps) y = 0 0.3333 1.0000 ps = name: 'mapminmax' xrows: 1 xmax: 4 xmin: 1

数据归一化和两种常用的归一化方法 数据标准化(归一化)处理是数据挖掘的一项基础工作,不同评价指标往往具有不同的量纲和量纲单位,如此的情况会阻碍到数据分析的结果,为了消除指标之间的量纲阻碍,需要进行数据标准化处理,以解决数据指标之间的可比性。原始数据通过数据标准化处理后,各指标处于同一数量级,适合进行综合对比评价。以下是两种常用的归一化方法: 一、min-max标准化(Min-Max Normalization) 也称为离差标准化,是对原始数据的线性变换,使结果值映射到[0 - 1]之间。转换函数如下: 其中max为样本数据的最大值,min为样本数据的最小值。这种方法有个缺陷就是当有新数据加入时,可能导致max和min的变化,需要重新定义。 二、Z-score标准化方法 这种方法给予原始数据的均值(mean)和标准差(standard deviation)进行数据的标准化。通过处理的数据符合标准正态分布,即均值为0,标准差为1,转化函数为: 其中为所有样本数据的均值,为所有样本数据的标准差。

“[学校计划]下学期英语教研组计划”学校工作计划 别详一、指导思想: 在教务处的领导下,团结奋斗,协调好各备课组间的关系。仔细学习新的教学大纲,巩固进展爱校爱生、教书育人,富有进取精神、乐观积极向上的融洽的教研新风貌,在上届中招取得良好成绩的基础上,为把我组的教研水平提高到一具新的台阶而努力奋斗。 二、奋斗目标: 1、开展学习新大纲的活动,稳步扎实地抓好素养教育; 2、加强教研治理,为把我组全体教师的教学水平提高一具新层面而奋斗; 3、协调处理好学科关系,在各备课内积极加强集体备课活动,在教学过程中要求各备课组按照"五个一"要求,做好教研工作,即"统一集体备课,统一内容,统一进度,统一作业,统一测试"。 4、配合各备课组,搞好第二课堂活动,把创新教育理念灌输到教书育人的过程中。 三、具体措施: 1、期初及期中后召集全组教师会议,布置教研活动安排及进行新大纲学习; 2、降实各备课组教学进度表及教学打算; 3、有的放矢地开展第二课堂活动 初一年组织学生单词竞赛; 初二年组织学生进行能力比赛; 初三年组织学生进听力比赛; 其中初一年有条件的话多教唱英文歌曲,培养学生学习英语的兴趣,含介绍英美文化背景常识。 4、各备课组降实好课外辅导打算,给学有余力的部分学生制造条件,积极备战英语"奥赛"。 5、要求各科任教师,积极主动及时地反馈教情学情,并提出整改意见,指出努力方向; 6、针对别同年段学生的别同表现,注意做好学生的思想教育工作,寓思想教育于教学工作中; 7、降实本学期教研听评课工作安排。

异常数据的处理 在使用“税务稽查查账软件”的过程中,其前提工作就是“企业数据采集”。通常可以使用奇星查账软件的“数据采集软件”完成企业电子账务数据的采集工作。但实际工作中,由于企业相关人员对“采集行为”的不理解、目前相关政策法规的不明确、企业服务器放在异地等情况,会造成无法通过“数据采集软件”完成正常的数据采集。这就需要通过一些技术手段,人工处理了。 通常对于无法正常采集的企业数据,我们采用下述三个环节进行处理: 一、要求企业从财务软件中,导出“余额表”及“序时账簿” 二、对企业提供的两个电子表进行格式化处理 三、将格式化处理的电子表利用查账软件中的“万能数据导入”还原到查账软件中,生 成电子账簿

出的格式会存在差异,我们对企业给出了规范性要求: 其一:余额表必须是对应数据年度的“一月份期初余额表”,表中所涉的会计科目应该“包含所有科目”,且所涉的会计科目级次应该是从“一级”到“最深科目级次”。并以Excel格式保存。 其二:序时账簿要求企业查询全年凭证,并根据数据量不同,按年、按季或分月导出为Excel。

需要进行处理后,才可使用 (一)处理“余额表” 企业提供的“余额表”中,应该含有科目代码、科目名称、借方余额、贷方余 额,如下图所示: 1、根据“查账软件”万能数据导入功能的要求,“科目名称”中不能含有科目代码信息,可通过Excel的替换功能,进行如下图所示操作,将类似“1002.01/”的信息清除掉

结果如下图所示 2、根据“查账软件”万能数据导入功能的要求,需要手工定义“科目性质”,即“资产”、“负债”、“所有者权益”等,在会计制度科目体系下,分别用“1——5”表示,在新准则下,分别用“1——6”表示 处理方法,通过Excel 的LEFT函数,取科目代码的“第一位”作为科目性质代码,如下图所示

数据预处理(data preprocessing)是指在主要的处理以前对数据进行的一些处理。如对大部分地球物理面积性观测数据在进行转换或增强处理之前,首先将不规则分布的测网经过插值转换为规则网的处理,以利于计算机的运算。另外,对于一些剖面测量数据,如地震资料预处理有垂直叠加、重排、加道头、编辑、重新取样、多路编辑等 数据挖掘中的数据预处理 现实世界中数据大体上都是不完整,不一致的脏数据,无法直接进行数据挖掘,或挖掘结果差强人意。为了提前数据挖掘的质量产生了数据预处理技术。数据预处理有多种方法:数据清理,数据集成,数据变换,数据归约等。这些数据处理技术在数据挖掘之前使用,大大提高了数据挖掘模式的质量,降低实际挖掘所需要的时间。 数据清理 用来自多个联机事务处理 (OLTP) 系统的数据生成数据仓库的进程的 一部分。该进程必须解决不正确的拼写、两个系统之间冲突的拼写规则和冲突的数据(如对于相同的部分具有两个编号)之类的错误。 编码或把资料录入时的错误,会威胁到测量的效度。数据清理主要解决数据文件建立中的人为误差,以及数据文件中一些对统计分析结果影响较大的特殊数值。常用的数据清理方法包括可编码式清理和联列式清理。 数据清理例程通过填写缺失的值、光滑噪声数据、识别或删除离群点并解决不一致性来“清理”数据。主要是达到如下目标:格式标准化,异常数据清除,错误纠正,重复数据的清除。 数据集成 数据集成是把不同来源、格式、特点性质的数据在逻辑上或物理上有机地集中,从而为企业提供全面的数据共享。在企业数据集成领域,已经有了很多成熟的框架可以利用。目前通常采用联邦式、基于中间件模型和数据仓库等方法来构造集成的系统,这些技术在不同的着重点和应用上解决数据共享和为企业提供决策支持。 数据集成例程将多个数据源中的数据结合起来并统一存储,建立数据仓库的过程实际上就是数据集成。 数据变换 通过平滑聚集,数据概化,规范化等方式将数据转换成适用于数据挖掘的形式。 数据归约 数据挖掘时往往数据量非常大,在少量数据上进行挖掘分析需要很长的时间,数据归约技术可以用来得到数据集的归约表示,它小得多,但仍然接近于保持原数据的完整性,并结果与归约前结果相同或几乎相同。目前,数据预处理是目前数据挖掘一个热门的研究方面,毕竟这是由数据预处理的产生背景所决定的--现实世界中的数据几乎都脏数据。 一、数据归约基本知识: