Domain-Specific IR for German, English and Russian Languages

- 格式:pdf

- 大小:150.12 KB

- 文档页数:11

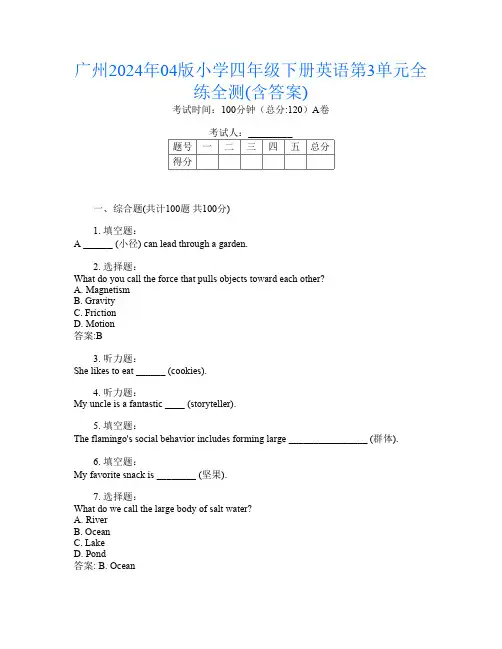

广州2024年04版小学四年级下册英语第3单元全练全测(含答案)考试时间:100分钟(总分:120)A卷考试人:_________题号一二三四五总分得分一、综合题(共计100题共100分)1. 填空题:A ______ (小径) can lead through a garden.2. 选择题:What do you call the force that pulls objects toward each other?A. MagnetismB. GravityC. FrictionD. Motion答案:B3. 听力题:She likes to eat ______ (cookies).4. 听力题:My uncle is a fantastic ____ (storyteller).5. 填空题:The flamingo's social behavior includes forming large ________________ (群体).6. 填空题:My favorite snack is ________ (坚果).7. 选择题:What do we call the large body of salt water?A. RiverB. OceanC. LakeD. Pond答案: B. Ocean8. collect _________. (坚果) 填空题:Squirrel9. 填空题:My favorite animal is the _____ (狗).10. 听力题:A ____ has a beautiful song and sings in the morning.11. 填空题:I enjoy _______ (阅读) books about history.12. 听力题:The chemical formula for calcium chloride is ______.13. 选择题:What do you call the tool used to cut paper?A. ScissorsB. KnifeC. RulerD. Glue答案: A14. 听力题:The ________ (campaign) raises awareness.15. 填空题:A gecko can change its ______ (颜色) to camouflage.16. 选择题:What is the opposite of "fast"?A. QuickB. SlowC. SpeedyD. Hasty答案:B17. 选择题:What do we call the process of a caterpillar becoming a butterfly?A. MetamorphosisB. TransformationC. EvolutionD. Development答案: A18. 选择题:What do we call a large tree that grows in the rainforest?a. Bushb. Shrubc. Palmd. Canopy答案:d19. 选择题:What is the capital city of the Seychelles?A. VictoriaB. MaleC. Port LouisD. Antananarivo答案: A20. 听力题:The _____ (pen/pencil) is on the desk.21. 听力题:The Great Wall of China is not visible from ______.22. 听力题:The ______ is a vital part of agriculture.23. 填空题:Certain plants evolved ______ (适应) to specific climates.24. 听力题:I like to ___ with my friends. (play)25. 听力题:They are _____ (watching) a documentary.26. 选择题:What do we call the liquid that we drink?A. WaterB. SandC. AirD. Food27. 选择题:What is the largest organ in the human body?A. HeartB. SkinC. BrainD. Lungs28. 选择题:What do you call a baby dog?A. PuppyB. KittenC. CubD. Calf29. 选择题:What is the capital of Slovakia?A. PragueB. BratislavaC. BudapestD. Warsaw答案:B30. 选择题:What do you call the place where we buy groceries?A. RestaurantB. Grocery storeC. SchoolD. Library31. 填空题:I like to ______ (画) pictures of nature.32. 选择题:What do you call the event where people gather to celebrate a holiday?A. GatheringB. CelebrationC. PartyD. Event答案: B33. 听力题:A telescope helps us see _____ objects in space.34. 听力题:I want to ___ a great leader. (become)35. 听力题:The elephant is very ___. (big)36. 选择题:What is the capital of Germany?A. MunichB. BerlinC. FrankfurtD. Hamburg答案: B37. 填空题:Understanding ______ (植物适应性) can enhance gardening techniques.38. 听力题:They are having a ______ (party) this weekend.39. 听力题:We enjoy ________ (cooking) together.40. 选择题:What is the main language spoken in the United Kingdom?A. FrenchB. SpanishC. EnglishD. German答案: C41. 填空题:My sister enjoys __________ (参加) local festivals.42. 填空题:A dolphin's intelligence is comparable to that of a ______ (狗).43. 填空题:The garden is full of lovely _______ that bloom brightly.44. 选择题:Which vegetable is orange and crunchy?A. PotatoB. CarrotC. SpinachD. Tomato答案:B45. 选择题:What do you call the time of day when the sun sets?A. MorningB. AfternoonC. EveningD. Night46. 听力题:A telescope helps us see ______ in the sky.47. 听力题:A chemical change often involves the release of ______.48. 选择题:What do you call the frozen form of water?A. SteamB. IceC. VaporD. Rain答案:B49. 听力题:The ______ helps with the growth of plants.50. 选择题:What is the name of the famous ancient city in Italy?A. PompeiiB. RomeC. VeniceD. Florence答案:A. Pompeii51. 填空题:My grandma is a wonderful __________ (谈话者) who shares stories.52. 选择题:What do we call the warm-blooded vertebrates that have feathers?A. MammalsB. FishC. BirdsD. Reptiles答案: C53. 听力题:I like to ___ (explore/hike) in the woods.54. 听力题:My friend enjoys drawing ____ (cartoons).The cat is sleeping on the ______.56. 听力题:A chemical reaction that absorbs energy is called an ______ reaction.57. 听力题:A __________ is a charged particle.58. 选择题:Which planet is known for its rings?A. MarsB. JupiterC. SaturnD. Neptune答案:C59. 小蜜蜂) buzzes around the flowers. 填空题:The ___60. 填空题:The fox is cunning and known for its ______ (智慧).61. 听力题:My father is a _____ (老师).62. 选择题:What is the capital city of Iceland?A. ReykjavikB. AkureyriC. EgilsstaðirD. Selfoss63. 听力题:I can ______ (build) a sandcastle at the beach.64. 填空题:A frog can change color to blend into its ______ (环境).65. 填空题:A ____(green roof) supports biodiversity in urban areas.66. 听力题:The ______ helps protect the roots of a plant.I have a _____ (picture) of my family.68. 选择题:What do we call the process of a caterpillar becoming a butterfly?A. GrowthB. MetamorphosisC. DevelopmentD. Evolution答案:B69. 选择题:What do we call the act of enhancing one's knowledge?A. LearningB. EducationC. StudyD. All of the Above答案:D70. 听力题:The chemical formula for manganese oxide is _______.71. 选择题:What do penguins live in?A. ForestB. DesertC. ArcticD. Ocean72. 填空题:The __________ (历史研究) involves analyzing primary sources.73. 选择题:Which planet is known as the Red Planet?A. VenusB. MarsC. JupiterD. Saturn答案:B74. 听力题:The _______ can be a perfect subject for drawing.75. 选择题:What is the capital of Australia?A. SydneyB. MelbourneC. CanberraD. Brisbane答案: C76. 填空题:The ______ (小鸟) takes flight as soon as it learns to spread its ______ (翅膀).77. 填空题:The __________ (历史的教训) highlight the importance of learning from the past.78. 填空题:The manatee is a gentle ______ (巨型) creature.79. 听力题:The stars twinkle _____ (brightly/dimly) at night.80. 听力题:I have a _____ (ticket) for the show.81. 听力题:A reaction that requires energy is called an ______ reaction.82. 选择题:What do you call the process of turning a gas into a liquid?A. FreezingB. EvaporationC. CondensationD. Boiling答案:C83. 填空题:The __________ (历史的实用性) informs policy-making.84. 听力题:The Earth’s crust is divided into many pieces called ______ plates.85. 听力题:The process of oxidation can lead to ______ of metals.86. 听力题:His favorite food is ________.87. 选择题:What is the name of the largest bird?A. PenguinB. EagleC. OstrichD. Sparrow88. 填空题:My dad helps me with _______ (作业).89. 小鸭子) splashes in the water. 填空题:The ___90. 选择题:What do we call the study of ancient civilizations?A. ArchaeologyB. AnthropologyC. SociologyD. History答案:A91. 选择题:What do you call a collection of stars?A. PlanetB. GalaxyC. CometD. Asteroid答案:B92. 填空题:The ______ (树木的) height varies by species.93. 填空题:I like to _______ (跳舞) at parties.94. 填空题:The __________ is a large archipelago in Southeast Asia. (印度尼西亚)95. 听力题:My ______ loves to share her knowledge.96. 听力题:He is running very ___. (fast)97. 选择题:How many legs does an octopus have?a. 6b. 8c. 10d. 12答案:b98. 选择题:What is the smallest prime number?a. 1b. 2c. 3d. 4答案:b99. 填空题:My favorite plant is a ______ (仙人掌). It needs very little ______ (水).100. 填空题:A ______ (花坛) adds beauty to a yard.。

英语词汇学考试重点整理Explain the following terms⼀1) free morpheme/ A free morpheme is one that can be uttered发出,表达alone with meaning.It can exist on its own without a bound morpheme. In the traditional sense, a free morpheme is a word. 例如hand ,eat, get 2) bound form/never used as sentences.– ess in countess, lioness and duchess –ish in boyish, childish and greenish –s in hats, books and cups3) function words/ function words are often short words, they do not have much lexical meaning and some of them have no lexical meaning of their own; They are often short words such as determiners限定词, conjunctions连词, prepositions介词, auxiliaries辅助物, and so forth. 如to, the , of , by4) content words实词/ They are used to name objects, qualities, actions, processes or states, andhave independent lexical meaning. They are the nouns, main verbs, adjectives形容词andadverbs副词of a language.⼆1) syntheti c综合的language / inflectional grammatical markers, French, German and Russian.2) analytic language/word order, prepositions or auxiliary verbs , English and Chinese3) Indo-European family of languages/ Europe and parts of Southern Asia Eight groups三1) morphemes /The morpheme is the smallest meaningful linguistic unit of language, not divisible可分的or analyzable into smaller forms.2) allomorphs/variants变体of the same morphem如im-, ir-, il- : allomorphs of the morpheme in-3) root / is the basic unchangeable part of a word, and it conveys the main lexical meaning of theword. work able, work er, work ed, and work ing4) stem /A stem is of concern only when dealing with inflectional morphology. Inflectional (butnot derivational) affixes are added to it. It is the part of word-form which remains when all inflectional affixes have been removed. 如undesirables, undesirable; desired, desire 5) base / A base is any form to which affixes of any kind can be added.Desirable, desire - base and root, not stem; undesirable, desirable-base, not root and stem 6) inflectional affixes/A inflectional affix serves to express such meanings as plurality复数,tense, and the comparative⽐较的or superlative 最⾼的degree. 如-s, -ed, -er, -est7) derivational affixes / When they are added to another morpheme, they derive a new word.re+write, mini+car, super+market, modern+ize, work+er8) compounding 复合法/Compounding is a word-formation process consisting of combiningtwo or more bases to form a compound word9) derivation 派⽣法/Derivation or affixation is generally defined as a word-formation process by which new words are created by adding a prefix or a suffix or both to the base10) conversion 转化法/Conversion is a word-formation process in which a word of a certainword-class is shifted into a word of another word-class without the addition of an affix.11) initialism/It is a type of shortening, using the first letters of words to form a proper name,a technical term, or a phrase.12) acronym⾸字母缩略词/Acronyms are words formed from the initial letters of the name ofan organization or a scientific term, etc. Acronyms differ from initialisms in that theyare pronounced as words rather than as sequences of letters.13) blending拼缀/Blending is a process of word-formation in which a new word is formed bycombining the meanings and sounds of two words, one of which is not in its full form or both of which are not in their full forms.14) clipping截短词/The process of clipping involves the deletion of one or more syllablesfrom a word (usually a noun), which is also available in its full form.15) back-formation逆⽣法/Back-formation is a term used to refer to a type of word-formationby which a shorter word is coined by the deletion of a supposed affix from a longerform already present in the language.四meaning /is the thing or idea that it refers to or represents and which can be explained using other words. conventionality/most words are conventional, arbitrary symbols; consequently, there is no intrinsic relation between the sound-symbol and its sense.motivation 理据/The connection between word symbol and its sense.grammatical meaning / Grammatical meaning consists of word-class and inflectional paradigm.World-class: it describes the word’s lexical meaning and also gives what is traditionally known as thepart of speech of the word, which modern linguists.lexical meaning /Lexical meaning is dominant in content words, whereas grammatical meaning is dominant in function words, but in neither is grammatical meaning absent.denotative meaning指⽰意义/is sometimes called the conceptual meaning. It is the central factor in linguistic communication. One of the functions of words is to designate or describesomething, such as an object, a property, a process or a state of affairs. Users of alanguage cannot talk about their knowledge of a physical object or a naturalphenomenon, unless this knowledge is express in words which have the same meaningfor all speakers of a given community.connotative meaning内涵意义/ refers to the emotional association which a word or a phrase suggests in one’s mind;it is the supplementary value which is added to the purelydenotative meaning of a word.stylistic meaning 社会意义/ What a word conveys about the social circumstances of its use affective meaning/ It is concerned with the expression of feelings and attitudes of thespeaker or writer.五1) Polysemy⼀词多义/Polysemy refers to a lexical term which has a range of different meanings.2) Homonymy同形异义/Pairs or groups of words, which, though different in meaning, arepronounced alike, or spelled alike, or both六restriction of meaning词义的缩⼩/A word of wide meaning acquires a narrower, specialized sense which is applicable合适的to only one of the objects it had previously以前denoted表⽰. extension of meaning词义的扩⼤/- the opposite of restriction- the widening of a word’s sense until it covers much more than what it originally conveyed. degeneration of meaning词义的降格/the meaning of a word narrows toward an unfavorable meaning elevation of meaning词义的升格/- A word meaning takes a turn for the better in the course of time, and has either risen from a “snarl”word to a “purr”word, or from a slang term to a common word.七linguistic context 语⾔语境/In a narrow sense, it refers to the words, clauses, sentences in which a word appears. This is known as linguistic context which may cover a paragraph, a whole chapter and even the entire book.extra-linguistic context⾮语⾔语境/In a broad sense, it includes the physical situation. This iscalled extra-linguistic or non-linguistic context, which embraces包含the people, time, place, and even the whole cultural background.the actual speech situation and the entire cultural background⼋complete synonyms/ Complete synonyms are the words which are fully identical in meaning and interchangeable in any context without the slightest alteration in connotative, affective and stylistic meanings.Scientific terms: delimited and neutral in affective情感的and stylistic meaning.relative synonyms /- the same denotative外延的meanings, but different connotative内涵的, affective and stylistic meanings contrary/gradable antonyms / They display a type of semantic contrast. They don’t represent an either/or relation but rather a more/less relation.cheap and expensive; fast and slow; sweet and sourcomplementary antonyms / They represent a type of binary semantic opposition. They are in an either/or relation of oppositeness. alive and dead; asleep and awake; shut and open converse antonyms /They are also called relational opposites. One expresses the converse meaning of the other. lend and borrow; buy and sell; husband and wife; parent and child; hyponym 下义词/Hyponymy deals with the relationship of semantic inclusion. That is, the meaning of a more specific word is included in that of another more general word.semantic field/The vocabulary of a language is not an unstructured collection of words. Instead, the vocabulary can be organized into a number of semantic fields.field of colours:pink, orange, scarlet, crimson, violet九Allusive words /words that are closely related to cultural history.Allusions : references参照to characters or events from history, legend, literature, religion.⼗idiom 习语/Idioms are usually metaphorical⽐喻性的rather than literal⽂字的.Structural criteria: phrase idioms; clause idioms; sentence idiomscollocation / Collocation is the way in which words are used together regularlyCollocation is often language-specific (e.g. “blue blood”)and not determined by universal semantic constrains (e.g. “green grass”).Answer the following questions⼀1) What are the fundamental features of the basic word stock of the English vocabulary?a. National characterb. Stability- sun, earth, rain, snow , on, of, can, will- arrow and bow ; telephone, computer, bus, car,radio, electricityc. Word-forming abilityheadache, headless不在意的;⽆头脑的;⽆领导者的, headline⼤标题;内容提要, headman⾸领, headmaster d. Ability to form collocations搭配hand over fist; hand in glove互相勾结、关系密切; to come hat in hand;2) How can we classify English vocabulary according to its origin, level of usage and notion ?⼆1) How do linguists divide the history of the English language for analysis? What are the characteristics of the English vocabulary as a result of its historical development?Three periods in the development of English language (vocabulary)1) Old English or Anglo-Saxon period (449-1100) 1 Much of the old English vocabulary was borrowed from Latin 如bargain, cheap, inch, pound; cup, dish, wall, wine, etc2- Old English was a highly inflected language. It has a complete system of declensions of words2) Middle English period ( 1100-1500 ) 1- French influence Norman Conquest in 1066 Law and government administration:、Military affairs: 、Religion: 、Art。

tier2英语要求Tier 2 is a term commonly used in various contexts, and the specific English requirements may vary depending on the particular industry or organization. However, I can provide you with some general guidelines and suggestions for English proficiency at the Tier 2 level:1. **Vocabulary:** Tier 2 typically requires a broader vocabulary range than Tier 1. In addition to everyday words, Tier 2 vocabulary includes more specialized and domain-specific terminology. It is important to expand your vocabulary in the relevant field to communicate effectively at this level.2. **Grammar and Syntax:** At Tier 2, you should have a good grasp of intermediate to advanced English grammar and syntax. This includes the correct use of tenses, verb forms, conditional sentences, passive voice, and more complex sentence structures. Accuracy and proficiency in grammar are essential for clear and effective communication.3. **Reading Comprehension:** Tier 2 requires the ability to read and understanda variety of texts, including technical documents, reports, academic articles, and business correspondence. You should be able to extract the main ideas, analyze information, and interpret figurative language.4. **Written Expression:** At this level, you are expected to produce well-structured and coherent written texts. This includes writing emails, reports, essays, or presentations with clarity, coherence, and proper punctuation. Your writing should demonstrate a good command of vocabulary, grammar, and organizational skills.5. **Listening and Speaking:** Tier 2 listening skills involve understanding extended conversations, presentations, and lectures in English. Speaking at this level requires the ability to express ideas fluently, participate in discussions, and deliver presentations with confidence.To meet the Tier 2 English requirements, it is recommended to engage incontinuous learning and practice. This may include taking advanced English courses, reading English materials, listening to English podcasts or news, practicing writing, and seeking opportunities to interact with native or fluent speakers. Additionally, exposure to real-life English-language environments, such as study or work abroad, can enhance your proficiency at the Tier 2 level.Remember, the specific requirements for Tier 2 may vary depending on the industry or organization. It is advisable to refer to the specific guidelines or standards provided by the relevant authority or employer to ensure you meet their expectations.。

langchain prompt 高级用法LangChain Prompt: Advanced UsageThe LangChain Prompt is a powerful tool that has revolutionized the field of natural language processing. In this article, we will explore some advanced ways to leverage the LangChain Prompt and unlock its full potential.1. Custom Prompts:One of the key features of the LangChain Prompt is its ability to understand custom prompts. By formulating prompts that are specific to your needs, you can fine-tune the generated output. Consider providing explicit instructions, constraints, or contextual information to guide the model's output.2. Domain-specific Language Generation:With the LangChain Prompt, you can train the model on domain-specific data for improved language generation. By fine-tuning the model using data relevant to your field, you can enhance its ability to generate accurate and specialized content.3. Multi-step Instructions:When using the LangChain Prompt, you can provide multi-step instructions to guide the model's response. Break down complex tasks into smaller steps and present them one by one. This technique is particularly beneficial when seeking detailed answers or assistance with more intricate problems.4. Conditional Prompts:By introducing conditional prompts, you can control the output based on specific criteria. For example, if you want the model to generate content from a certain perspective or follow certain guidelines, you can specify those conditions within the prompt.5. Evaluating Multiple Responses:The LangChain Prompt allows users to compare and evaluate multiple responses to identify the most suitable one. By generating multiple outputs using slight variations to your prompt, you can choose the best response based on predefined criteria, such as clarity, relevance, or uniqueness.6. Incorporating User Feedback:User feedback plays a vital role in improving the LangChain Prompt's performance. By providing feedback on the generated output, you can help refine the model and enhance its accuracy. Consistently offering feedback will contribute to the ongoing development of this powerful language processing tool.In conclusion, the LangChain Prompt offers advanced capabilities that can be leveraged to achieve more accurate and tailored output. By using custom prompts, employing domain-specific language generation, providing multi-step instructions, utilizing conditional prompts, evaluating multiple responses, and incorporating user feedback, you can unlock the full potential of the LangChain Prompt. Possessing these advanced techniques will assist you in maximizing the benefits of this powerful language processing tool.。

专利名称:DOMAIN SPECIFIC DOMAIN NAME SERVICE发明人:Kavitha V.M. Baratakke,Jagdish C.Gopalakrishnan,Nikhil Hegde,Prithvi Srihari申请号:US12138126申请日:20080612公开号:US20090313384A1公开日:20091217专利内容由知识产权出版社提供专利附图:摘要:The present invention provides a computer implemented method for resolving a universal resource identifier (URI). The client computer receives the universal resource identifier, which is comprised of a domain name. The client computer looks up a rowcorresponding to the domain name in a domain specific domain name service (DNS) server list. The row includes at least a first internet protocol address. The client computer transmits a domain name service (DNS) query addressed to the first internet protocol address responsive to looking up the row. Upon receiving a valid response in at least one packet, wherein the at least one packet is from the first internet protocol address, the client computer resolves the universal resource identifier to a second internet protocol address.申请人:Kavitha V.M. Baratakke,Jagdish C. Gopalakrishnan,Nikhil Hegde,Prithvi Srihari 地址:Austin TX US,Bangalore IN,Round Rock TX US,Bangalore IN国籍:US,IN,US,IN更多信息请下载全文后查看。

【干货】史上最全学习各国语言的网站大全,走遍全球都不怕!世界各国语言学习网站看到在不同语种里自由切换的牛人很羡慕?一直想学一种新语言却总是拖拉着不开始?“多学一种语言,不仅是多打开一扇窗子…...而且是多一个世界、多一个头脑、多一重生命”。

世界上大部分语言的学习网站……简直不能更全面,快收藏起来学习吧!篇幅比较长,是按地域分的,这里先列个地域清单:东亚,东南亚,南亚,西亚,北亚,东欧,南欧,西欧,北欧,中欧,古代语言,太平洋,北美印第安,南美印第安,其他美洲语言。

东亚1.汉语☆☆☆☆☆Chinese (Mandarin)汉语(普通话)/~txie/online.htm 【网上学中文】 【中文上网学习】/Mandarin/http://www.c /language/ 【学中文:免费汉语普通话指南】/learn/chinese 【学中文:免费网络有声教程】 【学中文学汉语普通话】 【汉语言网】☆☆☆☆Chinese (Shanghainese)汉语(上海话)/ 【上海话教程】http://www.shanghai.or.jp/zw/shanghai/ 【当代上海话】☆☆☆☆Chinese (Cantonese)汉语(广州话)/chinese/cantonese.asp 【粤语角】/ 【广东话学习】http://www.cantonese.ca/ 【学广东话】/ 【粤语会馆】/ 【粤语协会】/default.asp 【广东话学习天地】.hk/ 【现代标准韩语与粤语对照资料库】.hk/Lexis/lexi-can/ 【粤语审音配词字库】/ccc/jyt/index.htm 【粤语拼盘】☆☆☆☆Chinese (Taiwanese)汉语(闽南话)/ 【闽南语国际网】/en/dict/taiwanese/index.php 【学闽南语】http://www.dang.idv.tw/memo10_1.htm 【母语的田园】.tw/holo/ 【高雄国民小学闽南语资源中心】/bbs/ 【北风论坛】/index.php 【福建之声】2.藏语☆☆☆Tibetan 【藏语学生】/~c.fynn/tibetan/ 【藏文书写】.tw/Tibetan/main.htm 【轻松学藏文】/zw/tibetzw_news_media/voice/No_01_0 1.htm 【中国西藏信息中心藏语学习】3.维吾尔语☆☆☆Uyghur 【维语网】4.满语☆☆Manchu/ 【满族网】/ 【吉祥满族】/blog/22 【速成自学满语讲义】/index.php 【满洲的天空】/ 【锡伯人】5.蒙古语☆☆☆Mongolian/monggolhel.htm 【蒙古语口语教程(初级)】/lang/home/index.asp 【蒙古族语言文字】6.日语☆☆☆☆Japanese 【日语在线】 【学日语】http://www.jp-lesson.jp 【日语课程】/ 【贯通日本语】/ 【现代日语学习论坛】/ 【孙沈清日语教室】/ 【当当日语教室】/ 【沪江日语】/ 【和风日语】/ 【日语巴士】/ 【163日语】/ 【日语广场】/ 【日语学习港】/ 【大成日语网】/ 【日语入门】/ 【学日语】/ 【日本语天堂】/ 【日本语世界】/ 【中日交流】/ 【在线日语练习】/songcx/category/5968.html 【新版标日学习】欢迎关注@博士圈7.韩语☆☆☆☆Koreanhttp://korean.sogang.ac.kr 【西江大学韩语教程】/kintro/ 【韩语介绍】/ 【学韩语】http://www.interedu.go.kr 【通过因特网学韩语】/Language/korean.cfm 【韩语实践】/korean.htm 【Declan 韩语学习站】/index_e.htm 【韩语森林】http://rki.kbs.co.kr/learn_korean/lessons/c_index.htm 【KBS电台韩国语讲座】/home/ 【在线韩国语教室】/ 【韩国旅游官方网站】/ 【我爱韩语】/ 【韩语爱好者】/korea/ 【韩语学习网】/Forum/ 【韩岛论坛】东南亚1.泰语☆☆☆Thai/Thai/ 【北伊利诺斯大学东南亚研究中心泰语主页】 【轻松学泰语】http://www.kisa.ca/thai/ 【学泰语】/thai_language/ 【在亚洲泰语主页】/ 【泰语网】2.越南语☆☆☆Vietnamese/vietnamese/vn language/supportns/tableofcontent.htm 【北伊越南语主页】http://perso.orange.fr//langues/hanviet.htm 【汉越字典】/hanosoft/default.asp?chu= 【线上汉越字典】3.缅甸语☆☆Burmese/Burmese/ 【北伊利诺斯大学东南亚研究中心缅甸语主页】4.老挝语☆☆Lao/lao/LaoLanguage/Lao_la nguage_fp.htm 【北伊老挝语主页】 【老挝语软件】5.柬埔寨语/高棉语☆☆Cambodian/khmer/khmer/ 【北伊利诺斯大学东南亚研究中心柬埔寨语主页】6.马来语☆☆☆Malayhttp://pgoh13.free.fr/malay_course.php 【学马来语】7.印尼语☆☆☆Indonesian/Indonesian/ 【北伊利诺斯大学东南亚研究中心印尼语主页】/ 【一起学印尼语】8.菲律宾语/他加禄语☆☆Philipino/Tagalog/Tagalog/ 【北伊利诺斯大学东南亚研究中心他加禄语主页】/~pmorrow/ 【菲律宾历史语言文化及其他】欢迎关注@博士圈南亚1.梵语☆☆☆Sanskrithttp://acharya.iitm.ac.in/sanskrit/lessons/De v an/intro.html 【自学梵语】/zip/zsan01.htm 【Ukindia梵语阅读教程】/ 【悉昙梵文网】.tw/BDLM/lesson/fan/lesson_fan1.jsp 【梵文教学】/s-sanskrit2/gao-po/sanskrit-pronoun.htm 【古梵语语音教程】http://www.ucchusma.idv.tw/Sanskrit/sanskrit.htm 【轻松学梵文】2.印地语☆☆☆Hindi/Students/avatans/project.html 【印地语网络学习资源】/project/hindi_lessons/lessons.html 【印地语入门】 【在线印地语教师】/courses/hindi/ 【印地语教程】/zhin001.htm 【Ukindia印地语阅读教程】3.乌尔都语/zurdu1.htm 【Ukindia乌尔都语阅读教程】4.尼泊尔语☆☆Nepali/nepali/lessons/ 【尼泊尔语教程】5.孟加拉语☆☆Bengali/ 【孟加拉文化】/bengali_index.html 【初级孟加拉语】6.泰米尔语☆☆Tamil/~echeran/paadanool/ 【学泰米尔语】/~skc9/tamilclass/ 【用英语学泰米尔语】7.马尔代夫语☆☆Maldivian/thaana01.ht ml 【读写马尔代夫语】西亚1.普什图语☆☆Pashtohttp://www.khpala /homee.htm 【普什图语主页】2.波斯语☆☆☆Persian/Farsi 【轻松学波斯语】 【伊朗语言文字】/ 【伊朗语言文化】3.土耳其语☆☆☆Turkishhttp://cali.ari /maxnet/tur/ 【亚利桑那大学人文学院土耳其语教程】 【在线土耳其语】 【土耳其语课堂】4.阿拉伯语☆☆☆☆Arabic/babel/arabic/ 【巴别塔在线阿拉伯语教程】 【学阿拉伯语】 【阿拉伯语网】/learn-arabic.htm 【让我们学阿拉伯语】/arabic/eindex.html 【在线学阿拉伯语】/arabictutor/menuchn.htm 【非阿拉伯人学阿拉伯语】/study/Index.html 【伊斯兰之窗:学习阿语】5.希伯来语☆☆☆Hebrew 【在线学希伯来语】/onlineclass.html 【在线希伯来语课堂】/hebrewforme 【我的希伯来语】/ 【天主教徒的希伯来语】/alephbet.htm 【希伯来文字母】/ 【希伯来文教室】6.亚美尼亚语☆☆Armenianhttp://www.menq.am/tarer_main.htm 【亚美尼亚字母】 【学亚美尼亚语】7.格鲁吉亚语☆☆Georgian/Georgian.ht ml 【在线格鲁吉亚语】8.阿塞拜疆语☆☆Azeri/Azerbaijani/【阿塞拜疆语言文学】/az-lear.html 【学阿塞拜疆语】北亚1.楚科奇语☆Chukchi/ffpag/chuk lang.html 【楚科奇语介绍】/~spena/Chukchee/CHUKCHE E_HOMEPAGE.html 【楚科奇语主页】/gallery2/arctic/peoples/chukc hi/chukchi.htm 【楚科奇人图片】2.旁遮普语/5ratan/01_paath01.htm 旁遮普语教程/servlet/nguage?Actio n=Main 旁遮普语在线3.古吉拉特语/gujarati/index.htm 古吉拉特语字母等/plc/gujarati/index.html 古吉拉特语语法,词典等4.泰卢固语/learn/ 泰卢固语学习5.马拉亚拉姆语/malaindex.htm 马拉亚拉姆语学习6.马拉提语/ 马拉提语学习东欧1.俄语☆☆☆☆Russian 【学俄语:在线俄语中心】 【掌握俄语:从初级到高级】/WhatIsRussia/Russian.html 【通往俄罗斯之路:在线俄语指南和俄语词汇书】 【俄语教程】欢迎关注@博士圈2.白俄罗斯语☆☆Belarusian/~np214/lacin.htm 【白俄罗斯语网】3.乌克兰语☆☆Ukrainianma.kiev.ua/pub/courses/UFL/ 【乌克兰语入门】4.爱沙尼亚语☆☆Estonianhttp://www.einst.ee/publications/language/lan guage.html 【爱沙尼亚语介绍】5.拉脱维亚语☆☆Latvian/latvianasp/latonline. asp 【在线学拉脱维亚语】6.立陶宛语☆☆Lithuanianhttp://postilla.mch.mii.lt/Kalba/kalbarast.en.ht m 【立陶宛语言文字】/ 【在线学立陶宛语】/ma4/thelithuanians/index.html 【立陶宛人】南欧1.拉丁语☆☆☆Latin 【拉丁语和古希腊语学习】/latgramm.htm 【拉丁语词典和语法】/cola/centers/lrc/eieol/latol-TC-X.html 【在线拉丁语教程】2.希腊语☆☆☆Greek/LearnGreek/ (Modern/Ancient) 【在线学希腊语(现代/古代)】 (Modern) 【在线学希腊语(现代)】/gr-lessons/ (Modern) 【现代希腊语】http://www.xanthi.ilsp.gr/filog/ (Modern) 【外国人学现代希腊语】/koine/greek/lessons/ (New Testament) 【圣经新约希腊语学习】/~ancgreek/ (Ancient) 【古希腊语指南】 (Ancient) 【古希腊语和拉丁语学习】/cola/centers/lrc/eieol/grkol-TC-X.html 【在线古典希腊语教程】/cola/centers/lrc/eieol/ntgol-TC-X.html 【在线圣经新约希腊语教程】3.意大利语☆☆☆Italian/languages/italian/ 【BBC电台意大利语学习主页】 【用计算机学意大利语:课程和意大利旅游指南】http://www.italianforyou.it 【你的意大利语:在线互动意大利语教程】http://www.iluss.it/ 【在线学意大利语:教程语法词汇等】欢迎关注@博士圈4.西班牙语☆☆☆☆Spanish/languages/spanish/ 【BBC电台西班牙语主页】http://www.spanish.bz/learn-spanish.htm 【学西班牙语:在线教程和音频】 【免费西班牙语在线学习】 【学西班牙语】/learn.htm 【在线学西班牙语】 【西班牙城:学西班牙语】 【西班牙语语法自测】 【在线学西班牙语】5.葡萄牙语☆☆☆Portuguese/languages/other/p ortuguese/talk/ 【BBC电台:说葡萄牙语】http://www.sci.fi/~huuhilo/portuguese/ 【巴西葡萄牙语】 【学葡萄牙语】 【轻松学葡萄牙语】6.罗马尼亚语☆☆Romanian/ 【轻松学罗马尼亚语】7.保加利亚语☆☆Bulga rianhttp://learnbulgarian.hit.bg 【学保加利亚语】/ 【轻松学保加利亚语】http://www.hf.uio.no/east/bulg/mat/gram/index.html 【在线初级保加利亚语语法】8.阿尔巴尼亚语☆☆Albanian/ 【阿尔巴尼亚语概览】/fjalor/ 【在线英阿阿英词典】9.克罗地亚-塞尔维亚语☆☆Croatianhttp://www.hr/hrvatska/language/ 【克罗地亚语学习】☆☆Serbian 【塞尔维亚语学校】10.斯洛文尼亚语☆☆Slovenianhttp://www.ff.uni-lj.si/publikacije/sft/ 【旅游者斯洛文尼亚语】11.马其顿语☆☆Macedonian/azbuka.htm 【现代马其顿语字母】http://www.utoronto.ca/slavic/macedonian/ 【初级和中级马其顿语】/ 【古代马其顿】.mk/ancient-macedonians/lac_a.htm 【古代马其顿语言字母和文化】12.马耳他语☆☆Maltese/grazio/malti.html 【应急马耳他语】/grazio/maltesegrammar.html 【马耳他语语法】/language/engmal.htm 【基础英马词典】/language/phrasebook.htm 【马耳他语词汇】13.加泰隆语☆☆Catalan/curs/curs.html 【说加泰隆语】http://www.intercat.gencat.es/eng/learncatalan.html 【我在学加泰隆语】14.巴斯克语☆Ba squehttp://asignoret.free.fr/eskuara.html 【巴斯克语教程】http://www.ehu.es/grammar/ 【简易巴斯克语语法】西欧1.英语☆☆☆☆☆English/worldservice/learni ngenglish/ 【BBC电台英语学习主页】 【免费学英语】/medieval/research/rawl/IOE/ 【电子版古英语入门】/~modean52/oeme_dictionaries.ht m 【古英语词典】2.法语☆☆☆☆French/languages/french/ 【BBC电台法语学习主页】 【法语助手:免费在线法语课程】/languages/french/ 【法语教程】/french/ 【免费法语学习教程】 【我的图解法语词典(英法)】3.荷兰语☆☆☆Dutch荷兰语/ 【学荷兰语】 【旅游者荷兰语】http://www.gnomjas.nl/html/dutch/ 【学荷兰语:在线荷兰语语法教程】 【荷兰语学习】4.爱尔兰语/盖尔语☆☆Irish/Gaelic/lessons / 【爱尔兰语教程】/irishlanguage/ 【爱尔兰语教程】/brain/lang/ 【爱尔兰和苏格兰盖尔语教程】 【在线盖尔语】/~eofeasa/ 【在线爱尔兰语指导】/irishpeople/ 【爱尔兰人爱尔兰语教程】/ 【爱尔兰语语言信息和资源】欢迎关注@博士圈5.卢森堡语☆☆Luxembourgishnguages.lu/learnLuxembo urgish.htm 【自学卢森堡语】6.威尔士语☆☆Welsh/wales/learnwelsh/ 【BBC 威尔士语学习】/dace/e-wlpan/ 【E -Wlpan威尔士语教程】/fun/welsh/Welsh.html 【威尔士语教程】7.布列塔尼语☆Breton/scb/breton.html【布列塔尼语自由问答】/saoghal/mion-chanain/brezhoneg/ 【布列塔尼语简易教程】北欧1.冰岛语☆☆Icelandic/icelandic/ 【冰岛语教程】http://www.simnet.is/gardarj/gardar1.htm 【现实冰岛】/mimir/mimir.htm 【冰岛语语法笔记】2.丹麦语☆☆Danishhttp://www.speakdanish.dk 【丹麦语信息】/learndanish.htm 【让我们说丹麦语】http://users.cybercity.dk/~nmb3879/danish.html 【丹麦语语法】3.挪威语☆☆Norwegian /norwegian_culture/lan guagelessons_index.jsp 【挪威之子:挪威语教程】4.瑞典语☆☆Swedish/faculty/a/d/adr10 /swedish.html 【瑞典语教程】http://www.hhs.se/isa/swedish/ 【瑞典语介绍】/database/insightrecord.php?id=41 【瑞典语入门】5.芬兰语☆☆☆Finnishhttp://www.henkimaa.nu/finndex/suomea/lear ning/online.html 【在线芬兰语教程】http://www.cs.tut.fi/~jkorpela/Finnish.html 【芬兰语】http://virtual.finland.fi/finfo/english/finnlang.html 【现实芬兰:芬兰语】http://www.chiugate.fi/ 【芬兰语教程】中欧1.德语☆☆☆☆German/Deutschhtt p:///languages/ german/ 【BBC电台德语学习主页】 【在线学德语】/german/abinitio/ 【英国埃克赛特大学德语入门教程】/library/anfang/blanfang_inhalt.ht m 【德语入门】http://www.dw-world.de/dw/0,,2582,00.html 【德国之声德语教学节目】2.波兰语☆☆Polish/polishlessons/lekcje.htm 【波兰语入门】http://grzegorj.w.interia.pl/kurs/ 【波兰语教程】/gladney/Elementary_Polish/Start.h tml 【初级波兰语】3.捷克-斯洛伐克语☆☆Czech 【捷克语初级读本】/index.html 【捷克语学习资源】☆☆Slovak/ 【学斯洛伐克语】欢迎关注@博士圈5.匈牙利语/马扎尔语☆☆Hungarian/Magyar 【学匈牙利语】/faculty/a/d/adr10/hungarian.h tml 【匈牙利语教程】/hungarian/ 【匈牙利语教程】http://impulzus.sch.bme.hu/info/magyar.shtml 【匈牙利语入门】古代语言1.古斯堪的纳维亚语☆☆Old Norsehttp://www.hi.is/~haukurth/norse/ 【古斯堪的纳维亚语入门】/cola/centers/lrc/eieol/norol-TC-X.html 【在线古斯堪的纳维亚语教程】2.古教会斯拉夫语☆☆Old Church Slavonic/sla vonic/ 【帮我学教会斯拉夫语】/cola/centers/lrc/eieol/ocsol-TC.html 【在线古教会斯拉夫语教程】3.哥特语☆☆Gothic/cola/centers/lrc/eieol/got ol-TC-X.html 【在线哥特语教程】太平洋1.基里巴斯语☆Kiribati/kir/less01.htm 【基里巴斯语教程】2.查莫罗语☆Chamorroht tp:///cham.html 【查莫罗语】.gu/language.html 【关岛的语言】/chamorro-dictionary1.htm 【关岛查莫罗语词典及语法】/ 【世界查莫罗团体】3.塔希提语☆Tahitian/language.html 【塔希提语惯用语】/oceanic/tahiti/ 【塔希提语教程】4.萨摩亚语☆Samoan/ 【感觉萨摩亚人:文化、历史、语言等】5.斐济语☆Fijian/Facts/language.html【斐济群岛旅游指南:语言、信息、岛屿、观光旅游】6.毛利语☆Māori/ 【毛利网】/ 【Kōrero毛利语教程】/whakahuatanga/ 【毛利语发音】/ 【毛利语词典】/english/index.shtml 【毛利语代理】7.图瓦卢语☆Tuvaluan/lang-tv-index.htm 【图瓦卢语手册】8.瑙鲁语☆Nauruan/kir/petit.htm 【瑙鲁语词汇】9.比斯拉马语/瓦努阿图语☆Bislama/Vanuatu.au/langnet/bislama. htm 【比斯拉马语简介】/vanuatu/about_destin/bi slama.asp 【比斯拉马语简介】http://members.shaw.ca/scombs/bislama.html 【比斯拉马语,瓦努阿图的皮钦族际交际语】北美印第安语因纽特语☆Inuktituthttp://www.nu /~jtagak/resources/ 【因纽特文化资源】/ 【因纽特活词典】/topic/inuktitut 【因纽特语介绍】欢迎关注@博士圈奥杰布华语☆☆Ojibwe/~nancyv/ojibwe/ 【奥杰布华语言和文化】/ 【奥杰布华语言文化第一站】/ojib.html 【奥杰布华历史】黑脚语/布莱克福特语☆Blackfoothttp://people.uleth.ca/~frantz/blkft.html 【黑脚语介绍】http://www.fp.ucalgary.ca/blackfoot/ 【黑脚语主页】克里语☆Cree/cree/ 【说克里语】/en/ 【东克里语语言网】http://www.creeculture.ca/ 【克里文化】特拉华语☆Delaw are/~standingbear/language.h tm 【常用特拉华语】/ 【印第安特拉华部落】乔克托语☆Choctaw/areeves/choctaw/lan g.htm 【乔克托语常用语和语法】/language/tutor_chata.htm 【乔克托语教程】阿帕奇语☆Apache/Links/Staff/BGood/Apa chedictionary/Apachedict.html 【阿帕奇语有声词典】/apache/apache-index.htm 【阿帕奇部落:梦幻与现实】拿伐鹤语☆☆Navajo/~kchief/Language.htm l 【Karletta Chief的拿伐鹤语主页】/peoples/navajo/language.html 【拿伐鹤语语音样本】切罗基语☆☆Cherokee/ 【切罗基历史】/cocinc/language/ 【切罗基语教程】/nj/nativecrafts/language.html 【基础切罗基语】苏语☆Sioux/ 【达科他语教程】/lakota/iyapi/index2.html 【拉科他语教程】纳华特语☆Nahuatl/~dkjordan/nahuatl/nahuatl lessons/INL-00.html 【纳华特语教程】/home.htm 【纳华特语语言学院】南美印第安语凯楚亚语☆☆Quechua/quechua/ 【凯楚亚语主页】.pe/especiales/quechua/【凯楚亚语教程】http://www.runasimi.de/runaengl.htm 【凯楚亚语信息】/ 【安第斯文化:凯楚亚歌曲、诗歌、故事、图片】/quechua.html 【少许凯楚亚词语】/ 【凯楚亚语言和语言学】欢迎关注@博士圈艾马拉语☆Aymara/~h ardman/almp/almp.html 【艾马拉语语言材料】瓜拉尼语☆Guaranihttp://www.websters-online-/definition/Guarani-english/ 【瓜拉尼语词典】其他美洲语言复活节岛语言文字☆☆Rongorongohttp://www.portalrapanui.cl/ing/ing.htm 【复活节岛】。

Hikvision DS-2DE2A404IW-DE3(2.8-12mm) 4 MP 4 × IR PTZ Network Camera can be widely used in multiple scenes, such as the corridor, office, convenience store, and restaurant. ●1/3" progressive scan CMOS●Up to 2560 × 1440@25fps resolution●Excellent low-light performance with powered-by-DarkFighter technology● 4 × optical zoom, 16 × digital zoom●120 dB WDR, 3D DNR, EIS, Regional Exposure, RegionalFocus●12 VDC & PoE●Up to 20 m IR distance●IK10, IP66●Support H.265+/H.265 video compression●Built-in microphoneSpecificationsCamera ModuleImage Sensor 1/3" progressive scan CMOSMin. Illumination Color: 0.005 Lux @(F1.6, AGC ON) B/W:0.001 Lux @(F1.6, AGC ON) 0 Lux with IRWhite Balance Auto/Manual/ATW (Auto-tracking White Balance)/Indoor/Outdoor/Fluorescent Lamp/Sodium LampGain Auto/ManualShutter Time 50Hz: 1/1 s to 1/30,000 s 60Hz: 1/1 s to 1/30,000 sDay & Night IR Cut FilterDigital Zoom 16 ×Privacy Mask 24 programmable privacy masks Focus Mode Auto/Semi-automatic/Manual WDR 120 dB WDRLensFocal Length 2.8 mm to 12 mm, 4 × optical zoom Zoom Speed Approx. 2 s (optical lens, wide-tele)Field of View Horizontal field of view: 96.7° to 31.6° (Wide-Tele) Vertical field of view: 51.1° to 17.7° (Wide-Tele) Diagonal field of view: 115.1° to 36.3° (Wide-Tele)Working Distance 10 mm to 1500 mm (wide-tele)Aperture Range F1.6 to F2.7PTZMovement Range (Pan) 0° to 355°Pan Speed Configurable, from 0.1°/s to 100°/s. Preset speed: 100°/s Movement Range (Tilt) 0° to 90°Tilt Speed Configurable, from 0.1°/s to 100°/s. Preset speed: 100°/s Proportional Zoom YesPresets 300Power-off Memory YesCompression StandardVideo Compression Main Stream: H.265+/H.265/H.264+/H.264 Sub-stream: H.265/H.264/MJPEGThird Stream: H.265/H.264/MJPEGH.264 Type Baseline profile/main profile/high profileH.264+ YesH.265+ YesVideo Bitrate 32 Kbps to 16384 KbpsAudio Compression G.711alaw/G.711ulaw/G.722.1/G.726/MP2L2/PCMAudio Bitrate 64 Kbps (G.711)/16 Kbps (G.722.1)/16 Kbps (G.726)/32 Kbps to 192 Kbps(MP2L2) SVC YesSmart FeaturesBasic Event Motion Detection, Video Tampering Detection, ExceptionSmart Event Face detection, intrusion detection, line crossing detection, region entrance detection, region exiting detection, object removal detection, unattended baggage detection, audio exception detectionSmart Record ANR (Automatic Network Replenishment), dual-VCAROI Main stream, sub-stream, and third stream respectively support four fixed areas. IRIR Distance 20 mSmart IR YesImageMax. Resolution 2560 × 1440Main Stream 50Hz: 25fps (2560 × 1440, 2048 × 1536, 1920 × 1080, 1280 × 960, 1280 × 720)60Hz: 24fps (2560 × 1440), 30fps(2048 × 1536, 1920 × 1080, 1280 × 960, 1280 × 720)Sub-Stream 50Hz: 25fps (704 × 576, 640 × 480, 352 × 288) 60Hz: 30fps (704 × 480, 640 × 480, 352 × 240)Third Stream 50Hz: 25fps (1280 × 720, 704 × 576, 640 × 480, 352 × 288) 60Hz: 30fps (1280 × 720, 704 × 480, 640 × 480, 352 × 240)Image Enhancement 3D DNR, EIS, Regional Exposure, Regional Focus NetworkNetwork Storage Built-in memory card slot, support microSD/SDHC/SDXC, up to 256 GB; NAS (NFS, SMB/ CIFS), ANRAlarm Linkage Alarm actions, such as Memory Card Video Record, Trigger Recording, Notify Surveillance Center, Upload to FTP/Memory Card/NAS, Send Email, etc.Protocols IPv4/IPv6, HTTP, HTTPS, 802.1x, Qos, FTP, SMTP, UPnP, SNMP, DNS, DDNS, NTP, RTSP, RTCP, RTP, TCP/IP, DHCP, PPPoE, BonjourAPI ONVIF (Profile S, Profile G, Profile T), ISAPI, SDK Simultaneous Live View Up to 20 channelsUser/Host Up to 32 users. 3 user levels, administrator, operator and userSecurity Measures User authentication (ID and PW), Host authentication (MAC address); HTTPS encryption; IEEE 802.1x port-based network access control; IP address filteringClient iVMS-4200, Hik-Central, Hik-ConnectWeb Browser IE 8 to 11,Chrome 31.0+, Firefox 30.0+, Edge 16.16299+ InterfaceAudio Interface 1-ch audio input (mic in/line in) and 1-ch audio output (line out) 1 built-in microphoneNetwork Interface 1 RJ45 10 M/100 M Ethernet, PoE Power Output 12 VDC, max. 60 mAGeneralLanguage (Web Browser Access ) 32 languages.English, Russian, Estonian, Bulgarian, Hungarian, Greek, German, Italian, Czech, Slovak, French, Polish, Dutch, Portuguese, Spanish, Romanian, Danish, Swedish, Norwegian, Finnish, Croatian, Slovenian, Serbian, Turkish, Korean, Traditional Chinese, Thai, Vietnamese, Japanese, Latvian, Lithuanian, Portuguese (Brazil)Power 12 VDC, 1.5 A (Max. 9.9 W, including max. 4.2 W for IR)PoE (802.3af), 36 to 57 VDC, 0.35 A (Max. 11.2 W, including max. 4.2 W for IR)Working Environment Temperature: -20°C to 60°C (-4°F to 140°F), humidity: ≤ 90%Protection Level IP66 standard, IK 10, surge protection, ±2kV Line to Gnd, ±1kV Line to Line, IEC61000-4-5Material Aluminum alloy, PC, PC+ABSDimension Φ 130.7 mm × 101.7 mm (Φ 5.15" × 4.00")Weight Approx. 0.53 kg (1.17 lb.)DORIThe DORI (detect, observe, recognize, identify) distance gives the general idea of the camera ability to distinguish persons or objects within its field of view. It is calculated based on the camera sensor specification and the criteria given by EN 62676-4: 2015.DORI Detect Observe Recognize IdentifyDefinition 25 px/m 63 px/m 125 px/m 250 px/mDistance (Tele) 180.0 m (590.6 ft) 71.4 m (234.3 ft) 36.0 m (118.1 ft) 18.0 m (59.1 ft)Available ModelDS-2DE2A404IW-DE3(2.8-12 mm) (C), 12 VDC & PoETypical ApplicationHikvision products are classified into three levels according to their anti-corrosion performance. Refer to the following description to choose for your using environment.This model has NO SPECIFIC PROTECTION.Level DescriptionTop-level protection Hikvision products at this level are equipped for use in areas where professional anti-corrosion protection is a must. Typical application scenarios include coastlines, docks, chemical plants,and more.Moderate protection Hikvision products at this level are equipped for use in areas with moderate anti-corrosiondemands. Typical application scenarios include coastal areas about 2 kilometers (1.24 miles)away from coastlines, as well as areas affected by acid rain.No specific protection Hikvision products at this level are equipped for use in areas where no specific anti-corrosionprotection is needed.DimensionsAccessory OptionalDS-1294ZJ-PT Wall MountDS-1297ZJPendant Mount(extendable)DS-1299ZJPendant MountDS-1297ZJ-ESPendant Mount(extendable)DS-1297ZJ-M Pendant Mount (extendable) MSA-C1500IC12.0-18P-USMSA-C1500IC12.0-18P-GBMSA-C1500IC12.0-18P-JPPower adapterLAS60-57CN-RJ45Hi-PoE Midspan。

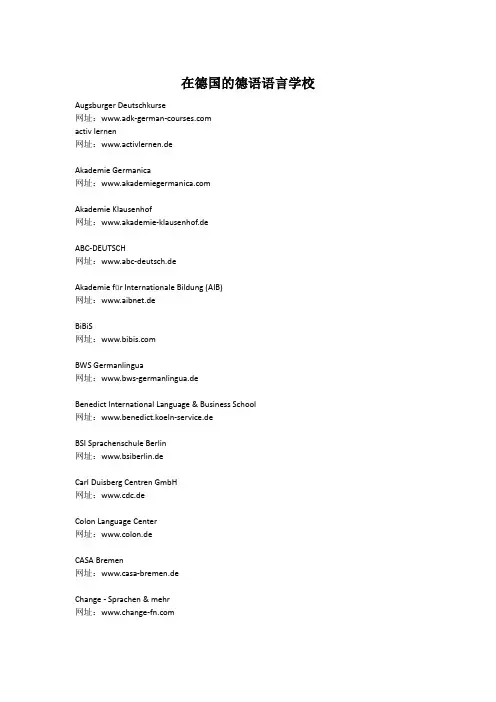

在德国的德语语言学校Augsburger Deutschkurse网址:activ lernen网址:www.activlernen.deAkademie Germanica网址:Akademie Klausenhof网址:www.akademie-klausenhof.deABC-DEUTSCH网址:www.abc-deutsch.deAkademie für Internationale Bildung (AIB)网址:www.aibnet.deBiBiS网址:BWS Germanlingua网址:www.bws-germanlingua.deBenedict International Language & Business School网址:www.benedict.koeln-service.deBSI Sprachenschule Berlin网址:www.bsiberlin.deCarl Duisberg Centren GmbH网址:www.cdc.deColon Language Center网址:www.colon.deCASA Bremen网址:www.casa-bremen.deChange - Sprachen & mehr网址:Deutsch im Gespäch / Really talking German网址:Dialog-Sprachschule网址:www.dialog-sprachschule.deDid Deustch-Institut网址:www.did.deDie Sprachfabrik网址:www.sprachfabrik.deDaF Deutschkurse für ausländische Führungskräfte in München 网址:www.dafkurse.deDie Neue Schule网址:www.neueschule.deEF International Language Schools网址:Eloquia网址:EURASIA Sprachen-Institut网址:Eurocentres köln网址:F+U International Academy for Professional & Language Training 网址:www.fuu.defremdsprachenforum网址:www.fremdsprachenforum.deGeothe Institut网址:www.geothe.deGLS Sprachenzentrum Berlin网址:GermanPlus网址:www.GermanPlus.deHorizonte网址:HSF Heidekberger Sprachinstitut网址:www.hsf.deICC Sprachinstitut网址:www.icc-sprachinstitut.deIFS Institut für Sprachvermittlung网址:www.ifs-deutsch.deIKL Business Language Training网址:International House Freiburg网址:www.ihfreiburg.deInlingua网址:www.inlingua.deLehrerkooperative网址:www.lehrerkooperative.deLinguarama GmbH网址:lingua franca网址:www.lingua-franca.deProlog网址:Sprachforum Augsburg网址:www.sprachforum-augsburg.deSprachforum Heinrich Heine网址:www.Sprachforum.deSprachenschule Würzburg网址:www.sprachenschule-wue.de Sprachschule zum Ehrstein网址:www.ehrstein.deSprachendienst Konstanz网址:www.sprachendienst-konstanz.deSprachenkolleg Stuttgart网址:www.deutschkurs-stuttgart.deSprachbörse网址:www.sprachboerse.deSprachzentrum Eine Welt网址:www.sprachzentrum.deSprachcaffe网址:www.sprachcaffe-duesseldorf.deTandem Berlin e.V.网址:www.tandem-berlin.deTandem Bielefeld网址:www.tandem-bielefeld.deTandem Hamburg网址:www.tandem-hamburg.deTANDEMünchen e.V.网址:www.tandem-muenchen.de。

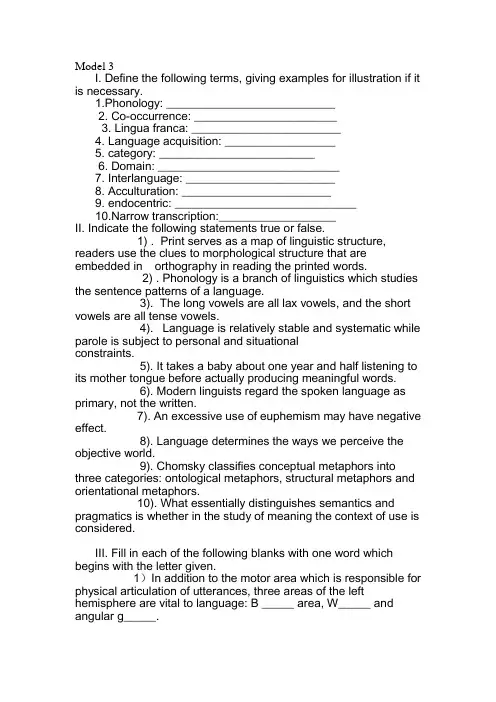

Model 3I. Define the following terms, giving examples for illustration if it is necessary.1.Phonology: __________________________2. Co-occurrence: ______________________3. Lingua franca: _______________________4. Language acquisition: _________________5. category: ________________________6. Domain: ____________________________7. Interlanguage: _______________________8. Acculturation: _______________________9. endocentric: ____________________________10.Narrow transcription:__________________II. Indicate the following statements true or false.1) . Print serves as a map of linguistic structure, readers use the clues to morphological structure that are embedded in orthography in reading the printed words.2) . Phonology is a branch of linguistics which studies the sentence patterns of a language.3). The long vowels are all lax vowels, and the short vowels are all tense vowels.4). Language is relatively stable and systematic while parole is subject to personal and situationalconstraints.5). It takes a baby about one year and half listening to its mother tongue before actually producing meaningful words.6). Modern linguists regard the spoken language as primary, not the written.7). An excessive use of euphemism may have negative effect.8). Language determines the ways we perceive the objective world.9). Chomsky classifies conceptual metaphors into three categories: ontological metaphors, structural metaphors and orientational metaphors.10). What essentially distinguishes semantics and pragmatics is whether in the study of meaning the context of use is considered.III. Fill in each of the following blanks with one word which begins with the letter given.1)In addition to the motor area which is responsible for physical articulation of utterances, three areas of the left hemisphere are vital to language: B _____ area, W_____ and angular g_____.2)Language varieties other than the standard are called v______.3)Social d_____ are varieties of language used by people belonging to particular classes.4)Like sound and morphological changes, syntactic change in English involves l_____, g _____ and modification.5)The history of English lexical expansion is one that is characterized with heavy b ____ and word f _____.6. Language is a system of arbitrary vocal symbols used for human c______.7. One general principle of linguistic analysis is the primacy of s_____ over writing.8. The idea of Paul Grice is that in making conversation, the participants must first of all be willing to c______; otherwise it would be impossible for them to go on with the talk. The general principle is called the C_____P____.9. The maxim of relation requires that what the conversation participants say must be r_____.10. The relationship between an embedded clause and its matrix clause is one of a p____ to a whole.IV. Mark the choice that would best complete the statement.1. Predication analysis refers to the kind of analysis which involves the breaking down of predications into their constituents: ______ and predicate.A. verbB. subjectC. objectD. arguments2. Language has at least seven basic functions: phatic, directive, informative, interrogative, expressive, evocative, and______.A. emotionalB.communicative C. performative D. interactive3. Black English is characterized by the followingExcept_______.A. omit auxiliary verbB. drop the final phoneme.C. the double negation constructionD. absence of the copula4. Langue refers to the abstract 1inguistic system shared by all the members of a speech community and _______ refers to actualized language, or realization of langue.A. speechB. paroleC. wordD. lexeme5. Lin guistic potential is similar to Saussure’s “langue” and Chomsky’s “_____”.A. performanceB. abilityC. competenceD. structure6. The vocal ______ are similar to strings such as one on a violin or a piano.A. stringsB. bandsC. cordsD. sounds7. Through the ______ of La-La sound, Engla-land came to be pronounced England.A. elaborationB. simplificationC. assimilationD. internal borrowing8. The word “ zoo” was formed in the way of ______.A. shorteningB. clippingC.abbreviation D. blending9. By ______, we refer to word forms which differ from each other only by one sound, e. g., "pin" and "bin".A. complementary distributionB. minimal pairC. free variationD. adjacency pairl0. Jacob Grimm’s great contribution to historical linguistics is his discovery of___.A. the Great Vowel ShiftB.the Indo-European languagesC. the sound shiftD. the Universal grammarl1. Morphologically the______ is the smallest unit that cannot be further divided.A. phonemeB. morphemeC.lexeme D. sememe12. Which of the following sounds is a voiced affricate?A. [ j ]B. [ t ]C. [ z ]D. [ ? ]l3. _____ is the study of the rules governing the ways words, word groups and phrases are combined to form sentences in language.A. StructureB. SyntaxC. GrammarD. Linguistics14. ______ construction is just the opposite of endocentric construction.A. ExtralinguisticB.Exocentric B. Internal D. Externall5. Traditional grammarians began with ____ definition of the sentence and its components.A. prescriptiveB. descriptiveC.notional D. structurall6. The semantic components of the word _____ are + Human, +Adult, +male, - Married.A. husbandB. manC. bachelorD. widow17. Dutch, English, Flemish, German, etc. are usually considered as West Germanic _______ Languages.A. ToneB. Indo-EuropeanC.Syllabic D. Agglutinative18. The view that language can be regarded as the dress of thought can be dated back to the time of ______.A. PlatoB. ShakespeareC. ChauD. Saussure19. The Sapir-Whorf Hypothesis has two major thrusts: linguistic determinism and linguistic _______.A. domainB. relativityC. performanceD. competence20. In sociolinguistics, ______ refers to a group of institutionalized social situations typically constrained by a common set of behavioral rules.A. domainB. situationC. societyD. communityV. Answer the following questions as comprehensively as possible, giving examples if necessary.1. Decide the meaning of the following affixes and roots and give each affix two examples.re- un- anti- super- mis- audi- ge ne- semi- ~path ~wise ~ize ~age2. How can consonants be classified?3. Why do we say language is arbitrary?4. For each of the underlined constructions or word groups do the following:1). State whether it is headed or non-headed2). If headed, state its headword3). Name the type of constructionsEx. His son will be keenly competing.Answer: headed, headword 一competing; verbal group.( a ) Ducks quack.( b ) The ladder in the shed is long enough.( c ) I saw a bridge damaged beyond repair.( d ) Singing hymns is forbidden in some countries.5. Explain the main characteristics of subjects in English.KeysI 1. The study of sound system---the inventory of distinctive sounds that occur in a language and the patterns into which they fall.2. It means that words of different sets of clauses may permit, or require, the occurrence of a word of another set or class to form a sentence or a particular part of a sentence. For instance , what can precede a noun ( dog ) is usually the determiners and adjectives , and what can follow it when it takes the position of subject will be predicators such as bark , bite , run , etc . In short, co-occurrence is the syntactic environment in which a construction, with its relevant elements, can appear grammatically and conventionally. Thus relations of co-occurrence partly belong to syntagmatic relations, partly to paradigmatic relations.3. Lingua franca is a variety of language that serves as a common speech for social contact among groups of people who speak different native languages or dialects.4. It is a general term used to refer to the development of a person’s first, second, or foreign language. That is, h ow he understands and to speak the language of his community.5. The term category in some approaches refers to classes and functions in its narrow sense ,e.g., noun , verb , subject , predicate , noun phrase , verb phrase , etc . More specifically, It refers to the defining properties of these general units: the categories of the noun, for example, include number, gender, case and countability; and of the verb, for example, tense, aspect , voice , and so on.6. Domain refers to a phenomenon that most bilingual communications have one thing in common, that is, a fairly clear functional differentiation of the two languages in respect of speech situations, for instance the Home Domain, Employment Domain etc.7. It refers to a separate linguistic system based on the observable out-put which results from a learner’s attempted production of a target language form. It is formed when he attempts to learn a new language, and it has features of both the first and the second language but is neither.8. Acculturation refers to the process of adapting to the culture and value system of the second language Community.9. Endocentric construction is one whose distribution is functionally equivalent to that of one or more of its constituents, i.e., a word or a group of words, which serves as a definable Centre or Head. In the phrase two pretty girls, girls, is the Centre or Head of this phrase or word group.10. Narrow transcription —— diacritics are added to the one – letter symbols to show the finer differences between sounds. Forexample, the sound [ l ] in the above mentioned words differ slightly. The [ l ] in leaf [ l:f ], occurring before a vowel is called a clear [ l ] and the [ l ] in feel [fi:l] , occurring at the end of a word or before another consonant is called a dark [ l ] and in narrow transcription the diacritic [ ~ ] is used to indicate it is a dark [ ? ]. Then in the sound combination [helθ] the sound is called a dental [l ] because it is followed by dental [θ ]II. 1.T 2.F 3.F 4.T 5.F 6.T 7.T 8.F 9.F 10.TIII. 1. Broca’s; Wernicke’s; gyrus 2. vernacular; 3. dialect; 4. loss, gain; 5. borrowing, formation;6. communication;7.speech;8. communicate, Cooperative Principle;9.relative; 10. part;IV. 1.D 2.B 3.A 4.B 5.C 6.C 7.C 8.B 9.B 10.A 11.B 12.D 13.B 14.B 15.A 16.C 17.B 18.A 19.B 20.AV. 1. again; not or the opposite action; greater or more than usual; badly or wrong(ly); listening; life; heat; half; emotion; inthemanner of; disease of inflection of; to make of the statedtype or put into the stated condition; the process of an action;2.Consonants ca be classified in two ways:1) according to the manner of articulation;2) according to the place of articulation;3. Language is arbitrary in the sense that there is no intrinsic connection between the sounds that people use and the objects to which these sounds refer. The fact that different languages have different words for the same object is a good illustration the arbitrary nature of language. It is only our tacit agreement of utterance.4. ( a. ) ( nonheaded, independent clause )( b ) ( non-head , prepositional phrase )( c ) ( headed; headword 一damaged ; adjectival group ) ( d ) ( headed; headword 一singing ; gerundial phrase )5. The grammatical category “subject” in different language possesses different characteristics. In English, "subject" may have the following characteristics:A. Word order: Subject ordinarily precedes the verb in a statement such as "Sally collects stamps."B. Pronoun forms: The first and third person pronouns In English appear in a special form when the pronoun is a subject. This form is not used when the pronoun occurs in other positions:He loves me I love him. We threw stones at them. They threw stones at us.C. Agreement with verb: In the simple present tense, an -s is added to the verb when a third person subject is singular. However , the number and person of the object or any other element in the sentence have no effect at all on the form of theverb :She angers him.They anger him. She angers them.D. Content questions: if the subject, is replaced by a question word (who or what),the rest of the sentence remains unchanged, as in ( b ) But when any other element of the sentence is replaced by a question word , an auxiliary verb must appear before the subject . If the basic sentence does not contain an auxiliary verb, we must Insert did or do (es) immediately after the question word, as in (d, e).。

英语词汇学笔记之-----章节部分2010.1.11===================================第一章1. Word —— A word is a minimal free form of a language that has a given sound and meaning and syntactic function.2. There is no logical relationship between sound and meaning as the symbolic connection between them is arbitrary and conventional. E.g. ―woman‖ means ’Frau’ in German,’Femme’ in French and ’Funv ’in Chinese. On the other hand,the same sound /rait/ can mean right,rite and write,though denoting different things,yet have the same sound.3. The difference between sound and form result from 4 major factors.(At least 80%of the English words fit consistent spelling patterns)a). the internal reason is English alphabet does not have a separate letter to represent each sound in the language.b). Pronunciation has changed more rapidly than spellingc). Influence of the work of scribes/printing freezes the spelling of words in 1500d). Borrowing of foreign language4. Vocabulary —— Vocabulary is most commonly used to refer to the sum total of all the words of a language. It can also refer to all the words of a given dialect,a given book,a given subject and all the words possessed by an individual person as well as all the words current in a particular period of time in history.The general estimate of the present day English vocabulary is over 1 million words.5.Classification of Words—by use frequency,by notion,by origin1). Basic word stock – the foundation of the vocabulary.1. all national character (most important)– natural phenomenamost common things and phenomena of the human body and relationsworld around us names of plants and animalsaction,size,domain,statenumerals,pronouns,prep. ,conj.2. stability – they donate the commonest thing necessary to life,they are like to remain unchanged. Only relative,some are undergoing some changes. But the change is slow.e.g. arrow,bow,chariot,knight – pastelectricity,machine,car,plane —— now3. productivity – they are mostly root words or monosyllabic words,they can form new words with other roots and affixes.e.g. foot – football,footage,footpath,footer4. polysemy – often possess more than one meaning. Become polysemous.e.g. take to move or carry from one place to anotherto remove5. collocability – quite a number of set expressions,idiomatic usages,proverbial saying and otherse.g. heart – a change of heart,a heart of goldNon-basic vocabulary ——1. terminology – technical termsphotoscanning,hepatitis,indigestion,penicillin,algebra,trigonometry,calculus2. jargon – specialized vocabulary in certain professions.Bottom line,ballpark figures,bargaining chips,hold him back,hold him in,paranoid3. slang —— substandard words often used in informal occasionsdough and bread,grass and pot,beaver,smoky,bear,catch,holler,Roger,X-rays,Certain words are labeled slang because of their usage.4. argot – words used by sub-cultured groupscan-opener,dip,persuadercant,jargon ,argot are associated with,or most available to,specific groups of the population.5. dialectal words – only by speakers of the dialectbeauty,chook,cocky,station,auld,build,coo,hame,lough,bog6. archaisms – words no longer in common use or restricted in use. In older poems,legal document and religious writing or speech.7. neologism – newly created words with new meaning e.g. microelectronics,futurology,AIDS,internet,E-mailold meaning acquired new meaning e.g. mouse,monitor2). Content word (notional word)– denote clear notions.Functional word (empty word,form word)– do not have notions of their own,express the relation between notions,words and sentences.a. Content words constitute the main body of the English vocabulary are numerous.Functional words are in a small number.b. Content words are growing.Functional words remain stable.c. Functional words do far more work of expression than content words.3). Native words – are words brought to Britain in the 15 century by the German tribes. Ango-Saxon Words,50,000-60,000What is true of the basic word stock is also true of native world. More are1. neutral in style (not stylistical specific )2. 2.frequent in use (in academic fields and science French,Latin or Greek are used)(usage 70-90%)Borrowed words (loan words,borrowing)– words taken over from foreign language. 80%According to the degree of assimilation and manner of borrowing,we can bring the loan words under 4 classes.1.Denizens – words borrowed early and now are well assimilated into English language.e.g. port from portus(L)shift,change,shirt,porkcup from cuppa(L)2.Aliens – retained their original pronunciation and spellinge.g. décor(F)blitzkreeg(G)emir,intermez,rowtow,bazaar,rajar,status quo3.translation loans – formed from the existing material in the English language but modeled on the patterns taken from another language.1). Word translated according to the meaninge.g. mother tough from lingua maternal(L)black humor from humor noirlong time no see,surplus value,master piece2). Words translated according to the sounde.g. kulak from kyrak(Russ)lama from lama(Tib)ketchuptea4. Semantic loans – their meaning are borrowed from another languagee.g. stupid old dumpnew sassydream old joy and peacepioneer old explorer/person doing pioneering worknew a member of the young pioneerfresh old impertinent,sassy,cheeky++++++++++++++++++++++++++++++++++++++++++++++++++第二章1.Indo-European language family (Europe,the Near East,India)Balto –Slavic Indo-Iranian Italic GermanicPrussian Persian Portuguese NorwegianLithuanian Hindi Spanish IcelandiePolish Italian DanishBulgarian Roumanian SwedishSlovenian French EnglishRussian GermanAlbanian Armenian Celtic HellenicIrish GreekBretonScottish2. History (时间,历史事件,特征)1)Old English (450-1150)totally 50,000-60,000 wordsThe 1st people known to inhabit England were Celts,the language was Celtic.The second language was the Latin of the Roman Legions.The Germanic tribes called angles,Saxons and Jutes and their language,Anglo-Saxon dominated and blotted out the Celtic. Now people refer toAnglo-Saxon as old English.At the end of 6th century,the introduction of Christianity has a great impact on the English vocabulary.The common practice was to create new words by combining two native words.In the 9th century,many Scandinavian words came into English. At least 900 words of Scandinavian are in modern English,our daily life and speech.特点:highly inflected languagecomplex endings or vowel changes (full ending)2)Middle English (1150-1500)English,Latin,FrenchUntil 1066,although there were borrowings from Latin,the influence on English was mainly Germanic. But the Norman Conquest started a continual flow of French words into English.By the end of the 13th century,English gradually come back into public areas.Between 1250 and 150 about 9000 words of French origin come into English. 75% of them are till in use today.As many as 2500 words of Dutch origin come into English.特点:fewer inflectionsleveled ending3)Modern English (1500-up to now)early modern English (1500-1700)late modern English(1700-up to now)The Renaissance,Latin and Greek were recognized as the languages of the Western world’s great literary heritage.The Industrial Revolution was in the mid-17 century. With the growth of colonization,British tentacles began a stretching out of to every corner of the globe,thus enabling English to absorb words from all major languages of the world.After World War II,many new words have been created to express new ideas,inventions and scientific achievements.More words are created by means of word-formation.thousands and thousands of new words have been entered to express new ideas inventions,and scientific achievements.more words are created by means of word-formation.in modern English,word endings were mostly lost with just a few exceptions English has evolved from a synthetic language to the present analytic language.science and technology terms make up about 45% of new words. words associated with life-style constitute of 24% and social and economic terms amount to over 10% .mention should be made of an opposite process of development i.e. old words falling out if use.特点:ending are almost lost.3. Three main sources new words1.The rapid development of modern science and technology2.Social,economic and political changes3.The influence of other cultures and languages4. Three modes of vocabulary development1. Creation – the formation of new words by using the existing materials,namely roots,affixes and other elements. (This is the most important way of vocabulary expansion.)2. Semantic change - an old form which take on a new meaning to meet the new need.3. Borrowing – to take in words from other languages.(particularly in earlier time)4. (Reviving archaic or obsolete)French 30%,Latin 8%,Japanese Italian 7%,Spanish 6%,German Greek 5%,Russian Yiddish 4%++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++第三章1. Morpheme —— A morpheme is the smallest meaningful unit of a language. (The smallest functional unit in the composition of words.)2.Morph—— A morpheme must be realized by discrete units. These actual spoken minimal carriers of meaning are morphs.3.Monomorphenic words – morphemes are realized by single morphs.4.Allomorph——Some morphemes are realized by more than one morph according to their position. Such alternative morphs are allomorphemes. E.g. the morpheme of plurality (-s)has a number if allomorphemes in different sound context,e.g. in cats/s/,in bags/z/,in matches/iz/.5. Free morphemes or Free root —— The morphemes have complete meaning and van be used as free grammatical units in sentences,e.g. cat,walk. They are identical with root words. morphemes which are independent of other morphemes are considered to be free.6. Bound Morphemes —— The morphemes cannot occur as separate words. They are bound to other morphemes to form words,e.g. recollection(re+collect+ion)collect – free morpheme re-and –ion are bound morphemes. (include bound root and affix)Bound morphemes are found in derived words.7. Bound root —— A bound root is that part of the word that carries the fundamental meaning just like a free root. Unlike a free root,it is a bound form and has to combine with other morphemes to make words. Take -dict- for example:it conveys the meaning of ―say or speak‖ as a Latin root,but not as a word. With the prefix pre-(=before)we obtain the verb predict meaning ―tell beforehand‖。

词汇学名词解释21、英语词汇概述:(8%)(1)英语词汇的谱系关系及其历史发展:英语的谱系关系;英语的三个发展阶段。

(2)英语词汇的构成:基本词汇与专⽤词汇;英语词汇中的本族词与外来词。

(3)英语词汇的三⼤特点:数量⼤、来源⼴、变化多。

‘Indo-European’印欧语系With Vikings’ invasion, many Scandinavian words at least 900 words of Scandinavian origin have survived in modern English. Old English has a vocabulary of about 50,000 to 60,000 words. It was a highly inflected language just like modern German.1. Word词--- A word is a minimal free form of a language that has a given sound and meaning and syntactic function. 2.Vocabulary词汇—— Vocabulary is most commonly used to refer to the sum total of all the words of a language. It can also refer to all the words of a given dialect,a given book,a given subject and all the words possessed by an individual person as well as all the words current in a particular period of time in history.3. basic word stock 基本词汇is the foundation of the vocabulary accumulated over centuries and forms the common core of the language. Though words of the basic word stock constitute a small percentage of the English vocabulary, yet it is the most important partof it. These words have obvious characteristics.(1)All national character全民性. Words of the basic word stock denote the most common things and phenomena of the world around us, which are indispensable to all the people who speak the language。

德国网站大全学桥网络(留学德国最大中文门户网站)(中国驻德国大使馆)(德国驻华使馆,包括审核部具体要求)(在德国学习于研究)(DAAD德文)(大学指南德文网页)(大学指南英文网页)(大学和专业选择仅供参考)(大学预科)(国际课程)(德国大学校长会议Hochschulrektorenkonferenz)(德国概况)(达福考试TestDaF)歌德学院Goethe-Institut(GI)(德国总部)(北京分院)(德语考试网页)E-Mail:德国大学生生活服务中心Deutsches Studentenwerk(DSW):德国青年旅社有限责任公司(DJH Service GmbH)Fax:+49.5231.7401-74E-Mail:德国文化及外教中心德国高校指数德国驻外学校一览德国外国留学生服务部德国学位大学一览(DFG)德国高校指南网德国教育服务网德国大学预科一览德国大学预科一览德国大学生服务部德国高校发展中心德国高等教育信息中心德国教育科研部/tr在线的英德,德英,中英互译翻译/index.php?act=detail&ID=906德国所有高校地址汇总(中文) 德国媒体政府网站一、报刊杂志德国的各大报刊杂志都有自己的网址,而且网址和报刊杂志同名。

除了提供最新一期的简要内容之外,一般还设有“Archive”一项,可查阅以前各期刊登的文章。

“Spiegel”杂志的网址“Focus”杂志的网址“Freundin”杂志的网址,内容为时装、美容、健美,还提供美食菜谱,教你如何做德国大餐。

“Deutschland”杂志的网址,有德、英、法和西班牙语版“Welt”报纸的网址“Handelsblatt”报纸的网址提供网上搜寻功能,可查询和访问德国所有上网的报纸网址号称是欧洲最大的网上杂志店二、电视台和广播电台这是“Deutsche Welle”的网址。

提供35种语言(包括中文)的可视听新闻。

这是ARD德国电视一台的“Tagesschau”新闻节目网址,可视听。