网络出版时间:2012-11-23 12:17 网络出版地址:https://www.doczj.com/doc/575776497.html,/kcms/detail/11.2560.TP.20121123.1217.006.html

软件学报 ISSN 1000-9825, CODEN RUXUEW Journal of Software ?中国科学院软件研究所版权所有 . E-mail: jos@https://www.doczj.com/doc/575776497.html, https://www.doczj.com/doc/575776497.html, Tel/Fax: +86-10-62562563

数据中心网络体系结构研究

?

魏祥麟 1,2, 陈 鸣 2, 范建华 1, 张国敏 2, 卢紫毅 1

1 2

(南京电讯技术研究所,江苏 南京

210007) 210007)

(解放军理工大学 指挥信息系统学院,江苏 南京

通讯作者 : 魏祥麟 , E-mail: wei_xianglin@https://www.doczj.com/doc/575776497.html, 魏祥麟 , 陈鸣 , 范建华 , 张国敏 , 卢紫毅 . 数据中心网络体系结构研究 . 软件学报 . https://www.doczj.com/doc/575776497.html,/1000-9825/4336.htm

摘

要:

在新的应用模式下,传统层次结构数据中心网络在规模、带宽、扩展性和成本方面存在诸多不足.为了适

应新型应用的需求,数据中心网络需要在低成本的前提下,满足高扩展性、低配置开销、健壮性和节能的要求.首先, 概述了传统数据中心网络体系结构及其不足,并指出了新的需求;其次,将现有方案划分两类,即为以网络为中心和 以服务器为中心的方案;然后,对两类方案中的代表性结构进行了详细的综述和对比分析;最后指出了数据中心网络 未来的发展方向. 关键词: 数据中心;网络;体系结构;拓扑;路由 中图法分类号: TP393 文献标识码: A

Research on the Architecture of the Data Center Network

WEI Xiang-Lin1,2,

1 2

CHEN Ming2,

FAN Jian-Hua1,

ZHANG Guo-Min2,

LU Zi-Yi1

(Nanjing Telecommunication Technology Research Institute of CESEC, Nanjing 210007, China) (College of Command Information Systems, PLA University of Science and Technology, Nanjing 210007, China) Under the new application mode, the traditional hierarchy data centers face several limitations in size, bandwidth, scalability

Abstract:

and cost. In order to meet the needs of new applications, data center network should fulfill the requirements with low-cost, such as high scalability, low configuration overhead, robustness and energy-saving. Firstly, the shortcomings of the traditional data center network architecture are summarized, and new requirements are pointed out. Secondly, the existing proposals are divided into two categories, i.e. server-centric and network-centric. Then, several representative architectures of these two categories are overviewed and compared in detail. Finally, the future directions of data center network are discussed. Key words: data center; network; architecture; topology; route

信息服务的集约化、社会化和专业化发展使得因特网上的应用、计算和存储资源向数据中心迁移.商业化 的发展促使了承载上万甚至超过 10 万台服务器的大型数据中心的出现.截止到 2006 年 ,Google 在其 30 个数据 中心拥有超过 45 万台服务器,微软和雅虎在其数据中心的服务器数量也达到数万台[1].随着规模的扩大,数据中 心不仅承载传统的客户机/服务器应用,也承载了包括 GFS 和 MapReduce 在内的新应用[2].这种趋势一方面突出 了数据中心作为信息服务基础设施的中心化地位 , 同时也凸显了传统分层数据中心在面临新应用和计算模式 时的诸多不足. 在新计算模式面前 ,分层数据中心的主要不足包括 :服务器到服务器连接和带宽受限、规模较小、资源分

?

基金项目 : 国家重点基础研究发展计划 (973)(2012CB315806); 国家自然科学基金 (61070173, 61103225, 61201216); 江苏省自 收稿时间 : 2012-08-09; 定稿时间 : 2012-10-19; jos 在线出版时间 : 2012-11-23

然科学基金 (BK2010133); 中国博士后科学基金 (201150M1512); 国防科技重点实验室基金 (9140C020302110C0206)

2

Journal of Software 软件学报

散、纵向扩展成本高、路由效率低、配置开销较大、不提供服务间的流量隔离和网络协议待改进等.这些问题 使其难以满足日益发展应用的需求 , 并在近几年得到了广泛关注 . 为了适应新型应用的需求 , 新型数据中心网络 需要满足的要求包括:大规模、高扩展性、高健壮性、低配置开销、服务器间的高带宽、高效的网络协议、灵 活的拓扑和链路容量控制、 绿色节能、 服务间的流量隔离和低成本等.这些要求也是当前研究的目标和出发点 . 目前 , 关于数据中心网络结构的研究可以分为两类 :网络为中心的方案和服务器为中心的方案 .在网络为中 心的方案中 , 网络流量路由和转发全部是由交换机或路由器完成的 . 这些方案大多通过改变现有网络的互联方 式和路由机制来满足新的设计目标 .在服务器为中心的方案设计中 ,采用迭代方式构建网络拓扑 ,服务器不仅是 计算单元,同时也充当路由节点,会主动参与分组转发和负载均衡. 本文首先指出了现有分层结构存在的不足并分析了针对新型数据中心网络的需求 , 然后系统分析了当前 具有代表性的多种数据中心网络方案,进行了综述和综合对比,最后对今后的研究方向进行了展望和探讨. 本文第 1 节介绍数据中心网络的基本结构和新的需求.在第 2 节和第 3 节分别系统讨论网络为中心和服务 器为中心的多种具有代表性的方案,并指出仍然存在的问题.第 4 节综合分析数据中心网络的各种方案,进行对 比,并展望未来研究方向.第 5 节总结全文.

1

数据中心网络:基本结构及新的需求

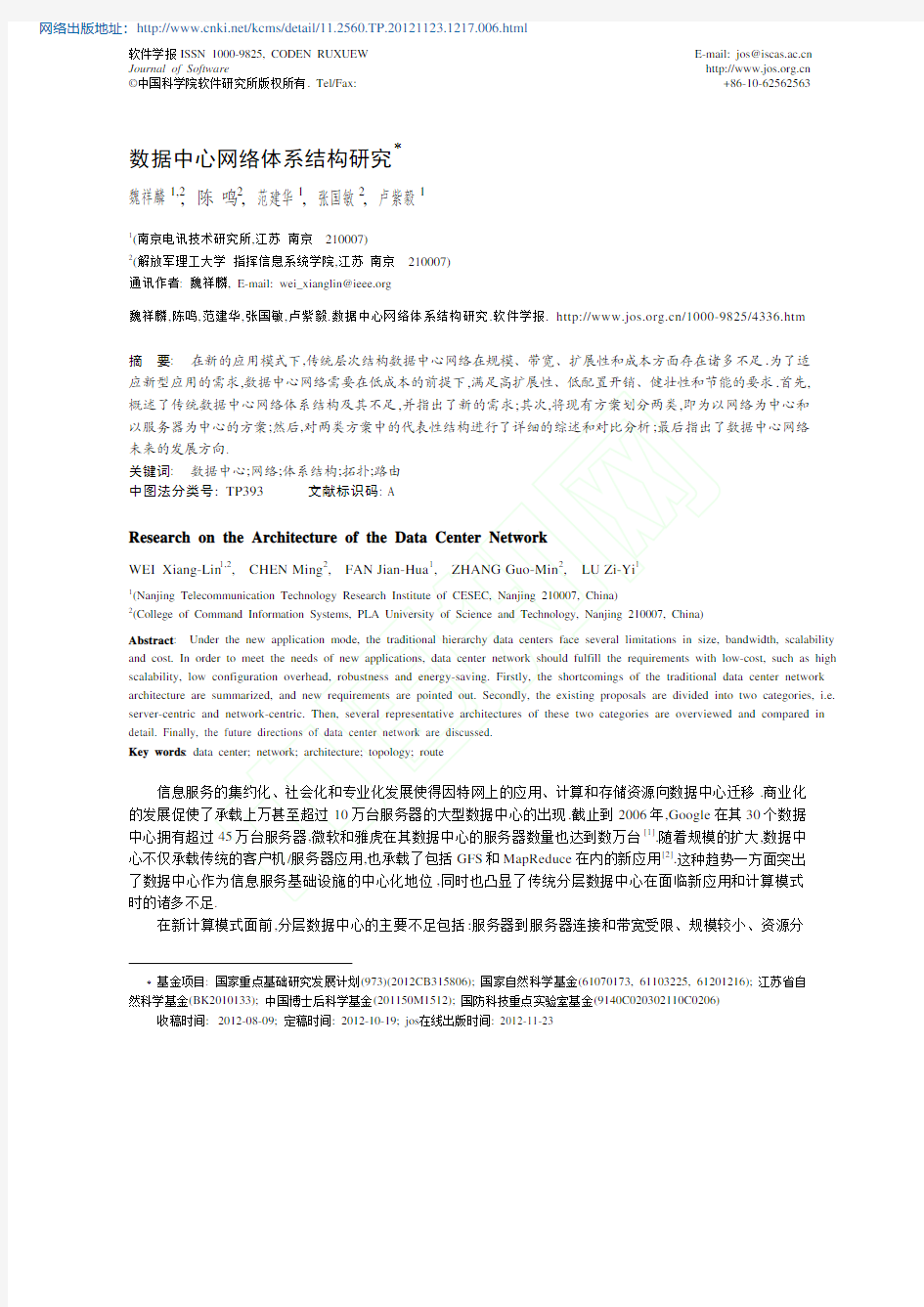

1.1 传统数据中心网络体系结构 数据中心网络 (data center network,简称 DCN)是指数据中心内部通过高速链路和交换机连接大量服务器 的网络 [1].传统数据中心网络主要采用层次结构实现 ,且承载的主要是客户机 /服务器模式应用 .多种应用同时在 同一个数据中心内运行 ,每种应用一般运行在其特定的服务器 /虚拟服务器集合上 .每个应用与一个或者多个因 特网可路由的 IP 地址绑定,用于接收来自因特网的客户端访问.在数据中心内部,来自因特网的请求被负载均衡 器分配到这个应用对应的服务器池中进行处理.根据传统负载均衡的术语,接受请求的 IP 地址称为虚拟 IP 地址 (virtual IP address,简称 VIP),负责处理请求的服务器的集合称为直接 IP 地址(direct IP addresses,简称 DIPs).一 个典型的传统数据中心网络体系结构如图 1 所示[1,3].

因特网 BR 因特网 BR

数据中心 第 3层 第 2层 LB

AR

AR

...

AR

AR

S

S

LB

S

S

S

S

A A ...

A

A A ... A

说明: BR: 3层边界路由器 AR: 3层接入路由器 S : 2层交换机 LB: 负载均衡器 A : 服务器机架

一个单独的2层域

Fig.1 图1

Traditional architecture of the DCN 传统的数据中心网络层次体系结构

在图 1 中,根据其 VIP 地址,来自因特网的请求通过 3 层的边界路由器(BR)和接入路由器(AR)被路由到 2

魏祥麟 等:数据中心网络体系结构研究

3

层域.应用对应的 VIP 地址被配置在图 1 中连接在上层交换机(S)的负载均衡器(LB)中.对于每个 VIP,负载均衡 器为其配置了一个 DIP 列表 ,这个列表包含的通常是服务器 (A)的内部私有地址 .根据这个列表 ,负载均衡器将 接收到的请求分配到 DIP 对应的服务器池中进行处理. 1.2 传统数据中心网络体系结构不足 面向云计算等新型计算模式的数据中心已经不同于企业数据中心[4],其呈现出许多新的特点: 第一,规模不断扩大,需要支持的服务器数量达到数十万或更高的量级; 第二,在流量特征方面,MapReduce 应用、虚拟机迁移以及其他带宽密集型应用等触发的数据中心内部流 量显著加,达到总流量的 80%左右,从而使得网络带宽经常成为稀缺资源[1]; 第三,出于成本考虑,数据中心规模的急剧扩大要求其采用成熟的普通商业化(commodity)网络设备达到横 向扩展,而不是采用昂贵的高性能设备进行纵向扩展[1,3,5,6]; 第四 , 一些新型数据中心网络结构具有不同于传统网络的结构 , 比如立方体 [7,8] 、随机图 [9] 、无标度网 络

[10,11]

、多根树[5]等,这些网络结构可以用来辅助设计高效的路由算法;

第五,为了保证服务质量和安全性,需要为各个服务的流量提供一定的流量隔离[12,13]; 第六 , 虚拟化已经成为数据中心的重要理念 , 其需要数据中心网络支持任意一个虚拟机的任意迁移和部 署,且不影响已经存在应用层状态; 第七 , 在大量服务器和交换机存在的前提下 , 数据中心网络不应该引入过多的交换机配置开销 , 需要做到 即插即用; 第八 , 一方面 ,数据中心网络已经成为全球能耗不可忽视的部分 ;另一方面 ,数据中心的超过 80%的链路负 载非常轻[14,15]; 第九 ,由于数据中心网络中广泛采用了低成本的低端设备 , 从而存在链路失效、服务器失效和交换机失效 等多种故障和差错,而持续的可靠服务能力需要数据中心网络提供高效的失效恢复策略和容错机制[1,12,16]. 根据这些特点以及图 1 展示的网络体系结构 , 可以总结出传统层次数据中心网络体系结构的不足主要包 括如下几个方面. (1) 服务器到服务器的连接和带宽受限.层次体系结构意味着隶属不同 2 层域的服务器间的通信流量需 要经过 3 层.但出于成本考虑,2 层到 3 层的链路经常是超额认购(oversubscription)的,也就是说,接入 路由器与边界路由器的链路容量显著低于连接到接入路由器的服务器总的输出容量 .这就导致了隶 属不同 2 层域的服务器间的可用带宽非常受限(取决于 3 层的超额认购比值以及流量分布情况); (2) 规模较小.如图 1 所示,所有连接到 1 对接入路由器的服务器构成单个 2 层域.如果使用传统的网络体 系结构和协议,受限于快速失效恢复的需要,单个 2 层域的规模约为 4 000 个服务器.由于广播流量(由 ARP 等引起)的开销的限制,2 层域大多被配置于 2 层交换机上的 VLAN 划分为子网.这个规模难以 用来构建十万级甚至百万级规模的数据中心; (3) 资源分散.目前流行的负载均衡技术,比如目的 NAT(半 NAT)和直接服务器返回(direct server return) 等,要求所有 VIP 的 DIP 池位于同一个 2 层域.这个限制意味着应用不能够使用其他 2 层域的服务器, 这导致了资源的分散和较低的资源利用率.通过源 NAT 或者全 NAT 的负载均衡允许服务器分散在 2 层域.但这种情况下服务器通常不能够看到客户端的 IP,这使得服务器无法利用客户端的 IP 地址信 息提供个性化服务或者进行数据挖掘类的工作,这对于服务器来说是无法接受的; (4) 采用专用硬件纵向扩展 ,成本高 .在传统体的系结构中 ,负载均衡器成对使用 .当负载变得太大时 ,运营 商使用新的拥有更大容量的均衡器代替现有的均衡器,这个纵向扩展的策略成本很高[3];另外,3 层的 路由器在超额认购比例发生变化或者拓扑发生变化时 , 需要纵向升级到更昂贵的路由器 , 而不是横 向升级 . 由于目前的高端设备与普通商业交换机 / 路由器的价格差别巨大 , 因此这种策略的升级成本 高昂; (5) 流量工程难度大 . 数据中心流量是高动态和突发的 ,约 80% 的流量都是内部流量 [14,17,18], 且流量持续

4

Journal of Software 软件学报

变化,难以预测,从而使得传统流量工程方法无法有效工作; (6) 自动化程度不高 [4].当服务需要在服务器间重分配时 ,传统数据中心网络的地址空间分片会导致巨大 的人工配置成本 , 且人工操作出错的概率很高 [6]. 在云服务数据中心网络中 , 提高自动化程度可以控 制 IT 员工与服务器成本的比值,并且能够降低由于员工操作失误带来的风险,使得网络更加健壮; (7) 配置开销大.3 层结构需要为每个交换机配置子网信息,并同步 DHCP 服务器来基于主机的子网来分 配 IP 地址[12];另外,VIP 与 DIP 列表的对应关系需要配置在负载均衡器上.当交换机或者网络设备故 障或 VIP 与 DIP 对应关系发生变化时,引入的配置开销较大,同时增加了误操作的风险; (8) 不提供服务间的流量隔离 . 在数据中心承载多个服务的同时 , 网络并没有阻止一个服务的流量影响 其周围的其他服务 . 当一个服务经历了流量洪泛时 , 位于其同一个子树的其他服务就会承担洪泛引 起的伤害[12]; (9) 网络协议待改进.在数据中心中大量沿用网络传输协议(TCP),而原有的 TCP 协议是面向互联网开发 的 ,没有考虑数据中心网络的低时延和高带宽特点 .研究发现 ,在多对一通信模式时 ,TCP 会出现链路 利用率不足的吞吐量崩溃现象[19,20]. 1.3 数据中心网络的新需求 为了满足新型计算模式和应用的需求,新型数据中心网络需要满足如下要求: (1) 服务器和虚拟机的便捷配置和迁移.允许部署在数据中心的任何地方的任何服务器作为 VIP 服务器 池的一部分 [3], 使得服务器池可以动态缩减或扩展 ; 并且 , 任意虚拟机可以迁移到任何物理机 . 迁移虚 拟机时无需更改其 IP 地址,从而不会打断已经存在的应用层状态; (2) (3) (4) 服务器间的高传输带宽 . 多数数据中心应用的服务器间的流量总量远大于数据中心与外部客户端的 流量.这意味着体系结构应该提供任意对服务器间的尽可能大的带宽[3]; 支持数十万甚至百万台的服务器 . 大的数据中心拥有数十万级或者更多的服务器 , 并允许增量的部 署和扩展[3]; 低成本且高扩展 [1]: 第一 , 物理结构可扩展 , 需要以较小的成本物理连接服务器 , 不依赖于高端交换机 来纵向扩展 , 而是采用普通商业化的组件实现横向扩展 ; 第二 , 可以通过增加更多的服务器到现有结 构上实现增量扩展 ,且当添加新的服务器时 ,现有的运行的服务器不受影响 ;第三 ,协议设计可扩展 , 比 如路由协议可扩展; (5) (6) (7) (8) 健壮性.数据中心网络必须能够有效的处理多种失效,包括服务器失效、链路断线或者机架失效等; 低配置开销 . 网络构建不应引入过多人工配置开销 . 理想情况下 , 管理员在部署前无需配置任何交换 机[16]; 高效的网络协议.根据数据中心结构和流量特点,设计高效的网络协议; 灵活的拓扑和链路容量控制 . 数据中心网络流量是高动态和突发的 , 从而使得网络中某些链路由于 超额认购产生拥塞 , 成为瓶颈链路 , 而很多其他链路则负载很轻 [14,18],因此 ,网络需要能够灵活地调配 负载或者灵活地调整自身拓扑和链路容量,从而适应网络流量变化的需求[21]; (9) 绿色节能 .新一代数据中心在当今能源紧缺与能源成本迅猛增长的情况下需要综合考虑能源效率问 题,提高利用率,降低流量传输和制冷开销; (10) 服务间的流量隔离.某服务的流量不应被其他服务的流量所影响,从而提供安全性和服务质量保证. 根据这些需求 , 研究者从多个角度出发 , 提出了多种设计方案 . 由于每个工作的出发点不同 , 为了描述清晰 , 本文着重综述数据中心网络体系结构方面的研究 ,并分析其存在的问题 .为了描述方便 ,将目前的研究划分为网 络为中心的方案和服务器为中心的方案两类,并在第 2 节和第 3 节分别进行描述.

2

网络为中心的方案

在网络为中心的方案中 ,网络流量路由和转发全部是由交换机和路由器完成的 .这些方案大多通过改变现

魏祥麟 等:数据中心网络体系结构研究

5

有网络的互联方式和路由机制来满足新的设计目标 . 相关方案主要包括 FatTree[5],ElasticTree[22],Monsoon[3], VL2[12],PortLand[16],SecondNet[13] 和 Jellyfish[9] 等 . 一些研究者引入光交换技术到数据中心网络 , 提出了包括 Helios[23],DOS[24],c-Through[25],OSA[21] 以及光电混合交换方案 [26]等 . 另一些研究者则将无线技术引入数据中心 , 提出了 Flyway[18] 和 WDCN[27,28] 等 .王聪等人也提出了一种低成本高连通性的数据中心网络体系结构 [29].本节 将选择具有代表性的方案进行综述. 2.1 FatTree 2.1.1

[5]

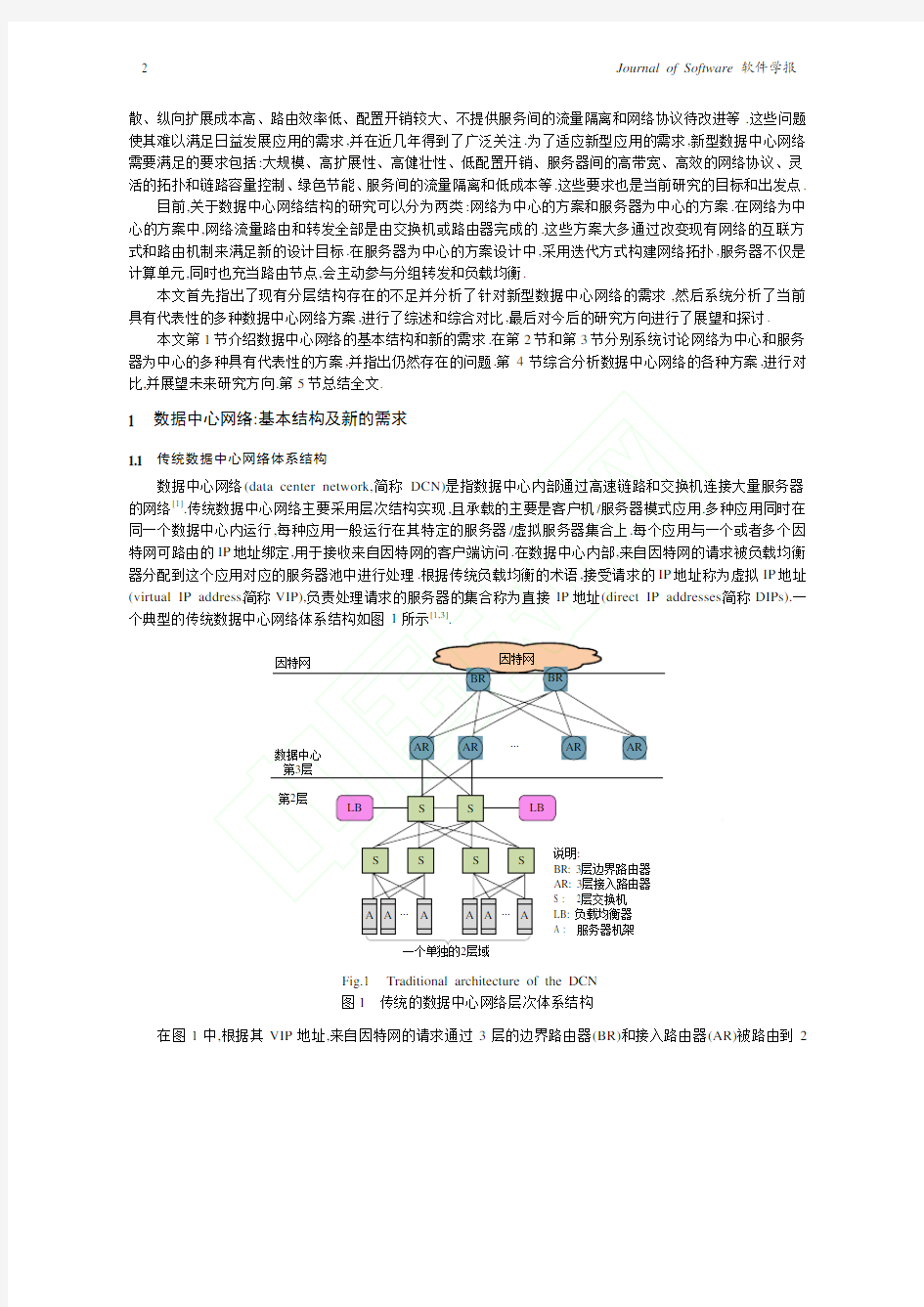

拓扑构建 Al-Fares 等人借鉴 Charles Clos 等人 50 年前在电话网络领域中的做法,提出使用 FatTree 来互联以太网交

换机 .FatTree 结构中交换机分为 3 层 :核心交换机、聚合交换机和边缘交换机.一个简单的 FatTree 的结构如 图 2 所示.图 2 展示的是一棵 k(=4)叉树 FatTree.图中有 4 个 Pod,每个 Pod 中包含 k 个交换机,k/2 个是边缘交换 机,k/2 个聚合交换机.并且边缘交换机有 k 个端口,其中,k/2 个连接到端主机,k/2 个连接到聚合交换机.聚合交换 机的 k/2 个端口连接到边缘交换机,另外 k/2 个连接到核心交换机.有(k/2)2 个核心交换机.核心交换机的 k 个端 口分别连接到 k 个 Pod 的聚合交换机.

核心

聚合 边缘

Pod 0

Pod 1

Pod 2

Pod 3

Fig.2 图2 2.1.2 地址配置

Topology of a simple FatTree network 一个简单的 FatTree 网络拓扑结构

Al-Fares 等人在私有的 10.0.0.0/8 块内设置网络中的所有 IP 地址.Pod 交换机的地址形式是 10.pod.switch.1, 其中,pod 代表 Pod 号 (属于[0,k?1]),switch 代表交换机在 Pod 中的位置(属于[0,k?1],从左到右,自底向上).核心交 换机地址形式为 10.k.j.i,其中,j 和 i 代表了交换机在(k/2)2 个核心交换机网格中的坐标(从左上角开始).主机的地 址跟随其连接到的 Pod 交换机,主机的地址形式是 10.pod.switch.ID,其中,ID 是主机在子网中的位置(在之间,从 左到右).因此,每个底层交换机负载一个/24 子网的 k/2 个主机. 2.1.3 两级路由表和路由 为了使得 Pod 间的流量尽量均匀地分布于核心交换机,FatTree 实现了两级路由表以允许两级前缀查询.一 些路由表的表项会有个额外的指针到一个二级路由表(suffix,port)项.图 3 展示了一个两级路由表的例子,其中, 左上角是一级路由表 , 而右下角则是二级路由表 .一级路由前缀如果不包含任何二级前缀的话 ,这个表项就称为 终结性表项,比如图 3 中一级路由表的前两个表项.一级路由表是左匹配的,二级路由表则从右开始匹配.图 3 中, 0.0.0.0/0 路由表项拥有二级路由表,包含两个表项,分别对应输出端口 2 和输出端口 3. FatTree 的任意两个不同 Pod 主机之间存在 k 条路径,从而提供了更多的路径选项,并且可以将流量在这些 路径之间进行分散.任意给定 Pod 的低层和高层交换机对位于本 Pod 的任意子网都有终结性表项.因此,如果一 个主机发送一个分组到同 Pod 的不同子网的另一个主机,那个 Pod 的所有的高层交换机会拥有指向目的子网交 换机的终结性表项.

6

Journal of Software 软件学报

对于 Pod 间流量,Pod 交换机有一个拥有二级表的/0 前缀匹配主机的 ID.使用目的主机 ID 作为确定性熵的 源,这会使得流量均匀地分布于所有的核心交换机[5].在核心交换机,为所有网络的 ID 分配终结性的一级表项指 向包含那个网络的合适的 Pod.一旦一个分组到达核心交换机 ,仅有一条链路到目的 Pod,那个交换机会为这个 分组的 Pod(10.pod.0.0/16,port)包含一个终结性的/16 前缀.一旦一个分组到达了目的 Pod,接收的高层 Pod 交换 机会包含一个 (10.pod.switch.0/24,port)前缀 ,从而将分组指向其目的子网交换机 .目的子网交换机最终将分组发 送到目的主机.

前缀 10.2.0.0/24 10.2.1.0/24 0.0.0.0/0 输出端口 0 1 前缀 0.0.0.2/8 0.0.0.3/8 输出端口 2 3

Fig.3

Two-Level route table of FatTree 图3 FatTree 两级路由表

2.1.4

ElasticTree 由于数据中心流量的突发性,Heller 等人认为,FatTree 为所有的端主机之间提供完全带宽(full bandwidth)

是没有必要的,并从节能的角度出发提出了 ElasticTree[22].其主要出发点是:关掉不用的链路和交换机,仅在需要

Optimizer Subset Traffic status Power control Port/linecard/ box on/off 数据中心网络 Flow routes Routing

时才开启 .其系统结构如图 4 所示 ,其中 ,优化器 (optimizer)负责 找到满足当前流量条件的最小能量网络子集;其输入是拓扑、 流 量矩阵、 每个交换机的电量模型和期望的容错属性.优化器输出 一个活动组件的集合给电量控制(power control)和路由 (routing) 模块 . 电量控制模块切换端口、板卡和整个交换机的能量状态 . 路由模块则为所有的流选择路径 , 然后将路由放入网络 . 在图 2 所示的 FatTree 拓扑中,当每个主机仅有 0.2Gbps(主机网卡容量 为 1Gbps)流量跨越核心交换机时,ElasticTree 的拓扑如图 5 中的 实线所示.

核心

Fig.4

Architecture of ElasticTree network ElasticTree 的系统结构图

图4

聚合 边缘

Pod 0

Pod 1

Pod 2

Pod 3

Fig.5 2.1.5 FatTree 和 ElasticTree 分析

Topology of a simple ElasticTree network 一个简单的 ElasticTree 网络拓扑

图5

与传统层次结构相比 : 首先 ,FatTree 结构消除了树形结构上层链路对吞吐量的限制 , 并能为内部节点间通 信提供多条并行链路 ;然后 , 其横向扩展的尝试降低了构建数据中心网络的成本 ;最后 ,FatTree 结构与现有数据

魏祥麟 等:数据中心网络体系结构研究

7

中心网络使用的以太网结构和 IP 配置的服务器兼容. 但是,FatTree 的扩展性受限于核心交换机端口数量,目前比较常用的是 48 端口 10GB 核心交换机,在 3 层树 结构中能够支持 27 648 台主机,因此,FatTree 存在扩展性不足的缺点[6];FatTree 的另一个缺点是容错性不够,具 体表现为处理交换机故障能力不足以及路由协议容错性不强 . 研究表明 [30]:FatTree 对边缘交换机故障非常敏 感,严重影响系统性能.因为 FatTree 仍然是树结构,本质上具有树结构的缺陷;第三,构建 FatTree 需要的交换机数 量为 5N/n,其中 ,N 是服务器的数量,n 是交换机的端口数量.当 n 较小时,连接 FatTree 需要的交换机数量庞大,从 而增加了布线和配置的复杂性 ;第四 ,FatTree 的流量调度依赖于中心服务器进行 ,这限制了其扩展性 , 面临单点 失效的问题. ElasticTree 基于 FatTree 构建,但是考虑了节能的问题,在轻载时降低了数据中心能耗,从而降低了成本;但 其没有根本上调整网络结构,从而面临与 FatTree 相似的问题. 2.2 Monsoon Monsoon 体系结构如图 6 所示[3],其中,所有的服务器连接到一个共同的 2 层网络,并且网络中没有超额认 购链路,这意味着任何服务器可以与其他服务器的网络接口以 1Gbps(假定主机网卡速度为 1Gbps)的速度进行 通信.Monsoon 网络的 3 层部分将数据中心连接到因特网,使用等耗费多路径(equal cost MultiPath,简称 ECMP) 将从因特网收到的请求均匀地分配到所有的路由器上.请求到达 2 层域后,接入路由器使用一致哈希将针对每 个 VIP 的请求均匀分布到负载均衡器上.最后,负载均衡器使用特定的负载均衡函数将请求均匀分布到服务器 池上.

因特网 BR 3层 ECMP AR AR 2层 全2层可达 扁平路由(以太网) AR AR BR

LB1 LB2 LB3 负载均衡器 LB4 (VIPs)

A1 A2 A3 A4 服务器机架 (DIPs)

LB5

A5

Fig.6 图6

Architecture of Monsoon Monsoon 体系结构

Monsoon 在 2 层商业以太网交换机构成的网络之上使用 VLB(valiant load balancing)实现了无热点的支持 任意流量模式的核心基础设施.Monsoon 利用扁平地址空间构建了单个可以支持 10 万台服务器的 2 层域,从而 解决了资源分散的问题.另外,Monsoon 使用造价低廉的硬件负载均衡硬件将服务的请求分散到服务器池中,从 而进一步消除了潜在的热点主机. 为了实现 Monsoon 的设计目标,Monsoon 使用了 MAC-in-MAC 技术,实现了 MAC 层隧道.另外,禁用了传 统的 ARP 功能 ,将其替换为一个用户态进程.一个新的称为封装器的 MAC 接口被增加来封装输出的以太网帧. 这使得 Monsoon 与传统的使用以太网的网络不能直接兼容.

8

Journal of Software 软件学报

Monsoon 还采用了控制平面来维护交换机的转发表 , 并维护目录服务 ,用于跟踪服务器连接到的交换机及 其 IP 和 MAC 地址.在收到关于 IP 的查询时 ,目录服务返回这个 IP 地址对应的多个 MAC 地址以及其使用的 VLB 中继交换机的集合.这使得控制平面的正常工作对 Monsoon 极为重要,面临单点故障. 2.3 VL2 图 7 是一个开关网络(clos network)的例子,也是 VL2 网络结构的示意图.与传统拓扑相似,机架(top of rack, 简称 ToR)交换机连接到两个聚合交换机.但是每两个聚合交换机都可以通过中继交换机互联,从而形成了大量 的可能路径.这意味着如果有 n 个中继交换机,任何一个的失效仅会减小 1/n 的双向带宽,这增加了路径数量和 健壮性.构建一个没有超额认购的开关网络很容易且成本较低,比如在图 7 中,如果使用拥有 DA 个端口的聚合交 换机和拥有 DI 个端口的中继交换机,那么每层间的容量是 DIDA/2 乘以链路容量.

因特网 链路状态网络 仅携带 LA Int

DI×10G

(DA/2)×中继交换机 …

Aggr

(DA/2)×10G … (DA/2)×10G ToR …

DADI/4×ToR 交换机

2×10G …

20 servers Int:中间交换机 Aggr:聚合交换机 ToR:机架交换机

20 servers

20(DADI/4)×服务器数量

20 servers

LA:位置地址 AA:应用地址 DA:聚合交换机端口数量 DI:中继交换机端口数量

可替换的服务器池 , 拥有 AA

Fig.7

Structure of VL2 network VL2 网络结构图

图7

这个开关网络拓扑特别适合 VLB,因为通过在网络顶层的一个中继交换机间接转发流量,网络可以为任何 服从软管模型 (hose model) 的流量矩阵提供带宽保证 . 同时 , 路由很简单且富有弹性 , 采用一个随机路径到达一 个随机中继交换机,然后沿一个随机路径到达目的 ToR 交换机. 在 VL2 中,IP 地址仅仅作为名字使用,没有拓扑含义.VL2 的寻址机制将服务器的名字和其位置分开.VL2 使用可扩展的、可靠的目录系统来维持名字和位置间的映射.当服务器发送分组时,服务器上的 VL2 代理开启 目录系统以得到实际的目的位置,然后将分组发送到目的地.VL2 代理也辅助消除由 2 层网络 ARP 产生的扩展 性问题.因此,VL2 同样依赖于中心化的基础设施来实现 2 层语义和资源整合,面临单点失效和扩展性问题. 2.4 PortLand 以 FatTree 网 络 结 构 为 基 础 ,Mysore 等 人 设 计 了 一 种 可 扩 展 和 容 错 的 2 层 路 由 和 转 发 协 议 , 称 为 PortLand[16].PortLand 引入了基本结构管理者(fabric manager),并使用层次伪 MAC 地址(pseudo MAC address,简

魏祥麟 等:数据中心网络体系结构研究

9

称 PMAC)进行分组转发: ? 基本结构管理者.PortLand 设置了一个逻辑上中心化的基本结构管理者,其维护诸如拓扑之类的网络配 置信息的软状态.管理者是一个运行于特定主机上的用户态进程,负责辅助 ARP 解析、容错和多播.管 理者可以是冗余连接的主机,也可以运行于一个单独的控制网络上; ? 层次伪 MAC 地址.PortLand 为每个端主机分配一个唯一的 PMAC 地址.PMAC 将端主机在拓扑中的位 置进行编码 . 比如 , 所有的位于同一个 Pod 的端节点的 PMAC 拥有相同的前缀 . 通过维持 PMAC 到 AMAC 的映射,端主机无需修改,仍然认为自身维持其真实的 MAC(actual MAC,简称 AMCA).为了得到 目的主机的 MAC 地址,主机会发起 ARP 请求以得到目的主机的 PMAC 地址.得到目的主机 PMAC 后, 所有的分组转发都基于 PMAC 进行,从而使得转发表很小.出口交换机进行 PMAC 和 AMAC 头的重写 , 以使得目的主机维持未修改的 MAC 地址. PortLand 的边缘交换机学习唯一的 pod 号以及 pod 里的一个唯一的位置号.交换机使用位置发现协议来分 配这些值.对于所有直接相连的主机,边缘交换机为其分配一个 48 比特的 PMAC,形式是 pod.position.port.vmid, 其中,pod(16 比特)反映了这个边缘交换机的 pod 号,position(8bit)是交换机在 pod 中的位置,port(8bit)是这个主 机连接到的端口号 ,vmid(16bit) 用来将位于同一个主机的多个虚拟机进行多路表示 . 边缘交换机为每个在给定 端口观察到的新 MAC 地址的 vmid 递增编号.PortLand 会设定 vmid 超时 ,如果在一定时间内没有任何来自于某 vmid 的流量,会重用这个 vmid. 图 8 展示了建立 PMAC 与 AMAC 的映射关系的一个例子.

基本结构 管理者

IP 10.5.1.2

PMAC 00:00:01:02:00:01

3

2a

2b 1

IP 10.5.1.2

AMAC 00:19:B9:FA:88:E2

PMAC 00:00:01:02:00:01

10.5.1.2 00:19:B9:FA:88:E2

Fig.8 图8

AMAC to PMAC mapping

AMAC 与 PMAC 的映射关系

在图 8 中:第 1 步,位于最左边 Pod 的一台主机发送分组到其直接连接的入口交换机(ingress switch);第 2 步, 入口交换机为其分配 PMAC 地址,并将其 IP、 AMAC 和 PMAC 的映射关系放入转发表(图 8 中的 2a 步所示), 并发送这个映射到基本结构管理者(图 8 中的 2b 步所示);第 3 步,基本结构管理者将收到的 IP 与 PMAC 地址映 射关系放入映射表格,这个表格可以用来响应 ARP 请求.

10

Journal of Software 软件学报

当一台主机需要同另一台主机通信时,其通过基本结构管理者进行 ARP 查询,获得目的主机的 PMAC 地 址.在分组将到达目的主机时,目的主机直接连接的交换机将 PMAC 地址重写为目的主机的 AMAC 地址,从而 实现了转发对主机的透明 .当发生虚拟机迁移时 , 由基本结构管理者存储迁移后的新映射 ,并向虚拟机原始连接 的交换机发送更新报文. PortLand 在 FatTree 的基础上构建了 2 层路由和转发协议,可以较好地进行容错路由和转发,支持虚拟机的 迁移和系统的扩展 .但 PortLand 对交换机的修改 ,使得需要升级原始交换机才能符合其要求 ;而且 ,其依赖于中 心化的基本结构管理者的体系结构,使得其面临单点故障和失效的威胁. 2.5 SecondNet 虚拟数据中心(virtual data center,简称 VDC)被定义为一组虚拟机的集合、客户提供的 IP 地址范围和一个 服务等级约定(service level agreement,简称 SLA).SLA 不仅定义了计算和存储需求,也定义了虚拟机的带宽需 求.VDC 允许 SLA 根据客户的动态需求进行调整.为了支持虚拟数据中心的抽象,Guo 等人从高扩展性、 低成本 和易伸缩的角度出发,设计了数据中心网络虚拟化体系结构,称为 SecondNet[13]. 为了提供带宽保证,需要在网络中维护带宽分配状态.出于扩展性考虑,Guo 等人并没有将这个状态维持在 交换机上 , 而是将带宽分配状态放在服务器的系统管理程序 (hypervisor) 上 , 且管理程序仅需维持其本身运行的 虚拟机的状态. 为了进行带宽分配,Guo 等人提出了一种中心化的启发式算法.在这个算法中,将邻居服务器分为规模不同 的组.需要分配一个 VDC 时,仅需搜索合适的组而不是整个物理网络,从而极大地减小了分配的时间.分配的服 务器距离较近,也使得 VDC 内的带宽较高;然后,使用高效的最小耗费流算法来将虚拟机映射到物理服务器上, 利用物理服务器网络的丰富连接进行路径分配. 完成带宽分配之后 ,Guo 等人又引入了基于端口交换的源路由 (port-switching based source routing, 简称 PSSR).因为网络拓扑已知,PSSR 将一个路由路径表示为一系列交换机输出端口的序列.PSSR 可以使用现有商 业交换机的 MPLS 功能进行部署 . 因此 ,SecondNet 可以在多数当前提出的数据中心网络结构之上部署 , 比如 FatTree,VL2 和 BCube 等. SecondNet 的体系结构如图 9 所示.

PSSR path: VDC0, VM0→VM1 0 2 1 2 无状态 交换机 4 2 5 3 VDC manager 请求 用户

0

1

4 0

5 1

2

3

2 0

s0

3 1

2 0

3 1

2 0

3 1

2 0

3 1

s1

信任域

0 1 Hypervisor State: v2p, band resv, pssr paths

VDC0 VM0 VDC1 VM0

有状态 服务器 不可信的虚拟机

0 1 Hypervisor State: v2p, band resv, pssr paths

VDC0 VM1 VDC1 VM1

Fig.9 图9

Architecture of SecondNet SecondNet 网络体系结构图

调整和删除.VDC 管理者、 从图中可以看出,SecondNet 引入了 VDC 管理者(VDC manager)进行 VDC 创建、 服务器管理软件和交换机构成了可信计算基础.VDC 管理者通过生成树来管理服务器和交换机,如图 9 中的虚 线所示.图 9 中还用粗实线显示了一条 PSSR 路径.

魏祥麟 等:数据中心网络体系结构研究

11

SecondNet 依赖于中心化的 VDC 管理者进行带宽分配和虚拟数据中心管理,使得其在 VDC 管理者处形成 瓶颈,面临单点失效的风险. 2.6 Jellyfish Singla 等人认为 ,严格的网络结构会限制网络的扩展性 , 因此提出通过随机互联网络中的交换机构成一张 随机图,从而获得更短的平均路径长度,并潜在地减小网络耗费[9].根据这种思想,提出了 Jellyfish. Jellyfish 的方法是在 ToR 交换机层上构建一个随机图.每个 ToR 交换机 i 有 ki 个端口,其中,ri 个连接到其他 ToR 交换机,使用剩下的 ki?ri 个端口连接到服务器.在最简单的情况下,每个交换机有相同数量的端口并承载相 同数量的服务器,即任取 i,k=ki,r=ri,有 N 个机架,网络可以支持 N(k?r)个服务器.在这种情况下,网络是一个随机 规则图.一个 Jellyfish 网络拓扑的示意图如图 10 所示.

服务器 端口 ... ... ... 交换机

服务器 交换机互联构成随机图

为了构建 Jellyfish 网络,可以采用如下方法:随机选取一对拥有空闲端口的非邻居交换机,使用一段链路将 其连接 ,并重复这个过程 ,直到网络中不能再添加新的链路为止 .当网络中新添加交换机或者仍然有交换机的空 闲端口大于 2 时 ,假定空闲端口为 (p1,p2),那么随机去掉一条已经存在的链路 (x,y),并添加两条新的链路 (p1,x)和 (p2,y). 通过这种构建方法 ,根据现有的关于随机图的理论结果 ,Singla 等人指出 :在网络中存在的服务器数量小于 900 时,Jellyfish 可以比 FatTree 多承载 27%的服务器,并且在网络规模扩大时优势更加明显.除此以外,Jellyfish 网络的平均路径长度小于 FatTree 的平均路径长度,并且在能耗方面也拥有优势. Jellyfish 主要从网络结构出发,取得了比 FatTree 更短的平均路径长度,并提供了比 FatTree 更宽的路径容 量 . 但随机的网络结构也使得布线成为一个挑战 ,并使得机架之间的位置摆放受限 .特别是需要互联由 Jellyfish 构成的集装箱数据中心时,如何处理互联数据中心的光纤成为一个挑战.另外,如何实现 Jellyfish 中假定的最优 路由,是随机拓扑面临的最大挑战. 2.7 OSA 2.7.1 动机和技术基础 通过分析数据中心流量的特征 ,Chen 等人认为 , 在数据中心中提供均匀的高性能网络场景没有必要 , 并指 出 ,如果网络能够根据流量变化调整自身的拓扑和链路带宽 ,将能够提供更大的灵活性和传输带宽 ,并引入了光 网络技术[21]. 光网络支持按需提供网络连接和链路容量 , 可以为服务器池构建灵活的连接 . 光链路可以使用比铜线更少 的电量在长距离上支持更高的比特率 .另外 ,光交换机比电交换机运行时产生的热量更少 ,使得其热耗散和制冷 成本更低.鉴于此,Chen 等人提出了基于光交换的数据中心网络体系结构 OSA(optical switching architecture),其 体系结构如图 11 所示.OSA 中主要引入了光交换矩阵和波分选择交换机作为技术基础.

... ...

交换机

服务器

Fig.10 图 10

Topology of Jellyfish Jellyfish 网络拓扑

12

Journal of Software 软件学报 ? 光交换矩阵(optical switching matrix,简称 OSM):大部分光交换模块是双向 N*N 矩阵,其中,任意输入端 口可以连接到任意的输出端口.目前流行的 OSM 技术使用 MEMS(micro-electro-mechanical switch)实 现,它可以在 10 毫秒以内通过机械地调整镜子的微排列来更改输入和输出端口的连接; ? 波分选择交换机(wavelength selective switch,简称 WSS):一个 WSS 是一个 1×N 交换机,由一个通用和 N 个波长端口组成.它将从通用端口进入的波长的集合在 N 个波长端口分开,这个过程可以在运行时以毫 秒级进行配置.例如,如果通用端口收到了 80 个波长,它可以在端口 1 路由第 1~第 20 个波长,将第 30~40 个波长和第 77 个波长通过端口 2 路由等.

Optical switching matrix (MEMS 320 ports)

k k k

Cir. 接收部分 发送部分 WSS MUX Coupler DEMUX ... ... ... ToR2 ... Optical mux/demux & switching components Optical mux/demux & switching components

ToR1

λ1 λ2 λ3 λ4

Server rack

λW

ToR 交换机

λ1 λ2 λ3 λ4

Server rack

λW

ToRN

λ1 λ2 λ3 λ4

Server rack

λW

...

...

Fig.11 图 11 2.7.2 OSA 网络体系结构和路由

Architecture of OSA OSA 体系结构图

OSA 通过利用 MEMS/OSM 的重配置能力达到灵活的拓扑.开始时,将 N 个 ToR 中的每一个连接到一个 N 端口 MEMS 中的一个端口.假定 MEMS 双向端口匹配,这意味着每个 ToR 在给定的时刻可以与一个其他的 ToR 进行通信.如果将 N/k 个 ToRs 连接到 MEMS 的 k 个端口,每个 ToR 可以同时与 k 个其他 ToR 通信,其中,k>1 是 一个 ToR 的度. 为了实现多跳连接,OSA 使用逐跳交换来达到网络范围的连通性.多跳路径上的每一跳都将分组从光转换 为电信号,然后转回光信号,并在 ToR 进行交换.OSA 通过管理拓扑来调整每个连接的容量和路由路径.OSA 采 用管理平面实现拓扑、链路容量和路由的计算与配置. 2.7.3 OSA 和光数据中心网络分析 光交换比点交换方式具有潜在的更高的传输速度、更灵活的拓扑结构 , 并且其制冷成本更低 ,因而是数据 中心网络很重要的研究方向. 但现有的 OSA 结构仍面临一些问题:第一,在当前的 OSA 体系结构中,一些时延敏感的短流,会受到光设备 重配置的约 10ms 的影响.通常,数据中心的时延小于 1ms,并且数据中心网络的控制流很多是短流,这会影响数 据中心在控制平面对整个系统的操作时效性;第二,OSA 当前的设计针对的是集装箱规模的数据中心,其规模有 限 .如何以其为基础 ,从体系结构和管理的角度设计和构建大规模数据中心网络很有挑战性 ;第三 ,OSA 中采用 的 ToR 交换机使用的交换机是同时支持光传输和电信号传输的交换机,这使其与传统数据中心的纯电信号交 换机难以兼容.

魏祥麟 等:数据中心网络体系结构研究

13

Helios 和 c-Through 是两个早期提出的混合电/光结构,在它们的模型中,每个 ToR 与一个电交换网络和一 个光网络有连接.电网络是一个 2 层或 3 层的具有特定超额认购比例的树.在光部分,每个 ToR 仅有一个连接到 其他 ToR 的光链路,但是这个链路容量很大,其成本较高并且没有充分利用光交换的灵活性. 2.8 无线数据中心网络 2.8.1 典型体系结构 无线技术可以在不用进行重新布线的情况下灵活调整拓扑,因此,Ramachandran 等人在 2008 年将无线技术 引入了数据中心网络.随后,Kandula 等人设计了 Flyways[18,31],通过在 ToR 交换机间增加无线链路来缓解机架的 拥塞问题 , 从而最小化最大传输时间 . 但是无线网络很难单独满足所有的针对数据中心网络的需求 , 包括扩展 性、高容量和容错等.比如,由于干扰和高的传输负载,无线链路的容量经常是受限的.因此,Cui 等人引入无线传 输来缓解热点服务器的拥塞 , 并将无线通信作为有线传输的补充 , 提出了一个异构的以太网 / 无线体系结构 , 其 体系结构如图 12 所示,这里称其为 WDCN[27]. 为了不引入过多的天线和彼此干扰,Cui 等人将每个机架作为一个无线传输单元(wireless transmission unit, 简称 WTU),如图 12 中底部所示.这样设计使得机架不会阻塞视线传输.

... 核心

聚合

...

...

...

...

机架

有线链路 无线链路 天线 ToR 无线 传输 单元 服务器 服务器 服务器 天线 ToR 服务器 服务器 服务器 无线 传输 单元

Fig.12 图 12 2.8.2 无线链路调度机制

Architecture of WDCN WDCN 体系结构图

Cui 等人提出的无线链路调度机制,包括收集流量需求和分配链路以及链路调度 3 个部分: ? 收集流量需求:一个 MTU 内的特定服务器被指定为 MTU 的单元头.单元头负责收集本地流量信息并执 行调度算法 .每个单元头安装了控制天线 ,所有的单元头通过共同的 2.4/5GHz 信道以推的方式广播其 流量负载.因此,所有的单元都可以得到全局流量负载分布,并可以独立进行无线链路调度;

14

Journal of Software 软件学报 ? 链路调度:在收集了流量需求信息之后,头服务器需要为无线传输分配信道.Cui 等人提出了一种启发式 的分配方法[27].

2.8.3

全无线架构数据中心网络 基于 60GHz 无线通信技术,Shin 等人提出了一种全无线架构的数据中心网络[31,32].Shin 等人将交换结构聚

合到服务器节点 ,期望将服务器节点布置的紧密相连、低伸展且支持失效恢复 .为了达到这个要求 ,将服务器的 网卡替换为 Y-交换机[32].另外 ,还将服务器布置在圆柱型机架里,从而可以方便地建立机架间和机架内的通信信 道 ,并使得这些连接一起构成了一个紧密链接的网状结构 . 由于其网络连接属于 Cayley 图的一种 , 因此称其为 Cayley 数据中心(cayley data center,简称 CayleyDC).根据这种结构,Shin 等人设计了全新的路由协议,可以让服 务器用少量内存短时间内计算路由,并保证路由的有效性和较短的跳数.CayleyDC 本质上属于服务器为中心的 结构,但为了讨论方便,本文在此集中讨论. 正如 Shin 等人指出的那样,Cayley 数据中心面临着几个问题:一是 MAC 层竞争极大的影响了系统的性能; 二是无线网络的性能受其网络跳数影响较大;三是多跳的性能问题限制了 Cayley 数据中心的扩展性. 2.8.4 ? 无线数据中心网络分析 无线/有线混合结构 无线技术的应用使得网络拓扑不再固定不变 ,并且省去了复杂的布线工作 ,使其在数据中心网络环境具有 一定的应用前景.Flyways 以及 WDCN 引入无线技术缓解热点主机的带宽问题,取得了一定的效果,并使得流量 需求与无线链路调度成为研究的焦点 .但无线技术在提供足够带宽的前提下 ,其传输距离是有限的 ,因而限制了 其在大规模数据中心中的部署;另外,WDCN 采用广播方式收集流量需求,使其面临时钟同步以及通信开销较大 的问题 ; 而且 , 测量结果显示 , 数据中心流量是持续改变的 , 这使得热点主机的位置是不确定的 , 从而对拓扑的调 整提出了更大的挑战. ? 全无线结构 如第 2.8.3 节所指出的那样,全无线数据中心网络在规模、扩展性和性能方面还面临着许多问题;但是无线 技术的优势和不断的发展,使得使用无线结构构建中小型、面向特定应用的数据中心成为可能.

3

服务器为中心的方案

在服务器为中心的方案设计中 , 采用迭代方式构建网络拓扑 , 服务器不仅是计算单元 , 同时也充当路由节

点 ,会主动参与分组转发和负载均衡 .这类方案通过迭代设计避免了位于核心层交换机的瓶颈 ,服务器之间拥有 多条可用的不相交路径 .这一类的典型设计方案包括 DCell[1] ,BCube[7],MDCube[8] ,PCube[15],FiConn[33],雪花结 构[3]和 HFN[2]等. 3.1 BCube和MDCube 3.1.1 拓扑结构与构建方法 BCube 网络中主要包括服务器和交换机两种组件[7].BCube 采用了递归的构建方法,BCube0 的结构如图 13 所示.从图 13 可以看出,BCube0 就是将 n 个服务器连接到一个 n 端口的交换机.在图 13 中 n=4.BCube1 结构如图 14 所示,其由 4 个 BCube0 和 4 个 4 端口交换机构成.更一般的,BCubek 由 n 个 BCubek?1 和 nk 个 n 端口交换机组 成.每个 BCubek 中的服务器拥有 k+1 个端口,标记为 level 0 到 level k.因此,一个 BCubek 拥有 N=nk+1 个服务器和 k+1 层交换机,每一层拥有 nk 个 n 端口交换机. BCubek 的构建规则如下:将 n 个 BCubek?1 标记为 0~n?1.每个 BCubek?1 中的服务器计数为 0 到 nk?1.然后将 第 j 个 BCubek?1 中的服务器 i 的第 k 层端口连接到第 k 层交换机的第 i 个交换机的第 j 个端口.

魏祥麟 等:数据中心网络体系结构研究

15

BCube0

? 0,0?

交换机 路由器 00 01 02 03

Fig.13 图 13

Bcube1

? 1,0? ? 1,1?

BCube0 network BCube0 网络

nk+1

? 1,2?

? 1,3?

Level-1 BCube0

? 0,0? ? 0,1? ? 0,2? ? 0,3?

Level-0 00 01 02 03 10 11 12 13 20 21 22 23 30 31 32 33

Fig.14 图 14 3.1.2 单播路由和多路径计算

BCube1 network BCube1 网络

给定两个服务器 A=akak?1…a0 和 B=bkbk?1…b0,其单路径路由算法如图 15 所示.从图 15 可以看出,从第 k 位 到第 0 位,BCubeRouting 每次遇到 A 与 B 不同的位时,就添加一个节点到 A 与 B 的路径中,最终成功到达节点 B.在 BCubek 中 ,任意两个服务器间存在 k+1 条并行路径.另外,为了进行负载均衡和容错,Guo 等人为 BCube 设 计了源路由协议 BSR[7].

/*A=akak?1…a0 和 B=bkbk?1…b0;A[i]=ai;B[i]=bi; Π=[πk,πk?1,…,π0]是 [k,k?1,…,1,0]的一个组合*/ BcubeRouting(A,B,Π): Path(A,B)={A,}; I_Node=A; For (i=k; i≥ 0; i??) If (A[πi]≠B[πi]) I_Node[πi]=B[πi] 将 I_Node 加入到 path(A,B) Return path(A,B);

Fig.15

Single-Path Routing algorithm in BCube BCube 中的单路径路由算法

图 15 3.1.3 MDCube

BCube 设计的目标是集装箱数据中心,而如何互联集装箱数据中心、 构建更大规模的数据中心,是 MDCube 互联结构的成本和布线的复杂 的主要目标[8].互联集装箱数据中心面临的 3 个挑战是:集装箱间的高带宽需求、 性. MDCube 使用 BCube 中交换机的高速接口来互联多个 BCube 集装箱.为了支持数百个集装箱,其使用光纤 作为高速链路.每个交换机将其高速接口作为其 BCube 集装箱的虚拟接口.因此,如果每个 BCube 集装箱都当作

16

Journal of Software 软件学报

一个虚拟节点,它将拥有多个虚拟接口.出于扩展性考虑,MDCube 引入了维度.每个 BCube 集装箱的交换机划分 为组,作为连接到不同维度的接口.一个集装箱由其映射到一个多维数组的 ID 标识.假定维度是 D,那么一个集 装箱的标识是 D 元组 cID=cDcD?1…c0(cd[0,md?1],d[0,D]).在维度 d 上,两个仅在维度 d 上 ID 元组不同的集装箱 之间存在一条链路.通过这种方法,BCube 集装箱互相连接形成一个超立方结构网络[34]. 3.1.4 BCube 类方案分析 BCube 类方案采用的服务器为中心的体系结构充分利用了服务器和普通交换机的转发功能 , 在支持大量 服务器的同时降低了构建成本,成为数据中心网络的重要研究方向.BCube 类方案提供多路径,并且提供了负载 均衡,不会出现明显的瓶颈链路,并增加了可靠性.当发生服务器或者交换机失效时,BCube 可以做到性能的优雅 下降,从而维持了服务的可用性. BCube 也存在一些不足: ? 首先 ,BCube 中使用普通商业交换机连接大量的服务器 ,从而使得其需要很多的交换机和链路 , 这增加 了其布线的难度和出错的概率; ? 第 二 ,BSR 执 行 时 ,BCube 会 探 测 服务器间存在的 k+1 条路径 , 从而确定最佳路径 , 在所有到所有 (all-to-all)通信模式中,这个探测过程会造成较大的通信和计算开销; ? 第三,BCube 要求每个服务器都要拥有 k+1 个端口,这使得目前的很多现有服务器难以符合其要求,需要进 行升级改造. 3.2 FiConn 普通商用服务器通常拥有 2 块网卡,但目前往往仅使用一块,另一块作为备用.这启发了 Li 等人使用备用端 口进行服务器互联的想法,从而设计了一个互联结构,称为 FiConn[33].每个 FiConn 中的服务器使用两个网卡端 口,一个连接到交换机,另一个连接到另外的 FiConn 服务器. FiConn 是一个递归定义的结构.高层 FiConn 由一些低层 FiConn 构建.Li 等人将 k 层 FiConn 标识为 FiConnk. FiConn0 是基本的构建单元,由 n 个服务器和一个 n 端口交换机连接.每个 FiConn 中的服务器有 1 个端口连接 到 FiConn0,称其为 0 层端口.连接到 0 层端口和交换机的链路称为 0 层链路.如果服务器的备用端口没有连接到 其他服务器,称其为可用备用端口.比如在 FiConn0 中,初始有 n 个服务器拥有可用备用端口. 如果一个 FiConnk?1 中一共有 b 个服务器拥有可用备份端口,那么 FiConnk 中 FiConnk?1 的数量 gk=b/2+1.在 每个 FiConnk?1 中,b 个服务器中的 b/2 个拥有备用端口的服务器使用其备用端口连接到其他的 FiConnk?1.这 b/2 个被选择的服务器称为 k 层服务器,k 层服务器上被选择的端口称为 k 层端口,连接 k 层端口的链路称为 k 层链 路.如果将 FiConnk?1 看作一个虚拟服务器,FiConnk 事实上是一个由 k 层链路连接的 FiConnk?1 的网络. 使用数字 uk 来标识中 FiConnk 的一个服务器 s.假定在 FiConnk 中服务器数量是 Nk,那么 uk 大于等于 0 且小 于等于 Nk.另外 ,服务器 s 可以使用 k+1 元组标识,也就是[ak,…,a1,a0],其中,a0 在 FiConn0 中标识 s.那么,为了标识 方便,s 也可以被标识为[ak,uk?1],[ak,ak?1,uk?2]等. 图 16 的算法展示了在 gk 个 FiConnk?1 基础上 FiConnk 的构建 .在每个 FiConnk?1,满足的服务器被选择作为 k 层服务器,它们在图 16 的第 4 行~第 6 行中被互联.

FiConnConstruct(k){ For (i1=0; i1

Constructing method of FiConnk FiConnk 的构建方法

图 16

魏祥麟 等:数据中心网络体系结构研究

17

以图 17 所示为例子.其中,n=4,k=2.FiConn0 由 4 个服务器和一个 4 端口交换机组成.用于组成 FiConn1 的 FiConn0 的数量是 4/2+1=3.服务器[0,0],[0,2],[1,0],[1,2],[2,0]和[2,2]被选择作为 1 层服务器,将[0,0]连接到[1,0], 将[0,2]连接到[2,0],将[1,2]连接到[2,2]. 在每个 FiConn1,有 6 个拥有可用备用端口的服务器,因此,用于构成 FiConn2 的 FiConn1 的数量是 6/2+1=4. 连接选择的 2 层服务器如下:[0,0,1]连接到 [1,0,1],[0,1,1]连接到[2,0,1],[0,2,1]连接到[3,0,1],[1,1,1]连接到 [2,1,1], [1,2,1]连接到[3,1,1],[2,2,1]连接到[3,2,1].这样就构成了图 17 所示的拓扑结构.

FiConn1[0]

0层链路 1层链路 2层链路

[0,0,0] [0,0,1] [0,0,2] [0,0,3] [0,2,3] [0,2,2] [0,2,1] [0,1,1] [0,1,2]

[0,1,0]

[0,2,0] [0,1,3] FiConn1[3] FiConn1[1] [3,1,0]

[3,0,0] [3,0,1] [3,0,2] [3,0,3] [3,2,3] [3,2,2] [3,2,1] [3,1,1] [3,1,2]

[1,0,0] [1,0,1][1,0,2] [1,0,3] [1,2,3] [1,1,1] [1,2,2] [1,2,1] [1,1,2]

[1,1,0]

[3,2,0]

[3,1,3] FiConn1[2]

[1,2,0]

[1,1,3]

[2,0,0] [2,0,1][2,0,2] [2,0,3] [2,2,3] [2,2,2] [2,2,1] [2,1,1] [2,1,2]

[2,1,0]

[2,2,0]

[2,1,3]

Fig.17 图 17

A FiConn2 with n=4

n=4 时,一个 FiConn2 的例子

FiConn 在不大量增加服务器端口的前提下,讨论了服务器为中心的结构,一定程度上提高了服务器间的联 通度,增加了服务器间通信的带宽.但从图 17 也可以看出,每个 FiConn0 对外连接的链路仍然有限,这使得 FiConn 的容错性较弱,且其路径长度较大,路由效率不高.

18

Journal of Software 软件学报

4

数据中心网络综合分析及未来研究方向

4.1 数据中心网络综合分析 第 2 节和第 3 节分别综述了网络为中心的方案和服务器为中心的方案,并简要分析了各个方案的优缺点. 这里将从总体上从以下几个测度对有代表性的方案进行集中对比: ? 规模:是指方案的现有设计能够支持的服务器的数量大小.分为 3 个层次:小、中和大; ? 带宽 : 是指在使用主流配置和数据中心的流量模式下 , 服务器间的带宽相对于服务器网卡带宽的比例 . 网络的超额认购比例越高,服务器间路径越少,其带宽就越小;反之则越大.分为 4 个层次:小、中、较大 和大; ? 容错性 :衡量方案容错性主要从该方案能否能够有效处理服务器故障、交换机故障和链路故障来衡量 的.分为 4 个层次:差、中、较好和好; ? 扩展性 :衡量扩展性主要从该方案是否存在中心化设施、单点失效以及是否容易增量部署几个方面进 行衡量的.分为 3 个层次:差、中和较好; ? 布线复杂性 :主要衡量方案引入的布线的复杂程度 . 一般地 ,结构越复杂、引入的端口和链路越多 , 其复 杂性就越高.分为 5 个层次:低、较低、中、较高和高; ? 成本:主要从方案使用的交换机类别/价格、交换机数量和链路数量进行衡量.分为低、中、较高和高 4 个层次; 网络 ? 兼容性:主要衡量各个方案是否与使用 IP 和以太网的传统数据中心兼容,包括服务器的端口数量、 协议和路由方式等.分为低、中、较高和高 4 个层次; ? 配置开销:主要反映方案中交换机配置、中心化基础设施的配置以及服务器配置的工作量.分为中、较 高和高 3 个层次; ? 流量隔离 : 反映方案是否考虑到服务的部署以及在服务之间提供流量隔离 . 可以看到 , 诸多方案中 , SecondNet 关注了这一点,其他方案多数未明确指出这一点; ? 灵活性:是指方案构建网络规模、网络拓扑和链路容量能否灵活变化.分为低、中、较高和高 4 个层次. 4.2 未来研究方向 从前文的综述可以看出,数据中心网络已经得到了极大的关注,研究者提出了诸多方案.但从表 1 的分析与 第 1.3 节的需求可看出,目前提出的方案很难完全满足当前诸如新型计算和应用模式对数据中心提出的需求. Table 1 Comparison of researches on the architecture of data center network 表1

分层结构 FatTree ElasticTree PortLand Monsoon VL2 Jellyfish OSA WDCN SecondNet DCell BCube FiConn 雪花结构 MDCube CayleyDC 规模 小 中 中 中 大 大 大 小 小 大 大 小 大 大 大 小 带宽 小 中 中 大 大 大 大 大 大 可变 较大 大 较大 较大 大 中

不同数据中心网络体系结构对比

扩展性 差 中 中 中 中 中 较好 中 中 中 较好 较好 较好 较好 较好 较好 布线复杂性 中 较高 较高 较高 较高 较高 高 较低 较低 高 高 高 较高 高 高 低 成本 高 较高 较高 较高 较高 较高 中 较高 中 中 较高 较高 中 较高 高 低 兼容性 高 高 高 较高 中 中 中 低 中 中 中 中 中 中 中 低 配置开销 高 较高 高 较高 较高 较高 较高 中 中 中 较高 较高 较高 较高 较高 中 流量隔离 无 无 无 无 无 无 无 无 无 有 无 无 无 无 无 无 灵活性 低 低 中 中 中 中 较高 高 高 高 较高 较高 较高 较高 较高 高

网络为 中心的 方案

服务器 为中心 方案

容错性 差 中 中 较好 中 中 较好 差 较好 较好 较好 好 较好 中 较好 中

魏祥麟 等:数据中心网络体系结构研究

19

在未来的研究中,重点关注的方向包括如下几个方面: (1) 新颖网络结构的应用和研究 . 网络结构在分布式系统中已经得到了广泛的研究 , 研究者也已经提出了 多种网络结构 [3,5,9,33,35]. 在数据中心网络环境下 , 现有成熟网络结构的应用需要进行验证和研究 . 尤其是在服务 器为中心的结构中,新兴网络结构研究的空间较大; (2) 数据中心网络协议的研究与改进.数据中心网络协议包括从 MAC 层到运输层的协议[36,37].数据中心网 络在管理和结构上都显著区别于现有的因特网体系结构 . 管理方面 ,数据中心网络往往由单个实体进行管理 , 因 而其全局拓扑、流量信息、失效信息和各种日志信息都是可以得到的,利用这些信息辅助协议设计和网络结构 设计具有很大的研究价值 [13]. 数据中心网络在结构上比因特网的结构更加严格 , 利用这种结构信息提出适合于 特定结构的协议可以增加运行的效率; (3) 流量以及失效规律的测量与建模 . 运行不同类型应用的数据中心的流量模式是不同的 , 从而使得其流 量特征也不一样 . 采用不同架构的数据中心网络 , 其失效规律也不一样 . 目前 , 已经有了一些关于数据中心流量 特征和失效规律的测量和研究 [14,17,38,39]. 全面理解数据中心流量和失效特征有待进一步的测量与建模分析 . 测 量分析结果可以帮助设计者理解数据中心的特性和探索新的网络结构及失效管理机制; (4) 地址自动配置 .诸如 PortLand、BCube、雪花结构等体系结构中将位置和拓扑信息编码到服务器或交 换机的地址中,从而提高路由的性能.因此,传统的诸如 DHCP 类的协议无法在这种场景下应用;而人工配置如此 大数量的交换机或服务器又是不可能完成的任务 . 因此 , 这些结构对自动地址配置提出了新的要求 . 另外 , 自动 配置可以降低人力成本并减小配置出错的风险 . 因此 ,针对拓扑已知甚至未知的数据中心网络 , 提出低开销、高 可靠和易管理的自动地址配置方法成为目前重要的研究方向,并且已经得到了许多关注[40,41]; (5) 数据中心的流量工程 .数据中心网络中的路由机制期望考虑和满足时延、可靠性、吞吐量和节能方面 的要求 , 这也是流量工程问题 . 包括数据中心内和数据中心间的流量工程问题 ,目前采用的方案包括 ECMP 和 VLB 等.但是 ECMP 不检查路径分配的负载,从而导致可能的路径拥塞.VLB 的随机分配方式也可能导致拥塞. 注意到 , 数据中心网络环境下的流量工程的前提不同于因特网环境 , 比如其虚拟机位置可变、拓扑可知并且可 以使用中心化的方法进行流量工程.因此,设计可靠、负载均衡和节能的流量工程方法是重要的研究方向[42?44]; (6) 光交换技术和无线传输技术的进一步应用 . 如果根据布线以及设计的复杂性和能量消耗来衡量 , 光 / 电 混合结构是优于传统电交换体系结构的 .但是光设备仍然比较昂贵且尚未在数据中心网络中得到应用 ,因此 , 除 了设计体系结构之外 ,如何降低其应用成本也是研究的重要内容 [45].全无线结构的布线复杂性最低 ,但如何在多 跳环境下设计可靠且高性能的结构仍然是个难题 .无线 /有线混合结构中 [46],无线技术可以有效缓解热点主机的 负载,如何感知流量需求并进行高效的无线链路调度是这个方向研究的重点; (7) 节能机制 [22]. 低碳、节能减排的社会发展大趋势 ,对数据中心结构以及路由的能耗提出了新的挑战 . 数 据中心网络的节能可以通过几个方面共同实现:设备节能、路由节能、虚拟机和任务调度的节能.ElasticTree 方 案和 Shang 等人提出的方案都通过调节设备的状态来实现节能 [47].关于虚拟机和任务调度的节能可以参考文 献 [48].另外 , 如何根据服务产生流量的特点和所采用的路由算法提出综合的节能方案是有效的节能思路 , 这方 面的研究目前尚且不多 .作者认为 , 服务的部署不能够仅从数据中心网络的结构出发 ,还应该考虑应用的特点和 流量特性,为服务定制合适的网络结构; (8) OpenFlow 等未来网络技术在数据中心网络中的应用 .数据中心网络管理实体单一 , 使其可以比因特网 更适合进行中心化的控制与管理.OpenFlow 是斯坦福大学在 2008 年提出的[49],基本思想是,将路由器的控制平 面和数据平面相分离,并采用流表来扁平化网络处理层次.目前,Jellyfish 使用 OpenFlow 寻找 k 最短路,MicroTE 使用 OpenFlow 实现流量工程[50],ElasticTree 在 OpenFlow 平台上实现了其原型系统,PortLand 使用 OpenFlow 构建实验床等 . 作者认为 ,OpenFlow 在未来的数据中心将会有更多更广泛的应用 . 另外 ,数据中心网络与因特网 相对独立 , 为了效率和成本 , 其完全有可能采用具有革命性的新架构 , 而未来网络领域的诸多研究值得其借鉴 , 比如其数据的标识、内容的定位与传输方法和路由的选择等.

20

Journal of Software 软件学报

5

结束语

首先 ,本文总结了在新型计算模式和应用面前传统分层数据中心呈现的不足以及面临额诸多需求 ;然后 ,将

现有研究方案分为两类进行了综述和对比分析 , 即以网络为中心的方案和以服务器为中心的方案 .分析发现 , 两 类方案各有优缺点 , 且其典型方案尚不能够满足目前对新型数据中心的需求 ;最后 ,对各种典型方案进行了综合 分析对比,并指出了未来的研究方向. References:

[1] [2] [3] Guo C, Wu H, Tan K, Shi L, Zhang Y, Lu S. Dcell: A scalable and fault-tolerant network structure for data centers. ACM SIGCOMM Computer Communication Review, 2008,38(4):75?86. [doi: 10.1145/1402958.1402968] Ding ZL, Guo DK, Shen JW, Luo AM, Luo XS. Researching data center networking topology for cloud computing. Journal of National University of Defense Technology, 2011,33(6):1?6 (in Chinese with English abstract). Greenberg A, Lahiri P, Maltz DA, Patel P, Sengupta S. Towards a next generation data center architecture: Scalability and commoditization. In: Proc. of the ACM Workshop on Programmable Routers for Extensible Services of Tomorrow. 2008. 57?62. [doi: 10.1145/1397718.1397732] [4] [5] [6] [7] Greenberg A, Hamilton J, Maltz DA, Patel P. The cost of a cloud: Research problems in data center networks. ACM SIGCOMM Computer Communication Review, 2009,39(1):68?73. [doi: 10.1145/1496091.1496103] Al-Fares M, Loukissas A, Vahdat A. A scalable commodity data center network architecture. ACM SIGCOMM Computer Communication Review, 2008,38(4):63?74. [doi: 10.1145/1402958.1402967] Liu XQ, Yang SB, Guo LM, Wang SL, Song H. Snowflake: A new type network structure of data center. Chinese Journal of Computers, 2011,34(1):76?86 (in Chinese with English abstract). Guo C, Lu G, Li D, Wu H, Zhang X, Shi Y, Tian C, Zhang Y, Lu S. BCube: A high performance, server-centric network architecture for modular data centers. ACM SIGCOMM Computer Communication Review, 2009,39(4):63?74. [doi: 10.1145/ 1592568.1592577] [8] Wu H, Lu G, Li D, Guo C, Zhang Y. MDCube: A high performance network structure for modular data center interconnection. In: Proc. of the 5th Int’l Conf. on Emerging Networking Experiments and Technologies. 2009. 25?36. [doi: 10.1145/1658939. 1658943] [9] [10] [11] [12] [13] [14] [15] [16] Singla A, Hong CY, Popa L, Godfrey PB. Jellyfish: Networking data centers randomly. In: Proc. of the 9th USENIX Symp. on Networked Systems Design and Implementation 2012 (NSDI 2012). San Jose, 2012. [doi: 10.1.1.224.9720] Gyarmati L, Trinh TA. Scafida: A scale-free network inspired data center architecture. ACM SIGCOMM Computer Communication Review, 2010,40(5):4?12. [doi: 10.1145/1880153.1880155] Shin JY, Wong B, Sirer EG. Small-World datacenters. In: Proc. of the 2nd ACM Symp. on Cloud Computing (SOCC). 2011. 2. [doi: 10.1145/2038916.2038918] Greenberg A, Hamilton JR, Jain N, Kandula S, Kim C, Lahiri P, Maltz DA, Patel P, Sengupta S. VL2: A scalable and flexible data center network. ACM SIGCOMM Computer Communication Review, 2009,39(4):51?62. [doi: 10.1145/1592568.1592576] Guo C, Lu G, Wang HJ, Yang S, Kong C, Sun P, Wu W, Zhang Y. Secondnet: A data center network virtualization architecture with bandwidth guarantees. In: Proc. of the 6th Int’l Conf. 2010. 15. [doi: 10.1145/1921168.1921188] Benson T, Anand A, Akella A, Zhang M. Understanding data center traffic characteristics. In: Proc. of the 1st ACM Workshop on Research on Enterprise Networking (WREN). 2009. 65?72. [doi: 10.1145/1672308.1672325] Huang L, Jia Q, Wang X, Yang S, Li B. PCube: Improving power efficiency in data center networks. In: Proc. of the 2011 IEEE Int’l Conf. on Cloud Computing (CLOUD). 2011. 65?72. [doi: 10.1109/CLOUD.2011.74] Mysore RN, Pamboris A, Farrington N, Huang N, Miri P, Radhakrishnan S, Subramanya V, Vahdat A. PortLand: A scalable faulttolerant layer 2 data center network fabric. ACM SIGCOMM Computer Communication Review, 2009,39(4):39?50. [doi: 10.1145/ 1592568.1592575] [17] [18] Kandula S, Sengupta S, Greenberg A, Patel P, Chaiken R. The nature of data center traffic: Measurements & analysis. In: Proc. of the 9th ACM SIGCOMM Conf. on Internet Measurement (IMC 2009). 2009. 202?208. [doi: 10.1145/1644893.1644918] Kandula JPS, Bahl P. Flyways to de-congest data center networks. In: Proc. of the 8th ACM Workshop. Hot Topics in Networks. 2009. 1?6.

NIKE 项目数据中心网络架构方案 1.概述 (2) 2.系统需求分析 (2) 3.企业网络信息系统设计思路 (2) 4.企业网络信息系统建设原则 (2) 5.系统技术实现细节 (3) 5.1 网络拓扑图 (3) 5.2 Nike项目服务器技术实现细节 (4) 5.2.1双机备份方案 (4) 5.2.1.1.双机备份方案描述 (4) 5.2.1.2.双机备份方案的原理 (4) 5.2.1.3.双机备份方案的适用范围 (4) 5.2.1.4.双机备份的方式及优缺点 (4) 5.2.1.5双机方案建议 (4) 5.2.1.6磁盘阵列备份模式示意图 (5)

5.2.1.7双机方案网络拓扑图 (5) 5.2.1.8双机热备工作原理 (6) 6.备份 (6) 7.建议配置方案及设备清单..................................................7-8 1.概述 21世纪世界竞争的焦点将是信息的竞争,社会和经济的发展对信息资源、信息技术和信息产业的依赖程度越来越大,信息技术的发展对政治、经济、科技、教育、军事等诸多方面的发展产生了重大的影响,信息化是世界各国发展经济的共同选择,信息化程度已成为衡量一个国家,一个行业现代化的重要标志。 2.系统需求分析 由于此方案是专为NIKE项目数据中心设计,此数据中心是为数据信息提供传递、处理、存储服务的,为了满足企业高效运作对于正常运行时间的要求,因此,此数据中心在通信、电源、冷却、线缆与安全方面都必须要做到非常可靠和安全,并可适应不断的增长与变化的要求。 3.系统设计思路 企业网络信息系统的建设是为企业业务的发展服务,综合考虑公司信息系统当前背景和状况,其建设设计主要应达到如下目标: 1) 系统的设计应能满足公司对公用信息资源的共享需求,满足3PL及客户查询数据的共享需求,并为实现公用信息资源共享提供良好的网络环境,概括而言之就是能让相关人员顺利流畅的访问数据中心的Nike XpDX Server及我司的TMS等相关系统。与此同时,系统的建设还需要考虑到投入和产出两者间的关系,注意强调成本节约,提高效费比的问题。 2) 系统的设计必须充分考虑到建成后系统的管理维护问题。为此设计应强调系统的统一集中管理,尽量减少资源的分散管理,注重提高信息系统平台运营维护的工作效率。 3) 系统的设计还需要考虑建成后资源的合理利用问题,必须保证建成系统资源主要服务于设定需求,保证设计数据流量在网络中流畅通行。因此,必须保证只有设计的数据流量才能优先在网络中传递,对于设计外数据流量(例如互联网网页访问、网络下载、网络视频、网络音频、P2P、IM聊天)应通过技术

集团云数据中心基础网络详细规划设计

目录 1前言 (2) 1.1背景 (2) 1.2文档目的 (2) 1.3适用范围 (2) 1.4参考文档 (2) 2设计综述 (3) 2.1设计原则 (3) 2.2设计思路 (5) 2.3建设目标 (7) 3集团云计算规划 (8) 3.1整体架构规划 (8) 3.2网络架构规划 (8) 3.2.1基础网络 (9) 3.2.2云网络 (70)

1前言 1.1背景 集团信息中心中心引入日趋成熟的云计算技术,建设面向全院及国网相关单位提供云计算服务的电力科研云,支撑全院各个单位的资源供给、数据共享、技术创新等需求。实现云计算中心资源的统一管理及云计算服务统一提供;完成云计算中心的模块化设计,逐渐完善云运营、云管理、云运维及云安全等模块的标准化、流程化、可视化的建设;是本次咨询规划的主要考虑。 1.2文档目的 本文档为集团云计算咨询项目的咨询设计方案,将作为集团信息中心云计算建设的指导性文件和依据。 1.3适用范围 本文档资料主要面向负责集团信息中心云计算建设的负责人、项目经理、设计人员、维护人员、工程师等,以便通过参考本文档资料指导集团云计算数据中心的具体建设。 1.4参考文档 《集团云计算咨询项目访谈纪要》 《信息安全技术信息系统安全等级保护基本要求》(GB/T 22239-2008) 《信息系统灾难恢复规范》(GB/T20988-2007) 《OpenStack Administrator Guide》(https://www.doczj.com/doc/575776497.html,/) 《OpenStack High Availability Guide》(https://www.doczj.com/doc/575776497.html,/) 《OpenStack Operations Guide》(https://www.doczj.com/doc/575776497.html,/) 《OpenStack Architecture Design Guide》(https://www.doczj.com/doc/575776497.html,/)

数据中心机房建设概述 发布时间:2012-03-06 14:33 浏览量: 2076 一、数据中心的概念 数据中心(DataCenter)通常是指在一个物理空间内实现信息的集中处理、存储、传输、交换、管理,而计算机设备、服务器设备、网络设备、存储设备等通常认为是网络核心机房的关键设备。 关键设备运行所需要的环境因素,如供电系统、制冷系统、机柜系统、消防系统、监控系统等通常被认为是关键物理基础设施。 二、机房工程(数据中心)的类型及特点 电子机房主要有计算机机房、电信机房、控制机房、屏蔽机房等。这些机房既有电子机房的共性,也有各自的特点,其所涵盖的内容不同,功能也各异。 (一)计算机机房 计算机机房内放置重要的数据处理设备、存储设备、网络传输设备及机房保障设备。计算机机房的建设应考虑以上设备的正常运行,确保信息数据的安全性以及工作人员身心健康的需要。 大型计算机机房一般由无人区机房、有人区机房组成。无人区机房一般包括小型机机房、服务器机房、存储机房、网络机房、介质存储间、空调设备间、UPS设备间、配电间等;有人区机房一般包括总控中心机房、研发机房、测试机房、设备测试间、设备维修存储间、缓冲间、更衣室、休息室等。 中、小型计算机机房可将小型机机房、服务器机房、存储机房等合并为一个主机房。 (二)电信机房 电信机房是每个电信运营商的宝贵资源,合理、有效、充分地利用电信机房,对于设备的运行维护、快速处理设备故障、降低成本、提高企业的核心竞争力等具有十分重要的意义。 电信机房一般是按不同的功能和专业来区分和布局的,通常分为设备机房、配套机房和辅助机房。 设备机房是用于安装某一类通信设备,实现某一种特定通信功能的建筑空间,便于完成相应专业内的操作、维护和生产,一般由传输机房、交换机房、网络机房等组成。配套机房是用于安装保证通信设施正常、安全和稳定运行设备的建筑空间,一般由计费中心、网管监控室、电力电池室、变配电室和油机室等组成。 辅助机房是除通信设施机房以外,保障生产、办公、生活需要的用房,一般由运维办公室、运维值班室、资料室、备品备件库、消防保安室、新风机房、钢瓶间和卫生间等组成。在一般智能建筑中通信机房经常与计算机网络机房合建。 (三)控制机房 随着智能化建筑的发展,为实现对建筑中智能化楼宇设备的控制,必需设立控制机房。控制机房相对于数据机房、电信机房而言,机房面积较小,功能比较单一,对环境要求稍低。但却关系到智能化建筑的安全运行及设备、设施的正常便用。

数据中心网络系统 设计方案

数据中心高可用网络系统设计 数据中心作为承载企业业务的重要IT基础设施,承担着稳定运行和业务创新的重任。伴随着数据的集中,企业数据中心的建设及运维给信息部门带来了巨大的压力,“数据集中就意味着风险集中、响应集中、复杂度集中……”,数据中心出现故障的情况几乎不可避免。因此,数据中心解决方案需要着重关注如何尽量减小数据中心出现故障后对企业关键业务造成的影响。为了实现这一目标,首先应该要了解企业数据中心出现故障的类型以及该类型故障产生的影响。影响数据中心的故障主要分为如下几类: 硬件故障 软件故障 链路故障 电源/环境故障 资源利用问题 网络设计问题 本文针对网络的高可用设计做详细的阐述。 高可用数据中心网络设计思路

数据中心的故障类型众多,但故障所导致的结果却大同小异。即数据中心中的设备、链路或server发生故障,无法对外提供正常服务。缓解这些问题最简单的方式就是冗余设计,能够经过对设备、链路、Server提供备份,从而将故障对用户业务的影响降低到最小。 可是,一味的增加冗余设计是否就能够达到缓解故障影响的目的?有人可能会将网络可用性与冗余性等同起来。事实上,冗余性只是整个可用性架构中的一个方面。一味的强调冗余性有可能会降低可用性,减小冗余所带来的优点,因为冗余性在带来好处的同时也会带来一些如下缺点: 网络复杂度增加 网络支撑负担加重 配置和管理难度增加 因此,数据中心的高可用设计是一个综合的概念。在选用高可靠设备组件、提高网络的冗余性的同时,还需要加强网络构架及协议部署的优化,从而实现真正的高可用。设计一个高可用的数据中心网络,可参考类似OSI七层模型,在各个层面保证高可用,最终实现数据中心基础网络系统的高可用,如图1所示。

智慧政务云数据中心总体架构设计

目录 第一章、项目总体设计 (3) 1.1、项目设计原则 (3) 1.1.1、统一建设 (3) 1.1.2、相对独立 (3) 1.1.3、共建共享 (3) 1.1.4、安全可靠 (3) 1.2、建设思路 (4) 1.2.1、需求驱动 (4) 1.2.2、标准先行 (4) 1.2.3、围绕数据 (4) 1.2.4、逐步扩展 (4) 1.3、数据中心总体结构设计 (5) 1.3.1、总体逻辑体系结构 (8) 1.3.1.1、信息资源体系 (8) 1.3.1.2、支撑体系 (9) 1.3.1.3、标准规范体系 (9) 1.3.1.4、运行管理体系 (10) 1.3.1.5、安全保障体系 (10) 1.3.2、总体实施结构设计 (10) 1.3.2.1、数据中心交换共享平台及信息资源 (11) 1.3.2.2、数据接口系统区 (12) 1.3.2.3、各部门系统 (12) 1.3.2.4、综合应用 (12) 1.3.3、总体物理体系结构 (12)

第一章、项目总体设计 1.1、项目设计原则 1.1.1、统一建设 数据中心必须统一规范建设。通过制定统一的数据交换与共享标准,建设统一的数据共享与交换平台和统一的前置机接口系统,可以避免重复投资,降低接口的复杂性,有效实现数据中心与业务部门以及业务部门之间的数据共享与数据交换,消除社会保障系统范围内的“信息孤岛”,实现数据资源的互联互通。 1.1.2、相对独立 根据数据中心的功能定位,数据中心的建设和运作必须保持业务系统的相对独立性。为此采用松散耦合方式,通过在业务部门统一配置接口系统实现数据资源整合。 1.1.3、共建共享 一方面建设数据中心的目的是为了实现业务部门之间的数据共享。 另一方面,数据中心的数据来源于各个业务部门,因此数据中心的建设必须依靠各业务部门的积极参与和配合。 1.1.4、安全可靠 由于社会保障数据与广大社会保障对象的切身利益密切相关,所以数据中心的安全是非常重要的。因此,必须要做好系统的安全设计,防范各种安全风险,确保数据中心能够安全可靠的运行。同时数据中心必须采用成熟的技术和体系结构,采用高质量的产品,并且要具有一定的容灾功能。

数据中心架构建设计方案建议书 1、数据中心网络功能区分区说明 功能区说明 图1:数据中心网络拓扑图 数据中心网络通过防火墙和交换机等网络安全设备分隔为个功能区:互联网区、应用服务器区、核心数据区、存储数据区、管理区和测试区。可通过在防火墙上设置策略来灵活控制各功能区之间的访问。各功能区拓扑结构应保持基本一致,并可根据需要新增功能区。 在安全级别的设定上,互联网区最低,应用区次之,测试区等,核心数据区和存储数据区最高。 数据中心网络采用冗余设计,实现网络设备、线路的冗余备份以保证较高的可靠性。 互联网区网络 外联区位于第一道防火墙之外,是数据中心网络的Internet接口,提供与Internet高速、可靠的连接,保证客户通过Internet访问支付中心。 根据中国南电信、北联通的网络分割现状,数据中心同时申请中国电信、中国联通各1条Internet线路。实现自动为来访用户选择最优的网络线路,保证优质的网络访问服务。当1条线路出现故障时,所有访问自动切换到另1条线路,即实现线路的冗余备份。

但随着移动互联网的迅猛发展,将来一定会有中国移动接入的需求,互联区网络为未来增加中国移动(铁通)链路接入提供了硬件准备,无需增加硬件便可以接入更多互联网接入链路。 外联区网络设备主要有:2台高性能链路负载均衡设备F5 LC1600,此交换机不断能够支持链路负载,通过DNS智能选择最佳线路给接入用户,同时确保其中一条链路发生故障后,另外一条链路能够迅速接管。互联网区使用交换机可以利用现有二层交换机,也可以通过VLAN方式从核心交换机上借用端口。 交换机具有端口镜像功能,并且每台交换机至少保留4个未使用端口,以便未来网络入侵检测器、网络流量分析仪等设备等接入。 建议未来在此处部署应用防火墙产品,以防止黑客在应用层上对应用系统的攻击。 应用服务器区网络 应用服务器区位于防火墙内,主要用于放置WEB服务器、应用服务器等。所有应用服务器和web服务器可以通过F5 BigIP1600实现服务器负载均衡。 外网防火墙均应采用千兆高性能防火墙。防火墙采用模块式设计,具有端口扩展能力,以满足未来扩展功能区的需要。 在此区部署服务器负载均衡交换机,实现服务器的负载均衡。也可以采用F5虚拟化版本,即无需硬件,只需要使用软件就可以象一台虚拟服务器一样,运行在vmware ESXi上。 数据库区

省县级国土资源局 数据中心与网络建设方案 省国土资源厅信息化工作办公室 二○○八年七月

目录 1. 前言 2. 目标任务 2.1 基本目标 2.2 配置要求 3. 建设依据 4. 建设容 5. 综合布线 5.1 位置选择 5.2 信息点和交换机 5.3 布线设计 5.4 主机房 6. 网络系统 6.1 总体结构 6.2 网络结构 6.3 网络核心层 6.4 网络接入层 6.5服务器区(数据中心) 7.安全系统 7.1安全配置 7.2安全管理 8. 计算机机房 8.1机房装饰设计 8.2 供、配电系统设计 8.3防雷系统设计 9. 经费概算

1、前言 数据中心和网络系统是国土资源电子政务运行的基础,是各级国土资源信息远程交换与共享的基础平台。全省国土资源工作会议上省厅明确要求今年底要实现省、市、县三级联网。国土资源部在2008年6月召开的国土资源业务网建设研讨会上,也提出了2008年年底实现我国中东部地区联网到县的基本要求。 2、目标任务 2.1基本目标 根据国土资源部和厅党组的要求,建设好县级国土资源数据中心和网络系统,在2008年底前实现国家、省、市、县四级联网,基本形成全省国土资源信息交换体系,为全省电子政务的运行提供基础保障。 2.2配置要求 方案一:基本配置,主要配置以下容: (1)至少保证1套与互联网物理隔离的网,1台路由器与市局联网; (2)至少配置3台网服务器,其中数据库服务器配置RAID和2T以上存储空间; (3)1台物理隔离网闸保证联网安全,1套网络版杀毒软件保证终端桌面安全; (4)具有基本防尘、防潮和控温的简易机房,1组机柜存放设备,有简单的防雷措施;

目录 第1章总述 (4) 1.1XXX公司数据中心网络建设需求 (4) 1.1.1 传统架构存在的问题 (4) 1.1.2 XXX公司数据中心目标架构 (5) 1.2XXX公司数据中心设计目标 (6) 1.3XXX公司数据中心技术需求 (7) 1.3.1 整合能力 (7) 1.3.2 虚拟化能力 (7) 1.3.3 自动化能力 (8) 1.3.4 绿色数据中心要求 (8) 第2章XXX公司数据中心技术实现 (9) 2.1整合能力 (9) 2.1.1 一体化交换技术 (9) 2.1.2 无丢弃以太网技术 (10) 2.1.3 性能支撑能力 (11) 2.1.4 智能服务的整合能力 (11) 2.2虚拟化能力 (12) 2.2.1 虚拟交换技术 (12) 2.2.2 网络服务虚拟化 (14) 2.2.3 服务器虚拟化 (14) 2.3自动化 (15) 2.4绿色数据中心 (16) 第3章XXX公司数据中心网络设计 (17) 3.1总体网络结构 (17) 3.1.1 层次化结构的优势 (17) 3.1.2 标准的网络分层结构 (17) 3.1.3 XXX公司的网络结构 (18) 3.2全网核心层设计 (19) 3.3数据中心分布层设计 (20) 3.3.1 数据中心分布层虚拟交换机 (20) 3.3.2 数据中心分布层智能服务机箱 (21) 3.4数据中心接入层设计 (22) 3.5数据中心地址路由设计 (25) 3.5.1 核心层 (25) 3.5.2 分布汇聚层和接入层 (25) 3.5.3 VLAN/VSAN和地址规划 (26) 第4章应用服务控制与负载均衡设计 (27) 4.1功能介绍 (27) 4.1.1 基本功能 (27)

避免数据中心和网络机房基础设施因过度规划造成的资金浪费

典型数据中心和网络机房基础设施最大的、可以避免的成本就是过度规划设计成本。数据中心或 网络机房中的物理和供电基础设施利用率通常在50%-60%左右。未被利用的容量就是一种原本可以避免的投资成本,这还代表着可以避免的维护和能源成本。 本文分为三个部分。首先,介绍与过度规划设计有关的情况和统计数据。接下来,讨论发生这种情况的原因。最后,介绍避免这些成本的新的架构和实现方法。 任何从事信息技术和基础设施产业的人都曾见过未被利用的数据中心空间、功率容量以及数据中心中其他未加利用的基础设施。为了对这种现象进行量化,对讨论中用到的术语进行定义是很重要的。 表1中定义了本文中有关过度规划设计的术语: 建模假设 为了收集并分析过度规划设计的相关数据,施耐德电气对用户进行了调查,并开发了一个简化模型来描述数据中心基础设施容量规划。该模型假设: ?数据中心的设计寿命为 10 年; ?数据中心规划有最终的设计容量要求和估计启动IT 负载要求; ?在数据中心典型生命周期过程中,预期负载从预期的启动负载开始呈线性增长,在预期生命周期一半的时候,达到预期最终容量。 由以上定义的模型得出下面图 1 显示的规划模型。我们假定,它是具有代表性的“一步到位”模式的系统规划模型。 简介有关过度规划设计的情况和统计数据表1 过度规划的相关定义

上图显示了一个典型的规划周期。在传统的设计方案中,供电和冷却设备的安装容量与设计容量相等。换句话说,系统从一开始就完全建成。根据计划,数据中心或网络机房的预期负载将从30% 开始,逐步增加到最终预期负载值。但是,实际启动负载通常小于预期启动负载,并且逐步增长到最终实际负载;最终实际负载有可能大大小于安装容量(注意:由于冗余或用户希望的额定值降低余量,实际安装设备的额定功率容量会大于计划安装容量)。 第143号白皮书《数据中心项目:成长模型》详细讨论了数据中心的规划以及制定一个有效的成长计划战略的关键要素。 实际安装数据收集 为了了解实际安装的情况,施耐德电气从许多客户那里收集了大量数据。这些数据是通过实际安装设备调查和客户访谈获得的。结果发现,预期启动负载通常只有最终设计容量的 30%,预期最终负载只有预期设计容量的80%-90%(留有安全余量)。进一步发现,实际启动负载通常只有最终设计负载的20%,而且实际最终负载通常为设计容量的 60% 左右。图 1 汇总了这些数据。根据设计值,通常的数据中心最终的容量设计比实际需要大 1.5 倍。在刚刚安装或调试过程中,超大规模设计甚至更加显著,通常在 5 倍左右。 与过度规划设计相关的额外成本 与过度规划设计相关的生命周期成本可以分为两个部分:投资成本和运营成本。 图 1 阴影部分指出了与投资相关的额外成本。阴影部分代表平均安装设备中未利用的系统设计容量的部分。额外容量可直接导致额外的投资成本。额外投资成本包括额外供电设备和冷却设备的成本,以及包括布线和管路系统的设计开销和安装成本。 对于一个典型的 100 kW 数据中心,供电和冷却系统有550万人民币(55元人民币/W )左右的资本成本。分析表明,这个投资的 40% 左右被浪费掉了,相当于 220万人民币。在使用早期,这个浪费甚至更大。算进资金周转的时间成本之后,由于过度规划设计导致的损失几乎等于数据中心50%的投资成本。也就是说,单单原始资本的利息几乎就能够满足实际资本一般的需求。 与过度规划设计有关的额外生命周期成本还包括设施运行的开支。这些成本包括维护合同、消耗品和电力。如果设备按制造商的说明进行维护,年维护费用一般是系统成本(投资成本)的10%左右,因此,数据中心或网络机房的生命周期过程中的维护成本几乎等于投资成本。由于过度规划设计会产生未充分利用的设备,而且这些设备必须加以维护,所以会浪费很大一部分的维护成本。以 100 kW 数据中心为例,系统生命周期过程中浪费的成本约为 950万人民币。 0% 20% 40% 60%80%100%120% 012345678910 容量百分比数据中心运行年份 图1 数据中心生命周期过程中的设计容量和预期负载要 求

云数据中心基础环境详细设计方案

目录 第一章综合布线系统 (11) 1.1 项目需求 (11) 1.2 综合布线系统概述 (11) 1.2.1 综合布线系统发展过程 (11) 1.2.2 综合布线系统的特点 (12) 1.2.3 综合布线系统的结构 (13) 1.3 综合布线系统产品 (14) 1.3.1 选择布线产品的参考因素 (14) 1.3.2 选型标准 (15) 1.3.3 综合布线产品的经济分析 (15) 1.3.4 综合布线产品的选择 (15) 1.3.5 综合布线系统特点 (16) 1.3.6 主要产品及特点 (17) 1.4 综合布线系统设计 (23) 1.4.1 设计原则 (23) 1.4.2 设计标准 (24) 1.4.3 设计任务 (25) 1.4.5 设计目标 (26) 1.4.6 设计要领 (26) 1.4.7 设计内容 (27) 1.5 工作区子系统设计方案 (34) 1.5.1 系统介绍 (34) 1.5.2 系统设计 (35) 1.5.3 主要使用产品 (39) 1.6 水平区子系统设计方案 (40) 1.6.1 系统介绍 (40) 1.6.2 系统设计 (41) 1.6.3 主要使用产品 (46) 1.7 管理子系统设计方案 (46) 1.7.1 系统介绍 (46) 1.7.2 系统设计 (47) 1.7.3 主要使用产品 (51) 1.8 垂直干线子系统设计方案 (52)

1.8.1 系统介绍 (52) 1.8.2 系统设计 (53) 1.8.3 主要使用产品 (56) 1.9 设备室子系统设计方案 (57) 1.9.1 系统介绍 (57) 1.9.2 系统设计 (57) 1.10 综合布线系统防护设计方案 (59) 1.10.1 系统介绍 (59) 1.10.2 系统设计 (60) 1.10.3 主要使用产品 (63) 第二章强电布线系统 (64) 2.1 概述 (64) 2.2 设计原则 (64) 2.3 设计依据 (65) 2.4 需求分析 (66) 2.5 系统设计 (67) 2.6 施工安装 (69) 2.6.1 桥架施工 (69) 2.6.2 管路施工 (69) 2.6.3 电缆敷设及安装 (70) 第三章配电系统 (71) 3.1 概述 (71) 3.2 用户需求 (72) 3.3 系统设计 (72) 3.3.1 UPS输入配电柜设计 (73) 3.3.2 UPS输出配电柜设计 (73) 3.3.3 UPS维修旁路配电柜设计 (74) 3.3.4 精密空调动力配电柜设计 (74) 3.3.5 动力配电柜设计 (75) 3.3.6 机房强电列头配电柜设计 (76) 3.4 施工安装 (83) 3.4.1 桥架管线施工 (83) 3.4.2 配电柜安装 (83) 第四章精密空调系统 (85) 4.1 项目概述 (85) 4.2 设计原则 (86)

数据中心网络建设方案

目录 第一章数据中心现状分析 (4) 第二章数据中心网络技术分析 (4) 2.1 路由与交换 (4) 2.2 EOR 与TOR (5) 2.3网络虚拟化 (5) 2.3.1 网络多虚一技术 (5) 2.3.2网络一虚多技术 (7) 2.4 VM互访技术(VEPA) (7) 2.5 虚拟机迁移网络技术 (11) 第三章方案设计 (13) 3.1网络总体规划 (13) 3.2省级数据中心网络设计 (15) 3.3市级数据中心网络设计 (16) 3.4区县级数据中心网络设计 (17) 3.5省、市、区/县数据中心互联设计 (18) 3.5.1省、市数据中心互联 (18) 3.5.2市、区/县数据中心互联 (19) 3.5.3数据中心安全解决方案 (19) 第四章方案的新技术特点 (21) 4.1量身定制的数据中心网络平台 (21) 4.1.1最先进的万兆以太网技术 (21) 4.1.2硬件全线速处理技术 (22) 4.1.3 Extreme Direct Attach技术 (24) 4.1.5 帮助虚机无缝迁移的XNV技术 (29) 4.1.5环保节能的网络建设 (33) 4.2 最稳定可靠的网络平台 (34) 4.2.1 独有的模块化操作系统设计 (34) 4.2.2超强的QOS服务质量保证 (35) 4.3先进的网络安全设计 (37) 4.3.1设备安全特性 (38) 4.3.2用户的安全接入 (39) 4.3.3智能化的安全防御措施 (40) 4.3.4常用安全策略建议 (41) 附录方案产品资料 (45) 1.核心交换机BD 8800 (45) 2.SummitX670系列产品 (49) 3.三层千兆交换机Summit X460 (61) 4.核心路由器MP7500 (69) 5.汇聚路由器MP7200 (75) 6.接入路由器MP3840 (81)

云计算下的数据中心架构 来源:机房360 作者:程应军陈鹰更新时间:2011-12-26 10:13:15 摘要:目前最引人关注的的IT 概念非“云计算”莫属,云计算已经成为当今IT 界乃至全球商界最为津津乐道的一个新概念。云计算是指利用大规模的数据中心或超级计算机集群,通过互联网将计算资源免费或按需租用方式提供给使用者。 云计算的一个重要应用在于由第三方机构提供云计算数据中心,并为大量的中小企业提供远程共享式的云计算应用服务。使得这些企业不需要建设自己的数据中心就可以使用所需的计算资源,实现成本最优化、资源共享最大化。 云计算,应当高度贴合网络未来更高层次的发展趋势,着力于提高网络数据处理和存储能力,致力于低碳高效的利用基础资源。具体而言,应着重从高端服务器、高密度低成本服务器、海量存储设备和高性能计算设备等基础设施领域提高云计算数据中心的数据处理能力。云计算要求基础设施具有良好的弹性、扩展性、自动化、数据移动、多租户、空间效率和对虚拟化的支持。那么,云计算环境下的数据中心基础设施各部分的架构应该是什么样的 呢? 1、云计算数据中心总体架构 云计算架构分为服务和管理两大部分。在服务方面,主要以提供用户基于云的各种服务为主,共包含3个层次:基础设施即服务IaaS、平台即服务PaaS、软件即服务SaaS。在管理方面,主要以云的管理层为主,它的功能是确保整个云计算中心能够安全、稳定地运行,并且能够被有效管理。其总体架构如下图。

2、云计算机房架构 根据长城电子公司多年的经验,为满足云计算服务弹性的需要,云计算机房采用标准化、模块化的机房设计架构。模块化机房包括集装箱模块化机房和楼宇模块化机房。集装箱模块化机房在室外无机房场景下应用,减轻了建设方在机房选址方面的压力,帮助建设方将原来半年的建设周期缩短到两个月,而能耗仅为传统机房的50%,可适应沙漠炎热干旱地区和极地严寒地区的极端恶劣环境。楼宇模块化机房采用冷热风道隔离、精确送风、室外冷源等领先制冷技术,可适用于大中型数据中心的积木化建设和扩展。 3、云计算网络系统架构 网络系统总体结构规划应坚持区域化、层次化、模块化的设计理念,使网络层次更加清楚、功能更加明确。数据中心网络根据业务性质或网络设备的作用进行区域划分,可从以下几方面的内容进行规划。 1)按照传送数据业务性质和面向用户的不同,网络系统可以划分为内部核心网、远程业务专网、公众服务网等区域。 2)按照网络结构中设备作用的不同,网络系统可以划分为核心层、汇聚层、接入层。 3)从网络服务的数据应用业务的独立性、各业务的互访关系及业务的安全隔离需求综合考虑,网络系统在逻辑上可以划分为存储区、应用业务区、前置区、系统管理区、托管区、

软件学报 ISSN 1000-9825, CODEN RUXUEW Journal of Software,2013,24(2):295?316 [doi: 10.3724/SP.J.1001.2013.04336] ?中国科学院软件研究所版权所有 .

E-mail: jos@https://www.doczj.com/doc/575776497.html, https://www.doczj.com/doc/575776497.html, Tel/Fax: +86-10-62562563

数据中心网络的体系结构

?

魏祥麟 1,2, 陈 鸣 2, 范建华 1, 张国敏 2, 卢紫毅 1

1 2

(南京电讯技术研究所,江苏 南京

210007) 210007)

(解放军理工大学 指挥信息系统学院,江苏 南京

通讯作者 : 魏祥麟 , E-mail: wei_xianglin@https://www.doczj.com/doc/575776497.html,

摘

要:

在新的应用模式下,传统层次结构数据中心网络在规模、带宽、扩展性和成本方面存在诸多不足.为了适

应新型应用的需求,数据中心网络需要在低成本的前提下,满足高扩展性、低配置开销、健壮性和节能的要求.首先, 概述了传统数据中心网络体系结构及其不足,并指出了新的需求;其次,将现有方案划分为两类,即以网络为中心和 以服务器为中心的方案;然后,对两类方案中的代表性结构进行了详细的综述和对比分析;最后指出了数据中心网络 未来的发展方向. 关键词: 数据中心;网络;体系结构;拓扑;路由 中图法分类号: TP393 文献标识码: A

中文引用格式 : 魏祥麟 ,陈鸣 ,范建华 ,张国敏 ,卢紫毅 .数据中心网络的体系结构 .软件学报 ,2013,24(2):295?316. http://www.jos. https://www.doczj.com/doc/575776497.html,/1000-9825/4336.htm 英文引用格式 : Wei XL, Chen M, Fan JH, Zhang GM, Lu ZY. Architecture of the data center network. Ruanjian Xuebao/Journal of Software, 2013,24(2):295?316 (in Chinese). https://www.doczj.com/doc/575776497.html,/1000-9825/4336.htm

Architecture of the Data Center Network

WEI Xiang-Lin1,2,

1 2

CHEN Ming2,

FAN Jian-Hua1,

ZHANG Guo-Min2,

LU Zi-Yi1

(Nanjing Telecommunication Technology Research Institute, Nanjing 210007, China) (College of Command Information Systems, PLA University of Science and Technology, Nanjing 210007, China)

Corresponding author: WEI Xiang-Lin, E-mail: wei_xianglin@https://www.doczj.com/doc/575776497.html, Abstract: Under the new application mode, the traditional hierarchy data centers face several limitations in size, bandwidth, scalability,

and cost. In order to meet the needs of new applications, data center network should fulfill the requirements with low-cost, such as high scalability, low configuration overhead, robustness and energy-saving. First, the shortcomings of the traditional data center network architecture are summarized, and new requirements are pointed out. Secondly, the existing proposals are divided into two categories, i.e. server-centric and network-centric. Then, several representative architectures of these two categories are overviewed and compared in detail. Finally, the future directions of data center network are discussed. Key words: data center; network; architecture; topology; route

信息服务的集约化、社会化和专业化发展使得因特网上的应用、计算和存储资源向数据中心迁移.商业化 的发展促使了承载上万甚至超过 10 万台服务器的大型数据中心的出现.截至 2006 年,Google 在其 30 个数据中 心拥有超过 45 万台服务器,微软和雅虎在其数据中心的服务器数量也达到数万台[1].随着规模的扩大,数据中心 不仅承载了传统的客户机/服务器应用,而且承载了包括 GFS 和 MapReduce 在内的新应用[2].这种趋势一方面突

?

基金项目 : 国家自然科学基金 (61070173, 61103225, 61201216); 国家重点基础研究发展计划 (973)(2012CB315806); 中国博士 收稿时间 : 2012-08-09; 定稿时间 : 2012-10-19; jos 在线出版时间 : 2012-11-23 CNKI 网络优先出版 : 2012-11-23 12:17, https://www.doczj.com/doc/575776497.html,/kcms/detail/11.2560.TP.20121123.1217.006.htm

后科学基金 (201150M1512); 江苏省自然科学基金 (BK2010133); 国防科技重点实验室基金 (9140C020302110C0206)

小型数据中心网络及机房建设方案

正文目录 第一章网络建设方案 5 1. 建设原则 5 2. 建设目标 6 3. 总体架构及建设内容7 3.1 总体架构方案7 3.2 建设方案8 3.2.1 小型数据中心机房网络建设方案8 3.3 网络可靠性设计10 3.3.1 设备级的可靠性10 3.3.2 链路级的可靠性11 3.3.3 网络级的可靠性11 3.3.4 业务可靠性12 3.4 网络安全建设13 3. 4.1 总体安全策略13 3.4.2 区域边界安全要求16 3.4.3 安全管理中心要求18 3.4.4 网络与基础设施安全要求19 3.4.5 网络安全部署23 3.4. 5.1防火墙23 3.4.5.2入侵防御检测24 3.4.5.3 上网行为管理24 3.4.6 交换及WLAN部署24 3.4. 6.1 核心及汇聚交换机25 3.4.6.2 接入交换机25 3.4.6.3无线AP 25 3.4.6.5 无线控制器25 第二章机房建设方案27 1. 设计依据27

2. 建设原则28 3. 建设目标30 4. 建设内容31 5. 建设方案32 5.1 机房装饰装修32 5.2 机房配电系统建设35 5.2.1 机房配电系统需求分析35 5.2.2 机房配电系统设计36 5.2.3 UPS供电系统要求39 5.3 机房防雷接地建设方案41 5.3.1 雷电的表现形式41 5.3.2 雷电干扰的入侵路径41 5.3.3 机房总电源防雷(第II级)42 5.3.4 UPS前端电源防雷(第III级)42 5.3.5 重要电子设备电源防雷(精细保护)43 5.3.6 机房等电位实施原则43 5.3.7 机房接地系统实施43 5.4 机房空调及新风系统建设方案44 5.4.1 空调系统说明44 5.4.2 机房环境特点45 5.4.3 机房空调的要求45 5.4.4 空调的上下水实施47 5.4.5 机房新风系统建设48 5.5 机房消防系统建设方案49 5.6 机房动力环境监控系统建设方案50 5. 6.1 动力环境监控系统需求分析50 5.6.2 配电监测系统51 5.6.3 UPS监控51 5.6.4 空调监控52 5.6.5 漏水监测52

技术与应用 echnology & Application T 53 2009年3 月 ■文/中国建设银行信息技术管理部 戴春辉 窦 彤 数据中心网络设计与实现 数 据集中后,所有银行业务和网点都依赖网络来支持其对数据中心中主机的访问。此外,未来的新型应用, 如网上培训、IP 电话、可视电话等应用也对网络提出高带宽、高服务质量以及支持多点广播等要求。因此,数据中心的网络建设必须能够最大化满足上述要求,适应未来新业务和技术的发展。 一、数据中心网络设计原则 网络的可靠性。银行业务的特点决定了其网络必须有极高的可用性,能最大限度地支持各业务系统正常运行。在网络设计上,合理组织网络架构,做到设备冗余、链路冗余,保证网络具有快速故障自愈能力,实现网络通讯不中断。 网络具有良好的可用性、灵活性。支持国际上各种通用的网络协议和标准,支持大型的动态路由协议及策略路由功能,保证与其他网络(如公共数据网、金融网络等)之间的平滑连接。 网络的可扩展性。根据未来业务的增长和变化,在不变动现有网络架构的前提下,可以平滑地扩展和升级。 网络安全性。制订统一的网络安全策略,整体考虑网络平台的安全性。 网络可集中管理。对网络实行集中监测、分权管理,构建网络管理平台,提供故障自动报警,具有对设备、端口等的管理和流量统计分析功能。 保证网络服务质量。保证对统一的网络带宽资源进行合理调配,当网络拥塞发生时,保障银行关键业务和用户数据的传输。提供对数据传输的服务质量(QoS)和优先级控制等,以保证骨干网上各类业务的QoS。 二、数据中心网络实现 1.网络技术 数据中心网络设计实现的技术基础如下。(1)路由交换技术 目前,在银行的网络设计中,绝大部分网络通信都是基于TCP/IP 协议及相关技术的。路由交换技术是构建IP 网络的基础技术,是网络互联的基础。在数据中心网络中,大面积使用高性能、高可靠的三层交换机,用以构建多个不同的功能分区。分区间相互隔离,通过1G/10G 接口连接高速的核心交换区。 网络互联路由协议主要有OSPF、RIPv2和BGP。在数据中心局域网中主要使用OSPF 路由协议,以达到快速收敛的目的;而在边界或与分支机构广域互联,通常使用BGP 路由协议,以实现对网络的有效管理。 (2)负载均衡技术 负载均衡建立在现有网络结构之上,提供了一种廉价、有效、透明的方法,扩展网络设备和服务器的带宽,增加吞吐量,加强网络数据处理能力,提高网络的灵活性和可用性。负载均衡技术主要有软/硬件负载均衡,本地/全局负载均衡。在数据中心主要使用硬件负载均衡解决方案。 (3)防火墙技术 当前银行网络主要使用状态检测型防火墙,集成了包过滤防火墙、电路层防火墙和应用防火墙三种技术,只有符合安全规则的网络连接和访问才可以通过防火墙,有效隔离各个安全区域,保障核心数据的安全性。 (4)入侵检测技术 入侵检测技术(IDS)从计算机系统或网络中收集、分析信息,检测任何企图破坏计算机资源完整性、机密性和

数据中心网络架构 7.6.2.3.1、网络核心 网络核心由2台双引擎万兆交换机构成,通过千兆实现各个功能分区的接入,同时交换机之间采用双千兆捆绑的方式实现高速互联。 为了保证各个功能分区的高可靠性,与各个功能分区的汇聚交换机或接入交换机采用双链路冗余连接。 网络为二层架构,要采用千兆接入层交换通过千兆线路上行到两台核心交换层交换机。服务器接入采用双网卡千兆上行,接入交换机采用万兆上行到核心交换机。 应急信息系统对网络安全、信息安全有着很高的要求,因此通过合理的防火墙、IPS和ASE部署,可以使网络对非法请求、异常攻击和病毒具有非常好的防御,同时可以对各种敏感和非法信息、网址和电子邮件进行有效的过滤。 7.6.2.3.2、全交换网络 建议采用全交换网络来保证网络的高性能。应急指挥中心服务器群规模不大,网络结构采用两层交换机即可。 在核心汇聚层采用高性能核心交换机,未采用路由器,主要的考虑基于以下两点: (1)交换机性能高,接口密度高,适合在数据中心的核心位置部署;相比而言路由器的性能和接口密度则远低于交换机; (2)交换机设备工作在二层,业务扩展灵活方便;

7.6.2.3.3、服务器接入的二层模式 在工作模式上,核心汇聚交换机工作在路由模式(三层),服务器接入层交换机工作在交换(二层)模式。 三层接入的好处在于配置管理相对简单,上行汇聚设备的报文比较“纯净”,都是单播报文。而三层接入的问题主要在服务器扩展性、灵活性以及L4/L7设备的部署上。 对于应急系统来说,服务器的扩展能力是一个非常重要的问题,在实际的部署中,经常会要求服务器之间做二层邻接,如果采用二层接入,可以很方便的实现VLAN的部署。 三层接入带来的另一个问题是L4/L7设备(如服务器Load-Balacne)的部署。Load-Balance通常部署在汇聚层,可以实现对服务器访问流量的分担,以及服务器健康状态的检查,对于某些负载均衡算法或服务器健康检查算法来说,必须要求服务器和Load-balance设备二层邻接,因此数据中心不建议采用三层接入。 对于二层接入方式,可以通过MSTP或SmartLink技术解决链路冗余问题。在MSTP中,端口的阻塞是逻辑上的,只对某些STP实例进行阻塞,一个端口可能对一个STP实例阻塞,但对另一个STP实例是可以转发的。合理的使用MSTP,可以做到链路的负载分担。而且,因为映射到一个MSTP实例的VLAN 可以灵活控制,并且引入了域的概念,使得MSTP在部署时有很好的扩展性。SmartLink提供了一种二层链路冗余技术,可以部分替代STP的功能,并且保证200毫秒的链路切换时间,可应用在HA要求较高的环境。 因此建议在数据中心的服务器区采用二层接入方式。 根据应急指挥应急指挥系统的需求,数据中心由以下几个功能区组成: (1)核心网络区: 由高速网络交换机组成,提供核心交换能力,同时部署安全和应用优化设备,保证数据安全和系统性能。 (2)核心数据库区: 由运行HA 系统的高效UNIX 主机组成,提供数据高速访问能力(3)应用区: