CRISP-DM 1.0

数据挖掘方法论指南

Pete Chapman (NCR), Julian Clinton (SPSS), Randy Kerber (NCR), Thomas Khabaza (SPSS), Thomas Reinartz (DaimlerChrysler), Colin Shearer (SPSS) and Rüdiger Wirth (DaimlerChrysler)

该手册描述了CRISP-DM(跨行业数据挖掘标准流程)过程模型,包括CRISP-DM的方法论、相关模型、用户指南、报告介绍,以及一个含有其他相关信息的附录。

本手册和此处的信息均为CRISP-DM协会以下成员的专利:NCR Systems Engineering Copenhagen (USA and Denmark), DaimlerChrysler AG (Germany), SPSS Inc. (USA) and OHRA Verzekeringen en Bank Groep B.V (The Netherlands)。

著作权? 1999, 2000

本手册中所有商标和服务标记均为它们各自所有者的标记,并且为CRISP-DM协会的成员所公认。

前言

1996年下半年,数据挖掘市场尚处于萌芽状态,CRISP-DM率先由三家资深公司共同提出。DaimlerChrysler (即后来的Daimler-Benz) 在其商业运营中运用数据挖掘的经验颇为丰富,远远领先于其他大多数商业组织。SPSS(即后来的ISL)自1990年以来一直致力于提供基于数据挖掘的服务,并于1994年推出了第一个商业数据挖掘平台——Clementine。至于NCR,作为对其Teradata数据仓库客户增值目标的一部分,它已经建立了数据挖掘顾问和技术专家队伍以满足其客户的需要。

当时,数据挖掘所引起的市场关注开始表明其进入爆炸式增长和广泛应用的迹象。这既令人兴奋又使人害怕。随着我们在这条路上不断走下去,所有人都不断研究和发展数据挖掘方法。可是我们做的是否正确?是否每一个数据挖掘的新使用者都必须像我们当初一样经历反复试验和学习?此外,从供应商的角度来看,我们怎样向潜在客户证明数据挖掘技术已足够成熟到可以作为它们商业流程的一个关键部分?

在这种情况下,我们认为急需一个标准的流程模型——非私人所有并可以免费获取——向我们和所有的从业者很好的回答这些问题。

一年后我们组建了联盟,名字CRISP-DM取自CRoss-Industry Standard Process for Data Mining的缩写,由欧洲委员会提供资助,开始实施我们最初的想法。因为CRISP-DM的定位是面向行业、工具导向和面向应用的,所以我们明白必须“海纳百川,博采众家之长”,必须在一个尽可能宽的范围内吸引人们的兴趣(比如数据仓库制造商和管理咨询顾问)。于是我们决定成立CRISP-DM 专门兴趣小组(即大家所知道的“The SIG”)。我们邀请所有感兴趣的团体和个人到阿姆斯特丹参加为期一天的工作会议,讨论并正式成立SIG组织:我们观念共享,鼓励与会者畅所欲言,为发展CRISP-DM共商大计。

当天每个协会成员都心怀惴惴,会不会没有人对CRISP-DM有足够的兴趣?即使有,那他们是否认为实际上并未看到一种对标准化流程的迫切需求?或者我们的想法迄今为止与别人的步调不一致,任何标准化的念头只是不切实际的白日梦?

事实上,讨论的结果大大超出了我们的期望。下面三点最为突出:

当天的与会人数是我们原先期望的两倍

行业需要而且现在就需要一个标准化流程——大家压倒性的一致同意

每个出席者从他们的项目经验出发陈述了自己关于数据挖掘的看法,这使我们越来越清晰地看到:尽管表述上有些区别——主要是在阶段的划分和术语方面,但在如何看待数据挖掘流程上大家具有极大的相似之处。

在工作组结束的时候,我们充满了自信,受SIG的启发和批评,我们能够建成一个标准化流程模型,为数据挖掘事业作出贡献。

接下来的两年半里,我们努力工作来完善和提炼CRISP-DM。我们不断地在Mercedes-Benz、保险部门的伙伴及OHRA的实际大型数据挖掘项目中进行尝试。同时也运用商业数据挖掘工具来整合CRISP-DM。SIG证明了是无价的,其成员增长到200多,并且在伦敦、纽约和布鲁塞尔都拥有工作组。

到该项目的欧洲委员会支持基金部分结束时——1999年年中,我们提出了自己觉得质量优良的流程模型草案。熟悉这一草案的人将会发现,一年以来,尽管现在的CRISP-DM1.0更完整更好,但从根本上讲并没有什么本质不同。我们强烈地意识到:在整个项目中,流程模型仍然是一个持续进行的工作;CRISP-DM还只是在一系列有限的项目中得到证实。过去的一年里,DaimlerChrysler有机会把CRISP-DM运用于更为广阔的范围。SPSS和NCR的专业服务团体采纳了CRISP-DM,而且用之成功地完成了无数客户委托,包括许多工业和商业的问题。这段时间以来,我们看到协会外部的服务供应商也采用了CRISP-DM;分析家不断重复地提及CRISP-DM

为行业实际的标准;此外,客户也越来越意识到CRISP-DM的重要性(目前CRISP-DM经常在投林邀请书和RFP文件中提到)。我们相信我们的初衷得到了彻底的证实,未来的扩展和改善是人们所需求的、不可避免的,CRISP-DM Version 1.0在充分的充分地验证后出版和发行。

从技术的原则上看,CRISP-DM不是以理论、学术的方式建立,也不是几个行业领袖组成的精英委员会闭门造车的。过去这两种发展方法论的途径都已经被人们尝试过了,但是很少得到实用、成功并被广泛采纳的标准。CRISP-DM之所以成功,就正是因为它来源于实践,是实际数据挖掘项目的智慧和经验的结晶。从这个意义上讲,我们尤其需要感谢在整个项目中贡献了努力和想法的众多同仁。

CRISP-DM协会

2000年8月

目录

第一章简介 (7)

1 CRISP-DM 方法论 (7)

1.1 层次分类模型Hierarchical breakdown (7)

1.2 参考模型和用户指导 (8)

2 将通用模型映射为特定模型 (8)

2.1 数据挖掘文法 (8)

2.2 文法映射Mappings with contexts (9)

2.3 如何映射How to map? (9)

3 具体部分的描述Description of parts (9)

3.1 内容Contents (9)

3.2 目的Purpose (9)

第二章 CRISP-DM参考模型 (10)

1 商业理解 (13)

1.1 确定商业目标 Determine business objectives (13)

1.2 形式评估 Assess situation (14)

1.3 确定数据挖掘目标 Determine data mining goals (14)

1.4 制定项目计划Produce project plan (15)

2 数据理解 Data understanding (16)

2.1 收集原始数据 Collect initial data (16)

2.2 数据描述 Describe data (17)

2.3 数据探索 Explore data (17)

2.4 数据质量检验 Verify data quality (17)

3 数据准备 Data preparation (18)

3.1 数据选择 Select data (18)

3.2 数据清洗 Clean data (19)

3.3 数据构建 Construct data (19)

3.4 数据整合 Integrate data (19)

3.5 格式化数据Format data (20)

4 建立模型 Modeling (20)

4.1 选择建模技术 Select modeling technique (20)

4.2 产生检验设计Generate test design (21)

4.3 建立模型 Build model (21)

4.4 模型评估 Assess model (22)

5 模型评价 Evaluation (22)

5.1 结果评估 Evaluate results (22)

5.2 回顾过程 Review process (23)

5.3 确定下一步的工作内容Determine next steps (24)

6 模型发布 Deployment (24)

6.1 发布计划Plan deployment (24)

6.2 监测和维护计划Plan monitoring and maintenance (25)

6.3 生成最终报告Produce final report (25)

6.4 项目回顾 Review project (26)

第三章CRISP-DM用户指南 (26)

1 商业理解 (26)

1.1 确定商业目标Determine business objectives (26)

1.2 形式评估Assess situation (28)

1.3 确定数据挖掘目标(Determine data mining goals) (30)

1.4 制订项目计划(Produce project plan) (31)

2 数据理解(Data understanding) (32)

2.1 收集原始数据(Collect initial data) (32)

2.2 数据描述(Describe data) (33)

2.3 探索数据(Explore data) (33)

2.4 检验数据质量(Verify data quality) (34)

3 数据准备(Data preparation) (35)

3.1 选择数据(Select data) (35)

3.2 数据清洗(Clean data) (35)

3.3 数据构建(Construct data) (36)

3.4 整合数据(Integrate data) (37)

3.5 格式化数据(Format data) (37)

4 建立模型(Modeling) (38)

4.1 选择建模技术(Select modeling technique) (38)

4.2 产生试验设计(Generate test design) (39)

4.3 建立模型(Build model) (40)

4.4 评价模型(Assess model) (40)

5 模型评价(Evaluation) (41)

5.1 结果评价(Evaluate results) (41)

5.2 数据挖掘过程回顾(Review process) (42)

5.3 确定下一步的内容(Determine next steps) (43)

6 模型发布(Deployment) (43)

6.1 发布结果计划(Plan deployment) (43)

6.2 检测和维护计划(Plan monitoring and maintenance) (44)

6.3 生成最终的报告(Produce final report) (44)

6.4 项目回顾(Review project) (45)

第四章 CRISP-DM的输出结果 (45)

1 商业理解 (45)

2 数据理解 (46)

3 数据准备 (47)

4 建立模型 (47)

5 模型评价 (48)

6 模型发布 (49)

7 依赖关系的总结(Summary of dependencies) (50)

第五章附录 (52)

1 词汇解释/术语 (52)

2 数据挖掘问题类型 (52)

2.1 数据描述和摘要 (53)

2.2 细分 (53)

2.3 概念描述 (54)

2.4 分类 (54)

2.5 预测 (55)

2.6 依赖性分析(Dependency analysis) (55)

第一章简介

1 CRISP-DM 方法论

1.1 层次分类模型Hierarchical breakdown

CRISP-DM数据挖掘方法论是一种层次流程模型,包括四个水平(从一般到具体)的任务:阶段,通用任务,特定任务和流程实例(见图1)。

在一级水平上,数据挖掘过程是由一些阶段组成的;每个阶段包括多个二级通用任务。这种二级水平被称为通用的,因为它旨在足够广泛以覆盖所有可能的数据挖掘情形。通用任务旨在尽可能地完整和稳定。完整是指覆盖数据挖掘的整个过程和所有可能的数据挖掘应用。而稳定则是指对于不可预见的发展如新的建模技术产生,模型应该仍然有效。

第三级——特定任务水平,主要是描述通用任务中的行动如何在某种具体情况里实施。例如,在二级水平里会有一些称为清洁数据的通用任务。第三级水平便会描述这一任务怎样在不同的情况里区别开来,如清扫连续性和离散性数据或者问题的类型是聚类模型还是预测模型。

将阶段和任务描述成分散开的各个步骤按一个具体的顺序实现,这是一个理想的事件序列。事实上,许多任务能够按不同的顺序实施,有时返回到上一阶段或重复某些步骤经常是必须的。我们的流程模型没有试图在数据挖掘过程中捕捉所有可能的路线,因为这需要一个极度复杂的流程模型。

第四级——流程实例,是一个实际数据挖掘项目的行动、决策和结果的记录。一个流程实例是根据在较高级上定义的任务来组织的,但它描述的是在某个具体的项目中真实发生了什么,而非一般发生了什么。

图1 CRISP-DM方法论的四级层次分类

1.2 参考模型和用户指导

从水平上而言,CRISP-DM方法论在参考模型和用户指导之间是有所区别的。参考模型介绍了阶段、任务和它们的输出结果的一个快速总揽,并且描述了在一个数据挖掘项目中要做些什么。用户指导则是给出更为详细的细节,提示每一个阶段和在某个阶段中的每一个任务,并描写出怎样处理一个数据挖掘项目。

本书同时覆盖了参考模型和通用级的用户指导。

2 将通用模型映射为特定模型

2.1 数据挖掘文法

数据挖掘文法驱动着CRISP-DM中通用级和特殊级之间的映射。当前,我们在数据挖掘文法的四个不同维度中进行区别:

应用领域是数据挖掘项目发生的具体领域

数据挖掘问题类型描述了数据挖掘项目处理目标的具体种类

技术方面覆盖了数据挖掘中的具体问题,这些问题描述了不同常在其中发生的(技术)挑战

工具和技术维度指出了数据挖掘项目中运用的数据挖掘工具和技术

下面的表1总结了数据挖掘文法的这些维度,并展示了每个维度的具体例子。

表1 数据挖掘文法的维度和举例

数据挖掘文法

维度适用范围数据挖掘问题类型技术面工具和技术

实例响应建模描述及汇总缺失值Clementine

流失预测分割异常值Mineset

概念描述决策树

分类

预测

依赖性分析

一个具体的数据挖掘文法是这些维度中一个或多个的具体值。比如说,一个处理流失预测分类问题的数据挖掘项目组成一个具体的文法。不同文法维度的值固定的越多,数据挖掘文法就越具体。

2.2 文法映射Mappings with contexts

我们区别一下两种不同类型的CRISP-DM通用级与特定级映射:

当前映射:

如果我们仅仅应用通用流程模型来完成一个单一的数据挖掘项目,只是试图把通用任务和它们的描述映射到所要求的具体项目,此即为一次应用而进行的单次映射。

未来映射:

如果我们根据一个预先定义好的文法来系统地专门化通用流程模型(或者类似于系统分析、巩固单个项目经验而作的特定模型),那么我们就是按照特定CRISP-DM写下一个特定的流程模型。

2.3 如何映射How to map?

将通用流程模型映射到特殊化水平的基本策略对两种类型的映射都一样:

分析具体文法

删除不用于文法中的任何细节

增加明确的细节到文法中

根据文法的具体特征将通用内容专门化(或者示例)

为了清楚很可能重命名通用内容来为你的文法提供更加清楚的含义

3 具体部分的描述Description of parts

3.1 内容Contents

CRISP-DM流程模型在本文中分为五个不同部分:

第一部分是对CRISP-DM方法论的介绍,同时提供一些通用流程模型映射到特殊流程模型的常用指导方针

第二部分描述了CRISP-DM的参考模型以及其阶段、通用任务和输出结果

第三部分提出了CRISP-DM的用户指南,该指南已超出对阶段、通用任务和输出结果的纯粹描述,包含了对如何实施数据挖掘项目的更为详细的建议及检查清单

第四部分集中论述在一个项目之中和之后产生的报告,而且说明这些报告的要点。同时它还展示了输出结果和任务之间的交叉关联

最后,第五部分是附录,包括一个关于重要术语的术语表和对数据挖掘问题类型的描述3.2 目的Purpose

本书的使用者和读者需要注意以下用法说明:

如果你是第一次看CRISP-DM流程模型,请从第一部分——简介开始,这样便于理解CRISP-DM方法论和其所有概念,及不同概念之间如何互相关联。在更深一点的阅读中,你则可能会跳过简介,而且只在需要弄清楚的时候才返回到简介部分。

如果你需要快速接触到CRISP-DM流程模型的总论,请参见第二部分——CRISP-DM参考模型,这样你能迅速开始一个数据挖掘项目或者得到CRISP-DM用户指南的入门。

如果你在实施数据挖掘项目时需要详细的建议,请参考第三部分——CRISP-DM用户指南,这是本书中最有价值的部分。注:如果你还未看过简介或参考模型,请先返回从这两部分开始。

如果你处在数据挖掘的写报告阶段,请跳到第四部分。如果你更愿意在项目中产生你的陈述性描述,那么请根据需要查看第三和第四部分。

最后,附录与CRISP-DM和数据挖掘的其它背景信息一样有用。如果你还不是该领域的专家,请使用附录查看各种术语。

第二章 CRISP-DM参考模型

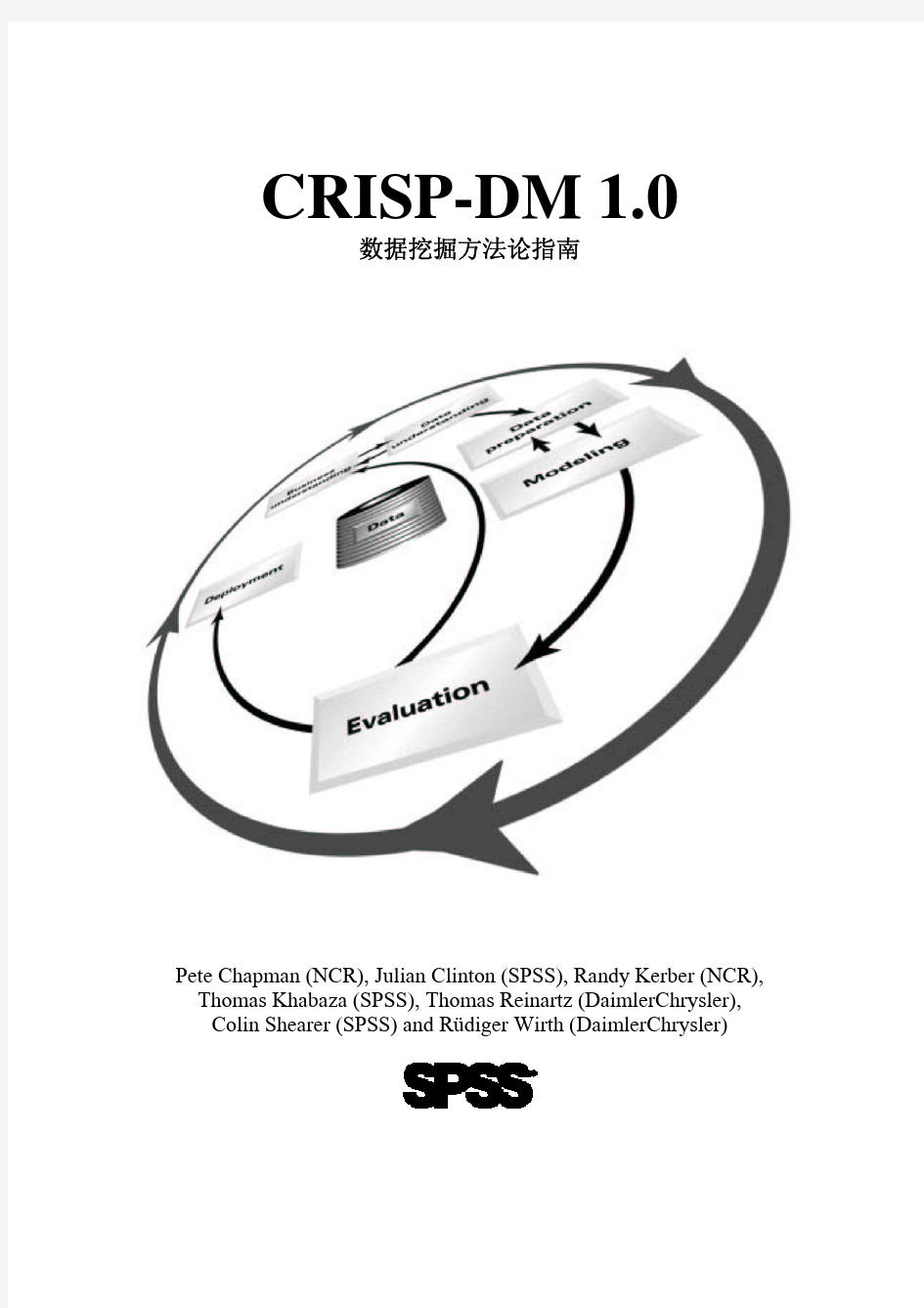

当前数据挖掘的流程模型提供了一个数据挖掘项目生命周期的大概描述。生命周期由项目的各阶段组成,这些阶段各自的任务和任务之间的关系。在这种描述水平上,我们不太可能指明所有关系。本质来说,关系会存在于任何两个数据挖掘任务之间,这取决于使用者的目标、背景和兴趣,更取决于数据。

图2 CRISP-DM参考模型的各个阶段

一个数据挖掘项目的生命周期包括六个阶段。图2显示了该流程的各个阶段。各个阶段的顺序不是僵硬不变的。有时需要在不同阶段之间向前和向后移动。这取决于每个阶段的结果和下一个阶段的具体任务。箭头指出了各个阶段间最为重要的和频繁的关联。

图2中最外面的循环表示数据挖掘本身的循环特征。数据挖掘并非是一旦得到一个解决方案就结束了。在流程及解决方案中得到的教训可能引发新的,常常是更为集中的商业问题。后来的数据挖掘过程将从前几次的经验中获益。

下面,我们简短地给出每个阶段的要点:

商业理解Business understanding

这一初始阶段集中在从商业角度理解项目的目标和要求,然后把理解转化为数据挖掘问题的定义和一个旨在实现目标的初步计划。

数据理解Data understanding

数据理解阶段开始于原始数据的收集,然后是熟悉数据,标明数据质量问题,探索对数据的初步理解,发觉有趣的子集以形成对隐藏信息的假设。

数据准备Data preparation

数据准备阶段包括所有从原始的未加工的数据构造最终数据集的活动(这些数据集指将要嵌入建模工具中的数据)。数据准备任务可能被实施多次,而且没有任何规定的顺序。这些任务

包括表格、记录和属性的选择以及按照建模工具要求,对数据的转换和清洗。

建模Modeling

在此阶段,主要是选择和应用各种建模技术,同时对它们的参数进行校准以达到最优值。通常对于同一个数据挖掘问题类型,会有多种模型技术。一些技术对数据格式有特殊的要求。因此,常常需要返回到数据准备阶段。

评估Evaluation

进入项目中的这个阶段时时,你已经建立了一个模型(或者多个),从数据分析的角度来看,该模型似乎有很高的质量。在模型最后发布前,有一点是很重要的——更为彻底地评估模型和检查建立模型的各个步骤,从而确保它真正地达到了商业目标。此阶段关键目的是决定是否存在一些重要地商业问题仍未得到充分地考虑。关于数据挖掘结果的使用决定应该在此阶段结束时确定下来。

发布Deployment

模型的创建通常并不是项目的结尾。即使建模的目的是增加对数据的了解,所获得的了解也需要进行组织并以一种客户能够使用的方式呈现出来。这常常包括在一个组织的决策过程中应用“现场”模型,如在网页的实时个人化中或营销数据的重复评分中。不过,根据需要,发布过程可以简单到产生一个报告,也可以复杂到在整个企业中执行一个可重复的数据挖掘过程。大部分情况下,是由客户来实施发布的,而非数据分析师。尽管如此,即使分析师并不执行发布,这对客户也是十分重要的——提前理解需要采取什么行动来实际利用产生的模型。

图3显示了伴随有一般任务(粗体)和输出结果(斜体)阶段的大致轮廓。在下面的各个部分里,我们将会更加详细地描述每个通用任务和它的输出结果。我们的注意力主要集中在任务和输出结果的概述上。

图3 CRISP-DM参考模型的通用任务(粗体)和输出结果(斜体)

1 商业理解

1.1 确定商业目标Determine business objectives

任务(Task)确定商业目标(Determine business objectives)

数据分析师的首要目标是从商业的角度来彻底了解客户真正想要完成什么。

通常客户会有诸多竞争目标和必须适当平衡的约束。分析师的目标就是在开

始时就揭示可能影响项目结果的重要因素。忽视这一步很可能造成的结果是

付出了许多努力,却得到了错误问题的正确答案。

输出结果(Outputs)背景(Background )

在项目开始时,记录关于机构商业情形的已知信息。

商业目标(Business objectives)

从商业的角度描述客户的主要目标。除了主要目标之外,通常还有其它客户

想要解决的相关商业问题。例如,主要目的可能是通过预测来留住倾向于转

向竞争对手的客户。相关商业问题是“一个银行客户使用的首要渠道(如:

ATM,访问分部,网络)怎样影响他们留下或者离开?”或者“是否更低的

ATM费用会明显减少高价值客户离开的数量?”

商业成功标准(Business success criteria)

从商业的观点来描述项目成功或者有用流失结果的标准。这可能是十分具体

的,而且要能够被客观地衡量,如一定水平上客户的减少;或者是全面的和主

观的,如“给出对关系的有用考虑”。在后一种情况中,应该指明是谁做出主

观判断。

图4 商业理解

1.2 形势评估 Assess situation

任务(Task)形势评估(Assess situation )

该任务涵盖了更为详尽的事实寻找——关于所有资源、约束、假设和在决

定数据分析目标及项目计划中应该予以考虑的其它因素。在前一个任务中,

你的目标是迅速到达问题的症结。而此处你则是想要扩充细节。

输出结果(Outputs)资源清单(Inventory of resources)

列出项目可以得到的资源,包括:人员(商业专家,数据专家,技术支持

人员,数据挖掘人员),数据(固定的提取,能够使用现场数据库或者实际

营运数据),计算资源(硬件平台)和软件(数据挖掘工具,其它相关软件)。

要求,假定和限制(Requirements, assumptions and constraints)

列出项目的所有要求,包括关于完成的时间表、结果的质量和易理解性、

安全性,以及法律事件。作为该输出结果的一部分,要确保你被允许使用

数据。

列出项目所作的假设。这些假设可能是在数据挖掘过程中能被检查的数据

的,但也有可能是有关项目基于商业假定而不可检查。如果后者形成了关

于结果有效性的条件,那么列出来尤其重要。

列出项目的限制条件。这些限制有可能是关于资源可得性的,也可能是技

术限制,如实际可用来建模的数据的多少。

风险和偶然性(Risks and contingencies)

列出风险,或者可能使项目拖延或失败的事件。列出相应的偶然性计划;

如果风险发生应该采取什么行动。

专业术语(Terminology)

编制关于项目的术语表。这包括两个部分:

(1) 相关商业术语表——构成了项目可得到的商业理解部分。建立该表

是一个很有用的“知识启发”和教育训练

(2) 数据挖掘术语表——通过与正在讨论的商业问题有关的例子来说明

成本和收益(Costs and benefits)

构造项目的成本收益分析,即如果该项目成功的话,将其成本与潜在的商

业利润相比较。该比较应该尽可能地具体,如在一个商业情况中使用货币

尺度。

1.3 确定数据挖掘目标 Determine data mining goals

任务(Task)确定数据挖掘目标(Determine data mining goals)

商业目标是用商业术语来阐明目的。一个数据挖掘目标则是用技术上的术语

来说明项目的目的。例如,商业目标可能是“增加现有客户的销售种类”。

一个数据挖掘目标便会是“考虑客户过去三年的购买、人口统计学信息(年

龄、工资、所在城市等等)及物品的价格,预测其将会购买多少小器具”。

输出结果(Outputs)数据挖掘目标(Data mining goals)

描述想要得到的项目输出结果——这使得商业目标得以实现。

数据挖掘成功标准(Data mining success criteria)

用技术性术语定义项目成功标准,如预测准确度或者在给定程度下“提高”

购买的倾向。与商业成功标准一样,用主观术语描述数据挖掘成功标准也

可能是必要的,这种情况下应该标明做出主观判断的人或者人们。

1.4 制定项目计划Produce project plan

任务(Task)制定项目计划(Produce project plan)

描述得以达到数据挖掘目标并从而实现商业目标的预定计划。该计划应该具

体说明在项目的剩余部分中预期要实施的各个步骤,并包括对工具方法的最

初选择。

输出结果(Outputs)项目计划(Project plan)

列出项目中执行的步骤,以及持续时间、所需资源、输入、输出结果和从属。

尽可能使得数据挖掘过程中大量的反复十分清楚,如建模和评估词语的重

复。

作为项目计划的一部分,分析时间表与风险之间的关联也是极为重要的。把

项目中这些分析的结果清楚地表达出来,尤其是如果风险发生,理想上地还

能明确表示出采取行动和建议。

注:项目计划包含每一个阶段的详细计划。如,在评估阶段决定使用什么样

的评估策略。

从某种意义上而言,项目计划是一个动态的文件。在每个阶段结束时,有必

要对进程和所完成的内容做一回顾,并推荐相应的更新项目计划。这些回顾

的具体检查要点也是项目计划的部分。

工具方法的初始评估(Initial assessment of tools and techniques)

在第一阶段末尾,也需要对工具和方法进行最初的评估。比如说,此处可以

挑选一种支持流程各个不同阶段多种方法的数据挖掘工具。在流程的早期就

评估工具方法是很重要的,因为工具与方法的选择很可能影响到整个项目。

2 数据理解 Data understanding

图5 数据理解

2.1 收集原始数据 Collect initial data

任务(Task)收集原始数据(Collect initial data)

获取(或者是有权使用)列在项目资源清单内的数据。如果对于数据理解是必

须的话,这一原始收集包括数据装载。例如,如果你使用一种明确的工具来进

行数据理解,那么原始收集对把数据装载到该工具中具有重大意义。这一努力

很可能通向初始数据的准备阶段。

注:如果你得到的是多个数据源,那么还需要另外的整合,可在此处进行,或

者在后面的数据准备阶段进行。

输出结果(Output)原始数据收集报告(Initial data collection report)

列出得到的数据集(单个或多个),以及它们在项目中的位置,用于取得它们

的方法和遇到的任何问题。记录遇到的问题和任何解决方法,以助于该项目未

来的重复实施或日后相似项目的完成。

2.2描述数据Describe data

任务(Task)描述数据(Describe data)

检查已获数据和结果报告“总的”或者“表面的”特征。

输出结果(Output)数据描述报告(Data description report)

描述已经获得的数据,包括:数据的格式,数据的数量,如每个表格中记录和

属性的数量,属性的特性和被探索数据的其它表面特征。获得的数据是否满足

相关的要求?

2.3 探索数据Explore data

任务(Task)探索数据Explore data

该任务主要是处理数据挖掘的问题——即可通过查询、可视化和报告说明的问

题。这些问题包括:关键属性的分布,如一个预测任务的目标属性;一对或几

个属性之间的关系;简单汇总的结果;重要亚群体的属性;简单的统计分析。

这些分析可能直接指向数据挖掘的目标;也可能有助于提炼数据描述和质量报

告,并实现进一步分析所需的转换和其它数据准备。

输出结果(Output)探索性数据分析报告(Data exploration report)

描述该任务的结果,包括最初的发现或假设,以及它们对项目剩余部分的影响。

如果适当的话,还包括图表,用以指出数据的特征或者为进一步的检查指向须

引起注意的数据子集。

2.4 检验数据质量Verify data quality

任务(Task)检验数据质量(Verify data quality)

检验数据的质量,列出如下的问题:数据是否完整(它是否覆盖了所有需要的

案例)?它是否正确或它是否包含错误,如果存在错误它们有什么共同之处?

数据中是否有缺失值?如果有的话,它们怎样表示,在哪发生,而且有什么共

同?

输出结果(Output)数据质量报告(Data quality report)

列出数据质量检验的结果;如果存在质量问题,写出可能的解决方法。数据

质量问题的解决方法通常在很大程度上依赖于对数据和商业问题二者的了

解。

3 数据准备 Data preparation

输出结果(Outputs)数据集(Dataset)

这是由数据准备阶段产生的数据集,将用于建模或者项目的主要分析工作。

图6 数据准备

3.1 选择数据Select data

任务(Task)选择数据(Select data)

决定用来分析的数据。选择标准包括与数据挖掘目标的相关性,质量和技术的

限制,如对数据容量或数据类型的限制。注意数据选择包括表格中属性和记录

(行)的选择。

输出结果(Output)包含/剔除数据的基本原理(Rationale for inclusion/exclusion)

列出被包含和剔除的数据及做出这些决定的原因。

3.2 清洗数据Clean data

任务(Task)清洗数据(Clean data)

将数据质量提高到所选分析技术要求的水平。这包括选择数据清洗的子集,插

入适当的默认值或者通过更加复杂的技术如建模来估计缺失值。

输出结果(Output)数据清洗报告(Data cleaning report)

描述采用什么决定和行动来说明在数据理解阶段的数据质量检验任务中报告

的数据质量问题。出于清洗目的和对分析结果的可能影响,应该考虑初级的转

换。

3.3 构建数据 Construct data

任务(Task)构建数据(Construct data)

该任务包括构建数据的准备操作,如生成派生属性、生成完整的新记录或者已

存属性的转换值。

输出结果(Outputs)派生字段(Derived attributes )

派生字段是从同一条记录中一个或多个已存字段构建而来的新字段。例子:

面积=长度*宽度。

产生记录(Generated records)

描述完全新记录的产生。如:产生在上一年未作任何购买的客户的记录。虽然

在原始数据中增加这些记录是不合理的,但出于建模的目的,明确地显示某些

客户没有做任何购买的事实是有意义地。

3.4 整合数据Integrate data

任务(Task)整合数据(Integrate data)

有些方法可对多个表格或者多条记录合并信息,从而建立新记录或新值。

输出结果(Output)合并的数据(Merged data)

合并表格是指把含有相同对象、不同信息的两个或多个表格连接起来。如:一

家零售连锁店有一个表格是关于每个商店的一般特征(如:房屋面积,商场类

型),另一个表格是关于总结后的销售数据(如:利润,与上年相比销售的百分

比变化),还有一个表格则是关于周围环境的人口统计信息。每个表格都包括每

家店的一条记录。然后,通过从原表格中合并字段,这些表格便可以合并在一

起得到一个新的表格——其中每个商店都有一条记录。数据整合同时也包括汇

总。汇总指的是通过把多条记录或多个表格的信息归纳在一起从而计算新值的

操作。比如说,把一个每笔购买都有一条记录的客户购买表转换成一个每个客

户一条记录的新表格,新表格的字段有购买次数、平均购买总额、用信用卡支

付的订单比例以及促销下购买的物品比例等等。

3.5 格式化数据Format data

任务(Task)格式化数据(Format data)

格式化转换是指根据建模的要求,对数据主要进行语法上的修改,而不改变其

意思。

输出结果(Output)更改格式的数据(Reformatted data)

一些工具对属性的顺序有要求,如第一个字段是每条记录唯一的标识符,或者

最后一个字段要是模型预测的结果字段。

在数据集中改变记录的顺序也是重要的。也许建模工具会要求记录按照结果属

性的值排序。一种常见的情况是数据集的记录按照某种方式进行最初排序,而

运算法则需要它们是以一种随机的顺序排列的。例如,当使用神经网络时,记

录通常最好是以随机的顺序出现,当然有些工具是自动完成该过程的,不需用

户进行操作。

此外,为了满足具体建模工具的要求,有时候会做一些纯粹句法上的改变。如:

从以逗号分割的数据文件的内部文本字段中删除逗号,削减所有32位字符及以

下的数值。

4 建模 Modeling

4.1 选择建模技术 Select modeling technique

任务(Task)选择建模技术(Select modeling technique)

建模的第一步是选择实际使用的建模技术。因为你很可能已经在商业理解中

选择了一种工具,所以该任务指的是明确的建模技术,如C4.5建立的决策树

或神经网络。如果运用多种技术,应分别用每种技术实施该技术。

输出(Outputs)建模技术(Modeling technique)

记录将要使用的实际建模技术。

数据挖掘整理(熊熊整理-----献给梦中的天涯) 单选题 1.下面哪种分类方法是属于神经网络学习算法?() A. 判定树归纳 B. 贝叶斯分类 C. 后向传播分类 D. 基于案例的推理 2.置信度(confidence)是衡量兴趣度度量( A )的指标。 A、简洁性 B、确定性 C.、实用性 D、新颖性 3.用户有一种感兴趣的模式并且希望在数据集中找到相似的模式,属于数据挖掘哪一类任务?(A) A. 根据内容检索 B. 建模描述 C. 预测建模 D. 寻找模式和规则 4.数据归约的目的是() A、填补数据种的空缺值 B、集成多个数据源的数据 C、得到数据集的压缩表示 D、规范化数据 5.下面哪种数据预处理技术可以用来平滑数据,消除数据噪声? A.数据清理 B.数据集成 C.数据变换 D.数据归约 6.假设12个销售价格记录组已经排序如下:5, 10, 11, 13, 15, 35, 50, 55, 72, 92, 204, 215 使用如下每种方法将它们划分成四个箱。等频(等深)划分时,15在第几个箱子内?(B) A 第一个 B 第二个 C 第三个 D 第四个 7.下面的数据操作中,()操作不是多维数据模型上的OLAP操作。 A、上卷(roll-up) B、选择(select) C、切片(slice) D、转轴(pivot) 8.关于OLAP和OLTP的区别描述,不正确的是: (C) A. OLAP主要是关于如何理解聚集的大量不同的数据.它与OTAP应用程序不同. B. 与OLAP应用程序不同,OLTP应用程序包含大量相对简单的事务. C. OLAP的特点在于事务量大,但事务内容比较简单且重复率高. D. OLAP是以数据仓库为基础的,但其最终数据来源与OLTP一样均来自底层的数据库系统,两者面对的用户是相同的 9.下列哪个描述是正确的?() A、分类和聚类都是有指导的学习 B、分类和聚类都是无指导的学习

基于案例学习数据挖掘 数据挖掘是近年来一个在IT领域非常活跃的实用性技术学科,由于其广泛的应用,极为出彩的实际应用效果,对于各行业几乎都可以无门槛地进行分析和挖掘部署,受到了越来越多的关注。 数据挖掘是一门综合学科,它包括了数据库技术、统计学、信息科学、机器学习、可视化、以及其他学科的部分内容。 课程介绍: 本次数据挖掘课程作为入门级别,通过较为具体、丰富的案例来为学员们带来数据挖掘具体项目的应用感受,按照标准流程的案例操作可以让学员以最快的时间熟悉数据挖掘并且能够处理一些简易的挖掘案例,数学、统计学、数据库、机器学习功底较好的同学在学完本科后可以举一反三,具备单独处理数据挖掘案例的能力,基础稍弱的同学也会用数据挖掘模型来提出问题。分析问题,解决问题。适用人群: 基本要求:对于数据挖掘感兴趣,喜欢用数据来思考问题,相信正确地处理数据能够反映问题的实质 知识要求:以下内容至少会一种,数据库知识、统计学、信息科学、机器学习。如果现在不会,可以通过网络先简单学习一下统计学基础知识。 课程内容: 第1课数据挖掘概论 第2课数据挖掘标准流程 第3课数据挖掘入门案例(一)

第4课数据挖掘入门案例(二) 第5课数据挖掘入门案例(三) 第6课数据处理专题 第7课变量选择专题 第8课K-mean聚类案例讲解 第9课线性回归与案例 第10课精准营销案例(一) 第11课精准营销案例(二) 第12课精准营销案例(三) 授课对象: 有一定相关知识背景,对数据挖掘感兴趣的朋友 收获预期: 可以大幅度提高学员的数学基础,使其学习其它大数据分析课程时觉得更加简单,得心应手 授课讲师: 赵鸿雁 明博智创明博智创(北京)软件技术有限责任公司数据分析师,硕士研究生,专业是计算数学,求学期间主要钻研数据挖掘中支持向量机的算法优化。擅长数据挖掘基础、统计基础和excel数据分析培训。 项目经验:中国烟草公司统计分析基础培训、某软件公司精准营销项目、某出版社畅销书目分析和推荐项目。

数据挖掘:是从大量数据中发现有趣(非平凡的、隐含的、先前未知、潜在有用)模式,这些数据可以存放在数据库,数据仓库或其他信息存储中。 挖掘流程: 1.学习应用域 2.目标数据创建集 3.数据清洗和预处理 4.数据规约和转换 5.选择数据挖掘函数(总结、分类、回归、关联、分类) 6.选择挖掘算法 7.找寻兴趣度模式 8.模式评估和知识展示 9.使用挖掘的知识 概念/类描述:一种数据泛化形式,用汇总的、简洁的和精确的方法描述各个类和概念,通过(1)数据特征化:目标类数据的一般特性或特征的汇总; (2)数据区分:将目标类数据的一般特性与一个或多个可比较类进行比较; (3)数据特征化和比较来得到。 关联分析:发现关联规则,这些规则展示属性-值频繁地在给定数据集中一起出现的条件,通常要满足最小支持度阈值和最小置信度阈值。 分类:找出能够描述和区分数据类或概念的模型,以便能够使用模型预测类标号未知的对象类,导出的模型是基于训练集的分析。导出模型的算法:决策树、神经网络、贝叶斯、(遗传、粗糙集、模糊集)。 预测:建立连续值函数模型,预测空缺的或不知道的数值数据集。 孤立点:与数据的一般行为或模型不一致的数据对象。 聚类:分析数据对象,而不考虑已知的类标记。训练数据中不提供类标记,对象根据最大化类内的相似性和最小化类间的原则进行聚类或分组,从而产生类标号。 第二章数据仓库 数据仓库是一个面向主题的、集成的、时变的、非易失的数据集合,支持管理部门的决策过程。从一个或多个数据源收集信息,存放在一个一致的模式下,并且通常驻留在单个站点。数据仓库通过数据清理、变换、继承、装入和定期刷新过程来构造。面向主题:排除无用数据,提供特定主题的简明视图。集成的:多个异构数据源。时变的:从历史角度提供信息,隐含时间信息。非易失的:和操作数据的分离,只提供初始装入和访问。 联机事务处理OLTP:主要任务是执行联机事务和查询处理。 联系分析处理OLAP:数据仓库系统在数据分析和决策方面为用户或‘知识工人’提供服务。这种系统可以用不同的格式和组织提供数据。OLAP是一种分析技术,具有汇总、合并和聚集功能,以及从不同的角度观察信息的能力。

《大数据分析与挖掘》课程教学大纲 一、课程基本信息 课程代码:16054103 课程名称:大数据分析与挖掘 英文名称:Big data analysis and mining 课程类别:专业选修课 学时:48(理论课:32, 实验课:16) 学 分:3 适用对象: 软件工程专业、计算机科学与技术 考核方式:考查 先修课程:多媒体技术、程序设计、软件工程 二、课程简介 本课程从大数据挖掘分析技术实战的角度,结合理论和实践,全方位地介绍基于Python语言的大数据挖掘算法的原理与使用。本课程涉及的主题包括基础篇和实战篇两部分, 其中基础篇包括:数据挖掘基础,Python数据分析简介,数据探索,数据预处理和挖掘建模;实战篇包括:电力窃漏电用户自动识别,航空公司客户价值分析,中医证型关联规则挖掘,基于水色图像的水质评价,家用电器用户行为分析与事件识别,应用系统负载分析与磁盘容量预测和电子商务网站用户行为分析及服务推荐。 本课程不是一个泛泛的理论性、概念性的介绍课程,而是针对问题讨论基于Python语言机器学习模型解决方案的深入课程。教师对于上述领域有深入的理论研究与实践经验,在课程中将会针对这些问题与学员一起进行研究,在关键点上还会搭建实验环境进行实践研究,以加深对于这些解决方案的理解。通过本课程学习,目的是让学生能够扎实地掌握大数据分析挖掘的理论与应用。 This course introduces the principle and application of big data mining algorithm based on Python language comprehensively from the perspective of big data mining analysis technology practice, combining theory and practice. This course covers two parts, the basic part and the practical part. The basic part includes: basic data mining, introduction to Python data analysis, data exploration, data preprocessing and mining modeling. Practical article included: electric power leakage automatic identification of the user, airlines customer value analysis, TCM syndrome association rule mining, based on water quality evaluation of color image, household electrical appliances

数据挖掘入门读物: 深入浅出数据分析这书挺简单的,基本的内容都涉及了,说得也比较清楚,最后谈到了R是大加分。难易程度:非常易。 啤酒与尿布通过案例来说事情,而且是最经典的例子。难易程度:非常易。 数据之美一本介绍性的书籍,每章都解决一个具体的问题,甚至还有代码,对理解数据分析的应用领域和做法非常有帮助。难易程度:易。 数学之美这本书非常棒啦,入门读起来很不错! 数据分析: SciPy and NumPy 这本书可以归类为数据分析书吧,因为numpy和scipy真的是非常强大啊。Python for Data Analysis 作者是Pandas这个包的作者,看过他在Scipy会议上的演讲,实例非常强!Bad Data Handbook 很好玩的书,作者的角度很不同。 数据挖掘适合入门的教程: 集体智慧编程学习数据分析、数据挖掘、机器学习人员应该仔细阅读的第一本书。作者通过实际例子介绍了机器学习和数据挖掘中的算法,浅显易懂,还有可执行的Python代码。难易程度:中。 Machine Learning in Action 用人话把复杂难懂的机器学习算法解释清楚了,其中有零星的数学公式,但是是以解释清楚为目的的。而且有Python代码,大赞!目前中科院的王斌老师(微博:王斌_ICTIR)已经翻译这本书了机器学习实战(豆瓣)。这本书本身质量就很高,王老师的翻译质量也很高。难易程度:中。我带的研究生入门必看数目之一! Building Machine Learning Systems with Python 虽然是英文的,但是由于写得很简单,比较理解,又有Python 代码跟着,辅助理解。 数据挖掘导论最近几年数据挖掘教材中比较好的一本书,被美国诸多大学的数据挖掘课作为教材,没有推荐Jiawei Han老师的那本书,因为个人觉得那本书对于初学者来说不太容易读懂。难易程度:中上。Machine Learning for Hackers 也是通过实例讲解机器学习算法,用R实现的,可以一边学习机器学习一边学习R。 数据挖掘稍微专业些的: Introduction to Semi-Supervised Learning 半监督学习必读必看的书。 Learning to Rank for Information Retrieval 微软亚院刘铁岩老师关于LTR的著作,啥都不说了,推荐!Learning to Rank for Information Retrieval and Natural Language Processing 李航老师关于LTR的书,也是当时他在微软亚院时候的书,可见微软亚院对LTR的研究之深,贡献之大。 推荐系统实践这本书不用说了,研究推荐系统必须要读的书,而且是第一本要读的书。 Graphical Models, Exponential Families, and Variational Inference 这个是Jordan老爷子和他的得意门徒Martin J Wainwright 在Foundation of Machine Learning Research上的创刊号,可以免费下载,比较难懂,但是一旦读通了,graphical model的相关内容就可以踏平了。 Natural Language Processing with Python NLP 经典,其实主要是讲NLTK 这个包,但是啊,NLTK 这个包几乎涵盖了NLP 的很多内容了啊! 数据挖掘机器学习教材: The Elements of Statistical Learning 这本书有对应的中文版:统计学习基础(豆瓣)。书中配有R包,非常赞!可以参照着代码学习算法。 统计学习方法李航老师的扛鼎之作,强烈推荐。难易程度:难。 Machine Learning 去年出版的新书,作者Kevin Murrphy教授是机器学习领域中年少有为的代表。这书是他的集大成之作,写完之后,就去Google了,产学研结合,没有比这个更好的了。

SAS 8.2 Enterprise Miner数据挖掘实例 目录 1.SAS 8.2 Enterprise Miner简介 (2) 2.EM工具具体使用说明 (2) 3.定义商业问题 (3) 4.创建一个工程 (4) 4.1调用EM (4) 4.2新建一个工程 (5) 4.3应用工作空间中的节点 (6) 5.数据挖掘工作流程 (6) 5.1定义数据源 (6) 5.2探索数据 (8) 5.2.1设置Insight节点 (8) 5.2.2察看Insight节点输出结果 (9) 5.3准备建模数据 (11) 5.3.1建立目标变量 (11) 5.3.2设置目标变量 (13) 5.3.3数据分割 (21) 5.3.4替换缺失值 (22) 5.4建模 (23) 5.4.1回归模型 (23) 5.4.2决策树模型 (25) 5.5评估模型 (28) 5.6应用模型 (30) 5.6.1抽取打分程序 (30) 5.6.2引入原始数据源 (31) 5.6.3查看结果 (32) 6.参考文献: (34)

1.SAS 8.2 Enterprise Miner简介 数据挖掘就是对观测到的庞大数据集进行分析,目的是发现未知的关系和以数据拥有者可以理解并对其有价值的新颖方式来总结数据。[1] 一个数据挖掘工程需要足够的软件来完成分析工作,为了计划、实现和成功建立一个数据挖掘工程,需要一个集成了所有分析阶段的软件解决方案,包括从数据抽样到分析和建模,最后公布结果信息。大部分专业统计数据分析软件只实现特定的数据挖掘技术,而SAS 8.2 Enterprise Miner是一个集成的数据挖掘系统,允许使用和比较不同的技术,同时还集成了复杂的数据库管理软件。SAS 8.2 Enterprise Miner把统计分析系统和图形用户界面(GUI)集成在一起,并与SAS协会定义的数据挖掘方法——SEMMA方法,即抽样(Sample)、探索(Explore)、修改(Modify)建模(Model)、评价(Assess)紧密结合,对用户友好、直观、灵活、适用方便,使对统计学无经验的用户也可以理解和使用。 Enterprise Miner简称EM,它的运行方式是通过在一个工作空间(workspace)中按照一定的顺序添加各种可以实现不同功能的节点,然后对不同节点进行相应的设置,最后运行整个工作流程(workflow),便可以得到相应的结果。 2.EM工具具体使用说明 EM中工具分为七类: ?Sample类包含Input Data Source、Sampling、Data Partition ?Explore类包含Distribution Explorer、Multiplot、Insight、 Association、Variable Selection、Link Analysis (Exp.) ?Modify类包含Data Set Attribute、Transform Variable、Filter Outliers、Replacement、Clustering、SOM/Kohonen、 Time Series(Exp.) ?Medel类包括Regression、Tree、Neural Network、 Princomp/Dmneural、User Defined Model、Ensemble、 Memory-Based Reasoning、Two Stage Model ?Assess类包括Assessment、Reporter

大数据挖掘入门教程 大数据时代的来临,给人们生活带来了巨大变化。对于中国而言,大数据产业起步晚,发展速度快。物联网、移动互联网的迅速发展,使数据产生速度加快、规模加大,迫切需要运用大数据手段进行分析处理,提炼其中的有效信息。千锋教育,经过多年的洗礼,在大数据培训中取得了不错的成绩。 下面是千锋教育对于大数据入门教程的步骤: 1)数据挖掘概述与数据: 讲解了数据挖掘技术的起源、应用场景以及基本的处理方法,并对于数据集、数据等基本的概念做了阐释。 2)可视化与多维数据分析: 讲解了数据可视化的基本方法,并分别演示了Excel数据透视表与SQLServerAnalysisService对于多维数据的可视化处理。 3)分类器与决策树: 讲解了分类器的基本概念与应用方法,并具体分析了分类器经典算法之一决策树的实现方法。 4)其他分类器:

讲解了另外两种经典的分类器算法:基于规则的分类器与基于距离的分类器和其他一些常见的分类器算法,如基于距离的分类器的改良算法、贝叶斯分类器、人工神经网络、支持向量机与组合方法等。 5)决策树的应用: 演示了利用WekaExplorer、KNIME、Tanagra等开源工具进行的数据挖掘处理。演示中对比了几类数据挖掘算法,如Cart决策树、C4.5决策树、KNIME决策树、简单贝叶斯分类、组合方法、人工神经网络、基于规则的分类等。 6)关联分析: 讲解了关联分析的常见算法,即Apriori算法与FP增长算法。 7)购物车数据分析: 主要演示了利用微软的解决方案来进行购物车数据的关联分析,包括SQLServiceAnalysisService的关联分析与Excel结合SSAS外接程序等方法。最后还利用WekaKnowledgeFlow工具来进行关联分析,以便对比第六章的实践。 8) 聚类算法: 讲解了聚类算法的基本原理与常见算法,包含K均值算法、层次聚类、基于密度的聚类算法。 大数据是未来的趋势,选择千锋教育,助力人生!

CRISP-DM 1.0 数据挖掘方法论指南 Pete Chapman (NCR), Julian Clinton (SPSS), Randy Kerber (NCR), Thomas Khabaza (SPSS), Thomas Reinartz (DaimlerChrysler), Colin Shearer (SPSS) and Rüdiger Wirth (DaimlerChrysler)

该手册描述了CRISP-DM(跨行业数据挖掘标准流程)过程模型,包括CRISP-DM的方法论、相关模型、用户指南、报告介绍,以及一个含有其他相关信息的附录。 本手册和此处的信息均为CRISP-DM协会以下成员的专利:NCR Systems Engineering Copenhagen (USA and Denmark), DaimlerChrysler AG (Germany), SPSS Inc. (USA) and OHRA Verzekeringen en Bank Groep B.V (The Netherlands)。 著作权? 1999, 2000 本手册中所有商标和服务标记均为它们各自所有者的标记,并且为CRISP-DM协会的成员所公认。

前言 1996年下半年,数据挖掘市场尚处于萌芽状态,CRISP-DM率先由三家资深公司共同提出。DaimlerChrysler (即后来的Daimler-Benz) 在其商业运营中运用数据挖掘的经验颇为丰富,远远领先于其他大多数商业组织。SPSS(即后来的ISL)自1990年以来一直致力于提供基于数据挖掘的服务,并于1994年推出了第一个商业数据挖掘平台——Clementine。至于NCR,作为对其Teradata数据仓库客户增值目标的一部分,它已经建立了数据挖掘顾问和技术专家队伍以满足其客户的需要。 当时,数据挖掘所引起的市场关注开始表明其进入爆炸式增长和广泛应用的迹象。这既令人兴奋又使人害怕。随着我们在这条路上不断走下去,所有人都不断研究和发展数据挖掘方法。可是我们做的是否正确?是否每一个数据挖掘的新使用者都必须像我们当初一样经历反复试验和学习?此外,从供应商的角度来看,我们怎样向潜在客户证明数据挖掘技术已足够成熟到可以作为它们商业流程的一个关键部分? 在这种情况下,我们认为急需一个标准的流程模型——非私人所有并可以免费获取——向我们和所有的从业者很好的回答这些问题。 一年后我们组建了联盟,名字CRISP-DM取自CRoss-Industry Standard Process for Data Mining的缩写,由欧洲委员会提供资助,开始实施我们最初的想法。因为CRISP-DM的定位是面向行业、工具导向和面向应用的,所以我们明白必须“海纳百川,博采众家之长”,必须在一个尽可能宽的范围内吸引人们的兴趣(比如数据仓库制造商和管理咨询顾问)。于是我们决定成立CRISP-DM 专门兴趣小组(即大家所知道的“The SIG”)。我们邀请所有感兴趣的团体和个人到阿姆斯特丹参加为期一天的工作会议,讨论并正式成立SIG组织:我们观念共享,鼓励与会者畅所欲言,为发展CRISP-DM共商大计。 当天每个协会成员都心怀惴惴,会不会没有人对CRISP-DM有足够的兴趣?即使有,那他们是否认为实际上并未看到一种对标准化流程的迫切需求?或者我们的想法迄今为止与别人的步调不一致,任何标准化的念头只是不切实际的白日梦? 事实上,讨论的结果大大超出了我们的期望。下面三点最为突出: 当天的与会人数是我们原先期望的两倍 行业需要而且现在就需要一个标准化流程——大家压倒性的一致同意 每个出席者从他们的项目经验出发陈述了自己关于数据挖掘的看法,这使我们越来越清晰地看到:尽管表述上有些区别——主要是在阶段的划分和术语方面,但在如何看待数据挖掘流程上大家具有极大的相似之处。 在工作组结束的时候,我们充满了自信,受SIG的启发和批评,我们能够建成一个标准化流程模型,为数据挖掘事业作出贡献。 接下来的两年半里,我们努力工作来完善和提炼CRISP-DM。我们不断地在Mercedes-Benz、保险部门的伙伴及OHRA的实际大型数据挖掘项目中进行尝试。同时也运用商业数据挖掘工具来整合CRISP-DM。SIG证明了是无价的,其成员增长到200多,并且在伦敦、纽约和布鲁塞尔都拥有工作组。 到该项目的欧洲委员会支持基金部分结束时——1999年年中,我们提出了自己觉得质量优良的流程模型草案。熟悉这一草案的人将会发现,一年以来,尽管现在的CRISP-DM1.0更完整更好,但从根本上讲并没有什么本质不同。我们强烈地意识到:在整个项目中,流程模型仍然是一个持续进行的工作;CRISP-DM还只是在一系列有限的项目中得到证实。过去的一年里,DaimlerChrysler有机会把CRISP-DM运用于更为广阔的范围。SPSS和NCR的专业服务团体采纳了CRISP-DM,而且用之成功地完成了无数客户委托,包括许多工业和商业的问题。这段时间以来,我们看到协会外部的服务供应商也采用了CRISP-DM;分析家不断重复地提及CRISP-DM

数据挖掘过程中的预处理阶段 整个数据挖掘过程中,数据预处理要花费60%左右的时间,而后的挖掘工作仅占总工作量的10%左右[1]。经过预处理的数据,不但可以节约大量的空间和时间,而且得到的挖掘结果能更好地起到决策和预测作用。 一般的,数据预处理分为4个步骤,本文把对初始数据源的选择作为数据预处理过程中的一个步骤,即共分为5个步骤。因为,如果在数据获得初期就有一定的指导,则可以减少数据获取的盲目性以及不必要噪声的引入且对后期的工作也可节约大量的时间和空间。整个预处理过程见下图: 1 初始源数据的获取 研究发现,通过对挖掘的错误结果去寻找原因,多半是由数据源的质量引起的。因此,原始数据的获取,从源头尽量减少错误和误差,尤其是减少人为误差,尤为重要。首先应了解任务所涉及到的原始数据的属性和数据结构及所代表的意义,确定所需要的数据项和数据提取原则,使用合适的手段和严格的操作规范来完成相关数据的获取,由于这一步骤涉及较多相关专业知识,可以结合专家和用户论证的方式尽量获取有较高含金量(预测能力)的变量因子。获取过程中若涉及到多源数据的抽取,由于运行的软硬件平台不同,对这些异质异构数据库要注意数据源的连接和数据格式的转换。若涉及到数据的保密,则在处理时应多注意此类相关数据的操作且对相关数据作备注说明以备查用。

2 数据清理 数据清理 数据清理是数据准备过程中最花费时间、最乏味,但也是最重要的步骤。该步骤可以有效减少学习过程中可能出现相互矛盾情况的问题。初始获得的数据主要有以下几种情况需要处理: 1)含噪声数据。处理此类数据,目前最广泛的是应用数据平滑技术。1999年,Pyle系统归纳了利用数据平滑技术处理噪声数据的方法,主要有:①分箱技术,检测周围相应属性值进行局部数据平滑。②利用聚类技术,根据要求选择包括模糊聚类分析或灰色聚类分析技术检测孤立点数据,并进行修正,还可结合使用灰色数学或粗糙集等数学方法进行相应检测。③利用回归函数或时间序列分析的方法进行修正。④计算机和人工相结合的方式等。 对此类数据,尤其对于孤立点或异常数据,是不可以随便以删除方式进行处理的。很可能孤立点的数据正是实验要找出的异常数据。因此,对于孤立点应先进入数据库,而不进行任何处理。当然,如果结合专业知识分析,确信无用则可进行删除处理。 2)错误数据。对有些带有错误的数据元组,结合数据所反映的实际问题进行分析进行更改或删除或忽略。同时也可以结合模糊数学的隶属函数寻找约束函数,根据前一段历史趋势数据对当前数据进行修正。 3)缺失数据。①若数据属于时间局部性的缺失,则可采用近阶段数据的线性插值法进行补缺;若时间段较长,则应该采用该时间段的历史数据恢复丢失数据。若属于数据的空间缺损则用其周围数据点的信息来代替,且对相关数据作备注说明,以备查用。②使用一个全局常量或属性的平均值填充空缺值。③使用回归的方法或使用基于推导的贝叶斯方法或判定树等来对数据的部分属性进行修复④忽略元组。 4)冗余数据。包括属性冗余和属性数据的冗余。若通过因子分析或经验等方法确信部分属性的相关数据足以对信息进行挖掘和决策,可通过用相关数学方法找出具有最大影响属性因子的属性数据即可,其余属性则可删除。若某属性的部分数据足以反映该问题的信息,则其余的可删除。若经过分析,这部分冗余数据可能还有他用则先保留并作备注说明。

生产再生钢的过程如下:组合后的废钢通过炉门送入炉子,电流通过悬浮在炉内的电极输送到熔化的废钢中。提供给这些电极的高电流通过电弧传输到内部的金属废料,对其加热并产生超过3000°C的温度。 通过添加各种活性气体和惰性气体以及固体物质来维持和优化炉内条件。然后,钢水从熔炉中流出,进入移动坩埚,并浇铸到钢坯中。 你将得到一个数据集,代表从各种金属废料lypes生产回收钢坯的过程。Hie数据集包含大 ?这是一个基于团队的项目。你需要组成一个小组,由三名(或两名)组员来完成这项练习。?您可以使用Weka或任何其他可用的数据挖掘资源和软件包来帮助您制定问题、计算、评

估等。 ?您的团队绩效将完全根据团队的结果和您的报告进行评估。 ?作为一个团队,您需要决定给定问题的性质;什么类型的数据挖掘问题公式适合解决此类问题;您的团队可以遵循什么样的基本数据挖掘过程;您的团队希望尝试什么类型的算法;以何种方式,您可以进一步利用或最大化您的性能,等等。 ?您的团队应致力于涵盖讲座、教程中包含的领域,考虑预处理、特征选择、各种算法、验证、测试和性能评估方法。 ?对于性能基准,建议您使用准确度和/或错误率作为评估指标。 ?表现最好的球队将被宣布为本次迷你KDD杯冠军,并将获得10%的加分,最高100%满分。 数据挖掘流程: 一、数据建模 1. 数据获取 2. 数据分析 3. 数据预处理 二、算法建模 1. 模型构建 2. 模型检验 三、评估 一、数据建模 1.数据获取及分析 数据集:EAF_process_dataqqq.csv 根据《assignment 2》中,数据集的说明,可知:

大数据分析工程师(基础级)考试大纲CBDA大数据分析工程师考试大纲是CBDA命题组基于CBDA大数据分析工程师等级认证标准而设定的一套科学、详细、系统的考试纲要。考纲规定并明确了CBDA大数据分析工程师认证考试的具体范围、内容和知识点,考生可按照CBDA大数据分析工程师考试大纲进行相关知识的复习。 大数据数学基础(占比30%) 1 微积分基础 2 概率论与数理统计 3 线性代数 4 数值计算基础 5 多元统计分析 数据分析基础(占比20%) 1 数据分析的基本流程 2 数据的描述分析 3 数据的推断分析 4 数据的相关分析 5 数据的回归分析 6 数据的可视化分析 Excel数据处理与分析(占比10%) 1 Excel函数及使用 2 Excel数据管理 3 Excel数据透视表 4 Excel数据可视化图表分析 数据采集与预处理(占比10%) 1 数据采集方法 2 数据取样方法 3 市场调研 4 数据预处理方法 5 数据存储方法 数据建模分析基础(占比30%) 1 主成分分析法(占比3%)、因子分析法(占比2%) 2 系统聚类法(占比3%)、K-Means 聚类法(占比3%) 3 对应分析(占比2%)、多维尺度分析(占比2%)

4 预测性分析法(多元线性回归(占比5%),逻辑回归(占比5%)) 5 时间序列(占比5%) 参考目录 1 大数据数学基础,,人民邮电出版社,2017 2 实用多元统计分析(第6 版),[美]约翰逊,[美]威克恩著;陆璇,叶俊译,清华大学出版社 3 经济计量学,[美]斯托克(Stock J.H.)著;王庆石译,东北财经大学出版社,2005 4 数据库系统及应用(第3版),崔巍,高等教育出版社,2012

大数据挖掘技术之DM经典模型(上) 数据分析微信公众号datadw——关注你想了解的,分享你需要的。 实际上,所有的数据挖掘技术都是以概率论和统计学为基础的。 下面我们将探讨如何用模型来表示简单的、描述性的统计数据。如果我们可以描述所要找的事物,那么想要找到它就会变得很容易。这就是相似度模型的来历——某事物与所要寻找的事物越相似,其得分就越高。 下面就是查询模型,该模型正在直销行业很受欢迎,并广泛用于其它领域。朴素贝叶斯模型是表查找模型中一种非常有用的泛化模型,通常表查询模型适用于较低的维度,而朴素贝叶斯模型准许更多的维度加入。还有线性回归和逻辑回归模型,都是最常见的预测建模技术。回归模型,用于表示散点图中两个变量之间的关系。多元回归模型,这个准许多个单值输入。随后介绍逻辑回归分析,该技术扩展了多元回归以限制其目标范围,例如:限定概率估计。还有固定效应和分层回归模型,该模型可将回归应用于个人客户,在许多以客户为中心的数据挖掘技术之间搭建了一座桥梁。 1、相似度模型 相似度模型中需要将观察值和原型进行比较,以得到相应的相似度得分。观察值与原型相似度越高,其得分也就越高。一种度量相似度的方法是测量距离。观察值与原型值之间的距离越近,观察值的得分就越高。当每个客户细分都有一个原型时,该模型可以根据得分把客户分配到与其最相似的原型所在的客户细分中。 相似度模型有原型和一个相似度函数构成。新数据通过计算其相似度函数,就可以计算出相似度得分。 1.1、相似度距离 通过出版社的读者比一般大众要富有,而且接受教育的程度要高为例。通常前者要比后者在富有程度、教育程度的比例大三倍。这样我们

SAS数据挖掘的流程 一、数据挖掘的一般流程 数据挖掘是指一个完整的过程,该过程从大型数据库中挖掘先前未知的,有效的,可实用的信息,并使用这些信息做出决策或丰富知识. 数据挖掘过程图如下所示,它描述了数据挖掘的基本过程和主要步骤 图1.数据挖掘过程图 数据挖掘过程中各步骤的大体内容如下 1. 确定业务对象 清晰地定义出业务问题,认清数据挖掘的目的是数据挖掘的重要一步.挖掘的最后结构是不可预测的,但要探索的问题应是有预见的,为了数据挖掘而数据挖掘则带有盲目性,是不会成功的. 2. 数据准备 1) 数据的选择 搜索所有与业务对象有关的内部和外部数据信息,并从中选择出适用于数据挖掘应用的数据. 2) 数据的预处理 研究数据的质量,为进一步的分析作准备.并确定将要进行的挖掘操作的类型. 3) 数据的转换 将数据转换成一个分析模型.这个分析模型是针对挖掘算法建立的.建立一个真正适合挖掘算法的分析模型是数据挖掘成功的关键. 3. 数据挖掘 对所得到的经过转换的数据进行挖掘.除了完善从选择合适的挖掘算法外,其余一切工作都能自动地完成. 4. 结果分析 解释并评估结果.其使用的分析方法一般应作数据挖掘操作而定,通常会用到可视化技术. 5. 知识的同化 将分析所得到的知识集成到业务信息系统的组织结构中去. 二、SAS数据挖掘的方法(SEMMA) 作为智能型的数据挖掘集成工具,SAS/EM的图形化界面、可视化操作可引导用户(即使是数理统计经验不太多的用户)按SEMMA原则成功地进行数据挖掘,用户只要将数据输入,经过SAS/EM运行,即可得到一些分析结果。有经验的专家还可通过修改数据调整分析处理过程。 SAS/EM可实现同数据仓库和数据集市、商务智能及报表工具的无缝集成,它内含完整的数据获取工具、数据取样工具、数据筛选工具、数据变量转换工具、数据挖掘数据库、数据挖掘过程以及数据挖掘评价工具。

摘要: 顾名思义, 数据挖掘就是从大量的数据中挖掘出有用的信息。它是根据人们的特定要求,从浩如烟海的数据中找出所需的信息来,供人们的特定需求使用。2000年7 月,IDC发布了有关信息存取工具市场的报告。1999年,数据挖掘市场大概约为7.5亿美元,估计在下个5年内市场的年增长率为32.4%,其中亚太地 区为26.6%。到2002年,该市场会发展到22亿美元。据国外专家预测,随着数据量的日益积累和计算机的广泛应用,在今后的5—10年内,数据挖掘将 在中国形成一个新型的产业。 为了帮助大家了解数据挖掘的基本理论和方法,我们从“数据挖掘讨论组”网站上整理加工了一组有关该概念的基本知识,省却了纷繁的技术方法,供读者学习参考。 第一课 数据挖掘技术的由来第二课 数据挖掘的定义 第三课 数据挖掘的研究历史和现状第四课 数据挖掘研究内容和本质 第五课 数据挖掘的功能第六课 数据挖掘常用技术 第七课 数据挖掘的流程第八课 数据挖掘未来研究方向及热点第九课 数据挖掘应用第十课 实施数据挖掘项目考虑的问题 URL:h ttp://https://www.doczj.com/doc/536828047.html,/learning/lesson/xinxi/20021125/lesson.asp

第一课数据挖掘技术的由来 1.1 网络之后的下一个技术热点 1.2 数据爆炸但知识贫乏 1.3 支持数据挖掘技术的基础 1.4 从商业数据到商业信息的进化 1.5 数据挖掘逐渐演变的过程 1.1网络之后的下一个技术热点 我们现在已经生活在一个网络化的时代,通信、计算机和网络技术正改变着整个人类和社会。如果用芯片集成度来衡量微电子技术,用CPU处理速度来衡量计 算机技术,用信道传输速率来衡量通信技术,那么摩尔定律告诉我们,它们都是以每18个月翻一番的速度在增长,这一势头已经维持了十多年。在美国,广播达到 5000万户用了38年;电视用了13年;Internet拨号上网达到5000万户仅用了4年。全球IP网发展速度达到每6个月翻一番,国内情况亦然。 1999年初,中国上网用户为210万,现在已经达到600万。网络的发展导致经济全球化,在1998年全球产值排序前100名中,跨国企业占了51个, 国家只占49个。有人提出,对待一个跨国企业也许比对待一个国家还要重要。在新世纪钟声刚刚敲响的时候,回顾往昔,人们不仅要问:就推动人类社会进步而 言,历史上能与网络技术相比拟的是什么技术呢?有人甚至提出要把网络技术与火的发明相比拟。火的发明区别了动物和人,种种科学技术的重大发现扩展了自然人 的体能、技能和智能,而网络技术则大大提高了人的生存质量和人的素质,使人成为社会人、全球人。 现在的问题是:网络之后的下一个技术热点是什么?让我们来看一些身边俯拾即是的现象:《纽约时报》由60年代的10~20版扩张至现在的 100~200版,最高曾达1572版;《北京青年报》也已是16~40版;市场营销报已达100版。然而在现实社会中,人均日阅读时间通常为30~45 分钟,只能浏览一份24版的报纸。大量信息在给人们带来方便的同时也带来了一大堆问题:第一是信息过量,难以消化;第二是信息真假难以辨识;第三是信息安 全难以保证;第四是信息形式不一致,难以统一处理。人们开始提出一个新的口号:“要学会抛弃信息”。人们开始考虑:“如何才能不被信息淹没,而是从中及时 发现有用的知识、提高信息利用率?” 面对这一挑战,数据开采和知识发现(DMKD)技术应运而生,并显示出强大的生命力。 1.2 数据爆炸但知识贫乏 另一方面,随着数据库技术的迅速发展以及数据库管理系统的广泛应用,人们积累的数据越来越多。激增的数据背后隐藏着许多重要的信息,人们希望能够对其 进行更高层次的分析,以便更好地利用这些数据。目前的数据库系统可以高效地实现数据的录入、查询、统计等功能,但无法发现数据中存在的关系和规则,无法根 据现有的数据预测未来的发展趋势。缺乏挖掘数据背后隐藏的知识的手段,导致了“数据爆炸但知识贫乏”的现象。 1.3 支持数据挖掘技术的基础

《金融市场数据分析与数据挖掘》教学大纲 二、课程的对象和性质

本课程的授课对象是金融专业的本科生,作为培养学生实际数据获取、数据分析、以及信息获取技能的金融实践性教学课程和选修课程列入金融学专业的教学计划。 三、课程的教学目的和要求 通过本课程的学习,使学生初步掌握金融数据分析的基本方法,掌握几种重要的数据挖掘方法,掌握如何利用计算软件分析数据、解决问题、完成相关研究通过本课程的学习和相关软件的使用,使学生了解数据分析和数据挖掘在金融领域的重要运用,使之能够利用所学到的数据分析与数据挖掘方法开展金融领域的应用研究,并有进一步学习的基础与能力。 四、授课方法 采用理论讲解和上机实验相、课外研究结合的方法。理论讲解利用课堂介绍金融数据挖掘的基本原理和基本方法,上机实验主要是结合具体的金融数据分析和数据挖掘案例学习和掌握如何在相应计算软件上完成数据挖掘与数据分析任务,课外研究则是学生在课程学习的基础上的拓展训练,培养利用数据挖掘方法解决实际问题的能力。 五、理论教学内容与基本要求(含学时分配) 第一章:数据采集与数据处理 课时安排:4课时 教学要求:通过本章学习,使学生理解金融数据的基本类型,初步掌握金融数据的采集方法,能利用相应软件对导入数据进行初步处理。 教学重点与难点:数据挖掘的概念、数据挖掘的主要功能、数据的基本处理方法,本章的难点是数据的基本处理方法。 教学内容: 第一节:理解金融数据 1、非定量性数据 2、数据挖掘,一种从海量数据中挖掘知识的新方法 3、数据挖掘涉及的主要学科领域 4、近年来数据挖掘技术的主要发展和主要应用领域 第二节:数据挖掘的主要功能 1、分类与预测 2、序列发现

第一章 一.填空 1.数据挖掘和知识发现的三大主要技术为:数据库、统计学、机器学习 2.数据挖掘获得知识的表现形式主要有6种:规则、决策树、知识基网络权值、公式、案例 3.规则是由前提条件、结论两部分组成 4.基于案例推理CBR的基础是案例库 5.知识发现的基本步骤:数据选择、处理、转换、数据挖掘、解释与评价。数据挖掘是知识发现的关键步骤 6.数据挖掘的核心技术是:人工智能、机器学、统计学 7.目前数据挖掘在医学领域的应用集中在疾病辅助诊断、药物开发、医院信息系统、遗传学等方面 二.名解 1.数据挖掘DM:在数据中正规的发现有效的、新颖的、潜在有用的、并且最终可以被读懂的模式的过程 2.案例推理CBR:当要解决一个新问题时,CBR利用相似性检索技术到案例库中搜索与新问题相似的案例,再经过对就案例的修改来解决新问题 三.简答 1.数据挖掘的特点 a挖掘对象是超大型的DB,b发现隐含的知识,c可以用于增进人类认知的知识,d不是手工完成的 2.案例是解决新问题的一种知识,案例知识表示为三元组 a问题描述:对求解的问题及周围环境的所有特征的描述,b解描述:对问题求解方案的描述,c效果描述:描述解决方案后的结果情况,是失败还是成功 3.医学数据挖掘存在的关键问题 a数据预处理,b信息融合技术,c快速的鲁棒的书库挖掘算法,d提供知识的准确性和安全性 4.数据挖掘在遗传学方面的应用 遗传学的研究表明,遗传疾病的发生是由基因决定的,基因数据库搜索技术在基因研究上做出了很多重大发现,其工作主要包括:a从各种生物体的大量DNA序列中定位出具有某种功能的基因,b在基因DB中搜索与某种具有高阶结构或功能的蛋白质相似的高阶结构序列 第二章 一.填空 1.DM的对象分为:关系型DB、数据仓库、文本DB、复杂类型DB 2.从用户角度来看,数据仓库的基本组成包括:数据源、数据存储、应用工具、可视化用户界面 3.数据仓库是最流行的数据模型是多维数据模型,多维数据模型将数据看作是数据立方体的形式,数据立方体是由维和事实来定义 4.常用的多维数据模式包括:星型模式、雪花模式、事实星座模式。星型模式是由事实表

1.熟悉数据挖掘的流程: 提示:1)业务理解2)数据理解3)数据准备4)建立模型5)模型评估6)模型发布 2.数据库系统与数据仓库系统的区别: 数据仓库是一个面向主题的、集成的、时变的和非易失的数据集合,支持管理部门的决策过程:而数据库是面向具体操作的、单一的、实时的、更新的数据集合,支持管理机构日常操作的。数据库系统的主要任务是执行联机事务和查询处理,这种系统称为OLTP系统,涵盖了组织机构的大部分日常操作;另一方面,数据仓库在数据分析和决策方面为用户和知识工人提供服务。 3. 数据聚合需考虑的问题; 4. 利用免费商品做促销的关联规则挖掘问题: 1)找到免费商品的频繁1—项集,记为S1。 2)使用FP增长算法生成那些价格不少于$200的频繁项集,记为S2。这是一个单调约束,因此不必要在每一步使用“生成—测试”过程,这样能 节省一些不必要的计算开销。如果我们有一个频繁项价格至少¥200,则 没必要对这个频繁项的任何超集进行测试。这是因为任何其他商品加到 这个频繁项里,价格肯定会增多。需要检验的是超集是否是频繁的。这 里之所以使用FP增长算法的原因是Apriori算法丢弃了那些价格低于 $200的频繁项集。这样导致了将不能够发现满足约束条件的频繁项集。 FP增长算法不会有这样的问题,因为它保留了关于数据库的完整信息在 一个树结构中。 3)从S1S2中找到频繁项集。 4)生成满足最小置信度且形如2 S 的规则。 1S 5.分布式数据的关联规则挖掘方法: 第一.在每一个站点挖掘局部频繁项集,设CF为四个站点的局部频繁项集的并集; 第二.计算CF中每个频繁项集在各个站点的支持度计数;