AIX系统cpu、内存、网卡、硬盘、HBA卡等硬件信息查看

- 格式:docx

- 大小:23.08 KB

- 文档页数:10

小型机、服务器内存和磁盘检查

一、内存检查占用率

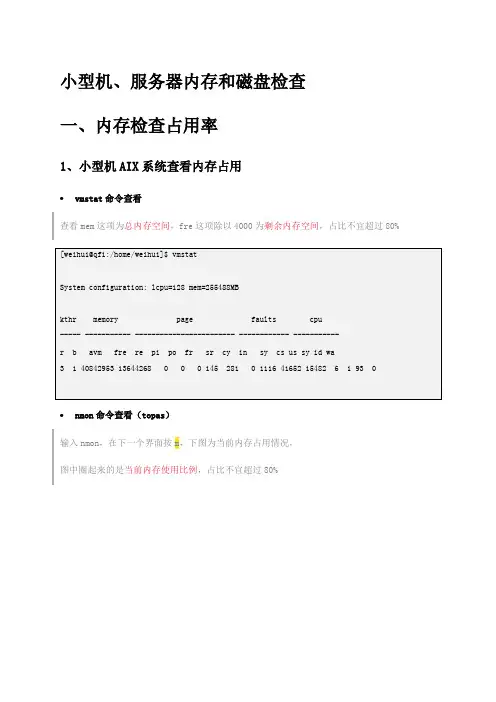

1、小型机AIX系统查看内存占用

•vmstat命令查看

查看mem这项为总内存空间,fre这项除以4000为剩余内存空间,占比不宜超过80%

•nmon命令查看(topas)

输入nmon,在下一个界面按m,下图为当前内存占用情况,

图中圈起来的是当前内存使用比例,占比不宜超过80%

2、服务器LINUX系统查看内存占用

•free命令查看

mem这行为内存,swap这行为交换分区

total这列为总容量,used这列为使用容量,计算占比,即为内存使用率,占比不宜超过80%

•top命令查看

第四行Mem,total为总容量,used为使用容量,计算出来占比即为内存使用率,占比不宜超过80%

二、磁盘空间检查

1、AIX磁盘占用检查

第一步:查看%used这列,使用率有没有超过80%

如果有超过80%的,进入该目录查看,执行第二步、第三步,反复执行

2、LINUX磁盘占用检查

第一步:查看%used这列,使用率有没有超过80%

如果有超过80%的,进入该目录查看,执行第二步、第三步,反复执行

3、SC服务器磁盘占用清理1、2号线数据库备份清理,步骤如下

3号线SC数据库备份清理如下。

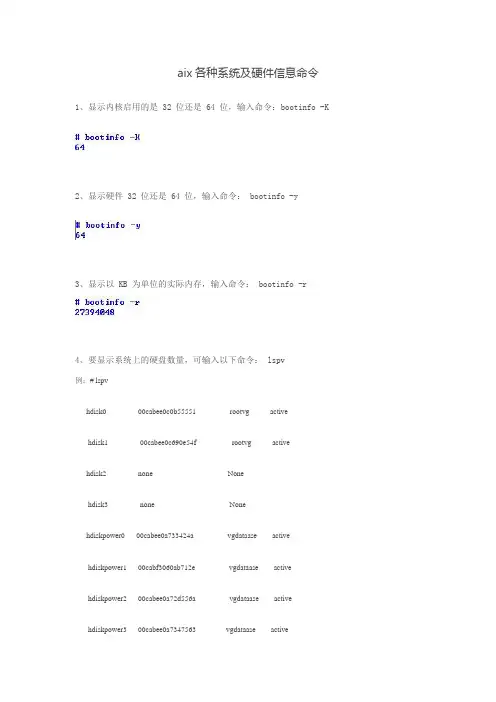

aix各种系统及硬件信息命令1、显示内核启用的是 32 位还是 64 位,输入命令:bootinfo -K2、显示硬件 32 位还是 64 位,输入命令: bootinfo -y3、显示以 KB 为单位的实际内存,输入命令: bootinfo -r4、要显示系统上的硬盘数量,可输入以下命令: lspv例:# lspvhdisk0 00cabee0c0b55551 rootvg active hdisk1 00cabee0c690e54f rootvg activehdisk2 none Nonehdisk3 none Nonehdiskpower0 00cabee0a733424a vgdataase active hdiskpower1 00cabf3060ab712e vgdataase activehdiskpower2 00cabee0a72d556a vgdataase activehdiskpower3 00cabee0a7347563 vgdataase activehdiskpower4 00cabee0a73c768a vgdataase activehdiskpower5 00cabee0a733821c vgdataase activehdiskpower7 00cabee0af63b30e vgsybdata active5、要了解有关 hdisk1 的详细信息,运行命令:lspv hdisk16、要显示您系统上的处理器数量,可输入以下命令: lscfg | grep proc查看其中一个cup主频等详细信息:7、获得系统的详细配置,输入命令:lscfg8、如何确定芯片类型、系统名称、节点名称、型号等?uname命令可以提供关于系统的详细信息。

uname -p 显示系统的芯片类型。

例如,PowerPC。

uname -r 显示操作系统的版本号。

uname -s 显示系统名称。

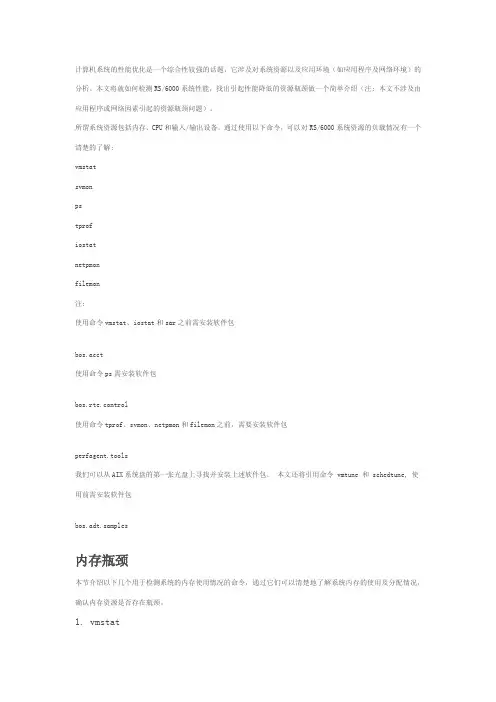

计算机系统的性能优化是一个综合性较强的话题,它涉及对系统资源以及应用环境(如应用程序及网络环境)的分析。

本文将就如何检测RS/6000系统性能,找出引起性能降低的资源瓶颈做一个简单介绍(注: 本文不涉及由应用程序或网络因素引起的资源瓶颈问题)。

所谓系统资源包括内存、CPU和输入/输出设备。

通过使用以下命令,可以对RS/6000系统资源的负载情况有一个清楚的了解:vmstatsvmonpstprofiostatnetpmonfilemon注:使用命令vmstat、iostat和sar之前需安装软件包bos.acct使用命令ps需安装软件包bos.rte.control使用命令tprof、svmon、netpmon和filemon之前,需要安装软件包perfagent.tools我们可以从AIX系统盘的第一张光盘上寻找并安装上述软件包。

本文还将引用命令 vmtune 和 schedtune, 使用前需安装软件包bos.adt.samples内存瓶颈本节介绍以下几个用于检测系统的内存使用情况的命令,通过它们可以清楚地了解系统内存的使用及分配情况,确认内存资源是否存在瓶颈。

1. vmstatvmstat命令用于统计并显示核心线程、虚拟内存、硬盘、中断及CPU的使用情况。

运行命令# vmstat 2 10使用vmstat来进行性能评估,该命令可获得关于系统各种资源之间的相关性能的简要信息。

当然我们也主要用它来看CPU的一个负载情况。

下面是我们调用vmstat命令的一个输出结果:$vmstat 1 2System configuration: lcpu=16 mem=23552MBkthr memory page faults cpu----- ----------- ------------------------ ----------------- -----------r b avm fre re pi po fr sr cy in sy cs us sy id wa0 0 3091988 2741152 0 0 0 0 0 0 1849 26129 4907 8 1 88 30 0 3091989 2741151 0 0 0 0 0 0 2527 32013 6561 15 2 77 6对上面的命令解释如下:Kthr段显示内容• r列表示可运行的内核线程平均数目,包括正在运行的线程和等待 CPU 的线程。

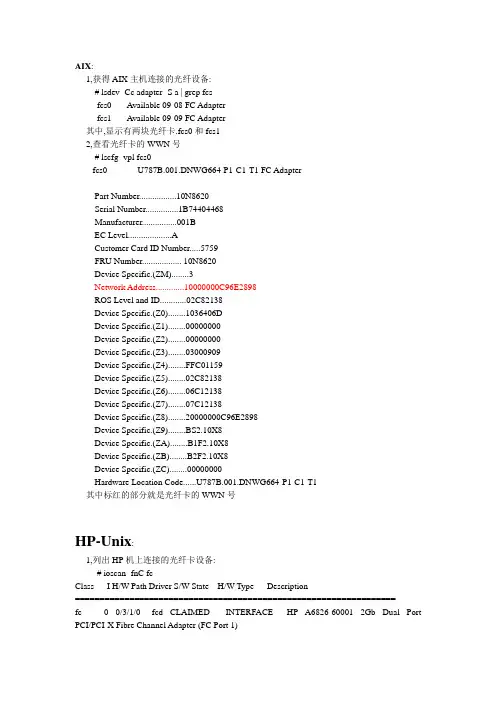

AIX:1,获得AIX主机连接的光纤设备:# lsdev -Cc adapter -S a | grep fcsfcs0 Available 09-08 FC Adapterfcs1 Available 09-09 FC Adapter其中,显示有两块光纤卡.fcs0和fcs12,查看光纤卡的WWN号# lscfg -vpl fcs0fcs0 U787B.001.DNWG664-P1-C1-T1 FC AdapterPart Number.................10N8620Serial Number...............1B74404468Manufacturer................001BEC Level....................ACustomer Card ID Number (5759)FRU Number.................. 10N8620Device Specific.(ZM) (3)Network Address.............10000000C96E2898ROS Level and ID............02C82138Device Specific.(Z0)........1036406DDevice Specific.(Z1) (00000000)Device Specific.(Z2) (00000000)Device Specific.(Z3) (03000909)Device Specific.(Z4)........FFC01159Device Specific.(Z5)........02C82138Device Specific.(Z6)........06C12138Device Specific.(Z7)........07C12138Device Specific.(Z8)........20000000C96E2898Device Specific.(Z9)........BS2.10X8Device Specific.(ZA)........B1F2.10X8Device Specific.(ZB)........B2F2.10X8Device Specific.(ZC) (00000000)Hardware Location Code......U787B.001.DNWG664-P1-C1-T1其中标红的部分就是光纤卡的WWN号HP-Unix:1,列出HP机上连接的光纤卡设备:# ioscan -fnC fcClass I H/W Path Driver S/W State H/W Type Description=================================================================fc 0 0/3/1/0 fcd CLAIMED INTERFACE HP A6826-60001 2Gb Dual Port PCI/PCI-X Fibre Channel Adapter (FC Port 1)/dev/fcd0fc 1 0/3/1/1 fcd CLAIMED INTERFACE HP A6826-60001 2Gb Dual Port PCI/PCI-X Fibre Channel Adapter (FC Port 2)/dev/fcd1由此图可以看到,/dev/fcd0和/dev/fcd1是两个光纤卡2, 查看光纤卡的WWN号# fcmsutil /dev/fcd0Vendor ID is = 0x001077Device ID is = 0x002312PCI Sub-system Vendor ID is = 0x00103cPCI Sub-system ID is = 0x0012baPCI Mode = PCI-X 133 MHzISP Code version = 3.3.18ISP Chip version = 3Topology = PTTOPT_FABRICLink Speed = 2GbLocal N_Port_id is = 0xa10500Previous N_Port_id is = NoneN_Port Node World Wide Name = 0x50060b00001db241N_Port Port World Wide Name = 0x50060b00001db240Switch Port World Wide Name = 0x205e000dec0e2e00Switch Node World Wide Name = 0x2001000dec0e2e01Driver state = ONLINEHardware Path is = 0/3/1/0Maximum Frame Size = 2048Driver-Firmware Dump Available = NODriver-Firmware Dump Timestamp = N/ADriver Version = @(#) libfcd.a HP Fibre Channel ISP 23xx & 24xx Driver B.11.23.04 /ux/core/isu/FCD/kern/src/common/wsio/fcd_init.c:Oct 18 2005,08:21:11其中红色部分显示了HBA卡的WWNN和WWPN号,另外还能看到该HBA卡连接的光纤交换机端口的WWN号Solaris:solaris上用luxadm命令来管理存储设备以及光纤相关设备.1, 查询现有存储设备和光纤设备,可以读到包括磁盘设备的WWN号# luxadm probe2, 查看HBA的prot,可以得到HBA卡的port值以及连接属性:# luxadm -e port/devices/pci@0,0/pci1022,7450@2/pci1077,101@1/fp@0,0:devctl NOT CONNECTED/devices/pci@0,0/pci1022,7450@2/pci1077,101@1,1/fp@0,0:devctl CONNECTED从中可以看到仅有一块光纤卡连接到存储设备3, 选择那个已经连接的HBA卡,查看其WWN号格式: # luxadm -e dump_map 设备port.其中port值可从步骤2得到.如下图啊所示:# luxadm -e dump_map /devices/pci@0,0/pci1022,7450@2/pci1077,101@1/fp@0,0:devctl Pos Port_ID Hard_Addr Port WWN Node WWN Type0 0 0 210000e08b19827a 200000e08b19827a 0x1f (Unknown Type,Host Bus Adapter)Redhat:在Redhat中,设备管理的相关信息都保存在内核中,即/proc目录.所以我们一般查询CPU,内存,磁盘等信息,也是在该目录下. 其中HBA卡相关信息保存在/proc/scsi/qla2300/目录下,不同设备对应不同的文件名,例如# grep scsi /proc/scsi/qla2300/1Number of reqs in pending_q= 0, retry_q= 0, done_q= 0, scsi_retry_q= 0scsi-qla0-adapter-node=200000e08b9cf661;scsi-qla0-adapter-port=210000e08b9cf661;就可以查到系统第一块HBA卡的WWNN和WWPN号.SUSE 下查HBA卡WWN号信息∙在SUSE9下:cat /proc/scsi/qla2xxx/1这个1可能是0,或者2,3等在SUSE10下:∙cat /sys/class/fc_host/host1/node_name有时会是host2或者host3在SUSE9下:cat /proc/scsi/qla2xxx/1这个1可能是0,或者2,3等在SUSE10下:cat /sys/class/fc_host/host1/node_name有时会是host2或者host3。

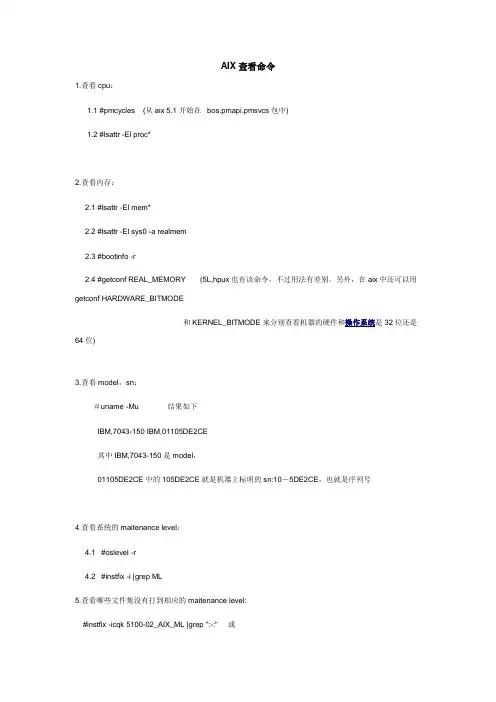

AIX查看命令1.查看cpu:1.1 #pmcycles (从aix 5.1开始在bos.pmapi.pmsvcs包中)1.2 #lsattr -El proc*2.查看内存:2.1 #lsattr -El mem*2.2 #lsattr -El sys0 -a realmem2.3 #bootinfo -r2.4 #getconf REAL_MEMORY (5L,hpux也有该命令,不过用法有差别。

另外,在aix中还可以用getconf HARDWARE_BITMODE和KERNEL_BITMODE来分别查看机器的硬件和操作系统是32位还是64位)3.查看model,sn:#uname -Mu 结果如下IBM,7043-150 IBM,01105DE2CE其中IBM,7043-150是model,01105DE2CE中的105DE2CE就是机器上标明的sn:10-5DE2CE,也就是序列号4.查看系统的maitenance level:4.1 #oslevel -r4.2 #instfix -i |grep ML5.查看哪些文件集没有打到相应的maitenance level:#instfix -icqk 5100-02_AIX_ML |grep ":-:" 或#oslevel -rl 5100-026.查看当前运行的fileset的maintenance level:#lslpp -lnotes:PTF用installp安装,APAR用instfix安装7.installp命令7.1 安装在 软件包中的所有的filesets到/usr/sys/inst.images:#installp avX d /usr/sys/inst.images 7.2 清除一个中断的安装和删除所有没有完成的安装#installp C7.3 提交安装(commit):#installp cgx 或smitty install_commit7.4 删除所有未committed的在./reject.list中的updates,同时将系统带回到以前的maintenance level:#installp rBfx ./reject.list 或smitty install_reject7.5 删除一个安装的软件:#installp ugp V2 .ipsec.rte 或smitty install_remove7.6 列示介质上的所有软件:#installp L d /dev/cd0在超级用户下键入smitty mksysb然后出现对话窗口键入备份装置( 如/dev/rmt0 ),按回车。

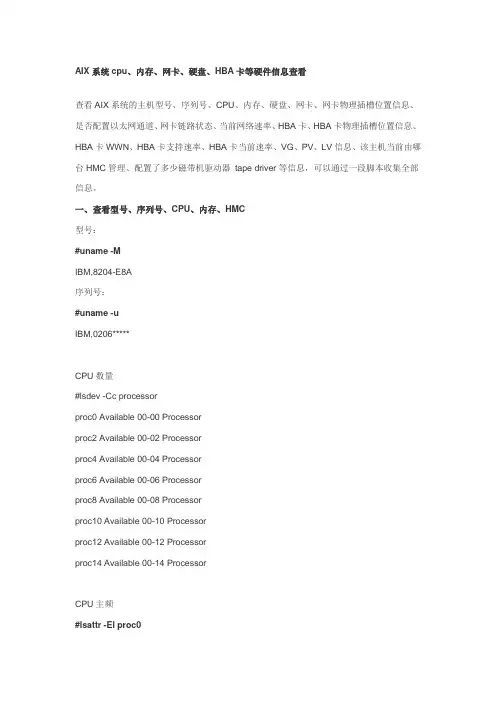

AIX系统cpu、内存、网卡、硬盘、HBA卡等硬件信息查看查看AIX系统的主机型号、序列号、CPU、内存、硬盘、网卡、网卡物理插槽位置信息、是否配置以太网通道、网卡链路状态、当前网络速率、HBA卡、HBA卡物理插槽位置信息、HBA卡WWN、HBA卡支持速率、HBA卡当前速率、VG、PV、LV信息、该主机当前由哪台HMC管理、配置了多少磁带机驱动器tape driver等信息,可以通过一段脚本收集全部信息。

一、查看型号、序列号、CPU、内存、HMC型号:#uname -MIBM,8204-E8A序列号:#uname -uIBM,0206*****CPU数量#lsdev -Cc processorproc0 Available 00-00 Processorproc2 Available 00-02 Processorproc4 Available 00-04 Processorproc6 Available 00-06 Processorproc8 Available 00-08 Processorproc10 Available 00-10 Processorproc12 Available 00-12 Processorproc14 Available 00-14 ProcessorCPU主频#lsattr -El proc0frequency 4204000000 Processor Speed Falsesmt_enabled true Processor SMT enabled Falsesmt_threads 2 Processor SMT threads Falsestate enable Processor state Falsetype PowerPC_POWER6 Processor type False查看CPU是否64位#prtconf -cCPU Type: 64-bit内存信息:#lsattr -El mem0ent_mem_cap I/O memory entitlement in Kbytes Falsegoodsize 63744 Amount of usable physical memory in Mbytes False mem_exp_factor Memory expansion factor Falsesize 63744 Total amount of physical memory in Mbytes Falsevar_mem_weight Variable memory capacity weight False查看该机当前由哪台HMC管理#lsrsrc IBM.ManagementServerResource Persistent Attributes for IBM.ManagementServer resource 1:Name= "123.123.123.9"Hostname= "123.123.123.9"ManagerType= "HMC"LocalHostname= "123.123.234.132"ClusterTM= "9078-160"ClusterSNum= ""ActivePeerDomain = ""NodeNameList= {"testdb1"}型号、序列号、内存统一信息:#lsattr -El sys0fwversion IBM,EL350_085 Firmware version and revision levels False modelname IBM,8204-E8A Machine name Falserealmem 65273856 Amount of usable physical memory in Kbytes False systemid IBM,0206***** Hardware system identifier False二、查看磁盘信息:#lspvhdisk0 00cb01e637be5983 rootvg activehdisk1 00cb01e6dd9045e6 rootvg active#lspathEnabled hdisk0 sas0Enabled hdisk1 sas0Available ses0 sas0Available ses1 sas0列出所有磁盘设备#lsdev -Cc diskhdisk0 Available 02-08-00 SAS Disk Drivehdisk1 Available 02-08-00 SAS Disk Drive查看磁盘容量#bootinfo -s hdisk0140013查看磁盘属性#lsattr -El hdisk0reserve_policy no_reserve Reserve Policy Truesize_in_mb 146800 Size in Megabytes False查看磁盘物理插槽信息#lscfg -vpl hdisk0hdisk0 U78A0.001.DNWK9W6-P2-D3 SAS Disk Drive (146800 MB)Hardware Location Code......U78A0.001.DNWK9W6-P2-D3以上命令适用于现场查看,需要查看哪些硬盘,就执行几条命令,但是当需要用户帮忙采集信息,而系统磁盘数量未知的情况下就难以胜任了,以下脚本列出本机所有磁盘信息并对每个磁盘执行bootinfo -s查看磁盘容量,执行lsattr -El查看磁盘属性、执行lscfg -vpl查看磁盘物理插槽、lspv查看磁盘pv信息等。

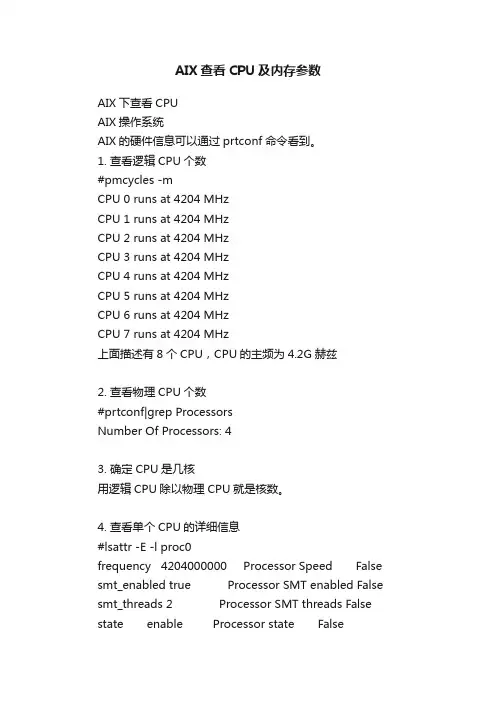

AIX查看CPU及内存参数AIX下查看CPUAIX操作系统AIX的硬件信息可以通过prtconf命令看到。

1. 查看逻辑CPU个数#pmcycles -mCPU 0 runs at 4204 MHzCPU 1 runs at 4204 MHzCPU 2 runs at 4204 MHzCPU 3 runs at 4204 MHzCPU 4 runs at 4204 MHzCPU 5 runs at 4204 MHzCPU 6 runs at 4204 MHzCPU 7 runs at 4204 MHz上面描述有8个CPU,CPU的主频为4.2G赫兹2. 查看物理CPU个数#prtconf|grep ProcessorsNumber Of Processors: 43. 确定CPU是几核用逻辑CPU除以物理CPU就是核数。

4. 查看单个CPU的详细信息#lsattr -E -l proc0frequency 4204000000 Processor Speed False smt_enabled true Processor SMT enabled False smt_threads 2 Processor SMT threads False state enable Processor state Falsetype PowerPC_POWER6 Processor type FalseLinux操作系统Linux下的CPU信息全部都在/proc/cpuinfo这个文件中,可以直接打开看。

1. 查看物理CPU的个数#cat /proc/cpuinfo |grep "physical id"|sort |uniq|wc -l2. 查看逻辑CPU的个数#cat /proc/cpuinfo |grep "processor"|wc -l3. 查看CPU是几核#cat /proc/cpuinfo |grep "cores"|uniq4. 查看CPU的主频#cat /proc/cpuinfo |grep MHz|uniqAix下查看内存命令关键字: aix 内存命令1、# lsdev -Cc memory查看配置的物理内存设备,下面为其输出示例:L2cache0 Available L2 Cachemem0 Available Memory# lsattr -El mem0输出类似如下所示:goodsize 7936 Amount of usable physical memory in MbytesFalsesize 7936 Total amount of physical memory in Mbytes False 此例说明机器的物理内存为5888MB。

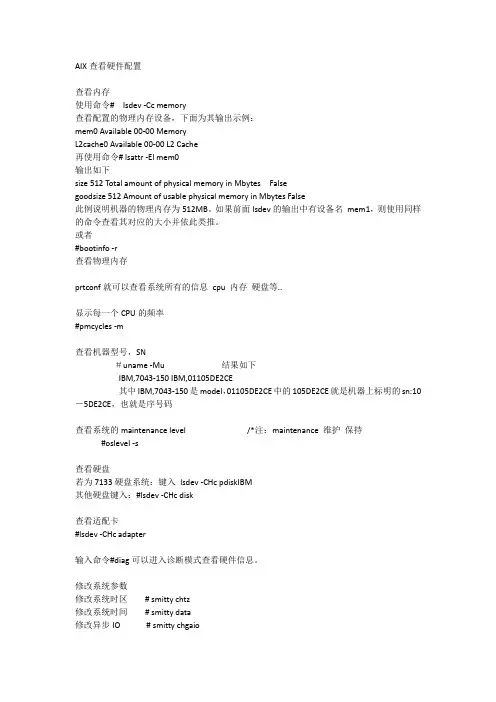

AIX查看硬件配置查看内存使用命令# lsdev -Cc memory查看配置的物理内存设备,下面为其输出示例:mem0 Available 00-00 MemoryL2cache0 Available 00-00 L2 Cache再使用命令# lsattr -El mem0输出如下size 512 Total amount of physical memory in Mbytes Falsegoodsize 512 Amount of usable physical memory in Mbytes False此例说明机器的物理内存为512MB。

如果前面lsdev的输出中有设备名mem1,则使用同样的命令查看其对应的大小并依此类推。

或者#bootinfo -r查看物理内存prtconf就可以查看系统所有的信息cpu 内存硬盘等..显示每一个CPU的频率#pmcycles -m查看机器型号,SN#uname -Mu 结果如下IBM,7043-150 IBM,01105DE2CE其中IBM,7043-150是model,01105DE2CE中的105DE2CE就是机器上标明的sn:10-5DE2CE,也就是序号码查看系统的maintenance level /*注:maintenance 维护保持#oslevel -s查看硬盘若为7133硬盘系统:键入lsdev -CHc pdiskIBM其他硬盘键入:#lsdev -CHc disk查看适配卡#lsdev -CHc adapter输入命令#diag可以进入诊断模式查看硬件信息。

修改系统参数修改系统时区# smitty chtz修改系统时间# smitty data修改异步IO # smitty chgaio更改最大进程数# smitty chgsys更改系统用户数# smitty chlicense配置主机名和IP # smitty mktcpip可以使用#lscfg -vl ent0 命令查看ent0网卡位于哪个扩展槽位上。

最近阿东,给一个客户做测试,客户的环境实在是复杂的一塌糊涂.天知道他们采购的为什么这么多产品,因为主机数量还是很多的,项目很大,为了在后期实施的弟兄们可能会遇到问题,特此分享一个做存储,都需要知道的事情,在不同的操作系统中,查看FC HBA卡信息的方法各有不同,本文就在Windows、Linux、IBM AIX、SUN Solaris、HP-UX 系统下如何查看FC HBA卡的信息作了介绍,供实施相关项目时参考。

在配置磁盘阵列、虚拟带库以及其他带FC HBA卡的设备时,经常需要查看FC HBA卡的WWPN信息以便进行端口添加、ZONE划分等操作,正确查看FC HBA卡的信息是保证顺利施工的前提。

本文主要通过以下3个章节分别讲述在同种系统下查看FC HBA卡信息的方法作一介绍:1 FC HBA卡概述2 Windows系统下查看FC HBA卡的信息3 Linux系统下查看FC HBA卡的信息4 UNIX系统下查看FC HBA卡的信息一.FC HBA卡概述FC HBA,也即Fibre Channel Host Bus Adapter,光纤通道主机适配器,简称光纤适配器。

在FC网络环境中,主机需要和FC网络、FC存储设备(SAN磁盘阵列)连接时需要使用一种接口卡,就如同连接以太网需要以太网卡一样,这种接口卡就叫做FC HBA,简称FC HBA卡。

和以太网卡的MAC地址一样,HBA上也有独一无二的标识,:WWN(World Wide Name),FC HBA上的WWN有两种:① Node WWN(WWNN):每块HBA有其独有的Node WWN;② Port WWN(WWPN):每块HBA卡上每个port有其独一无二的Port WWN。

由于通信是通过port进行的,因此多数情况下需要使用WWPN而不是WWNN。

WWN的长度为8bytes,用16进制表示并用冒号分隔,例如:50:06:04:81:D6:F3:45:42二Windows系统下查看FC HBA卡的信息QLOGIC和EMULEX是全球存储厂商产品配套使常见的FC HBA卡的制造厂商,下面就这两种类型的FC HBA卡在Windows系统下如何查看的方法作以介绍。

AIX怎么查看磁盘内存空间

aix如何查看磁盘空间?下面是店铺为大家介绍aix查看磁盘内存空间的方法,欢迎大家阅读。

aix查看磁盘内存空间的方法

打开电脑,远程连接打开aix系统服务器登陆界面

输入用户名、密码,登陆aix系统服务器。

进入ibm aix系统后,使用aix topas命令,可以看到aix系统的使用情况,aix查看cup使用率。

在命令行中,输入aix命令:df -g,可以看到当前aix系统的磁盘空间使用情况,即可以查看aix磁盘空间。

df命令后面的参数-g,是表示后面显示的磁盘空间大小以G计算并显示。

在命令行中,输入aix命令:du -g,可以看到当前用户目录下面的磁盘文件大小,即可以查看aix文件大小。

du命令后面的参数-g,是表示后面显示的磁盘空间大小、文件大小,以G计算并显示。

AIX系统资源使用情况查看技巧

在AIX系统中,您可以使用一些命令来查看系统资源的使用情况。

以下是一些常用的命令:

1.vmstat:显示虚拟内存统计信息,包括进程状态、内存使用、分页活动等。

2.topas:显示进程活动统计信息,包括CPU使用率、内存使用、I/O活动

等。

3.pstat:显示系统性能统计信息,包括CPU使用率、内存使用、I/O活动等。

4.vmstat结合grep命令可以查看特定进程的资源使用情况。

例如,vmstat

| grep PID可以查看特定进程(PID)的资源使用情况。

5.topas结合grep命令可以查看特定进程的资源使用情况。

例如,topas |

grep PID可以查看特定进程(PID)的资源使用情况。

6.pstat结合grep命令可以查看特定进程的资源使用情况。

例如,pstat -p

PID可以查看特定进程(PID)的资源使用情况。

另外,如果您需要更详细的系统资源使用情况,您可以使用AIX的系统管理工具(如SMIT或SMF),这些工具可以提供更详细的系统资源使用报告和图形化的界面。

对于一个满负荷运行的系统,需要定时检查机器的运行状态,及时了解系统的性能,避免由于机器过负荷的故障。

主要的检查项:CPU、内存、磁盘I/O。

观察主要使用的iostat和vmstat等命令观察。

如图1所示,主要对AIX系统性能进行在线判断的相关命令,其中常用的命令如下的vmstat、iostat、sar、topas、smvon 等,主要介绍vmstat、iostat、sar三个命令。

1 磁盘I/O 监控Iostat可以用来查看系统的 I/O的输入输出情况,在这里主要查看阵列上的硬盘的每秒读写量,同时估算磁盘阵列读写速度。

iostat命令显示结果,如图2所示。

参数说明:● TTY的I/O状态-tin:每秒从tty那里读取的字符数-tout:每秒写到tty那里的字符数其中tty设备包括真实(real)和虚拟 (pseudo)的tty● CPU的使用状态图1 AIX系统性能在线判断的相关命令图2 iostat命令显示结果-% user,表示平均用户占用时间-% sys,表示系统花费CPU时间-% idle,表示CPU空闲时间-% iowait,表示CPU等待I/O所花费时间如果%idle数值都很高而且%iowait数值也很高,大于25,这个说明系统存在I/O或者硬盘瓶颈。

注意:出现瞬间高的值是可能的,比如系统写CDR话单文件的时候。

高数值的%iowait有可能下面几个原因:(1)内存不够而引起频繁的swap空间的数据交换,导致数据存取存在交换空间的 I/O 瓶颈;(2)硬盘上面数据不合理的分布;(3)数据的fragment不合理。

● 硬盘使用状态-% tm_ a c t :表示某个硬盘处于active状态的百分比-tps:表示每秒某个硬盘有多少个数据传输次数-Kb_readKb_wrtn:分别显示从开机到运行iostat这个命令这段时间内对硬盘的read 和write的总数据量,单位kb。

2 内存使用情况监控VMSTAT由于AIX操作系统的内存管理机制与其它UNIX内存管理机制不同,因此其内存分配机制也不一样,在VMSTAT中看到的FREE MEM值并不是真正内存的FREE值。

AIX系统cpu、内存、网卡、硬盘、HBA卡等硬件信息查看查看AIX系统的主机型号、序列号、CPU、内存、硬盘、网卡、网卡物理插槽位置信息、是否配置以太网通道、网卡链路状态、当前网络速率、HBA卡、HBA卡物理插槽位置信息、HBA卡WWN、HBA卡支持速率、HBA卡当前速率、VG、PV、LV信息、该主机当前由哪台HMC管理、配置了多少磁带机驱动器tape driver等信息,可以通过一段脚本收集全部信息。

一、查看型号、序列号、CPU、内存、HMC型号:#uname -MIBM,8204-E8A序列号:#uname -uIBM,0206*****CPU数量#lsdev -Cc processorproc0 Available 00-00 Processorproc2 Available 00-02 Processorproc4 Available 00-04 Processorproc6 Available 00-06 Processorproc8 Available 00-08 Processorproc10 Available 00-10 Processorproc12 Available 00-12 Processorproc14 Available 00-14 ProcessorCPU主频#lsattr -El proc0frequency 4204000000 Processor Speed Falsesmt_enabled true Processor SMT enabled Falsesmt_threads 2 Processor SMT threads Falsestate enable Processor state Falsetype PowerPC_POWER6 Processor type False查看CPU是否64位#prtconf -cCPU Type: 64-bit内存信息:#lsattr -El mem0ent_mem_cap I/O memory entitlement in Kbytes Falsegoodsize 63744 Amount of usable physical memory in Mbytes False mem_exp_factor Memory expansion factor Falsesize 63744 Total amount of physical memory in Mbytes Falsevar_mem_weight Variable memory capacity weight False查看该机当前由哪台HMC管理#lsrsrc IBM.ManagementServerResource Persistent Attributes for IBM.ManagementServer resource 1:Name= "123.123.123.9"Hostname= "123.123.123.9"ManagerType= "HMC"LocalHostname= "123.123.234.132"ClusterTM= "9078-160"ClusterSNum= ""ActivePeerDomain = ""NodeNameList= {"testdb1"}型号、序列号、内存统一信息:#lsattr -El sys0fwversion IBM,EL350_085 Firmware version and revision levels False modelname IBM,8204-E8A Machine name Falserealmem 65273856 Amount of usable physical memory in Kbytes False systemid IBM,0206***** Hardware system identifier False二、查看磁盘信息:#lspvhdisk0 00cb01e637be5983 rootvg activehdisk1 00cb01e6dd9045e6 rootvg active#lspathEnabled hdisk0 sas0Enabled hdisk1 sas0Available ses0 sas0Available ses1 sas0列出所有磁盘设备#lsdev -Cc diskhdisk0 Available 02-08-00 SAS Disk Drivehdisk1 Available 02-08-00 SAS Disk Drive查看磁盘容量#bootinfo -s hdisk0140013查看磁盘属性#lsattr -El hdisk0reserve_policy no_reserve Reserve Policy Truesize_in_mb 146800 Size in Megabytes False查看磁盘物理插槽信息#lscfg -vpl hdisk0hdisk0 U78A0.001.DNWK9W6-P2-D3 SAS Disk Drive (146800 MB)Hardware Location Code......U78A0.001.DNWK9W6-P2-D3以上命令适用于现场查看,需要查看哪些硬盘,就执行几条命令,但是当需要用户帮忙采集信息,而系统磁盘数量未知的情况下就难以胜任了,以下脚本列出本机所有磁盘信息并对每个磁盘执行bootinfo -s查看磁盘容量,执行lsattr -El查看磁盘属性、执行lscfg -vpl查看磁盘物理插槽、lspv查看磁盘pv信息等。

1. echo "#lsdev -Cc disk"2. lsdev -Cc disk3. for i in `lsdev -Cc disk|awk '{print $1}'`;4. do5. echo "nInformation about "$i "n#bootinfo -s" $i6. bootinfo -s $i7. echo "n#lsattr -El" $i8. lsattr -El $i9. echo "n#lscfg -vpl " $i10. lscfg -vpl $i11. echo "n#lspv " $i12. lspv $i13. done复制代码三、查看网卡信息#lsdev -Cc adapter|grep entent0 Available Logical Host Ethernet Port (lp-hea)ent1 Available Logical Host Ethernet Port (lp-hea)ent2 Available 04-00 2-Port 10/100/1000 Base-TX PCI-Express Adapter (14104003)ent3 Available 04-01 2-Port 10/100/1000 Base-TX PCI-Express Adapter (14104003)ent4 Available EtherChannel / IEEE 802.3ad Link Aggregation以上信息显示ent4通过以太网通道绑定后生成的网卡,执行lsattr -El ent4可以查看ent4由哪些网卡绑定而成,是主备模式、负载均衡模式或者负载均衡+主备模式。

#lsattr -El ent4adapter_names ent0 EtherChannel Adapters Trueauto_recovery yes Enable automatic recovery after failover Truebackup_adapter ent2 Adapter used when whole channel fails Truemode standard EtherChannel mode of operation Truenetaddr 0 Address to ping True#lscfg -vpl ent2ent2 U78A0.001.DNWK58T-P1-C1-T1 2-Port 10/100/1000 Base-TX PCI-Express Adapter (14104003)Hardware Location Code......U78A0.001.DNWK58T-P1-C1-T1#lsattr -El en4netaddr 123.123.123.61 Internet Address Truenetmask 255.255.255.128 Subnet Mask Truestate up Current Interface Status True#netstat -in#netstat -rn#ifconfig -a#ifconfig -l查看网卡当前连接状态、链路速率#netstat -v en4 |grep -i SpeedMedia Speed Selected: AutonegotiateMedia Speed Running: 1000 Mbps / 1 Gbps, Full DuplexExternal-Network-Switch (ENS) Port Speed: 1000 Mbps / 1 Gbps, Full Duplex Media Speed Selected: Auto negotiationMedia Speed Running: 1000 Mbps Full Duplex在网卡数量未知的情况下,可以采用以下脚本一次性收集所有网卡信息:1. echo "#lsdev -Cc adapter|grep ent"2. lsdev -Cc adapter|grep ent3. for i in `lsdev -Cc adapter|awk '{print $1}' |grep ent`;4. do5. echo "nInformation about "$i "n#lsattr -El" $i6. lsattr -El $i7. echo "n#lscfg -vl " $i8. lscfg -vl $i9. done10. for i in `ifconfig -l`;11. do12. echo "nInformation about "$i "n#lsattr -El" $i13. lsattr -El $i14. echo "n#netstat -v " $i15. netstat -v $i16. echo "n#netstat -v " $i "|grep -i Speed"17. netstat -v $i |grep -i Speed18. done复制代码四、HBA卡信息#lsdev -Cc adapter|grep fcsfcs0 Available 01-08 FC Adapterfcs1 Available 01-09 FC Adapterfcs2 Available 04-08 FC Adapterfcs3 Available 04-09 FC Adapter#lsattr -El fcs0查看HBA卡的物理插槽、WWN:#lscfg -vpl fcs0fcs0 U78A0.001.DNWK9W6-P1-C4-T1 FC AdapterNetwork Address.............10000000C9B54A92Hardware Location Code......U78A0.001.DNWK9W6-P1-C4-T1以上Network Address即为fcs0的WWN。