hadoop安装全教程(1)

- 格式:doc

- 大小:1.69 MB

- 文档页数:31

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

Hadoop集群安装详细步骤亲测有效第一步:准备硬件环境- 64位操作系统,可以是Linux或者Windows-4核或更高的CPU-8GB或更高的内存-100GB或更大的硬盘空间第二步:准备软件环境- JDK安装:Hadoop运行需要Java环境,所以我们需要先安装JDK。

- SSH配置:在主节点和从节点之间建立SSH连接是Hadoop集群正常运行的前提条件,所以我们需要在主节点上生成SSH密钥,并将公钥分发到从节点上。

第四步:配置Hadoop- core-site.xml:配置Hadoop的核心参数,包括文件系统的默认URI和临时目录等。

例如,可以将`hadoop.tmp.dir`设置为`/tmp/hadoop`。

- hdfs-site.xml:配置Hadoop分布式文件系统的参数,包括副本数量和块大小等。

例如,可以将副本数量设置为`3`。

- yarn-site.xml:配置Hadoop的资源管理系统(YARN)的参数。

例如,可以设置YARN的内存资源分配方式为容器的最大和最小内存均为1GB。

- mapred-site.xml:配置Hadoop的MapReduce框架的参数。

例如,可以设置每个任务容器的内存限制为2GB。

第五步:格式化Hadoop分布式文件系统在主节点上执行以下命令,格式化HDFS文件系统:```hadoop namenode -format```第六步:启动Hadoop集群在主节点上执行以下命令来启动Hadoop集群:```start-all.sh```此命令将启动Hadoop的各个组件,包括NameNode、DataNode、ResourceManager和NodeManager。

第七步:测试Hadoop集群可以使用`jps`命令检查Hadoop的各个进程是否正常运行,例如`NameNode`、`DataNode`、`ResourceManager`和`NodeManager`等进程都应该在运行中。

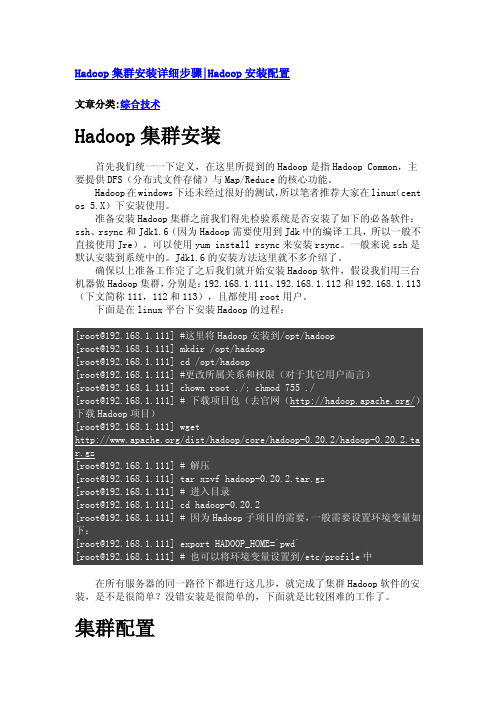

Hadoop集群安装详细步骤|Hadoop安装配置文章分类:综合技术Hadoop集群安装首先我们统一一下定义,在这里所提到的Hadoop是指Hadoop Common,主要提供DFS(分布式文件存储)与Map/Reduce的核心功能。

Hadoop在windows下还未经过很好的测试,所以笔者推荐大家在linux(cent os 5.X)下安装使用。

准备安装Hadoop集群之前我们得先检验系统是否安装了如下的必备软件:ssh、rsync和Jdk1.6(因为Hadoop需要使用到Jdk中的编译工具,所以一般不直接使用Jre)。

可以使用yum install rsync来安装rsync。

一般来说ssh是默认安装到系统中的。

Jdk1.6的安装方法这里就不多介绍了。

确保以上准备工作完了之后我们就开始安装Hadoop软件,假设我们用三台机器做Hadoop集群,分别是:192.168.1.111、192.168.1.112和192.168.1.113(下文简称111,112和113),且都使用root用户。

下面是在linux平台下安装Hadoop的过程:在所有服务器的同一路径下都进行这几步,就完成了集群Hadoop软件的安装,是不是很简单?没错安装是很简单的,下面就是比较困难的工作了。

集群配置根据Hadoop文档的描述“The Hadoop daemons are N ameNode/DataNode and JobTracker/TaskTracker.”可以看出Hadoop核心守护程序就是由NameNode/DataNode 和JobTracker/TaskTracker这几个角色构成。

Hadoop的DFS需要确立NameNode与DataNode角色,一般NameNode会部署到一台单独的服务器上而不与DataNode共同同一机器。

另外Map/Reduce服务也需要确立JobTracker和TaskTracker的角色,一般JobTracker与NameNode共用一台机器作为master,而TaskTracker与DataNode同属于slave。

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

1.下载并安装安装sshsudo apt-get install openssh-server openssh-client3.搭建vsftpd#sudo apt-get update#sudo apt-get install vsftpd配置参考的开始、关闭和重启$sudo /etc/vsftpd start #开始$sudo /etc/vsftpd stop #关闭$sudo /etc/vsftpd restart #重启4.安装sudo chown -R hadoop:hadoop /optcp /soft/ /optsudo vi /etc/profilealias untar='tar -zxvf'sudo source /etc/profilesource /etc/profileuntar jdk*环境变量配置# vi /etc/profile●在profile文件最后加上# set java environmentexport JAVA_HOME=/opt/export CLASSPATH=.:$JAVA_HOME/lib/:$JAVA_HOME/lib/ export PATH=$JAVA_HOME/bin:$PATH配置完成后,保存退出。

●不重启,更新命令#source /etc/profile●测试是否安装成功# Java –version其他问题:出现unable to resolve host 解决方法参考开机时停在Starting sendmail 不动了的解决方案参考安装软件时出现E: Unable to locate package vsftpd 参考vi/vim 使用方法讲解参考分类: Hadoop--------------------------------------------克隆master虚拟机至node1 、node2分别修改master的主机名为master、node1的主机名为node1、node2的主机名为node2 (启动node1、node2系统默认分配递增ip,无需手动修改)分别修改/etc/hosts中的ip和主机名(包含其他节点ip和主机名)---------配置ssh免密码连入hadoop@node1:~$ ssh-keygen -t dsa -P ''-f ~/.ssh/id_dsaGenerating public/private dsa key pair.Created directory '/home/hadoop/.ssh'.Your identification has been saved in/home/hadoop/.ssh/id_dsa.Your public key has been saved in/home/hadoop/.ssh/.The key fingerprint is:SHA256:B8vBju/uc3kl/v9lrMqtltttttCcXgRkQPbVoU hadoop@node1The key's randomart image is:+---[DSA 1024]----+|....||o+.E .||. oo +||..++||o +.o ooo +||=o.. o. ooo. o.||*o....+=o .+++.+|+----[SHA256]-----+hadoop@node1:~$ cd .sshhadoop@node1:~/.ssh$ ll总用量16drwx------ 2 hadoop hadoop 4096 Jul 24 20:31 ./drwxr-xr-x 18 hadoop hadoop 4096 Jul 2420:31../-rw------- 1 hadoop hadoop 668 Jul 24 20:31 id_dsa-rw-r--r-- 1 hadoop hadoop 602 Jul 24 20:31hadoop@node1:~/.ssh$ cat >> authorized_keyshadoop@node1:~/.ssh$ ll总用量20drwx------ 2 hadoop hadoop 4096 Jul 24 20:32 ./drwxr-xr-x 18 hadoop hadoop 4096 Jul 2420:31../-rw-rw-r-- 1 hadoop hadoop 602 Jul 24 20:32 authorized_keys-rw------- 1 hadoop hadoop 668 Jul 24 20:31 id_dsa-rw-r--r-- 1 hadoop hadoop 602 Jul 24 20:31单机回环ssh免密码登录测试hadoop@node1:~/.ssh$ ssh localhostThe authenticity of host'localhost ' can't be established.ECDSA key fingerprint is SHA256:daO0dssyqt12tt9yGUauImOh6tt6A1SgxzSfSmpQqJVEiQTxas. Are you sure you want to continue connecting (yes/no) yesWarning: Permanently added 'localhost'(ECDSA)to the list of known hosts.Welcome to Ubuntu (GNU/Linux x86_64)* Documentation:packages can be updated.178 updates are security updates.New release' LTS' available.Run 'do-release-upgrade'to upgrade to it.Last login: Sun Jul 2420:21:392016from exit注销Connection to localhost closed.hadoop@node1:~/.ssh$出现以上信息说明操作成功,其他两个节点同样操作让主结点(master)能通过SSH免密码登录两个子结点(slave)hadoop@node1:~/.ssh$ scp hadoop@master:~/.ssh/./The authenticity of host'master ' can't be established.ECDSA key fingerprint is SHA256:daO0dssyqtt9yGUuImOh646A1SgxzSfatSmpQqJVEiQTxas.Are you sure you want to continue connecting (yes/no) yesWarning: Permanently added 'master,'(ECDSA)to the list of known hosts.hadoop@master's password:100%603s 00:00 hadoop@node1:~/.ssh$ cat >> authorized_keys如上过程显示了node1结点通过scp命令远程登录master结点,并复制master的公钥文件到当前的目录下,这一过程需要密码验证。

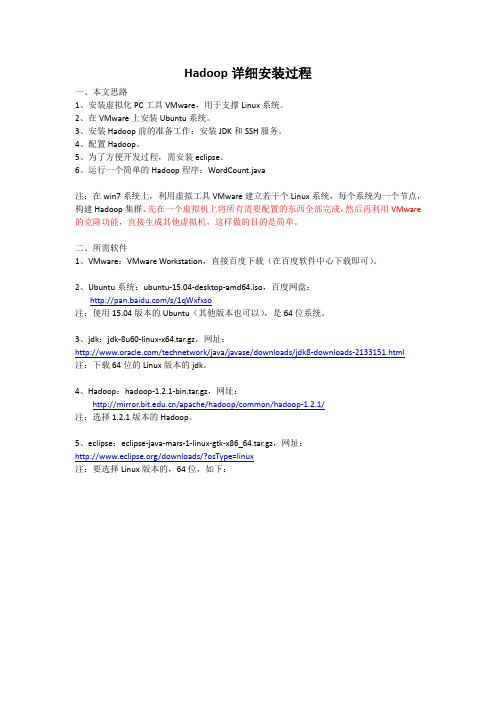

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

简述hadoop安装步骤简述hadoop安装步骤安装步骤:1、安装虚拟机系统,并进⾏准备⼯作(可安装- ⼀个然后克隆)2.修改各个虚拟机的hostname和host3.创建⽤户组和⽤户4、配置虚拟机⽹络,使虚拟机系统之间以及和host主机之间可以通过相互ping通。

5.安装jdk和配置环境变量,检查是否配置成功6、配置ssh,实现节点间的⽆密码登录ssh node1/2指令验证时候成功7、master 配置hadoop,并将hadoop⽂件传输到node节点8、配置环境变量,并启动hadoop, 检查是否安装成功,执⾏wordcount检查是否成功。

⼆.HDFS作⽤是什么Hadoop分布式⽂件系统(HDFS)是指被设计成适合运⾏在通⽤硬件(commodity hardware)上的分布式⽂件系统(Distributed File System)。

它和现有的分布式⽂件系统有很多共同点。

但同时,它和其他的分布式⽂件系统的区别也是很明显的。

HDFS是⼀个⾼度容错性的系统,适合部署在廉价的机器上。

HDFS能提供⾼吞吐量的数据访问,⾮常适合⼤规模数据集上的应⽤。

HDFS放宽了⼀部分POSIX约束,来实现流式读取⽂件系统数据的⽬的。

HDFS在最开始是作为Apache Nutch搜索引擎项⽬的基础架构⽽开发的。

HDFS是Apache Hadoop Core项⽬的⼀部分。

HDFS有着⾼容错性(fault-tolerant)的特点,并且设计⽤来部署在低廉的(low-cost)硬件上。

⽽且它提供⾼吞吐量(high throughput)来访问应⽤程序的数据,适合那些有着超⼤数据集(large data set)的应⽤程序。

HDFS放宽了(relax)POSIX的要求(requirements)这样可以实现流的形式访问(streaming access)⽂件系统中的数据。

三.常⽤的Hadoop FS Shell命令有哪些及其作⽤1.调⽤Hadoop的⽂件系统Shell(FileSystem Shell)的命令格式:语法:hadoop fs <args>:前提是位置位于hadoop/bin下,其中fs是参数,表⽰FS Shell,<args>是fs的⼦命令2.使⽤FS Shell命令⾏管理⽂件:mkdir -创建⽬录语法:hadoop fs -mkdir <paths>例⼦:hadoop fs -mkdir /user:在HDFS中创建"/user"⽬录hadoop fs -mkdir /user/hadoop:在HDFS中创建"/user/hadoop"⽬录hadoop fs -mkdir /user/hadoop/dir1 /user/hadoop/dir2:在HDFS中同时创建"/user/hadoop/dir1"和"/user/hadoop/dir2",⽬录ls -查看列表⽂件语法:hadoop fs -ls <args>如果是⽂件,则按照如下格式返回⽂件信息:⽂件名<副本数> ⽂件⼤⼩修改⽇期修改时间权限⽤户ID 组ID如果是⽬录,则返回它直接⼦⽂件的⼀个列表cat -查看⽂件语法:hadoop fs -cat URI <URI...>:输出路径指定⽂件的内容例⼦:hadoop fs -cat /input2/file1.txt /input2/file2.txt:在HDFS中查看input2⽬录下的file1.txt和file2.txt的⽂件内容put -从本地⽂件系统中复制⼀个或多个⽂件到HDFS(外部命令)语法:hadoop fs -put <localsrc>...<dst>其中localsrc只能是本地⽂件,dst只能是HDFS⽂件,且不受fs.defaultFS属性影响。

hadoop安装步骤1.准备Linux环境1.0先将虚拟机的⽹络模式选为NAT1.1修改主机名 hostnamectl set-hostname server11.2修改IP 修改配置⽂件⽅式(修改的是⽹卡信息 ip a 查看⽹卡),第⼀次启动时没有ip的,需要将⽹卡配置之中 ONBOOT=yes, 然后重启⽹络vim /etc/sysconfig/network-scripts/ifcfg-eth0DEVICE="eth0"BOOTPROTO="static"###HWADDR="00:0C:29:3C:BF:E7"IPV6INIT="yes"NM_CONTROLLED="yes"ONBOOT="yes"TYPE="Ethernet"UUID="ce22eeca-ecde-4536-8cc2-ef0dc36d4a8c"IPADDR="192.168.1.101"###NETMASK="255.255.255.0"###GATEWAY="192.168.1.1"###1.3修改主机名和IP的映射关系(每台机器都要有)192.168.33.101 server1192.168.33.102 server2192.168.33.103 server31.4关闭防⽕墙#查看防⽕墙状态service iptables status#关闭防⽕墙service iptables stop#查看防⽕墙开机启动状态chkconfig iptables --list#关闭防⽕墙开机启动chkconfig iptables off1.5 关闭linux服务器的图形界⾯:vi /etc/inittab1.6重启Linuxreboot2.安装JDK#创建⽂件夹mkdir /home/hadoop/app#解压tar -zxvf jdk-7u55-linux-i586.tar.gz -C /home/hadoop/app2.3将java添加到环境变量中(如果在 .bashrc 之中配置了java环境变量,hadoop 是不需要指定 JAVA_HOME,如果在 /etc/profile 需要指定,因为 ssh 默认不会加载 /et/profile) vim ~/.bashrc#在⽂件最后添加export JAVA_HOME=/home/hadoop/app/jdk-7u_65-i585export PATH=$PATH:$JAVA_HOME/bin#刷新配置source ~/.bashrc3.安装hadoop2.4.1(要保证以下⽂件都有读写权限)先上传hadoop的安装包到服务器上去/home/hadoop/分布式需要修改5个配置⽂件3.1配置hadoopvim hadoop-env.shexport JAVA_HOME=/home/hadoop/app/jdk-7u_65-i585第⼆个:core-site.xml<!-- 指定HADOOP所使⽤的⽂件系统schema(URI),HDFS的⽼⼤(NameNode)的地址 --><property><name>fs.defaultFS</name><value>hdfs://server1:9000</value><!--hadoop 的默认⽤户--><property><name>er</name><value>master</value></property><!--datanode.data.dir 存储⽂件⽬录, .dir 元数据,namenode.edits.dir ⽇志⽬录三者都依赖于此⽬录--> <property><name>hadoop.tmp.dir</name><value>/opt/modules/hadoop-2.7.0/data/tmp</value></property>第三个:hdfs-site.xml<!--其他⽤户使⽤hdfs 操作⽂件,是否进⾏验证!--><property><name>dfs.permissions</name><value>false</value></property>第四个:mapred-site.xml (mv mapred-site.xml.template mapred-site.xml)<property><name></name><value>yarn</value></property><!--⽇志页⾯的显⽰ ip:port--><property><name>mapreduce.jobhistory.address</name><value>sserver1:10020</value></property><!--运⾏ yarn 任务跳转的页⾯--><property><name>mapreduce.jobhistory.webapp.address</name><value>server1:19888</value></property>第五个:yarn-site.xml<property><name>yarn.resourcemanager.hostname</name><value>server1</value></property><!-- reducer获取数据的⽅式,⼀种辅助 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!--开启⽇志聚集--><property><name>yarn.log-aggregation-enable</name><value>true</value></property><!--⽇志存放的时间(s)--><property><name>yarn.log-aggregation.retain-seconds</name><value>100000</value></property>第六个 salves(代表着 DataNode个数, 在sbin/slaves 之中 ssh 遍历连接)server1server2server33.2将hadoop添加到环境变量vim /etc/proflieexport JAVA_HOME=/usr/java/jdk1.7.0_65export HADOOP_HOME=/master/hadoop-2.4.1export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbinsource /etc/profile3.3 将 app ⽂件夹配置到其他的节点之上(节点信息与master配置信息是⼀样的)scp -r app/ hdp-node-01:/home/slave3.4 格式化namenode(是对namenode进⾏初始化)hdfs namenode -format (hadoop namenode -format)3.5启动hadoop先启动HDFSsbin/start-dfs.shsbin/start-yarn.sh3.6验证是否启动成功使⽤jps命令验证27408 NameNode28218 Jps27643 SecondaryNameNode28066 NodeManager27803 ResourceManager27512 DataNodehttp://192.168.1.101:50070 (HDFS管理界⾯)http://192.168.1.101:8088 (MR管理界⾯)4.配置ssh免登陆#⽣成ssh免登陆密钥#进⼊到我的home⽬录cd ~ssh-keygen -t rsa #四个回车#执⾏完这个命令后,会⽣成两个⽂件id_rsa(私钥)、id_rsa.pub(公钥)# master ,authorized_keys ⽂件(新⽣成)ssh-copy-id -i ~/.ssh/id_rsa.pub localhost#slave, authorized_keys ⽂件(新⽣成),此处是在 /etc/hosts 写⼊的(集群是相同的⽤户名) ssh-copy-id -i ~/.ssh/id_rsa.pub server15,注:更改⽂件夹权限更改⽂件夹权限# 切换超级权限su# 当前⽂件夹所有的⽤户与组chown -R hadoop:hadoop *。

Hadoop安装教程_伪分布式配置_CentOS6.4/Hadoop2.6.0都能顺利在CentOS 中安装并运行Hadoop。

环境本教程使用CentOS 6.4 32位作为系统环境,请自行安装系统(可参考使用VirtualBox安装CentOS)。

如果用的是Ubuntu 系统,请查看相应的Ubuntu安装Hadoop教程。

本教程基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1, Hadoop 2.4.1等。

Hadoop版本Hadoop 有两个主要版本,Hadoop 1.x.y 和Hadoop 2.x.y 系列,比较老的教材上用的可能是0.20 这样的版本。

Hadoop 2.x 版本在不断更新,本教程均可适用。

如果需安装0.20,1.2.1这样的版本,本教程也可以作为参考,主要差别在于配置项,配置请参考官网教程或其他教程。

新版是兼容旧版的,书上旧版本的代码应该能够正常运行(我自己没验证,欢迎验证反馈)。

装好了CentOS 系统之后,在安装Hadoop 前还需要做一些必备工作。

创建hadoop用户如果你安装CentOS 的时候不是用的“hadoop” 用户,那么需要增加一个名为hadoop 的用户。

首先点击左上角的“应用程序” -> “系统工具” -> “终端”,首先在终端中输入su,按回车,输入root 密码以root 用户登录,接着执行命令创建新用户hadoop:如下图所示,这条命令创建了可以登陆的hadoop 用户,并使用/bin/bash 作为shell。

CentOS创建hadoop用户接着使用如下命令修改密码,按提示输入两次密码,可简单的设为“hadoop”(密码随意指定,若提示“无效的密码,过于简单”则再次输入确认就行):可为hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题,执行:如下图,找到root ALL=(ALL) ALL这行(应该在第98行,可以先按一下键盘上的ESC键,然后输入:98 (按一下冒号,接着输入98,再按回车键),可以直接跳到第98行),然后在这行下面增加一行内容:hadoop ALL=(ALL) ALL(当中的间隔为tab),如下图所示:为hadoop增加sudo权限添加上一行内容后,先按一下键盘上的ESC键,然后输入:wq (输入冒号还有wq,这是vi/vim编辑器的保存方法),再按回车键保存退出就可以了。

Temp 01 安装JAVA

进入终端的命令是Ctrl + Alt + T

以下hadoop-machine与h1是同一用户名,不影响安装

1.打开终端,建立新目录“/usr/lib/java”,如下图所示

输入密码回车。

2.把下载的JDK 文件移到刚刚创建的“/usr/lib/java”中,如下图所示

1.解压jdk

解压完成后ll查看文件如图

2.修改环境变量

1)安装vim 工具

Y继续

2)修改环境变量

按一下键盘上的i 键进入插入状态

在文档最下边输入

Ps:不同路径之间用“:“分割不是“;“按Esc 键输入:wq 回车

执行以下命令是配置文件的修改生效:

查看java版本:检查环境变量是否配置成功

至此JAVA 安装完毕。

Temp 02安装ssh 并配置SSH免密码登陆02.01 安装SSH

ssh配置

注意主机与节点用户名要相同,否则不能免密码登陆,切记

以下用户名hadoop与grid我们认为是同一用户名,对安装无影响,只要你自己的主机用户名与节点用户名相同就可以

每个节点作相同操作

一路回车直到。

然后::

分发ssh公钥

把各个节点的authorized_keys的内容互相拷贝加入到对方的此文件中,然后就可以免密码彼此ssh连入

重启各节点及主机

测试免密码登陆是否成功

无需输入密码登陆SSH 成功~

Exit 退出

Temp 03 安装hadoop 解压hadoop 并移动到/usr/local/hadoop 中

修改hadoop文件夹所有者~

在hadoop-env.sh 配置Java 安装信息.

进入/usr/local/hadoop/conf

打开hadoop-env.sh:

在大概第10行的位置加入以下信息(在最后加应该也好使)

保存退出

使配置生效

创建tmp文件夹

配置core-site.xml

保存并退出

配置hdfs-site.Xml

此处3为节点数,,根据实际情况自行修改配置mapred-site.xml

配置主节点Namenode

配置datanode

配置hadoop的环境变量

重命名机器

第一台做namenode节点

保存关闭

关闭系统

保存退出(系统为重启之前,主机名修改无效)Temp 04修改各节点IP

可以查看到我的IP是

编辑链接信息

点击编辑选择IPV4

以上信息除了地址修改外其他和刚开始查看到的信息一致保存

同理修改hadoopdata1 为192.168.233.102修改hadoopdata1 为192.168.233.103 在hadoopnamenode里配置主机信息

保存退出

同样修改hadoopdata1 和hadoopdata2 的hosts

可以只写本身节点和namenode节点的IP,

例如hadoopdata1的修改为下图

Hadoopdata2的修改为下图

将所有节点重启

让SSH 发现所有节点

Yes 继续

登陆成功

退出

然后对hadoopnamenode,hadoopdata2 做同样的操作向各节点复制hadoop

.......

接下来进行hadoop 的namenode 格式化:

启动hadoop服务

此时hadoopnamenode使用jps 查看后台进程:

Hadoopdata1 使用jps 查看后台进程:

如果节点jps没有datanode,可把节点hadoop下data文件夹删除重启服务即可。

关闭hadoop(在hadoopnamenode操作)

Temp 05 Eclipse集成开发05.01 安装Eclipse

找到下载好的安装包,解压

移动文件夹

到文件夹/usr/local/eclipse下启动eclipse 会出现如下错误

1 解决办法:将jdk文件夹下的jre文件夹拷贝到eclipse下即可

OK..再启动eclipse 成功。

05.02 安装had oop-eclipse-plugin

将hadoop-eclipse-plugin-1.1.2复制到/eclipse/plugins/ 下

重启Eclipse 启动Eclipse后:

点击Browse 找到hadoop安装的文件夹

找到OK

点击这个大象

修改

Finish

这样在左边的文件目录下就能够看到整个hdfs的文件夹了

若果出现链接失败的话可能是你的hadoop没有开启

Temp 06 安装Zookeeper 06.01 解压Zookeeper

进入到下载文件夹

06.02 修改配置

进入到文件夹zookeeper/conf 复制一份zoo_sample.cfg 重命名为zoo.cfg 打开zoo.cfg

修改dataDir

在zookeeper 文件夹下边新建文件夹datadir

在datadir文件夹下创建文件myid 编辑里边内容为1

用scp文件夹将zookeeper文件夹发送到hadoopdata1 和hadoopdata2上

由于权限问题不能直接将zookeeper发送到/usr/local 下(需要root密码可以自己尝试先修改密码再发送)这里先发送到下载文件夹下然后再移动

在hadoopdata1 hadoopdata2节点执行移动命令

同时将hadoopdata1 zookeeper/datadir/myid 改成2

hadoopdata2 zookeeper/datadir/myid 改成3

这里应该紧跟着修改环境变量但是按照hbase之后还需要修改环境变量所以这里先跳过

Temp 07 安装hbase

和zookeeper一样先解压hbase

然后移动hbase 到/usr/local 文件夹下

配置Hbase-site.xml(参照我的云空间hadoop/配置文件里)

修改Hbase-env.sh

将文件hadoop/conf/hdfs-site.xml 复制到hbase/conf/ 下修改环境变量将zoo.cfg 添加到环境变量中

在cof/regionservers中添加所有datanode节点

将hbase发送到各个datanode上并修改环境变量

环境变量修改完事后记得生效

OK 整个集群搭建完毕

开启集群的方法:。