模式识别

ch2 贝叶斯决策

1.贝叶斯公式

2.贝叶斯决策的特例

a)先验概率相同(均匀先验概率):决策仅依赖于类条件概率密度

b)类条件概率密度相同:决策仅依赖于先验概率

3.计算题(医学测试方法)

4.计算题(车身高低)

5.贝叶斯决策的最优性

a)最小化误差概率的角度

i.每次均选择概率大的类做判断结果,因此错误概率永远是最小的

b)最小化风险的角度

i.每次均选择条件风险最小的结果,因此总风险最小

6.对于两类分类问题,最小风险贝叶斯决策

a)可以基于似然比进行决策

b)p(x|ω1)

p(x|ω2)≥λ12?λ22

λ21?λ11

p(ω2)

p(ω1)

则判断为1类,否则为2类

c)似然比超过某个阈值(θ),那么可判决为ω1类

7.0-1损失(误判是等价的):最小化风险就是最大化后验,也就是选择后验最大的

a)最小化误差概率与最小化风险等价,即选择最大后验的分类,即满足最小误差概率,也满足最小风

险

8.先验概率未知时如何设计风险最小的分类器?

a)使先验概率取任意值时的总风险的最坏情况尽可能小

b)极小化极大准则:

i.极小化指的是贝叶斯风险,因为它是总风险的最小值

ii.极大化指的是使贝叶斯风险达到最大

iii.贝叶斯风险是和先验有关的,其最大也就是其极值,就是导数等于0 的时候

c)极小化极大风险是最坏的贝叶斯风险

9.从最小化误差概率的意义上讲,贝叶斯是最优的;贝叶斯决策得到的总风险也是最小的

10.判别函数

a)对于两类分类,根据判别函数的正负进行类的判断;对于多类问题,两两组成两类问题

b)两类问题下:g(x)=g1(x)?g2(x)

i.若g(x)≥0,即g1(x)≥g2(x),则判断为1类,否则为2类

c)g1(x),g2(x)的设计

i.最小总风险贝叶斯分类器

1.g1(x)=?R(α1|x),风险的相反数

ii.最小误差概率贝叶斯分类器

1. g 1(x )=p (ω1|x )

2. g 1(x )=p (x|ω1)p (ω1)

3. g 1(x )=log(p (x|ω1))+log(p (ω1))

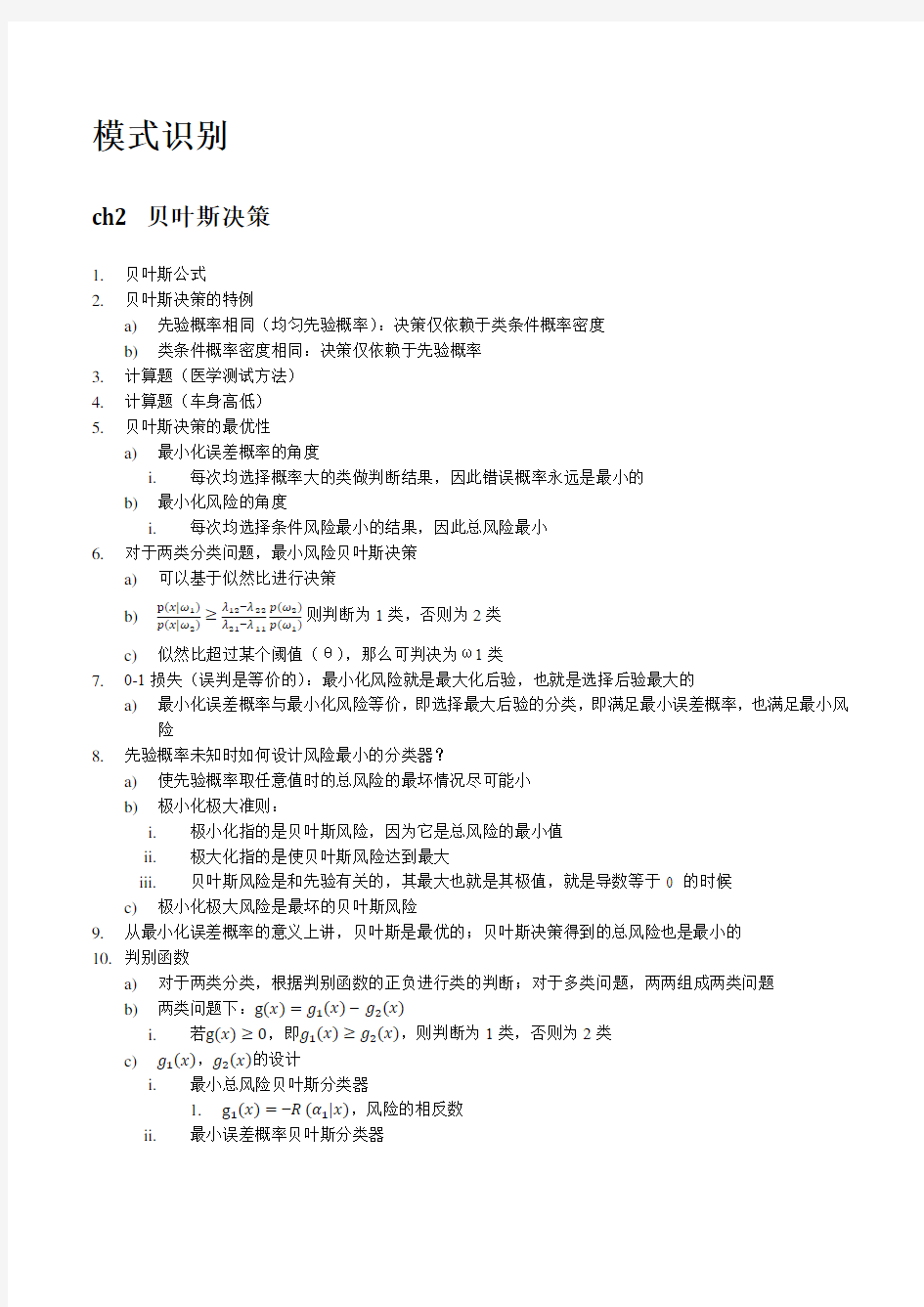

11.

12. 计算题(决策边界为何下偏)

ch3 参数估计

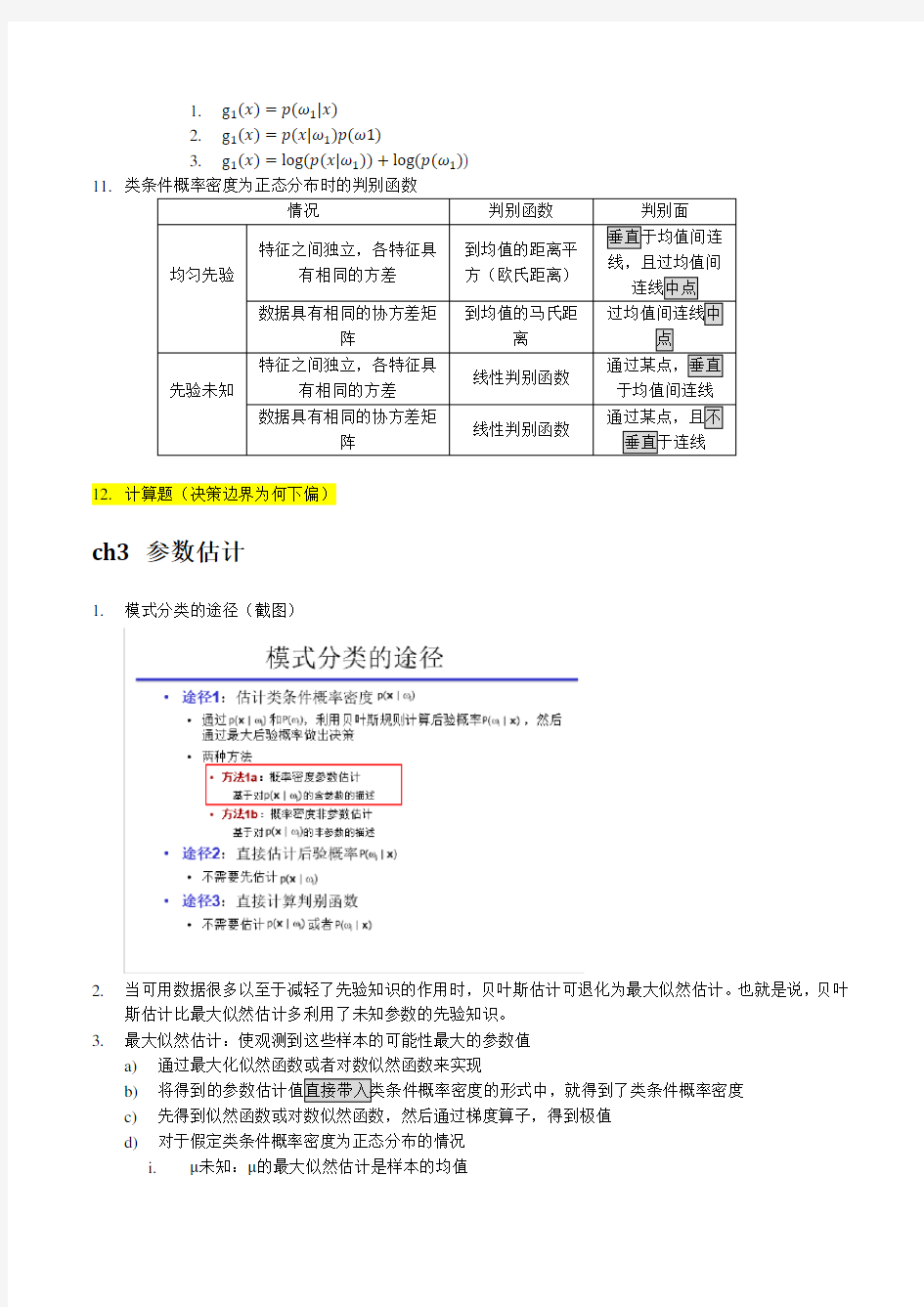

1. 模式分类的途径(截图)

2. 当可用数据很多以至于减轻了先验知识的作用时,贝叶斯估计可退化为最大似然估计。也就是说,贝叶

斯估计比最大似然估计多利用了未知参数的先验知识。 3. 最大似然估计:使观测到这些样本的可能性最大的参数值

a) 通过最大化似然函数或者对数似然函数来实现

b) c) 先得到似然函数或对数似然函数,然后通过梯度算子,得到极值 d) 对于假定类条件概率密度为正态分布的情况 i.

μ未知:μ的最大似然估计是样本的均值

ii.μ and Σ均未知

1.单变量(特征数目为1)

a)μ的最大似然估计是样本均值

b)Σ的最大似然估计是样本协方差

2.多元变量(特征数目不为1)

a)μ的最大似然估计是样本均值

b)Σ的最大似然估计是样本协方差(不是无偏估计)

4.贝叶斯估计

a)将未知参数看做随机变量,根据贝叶斯公式,利用先验概率和样本,得到观察样本之后的后验概率。

b)并非将后验概率分布的尖峰对应的未知参数值直接带入形式中,而是将整个后验概率分布与类条

p(x|ω,D)=∫p(x|θ)p(θ|D)dθ

p(x|θ)是形式已知,参数未知的类条件概率密度,p(θ|D)是未知参数的后验概率

c)若将后验概率分布的尖峰对应的未知参数值直接带入形式中,得到的是与p(x|ω,D)近似的解。

d)对于假定类条件概率密度为正态分布的情况,先验为已知的正态分布

i.单变量,μ未知,σ2已知

ii.多变量,μ未知,Σ已知

5.计算题(贝叶斯学习)

Ch4 参数模型

1.隐马尔可夫模型

a)估值问题:计算产生某观测序列的概率

i.计算时注意:序列是t=1开始产生的,而初始状态是t=0

ii.t=2是在t=1的基础上得到的。所以计算t=2时不能不考虑t=1时的符号

b)解码问题:根据观测序列,寻找最有可能的状态序列

i.与估值问题类似的地方在于均可以用前那一列的数据进一步进行计算;不同之处在于解码问

题在根据状态计算观测字符的步骤时,不是所有状态都计算之后相加,而是在乘以字符概率步

骤之前选择最大的状态概率,用这个概率进行计算。并同时标记选定的状态。

ii.将图做完后,进行回溯:选择最后一列最大的数值对应的元素的状态,然后该状态标记的状态,该标记的状态标记的状态等等一直回溯下去。然后倒序即可。

c)学习、参数估计模型:略

d)计算题,估值问题

e)计算题,解码问题

2.贝叶斯置信网

a)计算概率

i.从上向下算,没有箭头直连的乘时顺序无所谓

ii.箭头发出方如果有不确定情况,这种加和会延续至所有其子状态

b)计算置信度

i.对计算概率时的不确定项的取值,进行分析,选择出最有可能的不确定项的取值

ii. 和计算概率类似,将不确定项的每个取值都带入,算出多个结果,这个结果是概率的alpha 倍,归一化后得到置信度

iii.

如果问的置信度是相对于两个状态之间的,则分别计算每个状态的每个取值的alpha 概率,然后分别对每个状态得到的多个取值对应的概率归一化并得出每个状态符合题意的那个取值的归一化后的置信度,最后比较每个状态基于这个取值的置信度

c) 计算题 3. 期望最大化算法

Ch5 非参数方法

1. Parzen 窗

a) 体积是N 的函数 b) 举例,计算 2. Kn 近邻

a) 目标个数是N 的函数 3. K 近邻:直接估计后验概率

a) K=1:把x 判定为离它最近的那个点的类

b) K>1:把x 判定为它周围k 个点中出现次数最多的类 4. 距离度量(计算题)

a) 欧几里得距离 i. (∑(a k ?b k )2d k=1)

1/2

ii.

受特征尺度影响

b) Minkowski 距离 i. Lk 范数:(∑|a k ?b k |k

d k=1)

1/k

ii. L1范数:∑|a k ?b k |d k=1 iii. L2范数:欧几里得距离

iv. L 无穷范数:两个点在d 个坐标轴上投影长度的最大值 c) Mahalanobis 距离

i. √(a ?b )t Σ?1(a ?b) ii. 计算 d) Tanimoto 距离

i. 集合之间距离

ii. n 1+n 2?2n 1,2n 1+n 2?n 1,2

iii. 计算 e) Hausdorff 距离

i. 集合之间距离 ii. 最小距离的最大值 iii.

Mina1=Min(a1->b1, b2)

iv.Mina2=Min(a2->b1, b2)

v.Minb1=Min(b1->a1, a2)

vi.Minb2=Min(b2->a1, a2)

vii.Maxa=max(mina1, mina2)

viii.Maxb=max(minb1, minb2)

ix.Distance=max(maxa, maxb)

f)切空间距离

i.任意变换不变性

Ch6 特征降维和选择

1.特征组合

a)主成分分析PCA(最小化重构误差)

i.计算散布矩阵s -> s的特征值与特征向量-> 拿出较大的d个特征值对应的特征向量-> 组成

变换矩阵

ii.多大的d个特征值:值占全体的98%,或者找拐点

iii.选出来的向量是沿方差最大的方向的

b)线性判别分析LDA(最大化类别可分性,fisher线性判别)

i.不同类尽量分开,同一类尽量靠近

ii.between

within =|m1??m2?|

s12+s22

=w t S B w

w t S W w

最大:S B w=λS W w→S W?1S B w=λw

iii.

2.特征选择

a)搜索过程

i.循环向前选择法

ii.循环向后选择法

b)选择准则

i.泛化误差:均方误差

ii.类内距离度量:类内散布度

Ch7 线性判别函数

1.判别函数

2.广义线性判别函数

3.两类线性可分情况

4.准则函数

a)最小化准则函数的方法

i.梯度下降(阈值在准则函数值)

1.最优学习率

ii.牛顿下降(阈值在步长)

b)准则函数的选取:a为解向量时(也是不等式组的解),J(a)最小

i.感知器准则函数:被a确定的决策面错分的样本数,正比于错分的样本到决策面的距离。

ii.感知器准则函数最小化

5.线性不可分情况:将不等式组改为方程组

a)最小平方误差准则

b)Widrow-hoff方法

6.支持向量机

7.多维:kesler

Ch8 多层神经网络

1.是一种判别函数

2.简单感知器(仅包含输入层和输出层的两层前馈神经网络,两层之间全互连)

a)初始化w=[0, 0,…, 0]

b)放入x1,判断sig(wx1)是否满足期望结果

i.满足:放入下一个样本

ii.不满足:修正

c)直到所有样本都满足

d)修正方法:new_w=old_w+x*label

e)

f)

3.多层前馈神经网络(至少包含一个隐含层的前馈神经网络)

4.反向传播算法BP

a)首先给定的模式从输入层传到隐藏层,然后传到下一个隐藏层,最终输出。

b)推导过程

Ch10 决策树

1.节点代表测试(查询),分支代表结果,叶节点代表类别

2.是二叉树

3.如何设计查询

a)计算不纯度

b)选择使不纯度下降最快的查询

c)如果使用熵不纯度,则不纯度下降差就是本次查询所能提供的信息增益,应使信息增益尽可能大

4.如何确定停止准则

a)五个准则

b)预剪枝

c)后剪枝

Ch11 聚类

1.