大数据挖掘聚类算法课程设计报告材料

- 格式:doc

- 大小:274.40 KB

- 文档页数:12

实验二、聚类分析实验报告一、实验目的通过计算机编程实现并验证谱系聚类法的模式分类能力,了解和掌握最小距离归类原则在模式识别中的重要作用与地位。

二、实验内容1)用Matlab 实现谱系聚类算法,并对给定的样本集进行分类;2)通过改变实验参数,观察和分析影响谱系聚类算法的分类结果与收敛速度的因素;三、实验原理、方法和手段人类认识世界往往首先将被认识的对象进行分类,聚类分析是研究分类问题的多元数据分析方法,是数值分类学中的一支。

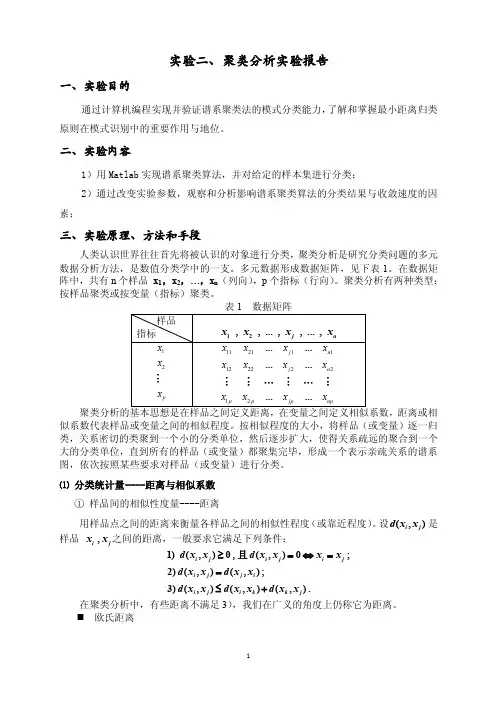

多元数据形成数据矩阵,见下表1。

在数据矩阵中,共有n 个样品 x 1,x 2,…,x n (列向),p 个指标(行向)。

聚类分析有两种类型:按样品聚类或按变量(指标)聚类。

距离或相似系数代表样品或变量之间的相似程度。

按相似程度的大小,将样品(或变量)逐一归类,关系密切的类聚到一个小的分类单位,然后逐步扩大,使得关系疏远的聚合到一个大的分类单位,直到所有的样品(或变量)都聚集完毕,形成一个表示亲疏关系的谱系图,依次按照某些要求对样品(或变量)进行分类。

⑴ 分类统计量----距离与相似系数① 样品间的相似性度量----距离用样品点之间的距离来衡量各样品之间的相似性程度(或靠近程度)。

设(,)i j d x x 是样品 ,i j x x 之间的距离,一般要求它满足下列条件:1)(,)0,(,)0;2)(,)(,);3)(,)(,)(,).i j i j i j i j j i i j i k k j d x x d x x x x d x x d x x d x x d x x d x x ≥=⇔==≤+且在聚类分析中,有些距离不满足3),我们在广义的角度上仍称它为距离。

欧氏距离1221(,)()pi j ik jk k d x x x x =⎡⎤=-⎢⎥⎣⎦∑⏹ 绝对距离1(,)||pi j ik jk k d x x x x ==-∑⏹ Minkowski 距离11(,)()pmm i j ik jk k d x x x x =⎡⎤=-⎢⎥⎣⎦∑⏹ Chebyshev 距离1(,)max ||i j ik jk k pd x x x x ≤≤=-⏹ 方差加权距离12221()(,)pik jk i j k k x x d x x s =⎡⎤-=⎢⎥⎢⎥⎣⎦∑ 其中 221111,().1n n ik k ik k i i x x s x x n n ====--∑∑ ⏹ 马氏距离112(,)()()T i j i j i j d x x x x S x x -⎡⎤=--⎣⎦其中 S 是由样品12,,...,,...,j n x x x x 算得的协方差矩阵:1111,()()1n n T i i i i i x x S x x x x n n ====---∑∑ 样品聚类通常称为Q 型聚类,其出发点是距离矩阵。

数据挖掘分析课程设计数据一、课程目标知识目标:1. 让学生掌握数据挖掘的基本概念、流程及常用算法,如分类、聚类和关联规则挖掘;2. 使学生了解数据预处理、特征工程等关键步骤,提高数据质量;3. 帮助学生掌握至少一种数据挖掘工具,如Python、R等,并运用至实际项目中;4. 让学生掌握数据分析的基本方法,能够运用统计图表展示数据挖掘结果。

技能目标:1. 培养学生运用数据挖掘技术解决实际问题的能力,如从大量数据中发现规律、趋势和关联性;2. 培养学生运用编程工具进行数据处理、分析和可视化的能力;3. 培养学生的团队协作和沟通能力,能够就数据挖掘项目进行有效讨论和展示。

情感态度价值观目标:1. 培养学生对数据挖掘的兴趣,激发他们探索未知、追求真理的精神;2. 培养学生具备良好的数据伦理观念,尊重数据隐私,遵循数据安全规范;3. 使学生认识到数据挖掘在现实生活中的广泛应用,增强社会责任感和时代使命感。

课程性质:本课程为选修课,适用于高年级学生,具有较强的实践性和应用性。

学生特点:学生具备一定的数学、计算机基础,对数据分析有一定了解,具备一定的自主学习能力。

教学要求:结合实际案例,注重理论与实践相结合,提高学生的动手操作能力和创新能力。

通过课程学习,使学生能够独立完成数据挖掘项目,并为后续相关课程和实际工作打下坚实基础。

二、教学内容1. 数据挖掘基本概念与流程:介绍数据挖掘的定义、任务、应用领域,以及数据挖掘的基本流程,包括数据收集、数据预处理、数据挖掘、结果评估和知识应用。

教材章节:第一章 数据挖掘概述2. 数据预处理与特征工程:讲解数据清洗、数据集成、数据变换等预处理方法,以及特征选择、特征提取等特征工程操作。

教材章节:第二章 数据预处理与特征工程3. 常用数据挖掘算法:学习分类、聚类、关联规则挖掘等常用算法,如决策树、支持向量机、K-means、Apriori等。

教材章节:第三章 分类与预测;第四章 聚类分析;第五章 关联规则挖掘4. 数据挖掘工具与实战:介绍Python、R等数据挖掘工具,通过实际案例让学生动手操作,提高实践能力。

大数据挖掘分析课程设计一、课程目标知识目标:1. 让学生掌握大数据挖掘的基本概念、原理和方法。

2. 使学生了解数据预处理、特征工程、模型评估等关键环节在大数据分析中的重要性。

3. 帮助学生理解常见的大数据分析算法,如决策树、支持向量机、神经网络等。

技能目标:1. 培养学生运用编程工具(如Python)进行数据处理和分析的能力。

2. 让学生具备使用大数据挖掘工具(如Hadoop、Spark)解决实际问题的能力。

3. 提高学生运用大数据分析方法解决实际问题的能力。

情感态度价值观目标:1. 培养学生积极探究、勤于思考的学习态度,增强对大数据挖掘分析的兴趣。

2. 培养学生团队协作、共同解决问题的意识,提高沟通与表达能力。

3. 增强学生对我国在大数据分析领域的发展信心,树立正确的价值观。

本课程针对高年级学生,结合学科特点和教学要求,注重理论与实践相结合,旨在提高学生的大数据挖掘分析能力。

课程目标具体、可衡量,便于后续教学设计和评估。

通过本课程的学习,学生将能够掌握大数据挖掘的基本知识和技能,为未来从事相关领域工作打下坚实基础。

二、教学内容1. 大数据挖掘基本概念:数据挖掘的定义、任务、方法及其在大数据时代的应用。

2. 数据预处理:数据清洗、数据集成、数据变换、数据规约等。

3. 特征工程:特征提取、特征选择、特征变换等,重点讲解主成分分析、线性判别分析等方法。

4. 常见大数据挖掘算法:决策树、支持向量机、K最近邻、神经网络、聚类分析等。

5. 模型评估与优化:交叉验证、网格搜索、参数调优等方法。

6. 大数据挖掘工具:Hadoop、Spark等分布式计算框架的介绍与应用。

教学内容按照以下进度安排:1. 第一周:大数据挖掘基本概念及数据预处理。

2. 第二周:特征工程及其在实际案例中的应用。

3. 第三周:常见大数据挖掘算法原理与实现。

4. 第四周:模型评估与优化方法。

5. 第五周:大数据挖掘工具的使用。

教学内容与课本紧密关联,涵盖《大数据挖掘技术与应用》教材的第1-5章,确保学生系统掌握大数据挖掘的核心知识。

第1篇一、实验背景聚类分析是数据挖掘中的一种重要技术,它将数据集划分成若干个类或簇,使得同一簇内的数据点具有较高的相似度,而不同簇之间的数据点则具有较低相似度。

本实验旨在通过实际操作,了解并掌握聚类分析的基本原理,并对比分析不同聚类算法的性能。

二、实验环境1. 操作系统:Windows 102. 软件环境:Python3.8、NumPy 1.19、Matplotlib 3.3.4、Scikit-learn0.24.03. 数据集:Iris数据集三、实验内容本实验主要对比分析以下聚类算法:1. K-means算法2. 聚类层次算法(Agglomerative Clustering)3. DBSCAN算法四、实验步骤1. K-means算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的KMeans类进行聚类,设置聚类数为3。

(3)计算聚类中心,并计算每个样本到聚类中心的距离。

(4)绘制聚类结果图。

2. 聚类层次算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的AgglomerativeClustering类进行聚类,设置链接方法为'ward'。

(3)计算聚类结果,并绘制树状图。

3. DBSCAN算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的DBSCAN类进行聚类,设置邻域半径为0.5,最小样本数为5。

(3)计算聚类结果,并绘制聚类结果图。

五、实验结果与分析1. K-means算法实验结果显示,K-means算法将Iris数据集划分为3个簇,每个簇包含3个样本。

从聚类结果图可以看出,K-means算法能够较好地将Iris数据集划分为3个簇,但存在一些噪声点。

2. 聚类层次算法聚类层次算法将Iris数据集划分为3个簇,与K-means算法的结果相同。

从树状图可以看出,聚类层次算法在聚类过程中形成了多个分支,说明该算法能够较好地处理不同簇之间的相似度。

数据挖掘聚类问题(Plants Data Set)实验报告1.数据源描述1.1数据特征本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。

数据集中总共有68个地区,主要分布在美国和加拿大。

一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。

可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。

图1 数据格式例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。

其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。

植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。

1.2任务要求聚类。

采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。

2.数据预处理2.1数据清理所给数据集中包含一些对聚类过程无用的冗余数据。

数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。

例如:abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,viabelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,viabelmoschus moschatus,hi,pr上述数据中第行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。

从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集合。

在聚类过程中第行数据是无用的,因此要对其进行清理。

实验三一、实验原理K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。

在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。

算法原理:(1) 随机选取k个中心点;(2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类;(3) 更新中心点为每类的均值;(4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步数,误差不变.空间复杂度o(N)时间复杂度o(I*K*N)其中N为样本点个数,K为中心点个数,I为迭代次数二、实验目的:1、利用R实现数据标准化。

2、利用R实现K-Meams聚类过程。

3、了解K-Means聚类算法在客户价值分析实例中的应用。

三、实验内容依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。

对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。

编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数四、实验步骤1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。

2、确定要探索分析的变量3、利用R实现数据标准化。

4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。

五、实验结果客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数六、思考与分析使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。

kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。

这样做的前提是我们已经知道数据集中包含多少个簇.1.与层次聚类结合经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果粗的数目,并找到一个初始聚类,然后用迭代重定位来改进该聚类。

目录§第1章数据挖掘基本理论 (2)§1.1数据挖掘的产生 (2)§1.2数据挖掘的概念 (3)§1.3数据挖掘的步骤 (3)§第2章系统分析 (4)§2.1系统用户分析 (4)§2.2系统功能分析 (4)§2.3系统算法分析 (5)§第3章数据管理 (6)§3.1数据管理的方法 (6)§第4章数据采集 (6)§4.1数据采集的方法 (6)§第5章数据预处理 (6)§5.1数据预处理的方法 (6)§第6章数据挖掘 (7)§6.1算法描述与流程图 (7)§6.1.1 算法描述 (7)§6.1.2 算法流程图 (8)§第7章结果显示与解释评估 (9)§7.1结果显示界面的具体实现 (9)§7.1.1 系统主界面的具体实现 (9)§7.1.2 超市销售记录界面的具体实现 (10)§7.1.3 数据采集界面的具体实现 (11)§7.1.4 挖掘条件界面的具体实现 (12)§7.1.5 数据挖掘界面的具体实现 (13)§7.1.6 帮助界面的具体实现 (14)§7.1.7 系统主界面运行后显示的结果 (14)学习体会 (15)参考文献 (16)§第1章数据挖掘基本理论§1.1 数据挖掘的产生随着计算机硬件和软件的飞速发展,尤其是数据库技术与应用的日益普及,人们面临着快速扩张的数据海洋,如何有效利用这一丰富数据海洋的宝藏为人类服务业已成为广大信息技术工作者的所重点关注的焦点之一。

与日趋成熟的数据管理术与软件工具相比,人们所依赖的数据分析工具功能,却无法有效地为决策者提其决策支持所需要的相关知识,从而形成了一种独特的现象“丰富的数据,贫乏知识”。

数据挖掘-WEKA

实验报告三

姓名及学号:杨珍20131198

班级:卓越计科1301

指导老师:吴珏老师

一、实验内容

1、聚类算法(掌握weka中k-means算法的使用)

1)加载weather.arrf文件,选择SimplerKmeans算法,使用默认参数,进行聚类。

对聚类结果进行分析。

2)使用EM算法进行聚类。

3)分别使用DBSCAN和OPTICS算法进行聚类,对结果进行分析。

二、实验步骤

(1)加载iris.arrf文件,选择SimplerKmeans算法

(2)使用EM算法进行聚类。

(3)使用DBSCAN进行聚类

(4)使用OPTICS进行聚类

二、思考与分析

1请分析为什么两种聚类方法的集成有时会改进聚类的质量和效率。

每种聚类方法各有自己的优缺点,采用两种聚类方法在某种程度上会使两种方法的优点缺点互补,从而提高质量和效率。

数据挖掘课设报告1.数据挖掘是一种从大量数据中提取隐藏模式、知识和信息的过程。

在当今信息爆炸的时代,数据挖掘技术在各个领域的应用越来越广泛。

本报告将介绍我们在数据挖掘课设中进行的工作和成果。

2. 数据集选择在课设开始前,我们需选择合适的数据集。

我们需要一个具有一定规模和特征的数据集,以便我们能够进行数据挖掘的实验和分析。

我们选择了一个关于电商销售的数据集,其中包含了订单时间、商品种类、销售金额等信息。

3. 数据预处理在进行数据挖掘之前,我们需要对数据进行预处理。

数据预处理是数据挖掘的重要步骤,可以清洗数据、填充缺失值、去除异常值等。

我们对选定的数据集进行了预处理,包括去除重复值和缺失值,并进行了数据的标准化处理,以便更好地进行挖掘模式。

4. 特征选择在数据挖掘中,特征选择是指从原始数据中选取与目标特征相关性较高的特征,以降低数据维度并提高模型性能。

在我们的课设中,我们使用了信息增益和卡方检验等特征选择方法,选取了一组与销售金额相关性较高的特征。

5. 模型建立在数据准备阶段完成后,我们开始建立模型。

根据我们的数据集和目标,我们选择了常用的回归模型进行建模。

我们使用了线性回归、决策树回归和随机森林回归等算法对数据进行建模,并评估了它们的模型性能。

6. 模型评估与优化建立模型后,我们需要对模型进行评估和优化。

我们使用了均方根误差(RMSE)和决定系数(R^2)等指标对模型进行评估。

通过评估结果,我们发现随机森林回归在预测销售金额时具有比较好的性能。

为了进一步提高模型性能,我们进行了参数调优和特征筛选。

我们使用了交叉验证和网格搜索等方法,寻找最佳的模型参数配置。

,我们还使用了递归特征消除等方法进一步筛选特征。

7. 结果分析与展示在模型优化后,我们对最终的模型进行了结果分析。

我们通过可视化方式展示了模型的预测结果,并与实际销售金额进行对比。

通过分析结果,我们发现我们的模型能够较为准确地预测销售金额,并且找到了一些影响销售金额的重要特征。

数据挖掘课设报告在当今数字化的时代,数据挖掘已经成为了从海量数据中获取有价值信息的关键技术。

通过本次数据挖掘课程设计,我深入了解了数据挖掘的流程和方法,并在实践中积累了宝贵的经验。

一、课程设计背景与目标随着信息技术的飞速发展,各个领域都积累了大量的数据。

这些数据中蕴含着丰富的知识和潜在的价值,但如何有效地提取和利用这些信息成为了一个重要的挑战。

数据挖掘作为一种能够从大规模数据中发现模式、趋势和关系的技术,具有重要的应用价值。

本次课程设计的目标是运用所学的数据挖掘知识和技术,解决一个实际的问题,并通过实践加深对数据挖掘流程和方法的理解,提高数据分析和解决问题的能力。

二、数据来源与预处理为了完成课程设计任务,我选择了一个公开的数据集,该数据集包含了有关_____的信息。

在获取数据后,首先需要对数据进行预处理,以确保数据的质量和可用性。

数据预处理包括数据清洗、数据集成、数据变换和数据规约等步骤。

在数据清洗过程中,我处理了缺失值、异常值和重复值等问题。

对于缺失值,根据数据的特点采用了合适的填充方法,如均值填充、中位数填充或使用模型预测填充。

对于异常值,通过数据可视化和统计分析进行识别,并根据具体情况进行删除或修正。

在数据集成方面,将来自多个数据源的数据进行整合,确保数据的一致性和准确性。

数据变换则包括对数据进行标准化、归一化和编码等操作,以便于后续的分析和建模。

最后,通过数据规约技术,如特征选择和主成分分析,减少数据的维度和规模,提高数据处理的效率。

三、数据挖掘方法选择与应用根据问题的特点和数据的特征,我选择了以下几种数据挖掘方法进行分析:1、分类算法决策树:决策树是一种直观且易于理解的分类算法。

通过对数据的递归分割,构建一棵决策树,能够根据输入的特征预测目标变量的类别。

支持向量机(SVM):SVM 是一种基于核函数的分类算法,对于线性不可分的数据具有较好的分类效果。

随机森林:随机森林是由多个决策树组成的集成学习算法,通过集成多个决策树的预测结果,提高了分类的准确性和稳定性。

资料范本本资料为word版本,可以直接编辑和打印,感谢您的下载数据挖掘实验报告-聚类分析地点:__________________时间:__________________说明:本资料适用于约定双方经过谈判,协商而共同承认,共同遵守的责任与义务,仅供参考,文档可直接下载或修改,不需要的部分可直接删除,使用时请详细阅读内容数据挖掘实验报告(三)聚类分析姓名:李圣杰班级:计算机1304学号:1311610602一、实验目的掌握k-means聚类方法;通过自行编程,对三维空间内的点用k-means方法聚类。

二、实验设备PC一台,dev-c++5.11三、实验内容1.问题描述:立体空间三维点的聚类.说明:数据放在数据文件中(不得放在程序中),第一行是数据的个数,以后各行是各个点的x,y,z坐标。

2.设计要求读取文本文件数据,并用K-means方法输出聚类中心3. 需求分析k-means 算法接受输入量k;然后将n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。

聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。

k-means算法的工作过程说明如下:首先从n个数据对象任意选择k个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。

然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。

一般都采用均方差作为标准测度函数,具体定义如下:(1)其中E为数据库中所有对象的均方差之和,p为代表对象的空间中的一个点,mi为聚类Ci的均值(p和mi均是多维的)。

公式(1)所示的聚类标准,旨在使所获得的k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。

四、实验步骤Step 1.读取数据组,从N个数据对象任意选择k个对象作为初始聚类中心;Step 2.循环Step 3到Step 4直到每个聚类不再发生变化为止;Step 3.根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分;Step 4.重新计算每个(有变化)聚类的均值(中心对象)。

一、实验背景随着大数据时代的到来,数据量呈爆炸式增长,如何有效地对海量数据进行处理和分析成为了一个重要课题。

聚类算法作为一种无监督学习方法,在数据挖掘、模式识别等领域有着广泛的应用。

本实验旨在通过实际操作,了解聚类算法的基本原理、实现方法及其在实际问题中的应用。

二、实验目的1. 理解聚类算法的基本原理和流程;2. 掌握K-means、层次聚类、DBSCAN等常用聚类算法;3. 分析不同聚类算法在处理不同类型数据时的优缺点;4. 学会使用聚类算法解决实际问题。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据库:Pandas4. 机器学习库:Scikit-learn四、实验内容1. K-means聚类算法(1)数据准备本实验使用的数据集为Iris数据集,包含150个样本,每个样本有4个特征。

(2)算法实现使用Scikit-learn库中的KMeans类实现K-means聚类算法。

(3)结果分析通过绘制样本分布图,观察聚类效果。

根据聚类结果,将样本分为3类,与Iris数据集的类别标签进行对比。

2. 层次聚类算法(1)数据准备本实验使用的数据集为鸢尾花数据集,包含150个样本,每个样本有4个特征。

(2)算法实现使用Scikit-learn库中的AgglomerativeClustering类实现层次聚类算法。

(3)结果分析通过绘制树状图,观察聚类过程。

根据聚类结果,将样本分为3类,与鸢尾花数据集的类别标签进行对比。

3. DBSCAN聚类算法(1)数据准备本实验使用的数据集为Iris数据集。

(2)算法实现使用Scikit-learn库中的DBSCAN类实现DBSCAN聚类算法。

(3)结果分析通过绘制样本分布图,观察聚类效果。

根据聚类结果,将样本分为3类,与Iris 数据集的类别标签进行对比。

五、实验结果与分析1. K-means聚类算法K-means聚类算法在Iris数据集上取得了较好的聚类效果,将样本分为3类,与真实标签一致。

数据挖掘课程设计报告题目:关联规则挖掘系统姓名: xxxxxx 班级:计算机0901 学号: xxxxxxxxxxx2013年 6 月 19 日一、设计目的该程序实现了对简单数据进行频繁项集挖掘的功能,主要使用 Apriori 算法,即使用候选产生发现频繁项集。

通过这次编程增强编程能力。

二、设计要求实现数据挖掘的关联规则,能够挖掘数据之间的关联信息,能够读取文件中的数据,能够保存分析结果。

界面友好。

三、设计实现流程图四、实现环境操作系统WindowsXP开发环境Netbeans7.1运行环境 Windows系列操作系统(装有Java运行时环境) 五、实现结果完整输出结果:run:顾客1商品A商品B商品C顾客2商品A商品B顾客3商品B商品C顾客4商品C商品B商品1,,,,,,,,,,,,,,,,,,,,,,,,,,,,3********************************************************************* ******************************候选集1:[商品A] [商品B] [商品C]频繁集1:[商品A] [商品B] [商品C]********************************************************************* ******************************候选集2:[商品A,商品B] [商品A,商品C] [商品B,商品C]频繁集2:[商品A,商品B] [商品B,商品C]********************************************************************* ******************************候选集3:[商品A,商品B,商品C]频繁集3:********************************************************************* ******************************最大频繁集:[商品A,商品B] [商品B,商品C]********************************************************************* ******************************关联规则:[商品A]=========>[商品B] 1.0[商品B]=========>[商品A] 0.6666666666666666[商品B]=========>[商品C] 0.6666666666666666[商品C]=========>[商品B] 1.0六、设计小结这学期学的数据挖掘课程丰富了我的知识面,让我看到了信息技术的巨大生命力和前景。

数据挖掘课程设计一.实验目的1)请根据所给的天津各区县经济和教育数据分别做聚类分析,并给出你的结论分析。

2)聚类分析结果时候与你的直观感受相符合?如果不符,请解释并给出解决方法。

二.实验过程及结果分析本实验采用聚类分析来对各个区县进行分类,这里我使用SPSS 20来进行聚类分析。

输入各区县经济数据如下图:使用SPSS 进行K均值聚类分析,分为六类,得到如下结果:每个聚类中的案例数聚类1 1.0002 4.0003 5.0004 4.0005 1.0006 1.000有效16.000缺失.000上图中的第三列(QCL_1)即为分类情况,说明如下:北辰区分为一类,标记为1;河东区、宝坻区、宁河县、蓟县分为一类,标记为2;南开区、河北区、津南区、武清区、静海县分为一类,标记为3;和平区、河西区、东丽区、西青区分为一类,标记为4;滨海新区为一类,标记为5;红桥区分为一类,标记为6 。

结果分析:分类结果从整体来看还是比较合理的。

滨海新区这一地区产值非常高,毫无疑问是单独的一类;红桥区产值最低,也分为一类,这个与我的直观感受不太相符,作为天津市市内六区之一的红桥区,产值最低,分为一类,我觉得很不可思议,问题可能是数据量不够大,或者说评价指标太少,这里我们只有一个评价指标(总产值),导致结果具有偶然性,适当增加评价指标应该可以增加结果的准确性。

输入各区县教育数据(中学数量和中学在校生以及教师数量)如下图:使用SPSS 对这三个变量进行K均值聚类分析,分为六类,得到如下结果:每个聚类中的案例数聚类1 1.0002 1.0003 2.0004 6.0005 1.0006 5.000有效16.000缺失 1.000上图中的第五列(QCL_1)即为分类情况,说明如下:滨海新区分为一类,标记为1;蓟县分为一类,标记为2;武清区、宝坻区分为一类,标记为3;和平区、河东区、河西区、南开区、河北区、宁河县分为一类,标记为4;静海县分为一类,标记为5;红桥区、东丽区、西青区、津南区、北辰区分为一类,标记为6 。

课时安排:2课时教学目标:1. 理解大数据挖掘的基本概念和重要性。

2. 掌握大数据挖掘的基本流程和常用算法。

3. 能够运用所学知识进行简单的数据挖掘实践。

教学重点:1. 大数据挖掘的基本概念和流程。

2. 常用的大数据挖掘算法。

教学难点:1. 复杂大数据挖掘算法的理解和应用。

2. 数据挖掘在实际项目中的应用。

教学准备:1. PPT课件2. 数据集3. 相关软件(如Python、R等)教学过程:第一课时一、导入1. 引入大数据的概念,引导学生思考大数据对日常生活的影响。

2. 提出问题:什么是大数据挖掘?大数据挖掘有哪些应用?二、基本概念1. 讲解大数据挖掘的基本概念,包括数据挖掘的定义、目标、流程等。

2. 通过案例展示大数据挖掘的重要性。

三、数据挖掘流程1. 讲解数据挖掘的基本流程,包括数据收集、数据预处理、数据挖掘、结果评估等步骤。

2. 结合实例,让学生了解每个步骤的具体操作。

四、常用算法1. 介绍常用的数据挖掘算法,如聚类、分类、关联规则挖掘等。

2. 讲解每种算法的基本原理和适用场景。

五、课堂练习1. 提供一个小型数据集,让学生进行数据预处理。

2. 引导学生运用所学算法对数据集进行挖掘。

第二课时一、复习上节课内容1. 回顾大数据挖掘的基本概念、流程和常用算法。

2. 检查学生对上节课内容的掌握程度。

二、复杂算法讲解1. 深入讲解聚类算法(如K-means、层次聚类等)和分类算法(如决策树、支持向量机等)。

2. 结合实例,让学生了解算法的优缺点和适用场景。

三、数据挖掘实践1. 提供一个实际数据集,让学生进行数据挖掘实践。

2. 引导学生运用所学知识解决实际问题。

四、结果评估1. 讲解数据挖掘结果评估的方法,如准确率、召回率、F1值等。

2. 引导学生评估自己的挖掘结果。

五、课堂总结1. 总结本节课所学内容,强调数据挖掘在实际项目中的应用。

2. 布置课后作业,让学生运用所学知识解决实际问题。

教学评价:1. 通过课堂提问、练习和作业,了解学生对大数据挖掘知识的掌握程度。

数据挖掘聚类问题(Plants Data Set)实验报告1.数据源描述1.1数据特征本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。

数据集中总共有68个地区,主要分布在美国和加拿大。

一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。

可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。

图1 数据格式例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。

其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。

植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。

1.2任务要求聚类。

采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。

2.数据预处理2.1数据清理所给数据集中包含一些对聚类过程无用的冗余数据。

数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。

例如:①abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,vi②abelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,vi③abelmoschus moschatus,hi,pr上述数据中第①行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的②③两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。

从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集合。

在聚类过程中第①行数据是无用的,因此要对其进行清理。

2.2数据变换本实验是依据植物的分布区域进行聚类,所给数据集中的分布区域是字符串形式,不适合进行聚类,因此将其变换成适合聚类的数值形式。

具体思想如下:数据集中总共包含68个区域,每一种植物的分布区域是这68个区域中的一部分。

本实验中将68个区域看成是数据对象的68个属性,这68个属性是二元类型的变量,其值只能去0或者1。

步骤如下:1.把68个区域按一定顺序存放在字符串数组(记为str)中(顺序可以自己定,确定后不能改变)。

2.为数据集中的每个数据对象设置一个长度为68字符串数组,初始元素值全为0。

将数据对象的分布区域逐个与str中的所有元素比较。

如果存在于str 中下标i的位置,就将该数据对象的字符串数组的第i位置为1。

例如,一个数据对象为:abies fraseri,ga,nc,tn,va。

其分布区域包含ga,nc,tn和va四个地区,将这四个地区逐个与str中全部68个元素比较。

假设这四个地区分别存在于str中的第0,1,2,3位置,则将为该数据对象设置的字符串数组中第0,1,2,3位置全部置为1。

★数据预处理代码(包括数据清理和数据变换):public ArrayList<String> getRaw_DataSet() {ArrayList<String> raw_dataSet = new ArrayList<String>();// 定义集合存储从本地获取的数据BufferedReader bufferedReader = null;FileReader fileReader = null;File dataFile = new File(this.fileName);if (dataFile.exists()) {// 如果数据文件存在try {fileReader = new FileReader(this.fileName);bufferedReader = new BufferedReader(fileReader);String data = null;while ((data = bufferedReader.readLine()) != null) {if (isRightData(data))raw_dataSet.add(data);}} catch (Exception e) {e.printStackTrace();}} elsethis.isFileExit = false;return raw_dataSet;}// getRaw_DataSet,从本地txt文件获取数据集public ArrayList<DataItem> getFinished_DataSet() {// 获取经过预处理,用来进行聚类的数据ArrayList<DataItem> finished_DataSet = new ArrayList<DataItem>();ArrayList<String> temp_DataSet = this.getRaw_DataSet();for (int i = 0; i < temp_DataSet.size(); i++) {ArrayList<String> eachRomItem = null;eachRomItem = this.spilt(temp_DataSet.get(i), ',');// 除去","后的每一行数据DataItem data_Item = new DataItem(eachRomItem, true);finished_DataSet.add(data_Item);}// forreturn finished_DataSet;}public boolean isRightData(String data) {// 筛选出合适的数据ArrayList<String> tempArrayList = new ArrayList<String>();tempArrayList = spilt(data, ' ');if (tempArrayList.size() <= 1)return false;return true;}// isRightData,筛选出合适的数据public ArrayList<String> spilt(String str, char ch) {ArrayList<String> words = new ArrayList<String>();// 用来存放找到的单词int beginIndex = 0;for (int i = 0; i < str.length(); i++) {if (str.charAt(i) != ch) {if (i != str.length() - 1)continue;else {words.add(str.substring(beginIndex));}} else {String temp = str.substring(beginIndex, i);words.add(temp);beginIndex = i + 1;}}// forreturn words;}3.聚类分析3.1 算法描述本实验采用了聚类分析中常用的K均值(K-Means)算法。

该算法思想如下:算法:K均值。

用于划分的K均值算法,每个簇的中心用簇中对象的均值表示。

输入:■k:簇的属目■D:包含n个对象的数据集。

输出:k个簇的集合。

方法:(1)从D中任意选择k个对象作为初始簇中心;(2)repeat(3) 根据簇中对象的均值,将每个对象(再)指派到最相似的簇;(4) 更新簇均值,既计算每个簇中对象的均值;(5)until 不再发生变化根据上述算法,结合本实验实际情况和数据集特征给出程序的执行流程图:图2 程序执行流程针对上面的流程图,有几点说明:1.数据预处理主要包括前述数据清理和数据变换,最终生成用于聚类分析的数据集。

2.簇的个数k 由用户指定,k 越大聚类过程耗时越久。

3.图中“最相似”意思就是距离中心点距离最近,本实验中采用欧几里得距离,其定义如下:)()()(222...2211),(x x x x x x jn in j i j i j i d ---+++=其中),...,,(21x x x in i i i =和),...,(21x x x jn j j j =是两个n 维数据对象。

在本实验中,x i 1和x j 1分别代表为i,j 两个数据对象设置的字符串数组(参看2.2)中下标为1的元素值,此处n 为68。

4.流程图中的终止条件指的是:前后两次中心点之间的距离(仍然用欧几里得距离)是否小于设定的值。

例如,第n 次迭代完成后重新生成了k 个新的中心点,计算k 个新中心点与k 个旧的中心点距离之和并将结果与设定的值比较,若小于设定值则终止迭代,聚类完成,否则继续迭代。

3.2 算法实现图3 代码文件的组织结构上图是本实验源码的组织结构,该项目包含五个Java 类。

每个类的功能描述如下: ◆Cluster.java 类 该类定义了簇的结构,包含簇标志,簇成员和簇中心点三个字段。

该类的每一个实例对应于聚类过程中的一个簇。

◆DataItem.java 类 该类定义了数据对象的结构,主要包含数据对象名称(即植物名称)和数据对象字符串数组(即植物的分布区域)。

该类的每一个实例对应于数据集中的一个数据对象。

◆Main.java类该类是程序的核心类,主要功能是执行聚类过程,包括中心点的选取与更新,计算各个数据对象与中心点之间的距离并把其派分到最相似的簇等。

◆ReadData.java类该类主要功能是生成聚类过程适用的数据集,包括读取文件,数据预处理等。

◆Tools.java类该类是一个工具类,其中定义了多个程序中使用到的静态方法。

★Mian.java类中的核心代码:(1) 随机选取中心点public void setCenter_ran() {// 第一次,从数据集中随机选取中心点beginTime = System.currentTimeMillis();System.out.println("聚类过程开始,开始于:" + Tools.currentTime());Random ran = new Random();int order = 0;// 随机选取中心点while (this.center.size() < numOfCluster) {order = ran.nextInt(toBeProcessed.size());if (Tools.isProCener(toBeProcessed.get(order), this.center))this.center.add(toBeProcessed.get(order));}// while}(2)初始化簇集合public void initArrayCluster(ArrayList<DataItem> center) {// 初始每个簇中的中心点属性this.arrayCluster.clear();// 把簇集合清空for (int i = 0; i < center.size(); i++) {Cluster cluster = new Cluster(i, center.get(i));if (this.center.get(i).getIsDataItem())cluster.addMembers(center.get(i));this.arrayCluster.add(cluster);}}(3)执行聚类过程(计算距离,把数据对象派分到最相似簇中)public void runCluster(ArrayList<DataItem> center) {int beyondIndex = 0;// 判断数据项属于哪一个簇,初始默认为是0簇Random rd = new Random();// 随机函数printBeginInfo();// 打印以此迭代开始前的信息。