Fast and light boosting for adaptive mining of data streams

- 格式:pdf

- 大小:173.09 KB

- 文档页数:10

超科幻未来房子英语作文Title: The Ultimate Abode: A Glimpse into the Super-Sci-Fi Future Home。

In the not-so-distant future, humanity's relationship with technology will transcend current boundaries, paving the way for a futuristic living experience that blurs the lines between imagination and reality. Enter the super-sci-fi future home, a marvel of innovation and comfort unlike anything seen before.At the heart of this futuristic dwelling lies an intricate network of artificial intelligence (AI) and advanced robotics, seamlessly integrated into every aspect of daily life. Imagine waking up to the gentle hum of your personal AI assistant, who not only greets you with your customized morning routine but also anticipates your needs before you even realize them yourself.Step into the living area, where the walls themselvescome to life with immersive holographic displays, allowing you to transform your surroundings at will. Whether you prefer a serene forest retreat or a bustling cityscape, the possibilities are endless, limited only by your imagination.But the true magic of the super-sci-fi future home lies in its adaptive architecture. Gone are the days of rigid floor plans and static living spaces. Instead, nanotechnology-infused materials enable the home to shape-shift according to your preferences, creating dynamic environments tailored to your mood and activities.Need a cozy nook for reading or a spacious area for entertaining guests? With a simple voice command or gesture, the furniture seamlessly reconfigures itself to suit your needs, blurring the lines between form and function.Of course, no futuristic home would be complete without cutting-edge sustainability features. Advanced solar panels and energy-efficient systems ensure minimal environmental impact, while integrated recycling and waste management systems work tirelessly behind the scenes to keep the homerunning smoothly.But perhaps the most awe-inspiring feature of thesuper-sci-fi future home is its ability to transcendphysical limitations. Through the power of virtual reality and augmented reality technologies, you can explore distant worlds, attend live events, or even meet up with friendsand family from the comfort of your own home.In this hyper-connected future, distance becomes obsolete, and the boundaries between the virtual and thereal begin to blur. Yet, amidst all the technological marvels, the super-sci-fi future home remains a sanctuary,a place where comfort, convenience, and innovation converge to create an unparalleled living experience.As we peer into the future, one thing becomes clear:the possibilities are as limitless as the imaginationitself. The super-sci-fi future home is not just a dwelling; it's a glimpse into a world where the boundaries between fantasy and reality fade away, leaving only endless possibilities in their wake.。

前沿调光原理【中英文实用版】英文文档:Frontier Dimming PrinciplesDimming is a crucial aspect of lighting control systems, allowing for the adjustment of light intensity to create the desired atmosphere or to conserve energy.The frontier dimming principles involve various technologies and methods that enhance the functionality and efficiency of lighting systems.One of the primary principles of dimming is the use of dimmers, which are devices that control the amount of power supplied to light fixtures.Dimmers can be manually adjusted or controlled automatically by sensors or remote controls.They work by varying the voltage and current supplied to the light source, which in turn adjusts the brightness.Another important principle is the use of LED lighting.LED lights are more energy-efficient and have a longer lifespan compared to traditional lighting sources.They can be dimmed using specific dimming protocols and drivers that ensure smooth and accurate adjustment of light intensity.Furthermore, the implementation of smart lighting systems is a significant aspect of the frontier dimming principles.These systems use sensors, such as occupancy sensors and light sensors, to automatically adjust the lighting based on the presence of people and the ambient lightlevels.This not only enhances energy efficiency but also creates a comfortable and convenient environment.In conclusion, the frontier dimming principles incorporate advanced technologies and methods to improve the functionality, efficiency, and user experience of lighting systems.The use of dimmers, LED lighting, and smart lighting systems are key components that enable precise control and adjustment of light intensity, resulting in energy savings and enhanced lighting ambiance.中文文档:前沿调光原理调光技术是照明控制系统中的关键组成部分,它允许调整灯光亮度,以创造所需的氛围或节约能源。

"After diving into Dell's Experience Tower theory on modern educational technology, I waspletely blown away! Dell really hammers home the idea that bringing technology into the classroom can supercharge the learning experience for students. By spicing things up with interactive gadgets, students are more likely to wrap their heads aroundplex concepts and actually*want* to learn. As a teacher, I've seen firsthand how tech can light a fire under student engagement and understanding. Dell's theory has only fueled my excitement to keep pumping up the tech factor in my teaching game. Here's to a future full of educational adventures powered by gadgets and gizmos!""在潜入戴尔关于现代教育技术的经验塔理论后,我被彻底吹走!戴尔把把技术带进教室的想法给学生的学习体验加载。

学生们通过用互动的装置来取笑事物,更有可能把头围在复杂的概念上,并且实际上想要学习。

作为一名教师,我亲眼目睹了科技如何在学生参与和理解下点燃火焰。

LIGHTTOOLS ADVANCED TRAININGLight Guide Design and Backlight Pattern Optimization in LightToolsLightTools is a unique optical engineering and design software product that features virtual prototyp-ing, simulation, optimization, and photorealistic renderings of precision illumination applications. The software has adapted solid modeling technology to accommodate the inherent accuracy required to simulate ray paths of light as they traverse through and within optical elements and mechanical struc-tures. The software is straightforward to use, accurate, has the most advanced capabilities commer-cially available, and supports the tasks of design and engineering iterations in addition to analysis.Course GoalsThis training covers LightTools’ special features for designing light guides and backlight panels. You will learn how to optimize light guides using the Light Guide Designer tool. This includes extractor parametrization as well as rendering of the design project.Backlights are similar to light guides in that extractors are optimized on a guiding solid in order to pro-vide uniform illuminance or luminance. You will learn how to use the Backlight Pattern Optimization feature to produce high-quality panel designs.Course FormatThis online course will combine lectures and demonstrations, as well as hands-on examples and workshop problems. Questions and discussions are encouraged.Schedule: 2 days: 9:00am – 12:00pm / 2:00pm – 5:00pm CEST Price: 1 000 Euros / AttendeeWho Should Attend?Current users of LightTools are invited to attend these training sessions.Training sessions are subject to space limitations and topics are subject to change without prior notificationRegistration InformationPlease contact: *******************Prerequisites and Notes:• Attendees must use their own laptops with the latest version of LightTools installed.• Synopsys can provide license key files if needed.• Tuition includes teaching materials.• Tuition much be paid in full 10 days after the training.• Minimum enrollments apply: if there are fewer than four participants, we will cancel the training and postpone your participation to the next training.OPTICAL SOLUTIONS Design Brilliance™LightTools Training。

sensmeSensMe: An Innovative Sensory TechnologyIntroductionIn today's modern world, technology has rapidly advanced and transformed various aspects of our lives. From smartphones to smart homes, there seems to be no limit to the possibilities that technology offers. One groundbreaking technology that has gained significant attention and has the potential to revolutionize the way we experience the world is SensMe. Developed by a team of dedicated researchers and engineers, SensMe integrates sensory technology into various devices, allowing users to interact with their surroundings in ways they never thought possible. In this document, we delve deeper into the concept of SensMe, exploring its features, applications, and potential impacts on various industries.What is SensMe?SensMe is a cutting-edge technology that enhances our sensory perception, enabling us to perceive and respond to our environment in new and exciting ways. It utilizes acombination of sensors and algorithms to collect and interpret data from our surroundings, transforming it into a comprehensive sensory experience. These sensors can detect a wide range of stimuli such as temperature, humidity, light, sound, and even more sophisticated inputs like facial expressions and gestures.How Does SensMe Work?At the core of SensMe lies a highly sophisticated algorithm that processes the data collected from the sensors. This algorithm analyzes and interprets the sensory inputs, generating meaningful content and responses tailored to the user's preferences. For example, SensMe can detect the user's mood through facial expressions and suggest appropriate music playlists to enhance their emotional state. Similarly, it can adjust lighting and temperature settings in a room based on the detected occupancy and environmental conditions, providing a comfortable and personalized experience.Applications of SensMeSensMe has wide-ranging applications across various industries. In the healthcare sector, SensMe can assist medical professionals in monitoring patients' vital signs in real-time,ensuring timely intervention in case of emergencies. In the automotive industry, SensMe can enhance the driving experience by dynamically adjusting the vehicle's settings based on the driver's preferences and environmental conditions. Additionally, SensMe can revolutionize the gaming industry by enabling more immersive and interactive gameplay, where the user's movements and gestures directly influence the virtual world.Impacts on IndustriesWith the integration of SensMe technology, industries are poised for significant transformations. In the retail sector, SensMe can revolutionize the shopping experience by personalizing recommendations based on the user's preferences and physiological state. For instance, when a shopper is browsing through a clothing store, SensMe can detect their body temperature and suggest suitable clothing options for the weather conditions. This level of personalization not only enhances customer satisfaction and loyalty but also opens up new revenue streams for businesses.In the entertainment industry, SensMe can amplify the user's experience by creating multisensory experiences. For example, while watching a movie, SensMe can synchronize the lighting, sound, and vibration patterns in a room to match the scenes,immersing the viewer in the movie's atmosphere. This level of immersion enhances the emotional impact of the content, making the entertainment experience more memorable and engaging.ConclusionSensMe is a monumental breakthrough in sensory technology that has the potential to reshape the way we experience the world. By harnessing the power of sensors and algorithms, SensMe offers a vast range of applications across industries, from healthcare to entertainment. As this technology continues to evolve, it will undoubtedly unlock new possibilities, allowing us to further enrich our daily lives and interactions with the world around us. SensMe opens the door to a future where our senses seamlessly merge with technology, creating a more personalized, interactive, and immersive reality.。

未来纳米管天梯的作文英文回答:In the future, nanotube elevators will revolutionizethe way we travel and transport goods. These elevators will be made of incredibly strong and lightweight carbon nanotubes, which will allow them to reach heightspreviously unimaginable. With the use of nanotubes,elevators will be able to extend into space, connecting different levels of Earth's atmosphere and even reachinginto outer space.Nanotube elevators will have numerous advantages over traditional elevators. Firstly, they will be able to transport people and cargo much faster and more efficiently. The lightweight nature of carbon nanotubes will allow for quick acceleration and deceleration, resulting in shorter travel times. Additionally, the strength of the nanotubes will enable the elevators to carry heavier loads withoutthe need for excessive energy consumption.Another benefit of nanotube elevators is theirpotential to reduce traffic congestion and pollution. As these elevators can reach into outer space, they will provide an alternative transportation method for long-distance travel. Instead of relying solely on airplanes or rockets, people can use the nanotube elevators to quickly and safely reach their destinations. This will not only reduce the number of vehicles on the roads but also decrease carbon emissions, leading to a cleaner and more sustainable environment.Furthermore, nanotube elevators will open up new possibilities for space exploration and colonization. With the ability to extend into outer space, these elevators can serve as a gateway to other planets and celestial bodies. People will be able to travel to space stations or even establish colonies on other planets using these elevators. This could lead to advancements in scientific research, resource extraction, and the potential for human expansion beyond Earth.中文回答:未来的纳米管天梯将彻底改变我们的出行和货物运输方式。

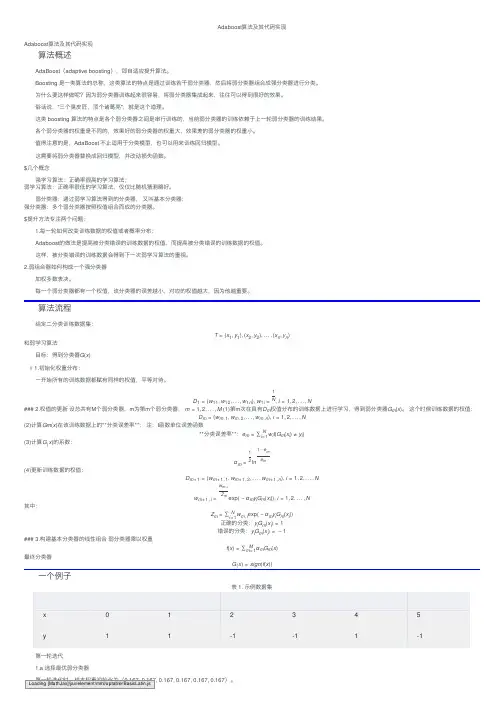

Adaboost 算法及其代码实现Adaboost 算法及其代码实现算法概述AdaBoost (adaptive boosting ),即⾃适应提升算法。

Boosting 是⼀类算法的总称,这类算法的特点是通过训练若⼲弱分类器,然后将弱分类器组合成强分类器进⾏分类。

为什么要这样做呢?因为弱分类器训练起来很容易,将弱分类器集成起来,往往可以得到很好的效果。

俗话说,"三个臭⽪匠,顶个诸葛亮",就是这个道理。

这类 boosting 算法的特点是各个弱分类器之间是串⾏训练的,当前弱分类器的训练依赖于上⼀轮弱分类器的训练结果。

各个弱分类器的权重是不同的,效果好的弱分类器的权重⼤,效果差的弱分类器的权重⼩。

值得注意的是,AdaBoost 不⽌适⽤于分类模型,也可以⽤来训练回归模型。

这需要将弱分类器替换成回归模型,并改动损失函数。

$⼏个概念强学习算法:正确率很⾼的学习算法;弱学习算法:正确率很低的学习算法,仅仅⽐随机猜测略好。

弱分类器:通过弱学习算法得到的分类器, ⼜叫基本分类器;强分类器:多个弱分类器按照权值组合⽽成的分类器。

$提升⽅法专注两个问题:1.每⼀轮如何改变训练数据的权值或者概率分布:Adaboost 的做法是提⾼被分类错误的训练数据的权值,⽽提⾼被分类错误的训练数据的权值。

这样,被分类错误的训练数据会得到下⼀次弱学习算法的重视。

2.弱组合器如何构成⼀个强分类器加权多数表决。

每⼀个弱分类器都有⼀个权值,该分类器的误差越⼩,对应的权值越⼤,因为他越重要。

算法流程给定⼆分类训练数据集:T =(x 1,y 1),(x 2,y 2),...,(x n ,y n )和弱学习算法⽬标:得到分类器G (x )# 1.初始化权重分布:⼀开始所有的训练数据都赋有同样的权值,平等对待。

D 1=(w 11,w 12,...,w 1n ), w 1i =1N , i =1,2,...,N### 2.权值的更新 设总共有M 个弱分类器,m 为第m 个弱分类器, m =1,2,...,M (1)第m 次在具有D m 权值分布的训练数据上进⾏学习,得到弱分类器G m (x )。

探索未来:科技,环境与人类共生In the fast-paced world of the 21st century, technology, environment, and human coexistence have become intertwined, shaping our future in profound ways. The Fujian Provincial Quality Inspection for the Class of 2024 highlights this intersection, urging students to reflect on how we can harness technology to safeguard our environment and foster sustainable development.Firstly, the role of technology in environmental protection cannot be overstated. Advancements in renewable energy, such as solar and wind power, have the potential to decarbonize our energy systems, reducing greenhouse gas emissions and air pollution. Additionally, technology canaid in waste management, recycling, and resource recovery, thus closing the loop on waste disposal and minimizing environmental impact.However, technology is not a panacea. Its unchecked growth and misuse can have devastating consequences for our planet. The rise of single-use plastics and fast fashion, enabled by modern manufacturing techniques, has led to a significant increase in plastic waste and carbon emissions.Therefore, it is crucial that we approach technology with caution, ensuring that it serves as a tool for environmental preservation, rather than a catalyst for degradation.Furthermore, human behavior plays a pivotal role in environmental sustainability. Simple lifestyle changes, such as reducing food waste, conserving water, and prioritizing public transportation or cycling, can have a significant impact on reducing environmental footprints. Education and awareness-raising are essential in encouraging these behaviors and fostering a culture of environmental responsibility.To achieve true sustainability, a holistic approach is necessary. Policymakers must prioritize environmental protection in their decisions, implementing regulations that encourage renewable energy use and discourage harmful practices. Corporations must also take responsibility, investing in clean technology and sustainable production methods. At the same time, individuals must embrace environmental values and incorporate them into their daily lives.In conclusion, the future of our planet depends on the harmonious coexistence of technology, environment, and humanity. By harnessing the power of technology, fostering sustainable human behaviors, and implementing policies that prioritize environmental protection, we can build a brighter, more sustainable future for all.**探索未来:科技、环境与人类共生**在21世纪这个快速发展的时代,科技、环境以及人类共生已经成为一个紧密相连的整体,它们以深远的方式塑造着我们的未来。

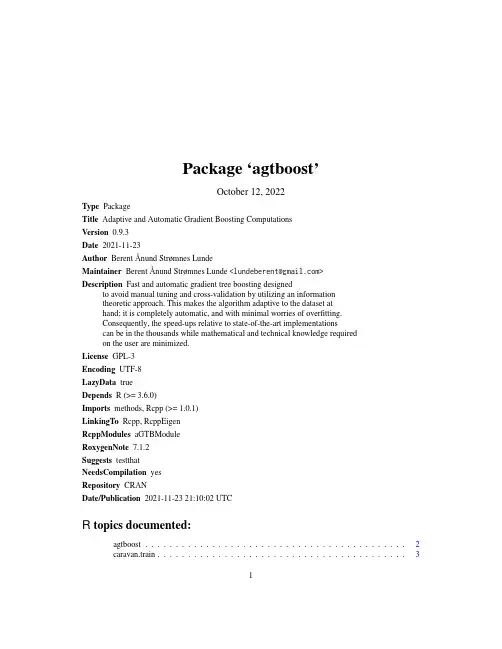

Package‘agtboost’October12,2022Type PackageTitle Adaptive and Automatic Gradient Boosting ComputationsVersion0.9.3Date2021-11-23Author BerentÅnund Strømnes LundeMaintainer BerentÅnund Strømnes Lunde<*********************>Description Fast and automatic gradient tree boosting designedto avoid manual tuning and cross-validation by utilizing an informationtheoretic approach.This makes the algorithm adaptive to the dataset athand;it is completely automatic,and with minimal worries of overfitting.Consequently,the speed-ups relative to state-of-the-art implementationscan be in the thousands while mathematical and technical knowledge requiredon the user are minimized.License GPL-3Encoding UTF-8LazyData trueDepends R(>=3.6.0)Imports methods,Rcpp(>=1.0.1)LinkingTo Rcpp,RcppEigenRcppModules aGTBModuleRoxygenNote7.1.2Suggests testthatNeedsCompilation yesRepository CRANDate/Publication2021-11-2321:10:02UTCR topics documented:agtboost (2)caravan.train (3)12agtboostplexity (4)gbt.convergence (5)gbt.importance (6)gbt.ksval (7)gbt.load (8)gbt.save (8)gbt.train (9)predict.Rcpp_ENSEMBLE (11)predict.Rcpp_GBT_COUNT_AUTO (13)Index14 agtboost Adaptive and automatic gradient boosting computations.DescriptionAdaptive and Automatic Gradient Boosting ComputationsDetailsagtboost is a lightning fast gradient boosting library designed to avoid manual tuning and cross-validation by utilizing an information theoretic approach.This makes the algorithm adaptive to the dataset at hand;it is completely automatic,and with minimal worries of overfitting.Consequently, the speed-ups relative to state-of-the-art implementations are in the thousands while mathematical and technical knowledge required on the user are minimized.Important functions:•gbt.train:function for training an agtboost ensemble•predict.Rcpp_ENSEMBLE:function for predicting from an agtboost ensemble See individual function documentation for usage.Author(s)BerentÅnund Strømnes Lundecaravan.train3 caravan.train The Insurance Company(TIC)BenchmarkDescriptioncaravan.train and caravan.test both contain a design matrix with85columns and a response vector.The train set consists of70%of the data,with4075rows.The test set consists of the remaining30%with1747rows.The following references the documentation within the ISLR package:The original data contains5822real customer records.Each record consists of86vari-ables,containing sociodemographic data(variables1-43)and product ownership(variables44-86).The sociodemographic data is derived from zip codes.All customers living in areas with the same zip code have the same sociodemographic attributes.Variable86(Purchase)indicates whether the customer purchased a caravan insurance policy.Further information on the individual variables can be obtained at http://www.liacs.nl/~putten/library/cc2000/data.htmlUsagecaravan.train;caravan.testFormatLists with a design matrix x and response ySourceThe data was originally supplied by Sentient Machine Research and was used in the CoIL Challenge 2000.ReferencesP.van der Putten and M.van Someren(eds).CoIL Challenge2000:The Insurance Company Case.Published by Sentient Machine Research,Amsterdam.Also a Leiden Institute of Advanced Com-puter Science Technical Report2000-09.June22,2000.See http://www.liacs.nl/~putten/library/cc2000/ P.van der Putten and M.van Someren.A Bias-Variance Analysis of a Real World Learning Prob-lem:The CoIL Challenge2000.Machine Learning,October2004,vol.57,iss.1-2,pp.177-195, Kluwer Academic PublishersJames,G.,Witten,D.,Hastie,T.,and Tibshirani,R.(2013)An Introduction to Statistical Learning with applications in R,https://trevorhastie.github.io/ISLR/,Springer-Verlag,New YorkExamplessummary(caravan.train)summary(caravan.test)plexity plexity Return complexity of model in terms of hyperparameters.Descriptionplexity creates a list of hyperparameters from a modelUsageplexity(model,type)Argumentsmodel object or pointer to object of class ENSEMBLEtype currently supports"xgboost"or"lightgbm"DetailsReturns the complexity of model in terms of hyperparameters associated to model type.Valuelist with type hyperparameters.Examplesset.seed(123)library(agtboost)n<-10000xtr<-as.matrix(runif(n,0,4))ytr<-rnorm(n,xtr,1)xte<-as.matrix(runif(n,0,4))yte<-rnorm(n,xte,1)model<-gbt.train(ytr,xtr,learning_rate=0.1)plexity(model,type="xgboost")plexity(model,type="lightgbm")##See demo(topic="gbt-complexity",package="agtboost")gbt.convergence5 gbt.convergence Convergence of agtboost model.Descriptiongbt.convergence calculates loss of data over iterations in the modelUsagegbt.convergence(object,y,x)Argumentsobject Object or pointer to object of class ENSEMBLEy response vectorx design matrix for training.Must be of type matrix.DetailsComputes the loss on supplied data at each boosting iterations of the model passed as object.This may be used to visually test for overfitting on test data,or the converce,to check for underfitting or non-convergence.Valuevector with$K+1$elements with loss at each boosting iteration and at thefirst constant predictionExamples##Gaussian regression:x_tr<-as.matrix(runif(500,0,4))y_tr<-rnorm(500,x_tr,1)x_te<-as.matrix(runif(500,0,4))y_te<-rnorm(500,x_te,1)mod<-gbt.train(y_tr,x_tr)convergence<-gbt.convergence(mod,y_te,x_te)which.min(convergence)#Should be fairly similar to boosting iterations+1mod$get_num_trees()+1#num_trees does not include initial prediction6gbt.importance gbt.importance Importance of features in a model.Descriptiongbt.importance creates a data.frame of feature importance in a modelUsagegbt.importance(feature_names,object)Argumentsfeature_names character vector of feature namesobject object or pointer to object of class ENSEMBLEDetailsSums up"expected reduction"in generalization loss(scaled using learning_rate)at each node for each tree in the model,and attributes it to the feature the node is split on.Returns result in terms of percents.Valuedata.frame with percentwise reduction in loss of total attributed to each feature.Examples##Load datadata(caravan.train,package="agtboost")train<-caravan.trainmod<-gbt.train(train$y,train$x,loss_function="logloss",verbose=10)feature_names<-colnames(train$x)imp<-gbt.importance(feature_names,mod)impgbt.ksval7 gbt.ksval Kolmogorov-Smirnov validation of modelDescriptiongbt.ksval transforms observations to U(0,1)if the model is correct and performs a Kolmogorov-Smirnov test for uniformity.Usagegbt.ksval(object,y,x)Argumentsobject Object or pointer to object of class ENSEMBLEy Observations to be testedx design matrix for training.Must be of type matrix.DetailsModel validation of model passed as object using observations y.Assuming the loss is a negative log-likelihood and thus a probabilistic model,the transformationu=F Y(y;x,θ)∼U(0,1),is usually valid.One parameter,µ=g−1(f(x)),is given by the model.Remaining parameters are estimated globally over feature space,assuming they are constant.This then allow the above trans-formation to be exploited,so that the Kolmogorov-Smirnov test for uniformity can be performed.If the response is a count model(poisson or negbinom),the transformationu i=F Y(y i−1;x,θ)+Uf Y(y i,x,θ),U∼U(0,1)is used to obtain a continuous transformation to the unit interval,which,if the model is correct,will give standard uniform random variables.ValueKolmogorov-Smirnov test of modelExamples##Gaussian regression:x_tr<-as.matrix(runif(500,0,4))y_tr<-rnorm(500,x_tr,1)x_te<-as.matrix(runif(500,0,4))y_te<-rnorm(500,x_te,1)mod<-gbt.train(y_tr,x_tr)gbt.ksval(mod,y_te,x_te)8gbt.save gbt.load Load an aGTBoost ModelDescriptiongbt.load is an interface for loading a agtboost model.Usagegbt.load(file)Argumentsfile Validfile-path to a stored aGTBoost modelDetailsThe load function for agtboost.Loades a GTB model from a txtfile.ValueTrained aGTBoost model.See Alsogbt.savegbt.save Save an aGTBoost ModelDescriptiongbt.save is an interface for storing a agtboost model.Usagegbt.save(gbt_model,file)Argumentsgbt_model Model object or pointer to object of class ENSEMBLEfile Validfile-pathDetailsThe model-storage function for agtboost.Saves a GTB model as a txtfile.Might be retrieved using gbt.loadValueTxtfile that can be loaded using gbt.load.See Alsogbt.loadgbt.train aGTBoost Training.Descriptiongbt.train is an interface for training an agtboost model.Usagegbt.train(y,x,learning_rate=0.01,loss_function="mse",nrounds=50000,verbose=0,gsub_compare,algorithm="global_subset",previous_pred=NULL,weights=NULL,force_continued_learning=FALSE,offset=NULL,...)Argumentsy response vector for training.Must correspond to the design matrix x.x design matrix for training.Must be of type matrix.learning_rate control the learning rate:scale the contribution of each tree by a factor of0< learning_rate<1when it is added to the current approximation.Lower valuefor learning_rate implies an increase in the number of boosting iterations:low learning_rate value means model more robust to overfitting but slower tocompute.Default:0.01loss_function specify the learning objective(loss function).Only pre-specified loss functions are currently supported.•mse regression with squared error loss(Default).•logloss logistic regression for binary classification,output score beforelogistic transformation.•poisson Poisson regression for count data using a log-link,output scorebefore natural transformation.•gamma::neginv gamma regression using the canonical negative inverselink.Scaling independent of y.•gamma::log gamma regression using the log-link.Constant informationparametrisation.•negbinom Negative binomial regression for count data with overdispersion.Log-link.•count::auto Chooses automatically between Poisson or negative binomialregression.nrounds a just-in-case max number of boosting iterations.Default:50000verbose Enable boosting tracing information at i-th iteration?Default:0.gsub_compare Deprecated.Boolean:Global-subset comparisons.FALSE means standard GTB, TRUE compare subset-splits with global splits(next root split).Default:TRUE.algorithm specify the algorithm used for gradient tree boosting.•vanilla ordinary gradient tree boosting.Trees are optimized as if theywere the last tree.•global_subset function-change to target maximized reduction in general-ization loss for individual datapointsprevious_pred prediction vector for training.Boosted training given predictions from another model.weights weights vector for scaling contributions of individual observations.Default NULL (the unit vector).force_continued_learningBoolean:FALSE(default)stops at information stopping criterion,TRUE stops atnround iterations.offset add offset to the model g(mu)=offset+F(x)....additional parameters passed.•if loss_function is’negbinom’,dispersion must be provided in...DetailsThese are the training functions for an agtboost.Explain the philosophy and the algorithm and a little mathgbt.train learn trees with adaptive complexity given by an information criterion,until the same (but scaled)information criterion tells the algorithm to stop.The data used for training at each boosting iteration stems from a second order Taylor expansion to the loss function,evaluated at predictions given by ensemble at the previous boosting iteration.ValueAn object of class ENSEMBLE with some or all of the following elements:•handle a handle(pointer)to the agtboost model in memory.•initialPred afield containing the initial prediction of the ensemble.•set_param function for changing the parameters of the ensemble.•train function for re-training(or from scratch)the ensemble directly on vector y and design matrix x.•predict function for predicting observations given a design matrix•predict2function as above,but takes a parameter max number of boosting ensemble itera-tions.•estimate_generalization_loss function for calculating the(approximate)optimism of the ensemble.•get_num_trees function returning the number of trees in the ensemble.ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926 See Alsopredict.Rcpp_ENSEMBLEExamples##A simple gtb.train example with linear regression:x<-runif(500,0,4)y<-rnorm(500,x,1)x.test<-runif(500,0,4)y.test<-rnorm(500,x.test,1)mod<-gbt.train(y,as.matrix(x))y.pred<-predict(mod,as.matrix(x.test))plot(x.test,y.test)points(x.test,y.pred,col="red")predict.Rcpp_ENSEMBLE aGTBoost PredictionDescriptionpredict is an interface for predicting from a agtboost model.Usage##S3method for class Rcpp_ENSEMBLEpredict(object,newdata,...)Argumentsobject Object or pointer to object of class ENSEMBLEnewdata Design matrix of data to be predicted.Type matrix...additional parameters passed.Currently not in use.DetailsThe prediction function for ing the generic predict function in R is also possible, using the same arguments.ValueFor regression or binary classification,it returns a vector of length nrows(newdata).ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926 See Alsogbt.trainExamples##A simple gtb.train example with linear regression:x<-runif(500,0,4)y<-rnorm(500,x,1)x.test<-runif(500,0,4)y.test<-rnorm(500,x.test,1)mod<-gbt.train(y,as.matrix(x))##predict is overloadedy.pred<-predict(mod,as.matrix(x.test))plot(x.test,y.test)points(x.test,y.pred,col="red")predict.Rcpp_GBT_COUNT_AUTO13 predict.Rcpp_GBT_COUNT_AUTOaGTBoost Count-Regression Auto PredictionDescriptionpredict is an interface for predicting from a agtboost model.Usage##S3method for class Rcpp_GBT_COUNT_AUTOpredict(object,newdata,...)Argumentsobject Object or pointer to object of class GBT_ZI_MIXnewdata Design matrix of data to be predicted.Type matrix...additional parameters passed.Currently not in use.DetailsThe prediction function for ing the generic predict function in R is also possible, using the same arguments.ValueFor regression or binary classification,it returns a vector of length nrows(newdata).ReferencesBerentÅnund Strømnes Lunde,Tore Selland Kleppe and Hans Julius Skaug,"An Information Criterion for Automatic Gradient Tree Boosting",2020,https:///abs/2008.05926See Alsogbt.trainExamples##A simple gtb.train example with linear regression:##Random generation of zero-inflated poisson2+2Index∗datasetscaravan.train,3agtboost,2caravan.test(caravan.train),3caravan.train,3plexity,4gbt.convergence,5gbt.importance,6gbt.ksval,7gbt.load,8,9gbt.save,8,8gbt.train,2,9,12,13predict.Rcpp_ENSEMBLE,2,11,11predict.Rcpp_GBT_COUNT_AUTO,1314。

In todays fastpaced world,the lifestyle of young people has undergone significant changes.The rapid development of technology,the pursuit of career success,and the pressure to keep up with societal expectations have all contributed to a lifestyle that is characterized by speed and efficiency.This essay will explore the various aspects of the fastpaced life of young people,including the reasons behind it,its impact on their lives, and the potential solutions to mitigate its negative effects.Reasons for the FastPaced Life1.Technological Advancements:The advent of smartphones,the internet,and social media has made it possible for young people to be constantly connected.This connectivity has led to an expectation of instant gratification and a need to stay updated with the latest trends and news,which contributes to a faster pace of life.cational Pressures:The competitive nature of education systems worldwide has put immense pressure on young people to excel academically.The need to stand out in a crowded job market has led to an emphasis on extracurricular activities,internships,and continuous learning,all of which require time and energy.3.Workplace Demands:The modern workplace is characterized by long hours,tight deadlines,and the expectation of being available at all times.This has led to a blurring of the lines between work and personal life,with young professionals often feeling the need to be always on.4.Social Media Influence:The influence of social media has created a culture where young people feel the need to document and share every aspect of their lives.This constant need for validation and the fear of missing out FOMO can lead to a sense of urgency and a faster pace of life.Impact on Young Peoples Lives1.Mental Health:The constant pressure to keep up with the fast pace of life can lead to stress,anxiety,and burnout.Young people may struggle with feelings of inadequacy anda fear of failure,which can negatively impact their mental health.2.Physical Health:A sedentary lifestyle,often a result of long hours spent working or studying,can lead to health issues such as obesity,cardiovascular diseases,and poor sleep quality.3.Social Relationships:The fastpaced life can also affect social relationships.Youngpeople may find it difficult to maintain close friendships and family bonds due to the lack of time and the prioritization of work and personal achievements.4.WorkLife Balance:Striking a balance between professional and personal life becomesa challenge.The fastpaced life can lead to a situation where work dominates,leaving little time for leisure activities,hobbies,and personal growth.Potential Solutions1.Promoting a Healthy WorkLife Balance:Employers and educational institutions can play a role by promoting a culture that values worklife balance.This could include flexible working hours,encouraging time off,and providing resources for stress management.2.Encouraging Mindfulness and SelfCare:Young people should be encouraged to practice mindfulness and engage in selfcare activities.This can help them manage stress and maintain a healthier lifestyle.3.Limiting Social Media Use:Reducing the time spent on social media can help young people focus on more meaningful activities and reduce the pressure to keep up with the online world.cation on Time Management:Teaching young people effective time management skills can help them navigate their busy lives more efficiently and reduce the feeling of being overwhelmed.In conclusion,the fastpaced life of young people is a complex issue with farreaching implications.It is essential to recognize the challenges it presents and to work towards creating a society that supports a more balanced and sustainable lifestyle for the younger generation.。

一、根据首字母填写单词(单词拼写)1. The tickets can only be p__________ in advance from our website. (根据首字母单词拼写)2. The old man is mentally ill and cannot be r__________ for his actions. (根据首字母单词拼写)3. Being a___________ to online games does harm to our physical and mental health. (根据首字母单词拼写)二、根据汉语意思填写单词(单词拼写)4. His quality of life has ________ (改善;提高) dramatically since the operation. (根据汉语提示单词拼写)5. The problem was so __________(令人糊涂的) that he had a _________(迷惑的) look on his face. (根据汉语提示单词拼写)6. The ________(生存) of the fittest is the basic law of market economy. (根据汉语提示单词拼写)三、根据中英文提示填写单词(单词拼写)7. Li and his v______ (志愿者) friends saved many milu deer from the flood and let them back into the wild. (根据中英文提示填空)8. Attempts to find a s__________ (解决方法) have failed. (根据中英文提示单词拼写)四、完成句子9. 老师建议每个人积极参加英语派对。

(take part in)The teacher recommended that everyone _________________________ the English party.10. 如果你想完成这项任务,我推荐你寻求专业的建议。

全文分为作者个人简介和正文两个部分:作者个人简介:Hello everyone, I am an author dedicated to creating and sharing high-quality document templates. In this era of information overload, accurate and efficient communication has become especially important. I firmly believe that good communication can build bridges between people, playing an indispensable role in academia, career, and daily life. Therefore, I decided to invest my knowledge and skills into creating valuable documents to help people find inspiration and direction when needed.正文:畅想未来智能生活英语作文800字免费全文共3篇示例,供读者参考篇1My Vision of the Intelligent FutureAs a high school student, I can't help but dream about what incredible technological advancements the future may hold. With the rapid pace of innovation happening all around us, Itruly believe we are on the cusp of an amazing era where artificial intelligence becomes seamlessly integrated into our daily lives in unimaginable ways.To envision this intelligent future, I think it's helpful to look at some of the AI-powered innovations that are already transforming how we live. Just in the last few years, we've seen the rise of virtual assistants like Siri, Alexa and Google Assistant that can handle tedious tasks just by us speaking natural voice commands. While currently fairly limited in scope, I can foresee a future where these AI helpers become infinitely smarter and can understand and engage with us like another human being.Rather than just playing music or setting reminders, superintelligent AI assistants could have free-flowing conversations with us on any topic imaginable. They could be customized to every individual's unique personality, interests and needs - acting as intelligent companions that understand us better than we understand ourselves. Need someone to beautifully explain a complex concept you're struggling with? Your AI companion will be able to break it down in a way your mind can grasp. Looking for someone to bounce ideas off for a creative project? Your AI sidekick will be able to ideate with you and provide valuable insights.Beyond just serving as intellectual partners, AI is also bound to pervade the physical world around us through the advent of ubiquitous computing and the Internet of Things. Our homes and cities will become blanketed in a network of interconnected smart devices and sensors, quietly optimizing and anticipating our needs without us ever having to lift a finger. Imagine an AIHomeOS that has complete control over every aspect of your living environment - from temperature control and lighting adjustments to keeping surfaces spotlessly clean through nanotech waste recyclers and automated repair drones.Smart infrastructure in smart cities will route our autonomous vehicles intelligently through traffic while managing distribution of renewable energy sources from solar grids and other clean power systems. Vertical hydroponic urban farms will use machine learning models to precisely optimize crop yields based on weather patterns and consumer demand. Every aspect of our civilization will become a seamlessly choreographed dance of hyper-efficient production and distribution powered by pervasive ambient intelligence.As exciting as those technological wonders sound, I know there are also potential risks that need to be carefully managed. AI systems as powerful as what I've described could potentiallycause vast disruptions to employment if not introduced responsibly. Privacy and security issues would also need to be ironclad. And of course, we must be vigilant against any possibility of superintelligent AI becoming misaligned with human ethics and values.I have faith, however, that humanity's brightest minds are already diligently working to address these risks and ensure advanced AI remains under meaningful human control as we reap its tremendous benefits. Ethical AI development frameworks and robust AI governance policies will be crucial for ensuring we shepherd in an era of peaceful and prosperous human-machine coexistence.All in all, while the shape of things to come is still wildly uncertain, I feel immensely optimistic about the positive potential that widely distributed artificial intelligence holds for my generation and those to follow. As intelligent systems grow ever more advanced, I believe they will empower humanity to solve our biggest challenges and unlock wondrous new frontiers of creativity, discovery and understanding. The intelligent future, while still just a dream today, feels wondrously inevitable. And as a student, I can't wait to play a part in manifesting it.篇2Envisioning the Intelligent FutureAs I gaze out the window at the soaring skyscrapers and hovercars zipping by, I can't help but marvel at how rapidly technology is advancing. Just a few decades ago, the smart devices and artificial intelligence that now permeate our lives seemed like pure science fiction. But here we are in the year 2050, living in an era of unprecedented innovation and intelligent living.One of the most transformative developments has been the rise of personal AI assistants. My AI companion, Alyx, is integrated into every aspect of my daily routine. In the morning, her soothing voice gently rouses me from slumber and provides a customized briefing - my schedule, important reminders, news updates tailored to my interests, and even personalized nutrition recommendations based on my biometrics.As I prepare for my day, Alyx handles thousands of minute tasks seamlessly in the background, from automating my smart home's temperature and lighting to coordinating my autonomous transport. With her predictive capabilities, she anticipates my needs before I even realize them myself.At school, Alyx is an indispensable study partner. She can instantly access and synthesize information across virtually anysubject, providing detailed explanations and insights far beyond what any textbook could offer. Better yet, she tailors her teaching methods to my unique learning style, ensuring I truly grasp complex concepts.Looking ahead, I can scarcely imagine the marvels the next few decades will bring. Nanotechnology and advanced manufacturing techniques could lead to intelligent,self-repairing homes and cities. Renewable energy sources like fusion power could provide abundant clean energy. And breakthroughs in fields like biotechnology and neural implants may one day amplify our cognitive abilities in astounding ways.Of course, such rapid technological progress is not without its challenges and risks. We've already witnessed how AI can be exploited for nefarious purposes like cyber-attacks, surveillance, and automated misinformation campaigns that undermine democracy. Rogue AIs that become misaligned with human values represent a catastrophic existential threat.Similarly, intelligent systems' voracious energy and resource demands could exacerbate environmental degradation if not carefully managed. And as AI increasingly automates jobs across industries, we'll need to rethink education, employment, andsocial policies to ensure no one is left behind in the coming transition.Resolving these complex ethical quandaries will require profound moral wisdom and foresight from today's leaders and policymakers. We must remain vigilant against the concentration of power that could arise from monopolistic control over transformative future technologies.Ultimately though, I'm optimistic that we can harness the incredible potential of intelligent technology to create a better world. For all its perils, the advent of AI and intelligent living represents a pivotal chance to solve humanity's grandest challenges - eliminating disease and poverty, reversing environmental destruction, making abundant clean energy, and perhaps even unlocking the secrets of our universe.Just as the agricultural and industrial revolutions radically reshaped past civilizations, the coming intelligence revolution will upend our economic, social, and political norms in unimaginable ways. But if we can carefully navigate the risks while embracing the opportunities, we may finally realize the age-old dream of a true utopia - a world of endless abundance, where intelligent machines empower humanity to achieve our immense potential.Our future is quickly materializing into a present of intelligent living. How we choose to wield these increasingly powerful technologies will determine the destiny of our civilization and species. I eagerly await what the coming decades will bring as we venture boldly into this new frontier.篇3Envisioning Future Intelligent LivingAs a student fascinated by the rapid pace of technological advancements, I often find myself pondering what the future may hold in terms of intelligent living. With artificial intelligence (AI), the Internet of Things (IoT), and cutting-edge innovations permeating every aspect of our lives, the way we live, work, and interact with our environments is poised for a seismic transformation. In this essay, I will explore my vision of how intelligent technologies could shape our daily experiences in the years to come.One area that holds immense potential is smart home automation. Imagine a world where our homes become intuitive, adaptive ecosystems tailored to our preferences and needs. Voice-controlled assistants, empowered by AI, could manage everything from temperature and lighting to security andentertainment systems, seamlessly adjusting to our routines and commands. Appliances and devices would communicate with each other, optimizing energy consumption and ensuring optimal functionality. For instance, your refrigerator could automatically place grocery orders when supplies run low, while your smart oven could download recipes and prepare meals based on your dietary preferences and schedule.Transportation is another realm poised for a paradigm shift. Self-driving vehicles, powered by advanced AI and sensor technologies, could revolutionize the way we commute. With enhanced safety features and efficient route planning, these autonomous vehicles could alleviate traffic congestion, reduce emissions, and provide greater mobility for those unable to drive. Moreover, the integration of these vehicles with smart city infrastructure could pave the way for seamless transportation experiences, where our vehicles communicate with traffic signals, parking systems, and other connected elements for optimal navigation.Education is an area that could benefit greatly from intelligent technologies. Personalized learning experiences, tailored to individual strengths, weaknesses, and learning styles, could become the norm. AI-powered tutoring systems couldadapt to each student's pace and needs, providing customized feedback and learning resources. Virtual and augmented reality could transport students to immersive educational environments, fostering hands-on learning and engagement with complex concepts. Additionally, intelligent learning platforms could analyze student data to identify areas for improvement and recommend personalized strategies for academic success.Healthcare is another domain ripe for transformation.AI-driven diagnostic tools could analyze vast amounts of medical data, including genomic information, to provide more accurate and personalized diagnoses and treatment plans. Wearable devices and implantable sensors could continuously monitor our vital signs, alerting healthcare professionals to potential issues before they become critical. Robotic surgery could enhance precision and minimize invasive procedures, while AI-powered drug discovery could accelerate the development of new and more effective therapies.While the potential benefits of intelligent living are vast, we must also consider the ethical implications and potential challenges. Issues surrounding privacy, data security, job displacement, and the responsible development and deployment of AI systems must be carefully addressed. As asociety, we must strike a balance between harnessing the power of these technologies and ensuring they are developed and used in a manner that prioritizes human well-being, privacy, and ethical principles.In conclusion, the future of intelligent living holds both exciting possibilities and complex challenges. As a student eagerly anticipating this technological revolution, I am filled with a sense of wonder and optimism. However, I also recognize the importance of responsible development and thoughtful implementation of these technologies. By embracing innovation while upholding ethical standards and prioritizing human values, we can shape a future where intelligent living enhances our quality of life, fosters sustainability, and unlocks new realms of opportunity for personal growth and societal progress.。

Roborock hits global top in smart vacuumcleaner sales石头科技:中国硬核科技出海新样本中文新闻:石头科技:中国硬核科技出海新样本根据市场调查机构欧睿国际的调研数据,一家中国科技公司,石头科技的智能吸尘器品牌在2023年销量登顶全球第一。

上周五,石头科技总裁全刚在北京的产品发布会上表示:“石头科技始终致力于将真正价值提供给用户,并坚持用长远的眼光看待事物。

”即使在机器人吸尘器市场增速放缓的情况下,石头科技不仅在中国本土市场,更在美国、欧洲、亚太等地区都取得了不俗的销售成绩。

作为一家成立十年的科技公司,石头科技将自身的快速增长归功于其在研发方面的大量投资。

该公司在研发方面投入了超过19亿元人民币(2.63亿美元),并成立了人工智能、机电工程和光电子三大研究院。

英文新闻:Roborock hits global top in smart vacuum cleaner sales Chinese tech company Roborock became the top-selling brand of smart vacuum cleaners worldwide in terms of global sales in 2023, according to the market research firm Euromonitor International.Quan Gang, president of Roborock, said in a product launch event in Beijing on Friday that "Roborock has always centered its efforts on creating genuine value for users and adhering to a long-term perspective."Even amidst a slowdown in the growth rate of the robotic vacuum cleaner market, Roborock has demonstrated exceptional sales performance not only in its home market of China but also in regions including the United States, Europe and the Asia-Pacific.As a ten-year-old technology company, Roborock attributed its rapid growth to its substantial investment in research and development. The company has invested over 1.9 billion yuan($263 million) in R&D efforts and established three major research institutes dedicated to AI, electromechanical engineering and optoelectronics.重点词汇1. vacuum英[ˈvækjuːm] 美[ˈvækjuːm]n. 真空2. adhering英 [ədˈhɪərɪ] 美 [ədˈhɪrɪŋ]v. 坚持3. amidst英 [əˈmɪdst] 美 [əˈmɪdst]prep. 在……中听双语新闻-填词Roborock hits global top in smart vacuum cleaner sales Chinese tech company Roborock became the top-selling brand of smart vacuum cleaners worldwide 1 global sales in 2023, according to the market research firm Euromonitor International.Quan Gang, president of Roborock, said in a product launch event in Beijing on Friday that "Roborock has always centered its efforts on creating 2 value for users and adhering to a long-term perspective."Even amidst a slowdown in the growth rate of the robotic vacuum cleaner market, Roborock has demonstrated exceptional sales performance not only in its home market of China but also in regions including the United States, Europe and the Asia-Pacific.As a ten-year-old technology company, Roborock attributed its rapid growth to its substantial investment in research and development. The company has invested over 1.9 billion yuan($263 million) in R&D efforts and 3 three major research institutes dedicated to AI, electromechanical engineering and optoelectronics.听双语新闻-语法填空Roborock hits global top in smart vacuum cleaner salesChinese tech company Roborock became the top-selling brand of smart vacuum cleaners worldwide in terms of global sales in 2023, according to the market research firm Euromonitor International.Quan Gang, president of Roborock, said in a product launch event in Beijing on Friday that "Roborock has always centered its efforts 1 creating genuine value for users and adhering to a long-term perspective."Even amidst a slowdown in the growth rate of the robotic vacuum cleaner market, Roborock has demonstrated 2 (exception) sales performance not only in its home market of China but also in regions including the United States, Europe and the Asia-Pacific.As a ten-year-old technology company, Roborock attributed its rapid growth to its substantial investment in research and development. The company has invested over 1.9 billion yuan($263 million) in R&D efforts and established three major research institutes 3 (dedicate) to AI, electromechanical engineering and optoelectronics.填词练习答案1. in terms of2. genuine3. established语法填空答案1. on2. exceptional3. dedicated。

前沿科技产品广告文案1. Introducing the New Generation SmartwatchTake control of your lifestyle with our state-of-the-art smartwatch. With its sleek design and advanced features, this cutting-edge gadget is designed to enhance your everyday life. Stay connected, monitor your health, and unleash your productivity with just a glance at your wrist. Get ready to experience the future of wearable technology.2. Rewrite the Rulebook with Our Groundbreaking Augmented Reality GlassesStep into the world of augmented reality like never before with our revolutionary AR glasses. Immerse yourself in a world where virtual and real blend seamlessly, providing endless possibilities for gaming, education, and entertainment. Say goodbye to traditional screens and let your imagination take flight. The future is here, and it's all within your vision.3. Your Personal Assistant Redefined – Meet the AI-Powered ChatbotExperience the next level of virtual assistance with our AI-powered chatbot. This intelligent companion is here to make your life easier, whether it's managing your tasks, answering queries, or keeping you entertained. With its advanced natural language processing capabilities, you'll never feel alone again. Discover a new side to technology with our smart and intuitive chatbot.4. Unlock the Power of Wireless ChargingFree yourself from the frustrations of tangled cords and limited battery life. Our groundbreaking wireless charging technologybrings convenience and efficiency to your daily routine. Simply place your compatible device on our sleek charging pad and watch as it powers up. Say goodbye to messy cables and hello to a wire-free future.5. Elevate Your Gaming Experience with the Ultimate Gaming ConsoleGet ready for an unparalleled gaming experience with our next-generation console. This powerhouse of innovation combines superior graphics, lightning-fast processing, and immersive audio to transport you to another realm. Whether you're a casual gamer or a hardcore enthusiast, our console is designed to exceed your expectations. Prepare to level up and be blown away.6. Fitness Tracking Redefined – Introducing the Smart Fitness BandTake your fitness journey to new heights with our advanced smart fitness band. Packed with features like heart rate monitoring, sleep analysis, and personalized coaching, this sleek wearable empowers you to reach your health goals effortlessly. Stay motivated, stay active, and stay ahead with our state-of-the-art smart fitness band.7. Unleash Your Creativity with the Next-Generation 3D Printer Say hello to limitless possibilities with our cutting-edge 3D printer. From prototyping to manufacturing, this revolutionary device transforms your ideas into reality. Create intricate designs, customize everyday objects, and redefine the boundaries of what's possible. Don't just think outside the box; print it with our innovative 3D printer.8. The Future of Transportation – Discover Electric Mobility Embrace a greener and smarter way to get around with our groundbreaking electric vehicle. Powered by the latest technology, our electric vehicle offers a fusion of performance, efficiency, and sustainability. Say goodbye to fossil fuels and hello to a cleaner tomorrow. Experience a new era of transportation with our state-of-the-art electric vehicle.注意:此为人工翻译,仅供参考,不代表最终内容。

The Night Vision of Owls:Guardians of the DarknessOwls are fascinating creatures known for their exceptional night vision, making them the guardians of the darkness.Their unique characteristics and impressive visual abilities have earned them the title of"masters of nocturnal vision."Here's an exploration of the night vision of owls and their significance as vigilant creatures in the darkness:Enhanced Low-Light Vision:Owls possess specialized adaptations that allow them to see clearly in low-light conditions.Their eyes are equipped with a high density of rod cells,which are highly sensitive to dim light. This adaptation enables them to navigate and hunt effectively in the darkness.Wide Field of View:Owls have large,forward-facing eyes that provide them with a wide field of view.This allows them to capture more light and perceive a broader range of visual information.Their ability to see in multiple directions simultaneously enhances their awareness of their surroundings,making them skilled nocturnal observers.Binocular Vision:Owls have binocular vision,meaning their eyes are positioned at the front of their head,providing them with depth perception.This depth perception helps them accurately judge distances, allowing for precise hunting and navigation in low-light environments.Excellent Depth Perception:Owls'binocular vision,combined with their specialized facial disc,enhances their depth perception.The facial disc acts as a sound collector,directing sounds toward their ears and enabling them to pinpoint the exact location of their prey,even in complete darkness.Silent Flight:Owls possess unique feathers that allow them to fly silently. This stealthy flight enables them to approach their prey without being detected.Their ability to glide noiselessly through the night enhancestheir hunting success and further emphasizes their role as guardians of the darkness.Adaptation to Nocturnal Prey:Owls'night vision has evolved to suit their nocturnal hunting habits.They feed primarily on small mammals,insects, and other creatures that are active during the night.Their exceptional visual abilities enable them to locate and capture their prey efficiently.Symbol of Wisdom:Owls'night vision and their association with darkness have made them symbolic of wisdom in various cultures.Their ability to see through the darkness represents insight,intuition,and the ability to perceive hidden truths.Owls are often depicted as wise and knowledgeable creatures in folklore and literature.In conclusion,the night vision of owls represents their exceptional visual abilities and their role as guardians of the darkness.Their enhanced low-light vision,wide field of view,binocular vision,excellent depth perception,silent flight,adaptation to nocturnal prey,and symbolic significance as wise creatures highlight their significance as vigilant beings in the night.Owls embody the mystery and beauty of the nocturnal world and continue to captivate the imagination of people who appreciate their extraordinary visual capabilities.。