基金项目:863计划个人信息处理终端SoC (2003AA1Z1350)及上海市科委AM 基金资助收稿日期:2004-09-04

第22卷 第11期

计 算 机 仿 真

2005年11月

文章编号:1006-9348(2005)11-0117-03

一种新的基于信息熵的带噪语音端点检测方法

严剑峰,付宇卓

(上海交通大学微电子学院,上海200030)

摘要:在自动语音识别和变速率语音编码技术中,语音端点检测是前端处理的一个重要环节。而在实际的噪声环境下,一些传统的端点检测方法已不适用。该文提出了一种新的基于信息熵的语音端点检测方法,该方法通过对语音信号的短时功率谱进行谱分析,由此构造熵函数作为端点检测的特征参数。实验结果表明,该方法在噪声环境下性能优于传统的基于能量的端点检测方法。而且相对于基于频谱谱熵的算法[1],在低信噪比(S NR <0dB )情况下,该文方法有更好的鲁棒性,可使平均检测精确度进一步提高约5%。

关键词:语音端点检测;信息熵;功率谱;语音识别中图分类号:T N912.3 文献标识码:A

A Novel Approach to En tropy -ba sed Endpo i n t D etecti on of No isy Speech

Y AN J ian -feng,F U Yu -zhuo

(I nstitute of M icr o Electr onics,Shanghai J iaot ong University,Shanghai 200030,China )

ABSTRACT:I n the technol ogy of s peech recogniti on and variable bit rate s peech coding,accurate deter m inati on of s peech is a crucial part .Some traditi onal endpoint detecti on methods are ineffective in real noisy envir on ments .This paper p resents a novel entr opy -based app r oach t o s peech endpoint detecti on .

I n the p r oposed method,we analyze

the short -ter m power s pectru m of s peech signal,fr om which the entr opy is derived and used as a feature in endpoint detecti on .Experi m ental results sho w that this method out perfor m s the traditi onal energy -based methods .Compared with the s pectral entr opy -based algorith m

[1]

,it possesses a better r obustness in l ow S NR envir on ments (S NR <

0d B )and can i m p r ove the p recisi on of endpoint detecti on about 5%.

KE YWO RD S:Speech endpoint detecti on;Entr opy;Power s pectru m;Speech recogniti on

1 引言

在自动语音识别(ASR )及变速率语音编码技术中,正确确定语音段的起始端点,不仅可以减少后续处理的运算量,而且对于提高语音识别的准确率也极为重要。传统的语音端点检测利用短时能量,并结合过零率作为特征参数来区分语音段和无声段,这种方法因简单而得到广泛的使用。然而,在信噪比(S NR )较低或者存在非平稳噪声的实际环境下,这种方法的性能极差,失去语音端点检测的能力。

为了解决这一问题,J.L.Shen 借助于信息论,第一次将信息熵(entr opy )的概念引入到语音端点检测中[1]。Shen 利用谱熵来反映语音段和非语音段在频谱上的差异,从而达到端点检测的目的。其实验表明,即使是在信噪比很低的情况下,也能进行准确的端点检测,性能大大优于传统的基于能量的检测方法。根据对语音信号中信息熵定义的不同,由此

衍生出其他一些基于信息熵的语音检测方法,如利用短时分形维数[2]、时域特征[3]来构造熵函数的方法。

本文提出一种用语音信号的短时功率谱来构造信息熵的新方法,先计算一帧语音信号的短时自相关序列,对其做

快速傅立叶变换(FFT ),得到语音帧的短时功率谱,由此定义和计算概率密度函数(pdf ),进而得出信息熵,然后通过熵值大小来区分语音段和无声段。用功率谱来定义信息熵更能体现语音段和无声段的差别。实验显示,相对于Shen 直接对语音帧做FFT 进行谱分析的方法,用新方法所得出的谱熵,在无声段的变化幅度要小,这样便于设定参考门限,提高检测精度,并且在低信噪比的情况下,语音段和无声段的谱熵区别更明显。

2 基于功率谱信息熵的端点检测方法

2.1 熵函数的构造

在信息论中,用熵函数表征信源输出的平均信息量。假设信源发出有限个符号s 1,s 2,...,s n ,它们组成的输出序列前后符号之间相互统计独立,p 1,p 2,...,p n 分别为n 个符号

出现的概率,则信源的熵定义为:

H =-

∑

n

i =1

p i log p i

(1)

信源熵仅与符号的概率分布有关,是概率分布的函数,且具有这样的性质,当信源n 个符号的概率相等即p 1=p 2

=...

=p n =1/n 时取最大值,也就是说,信源符号的概率分

布越平坦,则熵值越大,其包含的平均信息量越大[4]

。下面来

构造用于语音端点检测的熵函数。

对于像语音这样的功率信号,频域分析通常研究它们的功率谱密度。基于此考虑,本文通过分析语音信号的短时功率谱密度来构造熵函数,具体方法如下:对于一帧语音信号

s (n ),n =0,1,...,L -1。先求出其短时自相关序列

[5]

:r (n )=

∑L -n -1

i =0

s (i )s (i +n )

n =0,1,...L -1

(2)

由于短时功率谱密度是短时自相关序列的傅立叶变换,即:

s (ω)=

∑L -1

n =0

r (n )e

-j ωn

(3)

因而在实际中可以对序列r (n )进行快速傅立叶变换

(FFT ),由此得到各频率分量f i 的功率谱密度,设其幅度为S (f i ),则每个频率分量的归一化谱概率密度函数(pdf )定义

为

[1]

:

p i =S (f i )

∑N /2+1

k =1

S (f k

)

i =1,2,...,N /2+1

(4)

其中p i 为频率分量i 所对应的概率密度,N 为FFT 变换长度。由于功率谱密度的对称性,只取FFT 一半的点来构造

p i ,对应于实际频率范围(0~f s /2),f s 是语音信号的采样频

率。为了增强pdf 区分语音段和无声段的能力,引入以下约束条件:首先,考虑到语音信号主要集中在250~4500Hz 范围,有必要限制频段范围,即:

S (f i )=0,当f i <250Hz 或f i >4500Hz (5)

其次,为了消除某些能量集中在特定频率的噪声对算法的影响,需设定pdf 上限:

p i =0,当p i >0.9

(6)

考虑上述约束条件后,相应地,每帧语音信号的信息熵定义为:

H =-

∑N /2+1

i =1

p i

log p

i

(7)

2.2 语音信号的谱熵特征分析

无论是本文用功率谱求出的谱熵还是S hen 直接通过频谱求出的谱熵[1],实质都是通过检测谱的平坦程度,从而达到语音端点检测的目的。对于无声段,它的能量在各频率的的分布比较平稳,反映到信息量上,认为其所含的平均信息量即谱熵较大;而对于语音段,它的能量集中于某几个频段,起伏突变大,那么它所含的平均信息量即谱熵较小。于是可以利用两者谱熵的差异,进行语音段和无声段的划分。并且,理论上,如果谱的分布保持不变,信号幅值的大小不会影响

(4)式归一化的pdf,因而谱熵对于噪声有一定的鲁棒性。

本文提出不同于文献[1]的新方法,考虑到语音信号是功率信号而非能量信号的特点,采用功率谱密度而不是直接变换所得的频谱进行谱分析。因为功率谱更能反映出语音段和无声段的区别,所以更适合用来定义pdf,由此求得的谱熵在无声段要比文献[1]中方法平稳,在低SN R 的情况下,性能更是明显优于前者,这些将在第3节的实验中予以说明。不过,这种性能的提高是以先做自相关计算为代价的:假设一帧语音有N 个点,则短时自相关序列的计算给每帧引入

N (N +1)/2次乘法和N (N -1)/2次加法的运算量。但是,在

自动语音识别系统或变速率语音编码系统中,获取语音信号参数时,基本都需要先求出短时自相关函数才能计算所需要的语音参数,而且编码系统所需要的基音周期估计也大多基于自相关序列,如果端点检测再辅以能量方法,则r (0)的计算必不可少,综合考虑以上因素,用功率谱计算谱熵的方法,实际增加的计算量并不大,可运用到实际系统中。

2.3 基于功率谱熵的语音端点检测方法

基于功率谱熵的语音端点检测算法步骤如下[6]:

1)将语音信号分成相邻有重叠的语音帧,每个语音帧加

汉明窗处理。

2)计算参考信息熵值Ref -Entr opy,Ref -Entr opy 是语

音信号最初Ref -Silence 帧信息熵的均值。

3)设定语音段划分门限Entr opyth 。一般情况下,门限值Entr opyth 就取Ref -Entr opy,而如果Ref -Entr opy 低于一定

值,则Entr opyth 取一个预设值。

4)用上述方法计算各帧的谱熵Entr opy 。如果连续有Triger Begin 帧语音的Entr opy 都大于Entr opyth,则其开始处

定为语音段起始位置。继续监视语音帧,如果连续有Triger

End 帧语音的Entr opy 都小于Entr opyth,则其开始处定为定

为语音段终止位置。Triger 的设置是考虑到语音段和语音段间有最小间隔,以排除一些误判。在实时处理时,会产生

max{Triger Begin,Triger End}帧的延时。

5)重复4),直到输入语音信号结束。

3 实验结果及性能分析

本节通过几个实验来说明本文方法的有效性,并与文献

[1]中基于频谱信息熵的方法进行比较。以下实验的共同条

件是:采样频率为11.025KHz,16bit 量化,帧长为20m s,帧间重叠40%,即每帧有221个点,帧的步进为132个点。

为表述方便,用方法1表示文献[1]提出的基于直接频谱计算信息熵的方法,而方法2表示本文提出的基于短时功率谱的方法,以下均同。

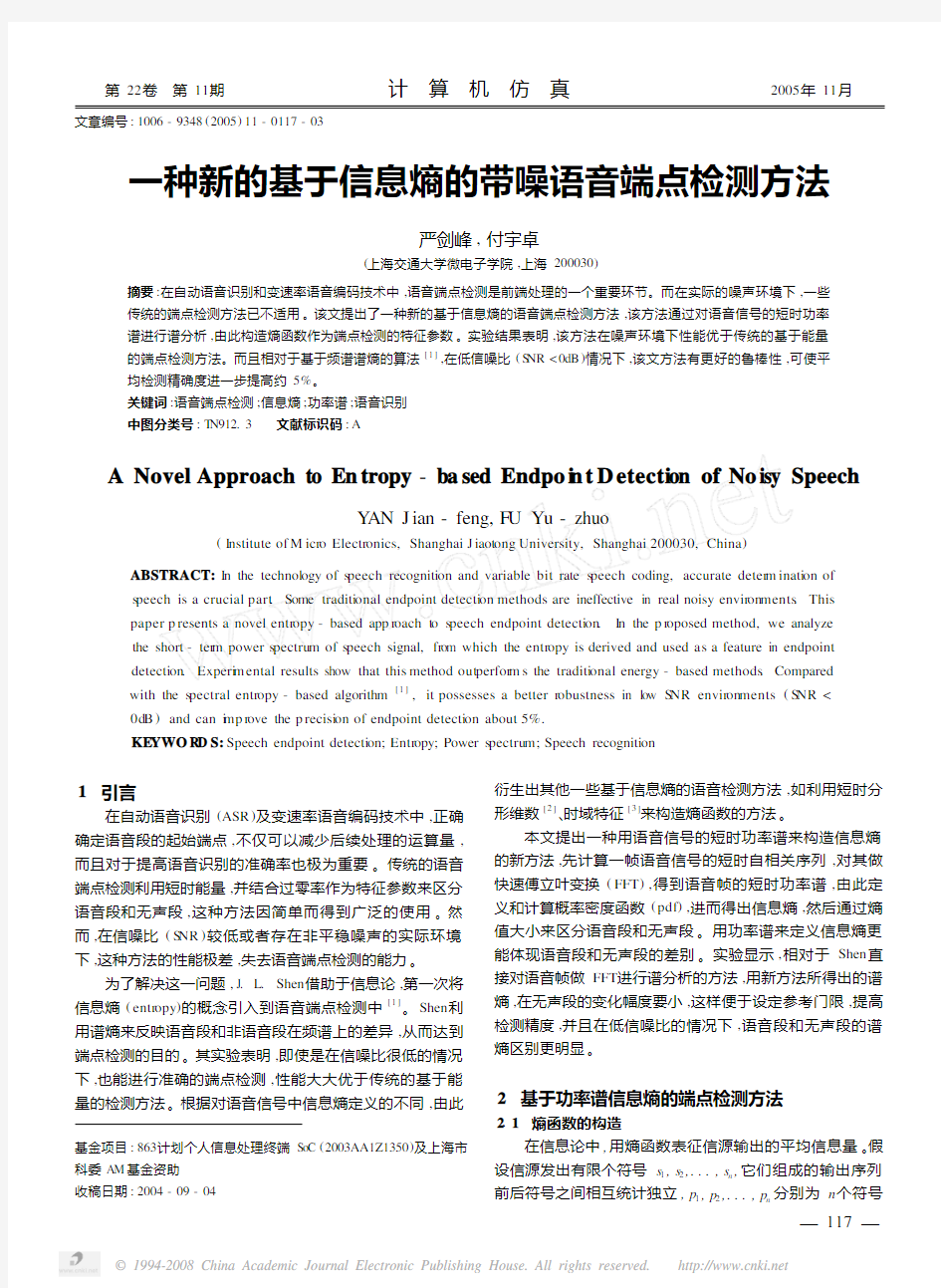

首先,分别用两种方法计算一段语音信号的谱熵。图1给出了汉语“上海交通大学”这段语音在两种方法下的谱熵图的比较,(a )是原始语音,(b )是用方法1实现的谱熵,(c )是用方法2实现的谱熵。谱熵图中的横坐标为帧号。图中,谱熵小的部分表示语音段,而谱熵大的部分表示无声段。图

1表明,方法2和方法1同样具有区分无声段和语音段的能

力,方法2的平均熵值比方法1的约大0.2,这是由于语音信号的功率谱普遍比直接频谱平坦造成的,但两者语音段和无声段熵的相对差值基本一致。并且注意到,在无声段部分,方法2熵值变化要比方法1的小,通过计算一段5秒钟无声语音的熵值方差,得到:方法1的标准方差为0.0739,方法2的标准方差为0.0292,可见本文提出基于功率谱的方法在无声段熵值要比方法1平稳得多,这样有利于设定有效的参考门限,是方法2的一个优点

。

图1 汉语“上海交通大学”的语音频谱熵和功率谱熵

(a )原始语音的归一化波形;(b )基于直接频谱的信息熵(方法1);(c )基于功率谱的信息熵(方法2)

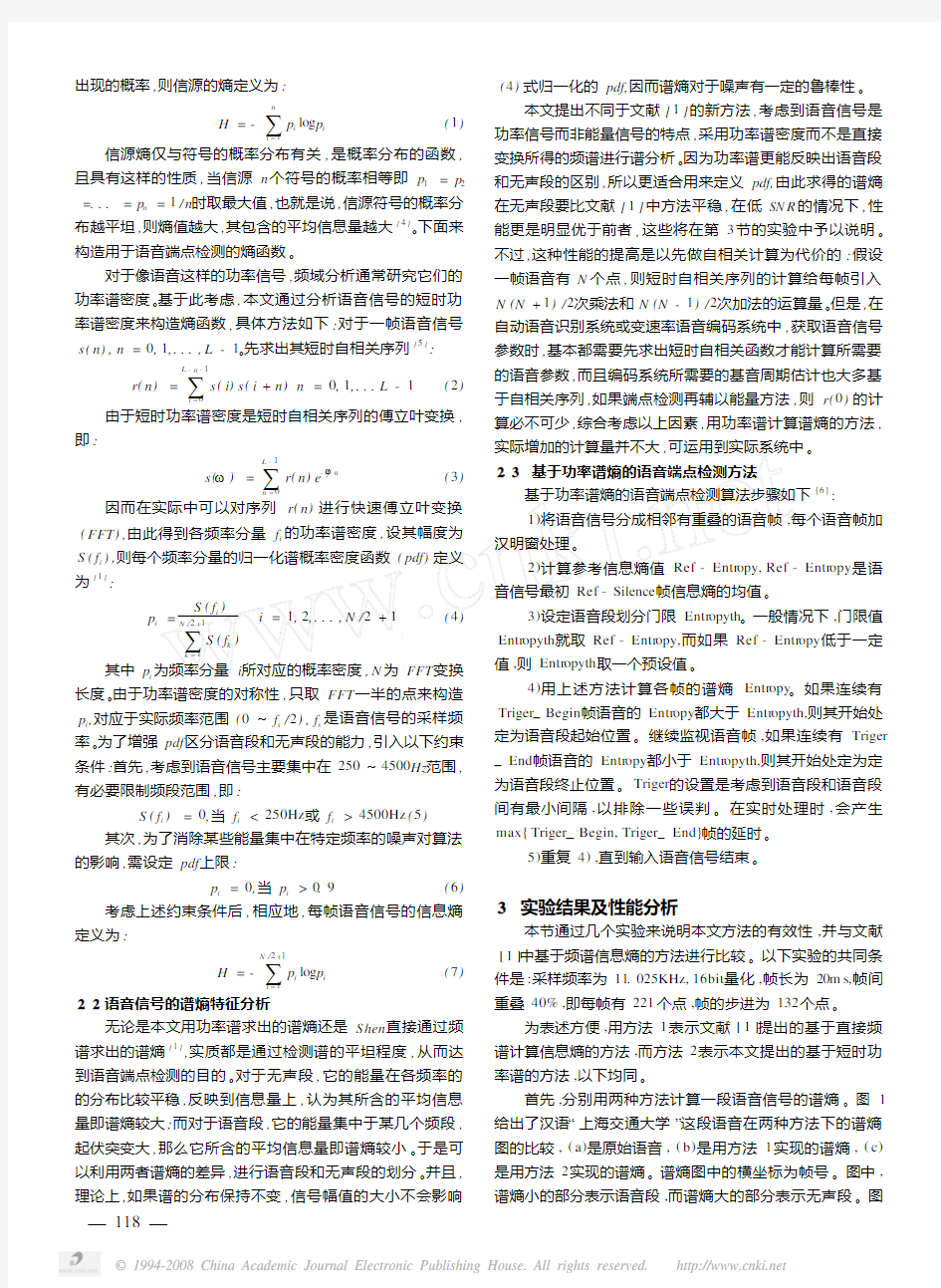

另外,在加入噪声的情况下,分别用两种方法计算一段带噪语音(加高斯白噪声)的谱熵,如图2所示,其中(a )(b )(c )分别表示0d B 环境下的带噪语音,方法1计算的谱熵,方法2计算的谱熵;(d )(e )(f )分别表示-5d B 环境下的带噪语音,方法1计算的谱熵,方法2计算的谱熵。此时方法2的优势明显体现出来,在低信噪比的情况下,两种方法无声段和语音段的差异都有所减小,但是方法1减少得更多。在

-5d B 情况下,用方法1已无法检测最后一个字,而方法2仍

能很好的检测出来。这是由于功率谱和直接频谱的差异造成的,图3给出了在0d B 环境下,一段无声帧和一段语音帧的直接频谱和短时功率谱。从中可以看出,语音帧的短时功率谱消除了噪声杂波的影响,相对于无声段的功率谱有更明显的突起变化,而直接频谱中,语音帧有很多杂波,从而减小了语音帧与无声帧的差别。反映到信息熵上,用直接频谱计算的无声帧与语音帧的谱熵差值为0.2632,而用短时功率谱计算的谱熵差值为0.3592,两者相差了将近0.1,因而本文方法在低信噪比下有更优秀的区分能力。

最后,我们在不同的噪声条件下,分别用三种算法进行语音端点检测实验。对每个语音样本通过手工标记以区分语音段和无声段,以此作为测试端点检测的标准,表1为实验结果简表。Energy 表示基于短时能量的端点检测,FS

Entr opy 表示基于文献[1]的直接频谱熵的端点检测,PS Entr opy 表示基于本文提出的短时功率谱的端点检测方法。

从表中可以看出,用PS Entr opy 的方法进行语音端点检测

,

图2 汉语“端点检测”在0dB 和-5dB 情况下的两种谱熵比较

图3 无声帧和语音帧的直接频谱和短时功率谱比较(已归一化)

(a )无声帧的直接频谱;(b )语音帧的直接频谱;(c )无声帧的短时功率谱;(d )语音帧的短时功率谱

相比FS Entr opy 方法,正确检测率平均可以提高5%。

表1 语音端点检测实验结果

正确检测率

S NR =10dB (白噪声)S NR =5dB (白噪声)S NR =0dB (白噪声)S NR =-5dB (白噪声)S NR =5dB (工厂噪声)Energy 0.990.750.640.300.70FS Entr opy 0.990.940.850.760.92PS Entr opy

0.99

0.95

0.91

0.88

0.93

4 结束语

本文提出一种新的基于信息熵的

(下转第139页)

=D+

2σ2n

12

f(D)

2

3

π2σ2

s

-2σ2n

12

f′(D)

=D+D

π3σ2

s D3+3π2D2σ2n

12

sinπD

3σ2

n12(πD cosπD-sinπD)

+2

=D 1+

1

π3D3SN R’+3π2D2sinπD

3(πD cosπD-sinπD)

+2

=D?ERR(A.6)上式中S NR′和ERR分别由(10)、(11)式表示,至此(9)式推导完毕。

参考文献:

[1] A H Quazi.An Overvie w on the Ti m e Delay Esti m ate in Active and

Passive System s f or Target Localizati on[J].I EEE Trans,Acoust,

Speech,Signal Pr ocessing,1981,ASSP-29(3):527-533.

[2] W W S m ith and P G Steffes.Ti m e-Delay Techniques for Satellite

I nterference Locati on Syste m[J].I EEE Trans.Aer os pace and E2

lect.Sys,1989,25(2):224-230.

[3] G C Carter.Coherence and Ti m e Delay Esti m ati on[C].Pr oceed2

ings of the I EEE,1987,75(2):236-255.

[4] R V Foutz.Esti m ati on of a Common Gr oup Delay Bet w een T wo

Multi p le Ti m e Series[J].Amer.Stat.A ss.,1980,75:779-

788.

[5] H C So,P C Ching,and Y T Chan.A Ne w A lgorithm for Exp licit

Adap tati on of Ti m e Delay[J].I EEE Trans.Signal Pr ocess.,

1994,42(7):1816-1820.

[6]

Y T Chan,J M F R iley and J B Plant.Modeling of Ti m e Delay and its App licati on t o Esti m ati on of Nonstati onary Delays[J].I EEE Trans.Acoust.,Speech,Signal Pr ocessing,1981,.ASSP-29:

577-581.

[作者简介]

李 强(1979-),男,(汉族),陕西长安,西北工业

大学,博士生,研究方向为信号与信息处理;

李志舜(1945-),男,(汉族),辽宁桓仁,西北工业

大学教授,博士生导师,研究方向为水下信号处理的

理论和应用;

王惠刚(1975-)男,(汉族),湖北孝感,西北工业大学讲师,博士,研究方向为信号与信息处理。

(上接第119页)

语音端点检测方法。实验比较表明,基于本文提出的基于功率谱熵的语音端点检测方法,在不利的环境下比基于频谱熵的端点检测方法的鲁棒性好,无声段的熵值比较平稳,便于设定有效的判决门限,提高检测精度,而且实际增加的计算量不大,适合实际运用的需要,如在噪声环境下的语音识别和变速率语音编码等。

参考文献:

[1] J L Shen,J W Hung,L S Lee.Robust Entr opy-based Endpoint

Detecti on f or Speech Recogniti on in Noisy Envir onments[C].Pr o2

ceedings of I CS LP-98,1998.

[2] 沈亚强,冯根良.基于时间序列短时分形维数的噪声语音信号

端点检测和滤波[J].浙江师大学报(自然科学版),1999,22

(1):16-21.

[3] 陈四根.基于熵函数的语音端点检测方法[J].声学与电子工

程,2001,():28-30.

[4] 韩声栋,袁三男.通信原理(读本)[M].上海交通大学电子工

程系,2000.11-12.

[5] L R Rabiner,B H Juang.Funda mentals of Speech Recogniti on

[M].Prentice Hall:1993,

154-155.

[6] L S Huang,C H Yang.A Novel App r oach t o Robust S peech End2

point Detecti on in Car Envir onments[J].I EEE Conference on A2 coustics,Speech,and Signal Pr ocessing,2000,3(5-9):1751-

1754.

[作者简介]

严剑峰(1979-),男(汉族),江苏人,上海交通大

学电子信息与电气工程学院电子信息工程系硕士研

究生,主要研究方向为数字信号处理,语音处理,嵌

入式系统;

付宇卓(1968-),男(汉族),黑龙江哈尔滨人,上海交通大学计算机科学与工程系副教授,主要研究方向为MPEG-2编码器的结构、运动估计。

实验一 灰度图像信息熵的相关计算与分析

一、实验目的 1、复习信息熵,条件熵,联合熵,互信息,相对熵的基本定义, 掌握其计算方法,学习互信息与相对熵的区别之处并比较两者的有效性,加深对所学理论理论知识的理解。 2、掌握图像的的基本处理方法,了解图像的编码原理。 3、学习使用matlab ,掌握matlab 的编程。 4、通过对比分析,。在解决问题的过程中,锻炼自身对问题的研究能力。 二、实验内容与要求 1、计算灰度图像的信息熵,条件熵,联合熵,互信息,相对熵,并比较互信息和相对熵在判别两幅图像的联系与区别。 2、利用matlab 编程计算,并书写完整实验报告。 三、实验原理 1、信息熵 离散随机变量X 的熵H(X)为: ()()log () x H X p x p x χ ∈=-∑ 图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。图像的一 维熵表示图像中灰度分布的聚集特征所包含的信息量,将图像的灰度值进行数学统计,便可得到每个灰度值出现的次数及概率,则定义灰度图像的一元灰度熵为: 255 log i i i H p p ==-∑ 利用信息熵的计算公式便可计算图像的信息熵,求出任意一个离散信源的熵(平均自信息量)。自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出的消息不同,它们所含有的信息量也就不同。任何一个消息的自信息量都代表不了信源所包含的平均自信息量。 信息熵的意义:信源的信息熵H 是从整个信源的统计特性来考虑的。它是从平均意义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。不同的信源因统计特性不同,其熵也不同。 图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。选择图像的邻域灰度均值作为灰度分布的空间特征量,与图像的像素灰度组成特征二元组,记为( i, j ),其中i 表示像素的灰度值(0255)i ≤≤,j 表示邻域灰度(0255)j ≤≤, 2 (,)/ij P f i j N =

信息熵理论 在通信系统中,信息从发送到接收的传输过程是一个有干扰的信息复制过程。 对每一个具体的应用而言,传输的信息是确定的,有明确的应用目的。 对一个通信系统而言主,不同的用户要传送的具体的信息内容是不同的,则如何从这些繁杂的具体信息中提炼出它们的共同特征,并可进行量化估计是shannon 信息论研究的基础。 所谓量化估计就是用提炼的共同特征估计与某些具体内容所对应的需要传输的信息量大小。 信息量定义的另一个重要特征是它能保证信息量值的大小与具体的信息内容无关。 1.定义信息熵: 设X 是一个离散的随机变量,其定义空间为一个字符集E 。 ()()E x x X P x p ∈==,,表示相应的概率分布函数,则 ()()()()x p x p X H x log ∑-=称为离散随机变量的熵。 有时记()()()()(){}X p E x p x p p H p x log log -=-=∑ {}p E 表示以概率分布()x p 对某随机变量或随机函数求概率平均。 2.定义联合熵: 设X ﹑Y 是丙个离散的随机变量,(X,Y )的联合概率分布函数为()()y Y x X P y x p ===,,,则 ()()()y x p y x P Y X H x y ,log ,,∑∑-= 称为离散随机变量X 与Y 的联合熵。 有时记为: ()()()(){}Y X p E y x p y x p Y X H p x y ,log ,log ,,-=-=∑∑ 3.定义条件熵: 如果()(),,~,y x p Y X 则条件熵()X Y H /定义为 ()()() ∑=-=x x X Y H x p X Y H // ()()()∑∑- =x y x y p x y p x p /log / ()()∑∑-=x y x y p y x p /log , (){}X Y p E /log -= 条件熵等于零的条件为()1==Y X p 事实上,对任意的y x ,都有()()0/log /=x y p x y p ,从而得()()1/0/==x y p x y p 或,又因为X 与Y 是取值空间完全相同的随机变量,所以有()1/=X Y p

摘要 信息论是人们在长期通信实践活动中,由通信技术与概率论、随机过程、数理统计等学科相结合而逐步发展起来的一门新兴交叉学科。而熵是信息论中事件出现概率的不确定性的量度,能有效反映事件包含的信息。随着科学技术,特别是信息技术的迅猛发展,信息理论在通信领域中发挥了越来越重要的作用,由于信息理论解决问题的思路和方法独特、新颖和有效,信息论已渗透到其他科学领域。随着计算机技术和数学理论的不断发展,人工智能、神经网络、遗传算法、模糊理论的不断完善,信息理论的应用越来越广泛。在图像处理研究中,信息熵也越来越受到关注。为了寻找快速有效的图像处理方法,信息理论越来越多地渗透到图像处理技术中。本文通过进一步探讨概论率中熵的概念,分析其在图像处理中的应用,通过概念的分析理解,详细讨论其在图像处理的各个方面:如图像分割、图像配准、人脸识别,特征检测等的应用。 本文介绍了信息熵在图像处理中的应用,总结了一些基于熵的基本概念,互信息的定义。并给出了信息熵在图像处理特别是图像分割和图像配准中的应用,最后实现了信息熵在图像配准中的方法。 关键词:信息熵,互信息,图像分割,图像配准

Abstract Information theory is a new interdisciplinary subject developed in people long-term communication practice, combining with communication technology, theory of probability, stochastic processes, and mathematical statistics. Entropy is a measure of the uncertainty the probability of the occurrence of the event in the information theory, it can effectively reflect the information event contains. With the development of science and technology, especially the rapid development of information technology, information theory has played a more and more important role in the communication field, because the ideas and methods to solve the problem of information theory is unique, novel and effective, information theory has penetrated into other areas of science. With the development of computer technology and mathematical theory, continuous improvement of artificial intelligence, neural network, genetic algorithm, fuzzy theory, there are more and more extensive applications of information theory. In the research of image processing, the information entropy has attracted more and more attention. In

一些信息熵的含义 (1) 信息熵的定义:假设X是一个离散随即变量,即它的取值范围R={x1,x2...}是有限可数的。设p i=P{X=x i},X的熵定义为: (a) 若(a)式中,对数的底为2,则熵表示为H2(x),此时以2为基底的熵单位是bits,即位。若某一项p i=0,则定义该项的p i logp i-1为0。 (2) 设R={0,1},并定义P{X=0}=p,P{X=1}=1-p。则此时的H(X)=-plogp-(1-p)log(1-p)。该H(x)非常重要,称为熵函数。熵函数的的曲线如下图表示: 再者,定义对于任意的x∈R,I(x)=-logP{X =x}。则H(X)就是I(x)的平均值。此时的I(x)可视为x所提供的信息量。I(x)的曲线如下: (3) H(X)的最大值。若X在定义域R={x1,x2,...x r},则0<=H(X)<=logr。 (4) 条件熵:定义

推导:H(X|Y=y)= ∑p(x|y)log{1/p(x,y)} H(X|Y)=∑p(y)H(X|Y=y)= ∑p(y)*∑p(x|y)log{1/p(x/y)} H(X|Y)表示得到Y后,X的平均信息量,即平均不确定度。 (5) Fano不等式:设X和Y都是离散随机变量,都取值于集合{x1,x2,...x r}。则 H(X|Y)<=H(Pe)+Pe*log(r-1) 其中Pe=P{X≠Y}。Fano表示在已经知道Y后,仍然需要通过检测X才能获得的信息量。检测X的一个方法是先确定X=Y。若X=Y,就知道X;若X≠Y,那么还有r-1个可能。 (6) 互信息量:I(X;Y)=H(X)-H(X|Y)。I(X;Y)可以理解成知道了Y后对于减少X的不确定性的贡献。 I(X;Y)的公式: I(X;Y)=∑(x,y)p(x,y)log{p(y|x)/p(y)} (7)联合熵定义为两个元素同时发生的不确定度。 联合熵H(X,Y)= ∑(x,y)p(x,y)logp(x,y)=H(X)+H(Y|X) (8)信道中互信息的含义 互信息的定义得: I(X,Y)=H(X)-H(X|Y)= I(Y,X)=H(Y)-H(Y|X) 若信道输入为H(X),输出为H(Y),则条件熵H(X|Y)可以看成由于信道上存在干扰和噪声而损失掉的平均信息量。条件熵H(X|Y)又可以看成由于信道上的干扰和噪声的缘故,接收端获得Y后还剩余的对符号X的平均不确定度,故称为疑义度。 条件熵H(Y|X)可以看作唯一地确定信道噪声所需要的平均信息量,故称为噪声熵或者散布度。 (9)I(X,Y)的重要结论

实验一信息熵与图像熵计算(2 学时) 一、实验目的 1.复习MATLAB的基本命令,熟悉MATLAB下的基本函数; 2.复习信息熵基本定义,能够自学图像熵定义和基本概念。 二、实验内容 1.能够写出MATLAB源代码,求信源的信息熵; 2.根据图像熵基本知识,综合设计出MATLAB程序,求出给定图像的图像熵。 三、实验仪器、设备 1.计算机-系统最低配置256M内存、P4 CPU; 2.MATLAB编程软件。 四实验流程图 五实验数据及结果分析

四、实验原理 1.MATLAB中数据类型、矩阵运算、图像文件输入与输出知识复习。 2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出的消息不同,它们所含有的信息量也就不同。任何一个消息的自信息量都代表不了信源所包含的平均自信息量。不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量: 1( ) 1 ( ) [log ] ( ) log ( ) i n i i p a i H E p a p a X 信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。它是从平均意

义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。不同的信源因统计特性不同,其熵也不同。 3.学习图像熵基本概念,能够求出图像一维熵和二维熵。 图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为: 2550 log i i i p p H 图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。选择图像的邻域灰度均值作为灰度2

分类号: O236单位代码:106 密级:一般学号: 本科毕业论文(设计) 题目:信息熵在球员选拔中的应用专业: 姓名: 指导教师: 职称: 答辩日期:

信息熵在球员选拔中的应用 摘要:.本课题通过研究信息熵的定义和性质,运用p c -分析法,通过统计一场球赛中各个球员的各项技术指标并该场球赛中各个队员的信息熵,自信息等值,得到球员选拔过程中对球员的评判方法.并以此法选出优秀的球员,根据信息熵的性质指出每个球员的不足之处,为今后的训练指明了方向. 关键字:信息熵;P-C分析法;球员选拔 Information entropy application in selecting players Abstract: Shannon information entropy presented expressions in 1948, which pioneered information theory. Now more and more international competitions, how to select best players on behalf of the state competition become critical .This issue through the definition and nature of information entropy, use of p c -law to come the assessment of each player, and select a good player, and point out the inadequacties of each player based on information entropy, that should be strengthened in future training exercises. Key Words: Information Entropy; P-C Analysis; Selecting Players

信息熵在遥感影像中的应用 所谓信息熵,是一个数学上颇为抽象的概念,我们不妨把信息熵理解成某种特定信息的出现概率。信源各个离散消息的自信息量得数学期望(即概率加权的统计平均值)为信源的平均信息量,一般称为信息源,也叫信源熵或香农熵,有时称为无条件熵或熵函数,简称熵。 一般而言,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高。我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值。这样子我们就有一个衡量信息价值高低的标准,可以做出关于知识流通问题的更多推论。 利用信息论中的熵模型,计算信息量是一种经典的方法,广泛应用于土地管理,城市扩张以及其他领域。熵值可以定量的反应信息的分散程度,将其应用于遥感图像的解译中可以定量的描述影像包含的信息量,从而为基于影像的研究提供科学的依据。利用信息熵方法对遥感影像的光谱特征进行离散化,根据信息熵的准则函数,寻找断点,对属性进行区间分割,以提高数据处理效率。 遥感影像熵值计算大致流程为:遥感影像数据经过图像预处理之后,进行一系列图像配准、校正,图像增强,去除噪声、条带后,进行图像的分类,然后根据研究区域进行数据的提取,结合一些辅助数据对图像进行监督分类后生成新的图像,将新的图像与研究区边界图和方格图生成的熵单元图进行进一步的融合便可得到熵分值图。 1.获得研究区遥感影像 以研究区南京市的2009 年6 月的中巴资源二号卫星分辨率20 米得影像为例,影像是有三幅拼接完成。通过ArGIS9.2 中的选择工具从全国的行政区域图中提取边界矢量图,再通过掩膜工具获得研究区的影像。分辨率的为90 米得DEM 图有两副影像拼接而得,操作的步骤与获取影像一致,为开展目视解译工作提供参考。然后依照相关学者的相关研究以及城市建设中的一些法律法规,参照分类标准,开展影像解译工作,对于中巴资源二号影像开展监督分类,以及开展目视解译工作。 2.二值图像的建立 将两种解译所得的图像按照一定的标准转化为城镇用地和非城镇用地两种,进一步计算二值图像的熵值。 3.熵值单元图 根据一些学者对城市边缘带的研究,其划分的熵值单元为 1 km ×1 km,针对样 区的具体情况,采用500 m ×500 m 的熵值单元。在ERDAS 软件和

信息熵理论的应用研究 [摘要] 广告活动是信息的活动,信息熵是信息活动的度量标准。本文利用信息熵理论对广告活动中的信息处理、广告传播、广告效果测定和广告受众进行了论证,指出了广告信息活动的规律。 [关键词] 信息熵;负熵;广告活动;广告受众 广告是一种非人际的信息传播,是信息交流的工具。广告系统实质上是信息系统,它具备了信息传播的五要素:谁——通过什么媒介——对谁——说了什么——取得了什么效果。广告的信息传播包括:广告发布者(包括广告主、广告制作者和传播者,即信息源)、广告信息内容、广告媒介、广告受众、广告效果等要素。信息熵理论是描述信息系统发展的基本理论,利用信息熵从信息的角度分析广告行为、预判广告活动的发展趋势,是研究广告活动的一种新方法。 一、熵、信息熵与广告活动的理论分析 熵是一个重要的物理概念,热力学中的熵通常被用于表征一个物理系统的无序程度。随着科学综合化的发展,熵又远远超出物理学范围。1948年,香农(shannon)第一次将熵这一概念引入到信息论中,从此,熵这一概念被广泛用于信息的度量,在自然科学和社会科学众多领域中得到广泛应用,并成为一些新学科的理论基础,由狭义熵发展为广义熵。正如爱因斯坦的评价那样:“熵理论对于整个科学来说是第一法则”。熵表示的是系统固有的、规律性的本质。在没有外界作用下,一个系统的熵越增,不可用能就越大,动力越小;换言之,一个系统的熵不相同时,对于相等的进程,它们的利用价值可以大不相同。一个孤立系统的熵永不减少,这叫做熵增原理。根据这一原理,以熵变为判据,不仅可以判断过程进行的方向,而且还能给出孤立系统达到平衡的条件。熵增原理揭示了一切自发过程都是不可逆的这一共同本质。为了打破平衡,必须与外部系统交换熵,从外部系统得到的熵称为负熵,目的是使本系统的熵值减少,更具有活力。

信息熵在图像处理中的应用 摘要:为了寻找快速有效的图像处理方法,信息理论越来越多地渗透到图像处理技术中。文章介绍了信息熵在图像处理中的应用,总 结了一些基于熵的图像处理特别是图像分割技术的方法,及其在这一领域内的应用现状和前景 同时介绍了熵在织物疵点检测中的应用。 Application of Information Entropy on Image Analysis Abstract :In order to find fast and efficient methods of image analysis ,information theory is used more and more in image analysis .The paper introduces the application of information entropy on the image analysis ,and summarizes some methods of image analysis based on information entropy ,especially the image segmentation method .At the same time ,the methods and application of fabric defect inspection based on information entropy ale introduced . 信息论是人们在长期通信实践活动中,由通信技术与概率论、随机过程、数理统计等学科相结合而逐步发展起来的一门新兴交叉学科。而熵是信息论中事件出现概率的不确定性的量度,能有效反映事件包含的信息。随着科学技术,特别是信息技术的迅猛发展,信息理论在通信领域中发挥了越来越重要的作用,由于信息理论解决问题的思路和方法独特、新颖和有效,信息论已渗透到其他科学领域。随着计算机技术和数学理论的不断发展,人工智能、神经网络、遗传算法、模糊理论的不断完善,信息理论的应用越来越广泛。在图像处理研究中,信息熵也越来越受到关注。 1 信息熵 1948年,美国科学家香农(C .E .Shannon)发表了一篇著名的论文《通信的数学理论》 。他从研究通信系统传输的实质出发,对信息做了科学的定义,并进行了定性和定量的描述。 他指出,信息是事物运动状态或存在方式的不确定性的描述。其通信系统的模型如下所示: 图1 信息的传播 信息的基本作用就是消除人们对事物的不确定性。信息熵是信息论中用于度量信息量的一个概念。假定X 是随机变量χ的集合,p (x )表示其概率密度,计算此随机变量的信息熵H (x )的公式是 P (x ,y )表示一对随机变量的联合密度函数,他们的联合熵H (x ,y )可以表示为 信息熵描述的是信源的不确定性,是信源中所有目标的平均信息量。信息量是信息论的中心概念,将熵作为一个随机事件的不确定性或信息量的量度,它奠定了现代信息论的科学理论基础,大大地促进了信息论的发展。设信源X 发符号a i ,的概率为Pi ,其中i=1,2,…,r ,P i >O ,要∑=r i Pi 1=1,则信息熵的代数定义形式为:

指标权重确定方法之熵权法 一、熵权法介绍 熵最先由申农引入信息论,目前已经在工程技术、社会经济等领域得到了非常广泛的应用。 熵权法的基本思路是根据指标变异性的大小来确定客观权重。 一般来说,若某个指标的信息熵越小,表明指标值得变异程度越大,提供的信息量越多,在综合评价中所能起到的作用也越大,其权重也就越大。相反,某个指标的信息熵越大,表明指标值得变异程度越小,提供的信息量也越少,在综合评价中所起到的作用也越小,其权重也就越小。 二、熵权法赋权步骤 1.数据标准化 将各个指标的数据进行标准化处理。 假设给定了k个指标,其中。假设对各指标数据标准化后的值为,那么。 2.求各指标的信息熵 根据信息论中信息熵的定义,一组数据的信息熵。其中,如果,则定义。 3.确定各指标权重 根据信息熵的计算公式,计算出各个指标的信息熵为。通过信息熵计算各指标的权重:。

三、熵权法赋权实例 1.背景介绍 某医院为了提高自身的护理水平,对拥有的11个科室进行了考核,考核标准包括9项整体护理,并对护理水平较好的科室进行奖励。下表是对各个科室指标考核后的评分结果。 但是由于各项护理的难易程度不同,因此需要对9项护理进行赋权,以便能够更加合理的对各个科室的护理水平进行评价。 2.熵权法进行赋权 1)数据标准化 根据原始评分表,对数据进行标准化后可以得到下列数据标准化表 表2 11个科室9项整体护理评价指标得分表标准化表 科室X1X2X3X4X5X6X7X8X9 A B C D

E F G H I J K 2)求各指标的信息熵 根据信息熵的计算公式,可以计算出9项护理指标各自的信息熵如下: 表3 9项指标信息熵表 X1X2X3X4X5X6X7X8X9 信息熵 3)计算各指标的权重 根据指标权重的计算公式,可以得到各个指标的权重如下表所示: 表4 9项指标权重表 W1W2W3W4W5W6W7W8W9权重 3.对各个科室进行评分 根据计算出的指标权重,以及对11个科室9项护理水平的评分。设Z l为第l个科室的最终得分,则,各个科室最终得分如下表所示 表5 11个科室最终得分表 科室A B C D E F G H I J K 得分

p (a i ) ∑ n 《信息论与编码》课程实验报告 班级:通信162 姓名:李浩坤 学号:163977 实验一 信息熵与图像熵计算 实验日期:2018.5.31 一、实验目的 1. 复习 MATLAB 的基本命令,熟悉 MATLAB 下的基本函数。 2. 复习信息熵基本定义, 能够自学图像熵定义和基本概念。 二、实验原理及内容 1.能够写出 MATLAB 源代码,求信源的信息熵。 2.根据图像熵基本知识,综合设计出 MATLAB 程序,求出给定图像的图像熵。 1.MATLAB 中数据类型、矩阵运算、图像文件输入与输出知识复习。 2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出 的消息不同,它们所含有的信息量也就不同。任何一个消息的自信息量都代表不了信源所包含的平均自信息量。不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量: H (X ) = E [ log 1 ] = -∑ p (a i ) log p (a i ) i =1 信息熵的意义:信源的信息熵H 是从整个信源的统计特性来考虑的。它是从平均意义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。不同的信源因统计特性不同,其熵也不同。 1. 学习图像熵基本概念,能够求出图像一维熵和二维熵。 图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令 P i 表示图像中灰度值为 i 的像素所占的比例,则定义灰度图像的一元灰度熵为: 255 H = p i log p i i =0

农业大学 本科生课程论文 论文题目信息熵及其性质和应用学生专业班级信息与计算科学09级2班学生学号 20093992 指导教师吴慧 完成时间2012年06月25日 2012 年 06 月 25 日

课程论文任务书 学生指导教师吴慧 论文题目信息熵及其性质和应用 论文容(需明确列出研究的问题):研究信息熵的目的就是为了更深入的了解信息熵,更好的了解信息熵的作用,更好地使用它解决现实生活中的问题。文中介绍了信息熵的定义和性质及其应用。使我们对信息熵有跟深入的了解。 资料、数据、技术水平等方面的要求:论文要符合一般学术论文的写作规,具备学术性、科学性和一定的创造性。文字要流畅、语言要准确、论点要清楚、论据要准确、论证要完整、严密,有独立的观点和见解。容要理论联系实际,计算数据要求准确,涉及到他人的观点、统计数据或计算公式等要标明出处,结论要写的概括简短。参考文献的书写按论文中引用的先后顺序连续编码。 发出任务书日期 06月15日完成论文日期 06月25日 教研室意见(签字) 院长意见(签字)

信息熵及其性质和应用 信息与计算科学专业 指导教师吴慧 摘要:信息熵是随机变量不确定性的度量,文中从信息熵的定义出发,结合信息熵的性质,介绍了目前信息熵在具体问题中的应用。信息是一个十分通俗而又广泛的名词,它是人类认识世界、改造世界的知识源泉。人类社会发展的速度,在一定程度上取决于人类对信息利用的水平,所以对信息的度量就很有必要。香农提出信息的一种度量,熵的定义形式,它是随机变量不确定性的度量,文中主要介绍熵的性质及其应用。 关键词;信息熵性质应用 Information entropy and its properties and Application Student majoring in Information and Computing Science Specialty dongqiang Tutor WuHui Abstract:information entropy is a measure of uncertainty of random variable, this paper from the definition of information entropy, combined with the nature of information entropy, information entropy, introduced the specific issues in the application https://www.doczj.com/doc/172896482.html,rmation is a very popular and wi dely noun, it is human understanding of the world, transforming the world knowledge source . The human society development speed, depend on on certain level the human make use of information level, so the measurement information is necessary.Shannon put forward the informa-tion a kind of measurement, the definition of entropy form, it is the uncertainty of random variable metric, this paper mainly introduces the property of entropy and its application. Key words:information entropy properties application

求一维序列的信息熵(香浓熵)的matlab程序实例 对于一个二维信号,比如灰度图像,灰度值的范围是0-255,因此只要根据像素灰度值(0-255)出现的概率,就可以计算出信息熵。 但是,对于一个一维信号,比如说心电信号,数据值的范围并不是确定的,不会是(0-255)这么确定,如果进行域值变换,使其转换到一个整数范围的话,就会丢失数据,请高手指点,怎么计算。 比如数字信号是x(n),n=1~N (1)先用Hist函数对x(n)的赋值范围进行分块,比如赋值范围在0~10的对应第 一块,10~20的第二块,以此类推。这之前需要对x(n)做一些归一化处理 (2)统计每一块的数据个数,并求出相应的概率 (3)用信息熵公式求解 以上求解方法获得的虽然是近似的信息熵,但是一般认为,这么做是没有问题的 求一维序列的信息熵的matlab程序代码如下:(已写成调用的函数形式) 测试程序: fs=12000; N=12000; T=1/fs; t=(0:N-1)*T; ff=104; sig=0.5*(1+sin(2*pi*ff*t)).*sin(2*pi*3000*t)+rand(1,length(t)); Hx=yyshang(sig,10) %———————求一维离散序列信息熵matlab代码 function Hx=yyshang(y,duan) %不以原信号为参考的时间域的信号熵 %输入:maxf:原信号的能量谱中能量最大的点 %y:待求信息熵的序列 %duan:待求信息熵的序列要被分块的块数 %Hx:y的信息熵 %duan=10;%将序列按duan数等分,如果duan=10,就将序列分为10等份 x_min=min(y); x_max=max(y); maxf(1)=abs(x_max-x_min); maxf(2)=x_min; duan_t=1.0/duan; jiange=maxf(1)*duan_t; % for i=1:10 % pnum(i)=length(find((y_p>=(i-1)*jiange)&(y_p 1 第5讲 随机变量的信息熵 在概率论和统计学中,随机变量表示随机试验结果的观测值。随机变量的取值是不确定的,但是服从一定的概率分布。因此,每个取值都有自己的信息量。平均每个取值的信息量称为该随机变量的信息熵。 信息熵这个名称是冯诺依曼向香农推荐的。在物理学中,熵是物理系统的状态函数,用于度量一个物理系统内部状态和运动的无序性。物理学中的熵也称为热熵。信息熵的表达式与热熵的表达式类似,可以视为热熵的推广。香农用信息熵度量一个物理系统内部状态和运动的不确定性。 信息熵是信息论的核心和基础概念,具有多种物理意义。香农所创立的信息论是从定义和研究信息熵开始的。这一讲我们学习信息熵的定义和性质。 1. 信息熵 我们这里考虑离散型随机变量的信息熵,连续型随机变量的信息熵以后有时间再讨论,读者也可以看课本上的定义,先简单地了解一下。 定义1.1 设离散型随机变量X 的概率空间为 1 21 2 ......n n x x x X p p p P ?? ??=???????? 我们把X 的所有取值的自信息的期望称为X 的平均自信息量,通常称为信息熵,简称熵(entropy ),记为H(X),即 1 1 ()[()]log n i i i H X E I X p p === ∑ (比特) 信息熵也称为香农熵。 注意,熵H (X )是X 的概率分布P 的函数,因此也记为H (P )。 定义1.2 信息熵表达式中的对数底可取任何大于等于2的整数r ,所得结果称为r-进制熵,记为H r (X ),其单位为“r-进制单位”。 我们有 2 ()() log r X H H r X = 注意,在关于熵的表达式中,我们仍然约定 0log 00 0log 00 x ==, 信息熵的物理意义: 信息熵可从多种不同角度来理解。 (1) H(X)是随机变量X 的取值所能提供的平均信息量。 (2) 统计学中用H(X)表征随机变量X 的不确定性,也就是随机性的大小。 例如,假设有甲乙两只箱子,每个箱子里都存放着100个球。甲里面有红蓝色球各50个,乙里面红、蓝色的球分别为99个和1个。显然,甲里面球的颜色更具有不确定性。从两个箱子各摸出一个球,甲里面摸出的球更不好猜。 (3) 若离散无记忆信源的符号概率分布为P ,则H(P)是该信源的所有无损编码的“平均 码长”的极限。 令X 是离散无记忆信源的符号集,所有长度为n 的消息集合为 {1,2, ,}n M X = 每个消息i 在某个无损编码下的码字为w i ,码字长为l i 比特。假设各消息i 出现的概率为p i ,则该每条消息的平均码长为 1 M n i i i L p l ==∑ 因此,平均每个信源符号的码长为 1 1M n i i i L p l n n ==∑ 这个平均每个信源符号的码长称为该编码的平均码长,其量纲为(码元/信源)。 我们有 () lim () n n n L L H X H X n n →∞≥=且 这是信源编码定理的推论。 青岛农业大学 本科生课程论文 论文题目信息熵及其性质和应用学生专业班级信息与计算科学09级2班学生学号姓名20093992 指导教师吴慧 完成时间2012年06月25日 2012 年06月25日 课程论文任务书 学生姓名指导教师吴慧 论文题目信息熵及其性质和应用 论文内容(需明确列出研究的问题):研究信息熵的目的就是为了更深入的了解信息熵,更好的了解信息熵的作用,更好地使用它解决现实生活中的问题。文中介绍了信息熵的定义和性质及其应用。使我们对信息熵有跟深入的了解。 资料、数据、技术水平等方面的要求:论文要符合一般学术论文的写作规范,具备学术性、科学性和一定的创造性。文字要流畅、语言要准确、论点要清楚、论据要准确、论证要完整、严密,有独立的观点和见解。内容要理论联系实际,计算数据要求准确,涉及到他人的观点、统计数据或计算公式等要标明出处,结论要写的概括简短。参考文献的书写按论文中引用的先后顺序连续编码。 发出任务书日期06月15日完成论文日期06月25日 教研室意见(签字) 院长意见(签字) 信息熵及其性质和应用 信息与计算科学专业 指导教师吴慧 摘要:信息熵是随机变量不确定性的度量,文中从信息熵的定义出发,结合信息熵的性质, 介绍了目前信息熵在具体问题中的应用。信息是一个十分通俗而又广泛的名词,它是人类认识世界、改造世界的知识源泉。人类社会发展的速度,在一定程度上取决于人类对信息利用的水平,所以对信息的度量就很有必要。香农提出信息的一种度量,熵的定义形式,它是随机变量不确定性的度量,文中主要介绍熵的性质及其应用。 关键词;信息熵性质应用 Information entropy and its properties and Application Student majoring in Information and Computing Science Specialty dongqiang Tutor WuHui Abstract:information entropy is a measure of uncertainty of random variable, this paper from the definition of information entropy, combined with the nature of information entropy, information entropy, introduced the specific issues in the application https://www.doczj.com/doc/172896482.html,rmation is a very popular and wi dely noun, it is human understanding of the world, transforming the world knowledge source . The human society development speed, depend on on certain level the human make use of information level, so the measurement information is necessary.Shannon put forward the informa-tion a kind of measurement, the definition of entropy form, it is the uncertainty of random variable metric, this paper mainly introduces the property of entropy and its application. Key words:information entropy properties application 中文信息处理报告 课题名称搜索引擎中的关键技术及解决学院(系)电子信息与工程学院 专业计算机科学与技术 学号072337 学生姓名张志佳 完成时间2009年1月 3 日 目前,国内的每个行业,领域都在飞速发展,这中间产生了大量的中文信息资源,为了能够及时准确的获取最新的信息,中文搜索引擎应运而生。中文搜索引擎与西文搜索引擎在实现的机制和原理上大致相同,但由于汉语本身的特点,必须引入对于中文语言的处理技术,而汉语自动分词技术就是其中很关键的部分,也是进行后续语义或者是语法分析的基础。汉语自动分词到底对搜索引擎有多大影响?对于搜索引擎来说,最重要的并不是找到所有结果,最重要的是把最相关的结果排在最前面,这也称为相关度排序。中文分词的准确与否,常常直接影响到对搜索结果的相关度排序。分词准确性对搜索引擎来说十分重要,但如果分词速度太慢,即使准确性再高,对于搜索引擎来说也是不可用的,在Internet上有上百亿可用的公共Web页面,如果分词耗用的时间过长,会严重影响搜索引擎内容更新的速度。因此对于搜索引擎来说,分词的准确性和速度,都需要达到很高的要求。 更具体的说,现在的搜索引擎要达到下面的三要求,才能适应当今这样一个信息爆炸的时代,分别是:数据量达到亿,单次查询毫秒级,每日查询总数能支持千万级。撇开搜索引擎要用到的数量庞大的服务器硬件和速度巨快的网络环境不提,就单单说说搜索引擎中软件部分的三大核心技术。我个人以为:一个优秀的搜索引擎,它必需在下面三个方面的技术必须是优秀的:中文分词,网络机器人(Spider)和后台索引结构。而这三方面又是紧密相关的,想要解决中文分词问题,就要解决搜索时间和搜索准确率两方面的难题。而搜索时间上便是通过网络机器人(Spider)和后台索引结构的改进实现的,搜索准确率则是通过分词本身算法的求精来实现的。下面的文章将从这两个大的方面来解决这两方面的问题。 为了能够更清楚的来说明现在的搜索引擎是如何解决这几个难题的,首先对搜索引擎的组成及工作原理在这里简要的说明一下。 搜索引擎的工作,可以看做三步:从互联网上抓取网页,建立索引数据库,在索引数据库中搜索排序。从互联网上抓取网页利用能够从互联网上自动收集网页的Spider系统程序,自动访问互联网,并沿着任何网页中的所有URL爬到其它网页,重复这过程,并把爬过的所有网页收集回来。下面是搜索引擎的工作原理图:Array 搜索引擎工作原理图1 信息熵及其性质和应 用 青岛农业大学 本科生课程论文 论文题目信息熵及其性质和应用学生专业班级信息与计算科学09级2班学生学号姓名 20093992 指导教师吴慧 完成时间2012年06月25日 2012 年 06 月 25 日 课程论文任务书 学生姓名指导教师吴慧 论文题目信息熵及其性质和应用 论文内容(需明确列出研究的问题):研究信息熵的目的就是为了更深入的了解信息熵,更好的了解信息熵的作用,更好地使用它解决现实生活中的问题。文中介绍了信息熵的定义和性质及其应用。使我们对信息熵有跟深入的了解。 资料、数据、技术水平等方面的要求:论文要符合一般学术论文的写作规范,具备学术性、科学性和一定的创造性。文字要流畅、语言要准确、论点要清楚、论据要准确、论证要完整、严密,有独立的观点和见解。内容要理论联系实际,计算数据要求准确,涉及到他人的观点、统计数据或计算公式等要标明出处,结论要写的概括简短。参考文献的书写按论文中引用的先后顺序连续编码。 发出任务书日期 06月15日完成论文日期 06月25日教研室意见(签字) 院长意见(签字) 信息熵及其性质和应用 信息与计算科学专业 指导教师吴慧 摘要:信息熵是随机变量不确定性的度量,文中从信息熵的定义出发,结合信息熵的性质,介绍了目前信息熵在具体问题中的应用。信息是一个十分通俗而又广泛的名词,它是人类认识世界、改造世界的知识源泉。人类社会发展的速度,在一定程度上取决于人类对信息利用的水平,所以对信息的度量就很有必要。香农提出信息的一种度量,熵的定义形式,它是随机变量不确定性的度量,文中主要介绍熵的性质及其应用。 关键词;信息熵性质应用 Information entropy and its properties and Application Student majoring in Information and Computing Science Specialty dongqiang Tutor WuHui Abstract:information entropy is a measure of uncertainty of random variable, this paper from the definition of information entropy, combined with the nature of information entropy, information entropy, introduced the specific issues in the application https://www.doczj.com/doc/172896482.html,rmation is a very popular and wi dely noun, it is human understanding of the world, transforming the world knowledge source . The human society development speed, depend on on certain level the human make use of information level, so the measurement information is necessary.Shannon put forward the informa-tion a kind of measurement, the definition of entropy form, it is the uncertainty of random variable metric, this paper mainly introduces the property of entropy and its application. Key words:information entropy properties application第5讲信息熵课件

信息熵及其性质和应用

中文公众事件信息熵计算方法

信息熵及其性质和应用复习课程