hadoop安装步骤

- 格式:docx

- 大小:53.50 KB

- 文档页数:13

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

cdh安装hadoop教程CDH(Cloudera's Distribution including Apache Hadoop)是一种基于Apache Hadoop的大数据处理平台,它提供了一套完整的Hadoop生态系统工具和组件。

CDH安装教程一共包含以下几个步骤:1. 系统准备:在开始安装之前,我们需要确保系统满足CDH的最低要求。

CDH要求操作系统为RHEL / CentOS 6或7,并且至少有8GB的内存,2个vCPU,100GB的磁盘空间和64位操作系统。

此外,还需要配置主机名、网络和防火墙设置。

2. JDK安装:CDH依赖于Java运行环境。

首先需要在系统上安装JDK。

可以从Oracle官方网站或OpenJDK获取JDK安装包。

安装JDK后,还需要设置JAVA_HOME环境变量。

3. CDH下载:在安装CDH之前,我们需要从Cloudera官网下载CDH安装包。

Cloudera提供了几个版本,包括CDH4、CDH5和CDH6。

根据需要选择合适的版本下载。

4. 安装CDH:解压CDH安装包,并根据官方文档进行安装。

安装过程中需要指定一个安装目录和一个临时目录,还需要配置Hadoop配置文件如core-site.xml、hdfs-site.xml、yarn-site.xml等。

这些配置文件用于定义Hadoop集群的相关属性,如数据节点、名称节点、资源管理器等。

5. 启动Hadoop集群:完成CDH安装后,我们需要启动Hadoop集群。

首先启动HDFS服务,然后启动YARN服务。

可以使用启动脚本启动Hadoop集群,或者使用Cloudera Manager进行管理。

6. 验证集群状态:一旦Hadoop集群成功启动,我们需要验证集群的状态。

可以通过命令行工具hdfs dfs -ls /或yarn node -list来检查HDFS和YARN的状态。

如果一切正常,应该能够看到节点列表和文件系统的目录。

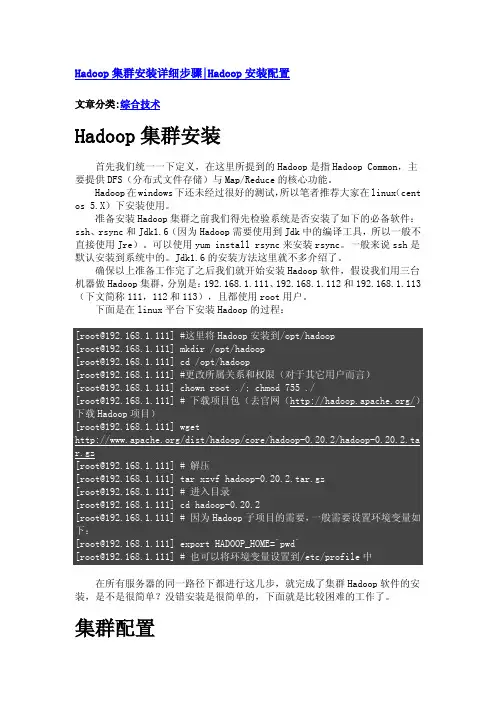

Hadoop集群安装详细步骤|Hadoop安装配置文章分类:综合技术Hadoop集群安装首先我们统一一下定义,在这里所提到的Hadoop是指Hadoop Common,主要提供DFS(分布式文件存储)与Map/Reduce的核心功能。

Hadoop在windows下还未经过很好的测试,所以笔者推荐大家在linux(cent os 5.X)下安装使用。

准备安装Hadoop集群之前我们得先检验系统是否安装了如下的必备软件:ssh、rsync和Jdk1.6(因为Hadoop需要使用到Jdk中的编译工具,所以一般不直接使用Jre)。

可以使用yum install rsync来安装rsync。

一般来说ssh是默认安装到系统中的。

Jdk1.6的安装方法这里就不多介绍了。

确保以上准备工作完了之后我们就开始安装Hadoop软件,假设我们用三台机器做Hadoop集群,分别是:192.168.1.111、192.168.1.112和192.168.1.113(下文简称111,112和113),且都使用root用户。

下面是在linux平台下安装Hadoop的过程:在所有服务器的同一路径下都进行这几步,就完成了集群Hadoop软件的安装,是不是很简单?没错安装是很简单的,下面就是比较困难的工作了。

集群配置根据Hadoop文档的描述“The Hadoop daemons are N ameNode/DataNode and JobTracker/TaskTracker.”可以看出Hadoop核心守护程序就是由NameNode/DataNode 和JobTracker/TaskTracker这几个角色构成。

Hadoop的DFS需要确立NameNode与DataNode角色,一般NameNode会部署到一台单独的服务器上而不与DataNode共同同一机器。

另外Map/Reduce服务也需要确立JobTracker和TaskTracker的角色,一般JobTracker与NameNode共用一台机器作为master,而TaskTracker与DataNode同属于slave。

Hadoop伪分布式安装配置过程在进行Hadoop伪分布式安装配置之前,首先需要确保系统环境符合安装要求。

Hadoop的安装需要在Linux系统下进行,并且需要安装好Java环境。

以下将详细介绍Hadoop伪分布式安装配置的步骤。

一、准备工作1. 确保系统为Linux系统,并且已经安装好Java环境。

2. 下载Hadoop安装包,并解压至指定目录。

二、配置Hadoop环境变量1. 打开.bashrc文件,添加以下内容:```bashexport HADOOP_HOME=/path/to/hadoopexport PATH=$PATH:$HADOOP_HOME/binexport HADOOP_CONF_DIR=/path/to/hadoop/etc/hadoop export HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOME```2. 执行以下命令使环境变量生效:```bashsource ~/.bashrc```三、配置Hadoop1. 编辑hadoop-env.sh文件,设置JAVA_HOME变量:```bashexport JAVA_HOME=/path/to/java```2. 编辑core-site.xml文件,添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```3. 编辑hdfs-site.xml文件,添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```4. 编辑mapred-site.xml.template文件,添加以下内容并保存为mapred-site.xml:```xml<configuration><property><name></name><value>yarn</value></property></configuration>```5. 编辑yarn-site.xml文件,添加以下内容:```xml<configuration><property><name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value></property><property><name>yarn.resourcemanager.hostname</name> <value>localhost</value></property></configuration>```四、格式化HDFS执行以下命令格式化HDFS:```bashhdfs namenode -format```五、启动Hadoop1. 启动HDFS:```bashstart-dfs.sh```2. 启动YARN:```bashstart-yarn.sh```六、验证Hadoop安装通过浏览器访问xxx,确认Hadoop是否成功启动。

Hadoop的安装与配置建立一个三台电脑的群组,操作系统均为Ubuntu,三个主机名分别为wjs1、wjs2、wjs3。

1、环境准备:所需要的软件及我使用的版本分别为:Hadoop版本为0.19.2,JDK版本为jdk-6u13-linux-i586.bin。

由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

所以在三台主机上都设置一个用户名为“wjs”的账户,主目录为/home/wjs。

a、配置三台机器的网络文件分别在三台机器上执行:sudo gedit /etc/network/interfaceswjs1机器上执行:在文件尾添加:auto eth0iface eth0 inet staticaddress 192.168.137.2gateway 192.168.137.1netmask 255.255.255.0wjs2和wjs3机器上分别执行:在文件尾添加:auto eth1iface eth1 inet staticaddress 192.168.137.3(wjs3上是address 192.168.137.4)gateway 192.168.137.1netmask 255.255.255.0b、重启网络:sudo /etc/init.d/networking restart查看ip是否配置成功:ifconfig{注:为了便于“wjs”用户能够修改系统设置访问系统文件,最好把“wjs”用户设为sudoers(有root权限的用户),具体做法:用已有的sudoer登录系统,执行sudo visudo -f /etc/sudoers,并在此文件中添加以下一行:wjsALL=(ALL)ALL,保存并退出。

}c、修改三台机器的/etc/hosts,让彼此的主机名称和ip都能顺利解析,在/etc/hosts中添加:192.168.137.2 wjs1192.168.137.3 wjs2192.168.137.4 wjs3d、由于Hadoop需要通过ssh服务在各个节点之间登陆并运行服务,因此必须确保安装Hadoop的各个节点之间网络的畅通,网络畅通的标准是每台机器的主机名和IP地址能够被所有机器正确解析(包括它自己)。

hadoop安装以及配置启动命令本次安装使⽤的Hadoop⽂件是badou学院的Hadoop1.2.1.tar.gz,以下步骤都是在此版本上进⾏。

1、安装,通过下载tar.gz⽂件安装到指定⽬录2、安装好后需要配置Hadoop集群配置信息: 在hadoop的conf路径中的masters中添加master(集群机器主的hostname)在slaves中添加集群的slave的hostname名称名称对应的是各⾃机器的hostname这样通过hosts⽂件中配置的域名地址映射可以直接找到对应的机器 a、core-site.xml 在xml⽂件中添加<property><name>hadoop.tmp.dir</name><value>/usr/local/src/hadoop.1.2.1/tmp</value></property> <property><name></name><value>hdfs://192.168.79.10:9000</value></property> c、hdfs-site.xml 在⽂件中添加<property><name>dfs.replication</name><value>3</value></property><!-- 复制节点数 --> d、hadoop-env.xml 在⽂件中添加export JAVA_HOME=/usr/local/src/jdk1.6.0_45 步骤2配置好后将当前hadoop⽂件夹复制到集群中其他机器上,只需要在对应机器上修改其对应的ip、port、jdk路径等信息即可搭建集群3、配置好Hadoop环境后需要测试环境是否可⽤: a、⾸先进⼊Hadoop的安装⽬录,进⼊bin⽬录下,先将Hadoop环境初始化,命令:./hadoop namenode -format b、初始化之后启动Hadoop,命令:./start_all.sh c、查看Hadoop根⽬录下的⽂件,命令:./hadoop fs -ls/ d、上传⽂件,命令:./hadoop fs -put ⽂件路径 e、查看⽂件内容,命令:./hadoopo fs -cat hadoop⽂件地址注意:在安装Hadoop环境时先安装好机器集群,使得⾄少3台以上(含3台)机器之间可以免密互相登录(可以查看上⼀篇的linux的ssh免密登录)执⾏Python⽂件时的部分配置/usr/local/src/hadoop-1.2.1/bin/hadoop/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar。

简述hadoop安装步骤简述hadoop安装步骤安装步骤:1、安装虚拟机系统,并进⾏准备⼯作(可安装- ⼀个然后克隆)2.修改各个虚拟机的hostname和host3.创建⽤户组和⽤户4、配置虚拟机⽹络,使虚拟机系统之间以及和host主机之间可以通过相互ping通。

5.安装jdk和配置环境变量,检查是否配置成功6、配置ssh,实现节点间的⽆密码登录ssh node1/2指令验证时候成功7、master 配置hadoop,并将hadoop⽂件传输到node节点8、配置环境变量,并启动hadoop, 检查是否安装成功,执⾏wordcount检查是否成功。

⼆.HDFS作⽤是什么Hadoop分布式⽂件系统(HDFS)是指被设计成适合运⾏在通⽤硬件(commodity hardware)上的分布式⽂件系统(Distributed File System)。

它和现有的分布式⽂件系统有很多共同点。

但同时,它和其他的分布式⽂件系统的区别也是很明显的。

HDFS是⼀个⾼度容错性的系统,适合部署在廉价的机器上。

HDFS能提供⾼吞吐量的数据访问,⾮常适合⼤规模数据集上的应⽤。

HDFS放宽了⼀部分POSIX约束,来实现流式读取⽂件系统数据的⽬的。

HDFS在最开始是作为Apache Nutch搜索引擎项⽬的基础架构⽽开发的。

HDFS是Apache Hadoop Core项⽬的⼀部分。

HDFS有着⾼容错性(fault-tolerant)的特点,并且设计⽤来部署在低廉的(low-cost)硬件上。

⽽且它提供⾼吞吐量(high throughput)来访问应⽤程序的数据,适合那些有着超⼤数据集(large data set)的应⽤程序。

HDFS放宽了(relax)POSIX的要求(requirements)这样可以实现流的形式访问(streaming access)⽂件系统中的数据。

三.常⽤的Hadoop FS Shell命令有哪些及其作⽤1.调⽤Hadoop的⽂件系统Shell(FileSystem Shell)的命令格式:语法:hadoop fs <args>:前提是位置位于hadoop/bin下,其中fs是参数,表⽰FS Shell,<args>是fs的⼦命令2.使⽤FS Shell命令⾏管理⽂件:mkdir -创建⽬录语法:hadoop fs -mkdir <paths>例⼦:hadoop fs -mkdir /user:在HDFS中创建"/user"⽬录hadoop fs -mkdir /user/hadoop:在HDFS中创建"/user/hadoop"⽬录hadoop fs -mkdir /user/hadoop/dir1 /user/hadoop/dir2:在HDFS中同时创建"/user/hadoop/dir1"和"/user/hadoop/dir2",⽬录ls -查看列表⽂件语法:hadoop fs -ls <args>如果是⽂件,则按照如下格式返回⽂件信息:⽂件名<副本数> ⽂件⼤⼩修改⽇期修改时间权限⽤户ID 组ID如果是⽬录,则返回它直接⼦⽂件的⼀个列表cat -查看⽂件语法:hadoop fs -cat URI <URI...>:输出路径指定⽂件的内容例⼦:hadoop fs -cat /input2/file1.txt /input2/file2.txt:在HDFS中查看input2⽬录下的file1.txt和file2.txt的⽂件内容put -从本地⽂件系统中复制⼀个或多个⽂件到HDFS(外部命令)语法:hadoop fs -put <localsrc>...<dst>其中localsrc只能是本地⽂件,dst只能是HDFS⽂件,且不受fs.defaultFS属性影响。

hadoop 操作手册Hadoop 是一个分布式计算框架,它使用 HDFS(Hadoop Distributed File System)存储大量数据,并通过 MapReduce 进行数据处理。

以下是一份简单的 Hadoop 操作手册,介绍了如何安装、配置和使用 Hadoop。

一、安装 Hadoop1. 下载 Hadoop 安装包,并解压到本地目录。

2. 配置 Hadoop 环境变量,将 Hadoop 安装目录添加到 PATH 中。

3. 配置 Hadoop 集群,包括 NameNode、DataNode 和 JobTracker 等节点的配置。

二、配置 Hadoop1. 配置 HDFS,包括 NameNode 和 DataNode 的配置。

2. 配置 MapReduce,包括 JobTracker 和 TaskTracker 的配置。

3. 配置 Hadoop 安全模式,如果需要的话。

三、使用 Hadoop1. 上传文件到 HDFS,使用命令 `hadoop fs -put local_file_path/hdfs_directory`。

2. 查看 HDFS 中的文件和目录信息,使用命令 `hadoop fs -ls /`。

3. 运行 MapReduce 作业,编写 MapReduce 程序,然后使用命令`hadoop jar my_` 运行程序。

4. 查看 MapReduce 作业的运行结果,使用命令 `hadoop fs -cat/output_directory/part-r-00000`。

5. 从 HDFS 中下载文件到本地,使用命令 `hadoop fs -get/hdfs_directory local_directory`。

6. 在 Web 控制台中查看 HDFS 集群信息,在浏览器中打开7. 在 Web 控制台中查看 MapReduce 作业运行情况,在浏览器中打开四、管理 Hadoop1. 启动和停止 Hadoop 集群,使用命令 `` 和 ``。

hadoop的基本使用Hadoop的基本使用Hadoop是一种开源的分布式计算系统和数据处理框架,具有可靠性、高可扩展性和容错性等特点。

它能够处理大规模数据集,并能够在集群中进行并行计算。

本文将逐步介绍Hadoop的基本使用。

一、Hadoop的安装在开始使用Hadoop之前,首先需要进行安装。

以下是Hadoop的安装步骤:1. 下载Hadoop:首先,从Hadoop的官方网站(2. 配置环境变量:接下来,需要将Hadoop的安装目录添加到系统的环境变量中。

编辑~/.bashrc文件(或其他相应的文件),并添加以下行:export HADOOP_HOME=/path/to/hadoopexport PATH=PATH:HADOOP_HOME/bin3. 配置Hadoop:Hadoop的配置文件位于Hadoop的安装目录下的`etc/hadoop`文件夹中。

其中,最重要的配置文件是hadoop-env.sh,core-site.xml,hdfs-site.xml和mapred-site.xml。

根据具体需求,可以在这些配置文件中进行各种参数的设置。

4. 启动Hadoop集群:在完成配置后,可以启动Hadoop集群。

运行以下命令以启动Hadoop集群:start-all.sh二、Hadoop的基本概念在开始使用Hadoop之前,了解一些Hadoop的基本概念是非常重要的。

以下是一些重要的概念:1. 分布式文件系统(HDFS):HDFS是Hadoop的核心组件之一,用于存储和管理大规模数据。

它是一个可扩展的、容错的文件系统,能够在多个计算机节点上存储数据。

2. MapReduce:MapReduce是Hadoop的编程模型,用于并行计算和处理大规模数据。

它由两个主要的阶段组成:Map阶段和Reduce阶段。

Map阶段将输入数据切分为一系列键值对,并运行在集群中的多个节点上。

Reduce阶段将Map阶段的输出结果进行合并和计算。

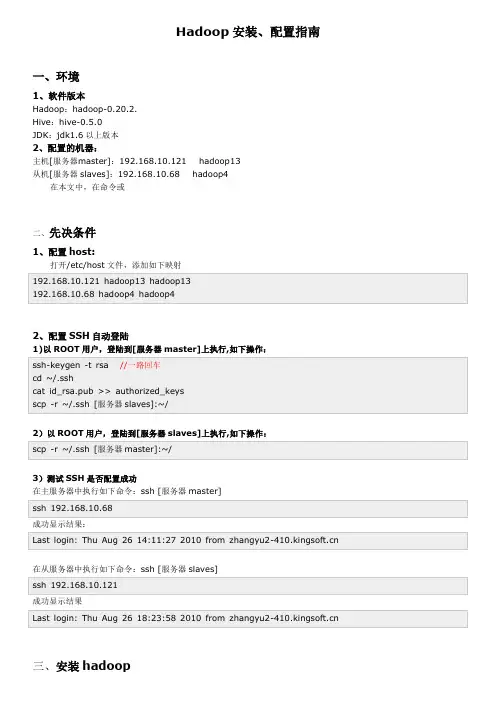

Hadoop安装、配置指南一、环境1、软件版本Hadoop:hadoop-0.20.2.Hive:hive-0.5.0JDK:jdk1.6以上版本2、配置的机器:主机[服务器master]:192.168.10.121 hadoop13从机[服务器slaves]:192.168.10.68 hadoop4在本文中,在命令或二、先决条件1、配置host:打开/etc/host文件,添加如下映射192.168.10.121 hadoop13 hadoop13192.168.10.68 hadoop4 hadoop42、配置SSH自动登陆1)以ROOT用户,登陆到[服务器master]上执行,如下操作:ssh-keygen -t rsa //一路回车cd ~/.sshcat id_rsa.pub >> authorized_keysscp -r ~/.ssh [服务器slaves]:~/2)以ROOT用户,登陆到[服务器slaves]上执行,如下操作:scp -r ~/.ssh [服务器master]:~/3)测试SSH是否配置成功在主服务器中执行如下命令:ssh [服务器master]ssh 192.168.10.68成功显示结果:Last login: Thu Aug 26 14:11:27 2010 from 在从服务器中执行如下命令:ssh [服务器slaves]ssh 192.168.10.121成功显示结果Last login: Thu Aug 26 18:23:58 2010 from 三、安装hadoop1、JDK安装,解压到/usr/local/jdk1.6.0_17,并配置/etc/profile环境export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jarJDK路径:/usr/local/jdk/jdk1.7.0export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar/usr/local/jdk/jdk1.7.02、下载Hadoop 并解压到[服务器master]的/root/zwmhadoop目录下tar zxvf hadoop-0.20.2.tar.gz四、配置hadoop1.配置主机[服务器master]到zwm hadoop/hadoop-0.20.2/ hadoop 目录下,修改以下文件:1)配置conf/hadoop-env.sh文件,在文件中添加环境变量,增加以下内容:export JAVA_HOME=/usr/local/jdk1.6.0_17export HADOOP_HOME=/root/zwmhadoop/hadoop-0.20.2/2)配置conf/core-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>hdfs://192.168.10.121:9000</value>//你的namenode的配置,机器名加端口<description>The nam e of the default file system. Either the literal string "local" o r a host:port for DFS.</description></property></configuration>3)配置conf/hdfs-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name>hadoop.t m p.dir</name><value>/root/zwmhadoop/t m p</value>//Hadoop的默认临时路径,这个最好配置,然后在新增节点或者其他情况下莫名其妙的DataNode启动不了,就删除此文件中的t mp目录即可。

大数据技术实验报告大数据技术实验一Hadoop大数据平台安装实验1实验目的在大数据时代,存在很多开源的分布式数据采集、计算、存储技术,本实验将在熟练掌握几种常见Linux命令的基础上搭建Hadoop(HDFS、MapReduce、HBase、Hive)、Spark、Scala、Storm、Kafka、JDK、MySQL、ZooKeeper等的大数据采集、处理分析技术环境。

2实验环境个人笔记本电脑Win10、Oracle VM VirtualBox 5.2.44、CentOS-7-x86_64-Minimal-1511.iso3实验步骤首先安装虚拟机管理程序,然后创建三台虚拟服务器,最后在虚拟服务器上搭建以Hadoop 集群为核心的大数据平台。

3.1快速热身,熟悉并操作下列Linux命令·创建一个初始文件夹,以自己的姓名(英文)命名;进入该文件夹,在这个文件夹下创建一个文件,命名为Hadoop.txt。

·查看这个文件夹下的文件列表。

·在Hadoop.txt中写入“Hello Hadoop!”,并保存·在该文件夹中创建子文件夹”Sub”,随后将Hadoop.txt文件移动到子文件夹中。

·递归的删除整个初始文件夹。

3.2安装虚拟机并做一些准备工作3.2.1安装虚拟机下载系统镜像,CentOS-7-x86_64-Minimal-1511.iso。

虚拟机软件使用Oracle VM VirtualBox 5.2.44。

3.2.2准备工作关闭防火墙和Selinux,其次要安装perl 、libaio、ntpdate 和screen。

然后检查网卡是否开机自启,之后修改hosts,检查网络是否正常如图:然后要创建hadoop用户,之后多次用,并且生成ssh 密钥并分发。

最后安装NTP 服务。

3.3安装MYSQL 3.3.1安装3.3.2测试3.4安装ZooKeeper。

hadoop集群搭建步骤Hadoop集群搭建步骤Hadoop是一个开源的分布式计算框架,被广泛应用于大数据处理。

搭建Hadoop集群可以提供高可用性、高性能的分布式计算环境。

下面将介绍Hadoop集群的搭建步骤。

1. 硬件准备需要准备一组具有较高性能的服务器作为集群中的节点。

这些服务器需满足一定的硬件要求,包括处理器、内存和存储空间等。

通常情况下,建议使用至少3台服务器来搭建一个最小的Hadoop集群。

2. 操作系统安装在每台服务器上安装合适的操作系统,例如CentOS、Ubuntu等。

操作系统应该是最新的稳定版本,并且需要进行基本的配置,如网络设置、安装必要的软件和工具等。

3. Java环境配置Hadoop是基于Java开发的,因此需要在每台服务器上安装Java 开发环境。

确保安装的Java版本符合Hadoop的要求,并设置好相应的环境变量。

4. Hadoop安装和配置下载Hadoop的最新稳定版本,并将其解压到指定的目录。

然后,需要进行一些配置来启动Hadoop集群。

主要的配置文件包括hadoop-env.sh、core-site.xml、hdfs-site.xml和mapred-site.xml等。

在hadoop-env.sh文件中,可以设置一些全局的环境变量,如Java路径、Hadoop日志目录等。

在core-site.xml文件中,配置Hadoop的核心设置,如Hadoop的文件系统类型(HDFS)和默认的文件系统地址等。

在hdfs-site.xml文件中,配置HDFS的相关设置,如副本数量、数据块大小等。

在mapred-site.xml文件中,配置MapReduce的相关设置,如任务调度方式、任务跟踪器地址等。

5. 配置SSH免密码登录为了实现集群中各节点之间的通信,需要配置SSH免密码登录。

在每台服务器上生成SSH密钥,并将公钥添加到所有其他服务器的授权文件中,以实现无需密码即可登录其他服务器。

Hadoop是Apache下的一个项目,由HDFS、MapReduce、Hbase、Hive和ZooKeeper等成员组成,其中HDFS和MapReduce是两个最重要的成员。

HDFS是Google GFS的开源版本,一个高度容错的分布式文件系统,它能够提供高吞吐量的数据访问,适合存储海量的大文件,其原理如下图所示:采用Master/Slave结构。

NameNode维护集群内的元数据,对外提供创建、打开、删除和重命名文件或目录的功能。

DataNode存储数据,并提负责处理数据的读写请求。

DataNode 定期向NameNode上报心跳,NameNode通过响应心跳来控制DataNode。

InfoWord将MapReduce评为2009年十大新兴技术的冠军。

MapReduce是大规模数据计算的利器,Map和Reduce是它的主要思想,来源于函数式编程语言,它的原理如下图所示:Map负责将数据打散,Reduce负责对数据进行集聚,用户只需要实现Map和Reduce 两个接口,即可完成TB级数据的计算,常见的应用包括:日志分析和数据挖掘等数据分析应用。

另外,还可用于科学数据计算,入圆周率PI的计算等。

Hadoop MapReduce的实现也采用了Master/Slave结构。

Master叫做JobTracker,而Slave 叫做TaskTracker。

用户提交的计算叫做Job,每一个Job会被划分成若干个Tasks。

JobTracker负责Job和Tasks的调度,而TaskTracker负责执行Tasks。

在Linux下搭建Hadoop集群,要先熟悉Linux的基本概念和操作,如cd、ls、tar、cat、ssh、sudo、scp等操作。

养成搜索意识很重要,遇到问题借用Google、百度等,或者论坛,推荐Hadoop技术论坛。

Ubuntu和redhat等版本的Linux在操作命令上有不同点,但安装Hadoop的流程一样。

Hadoop安装教程_伪分布式配置_CentOS6.4/Hadoop2.6.0都能顺利在CentOS 中安装并运行Hadoop。

环境本教程使用CentOS 6.4 32位作为系统环境,请自行安装系统(可参考使用VirtualBox安装CentOS)。

如果用的是Ubuntu 系统,请查看相应的Ubuntu安装Hadoop教程。

本教程基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1, Hadoop 2.4.1等。

Hadoop版本Hadoop 有两个主要版本,Hadoop 1.x.y 和Hadoop 2.x.y 系列,比较老的教材上用的可能是0.20 这样的版本。

Hadoop 2.x 版本在不断更新,本教程均可适用。

如果需安装0.20,1.2.1这样的版本,本教程也可以作为参考,主要差别在于配置项,配置请参考官网教程或其他教程。

新版是兼容旧版的,书上旧版本的代码应该能够正常运行(我自己没验证,欢迎验证反馈)。

装好了CentOS 系统之后,在安装Hadoop 前还需要做一些必备工作。

创建hadoop用户如果你安装CentOS 的时候不是用的“hadoop” 用户,那么需要增加一个名为hadoop 的用户。

首先点击左上角的“应用程序” -> “系统工具” -> “终端”,首先在终端中输入su,按回车,输入root 密码以root 用户登录,接着执行命令创建新用户hadoop:如下图所示,这条命令创建了可以登陆的hadoop 用户,并使用/bin/bash 作为shell。

CentOS创建hadoop用户接着使用如下命令修改密码,按提示输入两次密码,可简单的设为“hadoop”(密码随意指定,若提示“无效的密码,过于简单”则再次输入确认就行):可为hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题,执行:如下图,找到root ALL=(ALL) ALL这行(应该在第98行,可以先按一下键盘上的ESC键,然后输入:98 (按一下冒号,接着输入98,再按回车键),可以直接跳到第98行),然后在这行下面增加一行内容:hadoop ALL=(ALL) ALL(当中的间隔为tab),如下图所示:为hadoop增加sudo权限添加上一行内容后,先按一下键盘上的ESC键,然后输入:wq (输入冒号还有wq,这是vi/vim编辑器的保存方法),再按回车键保存退出就可以了。

➢3.10.2.进程➢JpsMaster节点:namenode/tasktracker(如果Master不兼做Slave, 不会出现datanode/TasktrackerSlave节点:datanode/Tasktracker说明:JobTracker 对应于NameNodeTaskTracker 对应于DataNodeDataNode 和NameNode 是针对数据存放来而言的JobTracker和TaskTracker是对于MapReduce执行而言的mapreduce中几个主要概念,mapreduce整体上可以分为这么几条执行线索:jobclient,JobTracker与TaskTracker。

1、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker创建每个Task(即MapTask和ReduceTask)并将它们分发到各个TaskTracker服务中去执行2、JobTracker是一个master服务,软件启动之后JobTracker接收Job,负责调度Job的每一个子任务task运行于TaskTracker上,并监控它们,如果发现有失败的task就重新运行它。

一般情况应该把JobTracker部署在单独的机器上。

3、TaskTracker是运行在多个节点上的slaver服务。

TaskTracker主动与JobTracker通信,接收作业,并负责直接执行每一个任务。

TaskTracker都需要运行在HDFS的DataNode上3.10.3.文件系统HDFS⏹查看文件系统根目录:Hadoop fs–ls /。

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

centos环境下hadoop的安装与配置实验总结实验总结:CentOS环境下Hadoop的安装与配置一、实验目标本次实验的主要目标是学习在CentOS环境下安装和配置Hadoop,了解其基本原理和工作机制,并能够运行简单的MapReduce程序。

二、实验步骤1. 准备CentOS环境:首先,我们需要在CentOS上安装和配置好必要的基础环境,包括Java、SSH等。

2. 下载Hadoop:从Hadoop官方网站下载Hadoop的稳定版本,或者使用CentOS的软件仓库进行安装。

3. 配置Hadoop:解压Hadoop安装包后,需要进行一系列的配置。

这包括设置环境变量、配置文件修改等步骤。

4. 格式化HDFS:使用Hadoop的命令行工具,对HDFS进行格式化,创建其存储空间。

5. 启动Hadoop:启动Hadoop集群,包括NameNode、DataNode等。

6. 测试Hadoop:运行一些简单的MapReduce程序,检查Hadoop是否正常工作。

三、遇到的问题和解决方案1. 环境变量配置问题:在配置Hadoop的环境变量时,有时会出现一些问题。

我们需要检查JAVA_HOME是否设置正确,并确保HADOOP_HOME 在PATH中。

2. SSH连接问题:在启动Hadoop集群时,需要确保各个节点之间可以通过SSH进行通信。

如果出现问题,需要检查防火墙设置和SSH配置。

3. MapReduce程序运行问题:在运行MapReduce程序时,可能会遇到一些错误。

这通常是由于程序本身的问题,或者是由于HDFS的权限问题。

我们需要仔细检查程序代码,并确保运行程序的用户有足够的权限访问HDFS。

四、实验总结通过本次实验,我们深入了解了Hadoop的安装和配置过程,以及如何解决在安装和运行过程中遇到的问题。

这对于我们今后在实际应用中部署和使用Hadoop非常重要。

同时,也提高了我们的实践能力和解决问题的能力。

本次环境一共三台服务器,JAVA使用的版本是jdk1.6.0_45,zookeeper-3.4.5,hadoop-2.0.0,hive-0.10.0,hbase-0.94.6对于hadoop来说,在hdfs看来节点分为namenode、datanode。

namenode只有一个,datanode可以是很多;在mapreduce 看来节点分为jobtracker、tasktracker,jobtracker只有一个,tasktracker有多个。

我这里是将namenode和jobtracker 部署在同一节点上,datanode和tasktracker部署在其它节点上,1.安装jdk,上传到/root目录下,执行chmod a+x jdk-6u14-linux-x64.bin./jdk-6u14-linux-x64.bin将安装目录移动到/app目录下mkdir /appmv jdk1.6.0_45 /app建立链接:mkdir -p /app/java/; (-p确保目录名称存在,如果目录不存在的就新创建一个)ln -sf /app/jdk1.6.0_45 /app/java/latest/(-f:链结时先将与dist 同档名的档案删除-s:进行软链结(symbolic link))配置JAVA的环境变量vi /etc/profile添加如下内容:export JAVA_HOME=/app/jdk1.6.0_45export PATH=$JAVA_HOME/bin:$PATH让添加的环境变量生效执行如下命令:source /etc/profile; java –version2.配置网络以root账户登录每台服务器,并执行如下操作:vi /etc/hosts添加如下内容:192.168.59.178 vmtmstorm01192.168.59.173 monitor04192.168.59.170 monitor01注:在所有服务器的/etc/hosts文件中添加如上内容;同时,修改windows下该文件,使得个人的笔记本也能识别主机名c:\windows\system32\drivers\etc\hosts 中添加如上内容。

3.配置SSH互信SSH互信:在目标机器上,预先设置好经过认证的key文件,当需要访问目标机器时,目标机器通过key文件,对访问者进行自动认证,从而实现互信。

在任意一台服务器上,以bdp账号登陆(密码123)执行如下命令,生成bdp账号的密钥对(这里是主机执行)/usr/bin/ssh-keygen -t rsacd ~/.ssh/cp id_rsa.pub authorized_keyschmod 600 authorized_keys将~/.ssh目录拷贝覆盖到集群其他节点的bdp用户目录下scp -r .ssh/ 192.168.59.173:~/scp -r .ssh/ 192.168.59.170:~/注意,要确保/etc/ssh/sshd_config 的RSAAuthentication和PubkeyAuthentication为yes,(打开认证方式)改好后重启ssh服务/sbin/service sshd restart执行 ssh `hostname` 测试是否配置成功4.操作系统参数优化(每台机器,且以root操作)4.1防火墙配置:关闭selinux / iptables (每台机器,root权限)•关闭iptables–停止服务:service iptables stop–关闭服务自动启动:chkconfig --del iptables•关闭selinux–修改/etc/selinux/config里SELINUX=disabled4.2 关闭swapiness,减少swap使用倾向 (每台机器,root权限)•当系统有swap时会很慢,所以让系统最大限度的使用物理内存(默认vm.swappiness = 60)•修改/etc/sysctl.conf,增加一行 vm.swappiness = 0echo "vm.swappiness = 0" >> /etc/sysctl.conf•动态生效 sysctl -w vm.swappiness=0 ( -w临时改变某个指定参数的值)•查看是否生效 cat /proc/sys/vm/swappiness(/proc 可以在该目录下获取系统信息,这些信息是在内存中由系统自己产生的)注:sysctl.conf是一个用于在系统运作中查看及调整系统参数的工具4.3 最大打开文件数和最大进程数limits.conf (每台机器,root权限)•Linux默认是1024,对于分布式文件系统太小,Hadoop有可能会报错误•执行 ulimit -a,查看open files项和max user processes项•执行下面脚本,修改这两项值•echo "* - nofile 1000000" >> /etc/security/limits.conf•echo "YOUR_USER_NAME - nproc 1000000">> /etc/security/limits.conf•sysctl –p•重启服务器,执行 ulimit -a 查看是否修改成功?在/etc/security/limits.conf中重复出现了多个YOUR_USER_NAME - nproc 10000004.4 屏蔽文件访问时间,优化/etc/fstab参数 (每台机器,root权限)(注:未配置)• HDFS存储着海量文件,如果屏蔽底层Linux的文件访问时间,会提高HDFS的IO•修改/etc/fstab,添加如下noatime,nodiration,例如LABEL=/data1 /data1 ext4 defaults,noatime,nodiratime 1 2LABEL=/data2 /data2 ext4 defaults,noatime,nodiratime 1 2LABEL=/data3 /data3 ext4 defaults,noatime,nodiratime 1 2•重新mount或重启机器使之生效•注:由于我们使用的是虚拟机,可以不配置该参数4.5 配置ntp时间同步 (每台机器,root权限)•在Hadoop集群中,要求服务器之间的时间同步•选一台服务器作为NTP server, 修改 /etc/ntp.conf 如下,restrict default nomodifyserver 192.168.59.178fudge 192.168.59.178 stratum 8并重启 service ntpd restart•在集群其他节点上,首先关闭NTPservice ntpd stop•执行/usr/sbin/ntpdate NTPSERVER_IP 进行同步,执行 date 查看是否正确•再cron里加入同步命令:执行 crontab –e (-e:执行文字编辑器来设定时程表,内定的文字编辑器是 VI,),添加如下内容,使其每小时同步一次测试情况:/etc/ntp.conf文件下192.168.59.178:restrict default nomodifyserver 192.168.59.178fudge 192.168.59.178 stratum 8192.168.59.173:server 192.168.59.178fudge 192.168.59.178 stratum 10192.168.59.173:无修改结果:三台机器时间已同步补充:crontab [ -u user ] filecrontab [ -u user ] { -l | -r | -e }说明:crontab 是用来让使用者在固定时间或固定间隔执行程式之用,换句话说,也就是类似使用者的时程表。

-u user 是指设定指定 user 的时程表,这个前提是你必须要有其权限(比如说是 root)才能够指定他人的时程表。

如果不使用 -u user 的话,就是表示设定自己的时程表。

参数:-e:执行文字编辑器来设定时程表,内定的文字编辑器是 VI,如果你想用别的文字编辑器,则请先设定 VISUAL 环境变数来指定使用那个文字编辑器(比如说 setenv VISUAL joe)-r:删除目前的时程表-l:列出目前的时程表时程表的格式如下:f1 f2 f3 f4 f5 program其中 f1 是表示分钟,f2 表示小时,f3 表示一个月份中的第几日,f4 表示月份,f5 表示一个星期中的第几天。

program 表示要执行的程式。

当 f1 为 * 时表示每分钟都要执行 program,f2 为 * 时表示每小时都要执行程式,其余类推当 f1 为 a-b 时表示从第 a 分钟到第 b 分钟这段时间内要执行,f2 为 a-b 时表示从第 a 到第 b 小时都要执行,其余类推当 f1 为 */n 时表示每 n 分钟个时间间隔执行一次,f2 为 */n 表示每 n 小时个时间间隔执行一次,其余类推5.Zookeeper安装5.1 ZK配置:单节点配置在${ZOOKEEPER_HOME}/conf/zoo.cfg ( /app/zookeeper-3.4.5-cdh4.3.0/conf/zoo.cfg)中做如下定义tickTime=5000dataDir=/app/zookeeper-3.4.5-cdh4.3.0/data (/tmp/zookeeper /tmp用来存放不同程序执行时产生的临时文件)clientPort=2181配置参数a)tickTime:每个tick的时间长度(毫秒),是zk中最小时间单元。

b)dataDir:内存快照(snapshot)和transaction log的存储目录c)clientPort :用于服务client连接的端口号5.2 ZK配置:多节点配置(为3个节点的集群)在${ZOOKEEPER_HOME}/conf/zoo.cfg ( /app/zookeeper-3.4.5-cdh4.3.0/conf/zoo.cfg)中做如下定义tickTime=5000dataDir=/app/zookeeper-3.4.5-cdh4.3.0/dataclientPort=2181initLimit=10syncLimit=5server.1=192.168.59.178:4888:5888server.2=192.168.59.173:4888:5888server.3=192.168.59.170:4888:5888•配置参数–initLimit: 刚选举出leader后,followers 与leader 连接和同步(connect/sync)的时间周期: initLimit*tickTime。