TREC 2003 QA at BBN Answering Definitional Questions

- 格式:pdf

- 大小:49.35 KB

- 文档页数:9

Multinomial Randomness Models for Retrieval withDocument FieldsVassilis Plachouras1and Iadh Ounis21Yahoo!Research,Barcelona,Spain2University of Glasgow,Glasgow,UKvassilis@,ounis@ Abstract.Documentfields,such as the title or the headings of a document,offer a way to consider the structure of documents for retrieval.Most of the pro-posed approaches in the literature employ either a linear combination of scoresassigned to differentfields,or a linear combination of frequencies in the termfrequency normalisation component.In the context of the Divergence From Ran-domness framework,we have a sound opportunity to integrate documentfieldsin the probabilistic randomness model.This paper introduces novel probabilis-tic models for incorporatingfields in the retrieval process using a multinomialrandomness model and its information theoretic approximation.The evaluationresults from experiments conducted with a standard TREC Web test collectionshow that the proposed models perform as well as a state-of-the-artfield-basedweighting model,while at the same time,they are theoretically founded and moreextensible than currentfield-based models.1IntroductionDocumentfields provide a way to incorporate the structure of a document in Information Retrieval(IR)models.In the context of HTML documents,the documentfields may correspond to the contents of particular HTML tags,such as the title,or the heading tags.The anchor text of the incoming hyperlinks can also be seen as a documentfield. In the case of email documents,thefields may correspond to the contents of the email’s subject,date,or to the email address of the sender[9].It has been shown that using documentfields for Web retrieval improves the retrieval effectiveness[17,7].The text and the distribution of terms in a particularfield depend on the function of thatfield.For example,the titlefield provides a concise and short description for the whole document,and terms are likely to appear once or twice in a given title[6].The anchor textfield also provides a concise description of the document,but the number of terms depends on the number of incoming hyperlinks of the document.In addition, anchor texts are not always written by the author of a document,and hence,they may enrich the document representation with alternative terms.The combination of evidence from the differentfields in a retrieval model requires special attention.Robertson et al.[14]pointed out that the linear combination of scores, which has been the approach mostly used for the combination offields,is difficult to interpret due to the non-linear relation between the assigned scores and the term frequencies in each of thefields.Hawking et al.[5]showed that the term frequency G.Amati,C.Carpineto,and G.Romano(Eds.):ECIR2007,LNCS4425,pp.28–39,2007.c Springer-Verlag Berlin Heidelberg2007Multinomial Randomness Models for Retrieval with Document Fields 29normalisation applied to each field depends on the nature of the corresponding field.Zaragoza et al.[17]introduced a field-based version of BM25,called BM25F,which applies term frequency normalisation and weighting of the fields independently.Mac-donald et al.[7]also introduced normalisation 2F in the Divergence From Randomness (DFR)framework [1]for performing independent term frequency normalisation and weighting of fields.In both cases of BM25F and the DFR models that employ normali-sation 2F,there is the assumption that the occurrences of terms in the fields follow the same distribution,because the combination of fields takes place in the term frequency normalisation component,and not in the probabilistic weighting model.In this work,we introduce weighting models,where the combination of evidence from the different fields does not take place in the term frequency normalisation part of the model,but instead,it constitutes an integral part of the probabilistic randomness model.We propose two DFR weighting models that combine the evidence from the different fields using a multinomial distribution,and its information theoretic approx-imation.We evaluate the performance of the introduced weighting models using the standard .Gov TREC Web test collection.We show that the models perform as well as the state-of-the-art model field-based PL2F,while at the same time,they employ a theoretically founded and more extensible combination of evidence from fields.The remainder of this paper is structured as follows.Section 2provides a description of the DFR framework,as well as the related field-based weighting models.Section 3introduces the proposed multinomial DFR weighting models.Section 4presents the evaluation of the proposed weighting models with a standard Web test collection.Sec-tions 5and 6close the paper with a discussion related to the proposed models and the obtained results,and some concluding remarks drawn from this work,respectively.2Divergence from Randomness Framework and Document Fields The Divergence From Randomness (DFR)framework [1]generates a family of prob-abilistic weighting models for IR.It provides a great extent of flexibility in the sense that the generated models are modular,allowing for the evaluation of new assumptions in a principled way.The remainder of this section provides a description of the DFR framework (Section 2.1),as well as a brief description of the combination of evidence from different document fields in the context of the DFR framework (Section 2.2).2.1DFR ModelsThe weighting models of the Divergence From Randomness framework are based on combinations of three components:a randomness model RM ;an information gain model GM ;and a term frequency normalisation model.Given a collection D of documents,the randomness model RM estimates the probability P RM (t ∈d |D )of having tf occurrences of a term t in a document d ,and the importance of t in d corresponds to the informative content −log 2(P RM (t ∈d |D )).Assuming that the sampling of terms corresponds to a sequence of independent Bernoulli trials,the randomness model RM is the binomial distribution:P B (t ∈d |D )= T F tfp tf (1−p )T F −tf (1)30V .Plachouras and I.Ouniswhere TF is the frequency of t in the collection D ,p =1N is a uniform prior probabilitythat the term t appears in the document d ,and N is the number of documents in the collection D .A limiting form of the binomial distribution is the Poisson distribution P :P B (t ∈d |D )≈P P (t ∈d |D )=λtf tf !e −λwhere λ=T F ·p =T FN (2)The information gain model GM estimates the informative content 1−P risk of the probability P risk that a term t is a good descriptor for a document.When a term t appears many times in a document,then there is very low risk in assuming that t describes the document.The information gain,however,from any future occurrences of t in d is lower.For example,the term ‘evaluation’is likely to have a high frequency in a document about the evaluation of IR systems.After the first few occurrences of the term,however,each additional occurrence of the term ‘evaluation’provides a diminishing additional amount of information.One model to compute the probability P risk is the Laplace after-effect model:P risk =tf tf +1(3)P risk estimates the probability of having one more occurrence of a term in a document,after having seen tf occurrences already.The third component of the DFR framework is the term frequency normalisation model,which adjusts the frequency tf of the term t in d ,given the length l of d and the average document length l in D .Normalisation 2assumes a decreasing density function of the normalised term frequency with respect to the document length l .The normalised term frequency tfn is given as follows:tfn =tf ·log 2(1+c ·l l )(4)where c is a hyperparameter,i.e.a tunable parameter.Normalisation 2is employed in the framework by replacing tf in Equations (2)and (3)with tfn .The relevance score w d,q of a document d for a query q is given by:w d,q =t ∈qqtw ·w d,t where w d,t =(1−P risk )·(−log 2P RM )(5)where w d,t is the weight of the term t in document d ,qtw =qtf qtf max ,qtf is the frequency of t in the query q ,and qtf max is the maximum qtf in q .If P RM is estimatedusing the Poisson randomness model,P risk is estimated using the Laplace after-effect model,and tfn is computed according to normalisation 2,then the resulting weight-ing model is denotedby PL2.The factorial is approximated using Stirling’s formula:tf !=√2π·tftf +0.5e −tf .The DFR framework generates a wide range of weighting models by using different randomness models,information gain models,or term frequency normalisation models.For example,the next section describes how normalisation 2is extended to handle the normalisation and weighting of term frequencies for different document fields.Multinomial Randomness Models for Retrieval with Document Fields31 2.2DFR Models for Document FieldsThe DFR framework has been extended to handle multiple documentfields,and to apply per-field term frequency normalisation and weighting.This is achieved by ex-tending normalisation2,and introducing normalisation2F[7],which is explained below.Suppose that a document has kfields.Each occurrence of a term can be assigned to exactly onefield.The frequency tf i of term t in the i-thfield is normalised and weighted independently of the otherfields.Then,the normalised and weighted term frequencies are combined into one pseudo-frequency tfn2F:tfn2F=ki=1w i·tf i log21+c i·l il i(6)where w i is the relative importance or weight of the i-thfield,tf i is the frequency of t in the i-thfield of document d,l i is the length of the i-thfield in d,l i is the average length of the i-thfield in the collection D,and c i is a hyperparameter for the i-thfield.The above formula corresponds to normalisation2F.The weighting model PL2F corresponds to PL2using tfn2F as given in Equation(6).The well-known BM25 weighting model has also been extended in a similar way to BM25F[17].3Multinomial Randomness ModelsThis section introduces DFR models which,instead of extending the term frequency normalisation component,as described in the previous section,use documentfields as part of the randomness model.While the weighting model PL2F has been shown to perform particularly well[7,8],the documentfields are not an integral part of the ran-domness weighting model.Indeed,the combination of evidence from the differentfields takes place as a linear combination of normalised frequencies in the term frequency nor-malisation component.This implies that the term frequencies are drawn from the same distribution,even though the nature of eachfield may be different.We propose two weighting models,which,instead of assuming that term frequen-cies infields are drawn from the same distribution,use multinomial distributions to incorporate documentfields in a theoretically driven way.Thefirst one is based on the multinomial distribution(Section3.1),and the second one is based on an information theoretic approximation of the multinomial distribution(Section3.2).3.1Multinomial DistributionWe employ the multinomial distribution to compute the probability that a term appears a given number of times in each of thefields of a document.The formula of the weighting model is derived as follows.Suppose that a document d has kfields.The probability that a term occurs tf i times in the i-thfield f i,is given as follows:P M(t∈d|D)=T Ftf1tf2...tf k tfp tf11p tf22...p tf kkp tf (7)32V .Plachouras and I.OunisIn the above equation,T F is the frequency of term t in the collection,p i =1k ·N is the prior probability that a term occurs in a particular field of document d ,and N is the number of documents in the collection D .The frequency tf =T F − ki =1tf i cor-responds to the number of occurrences of t in other documents than d .The probability p =1−k 1k ·N =N −1N corresponds to the probability that t does not appear in any of the fields of d .The DFR weighting model is generated using the multinomial distribution from Equation (7)as a randomness model,the Laplace after-effect from Equation (3),and replacing tf i with the normalised term frequency tfn i ,obtained by applying normal-isation 2from Equation (4).The relevance score of a document d for a query q is computed as follows:w d,q = t ∈q qtw ·w d,t = t ∈qqtw ·(1−P risk )· −log 2(P M (t ∈d |D )=t ∈q qtw k i =1tfn i +1· −log 2(T F !)+k i =1 log 2(tfn i !)−tfn i log 2(p i ) +log 2(tfn !)−tfn log 2(p ) (8)where qtw is the weight of a term t in query q ,tfn =T F − k i =1tfn i ,tfn i =tf i ·log 2(1+c i ·li l i )for the i -th field,and c i is the hyperparameter of normalisation 2for the i -th field.The weighting model introduced in the above equation is denoted by ML2,where M stands for the multinomial randomness model,L stands for the Laplace after-effect model,and 2stands for normalisation 2.Before continuing,it is interesting to note two issues related to the introduced weight-ing model ML2,namely setting the relative importance,or weight,of fields in the do-cument representation,and the computation of factorials.Weights of fields.In Equation (8),there are two different ways to incorporate weights for the fields of documents.The first one is to multiply each of the normalised term frequencies tfn i with a constant w i ,in a similar way to normalisation 2F (see Equa-tion (6)):tfn i :=w i ·tfn i .The second way is to adjust the prior probabilities p i of fields,in order to increase the scores assigned to terms occurring in fields with low prior probabilities:p i :=p i w i .Indeed,the assigned score to a query term occurring in a field with low probability is high,due to the factor −tfn i log 2(p i )in Equation (8).Computing factorials.As mentioned in Section 2.1,the factorial in the weighting model PL2is approximated using Stirling’s formula.A different method to approximate the factorial is to use the approximation of Lanczos to the Γfunction [12,p.213],which has a lower approximation error than Stirling’s formula.Indeed,preliminary experi-mentation with ML2has shown that using Stirling’s formula affects the performance of the weighting model,due to the accumulation of the approximation error from com-puting the factorial k +2times (k is the number of fields).This is not the case for the Poisson-based weighting models PL2and PL2F,where there is only one factorial com-putation for each query term (see Equation (2)).Hence,the computation of factorials in Equation (8)is performed using the approximation of Lanczos to the Γfunction.Multinomial Randomness Models for Retrieval with Document Fields33 3.2Approximation to the Multinomial DistributionThe DFR framework generates different models by replacing the binomial randomness model with its limiting forms,such as the Poisson randomness model.In this section, we introduce a new weighting model by replacing the multinomial randomness model in ML2with the following information theoretic approximation[13]:T F!tf1!tf2!···tf k!tf !p1tf1p2tf2···p k tf k p tf ≈1√2πT F k2−T F·Dtf iT F,p ip t1p t2···p tk p t(9)Dtf iT F,p icorresponds to the information theoretic divergence of the probability p ti=tf iT Fthat a term occurs in afield,from the prior probability p i of thefield:D tfiT F,p i=ki=1tfiT Flog2tf iT F·p i+tfT Flog2tfT F·p(10)where tf =T F− ki=1tf i.Hence,the multinomial randomness model M in theweighting model ML2can be replaced by its approximation from Equation(9):w d,q=t∈q qtw·k2log2(2πT F)ki=1tfn i+1·ki=1tfn i log2tfn i/T Fp i+12log2tfn iT F+tfn log2tfn /T Fp+12log2tfnT F(11)The above model is denoted by M D L2.The definitions of the variables involved in theabove equation have been introduced in Section3.1.It should be noted that the information theoretic divergence Dtf iT F,p iis definedonly when tf i>0for1≤i≤k.In other words,Dtf iT F,p iis defined only whenthere is at least one occurrence of a query term in all thefields.This is not always the case,because a Web document may contain all the query terms in its body,but it may contain only some of the query terms in its title.To overcome this issue,the weight of a query term t in a document is computed by considering only thefields in which the term t appears.The weights of differentfields can be defined in the same way as in the case of the weighting model ML2,as described in Section3.1.In more detail,the weighting of fields can be achieved by either multiplying the frequency of a term in afield by a constant,or by adjusting the prior probability of the correspondingfield.An advantage of the weighting model M D L2is that,because it approximates the multinomial distribution,there is no need to compute factorials.Hence,it is likely to provide a sufficiently accurate approximation to the multinomial distribution,and it may lead to improved retrieval effectiveness compared to ML2,due to the lower accu-mulated numerical errors.The experimental results in Section4.2will indeed confirm this advantage of M D L2.34V.Plachouras and I.Ounis4Experimental EvaluationIn this section,we evaluate the proposed multinomial DFR models ML2and M D L2, and compare their performance to that of PL2F,which has been shown to be particu-larly effective[7,8].A comparison of the retrieval effectiveness of PL2F and BM25F has shown that the two models perform equally well on various search tasks and test collections[11],including those employed in this work.Hence,we experiment only with the multinomial models and PL2F.Section4.1describes the experimental setting, and Section4.2presents the evaluation results.4.1Experimental SettingThe evaluation of the proposed models is conducted with TREC Web test collection,a crawl of approximately1.25million documents from domain.The .Gov collection has been used in the TREC Web tracks between2002and2004[2,3,4]. In this work,we employ the tasks from the Web tracks of TREC2003and2004,because they include both informational tasks,such as the topic distillation(td2003and td2004, respectively),as well as navigational tasks,such as named pagefinding(np2003and np2004,respectively)and home pagefinding(hp2003and hp2004,respectively).More specifically,we train and test for each type of task independently,in order to get insight on the performance of the proposed models[15].We employ each of the tasks from the TREC2003Web track for training the hyperparameters of the proposed models.Then, we evaluate the models on the corresponding tasks from the TREC2004Web track.In the reported set of experiments,we employ k=3documentfields:the contents of the<BODY>tag of Web documents(b),the anchor text associated with incoming hyperlinks(a),and the contents of the<TITLE>tag(t).Morefields can be defined for other types offields,such as the contents of the heading tags<H1>for example. It has been shown,however,that the body,title and anchor textfields are particularly effective for the considered search tasks[11].The collection of documents is indexed after removing stopwords and applying Porter’s stemming algorithm.We perform the experiments in this work using the Terrier IR platform[10].The proposed models ML2and M D L2,as well as PL2F,have a range of hyperpa-rameters,the setting of which can affect the retrieval effectiveness.More specifically,all three weighting models have two hyperparameters for each employed documentfield: one related to the term frequency normalisation,and a second one related to the weight of thatfield.As described in Sections3.1and3.2,there are two ways to define the weights offields for the weighting models ML2and M D L2:(i)multiplying the nor-malised frequency of a term in afield;(ii)adjusting the prior probability p i of the i-th field.Thefield weights in the case of PL2F are only defined in terms of multiplying the normalised term frequency by a constant w i,as shown in Equation(6).In this work,we consider only the term frequency normalisation hyperparameters, and we set all the weights offields to1,in order to avoid having one extra parameter in the discussion of the performance of the weighting models.We set the involved hyperparameters c b,c a,and c t,for the body,anchor text,and titlefields,respectively, by directly optimising mean average precision(MAP)on the training tasks from the Web track of TREC2003.We perform a3-dimensional optimisation to set the valuesMultinomial Randomness Models for Retrieval with Document Fields 35of the hyperparameters.The optimisation process is the following.Initially,we apply a simulated annealing algorithm,and then,we use the resulting hyperparameter values as a starting point for a second optimisation algorithm [16],to increase the likelihood of detecting a global maximum.For each of the three training tasks,we apply the above optimisation process three times,and we select the hyperparameter values that result in the highest MAP.We employ the above optimisation process to increase the likelihood that the hyperparameters values result in a global maximum for MAP.Figure 1shows the MAP obtained by ML2on the TREC 2003home page finding topics,for each iteration of the optimisation process.Table 1reports the hyperparameter values that resulted in the highest MAP for each of the training tasks,and that are used for the experiments in this work.0 0.20.40.60.80 40 80 120 160 200M A PiterationML2Fig.1.The MAP obtained by ML2on the TREC 2003home page finding topics,during the optimisation of the term frequency normalisation hyperparametersThe evaluation results from the Web tracks of TREC 2003[3]and 2004[4]have shown that employing evidence from the URLs of Web documents results in important improvements in retrieval effectiveness for the topic distillation and home page find-ing tasks,where relevant documents are home pages of relevant Web sites.In order to provide a more complete evaluation of the proposed models for these two types of Web search tasks,we also employ the length in characters of the URL path,denoted by URLpathlen ,using the following formula to transform it to a relevance score [17]:w d,q :=w d,q +ω·κκ+URLpathlen (12)where w d,q is the relevance score of a document.The parameters ωand κare set by per-forming a 2-dimensional optimisation as described for the case of the hyperparameters c i .The resulting values for ωand κare shown in Table 2.4.2Evaluation ResultsAfter setting the hyperparameter values of the proposed models,we evaluate the models with the search tasks from TREC 2004Web track [4].We report the official TREC evaluation measures for each search task:mean average precision (MAP)for the topic distillation task (td2004),and mean reciprocal rank (MRR)of the first correct answer for both named page finding (np2004)and home page finding (hp2004)tasks.36V.Plachouras and I.OunisTable1.The values of the hyperparameters c b,c a,and c t,for the body,anchor text and titlefields,respectively,which resulted in the highest MAP on the training tasks of TREC2003Web trackML2Task c b c a c ttd20030.0738 4.326810.8220np20030.1802 4.70578.4074hp20030.1926310.3289624.3673M D L2Task c b c a c ttd20030.256210.038324.6762np20031.02169.232121.3330hp20030.4093355.2554966.3637PL2FTask c b c a c ttd20030.1400 5.0527 4.3749np20031.015311.96529.1145hp20030.2785406.1059414.7778Table2.The values of the hyperparameters ωandκ,which resulted in the high-est MAP on the training topic distillation (td2003)and home pagefinding(hp2003) tasks of TREC2003Web trackML2Taskωκtd20038.809514.8852hp200310.66849.8822M D L2Taskωκtd20037.697412.4616hp200327.067867.3153PL2FTaskωκtd20037.36388.2178hp200313.347628.3669Table3presents the evaluation results for the proposed models ML2,M D L2,and the weighting model PL2F,as well as their combination with evidence from the URLs of documents(denoted by appending U to the weighting model’s name).When only the documentfields are employed,the multinomial weighting models have similar perfor-mance compared to the weighting model PL2F.The weighting models PL2F and M D L2 outperform ML2for both topic distillation and home pagefinding tasks.For the named pagefinding task,ML2results in higher MRR than M D L2and PL2F.Using the Wilcoxon signed rank test,we tested the significance of the differences in MAP and MRR between the proposed new multinomial models and PL2F.In the case of the topic distillation task td2004,PL2F and M D L2were found to perform statistically significantly better than ML2,with p<0.001in both cases.There was no statistically significant difference between PL2F and M D L2.Regarding the named pagefinding task np2004,there is no statistically significant difference between any of the three proposed models.For the home pagefinding task hp2004,only the difference between ML2and PL2F was found to be statistically significant(p=0.020).Regarding the combination of the weighting models with the evidence from the URLs of Web documents,Table3shows that PL2FU and M D L2U outperform ML2U for td2004.The differences in performance are statistically significant,with p=0.002 and p=0.012,respectively,but there is no significant difference in the retrieval ef-fectiveness between PL2FU and M D L2U.When considering hp2004,we can see that PL2F outperforms the multinomial weighting models.The only statistically significant difference in MRR was found between PL2FU and M D L2FU(p=0.012).Multinomial Randomness Models for Retrieval with Document Fields37 Table3.Evaluation results for the weighting models ML2,M D L2,and PL2F on the TREC 2004Web track topic distillation(td2004),named pagefinding(np2004),and home pagefinding (hp2004)tasks.ML2U,M D L2U,and PL2FU correspond to the combination of each weighting model with evidence from the URL of documents.The table reports mean average precision (MAP)for the topic distillation task,and mean reciprocal rank(MRR)of thefirst correct answer for the named pagefinding and home pagefinding tasks.ML2U,M D L2U and PL2FU are evalu-ated only for td2004and hp2004,where the relevant documents are home pages(see Section4.1).Task ML2M D L2PL2FMAPtd20040.12410.13910.1390MRRnp20040.69860.68560.6878hp20040.60750.62130.6270Task ML2U M D L2U PL2FUMAPtd20040.19160.20120.2045MRRhp20040.63640.62200.6464A comparison of the evaluation results with the best performing runs submitted to the Web track of TREC2004[4]shows that the combination of the proposed mod-els with the evidence from the URLs performs better than the best performing run of the topic distillation task in TREC2004,which achieved MAP0.179.The performance of the proposed models is comparable to that of the most effective method for the named pagefinding task(MRR0.731).Regarding the home pagefinding task,the dif-ference is greater between the performance of the proposed models with evidence from the URLs,and the best performing methods in the same track(MRR0.749).This can be explained in two ways.First,the over-fitting of the parametersωandκon the training task may result in lower performance for the test task.Second,usingfield weights may be more effective for the home pagefinding task,which is a high precision task,where the correct answers to the queries are documents of a very specific type.From the results in Table3,it can be seen that the model M D L2,which employs the information theoretic approximation to the multinomial distribution,significantly outperforms the model ML2,which employs the multinomial distribution,for the topic distillation task.As discussed in Section3.2,this may suggest that approximating the multinomial distribution is more effective than directly computing it,because of the number of computations involved,and the accumulated small approximation errors from the computation of the factorial.The difference in performance may be greater if more documentfields are considered.Overall,the evaluation results show that the proposed multinomial models ML2and M D L2have a very similar performance to that of PL2F for the tested search tasks. None of the models outperforms the others consistently for all three tested tasks,and the weighting models M D L2and PL2F achieve similar levels of retrieval effectiveness. The next section discusses some points related to the new multinomial models.。

这是一个圈套这是一个圈套是网络新兴的吐槽语之一,出自星球大战《绝地归来》的阿克巴上将。

阿克巴上将:采取回避!绿色舰队贴近在MV-7区域!(Take evasive action! Green group, stickclose to holding section MV-7!)战舰操控员:上将!在第47区有敌舰出现!(Admiral! We have enemy ships in sector 47!)阿克巴上将:这是个陷阱!(It's a trap!)— 《星球大战·绝地归来》语义随着《星球大战》的热播,这句话成了很多人把玩梗,向《星球大战》致敬的方式。

随后在4chan上,当时流行贴一些很漂亮的伪娘图片骗撸之后再告诉你这是伪娘的行为。

相应地,就也有人直接在这种图楼里贴上阿克巴的梗图提醒,久而久之这是个陷阱也有指代伪娘的含义。

不过现在的绅士往往会因为伪娘而更加兴♂奋使用方法•当某人发布引战言论,最后却发现其知名度随着战争水涨船高时——致敬&玩梗•在星球大战《汉索罗外传》以及《原力觉醒》中也出现过这句台词。

•许多美国电视节目,例如《每日秀》《科尔伯特报告》《生活大爆炸》《居家男人》也曾玩梗或致敬这个模因。

•在2008年以星球大战为题材的电子游戏《星球大战:原力释放》里;阿克巴是该游戏的隐藏角色,其中要呼叫出阿克巴的秘技便是输入拼起来很像“是陷阱”的字词“ITSATWAP”。

[1]•在《星际争霸2》中,人族的战列巡航舰(俗称大和舰)在向移动指令地点航行的过程中如果受到了哪怕些许的攻击,舰长就会特别激动的喊:“这是个陷阱!”更有甚者会大喊:“弃船”注释。

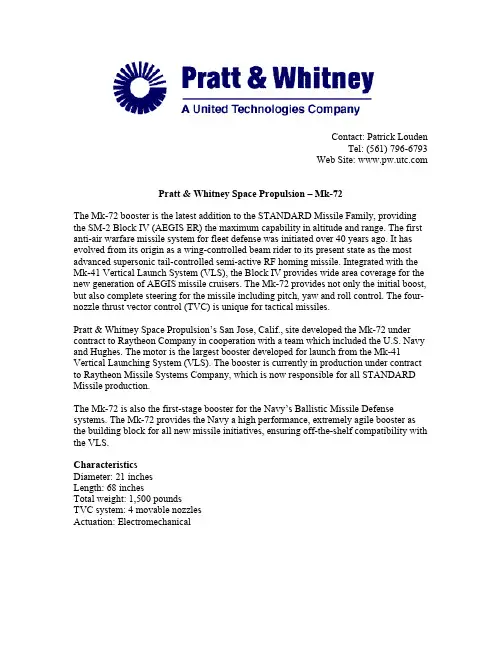

Contact: Patrick LoudenTel: (561) 796-6793Web Site: Pratt & Whitney Space Propulsion – Mk-72The Mk-72 booster is the latest addition to the STANDARD Missile Family, providing the SM-2 Block IV (AEGIS ER) the maximum capability in altitude and range. The first anti-air warfare missile system for fleet defense was initiated over 40 years ago. It has evolved from its origin as a wing-controlled beam rider to its present state as the most advanced supersonic tail-controlled semi-active RF homing missile. Integrated with the Mk-41 Vertical Launch System (VLS), the Block IV provides wide area coverage for the new generation of AEGIS missile cruisers. The Mk-72 provides not only the initial boost, but also complete steering for the missile including pitch, yaw and roll control. The four-nozzle thrust vector control (TVC) is unique for tactical missiles.Pratt & Whitney Space Propulsion’s San Jose, Calif., site developed the Mk-72 under contract to Raytheon Company in cooperation with a team which included the U.S. Navy and Hughes. The motor is the largest booster developed for launch from the Mk-41 Vertical Launching System (VLS). The booster is currently in production under contract to Raytheon Missile Systems Company, which is now responsible for all STANDARD Missile production.The Mk-72 is also the first-stage booster for the Navy’s Ballistic Missile Defense systems. The Mk-72 provides the Navy a high performance, extremely agile booster as the building block for all new missile initiatives, ensuring off-the-shelf compatibility with the VLS.CharacteristicsDiameter: 21 inchesLength: 68 inchesTotal weight: 1,500 poundsTVC system: 4 movable nozzlesActuation: Electromechanical。

・论著・糖皮质激素在重症社区获得性肺炎致急性呼吸窘迫综合征综合救治中的价值探讨宋志芳,郭晓红,王树云,谢 伟,殷 娜,张 悦,单慧敏,李文华(上海第二医科大学附属新华医院内科ICU,上海 200092) 摘要:目的:探讨糖皮质激素(GC)在重症社区获得性肺炎(SCA P)致急性呼吸窘迫综合征(AR DS)综合救治中的价值。

方法:收集2000年5月—2003年2月所有因SCAP致A RD S入住ICU患者的临床资料,分析年龄、性别、急性生理学与慢性健康状况评分Ⅱ(AP A CHEⅡ)、氧合指数(PaO2/F iO2)、肺内分流(Qs/Qt)、肺部感染严重程度、机械通气、呼气末正压(P EEP)水平、ICU停留时间、肺炎吸收指数、氧合改善率、病死率及直接死亡原因等,评价应用GC对缺氧与休克纠正和预后的影响。

结果:24例患者中,未接受G C治疗7例,痊愈5例(71.4%),死亡2例(28.6%),直接死亡原因分别为A RDS(拒绝接受机械通气治疗)和多脏器功能障碍综合征(M OD S);接受G C治疗17例,仅痊愈5例(29.4%),死亡12例(70.6%),主要死亡原因为M OD S(6例,75.0%),少数为A RD S与休克(各1例,12.5%)。

痊愈患者肺部感染严重程度等临床参数与死亡者无显著差异(P>0.05),但治疗后除P aO2/FiO2和Qs/Qt改善、休克纠正明显外,肺部感染有效率高(P<0.001)。

结论:GC能协助机械通气等常规治疗纠正SCA P等肺内性A RDS的顽固性缺氧和休克,为原发病治疗赢得时间。

关键词:激素;重症社区获得性肺炎;急性呼吸窘迫综合征;急性生理学与慢性健康状况评分Ⅱ;机械通气中图分类号:R563.1;R365;R969 文献标识码:A 文章编号:10030603(2003)11066906Evaluation of glucocorticoid in treatment f or patients with acute respiratory distress syndrome as a result ofserious community acquired pneumonia SON G Zhi f ang,GUO X iao hong,W A N G Shu y un,X I EW ei,Y I N N a,ZH A N G Y ue,S H A N H ui min,L I W en hua.M ed ical I ntensiv e Care U nit,X inhuaH osp ital,T he Second M edical University of S hanghai,Shanghai200092,ChinaAbstract:Obj ective:T o evaluate the usag e of g lucoco rtico id(GC)in treat ment f or patient s w it h acute respir ator y distr ess syndro me(A RD S)r esulting fr om ser io us community acquired pneumo nia(SCA P).Methods:T he clinical data fr om all patient s w ith A RD S r esulting fr om SCA P in medical ICU(M ICU)fr omM ay2000to F eb.2003w ere collected.T heir ag e,sex,acute physio lo gy and chr onic health ev aluat ion(A P ACHEⅡ)sco re,P aO2/FiO2and Q s/Q t,the sev erity of SCAP,mechanical ventilation(M V)and the levelof po sitiv e end ex pirat or y pressure(PEEP),time o f st ay in ICU,impr o vement of SCA P and o xy genation,asw ell as mor tality and r easo ns o f death wer e analy zed,respect ively.So w as did t he influence o f adm inistr atio nof GC o n hypox emia,septic sho ck,and their pr og nosis.Results:T here w ere24cases to tally,among them7patients had not taken GC,and5patients w er e cur ed(71.4per cent),and the other2cases died(28.6percent).T heir direct cause of death wer e m ultiple o rg an dysfunction sy ndr ome(M ODS)a nd A RD S,respectiv ely.In17cases GC w as g iv en because hy po xem ia and sept ic shock co uld not be alleviated w ithor dinary ther apy,including M V.A mong them o nly5patients(29.4per cent)w er e cur ed,and all o thers(12cases,70.6percent)died,and the majo r dir ect cause o f deat h w as M O DS(6cases,75.0per cent).A fewof t hem died of A RD S and sept ic sho ck(1case,12.5per cent,r espectiv ely).T he sev erity o f SCA P,as w ell asother clinical data o f t he surv iv or s,sho wed no significant differ ence compar ed w ith the nonsur vivo rs(P>0.05).But ex cept for their Pa O2/FiO2,Q s/Q t and sho ck,their pulmonar y infectio n w as bettercontr olled than deaths(P<0.001).Conclusion:R efracto ry hypo xemia and septic sho ck of pat ients w ithpulmonar y A RD S might be allev iated by GC when they ar e treat ed w ith ro utine methods,including M V,t husit enabled to win the time fo r o ther effective tr eatments.Key words:g lucoco rt icoid;ser ious community acquired pneumonia;acut e r espirat or y distr ess syndr om e;acute phy siolog y a nd chr o nic health eva luatio nⅡsco re;mechanica l v ent ilatio nCLC number:R563.1;R365;R969 Document code:A Article ID:10030603(2003)11066906 基金项目:上海市卫生局科技发展基金项目资助(00409)作者简介:宋志芳(1952),女(汉族),安徽省合肥市人,博士,教授,主任医师,主要研究方向为危重病与急救医学,主编《现代呼吸机治疗机械通气与危重病》专著,发表论文30余篇。

终结者2018英文剧本台词解析.txt52每个人都一条抛物线,天赋决定其开口,而最高点则需后天的努力。

没有秋日落叶的飘零,何来新春绿芽的饿明丽?只有懂得失去,才会重新拥有。

看电影学英语:Terminator Salvation 《终结者2018》[Scene: Longview state correctional facility,2003]朗维尤州立监狱2003年-Dr. Kogan:Marcus ,How are you?Marcus,你怎么样?-Marcus: Ask me in an hour.一小时后再问吧。

-Dr. Kogan: I thought I'd try... one last time.我想...最后再和你谈一次。

-Marcus:You should have stayed in San Francisco, Dr. Kogan .San Francisco: 旧金山 Dr.=Doctor: 博士你该呆在旧金山的,科根博士-Dr. Kogan: By signing this consent form, you'll be donating your body to a noble cause. You'd... have a second chance... through my research to live again. consent: 同意,许可 form:表格 donate: 捐赠 noble:高尚的,崇高的 cause:事业research: 研究签下这份承诺书,你的遗体会捐献给一项崇高的事业。

你可以... 得到救赎的机会。

我的研究可以让你重生。

-Marcus: You know what I did. My brother and two cops are dead because of me. I'm not lookin' cop: 警察 lookin’=looking:寻求你知道我做了些什么。

2003年 Text 1Wild Bill Donovan would have loved the Internet. The American spymaster who built the Office of Strategic Services in the World War II and later laid the roots for the CIA was fascinated with information. Donovan believed in using whatever too ls came to hand in the “great game” of espionage ——spying as a “profession.” These days the Net, which has already re-made such everyday pastimes as buying books and sending mail, is reshaping Donovan’s vocation as well.如果Wild Bill Donovan 当时有互联网的话他肯定会喜欢网络的。

这位美国间谍大王对情报格外着迷,他曾经在第二次世界大战时建立了战略服务办公室,后来又为中央情报局的成立打下了基础。

Donovan 相信,在谍报的“伟大游戏”当中,即间谍这一“职业”当中,可以使用任何可利用的手段。

如今,互联网已经改变了像买书和寄信这样的日常活动,也正在改变Donovan曾经从事的这个职业。

注:其实espionage 和 spying是一个意思,spying是对espionage的解释,espionage主要用于政府军事公司团体,相对正式些,可以翻译成“谍报”;spying是普通用法,主要指公司或个人,所以可以译为“间谍”,“密探”均可。

The latest revolution isn’t simply a matter of gentlemen reading other gentlemen’s e-mail. That kind of electronic spying has been going on for decades. In the past three or four years, the World Wide Web has given birth to a whole industry of point-and-click spying. The spooks call it “open-source intelligence,” and as the Net grows, it is becoming increasingly influential. In 1995 the CIA held a contest to see who could compile the most data about Burundi. The winner, by a large margin, was a tiny Virginia company called Open Source Solutions, whose clear advantage was its mastery of the electronic world.最近的这次革命性的改变不仅仅是一个人偷看他人电子邮件的问题,这样的电子间谍活动已经存在了数十年。

全国2003年4月高等教育自学考试英语阅读(一)试题课程代码:00595全部题目用用英文作答,并将答案写在答题纸相应的位置上,否则不计分。

PART ONEⅠ.TEXT CMOMPREHENSIONThe following comprehension questions are based on the texts you have learned, and each of them is provided with 4 choices marked [A],[B],[C]and[D].Choose the best answer to each question and write it on the ANSWER SHEET.(20 points,1 point each)1.In Gifts of the Magi,both “gift” and “Magus” are in plural, because O. Henry wants to tell the reader that .[A] People are kind to Mr. and Mrs. Young[B] Mr. Young loves Mr. Young[C] Mrs. Young loves Mr. Young[D] Mr. and Mrs. Young love each other2. “I am not sure what I am rebelling against, but I really don‟t see a need for marriage. That isn‟ta statement about my feelings about the relationship, because there is no less strength of commitment.” The underlined clause means .[A] the married couples have more responsibility for each other[B] the cohabiting couples have more responsibility for each other[C] the married couples and the cohabiting ones show no responsibility for each other[D] both the married couples and cohabiting ones should be equally responsible for each other3. “Having come to a very remote and deserted spot, they realized their chance had come: catching Lorenzo off guard, they killed him.” The underlined phrase means .[A] Lorenzo was caught unawares[B] Lorenzo was caught off duty[C] Lorenzo was handed over to them by their guards[D] Lorenzo was caught when his guard was away4.In The Necklace, when Mme. Loise1 took back the necklace, how did Mme. Forrester react?[A] She opened the box and examined the jewel carefully.[B] She said coldly that Mme. Loise1 shouldn‟t have returned it so late.[C] She complained that the necklace had been substituted.[D] She was only too pleased to see her old friend again.5. The Fisherman and His Wife is of .[A] fable [B] myth[C] fairy story [D] fairy-tale-romance6.Mark Twain is NOT the author of .[A] The Adventures of Tom Sawyer[B] The Adventures of Huckleberry Finn[C] The Celebrated Jumping Frog of Calaveras County[D] The Old Man and the Sea7. In his fable about a proud crow and a hungry fox, Aesop intends to tell the reader that .[A] the fox is never trust worthy[B] the fox is always homey-tongued[C] it is harmful to believe big talkers[D] it is harmful to listen to excessive flattery8. According to Bringing up Children, if one stage of child development has been left out, or not sufficiently experienced, .[A] the child may go back and recapture the experience of it[B] the parents may provide the child with the child with the opportunity to play with toys[C] the parents must be consistent in their attitude to their children[D] the child should be sent to a child clinic for a psychological treatment9.The theme of the story A Day‟s Wait is that.[A] misunderstandings can even occur between father and son[B] misunderstandings can sometimes lead to an odd experience[C] to be calm and controlled in the face of death is a mark of courage[D] death is something beyond a child‟s comprehension10. In A Day’s Wait, the hunting scene, at first glance, may seem to have little to do with the plot.However, the author has his own justification for describing it. Which of the following is NOT a reason for such description?[A] It diverts the reader so that the boy‟s real thoughts will be a greater surprise when they arerevealed.[B] It creates a sense of time passing so that we know it is close to evening by the time thefather gets home.[C] It gives the author an opportunity to show that he is able to write very complexsentences though he usually writes very short, simple ones.[D] It brings out a contrast between th e father‟s robust activities outside and the boy‟sterrible tension inside.11. In Art for Heart’s Sake, Dr. Caswell gave Ellsworth a suggestion that be .[A] take more medicine[B] listen to the radio or watch TV[C] take more automobile rides[D] take up art12. In How to live like a Millionaire, the self - made rich develop clear goals for .[A] accumulating income till the age of 50[B] having a dollar figure in mind and working for it[C] leaving an estate to their children[D] retiring early13. The short story as a genre in American literature probably began with Irving‟s The Sketch Book,a collection of essays, sketches and tales, among which the most famous and frequently anthologized are Rip Van Winkle and .[A] The Wild Honeysuckle[B] The Legend of Sleepy Hollow[C] The Scarlet Letter[D] The Pioneers14. “Not even the great Nicholas Veddle himself was safe from the tongue of this daring woman,who blamed himself for much of her husband‟s idleness.” The word tongue in this quotation probably refers to .[A] extremely intelligent and lively words[B] offensive or insulting remarks[C] a movable organ in the mouth[D] the tone or manner of speaking15. According to The Story of the Bible, the Jews were the first among all people to recognize that .[A] different gods made different things in nature[B] one single God created this world[C] one god was devoted to the making of water[D different gods were responsible for the making of the land16. According to Otto Jespersen, the ideal international language was the one that .[A] was the easiest to learn for people all over the world[B] was familiar to scientists all over the world[C] was based on Latin and Greek roots[D] derived the basic structure form non-Indo-European languages17. In Bricks from the Tower of the Babel, the writer provides a detailed explanation for which of the following?[A] The construction of the tower.[B] The structure and sound system of Esperanto.[C] The internationalization of some natural languages.[D] The Indo-European language family.18. In The Girls in Their Summer Dresses, Michael‟s state of mind suggests that .[A] he has adjusted himself to married life[B] he is often absent – minded and confused[C] he starts to resent Frances now[D] he takes for granted what he is doing19.In The Girls in Their Summer Dresses, Frances said, “You‟re going to make a move.” She said so to mean that Michael would .[A] move away to some other location[B] attract and move some girls[C] arouse deep emotions in girls[D] take action and leave her some day20. According to Universities and Polytechnics, Oxford and Cambridge are attractive to both the resident students and visitors for their .[A] advanced academic learning[B] excellent constituent colleges[C] organizational structures[D] buildings of historical significanceⅡ.READING COMPREHENSIONIn this part there are 4 reading passages followed by 20 questions or unfinished statements. For each of them there are 4 choices marked [A], [B],[C] and [D]. You should decide onthe best answer and write it on the ANSWER SHEET. (40 points, 2 points each)Passage 1Failure is probably the most fatiguing experience a person ever has. There is nothing more exhausting than not succeeding—being blocked, not moving ahead. It is an evil circle. Failure breeds fatigue, and fatigue makes it harder to get to work, which adds to the fatigue.We experience this tiredness in two main ways, as start-up fatigue and performance fatigue. In the former case, we keep putting off a task that we are forced to take up. Either because it is too tedious or because it is too difficult, we avoid it. And the longer we postpone it, the more tired we feel.Such start-up fatigue is very real, even not actually physical, not something in our muscles and bones. The remedy is obvious, though perhaps not easy to apply: willpower exercise. The moment I find myself turning away from a job, or putting it under a pile of other things I have to do, I clear my desk of everything else and attack the objectionable item first. To prevent start-up fatigue, always treat the most difficult job first.Performance fatigue is more difficult to handle. Here we are willing to get started, but we cannot seem to do the job right. Its difficulties appear to be insurmountable and however hard we work, we fail again and again. The mounting experience of failure carries with it an ever-increasing burden of mental fatigue. In such a situation, I work as hard as I can-then let the unconscious take over.21.Which of the following can be called an evil circle?[A] Success – zeal – success – zeal.[B] Failure – tiredness – failure – tiredness.[C] Failure – zeal – failure – tiredness.[D] Success – exhaustion – success – exhaustion.22. According to the passage, when keeping putting off a task, we can experience .[A] tiredness[B] performance fatigue[C] start-up fatigue[D] unconsciousness23. To overcome start-up fatigue, we need .[A] toughness[B] prevention[C] muscles[D] strong willpower24.The word insurmountable in the last paragraph probably means .[A]unable to be solved [B] unlikely to be understood[C] unable to be imagined [D] unlikely to be rejected25. According to the passage, which of the following statements is NOT true?[A] It is easier to overcome start-up fatigue.[B] Performance fatigue occurs when the job we are willing to take gets blocked.[C] One will finally succeed after experiencing the evil circle.[D] Fatigue often accompanies failure.Passage 2On days when there is work , I talk to the other guys. Some of them tell me that the harvest season is coming in northern California, and they say that one can earn good money there. Things haven‟t gone so badly in the car wash, but one afternoon I give the manager my thanks for having hired and promoted me, and with a little suitcase that night I board a Greyhound headed north. My ticket is made out for San Francisco, but I don‟t plan to go that far. I pla n to ride until I find a place where people are harvesting, and to get off the bus there.I sleep on the bus for a few hours that night, and in the morning, when I awake, I don‟t know where we are. I get up from my seat and walk down the bus aisle, looking for a Mexican or Chicano to tell me our location, but oddly enough, I don‟t see any among the passengers, who are all white-skinned. I pay attention to the road signs we pass, but they are not of much help. I can read the town names, but I don‟t know whe re the towns lie. A map would help me, and I decide to buy one at our next stop. Lots of things are for sale at the bus stop‟s gift shop, but there are no maps. I direct myself to wards the shop‟s operator, but I run into the language barrier. The operator is an Anglo, and when I speak to him in Spanish, he says that he doesn‟t understand. I try to practice my very precarious (不可靠的)English with him, but it‟s of no use. I have a rough idea of the sound of the words that I want to say, but I can‟t pronounce t hem right. I make signs, signaling a big piece of paper and say “form California,” but he turns into a question mark, with eyes wide open, arms raised and hands extended, “Map,” I say, but I don‟t pronounce the word very well. “Freeways, streets,” I add, but he still doesn‟t understand. He points out chewing gum, candies, pieces of cake, sandwiches, soft drinks, and cigarettes, trying to guess what I‟m asking for. But he doesn‟t show me any maps. Finally, I back out of the store, and as I leave I hear him say, “I‟m sorry.”A little before the bus leaves, I run into a Mexican-American in a hallway and I immediately ask him to help me find a map off California. We go back to the store. The Chicano asks for a map .“Ahh !Ahaaa!” the operator exclaims. Then he go es to a corner of his shelves and takes out what I‟ve been asking for. While I am paying him, he talks to the Chicano in a joyful tone. With the map in my hands, I give the Chicano my thanks, and he explains that the store-keeper thinks that I am asking if he needs anybody to clean the floor or “mop.”26. The writer decided to leave his job and go to northern California because .[A] his boss didn‟t like him[B] things were going badly in the car wash[C] he thought he could earn more money[D] th ere wasn‟t always work27. The writer wanted a map in order to .[A] find the way to San Francisco[B] help him with the road signs[C] know where he was in relation to the entire trip[D] find his way back to his workplace28. Form the passage, we can infer that .[A] the owner of the shop did not want to sell the writer a map[B] the writer was fired from the car wash[C] the writer was a migrant farm worker[D] the writer was traveling with a friend who could speak English29. The writer tries to make himself understood by all the following EXCEPT.[A]gestures[B] words or phrases[C] pronunciations[D] spelling the word30. We can learn from the story that .[A] incorrect pronunciations may result in misunderstanding[B] immigrants usually have a hard time in the foreign countries[C] a foreign language can be learned through conversations[D] traveling alone brings unexpected troubles and problemsPassage 3Exceptional children are different in some significant ways from others of the same age. For these children to develop to their full adult potential, their education must be adapted to those differences.Although we focus on the needs of exceptional children, we find ourselves describing their environment as well. While the leading actor on the stage captures our attention, we are aware of the importance to the supporting players and the scenery of the play itself. Both the family and the society in which exceptional children live are often the key to their growth and development. And it is in the public schools that we find the full expression of society‟s understanding-the knowledge, hopes, and fears that are passed on to the next generation.Education in any society is a mirror of that society. In that mirror we can see the strengths, the weaknesses, the hopes, the prejudices, and the central values of the culture itself. The great interest in exceptional children shown in public education over the past three decades indicates the strong feeling in our society that all citizens, whatever their special conditions, deserve the opportunity to fully develop their capabilities.“All men are created equal.” We‟ve heard it many times, but it still has important meaning for education in America. Although the phrase was used by this country‟s founders to denote equality before the law, it has also been interpreted to mean equality of opportunity. That concept implies educational opportunity for all children-the right of each child to receive help in learning to the limits of his or her capacity, whether that capacity be small or great. Recent court decisions have confirmed the right of all children-disabled or not-to an appropriate education, and have ordered that public schools take the necessary steps to provide that education. In response, schools are modifying their programs, adapting instruction to children who are exceptional, to those who can not profit substantially from regular programs.31.In Paragraph 2, the author cites the example of the leading actor on the stage to show that .[A] the growth of exceptional children has much to do with their families and the society[B] exceptional children are more influenced by their families than normal children are[C] exceptional children are the key interest of the family and society[D] the needs of the society weigh much heavier than the needs of the exceptional children32.The reason why exceptional children receive so much concern in education is that .[A] they are expected to be leaders of the society[B] they might become a burden of the society[C] they should fully develop their potentials[D] disabled children deserve special consideration33. This passage mainly deals with .[A] the differences of children in their learning capabilities[B] the definition of exceptional children in modern society[C] special educational programs for exceptional children[D] the necessity of adapting education to exceptional children34.Form this passage we learn that the educational concern for exceptional children .[A] is now enjoying legal support[B] disagrees with the tradition of the country[C] was cl early stated by the country‟s founders[D] will exert great influence over court decisions35 .Which of the following is TRUE according to the passage?[A] Exceptional children refer to those with mental or physical problems.[B] The author uses “All men are created equal” to counter the school program for exceptionalchildren.[C] Recent court decisions confirm the rights of exceptional children to learn with regularchildren.[D] Regular school programs fail to meet the requirements to develop the potential ofexceptional children.Passage 4Life is a series of problems. Do we want to moan about them or solve them? Do we want to teach our children to solve them?Discipline is the basic set of tools we require to solve life‟s problems. Without discipline w e can solve nothing. With only some discipline we can solve only some problems. With total discipline we can solve all problems.What makes life difficult is that the process of confronting and solving problems is a painful one. Problems, depending upon their nature, evoke in us frustration or grief or sadness or loneliness or guilt or regret or anger or fear or anxiety or anguish or despair. These are uncomfortable feelings, often very uncomfortable, often as painful as any kind of physical pain, sometimes equaling the very worst kind of physical pain. Indeed, it is because of the pain that events or conflicts engender in us all that we call them problems. And since life poses an endless series of problems, life is always difficult and is full of pain as well as joy.Yet it is this whole process of meeting and solving problems that life has its meaning. Problems are the cutting edge that distinguishes between success and failure. Problems call forth ourcourage and our wisdom; indeed, they create our courage and our wisdom. It is only because of problems that we grow mentally and spiritually. When we desire to encourage the growth of the human spirit, we challenge and encourage the human capacity to solve problems, just as in school we deliberately set problems for our children to solve. It is through the pain of confronting and resolving problems that we learn. As Benjamin Franklin said, “Those things that hurt, instruct.” It is for this reason that wise people learn not to dread but actually to welcome problems and actually to welcome the pain of problems.I have stated that discipline is the basic set of tools we require to solve life‟s problems. It will become clear that these tools are techniques of suffering, means by which we experience the pain of problems in such a way as to work them through and solve them successfully, learning and growing in the process. When we teach ourselves and our children discipline, we are teaching them and ourselves how to suffer and also how to grow.What are these tools, these techniques of suffering, these means of experiencing the pain of problems constructively that I call discipline? These are four: delaying of gratification (满足),acceptance of responsibility, dedication to truth, and balancing. As will be evident, these are not complex tools whose application demands extensive training. To the contrary, they are simple tools, and almost all children are adept in their use by the age of ten. Yet presidents and kings will often forget to use them, to their own downfall. The problem lies not in the complexity of these tools but in the will to use them. For they are tools with which pain is confronted rather than avoided, and if one seeks to avoid legitimate suffering, then one will avoid the use of these tools.36.The main point of this passage is that .[A] without discipline we can solve nothing[B] problems evoke in us frustration or grief[C] dealing with one‟s problems gives life meaning[D] the tendency to avoid problems results in mental illness37. People who use a little discipline .[A] can solve all of their problems[B] can solve some of their problems[C] can solve nothing[D] have total discipline38. According to the author, which of the following makes life difficult?[A] Physical pain.[B] Frustration and guilt.[C] Solving problems.[D] Conflicts.39.Problems give our life meaning by all of the following means EXCEPT.[A] showing us the difference between success and failure[B] giving us courage[C] challenging us to grow[D] teaching us to avoid problems40.According to the author, which of the following is TRUE?[A] Successful leaders avoid their problems.[B] The tools for solving problems are hard to learn.[C] We need to confront emotional pain.[D] The tools of discipline are complicated.Ⅲ.SKIMMING AND SCANNINGIn this part there are 3 reading passages followed by 10 questions or unfinished statements. For each of them there are 4 answers marked[A],[B],[C]and [D].Skim or scan the passages, then decide on the best answer and write it on the ANSWER SHEET.(10 points,1 point each)Passage 1Dear Sires: Oct.30,1996 We are pleased to make you an offer regarding our …Swinger‟ dresses and trouser suits in the sizes you require. All the models can be supplied by the middle of December 1996, subject to our receiving your firm order by 15th November. Our C.I.F. prices are understood to be for sea/land transport to Chicago. If you would prefer the goods to be sent by air freight, this will be charged extra cost.Trouser Suits: sizes 8 – 16 in white, yellow, red, turquoise, black, pink per 100$2650.00Swinger Dresses: sizes 8 – 16 in white, yellow, red, turquoise, black per 100$1845.00Prices: valid until 31 st December, 1996Delivery: C. I. F. ChicagoTransport: sea/land freightPayment: by irrevocable letter of credit, or cheque with orderYou will be receiving cuttings of our materials and a colour chart. These were airmailed to you this morning. We hope you agree that our prices are very competitive for these good quality clothes, and look forward to receiving your initial order.Yours FaithfullyRobert Morgan41.Judging from the message given in the letter, the writer is a .[A] seller[B] buyer[C] government official[D] lawyer42. The price quoted for each Swinger Dress is .[A] $2650[B] $1845[C] $26.5[D] $18.4543.The goods under discussion can be delivered by .[A] Oct. 30, 1996[B] the middle of Dec.1996[C] Nov. 15, 1996[D] Dec. 31, 1996Passage 2When the CEO of lotus, manufacturer of computer software, interviews job candidates, he looks for people who can laugh out loud. At the headquarters of ice –cream maker Ben & Jerry‟s, the “Minister of Joy” supervises the “Joy Gang”, which has the job of spending $100,100 a year planning and implementing workplace fun. Odetics, maker of video security systems and other recording equipment, considered it an honor when Industry Week called it “the funniest place to work in the U.S.”In corporate America today, humor is a serious business. Workers have been downsized, re-engineered, restructured, and overworked for so long they have forgotten how to smile and laugh. To remind them, companies are posting amusing notes and cartoons on bulletin boards, building libraries of humorous books for workers to read, sp onsoring “fun at work” days, “laughter” committees, and even hiring specialists.As a result, the corporate humor business has taken off. A “humor services” group, called Humor Project, reports that it receives about twenty requests each day from companies looking for humor consultants. The Laughter Remedy, an organization that teaches the benefits of humor, helps employees build “humor skills” through a program that includes such steps as “developing the ability to play program that includes such steps as “developing the ability to play with language” and “finding humor in everyday life.” Humor consultant Paul McGhee gives audiences “remedial belly laughing” lessons. He tells them to smile, raise their eyebrows, lower their jaws, tighten their stomach muscles, and laugh. Speakers from Lighten Up Limited, a humor consulting firm, urge workers to tell jokes and take humor breaks. In their search for comic relief, organizations are spending thousands of dollars. Humor consultant Matt Weinstein, for example, receives $7500 for a ninety – minute talk.Why all the fuss and expense over an activity that seems contrary to the work ethic? One recent study reports that the most productive workplaces have at least the minutes of laughter every hour. And corporations that have added humor to workplace report an increase not only in productivity but also in employee loyalty , creativity, and morale, as well as improved teamwork and employee health.44.The corporate laughter business is booming because .[A] such an activity seems contrary to the work ethic[B] the humor business has proved profitable[C] the workers overwork, so much so that they intend to get their work re-engineered andrestructured[D] few corporations consider humor a serious business and an incentive to productivity45.According to the passage, the Laughter Remedy helps employees .[A] take humor breaks and relax themselves[B] develop their abilities to use language[C] build “humor skills” through a designed program[D] free themselves from the overwork46. It may be inferred from the passage that .[A] the character of Americans seems to require that they should be humorous[B] wherever there is demand, a market will be created[C] humor is the most popular leisure pursuit in the western world[D] humor is the only source of revenue for the “laughter” specialistsPassage 3This Valentine‟s Day, 35-year-old Peter Henig had no trouble finding a date.He had been elected one of the 10 most wanted bachelors of the Internet by Women. com. Since then, Henig gets some 100 emails a day from women all over the word asking him for a date.Henig is good-looking enough to be considered one of the most suitable bachelors in cyberspace. As a senior editor at Red Herring, the bim onthly magazine of the tech word, he‟s certainly smart and successful.Forget the yuppies of the 1980s, the hottest bachelors these days-dot-com crisis or not-are the Silicon boys.“I didn‟t need a date the badly,” said Henig. But when he was contacted b y Women. com to be included in their “Top 10 Men of the Internet” contest, he eagerly accepted.“I don‟t look at it as a dating machine. I just thought it could be fun,” he said.In Silicon Valley, often dubbed(称之为)as “valley of guys” for its high percen tage of unmarried men, the venture capital gold rush may be over, but the dating industry is booming.According to a recent report, Silicon Valley should be the place for single women looking for love. For every 318 single men in the city of San Jose, the heart of Silicon Valley, there are 288 single women.Known for their lack of social skills, computer geeks are showing that they too can have a life. This is especially true during the economic downturn for tech industries, when there‟s no real need to spend all that time in front of their computers.According to Katherine Winter, who met her husband on Match. Com, an online dating service, the end of gold rush may not be bad news for the Silicon boys. She said, “Silicon Valley is definitely the place to be for single women, because of the quality and the number of men.”47. According to the passage, Henig has been elected as one of the most wanted single men because he is .[A] a handsome young man[B] a computer expert[C] one of the hottest bachelors[D] good-looking, smart and successful48. According to Katherine Winter, Silicon Valley is the ideal place for single women to find。