基于本体的语义标注工具比较与分析

- 格式:pdf

- 大小:228.20 KB

- 文档页数:5

文本标注总结1. 简介文本标注是一种将自然语言文本进行结构化处理的技术。

通过文本标注,可以将文本中的实体、关系、情感等信息标注出来,便于后续的语义分析、信息提取和机器学习等任务的处理。

本文将总结一些常见的文本标注方式和工具,并介绍它们的优缺点以及应用场景。

2. 常见的文本标注方式2.1. 命名实体识别 (Named Entity Recognition, NER)命名实体识别是一种将文本中的具体实体标注出来的任务。

常见的实体包括人名、地名、组织机构名、时间、日期等。

NER常用于信息抽取、问答系统和实体关系图谱构建等任务中。

2.2. 关系提取 (Relation Extraction)关系提取是指从文本中抽取实体之间的关系,例如人物之间的夫妻关系、产品与公司之间的关联等。

关系提取通常需要先进行实体识别,再根据实体之间的上下文进行关系推断。

2.3. 情感分析 (Sentiment Analysis)情感分析是指判断文本中所表达的情感倾向,例如正面、负面、中性等。

常用的方法包括基于规则的情感分析和基于机器学习的情感分类。

情感分析在舆情分析、产品评价等领域具有广泛的应用。

3. 常见的文本标注工具3.1. spaCyspaCy是一个流行的自然语言处理工具,提供了丰富的功能,包括分词、词性标注、命名实体识别等。

spaCy使用起来简单方便,而且速度较快,适合处理大规模的文本数据。

3.2. NLTKNLTK(Natural Language Toolkit)是一个Python库,提供了大量的自然语言处理功能。

NLTK具有丰富的文本标注功能,包括词性标注、句法分析、命名实体识别等。

与spaCy相比,NLTK更适合教学和研究领域。

3.3. Standford NERStandford NER是一种基于统计模型的命名实体识别工具。

它的模型基于条件随机场(Conditional Random Fields),在英文命名实体识别任务中表现较好。

用语义特征分析法对比下面各对词的异同教授,professor 我们都知道学过的词组,可以分为主语、宾语以及状语。

今天我想和大家分享一下我们的测试方法——语义特征分析法(又称 scratch professor)。

语义特征指的是词汇的内部结构,是词义的“关键”点,由它们之间或两者之间的相互作用决定。

它主要通过测量某个词中一些特定性质,来确定它们之间存在什么相似性。

在这种方法中,常用的有基于概率统计原理的词序检测法和基于语义分类算法系统分析法。

首先,用 scratch检验出哪些词属于“关键”点;然后,根据 scratch结果来判断哪些词可以归为“状语”或“主语”。

一、采用概率统计原理的词序检测法词序检测法是以概率统计原理为基础,借助软件统计程序、特征值等变量的值(如正负号),来识别词序差异情况的方法。

这是一种使用多个小变量(如1、3、5、7、10等)为输入变量来识别词序差异的方法。

它分为以下三种类型:0-1:无词序差异,即最多只有1个词序差异;1-2:有词序差异的,即有2个语序差异和3个以上词序差异;3-3:无词序差异和2个以上词序差异的,这就是最多只有2个(不含1个)词序差异;最后3-5:无词序差异和3-5之间差别较为显著和连续时(包括不连续时)出现频率最高的一个词序差异(无词序差异)。

它利用概率统计原理以少量样本多对数计算出具有不同特征值(如1、3、5)的词的词序差异,即在一定概率下不存在1和2之间和5之间具有相对显著且连续的词序差异。

二、基于语义分类算法系统分析法系统分析法利用机器学习的相关算法,对网络上的每个输入数据(如文本)进行分析,最终得到输出数据(如词语、句子)。

根据该方法计算出相关数据作为输入(scratch),进行处理的方法就是基于语义分类算法系统分析法。

这一方法在英语中较为常见。

主要通过搜索不同语言文字、词语搭配或句型组合所出现的词、句进行分析。

它包括基于词序检测法、基于语义分类算法系统分析法、非结构化数据、关联词检索或排序等。

语义角色标注与语义关系分析语义角色标注(Semantic Role Labeling,SRL)和语义关系分析(Semantic Relationship Analysis)是自然语言处理领域中的两个重要任务,旨在对句子中的词汇进行深入的语义分析和理解。

本文将介绍这两个任务的背景、方法和应用,并探讨它们在自然语言处理领域中的重要性和挑战。

一、背景在自然语言处理领域中,理解句子的深层次语义是一项重要而困难的任务。

传统的浅层次句法分析方法(如词性标注、句法分析)无法准确捕捉到词汇之间复杂而细致的关系。

因此,研究者们开始探索如何对句子进行更深入、更准确地理解。

二、方法1. 语义角色标注SRL旨在对句子中每个动词及其相关论元进行标注,以揭示动词与论元之间复杂而细致的关系。

传统方法主要基于基于规则或者基于统计机器学习模型,这些模型使用手工设计特征来捕捉动词与论元之间的依存关系。

近年来,随着深度学习的兴起,基于神经网络的方法也逐渐应用于SRL任务。

这些方法通过学习句子中词汇的分布式表示来捕捉词汇之间的语义关系。

2. 语义关系分析语义关系分析旨在识别句子中不同词汇之间的语义关系,如上位与下位、同义与反义、因果与条件等。

传统方法主要基于基于规则或者基于统计机器学习模型,这些模型使用手工设计特征来捕捉不同词汇之间的关系。

近年来,随着深度学习的兴起,基于神经网络的方法也逐渐应用于语义关系分析任务。

这些方法通过学习句子中不同词汇之间的分布式表示来捕捉不同关系。

三、应用1. 机器翻译SRL和语义关系分析在机器翻译任务中起着重要作用。

通过对源语言句子进行深层次语义分析和理解,可以更准确地理解源语言句子,并生成更准确、更自然流畅的目标语言翻译。

2. 信息抽取SRL和语义关系分析在信息抽取任务中也发挥着重要作用。

通过对句子中的词汇进行深层次语义分析和理解,可以更准确地识别出句子中的实体、关系和事件等重要信息,从而更准确地抽取出有用的信息。

基于本体的甲骨卜辞语义标注研究作者:高峰李东琦谭红超来源:《科技创新导报》2011年第02期摘要:以甲骨卜辞语料为基础,把本体作为知识表达和共享的载体,对甲骨卜辞语料进行标注,特别实现了基于本体的语义标注,试图构建语义标注的甲骨卜辞语料库,以便实现甲骨文辅助考释和知识共享。

关键词:甲骨卜辞本体语义标注中图分类号:TP391 文献标识码:A 文章编号:1674-098X(2011)01(b)-0231-01甲骨卜辞是研究甲骨文的基础,经过甲骨学者近百年的不懈努力,至今可以说已经具备了较为完备的知识体系。

但随着信息化的深入和知识发现等概念的提出,传统的研究缺乏规范的弊端也逐渐突显出来,甲骨文数字资源缺乏知识层次的统一描述,给甲骨文信息利用和共享造成了困难。

本文考虑在已建立甲骨文语料库的基础上,用本体技术进行甲骨卜辞的研究和分析,通过对甲骨卜辞的语料标注,主要是进行语义标注,试图构建甲骨卜辞的知识库,在语料知识库上构建推理程序,完成未识甲骨文字的相关知识发现。

1 甲骨卜辞本体因为本体所对应的应用领域不同,本体所需要表达的领域范围也不同,从而本体中包含的概念和术语也不同。

构建甲骨文卜辞本体的目的是为了达到能够根据甲骨文字释义的现有了解,对甲骨卜辞做出推导提示,对甲骨卜辞进行精细加工。

所以本文的领域本体建模的范围就是严格按照Gruber本体约定最小(Minimal Oniological Commitment)原则将甲骨卜辞细化、完善。

本文采用OWL语言作为本体的描述性语言,其中甲骨卜辞本体存储甲骨字语义概念信息,包括人、事、物、时、地、其他等类以及它们的属性及其之间的关系。

例如,对甲骨文“时间类”的描述如下:xmlns:rdf=”/2009/02/01-rdf-syntax- ns#”xmlns:owl=”/2010/02/owl#”xmlns=”/ontology#”xmlns:xsd=”/2009/XMLSchema#”xmins:rdfs=” /2010/01/rdf-schema#”xml:base=”/ontology#”>2 甲骨卜辞语料的语义标注2.1 语义标注和数据库类比,语义标注就如同为建立好的数据库表添加具体的纪录。

自然语言处理(Natural Language Processing,NLP)是一门涉及计算机和人类语言之间交互的领域,其主要目的是使计算机能够理解、解释和生成人类语言。

在NLP的诸多任务中,词性标注(Part-of-Speech Tagging)是其中一个重要的任务,它涉及对句子中每个单词进行词性标注,即确定该单词在句子中所扮演的角色,如名词、动词、形容词等。

在本文中,将介绍几种常见的词性标注模型,并对它们进行简要的分析和比较。

隐马尔可夫模型(Hidden Markov Model,HMM)是一种常见的词性标注模型。

在HMM中,将词性序列视为一个隐含的马尔可夫链,而单词序列则视为由隐含的马尔可夫链生成的观测序列。

HMM模型假设每个单词的词性只依赖于该单词本身以及其前一个单词的词性,而与整个句子的上下文无关。

虽然HMM模型的简单性使其易于实现和训练,但它忽略了上下文的信息,因此在处理歧义和多义问题时表现不佳。

另一种常见的词性标注模型是条件随机场(Conditional Random Field,CRF)。

与HMM不同,CRF考虑了整个句子的上下文信息,即在进行词性标注时,同时考虑了句子中所有单词的词性标注结果。

通过考虑全局上下文信息,CRF模型能够更好地解决歧义和多义问题,因此在词性标注任务中表现较好。

然而,CRF模型的复杂性导致了较高的计算开销和较长的训练时间,使其在大规模语料上的应用受到一定的限制。

除了HMM和CRF之外,神经网络模型在近年来也被广泛应用于词性标注任务。

基于神经网络的词性标注模型通常包括一个嵌入层(Embedding Layer)、多个隐藏层(Hidden Layers)和一个输出层(Output Layer)。

其中,嵌入层用于将单词映射到连续的低维空间,隐藏层用于提取句子中的特征表示,而输出层则用于预测每个单词的词性标注结果。

相比于传统的统计模型,基于神经网络的词性标注模型能够利用大规模语料中的丰富信息,从而取得更好的性能。

自然语言处理中的词性标注工具比较自然语言处理(Natural Language Processing,NLP)是一门研究计算机与人类自然语言之间交互的学科。

在NLP中,词性标注(Part-of-Speech Tagging,POS Tagging)是一个重要的任务,它的目标是为文本中的每个词汇赋予相应的词性标签,如名词、动词、形容词等,以便进一步的语义分析和信息提取。

在实际应用中,有许多词性标注工具可供选择,如Stanford POS Tagger、NLTK POS Tagger、SpaCy等。

这些工具在词性标注的准确性、处理速度、易用性等方面存在一定的差异。

首先,准确性是衡量词性标注工具优劣的重要指标之一。

Stanford POS Tagger是一种经典的词性标注工具,采用了条件随机场(Conditional Random Fields,CRF)模型,具有较高的准确性。

它能够根据上下文信息对词性进行较为准确的判断,但在处理歧义和未登录词方面可能存在一定的困难。

相比之下,NLTK POS Tagger使用了隐马尔可夫模型(Hidden Markov Model,HMM),准确性略低于Stanford POS Tagger,但在处理未登录词方面表现较好。

而SpaCy则采用了卷积神经网络(Convolutional Neural Networks,CNN)模型,准确性与前两者相当,但在处理速度上更具优势。

其次,处理速度也是选择词性标注工具时需要考虑的因素之一。

Stanford POS Tagger由于采用了复杂的CRF模型,处理速度较慢,对大规模文本的处理效率较低。

相比之下,NLTK POS Tagger和SpaCy采用了较为轻量级的模型,处理速度更快,尤其是SpaCy在处理大规模文本时表现出色。

此外,易用性也是选择词性标注工具时需要考虑的因素之一。

Stanford POS Tagger和NLTK POS Tagger都提供了Python接口,使用方便,可以方便地集成到自己的NLP项目中。

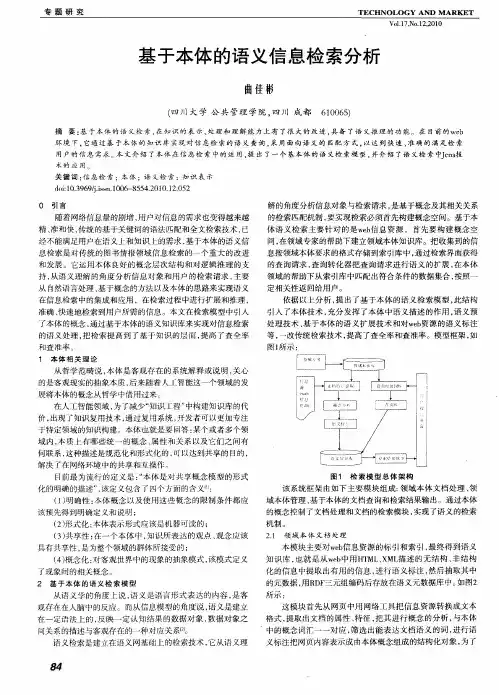

浅谈基于本体的语义信息检索及其在过程教学管理系统中的应用摘要:本文主要在对语义网和本体技术进行了解的基础上,构建了基于本体的语言信息检索框架:主要包括问题构建模块、文档处理模块、用户查询模块以及信息检索模块。

尝试应用在在基于数据挖掘的过程教学管理系统中。

关键词:语义;本体;信息检索;过程教学管理中图分类号:tp311伴随着计算机的不断发展和技术领域深入的研究,发现利用语义检索可以加快访问速度和准确性,因此基于本体的语义信息检索技术得到了不断地发展。

通过对国内外的检索技术的了解,其主要包括全文检索、数据检索、ontology检索等多种检索方式。

而现在重点研究的技术是ontology检索技术,它是在语义上的一种模型技术。

研究过程中发现本体本身具有非常好的概念层次,乃至在概念之间建立起来的非常丰富复杂语义联系的能力。

理解本体的含义在语义检索中也是非常重要的。

在一定的领域里,本体可以形成相应的知识体系。

1 语义网和本体技术1.1 语义网及其体系结构语义网的基础是人工智能技术与xml技术紧密的结合,它的运作步骤是将传统的信息数据加以处理,并且将其添加各类辅助的标签、备注和一部分数据的关联信息等,其中涉及了xml语言的语义标注技术及标签类别定义[1]。

1.2 本体描述语言及编辑工具2 解析信息检索框架(1)第一模块:构建模块。

本体构建部分是语义检索的基础,是框架中的资源存储核心。

模块的功能就是确保资源的一致性和完好性,随着领域知识的不断变化和发展,将领域本体库进行不断的更新和补充,来保证领域本体库中资源相关概念的新鲜度。

(2)第二模块:文档处理模块。

文档处理模块其主要功能为语义标注和构建索引。

工作流程是将领域资源文档中的相应的概念和实体与领域本体进行匹配,并且进行语义的标注。

将标注后的领域本体采用高速算法进行排序。

并建立索引库。

(3)第三模块:用户查询模块。

用户查询模块的主要功能是将用户的查询信息进行查理,根据不同用户的要求将查询信息进行相应的扩展。

《基于本体的教育资源异构数据集成的研究》篇一一、引言随着信息技术和数字化进程的推进,教育资源数字化与信息共享成为教育发展的重要方向。

然而,在现有教育资源的信息化管理中,不同来源的异构数据整合和利用一直是一个重要难题。

本研究基于本体理论,探讨教育资源异构数据集成的有效方法,为教育资源的整合和共享提供技术支持。

二、教育资源异构数据的特点与挑战教育资源异构数据主要指来自不同教育机构、不同系统平台以及不同格式的数据资源。

这些数据具有以下特点:数据结构多样、语义差异大、格式不统一等。

在整合这些异构数据时,面临的主要挑战包括:数据的一致性、准确性、语义互操作性和系统可扩展性等。

三、本体理论在教育资源异构数据集成中的应用本体是一种概念化的工具,用于描述领域知识及其相互关系。

在教育资源异构数据集成中,本体理论的应用主要体现在以下几个方面:1. 定义领域知识:通过构建领域本体,明确教育资源的概念、属性和关系,为数据整合提供统一的知识表示框架。

2. 数据映射与转换:利用本体对教育资源进行语义标注和映射,实现不同数据源之间的语义互操作性,从而完成数据的转换和整合。

3. 数据质量控制:通过本体对数据进行约束和验证,确保数据的准确性和一致性,提高数据质量。

四、教育资源异构数据集成的实现方法基于本体理论,本研究提出以下教育资源异构数据集成的实现方法:1. 数据预处理:对原始数据进行清洗、转换和标准化处理,为后续的数据集成奠定基础。

2. 本体构建:根据教育领域的实际情况,构建适合的领域本体,明确概念、属性和关系。

3. 数据映射与转换:利用本体对数据进行语义标注和映射,实现不同数据源之间的转换和整合。

4. 数据存储与查询:将整合后的数据存储到统一的数据仓库中,并提供灵活的查询方式,满足用户的不同需求。

五、实验与分析本研究通过实际案例进行实验验证,对基于本体的教育资源异构数据集成方法进行评估。

实验结果表明,该方法在数据一致性、准确性、语义互操作性和系统可扩展性等方面具有显著优势。

基于本体的语义信息检索系统模型研究【摘要】传统的信息检索无法实现信息对语义层面的查询,在信息膨胀的今天,越来越难以满足人么对查询效率的要求。

本文通过设计一个基于本体的语义检索系统模型,通过语义标签对非结构化数据进行标注,建立统一的元数据库,并且建立相应的领域本体,利用本体的语义推理功能,从而实现了对信息资源的语义检索。

【关键词】本体;语义检索;元数据1.引言随着互联网与信息技术的发展,信息化的越来越深入到工作与生活的各个层面,随之而来的是信息量的急剧膨胀。

由于信息处理技术的发展,如何从海量的信息中高效快速、准确地检索到所需信息已经成为计算机领域研究的一个热点问题。

信息检索就是从信息集合中找到用户所需信息的过程。

在实践中,传统的基于关键词的检索方法主要通过把表征用户查询请求的关键词与表征信息内容的索引词进行严格机械匹配进行的。

由于一义多词和一词多义现象的存在,缺乏语义理解能力,致使表示查询请求的关键词和用户的真实需求之间,关键词和索引词之间会存在多重表达差异,从而导致查询结果检准率低、误检率高。

为此,本文将研究研究面向本体的智能信息检索技术,并以此为基础构建一个系统模型,通过建立本体库与元数据库来准确映射信息资源,实现了对查询条件进行了语义层面的处理,从而提高检索效率。

2.信息检索与本体2.1 信息检索信息检索information retrieval)这个术语产生于calvin mooers1948年在mit的硕士论文。

信息检索是指将信息按照一定的方式组织和存储起来,并针对用户的需求找出所需信息的过程,又称为“信息存储与检索”[1]。

从广义上讲,信息检索包括存储过程和检索过程,对用户来说,往往仅指查找所需信息的检索过程。

信息的存储主要为对一定专业范围内的信息进行选择,并在此基础上进行信息特征描述、加工并使其有序化,即建立数据库。

检索是借助一定的设备与工具,采用—系列方法与策略从数据库中查找出所需信息。

自然语言处理中的词性标注工具推荐自然语言处理(Natural Language Processing,简称NLP)是人工智能领域中的一个重要分支,旨在使计算机能够理解和处理人类语言。

在NLP中,词性标注(Part-of-Speech Tagging)是一项基础任务,它的目标是为文本中的每个词汇赋予其对应的词性标签,如名词、动词、形容词等。

在本文中,我将向大家推荐几个在词性标注方面表现出色的工具。

1. NLTK(Natural Language Toolkit)NLTK是一个广受欢迎的Python库,提供了丰富的自然语言处理工具和数据集。

它包含了多个词性标注器,如基于规则的标注器、基于统计的标注器以及基于机器学习的标注器。

其中,最常用的是NLTK自带的最大熵标注器(MaxentTagger),它基于最大熵模型进行训练,具有较高的准确性和鲁棒性。

2. Stanford CoreNLPStanford CoreNLP是斯坦福大学开发的一个强大的自然语言处理工具包。

它提供了丰富的NLP功能,包括词性标注。

Stanford CoreNLP的词性标注器基于条件随机场(Conditional Random Fields,简称CRF)模型,具有较高的准确性和性能。

此外,Stanford CoreNLP还提供了多语言支持,适用于处理不同语种的文本数据。

3. SpaCySpaCy是一个快速高效的自然语言处理库,具有良好的性能和易用性。

它内置了多个词性标注器,如规则标注器、统计标注器和深度学习标注器。

SpaCy的深度学习标注器基于卷积神经网络(Convolutional Neural Network,简称CNN)和长短期记忆网络(Long Short-Term Memory,简称LSTM)进行训练,能够在多种语种和领域中实现准确的词性标注。

4. HMMTaggerHMMTagger是一个基于隐马尔可夫模型(Hidden Markov Model,简称HMM)的词性标注工具。