像Excel一样使用python进行数据分析_光环大数据python培训

- 格式:pdf

- 大小:333.91 KB

- 文档页数:11

使用Python进行大数据分析和处理一、引言随着大数据时代的到来,数据分析和处理技术愈发重要。

Python作为一种简单易学、功能强大的编程语言,被广泛应用于数据科学领域。

本文将介绍如何使用Python进行大数据分析和处理,并分为以下几个部分:数据获取、数据清洗、数据分析、数据可视化和模型建立。

二、数据获取在进行大数据分析和处理之前,我们需要从各种数据源中获取数据。

Python提供了丰富的库和工具,可以轻松地从数据库、API、Web页面以及本地文件中获取数据。

比如,我们可以使用pandas库中的read_sql()函数从数据库中读取数据,使用requests库从API获取数据,使用beautifulsoup库从Web页面获取数据,使用csv库从本地CSV文件中获取数据。

三、数据清洗获取到原始数据之后,通常需要进行数据清洗。

数据清洗是指对数据进行预处理,包括处理缺失值、处理异常值、处理重复值、数据格式转换等。

Python提供了丰富的库和函数来帮助我们进行数据清洗,如pandas库中的dropna()函数用于处理缺失值,使用numpy库中的where()函数用于处理异常值,使用pandas库中的duplicated()函数用于处理重复值。

四、数据分析数据分析是大数据处理的核心环节之一。

Python提供了强大的库和工具来进行数据分析,如pandas库和numpy库。

使用这些库,我们可以进行数据聚合、数据筛选、数据排序、数据计算等。

例如,我们可以使用pandas库中的groupby()函数进行数据聚合,使用pandas库中的query()函数进行数据筛选,使用pandas库中的sort_values()函数进行数据排序,使用numpy库中的mean()函数进行数据计算。

五、数据可视化数据可视化是将数据以图形化的方式展现出来,帮助我们更好地理解数据的分布和趋势。

Python提供了多种库和工具来进行数据可视化,如matplotlib库和seaborn库。

如何利用Python进行数据分析与可视化在当今数字化的时代,数据成为了企业和个人决策的重要依据。

Python 作为一种强大且灵活的编程语言,在数据分析和可视化领域发挥着至关重要的作用。

如果你想要从海量的数据中提取有价值的信息,并以直观清晰的方式展现出来,那么学习如何利用 Python 进行数据分析与可视化将是一项非常有意义的技能。

首先,让我们来谈谈数据分析。

在 Python 中,有几个关键的库是我们经常会用到的。

比如,`pandas` 库是处理数据的得力工具。

它提供了丰富的数据结构和函数,能够轻松地读取、处理和操作各种格式的数据文件,如 CSV、Excel 等。

通过`pandas` ,我们可以进行数据清洗、筛选、排序、合并等操作,将原始数据整理成我们需要的格式。

举个例子,如果我们有一份销售数据的 CSV 文件,其中包含了不同产品在不同地区的销售数量和销售额。

我们可以使用`pandas` 读取这个文件,然后筛选出特定地区或者特定产品的销售数据,计算每个产品的平均销售额,或者按照销售额对产品进行排序。

数据处理完成后,接下来就是数据分析的核心部分——数据分析和统计。

Python 中的`numpy` 库提供了高效的数值计算功能,而`scipy` 库则包含了更多的科学计算和统计分析工具。

我们可以使用这些库来计算数据的均值、中位数、标准差、相关性等统计指标,从而对数据的分布和特征有更深入的了解。

例如,通过计算销售数据的标准差,我们可以了解销售额的波动情况;通过计算不同产品销售额之间的相关性,我们可以发现哪些产品的销售趋势比较相似。

当我们对数据有了一定的分析和理解之后,就可以进入可视化的环节。

可视化能够让我们更直观地看到数据中的模式和趋势,帮助我们更好地传达数据背后的信息。

Python 中的`matplotlib` 库是一个基础且强大的可视化工具,它可以创建各种类型的图表,如折线图、柱状图、饼图等。

假设我们想要展示不同产品在过去一年中的销售额变化趋势,就可以使用`matplotlib` 绘制折线图。

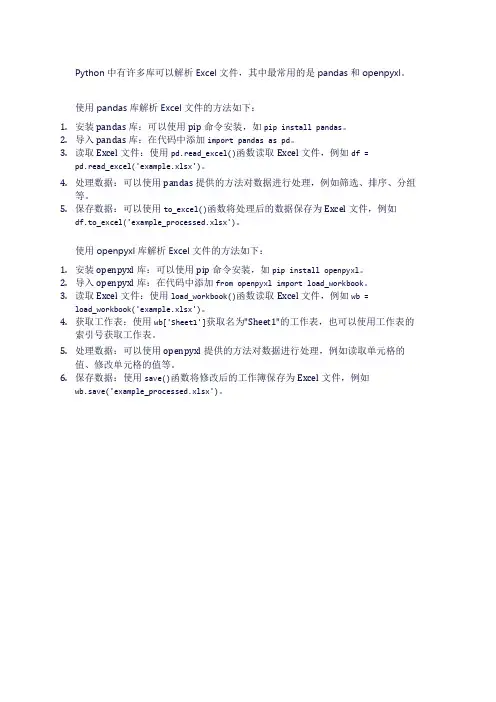

Python中有许多库可以解析Excel文件,其中最常用的是pandas和openpyxl。

使用pandas库解析Excel文件的方法如下:1.安装pandas库:可以使用pip命令安装,如pip install pandas。

2.导入pandas库:在代码中添加import pandas as pd。

3.读取Excel文件:使用pd.read_excel()函数读取Excel文件,例如df =pd.read_excel('example.xlsx')。

4.处理数据:可以使用pandas提供的方法对数据进行处理,例如筛选、排序、分组等。

5.保存数据:可以使用to_excel()函数将处理后的数据保存为Excel文件,例如df.to_excel('example_processed.xlsx')。

使用openpyxl库解析Excel文件的方法如下:1.安装openpyxl库:可以使用pip命令安装,如pip install openpyxl。

2.导入openpyxl库:在代码中添加from openpyxl import load_workbook。

3.读取Excel文件:使用load_workbook()函数读取Excel文件,例如wb =load_workbook('example.xlsx')。

4.获取工作表:使用wb['Sheet1']获取名为"Sheet1"的工作表,也可以使用工作表的索引号获取工作表。

5.处理数据:可以使用openpyxl提供的方法对数据进行处理,例如读取单元格的值、修改单元格的值等。

6.保存数据:使用save()函数将修改后的工作簿保存为Excel文件,例如wb.save('example_processed.xlsx')。

python数据分析方法本文研究Python数据分析的方法,以了解如何使用Python来收集、清理、组织和分析数据。

Python数据分析方法助力了人们做出正确且可靠的决策,通过对数据进行分析来挖掘有价值的信息。

此外,本文还分析了Python数据分析的主要步骤、Python协作开发工具、Python数据可视化工具、Python数据建模工具和Python机器学习工具,以及其他类型的Python数据分析工具,有助于读者了解Python 如何帮助人们做出更有价值的数据分析。

关键词:Python数据分析;Python协作开发工具;Python数据可视化工具;Python数据建模工具;Python机器学习工具1.言Python是一种面向对象的计算机编程语言,可以帮助开发人员以简易的方式解决复杂的IT问题,它可以用来处理大量数据和有效管理编码工程。

Python数据分析是将大量数据结构化,以便把握有价值信息的过程,Python数据分析可以帮助我们从大量数据中获得科学技术和商业决策的支持。

Python是实时数据分析的最流行的编程语言,它是一种建模和数据处理工具,可以帮助企业收集、整理、分析和处理数据,为企业提供更好的决策支持。

2. Python数据分析的主要步骤Python数据分析的主要步骤包括收集,清理,组织,分析和可视化步骤。

(1)收集步骤:首先,要收集处理大量数据,一般使用Python爬虫来进行,可以爬取网页上的数据,也可以从文件中读取数据,还可以从数据库获取数据。

(2)清理步骤:收集到的数据往往是很乱的,需要进行清理,利用Python语言的清理函数可以将数据进行清理,以便下一步进行数据分析。

(3)组织步骤:清理过的数据需要进一步组织,可以用Python 将数据进行组织,如排序、合并等。

(4)分析步骤:将数据进行组织之后,就可以进行分析,可以使用Python语言中的各种数学函数和统计函数进行数据分析,得出有价值的结果。

如何利用Python进行数据分析在当今信息化的时代,数据分析在各行各业中愈发重要,特别是业务和决策层在做出决策时需要大量的数据支持。

Python作为一种高级编程语言,加上它强大的数据处理及可视化库,Python 已成为最流行的数据分析和科学计算语言之一。

在本篇文章中,将从以下维度探讨如何利用Python进行数据分析。

1. 数据处理数据处理是数据分析的首要环节,也是数据分析中最繁琐的环节。

在Python中,Numpy、Pandas、Scipy、matplotlib等库都能为数据处理提供有效的帮助。

Numpy是Python数据处理的核心库,提供大量的数学函数和矩阵运算,使处理和计算数据变得十分方便快捷。

例如,可使用Numpy进行数组操作,如下所示:```pythonimport numpy as np# 创建一个数据数组data = np.array([1, 2, 3, 4, 5])# 进行运算mean = np.mean(data)variance = np.var(data)std_dev = np.std(data)# 打印结果print("Mean: ", mean)print("Variance: ", variance)print("Standard deviation: ", std_dev)```Pandas库同样是十分重要的数据处理库,它提供了灵活的数据结构和数据集操作的工具。

Pandas的DataFrame可以看做是一个二维表格数据结构,支持SQL,Excel等风格的操作语法。

```pythonimport pandas as pd# 将数据读入到dataframedf = pd.read_csv("filename.csv")# 输出前几行print(df.head())# 获取列数据data = df['column_name']# 计算平均数mean = data.mean()```除此以外,Pandas还具有强大的数据合并、数据统计、数据重塑等操作功能。

利用Python进行数据分析

Python 数据分析的主要内容包括三大部分:数据清洗、可视

化和建模。

首先,在数据清洗方面,Python提供了一系列的

库和工具,可以实现数据的抽取、处理、标准化等功能。

比如Pandas和Numpy库,它们可以帮助我们通过一些简单的技术,实现对数据的处理,比如清理数据中的缺失值,异常值,以及格式不一致的数据等等。

如此一来,可以为今后的数据分析提供更好的基础。

其次,Python也为可视化提供了很多强大的功能,比如Matplotlib和Seaborn库等,它们可以帮助我们快速、灵活地

展示出许多精美的图表来,比如画出直方图、折线图、散点图、气泡图等等。

通过这些可视化图表,可以将数据更直观呈现出来,从而更有效地分析和识别数据中的规律。

最后,Python还为建模提供了很强大的功能,比如Scikit Learn等库,可以帮助我们实现对数据的分类、预测等功能,

实现快速准确的数据分析。

它们可以用于实现各种回归算法,比如线性回归、逻辑回归、贝叶斯回归等等,以及一些其他常见的机器学习算法,比如支持向量机、决策树和随机森林等等,可以根据不同的应用场景选择合适的模型并进行拟合,以获得更准确的结果。

总之,利用Python实现数据分析,是一种非常有效的工作方式,可以帮助我们更快速准确地分析和识别数据中的规律,以实现准确有效的数据分析。

关于比对Excel数据的Python代码在日常工作中,我们经常需要比对Excel表格中的数据,以找出差异或重复的部分。

Python作为一种强大的编程语言,提供了丰富的库和工具,可以帮助我们高效地实现这一目标。

本文将介绍如何使用Python代码来比对Excel数据,帮助大家快速处理表格数据。

一、准备工作1. 安装Python环境我们需要在电脑上安装Python编程环境。

可以到冠方全球信息站xxx 下载安装最新版本的Python,并按照安装向导进行操作。

2. 安装相关库在Python环境中,我们需要使用一些第三方库来处理Excel表格。

常用的库包括pandas、openpyxl等,可以使用pip命令来安装这些库:```pythonpip install pandas openpyxl```3. 准备Excel文件准备好需要比对的Excel文件,确保文件格式正确,数据完整。

二、代码编写下面将介绍如何使用Python代码来比对Excel数据。

1. 读取Excel数据我们需要使用pandas库来读取Excel中的数据,将其转换为DataFrame格式方便处理:```pythonimport pandas as pddf1 = pd.read_excel('file1.xlsx')df2 = pd.read_excel('file2.xlsx')```2. 比对数据接下来,我们可以使用DataFrame提供的方法来比对数据。

常见的比对操作包括查找差异、查找重复等。

我们可以使用merge方法来找出两个表格中不同的部分:```pythondiff = pd.concat([df1, df2]).drop_duplicates(keep=False)```这样,diff中将包含了两个表格中不同的部分数据。

3. 输出结果我们可以将比对结果输出到新的Excel文件中,方便查看和分析:```pythondiff.to_excel('difference.xlsx', index=False)```三、注意事项在实际操作中,我们需要注意一些细节问题,以确保比对操作的准确性和高效性。

如何利用Python编程进行大数据处理和分析一、Python 在大数据处理中的优势Python 拥有丰富的库和工具,使其成为大数据处理的理想选择。

首先,Python 的语法简洁明了,易于理解和编写代码,降低了编程的门槛。

其次,像 Pandas、NumPy 和 SciPy 这样的库为数据处理和数值计算提供了高效的功能。

再者,Python 与 Hadoop、Spark 等大数据框架有着良好的集成性,可以方便地在分布式环境中处理大规模数据。

二、大数据处理的基本概念在深入学习 Python 大数据处理之前,了解一些基本概念是很有必要的。

大数据通常具有“4V”特征:Volume(大量)、Velocity(高速)、Variety(多样)和 Veracity(真实性)。

处理大数据需要考虑数据的采集、存储、清洗、转换、分析和可视化等环节。

三、数据采集数据采集是获取数据的第一步。

Python 可以通过多种方式采集数据,例如使用网络爬虫从网页中抓取数据,或者通过与数据库连接来获取存储在数据库中的数据。

在采集数据时,要注意数据的合法性和规范性。

四、数据存储对于大规模的数据,合适的存储方式至关重要。

常见的大数据存储技术包括 Hadoop 的分布式文件系统(HDFS)和 NoSQL 数据库(如MongoDB、Cassandra 等)。

Python 可以通过相关的库和接口与这些存储系统进行交互。

五、数据清洗采集到的数据往往存在缺失值、重复值、错误值等问题,需要进行清洗。

Pandas 库提供了强大的数据清洗功能,如删除重复行、填充缺失值、处理异常值等。

通过数据清洗,可以提高数据的质量,为后续的分析打下良好的基础。

六、数据转换将清洗后的数据转换为适合分析的格式也是重要的一步。

这可能包括数据的标准化、归一化、编码等操作。

Python 的库可以轻松实现这些转换,使数据更易于分析。

七、数据分析数据分析是挖掘数据价值的核心环节。

Python 中的统计分析库(如StatsModels)和机器学习库(如 Scikitlearn)可以用于进行数据的描述性统计、回归分析、分类、聚类等操作。

如何用Python实现数据分析?一篇文章搞定!如何用Python实现数据分析?一篇文章搞定!Python已经成为了数据分析领域中非常流行的编程语言之一。

通过使用Python的各种数据分析库,我们可以方便地处理、分析和可视化数据。

本文将介绍Python的基本数据分析工具,以及如何在Python中进行数据分析。

1.Python数据分析基础Python是一种非常流行的编程语言,因为它易读易写、可扩展性强、可移植性好等特点,因此在数据分析领域中被广泛使用。

在Python中进行数据分析的基本工具包括NumPy、Pandas、Matplotlib、Seaborn和Scikit-learn。

1.1 NumPyNumPy是Python中用于数值计算的基本库,它支持高效的多维数组运算。

在NumPy 中,最基本的数据结构是数组。

NumPy数组是由同类型元素的集合组成的,可以是一维数组或多维数组。

NumPy的一维数组类似于Python的列表,而多维数组则类似于矩阵。

1.1.1 安装NumPy在使用NumPy之前,需要先安装它。

可以通过pip命令来安装NumPy,具体方法如下:pip install numpy1.1.2 创建数组在NumPy中,可以使用np.array()函数来创建数组。

以下是一些基本的创建数组的方法:ini Copy codeimport numpy as np# 创建一维数组a = np.array([1, 2, 3, 4, 5])print(a)# 创建二维数组b = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])print(b)# 创建全0数组c = np.zeros((2, 3))print(c)# 创建全1数组d = np.on es((2, 3))print(d)1.1.3 数组运算NumPy支持多种数组运算,包括加、减、乘、除等。

以下是一些基本的数组运算方法:ini Copy codeimport numpy as npa = np.array([1, 2, 3])b = np.array([4, 5, 6])# 数组加法c = a + bprint(c)# 数组减法d = a - bprint(d)# 数组乘法e = a * bprint(e)# 数组除法f = a / bprint(f)1.2 PandasPandas是基于NumPy的数据处理库,提供了快速便捷的数据结构和数据分析工具。

Python 已经成为数据分析和数据挖掘的首选语言,作为除了 Java、C/C++/C# 外最受欢迎的语言。

本课程基于 Python 工具来实现大数据的数据分析和数据挖掘项目。

基于业务问题,在数据挖掘标准过程指导下,采用 Python 分析工具,实现数据挖掘项目的每一步操作,从数据预处理、数据建模、数据可视化,到最终数据挖掘结束,匡助学员掌握 Python 用于数据挖掘,提升学员的数据化运营及数据挖掘的能力。

通过本课程的学习,达到如下目的:1、全面掌握 Python 语言以及其编程思想。

2、掌握常用扩展库的使用,特殊是数据挖掘相关库的使用。

3、学会使用 Python 完成数据挖掘项目整个过程。

4、掌握利用 Python 实现可视化呈现。

5、掌握数据挖掘常见算法在 Python 中的实现。

5 天时间(全部模块讲完需要 5 天时间,可以根据时间需求拆份内容模块)。

业务支持部、 IT 系统部、大数据系统开辟部、大数据分析中心、网络运维部等相关技术人员。

课程为实战课程,要求:1、每一个学员自备一台便携机(必须)。

2、便携机中事先安装好 Excel 2022 版本及以上。

3、便携机中事先安装好 Python 3.6 版本及以上。

注:讲师现场提供开源的安装程序、扩展库,以及现场分析的数据源。

语言基础 +挖掘模型 +案例演练+开辟实践+可视化呈现采用互动式教学,环绕业务问题,展开数据分析过程,全过程演练操作,让学员在分析、分享、讲授、总结、自我实践过程中获得能力提升。

目的:掌握基本的 Python 编程思想与编程语句,熟悉常用数据结构的操作1、Python 简介2、开辟环境搭建Python 的安装扩展库的安装3、掌握 Python 的简单数据类型字符串的使用及操作整数、浮点数4、掌握基本语句:if、while、for、print 等基本运算:函数定义、参数传递、返回值5、掌握复杂的数据类型:列表/元组列表操作:访问、添加、修改、删除、排序列表切片、复制等列表相关的函数、方法元组的应用6、复杂数据类型:字典创建、访问、修改、删除、遍历字典函数和方法7、复杂数据类型:集合8、掌握面向对象编程思想创建类、继承类模块9、函数定义、参数传递、返回值10、标准库与扩展库的导入11、异常处理:try-except 块演练:基本的 Python 编程语句目的:掌握数据集结构及基本处理方法,进一步巩固 Python 语言1、数据挖掘常用扩展库介绍Numpy 数组处理支持Scipy 矩阵计算模块Matplotlib 数据可视化工具库Pandas 数据分析和探索工具StatsModels 统计建模库Scikit-Learn 机器学习库Keras 深度学习(神经网络)库Gensim 文本挖掘库2、数据集读取与操作:读取、写入读写文本文件读写 CSV 文件读写 Excel 文件从数据库获取数据集3、数据集的核心数据结构(Pandas 数据结构)DataFrame 对象及处理方法Series 对象及处理方法演练:用 Python 实现数据的基本统计分析功能目的:掌握作图扩展库,实现数据可视化1、常用的 Python 作图库Matplotlib 库Pygal 库2、实现分类汇总演练:按性别统计用户人数演练:按产品+日期统计各产品销售金额3、各种图形的画法直方图饼图折线图散点图4、绘图的美化技巧演练:用 Python 库作图来实现产品销量分析,并可视化目的:掌握数据挖掘标准流程1、数据挖掘概述2、数据挖掘的标准流程(CRISP-DM)商业理解数据准备数据理解模型建立模型评估模型应用3、数据挖掘常用任务与算法案例:用大数据实现精准营销的项目过程目的:掌握数据预处理的基本环节,以及 Python 的实现1、数据预处理异常值处理: 3σ准则, IQR 准则缺失值插补:均值、拉格朗日插补数据筛选/抽样数据的离散化处理变量变换、变量派生2、数据的基本分析相关分析:原理、公式、应用方差分析:原理、公式、应用卡方分析:原理、公式、应用主成份分析:降维案例:用 Python 实现数据预处理及数据准备1、常见分类预测的模型与算法2、如何评估分类预测模型的质量查准率查全率ROC 曲线3、逻辑回归分析模型逻辑回归的原理逻辑回归建模的步骤逻辑回归结果解读案例:用 sklearn 库实现银行贷款违约预测4、决策树模型决策树分类的原理决策树的三个关键问题决策树算法与实现案例:电力窃漏用户自动识别5、人工神经网络模型(ANN)神经网络概述神经元工作原理常见神经网络算法(BP、LM、RBF、FNN 等) 案例:神经网络预测产品销量6、支持向量机(SVM)SVM 基本原理维灾难与核心函数案例:基于水质图象的水质评价7、贝叶斯分析条件概率常见贝叶斯网络1、常用数值预测的模型通用预测模型:回归模型季节性预测模型:相加、相乘模型新产品预测模型:珀尔曲线与龚铂兹曲线2、回归分析概念3、常见回归分析类别1、客户细分常用方法2、聚类分析(Clustering)聚类方法原理介绍及合用场景常用聚类分析算法聚类算法的评价案例:使用 SKLearn 实现 K 均值聚类案例:使用 TSNE 实现聚类可视化3、RFM 模型分析RFM 模型,更深入了解你的客户价值 RFM 模型与市场策略案例:航空公司客户价值分析1、关联规则概述2、常用关联规则算法3、时间序列分析案例:使用 apriori 库实现关联分析案例:中医证型关联规则挖掘1、电商用户行为分析及服务推荐2、基于基站定位数据的商圈分析。

如何利用Python进行大数据处理和分析在当今数字化的时代,数据量呈爆炸式增长,大数据已经成为了各个领域的重要资产。

而 Python 作为一种强大而灵活的编程语言,在大数据处理和分析领域发挥着至关重要的作用。

接下来,让我们一起深入探讨如何利用 Python 进行大数据处理和分析。

一、Python 在大数据处理中的优势Python 之所以在大数据处理中备受青睐,主要归因于以下几个方面:1、丰富的库和工具Python 拥有众多强大的库,如 Pandas、NumPy 和 SciPy 等,这些库为数据处理和分析提供了高效的函数和方法。

2、简洁易读的语法Python 的语法简洁明了,使得代码易于理解和维护,降低了开发成本和出错率。

3、跨平台性Python 可以在不同的操作系统上运行,包括 Windows、Linux 和macOS,这为开发者提供了极大的便利。

4、活跃的社区支持Python 拥有庞大而活跃的社区,开发者可以在社区中获取丰富的资源和帮助,解决遇到的问题。

二、大数据处理的基本概念在深入了解如何使用 Python 进行大数据处理之前,我们先来了解一些基本概念。

1、数据采集这是获取数据的过程,数据来源可能包括数据库、文件、网络爬虫等。

2、数据清洗对采集到的数据进行清理和预处理,去除噪声、缺失值和异常值等。

3、数据分析运用各种统计和机器学习方法,对数据进行探索和分析,以提取有价值的信息。

4、数据可视化将分析结果以直观的图表形式展示出来,帮助人们更好地理解数据。

三、Python 中的数据处理库1、 PandasPandas 是 Python 的核心数据分析支持库,提供了快速、灵活、明确的数据结构,旨在简单、直观地处理关系型、标记型数据。

它的主要数据结构是 Series(一维数据)和 DataFrame(二维数据)。

通过Pandas,我们可以轻松地读取、写入各种格式的数据文件,如 CSV、Excel 等,并进行数据选择、过滤、排序、聚合等操作。

学习Python实现数据处理与分析Python是一种开源的编程语言,具备简洁、高效的特点,并且在数据处理与分析领域有着广泛的应用。

本文将从数据清洗、数据分析和数据可视化三个方面,介绍如何使用Python进行数据处理与分析。

一、数据清洗数据清洗是数据处理的第一步,也是非常重要的一步。

下面介绍几个常用的数据清洗方法。

1. 去除重复值在处理大量数据时,常常会遇到重复的数据。

可以使用Python 的pandas库中的drop_duplicates()函数去除重复值。

例如,我们可以使用以下代码去除data中的重复值:data = data.drop_duplicates()2. 缺失值处理在数据中,经常会遇到缺失值的情况。

可以使用Python的pandas库中的fillna()函数对缺失值进行处理。

例如,我们可以使用以下代码将data中的所有缺失值替换为0:data = data.fillna(0)3. 数据类型转换数据在导入时,可能会出现数据类型不一致的情况,影响后续的数据分析。

可以使用Python的pandas库中的astype()函数将数据类型进行转换。

例如,我们可以使用以下代码将data中的数据转换为整数类型:data = data.astype(int)二、数据分析Python具备强大的数据分析能力,下面介绍几个常用的数据分析方法。

1. 描述性统计描述性统计是对数据进行初步分析的一种方法,可以使用Python的pandas库中的describe()函数来得到数据的基本统计量,如均值、中位数、标准差等。

例如,我们可以使用以下代码计算data的描述性统计量:data.describe()2. 相关性分析相关性分析用来研究两个变量之间的相关关系,可以使用Python的pandas库中的corr()函数来计算变量之间的相关系数。

例如,我们可以使用以下代码计算data中各个变量之间的相关系数:data.corr()3. 数据建模数据建模是数据分析的重要环节,可以使用Python的scikit-learn库进行数据建模。

Python中的数据分析和统计方法Python是一门功能强大的编程语言,广泛应用于数据分析和统计方法。

本文将详细介绍Python中常用的数据分析和统计方法,并按类进行章节划分,深入探讨每个章节的具体内容。

第一章:数据预处理在进行数据分析之前,通常需要对原始数据进行清洗和预处理。

Python提供了很多用于数据预处理的库和方法。

其中,pandas是最常用的库之一。

pandas可以用于数据的读取、清洗、转换和合并等操作。

另外,NumPy库也提供了许多用于数组操作和数值运算的函数,可用于数据预处理过程中的一些计算。

第二章:数据可视化数据可视化是数据分析的重要环节,它可以使得数据更加直观和易于理解。

Python中有多个可视化库可以使用,如Matplotlib、Seaborn和Plotly等。

这些库可以生成各种类型的图表,如线图、散点图、柱状图和饼图等。

通过合理选择和使用可视化方法,可以更好地展示数据的分布和趋势。

第三章:统计描述统计描述是对数据进行摘要和概括的过程。

在Python中,可以使用pandas库的describe()函数来计算数据的基本统计量,如均值、标准差、最大值和最小值等。

此外,还可以使用scipy库中的一些函数来计算概率分布、置信区间和假设检验等统计指标。

第四章:回归分析回归分析是数据分析中常用的一种方法,用于探究变量之间的关系和预测未来趋势。

Python中的statsmodels库提供了许多回归分析的方法,如线性回归、逻辑回归和多元回归等。

通过回归分析,可以得到模型的参数估计和拟合优度等指标,进而对未知数据进行预测和推测。

第五章:聚类分析聚类分析是将数据按照相似性进行分组的一种方法。

在Python 中,可以使用scikit-learn库中的KMeans算法来进行聚类分析。

KMeans算法通过迭代计算将数据划分为K个簇,使得同一簇内的数据相似度最高,不同簇之间的相似度最低。

聚类分析可以帮助我们发现数据中潜在的模式和规律。

如何用Python进行数据分析和预测建模章节一:Python数据分析介绍Python是一种高级编程语言,因其简单易学、开源免费和强大的数据处理功能而受到广泛关注。

在数据科学领域,Python已成为最受欢迎的编程语言之一。

它提供了丰富的库和工具,用于数据收集、清洗、分析和可视化。

Python中最重要的数据处理库是pandas。

pandas提供了DataFrames和Series等两个重要的数据结构,能够轻松地处理和操作数据。

除此之外,NumPy和Matplotlib等库也是必不可少的,NumPy提供了高性能的数组和矩阵操作,而Matplotlib则可用于数据可视化。

章节二:数据收集和清洗数据分析的第一步是收集数据。

Python提供了多个库和工具,可以从各种来源获取数据,例如Web、数据库和文本文件。

其中,requests库可用于从Web API获取数据,而pandas库中的read_csv()函数等可以方便地读取和处理文本文件。

数据收集完毕后,需要对数据进行清洗和预处理。

数据清洗的目的是去除无效、不完整或错误的数据,以确保数据的准确性。

在pandas中,可以使用dropna()函数删除含有缺失值的行或列,也可以使用fillna()函数将缺失值填充为指定值。

章节三:数据分析和可视化在数据清洗完毕后,可以进行数据分析和可视化。

pandas提供了丰富的统计和分析函数,例如mean()、std()和describe()等,可用于计算数据的均值、标准差和其他统计指标。

此外,pandas的plot()函数支持多种类型的图表绘制,例如折线图、柱状图和散点图等。

除了pandas,NumPy也提供了一些用于数据分析的函数,例如corrcoef()可计算变量之间的相关系数。

Matplotlib库提供了更多高级的可视化功能,例如绘制等高线图和热力图等,有助于更深入地理解数据。

章节四:数据预处理在进行数据分析和预测建模之前,通常需要对数据进行预处理。

使⽤python进⾏数据分析原⽂链接:译⽂链接:有许多优秀的Python书籍和在线课程,然⽽我不并不推荐它们中的⼀些,因为,有些是给⼤众准备的⽽不是给那些⽤来数据分析的⼈准备的。

同样也有许多书是“⽤Python科学编程”的,但它们是⾯向各种数学为导向的主题的,⽽不是成为为了数据分析和统计。

不要浪费浪费你的时间去阅读那些为⼤众准备的Python书籍。

在进⼀步继续之前,⾸先设置好你的编程环境,然后学习怎么使⽤IPython notebook学习途径从开始学起,完成上⾯的所有练习。

每天投⼊3个⼩时,你应该在20天内完成它们。

Code academy涵盖了Python基本概念。

但是,它不像那样以项⽬为导向;没关系,因为你的⽬标是从事数据科学,⽽不是使⽤Python开发软件。

当完成了code academy练习之后,看看这个Ipython notebook:(在总结部分我已经提供了下载链接)。

它包括了code academy中没有提到的⼀些概念。

你能在1到2⼩时内学完这个教程。

现在,你知道⾜够的基础知识来学习Python库了。

Numpy⾸先,开始学习Numpy吧,因为它是利⽤Python科学计算的基础包。

对Numpy好的掌握将会帮助你有效地使⽤其他⼯具例如Pandas。

我已经准备好了IPython笔记,这包含了Numpy的⼀些基本概念。

这个教程包含了Numpy中最频繁使⽤的操作,例如,N维数组,索引,数组切⽚,整数索引,数组转换,通⽤函数,使⽤数组处理数据,常⽤的统计⽅法,等等。

遇到Numpy陌⽣函数,查询⽤法,推荐!PandasPandas包含了⾼级的数据结构和操作⼯具,它们使得Python数据分析更加快速和容易。

教程包含了series, data frams,从⼀个axis删除数据,缺失数据处理,等等。

遇到陌⽣函数,查询⽤法,推荐!Matplotlib这是⼀个分为四部分的Matplolib教程。

1st 部分:第⼀部分介绍了Matplotlib基本功能,基本figure类型。

金融量化交易分析利器-Tushare_光环大数据Python培训Dependenciespython 2.x/3.xpandasInstallation方式1:pip install tushare方式2:python setup.py install方式3:访问https:///pypi/tushare/下载安装Upgradepip install tushare --upgradeQuick StartExample 1. 获取个股历史交易数据(包括均线数据):import tushare as tsts.get_hist_data('600848') #一次性获取全部数据结果显示:日期,开盘价,最高价,收盘价,最低价,成交量,价格变动,涨跌幅,5日均价,10日均价,20日均价,5日均量,10日均量,20日均量,换手率open high close low volume p_changema5 /date 2012-01-11 6.880 7.380 7.060 6.880 14129.96 2.627.060 2012-01-12 7.050 7.100 6.980 6.900 7895.19-1.13 7.020 2012-01-13 6.950 7.000 6.700 6.690 6611.87-4.01 6.913 2012-01-16 6.680 6.750 6.510 6.480 2941.63-2.84 6.813 2012-01-17 6.660 6.880 6.860 6.460 8642.575.386.822 2012-01-187.000 7.300 6.890 6.880 13075.400.44 6.788 2012-01-19 6.690 6.950 6.890 6.680 6117.320.00 6.770 2012-01-20 6.870 7.080 7.010 6.870 6813.091.74 6.832 ma10 ma20 v_ma5 v_ma10v_ma20 turnover date 2012-01-11 7.060 7.060 14129.96 14129.96 14129.96 0.482012-01-12 7.020 7.020 11012.58 11012.58 11012.58 0.272012-01-13 6.913 6.913 9545.67 9545.67 9545.67 0.232012-01-16 6.813 6.813 7894.66 7894.66 7894.66 0.102012-01-17 6.822 6.822 8044.24 8044.24 8044.24 0.302012-01-18 6.833 6.833 7833.33 8882.77 8882.77 0.452012-01-19 6.841 6.841 7477.76 8487.71 8487.71 0.212012-01-20 6.863 6.863 7518.00 8278.38 8278.38 0.23 设定历史数据的时间:ts.get_hist_data('600848',start='2015-01-05',end='2015-01-09')open high close low volume p_change ma5 ma10 /date2015-01-05 11.160 11.390 11.260 10.890 46383.57 1.26 11.15611.212 2015-01-06 11.130 11.660 11.610 11.030 59199.933.11 11.182 11.155 2015-01-07 11.580 11.990 11.920 11.48086681.38 2.67 11.366 11.251 2015-01-08 11.700 11.92011.670 11.640 56845.71 -2.10 11.516 11.349 2015-01-0911.680 11.710 11.230 11.190 44851.56 -3.77 11.538 11.363 ma20 v_ma5 v_ma10 v_ma20 turnover date 2015-01-05 11.198 58648.75 68429.87 97141.81 1.592015-01-06 11.382 54854.38 63401.05 98686.98 2.032015-01-07 11.543 55049.74 61628.07 103010.58 2.972015-01-08 11.647 57268.99 61376.00 105823.50 1.952015-01-09 11.682 58792.43 60665.93 107924.27 1.54复权历史数据获取历史复权数据,分为前复权和后复权数据,接口提供股票上市以来所有历史数据,默认为前复权。

像Excel一样使用python进行数据分析_光环大数据python培训Excel是数据分析中最常用的工具,本篇文章通过python与excel的功能对比介绍如何使用python通过函数式编程完成excel中的数据处理及分析工作。

在Python中pandas库用于数据处理,我们从1787页的pandas官网文档中总结出最常用的36个函数,通过这些函数介绍如何通过python完成数据生成和导入,数据清洗,预处理,以及最常见的数据分类,数据筛选,分类汇总,透视等最常见的操作。

1.生成数据表第一部分是生成数据表,常见的生成方法有两种,第一种是导入外部数据,第二种是直接写入数据。

Excel中的文件菜单中提供了获取外部数据的功能,支持数据库和文本文件和页面的多种数据源导入。

python支持从多种类型的数据导入。

在开始使用python进行数据导入前需要先导入pandas库,为了方便起见,我们也同时导入numpy库。

import numpy as npimport pandas as pd导入数据表下面分别是从excel和csv格式文件导入数据并创建数据表的方法。

代码是最简模式,里面有很多可选参数设置,例如列名称,索引列,数据格式等等。

感兴趣的朋友可以参考pandas的官方文档。

df=pd.DataFrame(pd.read_csv('name.csv',header=1))df=pd.DataFrame( pd.read_excel('name.xlsx'))创建数据表另一种方法是通过直接写入数据来生成数据表,excel中直接在单元格中输入数据就可以,python中通过下面的代码来实现。

生成数据表的函数是pandas库中的DateFrame函数,数据表一共有6行数据,每行有6个字段。

在数据中我们特意设置了一些NA值和有问题的字段,例如包含空格等。

后面将在数据清洗步骤进行处理。

后面我们将统一以DataFrame的简称df来命名数据表。

df = pd.DataFrame({"id":[1001,1002,1003,1004,1005,1006], "date":pd.date_range('20130102', periods=6), "city":['Beijing ', 'SH', ' guangzhou ', 'Shenzhen', 'shanghai', 'BEIJING'], "age":[23,44,54,32,34,32], "category":['100-A','100-B','110-A','110-C','210-A','130-F'], "price":[1200,np.nan,2133,5433,np.nan,4432]},columns =['id','date','city','category','age','price'])这是刚刚创建的数据表,我们没有设置索引列,price字段中包含有NA值,city字段中还包含了一些脏数据。

2.数据表检查第二部分是对数据表进行检查,python中处理的数据量通常会比较大,比如我们之前的文章中介绍的纽约出租车数据和Citibike的骑行数据,数据量都在千万级,我们无法一目了然的了解数据表的整体情况,必须要通过一些方法来获得数据表的关键信息。

数据表检查的另一个目的是了解数据的概况,例如整个数据表的大小,所占空间,数据格式,是否有空值和重复项和具体的数据内容。

为后面的清洗和预处理做好准备。

数据维度(行列)Excel中可以通过CTRL+向下的光标键,和CTRL+向右的光标键来查看行号和列号。

Python中使用shape函数来查看数据表的维度,也就是行数和列数,函数返回的结果(6,6)表示数据表有6行,6列。

下面是具体的代码。

#查看数据表的维度df.shape(6, 6)数据表信息使用info函数查看数据表的整体信息,这里返回的信息比较多,包括数据维度,列名称,数据格式和所占空间等信息。

#数据表信息()<class 'pandas.core.frame.DataFrame'>RangeIndex: 6 entries, 0 to 5Data columns (total 6 columns):id 6 non-null int64date 6 non-null datetime64[ns]city 6 non-null objectcategory 6 non-null objectage 6 non-null int64price 4 non-null float64dtypes: datetime64[ns](1), float64(1), int64(2), object(2)memory usage: 368.0+ bytes查看数据格式Excel中通过选中单元格并查看开始菜单中的数值类型来判断数据的格式。

Python中使用dtypes函数来返回数据格式。

Dtypes是一个查看数据格式的函数,可以一次性查看数据表中所有数据的格式,也可以指定一列来单独查看。

#查看数据表各列格式df.dtypesid int64date datetime64[ns]city objectcategory objectage int64price float64dtype: object#查看单列格式df['B'].dtypedtype('int64')查看空值Excel中查看空值的方法是使用“定位条件”功能对数据表中的空值进行定位。

“定位条件”在“开始”目录下的“查找和选择”目录中。

Isnull是Python中检验空值的函数,返回的结果是逻辑值,包含空值返回True,不包含则返回False。

可以对整个数据表进行检查,也可以单独对某一列进行空值检查。

#检查数据空值df.isnull()#检查特定列空值df['price'].isnull()0 False1 True2False3 False4 True5 FalseName: price, dtype: bool查看唯一值Excel中查看唯一值的方法是使用“条件格式”对唯一值进行颜色标记。

Python中使用unique函数查看唯一值。

Unique是查看唯一值的函数,只能对数据表中的特定列进行检查。

下面是代码,返回的结果是该列中的唯一值。

类似与Excel中删除重复项后的结果。

#查看city列中的唯一值df['city'].unique()array(['Beijing ', 'SH',' guangzhou ', 'Shenzhen', 'shanghai', 'BEIJING '], dtype=object)查看数据表数值Python中的Values函数用来查看数据表中的数值。

以数组的形式返回,不包含表头信息。

#查看数据表的值df.valuesarray([[1001, Timestamp('2013-01-0200:00:00'), 'Beijing ', '100-A', 23, 1200.0], [1002, Timestamp('2013-01-03 00:00:00'), 'SH', '100-B', 44, nan], [1003, Timestamp('2013-01-04 00:00:00'), ' guangzhou ', '110-A', 54, 2133.0], [1004, Timestamp('2013-01-05 00:00:00'), 'Shenzhen','110-C', 32, 5433.0], [1005, Timestamp('2013-01-0600:00:00'), 'shanghai', '210-A', 34, nan], [1006, Timestamp('2013-01-07 00:00:00'), 'BEIJING ', '130-F', 32, 4432.0]], dtype=object)查看列名称Colums函数用来单独查看数据表中的列名称。

#查看列名称df.columnsIndex(['id', 'date', 'city', 'category', 'age','price'], dtype='object')查看前10行数据Head函数用来查看数据表中的前N行数据,默认head()显示前10行数据,可以自己设置参数值来确定查看的行数。

下面的代码中设置查看前3行的数据。

#查看前3行数据df.head(3)查看后10行数据Tail行数与head函数相反,用来查看数据表中后N行的数据,默认tail()显示后10行数据,可以自己设置参数值来确定查看的行数。

下面的代码中设置查看后3行的数据。

#查看最后3行df.tail(3)3.数据表清洗第三部分是对数据表中的问题进行清洗。

主要内容包括对空值,大小写问题,数据格式和重复值的处理。

这里不包含对数据间的逻辑验证。

处理空值(删除或填充)我们在创建数据表的时候在price字段中故意设置了几个NA值。

对于空值的处理方式有很多种,可以直接删除包含空值的数据,也可以对空值进行填充,比如用0填充或者用均值填充。

还可以根据不同字段的逻辑对空值进行推算。

Excel中可以通过“查找和替换”功能对空值进行处理,将空值统一替换为0或均值。

也可以通过“定位”空值来实现。

Python中处理空值的方法比较灵活,可以使用 Dropna函数用来删除数据表中包含空值的数据,也可以使用fillna函数对空值进行填充。