SSH 基本命令大全

- 格式:doc

- 大小:93.50 KB

- 文档页数:14

linux ssh命令用法-回复Linux SSH命令用法SSH(Secure Shell)是一个用于通过加密的方式在网络上安全地访问远程计算机的协议。

它为系统管理员和用户提供了一种安全的远程登录方式,同时也提供了文件传输和远程执行命令的功能。

在本文中,我将一步一步地解释SSH命令的用法,帮助您更好地理解和使用SSH。

1. SSH命令基本语法SSH命令的基本语法如下:ssh [选项] [用户名@]主机名[命令]选项通常用于设置SSH连接的一些参数,用户名@主机名用于指定连接到哪台远程主机,命令用于在远程主机上执行特定操作。

2. 连接到远程主机要连接到远程主机,只需在终端中输入ssh命令,然后在@符号后面输入主机名或IP地址。

例如,要连接到名为"example"的远程主机,您可以使用以下命令:ssh example如果需要指定用户名,可以将用户名放在主机名之前,使用以下命令:ssh username@example然后,系统会要求您输入密码以进行身份验证。

3. 使用SSH密钥对进行身份验证为了避免每次使用SSH命令时都要输入密码,您可以使用SSH密钥对进行身份验证。

这种方式更加安全和方便。

下面是使用SSH密钥对进行身份验证的步骤:步骤1:生成SSH密钥对在本地计算机上,打开终端并输入以下命令生成SSH密钥对:ssh-keygen按照提示输入保存密钥的文件名和密码选项,或者直接按回车键使用默认选项。

步骤2:将公钥复制到远程主机使用以下命令将公钥复制到远程主机:ssh-copy-id username@example这将要求您输入远程主机的密码。

输入密码后,公钥将自动复制到远程主机上,以便进行身份验证。

现在,您可以使用以下命令连接到远程主机,而无需再输入密码:ssh username@example4. 传输文件SSH还提供了一个名为`scp`的命令,用于在本地计算机和远程主机之间传输文件。

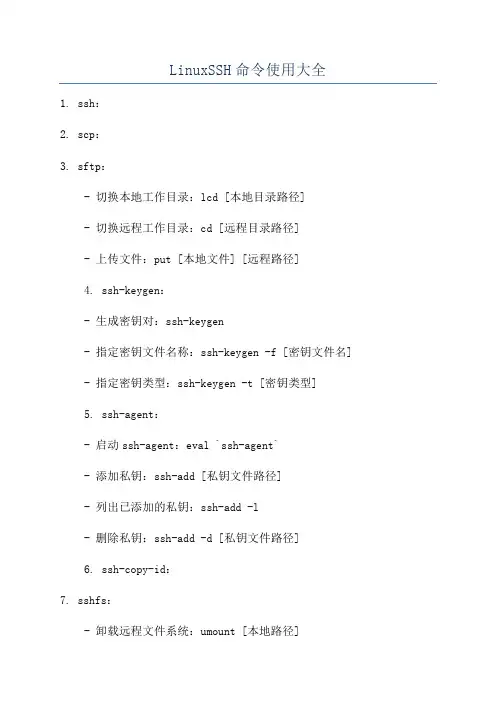

LinuxSSH命令使用大全1. ssh:2. scp:3. sftp:- 切换本地工作目录:lcd [本地目录路径]- 切换远程工作目录:cd [远程目录路径]- 上传文件:put [本地文件] [远程路径]4. ssh-keygen:- 生成密钥对:ssh-keygen- 指定密钥文件名称:ssh-keygen -f [密钥文件名] - 指定密钥类型:ssh-keygen -t [密钥类型]5. ssh-agent:- 启动ssh-agent:eval `ssh-agent`- 添加私钥:ssh-add [私钥文件路径]- 列出已添加的私钥:ssh-add -l- 删除私钥:ssh-add -d [私钥文件路径]6. ssh-copy-id:7. sshfs:- 卸载远程文件系统:umount [本地路径]8. ssh-keyscan:- 扫描主机公钥:ssh-keyscan [主机地址]- 导出主机公钥到文件:ssh-keyscan [主机地址] >> [公钥文件]9. ssh_config:- 配置别名主机:Host [别名] / HostName [主机地址] / User [用户名] / Port [端口号]10. sshd_config:- 修改SSH服务器监听端口:Port [新端口号]- 禁止Root用户直接登录:PermitRootLogin no- 禁止空密码登录:PermitEmptyPasswords no11. ssh-keyscan:- 检查服务器公钥指纹:ssh-keyscan -H [主机地址]12. ssh-add:- 添加私钥到ssh-agent:ssh-add [私钥文件路径]- 显示已添加的私钥列表:ssh-add -l- 删除私钥:ssh-add -d [私钥文件路径]13. ssh-keyscan:- 扫描主机公钥:ssh-keyscan [主机地址]- 导出主机公钥到文件:ssh-keyscan [主机地址] >> [公钥文件路径]14. ssh-keygen:- 生成密钥对:ssh-keygen- 指定密钥文件名:ssh-keygen -f [密钥文件名]- 指定密钥类型:ssh-keygen -t [密钥类型]15. sshfs:- 卸载远程文件系统:umount [本地路径]16. netstat:- 查看当前SSH连接:netstat -nat , grep ESTABLISHED , grep [主机地址]17. lsof:- 查找打开的SSH连接:lsof -i :22 , grep ssh以上是常用的SSH命令,可以帮助您在Linux系统中进行远程登录、文件传输和配置调整。

自己整理会很累,直接把大猫的这文章转过来,很简单也很实用.这是大猫给他MT用户的指导文章,当然在咱这Linode 用户及所有开通SSH的主机也适用,哈哈…….对于已经非常熟悉的朋友完全可以跳过,对于以前linux命令接触不多的,我觉得还是很有帮助,起码简单的问题完全可以自己解决了.大猫原文文章请进入:http://ooxx.me/common-ssh-commands.orz适用范围: 有SSH权限的空间难度: easy学习时间: 5分钟工具: 推荐SSH Secure Shell Client红色为jiucool补充1. 基础命令A.显示文件源代码cat ooxx.php没错, cat 是一个常用查看源代码的命令,优点是很方便很可爱,缺点是会直接刷刷刷显示所有源代码,文件太长只能看到屁股后面的那坨代码B. 查看当前目录pwdpwd不是password,而是查看当前目录,会输出完整的路径C. 更改目录Change Directory (cd)cd /path/to/directory/有DOS基础的同学应该会淫荡的一笑吧,路径可以用相对也可以用绝对D. 列出文件/子目录Listing Files/SubFolders(ls)ls默认只显示文件名,你也可以带个参数玩,比如ls -alh带-alh 输出会很爽… 自己试试, 大猫喜欢把ls -alh 颜射为ll-a显示全部文件-l比较详细的列表-h人类能看懂的比如把1024显示为1KE.帮助命令 --help任何命令后面带一个–help 都会显示一个简洁版的帮助,记不住参数就查一下F.获取远程文件wgetwget http://ooxx.me/me.jpg就会获取远程的me.jpg文件到当前目录,一般搬家的时候用这个让服务器去获取另一个服务器的数据,速度会快的完全不像男人G.压缩解压缩unzip wordpress.zip如果文件是zip形式的,比如刚从wordpress主站wget了一个压缩包过来,只需要输入unzip 文件名,就可以解压缩到当前目录了tar -czvf ooxx.tar.gz *把当前目录所有文件以tar命令打包为ooxx.tar.gz文件-c创建-z用gzip压缩方式-v显示压缩过程-f搞成一坨filetar -xzvf ooxx.tar.gz解压缩ooxx.tar.gz 里的文件到当前目录-x解压缩-z用gzip压缩方式-v显示压缩过程-f搞成一坨file2. 文件系统命令A.显示磁盘使用率df显示整个主机的总容量以及比率B.列表文件/子目录使用率(du)du会列出所有文件以及子目录的大小,不是人看的…du -sh-s就是summary,只输出当前文件夹总容量-h一般在linux就是human给人看的意思,会把1048580b转换为1mb显示du -h --max-depth=1嘿,只列出当前文件夹和第一级子目录占用大小C.删除文件Remove files (rm) 少儿不宜的命令,总是需要确认rm -vf miao.in强制删除miao.in这个文件并不需确认,列出删除文件列表强制删除,不要执行,除非你知道你在干嘛…-v一般v参数都是显示过程的意思-f 强奸的单词会不会拼? F-U-C-K的缩写,不确认直接F-word了rm -rf ooxx删除ooxx这个文件夹,包含它的子文件和子文件夹删除文件用上面的命令,但删除文件夹的时候就需要跑下遍历了-r 比较本土化,是"日"的缩写,在所有命令里都是recursive 的意思,有些命令是大写的R 需要注意D. 拷贝文件(cp)cp ooxx.me /home/jiucool复制ooxx.me这个文件到/home/jiucool 文件夹下cp –a /home/lovelygirl /home/jiucool复制lovelygirl 文件夹到/home/jiucool 文件夹下E. 移动文件/重命名(mv)mv ooxx.me miao.in重命名ooxx.me为miao.in如果加路径,就是移动到某个路径并重命名为miao.in和DOS不一样,移动文件和重命名换个思路,其实是一个套路,不是么?mv jiucool /home/jiucool将jiucool 移动到/home/jiucool文件夹下F. 创建空文件(touch)touch miao.in这个很色情的命令,就是创建一个miao.in 的空文件如果touch了已有的文件,则会更新那个文件的日期为当前如果touch次数多了,会high3. 文件权限A. 更改文件权限(chmod)chmod 777 miao.in默认文件为644,文件夹为755chmod -cfvR 777 /home/将/home/ 文件夹及下面所有文件权限修改为777TIP:1st digit=Owner; 2nd=Group; 3rd=Other(-rwxrwxwrx = 777, -rwxr-xr-x = 755, -rw-r–r– = 644, etc.)7 = Read + Write + Execute6 = Read + Write5 = Read + Execute4 = Read3 = Write + Execute2 = Write1 = Execute0 = All access denied4. 高级命令A. 查找. 常用命令,让我们来找一下10MB以上的文件吧find . -type f -size +10000k -exec ls -lh {} \; | awk '{ print $5 ": " $9 }' |sort -nB. Grep, 手里握着大西瓜ls -alh | grep ooxx只显示含有ooxx的那几列,当然你在cat的时候配合这个用找文件里的某些字段很方便C. 分页(Less/More)less miao.php如果源代码很长,则会分页显示,上下箭头滚动,输入q退出tail -n 1000 /var/log/httpd/error_log | more可以用| more 参数来滚动显示页面或行5. MYSQL 数据库导出数据库mysqldump -u 数据库用户名 -p 数据库名 > db_ooxx.sql导出数据库为db_ooxx.sql导入数据库mysql -u 数据库用户名 -p 数据库名 < db_ooxx.sql --default-character-set=utf8把当前目录的db_ooxx.sql 以utf8 编码导入,当然你原来是gbk就改成gbk中文blog经常遇到这个情况,一不小心就??? 满脑子都问号了。

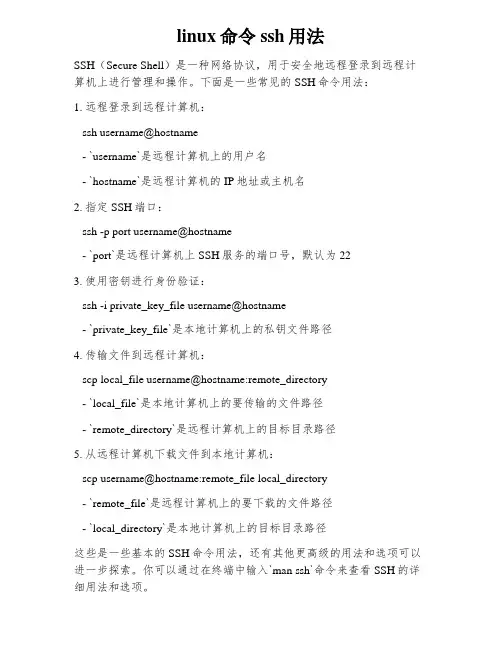

linux命令ssh用法

SSH(Secure Shell)是一种网络协议,用于安全地远程登录到远程计算机上进行管理和操作。

下面是一些常见的SSH命令用法:

1. 远程登录到远程计算机:

ssh username@hostname

- `username`是远程计算机上的用户名

- `hostname`是远程计算机的IP地址或主机名

2. 指定SSH端口:

ssh -p port username@hostname

- `port`是远程计算机上SSH服务的端口号,默认为22

3. 使用密钥进行身份验证:

ssh -i private_key_file username@hostname

- `private_key_file`是本地计算机上的私钥文件路径

4. 传输文件到远程计算机:

scp local_file username@hostname:remote_directory

- `local_file`是本地计算机上的要传输的文件路径

- `remote_directory`是远程计算机上的目标目录路径

5. 从远程计算机下载文件到本地计算机:

scp username@hostname:remote_file local_directory

- `remote_file`是远程计算机上的要下载的文件路径

- `local_directory`是本地计算机上的目标目录路径

这些是一些基本的SSH命令用法,还有其他更高级的用法和选项可以进一步探索。

你可以通过在终端中输入`man ssh`命令来查看SSH的详细用法和选项。

1、复制SSH密钥到目标主机,开启无密码SSH登录 (2)

2、从某主机的80端口开启到本地主机2001端口的隧道 (2)

3、将你的麦克风输出到远程计算机的扬声器 (2)

4、比较远程和本地文件 (2)

5、通过SSH挂载目录/文件系统 (2)

6、通过中间主机建立SSH连接 (2)

7、将你的SSH公钥复制到远程主机,开启无密码登录–简单的方法 (3)

8、直接连接到只能通过主机B连接的主机A (3)

9、创建到目标主机的持久化连接 (3)

10、通过SSH连接屏幕 (3)

11、端口检测(敲门) (3)

12、删除文本文件中的一行内容,有用的修复 (3)

13、通过SSH运行复杂的远程shell命令 (3)

14、通过SSH将MySQL数据库复制到新服务器 (4)

15、删除文本文件中的一行,修复“SSH主机密钥更改”的警告 (4)

16、从一台没有SSH-COPY-ID命令的主机将你的SSH公钥复制到服务器 (4)

17、实时SSH网络吞吐量测试 (4)

18、如果建立一个可以重新连接的远程GNU screen (4)

19、继续SCP大文件 (5)

20、通过SSH W/ WIRESHARK分析流量 (5)

21、保持SSH会话永久打开 (5)

22、更稳定,更快,更强的SSH客户端 (5)

23、使用cstream控制带宽 (5)

24、一步将SSH公钥传输到另一台机器 (6)

25、将标准输入(stdin)复制到你的X11缓冲区 (6)

在这种情况下,最好使用专业的工具。

13、通过SSH运行复杂的远程shell命令

更具移植性的版本:

或。

openwrt ssh命令用法SSH(Secure Shell)是一种网络协议,通过它我们可以在远程网络上进行安全的访问和执行命令。

在OpenWrt路由器上通过SSH访问,可以为用户提供远程管理和配置的便利。

以下是一些常用的OpenWrt SSH命令用法:1. 连接到OpenWrt路由器:使用SSH客户端连接到OpenWrt路由器的方法是在终端中输入以下命令: ```ssh <用户名>@<路由器IP地址>```其中,`<用户名>`是您在OpenWrt路由器上的用户名,`<路由器IP地址>`是路由器的IP地址.例如,如果用户名是"root",路由器IP地址是"192.168.1.1",则命令如下: ```***************.1.1```2. 执行命令:连接成功后,您可以在SSH会话中执行各种命令。

例如,检查网络连接状态可以使用以下命令:```ifconfig```查看系统负载情况可以使用以下命令:```top```安装和更新软件包可以使用以下命令:```opkg install <软件包名称>opkg update```更多命令和用法可以参考OpenWrt官方文档或相关资料。

3. 传输文件:通过SSH还可以通过SCP(Secure Copy)协议传输文件。

使用SCP命令可以将文件从本地电脑复制到OpenWrt路由器上,或者将文件从路由器复制到本地电脑上。

将本地文件复制到路由器上的命令如下:```scp <本地文件路径> <用户名>@<路由器IP地址>:<目标路径>```示例:```scp/path/to/*********************.1.1:/root/remotefile```将路由器上的文件复制到本地电脑上的命令如下:```scp <用户名>@<路由器IP地址>:<源路径> <本地文件路径>```示例:```***************.1.1:/root/remotefile/path/to/localfile```请注意,使用SSH时应格外注意安全性。

ssh命令用法(一)SSH命令使用指南什么是SSH命令SSH(Secure Shell)是一种网络协议,用于在不安全的网络环境中进行安全的远程访问和文件传输。

通过SSH命令,用户可以在本地计算机上执行远程服务器上的命令,也可以从本地向远程服务器传输文件。

SSH命令用法以下是一些常用的SSH命令及其详细解释:1.连接远程服务器:ssh [username]@[host]–username: 远程服务器的用户名–host: 远程服务器的IP地址或域名示例如下:ssh2.指定端口连接:ssh -p [port] [username]@[host]–port: 远程服务器的SSH端口号(默认为22)示例如下:ssh -p 22223.传输文件到远程服务器:scp [file] [username]@[host]:[destination]–file: 本地计算机上要传输的文件路径–destination: 远程服务器上文件的目标路径示例如下:scp /path/to/ :/home/john/files/4.从远程服务器拉取文件到本地计算机:scp [username]@[host]:[file] [destination]–file: 远程服务器上要拉取的文件路径–destination: 本地计算机上文件的目标路径示例如下:scp :/home/john/files/ /path/to/destinatio n/5.执行远程命令并返回结果:ssh [username]@[host] [command]–command: 要在远程服务器上执行的命令示例如下:ssh "ls -l /home/john"6.创建SSH密钥对:ssh-keygen -t rsa该命令会生成存储在用户主目录下的SSH密钥对(公钥和私钥),用于身份验证。

7.将公钥复制到远程服务器:ssh-copy-id -i ~/.ssh/id_ [username]@[host]–~/.ssh/id_: 本地计算机上的公钥文件路径示例如下:ssh-copy-id -i ~/.ssh/id_总结SSH命令是一种非常强大的远程访问和文件传输工具。

# du -sh # 查看指定目录的大小# uptime # 查看系统运行时间、用户数、负载# cat /proc/loadavg # 查看系统负载# iptables -L # 查看防火墙设置# route -n # 查看路由表# netstat -lntp # 查看所有监听端口# netstat -antp # 查看所有已经建立的连接# netstat -s # 查看网络统计信息# w # 查看活动用户# id # 查看指定用户信息# last # 查看用户登录日志# cut -d: -f1 /etc/passwd # 查看系统所有用户# cut -d: -f1 /etc/group # 查看系统所有组# crontab -l # 查看当前用户的计划任务# chkconfig --list # 列出所有系统服务# chkconfig --list | grep on # 列出所有启动的系统服务备份网站wget -mk -w 1 /命令行中的20代表间隔20秒下载一个文件# rpm -qa # 查看所有安装的软件包b~s 文档末尾Hjkl 移动光标:q! 不存盘就退出ZZ 保存后退出u 撤消上一次操作U 撤消对本行的所有修改rm -rf wordpress 删除/<文本>将向前查找, ?<文本>将向后查找. ??或者//将重复上次查找vi /etc/httpd/conf/httpd.conf编辑Apache的配置文件su 切换用户升级PHPStep 1) Set up the atomic channel:wget -q -O - /installers/atomic.sh | shStep 2) Upgrade to PHP 5.2.x:yum upgradeStep 3) Replace the PHP 4 php.ini with PHP 5.2.x's (if applicable):mv /etc/php.ini.rpmnew /etc/php.iniStep 4) Replace the php.conf with the PHP 5.2.x php.conf (if applicable):mv /etc/httpd/conf.d/php.conf.rpmnew /etc/httpd/conf.d/php.conf参考网址:/wiki/index.php/PHPCrontab 定时执行任务在DreamHost系统下, 通过Shell可以建立自己的crontab. 具体使用如下:使用支持shell登录的终端(如fterm或putty), 地址栏输入username@:22即可以SSH方式登录至服务器. 常用的crontab命令:crontab -l 显示所有现存cron job.crontab -r 删除当前cron jobs.crontab -e 编辑当前“crontab file”. DH推荐使用nano注意你的crontab包含所有的cron jobs, 每个cron一行, 断行结尾. 一个正常的cron如下所示:45 2 * * * /home/user/script.pl第一个数字是每小时的第几分钟,第二个数字是每天的第几小时,第三个数字是每月的第几天,第四个数字是每年的第几月,第五个数字是每周的第几天.使用方式例如:32 * * * * : 表示每小时的第32分钟.12,42 * * * * : 表示每小时的第12及第42分钟两次*/15 */2 * * *: 表示0:00, 0:15, 0:30, 0:45, 2:00, 2:15, 2:30, …43 18 * * 7: 表示每个周日的6:43pm运行命令行.。

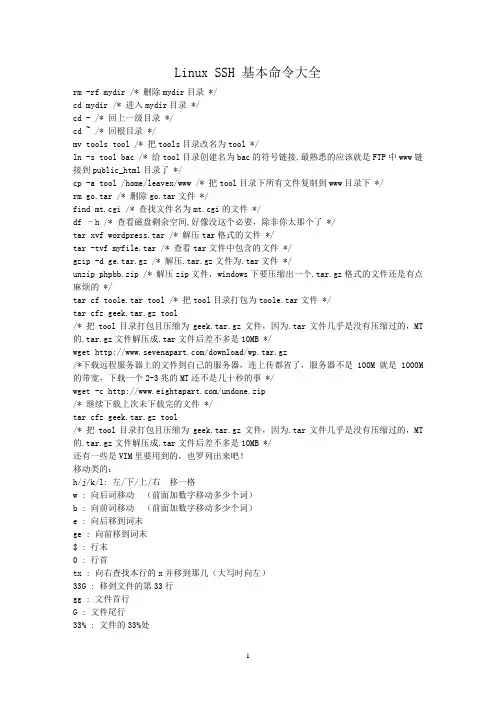

Linux SSH 基本命令大全rm -rf mydir /* 删除mydir目录 */cd mydir /* 进入mydir目录 */cd - /* 回上一级目录 */cd ~ /* 回根目录 */mv tools tool /* 把tools目录改名为tool */ln -s tool bac /* 给tool目录创建名为bac的符号链接,最熟悉的应该就是FTP中www链接到public_html目录了 */cp -a tool /home/leavex/www /* 把tool目录下所有文件复制到www目录下 */rm go.tar /* 删除go.tar文件 */find mt.cgi /* 查找文件名为mt.cgi的文件 */df –h /* 查看磁盘剩余空间,好像没这个必要,除非你太那个了 */tar xvf wordpress.tar /* 解压tar格式的文件 */tar -tvf myfile.tar /* 查看tar文件中包含的文件 */gzip -d ge.tar.gz /* 解压.tar.gz文件为.tar文件 */unzip phpbb.zip /* 解压zip文件,windows下要压缩出一个.tar.gz格式的文件还是有点麻烦的 */tar cf toole.tar tool /* 把tool目录打包为toole.tar文件 */tar cfz geek.tar.gz tool/* 把tool目录打包且压缩为geek.tar.gz文件,因为.tar文件几乎是没有压缩过的,MT 的.tar.gz文件解压成.tar文件后差不多是10MB */wget /download/wp.tar.gz/*下载远程服务器上的文件到自己的服务器,连上传都省了,服务器不是100M就是1000M 的带宽,下载一个2-3兆的MT还不是几十秒的事 */wget -c /undone.zip/* 继续下载上次未下载完的文件 */tar cfz geek.tar.gz tool/* 把tool目录打包且压缩为geek.tar.gz文件,因为.tar文件几乎是没有压缩过的,MT 的.tar.gz文件解压成.tar文件后差不多是10MB */还有一些是VIM里要用到的,也罗列出来吧!移动类的:h/j/k/l: 左/下/上/右移一格w : 向后词移动(前面加数字移动多少个词)b : 向前词移动(前面加数字移动多少个词)e : 向后移到词末ge : 向前移到词末$ : 行末0 : 行首tx : 向右查找本行的x并移到那儿(大写时向左)33G : 移到文件的第33行gg : 文件首行G : 文件尾行33% : 文件的33%处H/M/L : 屏幕的首/中/尾行zt/zz/zb : 当前行移到屏幕的首/中/底部跳转:” : 回到跳转来的地方CTRL-O : 跳到一个“较老” 的地方CTRL-I : 则跳到一个“较新” 的地方查找:/ : 向下查找(后加关键字)? : 向上查找(后加关键字)n : 下一条符合的记录编辑:i : 转换到插入模式x : 删除当前字符. : 重复最后一次的修改操作(同PS里ctrl+f执行滤镜)u : 撤销操作CTRL-R : 重做p : 将删除的字符插入到当前位置(put)退出保存::q : 退出:q! : 不保存退出ZZ : 保存后退出:e! : 放弃修改重新编辑退出SSH后,继续运行!#nohup wget /file.tar.gz &wget是一个Linux环境下用于从World Wide Web上提取文件的工具,这是一个GPL许可证下的自由软件,其作者为Hrvoje Niksic 。

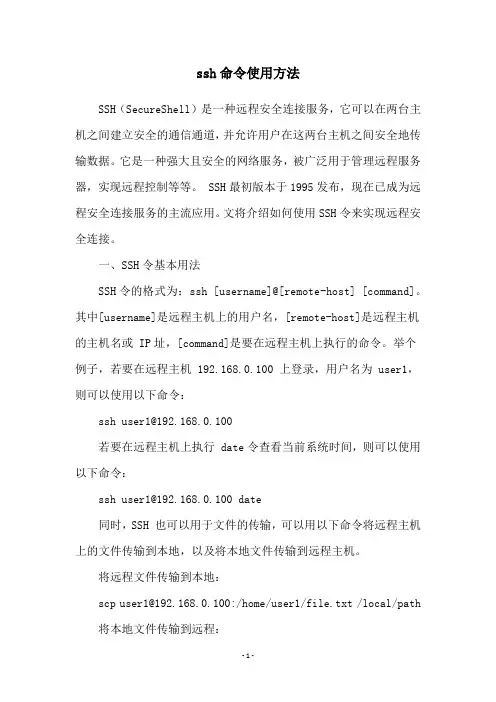

ssh命令使用方法SSH(SecureShell)是一种远程安全连接服务,它可以在两台主机之间建立安全的通信通道,并允许用户在这两台主机之间安全地传输数据。

它是一种强大且安全的网络服务,被广泛用于管理远程服务器,实现远程控制等等。

SSH最初版本于1995发布,现在已成为远程安全连接服务的主流应用。

文将介绍如何使用SSH令来实现远程安全连接。

一、SSH令基本用法SSH令的格式为:ssh [username]@[remote-host] [command]。

其中[username]是远程主机上的用户名,[remote-host]是远程主机的主机名或 IP址,[command]是要在远程主机上执行的命令。

举个例子,若要在远程主机 192.168.0.100 上登录,用户名为 user1,则可以使用以下命令:若要在远程主机上执行 date令查看当前系统时间,则可以使用以下命令:同时,SSH 也可以用于文件的传输,可以用以下命令将远程主机上的文件传输到本地,以及将本地文件传输到远程主机。

将远程文件传输到本地:scp /local/path 将本地文件传输到远程:scp /local/path *************.0.100:/home/user1/file.txt二、SSH户端设置使用SSH令需要在客户端主机上安装SSH户端软件,这可以通过在客户端下载、安装SSH户端软件来完成。

各类现代操作系统(如Linux、Mac OS)都自带SSH户端,无需再另外安装,但Windows作系统中则需要安装独立的SSH户端软件。

安装相关软件之后,就可以使用ssh令来连接远程主机,使用password验证身份。

但安全性较弱,可以使用公钥认证,从而提高安全性。

三、SSH钥认证使用SSH钥认证的原理非常简单,主要由两部分组成:公钥和私钥,其中公钥是公开的,可以传输到需要认证的远程主机上,私钥是保存在本地的,用来签署消息,以确认身份。

SSH(Secure Shell Client)常用命令一、ls 只列出文件名(相当于dir,dir也可以使用)-A:列出所有文件,包含隐藏文件。

-l:列表形式,包含文件的绝大部分属性。

-R:递归显示。

--help:此命令的帮助。

二、cd 改变目录cd /:进入根目录cd :回到自己的目录(用户不同则目录也不同,root为/root,xxt为/home/xxtcd ..:回到上级目录pwd:显示当前所在的目录三.less 文件名:查看文件内容。

tail -f 日志名:查看日志四.q 退出打开的文件。

五.上传文件:rz 选择要传送的文件,确定。

六.下载文件:sz 指定文件名,enter敲,即下载到了secureCRT/download目录下。

七:删除文件:rm 删除文件,rmdir 删除空目录。

rm -rf 强行删除非空目录八.显示最近输入的20条命令:history 20九.获得帮助命令--help查看命令下详细参数:如:rz --help ,sz --help 。

十.cd 进入某个文件夹的命令:mkdir+文件夹名创建某个文件夹的命令sz+文件名从服务器端向本机发送文件的命令rz 从本机向服务器端传送文件的命令ll 列出当前目录下的所有文件,包括每个文件的详细信息dir 对当前文件夹vi 打开当前文件十一.在编辑某个文件的时候:a 切换到编辑模式ctrl+c 退出编辑模式dd 删除整行:q 退出当前文件:w 写入并保存当前文件-f 强行xx的参数。

其它命令:1.ps -ef //查看server的进程,以列表形式显示的server进程。

ps 显示当前在系统运行的进程/usr/bin/ps [选项] -e 显示每个现在运行的进程-f 生成一个完全的列表2.ant -buildfile CMS_MainTrunk.xml //build 包3.vi test.txt //浏览文件内容i {insert写输入}esc 退出insert:wq! write 保存并退出vi模式:q! 不保存退出vi模式4、secureCRT中乱码解决:Options->SessionOptions->Appearance->font把default改成UTF-8,就可以显示中文字体了。

ssh命令常⽤的ssh命令cd 切换⽬录1.查看⽇志:举例: tail -f tomcat/apache-tomcat-6.0.26/logs/catalina.2010-11-10.out2.pwd 查看当前⽬录3.cd ../ 回上⼀级⽬录4. ./ shutdown.sh,./ startup.sh关闭和启动tomcat服务 ./catalina.sh run 带tomcat 控制台输出的tomcat 启动5.拷贝⽂件cp6.删除⽂件rm (-rf,表⽰强制删除),移动⽂件mv7.查看及终⽌进程 ps -ef | grep tomcat ,kill - 9 进程ID8.查看⽂件列表ll或ls或dir查看⽂件⼤⼩ du -sh (⼦⽬录)单位是M9.mkdir 创建⽬录 mkdir -P /www/ep/aaa/bbb10.tar -zcvf xxxxxxxxx.tar.gz 源⽂件(⽂件夹或⽂件都⾏)tar -zxvf xxxxxxxxx.tar.gz 解压⽂件su - (以root登录) root密码baidu123cp *。

imp 到/home/oracle/database_bak更改⽤户组 chown oracle:oracle .chown -R res:res ⽂件名切换到 oracle ⽤户 : su - oracle 密码:abc123执⾏导⼊命令 imp common/cnnic file=xxxx tables=xxx导出命令: exp common/cnnic file=xxxx tables =xxx编辑⽂件vi ****.txti ----表⽰进⼊插⼊模式,可以进⾏编辑了编辑好之后,按“ESC”,然后再输⼊“:”,然后输⼊“wq”就表⽰保存退出,若不想保存,输⼊“q!”,就退出了linux⽂件管理是以层级式⽅式管理根⽬录就是“/”,重要⽬录root:存放root⽤户相关的⽂件home:存放普通⽤户的相关⽂件bin:存放常⽤命令的⽬录sbin:存放需要⼀定权限才能使⽤的命令mnt:默认的挂载光驱软驱的⽬录(也可以不挂载在这)boot:存放引导相关的⽂件etc:存放配置相关⽂件,⽐如环境变量,mysql配置等等var:存放变化的⽂件usr:⽂件默认安装的⽂件夹添加⽤户useradd xiaoming设密码passwd xiaoming然后输密码即可,su - xiaoming 以⼩明的⾝份来操作 #号变$符号删除⽤户(两种)userdel xiaoming 此命令只删除⽤户,但xiaoming⽂件夹还在userdel -r xiaoming 此命令删除⽤户和⽤户的主⽬录linux运⾏级别(0,1,2,3,4,5,6)七个级别,重要概念(在 etc/inintab⽂件中改)0,关机(系统开机了就关机)1,单⽤户2,多⽤户没⽹络服务3,多⽤户有⽹络服务(⽤的最多)4.,系统未使⽤保留给⽤户5,图形界⾯(⼀开机就进⼊图形界⾯)6,系统重启(⼀直重启)ls 显⽰⽂件和⽬录的命令ls -a 显⽰隐藏⽂件ls -l 显⽰长列表格式ls -al 兼容上⾯两种形式显⽰mkdir 建⽴⽬录 mkdir aaarmdir 删除空⽬录 rmdir aaatouch 建空⽂件 cp mv rmmore 带分页显⽰ “空格”下⼀页 “PageUp”上⼀页“|”,管道命令(把前⾯命令的结果交给后⾯的命令处理)grep 查找⽂本 grep abc tt.txt (在tt.txt中查找abc)man ⼿册的意思(相当于windows下⾯的help)find 查找⽂件find /home/res/tmp/android/ -name readme.txt 在这个⽬录下以name查找,也就是查找⽂件名为readme.txt的⽂件重定向命令ls -l > a.txt 把列表的内容写到a.txt中 (覆盖写)ls -l >> a.txt 把列表的内容写到a.txt中(追加写)⽂件权限⽤户组groupadd aaa --添加组aaavi /etc/group 或 cat /etc/group --查看组useradd -g aaa yanxing --创建⽤户yangxing并添加到aaa组vi /etc/passwd 或 cat /etc/passwd --查看⽤户 res:x:608:608::/home/res:/bin/bash 第⼀个608是⽤户id,第⼆个608是组的id,/home/res 是该⽤户主⽬录,/bin/bash 是shell解析器举例说明:-rw-r--r-- 1 res res 4829 May 13 14:11 dom4j.txt-rw-r--r-- 表⽰各类⽤户对该⽂件的访问权限,第⼀个“-”表⽰⽂件类型,如果是“-”表⽰是普通⽂件rw- 表⽰⽂件所有者对该⽂件的权限(r(或4),可读,w(或2),可写,x(或1)可执⾏)r-- ⽂件所在组对该⽂件的权限r-- 其他组(的⽤户)对该⽂件的权限res res 分别表⽰⽤户和组修改⽂件的访问权限的问题chmod 777 res --第⼀个7对所有者修改,第⼆个7对所在组修改,第三个7表⽰对其他组的权限(4,2,1)usermod -g 组名⽤户名 --更改⽤户的⽤户组chown ⽤户名⽂件名 ---修改⽂件的所有者chgrp 组名⽂件名 --修改⽂件所在的组linux 分区基本分区扩展分区(不能直接使⽤,要分成逻辑分区)逻辑分区(理论上没有数量限制)基本分区+扩展分区<=4 个安装(略)samba (⽤于linux和windows的⽂件共享、传输等)shell (解析命令给内核,shell编程),常⽤的有三种:bash,csh,kshenv --查看当前操作系统的环境变量chsh -s 新的shell(如:/bin/csh) --改变系统的shell命令补全 tab键history --查看输⼊的命令的历史记录history 10 --最近执⾏的10条命令!5 --执⾏编号为5的命令tcp/ipln -s 源⽬标 ---建⽴连接⽂件,类似于windows的快捷⽅式mv 源⽂件⽬标⽂件unzip 解压⽂件rm -rf 删除⽂件1 :连接oraclesu - oracleabc123sqlplus /nologconn /as sysdbalsnrctl status 监听状态2:scp -rp /home/oracle/test/test.dmp oracle@218.241.108.14:/home/oracle/test 3: netstats - anp |grep oracle wl -c。

SSH常用命令目录操作:rm -rf mydir /*删除mydir目录*/cd mydir /*进入mydir目录*/cd – /*回上一级目录*/cd .. /*回父目录,中间有空格*/cd ~ /*回根目录*/mv tools tool /*把tools目录改名为tool */ln -s tool bac /*给tool目录创建名为bac的符号链接,最熟悉的应该就是FTP中www链接到public_html 目录了*/cp -a tool /home/vpser/www /*把tool目录下所有文件复制到www目录下 */文件操作:rm go.tar /* 删除go.tar文件 */find mt.cgi /* 查找文件名为mt.cgi的文件 */df –h /* 查看磁盘剩余空间,好像没这个必要,除非你太那个了 */解压缩:tar xvf wordpress.tar /* 解压tar格式的文件 */tar -tvf myfile.tar /* 查看tar文件中包含的文件 */tar cf toole.tar tool /* 把tool目录打包为toole.tar文件 */tar cfz vpser.tar.gz tool /* 把tool目录打包且压缩为vpser.tar.gz文件,因为.tar文件几乎是没有压缩过的,MT的.tar.gz文件解压成.tar文件后差不多是10MB */tar jcvf /var/bak/www.tar.bz2 /var/www/ /*创建.tar.bz2文件,压缩率高*/tar xjf www.tar.bz2 /*解压tar.bz2格式*/gzip -d ge.tar.gz /* 解压.tar.gz文件为.tar文件 */unzip phpbb.zip /* 解压zip文件,windows下要压缩出一个.tar.gz格式的文件还是有点麻烦的 */ 下载:wget /web/nginx/nginx-0.8.0.tar.gz/*下载远程服务器上的文件到自己的服务器,连上传都省了,服务器不是100M就是1000M的带宽,下载一个2-3兆的MT还不是几十秒的事 */wget -c /web/nginx/nginx-0.8.0.tar.gz/* 继续下载上次未下载完的文件 */进程管理:ps -aux /*ps 进程状态查询命令*/ps命令输出字段的含义:[list][*]USER,进程所有者的用户名。

命令vim /etc/sysconfig/network 改主机名uname -a 查看当前机器的架构i386uname -r 查看当前的内核版本cat /etc/redhat-release 查看当前系统版本whoami 查看当前登录的用户hostname 查看当前的主机名临时改主机名hostname [主机名]pwd 查看当前目录su 普通切换用户su -递归切换用户(包括权限)gedit 创建新的空白文件cd 切换目录~用户的家目录. 表示当前目录.. 表示上一级目录-返回上一次所在的目录cd 返回用户的家目录ls 显示当前目录下有那些文件ls /目录显示指定目录下有那些文件命令的语法格式:命令的名称[选项][参数]命令可以单独使用,可以不带选项和参数,命令后必须要加空格可以通过颜色区分文件的类型:蓝色代表目录浅蓝色代表连接文件黑色或灰色代表普通文本文件黄色代表设备文件如/dev下的文件红色代表压缩文件绿色代表有执行权限的文件.conf 代表配置文件.tar代表压缩文件/bin 普通可以使用的命令/sbin 特权用户可以使用的命令/lib 应用程序在运行过程中调用的库文件/media与/mnt 用来挂载移动设备的目录挂载u盘:如果是fat格式的U盘,挂载命令:mount -t vfat /dev/sdb1 /mnt/udisk如果是ntfs格式的U盘,挂载命令:mount -t ntfs-3g /dev/sdb1 /mnt/udisk 但是注意,ntfs格式要挂载的话,需要下载一个ntfs-3g-2011.4.12 /etc 应用程序配置文件存放的目录/dev 设备文件存放的目录/home 普通用户的家目录/root 管理员的家目/lost+found 存放磁盘检测时产生的磁盘碎片文件/opt 应用程序默认安装目录/proc 虚拟目录不占用系统磁盘空间/selinux 与selinux程序相关的文件/tftpboot tftp工作目录/tmp 临时文件/var 存放变化文件(各种服务的日志文件)/usr 安装源码文件时源码包文件存放的位置相对路径.. 绝对路径/相对路径是从当前目录为起点绝对路径是从根目录为起点ls -l 是长格式显示ls -a 显示所有内容(包括隐藏文件)隐藏文件以.开头ls -d 显示单个目录的文件属性ls -R 递归显示指定目录下的文件信息mkdir 目录的名字(名字不可重名区分大小写)创建目录(可指定路径)mkdir -p 同时创建多级子目录mkdir -m 创建目录时指定目录的权限rmdir 删除目录命令(只能删除空目录)rm -rf 删除非空目录及文件-r 递归 f 强制touch 创建空文件、更改文件的时间date 查看时间和日期修改时间和日期语法date “+参数” %Y4位的年%m两位的月%d两位的日%H小时%M分钟%S秒时间和日期的修改:日期date -s “20120314” 修改时间date -s“10.15.20”stat 文件名查看文件的状态、详细信息file 文件名查看文件的类型查看文件是否为空mv 移动、重命名cp 拷贝命令(文件的复制)不加参数只能考单个文件,要拷贝文件夹要加-r参数。

安全外壳协议(SSH)是一种在不安全网络上提供安全远程登录及其它安全网络服务的协议。

SecureShell,又可记为SSH,最初是UNIX系统上的一个程序,后来又迅速扩展到其他操作平台。

SSH是一个好的应用程序,在正确使用时,它可以弥补网络中的漏洞。

既然申请了国外的主机,那么SSH登录工具肯定是必不可少的,这里罗列一些常用的SSH命令,以备查用。

操作系统与外部最主要的接口就叫做shell,或许这样说过于术语化,例如cmd命令行,这是windows操作系统下的一个shell。

这里说的dreamhost的shell是指dreamhost提供给客户一个命令行,方便客户更好的使用他们的虚拟主机服务。

DreamHost中shell使用指南本shell指令及操作均基于Linuxord2.4.29,即DreamHost现在采用的系统,如果你也是DreamHost的用户,那本文或许对你有所帮助。

目录:1.BasicInstructions/基本2.wget/下载工具3.Crontab/定时任务4.tar/tar.gz/压缩文件5.查看文件大小cd[目录名]转换路径cd..返回上级目录ls显示当前目录下所有文件rm[-r]-f[][文件名]删除文件,加[-r]可以删除文件下所有子文件,如rm-rf[abc]删除abc文件夹及文件夹下的所有文件tar-[解压下载的压缩包]unzip[文件名]解压文件cp-rpf.A/*B将A文件夹中的所有文件拷贝到其上级目录B中wget(最爽的一个命令在linux下可以使用该工具快速地从网络上下载所需要的文件)SSH命令1.BasicInstructions基本操作命令通常来说,使用”$[Instructions]-help”可以获得以下各个命令[instructions]的帮助,包含其参数列表的定义。

-ls列出当前文件夹下所有内容$ls-o列出当前文件夹中所有内容,含详细信息,但不列出group$ls-l同上,含group信息$ls-a列出当前文件夹中所有内容,包含以”.”开头的文件$ls-t按更改时间排序$ls-v按版本-cd[dir]进入文件夹cd..退出当前文件夹,返回上级目录-pwd显示当前路径-mkdir[dir]新建文件夹-chmod更改文件/文件夹权限$chmod[Mode][dir],其中Mode形如”755″或”777″等。

putty ssh命令参数

putty是一个免费的SSH和telnet客户端,用于在Windows上远程连接到Linux服务器。

以下是一些常用的putty SSH命令参数:

1. -ssh :使用SSH协议进行连接。

2. -P port :指定要连接的服务器的端口号。

3. -l login-name :指定登录服务器的用户名。

4. -pw password :指定登录服务器的密码。

5. -i private-key-file :指定使用的私钥文件。

6. -m file :从文件中读取命令并在连接后执行。

7. -N :不打开远程登录窗口。

8. -L [local-host:]local-port:remote-host:remote-port :将本地端口转发到远程服务器。

9. -R [remote-host:]remote-port:local-host:local-port :将远程端口转发到本地机器。

10. -v :打开详细日志记录。

这些参数可以根据需要进行组合使用,根据具体情况来决定使用哪些参数。

ssh命令详解SSH 的详细使⽤⽅法如下:ssh [-l login_name] [hostname | user@hostname] [command] ssh [-afgknqtvxCPX246] [-c blowfish | 3des] [-e escape_char] [-i identity_file] [-l login_name] [-o option] [-p port] [-L port:host:hostport] [-R port:host:hostport] [hostname | user@hostname] [command]sshd为执⾏ ssh 的 daemon,在读者使⽤ ssh 之前必须去激活 sshd,在此建议把它加在 /etc/init/rc.local 中,在每次开机时激活。

在执⾏ sshd 之前可以指定它的 port,例如:sshd –p 999若有安装 SSL,可以指定 SSL 的 port 443,例如:sshd –p 443这样就可以经过 SSL 及 SSH 双重的保护,但必须去指明使⽤的 portssh –l user –p 443 .tw 才⾏,若不指明则仍然使⽤预设的port 22ssh选项:-l login_name指定登⼊于远程机器上的使⽤者,若没加这个选项,⽽直接打 ssh lost 也是可以的,它是以读者⽬前的使⽤者去做登⼊的动作。

例如: ssh –l shie .tw-c blowfish|3des在期间内选择所加密的密码型式。

预设是3des,3des(作三次的资料加密) 是⽤三种不同的密码键作三次的加密-解密-加密。

blowfish 是⼀个快速区块密码编制器,它⽐3des更安全以及更快速。

-vVerbose 模式。

使ssh 去印出关于⾏程的除错讯息,这在连接除错,认证和设定的问题上有很的帮助。

-V显⽰版本。

-a关闭认证代理联机。

Linux SSH 基本命令大全rm -rf mydir /* 删除mydir目录 */cd mydir /* 进入mydir目录 */cd - /* 回上一级目录 */cd ~ /* 回根目录 */mv tools tool /* 把tools目录改名为tool */ln -s tool bac /* 给tool目录创建名为bac的符号链接,最熟悉的应该就是FTP中www链接到public_html目录了 */cp -a tool /home/leavex/www /* 把tool目录下所有文件复制到www目录下 */rm go.tar /* 删除go.tar文件 */find mt.cgi /* 查找文件名为mt.cgi的文件 */df –h /* 查看磁盘剩余空间,好像没这个必要,除非你太那个了 */tar xvf wordpress.tar /* 解压tar格式的文件 */tar -tvf myfile.tar /* 查看tar文件中包含的文件 */gzip -d ge.tar.gz /* 解压.tar.gz文件为.tar文件 */unzip phpbb.zip /* 解压zip文件,windows下要压缩出一个.tar.gz格式的文件还是有点麻烦的 */tar cf toole.tar tool /* 把tool目录打包为toole.tar文件 */tar cfz geek.tar.gz tool/* 把tool目录打包且压缩为geek.tar.gz文件,因为.tar文件几乎是没有压缩过的,MT 的.tar.gz文件解压成.tar文件后差不多是10MB */wget /download/wp.tar.gz/*下载远程服务器上的文件到自己的服务器,连上传都省了,服务器不是100M就是1000M 的带宽,下载一个2-3兆的MT还不是几十秒的事 */wget -c /undone.zip/* 继续下载上次未下载完的文件 */tar cfz geek.tar.gz tool/* 把tool目录打包且压缩为geek.tar.gz文件,因为.tar文件几乎是没有压缩过的,MT 的.tar.gz文件解压成.tar文件后差不多是10MB */还有一些是VIM里要用到的,也罗列出来吧!移动类的:h/j/k/l: 左/下/上/右移一格w : 向后词移动(前面加数字移动多少个词)b : 向前词移动(前面加数字移动多少个词)e : 向后移到词末ge : 向前移到词末$ : 行末0 : 行首tx : 向右查找本行的x并移到那儿(大写时向左)33G : 移到文件的第33行gg : 文件首行G : 文件尾行33% : 文件的33%处H/M/L : 屏幕的首/中/尾行zt/zz/zb : 当前行移到屏幕的首/中/底部跳转:” : 回到跳转来的地方CTRL-O : 跳到一个“较老” 的地方CTRL-I : 则跳到一个“较新” 的地方查找:/ : 向下查找(后加关键字)? : 向上查找(后加关键字)n : 下一条符合的记录编辑:i : 转换到插入模式x : 删除当前字符. : 重复最后一次的修改操作(同PS里ctrl+f执行滤镜)u : 撤销操作CTRL-R : 重做p : 将删除的字符插入到当前位置(put)退出保存::q : 退出:q! : 不保存退出ZZ : 保存后退出:e! : 放弃修改重新编辑退出SSH后,继续运行!#nohup wget /file.tar.gz &wget是一个Linux环境下用于从World Wide Web上提取文件的工具,这是一个GPL许可证下的自由软件,其作者为Hrvoje Niksic 。

wget支持HTTP和FTP协议,支持代理服务器和断点续传功能,能够自动递归远程主机的目录,找到合乎条件的文件并将其下载到本地硬盘上;如果必要,wget将恰当地转换页面中的超级连接以在本地生成可浏览的镜像。

由于没有交互式界面,wget可在后台运行,截获并忽略HANGUP信号,因此在用户推出登录以后,仍可继续运行。

通常,wget用于成批量地下载Internet网站上的文件,或制作远程网站的镜像。

语法:wget [options] [URL-list]URL地址格式说明:可以使用如下格式的URL:http://host[:port]/path例如:.fer.hr/ftp:///pub/xemacs/xemacs-19.14.tar.gzftp://username:password@host/dir/file在最后一种形式中,以URL编码形式为FTP主机提供了用户名和密码(当然,也可以使用参数提供该信息,见后)。

参数说明:wget的参数较多,但大部分应用只需要如下几个常用的参数:-r 递归;对于HTTP主机,wget首先下载URL指定的文件,然后(如果该文件是一个HTML 文档的话)递归下载该文件所引用(超级连接)的所有文件(递归深度由参数-l指定)。

对FTP主机,该参数意味着要下载URL指定的目录中的所有文件,递归方法与HTTP主机类似。

-N 时间戳:该参数指定wget只下载更新的文件,也就是说,与本地目录中的对应文件的长度和最后修改日期一样的文件将不被下载。

-m 镜像:相当于同时使用-r和-N参数。

-l 设置递归级数;默认为5。

-l1相当于不递归;-l0为无穷递归;注意,当递归深度增加时,文件数量将呈指数级增长。

-t 设置重试次数。

当连接中断(或超时)时,wget将试图重新连接。

如果指定-t0,则重试次数设为无穷多。

-c 指定断点续传功能。

实际上,wget默认具有断点续传功能,只有当你使用别的ftp工具下载了某一文件的一部分,并希望wget接着完成此工作的时候,才需要指定此参数。

使用举例:wget -m -l4 -t0 /将在本地硬盘建立/的镜像,镜像文件存入当前目录下一个名为的子目录中(你也可以使用-nH参数指定不建立该子目录,而直接在当前目录下建立镜像的目录结构),递归深度为4,重试次数为无穷(若连接出现问题,wget将坚韧不拔地永远重试下去,知道任务完成!)另外一些使用频率稍低的参数如下:-A acclist / -R rejlist:这两个参数用于指定wget接受或排除的文件扩展名,多个名称之间用逗号隔开。

例如,假设我们不想下载MPEG视频影像文件和.AU声音文件,可使用如下参数:-R mpg,mpeg,au其它参数还有:-L 只扩展相对连接,该参数对于抓取指定站点很有用,可以避免向宿主主机的其他目录扩散。

例如,某个人网站地址为:/~ppfl/,使用如下命令行:wget -L /~ppfl/则只提取该个人网站,而不涉及主机上的其他目录。

-k 转换连接:HTML文件存盘时,将其中的非相对连接转换成为相对连接。

-X 在下载FTP主机上的文件时,排除若干指定的目录另外,下面参数用于设置wget的工作界面:-v 设置wget输出详细的工作信息。

-q 设置wget不输出任何信息。

如果我们已经在一个HTML文档(或普通文本文档)中存储了所要提取的文件的连接,可以让wget直接从该文件中提取信息,而不用在命令行中提供URL地址,参数格式为:-i filename 地址文件也可以不是HTML文档,例如,一个普通的文本文件,其中有需要下载的URL列表即可。

我们可以用以下技巧提高下载速度:由于Linux是一个多任务系统,我们可以同时运行多个wget进程以提高下载速度,例如,先下载某主页文件(index.html),然后将该文件所列出的所有地址分别用一个独立的wget进程进行下载。

至于其他的参数,可参考wget的man手册页,命令为:man wgetPost in LAMP | No Comments »DreamHost中shell使用指南1. Basic Instructions基本操作命令通常来说,使用”$[Instructions] –help”可以获得以下各个命令[instructions]的帮助,包含其参数列表的定义。

-ls 列出当前文件夹下所有内容$ls -o 列出当前文件夹中所有内容,含详细信息,但不列出group$ls -l 同上,含group信息$ls -a 列出当前文件夹中所有内容,包含以”.”开头的文件$ls -t 按更改时间排序$ls -v 按版本先后排序-cd [dir] 进入文件夹-pwd 显示当前路径-mkdir [dir] 新建文件夹-chmod 更改文件/文件夹权限$chmod [Mode] [dir],其中Mode形如”755″或”777″等。

$chmod [Mode] [file]$chmod -R [Mode] [dir],递归形式,即将目标文件夹内所有文件均改变权限Mode还有另一种表达方式,”755″即为”-rwxr-xr-x”,不列举了。

-rm [file] 删除文件/文件夹$rm -f [file] 强行删除,忽略不存在的文件,无提示$rm -r [file] 递归删除所有内容-cp 拷贝$cp [options] [source] [destination]其中[options]可以为-f(强行拷贝)或-r(递归拷贝)-mv 重命名或移动$mv [options] [source] [destination][options]常用:-f(强行移动/重命名), -i(移动/重命名前尝试), -u(更新)例如$mv wwwroot/cgi-bin . 将/cgi-bin目录移动到当前目录下$mv cronfile.txt myfile.txt 将cronfile.txt重命名为myfile.txt2. wget下载工具wget是一种非交互式的网络文件下载工具,在linux下可以使用该工具快速地从网络上下载所需要的文件而不需要经由本地硬盘中转,而且速度极快。

以下是一些使用方法:wget [参数列表] URL最简单的用法:$wget /file.tarwget的常用参数:· -t [nuber of times]:尝试次数,当wget无法与服务器建立连接时,尝试连接多少次。

比如”-t120″表示尝试120次。

当这一项为”0″的时候,指定尝试无穷多次直到连接成功为止,这个设置非常有用,当对方服务器突然关机或者网络突然中断的时候,可以在恢复正常后继续下载没有传完的文件;· -c:断点续传,这也是个非常有用的设置,特别当下载比较大的文件的时候,如果中途意外中断,那么连接恢复的时候会从上次没传完的地方接着传,而不是又从头开始,使用这一项需要远程服务器也支持断点续传,一般来讲,基于UNIX/linux的Web/FTP服务器都支持断点续传;· -T [number of seconds]:超时时间,指定多长时间远程服务器没有响应就中断连接,开始下一次尝试。