第6章基于产生式规则机器推理

- 格式:ppt

- 大小:497.50 KB

- 文档页数:58

人工智能导论课程教学大纲廉师友编写清华大学出版社(2020)说明为了方便各位任课老师的教学,本书作者结合自己多年来给计算机专业讲授人工智能课程的教学大纲和这部《人工智能导论》新教材的内容以及该课程的基本要求,制定了这一新的教学大纲,供各位老师参考。

从内容来看,这个大纲与这部新教材是一致的,其课时应该说已达到这门课程的上限。

各位老师可根据各自院校的实际情况对该大纲的教学内容进行取舍,并确定相应的课时,以制定适合各自教学任务的教学大纲。

希望这份资料对各位任课老师的教学能有所裨益和帮助!当然,若发现其中有不妥或错误之处也请指正!作者2020年3月《人工智能导论》课程教学大纲课程编号:英文课名:Introduction to Artificial Intelligence适用专业:人工智能、计算机、自动化和电子信息类专业(考试)学时:90 学分:课程类别:专业课课程性质:必修课/必选课一、课程性质和目的《人工智能导论》为人工智能、计算机、自动化和电子信息类专业的一门必修或必选课程,其目的是使学生理解人工智能的基本原理,初步学习和掌握人工智能的基本技术,为进一步学习人工智能后续专业课程或从事人工智能的研发奠定基础,指引方向。

二、课程内容第1章人工智能概述基本内容和要求:1.理解人工智能的概念、目标和研究策略;2.理解人工智能的研究内容与方法;3.了解人工智能的分支领域;4.了解人工智能的应用与发展概况。

第2章人工智能程序设计语言基本内容和要求:1.了解人工智能程序设计语言的特点、分类和发展概况;2.理解PROLOG语言的语句特点、程序结构和运行机理,能读懂和编写简单的PROLOG 程序;3.了解Python语言的特点和使用方法,能读懂和编写简单的Python程序。

教学重点:1.PROLOG语言;2.Python语言。

教学难点:1.PROLOG语言的匹配合一和回溯控制;2.Python语言的程序结构和资源库的使用。

《人工智能概论》课程笔记第一章人工智能概述1.1 人工智能的概念人工智能(Artificial Intelligence,简称AI)是指使计算机具有智能行为的技术。

智能行为包括视觉、听觉、语言、学习、推理等多种能力。

人工智能的研究目标是让计算机能够模拟人类智能的某些方面,从而实现自主感知、自主决策和自主行动。

人工智能的研究领域非常广泛,包括机器学习、计算机视觉、自然语言处理、知识表示与推理等。

1.2 人工智能的产生与发展人工智能的概念最早可以追溯到上世纪50 年代。

1950 年,Alan Turing 发表了著名的论文《计算机器与智能》,提出了“图灵测试”来衡量计算机是否具有智能。

1956 年,在达特茅斯会议上,John McCarthy 等人首次提出了“人工智能”这个术语,并确立了人工智能作为一个独立的研究领域。

人工智能的发展可以分为几个阶段:(1)推理期(1956-1969):主要研究基于逻辑的符号操作和自动推理。

代表性成果包括逻辑推理、专家系统等。

(2)知识期(1970-1980):研究重点转向知识表示和知识工程,出现了专家系统。

代表性成果包括产生式系统、框架等。

(3)机器学习期(1980-1990):机器学习成为人工智能的重要分支,研究如何让计算机从数据中学习。

代表性成果包括决策树、神经网络等。

(4)深度学习期(2006-至今):深度学习技术的出现,推动了计算机视觉、自然语言处理等领域的发展。

代表性成果包括卷积神经网络、循环神经网络等。

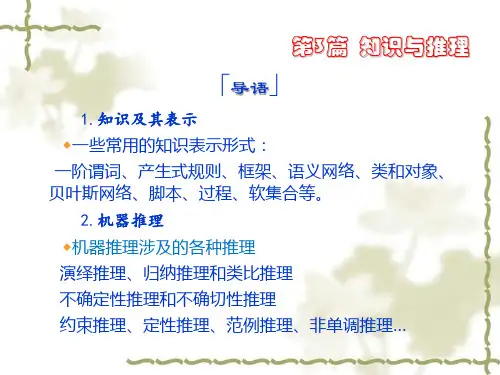

1.3 人工智能的三大学派人工智能的研究可以分为三大学派:(1)符号主义学派:认为智能行为的基础是符号操作和逻辑推理。

符号主义学派的研究方法包括逻辑推理、知识表示、专家系统等。

(2)连接主义学派:认为智能行为的基础是神经网络和机器学习。

连接主义学派的研究方法包括人工神经网络、深度学习、强化学习等。

(3)行为主义学派:认为智能行为的基础是感知和行动。

行为主义学派的研究方法包括遗传算法、蚁群算法、粒子群算法等。

第六章基于产生式规则的机器推理教学目的:使学生掌握产生式系统的定义、组成和推理技术。

教学重点和难点:产生式系统与规则演绎系统的差别和产生式系统的组成。

难点为产生式系统的控制策略等。

主要教学内容及要求:了解:产生式系统的程序实现理解:产生式系统与图搜索的区别掌握:产生式系统的组成结构,通过实践掌握产生式系统的设计和工作过程。

熟练掌握:产生式规则与产生式系统产生式这一术语,是1943年在美国数学家波斯特(E.Post)提出的一种称为波斯特机的计算模型里被首次使用的。

波斯特机的目的在于证明它和“图灵机”具有相同的计算能力。

在该模型中,波斯特主要是用类似于文法的规则对符号串做替换运算,并把其中的每一条符号变换规则称为一个产生式。

此后,产生式不断发展,1972年纽厄尔和西蒙在研究人类的认知模型中开发了基于规则的产生式系统。

目前,产生式表示法已成为人工智能中应用最多的一种知识表示模式,尤其是在专家系统方面,许多成功专家系统都是采用产生式知识表示方式。

产生式表示法也称为产生式规则表示法。

本节主要讨论产生式方法的基本方法、基本结构、基本过程和基本类型。

2.1.1产生式表示的基本方法及特性产生式表示法可以很容易地描述事实、规则以及它们的不确定性度量。

对非确定性知识的产生式表示方法,将主要在第4章讨论。

1.事实的表示事实可看作是断言一个语言变量的值或断言多个语言变量之间关系的陈述句。

其中,语言变量的值或语言变量之间的关系可以是数字,也可以是一个词等。

例如,陈述句“雪是白的”,其中“雪”是语言变量,“白的”是语言变量的值。

再如,陈述句“王峰热爱祖国”,其中,“王峰”和“祖国”是两个语言变量,“热爱”是语言变量之间的关系。

在产生式表示法中,事实通常是用三元组或四元组来表示的。

对确定性知识,一个事实可用一个三元组(对象,属性,值)或(关系,对象1,对象2)来表示。

其中,对象就是语言变量。

这种表示方式,在机器内部可用一个表来实现。

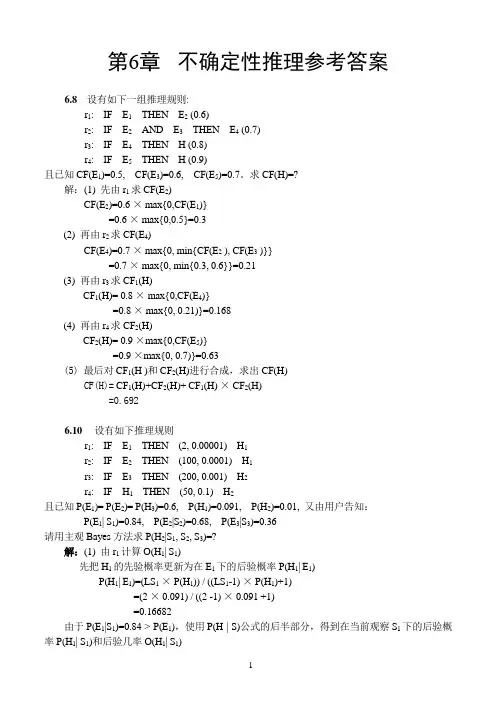

第6章不确定性推理参考答案6.8 设有如下一组推理规则:r1: IF E1THEN E2 (0.6)r2: IF E2AND E3THEN E4 (0.7)r3: IF E4THEN H (0.8)r4: IF E5THEN H (0.9)且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。

求CF(H)=?解:(1) 先由r1求CF(E2)CF(E2)=0.6 × max{0,CF(E1)}=0.6 × max{0,0.5}=0.3(2) 再由r2求CF(E4)CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}}=0.7 × max{0, min{0.3, 0.6}}=0.21(3) 再由r3求CF1(H)CF1(H)= 0.8 × max{0,CF(E4)}=0.8 × max{0, 0.21)}=0.168(4) 再由r4求CF2(H)CF2(H)= 0.9 ×max{0,CF(E5)}=0.9 ×max{0, 0.7)}=0.63(5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H)CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H)=0.6926.10 设有如下推理规则r1: IF E1THEN (2, 0.00001) H1r2: IF E2THEN (100, 0.0001) H1r3: IF E3THEN (200, 0.001) H2r4: IF H1THEN (50, 0.1) H2且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知:P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36请用主观Bayes方法求P(H2|S1, S2, S3)=?解:(1) 由r1计算O(H1| S1)先把H1的先验概率更新为在E1下的后验概率P(H1| E1)P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1)=(2 × 0.091) / ((2 -1) × 0.091 +1)=0.16682由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1)P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1))= 0.091 + (0.16682 –0.091) / (1 – 0.6)) × (0.84 – 0.6)=0.091 + 0.18955 × 0.24 = 0.136492O(H1| S1) = P(H1| S1) / (1 - P(H1| S1))= 0.15807(2) 由r2计算O(H1| S2)先把H1的先验概率更新为在E2下的后验概率P(H1| E2)P(H1| E2)=(LS2×P(H1)) / ((LS2-1) × P(H1)+1)=(100 × 0.091) / ((100 -1) × 0.091 +1)=0.90918由于P(E2|S2)=0.68 > P(E2),使用P(H | S)公式的后半部分,得到在当前观察S2下的后验概率P(H1| S2)和后验几率O(H1| S2)P(H1| S2) = P(H1) + ((P(H1| E2) – P(H1)) / (1 - P(E2))) × (P(E2| S2) – P(E2))= 0.091 + (0.90918 –0.091) / (1 – 0.6)) × (0.68 – 0.6)=0.25464O(H1| S2) = P(H1| S2) / (1 - P(H1| S2))=0.34163(3) 计算O(H1| S1,S2)和P(H1| S1,S2)先将H1的先验概率转换为先验几率O(H1) = P(H1) / (1 - P(H1)) = 0.091/(1-0.091)=0.10011再根据合成公式计算H1的后验几率O(H1| S1,S2)= (O(H1| S1) / O(H1)) × (O(H1| S2) / O(H1)) × O(H1)= (0.15807 / 0.10011) × (0.34163) / 0.10011) × 0.10011= 0.53942再将该后验几率转换为后验概率P(H1| S1,S2) = O(H1| S1,S2) / (1+ O(H1| S1,S2))= 0.35040(4) 由r3计算O(H2| S3)先把H2的先验概率更新为在E3下的后验概率P(H2| E3)P(H2| E3)=(LS3× P(H2)) / ((LS3-1) × P(H2)+1)=(200 × 0.01) / ((200 -1) × 0.01 +1)=0.09569由于P(E3|S3)=0.36 < P(E3),使用P(H | S)公式的前半部分,得到在当前观察S3下的后验概率P(H2| S3)和后验几率O(H2| S3)P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)由当E3肯定不存在时有P(H2 | ¬ E3) = LN3× P(H2) / ((LN3-1) × P(H2) +1)= 0.001 × 0.01 / ((0.001 - 1) × 0.01 + 1)= 0.00001因此有P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)=0.00001+((0.01-0.00001) / 0.6) × 0.36=0.00600O(H2| S3) = P(H2| S3) / (1 - P(H2| S3))=0.00604(5) 由r4计算O(H2| H1)先把H2的先验概率更新为在H1下的后验概率P(H2| H1)P(H2| H1)=(LS4× P(H2)) / ((LS4-1) × P(H2)+1)=(50 × 0.01) / ((50 -1) × 0.01 +1)=0.33557由于P(H1| S1,S2)=0.35040 > P(H1),使用P(H | S)公式的后半部分,得到在当前观察S1,S2下H2的后验概率P(H2| S1,S2)和后验几率O(H2| S1,S2)P(H2| S1,S2) = P(H2) + ((P(H2| H1) – P(H2)) / (1 - P(H1))) × (P(H1| S1,S2) – P(H1))= 0.01 + (0.33557 –0.01) / (1 – 0.091)) × (0.35040 – 0.091)=0.10291O(H2| S1,S2) = P(H2| S1, S2) / (1 - P(H2| S1, S2))=0.10291/ (1 - 0.10291) = 0.11472(6) 计算O(H2| S1,S2,S3)和P(H2| S1,S2,S3)先将H2的先验概率转换为先验几率O(H2) = P(H2) / (1 - P(H2) )= 0.01 / (1-0.01)=0.01010再根据合成公式计算H1的后验几率O(H2| S1,S2,S3)= (O(H2| S1,S2) / O(H2)) × (O(H2| S3) / O(H2)) ×O(H2)= (0.11472 / 0.01010) × (0.00604) / 0.01010) × 0.01010=0.06832再将该后验几率转换为后验概率P(H2| S1,S2,S3) = O(H1| S1,S2,S3) / (1+ O(H1| S1,S2,S3))= 0.06832 / (1+ 0.06832) = 0.06395可见,H2原来的概率是0.01,经过上述推理后得到的后验概率是0.06395,它相当于先验概率的6倍多。

生成式模型推理式模型-概述说明以及解释1.引言1.1 概述在机器学习领域中,生成式模型和推理式模型是两种常见的方法。

它们都是用于描述和处理概率和不确定性的模型。

生成式模型主要关注如何生成样本数据,而推理式模型则着眼于对给定数据进行推理和预测。

生成式模型是一种通过建模随机变量的联合概率分布,从而生成新的样本数据的方法。

它通过观察已知数据的特征,学习生成这些数据的分布规律。

生成式模型的核心思想是通过学习到的分布,来生成具有与训练样本相似的新样本。

生成式模型的一大优势是可以生成新的、不存在的数据样本,从而扩展数据集。

生成式模型常用的方法包括隐马尔可夫模型(HMM)、混合高斯模型(GMM)、变分自编码器(VAE)等。

与之相对,推理式模型则主要关注给定数据后如何进行推理,即通过已知的条件获得目标值的后验分布。

推理式模型用于对已知数据进行分类、回归、聚类等任务,并且可以用于预测未来的结果。

推理式模型更加注重对特征和目标之间的依赖关系建模,以便进行准确的预测。

推理式模型常用的方法包括逻辑回归、支持向量机(SVM)、深度神经网络(DNN)等。

生成式模型和推理式模型在应用领域上也有所差异。

生成式模型常用于自然语言处理、图像生成、语音合成等任务,因为它可以生成符合特定领域规则的新样本。

而推理式模型则广泛应用于文本分类、图像识别、推荐系统等任务,因为它能够对已知数据进行准确的预测和推理。

本文将详细介绍生成式模型和推理式模型的定义、原理和在不同领域的应用。

通过对两种模型的深入理解,有助于我们选择合适的模型用于解决具体问题,并推动机器学习技术的进一步发展。

1.2文章结构文章结构部分的内容如下:文章结构的目的是为读者概述本文的组织方式和内容安排,并给出每个部分的简要介绍。

通过清晰明了的结构,读者可以更好地理解和把握文章全貌,以便在阅读过程中更容易找到所需的信息。

本文主要包含以下几个部分:1. 引言:本部分将对生成式模型和推理式模型进行概述,并介绍文章的结构安排和目的。

1.什么是智能?智能有什么特征?答:智能可以理解为知识与智力的总和。

其中,知识是一切智能行为的基础,而智力是获取知识并运用知识求解问题的能力,即在任意给定的环境和目标的条件下,正确制订决策和实现目标的能力,它来自于人脑的思维活动。

智能具有下述特征:(1)具有感知能力(系统输入)。

(2)具有记忆与思维的能力。

(3)具有学习及自适应能力。

(4)具有行为能力(系统输出)。

2.人工智能有哪些学派?他们各自核心的观点有哪些?答:根据研究的理论、方法及侧重点的不同,目前人工智能主要有符号主义、联结主义和行为主义三个学派。

符号主义认为知识可用逻辑符号表达,认知过程是符号运算过程。

人和计算机都是物理符号系统,且可以用计算机的符号来模拟人的认知过程。

他们认为人工智能的核心问题是知识表示和知识推理,都可用符号来实现,所有认知活动都基于一个统一的体系结构。

联结主义原理主要是神经网络及神经网络间的连接机制与学习算法。

他们认为人的思维基元是神经元,而不是符号运算。

认为人脑不同于电脑,不能用符号运算来模拟大脑的工作模式。

行为主义原理为控制论及“感知—动作”型控制系统。

该学派认为智能取决于感知和行动,提出智能行为的“感知—动作”模式,他们认为知识不需要表示,不需要推理。

智能研究采用一种可增长的方式,它依赖于通过感知和行动来与外部世界联系和作用。

3.人工智能研究的近期目标和远期目标是什么?它们之间有什么样的关系?答:人工智能的近期目标是实现机器智能,即主要研究如何使现有的计算机更聪明,使它能够运用知识去处理问题,能够模拟人类的智能行为。

人工智能的远期目标是要制造智能机器。

即揭示人类智能的根本机理,用智能机器去模拟、延伸和扩展人类的智能。

人工智能的近期目标与远期目标之间并无严格的界限,二者相辅相成。

远期目标为近期目标指明了方向,近期目标则为远期目标奠定了理论和技术基础。

4.人工智能的研究途径有哪些?答:人工智能的研究途径主要有:(1)心理模拟,符号推演;(2)生理模拟,神经计算;(3)行为模拟,控制进化论。