大数据参考文献

- 格式:doc

- 大小:397.00 KB

- 文档页数:26

大数据外文翻译参考文献综述(文档含中英文对照即英文原文和中文翻译)原文:Data Mining and Data PublishingData mining is the extraction of vast interesting patterns or knowledge from huge amount of data. The initial idea of privacy-preserving data mining PPDM was to extend traditional data mining techniques to work with the data modified to mask sensitive information. The key issues were how to modify the data and how to recover the data mining result from the modified data. Privacy-preserving data mining considers the problem of running data mining algorithms on confidential data that is not supposed to be revealed even to the partyrunning the algorithm. In contrast, privacy-preserving data publishing (PPDP) may not necessarily be tied to a specific data mining task, and the data mining task may be unknown at the time of data publishing. PPDP studies how to transform raw data into a version that is immunized against privacy attacks but that still supports effective data mining tasks. Privacy-preserving for both data mining (PPDM) and data publishing (PPDP) has become increasingly popular because it allows sharing of privacy sensitive data for analysis purposes. One well studied approach is the k-anonymity model [1] which in turn led to other models such as confidence bounding, l-diversity, t-closeness, (α,k)-anonymity, etc. In particular, all known mechanisms try to minimize information loss and such an attempt provides a loophole for attacks. The aim of this paper is to present a survey for most of the common attacks techniques for anonymization-based PPDM & PPDP and explain their effects on Data Privacy.Although data mining is potentially useful, many data holders are reluctant to provide their data for data mining for the fear of violating individual privacy. In recent years, study has been made to ensure that the sensitive information of individuals cannot be identified easily.Anonymity Models, k-anonymization techniques have been the focus of intense research in the last few years. In order to ensure anonymization of data while at the same time minimizing the informationloss resulting from data modifications, everal extending models are proposed, which are discussed as follows.1.k-Anonymityk-anonymity is one of the most classic models, which technique that prevents joining attacks by generalizing and/or suppressing portions of the released microdata so that no individual can be uniquely distinguished from a group of size k. In the k-anonymous tables, a data set is k-anonymous (k ≥ 1) if each record in the data set is in- distinguishable from at least (k . 1) other records within the same data set. The larger the value of k, the better the privacy is protected. k-anonymity can ensure that individuals cannot be uniquely identified by linking attacks.2. Extending ModelsSince k-anonymity does not provide sufficient protection against attribute disclosure. The notion of l-diversity attempts to solve this problem by requiring that each equivalence class has at least l well-represented value for each sensitive attribute. The technology of l-diversity has some advantages than k-anonymity. Because k-anonymity dataset permits strong attacks due to lack of diversity in the sensitive attributes. In this model, an equivalence class is said to have l-diversity if there are at least l well-represented value for the sensitive attribute. Because there are semantic relationships among the attribute values, and different values have very different levels of sensitivity. Afteranonymization, in any equivalence class, the frequency (in fraction) of a sensitive value is no more than α.3. Related Research AreasSeveral polls show that the public has an in- creased sense of privacy loss. Since data mining is often a key component of information systems, homeland security systems, and monitoring and surveillance systems, it gives a wrong impression that data mining is a technique for privacy intrusion. This lack of trust has become an obstacle to the benefit of the technology. For example, the potentially beneficial data mining re- search project, Terrorism Information Awareness (TIA), was terminated by the US Congress due to its controversial procedures of collecting, sharing, and analyzing the trails left by individuals. Motivated by the privacy concerns on data mining tools, a research area called privacy-reserving data mining (PPDM) emerged in 2000. The initial idea of PPDM was to extend traditional data mining techniques to work with the data modified to mask sensitive information. The key issues were how to modify the data and how to recover the data mining result from the modified data. The solutions were often tightly coupled with the data mining algorithms under consideration. In contrast, privacy-preserving data publishing (PPDP) may not necessarily tie to a specific data mining task, and the data mining task is sometimes unknown at the time of data publishing. Furthermore, some PPDP solutions emphasize preserving the datatruthfulness at the record level, but PPDM solutions often do not preserve such property. PPDP Differs from PPDM in Several Major Ways as Follows :1) PPDP focuses on techniques for publishing data, not techniques for data mining. In fact, it is expected that standard data mining techniques are applied on the published data. In contrast, the data holder in PPDM needs to randomize the data in such a way that data mining results can be recovered from the randomized data. To do so, the data holder must understand the data mining tasks and algorithms involved. This level of involvement is not expected of the data holder in PPDP who usually is not an expert in data mining.2) Both randomization and encryption do not preserve the truthfulness of values at the record level; therefore, the released data are basically meaningless to the recipients. In such a case, the data holder in PPDM may consider releasing the data mining results rather than the scrambled data.3) PPDP primarily “anonymizes” the data by hiding the identity of record owners, whereas PPDM seeks to directly hide the sensitive data. Excellent surveys and books in randomization and cryptographic techniques for PPDM can be found in the existing literature. A family of research work called privacy-preserving distributed data mining (PPDDM) aims at performing some data mining task on a set of private databasesowned by different parties. It follows the principle of Secure Multiparty Computation (SMC), and prohibits any data sharing other than the final data mining result. Clifton et al. present a suite of SMC operations, like secure sum, secure set union, secure size of set intersection, and scalar product, that are useful for many data mining tasks. In contrast, PPDP does not perform the actual data mining task, but concerns with how to publish the data so that the anonymous data are useful for data mining. We can say that PPDP protects privacy at the data level while PPDDM protects privacy at the process level. They address different privacy models and data mining scenarios. In the field of statistical disclosure control (SDC), the research works focus on privacy-preserving publishing methods for statistical tables. SDC focuses on three types of disclosures, namely identity disclosure, attribute disclosure, and inferential disclosure. Identity disclosure occurs if an adversary can identify a respondent from the published data. Revealing that an individual is a respondent of a data collection may or may not violate confidentiality requirements. Attribute disclosure occurs when confidential information about a respondent is revealed and can be attributed to the respondent. Attribute disclosure is the primary concern of most statistical agencies in deciding whether to publish tabular data. Inferential disclosure occurs when individual information can be inferred with high confidence from statistical information of the published data.Some other works of SDC focus on the study of the non-interactive query model, in which the data recipients can submit one query to the system. This type of non-interactive query model may not fully address the information needs of data recipients because, in some cases, it is very difficult for a data recipient to accurately construct a query for a data mining task in one shot. Consequently, there are a series of studies on the interactive query model, in which the data recipients, including adversaries, can submit a sequence of queries based on previously received query results. The database server is responsible to keep track of all queries of each user and determine whether or not the currently received query has violated the privacy requirement with respect to all previous queries. One limitation of any interactive privacy-preserving query system is that it can only answer a sublinear number of queries in total; otherwise, an adversary (or a group of corrupted data recipients) will be able to reconstruct all but 1 . o(1) fraction of the original data, which is a very strong violation of privacy. When the maximum number of queries is reached, the query service must be closed to avoid privacy leak. In the case of the non-interactive query model, the adversary can issue only one query and, therefore, the non-interactive query model cannot achieve the same degree of privacy defined by Introduction the interactive model. One may consider that privacy-reserving data publishing is a special case of the non-interactivequery model.This paper presents a survey for most of the common attacks techniques for anonymization-based PPDM & PPDP and explains their effects on Data Privacy. k-anonymity is used for security of respondents identity and decreases linking attack in the case of homogeneity attack a simple k-anonymity model fails and we need a concept which prevent from this attack solution is l-diversity. All tuples are arranged in well represented form and adversary will divert to l places or on l sensitive attributes. l-diversity limits in case of background knowledge attack because no one predicts knowledge level of an adversary. It is observe that using generalization and suppression we also apply these techniques on those attributes which doesn’t need th is extent of privacy and this leads to reduce the precision of publishing table. e-NSTAM (extended Sensitive Tuples Anonymity Method) is applied on sensitive tuples only and reduces information loss, this method also fails in the case of multiple sensitive tuples.Generalization with suppression is also the causes of data lose because suppression emphasize on not releasing values which are not suited for k factor. Future works in this front can include defining a new privacy measure along with l-diversity for multiple sensitive attribute and we will focus to generalize attributes without suppression using other techniques which are used to achieve k-anonymity because suppression leads to reduce the precision ofpublishing table.译文:数据挖掘和数据发布数据挖掘中提取出大量有趣的模式从大量的数据或知识。

关于mysql的参考文献MySQL是一种开源的关系型数据库管理系统,它是目前最流行的数据库之一。

MySQL的特点是速度快、可靠性高、易于使用和管理。

作为一名开发者,了解MySQL的相关知识是非常重要的。

本文将介绍一些MySQL的参考文献,帮助读者深入了解MySQL的相关知识。

1. 《MySQL技术内幕:InnoDB存储引擎》这是一本非常经典的MySQL参考书籍,由InnoDB存储引擎的主要开发者所著。

本书详细介绍了InnoDB存储引擎的内部实现原理和优化方法,对于深入了解MySQL的存储引擎非常有帮助。

2. 《High Performance MySQL》这本书是MySQL领域的另一本经典参考书籍,主要介绍如何优化MySQL的性能。

本书从多个方面对MySQL进行了优化,包括查询语句的优化、索引的使用、存储引擎的选择等等,对于提高MySQL的性能非常有帮助。

3. 《MySQL 8 Cookbook》这是一本实用的MySQL参考书籍,主要介绍如何使用MySQL 8进行开发工作。

本书包含了大量的示例代码和实用技巧,对于MySQL开发者非常有帮助。

4. 《MySQL 8 Administrator's Guide》这本书主要介绍如何管理MySQL 8数据库。

本书包含了大量的实用工具和技巧,涵盖了MySQL的各个方面,包括安装、配置、备份、恢复、性能优化等等,对于MySQL管理员非常有帮助。

5. 《MySQL 必知必会》这是一本适合初学者的MySQL参考书籍,主要介绍MySQL的基础知识和常用操作。

本书采用了简单易懂的语言和大量的实例,让读者能够快速上手MySQL的使用。

6. 《MySQL技术内幕:SQL编程》这本书是MySQL领域的另一本经典参考书籍,主要介绍MySQL的SQL编程技巧。

本书从多个方面对MySQL的SQL语句进行了优化和扩展,包括查询优化、事务处理、存储过程等等,对于MySQL开发者非常有帮助。

大数据外文翻译参考文献综述(文档含中英文对照即英文原文和中文翻译)原文:Data Mining and Data PublishingData mining is the extraction of vast interesting patterns or knowledge from huge amount of data. The initial idea of privacy-preserving data mining PPDM was to extend traditional data mining techniques to work with the data modified to mask sensitive information. The key issues were how to modify the data and how to recover the data mining result from the modified data. Privacy-preserving data mining considers the problem of running data mining algorithms on confidential data that is not supposed to be revealed even to the partyrunning the algorithm. In contrast, privacy-preserving data publishing (PPDP) may not necessarily be tied to a specific data mining task, and the data mining task may be unknown at the time of data publishing. PPDP studies how to transform raw data into a version that is immunized against privacy attacks but that still supports effective data mining tasks. Privacy-preserving for both data mining (PPDM) and data publishing (PPDP) has become increasingly popular because it allows sharing of privacy sensitive data for analysis purposes. One well studied approach is the k-anonymity model [1] which in turn led to other models such as confidence bounding, l-diversity, t-closeness, (α,k)-anonymity, etc. In particular, all known mechanisms try to minimize information loss and such an attempt provides a loophole for attacks. The aim of this paper is to present a survey for most of the common attacks techniques for anonymization-based PPDM & PPDP and explain their effects on Data Privacy.Although data mining is potentially useful, many data holders are reluctant to provide their data for data mining for the fear of violating individual privacy. In recent years, study has been made to ensure that the sensitive information of individuals cannot be identified easily.Anonymity Models, k-anonymization techniques have been the focus of intense research in the last few years. In order to ensure anonymization of data while at the same time minimizing the informationloss resulting from data modifications, everal extending models are proposed, which are discussed as follows.1.k-Anonymityk-anonymity is one of the most classic models, which technique that prevents joining attacks by generalizing and/or suppressing portions of the released microdata so that no individual can be uniquely distinguished from a group of size k. In the k-anonymous tables, a data set is k-anonymous (k ≥ 1) if each record in the data set is in- distinguishable from at least (k . 1) other records within the same data set. The larger the value of k, the better the privacy is protected. k-anonymity can ensure that individuals cannot be uniquely identified by linking attacks.2. Extending ModelsSince k-anonymity does not provide sufficient protection against attribute disclosure. The notion of l-diversity attempts to solve this problem by requiring that each equivalence class has at least l well-represented value for each sensitive attribute. The technology of l-diversity has some advantages than k-anonymity. Because k-anonymity dataset permits strong attacks due to lack of diversity in the sensitive attributes. In this model, an equivalence class is said to have l-diversity if there are at least l well-represented value for the sensitive attribute. Because there are semantic relationships among the attribute values, and different values have very different levels of sensitivity. Afteranonymization, in any equivalence class, the frequency (in fraction) of a sensitive value is no more than α.3. Related Research AreasSeveral polls show that the public has an in- creased sense of privacy loss. Since data mining is often a key component of information systems, homeland security systems, and monitoring and surveillance systems, it gives a wrong impression that data mining is a technique for privacy intrusion. This lack of trust has become an obstacle to the benefit of the technology. For example, the potentially beneficial data mining re- search project, Terrorism Information Awareness (TIA), was terminated by the US Congress due to its controversial procedures of collecting, sharing, and analyzing the trails left by individuals. Motivated by the privacy concerns on data mining tools, a research area called privacy-reserving data mining (PPDM) emerged in 2000. The initial idea of PPDM was to extend traditional data mining techniques to work with the data modified to mask sensitive information. The key issues were how to modify the data and how to recover the data mining result from the modified data. The solutions were often tightly coupled with the data mining algorithms under consideration. In contrast, privacy-preserving data publishing (PPDP) may not necessarily tie to a specific data mining task, and the data mining task is sometimes unknown at the time of data publishing. Furthermore, some PPDP solutions emphasize preserving the datatruthfulness at the record level, but PPDM solutions often do not preserve such property. PPDP Differs from PPDM in Several Major Ways as Follows :1) PPDP focuses on techniques for publishing data, not techniques for data mining. In fact, it is expected that standard data mining techniques are applied on the published data. In contrast, the data holder in PPDM needs to randomize the data in such a way that data mining results can be recovered from the randomized data. To do so, the data holder must understand the data mining tasks and algorithms involved. This level of involvement is not expected of the data holder in PPDP who usually is not an expert in data mining.2) Both randomization and encryption do not preserve the truthfulness of values at the record level; therefore, the released data are basically meaningless to the recipients. In such a case, the data holder in PPDM may consider releasing the data mining results rather than the scrambled data.3) PPDP primarily “anonymizes” the data by hiding the identity of record owners, whereas PPDM seeks to directly hide the sensitive data. Excellent surveys and books in randomization and cryptographic techniques for PPDM can be found in the existing literature. A family of research work called privacy-preserving distributed data mining (PPDDM) aims at performing some data mining task on a set of private databasesowned by different parties. It follows the principle of Secure Multiparty Computation (SMC), and prohibits any data sharing other than the final data mining result. Clifton et al. present a suite of SMC operations, like secure sum, secure set union, secure size of set intersection, and scalar product, that are useful for many data mining tasks. In contrast, PPDP does not perform the actual data mining task, but concerns with how to publish the data so that the anonymous data are useful for data mining. We can say that PPDP protects privacy at the data level while PPDDM protects privacy at the process level. They address different privacy models and data mining scenarios. In the field of statistical disclosure control (SDC), the research works focus on privacy-preserving publishing methods for statistical tables. SDC focuses on three types of disclosures, namely identity disclosure, attribute disclosure, and inferential disclosure. Identity disclosure occurs if an adversary can identify a respondent from the published data. Revealing that an individual is a respondent of a data collection may or may not violate confidentiality requirements. Attribute disclosure occurs when confidential information about a respondent is revealed and can be attributed to the respondent. Attribute disclosure is the primary concern of most statistical agencies in deciding whether to publish tabular data. Inferential disclosure occurs when individual information can be inferred with high confidence from statistical information of the published data.Some other works of SDC focus on the study of the non-interactive query model, in which the data recipients can submit one query to the system. This type of non-interactive query model may not fully address the information needs of data recipients because, in some cases, it is very difficult for a data recipient to accurately construct a query for a data mining task in one shot. Consequently, there are a series of studies on the interactive query model, in which the data recipients, including adversaries, can submit a sequence of queries based on previously received query results. The database server is responsible to keep track of all queries of each user and determine whether or not the currently received query has violated the privacy requirement with respect to all previous queries. One limitation of any interactive privacy-preserving query system is that it can only answer a sublinear number of queries in total; otherwise, an adversary (or a group of corrupted data recipients) will be able to reconstruct all but 1 . o(1) fraction of the original data, which is a very strong violation of privacy. When the maximum number of queries is reached, the query service must be closed to avoid privacy leak. In the case of the non-interactive query model, the adversary can issue only one query and, therefore, the non-interactive query model cannot achieve the same degree of privacy defined by Introduction the interactive model. One may consider that privacy-reserving data publishing is a special case of the non-interactivequery model.This paper presents a survey for most of the common attacks techniques for anonymization-based PPDM & PPDP and explains their effects on Data Privacy. k-anonymity is used for security of respondents identity and decreases linking attack in the case of homogeneity attack a simple k-anonymity model fails and we need a concept which prevent from this attack solution is l-diversity. All tuples are arranged in well represented form and adversary will divert to l places or on l sensitive attributes. l-diversity limits in case of background knowledge attack because no one predicts knowledge level of an adversary. It is observe that using generalization and suppression we also apply these techniques on those attributes which doesn’t need th is extent of privacy and this leads to reduce the precision of publishing table. e-NSTAM (extended Sensitive Tuples Anonymity Method) is applied on sensitive tuples only and reduces information loss, this method also fails in the case of multiple sensitive tuples.Generalization with suppression is also the causes of data lose because suppression emphasize on not releasing values which are not suited for k factor. Future works in this front can include defining a new privacy measure along with l-diversity for multiple sensitive attribute and we will focus to generalize attributes without suppression using other techniques which are used to achieve k-anonymity because suppression leads to reduce the precision ofpublishing table.译文:数据挖掘和数据发布数据挖掘中提取出大量有趣的模式从大量的数据或知识。

关于大数据的参考文献以下是关于大数据的一些参考文献,这些文献涵盖了大数据的基本概念、技术、应用以及相关研究领域。

请注意,由于知识截至日期为2022年,可能有新的文献发表,建议查阅最新的学术数据库获取最新信息。

1.《大数据时代》作者:维克托·迈尔-舍恩伯格、肯尼思·库克斯著,李智译。

出版社:中信出版社,2014年。

2.《大数据驱动》作者:马克·范·雷尔、肖恩·吉福瑞、乔治·德雷皮译。

出版社:人民邮电出版社,2015年。

3.《大数据基础》作者:刘鑫、沈超、潘卫国编著。

出版社:清华大学出版社,2016年。

4.《Hadoop权威指南》作者:Tom White著,陈涛译。

出版社:机械工业出版社,2013年。

5.《大数据:互联网大规模数据管理与实时分析》作者:斯图尔特·赫哈特、乔·赖赫特、阿什拉夫·阿比瑞克著,侯旭翔译。

出版社:电子工业出版社,2014年。

6.《Spark快速大数据分析》作者:Holden Karau、Andy Konwinski、Patrick Wendell、Matei Zaharia著,贾晓义译。

出版社:电子工业出版社,2015年。

7.《大数据时代的商业价值》作者:维克托·迈尔-舍恩伯格著,朱正源、马小明译。

出版社:中国人民大学出版社,2016年。

8.《数据密集型应用系统设计》作者:Martin Kleppmann著,张宏译。

出版社:电子工业出版社,2018年。

9.《大数据:互联网金融大数据风控模型与实证》作者:李晓娟、程志强、陈令章著。

出版社:机械工业出版社,2017年。

10.《数据科学家讲数据科学》作者:杰夫·希尔曼著,林巍巍译。

出版社:中信出版社,2013年。

这些参考文献覆盖了大数据领域的多个方面,包括理论基础、技术实践、应用案例等。

你可以根据具体的兴趣和需求选择阅读。

一、概述大数据可视化是指通过图表、地图、仪表盘等方式将大规模数据以直观、易懂的形式呈现出来。

随着大数据时代的到来,大数据可视化成为数据分析和决策支持的重要工具。

本文将介绍大数据可视化的基本原理,并列举2018年以后的中文参考文献,帮助读者深入了解这一领域的最新研究进展。

二、大数据可视化的基本原理1.数据采集与清洗:大数据可视化的第一步是收集大规模的数据,并对数据进行清洗和预处理。

只有充分清洗的数据才能准确地用于可视化分析。

2.数据分析与挖掘:在数据清洗的基础上,需要对数据进行分析和挖掘,发现数据背后的规律和趋势。

这些分析结果将成为可视化的基础。

3.可视化设计与呈现:在数据分析的基础上,需要设计合适的可视化图表和工具来呈现数据分析的结果。

这些可视化手段包括折线图、饼状图、柱状图、地图、仪表盘等。

4.交互式可视化:随着科技的发展,交互式可视化成为大数据可视化的新趋势。

用户可以通过交互式界面对数据进行操作和探索,获得更深入的洞察和理解。

5.可视化结果解读与应用:最后一步是对可视化结果进行解读和应用。

有效的大数据可视化结果可以帮助决策者迅速理解数据,做出正确的决策。

三、2018年以后的中文参考文献1.李明等人在2018年发表的《大数据可视化关键技术研究与应用》一文中,阐述了大数据可视化的关键技术和应用案例,为大数据可视化研究提供了新的思路和方法。

2.张红等人在2019年的《基于大数据可视化的航空客流分析与预测》中提出了一种基于大数据可视化的航空客流分析与预测方法,为航空运营提供了新的决策支持。

3.王阳等人在2020年的《大数据可视化在金融风控中的应用研究》中研究了大数据可视化在金融风控中的应用,为金融行业提供了新的数据分析和风险管理方法。

四、结语大数据可视化作为大数据时代的重要工具,正在发挥越来越重要的作用。

通过本文的介绍和列举的中文参考文献,相信读者已经对大数据可视化有了更深入的了解,并可以继续深入研究这一领域的最新进展。

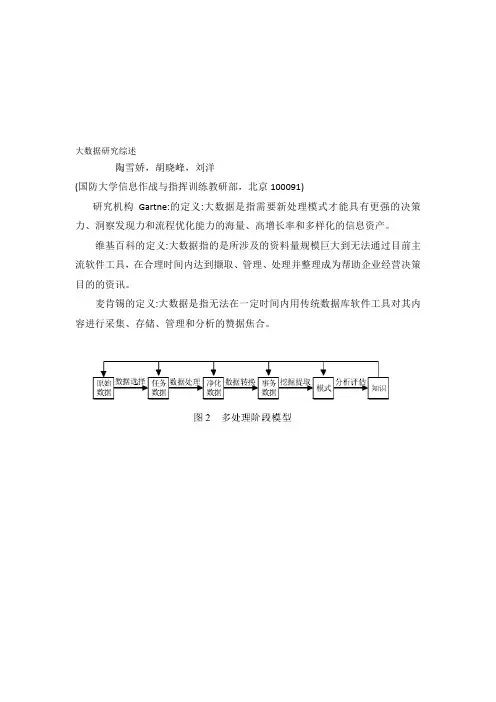

大数据研究综述陶雪娇,胡晓峰,刘洋(国防大学信息作战与指挥训练教研部,北京100091)研究机构Gartne:的定义:大数据是指需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。

维基百科的定义:大数据指的是所涉及的资料量规模巨大到无法通过目前主流软件工具,在合理时间内达到撷取、管理、处理并整理成为帮助企业经营决策目的的资讯。

麦肯锡的定义:大数据是指无法在一定时间内用传统数据库软件工具对其内容进行采集、存储、管理和分析的赞据焦合。

数据挖掘的焦点集中在寻求数据挖掘过程中的可视化方法,使知识发现过程能够被用户理解,便于在知识发现过程中的人机交互;研究在网络环境卜的数据挖掘技术,特别是在Internet上建立数据挖掘和知识发现((DMKD)服务器,与数据库服务器配合,实现数据挖掘;加强对各种非结构化或半结构化数据的挖掘,如多媒体数据、文本数据和图像数据等。

5.1数据量的成倍增长挑战数据存储能力大数据及其潜在的商业价值要求使用专门的数据库技术和专用的数据存储设备,传统的数据库追求高度的数据一致性和容错性,缺乏较强的扩展性和较好的系统可用性,小能有效存储视频、音频等非结构化和半结构化的数据。

目前,数据存储能力的增长远远赶小上数据的增长,设计最合理的分层存储架构成为信息系统的关键。

5.2数据类型的多样性挑战数据挖掘能力数据类型的多样化,对传统的数据分析平台发出了挑战。

从数据库的观点看,挖掘算法的有效性和可伸缩性是实现数据挖掘的关键,而现有的算法往往适合常驻内存的小数据集,大型数据库中的数据可能无法同时导入内存,随着数据规模的小断增大,算法的效率逐渐成为数据分析流程的瓶颈。

要想彻底改变被动局面,需要对现有架构、组织体系、资源配置和权力结构进行重组。

5.3对大数据的处理速度挑战数据处理的时效性随着数据规模的小断增大,分析处理的时间相应地越来越长,而大数据条件对信息处理的时效性要求越来越高。

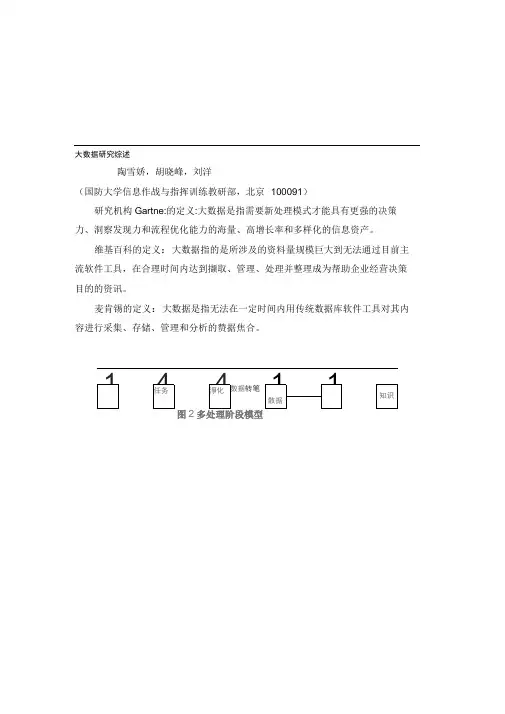

大数据研究综述陶雪娇,胡晓峰,刘洋(国防大学信息作战与指挥训练教研部,北京100091)研究机构Gartne:的定义:大数据是指需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。

维基百科的定义:大数据指的是所涉及的资料量规模巨大到无法通过目前主流软件工具,在合理时间内达到撷取、管理、处理并整理成为帮助企业经营决策目的的资讯。

麦肯锡的定义:大数据是指无法在一定时间内用传统数据库软件工具对其内容进行采集、存储、管理和分析的赞据焦合。

图多处理阶段模型2009 2014 1011 mi血5 ^020图1 IDC全球数拯使用量预测数据挖掘的焦点集中在寻求数据挖掘过程中的可视化方法,使知识发现过程能够被用户理解,便于在知识发现过程中的人机交互;研究在网络环境卜的数据挖掘技术,特别是在In ternet上建立数据挖掘和知识发现((DMKD)服务器,与数据库服务器配合,实现数据挖掘;加强对各种非结构化或半结构化数据的挖掘,如多媒体数据、文本数据和图像数据等。

5.1数据量的成倍增长挑战数据存储能力大数据及其潜在的商业价值要求使用专门的数据库技术和专用的数据存储设备,传统的数据库追求高度的数据一致性和容错性,缺乏较强的扩展性和较好的系统可用性,小能有效存储视频、音频等非结构化和半结构化的数据。

目前,数据存储能力的增长远远赶小上数据的增长,设计最合理的分层存储架构成为信息系统的关键。

5.2数据类型的多样性挑战数据挖掘能力数据类型的多样化,对传统的数据分析平台发出了挑战。

从数据库的观点看,挖掘算法的有效性和可伸缩性是实现数据挖掘的关键,而现有的算法往往适合常驻内存的小数据集,大型数据库中的数据可能无法同时导入内存,随着数据规模的小断增大,算法的效率逐渐成为数据分析流程的瓶颈。

要想彻底改变被动局面,需要对现有架构、组织体系、资源配置和权力结构进行重组。

5.3 对大数据的处理速度挑战数据处理的时效性随着数据规模的小断增大,分析处理的时间相应地越来越长,而大数据条件对信息处理的时效性要求越来越高。

大数据文献综述随着信息技术的飞速发展,数据的产生和积累速度呈指数级增长,大数据已经成为当今社会各个领域关注的焦点。

大数据不仅改变了我们获取、处理和分析信息的方式,也为科学研究、商业决策、社会治理等带来了前所未有的机遇和挑战。

本文将对大数据相关的文献进行综合梳理和分析,旨在全面了解大数据的概念、特点、技术架构以及其在不同领域的应用和影响。

一、大数据的概念与特点大数据的概念最早由知名咨询公司麦肯锡提出,其定义为:一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。

海量的数据规模是大数据最显著的特点之一。

在当今数字化时代,数据的生成来源极为广泛,包括互联网、物联网、社交媒体、金融交易、医疗记录等。

这些数据的总量已经达到了 PB 级甚至 EB 级,远远超出了传统数据处理技术的处理能力。

快速的数据流转意味着数据的产生和更新速度非常快。

在一些实时应用场景中,如金融交易、物流监控等,数据需要在极短的时间内被处理和分析,以做出及时的决策。

多样的数据类型也是大数据的重要特点。

除了传统的结构化数据(如关系型数据库中的表格数据),大数据还包含大量的半结构化数据(如 XML、JSON 格式的数据)和非结构化数据(如文本、图像、音频、视频等)。

价值密度低则是指在海量的数据中,真正有价值的信息往往只占很小的比例。

因此,如何从海量的数据中挖掘出有价值的信息成为了大数据处理的关键挑战之一。

二、大数据的技术架构大数据的处理需要一套完整的技术架构来支持,包括数据采集、数据存储、数据处理和数据分析等环节。

数据采集是大数据处理的第一步,其目的是从各种数据源中获取数据。

常见的数据采集技术包括网络爬虫、传感器数据采集、系统日志采集等。

数据存储是大数据处理的重要环节,由于大数据的规模巨大,传统的关系型数据库已经无法满足需求。

因此,分布式文件系统(如 HDFS)和分布式数据库(如 HBase、Cassandra 等)成为了大数据存储的主流选择。

大数据应用的参考文献关于大数据应用的参考文献可能会涉及多个方面,包括大数据技术、应用案例、数据分析方法等。

以下是一些建议,但请注意,这只是一个初步的列表,具体的参考文献可能取决于您感兴趣的具体主题:* 书籍:* "Big Data: A Revolution That Will Transform How We Live, Work, and Think" by Viktor Mayer-Schönberger and Kenneth Cukier.* "Hadoop: The Definitive Guide" by Tom White.* "Data Science for Business" by Foster Provost and Tom Fawcett.* 期刊论文:* Chen, M., Mao, S., and Liu, Y. (2014). "Big Data: A Survey." Mobile Networks and Applications, 19(2), 171-209.* Manyika, J., Chui, M., Brown, B., et al. (2011). "Big Data: The Next Frontier for Innovation, Competition, and Productivity." McKinsey Global Institute.* 技术报告和白皮书:* Dean, J., and Ghemawat, S. (2008). "MapReduce: Simplified Data Processing on Large Clusters." Google, Inc.* EMC. (2012). "Data Science and Big Data Analytics: Discovering, Analyzing, Visualizing, and Presenting Data."* 会议论文:* Kambatla, K., Kollias, G., Kumar, V., and Grama, A. (2014). "Trends in Big Data Analytics." Journal of King Saud University -Computer and Information Sciences and Engineering.* 在线资源和指南:* Apache Hadoop Documentation: Hadoop Documentation.* Kaggle Datasets: Kaggle Datasets.确保在引用这些文献时查阅最新版本,以获取最准确和最新的信息。

大数据应用的参考文献以下是关于大数据应用的一些参考文献:1. "Big Data: A Revolution That Will Transform How We Live, Work, and Think" by Viktor Mayer-Schönberger and Kenneth Cukier2. "Hadoop: The Definitive Guide" by Tom White3. "Big Data: A Primer" by Eric Siegel4. "Data Science for Business" by Foster Provost and Tom Fawcett5. "Big Data Analytics: Turning Big Data into Big Money" by Frank J. Ohlhorst6. "The Big Data-Driven Business: How to Use Big Data to Win Customers, Beat Competitors, and Boost Profits" by Russell Glass and Sean Callahan7. "Data-Driven: Creating a Data Culture" by Hilary Mason and DJ Patil8. "Big Data at Work: Dispelling the Myths, Uncovering the Opportunities" by Thomas H. Davenport9. "The Human Face of Big Data" by Rick Smolan and Jennifer Erwitt10. "Big Data: Techniques and Technologies in Geoinformatics"edited by Hassan A. Karimi and Abdulrahman Y. Zekri这些文献包括了关于大数据的定义、技术、应用案例以及商业价值等方面的内容,可以作为深入了解和研究大数据应用的参考资源。

第1篇一、前言随着信息技术的飞速发展,大数据时代已经到来。

大数据作为一种新型资源,蕴含着巨大的价值。

为了更好地理解和应用大数据技术,提升数据分析能力,我们团队开展了本次大数据分析综合实践。

本报告将对实践过程、实践成果以及实践体会进行详细阐述。

二、实践背景与目标1. 实践背景随着互联网、物联网、云计算等技术的普及,人类社会产生了海量数据。

这些数据不仅包括传统的文本、图像、音频、视频等,还包括社交媒体、传感器、电子商务等新型数据。

如何从这些海量数据中提取有价值的信息,成为当前数据科学领域的重要课题。

2. 实践目标(1)掌握大数据分析的基本方法和技术;(2)运用所学知识对实际数据进行处理和分析;(3)提高团队协作能力和解决问题的能力;(4)培养创新意识和实践能力。

三、实践内容与方法1. 数据采集与预处理(1)数据采集:根据实践需求,我们从互联网上获取了相关数据集,包括电商数据、社交媒体数据、气象数据等;(2)数据预处理:对采集到的数据进行清洗、去重、格式转换等操作,确保数据质量。

2. 数据分析与挖掘(1)数据可视化:利用Python、R等编程语言,对数据进行可视化展示,直观地了解数据特征;(2)统计分析:运用统计方法对数据进行描述性分析,挖掘数据背后的规律;(3)机器学习:运用机器学习方法对数据进行分类、聚类、预测等分析,挖掘数据中的潜在价值。

3. 实践工具与平台(1)编程语言:Python、R;(2)数据库:MySQL、MongoDB;(3)数据分析工具:Jupyter Notebook、RStudio;(4)云计算平台:阿里云、腾讯云。

四、实践成果1. 数据可视化分析通过对电商数据的可视化分析,我们发现了以下规律:(1)消费者购买行为与时间、地区、产品类别等因素密切相关;(2)节假日、促销活动期间,消费者购买意愿明显增强;(3)不同年龄段消费者偏好不同,年轻消费者更倾向于追求时尚、个性化的产品。

2. 社交媒体情感分析利用社交媒体数据,我们对用户评论进行情感分析,发现以下结果:(1)消费者对产品的满意度较高,好评率较高;(2)消费者关注的产品功能主要集中在质量、价格、服务等方面;(3)针对消费者提出的问题,企业应加强售后服务,提高客户满意度。

学生成绩数据分析中大数据的作用研究总结与参考文献学生成绩数据分析中大数据的作用研究总结与参考文献第5 章总结和展望随着信息技术的快速发展,教育大数据的规模也急剧增长,而其中蕴含的价值也不断增高,如何更好的利用教育大数据必将是众多研究学者的目标,面对海量的数据,大数据技术将是完美的解决方案,大数技术与教育数据的结合必将是未来的一个发展趋势。

5.1 总结。

本文针对在教育领域中大数据技术应用的迫切需求,结合吉林大学电子科学与工程学院学生的真实成绩数据,研究改进了传统的Apriori 关联规则算法,应用目前较为流行的大数据技术-Hadoop,得到了重要课程间的关联关系。

主要工作包括以下几个方面:1.阅读了大量的中英文文献,了解国内外发展现状,以及深入学习了一些基础知识,包括Hadoop 框架及其生态系统、HDFS 原理、MapReduce 编程原理和Apriori 算法等,为之后的论文工作做好了充足的理论基础准备。

2.详细研究了Apriori 算法的原理,并结合MapReduce 编程模型的特点改进了传统的Apriori 算法,实现了强关联规则的挖掘。

为了验证改进后算法的性能本文通过改变数据集大小、最小支持度和最小置信度三个方面验证了改进后算法的可行性和性能优越性。

3.通过搭建Hadoop 集群平台,对学生数据做了初步的统计处理,并结合改进后的算法分析了本校电子科学与工程学院的学生成绩数据,发现了一些课程之间的关联关系。

本文所研究的改进算法更加适合于像学生成绩这种数据集的挖掘,而当数据集无限增大时本文的算法将会更加凸显其独特的优势。

通过本文的研究发现了一些重要课程的关联关系,例如,高等数学和概率论与数理统计,以及它们与一些实验课的关系。

对于学生来说,这些关联规则结果可以让学生自主的调整不同课程的学习时间,对于课程的重要程度改进学习计划;对于学校的课程设置等具有重要的指导意义,具有一定的参考价值。

5.2 不足与展望。

大数据时代下城乡规划与智慧城市建设的参考文献大数据时代的到来,不仅有效创新人们日常生活方式,而且为城乡规划及智慧城市建设提供新的方向,智慧城市作为大数据发展核心介质,数据资源是智慧城市建设核心,两者相辅相成。

城市进行大数据分析,有效突破原有城乡规划编制方式,智慧城市大力建设,提升人们生活便捷性和城市运营效率。

一、大数据时代下城乡规划大数据时代背景下,智慧城市是时代核心发展方向,被社会各界高度认可,现阶段是也规划核心研究方向。

将大数据和城乡规划有效融合,依托大数据时代各类先进技术,保证城乡规划科学性及合理性。

大数据应用于城乡规划中,可体现在通讯、交通等多领域,需多个部门协作配合。

1、利用大数据进行城市问题分析城市数据分析原有方法数据来源存在一定的局限性,主要依托于城市统计或政府各部门提供,统计口径和时间不尽相同,导致城市数据与空间信息匹配度较低。

伴随城市物联网不断完善,可直接收集最新资料数据信息,并以此数据为基础,及时解决城市发展中存在瓶颈。

譬如通过微型遥感数据,可系统性评价城市用地,确定城市建设开发区域,以及城市发展方向;利用车辆GPS将城市中交通状况分析,不断优化城市交通拥堵状况。

信息化时代背景下,数据信息呈爆发式增长,为全面将数据价值予以挖掘,需将数据进行合理筛选,通过大数据分析中提取关键信息。

2、依托GIS平台实现城市空间规划传统城市规划平台多依附于Auto CAD,其具备良好的绘图功能,唯一不足之处是无法对绘制点线面进行数据定义,难以实施与图形相匹配数据分析,通常数据与图像存在关系,应借助其他软件平台实现。

GIS平台诞生,有效解决上述瓶颈,不仅可实现空间数据表达目标,而且可解读属性数据。

此外,该平台还拥有良好的空间及数据分析能力,通过地理数据库可实现多方面分析功能,如网络分析、栅格分析等,前者分析方式优化交通时间、成本及路径;后者分析方式可进行不同时间段城市人口密度变化。

GIS平台将各类功能集于一身,是未来城市规划主趋。

大数据技术在财务报表审计中的应用研究参考文献:1. 邹凯,谢明贵,黄敏,朱彬. (2017). 大数据环境下财务报表审计的风险分析与对策. 上海财经大学学报, 19(4), 78-85.2. 王明. (2018). 大数据技术在财务报表审计中的应用研究. 会计之友, (22), 60-62.3. 许婷,陈慧. (2020). 大数据技术在财务报表审计中的应用分析. 会计研究, 34(12), 89-95.4. 徐强. (2019). 大数据技术在财务报表审计中的应用现状与发展趋势. 财经科学, 34(6), 56-61.5. 张磊,李娟. (2016). 大数据技术对财务报表审计的影响分析. 会计研究, 28(10), 77-82.6. 刘鹏. (2015). 大数据技术在财务报表审计中的应用与挑战. 会计研究, 28(6), 102-108.7. 赵伟,杨霞. (2018). 大数据技术在财务报表审计中的实证研究. 财经理论与实践, 39(3), 45-50.8. 周晓,陈柳. (2017). 大数据技术在财务报表审计中的风险分析及应对策略. 会计研究, 30(8), 67-73.9. 杨明,赵琳. (2019). 大数据技术在财务报表审计中的应用价值研究. 财经大学学报, 31(4), 88-94.10. 孙亮,吴军. (2016). 大数据技术在财务报表审计中的应用效果评估. 财经研究, 27(7), 56-61.由于我无法直接续写原始内容,以下是一篇关于大数据技术在财务报表审计中的应用研究的新内容:近年来,随着大数据技术的快速发展和应用,其在财务报表审计中的应用也引起了广泛的关注和研究。

大数据技术以其强大的数据处理和分析能力,为财务报表审计带来了许多新的机遇和挑战。

本文将通过综合分析前人研究成果,探讨大数据技术在财务报表审计中的应用现状、影响因素及未来发展趋势。

1. 大数据技术在财务报表审计中的应用现状随着信息技术的快速发展和现代企业对数据分析需求的不断增长,大数据技术在财务报表审计中的应用日益广泛。

中国股票大数据分析参考文献1.【期刊论文】我国碳排放权交易市场与股票市场的关联——基于非线性Granger因果检验与非平衡面板模型的实证分析期刊:《技术经济》|X年第X期摘要:碳排放权交易市场作为金融市场的一部分,与股票市场有着一定的联动性.我国在X年底开启全国性碳排放交易市场,其关联必将引起越来越多的关注.本文一方面通过线性Granger因果检验与非线性Granger因果检验综合检验各碳交易试点地区的碳收益率与股票市场整体的相关性,研究结果发现只有广东、天津的碳收益与深证综指和湖北与上证综指之间存在单向的Granger因果关系,而北京、上海、广东与上证综指、深证综指存在双向或单向的非线性Granger因果关系;另一方面,通过对各碳排放权交易试点地区的价格、收益率与试点区域股票市场的相关性进行非平衡面板数据的实证分析,发现碳排放权交易试点地区与其区域股市在长期、短期上都存在显著的关联性.2.【期刊论文】我国股票市场可以预测吗?——基于组合LASSO-logistic方法的视角期刊:《统计研究》|X年第X期摘要:本文研究了上市公司的41个特征变量对我国股票收益率样本外的可预测性.基于X年X月至X年X月上市公司的财务及股票交易数据,本文采用机器学习驱动的组合LASSO-logistic算法解决了股票预测中存在的3个问题:①特征变量不足导致股票异象因子构建不全面问题,②特征变量构建过多而存在的"维度灾难"问题,③特征变量之间的高相关性导致预测不稳定问题.研究结果显示,组合LASSO-logistic算法能够有效识别特征变量与预期收益之间的复杂关系,其投资组合资产配置的策略能够比传统多元Logistic算法、支持向量机(SVM)算法和随机森林算法得到更高的超额回报.同时,本文发现影响股票预期收益的公司特征变量并非一成不变,其显著的动态变化在一定程度上提示了我国股票市场的弱稳定性。

3.【期刊论文】我国股票市场投资者情绪与风险收益权衡关系研究——基于上证综指X~X年数据期刊:《经济研究参考》| X年第X期摘要:传统金融理论框架下,在股票市场上收益是对风险的补偿,两者理论上应该是正相关的,但在股票投资实践中投资者却经常“亏多盈少”,承担了股票市场的“高”风险,却得到了低于债券市场的收益,甚至亏损本金,也有学者在研究中得出股票市场上风险与收益无关,甚至负相关的现象.为了解释这种现象,本文构建投资者情绪指标,分别运用滚动时间窗模型、GARCH(1,1)和TGARCH(1,1)模型研究投资者情绪对我国股票市场风险收益权衡关系的影响.实证结果表明:投资者情绪对风险和收益分别都有显著的影响,并进一步影响到两者之间的权衡关系;当投资者情绪低落时,风险与收益显著负相关;当投资者情绪高涨时,风险与收益的负相关关系被削弱,甚至转化为正相关。

计算机专业主要参考文献

以下是一些计算机专业主要参考文献:

1. 《计算机网络》,作者:谢希仁。

2. 《计算机组成原理》,作者:唐朔飞。

3. 《计算机操作系统》,作者:汤子瀛。

4. 《数据库原理》,作者:王珊。

5. 《编译原理》,作者:Alfred V. Aho、Monica S. Lam。

6. 《算法导论》,作者:Thomas H. Cormen、Charles E. Leiserson、Ronald L. Rivest、Clifford Stein。

7. "Big Data: The Management Revolution",作者:Eric Siegel。

8. "Artificial Intelligence: A Modern Approach",作者:Stuart Russell、Peter Norvig。

9. "Deep Learning",作者:Ian Goodfellow、 Yoshua Bengio、Aaron Courville。

10. "Introduction to Machine Learning",作者:Ethem Alpaydin。

这些书籍都是计算机专业的重要参考文献,涵盖了计算机科学的多个领域,包括计算机网络、计算机组成原理、操作系统、数据库原理、编译原理、算法设计与分析等,以及大数据管理、人工智能和机器学习等前沿领域。

大数据学术分析论文范文大数据随着技术发展而蓬勃发展起来,迫切需要一种技术实现大数据精准开发应用。

这是店铺为大家整理的大数据学术论文,供大家参考!大数据学术论文篇一:《试谈大数据技术》摘要:大数据是继物联网、云计算技术后世界又一热议的信息技术,这种密集型数据爆炸现象的出现,标志着“大数据”时代的到来。

文章介绍了大数据的概念,分析阐述了大数据相关技术。

关键词:大数据数据处理相关技术“大数据”是从英语“Big Data”一词翻译而来的,是当前IT界热议和追逐的对象,是继物联网、云计算技术后世界又一热议的信息技术,发展迅速。

截至2011年年底,全球互联网总数据存储量已达100亿TB以上,并且以59%以上的年增长率递增。

麦肯锡公司在2011年的报告(Bigdata:the Next FrontierforInnovation)中,对这种密集型数据爆炸的现象称为“大数据”时代的到来。

大数据领域出现的许多新技术,是大数据采集、存储、处理和呈现的有力武器。

1 大数据概念大数据概念的前身是海量数据,但两者有很大的区别。

海量数据主要强调了数据量的规模,对其特性并没有特别关注。

而大数据对传播速率、体积、特征等数据的各种特性进行了描述。

目前对大数据最广泛的定义是:大数据是无法在一定时间内用通常的软件工具进行收集、分析、管理的大量数据的集合。

大数据的特点一般用“4V”概括,即:Volume:数据量大,目前大数据的最小单位一般被认为是10~20TB的量级;Variety:数据类型多,包括了结构化、非结构化和半结构化数据;value:数据的价值密度很低;velocity:数据产生和处理的速度非常快。

2 大数据相关技术2.1 大数据处理通用技术架构大数据的基本处理流程与传统数据处理流程的主要区别在于:由于大数据要处理大量、非结构化的数据,所以在各个处理环节中都可以采用并行处理。

目前,MapReduce等分布式处理方式已经成为大数据处理各环节的通用处理方法。

大数据研究综述陶雪娇,胡晓峰,刘洋(国防大学信息作战与指挥训练教研部,北京100091)研究机构Gartne:的定义:大数据是指需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。

维基百科的定义:大数据指的是所涉及的资料量规模巨大到无法通过目前主流软件工具,在合理时间内达到撷取、管理、处理并整理成为帮助企业经营决策目的的资讯。

麦肯锡的定义:大数据是指无法在一定时间内用传统数据库软件工具对其内容进行采集、存储、管理和分析的赞据焦合。

数据挖掘的焦点集中在寻求数据挖掘过程中的可视化方法,使知识发现过程能够被用户理解,便于在知识发现过程中的人机交互;研究在网络环境卜的数据挖掘技术,特别是在Internet上建立数据挖掘和知识发现((DMKD)服务器,与数据库服务器配合,实现数据挖掘;加强对各种非结构化或半结构化数据的挖掘,如多媒体数据、文本数据和图像数据等。

5.1数据量的成倍增长挑战数据存储能力大数据及其潜在的商业价值要求使用专门的数据库技术和专用的数据存储设备,传统的数据库追求高度的数据一致性和容错性,缺乏较强的扩展性和较好的系统可用性,小能有效存储视频、音频等非结构化和半结构化的数据。

目前,数据存储能力的增长远远赶小上数据的增长,设计最合理的分层存储架构成为信息系统的关键。

5.2数据类型的多样性挑战数据挖掘能力数据类型的多样化,对传统的数据分析平台发出了挑战。

从数据库的观点看,挖掘算法的有效性和可伸缩性是实现数据挖掘的关键,而现有的算法往往适合常驻内存的小数据集,大型数据库中的数据可能无法同时导入内存,随着数据规模的小断增大,算法的效率逐渐成为数据分析流程的瓶颈。

要想彻底改变被动局面,需要对现有架构、组织体系、资源配置和权力结构进行重组。

5.3对大数据的处理速度挑战数据处理的时效性随着数据规模的小断增大,分析处理的时间相应地越来越长,而大数据条件对信息处理的时效性要求越来越高。

传统的数据挖掘技术在数据维度和规模增大时,需要的资源呈指数增长,面对PB级以上的海量数据,N1ogN甚至线性复杂度的算法都难以接受,处理大数据需要简单有效的人工智能算法和新的问题求解方法。

5.4数据跨越组织边界传播挑战信息安全随着技术的发展,大量信息跨越组织边界传播,信息安全问题相伴而生,不仅是没有价值的数据大量出现,保密数据、隐私数据也成倍增长,国家安全、知识产权、个人信息等等都面临着前所未有的安全挑战。

大数据时代,犯罪分子获取信息更加容易,人们防范、打击犯罪行为更加困难,这对数据存储的物理安全性以及数据的多副本与容灾机制提出了更高的要求。

要想应对瞬息万变的安全问题,最关键的是算法和特征,如何建立相应的强大安全防御体系来发现和识别安全漏洞是保证信息安全的重要环节。

5.5大数据时代的到来挑战人才资源从大数据中获取价值至少需要三类关键人才队伍:一是进行大数据分析的资深分析型人才;二是精通如何申请、使用大数据分析的管理者和分析家;三是实现大数据的技术支持人才。

此外,由于大数据涵盖内容广泛,所需的高端专业人才小仅包括程序员和数据库工程师,同时也需要天体物理学家、生态学家、数学和统计学家、社会网络学家和社会行为心理学家等。

可以预测,在未来几年,资深数据分析人才短缺问题将越来越突显。

同时,需要具有前瞻性思维的实干型领导者,能够基于从大数据中获得的见解和分析,制定相应策略并贯彻执行。

大数据分析与处理方法分析孔志文(广东省民政职业技术学校,广州510310)二、大数据分析的基本方面大数据分析可以划分为五个基本方而。

一是具有预测性分析能力。

分析员可以通过数据挖掘来更好地理解数据,而预测性分析是分析员在数据挖掘的基础上结合可视化分析得到的结果做出一些预测性的判断。

二是具有数据质量和数据管理能力。

数据管理和数据质量是数据分析的重点,是应用在管理方而的最佳实践,通过数据的标准化流程和工具,可以达到一个预先设定好的高质量的分析结果。

三是具有可视化分析能力。

可视化是服务于分析专家和使用用户的,数据可视化是数据分析的基木要求,它可以通过屏幕显示器直观地展示数据,提供给使用者,还可以让数据自己说话,让使用者听到结果。

四是具有数据挖掘算法。

可视化是给数据专家和使用用户提供的,数据挖掘是给机器使用的,通过集群、分割、孤立点分析等算法,深入数据内部,挖掘使用价值,数据挖掘算法不仅要处理大量的大数据,也要保持处理大数据的运行速度。

五是具有语义引擎。

语义引擎能从“文档”中只能提取信息,解决了非结构化数据多样性带来的数据分析困扰,通过语义引擎,能解析、提取、分析数据,完成使用者所需要的信息提取。

三、大数据处理方法1.大数据处理流程大数据整个处理流程可概括为四步。

一是大数据采集过程。

用户端数据通过多个数据库来接收,用户可以通过这些数据进行简单的查询和处理,在大数据采集过程中,可能有大量的用户来进行访问和操作,并发访问和使用量高,有时可峰值可达上百万,需要采集端部署大量的数据库才能支持止常运行。

二是进行大数据统计和分析过程。

统计和分析是通过对分布式计算集群内存储的数据进行分析和分类汇总,通过大数据处理方法,以满足使用者需求,统计与分析主要特点和挑战是分析所涉及的数据量大,极大地占用系统资源。

三是大数据导入和预处理过程。

因为采集端木身有很多数据库,在统计和分析数据时,如果对这些海量数据进行有效分析,还应该把来自各个前端数据导入集中的大型分布式数据库,也可以导入分布式存储集群,导入后在集群基础上再进行简单的清洗和预处理工作,导入和预处理环节主要特点是导入数据量大,每秒导入量经常达到几百兆,有时会达到千兆级别。

四是大数据挖掘过程。

数据挖掘与统计分析过程不同的是数据挖掘没有预先设定好的主题,主要在依据现有的数据进行计算,从而实现一些高级别数据分析的需求,达到预测效果。

2.大数据处理技术(1) Hadoop架构。

Hadoop是一个能够对大量数据进行分布式处理的软件框架。

Hadoop具有可靠性,能维护多个工作数据副木,可以对存储失败的节点重新分布处理。

它具有高效性,通过并行处理加快处理速度。

具有可伸缩性,能够处理PB级数据。

Hadoop架构的关键点是借助大量PC构成一个PC群难以实现对数据的处理。

处理数据时,现分析数据,后结合分配的相应电脑处理数据,最后整合数据处理结果。

浅谈数据挖掘技术及其应用舒正渝<1.西北师范大学数信学院计算机系,甘肃兰州730070; 2.兰州理工中等专业学校,甘肃兰州730050)摘要:科技的进步,特别是信息产业的发展,把我们带入了一个崭新的信息时代。

数据库管理系统的应用领域涉及到了各行各业,但目前所能做到的只是对数据库中已有的数据进行存储、查询、统计等功能,通过这些数据获得的信息量仅占整个数据库信息量的一小部分,如何才能从中提取有价值的知识,进一步提高信息量利用率,因此需要新的技术来自动、智能和快速地分析海量的原始数据,以使数据得以充分利用,由此引发了一个新的研究方向:数据挖掘与知识发现的理论与技术研究。

数据挖掘技术在分析大量数据中具有明显优势,基于数据挖掘的分析技术在金融、保险、电信等有大量数据的行业已有着广泛的应用。

2数据挖掘的定义数据挖掘(Data Mining),又称数据库中的知识发现(Knowledge Discovery in Database,简称KDD),比较公认的定义是由U. M. Fayyad等人提出的:数据挖掘就是从大量的、小完全的、有噪声的、模糊的、随机的数据集中,提取隐含在其中的、人们事先小知道的、但又是潜在的有用的信息和知识的过程,提取的知识表示为概念(Concepts)、规则(Rules)、规律(Regularities)、模式(Patterns)等形式。

数据挖掘是一种决策支持过程,分析各组织原有的数据,做出归纳的推理,从中挖掘出潜在的模式,为管理人员决策提供支持。

3数据挖掘的过程KDD的整个过程包括在指定的数据库中用数据挖掘算法提取模型,以及围绕数据挖掘所进行的预处理和结果表达等一系列的步骤,是一个需要经过反复的多次处理的过程。

整个知识发现过程是由若干挖掘步骤组成的,而数据挖掘仅是其中的一个主要步骤。

整个知识发现的主要步骤有以下几点。

3. 1目标定义阶段要求定义出明确的数据挖掘目标。

目标定义是否适度将影响到数据挖掘的成败,因此往往需要具有数据挖掘经验的技术人员和具有应用领域知识的专家以及最终用户紧密协作,一方面明确实际工作中对数据挖掘的要求,另一方面通过对各种学习算法的对比进而确定可用的算法。

3. 2数据准备阶段数据准备在整个数据挖掘过程中占的比例最大,通常达到60%左右。

这个阶段又可以进一步划分成三个子步骤:数据选择(DataSelection),数据预处理(Data Processing)和数据变换(Data Transformation)。

数据选择主要指从已存在的数据库或数据仓库中提取相关数据,形成目标数据(Target Data)。

数据预处理对提取的数据进行处理,使之符合数据挖掘的要求。

数据变换的主要目的是精减数据维数,即从初始特征中找出真正有用的特征以减少数据挖掘时要考虑的特征或变量个数。

3. 3数据挖掘阶段这一阶段进行实际的挖掘工作。

首先是算法规划,即决定采用何种类型的数据挖掘方法。

然后,针对该挖掘方法选择一种算法。

完成了上述的准备工作后,就可以运行数据挖掘算法模块了。

这个阶段是数据挖掘分析者和相关领域专家最关心的阶段,也可以称之为真正意义上的数据挖掘。

3. 4结果解释和评估阶段根据最终用户的决策目的对提取的信息进行分析,把最有价值的信息提取出来。

对于数据挖掘阶段发现的模式还要经过用户或机器的评估,对于存在冗余或无关的模式要将其删除;对于小能满足用户要求的模式,则需要退回到上一阶段。

另外,数据挖掘面对的最终用户是人,因此要对发现的模式进行可视化,或者把结果转换为用户易懂的其他方式。

4数据挖掘的研究方向目前研究主要从以卜几个方面开展:<1)针对小同的数据挖掘任务开发专用的数据挖掘系统。

一个功能很强的数据挖掘系统要能够处理各种类型的数据是小现实的,应当根据特定类型数据的挖掘任务构造专用的数据挖掘系统,如关系数据库挖掘,空问数据库挖掘等。

<2)高效率的挖掘算法。

数据挖掘算法必须是高效的,即算法的运行时问必须是可预测的和可接受的,带有指数甚至是中阶多项式的算法,没有实际使用价值。

<3)提高数据挖掘结果的有效性、确定性和可表达性。

对已发现的知识应能准确地描述数据库中的内容,并能用于实际领域。

对有缺陷的数据应当根据小确定性度量,以近似规律或定量规则形式表示出来。

还应能很好地处理和抑制噪声数据和小希望的数据。