蜘蛛程序 网络爬虫 源代码

- 格式:docx

- 大小:23.41 KB

- 文档页数:7

网络爬虫的六种方式突然对网络爬虫特别感兴趣,所以就上网查询了下,发现这个特别好。

给大家分享下。

现在有越来越多的人热衷于做网络爬虫(网络蜘蛛),也有越来越多的地方需要网络爬虫,比如搜索引擎、资讯采集、舆情监测等等,诸如此类。

网络爬虫涉及到的技术(算法/策略)广而复杂,如网页获取、网页跟踪、网页分析、网页搜索、网页评级和结构/非结构化数据抽取以及后期更细粒度的数据挖掘等方方面面,对于新手来说,不是一朝一夕便能完全掌握且熟练应用的,对于作者来说,更无法在一篇文章内就将其说清楚。

因此在本篇文章中,我们仅将视线聚焦在网络爬虫的最基础技术——网页抓取方面。

说到网页抓取,往往有两个点是不得不说的,首先是网页编码的识别,另外一个是对网页脚本运行的支持,除此之外,是否支持以POST方式提交请求和支持自动的cookie管理也是很多人所关注的重要方面。

其实Java世界里,已经有很多开源的组件来支持各种各样方式的网页抓取了,包括上面提到的四个重点,所以说使用Java做网页抓取还是比较容易的。

下面,作者将重点介绍其中的六种方式。

HttpClientHttpClient 是 Apache Jakarta Common 下的子项目,可以用来提供高效的、最新的、功能丰富的支持HTTP 协议的客户端编程工具包,并且它支持 HTTP 协议最新的版本和建议。

以下列出的是 HttpClient 提供的主要的功能,要知道更多详细的功能可以参见 HttpClient 的主页。

(1)实现了所有 HTTP 的方法(GET,POST,PUT,HEAD 等)(2)支持自动转向(3)支持 HTTPS 协议(4)支持代理服务器(5)支持自动的Cookies管理等Java爬虫开发中应用最多的一种网页获取技术,速度和性能一流,在功能支持方面显得较为底层,不支持JS脚本执行和CSS解析、渲染等准浏览器功能,推荐用于需要快速获取网页而无需解析脚本和CSS 的场景。

He ritri x是一个开源,可扩展的web爬虫项目。

H eritr ix设计成严格按照r obots.txt文件的排除指示和MET A rob ots标签。

htt p://c rawle r.arc hive.org/WebS PHINXWebS PHINX是一个Ja va类包和Web爬虫的交互式开发环境。

W eb爬虫(也叫作机器人或蜘蛛)是可以自动浏览与处理Web页面的程序。

W ebSPH INX由两部分组成:爬虫工作平台和Web SPHIN X类包。

http://www.cs.c mu.ed u/~rc m/web sphin x/W ebLec hWeb Lech是一个功能强大的Web站点下载与镜像工具。

它支持按功能需求来下载web站点并能够尽可能模仿标准Web浏览器的行为。

WebL ech有一个功能控制台并采用多线程操作。

http://we blech.sour cefor ge.ne t/A raleArale主要为个人使用而设计,而没有像其它爬虫一样是关注于页面索引。

Arale能够下载整个web站点或来自w eb站点的某些资源。

Arale还能够把动态页面映射成静态页面。

htt p://w eb.ti scali.it/_flat/arale.jsp.htmlJ-Sp iderJ-Spi der:是一个完全可配置和定制的WebSpide r引擎.你可以利用它来检查网站的错误(内在的服务器错误等),网站内外部链接检查,分析网站的结构(可创建一个网站地图),下载整个We b站点,你还可以写一个JSpi der插件来扩展你所需要的功能。

spider简介以及基础⽅法(第⼀章)查看⽹站结构import builtwithprint builtwith.parse("")最原始的爬⾍import urllib2def download(url):print"down", urltry:html = urllib2.urlopen(url).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Nonereturn htmlprint download("")增加递归import urllib2def download(url, num_retries):print"down", urltry:html = urllib2.urlopen(url).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif hasattr(e, "code") and 500 <= e.code <600:# recursively retry 5xx HTTP errorsreturn download(url, num_retries-1)return htmlprint download("",2)⽤户代理import urllib2def download(url, user_agent = "wswp", num_retries = 2):print"down",urlheaders = {"User_agent":user_agent}request = urllib2.Request(url, headers=headers)try:html = urllib2.urlopen(request).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif hasattr(e, "code") and 500 <= e.code < 600:# recursively retry 5xx Http errorsreturn download(url, user_agent, num_retries-1)return htmlprint download("")运⽤上述的download脚本读不出标签(问题:可能是标签不存在)import redef crawl_sitemap(url):# download the sitemapsite_map = download(url)print"site_map", site_map# extract the sitemap linkslinks = re.findall('<loc>(.*?)</loc>', site_map)print'links', links# download each linkfor link in links:html = download(links)crawl_sitemap("/sitmap.xml")对ID进⾏遍历,直到出错为⽌import itertools # ⽆限迭代器for page in itertools.count(1):url = "/view/-%d" % pagehtml = download(url)if html is None:breakelse:pass若ID出现中间被删除,就⽆法连续⾃动退出,为了解决这种问题,脚本加⼊连续判断5次,若都为空,就结束import itertoolsmax_error = 5 # 最⼤错误值num_error = 0 # 现有错误for page in itertools.count(1):url = "/view/-%d" % pagehtml = download(url)if html is None:num_error += 1if num_error == max_error:break# 若连续5次错误,程序结束else:num_error = 0 # 若错误不是连续的,则变量归0链接爬⾍import redef get_link(html):"""return a list of links from html"""webpage_regex = pile('<a[^>]+href=["\'](.*?)["\']', re.IGNORECASE) # re.IGNORECASE 忽略⼤⼩写return webpage_regex.findall(html)def link_crawler(seed_url, link_regex):""""""crawl_queue = [seed_url]while crawl_queue:url = crawl_queue.pop()html = download(url)for link in get_link(html):if re.match(link_regex, link):crawl_queue.append(link)python HTTP模块requests 来实现⽀持代理的功能import urlparseproxy = ""opener = urllib2.build_opener()proxy_params = {urlparse.urlparse(url).scheme: proxy}opener.add_handler(urllib2.ProxyHandler(proxy_params))response = opener.open(request)新版本的download函数def download(url, user_agent="wswp", proxy=None, num_retries=2):print"DownLoading", urlheaders = {"User-agent": user_agent}request = urllib2.Request(url, headers=headers)opener = urllib2.build_opener()if proxy:proxy_params = {urlparse.urlparse(url).scheme: proxy}opener.add_handler(urllib2.ProxyHandler(proxy_params))try:html = opener.open(request).read()except urllib2.URLError as e:print"download error", e.reasonhtml = Noneif num_retries > 0:if hasattr(e, "code") and 500 <= e.code <600:# retry 5xx http errorhtml = download(url, user_agent, proxy, num_retries-1)return html下载限速(两次下载中添加延时)import timeimport datetimeclass Throttle:"""Add a delay between downloads to the same domain"""def__init__(self, delay):# amount of delay between downloads for each domainself.delay = delay# timestamp of when a domain was last accessedself.domains = {}def wait(self, url):domain = urlparse.urlparse(url).netloclast_accessed = self.domains.get(domain)if self.delay > 0 and last_accessed is not None:sleep_secs = self.delay - (datetime.datetime.now() - last_accessed).seconds if sleep_secs > 0:# domain has been accessd recently# so need to sleeptime.sleep(sleep_secs)# update the last accessed timeself.domains[domain] = datetime.datetime.now()实例操作延时throttle = Throttle(delay)throttle.wait(url)result = download(url, headers, proxy=proxy, num_retries=num_retries)"""爬⾍陷阱(有些⽹站会动态⽣成内容如:下⼀⽉,下⼀年这种⽆限递归)⽅法:添加深度限制,修改seen变量(该变量原本只记录访问过的链接,现在修改成为⼀个字典,增加了页⾯深度记录)"""def link_crawler(... , max_depth=2):max_depth = 2...depth = seen[url]if depth != max_depth:for link in links:if link not in seen:seen[link] = depth + 1crawl_queue.append(link)"""禁⽤该功能把max_depth设成负数就永远不会相等"""调⽤最终版本seed_url = "/index"link_regex = "/(index|view)"link_crawler(seed_url, link_regex, user_agent="BadCrawler") # user_agent="BadCrawler"⽤户代理被屏蔽程序运⾏不了link_crawler(seed_url, link_regex, max_depth=1) # 这是使⽤默认⽤户代理的,深度为1。

Python爬虫项目实战源代码集锦为了满足标题描述的内容需求,下面是一些Python爬虫项目实战的源代码示例,供参考和学习。

1. 爬取网页数据import requests# 发送HTTP请求获取网页内容response = requests.get(url)content = response.text# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...2. 爬取图片import requests# 发送HTTP请求获取图片资源response = requests.get(image_url)# 保存图片到本地with open('image.jpg', 'wb') as f:f.write(response.content)3. 爬取动态网页from selenium import webdriver # 启动浏览器驱动driver = webdriver.Chrome()# 打开动态网页driver.get(url)# 等待动态内容加载完成# ...# 提取所需信息# ...# 存储数据# ...4. 登录网站并获取数据import requests# 登录网站login_data = {'username': 'your_username','password': 'your_password'}session = requests.Session() session.post(login_url, data=login_data) # 发送登录后的请求response = session.get(url)# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...5. 反爬虫处理import requestsfrom fake_useragent import UserAgent # 构造随机HTTP请求头user_agent = UserAgent().random# 发送带有伪装的HTTP请求headers = {'User-Agent': user_agent}response = requests.get(url, headers=headers)# 解析网页内容# ...# 提取所需信息# ...# 存储数据# ...以上是一些Python爬虫项目实战源代码的简单示例,可以根据具体项目的需求进行修改和扩展。

python 爬虫常规代码Python爬虫常规代码是指用Python编写的用于网页数据抓取和提取的代码。

爬虫是一种自动化程序,可以模拟人类在网页浏览器中的行为,从而获取所需的信息。

在这篇文章中,我们将一步一步地回答关于Python 爬虫常规代码的问题,帮助读者了解如何编写自己的爬虫程序。

第一步:安装Python和必要的库首先,我们需要安装Python和一些必要的库来编写爬虫代码。

Python 是一种流行的编程语言,可以用于开发各种应用程序,包括爬虫。

对于Python的版本,我们建议使用Python 3.x。

然后,我们需要安装一些常用的爬虫库,例如requests和beautifulsoup4。

可以使用pip命令来安装它们:pip install requestspip install beautifulsoup4第二步:发送HTTP请求在编写爬虫代码之前,我们首先需要发送HTTP请求以获取网页的内容。

这可以使用requests库来实现。

以下是一个简单的例子:pythonimport requestsurl = "response = requests.get(url)if response.status_code == 200:content = response.textprint(content)在这个例子中,我们首先指定了要访问的URL,然后使用requests库的get方法发送一个GET请求。

如果响应的状态码是200,表示请求成功,我们就可以从response对象中获取网页内容,并打印出来。

第三步:解析网页内容获取网页的原始内容后,我们通常需要解析网页,提取所需的信息。

这可以使用beautifulsoup4库来实现。

下面是一个示例:pythonfrom bs4 import BeautifulSoup# 假设content是之前获取的网页内容soup = BeautifulSoup(content, "html.parser")# 使用soup对象进行解析在这个例子中,我们首先导入了BeautifulSoup类并创建了一个soup对象,该对象将用于解析网页内容。

Python网络爬虫实践教程一、什么是网络爬虫网络爬虫,也称为网络蜘蛛或网络机器人,是一种自动获取互联网信息的程序工具。

通过模拟浏览器行为,爬虫程序可以访问网页、提取网页中的数据,在大规模数据采集、搜索引擎、数据分析等领域发挥着重要作用。

二、网络爬虫的基本原理网络爬虫的基本原理是通过发送HTTP请求,并解析响应得到的HTML文档来获取网页数据。

首先,我们需要使用Python中的requests库发送网络请求,并获得服务器的响应。

然后,通过解析HTML文档,提取出我们需要的数据。

三、准备工作在开始编写网络爬虫之前,我们需要安装Python以及相关的库。

首先,需要安装Python解释器和pip包管理工具。

然后,使用pip安装requests、beautifulsoup和lxml等库。

四、发送HTTP请求在编写爬虫程序之前,我们需要了解如何使用Python发送HTTP请求。

使用requests库发送GET请求非常简单,只需要调用get方法,并提供目标网址即可。

如果需要发送POST请求,同样使用post方法,并在参数中传递需要提交的数据。

五、解析HTML文档解析HTML文档是爬虫中非常重要的一步。

Python提供了多种解析HTML的库,其中比较常用的是beautifulsoup和lxml。

通过指定解析器,我们可以轻松地提取出HTML文档中的各个元素,并进行进一步的处理。

六、处理反爬机制为了阻止爬虫程序的访问,许多网站采取了反爬机制,例如设置验证码、限制IP访问频率等。

对于这些反爬措施,我们可以通过使用代理IP、设置请求头信息、使用验证码识别技术等方法来绕过。

七、数据存储与分析在爬虫过程中,我们通常需要将获取的数据进行存储和分析。

常用的数据存储方式包括将数据保存到数据库、文本文件、Excel 表格或者CSV文件中。

而要对数据进行分析,可以使用Python中的数据分析库,如pandas、numpy等。

八、实践案例:爬取豆瓣电影数据为了更好地理解网络爬虫的实践过程,我们以爬取豆瓣电影数据为例进行讲解。

搜索引擎/网络蜘蛛程序代码关于搜索引擎的相关知识国外开发的相关程序

一、Nutch

官方网站

中文站点

最新版本:NutchReleased

Nutch是一个开源Java实现的搜索引擎。

它提供了咱们运行自己的搜索引擎所需的全数工具,能够成立自己内部网的搜索引擎,也能够针对整个网络成立搜索引擎。

自由(Free)而免费(Free)。

二、Lucene

官方网站

中文站点

Lucene是apache软件基金会jakarta项目组的一个子项目,是一个开放源代码的全文检索引擎工具包[用Java写的],即它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部份文本分析引擎(英文与德文两种西方语言)。

Lucene的目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或是以此为基础成立起完整的全文检索引擎。

3、Larbin:

larbin是一种开源的网络爬虫/网络蜘蛛,由法国的年轻人SébastienAilleret 独立开发。

larbin目的是能够跟踪页面的url进行扩展的抓取,最后为搜索引擎提供普遍的数据来源。

蜘蛛程序的名词解释是蜘蛛程序的名词解释是“网络爬虫”网络爬虫,又称为蜘蛛程序、网络机器人,是一种能够自动浏览互联网信息的计算机程序。

它们为搜索引擎和其他应用程序收集网页,并将这些网页内容保存在数据库中,以便后续使用和分析。

网络爬虫的工作原理类似于现实生活中的蜘蛛。

它们从一个起始点(通常是一个特定的网页)开始,根据预设的规则和策略,沿着网页之间的链接不断爬行,将访问到的网页内容保存下来。

这些链接可以是超链接,也可以是表单提交等方式。

通过这种方式,网络爬虫可以覆盖并获取大量的网页信息。

网络爬虫的应用广泛,其中最常见的应用就是搜索引擎。

搜索引擎通过网络爬虫收集尽可能多的网页,然后对这些网页进行处理和索引,以便用户能够方便地找到所需的信息。

网络爬虫通过分析网页的标题、内容、链接等信息,搜索引擎可以建立起一个庞大的网页索引库,为用户提供准确、全面的搜索结果。

除了搜索引擎,网络爬虫还被广泛应用于数据挖掘和其他领域的研究中。

通过爬取互联网上的大量数据,研究人员可以对数据进行分析和挖掘,从中发现有价值的信息和规律。

例如,在市场调研中,研究人员可以爬取相关行业的网页数据来了解市场动态和竞争对手的情况。

在金融领域,网络爬虫可以帮助投资者获取最新的股票数据,并进行分析和预测。

然而,网络爬虫也面临着一些挑战和限制。

首先,由于互联网上的信息量庞大,网络爬虫可能无法有效地覆盖所有的网页。

其次,有些网站会设置反爬虫机制,限制爬虫程序的访问,并对其进行识别和封锁。

此外,网络爬虫在访问网页时需要消耗大量的带宽和计算资源,对服务器造成一定的负担,因此应该遵守相关的爬虫规范和道德准则。

为了提高网络爬虫的效率和准确性,研究人员不断提出新的算法和技术。

例如,基于机器学习和自然语言处理的技术可以帮助爬虫程序更好地理解和解析网页内容,从而提高数据的质量。

此外,分布式爬虫系统可以同时运行多个爬虫程序,从而加快数据的收集和处理速度。

总的来说,网络爬虫是一种能够自动浏览互联网信息的计算机程序。

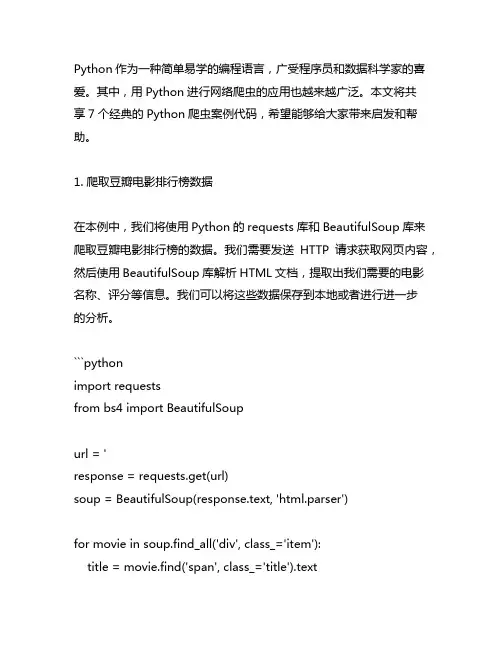

Python作为一种简单易学的编程语言,广受程序员和数据科学家的喜爱。

其中,用Python进行网络爬虫的应用也越来越广泛。

本文将共享7个经典的Python爬虫案例代码,希望能够给大家带来启发和帮助。

1. 爬取豆瓣电影排行榜数据在本例中,我们将使用Python的requests库和BeautifulSoup库来爬取豆瓣电影排行榜的数据。

我们需要发送HTTP请求获取网页内容,然后使用BeautifulSoup库解析HTML文档,提取出我们需要的电影名称、评分等信息。

我们可以将这些数据保存到本地或者进行进一步的分析。

```pythonimport requestsfrom bs4 import BeautifulSoupurl = 'response = requests.get(url)soup = BeautifulSoup(response.text, 'html.parser')for movie in soup.find_all('div', class_='item'):title = movie.find('span', class_='title').textrating = movie.find('span', class_='rating_num').textprint(title, rating)```2. 爬取博博用户信息在这个案例中,我们将利用Python的requests库和正则表达式来爬取博博用户的基本信息。

我们需要登录博博并获取用户主页的URL,然后发送HTTP请求获取用户主页的HTML文档。

我们可以使用正则表达式来提取用户的昵称、性别、位置区域等信息。

我们可以将这些信息保存到数据库或者进行其他处理。

```pythonimport requestsimport reurl = 'response = requests.get(url)pattern = repile(r'<title>(.*?)</title>.*?昵称:(.*?)<.*?性别:(.*?)<.*?地区:(.*?)<', re.S)result = re.search(pattern, response.text)if result:username = result.group(2)gender = result.group(3)location = result.group(4)print(username, gender, location)```3. 爬取新浪新闻在这个案例中,我们将使用Python的requests库和XPath来爬取新浪新闻的标题和信息。

Python爬虫入门教程[Python]网络爬虫(一):网络爬虫的定义网络爬虫,即Web Spider,是一个很形象的名字。

把互联网比喻成一个蜘蛛网,那么Spider就是在网上爬来爬去的蜘蛛。

网络蜘蛛是通过网页的链接地址来寻找网页的。

从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。

如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。

这样看来,网络爬虫就是一个爬行程序,一个抓取网页的程序。

网络爬虫的基本操作是抓取网页。

那么如何才能随心所欲地获得自己想要的页面?我们先从URL开始。

二、浏览网页的过程抓取网页的过程其实和读者平时使用IE浏览器浏览网页的道理是一样的。

比如说你在浏览器的地址栏中输入 这个地址。

打开网页的过程其实就是浏览器作为一个浏览的“客户端”,向服务器端发送了一次请求,把服务器端的文件“抓”到本地,再进行解释、展现。

HTML是一种标记语言,用标签标记内容并加以解析和区分。

浏览器的功能是将获取到的HTML代码进行解析,然后将原始的代码转变成我们直接看到的网站页面。

三、URI和URL的概念和举例简单的来讲,URL就是在浏览器端输入的 这个字符串。

在理解URL之前,首先要理解URI的概念。

什么是URI?Web上每种可用的资源,如HTML文档、图像、视频片段、程序等都由一个通用资源标志符(Universal Resource Identifier,URI)进行定位。

URI通常由三部分组成:①访问资源的命名机制;②存放资源的主机名;③资源自身的名称,由路径表示。

如下面的URI:/myhtml/html1223/我们可以这样解释它:①这是一个可以通过HTTP协议访问的资源,②位于主机上,③通过路径“/html/html40”访问。

四、URL的理解和举例URL是URI的一个子集。

最简单的爬虫代码

最简单的爬虫代码通常涉及使用Python和一个网络请求库,如`requests`,来获取网页内容。

以下是一个非常简单的示例,使用Python中的`requests`库爬取一个网页:

首先,确保你已经安装了`requests`库。

你可以通过以下命令安装:

```bash

pip install requests

```

然后,使用以下代码实现一个简单的爬虫:

```python

import requests

# 目标网页的URL

url = ''

# 发送HTTP GET请求获取页面内容

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 打印页面内容

print(response.text)

else:

print('Failed to retrieve the page. Status code:', response.status_code)

```

这段代码执行以下步骤:

1. 导入`requests`库。

2. 指定目标网页的URL。

3. 使用`requests.get(url)`发送HTTP GET请求获取网页内容。

4. 检查响应的状态码,如果为200表示成功,打印页面内容;否则,打印错误信息。

请注意,这只是一个非常简单的例子。

实际的爬虫可能需要更复杂的处理,包括处理页面内容、解析HTML、处理网页链接等。

在实际应用中,你可能会考虑使用更强大的爬虫框架,如Scrapy。

python爬⾍之spider⽤法Spider类定义了如何爬取某个⽹站, 包括爬取的动作以及如何从⽹页内容中提取结构化的数据, 总的来说spider就是定义爬取的动作以及分析某个⽹页.⼯作流程分析 : 1. 以初始的URLRequest, 并设置回调函数, 当该requeset下载完毕并返回时, 将⽣成response, 并作为参数传递给回调函数. spider中初始的request是通过start_requests()来获取的. start_requests()获取start_urls中的URL, 并以parse以回调函数⽣成Request 2. 在回调函数内分析返回的⽹页内容, 可以返回item对象, 或者Dict,或者Request, 以及是⼀个包含三者的可迭代的容器, 返回的Request对象之后会经过Scrapy 处理, 下载相应的内容, 并调⽤设置的callback函数. 3. 在回调函数, 可以通过lxml, bs4, xpath, css等⽅法获取我们想要的内容⽣成item 4. 最后将item传送给pipeline处理源码分析 : 在spiders下写爬⾍的时候, 并没有写start_request来处理start_urls处理start_urls中的url, 这是因为在继承的scrapy.Spider中已经写过了 在上述源码中可以看出在⽗类⾥实现了start_requests⽅法, 通过make_requests_from_url做了Request请求 上图中, parse回调函数中的response就是⽗类中start_requests⽅法调⽤make_requests_from_url返回的结果, 并且在parse回调函数中可以继续返回Request,就像代码中yield request()并设置回调函数.spider内的⼀些常⽤属性 : 所有⾃⼰写的爬⾍都是继承于spider.Spider这个类 name: 定义爬⾍名字, 通过命令启动的额时候⽤的就是这个名字, 这个名字必须唯⼀ allowed_domains: 包含了spider允许爬取的域名列表. 当offsiteMiddleware启⽤时, 域名不在列表中URL不会被访问, 所以在爬⾍⽂件中, 每次⽣成Request请求时都会进⾏和这⾥的域名进⾏判断. start_urls: 其实的URL列表 这⾥会通过spider.Spider⽅法调⽤start_request循环请求这个列表中的每个地址 custom_settings: ⾃定义配置, 可以覆盖settings的配置, 主要⽤于当我们队怕重有特定需求设置的时候 设置的以字典的⽅式设置: custom_settings = {} from_crawler: ⼀个类⽅法, 可以通过crawler.settings.get()这种⽅式获取settings配置⽂件中的信息. 同时这个也可以在pipeline中使⽤ start_requests(): 此⽅法必须返回⼀个可迭代对象, 该对象包含了spider⽤于爬取的第⼀个Request请求 此⽅法是在被继承的⽗类中spider.Spider中写的, 默认是通过get请求, 如果需要修改最开始的这个请求, 可以重写这个⽅法, 如想通过post请求 make_requests_from_url(url): 此房也是在⽗类中start_requests调⽤的, 可以重写 parse(response): 默认的回调函数 负责处理response并返回处理的数据以及跟进的url 该⽅法以及其他的Request回调函数必须返回⼀个⽽包含Request或者item的可迭代对象.。

.版本2.支持库RegEx.支持库EThread.支持库internet.支持库iext.程序集窗口程序集1.程序集变量多线程证书变量,整数型.程序集变量多线程证书变量a,整数型.程序集变量多线程证书变量b,整数型.程序集变量多线程句柄变量,整数型.程序集变量表项索引,整数型.程序集变量序号,整数型.程序集变量多线程句柄变量a,整数型.程序集变量多线程句柄变量b,整数型.子程序_按钮1_被单击时钟1.时钟周期=100.子程序子程序1.局部变量搜索,正则表达式.局部变量titleso,正则表达式.局部变量临时内容,文本型.局部变量n,搜索结果,,"0".局部变量nn,搜索结果,,"0".局部变量i,整数型.局部变量ii,整数型.局部变量m,整数型.局部变量网站标题,文本型.局部变量网站地址,文本型.局部变量输出地址,文本型.局部变量字节集a,字节集进入许可区(多线程证书变量)临时内容=到文本(HTTP读文件(编辑框1.内容))搜索.创建(“href=”+#引号+“(h.*?)”+#引号,)n=搜索.搜索全部(临时内容).计次循环首(取数组成员数(n),i)输出地址=到文本(HTTP读文件(到文本(n[i].取子匹配文本(临时内容,1,)))) titleso.创建(“<title>(.*?)</title>”,)nn=titleso.搜索全部(输出地址)网站地址=到文本(n[i].取子匹配文本(临时内容,1,)).计次循环首(取数组成员数(nn),ii)网站标题=删全部空(到文本(nn[ii].取子匹配文本(输出地址,1,))) .计次循环尾().如果真(网站标题>“”且网站地址>“”)序号=序号+1表项索引=超级列表框1.插入表项(,到文本(序号),,,,)超级列表框1.置标题(表项索引,0,网站标题)超级列表框1.置标题(表项索引,1,网站地址).如果真结束.计次循环尾()退出许可区(多线程证书变量)进入许可区(多线程证书变量a)临时内容=到文本(HTTP读文件(编辑框1.内容))搜索.创建(“href=”+#引号+“(h.*?)”+#引号,)n=搜索.搜索全部(临时内容).计次循环首(取数组成员数(n),i)输出地址=到文本(HTTP读文件(到文本(n[i].取子匹配文本(临时内容,1,)))) titleso.创建(“<title>(.*?)</title>”,)nn=titleso.搜索全部(输出地址)网站地址=到文本(n[i].取子匹配文本(临时内容,1,)).计次循环首(取数组成员数(nn),ii)网站标题=删全部空(到文本(nn[ii].取子匹配文本(输出地址,1,)))退出许可区(多线程证书变量).计次循环尾().如果真(网站标题>“”且网站地址>“”)序号=序号+1表项索引=超级列表框1.插入表项(,到文本(序号),,,,)超级列表框1.置标题(表项索引,0,网站标题)超级列表框1.置标题(表项索引,1,网站地址).如果真结束.计次循环尾()退出许可区(多线程证书变量a)进入许可区(多线程证书变量b)临时内容=到文本(HTTP读文件(编辑框1.内容))搜索.创建(“href=”+#引号+“(h.*?)”+#引号,)n=搜索.搜索全部(临时内容).计次循环首(取数组成员数(n),i)输出地址=到文本(HTTP读文件(到文本(n[i].取子匹配文本(临时内容,1,)))) titleso.创建(“<title>(.*?)</title>”,)nn=titleso.搜索全部(输出地址)网站地址=到文本(n[i].取子匹配文本(临时内容,1,)).计次循环首(取数组成员数(nn),ii)网站标题=删全部空(到文本(nn[ii].取子匹配文本(输出地址,1,))).计次循环尾().如果真(网站标题>“”且网站地址>“”)序号=序号+1表项索引=超级列表框1.插入表项(,到文本(序号),,,,)超级列表框1.置标题(表项索引,0,网站标题)超级列表框1.置标题(表项索引,1,网站地址).如果真结束.计次循环尾()退出许可区(多线程证书变量b).子程序__启动窗口_创建完毕多线程证书变量=创建进入许可证()多线程证书变量a=创建进入许可证()多线程证书变量b=创建进入许可证().子程序__启动窗口_可否被关闭,逻辑型删除进入许可证(多线程证书变量)删除进入许可证(多线程证书变量a)删除进入许可证(多线程证书变量b).子程序_按钮2_被单击强制结束线程(多线程句柄变量)强制结束线程(多线程句柄变量a)强制结束线程(多线程句柄变量b).子程序_时钟1_周期事件启动线程(&子程序1,,多线程句柄变量)启动线程(&子程序1,,多线程句柄变量a)启动线程(&子程序1,,多线程句柄变量b)。

28个python爬⾍项⽬,看完这些你离爬⾍⾼⼿就不远了互联⽹的数据爆炸式的增长,⽽利⽤ Python 爬⾍我们可以获取⼤量有价值的数据:1.爬取数据,进⾏市场调研和商业分析爬取知乎优质答案,筛选各话题下最优质的内容;抓取房产⽹站买卖信息,分析房价变化趋势、做不同区域的房价分析;爬取招聘⽹站职位信息,分析各⾏业⼈才需求情况及薪资⽔平。

2.作为机器学习、数据挖掘的原始数据⽐如你要做⼀个推荐系统,那么你可以去爬取更多维度的数据,做出更好的模型。

3.爬取优质的资源:图⽚、⽂本、视频爬取商品(店铺)评论以及各种图⽚⽹站,获得图⽚资源以及评论⽂本数据。

掌握正确的⽅法,在短时间内做到能够爬取主流⽹站的数据,其实⾮常容易实现。

但建议你从⼀开始就要有⼀个具体的⽬标,在⽬标的驱动下,你的学习才会更加精准和⾼效。

这⾥给你⼀条平滑的、零基础快速⼊门的学习路径:1.了解爬⾍的基本原理及过程2.Requests+Xpath 实现通⽤爬⾍套路3.了解⾮结构化数据的存储4.应对特殊⽹站的反爬⾍措施5.Scrapy 与 MongoDB,进阶分布式下⾯给⼤家展⽰⼀些爬⾍项⽬:有些项⽬可能⽐较⽼了,不能⽤了,⼤家可以参考⼀下,重要的是⼀个思路,借鉴前⼈的⼀些经验,希望能帮到⼤家(1)微信公众号爬⾍地址:https:///Chyroc/WechatSogou基于搜狗微信搜索的微信公众号爬⾍接⼝,可以扩展成基于搜狗搜索的爬⾍,返回结果是列表,每⼀项均是公众号具体信息字典。

(2)⾖瓣读书爬⾍地址:https:///lanbing510/DouBanSpider可以爬下⾖瓣读书标签下的所有图书,按评分排名依次存储,存储到Excel中,可⽅便⼤家筛选搜罗,⽐如筛选评价⼈数>1000的⾼分书籍;可依据不同的主题存储到Excel不同的Sheet ,采⽤User Agent伪装为浏览器进⾏爬取,并加⼊随机延时来更好的模仿浏览器⾏为,避免爬⾍被封。

有一天突然看了htmlparser工具包发现果然强大。

由于不是很熟悉所以下面代码或许写的有点烂。

首先做准备工作先写一个实体beanpackage bean; import java.util.Date;/*** @author Jeson* blog * @date:Oct 9, 2009 3:09:19 PM* @version :1.0**/publicclass Artical {private String title;private String body;private String link;private String author;private String [] tags;private Date dCreate;public String getTitle() {return title;}publicvoid setTitle(String title) {this.title = title;}public String getBody() {return body;}publicvoid setBody(String body) {this.body = body;}public String getLink() {return link;}publicvoid setLink(String link) {this.link = link;}public String getAuthor() {return author;}publicvoid setAuthor(String author) {this.author = author;}public String[] getTags() {return tags;}publicvoid setTags(String[] tags) {this.tags = tags;}public Date getDCreate() {return dCreate;}publicvoid setDCreate(Date create) {dCreate = create;}}2 写一个我们下面要用到的字符串处理类package util;import java.io.BufferedReader;import java.io.IOException;import java.io.InputStream;import java.io.InputStreamReader;import java.io.UnsupportedEncodingException;import java.util.regex.Matcher;import java.util.regex.Pattern;/*** @author Jeson* blog * @date:Oct 9, 2009 3:09:19 PM * @version:1.0 */publicclass StringUtil {/*** 使用正则匹配字符串** @param regex* 正则表达式* @param txt* 要验证的字符串* @return匹配则返回真否则返回假*/publicstaticboolean useRegex(String regex, String txt) {Pattern p = pile(regex);Matcher m = p.matcher(txt);return m.matches();}/*** 使用正则匹配字符串** @param regex* 正则表达式 ** @param index* 要取第几个元素* @param txt* 要验证的字符串* @return返回匹配的字符串*/publicstatic String getByRegex(String regex, int index, String txt) {Pattern p = pile(regex);Matcher m = p.matcher(txt);if (m.find()) {return m.group(index);}returnnull;}/*** 使用正则匹配字符串** @param regex* 正则表达式 ** @param index* 要取第几个元素* @param txt* 要验证的字符串* @return返回匹配的字符串数组*/publicstatic String [] getStringsByRegex(String regex, int[] index, String txt) {String res [] = new String[index.length];Pattern p = pile(regex);Matcher m = p.matcher(txt);if (m.find()) {for(int i : index){res[i] = m.group(i);}}return res;}}3 下面是我们的核心类他会去抓取cnblogs的页面并保存package test; import java.io.File;import java.io.FileNotFoundException;import java.io.FileOutputStream;import java.io.IOException;import java.io.OutputStream;import org.htmlparser.NodeFilter;import org.htmlparser.Parser;import org.htmlparser.filters.HasAttributeFilter; import org.htmlparser.util.NodeList;import bean.Artical;import util.StringUtil;/*** @author Jeson* @blog * @date:Oct 9, 2009 1:08:10 PM* @version :1.0**/publicclass Parse {privatestaticfinalint MAX_PAGE = 20;privatefinal String ENCODING = "UTF-8";/*** @param args*/publicstaticvoid main(String[] args) {try {for(int i=1;i<MAX_PAGE;i++){new Parse().testAttribute(i);}} catch (Exception e) {// TODO Auto-generated catch blocke.printStackTrace();}}privatevoid testAttribute(int pa) throws Exception{System.out.println("————开始解析页面:"+pa);Parser p = new Parser();p.setURL("/cate/java/?page="+pa);p.setEncoding("UTF-8");NodeFilter filter = new HasAttributeFilter("class","titlelnk");NodeList list = p.extractAllNodesThatMatch(filter);System.out.println(list.size());int cou = 0;for(int i=0 ; i<list.size();i++){String html = list.elementAt(i).toHtml(true);int [] index = {0,1,2};String [] bs = StringUtil.getStringsByRegex("<aclass=\\"titlelnk\\" href=\\"(.*)\\" target=\\"_blank\\">(.*)</a>", index, html);String title = bs[2];String url = bs[1];System.out.println(url);String content = getContent(bs[1]);if(content == null || "".equals(content)){continue;}Artical art = new Artical();art.setTitle(title);art.setBody(content);art.setLink(url);createFile(art);System.out.println("=========="+(i+1)+"============");System.out.println("title==>"+bs[2]);System.out.println("url==>"+bs[1]);System.out.println("content==>"+getContent(bs[1]));System.out.println("======================");System.out.println();cou++;}System.out.println("over"+cou);}private String getContent(String url) throws Exception{Parser p = new Parser();p.setURL(url);p.setEncoding(ENCODING);NodeFilter filter = new HasAttributeFilter("class","post");NodeList list = p.extractAllNodesThatMatch(filter);String a = list.toHtml();return a;}privatevoid createFile(Artical art){try {File d = new File("d:\\\\cnblog");if(!d.exists()){d.mkdir();}File f = newFile("d:\\\\cnblog\\\\"+art.getTitle()+".html");if(!f.exists()){f.createNewFile();System.out.println("——–>"+art.getTitle()+"文件已经创建");}OutputStream file = new FileOutputStream(f.getPath());file.write(art.getBody().getBytes());file.flush();file.close();System.out.println("文件写入完毕,地址"+f.getPath());} catch (FileNotFoundException e) {e.printStackTrace();} catch (IOException e) {e.printStackTrace();System.out.println(art.getLink()+" "+art.getTitle()+"文件写入失败");}}}。