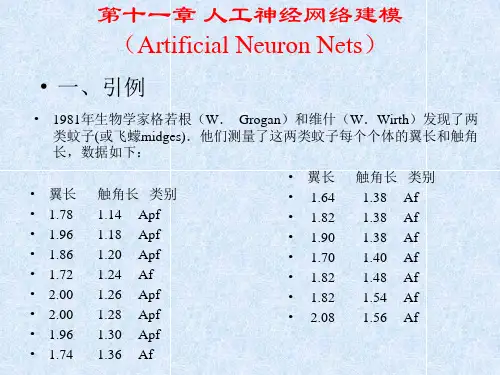

Keras—建立人工神经网络(ANN)

- 格式:pdf

- 大小:811.27 KB

- 文档页数:6

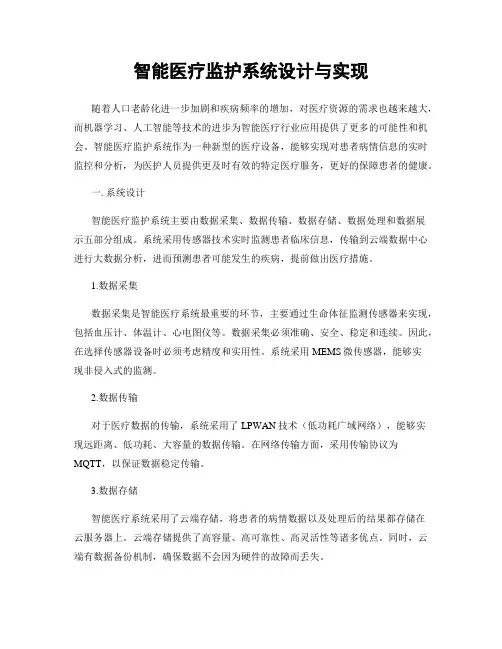

智能医疗监护系统设计与实现随着人口老龄化进一步加剧和疾病频率的增加,对医疗资源的需求也越来越大,而机器学习、人工智能等技术的进步为智能医疗行业应用提供了更多的可能性和机会。

智能医疗监护系统作为一种新型的医疗设备,能够实现对患者病情信息的实时监控和分析,为医护人员提供更及时有效的特定医疗服务,更好的保障患者的健康。

一. 系统设计智能医疗监护系统主要由数据采集、数据传输、数据存储、数据处理和数据展示五部分组成。

系统采用传感器技术实时监测患者临床信息,传输到云端数据中心进行大数据分析,进而预测患者可能发生的疾病,提前做出医疗措施。

1.数据采集数据采集是智能医疗系统最重要的环节,主要通过生命体征监测传感器来实现,包括血压计、体温计、心电图仪等。

数据采集必须准确、安全、稳定和连续。

因此,在选择传感器设备时必须考虑精度和实用性。

系统采用MEMS微传感器,能够实现非侵入式的监测。

2.数据传输对于医疗数据的传输,系统采用了LPWAN技术(低功耗广域网络),能够实现远距离、低功耗、大容量的数据传输。

在网络传输方面,采用传输协议为MQTT,以保证数据稳定传输。

3.数据存储智能医疗系统采用了云端存储,将患者的病情数据以及处理后的结果都存储在云服务器上。

云端存储提供了高容量、高可靠性、高灵活性等诸多优点。

同时,云端有数据备份机制,确保数据不会因为硬件的故障而丢失。

4.数据处理在数据处理方面,智能医疗系统采用了多种算法,如人工神经网络(ANN)、支持向量机(SVM)等,能够对原始数据进行处理和分类,并得出医疗健康结论。

采用病情评分体系,根据患者病情状态、临床表现等指标评估患者的健康状态。

5.数据展示数据展示主要由移动应用、Web界面和互联网 of Things 等方面组成。

移动应用提供Android和iOS两种版本,能够实现对患者信息的实时跟踪和监测,患者能够通过移动应用了解自己的身体状况,并及时分享给医生,以帮助医生进行医疗决策。

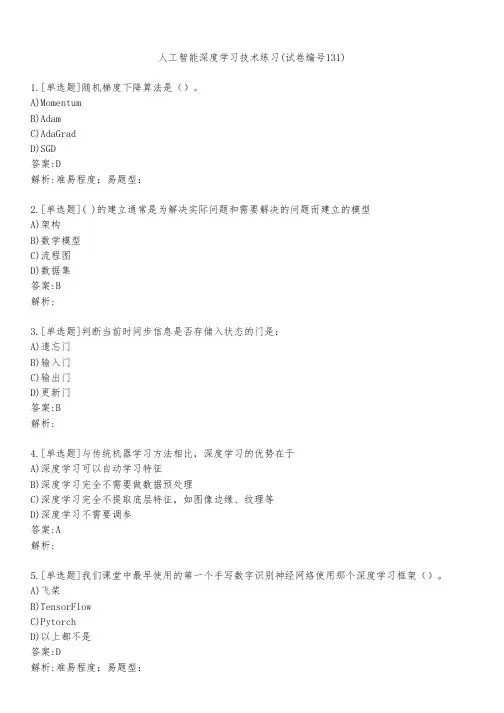

人工智能深度学习技术练习(试卷编号131)1.[单选题]随机梯度下降算法是()。

A)MomentumB)AdamC)AdaGradD)SGD答案:D解析:难易程度:易题型:2.[单选题]( )的建立通常是为解决实际问题和需要解决的问题而建立的模型A)架构B)数学模型C)流程图D)数据集答案:B解析:3.[单选题]判断当前时间步信息是否存储入状态的门是:A)遗忘门B)输入门C)输出门D)更新门答案:B解析:4.[单选题]与传统机器学习方法相比,深度学习的优势在于A)深度学习可以自动学习特征B)深度学习完全不需要做数据预处理C)深度学习完全不提取底层特征,如图像边缘、纹理等D)深度学习不需要调参答案:A解析:5.[单选题]我们课堂中最早使用的第一个手写数字识别神经网络使用那个深度学习框架()。

A)飞桨B)TensorFlowC)PytorchD)以上都不是6.[单选题]YOLO是Joseph Redmon和Ali Farhadi等人于2015年提出的第一个基于单个神经网络的目标检测系统。

在今年CVPR上,Joseph Redmon和Ali Farhadi发表的YOLO 2进一步提高了检测的( )和速度A)精度B)细度C)难度D)力度答案:A解析:7.[单选题]resnet网络中,如果通道数有变化,那么跃迁方式是A)直接使用原有数值B)使用1*1卷积核改变通道C)不做跃迁D)使用3*3卷积核改变通道答案:B解析:8.[单选题]基础的神经网络只在层与层之间建立了权连接,RNN最大的不同之处就是在层之间的神经元之间也建立的( )A)权连接B)层连接C)前馈连接D)反馈连接答案:A解析:9.[单选题]可以在同一个会话中运行两个图吗?()A)可以B)不可以C)可能可以D)以上都错答案:B解析:10.[单选题]双曲正切函数指的是那一个函数?A)Sigmoid函数B)tanh函数C)ReLU11.[单选题]是把训练样本分成k份,在验证时,依次选取每一份样本作为验证集,每次实验中,使用此过程在验证集合上取得最佳性能的迭代次数,并选择恰当的参数。

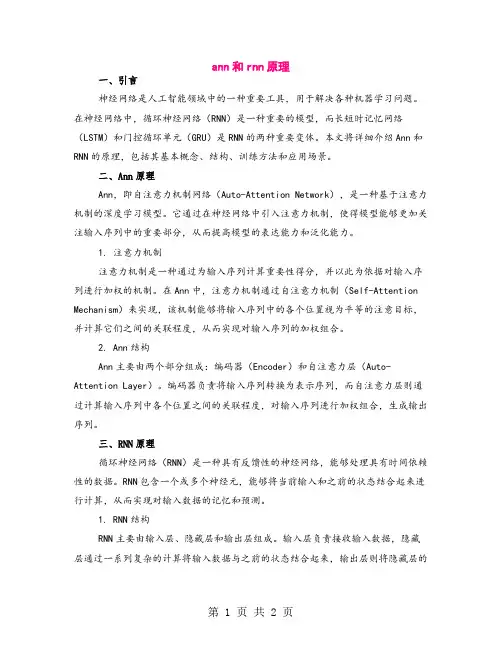

ann和rnn原理一、引言神经网络是人工智能领域中的一种重要工具,用于解决各种机器学习问题。

在神经网络中,循环神经网络(RNN)是一种重要的模型,而长短时记忆网络(LSTM)和门控循环单元(GRU)是RNN的两种重要变体。

本文将详细介绍Ann和RNN的原理,包括其基本概念、结构、训练方法和应用场景。

二、Ann原理Ann,即自注意力机制网络(Auto-Attention Network),是一种基于注意力机制的深度学习模型。

它通过在神经网络中引入注意力机制,使得模型能够更加关注输入序列中的重要部分,从而提高模型的表达能力和泛化能力。

1. 注意力机制注意力机制是一种通过为输入序列计算重要性得分,并以此为依据对输入序列进行加权的机制。

在Ann中,注意力机制通过自注意力机制(Self-Attention Mechanism)来实现,该机制能够将输入序列中的各个位置视为平等的注意目标,并计算它们之间的关联程度,从而实现对输入序列的加权组合。

2. Ann结构Ann主要由两个部分组成:编码器(Encoder)和自注意力层(Auto-Attention Layer)。

编码器负责将输入序列转换为表示序列,而自注意力层则通过计算输入序列中各个位置之间的关联程度,对输入序列进行加权组合,生成输出序列。

三、RNN原理循环神经网络(RNN)是一种具有反馈性的神经网络,能够处理具有时间依赖性的数据。

RNN包含一个或多个神经元,能够将当前输入和之前的状态结合起来进行计算,从而实现对输入数据的记忆和预测。

1. RNN结构RNN主要由输入层、隐藏层和输出层组成。

输入层负责接收输入数据,隐藏层通过一系列复杂的计算将输入数据与之前的状态结合起来,输出层则将隐藏层的结果作为输出。

RNN的这种结构使得它能够捕捉到时间序列数据中的长期依赖关系,因此在语音识别、自然语言处理、时间序列预测等任务中得到了广泛应用。

2. RNN训练方法RNN的训练方法主要包括反向传播算法和优化器。

ann 模型构建方法ANN(Artificial Neural Network)是一种模拟人脑神经网络机制的计算模型。

在构建ANN模型时,一般需要以下步骤:1. 确定网络的拓扑结构:选择合适的神经元层数和每层神经元的数量。

常见的网络结构有前馈神经网络(FeedforwardNeural Network)、卷积神经网络(Convolutional Neural Network)和循环神经网络(Recurrent Neural Network)等。

2. 确定网络的激活函数:通常选择非线性激活函数,如Sigmoid、ReLU或Tanh等。

激活函数在神经元的输出中引入非线性特性,增强了网络的表示能力。

3. 网络初始化:设置网络的初始权重和偏置。

这些参数可以随机初始化或根据特定任务进行预训练。

4. 前向传播:将输入数据通过网络进行前向传递,每个神经元计算输出。

前向传播过程中,使用权重和偏置进行计算,并将计算结果输入到下一层。

5. 计算损失函数:根据网络的输出和标签数据,计算损失函数。

常见的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等。

6. 反向传播:通过反向传播算法,根据损失函数的梯度信息,将误差从输出层传播回网络的每一层,以更新网络的参数。

反向传播过程中,使用梯度下降方法来更新权重和偏置。

7. 参数更新:根据反向传播过程中计算得到的梯度信息,使用优化算法(如随机梯度下降法)来更新网络的参数,以最小化损失函数。

8. 重复步骤4至7,直到达到预设的训练停止条件(如达到最大迭代次数或损失函数收敛)。

9. 模型评估和验证:使用测试数据对训练好的模型进行评估,计算预测的准确率、召回率等指标。

若模型表现不理想,可以尝试调整网络结构或训练参数。

10. 应用模型:完成模型训练后,可以将其用于新的数据进行预测或分类任务。

上述是ANN模型的一般构建方法,具体的实现细节和步骤可能会有所不同,取决于具体的任务和使用的库或框架。

人工智能应用技术理论知识测试题+答案一、单选题(共20题,每题1分,共20分)1、以下关于人工智能系统架构的表述,不正确的是A、应用层聚焦人工智能技术和各个领域的结合B、数据处理一般都是在应用层完成C、基础层提供计算能力和数据资源D、人工智能分为应用层、技术层、基础层正确答案:B2、TensorFlow2.0中的 Keras接口的三个主要优势是方便用户使用,模块化和可组合,易于扩展。

A、TRUEB、FALSE正确答案:A3、GPU擅长计算密集和易于并行的程序。

A、FALSEB、TRUE正确答案:B4、Python的 numpy库主要提供了以下哪方面的操作开发支撑?A、数组操作27B、聚类算法C、图形操作D、分类算法正确答案:A5、下列选择中,哪个不是关键词提取常用的算法?A、TE-IDFB、SSA43C、LDAD、TextRank正确答案:B6、设 X={1,2,3}是频繁项集,则可由 X产生__个关联规则。

A、7B、4C、5D、6正确答案:D7、下列哪项算法是深度学习的重要基础:()A、最大流-最小割算法B、SGD反向传播C、A*算法D、最小生成树算法正确答案:B8、深度学习中的“深度”是指()A、计算机对问题的处理更加灵活B、中间神经元网络的层次很多C、计算机的求解更加精准D、计算机理解的深度正确答案:B9、ModelArts服务与()服务相结合可以轻松将模型部署到“端”?A、OBSB、ECSC、HiLensD、OCR正确答案:C10、在感知机中(Perceptron)的任务顺序是什么?1随机初始化感知机的权重2去到数据集的下一批(batch)3如果预测值和输出不一致,则调整权重 4对一个输入样本,计算输出值A、3,1,2,4B、4,3,2,1C、1,2,3,4D、1,4,3,2正确答案:D11、优秀的编程规范应该是A、自模块的内聚程度要尽量低,且各模块间的耦合程度要尽量弱B、模块的内聚程度要尽量高,且各模块间的耦合程度要尽量强C、模块的内聚程度要尽量高,且各模块间的耦合程度要尽量弱D、模块的内聚程度要尽量低,且各模块间的耦合程度要尽量强正确答案:C12、训练图像分类模型时,对于图像的预处理,下列技术哪项经常要用?A、图片 RGB通道转换B、图片二值化C、图像增强D、图像灰度化正确答案:C13、下列选项中不属于华为全栈解决方案范畴的是?A、开源框架B、边缘计算C、芯片使能D、应用使能正确答案:B14、以下关于机器学习说法错误的是A、机器学习在一定程度上依赖于统计学习B、监督学习和非监督学习都属于机器学习C、目前机器学习已经可以代替人类D、机器学习可以解决图像识别问题正确答案:C15、可以在自然语言处理中用于语义关系提取的神经网络技术是以下哪种?A、递归神经网络B、循环神经网络C、残差神经网络7D、卷积神经网络正确答案:B16、以下关于人工智能概念的描述中,错误的是A、人工智能是对人的意识、思维过程进行模拟B、人工智能使计算机能实现更高层次应用C、人工智能英文翻译是 ArtificialIntelligenceD、人工智能就是机器学习正确答案:D17、下列算法哪些属于 K-means的变种?A、以上都不是B、MeanshiftC、kNND、k-means++正确答案:D18、用于模式识别的多层神经网络和反向传播算法出现于人工智能发展的第几次浪潮中?A、第三次B、第四次C、第一次D、第二次正确答案:D19、2017年,卡内基梅隆大学开发的一个人工智能程序在()大赛上战胜了四位人类玩家,这在人工智能发展史上具有里程碑式的意义。

yers.timedistributed实现原理1. 引言1.1 概述在现代深度学习中,循环神经网络(RNN)被广泛应用于处理序列数据的任务。

然而,传统的RNN在处理长期依赖关系时面临着梯度消失或梯度爆炸等问题。

为了解决这些问题,Keras提供了一个功能强大的层——TimeDistributed层。

TimeDistributed层是一个对指定的神经网络层进行封装的容器,它能够将其内部的神经网络层应用到每个时间步上。

这种操作可以有效地并行化处理输入序列中的各个时间步,提供更好的效率和性能。

1.2 文章结构本文首先介绍了Keras中TimeDistributed层的作用及原理简介,并通过一些使用示例来帮助读者更好地理解其工作机制。

接下来,我们将详细讲解TimeDistributed层的实现原理,包括输入数据格式要求、内部操作机制以及实现步骤分析。

然后,文章将探讨TimeDistributed在不同领域中的应用场景,如视频处理、语音识别和自然语言处理等。

最后,我们将总结本文内容和要点,并展望未来该领域发展趋势和研究方向。

1.3 目的本文的目的是帮助读者全面了解Keras中TimeDistributed层的实现原理,包括其作用、原理和使用方法。

通过深入研究TimeDistributed层,读者可以更好地理解该层对序列数据处理的优势,并能够灵活应用于各种实际场景中。

同时,本文也致力于展示TimeDistributed在不同领域中的应用潜力,以及未来发展趋势和研究方向。

2. Keras中的TimeDistributed层:2.1 TimeDistributed的作用:Keras中的TimeDistributed层是一种用于处理时间序列数据的技术。

当我们在神经网络中处理时间序列数据时,通常需要在每个时间步骤上应用相同的神经网络模型,并且希望每个时间步骤都有自己特定的权重。

这就是TimeDistributed 层发挥作用的地方。

ann算法分类-回复Ann算法是一种常见的分类算法,也可以用于回归和异常检测。

在本文中,我们将详细介绍Ann算法的原理、步骤和应用,并通过案例分析来说明其实际应用的效果。

一、Ann算法的原理Ann算法,全称为人工神经网络(Artificial Neural Network),其灵感来源于人脑的神经网络。

Ann算法模拟了神经网络的工作原理,通过大量的神经元和连接来处理输入数据,并在其中学习和建模,从而实现分类、回归和异常检测等任务。

Ann算法由三个基本组成部分组成:输入层、隐藏层和输出层。

输入层接收原始数据作为输入,隐藏层是用于处理输入数据的核心部分,输出层则给出最终结果。

每个神经元都与上一层和下一层的神经元连接,并通过调整连接权重来学习和优化模型。

Ann算法主要通过以下步骤实现分类:1. 数据准备:收集和整理用于训练和测试的数据集,并对其进行预处理,包括数据清洗、特征选择和特征缩放等。

2. 模型构建:根据数据集的特点和任务要求,选择适当的网络结构和激活函数,并初始化连接权重和偏置。

通常使用反向传播算法来调整权重和偏置。

3. 模型训练:将数据集输入到神经网络中,通过前向传播计算输出结果,并使用反向传播调整权重和偏置,以减小预测误差。

训练过程可以进行多个周期,直到达到一定的准确度。

4. 模型评估:使用独立的测试数据集评估模型的性能,可以通过计算准确率、精确率、召回率等指标来衡量分类模型的性能。

二、Ann算法的步骤Ann算法的一般步骤如下:1. 数据预处理:包括数据清洗、特征选择和特征缩放等操作,以准备好用于训练和测试的数据集。

2. 构建Ann模型:确定网络结构和激活函数,并初始化连接权重和偏置。

3. 训练Ann模型:使用训练数据集进行多轮训练,通过前向传播计算输出结果,再通过反向传播调整权重和偏置,从而优化模型。

4. 评估Ann模型:使用独立的测试数据集评估模型的性能,计算准确率、精确率、召回率等指标。

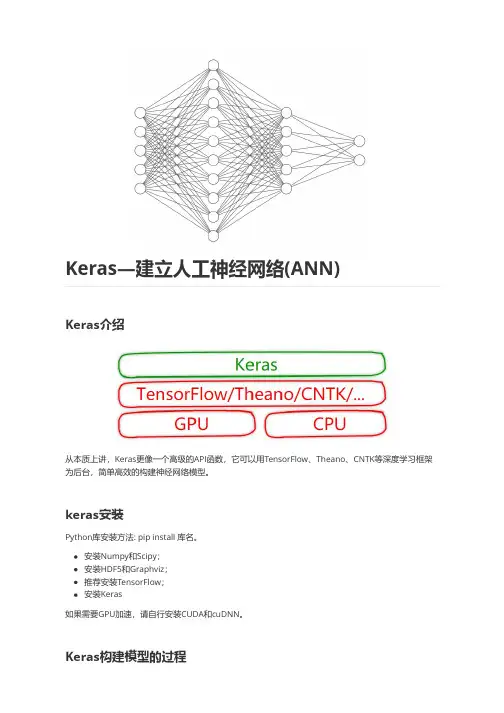

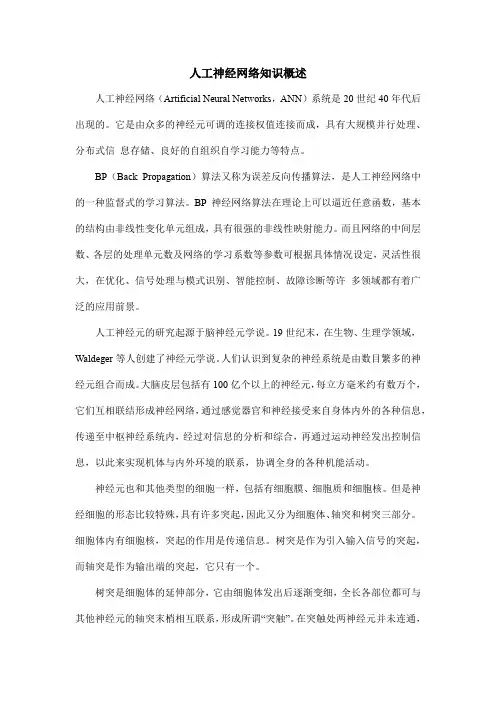

Keras—建立人工神经网络(ANN)Keras介绍从本质上讲,Keras更像一个高级的API函数,它可以用TensorFlow、Theano、CNTK等深度学习框架为后台,简单高效的构建神经网络模型。

keras安装Python库安装方法: pip install 库名。

安装Numpy和Scipy;安装HDF5和Graphviz;推荐安装TensorFlow;安装Keras如果需要GPU加速,请自行安装CUDA和cuDNN。

Keras构建模型的过程下载训练数据定义数据是必须的步骤。

实际应用过程当中,可以根据具体的需求定义数据大小。

为了展示网络的过程,我们选用IMDB数据集,来处理电影评论分类问题。

IMDB数据集已经内置到Keras中。

并且已经经过预处理:评论已经被转化成整数序列。

关于这部分内容,我们下面会专门说明。

本质上讲,就是把文字编码成数字,因为计算机无法识别文字。

编码的一个简单示例,把一句话分词为4个字符,用4位分别表示每个字符,编码的最大特点是每个编码只有一位是1。

ONE-HOT编码实现-enumerate函数def vectorize_sequences(sequences, dimension=10000):results = np.zeros((len(sequences), dimension))for i, sequence in enumerate(sequences):results[i, sequence] = 1.return resultsvectorize_sequences函数就是实现ONE-HOT编码的方法。

enumerate函数的作用是将一个可遍历的数据对象(如列表、元组或字符串)组合为一个索引序列。

List = ['I', 'Love', 'Beijing']enumerate(List) #结果是[(0,'I'), (1,'Love'), (2,'Beijing')]ONE-HOT编码实现-实现步骤我们可以把ONE-HOT编码实现步骤整理如下:1. 建立一个零矩阵,矩阵行数等于不重复字符个数,矩阵列数不少于不重复字符个数;2. 循环检索索引,并给零矩阵赋值预留训练数据集与测试数据集训练数据集用于训练网络,而测试数据集用来验证网络模型是否存在欠拟合与过拟合的现象。

人工神经网络知识概述人工神经网络(Artificial Neural Networks,ANN)系统是20世纪40年代后出现的。

它是由众多的神经元可调的连接权值连接而成,具有大规模并行处理、分布式信息存储、良好的自组织自学习能力等特点。

BP(Back Propagation)算法又称为误差反向传播算法,是人工神经网络中的一种监督式的学习算法。

BP 神经网络算法在理论上可以逼近任意函数,基本的结构由非线性变化单元组成,具有很强的非线性映射能力。

而且网络的中间层数、各层的处理单元数及网络的学习系数等参数可根据具体情况设定,灵活性很大,在优化、信号处理与模式识别、智能控制、故障诊断等许多领域都有着广泛的应用前景。

人工神经元的研究起源于脑神经元学说。

19世纪末,在生物、生理学领域,Waldeger等人创建了神经元学说。

人们认识到复杂的神经系统是由数目繁多的神经元组合而成。

大脑皮层包括有100亿个以上的神经元,每立方毫米约有数万个,它们互相联结形成神经网络,通过感觉器官和神经接受来自身体内外的各种信息,传递至中枢神经系统内,经过对信息的分析和综合,再通过运动神经发出控制信息,以此来实现机体与内外环境的联系,协调全身的各种机能活动。

神经元也和其他类型的细胞一样,包括有细胞膜、细胞质和细胞核。

但是神经细胞的形态比较特殊,具有许多突起,因此又分为细胞体、轴突和树突三部分。

细胞体内有细胞核,突起的作用是传递信息。

树突是作为引入输入信号的突起,而轴突是作为输出端的突起,它只有一个。

树突是细胞体的延伸部分,它由细胞体发出后逐渐变细,全长各部位都可与其他神经元的轴突末梢相互联系,形成所谓“突触”。

在突触处两神经元并未连通,它只是发生信息传递功能的结合部,联系界面之间间隙约为(15~50)×10米。

突触可分为兴奋性与抑制性两种类型,它相应于神经元之间耦合的极性。

每个神经元的突触数目正常,最高可达10个。

各神经元之间的连接强度和极性有所不同,并且都可调整、基于这一特性,人脑具有存储信息的功能。

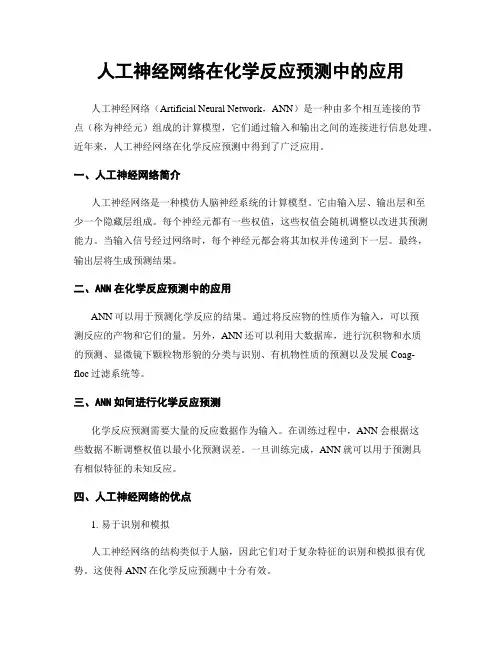

人工神经网络在化学反应预测中的应用人工神经网络(Artificial Neural Network,ANN)是一种由多个相互连接的节点(称为神经元)组成的计算模型,它们通过输入和输出之间的连接进行信息处理。

近年来,人工神经网络在化学反应预测中得到了广泛应用。

一、人工神经网络简介人工神经网络是一种模仿人脑神经系统的计算模型。

它由输入层、输出层和至少一个隐藏层组成。

每个神经元都有一些权值,这些权值会随机调整以改进其预测能力。

当输入信号经过网络时,每个神经元都会将其加权并传递到下一层。

最终,输出层将生成预测结果。

二、ANN在化学反应预测中的应用ANN可以用于预测化学反应的结果。

通过将反应物的性质作为输入,可以预测反应的产物和它们的量。

另外,ANN还可以利用大数据库,进行沉积物和水质的预测、显微镜下颗粒物形貌的分类与识别、有机物性质的预测以及发展Coag-floc过滤系统等。

三、ANN如何进行化学反应预测化学反应预测需要大量的反应数据作为输入。

在训练过程中,ANN会根据这些数据不断调整权值以最小化预测误差。

一旦训练完成,ANN就可以用于预测具有相似特征的未知反应。

四、人工神经网络的优点1. 易于识别和模拟人工神经网络的结构类似于人脑,因此它们对于复杂特征的识别和模拟很有优势。

这使得ANN在化学反应预测中十分有效。

2. 可以处理大量数据人工神经网络可以同时处理大量数据,这使得它们在学习和预测复杂化学反应时比传统方法要好。

3. 可以自我修正与传统的统计模型相比,人工神经网络可以自我修正。

这意味着它们可以在学习过程中不断改进,从而提高预测准确性。

五、人工神经网络的局限1. 易受局部最优解影响人工神经网络的优化方法通常涉及数个不同的局部最优解,选择的初始条件和算法可以对预测结果产生重要影响。

2. 对数据质量要求较高人工神经网络在化学反应预测中需要大量且高质量的数据作为输入。

这就要求我们对反应数据进行高质量的测量和收集。

rnn的案例代码以下是一个使用Python和Keras库实现的基本RNN(循环神经网络)的案例代码。

这个例子是一个简单的RNN模型,用于对序列数据进行预测。

```python# 导入所需库import numpy as npfrom keras.models import Sequentialfrom yers import SimpleRNN, Dense# 生成序列数据data = np.array([[[1, 2, 3, 4, 5], [2, 3, 4, 5, 6], [3, 4, 5, 6, 7]],[[10, 20, 30, 40, 50], [20, 30, 40, 50, 60], [30, 40, 50, 60, 70]]])# 生成标签数据labels = np.array([[1, 2, 3], [10, 20, 30]])# 将数据转换为适合RNN的格式data = np.reshape(data, (data.shape[0], data.shape[1], data.shape[2]))labels = np.reshape(labels, (labels.shape[0],labels.shape[1]))# 定义模型model = Sequential()model.add(SimpleRNN(10, input_shape=(3, 5)))model.add(Dense(1))pile(loss='mean_squared_error', optimizer='adam')# 训练模型model.fit(data, labels, epochs=100)# 使用模型进行预测test_data = np.array([[4, 5, 6], [30, 40, 50]])test_data = np.reshape(test_data, (test_data.shape[0],test_data.shape[1], test_data.shape[2]))prediction = model.predict(test_data)print(prediction)```这个例子中,我们首先生成了一些序列数据和对应的标签。

matlab ann源代码-回复如何编写一个简单的人工神经网络(ANN)的MATLAB源代码。

人工神经网络(Artificial Neural Networks,简称ANN)是一种模拟生物神经网络行为和结构的计算模型,它是一种广泛应用于机器学习和模式识别领域的人工智能技术。

通过对大量数据进行训练和学习,ANN 可以通过多层次的神经元之间的连接,进行复杂的非线性函数拟合和任务解决。

在本文中,我们将以MATLAB为编程语言,一步一步地介绍如何编写简单的人工神经网络的源代码。

下面是源代码的主要步骤:第一步:导入数据集在使用ANN进行训练和测试之前,我们需要准备一个数据集。

数据集应该包含输入特征以及对应的目标输出。

在MATLAB中,我们可以使用两个矩阵来表示输入和输出数据,其中每一行表示一个样本,每一列表示一个特征。

导入数据集的代码如下:matlab导入数据集load iris_dataset.mat第二步:设置网络结构在设计ANN之前,我们需要设置网络的结构,包括输入层、隐藏层和输出层的神经元数量。

一般来说,输入层的神经元数量应该与数据集的特征数量相同,而输出层的神经元数量应该与问题的类别数量相同。

隐藏层的数量和神经元数量可以根据具体问题的复杂性进行调整。

设置网络结构的代码如下:matlab设置网络结构input_size = size(inputs,2);output_size = size(targets,2);hidden_size = 10; 设置隐藏层神经元数量第三步:初始化权重和偏置在ANN中,神经元之间的连接强度由权重和偏置决定。

我们需要为所有神经元之间的连接,以及每个神经元的偏置,随机初始化一个初始值。

初始化权重和偏置的代码如下:matlab初始化权重和偏置W1 = rand(input_size,hidden_size); 初始化输入层到隐藏层的权重b1 = rand(1,hidden_size); 初始化隐藏层的偏置W2 = rand(hidden_size,output_size); 初始化隐藏层到输出层的权重b2 = rand(1,output_size); 初始化输出层的偏置第四步:定义激活函数激活函数是ANN中非线性转换的关键。

ann模型的基础知识ANN模型,全称Artificial Neural Network,即人工神经网络,是一种模拟生物神经网络行为的计算模型。

它由大量的人工神经元节点组成,通过节点之间的连接和传递信息来进行计算和学习。

ANN模型可以用于解决各种问题,如分类、回归、聚类等。

ANN模型的基础知识包括以下几个方面:1. 神经元的结构和功能:神经元是ANN模型的基本单元,它接收输入信号,并通过激活函数对输入信号进行处理得到输出。

神经元之间通过连接进行信息传递,每个连接都有一个权重值,用于调节输入信号的影响力。

2. 前馈神经网络:前馈神经网络是最常见的ANN模型,它的信息流只能从输入层到输出层,不存在反馈回路。

前馈神经网络按照层数的不同可以分为单层感知机和多层神经网络。

3. 反向传播算法:反向传播算法是训练ANN模型的一种常用方法。

它通过计算输出与实际值之间的误差,并通过反向传播调整连接权重,以最小化误差。

反向传播算法包括前向计算和反向传播两个过程。

4. 激活函数:激活函数是神经元中对输入信号进行处理的一种函数。

常见的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

不同的激活函数具有不同的性质,选择适合的激活函数可以提高ANN 模型的性能。

5. 深度学习:深度学习是建立在ANN模型基础上的一种机器学习方法。

它通过构建多层神经网络来提取数据的高层次特征,并通过反向传播算法进行训练。

深度学习在图像识别、语音识别等领域取得了令人瞩目的成果。

6. 优化算法:优化算法用于调整ANN模型的参数,以使其在训练数据上达到最佳性能。

常见的优化算法有梯度下降算法、Adam算法等。

这些算法通过调整连接权重和偏置项来最小化损失函数。

7. 过拟合和欠拟合:过拟合和欠拟合是ANN模型常见的问题。

过拟合指模型在训练数据上表现良好,但在测试数据上表现较差,欠拟合则指模型无法很好地拟合训练数据。

解决过拟合和欠拟合的方法有增加数据集、正则化、模型选择等。

谷歌机器学习库的对比:TensorFlow和KerasTensorFlow和Keras是两个非常受欢迎的机器学习(ML)库。

由于它们的出现,开发人员能够更轻松地创建各种人工智能(AI)应用程序,并训练各种机器学习模型。

虽然它们都是机器学习库,TensorFlow和Keras却有很大的不同之处,让我们来看一下它们的比较。

1. TensorFlowTensorFlow是谷歌开发的一个开源的机器学习库,也是其中最流行的一个。

它提供了一种灵活的编程方式,可以轻松地构建各种机器学习模型,例如神经网络、深度学习、递归神经网络(RNN)等等。

TensorFlow使用数据流图来表示计算任务,并将图形分解成小的可并行化的任务。

它可以在多个GPU和CPU上运行,以加速训练过程。

它的优点包括:-大规模可伸缩性:TensorFlow可以同时在多个CPU和GPU上运行,这使得它可以处理大规模的数据。

-灵活性:TensorFlow提供了灵活的编程方式,可以轻松地构建各种机器学习模型,例如神经网络、深度学习、递归神经网络(RNN)等等。

-可扩展性:TensorFlow可以与许多其他库相集成,例如OpenCV和NumPy,这使得它更加灵活和可扩展。

TensorFlow的缺点包括:-学习曲线:TensorFlow具有陡峭的学习曲线,对于一些初学者来说,它有些难以入门。

- API复杂性:TensorFlow的API相对复杂,这对于那些想要快速开始学习的人来说,可能会造成一些困难。

2. KerasKeras是一个高级的神经网络API,以TensorFlow为后端。

它也是一个开源的机器学习库,与TensorFlow相比,Keras有着更加简单和易于使用的API,它允许用户快速创建各种机器学习模型,例如神经网络和深度学习。

Keras的优点包括:-简单易用的API:与TensorFlow相比,Keras的API更加简单和易于使用。

-交互式:Keras提供了一个易于使用的命令行界面,可以方便地进行实验和排除故障。

ann算法原理ANN算法原理人工神经网络(Artificial Neural Network,简称ANN)是一种模拟人脑神经元之间信息传递和处理的数学模型。

它基于大量的数据样本进行训练,通过学习和调整连接权值来模拟人脑的学习能力和智能行为。

ANN算法的原理是通过构建多层的神经元网络,通过输入数据和权重的乘积得到输出结果,并通过反向传播算法不断调整权重,使得输出结果与实际值之间的误差最小化。

ANN算法的核心思想是模拟人脑神经元之间的相互连接和信息传递。

神经元是ANN的基本单元,它接收来自其他神经元的输入,并通过激活函数将输入信号加权相加后输出。

每个神经元与其他神经元之间的连接都有一个权重,这个权重决定了输入信号对神经元输出的影响程度。

ANN通过调整这些权重来学习和适应输入数据的模式和规律。

ANN算法一般由三层构成:输入层、隐藏层和输出层。

输入层接收外部输入数据,将其传递给隐藏层;隐藏层对输入数据进行加工处理,并将结果传递给输出层;输出层将隐藏层的结果转化为最终的输出结果。

每个神经元在隐藏层和输出层都有一个激活函数,用来对输入信号进行处理和输出。

常用的激活函数有Sigmoid函数、ReLU函数等。

ANN算法的训练过程主要分为两个阶段:前向传播和反向传播。

在前向传播过程中,输入数据从输入层经过隐藏层传递到输出层,每个神经元根据输入信号和权重的乘积计算输出结果。

在反向传播过程中,根据输出结果和实际值之间的误差,通过链式法则将误差逐层反向传播,并根据误差大小调整每个神经元之间的连接权重。

这个过程迭代进行,直到达到预设的训练次数或误差达到一定的收敛值。

ANN算法的训练需要大量的数据样本,以及对数据进行预处理和特征选择。

在训练过程中,需要将数据集分为训练集和验证集,训练集用于权重的调整和模型的训练,验证集用于模型的评估和调优。

同时,为了防止模型过拟合,需要采用正则化等方法进行模型的约束和优化。

ANN算法在多个领域有广泛的应用,如图像识别、语音识别、自然语言处理、金融预测等。

基于人工神经网络的大数据预测模型构建随着互联网技术的日益发展,数据量不断增加,人们对数据的需求也越来越大,人工智能技术在数据处理方面的应用变得越来越广泛。

其中,基于人工神经网络的大数据预测模型成为了研究热点之一。

一、人工神经网络简介人工神经网络(Artificial Neural Network,ANN)是一种模拟人脑神经元行为的计算模型。

它是由输入层、隐含层和输出层构成的一种多层前向结构。

输入层接受外部信号,输出层向外部发出处理结果,中间层为隐含层,不进行数据传输,而是对原始数据的信息进行分析和加工。

在神经网络中,每个神经元都会对输入的信息进行加工处理,并传递到下一层的神经元中。

经过多次迭代训练,神经网络可以学会一种模式或模型,用于对未来的数据进行预测或分类。

二、大数据预测模型构建大数据预测模型构建分为数据预处理、神经网络训练和模型评估三个步骤。

数据预处理是构建预测模型的第一步。

它包括数据获取、数据清洗、特征选择、数据归一化等步骤。

在这些步骤中,数据清洗的重要性不言而喻。

如果原始数据存在缺失值或错误数据,就需要进行清洗,以消除不良数据影响。

特征选择是进一步加工清洗后的数据,它是在保持数据完整性的前提下,对数据进行筛选和提取,以确定最终极具代表性的特征。

神经网络训练是即是利用构建的数据集,训练一个完整的神经网络模型。

到了这一步骤,数据即为预处理过后的数据。

此时需要确定一个合适的神经网络结构,并利用已经提取到的数据特征,确定神经元数量、隐层数和学习率等参数。

随后利用BP算法进行网络训练,使网络逐渐收敛,并达到预测准确的模型。

模型评估是对神经网络模型进行评估。

一般通过误差分析和分类精度等指标,对模型进行评价。

若模型精度达到较高水平,则可将模型应用于实际问题的预测和分析。

三、应用场景基于人工神经网络的大数据预测模型可用于各个领域。

例如交通异常预测、金融市场预测等。

下面以气象预测为例。

气象数据量大且多变,传统的气象预测方法需要依赖气象仪器,测量数据精度有限,且具有一定的时滞性。

Keras—建立人工神经网络(ANN)

Keras介绍

从本质上讲,Keras更像一个高级的API函数,它可以用TensorFlow、Theano、CNTK等深度学习框架为后台,简单高效的构建神经网络模型。

keras安装

Python库安装方法: pip install 库名。

安装Numpy和Scipy;

安装HDF5和Graphviz;

推荐安装TensorFlow;

安装Keras

如果需要GPU加速,请自行安装CUDA和cuDNN。

Keras构建模型的过程

下载训练数据

定义数据是必须的步骤。

实际应用过程当中,可以根据具体的需求定义数据大小。

为了展示

网络的过程,我们选用IMDB数据集,来处理电影评论分类问题。

IMDB数据集已经内置到Keras

中。

并且已经经过预处理:评论已经被转化成整数序列。

关于这部分内容,我们下面会专门说明。

本质上讲,就是把文字编码成数字,因为计算机无法识别文字。

编码的一个简单示例,把一句话分词为4个字符,用4位分别表示每个字符,编码的最大特点是每个编码只有一位是1。

ONE-HOT编码实现-enumerate函数

def vectorize_sequences(sequences, dimension=10000):

results = np.zeros((len(sequences), dimension))

for i, sequence in enumerate(sequences):

results[i, sequence] = 1.

return results

vectorize_sequences函数就是实现ONE-HOT编码的方法。

enumerate函数的作用是将一个可遍历的数据对象(如列表、元组或字符串)组合为一个索引序列。

List = ['I', 'Love', 'Beijing']

enumerate(List) #结果是[(0,'I'), (1,'Love'), (2,'Beijing')]

ONE-HOT编码实现-实现步骤

我们可以把ONE-HOT编码实现步骤整理如下:

1. 建立一个零矩阵,矩阵行数等于不重复字符个数,矩阵列数不少于不重复字符个数;

2. 循环检索索引,并给零矩阵赋值

预留训练数据集与测试数据集

训练数据集用于训练网络,而测试数据集用来验证网络模型是否存在欠拟合与过拟合的现象。

这两个概念稍后介绍。

#ONE-HOT编码

x_train = vectorize_sequences(train_data)

x_test = vectorize_sequences(test_data)

#将标签向量化(将数组转化成矩阵并转化成浮点型)

y_train = np.asarray(train_labels).astype('float32')

y_test = np.asarray(test_labels).astype('float32')

#训练集与测试集

x_val = x_train[:10000] #输入测试集

partial_x_train = x_train[10000:] #输入训练集

y_val = y_train[:10000] #输出测试集

partial_y_train = y_train[10000:] #输出训练集

欠拟合与过拟合-机器学习的根本问题

机器学习的根本问题是优化和泛化之间的对立。

优化是指调节模型以在训练数据上得到最佳性能;泛化是指训练好的模型,在前所未有的数据上的性能好坏。

机器学习的最终目的是得到良好的泛化,但是我们无法控制未知数据的泛化,只能根据已知的训练数据来调整模型。

什么是欠拟合与过拟合

我们希望模型具有良好的泛化能力,能够表征数据的一般特性。

过拟合与欠拟合都会影响泛化能力。

如何解决欠拟合与过拟合问题

1. 最优的方法是获取更多的训练数据;

2. 合理设计网络大小,包括网络层数与每层神经元个数,这一点完全依靠个人的经验;

Keras构建了一个简单的神经网络模型,通过本节:

Keras及其安装过程;

ONE-HOT编码的原理;

通过对过拟合与欠拟合的了解,掌握神经网络训练的目标和判断模型好坏的标准;掌握网络模型定义、编译与训练的过程;

了解小批量梯度下降法。

本节源码下载

更多内容可访问:www.deepthink.press。