快速无损TCP数据流重组算法研究

- 格式:pdf

- 大小:2.64 MB

- 文档页数:6

tcp数据传输的拥塞控制中的快重传算法和快恢复算法一、TCP数据传输中的拥塞控制TCP协议是一种可靠的传输协议,它通过拥塞控制机制来保证网络的可靠性和稳定性。

在TCP数据传输过程中,如果网络出现拥塞,就会导致数据包丢失或延迟,从而影响数据传输的效率和质量。

因此,TCP 协议需要通过拥塞控制机制来避免网络拥塞,并确保数据传输的顺利进行。

二、快重传算法快重传算法是TCP协议中常用的一种拥塞控制算法,它主要用于解决网络中出现丢包现象时的重传问题。

当一个发送方发现自己发送了一个分组后没有收到对应的确认消息时,它会认为该分组已经丢失,并立即重新发送该分组。

但是,在某些情况下,接收方其实已经正确地接收了该分组,并向发送方发送了确认消息。

这时,如果发送方继续重复发送该分组,就会导致网络拥塞。

快重传算法通过检测是否连续收到3个相同序号的确认消息来判断是否出现了丢包现象。

如果出现了丢包,则立即重发该分组,并不等待超时时间到达再进行重传。

这样可以避免网络拥塞,并提高数据传输的效率。

三、快恢复算法快恢复算法是TCP协议中另一种常用的拥塞控制算法,它主要用于解决网络中出现拥塞窗口减小时的问题。

当网络出现拥塞时,TCP协议会将拥塞窗口减小,并重新开始慢启动过程。

但是,在某些情况下,网络并没有真正出现拥塞,而是由于其他原因导致了数据包丢失或延迟,这时重新开始慢启动过程会导致数据传输效率降低。

快恢复算法通过检测是否连续收到3个相同序号的确认消息来判断是否出现了拥塞窗口减小的情况。

如果出现了该情况,则将拥塞窗口增加1,并进入快恢复状态。

在快恢复状态下,TCP协议会继续发送数据包,并等待接收方发送确认消息。

如果连续收到3个相同序号的确认消息,则说明网络已经恢复正常,TCP协议会退出快恢复状态,并将拥塞窗口设置为新的值。

四、总结快重传算法和快恢复算法是TCP协议中常用的拥塞控制算法,它们可以有效地避免网络拥塞,并提高数据传输的效率。

面向数据中心网络TCP Incast问题的关键技术研究面向数据中心网络TCP Incast问题的关键技术研究随着云计算和大数据时代的到来,数据中心网络扮演着至关重要的角色。

然而,数据中心网络中存在着一些挑战和问题,其中之一就是TCP Incast问题。

本文将对面向数据中心网络TCP Incast问题的关键技术进行研究,并介绍解决方案和优化方法,以提高数据中心网络的性能和吞吐量。

一、TCP Incast问题概述TCP Incast问题是指在数据中心网络中,多个服务器同时向一个目标服务器发送大量的数据请求,造成目标服务器无法及时处理所有请求,导致网络拥塞和性能下降。

这种问题特别针对数据中心网络中大规模并行计算和集群访问数据库等场景。

TCP Incast问题主要由以下几个因素引起:1. 并发请求:当多个服务器同时向目标服务器发送请求时,会产生大量的并发请求。

2. 突发请求:这些请求往往会在同一时间窗口内同时到达目标服务器。

3. 短暂的拥塞:目标服务器在短时间内无法及时处理所有请求,导致网络短暂拥塞。

4. 超时重传:由于网络拥塞,一些请求的响应可能超时,导致服务器需要重传数据。

5. 性能下降:TCP Incast问题会导致网络性能下降,延迟增加,吞吐量降低等问题。

二、解决方案和优化方法为了解决TCP Incast问题,研究人员提出了一系列的解决方案和优化方法。

下面将介绍其中一些关键技术。

1. 数据中心拓扑优化:通过优化数据中心网络的拓扑结构,可以减少数据中心网络的瓶颈和拥塞点。

例如,引入多层交换机结构,减少交换机之间的传输延迟和负载不均衡问题。

2. 流量调度算法:通过合理的流量调度算法,可以分配和管理数据中心网络中的数据流。

例如,ECMP (Equal-Cost Multipath)算法可以实现负载均衡和流量调度,减少网络拥塞。

3. 基于缓存的优化方法:通过在服务器端和交换机端引入缓存机制,可以减少网络拥塞和数据丢失。

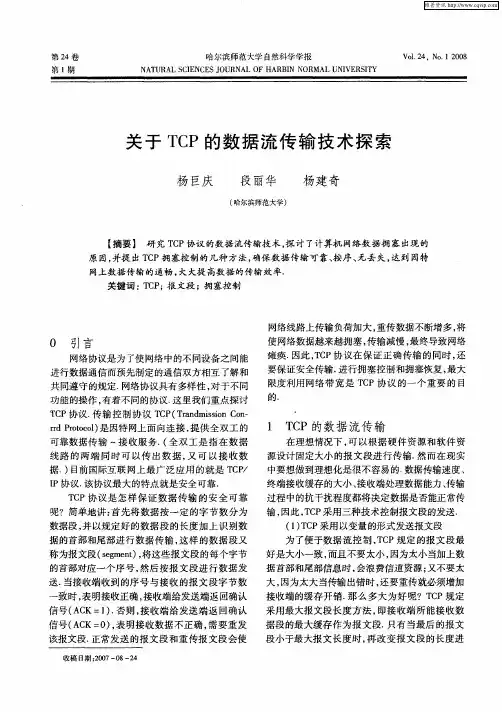

TCP Reno,TCP V egas,Fast TCP性能比较研究ComputerEngineeringandApplications计算机工程与应用2007,43(1)19 TCPReno,TCPV egas,FastTCP性能比较研究张牧.张顺颐ZHANGMu,ZHANGShun-yi南京邮电大学江苏省通信与网络技术工程研究中心,南京210003 JiangsuProvinceEngineeringResearchCenterofTelecommunication&NetworkTec hnology,NanjingUniversityofPostsandTelecommunications.Nanjing210003.ChinaE-mail:*******************ZHANGMu,parisonandresearchonTCPReno,TCPV egas.FastTC puterEngineeringandApplications,2007,43(1):19-23.Abstract:ThispaperintroducesbrieflytheTCPcongestioncontroltechniquesandanalyzest heircharacteristicofTCPReno.TCPV egasandFastTCP,thenssimulatorisusedtoevaluatetheperformanceofthosealgorith ms.Thenconcludesadvantageanddisadvantageofthethreealgorithms.Keywords:congestioncontrol;TCP;algorithm;ACK摘要:介绍了传榆控制协议(TCP)的拥塞控制技术.分析了三种典型TCP控制算法,在ns仿真环境下对这三种TCP控制算法进行了仿真.并分析总结了三种算法的优缺点.关键词:拥塞控制;传榆控制协议;算法;确认文章编号:1002—8331(2007)01—0019—05文献标识码:A中图分类号:TP3931引言计算机网络在过去十几年中经历了爆炸式的增长.随之而来是越来越严重的拥塞问题.网络产生拥塞的根本原因在于用户提供给网络的负载(1oad)大于网络资源容量和处理能力(over—load).表现为数据包时延增加.丢弃概率增大.上层应用系统性能下降等.拥塞产生的直接原因来自三个方面:(1)存储空间的不足;(2)带宽容量的不足;(3)处理器处理能力弱,速度慢也能引发拥塞.这三方面是网络系统潜在的瓶颈.随着信源主机数和信源端业务量的不断增加,瓶颈处就会发生资源竞争,从而导致网络拥塞.据统计.Internet上95%的数据流使用的是TCP/IP协议….TCP端到端拥塞控制机制RI对互联网的健壮性和稳定性具有非常重要的作用.拥塞控制也是确保Interact鲁棒性(robustness)的关键因素.因此一直是网络研究的一个热点问题.本文讨论了TCP拥塞控制典型的三种算法:TCPReno,TCPV egas[.FastTCJ.对i种算法的特点进行了分析,在as仿真环境下对算法进行了仿真,分析了仿真结果,最后对三种算法的优缺点进行了总结.2TCP拥塞控制的三种算法网络的许多问题.都可以从控制论角度观察.拥塞控制的方法.不论什么形式都可归为两类:开环和闭环控制四.开环控制是事先设计一个"好的"网络,确保它不发生拥塞,而网络一旦运行起来,就不再采取措施.显然对网络这样不断变化的复杂系统.开环控制并不是理想的选择.TCP的拥塞控制采用的是基于窗口的端到端的闭环控制方式.1988年V anJacobson在文献【2】中指出了TCP在控制网络拥塞方面的不足.并提出了"慢启动"(slowstart)算法."拥塞避免"(congestionavoidance)算法.1990年出现的TCPReno版本增加了"快速重传"(fastretransmit)算法,"快速恢复"(fast recovery)算法.避免了网络拥塞不够严重时采用"慢启动"算法而造成过大地减小发送窗口尺寸的现象,这样TCP的拥塞控制就由这4个核心部分组成.随后叉出现了TCP的改进版本如V egas.Fast等.TCP拥塞控制是通过控制一些重要参数的改变来实现的.这些重要参数包括:拥塞窗口(cwnd).发送窗口(wnd),慢启动阀值(ssthresh),回路响应时间(JR玎),超时重传计数器(RTO).2.1TCPRenoTCPReno是目前最通行的.应用最广泛的较为成熟的算法.该算法所包含的慢启动,拥塞避免和快速重传/快速恢复机制,是以后众多算法的基础.(1)慢启动:当建立新的TCP连接时,拥塞窗口(cwnd)初始化为一个TCP段的最大字节数(///$8).源端按cwnd大小发送数据.每收到一个对新数据的应答ACK,cwnd就最多增加基金项目:国家863高技术研究发展计划基金资助项目(2oo3AAl2l560);江苏省高技术研究计划资助(BG2003001).作者简介:张牧(1980一),男,博士研究生,主要方向是计算机网络;张顺颐(1944一),男,教授,博士生导师,南京邮电大学副校长.中国电子学会通信分会理事,中国通信学会通信软件分会理事,国家863通信主题高速宽带通信技术经济专家组成员.主要研究方向是计算机通信网及IP技术.202007.43(1)ComputerEngineeringandApplications计算机工程与应用17155个字节.显然cwnd的增长将随尺呈指数级(exponentia1)增长.当cwnd增长超过慢启动阀值(SSthresh)或者检测到拥塞时.停止执行慢启动算法,转入拥塞避免阶段.(2)拥塞避免:当发现超时或者收到三个相同ACK确认帧时,网络发生拥塞,此时进入拥塞避免阶段.ssthresh被置为当前cwnd值的一半.如果是超时.cwnd还要被置1.如果此时cwnd~ssthresh.TCP就重新进入慢启动过程;如果cwnd>ssthresh,TCP就执行拥塞避免算法,cwnd在每次收到一个ACK时只增加1/cwnd个数据包.所以在拥塞避免算法中cwnd 的增长不是指数的,而是线性的(1inear).(3)快速重传/快速恢复:当数据包超时时,cwnd要被置为1,重新进入慢启动,这会导致过大地减小发送窗口尺寸,降低TCP连接的吞吐量(throughput).所以快速重传和恢复就是在源端收到3个或3个以上重复ACK时,就断定数据包已经丢失,重传数据包,同时ssthresh置为当前cwnd的一半,而不必等到超时重传计数器(RTO)超时.2.2TCPV egasTCPV egas是标准TcP拥塞控制算法Reno的改进方案,和Reno采用报文段丢失作为拥塞度量所不同的是,V egas采用延迟作为拥塞度量.并且通过比较实际传输速率和期望传输速率之间的差值来预知拥塞的发生.并且在重传机制和慢启动机制方面做了一定修改.(1)拥塞避免:为了避免拥塞.V egas将实际传输输率(AC.tua1)和期望传输输率(Expected)比较,Expected定义为: Expected=WindowSize/BaseRTT.WindowSize为拥塞窗口大小, BaseRTT为所观察到的最小的RI3".Actual定义为:Actual= WindowSize/R.尺为当前观察到的值.V egas将Expected与Actual的差值与门限值和卢比较(),当差值小于时,V egas在下一个尺中线性增大拥塞窗口;当差值大于口时.V egas则在下一个尺中线性缩小拥塞窗口;否则拥塞窗口保持不变.(2)慢启动:在改进的慢启动算法中,cwnd每两个尺增加一倍.因此在两个尺期间,有一个R的期间cwnd不会变化.这样Actual和Expected的比较就较为准确.比较值同另一个门限值A作比较,当比较值达到门限值A,V egas就进入拥塞避免阶段.(3)快速重传/快速恢复:Vegas采用了较之Reno快速重传机制来讲性能更好的重传机制.在发送每个数据段时V egas读取并记录下系统时间.当一个ACK到达时,V egas再次读取系统时钟并以该时间和先前记录下的时间来计算.当接收到重复ACK时,V egas检查当前尺刀是否比超时值大,如果是.V egas就立即重发相应的数据段,而不必等到第三个重复ACK 的到来.当接收到非重复的ACK时.如果它是重发之后的第一或第二个确认,V egas将再次检测第一个未被确认的数据段发送的时间和此时的时间间隔是否大于超时阀值,如果是,V egas 将重发该数据段.2.3FastTCPFastTCP是建立在V egas采用延迟作为拥塞度量基础上的改进方案,它致力于解决高速大时延环境下Reno和V egas所无法逾越的带宽利用率低等问题,它仅限于对发送方的代码予以修改.Fast是根据距离平衡点位置的远近来调整窗口大小变化的快慢的.Fast与Vegas最大的区别在于拥塞窗I=I改变的机制上.在慢启动和拥塞避免阶段,Fast根据估算模块提供的平均尺和平均排队延迟周期性地更新拥塞窗口大小:.+—min{2,(1—)+y(鱼鱼;等L+(,qdelay))}nJ1其中,E(0,1】,6珊e尺是所观察到的最小的尺TT,qde是端到端的平均排队时延.实现中,拥塞窗口每两个尺刀改变一次:在一个尺中更新,在另一个尺中保持不变.更新只在第一个中进行,这样拥塞窗口就不可能平均在每个尺内增大一倍,这一点类似于V egas.函数(,qde)定义为:函数(,qdelay)在qdelay非零时取值为一个常数即a(w.qdelay)=p,而在qdelay为零时则a(w,qdelay)=pw.这样,当qdelay为零时,Fast就以速率P指数性地增大窗口,直到qdelay>O.然后a(w,qdelay)就变成一个常数P.窗口会根据qdelay以一个不同的速率指数性地汇聚到平衡点.Fast在丢失恢复阶段也采用上述的拥塞控制机制.但由于重传报文段的不确定性,目前Fast采用的做法可以遵循V egas 的快速重传/快速恢复机制.当检测到一个报文段丢失时,Fast 将其窗口减半并进入丢失恢复阶段.这样做的目的是在严重的拥塞发生时.迅速地减缓报文段的发送.以使系统回到能再次估计有效R1T的机制下,这样窗口调整叉能有效地进行了.3算法分析Reno的拥塞算法具有AIMD(Additive—increate—multiplica- tive—decrease)的形式:窗口在每个尺中增大一个报文段的长度,每检测到一个丢失则窗121大小缩小一半.在拥塞避免阶段,源端i窗口(f)在每个尺中增大一个报文段的长度,增长数据的大小就是:(一())(_p()南其中(£)是t时刻拥塞窗口大小,()是源i报文段的回路响应时间尺,Xf(t-T~(£))是t时刻收到AC的输率,P()是在t时刻端到端的丢失率,每收到一个ACK平均增长1/w()个报文段.在每个尺中减小数据的大小如下:(一())p(£)半因此,拥塞窗口()的变化就是:()(一())(_p()南+(t-T,(£))pf(£)半(1)由于在拥塞避免阶段传输输率变化非常慢,所以.(£一(£))~--'X(£).另外也因为数据包丢失的概率非常小,所以(1一P(£))1.由此,等式(1)可简化成(f))州)(2)由于传输输率xi=(£)(£),(£)是平均窗口大小,4wl(f)/3是峰值窗口大小.式(2)可简化为(南__2()p(嘲)(3)设置式(3)中W()=o时,得出TCPReno着名的1,,/张牧,张顺颐:TCPReno,TCPV egas,FastTCP性能比较研究21等式嘲,该等式在平衡点将丢失率和窗13大小建立了关系:Pl=V egas和Reno的最大区别在于拥塞避免阶段.V egas并不是只有在检测到超时或丢失才降低窗13.而是通过比较实际速率和期望速率之间的差值来决定增大窗13.缩小窗13还是维持不变,可以通过下面一个等式来说明这种调整机制:10i(t+1)=咖南半一器姐南半一器10i㈤telse其中(t)表不t时刻的回路响应时同刀,d代表传输时延,半为t时刻的期望速率,器表示t时刻的实际传输速率.两者之差腓半一器g聃基于平衡的窗口调整机制主要是以DIFF的变化为依据.两个参数的设置0f.V eg聃算法在平衡点处,存在一个值,冈,使得一=.由于l'i,=dl,g表示在平衡点处的排队延迟,表示平衡点的速率,那么等式可以变形为埠(5)g由此可以看出和g及有关.假设一条瓶颈链路上存在着多条TCP流,由于都共享路由器缓存,所以排队延迟g都应该是相等的,而0由于取值介于0f和卢之间是随机的.dl也因为各条流的传输距离长短而不同,所以各条TCP流的平衡点传输速率就会因的不同而不同.Fast算法每个源端i的窗13变化可以写成一个等式:1)--y(峨㈤))+(1)(6)其中dl代表传输时延,qt(t)表示排队延迟,',E(O,1】,0f(,q)定义为:,,lOWiql=0口f)otherwiseFast算法在平衡点处0f(,q),式(6)化简为:(t+1)=10;(t)(P;(t)ql(t))(7)于是可以得到:(t)(P--Xi(t)q(t))(8)当loi(t)-O时,向.因此可以看出,平衡点的速率只和平衡点排队延迟g有关,而与传送时延无关.从上述分析可以看到,Reno以报文段丢失作为拥塞的度量,当发现有连续报文段丢失,相应地调整窗13的大小.算法比较简单,在低带宽时延的网络环境下对某一时刻的网络拥塞能够较好地发现并调整窗13.为了维持动态平衡,Reon必须周期性地产生一定量的报文丢失,带宽的利用率不高,随着网络带宽的提升,这种弊端愈加明显.V egas以延迟作为拥寒度量,因此在低带宽延迟网络环境下可以很好地反映较长一段时间内的网络拥塞情况.平均性能高于Reno算法.Fast以平均刀和平均排队延迟周期性的更新拥塞窗13大小,能很好地适应大带宽延迟下的网络环境,获得较高的带宽利用率,在平衡点处平衡性能较好.4仿真与分析在ns—aUinone一2.26in仿真环境下对上述算法进行了仿真. 仿真采用的网络拓扑结构如图1所示.在网络拓扑中有两个路由器(采用DropTail队列策略),一个发送端和一个接受端.田1仿真实验网络拓扑结构田分别在瓶颈链路带宽为10Mbps和1(1t3Mbps两种环境下对Reno,V egas,Fast三种算法进行了仿真,得到了每个算法在该场景下的拥塞窗13变化曲线图,传输速率变化曲线图.刀变化曲线图和重复AC变化曲线图.图2至图4分别是Reno,V egas,Fast在10Mbps和1(1t3Mbps两种带宽环境下的系统仿真结果图.在10Mbps带宽下,对于V egas,选取参数O/----- 1,~---3.对于Fast,选取参数p--4.在1(1t3Mbps带宽下,对于V egas,选取参数=1O,fl=30.对于Fast,选取参数p=20.从图中可以看出,在低带宽(10Mbps)环境下,Reno的拥塞窗13曲线在平稳后呈锯齿状,但必须周期性地产生报文段丢失以维持这种平衡,当然,在低带宽的环境下,这对传输速率还不会造成太大影响.传输输率在达到平衡后也成周期性变化.V egas在3S左右的时刻窗13变化曲线突然断了,这是因为在3S以后,发送传输速率和期望传输速率之差介于0f和之间,窗口不变化了,并且达到稳定点后传送输率维持在较高的水平,带宽利用率几乎达到100%.Fast在平衡状态下,发送端的拥塞窗口在平衡位置大小附近上下波动,这主要是由于存在反馈延迟所造成的.由于Fast和V egas都是基于平衡的算法.所以两者在传输输率变化,刀变化.重复AC变化方面都类似.在高带宽(1(1t3Mbp8)环境下,Reno拥塞窗口从一个报文段丢失恢复到最大值需要多达几十秒钟的时间,这对带宽利用率的影响是非常明显的,随着带宽的不断增大,Reno的这种AIMD机制已经越来越不能适应网络的变化了.V egas存在着与Reno类似的问题,拥塞窗口从一个初始值达到平衡需要相当长的时问.而Fast在高带宽下显示出了良好的性能.拥塞窗口能很快达到平衡,带宽利用率较好.5结论Reno作为应用最广泛的算法,其包含的慢启动,拥塞避免和快速重传/快速恢复机制较好地解决了低带宽低时延下网络拥塞的问题.因此它也成为其他TCP算法的基础.但它存在着许多局限性.比如丢失率过高,增长过慢和摇摆过于严重等问题.这些问题随着网络带宽的增长已经日益凸现其危害性.V egas使用RrITI'的改变来判断网络可用带宽,所以能较好地预测网络带宽使用情况,并且对小缓存(smallbuffer)的适应性较强,其公平性,效率都较好.但V egas也存在着较多问题,比如刀的估算失误会导致长时间排队,速率分配不公平以及高时222007,43(1)ComputerEngineeringandApplications计算机工程与应用菪忡…….l●l●ll;,^l卵叠11:::…_厂—————1.广——竹———寸—'P—I!:i!i…I…?}……?-}……??……一?÷……-?;……-?;……-一;……?一lfiiii8目7宝654时间r吐曲线t-rK(t)ji要善曩是饕;::.上.,,/l一●…●●一L—L一—J一一薰×104时间速率曲线(t),进.::'—;j^;;8叠宝6时间rtt曲线t-rR(t);●ll_ll;jjr唧哪咖哪m_㈣l-脚_?n-舢---I_ImuInml帅II■啊珥町.呷.nn刚'¨刖.f¨"'¨¨叩m'f¨_¨'__¨町. ;;;;:∞5oF一./-…l/i0—J058目26窀4时间dupaeke曲线t--duparks(t) I.时间窗口曲线卜仲(1) 10152025303540时间速率曲线(1)I{510l52025303540时间m曲线t-rtt(t) 0510152025303540{瑚5ot…一§.05时问dupacks曲线t-dupacks(t) 驾喜喜羹::..--一一././/.——一主:.害宝窀x104时间速串曲线t-x(t)^..0510*******O3540llllll-●_●●●ii●●_:::咖_TⅡT_I啊uH翻__rIunⅡⅢ-哪n-l_咖珊-lml-衄-1.-¨_-__.---- .■IIIHHnFIllNIWlNlllllpfllliUIIflflgllpilflflfllflIlll[1●_……r…了一—一一;;;ll1l0o善.鲁言0时问dupaeks曲线t-dupacks(t)l520253035加0510152025303540时间时间圈3V egas在10Mbps和100Mbps带宽环境下仿真结果圈延环境下会变得不稳定等等.除了算法自身的原因外,V egas在带宽竞争能力方面也不及其它算法,这些原因,使得V egas没有能真正大规模地在IIltenlet上推广开来.Fast算法是近一两年才提出的一种新的TCP拥塞控制算法.该算法尤其适合大带宽高延迟环境下,在高速网络环境下.带宽利用率可达9O%以上,这一点是其他算法所无法比拟的.Fast根据当前到平衡点距离的远近非线性地调整窗口变化速度.以此提高窗口的响应速度和减缓窗口的波动幅度.使得数据流始终处在最优化的状态中.当然该算法也存在着一些问题.其中最主要的是平衡点的选择,平街点的选择是V egas算法的基石,选择不当,暑譬d,兽桀釜譬÷吐狙椭幂张牧,张顺颐:TCPReno.TCPV egas,FastTCP性能比较研究喜署恤黑善杂-5是鬻时问速率曲线t(t)/38璺26时间rtt曲线t-rtt(t)■一llI皿l衄m删皿lm"岫ⅢⅡmⅢ咖响蛐吐衄山蛐m咖叫哪_■II1t1邗硼mTT■霸7耵m11111l研啊"■啊哪哪I1啊n唧嗣O00510I52025303540时间dupacks曲线t-dupacks(t)510152025303540时间主善蕞是婴时问窗口曲线t(t)/-■H■w".{毒署悼|i0510152025303540;;_■imm-■■■●■-■■■一_●—一●●一l●.IlI鲁言0.00.00.10.20.30.40.50.60.70.80.91.0时阃圈4Fast在10Mbpo和100Mbps带宽环境下仿真结果图将会导致网络性能急剧下降.甚至崩溃.一条TCP流在建立的过程中如何找这个平衡点以及运行过程中如何根据网络环境的变化修正它.这个问题将是该算法今后研究的重点.(收稿日期:2005年l2月)参考文献:…1CaserriC.MeoM.Anewapproachtomodelthestationarybehav—iorofTCPconnections【qmcIEEElnfocom2000,TelAviv.Israe1. CAdEEEComputerSociety,2000.[2]2JacobsonV.Congestionavoidanceandcontrol[J].IEEE/ACMTrans—actionNetworking.l998,6(3):314—329.【3】BrakinoLS.TCPvegas:newtechniquesforcongestiondetection& avoidance[Cr0cSIGGCOMM'99,1999.【4】JinCheng,WEIDX.LowSH.FASTTCP:motivation,architecture, algorithms,performance[C]//ProcIEEEINFOCOM2004.HongKong: IEEECommunicationsSociety,2004.【5】KalampoukasLCongestionmanagementinhi【ghspeednetworks【D1.UCSC.1997.【6】MathisM.SemkeJ,MahdaviJ,eta1.Themacroscopicbehaviorof theTCPcongestionavoidancealgorithm[J].ACMComputerCommu—nicationReview,1997,27(3).【7】TheNetworkSimulator-ns-2[EB/OL].[20041./nsnam/ ns/.2004.(上接8页)[2J2PonnappanA,Y angLing-jia,RadhakrishnaPillaiR.Apolicybased QoSmanagementsystemforthelnterServ/DiflServbasedIntemet【C]//IEEE3rdInternationalWorkshoponPoliciesforDistributed A.2002:l59-168.【3】FlegkasP,TrlmintziosP,PavlouG.Apolicy—basedqualityofser- vicemanagementsystemforIPDiflServnetworks[J】.IEEENetwork.2002,16(2):50-56.?f41TMFGB922Addendum一1一POLCommonbusinessentitydefini.tions-policy[S】.2003.【5】IETFRFC2753Frameworkforpolicy-basedadmissioncontrol【S】,2ooo.[6】6IETFRFC3198Terminologyforpolicy-basedmanagement[s】,20O1.【7】LupuEC.SlomanM.Conflictsinpolicy—baseddistributedsystems management[J].IEEETransactionsonSoftwareEngineering,1999.25(6):852—869.【8】DunlopN.IndulskaJ.RaymondK.Methodsforconflictresolution inpolicy-basedmanagementsystems[CEEE7thInternationalEn- terpriseDistributedObjectComputingConference.Brisbane,Aus-tralia.2003:98-109.【9】DunlopN,lndulskaJ,RaymondK.Bynamicconflictdetectioninpolicy-basedmanagementsystems[CEEE6thInternationalEnter-usanne.Switzer-1and.2002:I5—26.【lO】李祥军.基于策略的网络管理关键技术及其应用的研究【DJ.北京: 北京邮电大学.2Oo5.。

网络优化中的TCP优化技术随着互联网的不断发展和应用规模的扩大,网络优化变得至关重要。

而在网络优化的过程中,TCP(传输控制协议)优化技术是一项关键的技术。

本文将介绍TCP优化技术的相关概念、作用和具体实施方法,并探讨其在网络优化中的重要性。

一、TCP优化技术的概念和作用TCP是一种面向连接的协议,它负责在互联网上可靠地传输数据。

然而,在实际应用中,由于网络环境的复杂性和传输过程中的各种因素,TCP可能会遭遇流量拥塞、时延过高、丢包等问题,从而影响传输速度和稳定性。

而TCP优化技术旨在解决这些问题,改进TCP协议的性能,提升网络传输的效率和质量。

其主要作用可以总结为以下几个方面:1. 提高吞吐量:通过优化TCP协议的拥塞控制算法、流量控制机制等,提高网络吞吐量,实现更高的传输速度和数据传输能力。

2. 减少拥塞:通过有效控制拥塞窗口、快速调整拥塞窗口大小等手段,及时发现和响应网络拥塞,减少拥塞带来的传输延迟和丢包率。

3. 提高稳定性:通过改善TCP协议的丢包恢复机制、拥塞避免算法等,减少传输中的丢包现象,提升传输的稳定性和可靠性。

4. 降低延迟:通过对TCP协议进行优化,减少传输时延,提高响应速度,提供更好的用户体验。

二、TCP优化技术的实施方法为了实现TCP协议的优化,有多种技术和方法可供选择。

以下是一些常见的TCP优化技术:1. 拥塞控制算法优化:对传统的TCP拥塞控制算法进行改进,引入新的算法或优化现有算法,以更好地适应不同的网络环境和拥塞状况。

2. 数据包捎带机制:通过在ACK(确认应答)数据包中携带数据,实现数据的批量传输,减少传输延迟。

3. 数据压缩:对传输的数据进行压缩处理,减少传输的数据量,提高传输效率。

4. 传输层代理:在网络中增加传输层代理服务器,对传输过程进行优化,提供更高的传输性能。

5. 前向纠错机制:对传输的数据进行冗余编码,使接收端能够校正一定程度的数据错误,提高数据传输的可靠性。

TCP协议的数据压缩与解压缩技术简介在网络通信中,TCP协议被广泛应用于数据传输,其可靠性和稳定性被广泛认可。

然而,随着网络应用的不断发展,传输的数据量也日益增多,这对网络带宽和传输速度提出了更高的要求。

为了提高TCP 协议的性能和效率,数据压缩与解压缩技术应运而生。

一、数据压缩技术的基本原理数据压缩技术是指将大容量的数据通过某种算法进行处理,使其在占用更小的空间的前提下保持原始数据的完整。

常见的数据压缩算法包括无损压缩和有损压缩。

无损压缩是指在压缩数据时,不丢失原始数据的任何信息,使数据能够通过解压缩还原到原始数据;而有损压缩则是在保证数据主要特点的前提下,舍弃一些不重要的信息,从而达到更高的压缩比例。

二、 TCP协议中的数据压缩技术为了在网络传输中减少数据量,提高传输效率,TCP协议引入了数据压缩技术。

数据在传输过程中,可以进行压缩以减少传输的数据量,节省带宽资源。

当数据到达目的地后,再进行解压缩,还原为原始数据。

常见的TCP协议中的数据压缩技术有以下几种:1. 基于字典的压缩算法基于字典的压缩算法将待压缩的数据与事先定义好的字典进行对比,找出重复的片段,并用索引来替代这些重复的片段。

这样可以大大减少重复数据的传输,从而达到数据压缩的效果。

2. 基于哈夫曼编码的压缩算法基于哈夫曼编码的压缩算法通过构建一颗哈夫曼树,为频率高的数据分配较短的编码,为频率低的数据分配较长的编码,从而提高压缩率。

解压缩时根据编码表进行解码,还原为原始数据。

3. 基于LZ算法的压缩算法LZ算法是一种常用的无损压缩算法,在TCP协议中被广泛应用。

它的基本原理是将已经传输的数据作为查找表,通过引用查找已经出现的数据块,将其替换为指向其在数据流中的位置的指针。

这样在传输时只需要传送该指针而不是重复的数据,从而实现数据的有效压缩。

三、数据解压缩技术数据解压缩技术是对压缩后的数据进行还原,使其恢复为原始的数据格式。

解压缩技术需要与压缩技术相对应,通过解析压缩后的数据,根据压缩时使用的算法进行相应的解压操作。

计算机网络中的拥塞控制算法研究随着计算机网络愈发普及,网络瓶颈和拥塞控制问题日益引起人们的关注。

拥塞控制算法是计算机网络中避免网络拥塞的重要手段,其目的就是防止网络中流量的过度增长,从而保证网络的稳定性和性能。

本文将从三个方面来探讨计算机网络中的拥塞控制算法,分别包括:传输控制协议(TCP)拥塞控制算法、自适应拥塞控制算法和流量监测及拥塞控制方法。

1. TCP拥塞控制算法TCP是计算机网络中最常用的传输协议之一,其拥塞控制算法也是最为基础的。

TCP拥塞控制算法主要分为四个部分:慢启动、拥塞避免、快重传和快恢复。

慢启动是当一个TCP连接被建立时,TCP传输以极低速度进行数据包的传输,以便确定网络的瓶颈容量,并逐步增加其传输速度。

拥塞避免是在慢启动阶段结束后,系统将以一个相对较小的速度增加发送数据包和窗口大小,以避免网络拥塞。

如果接收到了重复数据包,则说明网络中可能存在拥塞,此时就会触发快重传算法,即跳过等待重复确认的步骤,立即进行重传。

当数据包正确到达接收方并获得确认时,TCP会将窗口大小减半,然后进行快恢复算法,利用这部分确认的数据包进行拥塞控制,重新计算拥塞窗口大小。

2. 自适应拥塞控制算法自适应拥塞控制算法是建立在TCP拥塞控制算法之上的,其最大特点在于对网络拥塞的敏感性以及能够自适应地根据网络情况调整传输速度。

现在,在自适应拥塞控制算法方面最常用的是基于反馈的算法,例如,零控制(AIMD),增量式拥塞控制算法,复合增量式算法(CUBIC)和幅度减少拥塞控制算法(RCP)。

零控制算法(AIMD)是在TCP基础之上进一步改进的拥塞控制算法,它是一种相对简单的算法,主要通过周期性的增加或减少速度来控制网络的拥塞。

增量式拥塞控制算法通过计算TCP连接的平均速度,根据连接是否发送或接收数据来计算其拥塞,并进行拥塞控制策略的调整。

CUBIC算法是一种拥有突出性能的自适应算法,该算法能够自适应地调整传输窗口大小,并且对高延迟的网络有着更好的适应性。

TCPIP协议中分包与重组原理介绍TCP/IP协议中分包与重组原理介绍分片是分组交换的思想体现,也是IP协议解决的两个主要问题之一。

在IP协议中的分片算法主要解决不同物理网络最大传输单元(MTU) 的不同造成的传输问题。

但是分组在传输过程中不断地分片和重组会带来很大的工作量还会增加一些不安全的因素。

我们将在这篇小论文中讨论IP分片的原因、原理、实现以及引起的安全问题。

一、什么是IP分片IP分片是网络上传输IP报文的一种技术手段。

IP协议在传输数据包时,将数据报文分为若干分片进行传输,并在目标系统中进行重组。

这一过程称为分片(fragmentation)。

二、为什么要进行IP分片每一种物理网络都会规定链路层数据帧的最大长度,称为链路层MTU(Maximum Transmission Unit).IP协议在传输数据包时,若IP 数据报加上数据帧头部后长度大于MTU,则将数据报文分为若干分片进行传输,并在目标系统中进行重组。

比如说,在以太网环境中可传输最大IP报文大小(MTU)为1500字节。

如果要传输的数据帧大小超过1500字节,即IP数据报长度大于1472(1500-20-8=1472,普通数据报)字节,则需要分片之后进行传输。

三、IP分片原理及分析分片和重新组装的过程对传输层是透明的,其原因是当IP数据报进行分片之后,只有当它到达目的站时,才可进行重新组装,且它是由目的端的IP层来完成的。

分片之后的数据报根据需要也可以再次进行分片。

IP分片和完整IP报文差不多拥有相同的IP头,ID域对于每个分片都是一致的,这样才能在重新组装的时候识别出来自同一个IP报文的分片。

在IP头里面,16位识别号唯一记录了一个IP包的ID,具有同一个ID的IP分片将会重新组装;而13位片偏移则记录了某IP片相对整个包的位置;而这两个表中间的3位标志则标志着该分片后面是否还有新的分片。

这三个标志就组成了IP分片的所有信息(将在后面介绍),接受方就可以利用这些信息对IP数据进行重新组织。

TCP协议的数据压缩与解压缩技术简介一、引言TCP(Transmission Control Protocol)是一种面向连接的传输层协议,它在网络通信中起着至关重要的作用。

为了提高数据传输的效率和速度,人们不断探索和研究新技术。

其中数据压缩与解压缩技术在TCP协议中具有重要意义。

本文将对TCP协议的数据压缩与解压缩技术进行简要介绍。

二、数据压缩技术数据压缩技术是将数据流中的冗余信息删除或者改变编码方式,以减少数据占用的带宽或存储空间。

在TCP协议中,数据压缩技术通过减少数据传输量来提高网络的传输效率。

常用的数据压缩技术有无损压缩和有损压缩。

1. 无损压缩无损压缩是指在压缩过程中不丢失任何数据信息。

常见的无损压缩算法有哈夫曼编码、LZW(Lempel-Ziv-Welch)编码等。

这些算法通过利用统计学原理和数据的重复性特征,将频繁出现的数据或者字符用较短的编码表示,从而达到压缩数据的目的。

在TCP协议中,无损压缩常用于文本等数据的传输。

2. 有损压缩有损压缩是指在压缩过程中会丢失一部分数据信息,但可以在可接受范围内保持数据质量。

有损压缩常用于图片、音频、视频等数据的传输。

其中,JPEG(Joint Photographic Experts Group)是一种常用的图像压缩算法,通过丢弃图像中的某些细节和颜色信息,以达到更高的压缩比和更小的文件大小。

三、数据解压缩技术数据解压缩技术是将压缩后的数据恢复为原始数据的过程。

在TCP协议中,解压缩技术扮演着重要角色,它能够将压缩的数据重新还原,以便接收端正确理解数据。

1. 解压缩算法解压缩算法与压缩算法相对应,常见的解压缩算法有与压缩算法类似的哈夫曼解码、LZW解码等。

这些算法通过参照压缩过程中产生的编码表或者字典,对压缩后的数据进行解码,从而恢复原始数据。

2. 数据缓存TCP协议中,解压缩往往需要对数据进行缓存。

因为在压缩的过程中,很可能将多个原始数据合并成一个数据包进行传输。

snort的流重组原理Snort是一种开源的入侵检测系统(IDS),它可以用于监控和分析网络流量。

在Snort中,流重组是一个重要的功能,它可以帮助将分散在多个网络数据包中的信息重新组装成完整的数据流。

本文将介绍Snort的流重组原理及其工作机制。

一、流重组原理在网络通信中,数据通常被分割成多个数据包进行传输。

这些数据包通过网络传输到达目的地后,需要按照一定的顺序重新组装成完整的数据流才能被正确解析和处理。

流重组就是将这些分散的数据包按照其序列号重新组装成原始的数据流。

在Snort中,流重组是通过分析数据包的IP头部和TCP/UDP头部信息来实现的。

IP头部中的源IP地址、目的IP地址以及协议类型可以帮助识别数据包所属的流。

而TCP/UDP头部中的源端口号和目的端口号可以帮助将数据包按照流的顺序进行重组。

二、流重组的工作机制1. 数据包捕获与预处理:Snort使用网络接口捕获数据包,并对数据包进行预处理。

预处理的过程包括对数据包进行解析,提取其中的关键信息,如IP头部和TCP/UDP头部信息。

2. 流跟踪:Snort使用流跟踪模块对捕获到的数据包进行跟踪。

流跟踪模块根据数据包的IP头部信息和TCP/UDP头部信息,将数据包分组成不同的流。

每个流都有一个唯一标识符,用于区分不同的流。

3. 数据包排序:流跟踪模块将每个流中的数据包按照其序列号进行排序。

这样可以确保数据包按照正确的顺序进行重组。

4. 流重组:一旦数据包按照顺序排序,流重组模块将按照其序列号将数据包重新组装成完整的数据流。

在重组的过程中,流重组模块会检查数据包的有效性和完整性,如果发现数据包有错误或缺失,将会进行相应的处理。

5. 数据流分析:完成流重组后,Snort可以对完整的数据流进行分析和检测。

它可以通过预定义的规则对数据流进行匹配,以便识别潜在的安全威胁或异常行为。

三、流重组的应用场景流重组在网络安全领域有着广泛的应用。

它可以帮助检测和防御各种网络攻击,如拒绝服务攻击、端口扫描、漏洞利用等。

TCP协议的乱序与重复数据处理策略引言:TCP(Transmission Control Protocol)是一种基于连接、可靠的传输协议,它负责将数据可靠地传送给目标主机。

但在数据传输过程中,由于网络中的各种因素,例如网络拥塞、路由器故障等,TCP协议中所传输的数据有可能出现乱序和重复的情况。

本文将探讨TCP协议对乱序和重复数据的处理策略。

一、乱序数据处理策略在数据传输过程中,TCP协议使用序号(Sequence Number)来对传输的数据进行排序和组装。

当接收端收到乱序的数据时,它会将这些乱序的数据存储在缓冲区中,待所有乱序数据完全收到后,再进行排序和组装。

1. 排序和组装TCP协议中的接收端使用序号来对数据进行排序和组装。

每个TCP 分段中都会有一个序号字段,通过比较序号大小,接收端可以将乱序的数据排列成正确的顺序。

一般而言,TCP协议使用累计确认(Cumulative ACK)来表示它所期望收到的下一个连续字节的序号。

2. 容错处理当数据出现乱序时,TCP协议使用超时重传机制来容错。

接收端会定时向发送端发送确认消息,如果发送端在规定的时间内没有收到确认消息,就会触发超时重传机制,将已发送但未确认的数据重新发送。

3. 乱序缓冲区接收端为了处理乱序数据,会使用乱序缓冲区来存储乱序数据。

当乱序数据到达时,它会被存储到相应的位置,等待后续的数据。

一般情况下,接收端会限制乱序缓冲区的大小,以防缓冲区溢出。

对于超过缓冲区大小的数据,接收端会丢弃掉。

二、重复数据处理策略在数据传输过程中,TCP协议中的数据包有可能由于网络的原因而重复发送。

为了处理重复数据,TCP协议采用了以下策略:1. 接收端去重接收端收到重复数据时,它会利用已接收数据的累积确认来丢弃重复数据。

通过比较序号大小,接收端可以判断数据是否为重复数据,并对重复数据进行丢弃。

2. 发送端重发发送端在收到接收端的冗余确认时,会认为数据包丢失,并进行重发。

TCP系列16—重传—6、基础快速重传(FastRetransmit)⼀、快速重传介绍按照TCP协议,RTO超时重传是⼀个⾮常重要的事件,当RTO超时的时候,TCP会同时通过两种⽅式⾮常谨慎的降低发送数据包的速率,⼀种是基于拥塞控制削减发送窗⼝的⼤⼩,另外⼀个是通过指数回退增加每次RTO超时的时间(即karn算法的第⼆部分)。

所以RTO超时后有可能会导致⽹络容量的利⽤不⾜。

最开始我们介绍tcp重传的时候就介绍过TCP还有另外⼀种重传⽅式--快速重传。

快速重传是RFC5681定⼀个的⼀个过程。

快速重传不依赖定时器的超时,⽽是依靠ACK确认包来进⾏重传。

使⽤快速重传相⽐RTO超时重传通常可以更⾼效的修复TCP丢包问题。

快速重传是基于⼀个前提:即按照RFC5681,当TCP收到⼀个乱序报⽂的时候应该⽴即回复ACK确认包,⽽不会延迟ACK(延迟ACK介绍参考之前⽂章介绍)确认。

另外RFC5681还指出如果接收序列号空间存在洞,新接收的报⽂完全填充了这个洞或者部分填充了这个洞,TCP也应该⽴即回复⼀个ACK确认包以便发送端及时获取接收端相关的信息。

我们举个例⼦假设有5个TCP报⽂,P1(1-10)、P2(11-20)、P3(21-30)、P4(31-40)、P5(41-50),其中括号中标注的是报⽂的⽐特系列号,每个报⽂的长度都为10bytes。

假设发送端依次发送这5个报⽂,其中P2报⽂在⽹络传输过程中丢失,P1、P3、P4、P5报⽂依次按序到达,接收端收到这P1的时候发送ack=11的确认包(实际上这⾥可能会延迟发送ACK报⽂,为了描述简单我们假设⽴即发送ACK报⽂),接收端收到P3的时候发现是乱序的报⽂则会⽴即回复ack=11确认包(还记得ACK是累计确认的吧,因为P2丢失了ACK只能累计到11),同样后⾯收到P4和P5的时候还是会回复ack=11的确认包。

这样发送端就会连续接收到4个ack=11的确认包,后⾯三个确认包因为和第⼀个ack number重复,因为称呼为duplicate ACK。

TCP协议的乱序与重复数据处理策略TCP协议是互联网传输控制协议的缩写,它在实现可靠数据传输的过程中,会面临一些挑战,其中就包括乱序和重复数据。

本文将就TCP协议中的乱序与重复数据处理策略展开讨论。

1. 乱序数据处理策略在TCP协议中,由于网络传输的不稳定性,接收端有可能会收到乱序的数据包。

为了保证数据的正确性和完整性,TCP协议引入了乱序数据处理策略。

首先,接收端维护一个接收缓冲区,每当收到一个乱序的数据包时,将其按序号存储在接收缓冲区中。

接收端会根据数据包头部中的序号信息,将乱序的数据包按序组装成完整的数据流。

当收到一个缺失的数据包时,接收端会向发送端发送一个重复确认(ACK)请求,要求发送端重新发送该数据包。

这种方式可以保证乱序数据被正确地重组。

此外,接收端还可以借助于接收窗口机制来处理乱序数据。

接收窗口定义了接收端可以接受的数据范围,通过调整接收窗口的大小,接收端可以控制能够接受的乱序数据的数量。

当接收窗口关闭时,接收端会暂停向发送端发送确认信息,从而实现流量控制,更好地处理乱序数据。

2. 重复数据处理策略重复数据是指在数据传输过程中,接收端收到了发送端已经发送过的数据包。

虽然TCP协议已经通过序号来保证数据包的有序传输,但仍有可能出现重复数据包。

为了解决这个问题,TCP协议引入了重复数据处理策略。

在TCP协议中,每个数据包都有一个唯一的序号,当接收端收到一个重复的数据包时,会向发送端发送一个重复确认(ACK)通知。

发送端收到重复确认后,会根据确认信息判断数据包是否已经被接收,若已经被接收,则丢弃重复数据包,防止发送端重复发送数据。

此外,发送端也可以采取一些策略来处理重复数据。

例如,发送端可以维护一个发送窗口,当接收到一个重复确认时,发送端会将窗口中已经确认接收的数据包从发送缓冲区中移除,避免重复发送。

综上所述,TCP协议的乱序与重复数据处理策略是通过序号和确认机制来实现的。

接收端通过维护接收缓冲区和接收窗口来处理乱序数据,而发送端通过重复确认和发送窗口来处理重复数据。

tcp协议中发送方和接收方进行流量控制的机制TCP协议中的流量控制机制是确保发送方和接收方之间数据传输的平衡与稳定的重要手段。

通过有效的流量控制,TCP能够避免接收方无法及时处理过多数据而导致的丢包和网络拥塞问题。

本文将深入探讨TCP协议中发送方和接收方进行流量控制的机制,并分享本人的观点和理解。

1. TCP流量控制的概念和重要性TCP流量控制是指发送方根据接收方的处理能力,动态调整发送数据的速率,以保证接收方能够及时处理并接收数据。

这种机制避免了数据的积压和丢失,并能有效避免网络拥塞。

在高速网络和大带宽环境下, TCP流量控制显得尤为重要,以保持数据传输的平衡和稳定性。

2. 滑动窗口机制TCP协议通过使用滑动窗口机制来实现流量控制。

滑动窗口是发送方和接收方之间的一个缓冲区,用于存储要发送或接收的数据。

通过控制滑动窗口的大小和移动,TCP协议实现了数据的有序传输和流量控制。

3. 接收方的窗口大小接收方通过在TCP首部中的窗口字段来告知发送方当前可以接受的数据量。

发送方根据接收方窗口大小调整发送数据的速率,确保不会发送超过接收方处理能力的数据量。

如果接收方窗口为0,表示接收方当前无法接收数据,发送方将停止发送数据,直到接收方窗口重新打开。

4. 慢开始算法发送方在建立TCP连接时,会先发送一个较小的数据量,并逐渐增加发送数据量的速率,这个过程称为慢开始。

慢开始算法旨在避免在网络发生拥塞时一次性发送过多的数据,导致网络瓶颈和数据丢失。

5. 拥塞窗口和拥塞避免拥塞窗口是发送方根据网络拥塞情况动态调整的一个参数,用于限制发送方的数据流量。

拥塞避免算法通过根据网络拥塞程度调整拥塞窗口的大小,使得发送方的数据流量逐步增长,以避免网络拥塞。

6. 快速重传和快速恢复快速重传和快速恢复是TCP协议中用于处理丢包问题的机制。

当发送方未收到接收方的确认消息时,会进行重传,而不是等待超时再重传。

这种机制能够快速恢复丢失的数据段,减少数据的重复传输。