最大后验概率(MAP)准则教学教案

- 格式:pptx

- 大小:595.46 KB

- 文档页数:17

贝叶斯网络(Bayesian Network)是一种表示变量之间概率依赖关系的图模型,其能够有效地处理不确定性信息,并在推理、预测、诊断、决策等领域有广泛应用。

在实际应用中,贝叶斯网络模型调优是非常重要的一环,它直接影响到模型的准确性和可靠性。

本文将从参数学习和结构学习两方面介绍贝叶斯网络模型的调优方法,并探讨当前的一些研究进展和应用场景。

参数学习是指在给定贝叶斯网络结构的情况下,通过观测数据估计网络中的概率参数。

常用的方法包括最大似然估计(MLE)、期望最大化算法(EM)、贝叶斯方法等。

其中,MLE是最简单和直接的参数学习方法,它通过最大化数据的似然函数来估计参数,但在数据较少或者样本稀疏的情况下容易产生过拟合现象。

EM 算法则是一种迭代的优化算法,它在参数估计中引入了隐变量,通过不断迭代求解期望和最大化两个步骤来逐步提升参数估计的准确性。

贝叶斯方法则是基于贝叶斯定理,通过引入先验分布和后验分布来对参数进行估计,能够有效地处理数据不平衡和噪声干扰的情况。

另一方面,结构学习是指在给定观测数据的情况下,通过优化准则来搜索最优的网络结构。

常用的方法包括贝叶斯信息准则(BIC)、最大后验概率准则(MAP)、爬山算法等。

BIC是一种模型选择准则,它在考虑模型复杂度的同时最大化模型的似然函数,以选择最优的网络结构。

MAP准则则是在BIC的基础上引入了先验分布,通过最大化后验概率来进行结构学习,能够有效地防止过拟合和提高模型的泛化能力。

爬山算法是一种启发式搜索算法,通过不断调整网络结构来优化评估准则,能够在较短的时间内搜索到局部最优解。

除了上述常用的方法,近年来还涌现了一些新的模型调优方法。

例如,基于深度学习的贝叶斯网络模型调优方法,它将深度学习模型和贝叶斯网络相结合,通过端到端的训练来优化网络结构和参数,能够处理大规模数据和复杂任务。

此外,基于元学习的贝叶斯网络模型调优方法也备受关注,它通过学习不同任务之间的相似性和差异性,来自动调整网络结构和参数,提高了模型的适应性和泛化能力。

马尔可夫网络的参数估计方法马尔可夫网络是一种描述随机过程的数学工具,它可以用来建模时间序列数据、自然语言处理等领域。

在实际应用中,我们通常需要对马尔可夫网络的参数进行估计,以便更准确地模拟和预测系统的行为。

在本文中,我们将讨论一些常见的马尔可夫网络参数估计方法,并对它们的优缺点进行比较。

1. 最大似然估计(Maximum Likelihood Estimation, MLE)最大似然估计是一种常见的参数估计方法,它通过最大化观测数据的似然函数来估计参数值。

对于马尔可夫链模型来说,我们可以通过观测数据的转移概率来估计状态转移矩阵。

具体来说,对于一个马尔可夫链模型,我们可以定义观测数据的似然函数为所有状态转移的联合概率,然后通过最大化这个似然函数来估计状态转移矩阵的参数值。

虽然最大似然估计是一种直观简单的估计方法,但是它也存在一些缺点。

首先,当观测数据较少时,似然函数可能存在多个局部最优解,使得估计结果不够稳定。

其次,当模型的参数维度较高时,最大似然估计可能会导致过拟合,从而影响模型的泛化能力。

2. 贝叶斯估计(Bayesian Estimation)贝叶斯估计是一种基于贝叶斯统计理论的参数估计方法,它通过引入先验概率分布来对参数进行估计。

对于马尔可夫链模型来说,我们可以通过引入状态转移概率的先验分布来对状态转移矩阵进行估计。

具体来说,我们可以选择一个合适的先验分布,然后通过观测数据来更新参数的后验分布,最终得到参数的估计值。

贝叶斯估计的优点在于它可以有效地利用先验信息,从而提高参数估计的稳定性和泛化能力。

另外,贝叶斯估计还可以提供参数估计的不确定性信息,这对于模型的评估和选择非常有帮助。

然而,贝叶斯估计也存在一些问题,比如选择合适的先验分布可能会影响参数估计的结果,而且计算复杂度较高。

3. 最大后验概率估计(Maximum a posteriori Estimation, MAP)最大后验概率估计是贝叶斯估计的一种特殊情况,它通过最大化后验概率来估计参数值。

最⼤后验概率(MAP)- maximum a posteriori最⼤后验(英⽂为Maximum a posteriori,缩写为MAP)估计⽅法根据经验数据获得对难以观察的量的点估计。

在统计学中,最⼤后验它与最⼤似然估计中的Fisher⽅法有密切关系,但是它使⽤了⼀个增⼤的优化⽬标,这种⽅法将被估计量的先验分布融合到其中。

所以最⼤后验估计可以看作是规则化(regularization)的最⼤似然估计。

假设我们需要根据观察数据x估计没有观察到的总体参数θ,让f作为x的采样分布,这样f(x | θ) 就是总体参数为θ时x的概率。

函数即为似然函数,其估计就是θ的最⼤似然估计。

假设θ存在⼀个先验分布g,这就允许我们将θ作为贝叶斯统计(en:Bayesian statistics)中的随机变量,这样θ的后验分布就是:其中Θ是g的domain,这是贝叶斯定理(en: Bayes' theorem)的直接应⽤。

最⼤后验估计⽅法于是估计θ为这个随机变量的后验分布的mode:后验分布的分母与θ⽆关,所以在优化过程中不起作⽤。

注意当前验g是 uniform(也就是常函数)时最⼤后验估计与最⼤似然估计重和。

最⼤后验估计可以⽤以下⼏种⽅法计算:1. 解析⽅法,当后验分布的模能够⽤closed form⽅式表⽰的时候⽤这种⽅法。

当使⽤en:conjugate prior的时候就是这种情况。

2. 通过如共扼积分法或者⽜顿法这样的数值优化⽅法进⾏,这通常需要⼀阶或者导数,导数需要通过解析或者数值⽅法得到。

3. 通过期望最⼤化算法的修改实现,这种⽅法不需要后验密度的导数。

尽管最⼤后验估计与 Bayesian 统计共享前验分布的使⽤,通常并不认为它是⼀种 Bayesian ⽅法,这是因为最⼤后验估计是点估计,然⽽ Bayesian ⽅法的特点是使⽤这些分布来总结数据、得到推论。

Bayesian ⽅法试图算出后验均值或者中值以及posterior interval,⽽不是后验模。

引言未来的无线通信系统必须能为用户提供高速率、高质量、实时的多媒体业务,然而无线信道,特别是移动无线信道是典型的随机时变信道,其在时间域、频率域以及空间角域均存在着随机性的扩散,这些扩散将造成接收信号在相对应的频率域、时间域以及空间域产生严重的衰落现象,衰落将严重地恶化无线通信系统的传输可靠性及频谱效率。

为了实现高效、可靠的无线数据传输,两种手段是必要的:①利用各种分集对抗衰落,②利用信道编码实现差错控制。

频率分集、时间分集、空间分集是主要的分集手段,充分利用这些分集方法将衰落信道尽可能地改造为AWGN信道,然后利用信道编码进行检错和纠错。

一般的信道编译码方案,难以在无线通信中以较低的信噪比达到数据业务的服务质量(QoS)(例如一般要求误比特率 BER≤10-6),即使在以前的无线移动通信系统中通常采用的RS码与卷积码串行级联的信道编码方案,与香农(C.E. Shannon)界有较大的差距,直到1993年出现的Turbo码的性能与香农界的差距仅为0.5dB。

他们发明的Turbo码的创新之处在于:用两个递归系统卷积成员码并行级联编码,这两个系统递归卷积成员码之间用一个伪随机交织器相连接,并且采用软入软出(SISO, Soft-In-Soft-Out)的迭代译码算法。

从此,Turbo 码就成为编码界的一个研究热点。

S. Ten Brink在[2]得到的Turbo码的性能与香农界的差距仅为0.1dB。

一、3G 移动通信系统的特点&Turbo 码的应用1.13G 移动通信系统的特点第三代移动通信系统的数据速率可从几kbps 到2 Mbps ;高速移动时为144 kbps ;慢速移动时为384 kbps ;静止时为2 Mbps 。

多媒体化:提供高质量的多媒体业务,如话音、可变速率数据、活动视频和高清晰图像等多种业务,实现多种信息一体化。

全球性:公用频段, 全球漫游, 大市场。

在设计上具有高度的通用性,该系统中的业务以及它与固定网之间的业务可以兼容,拥有足够的系统容量和强大的多种用户管理能力,能提供全球漫游。

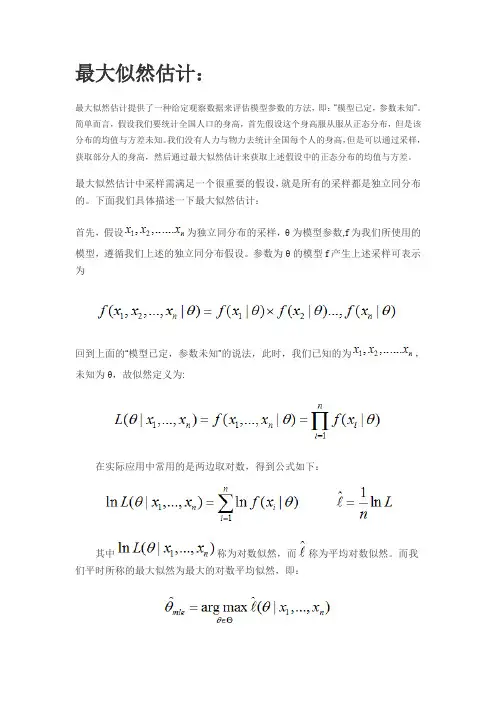

最大似然估计:最大似然估计提供了一种给定观察数据来评估模型参数的方法,即:“模型已定,参数未知”。

简单而言,假设我们要统计全国人口的身高,首先假设这个身高服从服从正态分布,但是该分布的均值与方差未知。

我们没有人力与物力去统计全国每个人的身高,但是可以通过采样,获取部分人的身高,然后通过最大似然估计来获取上述假设中的正态分布的均值与方差。

最大似然估计中采样需满足一个很重要的假设,就是所有的采样都是独立同分布的。

下面我们具体描述一下最大似然估计:首先,假设为独立同分布的采样,θ为模型参数,f为我们所使用的模型,遵循我们上述的独立同分布假设。

参数为θ的模型f产生上述采样可表示为回到上面的“模型已定,参数未知”的说法,此时,我们已知的为,未知为θ,故似然定义为:在实际应用中常用的是两边取对数,得到公式如下:其中称为对数似然,而称为平均对数似然。

而我们平时所称的最大似然为最大的对数平均似然,即:举个别人博客中的例子,假如有一个罐子,里面有黑白两种颜色的球,数目多少不知,两种颜色的比例也不知。

我们想知道罐中白球和黑球的比例,但我们不能把罐中的球全部拿出来数。

现在我们可以每次任意从已经摇匀的罐中拿一个球出来,记录球的颜色,然后把拿出来的球再放回罐中。

这个过程可以重复,我们可以用记录的球的颜色来估计罐中黑白球的比例。

假如在前面的一百次重复记录中,有七十次是白球,请问罐中白球所占的比例最有可能是多少?很多人马上就有答案了:70%。

而其后的理论支撑是什么呢?我们假设罐中白球的比例是p,那么黑球的比例就是1-p。

因为每抽一个球出来,在记录颜色之后,我们把抽出的球放回了罐中并摇匀,所以每次抽出来的球的颜色服从同一独立分布。

这里我们把一次抽出来球的颜色称为一次抽样。

题目中在一百次抽样中,七十次是白球的概率是P(Data | M),这里Data是所有的数据,M是所给出的模型,表示每次抽出来的球是白色的概率为p。

如果第一抽样的结果记为x1,第二抽样的结果记为x2... 那么Data = (x1,x2,…,x100)。

伽马分布最大后验估计公式你知道伽马分布吗?它可不是什么神秘的外星数学公式,它其实是一个挺常见的概率分布,尤其在统计学和数据科学中,简直是“常客”了。

我们今天不聊伽马分布的背景和定义,那些你可以去翻书。

今天我们聊聊一个稍微深一点的东西——伽马分布的最大后验估计,听起来有点拗口是吧?但是放轻松,咱们慢慢来,保证让你听了之后觉得其实挺有趣。

先说说什么是最大后验估计(MAP估计)。

其实呢,它就是在已知某些信息的基础上,帮你“猜”一个你不确定的参数最有可能的值。

比如你走进一个超市,想要买最便宜的苹果,但你不知道每种苹果的价格。

好在你有一些线索:有个小道消息说,红苹果的价格大致在3块到5块之间。

于是,你就可以根据这些信息,通过一些聪明的估算,猜测最合适的价格——这就是最大后验估计。

好了,回到伽马分布。

伽马分布其实是个连续概率分布,通常用来描述一些“等待时间”类的问题,比如说某个机器零件在破损前的工作时长,或者某项服务的到达时间。

如果你是学统计的朋友,肯定知道很多时候,参数不容易直接观测到。

这时候,最大后验估计就派上了大用场。

那我们具体怎么操作呢?首先得了解一下,伽马分布的参数。

它有两个:一个是形状参数α,另一个是尺度参数β。

简而言之,α决定了分布的形状,β则决定了分布的宽度。

你如果没搞明白这些参数,也能理解。

就像你买衣服,款式(α)决定了它长啥样,尺寸(β)决定了它合不合身。

假设你现在有一堆数据,假设这些数据是符合伽马分布的,你就需要最大后验估计来“猜”出这两个参数。

怎么猜呢?其实方法很简单。

你把观测到的数据和你对这些参数的先验知识结合起来,算出一个“后验分布”。

这就像你从一堆线索中,推理出最可能的事情。

比如说,形状参数α和尺度参数β一开始,你可能对它们并不确定,这时候你就需要定义一个“先验分布”。

如果你知道这些参数大致是在哪个范围内,你就可以通过这个先验分布来设定它们的“可能性”。

然后,利用你手头的数据,你就可以推导出一个后验分布。

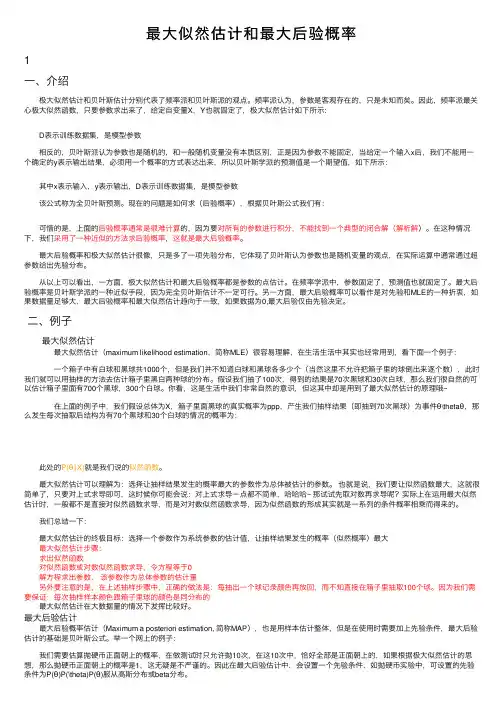

最⼤似然估计和最⼤后验概率1⼀、介绍 极⼤似然估计和贝叶斯估计分别代表了频率派和贝叶斯派的观点。

频率派认为,参数是客观存在的,只是未知⽽矣。

因此,频率派最关⼼极⼤似然函数,只要参数求出来了,给定⾃变量X,Y也就固定了,极⼤似然估计如下所⽰: D表⽰训练数据集,是模型参数 相反的,贝叶斯派认为参数也是随机的,和⼀般随机变量没有本质区别,正是因为参数不能固定,当给定⼀个输⼊x后,我们不能⽤⼀个确定的y表⽰输出结果,必须⽤⼀个概率的⽅式表达出来,所以贝叶斯学派的预测值是⼀个期望值,如下所⽰: 其中x表⽰输⼊,y表⽰输出,D表⽰训练数据集,是模型参数 该公式称为全贝叶斯预测。

现在的问题是如何求(后验概率),根据贝叶斯公式我们有: 可惜的是,上⾯的后验概率通常是很难计算的,因为要对所有的参数进⾏积分,不能找到⼀个典型的闭合解(解析解)。

在这种情况下,我们采⽤了⼀种近似的⽅法求后验概率,这就是最⼤后验概率。

最⼤后验概率和极⼤似然估计很像,只是多了⼀项先验分布,它体现了贝叶斯认为参数也是随机变量的观点,在实际运算中通常通过超参数给出先验分布。

从以上可以看出,⼀⽅⾯,极⼤似然估计和最⼤后验概率都是参数的点估计。

在频率学派中,参数固定了,预测值也就固定了。

最⼤后验概率是贝叶斯学派的⼀种近似⼿段,因为完全贝叶斯估计不⼀定可⾏。

另⼀⽅⾯,最⼤后验概率可以看作是对先验和MLE的⼀种折衷,如果数据量⾜够⼤,最⼤后验概率和最⼤似然估计趋向于⼀致,如果数据为0,最⼤后验仅由先验决定。

⼆、例⼦ 最⼤似然估计 最⼤似然估计(maximum likelihood estimation,简称MLE)很容易理解,在⽣活⽣活中其实也经常⽤到,看下⾯⼀个例⼦: ⼀个箱⼦中有⽩球和⿊球共1000个,但是我们并不知道⽩球和⿊球各多少个(当然这⾥不允许把箱⼦⾥的球倒出来逐个数),此时我们就可以⽤抽样的⽅法去估计箱⼦⾥⿊⽩两种球的分布。

假设我们抽了100次,得到的结果是70次⿊球和30次⽩球,那么我们很⾃然的可以估计箱⼦⾥⾯有700个⿊球,300个⽩球。

《机器学习(Machine Learning)》教学大纲学分:5学时:90开课单位:软件学院任课教师及职称(学位):汪浩教授、龙浩副教授、李第平博士教学内容及要求1、课程简介:世界的本质是数据(参见维克托·迈尔·舍恩伯格《大数据时代》),数据挖掘的任务是从大量数据中发现隐藏的、未知的和潜在的知识或模式的过程。

机器学习(Machine Learning, ML)是数据挖掘的基础,为数据挖掘提供了基本工具,是大数据时代重要的课程。

机器学习涉及概率论、统计学、最优化理论、算法复杂性理论等多门课程,本课程将讨论机器学习方法背后的基本数学原理,机器学习方法的基本数学模型,以及机器学习的基本方法和算法。

2、教学目的与要求:了解和掌握回归分析、分类、聚类、降维等机器学习的基本算法,同时掌握这些方法背后的数学原理,学习这些算法的基本原理,并能利用对应的软件包进行数据分析和挖掘。

3、主要内容第一章引言(10课时)教学目的和基本要求:了解机器学习的基本内容,机器学习的分类,机器学习的三要素,机器学习的模型评估和选择。

教学重点、难点:机器学习三要素,机器学习模型评估与选择教学基本内容:1.1.什么是机器学习1.2.机器学习分类●有监督学习●无监督学习●半监督学习1.3.机器学习三要素●模型●策略●算法1.4.机器学习模型评估与选择●训练误差与测试误差●过拟合与模型选择第二章回归分析(12课时)教学目的和基本要求:了解回归分析的作用,掌握回归分析的基本方法。

教学重点、难点:最小二乘法、最大似然法。

教学基本内容:1.1线性建模:最小二乘法1.2回归分析用于预测1.3正则化最小二乘法1.4线性建模:最大似然法第三章机器学习的贝叶斯方法(12课时)教学目的和基本要求:学习掌握共轭模型和非共轭模型等两种贝叶斯推理的基本方法。

教学重点、难点:图模型、共轭模型、最大后验估计MAP,拉普拉斯近似等。

教学基本内容:3.1 图模型3.2 贝叶斯估计的共轭模型●硬币游戏●后验概率●三个场景●边缘似然估计3.3 贝叶斯计的非共轭模型●非共轭模型●二值响应●最大后验估计MAP●拉普拉斯近似●抽样技术第四章分类(12课时)教学目的和基本要求:了解什么是分类,学习机器分类概率分类器和非概率分类器。

最大后验概率(map)方法Maximum a posteriori probability (MAP) methods are commonly used in statistics and machine learning to estimate the most probable value of a parameter given some observed data. In Chinese, 最大后验概率 (MAP)方法通常用于统计和机器学习领域,用于估计在给定一些观察数据的情况下,参数的最可能值。

MAP estimation is widely used in various applications such as image processing, signal processing, and natural language processing. It aims to find the parameter value that maximizes the posterior probability of the parameter given the observed data. In Chinese, MAP估计在各种应用中被广泛使用,如图像处理、信号处理和自然语言处理。

它的目标是找到在给定观察数据的情况下,使参数的后验概率最大化的参数值。

To understand MAP estimation, it is essential to have a basic knowledge of probability theory. It involves the calculation of the prior probability, likelihood function, and posterior probability. In Chinese, 要了解MAP估计,有必要对概率论有基本的了解。

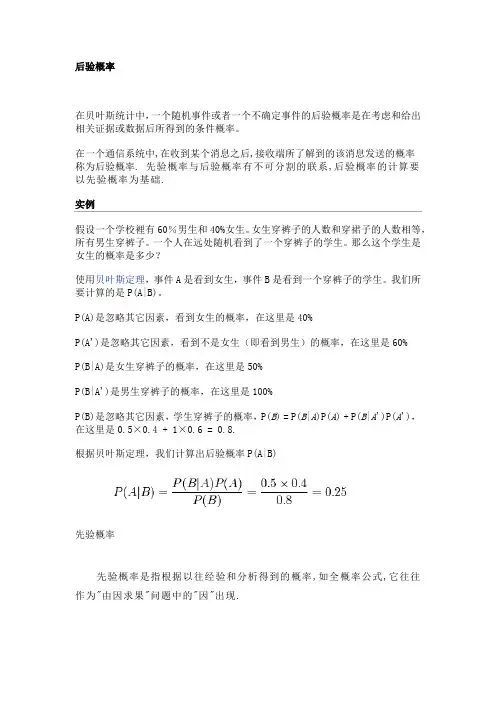

后验概率在贝叶斯统计中,一个随机事件或者一个不确定事件的后验概率是在考虑和给出相关证据或数据后所得到的条件概率。

在一个通信系统中,在收到某个消息之后,接收端所了解到的该消息发送的概率称为后验概率. 先验概率与后验概率有不可分割的联系,后验概率的计算要以先验概率为基础.实例假设一个学校裡有60%男生和40%女生。

女生穿裤子的人数和穿裙子的人数相等,所有男生穿裤子。

一个人在远处随机看到了一个穿裤子的学生。

那么这个学生是女生的概率是多少?使用贝叶斯定理,事件A是看到女生,事件B是看到一个穿裤子的学生。

我们所要计算的是P(A|B)。

P(A)是忽略其它因素,看到女生的概率,在这里是40%P(A')是忽略其它因素,看到不是女生(即看到男生)的概率,在这里是60%P(B|A)是女生穿裤子的概率,在这里是50%P(B|A')是男生穿裤子的概率,在这里是100%P(B)是忽略其它因素,学生穿裤子的概率,P(B) = P(B|A)P(A) + P(B|A')P(A'),在这里是0.5×0.4 + 1×0.6 = 0.8.根据贝叶斯定理,我们计算出后验概率P(A|B)先验概率先验概率是指根据以往经验和分析得到的概率,如全概率公式,它往往作为"由因求果"问题中的"因"出现.先验概率的分类利用过去历史资料计算得到的先验概率,称为客观先验概率;当历史资料无从取得或资料不完全时,凭人们的主观经验来判断而得到的先验概率,称为主观先验概率。

先验概率的条件先验概率是通过古典概率模型加以定义的,故又称为古典概率。

古典概率模型要求满足两个条件:(1)试验的所有可能结果是有限的;(2)每一种可能结果出现的可能性(概率)相等。

若所有可能结果的总数为n,随机事件A包括m个可能结果。

编辑本段先验概率与后验概率的区别先验概率不是根据有关自然状态的全部资料测定的,而只是利用现有的材料(主要是历史资料)计算的;后验概率使用了有关自然状态更加全面的资料,既有先验概率资料,也有补充资料;先验概率的计算比较简单,没有使用贝叶斯公式;而后验概率的计算,要使用贝叶斯公式,而且在利用样本资料计算逻辑概率时,还要使用理论概率分布,需要更多的数理统计知识。

《概率》教案设计一、教学目标1. 知识与技能目标:使学生了解不确定事件发生的可能性的大小,并能用分数表示可能性的大小;能按可能性大小判断事件的类型,能根据可能性大小的比较,推断事件的类型;使学生知道游戏的规则公平,各方获胜的可能性相同。

2. 过程与方法目标:通过大量的实例,使学生了解随机事件;通过列举法,使学生理解不确定事件发生的可能性的大小,并能用分数表示可能性的大小;通过游戏,使学生能按可能性大小判断事件的类型,能根据可能性大小的比较,推断事件的类型;通过实例,使学生知道游戏的规则公平,各方获胜的可能性相同。

3. 情感态度与价值观目标:培养学生对数学的兴趣,使他们愿意了解社会生活中与数学相关的信息,主动参与数学学习活动;培养学生合作交流的意识和能力,使他们能够在小组内交流各自的看法,解决问题;培养学生思维的条理性,能比较清楚地表达自己的思考过程与结果;使学生了解数学的价值,提高学习数学的兴趣。

二、教学内容1. 不确定事件发生的可能性。

2. 游戏规则的公平性。

三、教学重点与难点1. 教学重点:使学生了解不确定事件发生的可能性的大小,并能用分数表示可能性的大小;能按可能性大小判断事件的类型,能根据可能性大小的比较,推断事件的类型;使学生知道游戏的规则公平,各方获胜的可能性相同。

2. 教学难点:使学生了解不确定事件发生的可能性的大小,并能用分数表示可能性的大小;能按可能性大小判断事件的类型,能根据可能性大小的比较,推断事件的类型;使学生知道游戏的规则公平,各方获胜的可能性相同。

四、教学过程1. 导入通过提问方式,让学生思考在生活中有哪些事件是确定的,有哪些事件是不确定的。

2. 新课讲解(1)不确定事件发生的可能性通过实例,使学生了解不确定事件,并引导学生用“可能”、“不可能”、“一定”等词语来描述事件发生的可能性。

通过实例,使学生了解不确定事件发生的可能性的大小,并能用分数表示可能性的大小。

通过实例,使学生能按可能性大小判断事件的类型,能根据可能性大小的比较,推断事件的类型。

最大后验估计(MAP)最大后验估计是根据经验数据获得对难以观察的量的点估计。

与最大似然估计类似,但是最大的不同时,最大后验估计的融入了要估计量的先验分布在其中。

故最大后验估计可以看做规则化的最大似然估计。

首先,我们回顾上篇文章中的最大似然估计,假设x为独立同分布的采样,θ为模型参数,f为我们所使用的模型。

那么最大似然估计可以表示为:现在,假设θ的先验分布为g。

通过贝叶斯理论,对于θ的后验分布如下式所示:最后验分布的目标为:注:最大后验估计可以看做贝叶斯估计的一种特定形式。

举例来说:假设有五个袋子,各袋中都有无限量的饼干(樱桃口味或柠檬口味),已知五个袋子中两种口味的比例分别是樱桃 100%樱桃 75% + 柠檬 25%樱桃 50% + 柠檬 50%樱桃 25% + 柠檬 75%柠檬 100%如果只有如上所述条件,那问从同一个袋子中连续拿到2个柠檬饼干,那么这个袋子最有可能是上述五个的哪一个?我们首先采用最大似然估计来解这个问题,写出似然函数。

假设从袋子中能拿出柠檬饼干的概率为p(我们通过这个概率p来确定是从哪个袋子中拿出来的),则似然函数可以写作由于p的取值是一个离散值,即上面描述中的0,25%,50%,75%,1。

我们只需要评估一下这五个值哪个值使得似然函数最大即可,得到为袋子5。

这里便是最大似然估计的结果。

上述最大似然估计有一个问题,就是没有考虑到模型本身的概率分布,下面我们扩展这个饼干的问题。

假设拿到袋子1或5的机率都是0.1,拿到2或4的机率都是0.2,拿到3的机率是0.4,那同样上述问题的答案呢?这个时候就变MAP 了。

我们根据公式写出我们的MAP函数。

根据题意的描述可知,p的取值分别为0,25%,50%,75%,1,g的取值分别为0.1,0.2,0.4,0.2,0.1.分别计算出MAP函数的结果为:0,0.0125,0.125,0.28125,0.1.由上可知,通过MAP估计可得结果是从第四个袋子中取得的最高。

最大后验概率估计⏹标量参数的最大后验概率估计⏹矢量参数的最大后验概率估计1. 标量参数的最大后验概率估计观测数据能使后验PDF 变得更为集中,被估计参量的不确定性减少,后验PDF 的均值、最大值和中位数都可以用作为估计。

ˆarg max((|))map p θθ=θz 定义:(|)()(|)()p p p p θθθ=z z z 由于ˆarg max{(|)()}mapp p θθ=θθz 最大后验概率方程:ˆ(|)|mapp θ=θ∂θ=∂θz 0ˆln (|)|mapp θ=θ∂θ=∂θz 0例1:考虑高斯白噪声中随机变量的估计问题,0,1,...,1i iz A w i N =+=-其中是均值为零、方差为σ2高斯白噪声序列, 。

A 和是统计独立的,求A 的最大后验概率估计。

i w 00~(,)A U A A -A 的后验PDF 为2221()(|)exp 2/()2/A z p A N c N ⎡⎤-=-⎢⎥σπσ⎣⎦z z 02221()()exp 2/2/A A A z c dA N N -⎡⎤-=-⎢⎥σπσ⎣⎦⎰z 0A A <iwA -0A A(|)p A z z 0A -0A A(|)p A z z 0A -0A A(|)p A z z A z A -<<00ˆmapA z A A z A z A A z A -≤-⎧⎪=-<<⎨⎪≥⎩000000z A ≤-0z A ≥02. 矢量参数的最大后验概率估计矢量参数的最大后验概率估计有两种形式:(1) 按标量形式推广而来,...Tp ⎡⎤=θθθ⎣⎦θ12假定12(|)()pp p d d θ=θθ⎰⎰z θ|z ˆarg max((|))p θθ=θz 111更一般的情况是:ˆarg max((|))ii ip θθ=θzˆarg max (|)p =θθθz (2)矢量的最大后验概率估计由于(|)()(|)()p p p p =z θθθz z ˆarg max (|)()p p =θθz θθ所以需要注意的是:对于矢量参数的估计,按照以上两种方式得出的估计有可能不同。

童年第四章精读版批注

摘要:

1.通信最大后验概率准则的定义和原理

2.通信最大后验概率准则在通信系统中的应用

3.通信最大后验概率准则的优缺点分析

正文:

在通信领域,最大后验概率准则(MAP)是一种常用的信号处理方法。

它的原理是根据已知的观测数据,计算出最有可能的某个变量的值。

在这里,我们主要讨论通信最大后验概率准则,也就是在通信系统中如何应用这一准则来提高通信效果。

通信最大后验概率准则的定义和原理相对简单。

通信系统中的信号可以看作是某个随机变量的函数,而我们的目标是估计这个随机变量的某个值。

根据贝叶斯公式,我们可以得到某个值的后验概率,而通信最大后验概率准则要求我们选择具有最大后验概率的值作为估计。

在通信系统中,通信最大后验概率准则可以应用于许多场景,例如信号解调、信道估计、信号检测等。

以信号解调为例,我们知道信号解调的目的是恢复传输中的原始信号。

通过应用通信最大后验概率准则,我们可以在接收到观测数据后,计算出最有可能的原始信号。

这样,我们就可以更准确地恢复传输中的信息。

通信最大后验概率准则具有一定的优点,例如计算简单、易于实现等。

然而,它也存在一些缺点。

首先,通信最大后验概率准则在实际应用中可能会受到噪声的影响,导致估计的值不准确。

其次,在某些情况下,通信最大后验概率准则可能无法得到全局最优解,而只能得到局部最优解。

综上所述,通信最大后验概率准则在通信系统中具有一定的应用价值。

通过计算最大后验概率,我们可以在通信过程中更准确地估计某些变量的值,从而提高通信效果。

[转]最⼤后验概率(MAP)1)最⼤似然估计 MLE给定⼀堆数据,假如我们知道它是从某⼀种分布中随机取出来的,可是我们并不知道这个分布具体的参,即“模型已定,参数未知”。

例如,我们知道这个分布是正态分布,但是不知道均值和⽅差;或者是⼆项分布,但是不知道均值。

最⼤似然估计(MLE,Maximum Likelihood Estimation)就可以⽤来估计模型的参数。

MLE的⽬标是找出⼀组参数,使得模型产⽣出观测数据的概率最⼤:其中就是似然函数,表⽰在参数下出现观测数据的概率。

我们假设每个观测数据是独⽴的,那么有为了求导⽅便,⼀般对⽬标取log。

所以最优化对似然函数等同于最优化对数似然函数:举⼀个抛硬币的简单例⼦。

现在有⼀个正反⾯不是很匀称的硬币,如果正⾯朝上记为H,⽅⾯朝上记为T,抛10次的结果如下:求这个硬币正⾯朝上的概率有多⼤?很显然这个概率是0.2。

现在我们⽤MLE的思想去求解它。

我们知道每次抛硬币都是⼀次⼆项分布,设正⾯朝上的概率是,那么似然函数为:x=1表⽰正⾯朝上,x=0表⽰⽅⾯朝上。

那么有:求导:令导数为0,很容易得到:也就是0.2 。

2)最⼤后验概率 MAP以上MLE求的是找出⼀组能够使似然函数最⼤的参数,即。

现在问题稍微复杂⼀点点,假如这个参数有⼀个先验概率呢?⽐如说,在上⾯抛硬币的例⼦,假如我们的经验告诉我们,硬币⼀般都是匀称的,也就是=0.5的可能性最⼤,=0.2的可能性⽐较⼩,那么参数该怎么估计呢?这就是MAP要考虑的问题。

MAP优化的是⼀个后验概率,即给定了观测值后使概率最⼤:把上式根据贝叶斯公式展开:我们可以看出第⼀项就是似然函数,第⼆项就是参数的先验知识。

取log之后就是:回到刚才的抛硬币例⼦,假设参数有⼀个先验估计,它服从Beta分布,即:⽽每次抛硬币任然服从⼆项分布:那么,⽬标函数的导数为:求导的第⼀项已经在上⾯MLE中给出了,第⼆项为:令导数为0,求解为:其中,表⽰正⾯朝上的次数。