体验vSphere 6之5-添加虚拟交换机及iSCSI存储

- 格式:doc

- 大小:1.23 MB

- 文档页数:12

在通过数台虚拟服务器平台共同使用一个存储池的架构里,企业可以对虚拟环境进行更多的进阶管理,我们将利用DataCore的SANMelody实作软件式的iSCSI环境,扩增存储容量并示范如何连接至虚拟化平台。

在同时拥有多台虚拟平台服务器(例如Citrix XenServer、VMware vSphere、微软Hyper-V)的环境下,存储池(也称之为共享存储服务器)是一项不可或缺的重要组件,通过数台虚拟平台服务器共同使用一座存储池的架构,企业可以针对虚拟环境从事更多的进阶管理,这其中以VMotion这一类的在线动态移转技术最具代表性,在不搬动虚拟机文件的前提下,仅需透过网络将暂存在服务器内存的少量数据搬移到另外一台虚拟平台服务器运作,而不会造成长时间的断线,方便企业维修、升级,或者是排除服务器硬件上的故障。

使用iSCSI做为虚拟平台存储池为了减少后续管理上的不便,大部份企业都是在导入虚拟化技术的初期,将存储池一并建置完毕,然而,在多种能够搭配虚拟化平台运作的方案之中,iSCSI是一种成本较低廉的选择,因此十分受到企业欢迎。

iSCSI有软、硬件2种产品,软件产品的好处在于建置成本较低,可安装在现有的服务器硬件上运作,不一定需要额外购买专用的服务器才能提供服务,至于硬设备的优点则是具备较佳的效能,这次我们这次使用的DataCore SANMelody是属于软件产品,搭配VMware新版的vSphere套件,建立一个iSCSI存储池,放置虚拟机运作所需的文件。

DataCore SANMelody本身是付费软件,我们可以从官网取得30天的试用版本,如果想要长期使用,网络上也有免费的同类型软件可供选择,目前比较具代表性的有StarWind及FreeNAS等2套。

StarWind的免费版本只能建立2GB大小的iSCSI扇区,想要取消这个限制,就必须付费购买更高阶的完整版,至于FreeNAS则没有容量上限,不过套件本身是由FreeBSD 所衍生而来,对于少数不熟悉接口操作的用户来说,可能有应用门坎,不过网络上可供参考的数据很多,可以帮助我们解决设定过程中所碰到的各项问题。

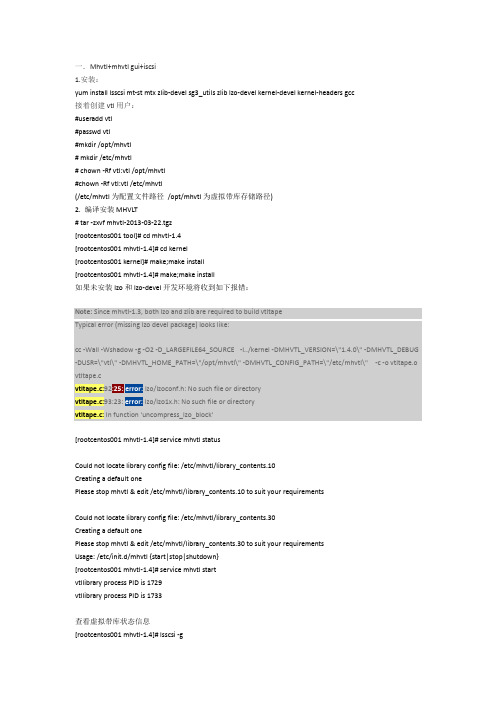

一.Mhvtl+mhvtl gui+iscsi1.安装:yum install lsscsi mt-st mtx zlib-devel sg3_utils zlib lzo-devel kernel-devel kernel-headers gcc接着创建vtl用户:#useradd vtl#passwd vtl#mkdir /opt/mhvtl# mkdir /etc/mhvtl# chown -Rf vtl:vtl /opt/mhvtl#chown -Rf vtl:vtl /etc/mhvtl(/etc/mhvtl为配置文件路径/opt/mhvtl为虚拟带库存储路径)2. 编译安装 MHVLT# tar -zxvf mhvtl-2013-03-22.tgz[rootcentos001 tool]# cd mhvtl-1.4[rootcentos001 mhvtl-1.4]# cd kernel[rootcentos001 kernel]# make;make install[rootcentos001 mhvtl-1.4]# make;make install如果未安装lzo和lzo-devel开发环境将收到如下报错:Note: Since mhvtl-1.3, both lzo and zlib are required to build vtltapeTypical error (missing lzo devel package) looks like:cc -Wall -Wshadow -g -O2 -D_LARGEFILE64_SOURCE -I../kernel -DMHVTL_VERSION=\"1.4.0\" -DMHVTL_DEBUG -DUSR=\"vtl\" -DMHVTL_HOME_PATH=\"/opt/mhvtl\" -DMHVTL_CONFIG_PATH=\"/etc/mhvtl\" -c -o vtltape.o vtltape.cvtltape.c:92 lzo/lzoconf.h: No such file or directoryvtltape.c:93:23: lzo/lzo1x.h: No such file or directoryvtltape.c: In function 'uncompress_lzo_block'[rootcentos001 mhvtl-1.4]# service mhvtl statusCould not locate library config file: /etc/mhvtl/library_contents.10Creating a default onePlease stop mhvtl & edit /etc/mhvtl/library_contents.10 to suit your requirementsCould not locate library config file: /etc/mhvtl/library_contents.30Creating a default onePlease stop mhvtl & edit /etc/mhvtl/library_contents.30 to suit your requirementsUsage: /etc/init.d/mhvtl {start|stop|shutdown}[rootcentos001 mhvtl-1.4]# service mhvtl startvtllibrary process PID is 1729vtllibrary process PID is 1733查看虚拟带库状态信息[rootcentos001 mhvtl-1.4]# lsscsi -g[1:0:0:0] cd/dvd NECVMWar VMware IDE CDR10 1.00 /dev/sr0 /dev/sg0 [2:0:0:0] disk VMware, VMware Virtual S 1.0 /dev/sda /dev/sg1 [3:0:0:0] mediumx STK L700 0104 /dev/sch0 /dev/sg10 [3:0:1:0] tape IBM ULT3580-TD5 0104 /dev/st0 /dev/sg2 [3:0:2:0] tape IBM ULT3580-TD5 0104 /dev/st1 /dev/sg3 [3:0:3:0] tape IBM ULT3580-TD4 0104 /dev/st2 /dev/sg4 [3:0:4:0] tape IBM ULT3580-TD4 0104 /dev/st3 /dev/sg5 [3:0:8:0] mediumx STK L80 0104 /dev/sch1 /dev/sg11 [3:0:9:0] tape STK T10000B 0104 /dev/st4 /dev/sg6 [3:0:10:0] tape STK T10000B 0104 /dev/st5 /dev/sg7 [3:0:11:0] tape STK T10000B 0104 /dev/st6 /dev/sg8 [3:0:12:0] tape STK T10000B 0104 /dev/st7 /dev/sg9 [rootcentos001 mhvtl-1.4]# lsscsi -l[1:0:0:0] cd/dvd NECVMWar VMware IDE CDR10 1.00 /dev/sr0state=running queue_depth=1 scsi_level=6 type=5 device_blocked=0 timeout=30 [2:0:0:0] disk VMware, VMware Virtual S 1.0 /dev/sdastate=running queue_depth=32 scsi_level=3 type=0 device_blocked=0 timeout=30 [3:0:0:0] mediumx STK L700 0104 /dev/sch0state=running queue_depth=32 scsi_level=6 type=8 device_blocked=0 timeout=0 [3:0:1:0] tape IBM ULT3580-TD5 0104 /dev/st0state=running queue_depth=32 scsi_level=6 type=1 device_blocked=0 timeout=900 [3:0:2:0] tape IBM ULT3580-TD5 0104 /dev/st1state=running queue_depth=32 scsi_level=6 type=1 device_blocked=0 timeout=900 [3:0:3:0] tape IBM ULT3580-TD4 0104 /dev/st2state=running queue_depth=32 scsi_level=6 type=1 device_blocked=0 timeout=900 [3:0:4:0] tape IBM ULT3580-TD4 0104 /dev/st3state=running queue_depth=32 scsi_level=6 type=1 device_blocked=0 timeout=900 [3:0:8:0] mediumx STK L80 0104 /dev/sch1state=running queue_depth=32 scsi_level=6 type=8 device_blocked=0 timeout=0 [3:0:9:0] tape STK T10000B 0104 /dev/st4state=running queue_depth=32 scsi_level=0 type=1 device_blocked=0 timeout=900 [3:0:10:0] tape STK T10000B 0104 /dev/st5state=running queue_depth=32 scsi_level=0 type=1 device_blocked=0 timeout=900 [3:0:11:0] tape STK T10000B 0104 /dev/st6state=running queue_depth=32 scsi_level=0 type=1 device_blocked=0 timeout=900 [3:0:12:0] tape STK T10000B 0104 /dev/st7state=running queue_depth=32 scsi_level=0 type=1 device_blocked=0 timeout=900 这里的/dev/sg10和/dev/sg11是机械手。

VMware vSphere 4.1虚拟化学习手册8:配置iSCSI及NFS存储上一篇([VMware vSphere 4.1虚拟化学习手册7:存储基础] )介绍了VMware vSphere存储,这里看看如何配置iscsi及NFS共享存储。

FC SAN的配置和iscsi 配置方法基本一致,这里由于环境限制不做介绍。

测试环境如下:•两台esx Server•一台windows 2008做vCenter•freenas做iscsi服务器iSCSI存储简介:iSCSI 是把SCSI指令集封装在以太网协议中,通过现有的IP网络来传输存储数据;iSCSI存储一般分为服务器端(Target)和客户端连接器(Initiator),其中Initiator可以分为硬件和软件2种,硬件Initiator一般称作iSCSI HBA 卡,因为SCSI指令集的装载通过HBA卡完成,所以硬件Initiator比软件Initiator效率更高,并且可显著降低iSCSI对主机 CPU的使用率;ESX已内置软件Initiator,并且也支持iSCSI HBA卡(具体可参考vSphere硬件兼容性网站)。

这里我们使用的是FreeNAS作为iSCSI服务器的软件iSCSI方式。

VMware vSphere中配置iSCSI需要建立一个单独的存储网络来走存储流量,参考[VMware vSphere 4.1虚拟化学习手册5:虚拟交换机vSwitch]首先添加VMkernel,这个网络是专门用来走iSCSI和NFS存储数据的选择VMkernel使用的vSwitch设置VMkernel使用的名称及是否用作vMotion配置VMkernel的IP地址及网关确认添加VMkernel配置完成配置之后再vSwitch0下多了一个VMkernel的虚拟端口。

接下来添加iscsi存储器开启软件iscsi功能在动态发现中输入iscsi服务器地址,如果只是要加入iscsi服务器中的某块硬盘可以选择静态发现添加成功之后就可以看到新增了一个iscsi software adapter的存储适配器及这块适配器下的两个iscsi硬盘接下来添加存储器,也就是我们存储虚拟机的存储空间选择磁盘/LUN选择可用的iSCSI磁盘显示选择的磁盘状况为数据存储起一个名称选择块大小及容量确认添加添加完成之后再存储数据中就可以看到新增加的iscsi空间了接着在看看如何配置NFS存储关于NFS的介绍可以参考:[Redhat Linux下NFS的配置及操作] 再添加一个存储控制器,选择网络文件系统输入服务器地址,nfs的目录,再给数据存储起个名称确认配置配置完成之后可以在数据存储中看到新增的nfs1在同一个数据中心中,只要一台服务器添加了iscsi共享存储,其他服务器会自动添加这些iscsi共享存储,也就是只需要添加一次就可以了。

体验vSphere 6之4-为VMware ESXi分配iSCSI存储空间5 为VMware ESXi分配iSCSI存储空间返回到Windows Server 2008 R2的主机,打开"iSCSITarget"程序,创建iSCSI目标,并为其分配两个磁盘。

分配目标可以是VMware ESXi的IP地址也可以是MAC地址,要本示例中以ESXi网卡的MAC地址为例。

(1)在"iSCSI目标"中右击选择"创建iSCSI目标",如图5-1所示。

图5-1 创建iSCSI目标(2)设置目标名称为"VMware ESXi6",如图5-2所示。

图5-2 设置目标名称(3)在"iSCSI发起程序标识符"对话框中,单击"高级"按钮,如图5-3所示。

图5-3 高级(4)在"高级标识符"对话框中单击"添加"按钮,如图5-4所示。

图5-4 添加(5)在"添加/编辑标识符"对话框中,在"标识符类型"下拉列表中选择"MAC地址",并在值中添加VMware ESXi服务器网卡的MAC地址,如图5-5所示。

图5-5 MAC地址(6)如果要查看网卡的MAC地址,可以选中每一个网卡,单击"高级"按钮,在弹出的对话框中,显示MAC地址,如图5-6所示。

图5-6 显示MAC地址(7)对于两台ESXi主机、每个主机4个网卡来说,一共8个MAC地址,都要添加到列表中,如图5-7所示。

图5-7 添加网卡的MAC地址(8)添加目标之后,向iSCSI目标中创建虚拟磁盘,如图5-8所示。

图5-8 创建虚拟磁盘(9)将虚拟磁盘保存在D盘一个文件夹,例如VHD-iSCSI文件夹中,如图5-9所示。

图5-9 设置虚拟磁盘保存位置(10)添加的第一个磁盘文件名为esxi6.vhd,如图5-10所示。

SRM 实战之 vSphere 5 iSCSI 存储配置(1)2011-12-23 10:45 Ivan Liao 51CTO 我要评论(0)字号:T | T本章节节选自VMware SRM 5.0安装配置手册,主要为您介绍 iSCSI 存储配置网络(所有站点)。

AD:为iSCSI存储配置网络 (所有站点)在连接到iSCSI或者NFS类型的存储之前,您需要为ESX/ESXi服务器的虚拟交换机添加类型为VMkernel网络端口。

您可以为现有的虚拟交换机添加VMkernel网络端口,或者为iSCSI存储新建独立的虚拟交换机以获得更佳的性能。

第1步:添加VMkernel类型虚拟交换机在清单中选择需要连接iSCSI存储的ESX/ESXi 服务器,然后选择Configuration配置标签页,从配置清单中选择 Networking ,然后点击右上角的Add Networking…链接打开网络配置向导;在连接类型中选择VMkernel,然后电解Next按钮继续;第2步:为虚拟交换机选择上行网络适配器使用独立的网络适配器作为iSCSI存储连接将会获得更佳的性能。

在此文档示例中将使用vmnic1 作为iSCSI存储连接适配器,vmnic0 默认已经被用于虚拟机以及管理控制台连接;给新建的虚拟交换机端口/端口组命名;第3步:为VMkernel配置连接设置输入IP地址,网络掩码以及配置网关,然后完成配置;新增的vSwitch1交换机中命名为VMK-iSCSI的端口用于iSCSI连接,使用ESX/ESXi服务器的第二块物理网卡vmnic1作为上行网络适配器。

请确定此网络适配器在生产中与您iSCSI存储服务器连接在同一物理交换机,并相应修改防火墙设置。

添加以及配置iSCSI软件适配器(所有站点)vSphere 5默认没有配置 iSCSI 软件适配器,您必须手工添加。

第1步:添加 iSCSI 软件适配器在vSphere Client中选择ESX/ESXi服务器,然后选择 Configuration 标签,在配置清单中选择Storage Adapters ,然后点击Add…链接;点击OK按钮确认添加iSCSI软件适配器;vSphere Client提示您需要在添加适配器后进行配置以访问iSCSI目标。

测试2台ESXi部署vSAN实验一、实验环境和介质1.1: 实验环境这里我是使用一台Dell R730物理机来做这次的测试,R730安装ESXi 6.5,然后在这上面虚拟2台ESXi6.5服务器,和一台vCenter 6.5管理服务器,来模拟2台ESXi 配置vSAN。

因为6.0 U1 U2版本可能vSAN功能还有些问题,我这里就直接用6.5的版本了。

Dell R730配置如下:1.2:vSAN原理和用途因为vSAN必须使用3台ESXi主机,那么我们2台ESXi主机怎么配置vSAN呢?这个你就必须了解vSAN的原理和通途。

vSAN全名叫vSphere Virtual Storage Area Network,vSphere 虚拟化局域网存储。

是vSphere 5.5后才开始出来的新功能,而且只能通过Web Client来部署。

是基于服务器端存储的共享分布式对象存储系统,可以用来取代vSphere后端的外置磁盘阵列。

vSAN就是一种分布式存储,其数据保护技术不是采用传统的RAID方式,而是叫分布式RAID。

VSAN在主机之间使用RAID来满足对系统中存储对象的可用性和可靠性的要求,虚拟机存储对象的镜像拷贝数量取决于虚拟机存储策略。

数据的副本都是存储在主机上的,当某台主机失效或宕机,就会出现类似脑裂问题,vSphere为了解决这个问题,引入了一个重要的组件—见证(winess),类似于我们常说的仲裁盘。

由于见证只是一个逻辑组件,不保存数据,占用空间非常小,我们也就可以实现2台ESXi 主机的vSAN集群。

这个见证是一个模板,可以从官网直接下,免费的,安装这个模板,最好从vCenter web client添加,就可以省去2个CPU的许可,用client部署这个模板是看不到见证自带的许可的。

1.4:虚拟机规划1.5:需要准备的介质vCenter6.5:VMware-VIM-all-6.5.0-4602587.isoESXi6.5:VMware-VMvisor-Installer-201701001-4887370.x86_64.iso Winess6.5:VMware-VirtualSAN-Witness-6.5.0-4564106.ova二、配置主机,安装虚拟机,安装vCenter2.1:配置主机因为要开启vSAN功能,虚拟机必须配置2块网卡,1块单独来处理vSAN流量,所以在安装ESXi的主机上最好配置2个交换机,1个交换机放正常的虚拟机的管理,另一个当2台ESXi虚拟机的vSAN网卡的交换机。

vmwarevsphere6.5安装教程(图⽂)vmware vsphere 6.5是vsphere软件的经典版本,也是⼀款业界领先的服务器虚拟化平台,作为基础平台,是任何云计算环境的理想之选,其组件包括vCenter Server,ESXi,vSphere Web Client,vSphere Client和vSphere Host Client,其中VCSA 新功能包括增强的vCenter安装,配置,管理,升级,打补丁等,⽀持命令⾏模板化vCenter Server⽣命周期管理;增强了Auto Deploy能⼒,有更好的弹性,性能以及兼容更多的vSphere功能组件;另外vmware vsphere 6.5版本的VCSA管理界⾯包含了对于嵌⼊式vCenter vPostgres数据库的管理界⾯,⽽存储部分增强了存储I / O控制,⽀持I / O限制,共享和预留,切这些功能可以与Storage Policy-Based Management结合。

增强了NFS 4.1 Client,⽀持更强健的加密算法等等,欢迎免费下载体验。

另外全新的vmware vsphere 6.5为实现业务敏捷性奠定了强⼤,灵活,安全的基础,加快有助于向混合云展的数字化转型进程并推动数字经济取得成功。

它可帮助您跨整个混合云在⼀个通⽤操作环境中运⾏,管理,连接和保护您的应⽤。

借助的vSphere 中,您可以在满⾜⽇益增长的基础架构需求和复杂性的同时,⽀持新的⼯作负载和⽤例。

升级vmware vsphere 6.5⼗⼋理由?1,运⽤vCenter ServerAppliance降低IT作业复杂度重新诠释的VMware vCenter Server Appliance可提供⾼出2到3倍的效能,与规模,原⽣vCenter⾼可⽤性,档案形式的备份与复原,以及整合式vSphere主机管理与修补功能2,虚拟运⽤机层级加密技术降低风险原则导向的的vSphere加密技术可在企业资料中⼼内⼤规模模具保护静态及动态资料安全3,运⽤API推动IT与⾃动化商业灵活性简易的REST API可轻松实现作业⾃动化,资料让中⼼更加灵活御姐现代化0.4,安全运⽤技术开机资料保护中⼼基础架构的安全柯林斯运⽤数位签章验证程式码,保护虚拟化管理程序与访客作业系统免于遭到窜改,进⽽确保只有信任的作业系统软体才能执⾏5,透过,科学⽇志记录功能,取得可供验证的洞⽳见解收集关于使⽤者动作的深⼊见解,这样当安全性威胁或异常状况发⽣时,IT参照团队就能更确切了解使⽤者的操作动态,时间和位置6,运⽤预测式负载平衡技术,发挥充分资料中⼼资源的效益预测式DRS技术运⽤系统使⽤率模式与分析技术,协助充分发挥IT资源效益,同时降低资⾦⽀出7运⾏vSphere Integrated Containers进⾏资源中⼼现代化改造在现有的vSphere环境中,同时执⾏企业容器与虚拟机,⽽不变更⼯具或流程8,透过主动式⾼可⽤性技术,防⽌出现停机时间主动式⾼可⽤性技术能够事先预测硬体故障,并在问题发⽣前先移转⼯作负载9,透过采⽤HTML5技术的现代化使⽤者介⾯简化管理采⽤HTML5技术的全新vSphere Client介⾯回应快速且容易使⽤,⽅便使⽤者管理虚拟资料中⼼0.10%,0.50运⽤主机设定档管理技术提升IT规合性精简御姐柯林斯扩充的中主机设定档管理技术,有助于遵守IT所制订的相关原则与程序。

vSphere环境下iSCSI存储的最佳实践下面罗列的一些关于iSCSI存储系统的最佳实践,有助于我们在使用过程中获得最佳的性能和可用性。

●iSCSI存储系统的性能表现与网络的健康程度和利用率密切相关,为了追求最佳的效果,准备一个独立的网络环境,完全隔离iSCSI数据流是必要的。

●每台ESX server主机只能配置一个软件initiator。

为iSCSI连接配置vSwitch时,可以利用多个物理网络端口形成冗余结构。

如果想正确的配置多路径,还要确保VMkernel接口与vSwithc中的网络端口有正确的绑定关系。

●确保iSCSI vSwitch的网络端口与一个独立的网络交换机连接,以降低网络单点故障所带来的影响。

●vSphere支持存储协议中使用jumbo frames(巨帧),但是jumbo frames的优势只在一些非常特殊的环境中才能发挥出来,比如I / O的尺寸非常大的数据流。

此外,后端的存储系统必须能够处理较大的吞吐量,比如RAID组中磁盘的数量大于等于15个,否则我们将看不到任何效果。

如果I / O尺寸太小或者磁盘数量不够,那么使用jumbo frames的效果会很差,甚至感觉不到任何性能的提升。

在某些环境下,jumbo frames还可能会造成性能的衰减,所以在启用jumbo frames 之前和之后做两次性能测试,比较jumbo frames产生的影响是必要的。

还有一个需要注意的问题是,整个连接环节中,每一个端到端的组件都必须支持并且打开jumbo frames功能,包括物理网络端口和网络交换机、vSwitch(虚拟交换机)、VMkernel端口、以及iSCSI目标端。

其中任何一个环节没有设置jumbo frames,jumbo frames都不会起作用。

●使用最新的Paravirtual SCSI总线控制器(PVSCSI)作为虚拟机的磁盘控制器,可以带来最大的吞吐带宽和性能,超过传统上常用的标准LSI Logic以及BusLogic总线控制器。

试用vSphere 6(四):配置数据中心(添加ESXi 主机、新建数据中心\集群等)2015 年3 月2 日, 下午11:13 —————————————————————————————————————————-一、VMware vSphere 6(RC版)安装配置系列文章:1、试用vSphere 6(一):安装ESXi 6 RC版2、试用vSphere 6(二):使用vSphere Client 6.0管理ESXi主机3、试用vSphere 6(三):安装vCenter 6(独立数据库)之:域控服务器安装与配置4、试用vSphere 6(三):安装vCenter 6(独立数据库)之:数据库服务器安装与配置5、试用vSphere 6(三):安装vCenter 6(独立数据库)之:vCenter安装与配置6、试用vSphere 6(四):配置数据中心(添加ESXi主机、新建数据中心\集群等)7、试用vSphere 6(五):ESXi主机添加iSCSI存储8、试用vSphere 6(六):VCSA(6.0.0.2175370)的安装与配置二、VMware vSphere 6 RC版下载三、整个实验环境如下:数据中心名称:DataCenterESXi集群名称:Cluster域:vsphere6.local业务网网络:192.168.232.0/24,网关:192.168.232.2iSCSI网络:192.168.222.0/24ESXi主机01:192.168.232.100,iSCSI网卡:192.168.222.100,主机名:esxi01ESXi主机02:192.168.232.101,iSCSI网卡:192.168.222.101,主机名:esxi02域控服务器01:192.168.232.201,主机名:dc01域控服务器02:192.168.232.202,主机名:dc02vCenter数据库服务器:192.168.232.203,主机名:vcdbvCenter服务器:192.168.232.204,主机名:vCenteriSCSI服务器:192.168.222.10四、实验拓扑图:—————————————————————————————————————————-完成了vCenter服务器的安装后,可以开始添加ESXi主机以及其它配置的进行,首先在域控服务器中,按照规划将两个ESXi主机的A记录完成添加,两台分别为esxi01和esxi02,如下图完成后,使用vSphere Client管理客户端分别连接两个ESXi主机,进入配置->DNS和路由,再点击属性,如下图按照规划填写相应内容,名称为esxi01,域为vsphere6.local,DNS即为两台域控(232.201和232.202),如下图,另一台也相同配置。

体验vSphere 6之5-添加虚拟交换机及iSCSI存储

7 添加虚拟交换机及iSCSI存储

虚拟机的容错的基础是群集,而要管理与使用群集,需要有"管理网络冗余"、"至少两个共享存储磁盘"。

接来下,为每台ESXi主机的管理网络添加冗余网卡,并为ESXi主机添加网络存储磁盘。

(1)在vSphere Web Client管理界面中,在左侧选中一台主机,在右侧选择"管理→网络

自己虚拟交换机",在列表中选择系统己有的虚拟交换机,单击""按钮,如图7-1所示。

图7-1 管理虚拟交换机

(2)在"分配的适配器"对话框中,当前可以看到有一个网卡,单击"+"按钮,为交换机添加另一个网卡。

(3)在弹出的"将物理适配器添加到交换机"对话框中,从"网络适配器"列表中,选择要添加的网卡,在此选择vmnic1,这是ESXi主机的第2块网卡,在前期的规划中,我们将1、第2网卡用做ESXi的管理网卡。

如果要添加多个网卡,可以按住Shift键选择。

(4)返回到"分配的适配器"对话框,可以看到添加的网卡。

(5)添加之后返回到vSphere Web Client管理控制台,如图7-5所示,可以看到当前的虚拟交换机已经有两个网卡。

图7-5 虚拟交换机

在我们设计实验环境时,为ESXi主机添加了4个网卡,此时可以将剩余的两个网卡添加为虚拟交换机,主要步骤如下。

(1)单击""按钮,添加主机网络,如图7-6所示。

图7-6 添加主机网络

(2)在"选择连接类型"对话框,选择"VMkernel网络适配器",如图7-7所示。

如果新添加的交换机只需要处理虚拟机网卡流量,则可以选择"标准交换机的虚拟机端口组"。

图7-7 选择连接类型

(3)在"选择目标设备"对话框,选择"新建标准交换机"。

(4)在"创建标准交换机"对话框中,单击"+"按钮,将剩余的vmnic2、vmnic3网卡添加到列表中,如图7-9所示。

图7-9 添加网卡

(5)在"端口属性"对话框,在"启用服务"处根据需要选择,一般要选择vMotion流量、Fault Tolerance日志记录、管理流量,如图7-10所示。

图7-10 端口属性

(6)在"IPv4设置"对话框,为新添加VMkernetl设置管理地址,因为该网卡连接的是VMnet1,在前期我们规划VMnet1使用192.168.10.0/24网段,在此我们设置管理地址为

192.168.10.11,如图7-11所示。

图7-11 设置管理地址

(7)在"即将完成"对话框,单击"完成"按钮。

(8)添加之后如图7-13所示。

图7-13 添加标准交换机

(9)同样为要另一个ESXi主机进行相同的操作。

在添加标准交换机之后,为ESXi主机添加"iSCSI软件适配器",并添加iSCSI存储服务器地址,为ESXi添加存储,主要步骤如下。

(1)在左侧选中ESXi主机,在右侧选择"管理→存储器→存储适配器",单击"+"按钮,在弹出的列表中选择"",如图7-14所示。

图7-14 添加新的存储适配器

(2)添加iSCSI软件适配器后,在列表中选中新添加的名为vmhba33的iSCSI软件适配器,在适配器详细信息列表中选择"目标"选项卡,单击"添加"按钮,添加iSCSI服务器,如图

7-15所示。

图7-15 向iSCSI软件适配器中添加服务器

(3)在弹出的"添加发送目标服务器"对话框中,输入iSCSI服务器的IP地址,在此案例中,由于iSCSI服务器配置在Windows Server 2008 R2的主机中,而ESXi Server、vCenter Server 使用的是VMware VMnet8虚拟网卡,所以iSCSI服务器的地址是VMnet8虚拟网卡主机端的IP地址192.168.80.1,如图7-16所示。

图7-16 添加发送目标服务器

(4)另外,由于在本案例中,每台ESXi分配了4个网卡,其中2个网卡属于VMnet8,2

个网卡属于VMnet1,并且为VMnet1添加了管理地址,所以还可以将主机的VMnet1虚拟网卡地址192.168.10.1添加到iSCSI服务器的目标中来,这是添加了iSCSI服务器目标之后的截图,在iSCSI服务器的列表中显示的地址是192.168.80.1及192.168.10.1。

(5)同样为要另一个ESXi主机进行相同的操作。

由于新添加了存储,所以需要重新扫描存储适配器,才能搜索并找到新的存储设备。

扫描并添加新设备的操作如下。

(1)在"管理→存储器→存储适配器"中,单击""按钮,重新扫描主机上的所有存储适配器以发现新添加的存储设备或VMFS卷。

在弹出的"重新扫描存储器"对话框中,选择默认值"扫描新的存储设备"及"扫描新的VMFS卷"。

(2)扫描之后,单击iSCSI适配器,在"目标"、"路径"及"设备"列表中可以看到发现并添加的目标及设备,如图7-19所示。

(3)在"管理→存储器→存储设备"列表中,可以看到新添加的存储设备,名为"MSFT iSCSI DISK",大小分别为1000GB和200GB,如图7-20所示。

图7-20 存储设备

(4)找到存储设备之后,接下来需要将存储设备添加到数据存储中。

在左侧选择ESXi主机,在右侧选择"相关对象→datastores",在此列表中可以将存储设备添加为ESXi可用的数据存储。

为了方便后期的管理,我们需要将ESXi本地存储重新命名,例如将第1台ESXi的本地存储命名为esx01-os,将第2台ESXi的本地存储命名为esx02-os,表示这分别是两台ESXi安装操作系统的存储。

而对于以后添加的共享存储则用另外的命名方式。

右击要重命名的数据存储,在弹出的快捷菜单中选择"重命名",如图7-21所示。

图7-21 重命名

(5)将192.168.80.12的数据存储重命名为esx02-os。

(6)同样操作,在左侧选中另一台ESXi主机,将该主机本地存储重命名为esx01-os。

(7)在重命名数据存储之后,将扫描到的iSCSI磁盘添加到ESXi中,作为ESXi共享数据

存储使用。

单击""按钮,在弹出的"新建数据存储→类型"对话框中选择"VMFS",如图7-24所示。

图7-24 选择存储类型

(8)在"名称和设备选择"对话框中,在"列表中"选择可用的数据存储,当前iSCSI存储列表中有两个存储磁盘,大小分别为200GB和1000GB,在此选择其中一个,并在"数据存储名称"文本框中输入新添加的存储名称,如图7-25所示。

图7-25 存储名称和设备选项

(9)在"分区配置"对话框,选择"使用所有可用分区"。

(10)在"即将完成"对话框,显示了添加的存储的大小、存储类型、存储名称、VMFS版本等信息,如图7-27所示。

图7-27 添加存储完成

(11)同样将剩下的另一个iSCSI磁盘添加到数据存储,命名为data02,而原来添加的第1个数据存储则命名为data01。

(12)在网络中有多台VMware ESXi主机时,只需要在一台主机上,添加一次共享存储即可,对于连接到同一存储服务器的存储磁盘,其他主机会自动添加。

在配置好网卡、添加完共享存储之后,修改HA配置,在“vSphere HA→用于检测信号的数据存储”中,选择“使用指定列表中的数据存储并根据需要自动补充”,在“可用检测信号数据存储”列表中选择新添加的data01及data02。

最后,在左侧选中ESXi主机,在“摘要”选项中,没有警告信息。

而在没有添加数据存储、没有添加冗余网卡时,摘要中会显示“该主机的vSphere HA检测信号数据存储数目为0,少于要求数目2”及“此主机当前没有管理网络冗余”。