kettle日志配置文档

- 格式:docx

- 大小:12.07 KB

- 文档页数:2

1.Kettle简介Kettle是一款国外开源的ETL工具,纯java编写,可以在Window、Linux、Unix上运行,数据抽取高效稳定。

Kettle 中文名称叫水壶,该项目的主程序员MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

Kettle主要由资源库、数据库、作业(job)、转换、步骤五部分组成,资源库是用来存储用户所编写的作业和转换(即kjb文件和ktr文件)一般是在数据库中存储,方便用户的查找和使用。

数据库就是处理数据是需要的数据库。

作业是用来确定一个工程中需要使用的转换和转换的执行顺序。

转换是数据在ktr文件中的具体转换过程,类似于Java的一个方法,而作业就类似于java的一个类,它可以调用各种不同的方法(转换)。

2.Kettle框架搭建(1)下载安装可以从下载最新版的Kettle软件,同时,Kettle 是绿色软件,下载后,解压到任意目录即可。

(2)配置环境变量使用Kettle前提是配置好Java的环境变量,因为Kettle是java编写,需要本地的JVM的运行环境。

配置Java环境变量可参考:/zzq900503/article/details/9770237配置Kettle环境变量步骤:一、在系统的环境变量中添加KETTLE_HOME变量,目录指向kettle的安装目录:D:kettledata-integration(具体以安装路径为准)二、新建系统变量:KETTLE_HOME变量值:D:kettledata-integration(具体以安装路径为准,Kettle的解压路径,直到Kettle.exe所在目录)三、选择PATH添加环境变量:变量名:PATH变量值:%KETTLE_HOME%;(3)Kettle工具的运行在Windows系统下运行,只需要解压kettle文件后,双击data-integration文件夹中的Spoon.bat文件在Linux下运行则双击data-integration文件夹中的Spoon.sh文件3.Kettle的基本概念(1)作业(job)负责将【转换】组织在一起进而完成某一块工作,通常我们需要把一个大的任务分解成几个逻辑上隔离的作业,当这几个作业都完成了,也就说明这项任务完成了。

Kettle操作文档1.Kettle介绍。

(2)2. Kettle下载。

(2)3.使用规范和注意事项。

(3)3.1.配置数据库的全局变量。

(3)3.2.文件命名规范(不要用汉字)。

(3)3.3.文件存放位置。

(3)3.4.配置启动任务文件。

(3)3.5.注意事项。

(4)4. Kettle部署使用。

(4)4.1.启动kettle。

(4)4.2.创建转换文件。

(5)4.2.1.使用标识字段实现新增数据。

(5)4.2.2.使用时间戳实现新增或修改数据。

(11)4.2.3.使用时间比较实现新增或修改数据。

(14)4.2.4.使用对某一数据值比较实现新增或修改数据。

(17)4.3.创建任务文件。

(19)4.4.命令行启动任务。

(20)1.Kettle介绍。

ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于政府部门来说,经常会遇到大数据量的处理,转换,迁移,所以了解并掌握一种etl工具的使用,必不可少。

Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定,提供了图形化界面,使用很方便。

Kettle中有两种脚本文件,transformation和job,transformation 完成针对数据的基础转换,job则完成整个工作流的控制。

2.Kettle下载。

Kettle可以在http://2.2.2.240/bbs/网站下载kettle压缩包,因kettle为绿色软件,解压即可使用。

这个压缩包,公司加了一些功能,跟官网下载的不太一样,建议使用公司论坛上的压缩包。

资料网站:/。

注:解压路径尽量不要有中文。

.kettle:存放kettle的一些环境变量信息,资源库的信息。

jre6:存放java运行库文件(1.6版本)。

launcher:存放启动的文件以及启动的配置信息。

lib:存放kettle的库文件。

Kettle操作文档1.Kettle介绍。

(2)2. Kettle下载。

(2)3.使用规范和注意事项。

(3)3.1.配置数据库的全局变量。

(3)3.2.文件命名规范(不要用汉字)。

(3)3.3.文件存放位置。

(3)3.4.配置启动任务文件。

(3)3.5.注意事项。

(4)4. Kettle部署使用。

(4)4.1.启动kettle。

(4)4.2.创建转换文件。

(5)4.2.1.使用标识字段实现新增数据。

(5)4.2.2.使用时间戳实现新增或修改数据。

(11)4.2.3.使用时间比较实现新增或修改数据。

(14)4.2.4.使用对某一数据值比较实现新增或修改数据。

(17)4.3.创建任务文件。

(19)4.4.命令行启动任务。

(20)1.Kettle介绍。

ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于政府部门来说,经常会遇到大数据量的处理,转换,迁移,所以了解并掌握一种etl工具的使用,必不可少。

Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定,提供了图形化界面,使用很方便。

Kettle中有两种脚本文件,transformation和job,transformation 完成针对数据的基础转换,job则完成整个工作流的控制。

2.Kettle下载。

Kettle可以在http://2.2.2.240/bbs/网站下载kettle压缩包,因kettle为绿色软件,解压即可使用。

这个压缩包,公司加了一些功能,跟官网下载的不太一样,建议使用公司论坛上的压缩包。

资料网站:/。

注:解压路径尽量不要有中文。

.kettle:存放kettle的一些环境变量信息,资源库的信息。

jre6:存放java运行库文件(1.6版本)。

launcher:存放启动的文件以及启动的配置信息。

lib:存放kettle的库文件。

Kettle操作文档1.Kettle介绍。

(2)2. Kettle下载。

(2)3.使用规范和注意事项。

(3)3.1.配置数据库的全局变量。

(3)3.2.文件命名规范(不要用汉字)。

(3)3.3.文件存放位置。

(3)3.4.配置启动任务文件。

(3)3.5.注意事项。

(4)4. Kettle部署使用。

(4)4.1.启动kettle。

(4)4.2.创建转换文件。

(5)4.2.1.使用标识字段实现新增数据。

(5)4.2.2.使用时间戳实现新增或修改数据。

(11)4.2.3.使用时间比较实现新增或修改数据。

(14)4.2.4.使用对某一数据值比较实现新增或修改数据。

(17)4.3.创建任务文件。

(19)4.4.命令行启动任务。

(20)1.Kettle介绍。

ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于政府部门来说,经常会遇到大数据量的处理,转换,迁移,所以了解并掌握一种etl工具的使用,必不可少。

Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定,提供了图形化界面,使用很方便。

Kettle中有两种脚本文件,transformation和job,transformation 完成针对数据的基础转换,job则完成整个工作流的控制。

2.Kettle下载。

Kettle可以在网站下载kettle压缩包,因kettle为绿色软件,解压即可使用。

这个压缩包,公司加了一些功能,跟官网下载的不太一样,建议使用公司论坛上的压缩包。

资料网站:。

注:解压路径尽量不要有中文。

.kettle:存放kettle的一些环境变量信息,资源库的信息。

jre6:存放java运行库文件(1.6版本)。

launcher:存放启动的文件以及启动的配置信息。

lib:存放kettle的库文件。

libext:存放用到的外部库文件。

libswt:存放用到的界面库文件。

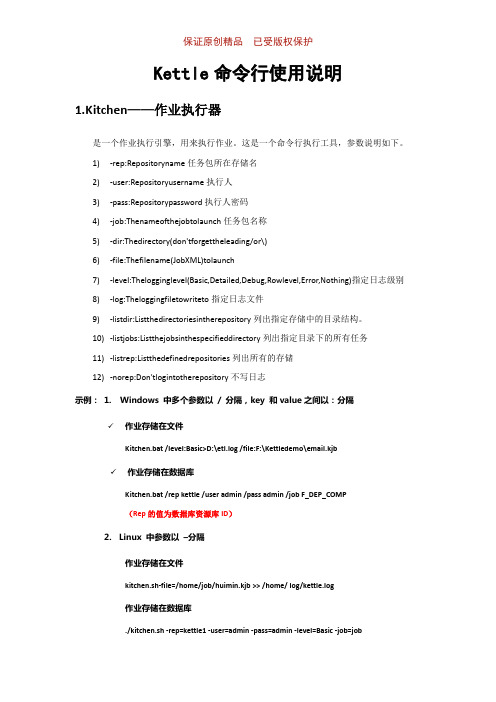

保证原创精品已受版权保护Kettle命令行使用说明1.Kitchen——作业执行器是一个作业执行引擎,用来执行作业。

这是一个命令行执行工具,参数说明如下。

1)-rep:Repositoryname任务包所在存储名2)-user:Repositoryusername执行人3)-pass:Repositorypassword执行人密码4)-job:Thenameofthejobtolaunch任务包名称5)-dir:Thedirectory(don'tforgettheleading/or\)6)-file:Thefilename(JobXML)tolaunch7)-level:Thelogginglevel(Basic,Detailed,Debug,Rowlevel,Error,Nothing)指定日志级别8)-log:Theloggingfiletowriteto指定日志文件9)-listdir:Listthedirectoriesintherepository列出指定存储中的目录结构。

10)-listjobs:Listthejobsinthespecifieddirectory列出指定目录下的所有任务11)-listrep:Listthedefinedrepositories列出所有的存储12)-norep:Don'tlogintotherepository不写日志示例:1. Windows 中多个参数以/ 分隔,key 和value之间以:分隔✓作业存储在文件Kitchen.bat /level:Basic>D:\etl.log /file:F:\Kettledemo\email.kjb✓作业存储在数据库Kitchen.bat /rep kettle /user admin /pass admin /job F_DEP_COMP(Rep的值为数据库资源库ID)2.Linux 中参数以–分隔作业存储在文件kitchen.sh-file=/home/job/huimin.kjb >> /home/ log/kettle.log作业存储在数据库./kitchen.sh -rep=kettle1 -user=admin -pass=admin -level=Basic -job=job。

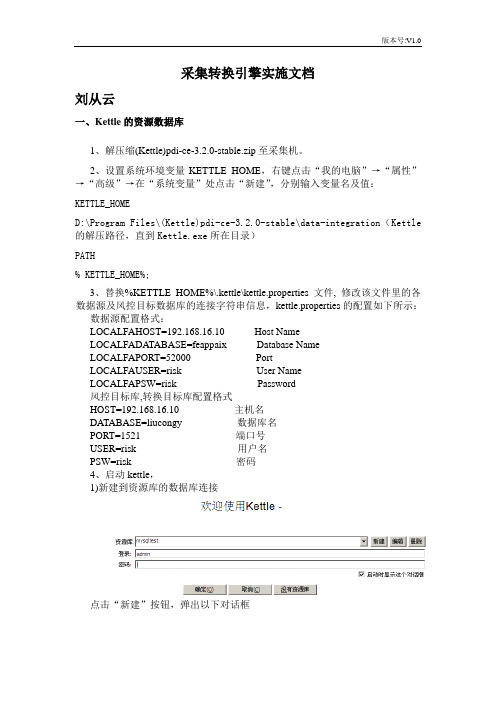

采集转换引擎实施文档刘从云一、Kettle的资源数据库1、解压缩(Kettle)pdi-ce-3.2.0-stable.zip至采集机。

2、设置系统环境变量KETTLE_HOME,右键点击“我的电脑”→“属性”→“高级”→在“系统变量”处点击“新建”,分别输入变量名及值:KETTLE_HOMED:\Program Files\(Kettle)pdi-ce-3.2.0-stable\data-integration(Kettle 的解压路径,直到Kettle.exe所在目录)PATH% KETTLE_HOME%;3、替换%KETTLE_HOME%\.kettle\kettle.properties文件, 修改该文件里的各数据源及风控目标数据库的连接字符串信息,kettle.properties的配置如下所示:数据源配置格式:LOCALFAHOST=192.168.16.10 Host NameLOCALFADA TABASE=feappaix Database NameLOCALFAPORT=52000 PortLOCALFAUSER=risk User NameLOCALFAPSW=risk Password风控目标库,转换目标库配置格式HOST=192.168.16.10 主机名DATABASE=liucongy 数据库名PORT=1521 端口号USER=risk 用户名PSW=risk 密码4、启动kettle,1)新建到资源库的数据库连接点击“新建”按钮,弹出以下对话框这里可以选择本地一个数据库作为资源库,,最初没有资源库,则点击新建按钮,新建一个数据库(做资源库)连接,注意前提是(mysql为例)已存在该数据库。

(\\192.168.16.8\Share\个人杂项目录\lubacui\Database\kettle)目录下有关于mysql,kettle的相关安装文件。

建立到数据库的连接:点击“新建”按钮,选择General 选项,输入mysql数据库连接的相关信息。

Kettle配置使用说明----4ed6e1fa-6ea4-11ec-a27d-7cb59b590d7d1.文件结构1.1kettle4.0.1此文件夹存储Ketter4 0.1桌面应用程序/Ketter4 0.1/spoon。

Bat是用于运行软件的批处理文件。

双击以运行它。

1.2workspace该文件夹以整个警察部队KTR文件和工作文件的文件夹命名。

开始这份工作是一个总的开始大纲。

1.3script此文件夹是存储在其中的数据库创建脚本。

目前,它是Oracle 10g版本1.4model存储的是powerdesign的CDM概念模型文件,用于根据需要生成PDM和脚本。

2.文件路径配置系统使用系统所在路径的相对路径。

无论它在哪个目录中,请将其放入0.1,工作区文件夹也放在同一目录中。

当然,您可以随意更改文件夹的名称。

3.运行环境配置先运行一次/壶4 0.1/勺。

蝙蝠,不是Linux。

如果你使用windows,你可以使用/${userhome}/I在Ketter下找到一个。

Ketter的文件夹主要包括以下内容:response.xml-记录资源库信息(自己去勾)水壶财产——这是件好事。

您可以在任何可以在软件中使用环境变量的地方使用配置信息(键值对配置),类似于全局变量。

当然是有利有弊,配置点什么数据库连接和一些常用的东西之外别把那里当仓库,想下全更多的局部变量会给系统带来什么风险。

a_fileinput=file:///e:/test_server/srcfile/a_fileoutput=file:///e:/test_server /errfile/这两个属性是用于配置读取excel文件并输出错误excel文件的路径配置。

由于文件名和存储位置不同,用户需要自行配置。

存在修改系统中文件路径的风险。

当然,这是无法避免的。

它只能在项目的早期阶段与用户建立。

3.1数据库您可以运行SQL脚本来创建自己的表空间和数据表,也可以连接到我的数据库进行测试。

本文部分内容来自网络整理,本司不为其真实性负责,如有异议或侵权请及时联系,本司将立即删除!== 本文为word格式,下载后可方便编辑和修改! ==kettle日志篇一:Kettle5.x使用步骤带案例超详细版Kettle使用方法介绍1、Kettle概念Kettle是一款国外开源的ETL工具,纯java编写,可以在Window、Linux、Unix上运行,绿色无需安装,数据抽取高效稳定。

Kettle 中文名称叫水壶,该项目的主程序员MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

Kettle这个ETL工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

2、下载和部署下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可3、Kettle环境配置1.安装JDK(略)2.测试JDK安装成功(略)3.运行KettleWindows下找到$KETTLE_HOME/spoon.dat,双击运行欢迎界面如下图所示:4、KETTLE组件介绍与使用4.1 Kettle使用Kettle提供了资源库的方式来整合所有的工作,;1)创建一个新的transformation,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为Trans,kettle默认transformation文件保存后后缀名为ktr;2)创建一个新的job,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为Job,kettle默认job文件保存后后缀名为kjb;4.2 组件树介绍4.2.1Transformation 的主对象树和核心对象分别如下图:Transformation中的节点介绍如下:Main Tree:菜单列出的是一个transformation中基本的属性,可以通过各个节点来查看。

kettle 运行参数Kettle运行参数Kettle是一款强大的开源ETL(Extract-Transform-Load)工具,用于数据集成和数据处理。

在使用Kettle进行数据处理时,我们可以根据需求来配置不同的运行参数,以达到最佳的运行效果。

本文将介绍一些常用的Kettle运行参数,并详细解释它们的作用和用法。

1. 日志级别(LogLevel)日志级别参数用于控制Kettle在运行过程中输出的日志信息的详细程度。

常用的日志级别包括:Basic、Detailed、Debug、Minimal 和Rowlevel。

设置为Basic时,只会输出最基本的运行信息;设置为Detailed时,会输出详细的运行信息;设置为Debug时,会输出更为详细的调试信息;设置为Minimal时,会输出更少的运行信息;设置为Rowlevel时,会输出每一行数据的详细运行信息。

根据实际需求,可灵活选择合适的日志级别参数来监控和调试Kettle 的运行过程。

2. 缓冲区大小(Buffer Size)缓冲区大小参数用于控制Kettle在处理数据时的内存使用情况。

当处理大量数据时,为了避免内存溢出的问题,可以适当增大缓冲区大小,以提高处理效率。

反之,当处理的数据量较小时,可以适当减小缓冲区大小,以节省内存资源。

3. 并行度(Parallelism)并行度参数用于控制Kettle在处理数据时的并行程度。

通过设置并行度参数,可以让Kettle同时处理多个数据流,以提高数据处理的速度。

并行度参数的取值范围通常为1到10之间,具体取值应根据系统的硬件配置和数据量大小来决定。

4. 数据库连接参数(Database Connection)数据库连接参数用于指定Kettle与数据库的连接信息。

在使用Kettle进行数据处理时,需要连接到数据库来读取或写入数据。

数据库连接参数通常包括数据库类型、主机名、端口号、数据库名称、用户名和密码等信息。

Kettle使用方法说明文档安装程序解压pdi-ce-4.0.0-stable.zip到任意盘符,解压后点击根目录下Spoon.bat如下图所示。

点击cancel创建表到表直接抽取本实例演示的是在Oracle数据库zhwater下的zh用户里面表sys_user转换到本地Oracle数据库orcl下的zw用户下的表sys_user。

演示过程是建立transform将数据从zh.sys_user抽取到zw. sys_user 里面。

两个表结构相同。

建立转换进入系统后如下图所示,双击转换。

创建源和目标数据库连接点开【输入】——>【表输入】将表输入拉到右侧。

双击右侧的表输入,如下图,配置点开【输出】——>【插入/更新】将其拉到右侧。

按住shift先后左键点击表输入和插入/更新的图标。

双击插入/更新图标,点击【获取字段】和【获取和更新字段】用来查询的关键字保留主键USERID,其余删掉。

点击确定保存,点击上方验证无错误后,点击执行,如下图。

数据库中可以看到数据已从zh.sys_user抽取到zw.sys_user定时抽取设置建立job点击【文件】→【新建】→【作业】,如下图将【STRAT】拉入图中。

将【Transformation】拉入到图中,按住shift连接。

点开【Transformation】,将test转换加进去,并重命名job为test。

设置定时抽取双击【START】,设定自动抽取时间。

下图中显示为间隔5分钟自动执行抽取。

点击执行,如下图。

然后进行下一次执行等待。

如下图。

命令行执行编写test.bat内容如下E:\kettle\data-integration\Kitchen.bat /norep /file E:\kettle\test.kjb其中红色部分为安装路径下Kitchen.bat文件所在位置,蓝色部分为job 文件所在位置。

注意:/norep和/file前面都有一个空格。

<!DOCTYPE log4j:configuration SYSTEM "log4j.dtd">

<log4j:configuration xmlns:log4j='/log4j/'>

<appender name="console" class="org.apache.log4j.ConsoleAppender">

<param name="Target" value="System.out"/>

<layout class="org.apache.log4j.PatternLayout">

<param name="ConversionPattern" value="%d{yyyy-MM-dd HH:mm:ss.SSS} %-5p %c{1}:%L - %m%n" />

</layout>

</appender>

<appender name="activexAppender" class="org.apache.log4j.DailyRollingFileAppender">

<param name="File" value="logs/kettle.log" />

<param name="DatePattern" value="yyyy-MM-dd" />

<layout class="org.apache.log4j.PatternLayout">

<param name="ConversionPattern" value="[%d{MMdd HH:mm:ss SSS\} %-5p] [%t] %c{3\} - %m%n" />

</layout>

</appender>

<logger name="org.pentaho.di">

<level value="on"/>

<appender-ref ref="activexAppender" />

</logger>

<root>

<priority value ="off"></priority>

<appender-ref ref="console"></appender-ref> </root>

</log4j:configuration>。