一特征值与特征向量

- 格式:ppt

- 大小:710.52 KB

- 文档页数:28

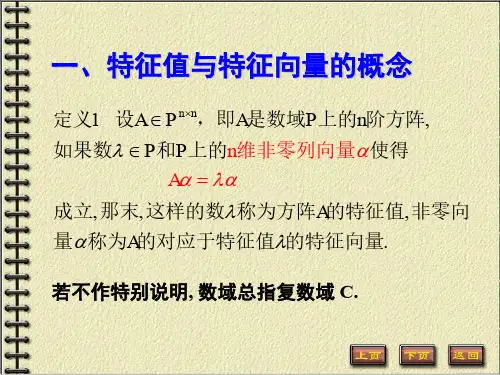

一特征值与特征向量的概念

特征值和特征向量是矩阵分析中非常重要的概念,它们是一种表示矩阵变换特性的方法。

特征值是指矩阵能量的极值,而特征向量则是指矩阵的解决方案。

特征值是一个实数,用来描述矩阵变换的行为。

对于方阵,特征值就是矩阵的特征根。

所有特征值都是矩阵A的根。

特征值定义了矩阵变换的属性,可以用来描述矩阵的秩和特征。

特征向量是矩阵分析的另一个重要概念,它是可以满足特征值方程的向量。

如果矩阵A的特征值是λ,那么特征向量就是向量x使A*x=λ*x 成立的向量x。

特征向量提供了实际的解决方案,可以用来求解矩阵上的最小值。

特征值和特征向量也常用于图像处理、信号处理等领域。

图像处理中特征值和特征向量可以用来识别对象,提取特征,从而更好地分析图像。

例如,在图像检索中,可以使用特征值和特征向量来提取有用的特征,然后将图像分解成不同的基础元素,并使用这些基础元素来识别目标对象。

特征值和特征向量还有助于改善信号处理中的信号品质。

特征值和特征向量可以用来分析信号的频率谱,以便更好地识别噪声和其他干扰。

另外,特征值和特征向量也用于凸优化问题的求解。

[1. 特征的数学意义]我们先考察一种线性变化,例如x,y坐标系的椭圆方程可以写为x^2/a^2+y^2/b^2=1,那么坐标系关于原点做旋转以后,椭圆方程就要发生变换。

我们可以把原坐标系的(x,y)乘以一个矩阵,得到一个新的(x',y')的表示形式,写为算子的形式就是(x,y)*M=(x',y')。

这里的矩阵M代表一种线性变换:拉伸,平移,旋转。

那么,有没有什么样的线性变换b(b是一个向量),使得变换后的结果,看起来和让(x,y)*b像是一个数b乘以了一个数字m*b? 换句话说,有没有这样的矢量b,使得矩阵A*b这样的线性变换相当于A在矢量b上面的投影m*b? 如果有,那么b就是A的一个特征向量,m 就是对应的一个特征值。

一个矩阵的特征向量可以有很多个。

特征值可以用特征方程求出,特征向量可以有特征值对应的方程组通解求出,反过来也一样。

例如,设A为3阶实对称矩阵,a1=(a,-a,1)T是Ax=0的解,a2=(a,1,-a)T是(A+E)x=0的解,a≠2,则常数a=? 因为a1=(a,-a,1)T是Ax=0的解,说明a1=(a,-a,1)T是A的属于0的特征向量,a2=(a,1,-a)T是(A+E)x=0的解,说明a2=(a,1,-a)T是A的属于-1的特征向量。

实对称矩阵属于不同特征值的特征向量式正交的,所以a^2-a-a=0,a≠2,所以a=0。

还是太抽象了,具体的说,求特征向量的关系,就是把矩阵A所代表的空间,进行正交分解,使得A的向量集合可以表示为每个向量a在各个特征向量上面的投影长度。

例如A是m*n的矩阵,n>m,那么特征向量就是m个(因为秩最大是m),n个行向量在每个特征向量E上面有投影,其特征值v就是权重。

那么每个行向量现在就可以写为Vn=(E1*v1n,E2*v2n...Em*vmn),矩阵变成了方阵。

如果矩阵的秩更小,矩阵的存储还可以压缩。

特征值与特征向量的求法总结特征值与特征向量是线性代数中的重要概念,广泛应用于各个领域的数学和工程问题中。

在本文中,我们将总结特征值与特征向量的求法,并介绍它们的应用。

一、特征值与特征向量的定义在矩阵理论中,给定一个n阶方阵A,如果存在一个非零向量x,使得Ax与x的线性关系为Ax=λx,其中λ为常数,则称λ为矩阵A的特征值,x为对应于特征值λ的特征向量。

二、特征值与特征向量的求法要求解矩阵A的特征值和特征向量,需要解决以下问题:1. 求解特征值:设特征值为λ,需要解决方程|A-λI|=0,其中I为单位矩阵。

这个方程称为特征方程,其解即为矩阵A的特征值。

2. 求解特征向量:已知特征值λ后,需要求解方程(A-λI)x=0的非零解,其中x为特征向量。

这个方程组称为特征方程组,其解即为矩阵A的特征向量。

特征值和特征向量的求解可以通过以下步骤进行:1. 求解特征值:解特征方程|A-λI|=0,得到特征值λ1, λ2, ..., λn。

2. 求解特征向量:将每个特征值代入方程组(A-λI)x=0,解得对应的特征向量x1, x2, ..., xn。

三、特征值与特征向量的应用特征值与特征向量在许多领域中都有重要的应用,下面我们介绍几个常见的应用场景:1. 特征值分解:特征值分解是将一个矩阵分解为特征值和特征向量的乘积的形式,常用于矩阵的对角化和求解矩阵的幂等问题。

2. 主成分分析:主成分分析是一种常用的数据降维技术,通过计算协方差矩阵的特征值和特征向量,将原始数据转换为新的特征空间,以实现数据的降维和特征提取。

3. 图像处理:特征值与特征向量在图像处理中有着广泛的应用,如图像压缩、图像去噪、图像特征提取等。

4. 控制系统分析:在控制系统中,特征值与特征向量可以用于分析系统的稳定性和响应特性,如振荡频率、阻尼比等。

5. 网络分析:特征值与特征向量在网络分析中有着重要的作用,例如用于社交网络中节点的中心性分析、网络的连通性分析等。

特征值与特征向量特征值与特征向量是线性代数中重要的概念,它们在矩阵理论和多个领域中都有广泛的应用。

特征值与特征向量的理解对于深入理解线性代数的基础及其应用具有重要的意义。

本文将简要介绍特征值与特征向量的概念、性质及其应用,并通过示例加深理解。

1. 概念特征值和特征向量是矩阵理论中一个重要的概念。

对于一个n阶矩阵A,如果存在一个非零向量x,使得Ax=kx,其中k为一个常数,那么k称为矩阵A的特征值,x称为对应于特征值k的特征向量。

特征值与特征向量总是成对出现的,一个特征向量对应一个特征值。

2. 性质(1)特征值是矩阵的本征性质,是一个与矩阵本身相关的特征。

(2)特征向量是矩阵A的一个零空间的非零向量,表示在矩阵A 的作用下,该向量只发生一个伸缩变换,方向不变。

(3)特征值和特征向量存在一定的关系,特征值为k的特征向量与特征值为-1/k的特征向量互为相反数。

(4)特征值的个数等于矩阵的秩,特征向量的个数与矩阵的阶数相同。

3. 应用特征值与特征向量在多个学科领域具有广泛的应用,以下列举几个常见的应用案例:(1)数据降维:在机器学习和数据挖掘中,通过对数据矩阵的特征值分解,可以实现数据的降维处理,减少冗余信息,提高计算效率。

(2)图像处理:图像处理中常常利用矩阵的特征值与特征向量进行图像的压缩、滤波、边缘检测等操作。

例如,利用特征值分解进行图像去噪处理。

(3)网络分析:在网络分析中,可以利用特征值与特征向量来研究网络结构的特征,如网络的连通性、中心性等。

(4)量子力学:量子力学中的波函数也可以通过特征值和特征向量的计算得到,从而得到物理系统的某些性质。

通过以上示例,我们可以看到特征值与特征向量在多个领域中的重要性。

对于线性代数的学习,深入理解特征值与特征向量的概念、性质及其应用,对于进一步的学术研究和应用都具有重要的意义。

总结:特征值与特征向量是矩阵理论中重要的概念,它们在多个学科领域中有广泛的应用。

特征值是矩阵的本征性质,特征向量表示在矩阵作用下只发生一个伸缩变换。

特征值和特征向量首先,我们先来了解一下矩阵。

矩阵是由一个矩形的数组组成的,其中的每个元素都可以是实数或复数。

例如,3x3的矩阵可以写为:A=[abc][def][ghi]Av=λv那么v就是矩阵A的特征向量,λ就是矩阵A的特征值。

换句话说,特征向量在矩阵的变换下只发生拉伸或缩放,而不发生旋转或扭曲。

特征值表示特征向量被拉伸或缩放的比例。

det(A - λI) = 0其中,det表示矩阵的行列式,I是单位矩阵。

通过解特征方程,我们可以求得特征值λ。

然后,我们可以将每个特征值代入原方程Av =λv中,从而求得对应的特征向量v。

1.矩阵的对角化:特征值和特征向量可以帮助我们将一个复杂的矩阵对角化,即将矩阵表示为对角矩阵的形式。

对角化后的矩阵更容易进行计算和分析,也更便于推导矩阵的性质。

2.矩阵的相似性:如果一个方阵A和B有相同的特征值和特征向量,那么A和B是相似的。

相似的矩阵在一些数学和物理问题中具有相同的性质和行为,因此,通过特征值和特征向量可以判断矩阵的相似性。

3.矩阵的主成分分析(PCA):主成分分析是一种常用的数据降维方法,它可以通过计算矩阵的特征值和特征向量,将高维数据降低到低维空间中。

通过PCA,我们可以找到数据中最重要的特征和主要方向,从而减少冗余信息。

4.矩阵的奇异值分解(SVD):奇异值分解是矩阵分解的一种重要方法,它可以将一个任意形状的矩阵表示为三个矩阵的乘积。

在奇异值分解中,矩阵的特征值和特征向量扮演了重要的角色。

5.线性变换和矩阵的谱:特征值和特征向量可以帮助我们理解和描述线性变换和矩阵的谱。

谱是矩阵A的特征值的集合,它可以提供关于矩阵的一些性质信息,比如矩阵的正定性、对称性、收敛性等。

总结起来,特征值和特征向量是矩阵理论中非常重要的概念。

它们可以帮助我们理解和描述矩阵的性质和变换,以及在许多实际问题中的应用。

特征值和特征向量的计算和应用对于数学、物理、工程和计算机科学等领域都有重要意义。

特征值与特征向量的求解特征值和特征向量是线性代数中一对重要的概念,广泛应用于物理学、工程学和计算机科学等领域。

在本篇文章中,我们将深入探讨特征值和特征向量的定义、性质以及求解方法。

一、特征值与特征向量的定义在介绍特征值与特征向量的求解方法之前,我们先来了解它们的定义。

在一个n维向量空间V中,若存在一个n阶方阵A和一个非零向量X,使得下式成立:AX = λX其中,λ为标量,称为矩阵A的特征值;X为矩阵A的特征向量。

特征值与特征向量的求解方法有多种,下面将介绍其中两种常用的方法。

二、特征值与特征向量的求解方法1. 特征方程法特征方程法是求解特征值和特征向量的一种常用方法。

假设A是一个n阶方阵,我们的目标是求解它的特征值和特征向量。

首先,我们将上述特征方程AX = λX两边同时左乘一个单位矩阵I,得到:(A-λI)X = 0其中,I为n阶单位矩阵,0为n维零向量。

由于X为非零向量,所以矩阵(A-λI)必须是奇异矩阵,即其行列式为0:|A-λI| = 0这就是特征方程。

接下来,我们需要求解特征方程|A-λI| = 0的根λ,即矩阵A的特征值。

求解得到的特征值λ可以有重根。

然后,将每个特征值λ带入原特征方程(A-λI)X = 0,解得对应的特征向量X。

注意,对于每个不同的特征值,我们都可以对应多个特征向量。

通过特征方程法,我们可以求解出矩阵A的所有特征值和对应的特征向量。

2. 幂法幂法是求解矩阵特征值和特征向量的一种迭代方法,适用于大规模稀疏矩阵。

幂法的基本思想是:通过迭代将初始向量不断与矩阵A进行乘法运算,使得向量的模不断增大,趋向于对应最大特征值的特征向量。

具体做法是:1) 先选择一个非零向量X0作为初始向量。

2) 迭代计算X(k+1) = AX(k),其中k表示迭代次数。

3) 归一化向量X(k+1),即X(k+1) = X(k+1) / ||X(k+1)||,其中||X(k+1)||表示向量X(k+1)的模。

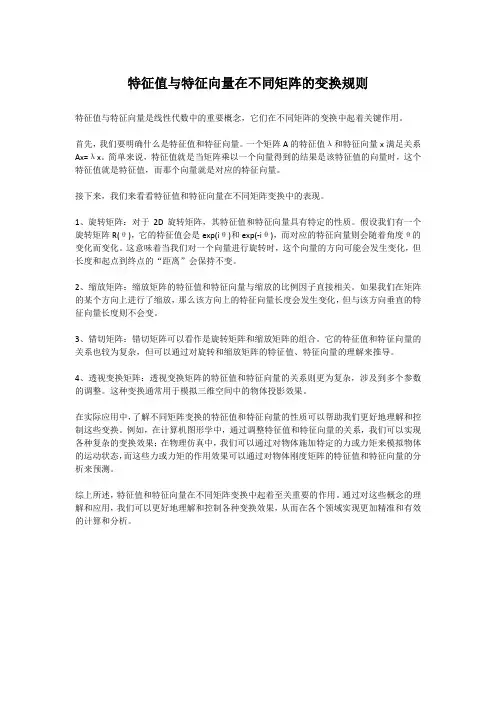

特征值与特征向量在不同矩阵的变换规则特征值与特征向量是线性代数中的重要概念,它们在不同矩阵的变换中起着关键作用。

首先,我们要明确什么是特征值和特征向量。

一个矩阵A的特征值λ和特征向量x满足关系Ax=λx。

简单来说,特征值就是当矩阵乘以一个向量得到的结果是该特征值的向量时,这个特征值就是特征值,而那个向量就是对应的特征向量。

接下来,我们来看看特征值和特征向量在不同矩阵变换中的表现。

1、旋转矩阵:对于2D旋转矩阵,其特征值和特征向量具有特定的性质。

假设我们有一个旋转矩阵R(θ),它的特征值会是exp(iθ)和exp(-iθ),而对应的特征向量则会随着角度θ的变化而变化。

这意味着当我们对一个向量进行旋转时,这个向量的方向可能会发生变化,但长度和起点到终点的“距离”会保持不变。

2、缩放矩阵:缩放矩阵的特征值和特征向量与缩放的比例因子直接相关。

如果我们在矩阵的某个方向上进行了缩放,那么该方向上的特征向量长度会发生变化,但与该方向垂直的特征向量长度则不会变。

3、错切矩阵:错切矩阵可以看作是旋转矩阵和缩放矩阵的组合。

它的特征值和特征向量的关系也较为复杂,但可以通过对旋转和缩放矩阵的特征值、特征向量的理解来推导。

4、透视变换矩阵:透视变换矩阵的特征值和特征向量的关系则更为复杂,涉及到多个参数的调整。

这种变换通常用于模拟三维空间中的物体投影效果。

在实际应用中,了解不同矩阵变换的特征值和特征向量的性质可以帮助我们更好地理解和控制这些变换。

例如,在计算机图形学中,通过调整特征值和特征向量的关系,我们可以实现各种复杂的变换效果;在物理仿真中,我们可以通过对物体施加特定的力或力矩来模拟物体的运动状态,而这些力或力矩的作用效果可以通过对物体刚度矩阵的特征值和特征向量的分析来预测。

综上所述,特征值和特征向量在不同矩阵变换中起着至关重要的作用。

通过对这些概念的理解和应用,我们可以更好地理解和控制各种变换效果,从而在各个领域实现更加精准和有效的计算和分析。

特征值与特征向量的几何意义特征值(eigenvalue)是一个线性变换对应的方程的根。

在二维平面内,我们可以将线性变换看作是对向量的旋转和缩放。

特征值代表了旋转和缩放的程度,而特征向量表示了在这个变换下不变的方向。

假设有一个线性变换A,对应方程A*v=λ*v,其中A是一个n×n的矩阵,v是一个n维的非零向量,λ是一个标量。

v是A的特征向量,λ是v在变换A下的特征值。

这个方程可以进一步写作(A-λI)*v=0,其中I是单位矩阵。

这意味着矩阵(A-λI)对向量v的作用是将其压缩到零向量。

特征向量是在这个变换下保持不变的向量。

特征向量的几何意义是,线性变换A对应的特征向量沿着自己的方向不发生变化,只发生了长度的缩放。

特征值表示了特征向量的缩放比例。

当λ为正数时,特征向量的长度被放大;当λ为负数时,特征向量的长度被缩小;当λ为零时,特征向量的长度不变。

特征向量与特征值之间的关系可以通过线性代数的性质进行证明。

在几何意义上,特征值和特征向量可以帮助我们理解几何变换的变化情况。

例如,在二维平面上,一个线性变换可以将一个平行于特征向量的直线映射为平行于其对应特征向量的直线,并根据对应特征值的大小调整线段的长度。

如果特征值为正数,线段长度增加;如果特征值为负数,线段长度减小;如果特征值为零,则线段长度不变。

这是线性变换作用于特征向量的几何意义。

特征值和特征向量的重要性在于它们提供了一种将复杂的线性变换简化为对角形式(在特定坐标系下)的方法。

对角化是一种将矩阵的形式变为对角矩阵的过程,对角矩阵包含了特征值作为对角元素。

这种变换可以将线性变换的复杂度降低,使得计算和理解更加简单。

特征向量提供了一个由线性变换所定义的特定的坐标系,而特征值则提供了在这个坐标系下压缩或扩大每个坐标轴的尺度。

总结来说,特征值和特征向量的几何意义是用来描述线性变换对向量的旋转和缩放程度的。

特征向量是在这个变换下保持方向不变的向量,特征值则表示了特征向量的缩放比例。

特征值特征向量的判定概述特征值和特征向量是矩阵理论中的重要概念,被广泛应用于线性代数、物理学、工程学等领域。

特征值特征向量的判定是指确定一个矩阵的特征值和特征向量的过程。

在本文中,我们将深入探讨特征值特征向量的判定方法及其应用。

特征值和特征向量的定义在矩阵理论中,对于一个n×n的矩阵A,如果存在一个非零向量x,使得Ax=kx,其中k是一个常数,那么称k为矩阵A的特征值,x称为矩阵A对应于特征值k的特征向量。

特征值特征向量的判定方法1. 特征值的计算特征值的计算是特征值特征向量判定的第一步。

对于一个n×n的矩阵A,特征值的计算可以通过求解矩阵A的特征方程det(A-kI)=0来实现,其中I是单位矩阵,k是一个待定的常数。

解特征方程可以得到n个特征值。

2. 特征向量的计算一旦特征值被计算出来,接下来就是计算对应于每个特征值的特征向量。

对于矩阵A和特征值k,特征向量可以通过求解方程组(A-kI)x=0来得到。

方程组的解就是特征向量。

3. 判定特征值特征向量的条件特征值特征向量的判定需要满足一定的条件。

对于一个给定的特征值k和特征向量x,Ax=kx。

根据这个等式,我们可以推导出判断特征向量的条件:如果存在一个非零向量x,使得Ax=kx成立,那么矩阵A的特征值为k,特征向量为x。

特征值特征向量的应用特征值特征向量在许多领域中都有广泛的应用。

1. 线性代数在线性代数中,特征值特征向量的理论是非常重要的。

通过求解特征值和特征向量,我们可以得到矩阵的对角化形式,简化了矩阵的计算。

特征值特征向量还可以用于解决线性方程组、矩阵的相似性等问题。

2. 物理学在量子力学中,特征值特征向量被广泛应用于描述量子系统的态。

特征向量表示了系统的基本状态,特征值则表示这些状态所具有的能量。

3. 工程学在工程学中,特征值特征向量被用于振动分析和控制系统分析。

通过计算系统的特征值和特征向量,可以评估系统的稳定性、阻尼性能等。

已知一个特征值,求解特征向量的方法

求解特征向量是机器学习中一种重要的应用,从表达数据信息的角度出发,重

要的特征向量可以简化数据之间的复杂关系,从而帮助用户更好地理解相关的资料,适应世界的变化。

那么当我们已经知道一个特征值时,如何求解该特征向量呢?

首先,需要明确要解决的问题:获得序列中特征值对应的特征向量。

根据求解

特征向量的基本原理,就是需要定义一组特征向量Ψ(Ψ1,Ψ2,……,Ψm),

使得特征值符合如下的关系式:λ=Ψ*A*Ψ,其中,A是特征值与特征向量的关系表,λ表示已知的特征值,而Ψ表示未知的特征向量。

因此,可以先采用特定的算法,将λ代入到上述的表达式中,并采用变分原

理求得Ψ的取值。

由于A的未知参数十分多,因此需要进行线性组合,定义出一

个适合这一组特征向量的特殊表达式,在此基础上,通过构造合适的优化函数,进而利用梯度下降法或共轭梯度下降法,求解出满足Ψ*A*Ψ=λ的最佳特征向量。

求解特征向量可以显著提升机器学习中模型的准确性与泛化能力,这也是工程

实践中常用的一种技术。

不仅能够精准定位已有的特征,而且可以在机器学习的过程中发现新的特征,进一步提升模型的准确度。