视觉伺服控制

- 格式:docx

- 大小:932.09 KB

- 文档页数:24

基于图像的机器人视觉伺服系统基于图像的机器人视觉伺服系统对工作在未知环境中的机器人,在其位置控制和运动控制中引入视觉反馈信息是一种很有吸引力的解决方案。

利用视觉传感器得到的图像作为反馈信息,构造机器人的位置和运动闭环控制,即视觉伺服[1]。

本文主要研究手部摄像机视觉机器人的控制问题,采用基于图像的直接视觉伺服。

它的控制算法不需要求解逆像问题以及机器人运动学,同时它的结构不依赖于机器人惯量以及科里奥利矩阵。

机器人视觉伺服系统的物理结构机器人视觉伺服系统的结构可分为摄像机固定和手部摄像机两种。

在摄像机位置固定的机器人系统中,有多个摄像机安装在机器人周围的环境中,可同时获得机器人和周围环境的图像,这种方法的目标是控制机器人末端执行器的运动直至触碰到期望目标。

而手部摄像机机器人的摄像机安装在机器人手部,只能获取机器人周围环境的信息,这种方法的目标是控制机器人的运动,使运动或静止的目标在摄像机图像平面上到达期望位置。

摄像机固定的安装方式可获得固定的图像分辨率,并同时获得机器人和机器人周围环境的信息,便于将视觉系统集成到控制中。

但在机器人运动过程中,可能发生图像特征遮盖现象,观察灵活性差。

而手部摄像机方式具有较大的工作范围,不存在图像特征遮盖问题。

同时,随着手爪接近目标物体,可获得较高的图像分辨率,从而提高图像精度。

本文建立的机器人系统采用较低的运动速率,避免了因摄像机运动引起的图像的模糊,同时能够保证目标处于摄像机视场范围内,故采用手部摄像机的安装方式[2]。

视觉伺服的方式根据反馈信号表达方式,分为基于位置的视觉伺服和基于图像的视觉伺服。

基于位置的视觉伺服其反馈信号在三维任务空间中以直角坐标形式定义。

基本原理是通过对图像特征的抽取,并结合已知的目标几何模型及摄像机模型,在三维笛卡尔坐标系中对目标位姿进行估计,然后以机械手当前位姿与目标位姿之差作为视觉控制器的输入,进行轨迹规划并计算出控制量,驱动机械手向目标运动,最终实现定位、抓取功能。

有约束的无标定模型预测控制在视觉伺服控制器的设计中,图像雅可比矩阵是建立运动学模型的关键。

经典的IBVS采用比例控制律,它利用图像雅可比矩阵的逆(或伪逆)。

然而,比例控制器可能存在局部极小问题。

也就是说,如果视觉特征数大于3,则图像雅可比矩阵不是满秩的,图像误差可能存在于图像雅可比矩阵的逆(或伪逆)的零空间中,从而导致局部收敛,使得最终的图像特征远离期望的图像特征。

另外,系统约束处理困难,尤其是可见性约束。

当相机的初始位置和所需位置之间的距离较大时,图像特征将不可见。

在视觉伺服控制过程中,可能会违反关节的物理限制和机器人的工作空间。

此外,比例控制器的主要缺点是需要知道摄像机内参数、摄像机外参数和特征点的深度参数,而这些特征点的精确值很难获得。

为了避免使用图像雅可比矩阵中元素的精确值,人们对图像雅可比矩阵的数值估计进行了广泛的研究,如神经网络、迭代学习、拟牛顿方法和模糊控制。

文献提出了许多基于深度无关交互(或图像雅可比)矩阵的自适应控制器,以克服深度限制问题。

文献首次针对摄像机参数未知且深度随时间变化的固定摄像机构型,提出了与深度无关的交互矩阵。

文献提出了眼在手和固定眼构型的自适应视觉跟踪控制的统一设计方法。

然而,这些方案没有明确考虑系统约束,而这些约束对于视觉伺服控制器的设计是至关重要的。

已经提出了许多方法来处理有约束的视觉伺服任务。

例如路径规划、非线性反馈等,但大多需要给定摄像机的外部参数,并且假定摄像机的内部参数和深度信息是已知的。

在IBVS中,通常采用模型预测控制(Model Predictive Control,MPC)来处理系统约束,且MPC控制器具有在未知影响和模型误差的情况下对系统进行控制的能力。

因此,MPC算法可以用来设计无标定环境下的视觉伺服控制器。

本章主要提出了一种新的基于MPC的IBVS设计方法,该方法明确地考虑了系统的约束条件,能够有效地处理未知的摄像机参数和深度参数。

通过模型预测控制获得控制输入,通过参数估计算法在线更新预测模型的未知参数,完成视觉伺服任务。

机器人视觉伺服系统的控制结构1 前言对机器人视觉伺服系统的研究是机器人领域中的重要内容之一,其研究成果可直接用于机器人手—眼系统、移动机器人的自动避障及对周围环境的自适应、轨线跟踪等问题中。

通常所说的机器视觉是指:自动获取并分析图像,以得到一组可对景物描述的数据或控制某种动作的数据。

而视觉伺服则不同于机器视觉,它利用机器视觉的原理对图像进行自动获取与分析,以实现对机器人的某项控制为目的。

正是由于系统以实现某种控制为目的,所以视觉伺服系统中的图像处理过程必须快速准确。

视觉伺服系统采用视觉反馈环形成闭环,在视觉反馈环中抽取某种图像特征。

图像特征可以是点、曲线、图像上的某一区域等,比如,它可以是点在图像平面的坐标位置,或投影面的形心及其惯量的高次幂。

2 视觉伺服系统的分类视觉伺服的控制策略主要基于以下两个问题:1)是否采用分层控制结构?即机器人是否需要闭环关节控制器?进一步说,就是系统的视觉反馈是为机器人的关节控制闭环提供输入量,还是由视觉控制器直接控制机器人各关节。

2)误差输入量是以机器人所在空间的三维坐标表示,还是以图像特征?按控制策略2)区分,视觉伺服系统分为两类:基于位置的控制系统(position-based control,又称3D视觉伺服,3Dvisualservoing),基于图像的控制系统(image-base control,或称2D视觉伺服,2Dvisualservoing)。

由于基于位置和基于图像的视觉伺服各有其优缺点,于是近年有学者综合上述两类视觉伺服系统的优点,设计出2-1/2D视觉伺服系统。

按控制策略1)区分,视觉伺服系统可分为动态观察—移动系统和直接视觉伺服。

前者采用机器人关节反馈内环稳定机械臂,由图像处理模块计算出摄像机应具有的速度或位置增量,反馈至机器人关节控制器;后者则由图像处理模块直接计算机械壁各关节运动的控制量。

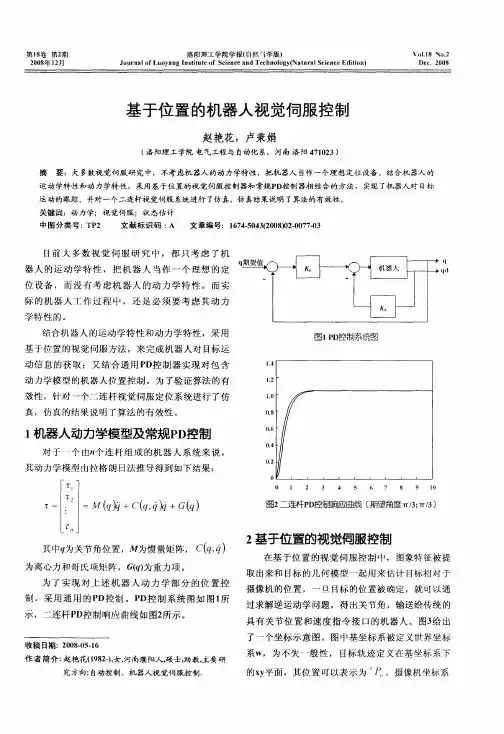

3 视觉伺服系统的控制结构3.1 基于位置的视觉伺服控制结构在基于位置的控制系统中,输入量以三维笛卡尔坐标表示(又称3D伺服控制),多数基于位置的视觉伺服系统采用一具有5~6个自由度的机械臂作为摄像机的运动载体。

机器人视觉伺服系统2014-2-18 15:28:29 浏览:112目前,在全世界的制造业中,工业机器人已经在生产中起到了越来越重要的作用。

为了使机器人能够胜任更复杂的工作,机器人不但要有更好的控制系统,还需要更多地感知环境的变化。

其中机器人视觉以其信息量大、信息完整成为最重要的机器人感知功能。

机器人视觉伺服系统是机器视觉和机器人控制的有机结合,是一个非线性、强耦合的复杂系统,其内容涉及图象处理、机器人运动学和动力学、控制理论等研究领域。

随着摄像设备性能价格比和计算机信息处理速度的提高,以及有关理论的日益完善,视觉伺服已具备实际应用的技术条件,相关的技术问题也成为当前研究的热点。

本文对机器人视觉伺服技术进行了综述,介绍了机器人视觉伺服系统的概念及发展历程和分类,重点介绍了基于位置的视觉伺服系统和基于图像的视觉伺服系统。

对机器人视觉所涉及的前沿问题做了概括,并指出了目前研究中所存在的问题及今后发展方向。

机器人视觉伺服系统视觉伺服的定义:人类对于外部的信息获取大部分是通过眼睛获得的,千百年来人类一直梦想着能够制造出智能机器,这种智能机器首先具有人眼的功能,可以对外部世界进行认识和理解。

人脑中有很多组织参与了视觉信息的处理,因而能够轻易的处理许多视觉问题,可是视觉认知作为一个过程,人类却知道的很少,从而造成了对智能机器的梦想一直难以实现。

随着照相机技术的发展和计算机技术的出现,具有视觉功能的智能机器开始被人类制造出来,逐步形成了机器视觉学科和产业。

所谓机器视觉,美国制造工程师协会(sme society of manufacturing engineers)机器视觉分会和美国机器人工业协会(ria robotic industries association) 的自动化视觉分会给出的定义是:“机器视觉是通过光学的装置和非接触的传感器自动地接收和处理一个真实物体的图像,以获得所需信息或用于控制机器人运动的装置。

视觉伺服综述一、视觉伺服定义:视觉伺服是利用视觉信息控制机械手末端执行器与目标物体之间的相对位姿(pose:position and orientation),或者是利用一组从图像中提取的特征来控制机械手末端执行器与该组特征之间的相对位姿。

根据利用图像信息的不同,可以将视觉伺服分为基于位置的视觉伺服、基于图像的视觉伺服和2.5D视觉伺服。

如果将视觉伺服控制应用到移动机器人,例如自治车辆、自治飞行器和自治潜水器,那么就是利用视觉信息或者一组从图像中提出的特征信息来控制机器人与目标物体之间的相对位姿。

因此,可以认为视觉伺服控制是一门多学科交叉的研究领域,它涉及许多学科,主要包括:数字图像处理、数字信号处理、实时系统、控制理论、运动学、动力学、计算机视觉和机器人学等。

到了80年代末、90年代初,关于视觉伺服的论文数量明显增加,这得益于个人计算机处理能力的提高以及摄像机技术的发展。

因为在个人计算机性能提高之前,研究视觉伺服需要专用的、价格昂贵的采用流水线技术的像素处理设备,因此,当个人计算机性能大幅度提高以后,越来越多的学者加入到视觉伺服控制研究领域,大大地提高了视觉伺服控制研究方面的论文数量。

针对视觉伺服的应用,各国学者也提出了很多的应用原型,例如:从传送带上抓取零件、零件装配、机器人遥操作、导弹跟踪图像系统、水果采摘、汽车无人驾驶和飞机降落等。

二、视觉伺服系统的组成一个典型的工业机器视觉应用系统包括光源、光学系统、图像捕捉系统、图像数字化模块、数字图像处理模块、智能判断决策模块和机械控制执行模块。

系统首先采用CCD摄像机或其它图像拍摄装置将目标转换成图像信号,然后转变成数字化信号传送给专用的图像处理系统,根据像素分布、亮度和颜色等信息,进行各种运算来抽取目标的特征,根据预设的容许度和其他条件输出判断结果。

三、视觉伺服控制的研究内容典型的视觉伺服控制任务通常有:①定位问题(positioning),即通过视觉信息控制机械手末端执行器对准目标物体,也就是控制机械手末端执行器运动到理想位姿。

!第"#卷第$期郑州大学学报!理学版"%&’("#)&($ !$#*+年,月-./012340&56278.!)9:.;<7.=>."-52.$#*+机器人视觉伺服控制研究进展与挑战杨月全*!!秦瑞康*!!李福东*!!曹志强$!!季!涛*!!张天平*!*.扬州大学信息工程学院!江苏扬州$$"##A#$.中科院自动化研究所复杂系统管理与控制国家重点实验室!北京*##*A#"摘要!针对机器人视觉伺服研究’分别从基于位置的视觉伺服)基于图像的视觉伺服)混合视觉伺服等对视觉伺服的研究进展进行了回顾.从雅可比在线估计法)雅可比自适应估计法)深度独立雅可比矩阵估计法等多方面详细分析了无标定视觉伺服.在此基础上’就视觉伺服的实时性)可靠性)多传感器融合)多任务控制)基于离散时间域及混杂系统的控制器等’对机器人视觉伺服控制所面临的挑战及进一步研究进行了分析与展望.关键词!机器人#视觉伺服#雅可比矩阵#无标定中图分类号!K L$B$(,文献标志码!M文章编号!*,?*@,+B*!$#*+"#$@##B*@#+!"#!*#(*C?#"N O.7P P2.*,?*@,+B*($#*?$$$$%引言自从机器人诞生以来’其应用之初主要在工业制造领域’后逐渐扩大至军事)航天)医疗)娱乐)生活等领域**Q++.传统的机器人控制一般使用示教再现方式’这种方法精度很高’但缺乏灵活性.后来将b b W像机用到机器人上’带有视觉功能的机器人技术成为研究热点.最初是一种$看后走%方法’该方法首先对物体进行特征提取’计算出像机坐标系下物体的位姿信息’通过正向运动学得出期望位姿#然后根据期望位姿通过解逆运动学来求解相应的期望关节向量.这种方法只能运用于静止物体’而且进度受多方面影响’如标定精度)机器人结构参数等.为了提高任务精度’*A?C年;07S97和U2&51提出了传统的视觉反馈*A+’称之为$静态边走边看%’但受当时图像处理技术发展的限制’实时性无法得到满足.*A?A年’f7’’和L9S G正式提出了$视觉伺服%的概念**#+’与传统的视觉反馈的不同之处在于图像的处理与信息的反馈是同时进行的’控制精度)灵活性以及鲁棒性都有了较大提高.结合近几年的国内外对视觉伺服控制研究情况’本文重点对机器人视觉伺服控制进展进行了回顾’对该领域研究所面临的挑战进行了分析.&%机器人视觉伺服系统自从机器人视觉伺服被提出来以后’研究人员提出了许多伺服方法和伺服结构’按不同的标准可以将其分成不同的类别.根据摄像机个数不同’可分为单目视觉系统)双目视觉系统和多目视觉系统等.根据摄像机的安装方式’可分为手眼视觉系统!1H1@72@092>"和场景视觉系统!1H1@:&@092>"等.根据输出信号的形式’可分为基于动力学的视觉伺服和基于运动学的视觉伺服.根据摄像机参数的需求情况’可分为基于标定的视觉伺服和基于无标定的视觉伺服.下面’根据反馈信息的类型’从基于位置的视觉伺服)基于图像的视觉伺服和混合视觉伺服等对国内外研究现状进行分析.&,&%基于位置的视觉伺服在基于位置的视觉伺服结构中’其初始给定信息与反馈信息都以笛卡尔空间的形式呈现.在笛卡尔空间中’将机器人末端执行器和目标物体间的相对位姿定义为伺服任务.利用所采集的图像信号得到机器人的当前位姿信息’将当前位姿与期望位姿的差值传输给视觉控制器’形成闭环反馈***Q*B+.收稿日期!$#*?@#?@$C基金项目!国家自然科学基金项目!,**?"***".作者简介!杨月全!*A?*&"’男’江苏盐城人’教授’主要从事多机器人系统研究’=@F97’(H923I H45.1>5.<2#通信作者(秦瑞康!*AA$&"’男’江苏无锡人’硕士研究生’主要从事机器人视觉伺服控制研究’=@F97’(J72S57G923IH190.21:.Copyright©博看网 . All Rights Reserved.$B郑州大学学报!理学版"第"#卷在基于位置的模型依赖视觉伺服结构中’利用扩展卡尔曼滤波器来求得相对位姿’文献**"+采用拥有1H1@72@092>N1H1@:&@092>混合配置的多像机配置’这种方法计算量小.另外’广义预测控制器**,+与自回归模型**?+等方法也可用来估计机械手的位姿.在基于位置的模型无关的视觉伺服结构中’可以通过分解机器人当前和期望图像之间的本质矩阵**++’求得旋转和平移信息’以使其完成伺服任务.利用当前图像与目标图像间的对极几何关系’文献**A+得到两幅图像间分别在位置和方向上的参数.采用基于位置的视觉伺服控制器和常规L W控制器相结合的方法’文献*$#+实现了机器人对目标运动的跟踪.针对激光焊接工业机器人运动轨迹的精度问题’文献*$*+提出一种基于视觉反馈的激光焊接机器人轨迹跟踪控制策略.针对1H1@ :&@092>单目视觉配置的目标跟踪问题’文献*$$+提出了一种利用虚拟视觉伺服算法’使得b M W模型在图像空间中的投影收敛至目标边缘’从而实现笛卡尔空间中三维目标物的精确跟踪的基于模型的三维跟踪算法.针对利用视觉引导的机器鱼水下追踪问题’文献*$C+利用基于模糊滑膜控制机器鱼到达目标水深并保持该水深的位置’利用多步骤的方法控制机器鱼的走向’并且保持快速性与准确性.由于伺服任务的精度较大程度依赖于系统标定.像机标定包括像机内参标定与像机外参标定’主要有直接线性变换)K P97两步法*$B+)张正友平面标定法*$"+)平面圆标定法*$,+)平行圆标定法*$?+等.基于标定板的传统标定方法’为了进一步改进内参标定的精度’文献*$++在传统标定方法的基础上’提出一种共面点的改进摄像机标定方法.基于张正友标定法’文献*$A+提出一种新的基于遗传算法的摄像机内参标定优化.文献*C#Q C$+分别提出一种新的标定板块及配套的)远心镜头的)基于两相同圆的标定算法.以上方法都是针对标定模板的标定方法’无法应用于无模板的场合.另外’自标定方法*CC+研究主要有直接求解g S5RR9方程法*CB+)分层逐步标定法*C"Q C,+)绝对二次曲面自标定*C?+等.为了提高外参标定的精度’文献*C++提出了一种迭代计算的方法.针对位置姿态分开标定引起的测量误差’文献*CA+提出了一种奇异值分解的方法.以上的标定方法使得像机标定的精度问题得到有效解决.在实际应用过程中’每当系统发生改变的时候都需要重新精确标定.这种伺服方法在伺服控制中计算量较大’由于机器人运动过程中可能部分或者全部不在视野之内’使得伺服任务较难以完成.&,’%基于图像的视觉伺服基于图像的视觉伺服将给定信息与反馈信息均定义在图像特征空间.通过当前图像与期望图像相关特征的比较’求出两种图像间的误差关系’并将此作为控制信号’形成闭环反馈’通过控制机器人’使其末端执行器满足当前图像与期望图像特征相等的条件以完成伺服任务.使用此种伺服结构’比较重要的一个任务就是解决图像雅可比矩阵的求解问题*B#Q B"+.求解图像雅可比矩阵也就是求解机器人末端执行器空间速度与图像特征变化率之间的变换关系.常数近似法是利用目标位姿得到的图像雅可比矩阵用于整个伺服过程’这种求解方法只能在期望位姿的小范围内完成伺服任务.文献*B*+中指出在线估计不需要三维物体模型和精确像机标定参数.直接估计法是在机器人进行伺服任务时’用辨识来直接获取图像雅可比矩阵.与基于位置的视觉伺服控制方法相比’这种伺服控制方法无须进行位姿估计’也无须对物体三维重构’复杂程度大大降低.此外’这种方法不需要精确手眼标定’因此对手眼标定误差的鲁棒性较强.但这种方法也存在一些弊端.首先’这种伺服控制方法可以确保伺服系统局部渐近稳定’但确定稳定域大小却有一定的困难*BC+.其次’其本身是在二维空间定义的’无法对三维空间的路径直接控制’此时的路径可能无法达到最优.此外’雅可比矩阵的求解过程中还存在奇异性问题和局部极小值的问题.文献*BB+指出选取C个以上的图像特征可一定程度上避免奇异性问题.&,/%混合视觉伺服无论是基于位置的视觉伺服’还是基于图像的视觉伺服’都存在各自的优缺点’因此’法国专家_9’7P等人提出了混合视觉伺服的方法*B,+.与基于图像的视觉伺服相比’混合视觉伺服可使任务空间严格收敛’与基于位置的视觉伺服相比’混合视觉伺服不需要物体的三维模型信息.在这种伺服结构中’需要提前知道机器人的期望位姿信息’由机器人当前位姿与期望位姿之间的关系可得到对应的单应性矩阵’通过这个矩阵对机器人旋转操作控制.由图像特征的变化得到平移信息’从而对机器人平移操作控制.此方法实现了对机器人平移运动和旋转运动的部分解耦’也可将其称为基于单应性矩阵的视觉伺服控制.这种方法一定程度上可解决局部极小值问题.此外’文献*B,+指出这种视觉伺服方法不存在奇异性问题.文献*B?+对像机标定和手眼像机标定的误差进行了稳定性和鲁棒性分析.但是这种混合视Copyright©博看网 . All Rights Reserved.C B!第$期杨月全#等$机器人视觉伺服控制研究进展与挑战觉伺服方法也存在不足’主要是单应性矩阵的求解问题.文献*B,+指出单应性矩阵的求解对特征点的个数有要求’单应性矩阵的求解过程耗时大’而且可能存在多解问题’另外单应性矩阵的求解过程中对图像噪声比较敏感.’%基于无标定的视觉伺服传统视觉伺服一般需要像机内外参数标定*B+Q""+’受像机畸变以及图像噪声的影响’使得标定的结果很难达到要求.鉴于基于标定的视觉伺服仍存在很多的问题’*AAB年f&P&>9等提出了无标定视觉伺服*"*+.这种方法的本质是通过求解图像雅可比矩阵设计视觉控制器’在只有粗略的像机内外参数以及粗略的机器人结构和运动参数的情况下控制机器人.无标定视觉伺服分为雅可比在线估计法)雅可比自适应法)深度独立雅可比矩阵估计法等.’,&%雅可比在线估计法该法又称为雅可比直接估计’是一种研究较为广泛的方法*",Q,?+.针对不同运行速度的系统’文献*"*+提出了静态加权E S&H>12法和指数加权递归最小二乘法的辨识方法.针对不依赖先验知识的情况’文献*"++提出了一种基于切比雪夫多项式构成成本函数的E S&H>12图像雅可比矩阵估计方法’该方法有较好的收敛速度与系统性能.为了解决大偏差对系统的影响问题’基于误差仿射模型’利用拟牛顿法估计图像雅可比矩阵’文献*"A+提出了大偏差条件下的无标定视觉伺服控制策略.针对残差项的问题’基于动态割线法获得图像雅可比矩阵’文献*,#+提出了全局f1P P792矩阵逆的W@E h D;直接估计法.针对高斯牛顿法在大残量情况时可能不收敛或不能收敛到期望值的问题’文献*,*+提出了一种采用a@_方法的无标定视觉伺服控制方法.在雅可比的求解过程中’环境噪声会对其求解造成影响’文献*,$+提出了一种基于卡尔曼滤波器的雅可比在线估计方法.针对计算雅可比伪逆矩阵引起的奇异性问题’文献*,,+提出了一种递推最小二乘法估计图像雅可比矩阵伪逆.针对视觉信息获取延时问题’文献*,?+提出了一种带有时延补偿的视觉跟踪方法.’,’%雅可比自适应估计法雅可比自适应估计法不需要任何手眼系统参数’利用各种自适应算法对手眼系统参数进行在线估计*,+Q?++.在运动学方面’基于单应性矩阵分解’文献*,++提出了一种1H1@:&@092>系统运动学自适应控制策略.利用分解单应性矩阵的方法’文献*,A+设计高增益鲁棒控制器使得旋转误差稳定’以补偿未知深度信息和像机标定内参的自适应控制器使得平移误差稳定.在动力学方面’针对深度信息不断变化目标跟踪问题’文献*?*+设计了自适应跟踪控制器.基于李雅普诺夫方法的自适应控制策略’文献*?C+对特征点的深度信息进行补偿.基于自适应控制问题’文献*?,+提出一种基于;W6分解的模型在线标定方法.在视觉跟踪方面’针对运动学和动力学参数的不确定问题’文献*??+提出了一种利用T9<GP:1RR723设计的自适应雅可比跟踪方法’设计观测器避免关节和任务空间加速度问题.在不测量图像空间速度的情况下’文献*?++提出了一种基于非线性观测器的控制方法’通过自适应控制器实现了深度信息)动力学参数以及深度无关运动模型参数的分离.’,/%深度独立雅可比矩阵估计法该法既能对未标定摄像机参数补偿’也可对未知变化运动的深度信息补偿’且对深度信息无约束*?A Q+"+.利用;’&:721@a7算法与图像误差梯度最小下降法在线估计系统未知参数信息’文献*?A+首次提出了深度独立雅可比矩阵的无标定视觉伺服控制方法.在定位方面’文献*+#+提出了一种可同时处理动力学参数)机器人几何参数以及摄像机内外参数的自适应定位方法.在动态跟踪方面’文献*+$+将基于深度独立雅可比矩阵估计法应用于1H1@:&@092>场景系统的单特征点动态轨迹跟踪问题.针对未知物体的跟踪问题’文献*+B+提出了一种利用非线性观测器’在线估计未知物体运动状态的动态视觉跟踪方法’设计了基于深度独立雅可比矩阵估计的动态跟踪器.针对系统建模偏差或者外部干扰所导致的测量误差大和关节速度无法测量的问题’在使用深度无关矩阵实现参数线性表达的基础上’文献*+"+提出了一种采用浸入与不变流形观测器对关节速度进行估计的无标定视觉伺服.’,0%其他无标定视觉伺服方法除了以上C种方法’还有其他无标定视觉伺服方法.在只知道摄像机内部粗略参数的情况下’文献*+,+ Copyright©博看网 . All Rights Reserved.B B郑州大学学报!理学版"第"#卷提出了一种采用图像特征信息和相对位姿分别作为平移运动和旋转运动反馈信号’使得定位系统渐近稳定的策略.基于自抗扰控制器’文献*+?+提出一种将图像雅可比矩阵近似误差作为扰动进行补偿和估计的无标定视觉伺服方法.由于机器人的视觉系统与机械手末端之间的关系是一个非线性时变问题’而现在的优化方法可能会导致某些情况下无解’或需要强约束条件.故也有基于智能学习方法展开的研究*++Q AC+.针对人工神经网络的结构选取问题’文献*+A+设计了基于人工神经网络的视觉跟踪控制器’完成三维目标跟踪任务.针对自由度机器人平动的视觉定位问题’文献*A*+提出了一种利用人工神经网络对全局有效的非线性视觉映射关系模型拟合的无标定视觉伺服策略.由于雅可比矩阵本质上是线性和局部的’这影响了神经网络对全局非线性输入输出关系的逼近能力.自抗扰控制器是针对不确定系统的非线性控制器*AB Q AA+.将机器人视觉与机器人末端执行器之间的未知映射关系作为未建模动态’文献*A"+利用自抗扰控制器的思想设计控制器完成伺服任务.基于耦合的自抗扰控制器思想’文献*A,+通过对系统建模的不确定性及其未知外扰进行非线性补偿’完成了相互耦合的不依赖于系统特定任务的无标定手眼协调控制器的设计.基于自抗扰控制器思想’文献*A?+通过对系统未建模动态和外部扰动的补偿’完成了不依赖于任务的无标定手眼协调控制器的设计.利用一个外部扩展状态观测器估计未建模动态和外部扰动’文献*+?+设计了基于非线性状态误差反馈的控制策略./%面临的挑战经过几十年的发展’机器人视觉伺服研究和应用取得了很大的发展和成就.但可以看出大多数的伺服算法仍有一定的局限性.为了将机器人视觉伺服系统应用于实际中’必须解决其精确度)实时性)可靠性以及鲁棒性等问题和要求’在这些方面仍面临很大挑战.第一’视觉伺服的实时性问题.视觉伺服的过程中包含图像采集)图像处理)特征提取与分析)控制信息!如位姿)深度信息等"转换生成等.无论是基于位置的视觉伺服过程中的位姿估计’还是基于图像的视觉伺服过程中的图像雅可比矩阵估计)深度信息估计等’都需要有较强的算法来提高实时性.为了拓宽伺服系统的应用领域’如何进一步改善系统的实时性仍是当前亟待深入研究的问题之一.第二’复杂动态环境下视觉伺服的可靠性问题.近年来针对视觉伺服的研究’往往将其处于理想的静态环境下’或者假设环境已知对系统约束处理’但真实环境是复杂的’多变的)未知的动态约束可能会导致机器人碰撞或者目标物遮挡#其次’在实际应用中会有图像噪声)控制延时和模型误差等问题’从而使得系统的稳定性以及动态性能受到影响.因此’针对视觉伺服可靠性’还有很多问题值得深入探索.第三’多传感器的信息融合问题.当前的研究大多是利用单一视觉传感器进行的’但其自身存在某些缺陷’如探测空间受限.在复杂的实际环境中’如何有效地使多视觉传感器的信息进行有效融合’从而提高实际控制的性能成为研究重点.第四’多任务控制问题.当前大多数的视觉伺服方法是基于单任务控制问题.但在一个实际应用中往往有多个任务’如机器人抓取系统)装配系统等’处理多任务控制问题是必不可少的.第五’基于离散时间域以及混杂系统的控制器设计问题.由于当前大多数的动态视觉伺服控制器都是基于连续时间域的机器人动力学设计的’但是实际应用多是在离散时间域或连续N离散时间域混合情形下实现的.因此’如何基于离散时间域)混杂系统的机器人运动学和动力学设计与分析’开展动态视觉伺服控制器问题变得越来越重要.0%总结本文根据反馈方式对视觉伺服分为基于位置的视觉伺服)基于图像的视觉伺服和混合视觉伺服等C类’对其控制结构)算法等进行了回顾分析.此外’特别对无标定视觉伺服进行了着重分析和小结.最后’就当前视觉伺服研究所面临的挑战进行了分析.Copyright©博看网 . All Rights Reserved."B!第$期杨月全#等$机器人视觉伺服控制研究进展与挑战参考文献!**+!g f6V;f U W-’f c)DEV._7’7:9S H S&T&:P@93’7F RP1[S&F:&>9H92>:&F&S S&\*b+N N L S&<11>723P&[:01+:0U2:1S29:7&29’b&2@ [1S12<1&2b&2:S&’’M5:&F9:7&2’V&T&:7<P92>%7P7&2.g52F723’$##B(??*Q.*$+!_U a a;;’M c6h)’_=-U M;a.U F931T9P1>87P59’P1S8&<&2:S&’[&S[7j1>\7236M%P:S9<G723’7219S72[S9P:S5<:5S172\72> *b+N N L S&<11>723P&[$#*C U===U2:1S29:7&29’b&2[1S12<1&2V&T&:7<P92>M5:&F9:7&2!U b V M".g9S’P S501’$#*C("?,A Q "??B.*C+!a6cVb’b f=)bK’L6e-.U2:1S21:T9P1>S1F&:1P5R1S87P&S H P H P:1F[&S K1’1@F1>7<721S&T&:9RR’7<9:7&2*b+N N L S&<11>723P &[U===^&S GP0&R&2M>892<1>V&T&:7<P92>7:P;&<79’U F R9<:P.6;M(U===b&F R5:1S;&<71:H’$##A(*"C Q*"+.*B+!U;f U W MK’g6V c g U e._&:7&292>S19’@\&S’>P12P723P H P:1F&[9P F9’’T7R1>12:1S:972F12:S&T&:*-+.L S&<11>723P&[:01 \&S’><&23S1P P&272:1’’7312:<&2:S&’o95:&F9:7&2’$##B’,!*#"(B+CB Q B+CA.*"+!赵清杰’连广宇’孙增圻.机器人视觉伺服综述*-+.控制与决策’$##*’*,!,"(+BA Q+"C.*,+!方勇纯.机器人视觉伺服研究综述*-+.智能系统学报’$##+’C!$"(*#A Q**B.*?+!黎志刚’段锁林’赵建英’等.机器人视觉伺服控制及应用研究的现状*-+.太原科技大学学报’$##?’$+!*"($B Q C*.*++!贾丙西’刘山’张凯祥’等.机器人视觉伺服研究进展(视觉系统与控制策略*-+.自动化学报’$#*"’B*!""(+,*Q +?C.*A+!;f U V M U e’U)c6=f.D57>7239S&T&:TH87P59’[11>T9<G729P P1F T’723:9P GP*-+.L9::1S2S1<&327:7&2’*A?C’"!$"(AA Q *#,.**#+f U a a-’L M V g^K.V19’:7F1<&2:S&’&[9S&T&:\7:09F&T7’1<9F1S9*b+N N L S&<11>723P&[72:1S F9:7&29’P H F R&P75F&272>5P@ :S79’S&T&:P.^9P0723:&2(Wb’*A?A($CC Q$B,.***+K M e a c VD’g a==_M)a.f H TS7>R&P7:7&2@T9P1>87P59’P1S8&723\7:0&2’721<9’7TS9:7&2[&S905F92&7>S&T&:*b+N N L S&<11>@ 723P&[:01U===N V;-U2:1S29:7&29’b&2[1S12<1&2U2:1’’7312:V&T&:P92>;H P:1F P.-9R92(;12>97’$##B(,+,Q,A*.**$+D M);)V’W M)U ML’W U i c)^=.%7P59’P1S8&723:&929S T7:S9S H R&P1\7:0S1P R1<::&92&TO1<:378129P723’1G2&\2’123:0 *b+N N L S&<11>723P&[:01M F1S7<92b&2:S&’b&2[1S12<1.^9P0723:&2’$##+(*$,*Q*$,?.**C+董鹏飞.基于位置的工业机器人视觉伺服控制系统研究*W+.广州(华南理工大学’$#*".**B+李国栋’田国会’薛英花.基于‘V b&>1技术的家庭服务机器人视觉伺服抓取操作研究*-+.东南大学学报!自然科学版"’$#*#’B#!;*"(C#Q C,.**"+a U L L U=a a c%’;U b U a U M)c E’%U a a M)U a.=H1@72@092>N1H1@:&@092>F5’:7@<9F1S987P59’P1S8&723*b+N N L S&<11>723P&[:01 BB:0U===b&2[1S12<1&2W1<7P7&292>b&2:S&’.;187’’1’$##"("C"B Q"C"A.**,+g c U%cM-’f c6;f M)D U).V19’@:7F187P7&2[11>T9<G[&S P1S8&723S&T&:7<F927R5’9:&S\7:0P1’[@:52723<&2:S&’’1S*-+.U=== :S92P9<:7&2P&2P H P:1F P F9292><H T1S21:7<P’*AA*’$*!*"(*CB Q*B$.**?+^=;K_c V=WE’^U a;c)^-.W7S1<:>H29F7<<&2:S&’&[9S&T&:5P7239212>@R&72:F&52:1><9F1S992>g9’F92[7’:1S R&P7@ :7&21P:7F9:7&2*b+N N L S&<11>723P&[:01U===U2:1S29:7&29’b&2[1S12<1&2V&T&:7<P92>M5:&F9:7&2.;9<S9F12:&’b M’*AA*( $C?,Q$C+B.**++D=c V D U=%Df’V M W6a c%%W.MRS9<:7<9’F1:0&>[&S>1<&F R&P7:7&2&[:011P P12:79’F9:S7j*-+.M RR’71>F9:01F9:7<9’P<7@ 12<1P’$#*B’+!*?,"(+?""Q+??#.**A+E M;V U V’V U%a U)=’;f U_;f c)U U.%7P59’0&F723(;5S[723&2:011R7R&’1P*-+.U2:1S29:7&29’O&5S29’&[<&F R5:1S87P7&2’*AAA’CC!$"(**?Q*C?.*$#+赵艳花’卢秉娟.基于位置的机器人视觉伺服控制*-+.洛阳理工学院学报!自然科学版"’$##+’*+!$"(??Q?A.*$*+张文增’陈强’都东’等.基于三维视觉的焊接机器人轨迹跟踪*-+.清华大学学报!自然科学版"’$##?’B?!+"(*$?#Q *$?C.*$$+张鹏程’徐德.基于b M W模型的目标跟踪和定位算法研究*-+.高技术通讯’$#*B’$B!,"(,$C Q,C*.*$C+e6-’;6)h’i6W’1:9’.=F T1>>1>87P7&2@357>1>C@W:S9<G723<&2:S&’[&S S&T&:7<[7P0*-+.U===:S92P9<:7&2P&272>5P:S79’1’1<:S&27<P’$#*,’,C!*"(C""Q C,C.*$B+K;M U V.M81S P9:7’1<9F1S9<9’7TS9:7&2:1<027J51[&S0730@9<<5S9<H CWF9<072187P7&2F1:S&’&3H5P723&[[@:01@P01’[K%<9F1S9P92>’12P1P*-+.U===O&5S29’&2S&T&:7<P92>95:&F9:7&2’$##C’C!B"(C$C Q CBB.*$"+/f M)D/.M[’1j7T’121\:1<027J51[&S<9F1S9<9’7TS9:7&2*-+.U===:S92P9<:7&2P&2R9::1S2929’H P7P92>F9<072172:1’’7312<1’$###’$$!**"(*CC#Q*CCB.Copyright©博看网 . All Rights Reserved.,B郑州大学学报!理学版"第"#卷*$,+孟晓桥’胡占义.一种新的基于圆环点的摄像机自标定方法*-+.软件学报’$##$’*C!""(A"?Q A,".*$?+黄凤荣’胡占义’吴毅红.单幅图像测量的一种新方法*-+.自动化学报’$##B’C#!B"(B+?Q BA".*$++刘杨豪’谢林柏.基于共面点的改进摄像机标定方法研究*-+.计算机工程’$#*,’B$!+"($+A Q$AC.*$A+徐中宇’李春龙’孙秋成’等.基于遗传算法的摄像机内部参数标定优化方法*-+.吉林大学学报!理学版"’$#*B’"$ !,"(*$,?Q*$?*.*C#+文涛’左东广’李忠科’等.一种鲁棒的高精度摄像机标定方法*-+.计算机应用研究’$#*"’C$!**"(CB+A Q CBA*.*C*+李林娜’毕德学’马丽.基于有序图像序列与可控外部参数的远心镜头标定方法*-+.天津科技大学学报’$#*"’C#!B"( ,#Q,B.*C$+张虎’达飞鹏’李勤.基于两相同圆的自标定方法*-+.仪器仪表学报’$#*#’C*!C"(,*+Q,$B.*CC+孟晓桥’胡占义.摄像机自标定方法的研究与进展*-+.自动化学报’$##C’$A!*"(**#Q*$B.*CB+_M;W.M P1’[@<9’7TS9:7&2:1<027J51[&S9<:78187P7&2P H P:1F P*-+.U===:S92P9<:7&2P&2S&T&:7<P92>95:&F9:7&2’*AA,’*$ !*"(**B Q*$#.*C"+f=e W=)M’M;K V c_g.=5<’7>192S1<&2P:S5<:7&2[S&F<&2P:92:72:S72P7<R9S9F1:1S P*b+N N L S&<11>723P&[:01*C:0U2:1S29@ :7&29’b&2[1S12<1&2L9::1S2V1<&327:7&2(M5P:S79’%71229’*AA,(CCA Q CB*.*C,+L c a a=h=e;_’D c c aa%.;1’[@<9’7TS9:7&2[S&F:019TP&’5:1<&27<&2:01R’9219:72[727:H*b+N N L S&<11>723P&[:01U2:1S29@ :7&29’b&2[1S12<1&2b&F R5:1S M29’H P7P&[U F931P92>L9::1S2P.E1S’72(;RS7231S%1S’93’*AA?(*?"Q*+$.*C?+K V U D D;E.M5:&<9’7TS9:7&292>:019TP&’5:1J59>S7<*b+N N L S&<11>723P&[:01U===b&F R5:1S;&<71:H b&2[1S12<1&2b&F R5:1S %7P7&292>L9::1S2V1<&327:7&2.M S312:729(;92-592’*AA?(,#A Q,*B.*C++/f M)Df.f92>N1H1<9’7TS9:7&2[&S1’1<:S&27<9P P1F T’H S&T&:P*-+.U===K S92P9<:7&2P&2V&T&:7<P92>M5:&F9:7&2’*AA+’*B !B"(,*$Q,*,.*CA+W M)U U a U W U;g’E M e V c@b c V V c b f M)c=.K01>59’J59:1S27&29RRS&9<0:&092>@1H1<9’7TS9:7&2*b+N N L S&<11>723P&[*C:0 U2:1S29:7&29’b&2[1S12<1&2L9::1S2V1<&327:7&2.M5P:S79(%71229’*AA,(C*+Q C$$.*B#+b f M6_=K K=h’E c6g U V;’E c6K f=_eL’1:9’.;:S5<:5S1[S&F<&2:S&’’1>F&:7&2*-+.U===:S92P9<:7&2P&2R9::1S2929’H@ P7P92>F9<072172:1’’7312<1’*AA,’*+!""(BA$Q"#B.*B*+W=a6b MM’c V U c a cD’D U c V W M)cLV.c2@’7211P:7F9:7&2&[[19:5S1>1R:0[&S7F931@T9P1>87P59’P1S8&723P<01F1P*b+N N L S&<11>723P&[$##?U===U2:1S29:7&29’b&2[1S12<1&2V&T&:7<P92>M5:&F9:7&2.U:9’H(V&F1’$##?($+$C Q$+$+.*B$+L U=L_=U=V-M’_b_6V V M eD%’a U L g U)f.62<9’7TS9:1>>H29F7<87P59’P1S8&723*-+.U===:S92P9<:7&2P&2S&T&:7<P92> 95:&F9:7&2’$##B’$#!*"(*BC Q*B?.*BC+b f M6_=K K=h.L&:12:79’RS&T’1F P&[P:9T7’7:H92><&281S312<1727F931@T9P1>92>R&P7:7&2@T9P1>87P59’P1S8&723*_+.a&2@ >&2(;RS7231S a&2>&2’*AA+(,,Q?+.*BB+b f M6_=K K=h’f6K b f U);c);.%7P59’P1S8&<&2:S&’’R9S:U(T9P7<9RRS&9<01P*-+.U===S&T&:7<P92>95:&F9:7&2F939@ 4721’$##?’*C!B"(+$Q A#.*B"+_M/’;6-.V&T5P:52<9’7TS9:1>87P59’P1S8&723<&2:S&’T9P1>&2>7P:5S T92<1&TP1S81S*-+.U P9:S92P9<:7&2P’$#*"’"A(*AC Q $#B.*B,+_M a U;=’b f M6_=K K=h’E c6W=K;.$@W87P59’P1S8&723*-+.U===:S92P9<:7&2P&2S&T&:7<P92>95:&F9:7&2’*AAA’*"!$"($C+Q$"#.*B?+_M a U;=’b f M6_=K K=h.K01&S1:7<9’7F RS&81F12:P72:01P:9T7’7:H929’H P7P&[921\<’9P P&[F&>1’@[S1187P59’P1S8&723F1:0@ &>P*-+.U===:S92P9<:7&2P&2S&T&:7<P92>95:&F9:7&2’$##$’*+!$"(*?,Q*+,.*B++江祥奎’纪旭.一种摄像机标定系统的实现*-+.西安邮电大学学报’$#*"’$#!""(?*Q?".*BA+胡小平’左富勇’谢珂.微装配机器人手眼标定方法研究*-+.仪器仪表学报’$#*$’CC!?"(*"$*Q*"$,.*"#+冯春’周文.手眼系统中摄像机标定和手眼标定的同步算法*-+.机械设计与制造’$#*"!*$"("+Q,*.*"*+f c;c W Mg’M;M W M_.%1S P9:7’187P59’P1S8&723\7:0&5:G2&\’1>31&[:S51O9<&T792*b+N N L S&<11>723P&[:01U===N V;-N D U U2:1S29:7&29’b&2[1S12<1&2U2:1’’7312:V&T&:P92>;H P:1F P.D1S F92H(_527<0’*AAB(*+,Q*AC.*"$+付清山.机器人无标定视觉伺服控制研究*W+.南京(东南大学’$#**.*"C+梁新武.机械手无标定动态视觉伺服研究*W+.武汉(华中科技大学’$#**.*"B+毛尚勤.微操作系统的机器视觉与无标定视觉伺服研究*W+.武汉(华中科技大学’$#*C.*""+陶波’龚泽宇’丁汉.机器人无标定视觉伺服控制研究进展*-+.力学学报’$#*,’B+!B"(?,?Q?+C.*",+L U=L_=U=V-M’_b_6V V M eD%’a U L g U)f.K S9<G7239F&8723:9S31:\7:0F&>1’72>1R12>12:87P59’P1S8&723(9RS1>7<:781 1P:7F9:7&29RRS&9<0*b+N N L S&<11>723P&[:01U===U2:1S29:7&29’b&2[1S12<1&2V&T&:7<P92>M5:&F9:7&2.E1’375F(a15812’Copyright©博看网 . All Rights Reserved.。

视觉伺服控制原理视觉伺服控制是一种利用计算机视觉技术来实现物体精确定位的自动化控制方法。

该控制方法是在计算机视觉技术和传统伺服控制技术的基础上实现的。

它能够在机器人和自动化设备中实现很多任务,如自动化装配、机器人导航和质量检测等。

视觉伺服控制的核心原理是依靠计算机视觉技术来获取复杂的视觉信息,并以此控制机器人或自动化设备的精确位置和运动。

视觉伺服控制系统一般由四个部分组成:图像采集系统、图像处理系统、运动控制系统和控制算法。

图像采集系统可以是相机、激光测距器、扫描器等设备,它能够采集物体的图像信息。

图像处理系统负责从采集到的图像数据中提取出所需要的物体信息,如物体位置、形状和大小等。

运动控制系统根据所提取的物体信息和指令,实现精确定位和运动控制。

控制算法为视觉伺服控制的核心,利用PID控制方法来根据图像处理系统提供的物体信息对物体进行控制。

视觉伺服控制的原理是基于反馈控制的思想。

它实现了机器人和自动化设备的实时跟踪和位置控制。

通过视觉反馈,一旦运动偏离预定轨迹或目标位置,视觉伺服系统即可及时发出控制信号,调整伺服系统的控制策略,控制机器人或自动化设备的方向和速度,使其重新回到目标设定位置,从而实现目标物体的精准定位。

视觉伺服控制主要应用在自动化装配中,如汽车、电子设备的组装线。

此外还可以应用在工业自动化控制和机器人导航等领域。

其优点是精度高、速度快、适应性强、可扩展性好等。

同时也存在一些挑战,如图像噪声影响、系统复杂性、时滞带来的控制问题等。

总的来说,视觉伺服控制在自动化控制领域中发挥着越来越重要的作用。

它可以帮助制造商提高生产效率和产品质量,降低成本,也可以应用在智能制造、智能交通等领域。

随着计算机视觉技术的不断进步,视觉伺服控制将会有更广泛的应用前景。

机器人无标定视觉伺服控制系统研究共3篇机器人无标定视觉伺服控制系统研究1随着科技的不断发展,机器人技术在各个领域得到了广泛应用。

在机器人控制系统中,视觉伺服控制系统起到了重要的作用。

在传统的机器人视觉伺服控制系统中,需要进行标定过程,以确定机器人和相机之间的空间关系。

但是,标定过程存在一定的难度和不确定性,同时还需要一定的时间和成本。

为了解决这个问题,无标定视觉伺服控制系统逐渐被广泛应用。

无标定视觉伺服控制系统是指在机器人和相机之间没有固定的空间关系的情况下,通过计算机视觉算法来实现机器人的运动控制。

相比于传统的标定方法,它可以减少标定时间和成本,提高对环境变化的适应能力。

无标定视觉伺服控制系统主要包括以下三个方面的技术:相机姿态估计、空间姿态解算和运动控制。

相机姿态估计是指通过像素坐标计算相机的位置和姿态。

这个过程中需要用到相机内参矩阵和外参矩阵,它们包括了相机的焦距、畸变参数和相机与世界参考坐标系之间的变换关系。

在无标定系统中,这些参数通过计算机视觉算法来估计,例如SIFT、SURF等特征匹配算法或者SLAM算法。

空间姿态解算是指将相机坐标系下的位置和姿态转换到机器人坐标系下。

这个过程中需要进行空间转换和坐标系变换,具体可以通过四元数、欧拉角或旋转矩阵来实现。

运动控制是指根据机器人姿态和速度,通过控制器来实现机器人的运动。

在无标定视觉伺服控制系统中,运动控制需要结合相机姿态估计和空间姿态解算来实现,确保机器人的运动和相机的拍摄一致。

总的来说,无标定视觉伺服控制系统的优点在于它可以实现快速标定和灵活控制,同时具有一定的适应环境变化的能力。

但是,它的缺点在于精度和稳定性无法与传统标定方法相比,同时需要更加复杂的计算算法和硬件设备。

因此,根据具体的应用场景和需求,需要选择合适的视觉伺服控制系统。

机器人无标定视觉伺服控制系统研究2机器人无标定视觉伺服控制系统研究机器人在现代制造业中扮演着越来越重要的角色,而机器人的视觉伺服控制系统是提高机器人性能以及实现工业自动化的关键技术之一。

有约束的无标定模型预测控制在视觉伺服控制器的设计中,图像雅可比矩阵是建立运动学模型的关键。

经典的IBVS采用比例控制律,它利用图像雅可比矩阵的逆(或伪逆)。

然而,比例控制器可能存在局部极小问题。

也就是说,如果视觉特征数大于3,则图像雅可比矩阵不是满秩的,图像误差可能存在于图像雅可比矩阵的逆(或伪逆)的零空间中,从而导致局部收敛,使得最终的图像特征远离期望的图像特征。

另外,系统约束处理困难,尤其是可见性约束。

当相机的初始位置和所需位置之间的距离较大时,图像特征将不可见。

在视觉伺服控制过程中,可能会违反关节的物理限制和机器人的工作空间。

此外,比例控制器的主要缺点是需要知道摄像机内参数、摄像机外参数和特征点的深度参数,而这些特征点的精确值很难获得。

为了避免使用图像雅可比矩阵中元素的精确值,人们对图像雅可比矩阵的数值估计进行了广泛的研究,如神经网络、迭代学习、拟牛顿方法和模糊控制。

文献提出了许多基于深度无关交互(或图像雅可比)矩阵的自适应控制器,以克服深度限制问题。

文献首次针对摄像机参数未知且深度随时间变化的固定摄像机构型,提出了与深度无关的交互矩阵。

文献提出了眼在手和固定眼构型的自适应视觉跟踪控制的统一设计方法。

然而,这些方案没有明确考虑系统约束,而这些约束对于视觉伺服控制器的设计是至关重要的。

已经提出了许多方法来处理有约束的视觉伺服任务。

例如路径规划、非线性反馈等,但大多需要给定摄像机的外部参数,并且假定摄像机的内部参数和深度信息是已知的。

在IBVS中,通常采用模型预测控制(Model Predictive Control,MPC)来处理系统约束,且MPC控制器具有在未知影响和模型误差的情况下对系统进行控制的能力。

因此,MPC算法可以用来设计无标定环境下的视觉伺服控制器。

本章主要提出了一种新的基于MPC的IBVS设计方法,该方法明确地考虑了系统的约束条件,能够有效地处理未知的摄像机参数和深度参数。

通过模型预测控制获得控制输入,通过参数估计算法在线更新预测模型的未知参数,完成视觉伺服任务。

有约束和无标定视觉伺服的预测模型模型预测控制被用来处理未标定环境中眼在手上和眼在手外摄像机构型的IBVS系统的控制约束。

在无标定的环境中,摄像机的内外参数和特征的三维坐标是未知的。

为了通过MPC获得最优控制输入,需要找到一个预测模型来描述系统的动态行为。

介绍了基于深度无关交互矩阵的预测模型。

在透视投影模型下,特征点的图像坐标可以描述为:s m (t) c其中s m (t) (u(t), v(t))T表示特征点在图像平面上的图像坐标。

特征点的深度用c决于摄像机的内部参数和外部参数。

H表示机器人正向运动学的齐次变换矩阵,和p分别是H的旋转矩阵和平移矢量。

在眼在手上摄像机构型中C BH ec,H ec 是摄像机外部参数矩阵,它表示末端执行器坐标系相对于摄像机坐标系的齐次矩阵。

B是相机的内参数矩阵,由相机内部结构决定。

H ( H eb )1,其中H eb为末端执行器坐标系相对于机器人基坐标系的齐次矩阵。

b x是特征点在机器人基坐标系的三维位置参数,b x是具有3个独立元素的常数向量。

在眼在手外构型中,C BH bc,其中H bc是相机外参数矩阵,它表示机器人基坐标系相对于相机坐标系的齐次矩阵的,H H eb,b x是特征点在末端执行器坐标系中的三维位置参数。

通过对式(4.1)微分,有视觉变化与关节速度的关系:s m (t)其中矩阵A(s m (t), q(t)) 2n是与深度无关的相互作用矩阵,形式为:c2 v(t)c3 q(t)其中q(t) n 1表示机器人的关节角度,n是自由度。

约束视觉伺服大多是采用传统的图像雅可比矩阵,但是传统的图像雅可比矩阵依赖于特征点的二维图像坐标、摄像机内部参数和图像中未实际测量的深度参数。

在以前的基于传统图像雅可比矩阵的预测模型中,深度呈现非线性。

这里,基于深度无关交互矩阵的预测模型中的深度可以由未知的摄像机参数和特征点的三维笛卡尔坐标线性表示。

深度c Z (t)可以由未知参数表示如下:c基于预测控制的控制律设计应采用离散时间模型,而不是连续时间模型(4.2)。

每个特征点的离散状态空间模型可写为:x(k 1) Fx(k ) G(k )u c (k )其中F是2 2常数矩阵,G(k )是时变变量和未知常数参数的函数:G(k )时变变量是特征点和机器人关节的二维图像坐标,且两者都可以测量。

未知常数参数包括摄像机内部参数、摄像机外部参数和特征点的三维位置参数。

T e为采样周期。

基于离散化的深度无关交互矩阵的预测模型用于设计预测控制律。

在(4.5)中,s m可作为系统状态和输出,k为当前采样时间,u c (k ) n 1表示控制输入,即关节速度q(k )。

给定静态或动态的期望轨迹s d。

当s d为静态时,视觉伺服定位任务是将特征点从图像平面上的初始位置带到期望位置。

当s d为随时间变化的动态轨迹时,视觉伺服跟踪任务是使特征点在图像平面上跟踪期望的轨迹。

Z (t ) c 3T H s m (k ) x (k )模型预测控制与在线参数估计为了实现有约束和无标定环境下的视觉伺服控制任务,需要确定控制输入, 并在线更新预测模型的未知参数。

此外,MPC 算法是在自适应控制的基础上发 展起来的,能够保持自适应控制利用过去的输入输出辨识系统模型的特点。

根据 控制论中的分离原理,分别计算控制输入和模型参数,更新系统模型,使系统状 态更接近实际。

在本节中,控制由 MPC 确定,并从模型参数的初始估计开始。

模型参数的估计值是在线更新的。

视觉伺服系统主要由最优控制模块和参数估计 模块两部分组成。

最优控制模块为机器人系统生成控制输入 u c ,其将当前图像特 征 s m 引导到期望的特征 s d 。

在参数估计模块中,基于特征 s m 的二维图像坐标和关节角度的测量值来更新模型参数 。

机器人视觉系统的控制方案如图 4.1 所示。

s m m (k ) F i 1 G (k m i )u (k m i ) (k m ) F s U c (k ){U c c max },U视觉伺服约束s d (k )s m (k )有约束无标定 IBVS 的模型预测控制通过使用 MPC ,可以通过如下步骤实现控制:(1) 采用模型对 IBVS 系统的未来行为进行预测。

根据预测模型(4.5),图像状态的预测可以根据最后 m (mN p ) 个状态和控制输入来定义:m其中 N p 是预测范围。

该动态预测模型在每个采样时刻以有限的 N p 步预测特征点s m 。

用 N c 表示控制水平,它表示控制输入的自由度数目[79]。

此外,N c N p 减少了最优问题的自由度数目,提高了在线最优控制问题数值解的计算速度。

从 u (kN c1) 到 u (kN p1) ,控制输入等于 u (k N c ) [80]。

更新模型参数将在下一小节中提及。

预测模型在每个采样时间 k 在线更新。

(2) 求解有限时间开环约束最优控制问题。

优化的目的是计算最优控制信号, 使图像特征达到期望的轨迹。

同时,满足了系统的约束条件。

IBVS 系统约束包 括机器人约束和图像约束。

机器人约束主要包含机器人的物理约束,如关节边界、关节速度饱和或关节加速度限制等,可视为系统的输入约束:min此外,还将工作空间限制和深度范围视为与机器人关节测量相关的机器人约 束。

q(k ) {q min , q max }图像约束是将特征保持在视场中或在图像平面中设置范围的可见性约束。

可 见性约束可以看作是系统的输出约束:s m (k ) {s m m max }, s min J ((k ), U c (k ))U c (k ) [u c (k ) , ,u c (kN p1) ]TJ ( (k ),U c (k ))(s d (k i ) s m (k i ))T Q (s d (k i ) s m (k i ))(k i 1) R u( u c c (k i 1))min通过考虑 IBVS 系统的输入和输出约束的 MPC 策略可以写成:U c( k ) 其中, U c (k ) 表示控制输入变化的最优序列,为:动态预测模型为:s m (k 1) s m (k )(ki ) s d (k i ) s m (k i )u c (k )u c (k1)u c (k )其中, s m 是可以测量的模型状态和模型输出, s d 是期望状态, (k ) 是在时间i [k1, kN p ]时期望状态和预测状态之间的差。

关节速度约束:q (k ){q min , q max }关节速度约束的变化,可以有效地抑制关节速度的突变:q{q min ,q max }式子(4.16)和(4.17)都是 IBVS 系统的输入约束。

s m (k ){s m min , s m max }式子(4.18)表示可见性约束,它是 IBVS 系统的输出约束。

输入和输出约束 可以表示为控制输入U c 的变化的最优序列的函数。

要最小化的二次成本函数包括预测误差和控制输入变化的顺序,其描述为:N pi1N c i1其中第一项最小化有限预测范围 N p 上的预测状态 s m 和期望状态 s d 之间的误差。

第二项最小化有限控制范围 N c 上控制输入的变化。

Q 和 二项的对称加权矩阵。

对于在线约束优化问题,需要采用一种有效的算法进行求解。

利用序列二次 规划(SQP)算法计算约束条件下的可行解,得到 N c 上控制输入U c 变化的最优序Z (t)THZ (t)c i 3 b x 1, c i1 b x 2 , c i 2 b x 2 , c i 3 b x 2 , c i1 b x 3, c i 2 b x 3, c i 3 b x 3, c i1, c i 2 , c i 3 )T , i(iT, c i 4 ) (i 1, 2,3) 。

1列。

(3) 获取每个采样时间的控制输入。

由于模型的不确定性和摄像机标定误差、 图像噪声、未知效应等干扰,最优控制序列 U c 中的所有元素都不能作用于动态 系统。

实际上,(4.12)中的最优控制序列U c 的第一个元素是u c (k ) , u c (k ) 被定义为当前时刻 k 的控制输入的最优变化,在下一个采样时刻,水平向前移动一 步,并且在更新输出度量和未知动态效应之后,整个优化过程重新开始[80]。

与最 优控制的全局优化策略不同,MPC 算法采用滚动时域策略,对工业实际中的模 型失配和扰动进行补偿是实用和有效的。

此外,在(4.19)中,未来参考输入 s d (ki) 是(ki)[k1; kN p ] 时刻期望的特征, s m (k ) 是当前时刻的可测量状态,这分别作用于预测控制律的前馈补偿 和反馈补偿。