模式识别第六篇最近邻方法

- 格式:ppt

- 大小:197.00 KB

- 文档页数:8

最近邻算法

最近邻算法(k-Nearest Neighbor Algorithm,KNN)是一种基于实例的学习或懒惰学习算法,它允许计算机系统“学习”在给定的训练集上的输入实例的属性与相应的类标号之间的关系,从而实现对新的数据实例进行分类。

KNN算法是一种被称作非参数学习法的监督学习方法,该方法不需要事先对数据进行定量化和标准化处理,也不涉及参数估计,大大简化了模型的构建过程。

KNN算法的基本思想十分简单:给定一个新的实例,将其与训练样本中的所有数据进行比较,然后依据一定的距离度量准则将新的实例分配给与其最为相似的那些训练样本所对应的类别。

KNN算法的实现原理很容易理解,但是在实际应用中,它却是一种高效的分类算法。

该算法能够从无序的、高维度的数据集中提取出有用的类别信息,使用者只需少量参数调节以及短暂的训练过程便可得到一个完整的建模。

KNN算法是一种基于实例的学习,主要由两步组成:第一步是计算两个实例之间的“距离”,第二步是根据距离选取“k”个最邻近的实例,并将其类标号合并以形成最终的预测类标号。

当新的数据实例到达时,KNN算法可以计算与该实例的每一个已知实例的距离,选择与该实例距离最近的K个实例来投票确定该新实例的类别标号。

KNN算法具有训练速度快、容易理解、可解释性高、支持多样性等优点,因此近年来得到了越来越多的应用。

然而,KNN算法也存在一些缺点,如计算复杂度高、空间开销不稳定以及容易受到噪声影响等。

最近邻点法最近邻点法(KNN)是一种基于数据距离度量的机器学习算法。

它是监督学习算法中最简单和最常用的算法之一。

其基本思想是通过测量不同特征之间的距离,将一个未知样本标记为与距离最近的已知样本相同的类别。

KNN算法可以用来分类或回归,常用于分类问题。

KNN分类器的工作原理如下:给定一组已分类的样本数据,将一个新的样本与已有样本数据进行比较,找到与新样本最接近的K个样本(K是一个既定的数目),并将新样本分配给这K个样本中最普遍的类别。

KNN算法的核心是进行距离度量。

KNN算法中距离度量方法的种类很多,例如欧氏距离、曼哈顿距离、马氏距离等。

其中欧氏距离最为常用。

KNN算法的距离度量可以通过计算每个特征的差异来实现,也可以使用其他方法进行度量。

距离度量完成后,KNN算法开始确定K值。

通常情况下,较小的K值能够产生较小的误差,而较大的K值则能更好地抵御噪声。

但是,较大的K值会使算法更加耗时,并且可能使一些例子中的极端离群值对算法产生负面影响。

KNN算法是一种简单而有效的算法,但需要注意以下几点:1.选择合适的K值:过大或过小的K值都可能导致算法的失效。

2.特征归一化:由于不同特征的度量单位和尺度不同,在距离度量时可能会对结果造成很大的影响。

为了使算法更加准确,应该对所有特征进行归一化处理。

3.算法的分类速度比较慢:当样本数据量很大时,KNN算法的计算量会非常庞大。

因此,在处理大量数据时,KNN算法可能会变得非常缓慢。

总的来说,KNN算法在数据量不大、特征数量较少的情况下,非常适合进行分类问题的处理,并且对于数据本身的特征分布不作限定,因此具有比较好的适应性。

但是,由于距离度量方法和K值的选择等问题,需要谨慎使用。

什么是计算机模式识别请解释几种常见的算法什么是计算机模式识别?请解释几种常见的算法计算机模式识别是一种利用计算机技术来识别和分类不同模式的方法。

模式是指事物之间的某种形式、结构、特征或行为的概念。

计算机模式识别广泛应用于图像识别、语音识别、文字识别等领域,对人类视觉、听觉和认知等感知过程进行仿真,以实现机器对模式的自动识别和理解。

计算机模式识别中常见的算法有:1. 最近邻算法(K-Nearest Neighbors, KNN)最近邻算法是一种基本的分类算法。

它的思想是如果一个样本在特征空间中的K个最相似的样本中的大多数属于某个类别,那么该样本也可以划分为这个类别。

最近邻算法主要通过计算样本之间的距离来进行分类决策,距离可以使用欧氏距离、曼哈顿距离等。

2. 决策树算法(Decision Tree)决策树算法是一种基于树形结构的分类算法。

它通过一系列的判断问题构建一棵树,每个内部节点代表一个问题,每个叶子节点代表一个类别。

决策树算法通过划分样本空间,使得每个子空间内样本的类别纯度最大化。

常用的决策树算法包括ID3算法、C4.5算法、CART 算法等。

3. 支持向量机算法(Support Vector Machines, SVM)支持向量机算法是一种二类分类算法。

它通过构建一个超平面,使得离该超平面最近的一些样本点(即支持向量)到超平面的距离最大化。

支持向量机算法可以用于线性可分问题和非线性可分问题,通过核函数的引入可以将低维特征空间映射到高维特征空间,提高模型的表达能力。

4. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯算法是一种基于贝叶斯定理和特征条件独立性假设的分类算法。

它通过计算样本的后验概率来进行分类决策,选择后验概率最大的类别作为样本的分类结果。

朴素贝叶斯算法在文本分类、垃圾邮件过滤等任务中得到了广泛应用。

5. 神经网络算法(Neural Networks)神经网络算法是一种模拟人类神经系统进行学习和决策的模式识别算法。

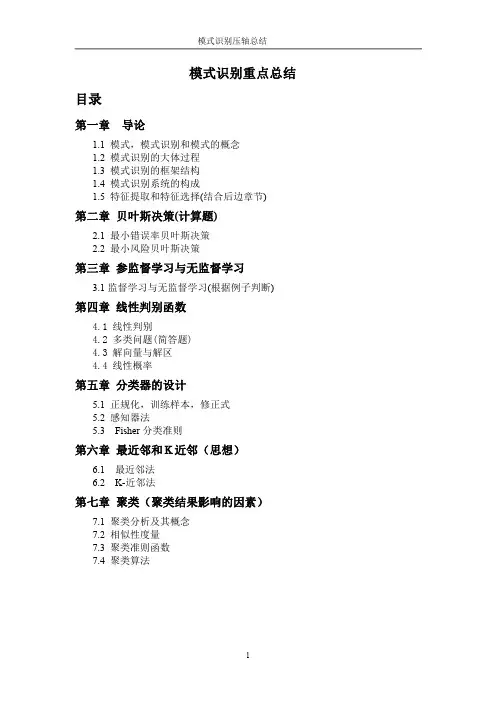

《模式识别基础》课程标准(执笔人:刘雨审阅学院:电子科学与工程学院)课程编号:08113英文名称:Pattern Recognition预修课程:高等数学,线性代数,概率论与数理统计,程序设计学时安排:40学时,其中讲授32学时,实践8学时。

学分:2一、课程概述(一)课程性质地位模式识别课基础程是军事指挥类本科生信息工程专业的专业基础课,通信工程专业的选修课。

在知识结构中处于承上启下的重要位置,对于巩固已学知识、开展专业课学习及未来工作具有重要意义。

课程特点是理论与实践联系密切,是培养学生理论素养、实践技能和创新能力的重要环节。

是以后工作中理解、使用信息战中涉及的众多信息处理技术的重要知识储备。

本课程主要介绍统计模式识别的基本理论和方法,包括聚类分析,判别域代数界面方程法,统计判决、训练学习与错误率估计,最近邻方法以及特征提取与选择。

模式识别是研究信息分类识别理论和方法的学科,综合性、交叉性强。

从内涵讲,模式识别是一门数据处理、信息分析的学科,从应用讲,属于人工智能、机器学习范畴。

理论上它涉及的数学知识较多,如代数学、矩阵论、函数论、概率统计、最优化方法、图论等,用到信号处理、控制论、计算机技术、生理物理学等知识。

典型应用有文字、语音、图像、视频机器识别,雷达、红外、声纳、遥感目标识别,可用于军事、侦探、生物、天文、地质、经济、医学等众多领域。

(二)课程基本理念以学生为主体,教师为主导,精讲多练,以用促学,学以致用。

使学生理解模式识别的本质,掌握利用机器进行信息识别分类的基本原理和方法,在思、学、用、思、学、用的循环中,达到培养理论素养,锻炼实践技能,激发创新能力的目的。

(三)课程设计思路围绕培养科技底蕴厚实、创新能力突出的高素质人才的目标,本课程的培养目标是:使学生掌握统计模式识别的基本原理和方法,了解其应用领域和发展动态,达到夯实理论基础、锻炼理论素养及实践技能、激发创新能力的目的。

模式识别是研究分类识别理论和方法的学科,综合性、交叉性强,涉及的数学知识多,应用广。

模式识别大作业1.最近邻/k近邻法一.基本概念:最近邻法:对于未知样本x,比较x与N个已知类别的样本之间的欧式距离,并决策x与距离它最近的样本同类。

K近邻法:取未知样本x的k个近邻,看这k个近邻中多数属于哪一类,就把x归为哪一类。

K取奇数,为了是避免k1=k2的情况。

二.问题分析:要判别x属于哪一类,关键要求得与x最近的k个样本(当k=1时,即是最近邻法),然后判别这k个样本的多数属于哪一类。

可采用欧式距离公式求得两个样本间的距离s=sqrt((x1-x2)^2+(y1-y2)^2)三.算法分析:该算法中任取每类样本的一半作为训练样本,其余作为测试样本。

例如iris中取每类样本的25组作为训练样本,剩余25组作为测试样本,依次求得与一测试样本x距离最近的k 个样本,并判断k个样本多数属于哪一类,则x就属于哪类。

测试10次,取10次分类正确率的平均值来检验算法的性能。

四.MATLAB代码:最近邻算实现对Iris分类clc;totalsum=0;for ii=1:10data=load('iris.txt');data1=data(1:50,1:4);%任取Iris-setosa数据的25组rbow1=randperm(50);trainsample1=data1(rbow1(:,1:25),1:4);rbow1(:,26:50)=sort(rbow1(:,26:50));%剩余的25组按行下标大小顺序排列testsample1=data1(rbow1(:,26:50),1:4);data2=data(51:100,1:4);%任取Iris-versicolor数据的25组rbow2=randperm(50);trainsample2=data2(rbow2(:,1:25),1:4);rbow2(:,26:50)=sort(rbow2(:,26:50));testsample2=data2(rbow2(:,26:50),1:4);data3=data(101:150,1:4);%任取Iris-virginica数据的25组rbow3=randperm(50);trainsample3=data3(rbow3(:,1:25),1:4);rbow3(:,26:50)=sort(rbow3(:,26:50));testsample3=data3(rbow3(:,26:50),1:4);trainsample=cat(1,trainsample1,trainsample2,trainsample3);%包含75组数据的样本集testsample=cat(1,testsample1,testsample2,testsample3);newchar=zeros(1,75);sum=0;[i,j]=size(trainsample);%i=60,j=4[u,v]=size(testsample);%u=90,v=4for x=1:ufor y=1:iresult=sqrt((testsample(x,1)-trainsample(y,1))^2+(testsample(x,2) -trainsample(y,2))^2+(testsample(x,3)-trainsample(y,3))^2+(testsa mple(x,4)-trainsample(y,4))^2); %欧式距离newchar(1,y)=result;end;[new,Ind]=sort(newchar);class1=0;class2=0;class3=0;if Ind(1,1)<=25class1=class1+1;elseif Ind(1,1)>25&&Ind(1,1)<=50class2=class2+1;elseclass3=class3+1;endif class1>class2&&class1>class3m=1;ty='Iris-setosa';elseif class2>class1&&class2>class3m=2;ty='Iris-versicolor';elseif class3>class1&&class3>class2m=3;ty='Iris-virginica';elsem=0;ty='none';endif x<=25&&m>0disp(sprintf('第%d组数据分类后为%s类',rbow1(:,x+25),ty));elseif x<=25&&m==0disp(sprintf('第%d组数据分类后为%s类',rbow1(:,x+25),'none'));endif x>25&&x<=50&&m>0disp(sprintf('第%d组数据分类后为%s类',50+rbow2(:,x),ty));elseif x>25&&x<=50&&m==0disp(sprintf('第%d组数据分类后为%s类',50+rbow2(:,x),'none'));endif x>50&&x<=75&&m>0disp(sprintf('第%d组数据分类后为%s类',100+rbow3(:,x-25),ty));elseif x>50&&x<=75&&m==0disp(sprintf('第%d组数据分类后为%s类',100+rbow3(:,x-25),'none'));endif (x<=25&&m==1)||(x>25&&x<=50&&m==2)||(x>50&&x<=75&&m==3)sum=sum+1;endenddisp(sprintf('第%d次分类识别率为%4.2f',ii,sum/75));totalsum=totalsum+(sum/75);enddisp(sprintf('10次分类平均识别率为%4.2f',totalsum/10));测试结果:第3组数据分类后为Iris-setosa类第5组数据分类后为Iris-setosa类第6组数据分类后为Iris-setosa类第7组数据分类后为Iris-setosa类第10组数据分类后为Iris-setosa类第11组数据分类后为Iris-setosa类第12组数据分类后为Iris-setosa类第14组数据分类后为Iris-setosa类第16组数据分类后为Iris-setosa类第18组数据分类后为Iris-setosa类第19组数据分类后为Iris-setosa类第20组数据分类后为Iris-setosa类第23组数据分类后为Iris-setosa类第24组数据分类后为Iris-setosa类第26组数据分类后为Iris-setosa类第28组数据分类后为Iris-setosa类第30组数据分类后为Iris-setosa类第31组数据分类后为Iris-setosa类第34组数据分类后为Iris-setosa类第37组数据分类后为Iris-setosa类第39组数据分类后为Iris-setosa类第41组数据分类后为Iris-setosa类第44组数据分类后为Iris-setosa类第45组数据分类后为Iris-setosa类第49组数据分类后为Iris-setosa类第53组数据分类后为Iris-versicolor类第54组数据分类后为Iris-versicolor类第55组数据分类后为Iris-versicolor类第57组数据分类后为Iris-versicolor类第58组数据分类后为Iris-versicolor类第59组数据分类后为Iris-versicolor类第60组数据分类后为Iris-versicolor类第61组数据分类后为Iris-versicolor类第62组数据分类后为Iris-versicolor类第68组数据分类后为Iris-versicolor类第70组数据分类后为Iris-versicolor类第71组数据分类后为Iris-virginica类第74组数据分类后为Iris-versicolor类第75组数据分类后为Iris-versicolor类第77组数据分类后为Iris-versicolor类第79组数据分类后为Iris-versicolor类第80组数据分类后为Iris-versicolor类第84组数据分类后为Iris-virginica类第85组数据分类后为Iris-versicolor类第92组数据分类后为Iris-versicolor类第95组数据分类后为Iris-versicolor类第97组数据分类后为Iris-versicolor类第98组数据分类后为Iris-versicolor类第99组数据分类后为Iris-versicolor类第102组数据分类后为Iris-virginica类第103组数据分类后为Iris-virginica类第105组数据分类后为Iris-virginica类第106组数据分类后为Iris-virginica类第107组数据分类后为Iris-versicolor类第108组数据分类后为Iris-virginica类第114组数据分类后为Iris-virginica类第118组数据分类后为Iris-virginica类第119组数据分类后为Iris-virginica类第124组数据分类后为Iris-virginica类第125组数据分类后为Iris-virginica类第126组数据分类后为Iris-virginica类第127组数据分类后为Iris-virginica类第128组数据分类后为Iris-virginica类第129组数据分类后为Iris-virginica类第130组数据分类后为Iris-virginica类第133组数据分类后为Iris-virginica类第135组数据分类后为Iris-virginica类第137组数据分类后为Iris-virginica类第142组数据分类后为Iris-virginica类第144组数据分类后为Iris-virginica类第148组数据分类后为Iris-virginica类第149组数据分类后为Iris-virginica类第150组数据分类后为Iris-virginica类k近邻法对wine分类:clc;otalsum=0;for ii=1:10 %循环测试10次data=load('wine.txt');%导入wine数据data1=data(1:59,1:13);%任取第一类数据的30组rbow1=randperm(59);trainsample1=data1(sort(rbow1(:,1:30)),1:13);rbow1(:,31:59)=sort(rbow1(:,31:59)); %剩余的29组按行下标大小顺序排列testsample1=data1(rbow1(:,31:59),1:13);data2=data(60:130,1:13);%任取第二类数据的35组rbow2=randperm(71);trainsample2=data2(sort(rbow2(:,1:35)),1:13);rbow2(:,36:71)=sort(rbow2(:,36:71));testsample2=data2(rbow2(:,36:71),1:13);data3=data(131:178,1:13);%任取第三类数据的24组rbow3=randperm(48);trainsample3=data3(sort(rbow3(:,1:24)),1:13);rbow3(:,25:48)=sort(rbow3(:,25:48));testsample3=data3(rbow3(:,25:48),1:13);train_sample=cat(1,trainsample1,trainsample2,trainsample3);%包含89组数据的样本集test_sample=cat(1,testsample1,testsample2,testsample3);k=19;%19近邻法newchar=zeros(1,89);sum=0;[i,j]=size(train_sample);%i=89,j=13[u,v]=size(test_sample);%u=89,v=13for x=1:ufor y=1:iresult=sqrt((test_sample(x,1)-train_sample(y,1))^2+(test_sample(x ,2)-train_sample(y,2))^2+(test_sample(x,3)-train_sample(y,3))^2+( test_sample(x,4)-train_sample(y,4))^2+(test_sample(x,5)-train_sam ple(y,5))^2+(test_sample(x,6)-train_sample(y,6))^2+(test_sample(x ,7)-train_sample(y,7))^2+(test_sample(x,8)-train_sample(y,8))^2+( test_sample(x,9)-train_sample(y,9))^2+(test_sample(x,10)-train_sa mple(y,10))^2+(test_sample(x,11)-train_sample(y,11))^2+(test_samp le(x,12)-train_sample(y,12))^2+(test_sample(x,13)-train_sample(y, 13))^2); %欧式距离newchar(1,y)=result;end;[new,Ind]=sort(newchar);class1=0;class 2=0;class 3=0;for n=1:kif Ind(1,n)<=30class 1= class 1+1;elseif Ind(1,n)>30&&Ind(1,n)<=65class 2= class 2+1;elseclass 3= class3+1;endendif class 1>= class 2&& class1>= class3m=1;elseif class2>= class1&& class2>= class3m=2;elseif class3>= class1&& class3>= class2m=3;endif x<=29disp(sprintf('第%d组数据分类后为第%d类',rbow1(:,30+x),m));elseif x>29&&x<=65disp(sprintf('第%d组数据分类后为第%d类',59+rbow2(:,x+6),m));elseif x>65&&x<=89disp(sprintf('第%d组数据分类后为第%d类',130+rbow3(:,x-41),m));endif (x<=29&&m==1)||(x>29&&x<=65&&m==2)||(x>65&&x<=89&&m==3) sum=sum+1;endenddisp(sprintf('第%d次分类识别率为%4.2f',ii,sum/89));totalsum=totalsum+(sum/89);enddisp(sprintf('10次分类平均识别率为%4.2f',totalsum/10));第2组数据分类后为第1类第4组数据分类后为第1类第5组数据分类后为第3类第6组数据分类后为第1类第8组数据分类后为第1类第10组数据分类后为第1类第11组数据分类后为第1类第14组数据分类后为第1类第16组数据分类后为第1类第19组数据分类后为第1类第20组数据分类后为第3类第21组数据分类后为第3类第22组数据分类后为第3类第26组数据分类后为第3类第27组数据分类后为第1类第28组数据分类后为第1类第30组数据分类后为第1类第33组数据分类后为第1类第36组数据分类后为第1类第37组数据分类后为第1类第43组数据分类后为第1类第44组数据分类后为第3类第45组数据分类后为第1类第46组数据分类后为第1类第49组数据分类后为第1类第54组数据分类后为第1类第56组数据分类后为第1类第57组数据分类后为第1类第60组数据分类后为第2类第61组数据分类后为第3类第63组数据分类后为第3类第65组数据分类后为第2类第66组数据分类后为第3类第67组数据分类后为第2类第71组数据分类后为第1类第72组数据分类后为第2类第74组数据分类后为第1类第76组数据分类后为第2类第77组数据分类后为第2类第79组数据分类后为第3类第81组数据分类后为第2类第82组数据分类后为第3类第83组数据分类后为第3类第84组数据分类后为第2类第86组数据分类后为第2类第87组数据分类后为第2类第88组数据分类后为第2类第93组数据分类后为第2类第96组数据分类后为第1类第98组数据分类后为第2类第99组数据分类后为第3类第102组数据分类后为第2类第104组数据分类后为第2类第105组数据分类后为第3类第106组数据分类后为第2类第110组数据分类后为第3类第113组数据分类后为第3类第114组数据分类后为第2类第115组数据分类后为第2类第116组数据分类后为第2类第118组数据分类后为第2类第122组数据分类后为第2类第123组数据分类后为第2类第124组数据分类后为第2类第133组数据分类后为第3类第134组数据分类后为第3类第135组数据分类后为第2类第136组数据分类后为第3类第140组数据分类后为第3类第142组数据分类后为第3类第144组数据分类后为第2类第145组数据分类后为第1类第146组数据分类后为第3类第148组数据分类后为第3类第149组数据分类后为第2类第152组数据分类后为第2类第157组数据分类后为第2类第159组数据分类后为第3类第161组数据分类后为第2类第162组数据分类后为第3类第163组数据分类后为第3类第164组数据分类后为第3类第165组数据分类后为第3类第167组数据分类后为第3类第168组数据分类后为第3类第173组数据分类后为第3类第174组数据分类后为第3类2.Fisher线性判别法Fisher 线性判别是统计模式识别的基本方法之一。

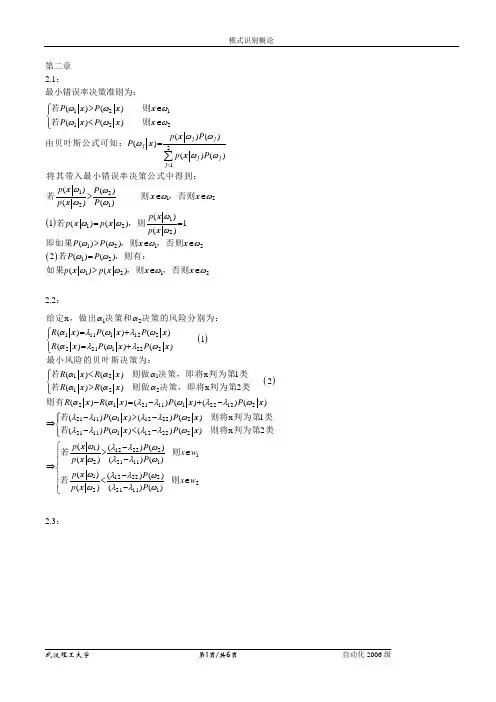

第二章 2.1:最小错误率决策准则为: ()12112221121221112212()() ()() ()()()()()()()()()()1()()1()()()j j j j j j P P P P p P P p P p P p P p p p p P P ωωωωωωωωωωωωωωωωωωωωωωω=⎧>∈⎪⎨<∈⎪⎩=>∈∈==>∑若则若则由贝叶斯公式可知:将其带入最小错误率决策公式中得到:若则,否则若,则即如果,则x x x x x x x x x x x x x x x x x ()121212122()()()()P P p p ωωωωωωωω∈∈=>∈∈,否则若,则有:如果,则,否则x x x x x x2.2:()()1211111222211222121122212111122x ()()()1()()()()() x 12()() x 2()()()()(R P P R P P R R R R R R P αααλωλωαλωλωααααααααλλωλ⎧=+⎪⎨=+⎪⎩⎧<⎪⎨>⎪⎩-=-+-给定,做出决策和决策的风险分别为:最小风险的贝叶斯决策为:若则做决策,即将判为第类若则做决策,即将判为第类则有x x x x x x x x x x x x x 122211111222221111122221122221221111112222221111)()()()()() x 1 ()()()() x 2()()()()()()()()() ()()()P P P P P p P x w p P p P x p P λωλλωλλωλλωλλωωλλωωλλωωλλωωλλω⎧->-⎪⇒⎨-<-⎪⎩->∈-⇒-<∈-若则将判为第类若则将判为第类若则若则x x x x x x x x x 2w⎧⎪⎪⎨⎪⎪⎩2.3:1111122211112111112222()()()()()()()0.9950.990.99970.9950.990.0050.05()1()0.0003()()()()()P p P P p P p P P P R P P R ωωωωωωωωωωωαααλωλωαλ=+⨯==⨯+⨯=-=<=+=阴阴阴阴阴阴阴按照最小错误率贝叶斯决策规则,结果为类,即正常人但若按最小风险决策规则,做出决策和决策的风险分别为:阴阴阴阴112221*********211112222111122221111222()()()0.99970.0003()0.99970.00030.9997()0.0003() 1 0.9997()0.0003() 2()0.000()P P R R ωλωαλλαλλλλλλλλλλλλλλ⎧⎪⎨+⎪⎩⎧=+⎪⇒⎨=+⎪⎩->-⎧⇒⎨-<-⎩>-⇒<-阴阴阴阴若则将王某判为第类若则将王某判为第类若3则将王某判为正常人则将王某判为癌症患者3.1()()()()()()()()12121212111,2222121,2,22,12121TTx g x x x x g x x x x x x x x ⎡⎤⎡⎤=-=-⎢⎥⎢⎥⎣⎦⎣⎦⎡⎤⎡⎤⎢⎥⎢⎥=-=⎢⎥⎢⎥⎢⎥⎢⎥-⎣⎦⎣⎦⎡⎤⎢⎥⎣⎦⎡⎤⎢⎥⎢⎥⎢⎥⎣⎦::为增广特征向量的特征空间为,是二维平面的特征空间为,是三维空间中一个平面3.2将样本全部化为规范化增广样本向量:()()()()()()()1234567811223(0,0,0,1),(1,0,0,1),(1,0,1,1),(1,1,0,1)(0,0,1,1),(0,1,1,1),(0,1,0,1),(1,1,1,1)00,10(1,2,2,1)1110,21(0,2,2,2)2220,T T T TT T T T T TT T T y y y y y y y y w y w w y w y w w y w y =====--=---=--=----=∴=+=---=-+=∴=+=--=-+=()()()()()()()()345532(1,2,1,3)312320,43(1,2,1,3)41320,54(1,2,2,2)TT T T Tw w y w y w w w y w w y ∴=+=--=-+=>∴==--=-=-<∴=+=--()()()()()()()()()()()()()()()()()()()()()()6778123345522220,65(1,2,2,2)6220,76(1,3,2,1)7132130,87(1,3,2,1)810,98920,109100,1110(2,3,1,2)1110,121112T TT TT TT T T TT T w y w w w y w w y w y w w w y w w w y w w w y w w y w y w w w y =+-=>∴==--=-=∴=+=--=-++-=>∴==--=>∴==>∴==∴=+=--=>∴==-()()()()()()()()()()()()()()()()()()()()5673445510,1312(2,3,2,1)1340,14131420,15141810,1918(2,3,2,1)190,2019(3,2,2,2)200,2120(3,2,3,1)21210,1,2,,8T T T T T T T T TT i w w y w y w w w y w w w y w w w y w w y w y w w y w w y i g x <∴=+=--=>∴==>∴==>∴==--=∴=+=--=∴=+=-->==满足:故此时算法收敛,12332310T w x x x x =--+=为决策面方程分界面示意图如下:3.3()()()1##0001100110111101001101110101111111111111111111111111111114210010111,1,1,1,1,1,1,1,1,1,1,0.5T TTTX X X X X X b w X b -⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥--⎢⎥---⎢⎥⎢⎥--⎢⎥----⎢⎥⎣⎦--⎡⎤⎢⎥------⎢⎥==⎢⎥------⎢⎥--⎣⎦===--增广样本矩阵为:的伪逆矩阵为:令则 3.6()12*112**11221201*02*022200210002121020,212110w w T T T T S S S w S m m m w m mw m mm y x w y w x y x w w x y x x -⎡⎤=+=⎢⎥⎣⎦⎡⎤⎢⎥⎡⎤⎡⎤=-==⎢⎥⎢⎥⎢⎥--⎣⎦⎣⎦⎢⎥⎢⎥⎣⎦====-+∴==->∈=<∈=⇒-=-⇒+= 投影向量为:则所以若则决策面方程为:4.2最近邻法与k 近邻法都是近邻分类的方法,都属于有监督的模式识别非参数方法。

人工智能的模式识别和模式匹配方法人工智能(Artificial Intelligence,AI)是一门研究如何使计算机可以像人类一样进行智能行为的学科。

其中,模式识别和模式匹配是人工智能的重要组成部分。

模式识别和模式匹配方法以其广泛的应用领域和强大的技术支持,受到了学术界和工业界的广泛关注。

模式识别是指通过对数据进行分析和处理,识别和提取出其中的模式或特征。

而模式匹配则是将一个待匹配的模式与一组已知模式进行比较,并找出最佳匹配的过程。

模式识别和模式匹配方法可以应用于图像识别、语音识别、生物医学、金融数据分析等领域,在提高效率和准确性方面发挥着重要作用。

在模式识别和模式匹配领域,最常见的方法之一是统计模式识别。

统计模式识别基于统计学原理,通过对大量样本进行统计分析,建立模型来描述和区分不同的模式。

常见的统计模式识别方法包括最近邻法、贝叶斯分类器、支持向量机等。

最近邻法是最简单和直观的方法之一,它通过计算待匹配模式与已知模式之间的距离来确定最佳匹配。

贝叶斯分类器则是一种基于贝叶斯概率理论的分类方法,通过计算待匹配模式与已知模式之间的条件概率,确定最佳分类结果。

支持向量机是一种基于最大间隔原理的分类方法,通过在特征空间中找到一个最佳超平面,将不同类别的模式分开。

除了统计模式识别方法,神经网络也是模式识别和模式匹配的常用工具。

神经网络通过模拟人脑的神经元网络,学习和提取模式中的特征。

常见的神经网络包括前馈神经网络、反馈神经网络和深度学习网络。

前馈神经网络是最简单的神经网络之一,它由一个输入层、若干个隐藏层和一个输出层组成,通过调整网络中的权重和偏置,实现对待匹配模式的识别和分类。

反馈神经网络是一种具有反馈连接的神经网络,它可以处理序列数据和动态模式。

深度学习网络则是一种多层次的神经网络结构,通过多层次的特征学习和抽象,实现对复杂模式的识别和匹配。

除了统计模式识别和神经网络,还有一些其他的模式识别和模式匹配方法。

最近邻方法是一种常见的机器学习算法,它被广泛应用于模式识别、数据挖掘和推荐系统等领域。

在这篇文章中,我们将深入探讨最近邻方法的原理、应用和局限性,以便更好地理解这一方法。

1. 最近邻方法的原理最近邻方法是一种基于实例的学习算法,它的核心思想是通过计算样本之间的距离来进行分类或回归预测。

在分类问题中,最近邻方法会找到离目标样本最近的K个训练样本,然后根据它们的类别进行投票决定目标样本的类别。

而在回归问题中,最近邻方法会找到离目标样本最近的K个训练样本,然后根据它们的值进行加权平均来预测目标样本的值。

最近邻方法的优点在于简单易懂,适用于多种类型的数据,但它也有一些局限性,比如对噪声和维度灾难敏感。

2. 最近邻方法的应用最近邻方法在各种领域都有广泛的应用。

在模式识别领域,最近邻方法常被用于人脸识别、手写字体识别等任务。

在数据挖掘领域,最近邻方法常被用于聚类分析、异常检测等任务。

在推荐系统领域,最近邻方法常被用于基于用户的协同过滤推荐算法。

这些应用充分展示了最近邻方法的灵活性和强大性。

3. 最近邻方法的局限性尽管最近邻方法有诸多优点,但它也存在一些局限性。

最近邻方法对数据中的噪声和异常值非常敏感,这会导致它在一些情况下表现不稳定。

最近邻方法在处理高维数据时会遇到维度灾难的问题,因为随着维度的增加,样本之间的距离会变得越来越稀疏,导致算法性能下降。

另外,最近邻方法在处理大规模数据时效率较低,因为需要计算目标样本与所有训练样本之间的距离。

4. 个人观点和理解从个人角度来看,我认为最近邻方法是一种简单而有效的机器学习算法,它能够基于实例进行快速学习并进行准确的预测。

然而,我们也需要认识到它的局限性,比如对噪声和维度灾难的敏感性,以及在大规模数据下的效率低下。

在实际应用中,我们可能需要结合其他方法来克服这些问题,或者对最近邻方法进行改进和优化。

总结最近邻方法是一种强大的机器学习算法,它在模式识别、数据挖掘和推荐系统等领域都有着广泛的应用。

nearestneighbors方法nearestneighbors方法是一种常用的机器学习算法,用于解决分类和回归问题。

它是一种基于实例的学习方法,通过根据已有的样本数据进行推断和预测。

本文将介绍nearestneighbors方法的原理、应用场景以及使用方法。

一、原理nearestneighbors方法是一种基于实例的学习方法,其基本思想是通过计算新样本与已有样本之间的距离,然后选取距离最近的K个样本作为其最近邻,再根据最近邻的标签进行分类或回归预测。

在分类问题中,nearestneighbors方法通过计算新样本与已有样本之间的距离,并选取距离最近的K个样本作为其最近邻。

然后,根据最近邻的标签进行投票,选择票数最多的类别作为预测结果。

在回归问题中,nearestneighbors方法通过计算新样本与已有样本之间的距离,并选取距离最近的K个样本作为其最近邻。

然后,根据最近邻的标签进行加权平均,将加权平均值作为预测结果。

二、应用场景nearestneighbors方法在实际应用中具有广泛的应用场景,如人脸识别、推荐系统、异常检测等。

在人脸识别中,nearestneighbors方法可以通过计算待识别人脸与已有人脸数据集之间的距离,选取距离最近的K个人脸作为其最近邻,然后根据最近邻的标签进行人脸识别。

在推荐系统中,nearestneighbors方法可以通过计算用户与商品之间的相似度,选取相似度最高的K个商品作为其最近邻,然后根据最近邻的评分进行商品推荐。

在异常检测中,nearestneighbors方法可以通过计算待检测样本与已有正常样本之间的距离,选取距离最近的K个样本作为其最近邻,然后根据最近邻的标签进行异常检测。

三、使用方法nearestneighbors方法在Python的机器学习库scikit-learn中有相应的实现。

下面以分类问题为例,介绍nearestneighbors方法的使用方法。

什么是计算机模式识别请解释几种常见的模式识别算法计算机模式识别是一种基于模式匹配和统计学方法,旨在从数据中自动识别和分类模式的技术。

它在图像处理、语音识别、自然语言处理、生物信息学等领域都有广泛的应用。

本文将解释计算机模式识别的定义,并介绍几种常见的模式识别算法。

一、计算机模式识别的定义计算机模式识别是指通过采集、处理、分析和理解数据,自动地从中学习和发现模式,并将其应用于模式识别和分类的过程。

它的主要目标是通过数学和统计学方法,为模式之间的相似性和差异性提供度量,并基于这些度量进行分类、识别或预测。

二、常见的模式识别算法1. K最近邻算法(K-Nearest Neighbors,简称KNN)K最近邻算法是一种简单而有效的模式分类算法。

它的基本思想是,将新的样本与已知的样本进行比较,找到其最近的K个邻居,然后根据这些邻居的类别进行分类。

KNN算法的优点是简单易懂、易于实现,但缺点是计算量大、对数据分布敏感。

2. 支持向量机(Support Vector Machine,简称SVM)支持向量机是一种常用的模式识别算法。

它的目标是找到一个超平面,将不同类别的样本分开,并使支持向量(距离超平面最近的样本点)最大化。

SVM算法的优点是可以处理高维数据、泛化能力强,但缺点是模型训练时间较长、对噪声敏感。

3. 决策树算法(Decision Tree)决策树算法是一种基于树状结构的模式识别算法。

它通过将数据集分割成不同的子集,构建决策树,并根据特征的取值来进行分类。

决策树算法的优点是可解释性强、适用于处理大规模数据,但缺点是容易过拟合、对噪声和缺失值敏感。

4. 人工神经网络(Artificial Neural Network,简称ANN)人工神经网络是一种模拟人脑神经网络结构和功能的模式识别算法。

它由多个神经元组成的层级结构,并通过学习调整神经元之间的连接权重来实现模式识别和分类。

人工神经网络的优点是适应能力强、可以处理非线性问题,但缺点是需要大量的训练样本、计算量较大。

近邻法的快速算法近邻法是一种经典的机器学习算法,用于模式识别、分类和回归问题。

它的原理是基于样本的相似度,即将一个新的样本与已有的样本进行比较,找到与之最相似的样本,并将其分类或者进行预测。

然而,传统的近邻法算法在处理大规模数据集时速度较慢,计算量较大。

随着数据量的不断增加,传统算法的效率逐渐受到限制。

为了解决这个问题,研究者们提出了一些快速近邻法算法,以提高算法的效率和准确性。

一种常见的快速近邻法算法是基于空间索引的方法,如KD树和Ball树。

这些方法将数据集按照某种规则划分成多个子空间,然后利用索引结构进行快速搜索。

例如,KD树是一种二叉树结构,每个节点代表一个样本,它通过计算样本在每个维度上的中位数来构建子空间。

Ball树则是一种基于球形区域划分的数据结构,通过计算样本集的中心和半径来构建子空间。

这些索引结构可以大大减少搜索的时间复杂度,提高算法的效率。

另一种快速近邻法算法是基于局部敏感哈希(LSH)的方法。

LSH通过将样本映射到哈希空间,并保证具有相似特征的样本映射到相同的桶中,从而实现快速检索。

LSH算法有很多种实现方式,如最常见的MinHash算法和SimHash算法。

这些算法可以在保证较高准确性的同时,大大减少计算量,提高近邻搜索的速度。

除了基于空间索引和LSH的方法,还有一些其他的快速近邻法算法。

例如,近似最近邻(ANN)算法是一种通过近似计算最近邻的方法,可以在牺牲一定的准确性的情况下大幅提高计算速度。

ANN算法包括了很多种实现方式,如Locality Sensitive Hashing(LSH)和随机投影等。

综上所述,近邻法的快速算法有多种实现方法,如基于空间索引的方法、基于LSH的方法以及近似最近邻的方法。

这些方法通过减少计算量、提高搜索速度,来实现在大规模数据集上的高效近邻搜索。

在实际应用中,根据具体问题的特点和数据集的规模,可以选择适合的快速近邻法算法来提高算法的效率和准确性。

近邻分类方法及其应用近邻分类是一种实用、有效且泛化性强的分类方法,它是由Cover 和Hart于1968年首次提出的分类算法,近年来广泛应用于机器学习,被誉为模式识别领域里最常见的算法之一。

该算法基于最近邻原则,通过基于实例的学习来自动构建类模型,其分类精度高,是实现计算机视觉的重要基础和工具之一。

近邻分类主要应用于分类任务,该算法可以用于分类数据,以确定数据属于哪一类,并能够计算数据中的每个点的概率。

它主要利用最近邻原则,即距离最近的k个点决定了一个点的分类结果,因此它属于基于实例学习的有监督学习算法,即在分类前,算法先要学习分类样本,才能完成分类。

近邻分类算法的工作原理非常简单,根据距离度量基于空间原理,该算法可以计算待判定样本和样本库中已有样本的距离,距离最近的k个样本最为重要,根据和k个样本的距离可以推断出待判定样本的分类结果,即k个样本中类别数量最多的类别就是待分类结果。

近邻分类算法的应用广泛,其具有较高的普遍性和实用性,能够处理多维的数据特征,因此在计算机视觉和模式识别领域有着广泛的应用场景。

近邻分类算法在实际应用中有很多变形,如K近邻算法、W欧氏距离计算法、P-近邻算法等,它们都具有同样的应用原理,但是每种算法的具体策略与实际应用有关,在实际应用中的效果也不尽相同。

K近邻算法是近邻分类算法的最常用形式,它由Cover和Hart于1968年首次提出,是属于基于实例学习的分类器,其特点是实现简单,分类效果好,但是存在计算量大,识别精度低的缺点,其主要思想是根据输入待分类样本和训练样本之间的距离,将最接近待分类样本的K个训练样本预先存储下来,根据K个训练样本中出现最多的类别来确定待分类样本的类别,从而达到识别的目的。

K近邻算法的参数外设是非常重要的,其中最关键的就是K值的外设,K值的大小决定了待分类样本被最接近的K个样本的数量,从而直接影响算法的识别精度,因此选择K值时要根据训练样本数据特点,如数据分布情况、特征数量、密度等来判断,以保证算法的最佳性能。