机器人视觉大作业

- 格式:docx

- 大小:386.31 KB

- 文档页数:9

高空作业机器人的机器视觉技术研究高空作业机器人是一种能够在高空环境中完成各种任务的机器人系统。

机器视觉技术在高空作业机器人中起着至关重要的作用。

它能够为机器人提供靶标识别、路径规划、障碍物检测等功能,从而实现更安全、更高效的高空作业。

一、高空作业机器人的应用领域和需求高空作业机器人广泛应用于建筑、电力、航空等领域。

在这些领域中,高空作业往往需要人工登高、悬挂等特殊环境下进行。

由于高空作业的高度、风力等因素对人的安全造成了巨大的威胁,因此开发一种能够代替人工进行高空作业的机器人系统具有重要的意义。

高空作业机器人需要具备稳定性、高精度、高效率等特点,而这些特点可以通过机器视觉技术来实现。

二、高空作业机器人的机器视觉技术研究进展1. 靶标识别技术高空作业机器人在进行作业时,往往需要对特定靶标进行识别。

通过机器视觉技术,可以实现对靶标的自动识别和定位。

传统的方法常常使用特定颜色或形状的标志物作为靶标,通过图像处理算法进行识别。

近年来,深度学习技术的发展使得机器视觉在靶标识别上取得了突破性进展。

通过训练神经网络,高空作业机器人可以准确、快速地识别靶标,实现自动化的高空定位。

2. 路径规划技术高空作业机器人在进行作业时,需要根据任务要求规划合理的路径。

机器视觉技术可以实现对高空作业环境的感知和建模,从而为机器人提供路线规划的信息。

传统的方法使用激光雷达、摄像头等传感器对环境进行感知,根据建模结果进行路径规划。

近年来,随着视觉SLAM和深度学习技术的发展,高空作业机器人可以通过摄像头获取环境图像,结合传感器数据进行环境建模,从而实现更精确的路径规划。

3. 障碍物检测技术在高空作业环境中,障碍物的检测对于保障机器人和工作人员的安全至关重要。

机器视觉技术可以通过对高空环境图像的处理和分析,检测出潜在的障碍物。

传统的方法使用形态学滤波、边缘检测等算法进行障碍物检测,但存在灵敏度低、误检率高的问题。

深度学习技术的应用可以解决这些问题,通过训练神经网络,机器人可以准确地检测出各种障碍物,避免发生事故。

大工20秋《生产实习(人工智能专业)》大作业及要求一、背景介绍《生产实(人工智能专业)》是大工20秋学期的一门重要课程,旨在帮助学生将所学知识应用到实际生产中。

本课程将为学生提供一个机会,通过完成大作业来展示他们在人工智能领域的能力和实践经验。

二、大作业要求大作业的主要目的是让学生能够综合运用所学的人工智能知识,解决实际问题并提出创新性的解决方案。

具体要求如下:1. 选择一个与人工智能相关的实际问题或挑战,并提出明确的研究目标和问题陈述。

2. 设计和实施一个合适的人工智能算法和模型来解决所选择的问题。

学生可以使用现有的开源框架或自行开发算法。

但请确保学术诚信,不得抄袭他人成果。

3. 收集和整理相关的数据集,并对数据进行预处理和分析。

确保数据集的合法性和准确性。

4. 设计一个实验方案,验证所提出的算法和模型的有效性和性能。

合理选择评价指标,并进行实验结果的分析和讨论。

5. 撰写一份详细的实报告,并呈现在实践展示会上。

报告需要包含问题陈述、算法设计、数据处理和分析、实验设计和结果分析等内容。

三、评分标准大作业将根据以下标准进行评分:1. 问题的挑战性和创新性:是否选择了一个具有一定难度和挑战性的问题,并提出了创新的解决方案。

2. 算法和模型的设计和实现:算法和模型是否合理且有效地解决了问题,是否使用了合适的数据集和评价指标。

3. 数据处理和分析:是否正确地收集、整理和预处理了数据,并对数据进行了合理的分析。

4. 实验设计和结果分析:实验方案是否严谨,结果是否具有说服力,分析是否深入。

5. 实报告和实践展示:报告是否完整、详细,并能清晰地表达研究过程和结果,展示会演示是否准备充分并能回答问题。

四、提交要求大作业的提交包括以下内容:1. 一份完整的实报告,包含问题陈述、算法设计、数据处理和分析、实验设计和结果分析等内容。

2. 代码实现和相关文档。

3. 选定的实际问题的相关背景介绍和数据集说明。

请在规定时间内将大作业提交到指定的邮箱或平台,并按照要求命名文件和邮件主题。

《机器人技术基础》大作业题目:班级:姓名:成绩:一、机器人功能描述(200字)具有供人观赏,娱乐为目的,具有机器人的外部特征,也可以像人,像某种动物等。

同时具有机器人的功能,可以行走或完成动作,有语言能力,会唱歌,有一定的感知能力,可以自主的连续表演事先编好的多套动作。

二、机器人系统的功能构成(框图+文字说明)驱动:电动传动机械结构系统:感受系统:智能传感器基本思路:通过对人类动作的深入了解,分析人类的动作特性,并且与控制对象跳舞机器人的工作原理、动作过程进行比较,从而确定机器人的基本构成并选择合适的机械构件,组装完成机器人的造型。

分析机器人动作的局限性与优势,设定机器人的舞蹈动作,按动作编写程序,完成作品设计。

跳舞机器人的结构完全模仿真人,并实现了双腿分立走路,双臂有很强的自由度,可以完成多种高难度动作。

机器人的双脚为轮式结构,这样不仅可以实现转身和滑步,更突出的优点是在走路时减少了重心的调整,从而减少了机器人的倾斜度,实现了类似真人的走路及跳舞模式。

舞蹈机器人的控制方式是将uC/OS-Ⅱ操作系统嵌入Atmega128处理器中,采用PID算法,对电机、舵机进行实时可靠的控制,进而对机器人主动轮的速度、方向进行有效的控制,使机器人的动作定位更加准确,动作过程更加优美协调。

机器人的双脚为轮式结构,此结构可以很完美地实现转身和滑步。

更突出的优点是在走路时减少了重心的调整,同时也克服了塑料构件机械强度不够高的局限性。

跳舞机器人完全实现了智能化运行,可以用相应软件通过编程实现对舵机的控制,做出各种不同的动作,带给人们另类娱乐。

它可以走进各种不同的场合,如:在学校用于科技教育学习;在家庭用于提供丰富的生活享受;用于社会可以增加更多的新型娱乐项目等。

随着社会对服务业的需求不断扩大,可以代替人的机器人将会有更广阔的前景从近几年世界范围内推出的机器人产品来看,机器人技术正在向智能化、模块化和系统化的方向发展。

其发展趋势主要为:结构的模块化和可重构化;控制技术的的开放化;PC化和网络化;伺服驱动技术的数字化和分散化。

人工智能大作业(一)引言:人工智能(Artificial Intelligence,简称AI)是近年来备受关注的热门领域。

随着计算能力的提高和算法的进步,人工智能正在日益渗透到各个行业和领域中。

本文将探讨人工智能大作业的相关内容,着重分析了其中的五个重要方面。

正文:一、机器学习(Machine Learning)1.1 监督学习(Supervised Learning)的基本概念及示例1.2 无监督学习(Unsupervised Learning)的基本概念及应用领域1.3 强化学习(Reinforcement Learning)的基本原理和算法1.4 深度学习(Deep Learning)的基本结构和典型应用1.5 机器学习在人工智能大作业中的实践与挑战二、自然语言处理(Natural Language Processing)2.1 词法分析和语法分析的基本原理和任务2.2 语义分析和语义关系的理论基础和实践应用2.3 文本分类和情感分析的相关技术和方法2.4 机器翻译和语音识别的高级应用和发展趋势2.5 自然语言处理在人工智能大作业中的应用与挑战三、计算机视觉(Computer Vision)3.1 图像处理和特征提取的基本原理和方法3.2 目标检测和图像识别的常用算法和技术3.3 图像分割和场景理解的相关研究和实践3.4 视频分析和行为识别的进展和应用领域3.5 计算机视觉在人工智能大作业中的应用案例和前景展望四、数据挖掘(Data Mining)4.1 数据预处理和数据清洗的基础知识和常用技术4.2 数据集成和数据转换的数据挖掘流程和方法4.3 关联规则和聚类分析的基本概念和算法4.4 分类和预测分析的实践案例和评价指标4.5 数据挖掘在人工智能大作业中的应用与发展趋势五、智能决策系统(Intelligent Decision System)5.1 知识表示和推理的基本方法和知识表示语言5.2 不确定性建模和决策制定的技术和策略5.3 专家系统和推荐系统的典型特征和实现方法5.4 异常检测和智能优化的相关研究和应用5.5 智能决策系统在人工智能大作业中的实践案例和展望总结:人工智能大作业(一)涵盖了机器学习、自然语言处理、计算机视觉、数据挖掘和智能决策系统等五个重要方面。

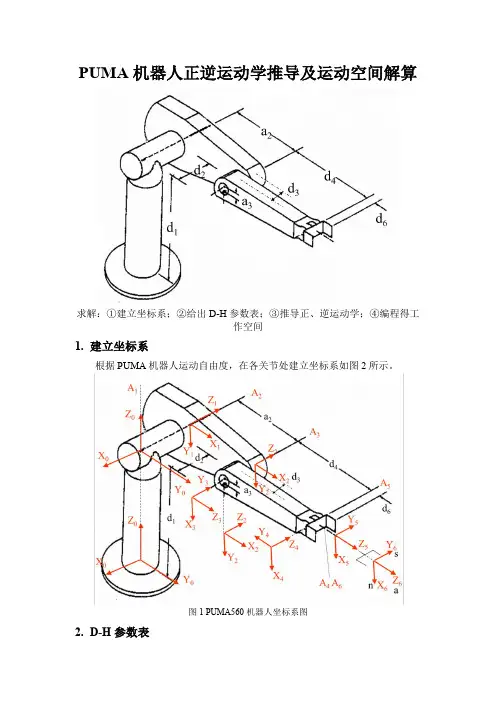

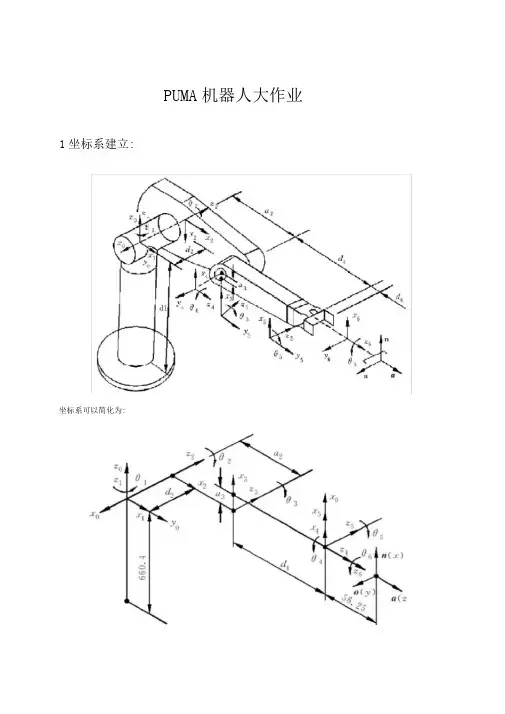

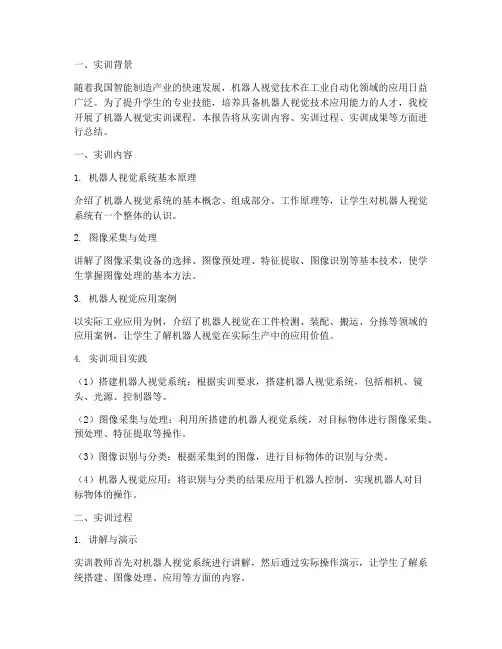

PUMA机器人正逆运动学推导及运动空间解算求解:①建立坐标系;②给出D-H参数表;③推导正、逆运动学;④编程得工作空间1.建立坐标系根据PUMA机器人运动自由度,在各关节处建立坐标系如图2所示。

图1 PUMA560机器人坐标系图2.D-H参数表D-H 参数表可根据坐标系设定而得出,见表1。

(1)i θ为绕1i Z -轴从1i X -到i X 的角度; (2)1i α-为绕i X 轴从1i Z -到i Z 的角度;(3)1i a -为沿i X 轴从1i Z -与i X 交点到i O 的距离; (4)i d 为沿1i Z -轴从1i Z -与i X 交点到1i O -的距离。

表1 PUMA 机器人的杆件参数表3. 正运动学推导由坐标系图及各杆件参数可得个连杆变换矩阵。

111101000001100001c s s c T θθθθ-⎡⎤⎢⎥⎢⎥=⎢⎥-⎢⎥⎣⎦ 22222222122000010001c s c a s c s a T d θθθθθθ-⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦3333333323000100001c s c a s c s a T θθθθθθ-⎡⎤⎢⎥--⎢⎥=⎢⎥⎢⎥⎣⎦ 444434400000100001c s s c T d θθθθ-⎡⎤⎢⎥⎢⎥=⎢⎥-⎢⎥⎣⎦5555450000010001c s s c T θθθθ⎡⎤⎢⎥-⎢⎥=⎢⎥⎢⎥⎣⎦ 66665660000001001c s s c T d θθθθ-⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦根据各连杆变换矩阵相乘,可以得到PUMA560的机械手变换矩阵,其矩阵为关节变量的函数。

()()()()()()00123456112233445566T T T T T T T θθθθθθ=将上述变换矩阵逐个依次相乘可以得到06T 。

601x x x x yy y y z z z z n o a p n o a p T n o a p ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦()()()()()()()()6514142315236411234651442311523614231446236235452365141423152364112346514423115236x y z x y n c c s s c c c c s s s c s c c s n c c c s c c s s s s s c c c s s n s s s c c s c c s o s c s s c c c c s s c c s c c s o s c c s c c s s s s c =--+-+⎡⎤⎣⎦=+-+-⎡⎤⎣⎦=-+=-+-+⎡⎤⎣⎦=-+-+⎡⎤⎣⎦()()()()()()()()142314623545236423152351414235123514423152345231223232165141423152314231223231265144231z x y z x y c c c s s o s c s c c s c s s a c c s s s s c c c a c s s s c s c c s a a c c s s p c a c a c d s d s s s c c c c c s c d s p s a c a c c d d s c s c c s c -=++=--=++=-=-----+⎡⎤⎣⎦=-++++()512341232342232365234523z s s d s s p c d a s a s d c c c s s ⎫⎪⎪⎪⎪⎪⎪⎪⎪⎪⎪⎬⎪⎪⎪⎪⎪⎪⎪⎪+⎡⎤⎣⎦⎪=-++-⎪⎭上式中()()23232323cos ,sin c s θθθθ=+=+。

机器人视觉系统设计作业指导书一、引言机器人视觉系统是指通过摄像头或其他图像采集设备获取环境中的影像信息,并通过图像处理和分析算法,从中提取出实时的、有用的图像特征用于机器人的感知与决策。

本作业指导书旨在帮助学生了解机器人视觉系统的设计原理和方法,并指导他们完成相关的作业任务。

二、背景知识在开始设计机器人视觉系统之前,学生需要对以下背景知识有所了解:1. 机器人的感知和定位技术;2. 图像采集设备的原理和类型;3. 图像处理与分析的基本概念;4. 常见的计算机视觉算法和库。

三、作业任务1. 确定项目需求:学生需要确定机器人视觉系统的具体应用场景和功能需求。

例如,机器人导航、目标检测或人脸识别等。

在此基础上,设计系统的整体框架。

2. 图像采集与传输:学生需要选择合适的图像采集设备,并了解其工作原理和技术参数。

在此基础上,完成图像采集和传输的模块设计,并实现图像数据的传递和接收。

3. 图像处理与分析:学生需要学习并运用适当的图像处理算法,如边缘检测、特征点提取等。

根据项目需求,设计并实现相应的图像处理和分析模块。

4. 目标检测与跟踪:学生需要了解目标检测与跟踪的基本原理和方法。

选择适当的目标检测算法,并根据项目需求完成目标检测和跟踪模块的设计与实现。

5. 系统集成与测试:将以上所有模块进行集成,并测试系统的功能和性能。

根据测试结果,优化系统设计,并解决可能出现的问题。

6. 文档撰写:学生需要按照规定的格式,编写系统设计报告。

报告内容包括项目需求、系统设计、算法原理、实验结果和总结等。

四、作业要求1. 学生需要独立完成作业,并在规定时间内提交设计报告和相关源代码。

2. 学生需要使用合适的编程语言和开发工具,如Python、OpenCV 等。

3. 学生需要保证设计的系统能够良好运行,并在报告中说明系统的功能和性能。

4. 报告中需要包含详细的算法原理和实验结果,以及对系统存在问题的分析和改进方法。

五、评分标准根据学生的作业报告和代码,评分标准如下:1. 报告完整度:包括项目需求描述、系统设计、算法原理、实验结果等。

实习报告实习岗位:机器人视觉识别工程师实习单位:XX科技有限公司实习时间:2021年6月1日至2021年8月31日一、实习背景及目的随着科技的飞速发展,人工智能和机器人技术得到了广泛的关注和应用。

作为人工智能的重要组成部分,机器视觉识别技术在工业生产、物流运输、医疗保健等领域发挥着重要作用。

本次实习旨在通过在XX科技有限公司的机器人视觉识别岗位实习,了解并掌握机器视觉识别技术的原理和应用,提高自己的实际工作能力和专业技能。

二、实习内容及收获1. 实习内容(1)参与公司机器人视觉识别项目的开发和实施,包括图像采集、处理和分析等环节。

(2)学习和应用各种机器视觉算法,如特征提取、目标识别和跟踪等。

(3)与团队成员合作,进行机器视觉系统的调试和优化,提高系统的准确性和稳定性。

(4)参与项目讨论和技术交流,分享经验和心得,提升自身技术水平。

2. 实习收获(1)掌握了机器视觉识别技术的基本原理和常用算法,如YOLO、SSD、Faster R-CNN等。

(2)学会了使用OpenCV、TensorFlow、PyTorch等开源工具和框架进行机器视觉项目的开发和实施。

(3)通过实际项目的操作,提高了自己的问题解决能力和团队合作能力。

(4)了解了机器人视觉识别技术在工业生产、物流运输等领域的应用和挑战。

三、实习总结与展望通过为期三个月的实习,我深刻体会到了机器视觉识别技术在实际应用中的重要性和挑战。

在实习过程中,我学到了很多专业知识和技能,也锻炼了自己的团队合作和沟通能力。

同时,我也认识到自己在某些方面还存在不足,需要继续努力学习和提高。

展望未来,我相信机器人视觉识别技术将在人工智能领域发挥更大的作用。

作为一名机器人视觉识别工程师,我将不断学习和探索新的技术,为我国机器人视觉识别技术的发展贡献自己的力量。

同时,我也希望能够有更多的机会和平台,与同行们共同交流和进步,共同推动人工智能技术的发展。

最后,感谢XX科技有限公司给我提供的实习机会和指导,感谢实习期间同事们的帮助和支持。

一、引言随着科技的飞速发展,机器人技术逐渐成为工业自动化领域的重要分支。

机器人视觉系统作为机器人感知外界环境的关键技术,其在工业生产、物流搬运、医疗辅助等领域的应用日益广泛。

为了深入了解机器人视觉系统的原理与应用,我们进行了为期一周的实训,以下是对本次实训的总结报告。

二、实训目的与内容1. 实训目的(1)掌握机器人视觉系统的基本原理和组成;(2)熟悉机器视觉软件的操作和图像处理方法;(3)了解机器人视觉系统的应用场景和案例;(4)培养动手实践能力和团队协作精神。

2. 实训内容(1)机器人视觉系统基本原理:学习机器人视觉系统的组成、工作原理和常用算法;(2)机器视觉软件操作:掌握机器视觉软件的使用方法,包括图像采集、处理、特征提取等;(3)图像处理方法:学习图像处理的基本方法,如滤波、边缘检测、形态学操作等;(4)机器人视觉系统应用案例:了解机器人视觉系统在工业生产、物流搬运、医疗辅助等领域的应用案例;(5)动手实践:通过搭建机器人视觉系统,进行图像采集、处理、特征提取等操作,实现机器人视觉系统的基本功能。

三、实训过程1. 实训环境本次实训在XXX实验室进行,实验室配备了机器人视觉系统实训平台,包括工业机器人、视觉检测系统、基础工作台、PC平台等。

2. 实训步骤(1)熟悉实验室环境和设备,了解机器人视觉系统实训平台的结构和功能;(2)学习机器人视觉系统的基本原理,包括组成、工作原理和常用算法;(3)学习机器视觉软件的使用方法,包括图像采集、处理、特征提取等;(4)学习图像处理的基本方法,如滤波、边缘检测、形态学操作等;(5)搭建机器人视觉系统,进行图像采集、处理、特征提取等操作;(6)测试机器人视觉系统的基本功能,如物体识别、定位、跟踪等;(7)分析实验结果,总结实训经验。

四、实训成果通过本次实训,我们取得了以下成果:(1)掌握了机器人视觉系统的基本原理和组成;(2)熟悉了机器视觉软件的操作和图像处理方法;(3)了解了机器人视觉系统的应用场景和案例;(4)培养了动手实践能力和团队协作精神。

1坐标系建立:PUMA机器人大作业坐标系可以简化为:2 D-H参数表:PUMA机器人的杆件参数d10.6604m , d20.14909m , d40.43307m , d60.05625m , a20.4318m a30.02032m3正运动学推导c i s i 0 a 1,,i i S i C i 1 C i C i 1 s i 1 d i s i 1由式T i可得s i s i 1 c i s i 1 C i 1 d i C i 10 0 0 1c 1 s 1 0 0c 20 s1 c10 01 0T 1T20 0 1 02s20 1,c4 s40 a3 c5 3T1 d4 4 0T4s4c4T 55s50 0 0 1,T 6 0T 11T 22T 3 3T 4 4T 5 5T 6s20 0c 3s 3 0a20 1d2 2 s3 c3c2T 30 0 10 01,1s50 0 c6s60 0 01 051 05T 6c56s6c60 0 0 0 1,0 1机械手变换矩阵4 逆运动学推导1 .求 1用逆变换0T i 1左乘方程 %T i 工2T 3 3T 4 4T 5 5T 6两边:n x o xa x p xT 6n y o y a y p y n z o z a z p z 0001nx c23 ( c 6 c 5 c 4 c 1 s6s 4c 1 ) s 23c 6s 5c 1c6c 5 s 4 s1 n yc23 (c6 c5 c4 s1s6 s4 s1)s23 c 6 s 5 s 1c 6c5s 4c1nz s 23(c 6c 5c4s 6s4) c23c 6s5ox c23(s 6c 5c 4c 1 c6s 4c 1) s23s 6s 5c 1s6c 5s 4s1 oyc23(s 6c5c 4s1c6s4s 1) s23s 6s 5s1s6s4c 5c1oz s23(s 6c 5c4s6s 4) c23c 6s5ax c23 s 5c 4 c 1 s23c 5c 1 s 5s4s1ay c23s5c 4s1 s23c5s1s5s 4c1azc23c5s2 3 s5c4p x a 3c 23c 1 a 2c 2c 1 d 4 s 23c 1 d 2s 1p y a 3c 23s 1 a 2 c 2 s 1 d 4 s 23s 1 d 2c 1pzd 4c23a3s 23a 2s2s6 c 4 s1 s6c4c1c6c 4s1 c6c4c1矩阵方程两端的元素1 , 4)和(2, 4)分别对应相等G P x S P ya 3C23a 2C2d4 S23P zd 4C 23a 3S23 a 2S 2 10T 6其中kT i 10T 6得到1的解1atan2(p y ,p x ) atan2(d 2, 届p : d ;)2 •求3平方和为:d4 S 3a3C32 2 2,2 ,2 2 2P x P y P z d 2 d 4 a 2 a 32a 2解得: 3 atan2(a 3,d 4) atan2(k, _d : a f k 2)C1C 23S1C 23S23a2C3n xO x a x P xC| S 23Si S 23C 23 a 2S 3nyO y ayPy 3T 6S iC 1 0d 2 n z O z a z P z 00 10 01C i S iS! 0 0 C i 0 0 0 0 1 0 0 00 1 n x O x a x得 S i P x C|P y 三角代换 P x式中,nyn z 0 O yO z 0 aya z0 P x P y P z1d 2cos ,P ysi n 2 2-P x P yatan2(P x , P y )方程两边的元素( 1 , 4) 和(3 , 4) 分别对应相等,得C 1C 23P: x 4 5I C 23 P yS23 Pza3a 2C3C l S23P 〉<SI S23 PyC23Pza 2S3d 4联立,得S23 和 C23Qa 2Ss d 4 GP xSP yP z a ?C 3 a 323P x C 1 2P y S 12P za 2C3a3GP x S 1P yP z a 2S3d 423P x C 1 2P y S 12P zS 23和C 23表达式的分母相等,且为正,于是4 •求4令两边元素(1 , 3)和(2, 3)分别对应相等,则可得C 1C 23axS l C 23a y S 23a z C 4S5S| a x GR y S 4S 5只要S s 0 ,便可求出 44ata n2 sa x c i a y , c i C 23a x Si C 23a y S 23a z当S S 0时,机械手处于奇异形位。

一、实训背景随着我国智能制造产业的快速发展,机器人视觉技术在工业自动化领域的应用日益广泛。

为了提升学生的专业技能,培养具备机器人视觉技术应用能力的人才,我校开展了机器人视觉实训课程。

本报告将从实训内容、实训过程、实训成果等方面进行总结。

一、实训内容1. 机器人视觉系统基本原理介绍了机器人视觉系统的基本概念、组成部分、工作原理等,让学生对机器人视觉系统有一个整体的认识。

2. 图像采集与处理讲解了图像采集设备的选择、图像预处理、特征提取、图像识别等基本技术,使学生掌握图像处理的基本方法。

3. 机器人视觉应用案例以实际工业应用为例,介绍了机器人视觉在工件检测、装配、搬运、分拣等领域的应用案例,让学生了解机器人视觉在实际生产中的应用价值。

4. 实训项目实践(1)搭建机器人视觉系统:根据实训要求,搭建机器人视觉系统,包括相机、镜头、光源、控制器等。

(2)图像采集与处理:利用所搭建的机器人视觉系统,对目标物体进行图像采集、预处理、特征提取等操作。

(3)图像识别与分类:根据采集到的图像,进行目标物体的识别与分类。

(4)机器人视觉应用:将识别与分类的结果应用于机器人控制,实现机器人对目标物体的操作。

二、实训过程1. 讲解与演示实训教师首先对机器人视觉系统进行讲解,然后通过实际操作演示,让学生了解系统搭建、图像处理、应用等方面的内容。

2. 学生分组实践将学生分成若干小组,每组负责完成一个实训项目。

在实训过程中,教师进行现场指导,解答学生遇到的问题。

3. 交流与讨论实训过程中,各小组之间进行交流与讨论,分享经验、互相学习,共同提高。

4. 作品展示与评审实训结束后,各小组展示自己的作品,并接受教师评审。

教师根据作品质量、团队合作等方面进行评分。

三、实训成果1. 学生掌握了机器人视觉系统基本原理,能够搭建简单的机器人视觉系统。

2. 学生熟悉了图像采集、处理、识别等基本技术,能够对图像进行处理和分析。

3. 学生了解了机器人视觉在实际生产中的应用案例,提高了对机器人视觉技术的认识。

机器人视觉操作方法

机器人视觉操作方法通常包括以下步骤:

1. 相机校准:机器人视觉操作前必须进行相机校准,确保相机位置、焦距和畸变等参数正确。

校准通常需要使用特定的软件和标定板。

2. 物体检测和识别:机器人需要检测和识别要操作的物体,通常使用深度学习等技术来进行图像分析和处理,以获取目标物体的位置和特征信息。

3. 姿态估计和路径规划:根据目标物体的位置和特征信息,机器人需要进行姿态估计和路径规划,确定操作路径和姿态。

4. 操作执行:机器人根据规划好的路径和姿态,进行相应的操作,包括抓取、放置、拧紧等各种动作。

操作执行通常需要使用机器人控制软件和相关硬件设备。

5. 操作反馈和优化:机器人完成操作后,需要进行反馈和优化,例如检查操作结果是否正确、优化操作路径和姿态等。

这一步通常需要使用传感器和相应的算法来实现。

大模型在机器人视觉中的应用

大模型在机器人视觉中的应用非常广泛。

随着深度学习技术的发展,大模型已经成为机器人视觉领域的关键技术之一。

大模型通过大量的数据训练,可以学习到各种复杂的特征和模式,从而提升机器人对图像的识别和理解能力。

在机器人视觉中,大模型主要应用于以下几个方面:

1. 目标检测和识别:大模型可以通过训练学习识别不同类型的物体,包括人、物体、人脸等。

在机器人视觉中,目标检测和识别是实现机器人自主导航、交互等的关键技术。

2. 场景理解:大模型可以对图像中的场景进行理解和分类,从而帮助机器人更好地理解周围环境。

例如,机器人可以通过对不同场景的分类,实现自主导航、智能巡航等功能。

3. 图像生成和增强:大模型可以通过生成对抗网络(GAN)等技术生成高

质量的图像,从而增强机器人的感知能力。

例如,机器人可以通过生成人脸图像,实现人脸识别等功能。

4. 姿态估计和动作预测:大模型可以对图像中的姿态进行估计,预测人体的动作和行为,从而帮助机器人更好地与人类交互。

例如,机器人可以通过对人类手势的识别和理解,实现手势控制等功能。

总之,大模型在机器人视觉中的应用非常广泛,可以提升机器人的感知和理解能力,从而使其更好地适应各种复杂的环境和任务。

随着深度学习技术的不断发展,大模型在机器人视觉领域的应用前景将更加广阔。

一、引言随着工业自动化和智能制造的快速发展,工业机器人已成为现代制造业的重要装备。

机器人视觉分拣技术作为机器人技术的重要组成部分,在提高生产效率、降低成本、保证产品质量等方面发挥着越来越重要的作用。

本实训报告主要针对机器人视觉分拣技术进行实践操作,通过搭建实验平台,完成工件分拣任务,并对实验过程进行分析和总结。

二、实验目的1. 了解机器人视觉分拣系统的基本原理和组成;2. 掌握机器人视觉分拣系统的搭建方法;3. 熟悉机器人视觉分拣软件的操作;4. 提高机器人视觉分拣系统的应用能力。

三、实验原理机器人视觉分拣系统主要由以下几个部分组成:1. 成像系统:包括工业相机、镜头、光源等,用于采集工件图像;2. 图像处理系统:包括图像预处理、特征提取、目标识别等,用于对采集到的图像进行处理和分析;3. 控制系统:包括机器人控制器、视觉控制器等,用于控制机器人执行分拣任务;4. 执行机构:包括机械臂、分拣机构等,用于完成分拣动作。

实验过程中,机器人视觉系统首先通过工业相机采集工件图像,然后对图像进行预处理,提取工件特征,并进行目标识别。

识别出目标后,控制系统根据目标位置和姿态信息,控制机械臂执行分拣动作。

四、实验平台本次实验平台采用创拓科技CT500工业机器人视觉实训系统,该系统包括以下设备:1. 6轴工业机器人:具有6个自由度,可完成复杂的分拣任务;2. 视觉检测系统:包括工业相机、镜头、光源、视觉控制器等;3. 基础工作台:用于放置待分拣工件;4. PC平台:用于运行视觉分拣软件;5. 分拣机构:用于完成分拣动作。

五、实验步骤1. 系统搭建:将工业相机、镜头、光源、视觉控制器等设备连接到PC平台上,搭建视觉检测系统;2. 软件安装与配置:安装机器人视觉分拣软件,配置相关参数;3. 图像采集:将待分拣工件放置在基础工作台上,通过工业相机采集工件图像;4. 图像处理:对采集到的图像进行预处理、特征提取、目标识别等操作;5. 分拣任务分配:根据识别出的目标位置和姿态信息,控制机械臂执行分拣动作;6. 实验结果分析:对实验结果进行分析,评估机器人视觉分拣系统的性能。

我设计的机器人小学四年级作文在我们班上,有一个特别厉害的小朋友,他叫小明。

哎呀,这小子可真是个小机灵鬼,聪明得不得了,而且还特别喜欢搞那些新奇的东西。

有一次,老师给我们布置了一个超级有趣的作业:设计一个能帮我们做功课的机器人!嗯,听起来有点像科幻片里的情节,但其实挺刺激的!小明就像发现了新大陆一样,眼睛一亮,开始了他的大作业。

首先,他把爸爸的旧掃地機器人从储藏室里拿了出来,嘿,那玩意可是会自己跑来跑去的呀!不过,小明想要的可不只是一个会扫地的机器人,他可是有大抱负的,想着怎么能让它变得更牛逼些。

于是,他拿着电动玩具的遥控器,决定先给这机器人加上一点“智慧”。

他把自己的平板电脑用数据线插进了机器人的脑袋,一顿设置操作之后,老掃地機器人顿时变得不一样了!它不仅会自己扫地,还能听懂小明说的话,对吧,简直就是变身了。

接下来,小明又琢磨了一番,说“哎呀,光是扫地可不够好玩,我们还能让它帮我们背书呢!”于是他在机器人的背上绑上了一个大大的书包,把书一本本地塞了进去。

看到那机器人屁颠屁颠地像只背书包的小驴子一样,我们都笑得合不拢嘴。

不过,问题也随之而来。

有一天,小明的机器人在帮我们做功课的时候,突然停住了。

我们一群小家伙围在机器人身边,发现它像是生病了一样,啥动静都没有。

小明急得跳脚,“它怎么了?难道是它累坏了?”我想,或许它真的累了吧,毕竟天天帮我们扫地背书,这个机器人也是有点承受不住了。

不过,小明可是个聪明的孩子,他马上就发现了问题的所在。

原来,是机器人的电池没电了!这下好办,小明又一边跳脚一边找来了电池充电器,不一会儿,机器人又活蹦乱跳地继续干活了。

我们都感慨,这个机器人虽然有时候会有点“小毛病”,但是它帮我们省了不少力气,有时候还挺有趣的。

最后,小明决定给这个机器人取个名字叫“小助手”,因为它不仅仅是个机器人,更像是我们的小帮手。

每次看到它在忙忙碌碌地工作,我们都觉得特别有成就感,毕竟这是我们自己设计的“小助手”呀!嗯,这件事情让我们学到了不少东西。

20秋大工人工智能课程大作业一、项目背景随着人工智能技术的快速发展,在我国高等教育中,人工智能课程的地位日益凸显。

为了让学生更好地掌握人工智能的基本理论、方法和技术,提高其实践能力,我校开设了20秋季人工智能课程。

本课程的大作业旨在让学生将所学知识应用到实际问题中,培养其解决复杂问题的能力。

二、项目要求1. 学生需在指导下,独立完成一个与人工智能相关的研究项目。

2. 项目需涉及人工智能的基本理论、方法和技术,如机器学习、深度学习、自然语言处理等。

3. 项目应具有实际应用价值,能够解决某一具体问题。

4. 项目需提交详细的研究报告,包括项目背景、研究方法、实验结果和结论等。

三、项目评分标准1. 项目选题:是否有实际应用价值,是否涉及人工智能的基本理论、方法和技术(20%)2. 研究方法:是否合理运用了相关理论和方法,是否充分考虑了实验条件(30%)3. 实验结果:是否取得了预期的效果,是否对结果进行了合理的分析(30%)4. 报告撰写:报告结构是否清晰,论述是否合理,表达能力如何(20%)四、项目时间表1. 项目启动:2020年9月30日2. 项目中期检查:2020年11月30日3. 项目结题:2020年12月31日五、项目支持1. 教师指导:教师将提供必要的学术支持,解答学生疑问,指导项目完成。

2. 资源保障:学校将提供实验室、计算资源等支持,确保项目顺利进行。

六、项目预期成果通过本课程大作业,学生将能够:1. 掌握人工智能的基本理论、方法和技术。

2. 提高解决实际问题的能力。

3. 培养团队合作、创新和沟通能力。

七、项目疑问及反馈如有疑问,请及时与指导教师沟通。

我们将及时解答您的疑问,确保项目的顺利进行。

{content}。

机器人触觉传感器概况姓名:徐乾荣学号:1402311.1背景介绍触觉是人与外界环境直接接触时的重要感觉功能,研制满足要求的触觉传感器是机器人发展中的技术关键之一。

随着微电子技术的发展和各种有机材料的出现,已经提出了多种多样的触觉传感器的研制方案,但目前大都属于实验室阶段,达到产品化的不多。

现代工业的高度自动化以及电子工业的迅猛发展,使得机器人在各领域的应用更加广泛和深入。

实现机器人智能化的关键是模拟人类五官感知功能的传感器的研究设计。

触觉传感技术作为实现智能机器人技术的关键因素之一,不仅仅是视觉的一种补充,它与视觉一样,都是模拟人的感觉,是实现机器人与环境直接作用的必须媒介。

1.2机器人触觉传感器国外研究现状国外学者对机器人触觉传感技术较系统的研究开始于上世纪70年代,目前国外触觉传感技术研究已经取得很大成果。

2002年,美国科研人员在内窥镜手术的导管顶部安装触觉传感器,可检测疾病组织的刚度,根据组织柔软度施加合适的力度,保证手术操作的安全。

2008年,日本Kazuto Takashima等人设计了压电三维力触觉传感器,将其安装在机器人灵巧手指端,并建立了肝脏模拟界面,外科医生可以通过对机器人灵巧手的控制,感受肝脏病变部位的信息,进行封闭式手术。

2009年,德国菲劳恩霍夫制造技术和应用材料研究院的马库斯-梅瓦尔研制出新型触觉系统的章鱼水下机器人,可精确地感知障碍物状况,可以自动完成海底环境的勘测工作。

1.3机器人触觉传感器国内研究现状国内对机器人触觉传感技术的研究起步较晚,受到客观条件的限制,在1987年国家863计划开始实施以后才加快研究步伐。

在863计划的支持下,东南大学、北京理工大学,中科院合肥智能所等单位在90年代初相继开展了各有特色的研究,并取得了一定的成果。

1.4触觉传感器分类机器人感知能力的技术研究中,触觉类传感器极其重要。

触觉类的传感器研究有广义和狭义之分。

广义的触觉包括触觉、压觉、力觉、滑觉、冷热觉等。

机器人视觉论文论文题目:基于opencv的手势识别院系:信息科学与工程学院专业:信号与信息处理姓名:孙竟豪学号:21160211123摘要文中介绍了一种易于实现的快速实时手势识别算法。

研究借助计算机视觉库OpenCV和微软Visual Studio 2008 搭建开发平台,通过视频方式实时提取人的手势信息,进而经二值化、膨胀腐蚀、轮廓提取、区域分割等图像处理流程甄别出当前手势中张开的手指,识别手势特征,提取出人手所包含的特定信息,并最终将手势信息作为控制仪器设备的操作指令,控制相关设备仪器。

0、引言随着现代科技的高速发展及生活方式的转变,人们越发追求生活、工作中的智能化,希望享有简便、高效、人性化的智能操作控制方式。

而伴随计算机的微型化,人机交互需求越来越高,人机友好交互也日益成为研发的热点。

目前,人们已不仅仅满足按键式的操作控制,其目光已转向利用人体动作、表情变化等更加方便、友好、直观地应用智能化交互控制体系方面。

近年来,国内外科学家在手势识别领域有了突破性进展。

1993 年B.Thamas等人最先提出借助数据手套或在人手粘贴特殊颜色的辅助标记来进行手势动作的识别,由此开启了人们对手势识别领域的探索。

随后,手势识别研究成果和各种方式的识别方法也纷然出现。

从基于方向直方图的手势识别到复杂背景手势目标的捕获与识别,再到基于立体视觉的自然手势识别,每次探索都是手势识别领域内的重大突破。

1 手势识别流程及关键技术本文将介绍一种基于 OpenCV 的实时手势识别算法,该算法是在现有手势识别技术基础上通过解决手心追踪定位问题来实现手势识别的实时性和高效性。

基于 OpenCV 的手势识别流程如图 1 所示。

首先通过视频流采集实时手势图像,而后进行包括图像增强、图像锐化在内的图像预处理,目的是提高图像清晰度并明晰轮廓边缘。

根据肤色在 YCrCb 色彩空间中的自适应阈值对图像进行二值化处理,提取图像中所有的肤色以及类肤色像素点,而后经过膨胀、腐蚀、图像平滑处理后,祛除小块的类肤色区域干扰,得到若干块面积较大的肤色区域; 此时根据各个肤色区域的轮廓特征进行甄选,获取目标手势区域,而后根据目标区域的特征进行识别,确定当前手势,获取手势信息。

图 1 基于OpenCV的手势识别流程此识别过程有三个关键流程: 肤色分割、区域分割和手势识别。

1.1肤色分割完成图像的预处理后,将其色彩空间由RGB 转化到YCrCb。

“Y” 代表亮度( Luminance) ,也就是灰阶值; 而“Cr” 和“Cb” 分别表示色调与饱和度,二者统一起来共同代表色度( Chrominance) 。

YCrCb转换到RGB 的公式如下 ( RGB 取值范围均为0 ~255) :Y = 0.299R + 0.587G + 0.114BCr = -0.147R -0.289G + 0.436BCb= 0.615R -0.515G -0.100B本文采用YCrCb色彩空间的原因是其亮度信号Y 和色度信号Cr、Cb是分离的。

把RGB 转为YCrCb空间后,因该空间受亮度影响较小,其亮度Y的影响则可忽略,由此将三维空间模型便可转换为二维空间模型,肤色将会产生较好的类聚。

通常,当Cr 和Cb满足: 133≤Cr≤173,77≤Cb≤127 时,即可认为是肤色区域; 而此时在事先设定的自调节阈值基础上,通过对当前时刻的Cr 和Cb阈值进行经验性调整,便可更加精确地确定肤色区域。

之后,若将肤色区域像素点的像素分量调为255,非肤色区域像素点的像素分量调为0,即可得到肤色区域的二值化图像。

其原视频图像与二值化图像对比结果示例如图 2 所示。

图 2 图像二值化前后对比1.2 区域分割区域分割的主要目的是为剔除与手势无关的脸部、另一只无效手部、以及其它类肤色背景的干扰,进而精确定位有效的目标手势区域。

使用cvFindContours 函数对已获取的二值化图像进行轮廓查找,可得到二值化图像中的轮廓总数,继而通过统计每一个轮廓区域占肤色区域总面积的百分比,并判断其百分比的大小( 如是否小于10% ) ,来认定其是否为干扰区域。

剔除所有干扰区域后,即可得到若干块较大面积的肤色区域。

而后为了在此若干块肤色区域中确定目标手势区域,根据仿生学原理,本研究尝试性地提出“周积比” 的概念并以此作为有效手势区域的判别标准。

“周积比” 即某孤立区域的周长与面积的比值,生态学特征理念之中,生物表面积与体重的比值越大,说明延展度越大。

“周积比”概念正是以此为借鉴,来用以确定张开手指的手势区域。

经实际测试,在肤色区域块正常识别的情况下,此种方法可以精确地将伸出手指的手势区域与脸部区域区分开来,从而有效确定出手势区域。

其区域分割对比结果示例如图 3 所示。

图 3 区域分割的结果对比1.3 手势识别手势识别是整体设计中最关键的一环,手势识别的方法有很多种,不同的识别方法所建立的模型不尽相同。

相对于常见且较为耗时的神经网络法以及传统的模板匹配法,本文将采用“手心定位法”。

“手心定位法” 是将定位目标设定为手势的手掌中心,同时由于正常人的五指指根到手掌中心之间的距离基本相等,因而可以手掌中心为圆心,以大于指根与手心间距的半径做圆,使圆周曲线有效地交割于所有手指,由此进行张开手指个数的识别。

继而根据手指交割的相对角度进一步确定是哪根手指张开,由此判定相应的手势信息。

此种方法最大的优点是适用性强,可准确识别出多种手势信息。

2 手势识别算法的探究本文为实现手势识别的高效与实时性,特在具体识别算法中加以深入探究。

本研究中手势识别所采用的“手心定位法” 关键在于如何高效地确定手心位置。

手心定位的主要思路为: 确定手掌最宽位置及手掌上下沿位置,并分别确定此三条平行线段的中点; 由于掌心处于三个中点所构成的圆弧上,故可在此弧线上等分若干点,以此作为备选手心点; 为确定手心位置,将对各备选手心点做手掌最大内接圆,并选取半径最大者对应的备选点定为手心位置。

如若旨在精确定位手心,将需在中点圆弧线上反复优化迭代以选取相应的手心点。

而本研究的主要目的是为确定张开的手指个数及其位置,故无需极其精确定位手心,因而在不影响精度的前提下,以 10等分划分来确定备选手心点。

2.1 算法流程本研究算法流程如图 4 所示。

图 4 手心定位算法流程2.2 算法实现方法本算法具体实现方法如下。

①确定手掌最宽及上下沿位置对手势所在区域进行初次扫描,确定区域之中最宽一行记为 CD,并记录最宽像素个数 Lmax、所在行数 iCD,而后再一次扫描,找出手掌上边沿 AB 和手掌下边沿 EF。

其定位示意图如图 5 所示。

在此,本文对手掌上下边沿的界定方法如下。

手掌上沿: 手势区域中首次满足行数不大于 iCD且连续肤色像素点个数大于 2* Lmax /3 的像素行,记为 AB,行数为 iAB。

手掌下沿: 手势区域中满足行数不小于 iCD且连续肤色像素点个数大于 Lmax /2 的像素行中肤色像素点变化率最大的一行,记为 EF,行数为 iEF。

其中,系数 2 /3、 1 /2 分别为正常人手五指张开时上沿与最宽部位、下沿与最宽部位的近似比值。

图 5 手心定位方法示意图②中点圆弧曲线的确定确定AB、CD、EF 后,分别取其中点,记为M、K、N,其坐标依次为: M( XM,YM ) 、K( XK,YK ) 、N( XN,YN) 。

根据三角函数方法可求出经由三个中点的圆弧曲线中心及半径。

即:首先求得直线MK 和NK 的直线方程:进而求得直线MK、NK 的中垂线方程L1、L2:(2)随后求得L1 与L2 的交点O,此交点即为由M、K、N 三点确定的唯一圆O( XO,YO ) 的圆心,其圆心坐标及半径R 的表达式分别如下:③备选点及最大内接圆的确定在圆O 的圆弧M ———N中均匀选取若干备选手心点(本文在此选取十个备选点) 。

设其中某备选点为P,而后分别计算P 点到手掌的上、下、左、右四个边缘的距离Lp1、Lp2、Lp3、Lp4,并取其中最小值Lp =MIN( Lp1,Lp2,Lp3,Lp4) 作为P 点在有效手势区域内的最大内接圆半径的近似值。

通过对十个备选点分别计算近似最大内接圆的半径,而后取其最大者Rmax作为所需的手掌内最大内接圆半径,并令对应的圆心为Q。

Q 点即为所需确定的手心位置近似点。

④手指交割圆的确定以近似手心位置的Q 点为圆心,以 2 倍Rmax为半径做圆,并通过逐一检测此圆上像素点的突变情况,来判定是否交割于手指,由此得出具体伸出的那几根手指,进而获得该手势的实际含义。

图 6 为基于此算法的手心定位示例。

图 6 手心定位结果对比参考文献:[1]翁汉良,战荫伟.基于视觉的多特征手势识别[J].计算机工程与科学,2012,34( 2) : 123 -127.[2]曹雏清,李瑞峰,赵立军.基于深度图像技术的手势识别方法[J].计算机工程,2012,38( 8) : 16 -21.[3]姜丽,许杰,等.基于YCbCr空间的自适应肤色分割方法[J].科技传播,2010( 14) : 235 -236.[4]张晓宇,彭四伟.基于OpenCV的运动目标识别算法与实现[J].现代电子技术,2009,22: 99 -101.[5]韩旭,于小亿.OpenCV在体感遥控中的应用[J].黑龙江工程学院学报,2012,26( 1) : 74 -77.[6]Zhou H,Ruan Q Q.A Real-Time Gesture Recognition Algorithm on Video Serveillance[C].ICSP2006.Beijing: IEEE,2006,II:1754 -1757.[7]姜丽,许杰,等.基于YCrCb空间的自适应肤色分割方法[J].科技传播,2010( 14) : 235 -236.。