4凸优化初步详解

- 格式:ppt

- 大小:4.30 MB

- 文档页数:85

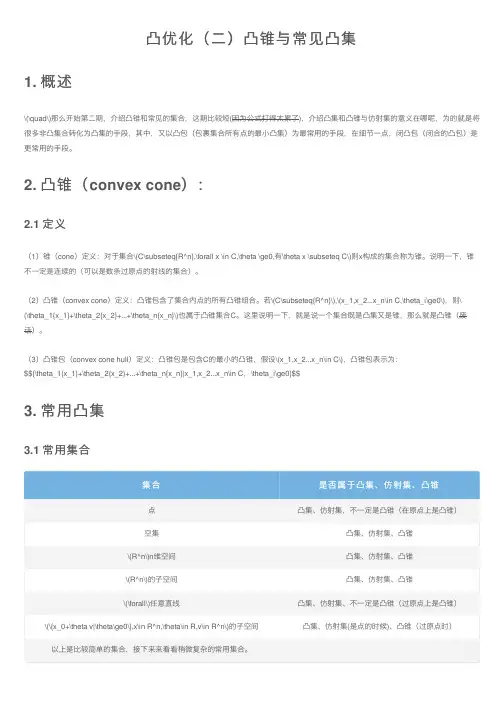

凸优化(⼆)凸锥与常见凸集1. 概述\(\quad\)那么开始第⼆期,介绍凸锥和常见的集合,这期⽐较短(因为公式打得太累了),介绍凸集和凸锥与仿射集的意义在哪呢,为的就是将很多⾮凸集合转化为凸集的⼿段,其中,⼜以凸包(包裹集合所有点的最⼩凸集)为最常⽤的⼿段,在细节⼀点,闭凸包(闭合的凸包)是更常⽤的⼿段。

2. 凸锥(convex cone):2.1 定义(1)锥(cone)定义:对于集合\(C\subseteq{R^n},\forall x \in C,\theta \ge0,有\theta x \subseteq C\)则x构成的集合称为锥。

说明⼀下,锥不⼀定是连续的(可以是数条过原点的射线的集合)。

(2)凸锥(convex cone)定义:凸锥包含了集合内点的所有凸锥组合。

若\(C\subseteq{R^n}\),\(x_1,x_2...x_n\in C,\theta_i\ge0\),则\ (\theta_1{x_1}+\theta_2{x_2}+...+\theta_n{x_n}\)也属于凸锥集合C。

这⾥说明⼀下,就是说⼀个集合既是凸集⼜是锥,那么就是凸锥(废话)。

(3)凸锥包(convex cone hull)定义:凸锥包是包含C的最⼩的凸锥,假设\(x_1,x_2...x_n\in C\),凸锥包表⽰为:$${\theta_1{x_1}+\theta_2{x_2}+...+\theta_n{x_n}|x_1,x_2...x_n\in C,\theta_i\ge0}$$3. 常⽤凸集3.1 常⽤集合集合是否属于凸集、仿射集、凸锥点凸集、仿射集,不⼀定是凸锥(在原点上是凸锥)空集凸集、仿射集、凸锥\(R^n\)n维空间凸集、仿射集、凸锥\(R^n\)的⼦空间凸集、仿射集、凸锥\(\forall\)任意直线凸集、仿射集、不⼀定是凸锥(过原点上是凸锥)\(\{x_0+\theta v|\theta\ge0\},x\in R^n,\theta\in R,v\in R^n\)的⼦空间凸集、仿射集(是点的时候)、凸锥(过原点时)以上是⽐较简单的集合,接下来来看看稍微复杂的常⽤集合。

凸优化面试题凸优化是数学中一种重要的优化问题的研究领域,针对凸优化问题,以下是一些常见的面试题,帮助你更好地理解和应对相关问题。

1. 什么是凸集?凸集是指其中的任意两点之间的连线上的点也在集合中的集合。

换句话说,对于凸集中的任意两点,在集合中的连线上的点都在该凸集中。

2. 什么是凸函数?凸函数是定义在凸集上的实值函数,对于凸集中的任意两点,函数值的连线上的点也在函数图像的上方或者等于函数图像。

3. 什么是凸优化问题?凸优化问题是指目标函数是凸函数,约束条件为线性等式或线性不等式的优化问题。

常见的凸优化问题有线性规划、二次规划等。

4. 凸集的性质有哪些?凸集具有以下性质:闭性、凸性、可加性、稳定性和非空性。

5. 凸函数的性质有哪些?凸函数具有以下性质:极小值点就是全局最小值点、任意两点间的连线上的点都满足函数值小于等于这两个点的函数值,并且函数的一次导数是递增的。

6. 如何证明一个函数是凸函数?可以使用以下方法证明函数的凸性:- 使用定义证明:利用定义证明函数图像上的任意两点之间的连线上的点的函数值都小于等于这两个点的函数值。

- 使用一阶导数证明:证明函数的一阶导数是递增的。

- 使用二阶导数证明:证明函数的二阶导数非负。

7. 凸优化问题有哪些常见方法可以求解?常见的凸优化方法包括:梯度下降法、牛顿法、内点法等。

具体选择方法取决于问题的规模、约束条件和求解效率的要求。

8. 怎样将非凸优化问题转化为凸优化问题?有一些常见的方法可以将非凸优化问题转化为凸优化问题,例如引入新的变量、利用凸函数的性质进行放缩、通过松弛约束等。

9. 如何判断一个凸优化问题是否有解?对于凸优化问题,如果目标函数有界且问题满足约束条件,则凸优化问题有解。

此外,一些具体的凸优化问题可以应用解析解或者数值方法得到解。

10. 为什么凸优化在现实中具有重要意义?凸优化在现实中具有广泛的应用,例如在机器学习中用于参数估计、模型拟合和分类问题,还可以应用于经济学、物理学、工程学等领域。

我们要解决一个简单的凸优化问题,目标是找到一个点(x) 使得(f(x)) 最小,同时满足约束条件(g(x) \leq 0) 和(h(x) = 0)。

假设我们的目标函数是(f(x) = x^2 - 2x),约束条件是(g(x) = x - 2 \leq 0) 和(h(x) = x - 1 = 0)。

首先,我们需要找到目标函数的梯度(\nabla f(x)) 和约束条件的梯度(\nabla g(x)) 和(\nabla h(x))。

然后,我们将使用KKT 条件来求解这个问题。

KKT 条件包括:拉格朗日乘子(\lambda) 和(\mu) 存在。

拉格朗日函数在最优解处取得极值。

拉格朗日乘子满足约束条件。

现在,我们开始计算。

目标函数的梯度:(\nabla f(x) = 2x - 2)约束条件的梯度:(\nabla g(x) = 1, \nabla h(x) = 1)拉格朗日函数:(L(x, \lambda, \mu) = f(x) + \lambda g(x) + \mu h(x))将目标函数和约束条件的梯度代入拉格朗日函数:(L(x, \lambda, \mu) = x^2 - 2x + \lambda (x - 2) + \mu (x - 1))对(x) 求导并令其为零:(2x - 2 + \lambda + \mu = 0)解得:(x = \frac{2 - \lambda - \mu}{2})将(x) 的值代入约束条件:(g(x) = x - 2 \leq 0) 和(h(x) = x - 1 = 0)解得:(\lambda = -1, \mu = -1)代入(x) 的值,得:(x = 0)所以,最优解(x*) = 0。

凸优化问题的神经网络算法研究第一章引言凸优化问题是一类在数学和工程领域中广泛应用的问题。

在实际应用中,凸优化问题的解决对于提高效率、降低成本、优化资源分配等方面具有重要意义。

神经网络算法作为一种强大的工具,近年来在解决凸优化问题方面展现出了巨大潜力。

本章将介绍研究背景和意义,并对文章的结构进行概述。

第二章凸优化问题概述本章将对凸优化问题进行概述,包括定义、性质和求解方法等方面。

首先介绍了凸集和凸函数的定义,并讨论了常见的几何性质,如拟凸性和强凸性。

然后介绍了常见的求解方法,包括梯度下降法、牛顿法和内点法等。

第三章神经网络算法简介本章将简要介绍神经网络算法及其在机器学习领域中的应用。

首先介绍了神经网络模型及其基本结构,并讨论了常见的神经网络训练算法,如反向传播算法和随机梯度下降算法。

然后介绍了神经网络在分类、回归和聚类等任务中的应用。

第四章神经网络在凸优化问题中的应用本章将详细介绍神经网络在解决凸优化问题中的应用。

首先讨论了将凸优化问题转化为神经网络模型的方法,并介绍了常见的转化技巧,如拉格朗日松弛和支持向量机等。

然后讨论了神经网络在约束优化、凸二次规划和线性规划等问题中的应用。

第五章神经网络算法性能分析本章将对神经网络算法在解决凸优化问题中的性能进行分析。

首先讨论了算法收敛性和稳定性等方面的指标,并介绍了常见的评估方法,如收敛速度和误差分析等。

然后通过实验对比,评估了神经网络算法与传统求解方法在不同场景下的性能差异。

第六章神经网络算法改进与扩展本章将讨论如何改进和扩展神经网络算法以提高其在解决凸优化问题中的效果。

首先介绍了常见改进技术,如正则化、批归一化和参数初始化等。

然后讨论了如何将神经网络算法与其他优化算法相结合,以提高求解效率和稳定性。

第七章实际应用与案例分析本章将通过实际应用和案例分析,展示神经网络算法在解决凸优化问题中的实际效果。

以图像处理、信号处理和金融风险管理等领域为例,介绍了神经网络算法在不同领域中的应用情况和效果。

数学中的凸优化与凸分析凸优化和凸分析是数学中重要的分支领域,它们在诸多应用领域都有着广泛的应用。

本文将介绍凸优化和凸分析的基本概念、性质以及它们在实际问题中的应用。

一、凸集与凸函数在进一步探讨凸优化和凸分析之前,我们先来了解一些基本概念。

首先是凸集和凸函数。

1. 凸集凸集是指集合中任意两点的连线上的点都属于该集合。

具体地,对于任意$x, y$属于集合$C$和$0\leq\lambda\leq 1$,满足$\lambda x+(1-\lambda)y$也属于$C$,则$C$是一个凸集。

2. 凸函数凸函数是定义在凸集上的实值函数,满足对于集合内的任意$x,y$和$0\leq\lambda\leq 1$,有$f(\lambda x+(1-\lambda)y)\leq \lambdaf(x)+(1-\lambda)f(y)$。

简单来说,凸函数的任意两点的连线上的函数值都不超过连线两端的函数值。

二、凸优化凸优化是指优化问题的目标函数是凸函数,约束条件是凸集的优化问题。

凸优化问题有着许多重要的性质和算法。

1. 凸优化问题的一般形式凸优化问题的一般形式可以表示为:$$\begin{align*}\text{minimize}\quad &f(x)\\\text{subject to}\quad &x\in C\end{align*}$$其中,$f(x)$是凸函数,$C$是凸集。

2. 凸优化问题的性质凸优化问题具有以下性质:(1)全局最优解是局部最优解。

这意味着在凸优化问题中,存在一个全局最优解,同时该最优解也是局部最优解。

(2)凸优化问题无局部最优解和全局最优解之间的鞍点。

凸优化问题不存在鞍点,因此可以通过寻找局部最优解来获得全局最优解。

3. 典型凸优化问题凸优化问题在实践中有着广泛的应用,以下是一些典型的凸优化问题:(1)线性规划问题(Linear Programming,简称LP)$$\begin{align*}\text{minimize}\quad &c^Tx\\\text{subject to}\quad &Ax\leq b\\&x\geq 0\end{align*}$$(2)二次规划问题(Quadratic Programming,简称QP)$$\begin{align*}\text{minimize}\quad &\frac{1}{2}x^TPx+q^Tx+r\\\text{subject to}\quad &Gx\leq h\\&Ax=b\end{align*}$$(3)半正定规划问题(Semidefinite Programming,简称SDP)$$\begin{align*}\text{minimize}\quad &\langle C,X\rangle\\\text{subject to}\quad &\langle A_i,X\rangle=b_i,\quad i=1,\ldots,m\\&X\succeq 0\end{align*}$$三、凸分析凸分析是研究凸集和凸函数性质的数学分支,它主要研究凸集的性质以及凸函数的导数和二阶导数。

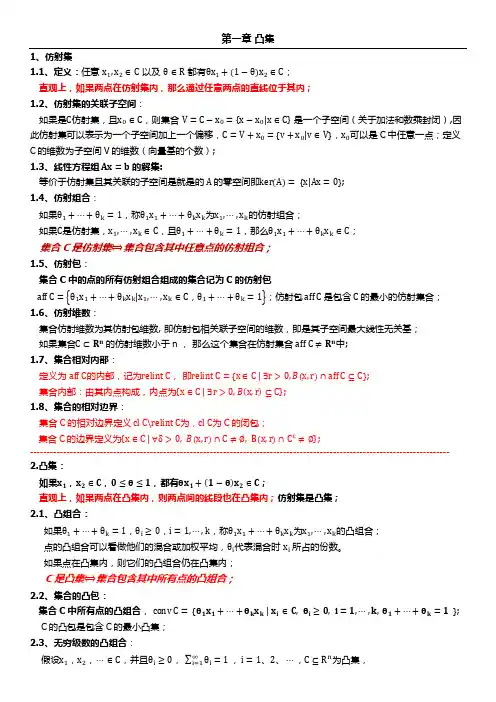

第一章 凸集1、仿射集1.1、定义:任意 x 1,x 2∈C 以及 θ∈R 都有θx 1+(1−θ)x 2∈C ;直观上,如果两点在仿射集内,那么通过任意两点的直线位于其内;1.2、仿射集的关联子空间:如果是C 仿射集,且x 0∈C ,则集合 V =C −x 0={x −x 0|x ∈C } 是一个子空间(关于加法和数乘封闭),因此仿射集可以表示为一个子空间加上一个偏移,C =V +x 0={v +x 0|v ∈V },x 0可以是C 中任意一点;定义C 的维数为子空间V 的维数(向量基的个数);1.3、线性方程组 Ax =b 的解集:等价于仿射集且其关联的子空间是就是的 A 的零空间即ker (A )= {x|Ax =0};1.4、仿射组合:如果θ1+⋯+θk =1,称θ1x 1+⋯+θk x k 为x 1,⋯,x k 的仿射组合;如果C 是仿射集,x 1,⋯,x k ∈C ,且θ1+⋯+θk =1,那么θ1x 1+⋯+θk x k ∈C ;集合C 是仿射集⟺集合包含其中任意点的仿射组合;1.5、仿射包:集合C 中的点的所有仿射组合组成的集合记为C 的仿射包aff C ={θ1x 1+⋯+θk x k |x 1,⋯,x k ∈C ,θ1+⋯+θk =1};仿射包 aff C 是包含 C 的最小的仿射集合;1.6、仿射维数:集合仿射维数为其仿射包维数, 即仿射包相关联子空间的维数,即是其子空间最大线性无关基;如果集合C ⊂R n 的仿射维数小于n , 那么这个集合在仿射集合 aff C ≠R n 中;1.7、集合相对内部:定义为 aff C 的内部,记为relint C , 即relint C ={x ∈C | ∃r >0,B (x,r )∩aff C ⊆C };集合内部:由其内点构成,内点为{x ∈C | ∃r >0,B (x,r )⊆C };1.8、集合的相对边界:集合C 的相对边界定义 cl C\relint C 为,cl C 为C 的闭包;集合C 的边界定义为{x ∈C | ∀δ>0,B (x,r )∩C ≠∅,B (x,r )∩C c ≠∅};------------------------------------------------------------------------------------------------------------------------------2.凸集:如果x 1,x 2∈C ,0≤θ≤1,都有θx 1+(1−θ)x 2∈C ;直观上,如果两点在凸集内,则两点间的线段也在凸集内;仿射集是凸集;2.1、凸组合:如果θ1+⋯+θk =1,θi ≥0,i =1,⋯,k ,称θ1x 1+⋯+θk x k 为x 1,⋯,x k 的凸组合;点的凸组合可以看做他们的混合或加权平均,θi 代表混合时 x i 所占的份数。

凸优化算法在机器学习中的应用研究随着人工智能技术的快速发展,机器学习成为了当今科技领域的热门话题。

机器学习的目标是通过设计和开发算法,使计算机能够从数据中学习并自动改进性能。

而凸优化算法作为机器学习中的重要工具,被广泛应用于解决各种优化问题。

一、凸优化算法的基本概念在了解凸优化算法在机器学习中的应用之前,我们首先需要了解凸优化算法的基本概念。

凸优化问题是指目标函数为凸函数,约束条件为凸集的优化问题。

凸函数具有很多良好的性质,比如局部极小值即为全局极小值,因此凸优化问题的解具有较好的稳定性和可靠性。

二、凸优化算法在机器学习中的应用1. 线性回归线性回归是机器学习中最简单的模型之一,它通过寻找最小化目标函数的参数来拟合数据。

凸优化算法可以应用于线性回归中,例如梯度下降算法、共轭梯度法等。

这些算法通过迭代优化参数,使得目标函数的值逐渐趋近于最小值,从而实现对数据的拟合。

2. 逻辑回归逻辑回归是一种常用的分类算法,它通过建立一个逻辑函数来预测离散的输出。

凸优化算法可以用于逻辑回归的参数优化,例如牛顿法、拟牛顿法等。

这些算法通过迭代优化参数,使得逻辑回归模型的预测结果与实际结果尽可能接近。

3. 支持向量机支持向量机是一种常用的分类算法,它通过找到一个最优的超平面来将不同类别的数据分开。

凸优化算法可以应用于支持向量机的求解过程中,例如序列最小优化算法、凸二次规划算法等。

这些算法通过迭代优化超平面的参数,使得支持向量机能够更好地分类数据。

4. 神经网络神经网络是一种模拟人脑神经元网络的机器学习模型,它通过多层神经元的连接和权重调整来实现对数据的学习和预测。

凸优化算法可以用于神经网络的参数优化,例如反向传播算法、共轭梯度法等。

这些算法通过迭代优化神经网络的权重和偏置,使得神经网络能够更准确地预测数据。

三、凸优化算法在机器学习中的优势凸优化算法在机器学习中具有以下优势:1. 稳定性:凸优化问题的解具有较好的稳定性,即局部极小值即为全局极小值。

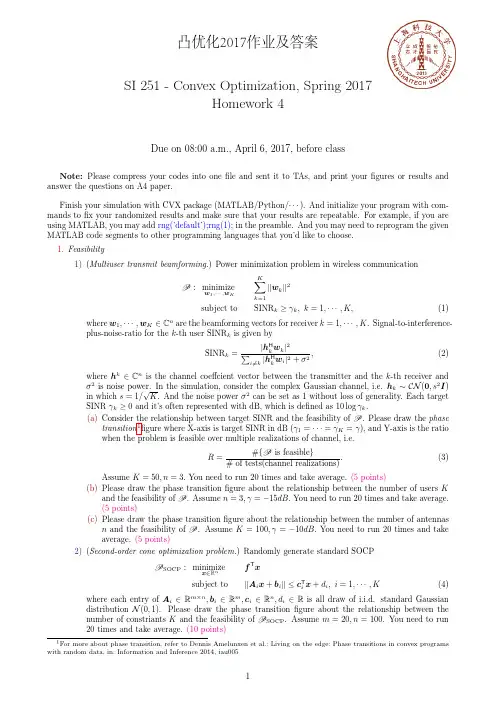

SI 251-Convex Optimization,Spring 2017Homework 4Due on 08:00a.m.,April 6,2017,before classNote:Please compress your codes into one file and sent it to TAs,and print your figures or results and answer the questions on A4paper.Finish your simulation with CVX package (MATLAB/Python/···).And initialize your program with com-mands to fix your randomized results and make sure that your results are repeatable.For example,if you are using MATLAB,you may add rng(’default’);rng(1);in the preamble.And you may need to reprogram the given MATLAB code segments to other programming languages that you’d like to choose.1.Feasibility1)(Multiuser transmit beamforming.)Power minimization problem in wireless communicationP :minimizew 1,···,w KK k =1w k 2subject to SINR k ≥γk ,k =1,···,K,(1)where w 1,···,w K ∈C n are the beamforming vectors for receiver k =1,···,K .Signal-to-interference-plus-noise-ratio for the k -th user SINR k is given bySINR k =|h H k w k |2 i =k |h H kw i |2+σ2,(2)where h k ∈C n is the channel coeffcient vector between the transmitter and the k -th receiver andσ2is noise power.In the simulation,considerthe complex Gaussian channel,i.e.h k ∼CN (0,s 2I )in which s =1/√K .And the noise power σ2can be set as 1without loss of generality.Each target SINR γk ≥0and it’s often represented with dB,which is defined as 10log γk .(a)Considerthe relationship between target SINR and the feasibility of P .Please draw the phasetransition 1figure where X-axis is target SINR in dB (γ1=···=γK =γ),and Y-axis is the ratio when the problem is feasible over multiple realizations of channel,i.e.R =#{P is feasible }#of tests(channel realizations).(3)Assume K =50,n =3.You need to run 20times and take average.(5points)(b)Please draw the phase transition figure about the relationship between the number of users Kand the feasibility of P .Assume n =3,γ=−15dB.You need to run 20times and take average.(5points)(c)Please draw the phase transition figure about the relationship between the number of antennasn and the feasibility of P .Assume K =100,γ=−10dB.You need to run 20times and take average.(5points)2)(Second-order cone optimization problem.)Randomly generate standard SOCPP SOCP :minimize x ∈Rnf T xsubject toA i x +b i ≤c T i x +d i ,i =1,···,K(4)where each entry of A i ∈R m ×n ,b i ∈R m ,c i ∈R n ,d i ∈R is all draw of i.i.d.standard Gaussiandistribution N (0,1).Please draw the phase transition figure about the relationship between the number of constriants K and the feasibility of P SOCP .Assume m =20,n =100.You need to run 20times and take average.(10points)1Formore about phase transition,refer to Dennis Amelunxen et al.:Living on the edge:Phase transitions in convex programswith random data,in:Information and Inference 2014,iau005凸优化2017作业及答案2.Optimization problems.(a)(LASSO.)We wish to recover a sparse vector x∈R n from measurements y∈R m.Our measurementmodel tells us thaty=Ax+v,where A∈R m×n is a known matrix and v∈R m is unknown measurement error.The entries of v are drawn IID from the distribution N(0,σ2).We canfirst try to recover x by solving the optimization problemminAx−y 22+γ||x||22.(5)xThis problem is called ridge regression.A more successful approach is to solve the LASSO problemminAx−y 22+γ||x||1.(6)xPlease use the code below to define n,m,A,x,and y.1234567(a)Use CVX to estimate x from y using ridge regression and LASSO problem,respectively.(15points)(b)Plot your result to compare the estimated x with the true x.(5points)(c)How many measurements m are needed tofind an accurate x with ridge regression?How aboutwith the LASSO?(5points)(b)(Portfolio Optimization.)Find minimum-risk portfolios with the same expected return as the uniformportfolio(w=(1/n)1),with risk measured by portfolio return variance,and the following portfolio constraints(in addition to1T w=1):•No(additional)constraints.•Long-only:w 0.•Limit on total short position:1T w−≤0.5,where(w−)i=max{w i,0}.(a)Use CVX to compare the optimal risk in these portfolios with each other and the uniformportfolio.(10points)(b)Plot the optimal risk-return trade-offcurves for the long-only portfolio,and for total shortposition limited to0.5,in the samefiment on the relationship between the two trade-offcurves.(10points)(c)(Energy Storage Trade-offs.)We consider the use of a storage device(say,a battery)to reduce thetotal cost of electricity consumed over one day.We divide the day into T time periods,and let p t denote the(positive,time-varying)electricity price,and u t denote the(nonnegative)usage or consumption,in period t,for t=1,...,T.Without the use of a battery,the total cost is p T u.Let q t denote the(nonnegative)energy stored in the battery in period t.For simplicity,we neglect energy loss(although this is easily handled as well),so we have q t+1=q t+c t,t=1,...,T1,where c t is the charging of the battery in period t;c t<0means the battery is discharged.We will require that q1=q T+c T,i.e.,wefinish with the same battery charge that we start with.With the battery operating,the net consumption in period t is u t+c t;we require this to be nonnegative(i.e.,we do not pump power back into the grid).The total cost is then p T(u+c).The battery is characterized by three parameters:The capacity Q,where q t≤Q;the maximum charge rate C,where c t≤C;and the maximum discharge rate D,where c t≥D.(The parameters Q,C,and D are nonnegative.)(a)Explain how tofind the charging profile c∈R T(and associated stored energy profile q∈R T)that minimizes the total cost,subject to the constraints.(5points)p T(u+c)minq,cs.t q t+1=q t+c t,t=1,...,T−1q1=q T+c T0≤q t≤Q,t=1,...,T−D≤c t≤C,t=1,...,T0≤u t+c t,t=1,...,T(b)Use CVX to solve the problem above with Q=35,C=D=3as well as p and u defined by thefollowing code:12345Plot u t,p t,c t,and q t versus t.(15points)(c)Storage Trade-offs Plot the minimum total cost versus the storage capacity Q,using p and ubelow,and charge/discharge limits C=D=3.Repeat for charge/discharge limits C=D=1.(Put these two trade-offcurves on the same plot.)Give an interpretation of the endpoints of the trade-offcurves.(10points)SI 251-Convex Optimization,Spring 2017Homework 4Due on 08:00a.m.,April 6,2017,before classNote:Please compress your codes into one file and sent it to TAs,and print your figures or results and answer the questions on A4paper.Finish your simulation with CVX package (MATLAB/Python/···).And initialize your program with com-mands to fix your randomized results and make sure that your results are repeatable.For example,if you are using MATLAB,you may add rng(’default’);rng(1);in the preamble.And you may need to reprogram the given MATLAB code segments to other programming languages that you’d like to choose.1.Feasibility1)(Multiuser transmit beamforming.)Power minimization problem in wireless communicationP :minimizew 1,···,w KK ∑k =1∥w k ∥2subject toSINR k ≥γk ,k =1,···,K,(1)where w 1,···,w K ∈C n are the beamforming vectors for receiver k =1,···,K .Signal-to-interference-plus-noise-ratio for the k -th user SINR k is given bySINR k =|h H k w k |2∑i =k |h H kw i |2+σ2,(2)where h k ∈C n is the channel coeffcient vector between the transmitter and the k -th receiver andσ2is noise power.In the simulation,considerthe complex Gaussian channel,i.e.h k ∼CN (0,s 2I )in which s =1/√K .And the noise power σ2can be set as 1without loss of generality.Each target SINR γk ≥0and it’s often represented with dB,which is defined as 10log γk .(a)Consider the relationship between target SINR and the feasibility of P .Please draw the phasetransition 1figure where X-axis is target SINR in dB (γ1=···=γK =γ),and Y-axis is the ratio when the problem is feasible over multiple realizations of channel,i.e.R =#{P is feasible }#of tests(channel realizations).(3)Assume K =50,n =3.You need to run 20times and take average.(5points)(b)Please draw the phase transition figure about the relationship between the number of users Kand the feasibility of P .Assume n =3,γ=−15dB.You need to run 20times and take average.(5points)(c)Please draw the phase transition figure about the relationship between the number of antennasn and the feasibility of P .Assume K =100,γ=−10dB.You need to run 20times and take average.(5points)Solution:1Formore about phase transition,refer to Dennis Amelunxen et al.:Living on the edge:Phase transitions in convex programswith random data,in:Information and Inference 2014,iau0051 2 3 4 5 678910111213142)(Second-order cone optimization problem.)Randomly generate standard SOCPP SOCP:minimizef T xx∈R nsubject to∥A i x+b i∥≤c T i x+d i,i=1,···,K(4) where each entry of A i∈R m×n,b i∈R m,c i∈R n,d i∈R is all draw of i.i.d.standard Gaussian distribution N(0,1).Please draw the phase transitionfigure about the relationship between the number of constriants K and the feasibility of P SOCP.Assume m=20,n=100.You need to run 20times and take average.(10points)Solution:123456789101112132.Optimization problems.(a)(LASSO.)We wish to recover a sparse vector x∈R n from measurements y∈R m.Our measurementmodel tells us thaty=Ax+v,where A∈R m×n is a known matrix and v∈R m is unknown measurement error.The entries of v are drawn IID from the distribution N(0,σ2).We canfirst try to recover x by solving the optimization problem∥Ax−y∥22+γ||x||22.(5)minxThis problem is called ridge regression.A more successful approach is to solve the LASSO problem∥Ax−y∥22+γ||x||1.(6)minxPlease use the code below to define n,m,A,x,and y.1234567(a)Use CVX to estimate x from y using ridge regression and LASSO problem,respectively.(15points)(b)Plot your result to compare the estimated x with the true x.(5points)(c)How many measurements m are needed tofind an accurate x with ridge regression?How aboutwith the LASSO?(5points)Solution:(b)(Portfolio Optimization.)Find minimum-risk portfolios with the same expected return as the uniformportfolio(w=(1/n)1),with risk measured by portfolio return variance,and the following portfolio constraints(in addition to1T w=1):•No(additional)constraints.•Long-only:w≽0.•Limit on total short position:1T w−≤0.5,where(w−)i=max{−w i,0}.(a)Use CVX to compare the optimal risk in these portfolios with each other and the uniformportfolio.(10points)(b)Plot the optimal risk-return trade-offcurves for the long-only portfolio,and for total shortposition limited to0.5,in the samefiment on the relationship between the two trade-offcurves.(10points)Solution:92017/4/16portfolio_yangkai(b)Plot the optimal risk-return trade-off curves for the long-only portfolio, and for total short positionlimited to 0.5, in the same figure.Comment on the relationship between the two trade-off curves.file:///C:/Users/Line/Box%20Sync/Course/convex%20optimization%202017/hw4/result/portfolio_yangkai.html3/6In [ ]: In [ ]:(c)(Energy Storage Trade-offs.)We consider the use of a storage device(say,a battery)to reduce thetotal cost of electricity consumed over one day.We divide the day into T time periods,and let p t denote the(positive,time-varying)electricity price,and u t denote the(nonnegative)usage or consumption,in period t,for t=1,...,T.Without the use of a battery,the total cost is p T u.Let q t denote the(nonnegative)energy stored in the battery in period t.For simplicity,we neglect energy loss(although this is easily handled as well),so we have q t+1=q t+c t,t=1,...,T1,where c t is the charging of the battery in period t;c t<0means the battery is discharged.We will require that q1=q T+c T,i.e.,wefinish with the same battery charge that we start with.With the battery operating,the net consumption in period t is u t+c t;we require this to be nonnegative(i.e.,we do not pump power back into the grid).The total cost is then p T(u+c).The battery is characterized by three parameters:The capacity Q,where q t≤Q;the maximum charge rate C,where c t≤C;and the maximum discharge rate D,where c t≥D.(The parameters Q,C,and D are nonnegative.)(a)Explain how tofind the charging profile c∈R T(and associated stored energy profile q∈R T)that minimizes the total cost,subject to the constraints.(5points)minp T(u+c)q,cs.t q t+1=q t+c t,t=1,...,T−1q1=q T+c T0≤q t≤Q,t=1,...,T−D≤c t≤C,t=1,...,T0≤u t+c t,t=1,...,T(b)Use CVX to solve the problem above with Q=35,C=D=3as well as p and u defined by thefollowing code:12345Plot u t,p t,c t,and q t versus t.(15points)(c)Storage Trade-offs Plot the minimum total cost versus the storage capacity Q,using p and ubelow,and charge/discharge limits C=D=3.Repeat for charge/discharge limits C=D=1.(Put these two trade-offcurves on the same plot.)Give an interpretation of the endpoints of the trade-offcurves.(10points)Solution:16In [28]:# Here we plot the demands u and prices p.import numpy as npimport matplotlib.pyplot as plt%matplotlib inlinenp.random.seed(1)T = 96t = np.linspace(1, T, num=T).reshape(T,1)p = np.exp(-np.cos((t-15)*2*np.pi/T)+0.01*np.random.randn(T,1)) u = 2*np.exp(-0.6*np.cos((t+40)*np.pi/T) - \0.7*np.cos(t*4*np.pi/T)+0.01*np.random.randn(T,1))plt.figure(1)plt.plot(t/4, p, 'g', label=r"$p$");plt.plot(t/4, u, 'r', label=r"$u$");plt.ylabel("$")plt.xlabel("t")plt.legend()plt.show()2017/4/16energystorage_yangkaifile:///C:/Users/Line/Box%20Sync/Course/convex%20optimization%202017/hw4/result/energystorage_yangkai.html6/6。

凸优化总结1基本概念1.1) 凸集合:nS R ⊂是凸集,如果其满足:x; y S + = 1 x + y S λμλμ∈⇒∈几何解释:x; y S ∈,则线段[x,y]上的任何点都S ∈1.2) 仿射集:nSR⊂是仿射集,如果其满足:x; y S , R ,+ = 1 x + y S λμλμλμ∈∈⇒∈几何解释:x; y S ∈,则穿过x, y 的直线上的任何点都S ∈1.3) 子空间:nS R ⊂是子空间,如果其满足:x; y S , R , x + y S λμλμ∈∈⇒∈ 几何解释:x; y S ∈,则穿过x, y ,0的平面上的任何点都S ∈1.4) 凸锥:n S R ⊂是凸锥,如果其满足:x; y S ,0 x + y S λμλμ∈≥⇒∈ 几何解释:x; y S ∈,则x, y 之间的扇形面的任何点都S ⊂集合C 是凸锥的充分必要条件是集合C 中的元素的非负线性组合仍在C 中,作为一般化结果,其中非负线性组合的数目可以推广到无穷1.5) 超平面:满足{}Tx a x = b (a 0)≠的仿射集,如果b=0则变为子空间1.6) 半空间:满足{}Tx a x b (a 0)≤≠的凸集,如果b=0则变为凸锥1.7) 椭球体:{}T -1c c =x (x-x )A (x-x ) 1 ξ≤T n c A = A 0; x R ∈ 球心 1.8) 范数:f :R n —R 是一种范数,如果对所有的nx; y R , t R ∈∈满足1. f(x) 0; f(x) = 0 x = 02. f(tx) = tf(x)3. f(x + y) f(x) + f(y)≥⇒≤范数分类● 1范数2x=● 2范数 1i xx x =∑● 3无穷范数 max i i xx ∞=1.9) 有效域:集合(){()}dom f x X f x =∈<∞1.10) 水平集:{()}{()}x X f x and x X f x αα∈<∈≤,其中α为一标量1.11) 上镜图:函数:(,f x ∈-∞∞的上镜图由下面的集合给定{}()(,),,()epi f x w x X w R f x w =∈∈<给出的1n R +给出的子集。

凸优化广义不等式-概述说明以及解释1.引言引言部分是文章的开篇,用于引起读者的兴趣,并简要介绍文章要讨论的主题。

在本文中,引言的概述部分应该包含凸优化和广义不等式的基本概念。

下面是一个可能的写作范例:1.1 概述在现代数学和应用领域中,凸优化和广义不等式是两个重要的研究领域。

凸优化是数学中一种重要的优化方法,其旨在寻找一个函数的全局最小值,但只需要求函数定义域上的局部极小值;而广义不等式则涵盖了多种不等式类型,如线性不等式、二次不等式、半正定规划等。

凸优化作为一种强大的数学工具,广泛应用于各个领域,如金融、运筹学、信号处理等。

它不仅可以求解实际问题,并且具有良好的理论基础和算法支持。

而广义不等式则为凸优化提供了一种重要的约束条件,通过引入不等式约束,可以更加灵活地建模和求解实际问题。

本文将详细介绍凸优化和广义不等式的基本概念,并探讨它们在实际问题中的应用。

首先,我们将介绍凸优化的基本概念,包括凸集、凸函数和凸优化问题的定义。

然后,我们会详细讨论广义不等式约束的相关知识,包括线性不等式约束、二次不等式约束和半正定规划等。

通过对凸优化和广义不等式的深入理解,我们可以更加灵活地应用它们解决实际问题,提高问题求解的效率和精度。

同时,我们也能够更好地理解优化问题背后的数学原理和算法思想。

在现代科学技术的发展中,凸优化和广义不等式将发挥着越来越重要的作用,在实践中具有广阔的应用前景。

接下来,我们将开始介绍凸优化的基本概念,为后续的讨论做好准备。

1.2 文章结构文章结构的目的是为了让读者更好地理解和掌握凸优化广义不等式的相关知识。

为了达到这个目的,本文分为引言、正文和结论三个部分。

引言部分首先对该主题进行了概述,介绍凸优化和广义不等式的基本概念及其在实际问题中的应用。

接着,引言部分明确了本文的结构和目的,让读者知道本文的内容和安排。

正文部分是本文的重点,它分为两个小节:凸优化的基本概念和广义不等式约束。

在凸优化的基本概念部分,将介绍凸优化的定义、性质和常见算法。

函数凹凸性与优化问题求解策略函数的凹凸性和极值之间的关系在实际优化问题中具有广泛的应用。

这种关系不仅有助于我们理解问题的本质,还能指导我们设计有效的求解策略。

以下是将这种关系应用于实际优化问题中的几个方面:1. 简化问题复杂性●凸优化问题:当优化问题可以转化为凸优化问题时,其求解过程大大简化。

凸函数的凹凸性保证了局部最优解即为全局最优解,这使得我们可以使用更高效的算法(如梯度下降法、牛顿法等)来求解。

●非凸优化问题:对于非凸优化问题,虽然其求解过程可能更加复杂,但我们可以利用函数的凹凸性来识别可能的局部最优解或全局最优解的候选点。

例如,通过寻找函数的拐点(即凹凸性改变的点)或利用凸包络(convex envelope)等方法来近似原问题。

2. 指导算法设计●算法选择:根据函数的凹凸性,我们可以选择合适的算法来求解优化问题。

例如,对于凸优化问题,我们可以选择具有全局收敛性的算法;而对于非凸优化问题,我们可能需要采用启发式算法或元启发式算法来寻找近似解。

●算法参数调整:在算法运行过程中,我们可以根据函数的凹凸性来调整算法参数,以提高求解效率和准确性。

例如,在梯度下降法中,我们可以根据函数的二阶导数(即凹凸性信息)来调整学习率的大小。

3. 评估解的质量●全局最优性检验:对于凸优化问题,我们可以通过比较解与已知的全局最优解(如果存在的话)来检验解的质量。

如果两者相等或非常接近,则可以认为找到了全局最优解。

●局部最优性检验:对于非凸优化问题,我们可以通过检查解附近的函数值来评估其是否为局部最优解。

如果解附近的函数值都大于或等于该点的函数值,则可以认为该点是局部最优解。

4. 实际应用案例●金融领域:在投资组合优化中,我们可以利用凸优化来确保投资组合能够最小化风险。

由于投资组合的期望收益和风险函数通常是凸的,因此我们可以使用凸优化算法来找到最优的投资组合权重。

●工程设计:在工程设计中,我们经常需要优化某些性能指标(如成本、重量、效率等)。