人工神经网络复习资料

- 格式:docx

- 大小:4.03 MB

- 文档页数:36

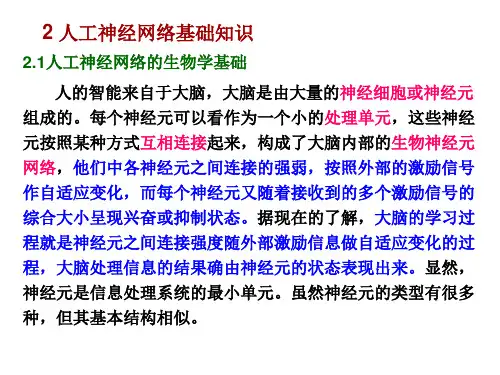

人工神经网络第章(1)人工神经网络第章人工神经网络(Artificial Neural Networks,ANN)是一种受到生物神经系统启发而开发出来的计算模型,在机器学习、数据挖掘、自然语言处理等领域广泛应用。

在本章节中,我们将对人工神经网络的基本原理、训练方法和应用进行介绍。

一、基本原理人工神经网络是由多个神经元(Neuron)组成的网络。

每个神经元接收多个输入信号,经过一些加权处理后,产生一个输出信号,输出信号又作为下一层神经元的输入。

这种层层叠加的结构被称为前馈神经网络(Feedforward neural networks)。

每个神经元的输入信号通过一个激活函数(Activation function)进行非线性转换,得到神经元的输出。

常用的激活函数有sigmoid、ReLU、tanh等。

神经网络的输出可以用于分类、回归等任务。

二、训练方法神经网络训练的目标是调整神经元之间的权值,使得网络的输出接近于真实值。

常用的训练方法包括反向传播算法(Backpropagation)和随机梯度下降算法(Stochastic Gradient Descent)。

反向传播算法是目前使用最广泛的神经网络训练方法,其核心思想是“误差反向传播”。

即从输出层开始,将网络的输出误差逐层反向传播到输入层,计算每个神经元的误差贡献,最后通过梯度下降算法调整神经元权值。

随机梯度下降算法是一种在线学习算法,每次选择一个样本进行训练,通过计算损失函数的梯度方向,调整网络权值,直到收敛。

随机梯度下降算法能够处理大规模数据训练,但更容易陷入局部极小值。

三、应用领域人工神经网络在图像识别、语音识别、自然语言处理、机器翻译等领域取得了广泛应用。

在图像识别领域,卷积神经网络(CNN)被广泛应用,已经实现了在ImageNet等数据集上的超越人类表现的成果。

在自然语言处理领域,循环神经网络(RNN)和长短时记忆网络(LSTM)能够处理变长序列数据,已经成功应用于机器翻译、情感分析等任务。

人工神经网络1、基本特征(1)结构特征 并行处理(时间)、分布式存储(空间)与容错性(2)能力特征 自适应性(自学习和自组织)2、基本功能(1)联想记忆 自联想和异联想(2)非线性映射(3)分类与识别(4)优化计算(5)知识处理3、神经元建模:(1)每个神经元都是一个多输入单输出的信息处理单元;(2)神经元输入分兴奋性输入和抑制性输入两种类型;(3)神经元具有空间整合性和阈值特性;(4)神经元输入与输出间有固定的时滞,主要取决于突触延搁;(5)忽略时间整合作用和不应期;(6)神经元本身是非时变的,即其突触时延和突触强度均为常数。

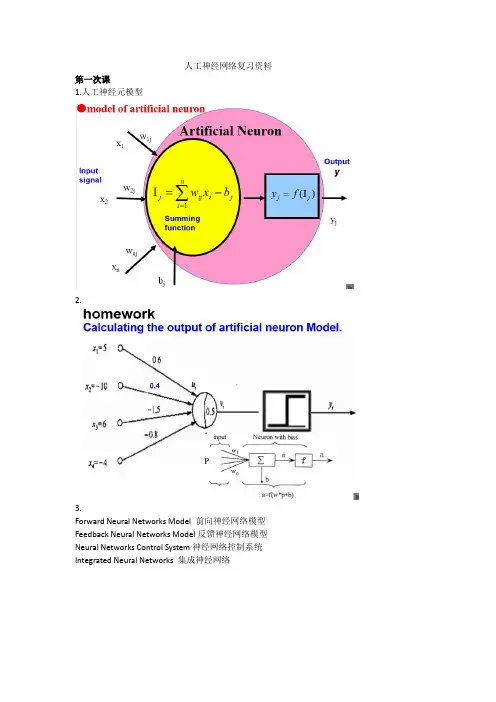

4、人工神经元模型令)(t x i 表示t 时刻神经元j 接收的来自神经元i 的输入信息,)(t o j 表示t 时刻神经元j 的输出信息,则神经元j 的状态可表达为:})]({[)(1∑=--=ni j ij i ij j T t x w f t o τ其中,ij τ为输入输出间的突触时延,j T 为神经元j 的阈值,ij w 为神经元i 到j 的突触连接系数或称权重值,()∙f 为神经元转移函数。

取1=ij τ,则有:})]({[)1(1∑=-=+ni j i ij j T t x w f t o输入总和常称为神经元在t 时刻的净输入,用下式表示:∑=='ni i ij j t x w t t ne 1)()()(t t ne j '体现了神经元j 的空间整合性,而未考虑时间整合,当0)(>-'j j T t t ne 时,神经元才能被激活。

上式还可表示为权重向量j W 和输入向量X 的点积:X W t ne T j j ='其中j W 和X 均为列向量,定义为:T nj j j j w w w W ),,,(21 =T n x x x X ),,,(21 =如果令10-=x ,j j T w =0,则有j j w x T 00=-,因此净输入与阈值之差可表达为:∑====-'ni T j i ij j j j X W x w net T t ne 0综合以上各式,神经元模型可简化为:)()(X W f net f o T j j j ==5、神经元的转移函数(1)阈值型转移函数(M-P 模型) 处理离散信号单极性阈值型转移函数 单位阶跃函数双极性阈值型转移函数 sgn(x)(2)非线性转移函数(单极性/双极性Sigmoid 函数曲线)实数域R 到[0,1]闭集的非减性连续函数,代表了状态连续型神经元模型。

人工神经网络人工神经网络(Artificial Neural Networks, ANN),一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。

这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。

人工神经网络具有自学习和自适应的能力,可以通过预先提供的一批相互对应的输入-输出数据,分析掌握两者之间潜在的规律,最终根据这些规律,用新的输入数据来推算输出结果,这种学习分析的过程被称为“训练”。

(引自《环球科学》2007年第一期《神经语言:老鼠胡须下的秘密》)概念由大量处理单元互联组成的非线性、自适应信息处理系统。

它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理、记忆信息的方式进行信息处理。

人工神经网络具有四个基本特征:(1)非线性非线性关系是自然界的普遍特性。

大脑的智慧就是一种非线性现象。

人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系。

具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量。

(2)非局限性一个神经网络通常由多个神经元广泛连接而成。

一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定。

通过单元之间的大量连接模拟大脑的非局限性。

联想记忆是非局限性的典型例子。

(3)非常定性人工神经网络具有自适应、自组织、自学习能力。

神经网络不但处理的信息可以有各种变化,而且在处理信息的同时,非线性动力系统本身也在不断变化。

经常采用迭代过程描写动力系统的演化过程。

(4)非凸性一个系统的演化方向,在一定条件下将取决于某个特定的状态函数。

例如能量函数,它的极值相应于系统比较稳定的状态。

非凸性是指这种函数有多个极值,故系统具有多个较稳定的平衡态,这将导致系统演化的多样性。

人工神经网络中,神经元处理单元可表示不同的对象,例如特征、字母、概念,或者一些有意义的抽象模式。

,.《神经网络原理》一、填空题1、从系统的看法讲,人工神经元网络是由大批神经元经过极其丰富和完美的连结而产生的自适应、非线性、动力学系统。

2、神经网络的基本特征有拓扑性、学习惯和坚固收敛性。

3、神经网络按构造可分为前馈网络和反应网络,按性能可分为失散型和连续型,按学习形式可分为有导师和无导师。

4、神经网络研究的发展约略经过了四个阶段。

5、网络坚固性指从t=0时辰初态开始,到t时辰后v(t+△t)=v(t),(t>0),称网络坚固。

6、联想的形式有两种,它们分是自联想和异联想。

7、储存容量指网络坚固点的个数,提升储存容量的门路一是改进网络的拓扑构造,二是改良学习形式。

8、非坚固吸引子有两种状态,一是有限环状态,二是混沌状态。

9、神经元分愉悦性神经元和克制性神经元。

、汉明间隔指两个向量中对应元素不一样的个数。

二、简答题1、人工神经元网络的特征?答:〔1〕、信息分布储存和容错性。

2〕、大范围并行一起办理。

3〕、自学习、自组织和自适应。

(4〕、人工神经元网络是大批的神经元的集体行为,表现为错杂,.的非线性动力学特征。

5〕人式神经元网络拥有不合适高精度计算、学习算法和网络设计没有一致标准等限制性。

2、单个神经元的动作特征有哪些?答:单个神经元的动作特征有:〔1〕、空间相加性;〔2〕、时间相加性;〔3〕、阈值作用;〔4〕、不该期;〔5〕、可塑性;〔6〕疲惫。

3、如何描绘动力学系统?答:对于失散时间系统,用一组一阶差分方程来描绘:X(t+1)=F[X(t)] ;对于连续时间系统,用一阶微分方程来描绘:dU(t)/dt=F[U(t)] 。

4、F(x)与x的关系如以下列图,试述它们辩解有几个均衡状态,是否为坚固的均衡状态?F(X) F(X)(1) (2)0 a b X 0 a X答:在图〔1〕中,有两个均衡状态a、b,此中,在a点曲线斜率|F’(X)|>1,为非坚固安稳状态;在 b 点曲线斜率|F’(X)|<1,为坚固安稳状态。

人工神经网络复习资料第一次课1.人工神经元模型2.3.Forward Neural Networks Model前向神经网络模型Feedback Neural Networks Model反馈神经网络模型Neural Networks Control System神经网络控制系统Integrated Neural Networks集成神经网络4.5.6.When no node节点output is an input to a node in the same layer or preceding layer前层, the network is a feedforward network(前向网络).当输出被引导为输入到相同的或之前的层节点时,网络是反馈网络 反馈网络,封闭的循环称为复发性网络(递归网络)7.8.n123n9.神经网络的用途是1分类2模式识别、特征提取、图像匹配3降噪4预测4.感知器(前向网络)5.感知器是一个具有单层计算神经元的神经网络,并由线性阈值元件组成,是最简单的前向网络。

感知器模型是美国学者罗森勃拉特(Rosenblatt)为研究大脑的存储、学习和认知过程而提出的一类具有自学习能力的神经网络模型,Rosenblatt提出的感知器模型是一个只有单层计算单元的前向神经网络,称为单层感知器。

它主要用于模式分类,单层的感知器网络结构如下图所示。

5.感知器算法1)随机地给定一组连接权2)输入一组样本和期望的输出3)计算感知器实际输出4)修正权值5)选取另外一组样本,重复上述2)~4)的过程,直到权值对一切样本均稳定不变为止,学习过程结束。

5. Perceptron Learning Rule该学习算法收敛的充分必要条件是输入样本是线性可分的。

同时的选取也是十分关键的。

学习率选取太小,学习太慢;学习率太大,学习过程可能出现修正过头的情况,从而产生振荡。

5.感知器训练规则及计算方法的掌握5.感知器网络应用利用感知器神经网络架构解决一个简单的模式识别问题。

使用感知器神经网络架构来表示和门1)分类:训练网络预测心脏病新病人2)逻辑运算:单层感知器可以表示和,或者,不,等等,但不是XOR3)6. MATLAB functions for perceptron networks5.应用实例:设计一单层单输出感知器神经网络,进行二值化图像卡片上数字的奇偶分类5.第二次课1.Key wordsbiological neuronArtificial Neural neuron output neurons interconnection weighted bias levelsactivation function feedforward neural network hidden layersoutput layerinput-output mapping Association memory Pattern Recognition system identification perceptron model Learning Processes learning algorithm training examplesinput vectorTarget outputdesired response supervised learning Unsupervised Learninglearning tasks rate of learning 生物神经元人工神经元神经元输出神经元互联加权偏见水平激活功能前馈神经网络隐藏的图层输出层输入输出映射关联记忆模式识别系统识别感知器模型学习过程学习算法训练实例输入矢量目标输出期望的响应监督学习无监督学习学习任务学习的速度2.3.3.3.3.4.算法实现步骤:第一步:初始化第二步:输入一个样本,计算连接权值的调整量第三步:调整连接权值第四步:计算均方误差5.6.线性神经网络的应用线性神经网络在模式识别、信号滤波和预测、函数近似等方面有广泛的用途,至今仍然广泛应用于各种实际系统中,特别是在自适应滤波方面,用途更为广泛。

1以自适应线性网络实现噪声对消2胎儿心率的检测3电话中的回音对消第三次课1.BP网络具有一层或多层隐含层,除了在多层网络上与前面已介绍过的感知器模型有不同外,其主要差别也表现在激活函数上。

感知器是二值型的函数。

BP网络的激活函数必须是处处可微的,所以它就不能采用二值型的阀值函数{0,1}或符号函数{-1,1},BP网络经常使用的是S型的对数或正切激活函数和线性函数。

用了“BP算法”进行训练的“多层感知器模型3.3.3.3.2.BP网络主要用于(1)Functions approximation:BP can be applied to learn non-linear functions(2)pattern recognition模式识别3.第四次课1.2.径向基函数(RBF-Radial Basis Function)神经网络是由J.Moody和C.Darken 在80年代末提出的一种神经网络,它是具有单隐层的三层前馈网络。

3.3.3.5.6.7.Learning Algorithm如何确定RBF网络隐层节点的中心及基宽度参数是一个困难的问题8.学习算法需要求解的参数1)径向基函数的中心2)方差3)隐含层到输出层的权值学习方法分类(按RBF中心选取方法的不同分)1)随机选取中心法2)自组织选取中心法3)有监督选取中心法4)正交最小二乘法等.自组织选取中心法:第一步,自组织学习阶段无导师学习过程,求解隐含层基函数的中心与方差;第二步,有导师学习阶段求解隐含层到输出层之间的权值。

9.无导师学习阶段,对所有样本的输入进行聚类,求得各隐层节点的RBF的中心ci。

如用k均值聚类算法,调整中心,算法步骤为:(1)给定各隐节点的初始中心;(2)计算距离(欧氏距离)并求出最小距离的节点(3)调整中心(4)计算节点的距离(5)重新调整聚类中心(6).求解方差有导师学习阶段:计算隐含层和输出层之间的权值10,。

Applications of RBF networkFunction Approximation:ClassificationPattern recognition, information process, image process system modelingFailure diagnosisRBF 神经网络结构简单、训练简洁且学习收敛速度快,因此被广泛引用于时间序列分析、模式识别、非线性控制和图像处理等领域。

11.12.13.(1)从网络结构上看。

BP神经网络实行权连接,而RBF神经网络输入层到隐层单元之间为直接连接,隐层到输出层实行权连接。

BP神经网络隐层单元的转移函数一般选择非线性函数(如反正切函数),RBF神经网络隐层单元的转移函数是关于中心对称的RBF(如高斯函数)。

BP神经网络是三层或三层以上的静态前馈神经网络,其隐层和隐层节点数不容易确定,没有普遍适用的规律可循,一旦网络的结构确定下来,在训练阶段网络结构将不再变化;RBF神经网络是三层静态前馈神经网络,隐层单元数也就是网络的结构可以根据研究的具体问题,在训练阶段自适应地调整,这样网络的适用性就更好了.(2)从训练算法上看。

BP神经网络需要确定的参数是连接权值和阈值,主要的训练算法为BP算法和改进的BP算法。

但BP算法易限于局部极小值,学习过程收敛速度慢,隐层和隐层节点数难以确定;RBF神经网络的训练算法支持在线和离线训练,可以动态确定网络结构和隐层单元的数据中心和扩展常数,学习速度快,比BP算法表现出更好的性能。

总之,RBF神经网络可以根据具体问题确定相应的网络拓扑结构,具有自学习、自组织、自适应功能,学习速度快,可以进行大范围的数据融合,可以并行高速地处理数据。

RBF神经网络的优良特性使得其显示出比BP神经网络更强的生命力,正在越来越多的领域内替代BP神经网络。

目前,RBF神经网络已经成功地用于非线性函数、时间序列分析、数据分类、模式识别、信息处理、图像处理、系统建模、控制和故障诊断等.第六次课1.2.竞争学习的概念与原理竞争学习是自组织网络中最常用的一种学习策略,首先说明与之相关的几个基本概念。

1 )模式、分类、聚类与相似性模式:一般当网络涉及识别、分类问题时,常用输入模式(而不称输入样本);分类:将待识别的输入模式划分为各自的模式类中去;聚类:无导师指导的分类称为聚类,聚类的目的是将相似的模式样本划归一类;相似性:输入模式的聚类依据。

2)相似性测量神经网络的输入模式用向量表示,比较不同模式的相似性可转化为比较两个向量的距离,因而可用模式向量间的距离作为聚类判据。

模式识别中常用到的两种聚类判据是欧式最小距离法和余弦法。

3.自组织竞争网络机理:采用无教师学习方式,无须期望输出,只是根据数据样本进行学习,并调整自身的权重以达到学习目的。

自组织神经网络的学习规则大都采用竞争型的学习规则。

竞争型神经网络的基本思想是网络竞争层的各神经元通过竞争来获取对输入模式的响应机会,最后仅有一个神经元成为胜利者,并将与获胜神经元有关的各连接权值向着更有利于其竞争的方向调整。

用途:模式分类和模式识别。

4.竞争学习规则——Winner-Take-All网络的输出神经元之间相互竞争以求被激活,结果在每一时刻只有一个输出神经元被激活。

这个被激活的神经元称为竞争获胜神经元,而其它神经元的状态被抑制,故称为Winner Take All。

5.竞争学习规则——Winner-Take-All1)向量归一化2)寻找获胜神经元3)网络输出与权值调整6. SOM网络共有两层,输入层模拟感知外界输入信息的视网膜。

输出层模拟做出响应的大脑皮层。

输出层也是竞争层,网络拓扑结构形式常见有一维线阵和二维平面阵。

7.8. SOM网的学习算法(1)初始化(2)接受输入(3)寻找获胜节点(4)定义优胜邻域(5)调整权值(6)检查总模式数是否全部参与了学习(7)更新邻域Nj*(t)及学习率η(t) (8)结束检查学习率是否衰减到零或某个预定的正小数.9. SOM设计输出层设计输出层神经元数量设定和训练集样本的类别数相关,但是实际中我们往往不能清除地知道有多少类。

如果神经元节点数少于类别数,则不足以区分全部模式,训练的结果势必将相近的模式类合并为一类;相反,如果神经元节点数多于类别数,则有可能分的过细,或者是出现“死节点”,即在训练过程中,某个节点从未获胜过且远离其他获胜节点,因此它们的权值从未得到过更新。

不过一般来说,如果对类别数没有确定知识,宁可先设定较多的节点数,以便较好的映射样本的拓扑结构,如果分类过细再酌情减少输出节点。