第23卷 第4期

1997年7月自 动 化 学 报AC T A AU TO M A T ICA SIN ICA V o l.23,N o.4Jul,1997

小脑模型神经网络改进算法的研究

1)

刘 慧 许晓鸣 张钟俊

(上海交通大学自动化系 上海 200030)摘 要 该文介绍了小脑模型神经网络的基本原理,在分析Albus [1]算法的基础上,指出了

该算法在批量学习时的缺陷.针对批量学习提出了相应的改进算法,并证明了该算法的收敛

性,仿真结果表明了该改进算法具有收敛速度快的特点.

关键词 神经网络,杂凑编码,联想网络,CM AC.1) 留学回国人员科研基金资助课题.

收稿日期 1995-04-101 引言

自1982年H o pfield 发表了关于反馈神经网络的文章以及Rumelha rt 等人发表了专著PDP 以来,在世界范围内掀起了研究神经网络的热潮.近年来,人工神经元网络和人工智能在控制界中的应用研究正在兴起和蓬勃发展,特别是神经网络具有充分逼近任意复杂非线性函数的能力,为解决复杂的非线性问题开辟了一条控制的具有特殊联想功能的神经网络CM AC(Cerebellar Mo del Articula tion Co ntroller).

CM AC 神经网络是由J .S .Albus [2]在1975年提出的.它与Perceptro n 网相似,虽然

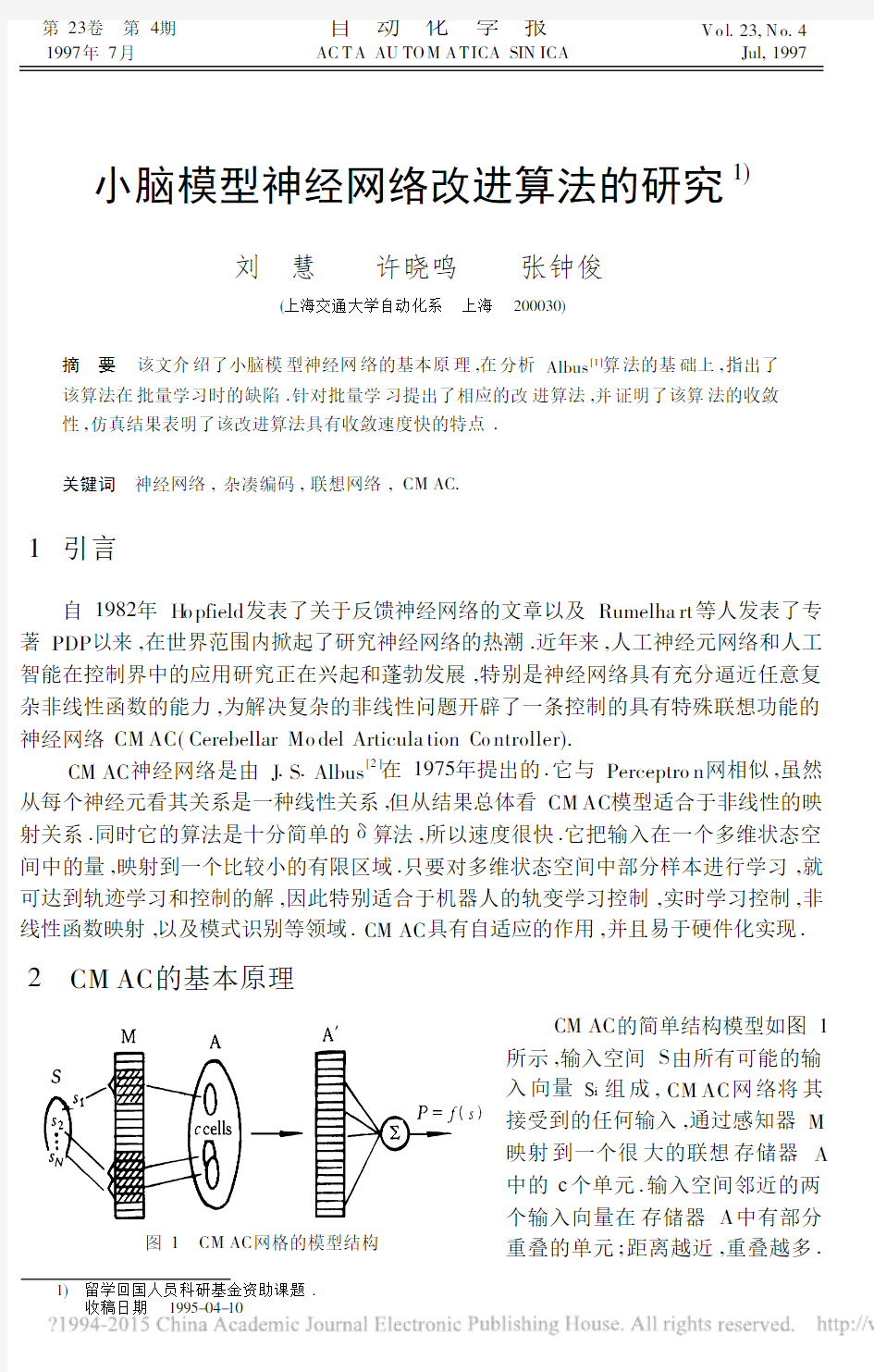

从每个神经元看其关系是一种线性关系,但从结果总体看CM AC 模型适合于非线性的映射关系.同时它的算法是十分简单的δ算法,所以速度很快.它把输入在一个多维状态空间中的量,映射到一个比较小的有限区域.只要对多维状态空间中部分样本进行学习,就可达到轨迹学习和控制的解,因此特别适合于机器人的轨变学习控制,实时学习控制,非线性函数映射,以及模式识别等领域.CM AC 具有自适应的作用,并且易于硬件化实现.图1 CM AC 网格的模型结构

2 CM AC 的基本原理

CM AC 的简单结构模型如图1

所示,输入空间S 由所有可能的输

入向量S i 组成,CM AC 网络将其

接受到的任何输入,通过感知器M

映射到一个很大的联想存储器A

中的c 个单元.输入空间邻近的两

个输入向量在存储器A 中有部分重叠的单元;距离越近,重叠越多.

反之,若输入空间远离的两个输入向量在A 中并不重叠.对一个实际系统,输入空间中的向量数是很大的,例如,某系统有10个输入,而每个输入可取100个值,则在输入空间有10010个向量,A 的存储量需要10010个单元.由于绝大多数学习问题并不包括所有输入空间中的状态,故所需的存储空间可通过常用的计算机存储压缩技术——随机杂凑编码(Hash-coding )技术映射到一个小得多的物理可实现的存储器A ′.任何CM AC 网络的输入激活c 个真实存储位置,而这些位置的值被相加得到输出向量P .

3 Albus 的CM AC 算法

设共有P 个训练样本,联想向量a i 为M →A 的映射,CM AC 网络对于第i 个训练样本的输出为f (S i )=w T a i ,理想输出为d i ,误差信号W i =d i -f (s i ),CM AC 是按W 学习律调整网络的权值,是在梯度法的基础上采用LM S 算法得到的[2]

Δw i =U c W i a 1

(1)其中U 为学习步长.

当我们在第l 次循环时对第k 个样本进行训练时,产生的修整量为U W

(l )k /c ,其中W (l )k 为第k 个样本的输出误差.因CM AC 网络内在的泛化能力,在输入空间相近的向量在实际存储器A ′中有重叠,故该修正量势必影响其它样本的输出,如它使第i 个样本的新输出为

f (s i )=w (l )T i a (l )i +c ik U c

W (l )k (2)其中c ik 为第i ,k 个样本在A ′中的重叠单元数,显然c ik =c ki .经I 次循环后,输入样本k 产生的修正量对其本身的累积输出误差为E k =

∑l U W (l )k ,与之相关的每个权的修正量为Δk =E k /c ,Δk 称为累积权误差.累积权误差对第i 个样本的输出贡献为c ik Δk .当CM AC 算法收敛,W (L )k →0,则Δk →co nst.若我们由Δi 得w i ,则在网络算法中可换一个角度将累积权

误差Δi 而不是权w i 视为需要学习的变量,这样CM AC 的收敛也可转化为Δi 的收敛问题.设网络初始权为零,则对每个输入向量s i ,网络的输出为

f (s i )=

∑P

j =1c ij Δj (3)

学习的目的是使f (s i )=d i ,即∑P j =1

c ij Δj =

d i ,写成矩阵形式C Δ=D

(4)

令 A =[a 1a 2…a p ]T ,则

AW =D (5)

通常神经网络权的学习有逐一和批量两种方法,设训练样本集为{(s 1,d 1),(s 2,d 2),…,(s p ,d p )}.逐一学习是每输入一个样本便对整个网络的权进行修正.即先对(s 1,d 1)进行学习,利用输出误差来对网络的权进行修正,使网络的对应关系满足f (s 1)=d 1,设此时网络的权为w 1.然后以w 1为基础,对样本(s 2,d 2)进行学习,直到权值w 2满足f (s 2)=d 2.但是一般情况下,w 1≠w 2,故此时未必有f (s 1)=d 1成立.所以逐一学习的方法会出现学了483 4期刘 慧等:小脑模型神经网络改进算法的研究

新的,忘了旧的“遗忘”现象.为了克服这个缺点需采用反复循环学习,但这样又会带来收敛慢的问题.我们建议用批量学习的方法来对权进行更新,将样本一一输入,为一批样本输入后用总的误差来修整权,这种方法可以克服“遗忘”的缺点,又有较快的收敛速度.

Albus 本人并未给出CM AC 算法收敛性的证明,Wo ng [3]和Parks [4]

从线性方程组迭代解的角度,W ong [5]还从频域的角度阐述了Albus 算法的收敛性问题.他们的研究都是针对逐一学习的,对批量学习的情况并未进行研究.作者针对批量学习情况进行了一些探索,指出了Albus 算法在逐一学习时适用,而在批量学习时易发散的缺陷,并提出了相应的改进算法.4 批量学习时Albus 算法的缺陷及改进算法

定理1.对于多输入输出目标中的一组训练样本,如果输入空间被量化后不存在两个不同训练样本激活相同一组神经元的情况,则Albus 算法采用批量学习方法时的收敛条

件为c 2 .证明.当Albus 算法采用批量学习时,累积权误差的修正公式为 Δ(l +1)i =1c (d i -∑j ≠i c ij Δ(l )j ),(6)其中 c ij =c -|i -j | if |i -j | 0 o therwise.(7) 为方便起见,设输入输出空间均为一维,所有训练样本的量化值都在[0,R ]上,则所需神经元为R +c -1个. 当收敛到Δ*时,由式(6)得 Δ*i = 1c (d i -∑j ≠i c ij Δ*j ).(8)令 e (l )i =Δ(l )i -Δ*i ,得e (l +1) i =-1c ∑j ≠i c ij e (l )j .(9) e 为一有限长的N 1点非周期序列,N 1=R +2c -2.将其作周期延拓,e 可写成Fouri-er 级数形式e n =∑N 1 -1k =0 e ~k ex p(j 2c N 1kn ).(10) 将(10)代入(9)并考虑(7)可得e ~(l + 1)k =H (e j k )e ~(l )k ,(11)其中 H (e j k )=-1c (∑c n =1(c -n )e -j k n +∑c n =1(c -n )e j k n )=-j sin k -sin(c k )/c 2sin 2(k /2).(12) c 一般取为32~256,故sin(c k )/c 可忽略.若k ≠2c ,则 484自 动 化 学 报23卷 |H (e j k )|≈|ctg k 2 |.(13) 当且仅当|H (e j k )|<1时算法收敛,在一个数字频率周期(2c )内|H (e j k )|<1,即c 2 当k =2c 时,k ∈Ker (A ),不影响w 和Δ的收敛.所以Albus 算法采用批量学习时的收敛条件为c 2 .推论1.对于多输入输出目标中的一组训练样本,设所有训练样本的量化值都在[0,R ]上,感受野宽度为c .如果输入空间被量化后不存在两个不同训练样本激活相同一组神经元的情况,则Albus 算法采用批量学习方法时的收敛条件为 N 14 ,N 1=R +2c -2.证明. 将k =2c k N 1 代入式(14),得 c 2<2c k N 1<3c 2. ∴ N 14 由Fourier 级数(10)知,k 的取值为[0,N ,-1]间的连续整数,而采用Albus 算法批 量学习时的收敛条件为N 14 ,N 1-1]两段取值时算法不收敛.N 1越大,即量化取值数R 和感受野宽度c 越大,不收敛的点越多. 为了克服Albus 算法对批量学习不太适合的缺陷,提出了一种改进的CM AC 算法把式(1)修改为 Δw i =U c W i q a i ,(16) 其中q 为批量学习一次每个权平均被更新的次数. 定理2.对于多输入输出目标中的一组训练样本,如果输入空间被量化后不存在两个不同训练样本激活相同一组神经元的情况,改进CM AC 算法采用批量学习方法时的收敛条件为2ctg -1q 证明. 改进CM AC 算法采用批量方法对权进行更新时,相应的算法收敛证明中的公式(13)变为 |H (e j k )|≈ 1q |ctg k 2|.(17) 当且仅当|H (e j k )|<1时算法收敛,在一个数字频率周期(2c )内|H (e j k )|<1,即2ctg -1q 当k =2c 时,k ∈Ker (A ),不影响w 和Δ的收敛.所以改进CM AC 算法采用批量学习时的收敛条件为2ctg -1q 讨论.由于CM AC 网络所固有的局域泛化能力,每个输入向量使其对应量化值周围c 个感知器同时被激励;相应地,当一批样本被学习一遍后,每个网络的权也不止一次被更新.所以min q = 2.当q 取最小值2时,由(18)得改进算法的收敛条件为0.93 4期刘 慧等:小脑模型神经网络改进算法的研究 弧度,改进算法的收敛范围比Albus算法(14)宽,q越大改进算法的收敛范围将越宽. 推论2.对于多输入输出目标中的一组训练样本,设所有训练样本的量化值都在[0, R]上,感受野宽度为c.如果输入空间被量化后不存在两个不同训练样本激活相同一组神 经元的情况,改进CM AC算法采用批量学习方法时的收敛条件为(ctg-1q)·N1 c (c-ctg-1q)·N1 c, N1=R+2c-2. 证明. 将k=2c k N1 代入式(18)即可得改进算法采用批量学习时的收敛条件为 (ctg-1q)N1 c (c-ctg-1q)N1 c.(19) 讨论.将(19)进一步展开为 N1 4-b1 3N1 4 +b2,(20) 其中 b1=N1 4 - N1ctg-1q π= N1(c-ctg-1q) 4π , b2=N1 4 - N1ctg-1q π= N1(c-4ctg-1q) 4π . (21) 当q取最小值2时,ctg-1q=0.46弧度,而反余切函数在区间[0,c]内是递减的,所以ctg-1q<0.46,从而b1>0,b2>0.可见改进算法的收敛范围比Albus算法宽.q越大则b1和b2越大,改进算法的收敛范围也将越宽. 改进CM AC算法对逐一学习也是适用的,其收敛性证明可参见文献[4],其中累积权误差的修正类似Joco bi迭代法解线性方程组. 5 仿真结果 设某CM AC网络用来实现下列一维非线性函数的映射, f(s)=sin(2c s 360 ).(22)其中输入变量s i∈[0,180],分辨率为1,所有训练样本的量化值都在[0,R]上,R=180. CM AC网络的感受野宽度c=32,批量学习一次每个权平均被更新的次数q取为6.则N1 =242,ctg-1q=0.17.按Δs=5的间隔均匀取点,由式(22)进行理论计算,可得37组输入输出的样本数据,运用这些样本数据分别按Albus算法和本文的改进算法对CM AC神经网络进行训练.为了显示网络的泛化能力,计算网络输出时采用了不同于训练时的数据Δs= 6.由式(15)计算得Albus算法批量训练时的收敛条件为60 图2所示为逐一学习时的误差曲线,两种算法都可取得较好的收敛效果,而本文提出的改进方法收敛速度更快一些.图3是在批量学习时的误差曲线,由该图可见,Albus算法易导致发散,而采用本文的改进算法可以获得收敛较快的效果. 486自 动 化 学 报23卷 图2 逐一学 习误差曲线 图3 批量学习误差曲线 6 结论 本文在对Albus 算法研究的基础上,提出了适合于批量学习的改进算法,并在理论上证明了该算法的收敛性,仿真结果表明了该算法在逐一和批量学习时都有较好的收敛性和快速性. 参考 文献[1] Albus J S.Data s torage in th e cerebellar model ar ticulation controller (CM ·AC).Trans.A S ME ,J .Dyn . Syst .Meas .Contr .,1975,97 :228—233.[2] Albus J S.A new approach to manipu lator control :Th e cerebellar m od el articulation Con troller (CM AC). Trans .A SME ,J .Dyn .Syst .Meas .Contr .,1975,97:220—227. [3] W ong Y F,Sideris A.Learning conv ergence in th e cerebellar model articulation controller .I EE E Trans .on N eural Networks ,1992,3(1):115—121. [4] Parks P C ,M ilitzer J .Conv ergence p roperties of associative memo ry s to rage for learning control sys tem .Au - toma tion and Remote Contr ol ,1989,50(2):254—286. [5] W ong Y F .CM AC learning is gov erned by a single parameter .IE EE Int .Conf .on N N ,1993,1439—1443.AN IMPROVED C MAC NEURAL NETW ORK ALGORITHM 487 4期刘 慧等:小脑模型神经网络改进算法的研究 L IU H U I X U X IAOMIN G Z HANG Z H ONG JUN (Department of Automation,Shanghai Jiaot on g University,Shangh ai200030) Abstract The basic pri nciple of CM A C(Cerebelllar M odel Articulation Co nt roller)is intro-duced.Based on a detail analysi s of Albus algori thm[1],the paper points out i ts draw back in bat ch learning.An improved algori thm is proposed and theo retical proof s are also given.Sim-ulation resul ts show that the improved method has higher speed and better co nv ergence than the original. Key words N eural net work,hash-codi ng,associative netw ork,CM AC. 刘 慧 1968年生,1996年获上海交通大学自动控制理论及应用专业博士学位.现为上海交通大学自动化系讲师.主要研究兴趣是智能控制,学习控制及神经网络在控制中的应用. 许晓鸣 1957年生,现任上海交通大学自动化系教授、博士生导师.主要研究兴趣是智能控制和复杂工业系统预测控制等方面的研究. 488自 动 化 学 报23卷 基于动态BP神经网络的预测方法及其应用来源:中国论文下载中心 [ 08-05-05 15:35:00 ] 作者:朱海燕朱晓莲黄頔编辑:studa0714 摘要人工神经网络是一种新的数学建模方式,它具有通过学习逼近任意非线性映射的能力。本文提出了一种基于动态BP神经网络的预测方法,阐述了其基本原理,并以典型实例验证。 关键字神经网络,BP模型,预测 1 引言 在系统建模、辨识和预测中,对于线性系统,在频域,传递函数矩阵可以很好地表达系统的黑箱式输入输出模型;在时域,Box-Jenkins方法、回归分析方法、ARMA模型等,通过各种参数估计方法也可以给出描述。对于非线性时间序列预测系统,双线性模型、门限自回归模型、ARCH模型都需要在对数据的内在规律知道不多的情况下对序列间关系进行假定。可以说传统的非线性系统预测,在理论研究和实际应用方面,都存在极大的困难。相比之下,神经网络可以在不了解输入或输出变量间关系的前提下完成非线性建模[4,6]。神经元、神经网络都有非线性、非局域性、非定常性、非凸性和混沌等特性,与各种预测方法有机结合具有很好的发展前景,也给预测系统带来了新的方向与突破。建模算法和预测系统的稳定性、动态性等研究成为当今热点问题。目前在系统建模与预测中,应用最多的是静态的多层前向神经网络,这主要是因为这种网络具有通过学习逼近任意非线性映射的能力。利用静态的多层前向神经网络建立系统的输入/输出模型,本质上就是基于网络逼近能力,通过学习获知系统差分方程中的非线性函数。但在实际应用中,需要建模和预测的多为非线性动态系统,利用静态的多层前向神经网络必须事先给定模型的阶次,即预先确定系统的模型,这一点非常难做到。近来,有关基于动态网络的建模和预测的研究,代表了神经网络建模和预测新的发展方向。 2 BP神经网络模型 BP网络是采用Widrow-Hoff学习算法和非线性可微转移函数的多层网络。典型的BP算法采用梯度下降法,也就是Widrow-Hoff算法。现在有许多基本的优化算法,例如变尺度算法和牛顿算法。如图1所示,BP神经网络包括以下单元:①处理单元(神经元)(图中用圆圈表示),即神经网络的基本组成部分。输入层的处理单元只是将输入值转入相邻的联接权重,隐层和输出层的处理单元将它们的输入值求和并根据转移函数计算输出值。②联接权重(图中如V,W)。它将神经网络中的处理单元联系起来,其值随各处理单元的联接程度而变化。③层。神经网络一般具有输入层x、隐层y和输出层o。④阈值。其值可为恒值或可变值,它可使网络能更自由地获取所要描述的函数关系。⑤转移函数F。它是将输入的数据转化为输出的处理单元,通常为非线性函数。 #include "stdio.h" #include "stdlib.h" #include "time.h" #include "math.h" /********************************************* inpoints 为输入神经元个数,可改变 outpoints为输出神经元个数 defaultpoints为隐层神经元个数 datagrough为样本数据个数 ********************************************** ******以下数据定义可以修改*****/ #define A 0 #define a 1 #define b 1 #define c 1 #define ALFA 0.85 #define BETA 0.2 //学习率0~1 #define Total 20000 #define inpoints 9 #define outpoints 5 #define defaultpoints 28 #define datagrough 44 #define forecastdata 4 /**********定义所需变量********/ double InpointData[datagrough][inpoints],OutpointData[datagrough][outpoints]; /* 输入输出数据*/ double InpointData_MAX[inpoints],InpointData_MIN[inpoints]; /* 每个因素最大数据*/ double OutpointData_MAX[outpoints],OutpointData_MIN[outpoints]; /* 每个因素最小数据*/ double w[defaultpoints][inpoints],limen[defaultpoints],v[outpoints][defaultpoints]; /* 连接权值、阈值*/ double dlta_w[defaultpoints][inpoints],dlta_limen[defaultpoints],dlta_v[outpoints][defaultpoints]; /* 连接权、阈值修正值*/ double defaultOutpoint[defaultpoints],Outpoint_dp[outpoints],Outpoint_ep[datagrough]; /**************************读数据文件******************************/ void ReadData() { FILE *fp1,*fp2; int i,j; if((fp1=fopen("D:\\data\\训练输入.txt","r"))==NULL) { BP 神经网络模型 近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注. 目前,已发展了几十种神经网络,例如Hopficld 模型,Feldmann 等的连接型网络模型,Hinton 等的玻尔茨曼机模型,以及Rumelhart 等的多层感知机模型和Kohonen 的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart 等人提出了误差反向传递学习算法(即BP 算),实现了Minsky 的多层网络设想,如图34-1所示。 BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。节点的作用的激励函数通常选取S 型函数,如 Q x e x f /11 )(-+= 式中Q 为调整激励函数形式的Sigmoid 参数。该算法的学习过程由正向传播和反向传播组成。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向输出层。每一层神经元的状态只影响下一层神经元的状态。如果输出层得不到期望的输出,则转入反向传播,将误差信号沿原来的连接通道返回,通过修改各层神经元的权值,使得误差信号最小。 社含有n 个节点的任意网络,各节点之特性为Sigmoid 型。为简便起见,指定网络只有一个输出y ,任一节点i 的输出为O i ,并设有N 个样本(x k ,y k )(k =1,2,3,…,N ),对某一输入x k ,网络输出为y k 节点i 的输出为O ik ,节点j 的输入为net jk = ∑i ik ij O W 并将误差函数定义为∑=-=N k k k y y E 12 )(21 B P神经网络算法步骤 SANY GROUP system office room 【SANYUA16H- 传统的BP 算法简述 BP 算法是一种有监督式的学习算法,其主要思想是:输入学习样本,使用反向传播算法对网络的权值和偏差进行反复的调整训练,使输出的向量与期望向量尽可能地接近,当网络输出层的误差平方和小于指定的误差时训练完成,保存网络的权值和偏差。具体步骤如下: (1)初始化,随机给定各连接权[w],[v]及阀值θi ,rt 。 (2)由给定的输入输出模式对计算隐层、输出层各单元输出 (3)计算新的连接权及阀值,计算公式如下: (4)选取下一个输入模式对返回第2步反复训练直到网络设输出误差达到要求结束训练。 第一步,网络初始化 给各连接权值分别赋一个区间(-1,1)内的随机数,设定误差函数e ,给定计 算精度值 和最大学习次数M 。 第二步,随机选取第k 个输入样本及对应期望输出 ()12()(),(),,()q k d k d k d k =o d ()12()(),(),,()n k x k x k x k =x 第三步,计算隐含层各神经元的输入和输出 第四步,利用网络期望输出和实际输出,计算误差函数对输出层的各神经元的偏导数()o k a δ 第五步,利用隐含层到输出层的连接权值、输出层的()o k δ和隐含层的输出计算误差函数对隐含层各神经元的偏导数()h k δ 第六步,利用输出层各神经元的()o k δ和隐含层各神经元的输出来修正连接权值()ho w k 第七步,利用隐含层各神经元的()h k δ和输入层各神经元的输入修正连接权。 第八步,计算全局误差211 1(()())2q m o o k o E d k y k m ===-∑∑ ε BP神经网络模型与学习算法 BP神经网络模型与学习算法 (1) 一,什么是BP (1) 二、反向传播BP模型 (8) 一,什么是BP "BP(Back Propagation)网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。它的学习规则是使用最速下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)。" 我们现在来分析下这些话: ?“是一种按误差逆传播算法训练的多层前馈网络” BP是后向传播的英文缩写,那么传播对象是什么?传播的目的是什么?传播的方式是后向,可这又是什么意思呢。 传播的对象是误差,传播的目的是得到所有层的估计误差,后向是说由后层误差推导前层误差: 即BP的思想可以总结为 利用输出后的误差来估计输出层的直接前导层的误差,再用这个误差估计更前一层的误差,如此一层一层的反传下去,就获得了所有其他各层的误差估计。 ?“BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)” 最简单的三层BP: ?“BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。”BP利用一种称为激活函数来描述层与层输出之间的关系,从而模拟各层神经元之间的交互反应。 激活函数必须满足处处可导的条件。那么比较常用的是一种称为S型函数的激活函数: 那么上面的函数为什么称为是S型函数呢: 我们来看它的形态和它导数的形态: p.s. S型函数的导数: 神经网络学习算法的过拟合问题及解决方法 李俭川 秦国军 温熙森 胡茑庆 (国防科技大学机电工程与自动化学院 长沙,410073) 摘要 针对反向传播学习算法及其改进算法中出现的过拟合问题,探讨了三种解决方法:调整法、提前停止法和隐层节点自生成法,并用实例对三种方法进行了验证和比较。其中,调整法和提前停 止法针对一个较大的网络可以解决过拟合问题,而隐层节点自生成法的提出既能避免过拟合问 题,又能获得最少神经元网络结构。这三种方法有效地解决了在神经网络学习过程中的过拟合问 题,提高了网络的适应性。它们不仅适合于函数逼近,而且可以推广到其他网络结构等应用领域。关键词 神经网络 计算机 BP 算法 过拟合 均方误差 自生成 故障诊断 中图分类号 T H 165.3神经网络已经在模式分类、机器视觉、机器听觉、智能计算、自动控制、故障诊断、信息处理、地震勘探、通信、雷达和声纳等领域有着十分广泛的应用前景,并随着计算机技术和信号处理技术的发展而发展。应用神经网络必须解决两个问题:模型和算法。现有的神经网络模型已达上百种[1] ,应用最多的是Hopfield 神经网络、多层感知器、自组织神经网络、概率神经网络以及它们的改进型。自Rumellhart D E,H inton 和Williams 提出误差反向传播算法(即BP 算法),解决了神经网络在引入隐层节点后的学习(或训练)问题后,已经发展了许多的改进学习算法[1],如快速下降法、共轭梯度法、一维搜索法及Lev enberg -Mar quardt 法等,其收敛速度很快,能满足实时性要求,但也存在着一些问题。1 学习算法及其过拟合问题 BP 算法及其改进算法是目前应用最广泛的学习算法,尽管不能证明这类算法能象单层感知器一样收敛,但是对许多问题的解决是成功的[2]。实际上,BP 算法是把一组样本的输入输出问题,变为一个非线性优化问题,它使用了优化技术中最普通的一种梯度下降法,用迭代运算求解权值并相应于学习记忆问题,加入隐层节点可使优化问题的可调参数增加,这样可得到更精确的解。要应用学习算法对网络进行训练,首先需要确定网络的结构,即输入、输出层神经元数目和隐层数及其神经元数目。 如何适宜地选取隐含层神经元的数目还没有确定的规律可以指导,但是,隐含层神经元数目是否合适对整个网络是否能够正常工作具有重要的甚至是决定性的意义。隐含层神经元数第22卷第4期2002年12月 振动、测试与诊断Jo ur nal of Vibr ation,M easur em ent &Diag no sis V o l.22No.4 D ec.2002 国家自然科学基金资助项目(编号:59775025)。 收稿日期:2001-07-09;修改稿收到日期:2001-12-03。 一、填空题 1、神经元(即神经细胞)是由、、和四部分构成。 2、按网络结构分,人工神经元细胞可分为和,按照学习方式分可分为和。 3、人工神经网络常见的输出变换函数有和。 4、人工神经网络的学习规则有、和。 5、国内外学者提出了许多面向对象的神经网络控制结构和方法,从大类上看,较具代表性的有以下几种、和。 6、在一个神经网络中,常常根据处理单元的不同处理功能,将处理单元分成有以下三种、和。 7、在一个神经网络中,基本单元神经元的三个基本要素是、和。 8、人工神经网络常见的激发函数或作用函数有、、和。9、BP网络的学习算法的改进有、和。 10、神经网络是由大量广泛互联而成的网络。 11、人工神经网络的学习方法有和。 12、从生物控制论的观点来看,神经元具有以下功能和特性、和。13、一般来讲,人工神经网络的结构可以分成两种基本类型和。 14、人工神经网络的学习算法有、和。 15、BP学习算法实际包含了两类信号不同方向的传播过程,一类是施加输入信号由输入层 经隐层到输出层,产生输出响应的过程;另一类是希望输出与实际输出之间的误差信号由输出层返回隐层和输入层,反向逐层修正连接权值和神经元输出阈值的过程。 16、神经网络的学习方式可以分成、和。 17、An biologic neuron is composed of and . 二、选择题 1、一般认为,人工神经网络(ANN)适用于() A、线性系统 B、多变量系统 C、多输入多输出系统 D、非线性系统 2、最早提出人工神经网络思想的学者是() A、McCulloch-Pitts B、Hebb C、Widrow-Hoff D、Rosenblatt 3、神经元模型一般为() A、单输入多输出 B、多输入单输出 C、单输入单输出 D、多输入多输出 三、简答题 1、简述神经网络的特点。 2、试画出一个2-3-5-2 BP网络的结构图,说明节点函数。 3、简要说明多层感知器的结构和学习算法。 4、前馈型神经网络有什么特点?哪些结构的神经网络属于前馈神经网络? https://www.doczj.com/doc/f06608366.html,/s/blog_5bbd6ec00100b5nk.html 人工神经网络算法(2008-11-20 17:24:22) 标签:杂谈 人工神经网络算法的作用机理还是比较难理解,现在以一个例子来说明其原理。这个例子是关于人的识别技术的,在门禁系统,逃犯识别,各种验证码破译,银行预留印鉴签名比对,机器人设计等领域都有比较好的应用前景,当然也可以用来做客户数据的挖掘工作,比如建立一个能筛选满足某种要求的客户群的模型。 机器识别人和我们人类识别人的机理大体相似,看到一个人也就是识别对象以后,我们首先提取其关键的外部特征比如身高,体形,面部特征,声音等等。根据这些信息大脑迅速在内部寻找相关的记忆区间,有这个人的信息的话,这个人就是熟人,否则就是陌生人。 人工神经网络就是这种机理。假设上图中X(1)代表我们为电脑输入的人的面部特征,X(2)代表人的身高特征X(3)代表人的体形特征X(4)代表人的声音特征W(1)W(2)W(3)W(4)分别代表四种特征的链接权重,这个权重非常重要,也是人工神经网络起作用的核心变量。 现在我们随便找一个人阿猫站在电脑面前,电脑根据预设变量提取这个人的信息,阿猫面部怎么样,身高多少,体形胖瘦,声音有什么特征,链接权重初始值是随机的,假设每一个W均是0.25,这时候电脑按这个公式自动计 算,Y=X(1)*W(1)+X(2)*W(2)+X(3)*W(3)+X(4)*W(4)得出一个结果Y,这个Y要和一个门槛值(设为Q)进行比较,如果Y>Q,那么电脑就判定这个人是阿猫,否则判定不是阿猫.由于第一次计算电脑没有经验,所以结果是随机的.一般我们设定是正确的,因为我们输入的就是阿猫的身体数据啊. 现在还是阿猫站在电脑面前,不过阿猫怕被电脑认出来,所以换了一件衣服,这个行为会影响阿猫的体形,也就是X(3)变了,那么最后计算的Y值也就变了,它和Q比较的结果随即发生变化,这时候电脑的判断失误,它的结论是这个人不是阿猫.但是我们告诉它这个人就是阿猫,电脑就会追溯自己的判断过程,到底是哪一步出错了,结果发现原来阿猫体形X(3)这个 体征的变化导致了其判断失误,很显然,体形X(3)欺骗了它,这个属性在人的识别中不是那 么重要,电脑自动修改其权重W(3),第一次我对你是0.25的相信,现在我降低信任值,我0.10的相信你.修改了这个权重就意味着电脑通过学习认为体形在判断一个人是否是自己认识的人的时候并不是那么重要.这就是机器学习的一个循环.我们可以要求阿猫再穿一双高跟皮鞋改变一下身高这个属性,让电脑再一次进行学习,通过变换所有可能变换的外部特征,轮换让电脑学习记忆,它就会记住阿猫这个人比较关键的特征,也就是没有经过修改的特征.也就是电脑通过学习会总结出识别阿猫甚至任何一个人所依赖的关键特征.经过阿猫的训练电脑,电脑已经非常聪明了,这时你在让阿猫换身衣服或者换双鞋站在电脑前面,电脑都可以迅速的判断这个人就是阿猫.因为电脑已经不主要依据这些特征识别人了,通过改变衣服,身高骗不了它.当然,有时候如果电脑赖以判断的阿猫关键特征发生变化,它也会判断失误.我们就 毕业论文(设 计) 题目基于神经网络的中国人口预测 算法研究 所在院(系)数学与计算机科学学院 专业班级信息与计算科学1102班 指导教师赵晖 完成地点陕西理工学院 2015年5 月25日 基于神经网络的中国人口预测算法研究 作者:宋波 (陕理工学院数学与计算机科学学院信息与计算科学专业1102班,陕西汉中 723000) 指导教师:赵晖 [摘要]我国现正处于全面建成小康社会时期,人口发展面临着巨大的挑战,经济社会发展与资源环境的矛盾日益尖锐。我国是个人口大国、资源小国,这对矛盾将长期制约我国经济社会的发展。准确地预测未来人口的发展趋势,制定合理的人口规划和人口布局方案具有重大的理论意义和实用意义。本文介绍了人口预测的概念及发展规律等。 首先,本文考虑到人口预测具有大量冗余、流动范围和数量扩大的特性,又为提高人口预测的效果,因此,使用归一化对人口数据进行了处理,该方法不需要离散化原数据,这样就保证了人口预测的准确性和原始数据的信息完整性。其次,本文提出了一种基于神经网络预测的优化算法,该算法避免了人们在预测中参数选择的主观性而带来的精度的风险,增强了人口预测的准确性。同时,为说明该算法的有效性,又设计了几种人们通常所用的人口模型和灰色预测模型算法,并用相同的数据进行实验,得到了良好的效果,即本文算法的人口预测最为准确,其预测性能明显优于其他算法,而这主要是参数的选择对于增强预测性方面的影响,最终导致人口预测精确度。同时,在算法的稳定性和扩展性方面,该算法也明显优于其他算法。 考虑出生率、死亡率、人口增长率等因素的影响,重建神经网络模型预测人口数量。 [关键词] 神经网络人口模型灰色预测模型软件 神经网络系统建模综述 一、人工神经网络简介 1.1人工神经网络的发展历史 人工神经网络早期的研究工作应追溯至本世纪40年代。下面以时间顺序,以著名的人物或某一方面突出的研究成果为线索,简要介绍人工神经网络的发展历史。 1943年,心理学家W·Mcculloch和数理逻辑学家W·Pitts在分析、总结神经元基本特性的基础上首先提出神经元的数学模型。此模型沿用至今,并且直接影响着这一领域研究的进展。因而,他们两人可称为人工神经网络研究的先驱。 1945年冯·诺依曼领导的设计小组试制成功存储程序式电子计算机,标志着电子计算机时代的开始。 50年代末,F·Rosenblatt设计制作了“感知机”,它是一种多层的神经网络。这项工作首次把人工神经网络的研究从理论探讨付诸工程实践。 在60年代初期,Widrow提出了自适应线性元件网络,这是一种连续取值的线性加权求和阈值网络。后来,在此基础上发展了非线性多层自适应网络。当时,这些工作虽未标出神经网络的名称,而实际上就是一种人工神经网络模型。 80年代初期,模拟与数字混合的超大规模集成电路制作技术提高到新的水平,完全付诸实用化,此外,数字计算机的发展在若干应用领域遇到困难。这一背景预示,向人工神经网络寻求出路的时机已经成熟。美国的物理学家Hopfield于1982年和1984年在美国科学院院刊上发表了两篇关于人工神经网络研究的论文,引起了巨大的反响。人们重新认识到神经网络的威力以及付诸应用的现实性。随即,一大批学者和研究人员围绕着Hopfield提出的方法展开了进一步的工作,形成了80年代中期以来人工神经网络的研究热潮。 1.2人工神经网络的工作原理 人工神经网络是由大量处理单元广泛互连而成的网络结构,是人脑的抽象、简化和模拟。人工神经网络就是模拟人思维的第二种方式。这是一个非线性动力学系统,其特色在于信息的分布式存储和并行协同处理。虽然单个神经元的结构极其简单,功能有限,但大量神经元构成的网络系统所能实现的行为却是极其丰富多彩的。 人工神经网络首先要以一定的学习准则进行学习,然后才能工作。所以网络学习的准则应该是:如果网络作出错误的的判决,则通过网络的学习,应使得网络减少下次犯同样错误的可能性。 BP神经网络 算法原理: 输入信号 x i通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输 出信号 y k,网络训练的每个样本包括输入向量x 和期望输出量d,网络输出值y 与期望输出值 d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值w ij和隐层节点与输出节点之间的联接强度T jk以及阈值,使误差沿梯度方向下降,经过反复学习训练, 确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。 变量定义: 设输入层有 n 个神经元,隐含层有p 个神经元 , 输出层有 q 个神经元 输入向量: x x1 , x2 ,L , x n 隐含层输入向量:hi hi1, hi2 ,L , hi p 隐含层输出向量:ho ho1 , ho2 ,L ,ho p 输出层输入向量:yi yi1, yi2 ,L , yi q 输出层输出向量:yo yo1, yo2 ,L , yo q 期望输出向量 : do d1, d2 ,L , d q 输入层与中间层的连接权值:w ih 隐含层与输出层的连接权值:w ho 隐含层各神经元的阈值: b h 输出层各神经元的阈值:b o 样本数据个数 :k1,2,L m 激活函数 : f 误差函数: e 1 q(d o (k )yo o (k )) 2 2 o1 算法步骤: Step1. 网络初始化 。给各连接权值分别赋一个区间( -1 , 1)内的随机数,设定 误差函数 e ,给定计算精度值 和最大学习次数 M 。 Step2. 随机选取第 k 个输入样本 x( k) x 1( k ), x 2 (k),L , x n (k ) 及对应期望输出 d o ( k) d 1 (k ), d 2 ( k),L , d q (k) Step3. 计算隐含层各神经元的输入 n hi h ( k) w ih x i (k ) b h h 1,2,L , p 和输出 i 1 ho h (k) f (hi h (k )) h 1,2, L , p 及 输 出 层 各 神 经 元 的 输 入 p yi o (k ) w ho ho h (k) b o o 1,2,L q 和输出 yo o ( k) f ( yi o (k )) o 1,2, L , p h 1 Step4. 利用网络期望输出和实际输出, 计算误差函数对输出层的各神经元的偏导 数 o (k ) 。 e e yi o w ho yi o w ho p yi o ( k) ( h w ho ho h (k ) b o ) ho h (k ) w ho w ho e ( 1 q (d o ( k) yo o (k))) 2 2 o 1 ( d o (k ) yi o yi o (d o (k) yo o (k ))f ( yi o (k )) @ o (k ) Step5. 利用隐含层到输出层的连接权值、输出层的 差函数对隐含层各神经元的偏导数 h (k ) 。 e e yi o o ( k) ho h (k ) w ho yi o w ho e e hi h (k) w ih hi h ( k) w ih n hi h (k ) ( w ih x i (k ) b h ) i 1 x i ( k) w ih w ih yo o (k )) yo o (k ) o ( k) 和隐含层的输出计算误 CMAC(神经网络)与PID混合控制器的设计 1、CMAC概述 小脑模型神经网络(CMAC—Cerebellar Model Articulation Controller)是一种表达复杂非线性函数的表格查询性自适应神经网络,该网络可通过学习算法改变表格的内容,具有信息分类存储能力。 CMAC把系统的输入状态作为一个指针,把相关信息分布式的存入一组存储单元。它本质上是一种用于映射复杂非线性函数的查表技术。具体作法是将输入空间分为许多分块,每个分块指定一个实际的存储器的位置;每个分块学习到的信息分布地存储到相邻分块的位置上;存储单元通常比所考虑问题的最大可能输入空间的分块数少的多,故实际的是多对一的映射。 CMAC已被公认为是一类联想记忆神经网络的重要组成部分,它能够学习任意多维非线性映射。CMAC算法可有效地用于非线性函数逼近、动态建模、控制系统设计等。CMAC较其他神经网络的优越性体现在: (1)它是基于局部学习的神经网络,它把信息存储在局部结构上,使每次修正的权值很少,在保证函数非线性逼近的前提下,学习速度快,适合于实时控制; (2)具有一定的泛化能力,即所谓相近输入产生行进输出,不同输入给出不同输出; (3) 连续(模拟)输入、输出能力; (4) 寻址编程方式,在利用串行计算机仿真,它可使回响速度更快; (5)作为非线性逼近器,它对学习数据出现的次序不敏感。 由于CMAC所具有的上述优越性能,使它比一般的神经网络具有更好的非线性逼近能力,更适合于复杂环境下的非线性实时控制。 CMAC的基本思想在于:在输入空间给出一个状态,从储存单元中找到对应于该状态的地址,将这些存储单元的内容求和得到CMAC的输出;将此响应值与期望输出值进行比较,并根据学习算法修改这些已激活的存储单元的内容。 图1 CMAC结构图 CMAC的设计方法分为以下三步: (1)量化(概念映射) 在输入层对N维输入空间进行划分,每一个输入都降落到N维网络基的一个超立方体单元内。中间层由若干个判断区间构成,对任意一个输入只有少数几个区间的输出为非零值,非零值区间的个数为泛化参数c,它规定了网络内部影响网络输出的区域大小。 (2)地址映射(实际映射) BP神经网络模型与学习算法 一,什么是BP "BP(Back Propagation)网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。它的学习规则是使用最速下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)。" 我们现在来分析下这些话: “是一种按误差逆传播算法训练的多层前馈网络” BP是后向传播的英文缩写,那么传播对象是什么?传播的目的是什么?传播的方式是后向,可这又是什么意思呢。 传播的对象是误差,传播的目的是得到所有层的估计误差,后向是说由后层误差推导前层误差: 即BP的思想可以总结为 利用输出后的误差来估计输出层的直接前导层的误差,再用 这个误差估计更前一层的误差,如此一层一层的反传下去,就获得了所有其他各层的误差估计。 “BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)” 我们来看一个最简单的三层BP: “BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。” BP利用一种称为激活函数来描述层与层输出之间的关系,从而模拟各层神经元之间的交互反应。 激活函数必须满足处处可导的条件。那么比较常用的是一种称为S型函数的激活函数: 那么上面的函数为什么称为是S型函数呢: 我们来看它的形态和它导数的形态: p.s. S型函数的导数: 第1期(总第125期)机械管理开发 2012年2月No.1(S UM No.125) M EC HANIC AL M ANAGEM ENT AND DEVELOPM ENT Feb.2012 0引言 从第一台计算机发明以来,以计算机为中心的信息处理技术得到迅速发展,然而,计算机在处理一些人工智能的问题时遇到很大困难。一个人很容易辨认出他人的脸庞,而计算机却很难做到。这是因为传统的信息处理,都有精确的模型做指导,而人工智能却没有,很难为计算机编写明确的指令或程序。大脑是由生物神经元构成的巨型网络,本质上不同于计算机,是一种大规模的秉性处理系统,它有学习、联想、记忆、综合等能力,并有巧妙的信息处理方法。神经元不仅是组成大脑的基本单元,而且是大脑进行信息处理的基本单元。 人工神经网络(Artificial Neural Netw ork-ANN )是对人脑最简单的一种抽象和模拟,是模仿人的大脑神经系统信息处理功能的一个智能化系统,也是人们进一步解开人脑思维奥秘的有力工具。智能是指对环境的适应和自我调整能力,人工神经网络是有智能的。预测作为决策的前提和基础,对最终决策方案的选择具有至关重要的作用。1神经网络的观念介绍1.1 神经网络的模型与内涵 神经网络的学习可分为有导师学习和无导师学习。有导师学习是指基于知识系统,在实际的学习过程中,需要通过给定的输入输出数据,所进行的一种学习方式。无导师学习是指通过系统自身的学习,来达到期望的学习结果,所进行的一种学习。该学习不需要老师为系统提供各种精确的输入输出信息和有关知识,而只需提供系统所期望达到的目标和结果。 1)MP 模型。每个神经元的状态由M P 方程决定,U i =f ((ΣT ij *V j )-θi ).其意义是每个神经元的状态是由一定强度(权值Tij )的外界刺激(输入Vj )累加后经过细胞体加工(激励函数f (x))产生一个输出。神经元的模型,见图1 。 图1神经元的模型 2)联想学习。Hebb 定理:神经元i 和神经元j 之间,同时处于兴奋状态,则他们间的连接应该加强,即 △Wij =αS i *S j.. 1.2 神经网络的几何意义与样本 1)神经网络的几何意义。N 个神经元(j =1..n )对神经元i 的总输入I i 为:I i =ΣW ij x j -θi 令I =0,得到一个几何上的超平面。从几何角度看,一个神经元代表一个超平面。超平面将解空间分为3部分:平面本身、平面上部、平面下部,神经元起到分类的作用。 2)线性样本和非线性样本。现举两例说明:OR (逻辑加法):输入为((0,0),(0,1),(1,0),(1,1)),期望输出为(0,1,1,1),见图2(a )。XOR (异或运算): 输入为((0,0),(0,1),(1,0),(1,1)),期望输出为(0,1,1,0),见图2(b )。非线性样本在最早的感知机模型中遇到了障碍,因为感知机的两层网络结构不能对非线性样本 进行超平面的划分。 (a )样本能够均匀的分布 (b )不存在一个超平面 在超平面的两侧 能将样本区分开 图2超平面的划分举例 3)非线性样本转化为线性样本。一个超平面不 收稿日期:;修回日期:作者简介:白 鹏(),男,山西太原人,在读工程硕士,研究方向:计算机软件开发。 神经网络算法的软件应用研究 白 鹏 (太原理工大学计算机科学与技术学院,山西 太原 030024) 摘 要:B ackPropagation 神经网络是重要的人工神经网络,有强大的非线性映射、自学习、泛化容错能力,并能充分 考虑主观因素,具有启发式搜索的特点。主要介绍BP 网络算法用JAVA 语言的实现方式及其在预测股票价格方面的应用。 关键词:神经网络;人工神经网络;预测中图分类号:TP391.9 文献标识码:A 文章编号:1003-773X (2012)01-0201-03 2011-04-142011-09-101979-201 5.4 神经网络与遗传算法简介 在本节中,我们将着重讲述一些在网络设计、优化、性能分析、通信路由优化、选择、神经网络控制优化中有重要应用的常用的算法,包括神经网络算法、遗传算法、模拟退火算法等方法。用这些算法可以较容易地解决一些很复杂的,常规算法很难解决的问题。这些算法都有着很深的理论背景,本节不准备详细地讨论这些算法的理论,只对算法的原理和方法作简要的讨论。 5.4.1 神经网络 1. 神经网络的简单原理 人工神经网络(Artificial Neural Networks,简写为ANNs)也简称为神经网络(NNs)或称作连接模型(Connectionist Model),是对人脑或自然神经网络(Natural Neural Network)若干基本特性的抽象和模拟。人工神经网络以对大脑的生理研究成果为基础的,其目的在于模拟大脑的某些机理与机制,实现某个方面的功能。所以说, 人工神经网络是由人工建立的以有向图为拓扑结构的动态系统,它通过对连续或断续的输入作出状态相应而进行信息处理。它是根据人的认识过程而开发出的一种算法。假如我们现在只有一些输入和相应的输出,而对如何由输入得到输出的机理并不清楚,那么我们可以把输入与输出之间的未知过程看成是一个“网络”,通过不断地给这个网络输入和相应的输出来“训练”这个网络,网络根据输入和输出不断地调节自己的各节点之间的权值来满足输入和输出。这样,当训练结束后,我们给定一个输入,网络便会根据自己已调节好的权值计算出一个输出。这就是神经网络的简单原理。 2. 神经元和神经网络的结构 如上所述,神经网络的基本结构如图5.35所示: 隐层隐层2 1 图5.35 神经网络一般都有多层,分为输入层,输出层和隐含层,层数越多,计算结果越精确,但所需的时间也就越长,所以实际应用中要根据要求设计网络层数。神经网络中每一个节点叫做一个人工神经元,他对应于人脑中的神经元。人脑神经元由细胞体、树突和轴突三部分组成,是一种根须状蔓延物。神经元的中心有一闭点,称为细胞体,它能对接受到的信息进行处理,细胞体周围的纤维有两类,轴突是较长的神经纤维,是发出信息的。树突的神经纤维较短,而分支众多,是接收信息的。一个神经元的轴突末端与另一神经元的树突之间密 算法起源 在思维学中,人类的大脑的思维分为:逻辑思维、直观思维、和灵感思维三种基本方式。 而神经网络就是利用其算法特点来模拟人脑思维的第二种方式,它是一个非线性动力学系统,其特点就是信息分布式存储和并行协同处理,虽然单个神经元的结构及其简单,功能有限,但是如果大量的神经元构成的网络系统所能实现的行为确实及其丰富多彩的。其实简单点讲就是利用该算法来模拟人类大脑来进行推理和验证的。 我们先简要的分析下人类大脑的工作过程,我小心翼翼的在网上找到了一张勉强看起来舒服的大脑图片 嗯,看着有那么点意思了,起码看起来舒服点,那还是在19世纪末,有一位叫做:Waldege 的大牛创建了神经元学活,他说人类复杂的神经系统是由数目繁多的神经元组成,说大脑皮层包括100亿个以上的神经元,每立方毫米源数万个,汗..我想的是典型的大数据。他们 相互联系形成神经网络,通过感官器官和神经来接受来自身体外的各种信息(在神经网络算法中我们称:训练)传递中枢神经,然后经过对信息的分析和综合,再通过运动神经发出控制信息(比如我在博客园敲文字),依次来实现机体与外部环境的联系。 神经元这玩意跟其它细胞一样,包括:细胞核、细胞质和细胞核,但是它还有比较特殊的,比如有许多突起,就跟上面的那个图片一样,分为:细胞体、轴突和树突三分部。细胞体内有细胞核,突起的作用是传递信息。树突的作用是作为引入输入信息的突起,而轴突是作为输出端的突起,但它只有一个。 也就是说一个神经元它有N个输入(树突),然后经过信息加工(细胞核),然后只有一 个输出(轴突)。而神经元之间四通过树突和另一个神经元的轴突相联系,同时进行着信息传递和加工。我去...好复杂.... 神经网络算法详解 第0节、引例 本文以Fisher的Iris数据集作为神经网络程序的测试数据集。Iris数据集可以在https://www.doczj.com/doc/f06608366.html,/wiki/Iris_flower_data_set 找到。这里简要介绍一下Iris数据集: 有一批Iris花,已知这批Iris花可分为3个品种,现需要对其进行分类。不同品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度会有差异。我们现有一批已知品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度的数据。 一种解决方法是用已有的数据训练一个神经网络用作分类器。 如果你只想用C#或Matlab快速实现神经网络来解决你手头上的问题,或者已经了解神经网络基本原理,请直接跳到第二节——神经网络实现。 第一节、神经网络基本原理 1. 人工神经元( Artificial Neuron )模型 人工神经元是神经网络的基本元素,其原理可以用下图表示: 图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为: 图中yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ] 则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net 为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function ) 几种神经网络模型及其应用 摘要:本文介绍了径向基网络,支撑矢量机,小波神经网络,反馈神经网络这几种神经网络结构的基本概念与特点,并对它们在科研方面的具体应用做了一些介绍。 关键词:神经网络径向基网络支撑矢量机小波神经网络反馈神经网络Several neural network models and their application Abstract: This paper introduced the RBF networks, support vector machines, wavelet neural networks, feedback neural networks with their concepts and features, as well as their applications in scientific research field. Key words: neural networks RBF networks support vector machines wavelet neural networks feedback neural networks 2 引言 随着对神经网络理论的不断深入研究,其应用目前已经渗透到各个领域。并在智能控制,模式识别,计算机视觉,自适应滤波和信号处理,非线性优化,语音识别,传感技术与机器人,生物医学工程等方面取得了令人吃惊的成绩。本文介绍几种典型的神经网络,径向基神经网络,支撑矢量机,小波神经网络和反馈神经网络的概念及它们在科研中的一些具体应用。 1. 径向基网络 1.1 径向基网络的概念 径向基的理论最早由Hardy,Harder和Desmarais 等人提出。径向基函数(Radial Basis Function,RBF)神经网络,它的输出与连接权之间呈线性关系,因此可采用保证全局收敛的线性优化算法。径向基神经网络(RBFNN)是 3 层单元的神经网络,它是一种静态的神经网络,与函数逼近理论相吻合并且具有唯一的最佳逼近点。由于其结构简单且神经元的敏感区较小,因此可以广泛地应用于非线性函数的局部逼近中。主要影响其网络性能的参数有3 个:输出层权值向量,隐层神经元的中心以及隐层神经元的宽度(方差)。一般径向基网络的学习总是从网络的权值入手,然后逐步调整网络的其它参数,由于权值与神经元中心及宽度有着直接关系,一旦权值确定,其它两个参数的调整就相对困难。 其一般结构如下: 如图 1 所示,该网络由三层构成,各层含义如下: 第一层:输入层:输入层神经元只起连接作用。 第二层:隐含层:隐含层神经元的变换函数为高斯核. 第三层:输出层:它对输入模式的作用做出响应. 图 1. 径向基神经网络拓扑结构 其数学模型通常如下: 设网络的输入为x = ( x1 , x2 , ?, xH ) T,输入层神经元至隐含层第j 个神经元的中心矢 为vj = ( v1 j , v2 j , ?, vIj ) T (1 ≤j ≤H),隐含层第j 个神经元对应输入x的状态为:zj = φ= ‖x - vj ‖= exp Σx1 - vij ) 2 / (2σ2j ) ,其中σ(1≤j ≤H)为隐含层第j个神神经网络分析应用

改进的BP神经网络算法(C语言源码)

神经网络模型应用实例

BP神经网络算法步骤

BP神经网络模型与学习算法

神经网络学习算法的过拟合问题及解决方法

第六章-神经网络

人工神经网络算法

(完整版)基于神经网络的中国人口预测算法研究毕业论文

神经网络系统建模综述

最新数学建模bp神经网络.docx

CMAC(神经网络)与PID

BP神经网络模型与学习算法

神经网络算法的软件应用研究

神经网络与遗传算法

什么是神经网络算法

神经网络算法详解

几种神经网络模型及其应用