第二章无失真信源与信息熵

讲授思路

1)按照“概念、描述、度量、分析、计算”10字方针逐步深入。

2)讲授步骤按照

离散单个消息→离散消息序列

↑↑离散化(纵向)

连续单个消息→连续消息序列

↑离散化(横向)

连续消息过程

重点

熵H(U)—无失真单消息信源的度量值;概念、度量与计算

互信息I(U;V)—单消息信宿的度量值;概念、度量与计算

§2-1 信源特性与分类

一)信源的统计特性

1)什么是信源?

信源是信息的来源,实际通信中常见的信源有:语音、文字、图像、数据…。在信息论中,信源是产生消息(符号)、消息(符号)序列以及连续消息的来源,数学上,

信源是产生随机变量U ,随机序列U 和随机过程U(t,ω)的源。

2)信源的主要特性

信源的最基本的特性是具有统计不确定性,它可用概率统计特性来描述。 二)信源的描述与分类

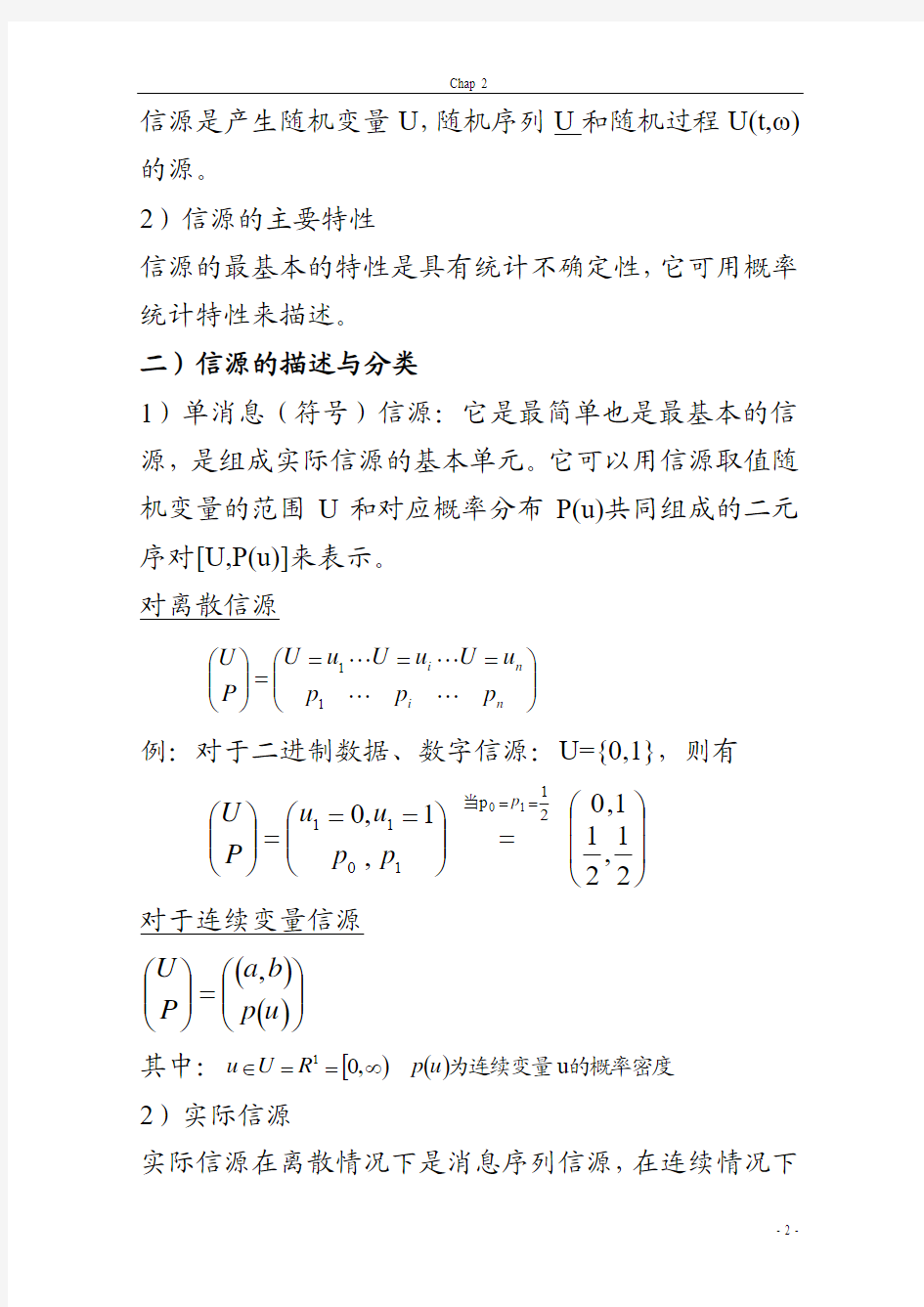

1)单消息(符号)信源:它是最简单也是最基本的信源,是组成实际信源的基本单元。它可以用信源取值随机变量的范围U 和对应概率分布P(u)共同组成的二元序对[U,P(u)]来表示。 对离散信源

???

?

??====???? ??n i n i p p p u U u U u U P U 11 例:对于二进制数据、数字信源:U={0,1},则有

???

? ??=

????

??===???? ??=

=21,211,0,1,02

1

p 101110p p p u u P U 当 对于连续变量信源

()()???

? ??=???? ??u p b a P U , 其中:[)()的概率密度为连续变量u ,01u p R U u ∞==∈ 2)实际信源

实际信源在离散情况下是消息序列信源,在连续情况下

是随机过程信源,它们分别代表数字与模拟信源。 ①离散序列信源

()

()

L l iL il i i U U U U U U U U U 2121简记

==

其中,i=1,2,…n 为每个消息(符号)取值的种类数 l =1,2,…L 为消息(符号)序列的长度

应注意的是i 和l 是代表两个不同范畴的变量,表示不同的概念,切勿混淆。

信源输出是一组随机序列(矢量):

()()维取值范围L U U U U U L L l ∈= 1

其样值为:

()L l L u u u u 1= 对应概率为:

()

()L l L u u u p u p 1=

由于每个随机变量U={1,2,…n}有n 种取值,则L U 有

L

n 种可能取值。 对消息序列信源有:

()???

?

??===???? ??)()(11L L n n L u p u p u U u U u p U

例:最简单L=3的三位PCM 信源:这时L=3, n=2, 即i={0,1},则有:

???? ??=????

???====???? ??=

=818

181812

131

120303,,,,111,,010,001,000,,111,,001,000)(10 时

当p p p p p p U U U u p U

i=1,2,…n

l =1,2,…L

ⅰⅰ)离散无记忆信源

()())()(1

1等概率,同分布平稳

无记忆L

L

l l L l p u p u u u p u p ==

=∏=

ⅱⅱ)离散有记忆信源

大部分实际信源属于这类,尤其当L 足够大时,

L

ji L ji L l u u u u u u u u u u u u u u u u u u u u u u P P p P u p P P P u p P P P u p P P P u p u p l l L L L L L L ≈=====--=∏+---111

1

1111)

()()()()()()

()()()()()()()()(11231211213121112312齐次

马氏链

这里需要进一步解释有两点:

首先,我们称仅对转移概率,平稳的为齐次; 其次,当齐次马氏链满足不可约、非周期性条件时,称为遍历,它与起始条件分布无关。

在实际信源中,数字图像信源往往采用马氏链模型。 ②连续信源

在实际的连续信源中,可以采用两种方法进行分析 一类是将连续信源离散化随机序列信源 另一类是仍然采用随机过程来分析

下面,首先要回答什么样的信源可以进行离散化处理? 实际上,只要满足一个非常宽松的条件,即满足限时(T)、限频(F)的连续消息信源,即满足物理可实现条件下,均可离散化为随机序列。

类似于在信号分析中对周期性确知信号的正交展开,这里也可以类似的对非确知连续随机信号在满足限时(T)、限频(F)条件下展开成类似的离散随机序列信号。

??

???==????

????==???

???==?∑?∑?∑--∞

-∞=--∞-∞=--∞-∞

=22

2222

222222)()()()(),()()(),()()(1221.).(.).(1T

T n T n T

T T n T

n T

T T n T n t j T T n t j T t j T e a n n t j n e a t j T n n t j n e R n G e

n G R e t U c e c t U e

t U c e

c t U ππππππττωωωωππ

随机信号

确知信号

下面,我们给出三类最常用的展开式:

ⅰⅰ)付氏级数展开式—对限时(T)、限频(F)信号; ⅱⅱ)取样函数展开式—对限频(F)、限时(T)信号; ⅲⅲ)K-L 展开式—展成线性无关或统计独立序列。 下面逐一讨论

ⅰⅰ)限时(T)、限频(F)过程的付氏展开:U(t, ω)

若?????

<=>=时

当时当,

2/),,(),(2/0),(.

..

.T t t U t U T t t U e a e a ωωω 这里,),(ωt U 为一周期性随机过程;

―a.e.‖为almost everywhere, 几乎处处含义下相等(收敛)

类似于周期性确知信号,在时域内可做下列付氏级数展开:当2/T t <时,

∑∑-=∞

-∞

==

=

=N

N

n t

j n

n t

j n

e a e a T n T n e

c e

c t U t U π

πωωωω22)()(),(),()

F (.

...限频

其中: ?

?

----=

=

2

2

22

2

2),(),()(1

1

.)

.(T T T n T

T T n t

j T

t

j T

e a n e

t U e

t U c ππωωω

ⅱⅱ)限频(F)、限时(T)过程H(f,ω)的取样函数展开:

若?????

<=>=时

当时当F f f H f H F f f H e a e a ),,(),(,

0),(.)

.(.)

.(ωωω 这里,),(ωf H 为一频域中周期性随机过程,同理,类似于对周期性确知信号,在频域可做下列付氏级数展开:当F f <时,

∑∞

-∞

===n f F

n j

n e

a e a e

g f H f H 22..)(),(),(π

ωωω

而

df

e f H F df e f H F g F

F

f F

n j

F F

f F

n j e

a n ??----==2222.),(21

),(21

)(π

π

ωωω

由于

),(),(.ωωt U f H T

F ??→←, 即df e

f H t U ft

j F

F πωω2),(),(?-=

现令F n t 2-=,

则有)2(21),(21

)()2(

2.F

n U F df e

f H F

g F

F

F

n f j e

a n -==?

--πωω

∑∑∑∑∑??

∑?-=∞-∞=-=∞

-∞=∞-∞

=∞-∞=-+

-∞

-∞

=---=--=++-=++====∴FT FT m T n n m n n n n F F F

n t f j n F

F

n ft j f F

n j

n F F

ft j F

m t F m

t F F m U F F

m t F m

t F F m U F F n t F n t F F n U F F

n t F n

t F g df e g df

e e

g df e f H t U )2()2(2sin )

2(21)2()2(2sin )

2(21)2()2(2sin )2(21)

2()2(2sin )

()()(),(),()2(22222ππππππππωωωωωππππ限时令ⅲ)K-L 展开(Karhunen-Loeve 展开)

上述两类展开,在一般情况下*

其展开系数之间是统计关联的,即展开后的离散随机序列是有记忆的。这给进一步分析带来了一定的困难。能否在理论上寻找一类展开,展开后的随机序列是相互统计独立的,或者至少是线性无关的。满足这一要求的是K-L 展开。

设:随机过程U(t, w), t ∈T, 若E[U(t, w)]=0,则有 R(t 1, t 2)=E[U(t 1, w)U(t 2, w)],又设在区间T=[a, b]时,有一组完备正交函数)(t i ?,即

?

??≠==?j i j

i dt t t b

a j i 当当,0,1)()(?? 其中i=1, 2, …n,且n 为有限或可数。

*

对于付氏展开,仅当U(t, w)为弱(广义)平稳时,对

于取样函数展开,仅当谱函数绝对值恒定时,即|H(f)|=1, 当|f| 则????? ==?∑∞=b a i e a i i i i e a dt t t U a t a t U )(),()() ()(),(.1.?ωω?ωω 注意:是单边展开。 00)],([=∴=i Ea t U E ω 而])()([),(2121∑∑=i i i i i i t a t a E t t R ?? 我们希望各a i 之间线性无关,即 ? ??≠===j i j i a Ea i i j i 当当,0,2σλ ∑=∴i i i i t t t t R )()()(2121??λ 两边同乘)(2t j ? 并在[a,b]内对t 2积分,由归一性可得: ) ()()()()()()()()(122112 22 1 222 1t dt t t t dt t t t dt t t t R j j b a j j j j j i j b a i i i i b a j ?λ???λ? ??λ? ===?? ∑?=当 可见,正交函数系应满足下列积分方程: )()()(12221t dt t t t R b a λ??=? 下面简要介绍积分方程的概念,所谓积分方程,是指未知函数在积分号内的方程式,我们这里讨论的是最常见的线性积分方程。即一般积分方程可写为: ?????d x K x f x x a b a ?=+)(),()()()( 对照上述K-L 展开应满足的积分方程,可得: ), ,(),(,0)(,)(21t t R x K x f x a ===?λ积分核仅有 )()(2t ???=是未知的。这类积分方程又称为齐次第二 类线性积分方程,其核是对称型的,求解比较容易。它要求特征值λi 为某些离散值,而与之对应的正交函数则是积分方程的特征函数)(t i ?。 可见,当),(21t t R 已知时,可求解上述积分方程,得特征值λi 和相应特征函数)(t i ?,然后即可将U(t, ω)展成为:∑∞ ==1.)()(),(i i i e a t a t U ?ωω 展开后所得的函数)(ωi a 是线性无关的随机变量。若U(t, ω)为一正态随机过程,则)(ωi a 不仅线性无关而且是统计 独立的随机变量。 可见,K-L 展开主要优点在于展成的系数是线性无关的,且对正态是统计独立的,因此展开后可作为无记忆信源来处理。另外据分析它的收敛速度也比较快。但是可惜目前尚未找到它的快速收敛算法,另外在概念上又不像付氏展开、取样展开那样直观,所以在实际问题中很少应用,而是将它作为理论上最优变换的一个参考标准。 三)实际信源举例 下面仅以最常见的图像与语音信源为例 1)图像信源 图像信源一般可以引用一个五元的随机场来表示: ),(),,,,(t x U t z y x U 扫描时 =λ(简化) 主要统计特性:初步可以认为是一个近似的平稳遍历过程 ①幅度概率分布:它主要采用专用仪器测试并用直方图分析,但未得出一致性结论,主要原因是其分布与图像类型密切相关,比如对准动态型,其分布接近于正态分布,而对于动态型,其分布则接近于对数正态分布。 ②自相关函数:一般可认为) ()(ττi K e R -=即相关函数呈 指数分布。 ) ) ) τ 电视信号还可以进一步划分为行内、行间、场间不同情况,其相应的相关函数与功率谱分布如下: f且 G T F? ?→ ← f R ( ) ) (.τ 对于数字型图像信号,可以采用马氏链模型 ????? ?? ? ??=Φ--11 1 112 122 N N x X ρ ρρρρρ σ 而ρ为相邻像素之间的相关系 数。 2)语音信源 可以近似用一个一维随机过程U(ω, t)表示。严格的讲,它是一个非平稳过程,但是对于短时段(5-50ms)可认为是平稳的,且某些是随机噪声(清辅音)而某些时段则呈现周期性特征(浊音),还有一些短时段是二者的混合。 非参数描述: ①幅度概率分布 语音的一阶近似:Laplace 分布u u u L e p σσ) (221-= 二阶近似:Gama 分布u u u G e u p σπσ2)(3)(83-= u ②短时相关函数 ③短时功率谱 -40dB -50dB -60dB -70dB log f 参数表示法 ①共振峰?????===Hz f Hz f Hz f 260012008003 21 ②基音:最低基本频率 男100-200Hz, 女200-400Hz 。 ③音素 英语为例:27 =128–28 =256种 每秒平均发出10个音素 §2-2 离散信源的信息熵 一> 信息熵与信息量的基本概念 上一节我们引用概率论来描述信源,然而信源是信息的来源,那么信息与概率到底是什么样的关系呢? 本节,我们首先从直观概念出发,推导出信源的信息度量公式:信息熵H(U),在进一步探讨它的基本概念与基本性质,最后再用严格的公理化结构证明熵的唯一性。 信息的定量化,首先是1928年Hartley 研究了具有 m N 个组合的信息源(即由N 种m 位符号所构成的信源),它给出了最早的信息度量公式: N m N I m l o g l o g == 这一度量公式给后来Shannon 建立概率信息的度量公式有很大的启发,仙农保留了对数度量的合理性,并将它从特殊的非概率(等概率)情况推广到一般的不等概率信源。下面将从直观概念来推广: 对于单个消息信源U ,发送某个消息U u i ∈,对应概率为i p ,这时信源输出的信息量为I ,则有: 的递降函数 是i i i i i i i i i p I p I p p I p p I p p I p 0 )(,1;)(,)(,0;)(,→→↓↑∞ →→↑↓ 小概率事件,一当出现必然使人感到意外,因此产生的信息量就越大;几乎不可能事件一当出现,将是一条爆炸性的新闻,一鸣惊人。 大概率事件,是预料之中的,即使发生,也没什么信息量,特别是当必然事件发生了,它不会给人以任何信息量。 另外,从直观概念上讲,由两个不同的消息(相对独立)所提供的信息应等于它们分别提供的信息之和,即满足可加性:I (A B) = I (A) + I (B) 由对概率的递降性和可加性可以导出这类函数应是概率的对数函数: i i i p p p I log 1 log )(-== 称)(i p I 为单个消息信源的非平均自信息量。 同理可定义: j j j q q q I log 1 log )(-== ji ji ji P P P I log 1 log )(-== ij ij ij Q Q Q I log 1 log )(-== j i ij ij ij q p r r r I log log log 1 log )(--=-== )()(j i q I p I +=(当p i , q j 独立) 其中: ji P 表示已知消息i u 的条件下,消息j u 出现的条件概率, ij Q 表示已知消息j u 的条件下,消息i u 出现的条件概率, ij r 表示两个消息i u 与j u 同时出现的联合概率 至此,我们从直观概念引入了信源输出的单个消息(符号)的非平均信息量的表达式。 然而,对于信源而言,即使是单消息(符号),它亦含有有限种的i u ,i=1,2…n ,因此由它给出的信息量应是n 种可能的统计平均值,即 ∑=-=-==n i i i i n p p p E p p H U H 1 1l o g ]l o g [)()( 其中“E ”表示求概率的统计平均值,即求数学期望值。 同理可定义: ∑=-=-==m j j j j m q q q E q q H V H 1 1log ]log [)()( ∑∑-=-==i j ji ij ji ji P r P E P H U V H log ]log [)()( ∑∑-=-==i j ij ij ij ij Q r Q E Q H V U H log ]log [)()( ∑∑-=-==i j ij ij ij ij r r r E r H V U H log ]log [)(),( 称H(U) [ H(V) ] 为信源 [信宿] 的信息熵,H(V/U) ﹑H(U/V)为条件熵,H(U,V)为联合熵。 信息熵H(U)是某个具体单个消息(i u U )的非平均自信息量)(i u I 的统计平均值,是描述信源统计的一个客观物理量。它首先是1948年仙农给出的,后来Feinstein 等人又从数学上严格的证明了当信息满足对概率递降性和可加性条件下,上述信息熵的表达形式是唯一的。 熵这个名词是仙农从物理学中的统计热力学借用过来的,在物理学中称它为热熵是表示分子混乱程度的一个物理量,这里,仙农引用它来描述信源的平均不确定性,含义是类似的。但是在热力学中已知任何孤立系统的演化,热熵只能增加不能减少;而在信息论中,信息熵正相反,只会减少,不会增加。所以有人称信息熵为负热熵。 信息熵的单位与公式中的对数取底有关。通信与信息中最常用的是以2为底,这时单位为比特(bit );理论推导中用以e 为底较方便,这时单位为奈特(Nat );工程上用以10为底较方便,这时单位为笛特(Det )。它们之间可以引用对数换底公式进行互换。比如: 1 bit = 0.693 Nat = 0.301 Det 最后,有必要阐述一下信息熵与信息量之间的关系: 信息熵是表征信源本身统计特性的一个物理量, 它是信源平均不确定性的度量,是从总体统计特性上对信源的一个客观描述。 信息量一般是针对接收者而言的,是一个相对量,是指接收者从信源中所获得的信息度量。我们又称它为互信息量I(U;V)。当通信中无干扰时,接受者获得的信息量数量上就等于信源给出的信息熵,但是两者的概念不一样;当信道有干扰时,不仅概念上不一样,而且数量上也不相等。信息熵也可理解为信源输出的信息量。 二> 熵的数学性质 主要用三个定理加以概括。 定理2-2-1:熵函数H(U)具有以下主要性质: 1>对称性:)()(11kn k n p p H p p H =,其中n k k 1 是 1…n 的重排列。它体现熵是描述信源总体特性; 2>非负性:)()(11kn k n p p H p p H =≥ 0 它体现信息的非负性; 3>确定性:H(1,0) = H(0,1) = H(0…0,1,0…0) = 0 它说明熵是度量不确定性的物理量; 4>扩展性:= )(1n n p p H ),()(1110 1lim εεεεn n n n n p p H p p H --=+→ 其中 ∑==n i i 1 εε 5>可加性: ) ()()(11 1111111mi i m n i i n n mn n n n m mn P P H p p p H P p P p P p P p H ∑=+= 证明:1>,2>,3>由熵的定义显见。 4> 由于∑==n i i 1εε,且0→ε ,在熵公式中当0=i p 可 解释00log 0=,则扩展性得证。 5>可加性:)(111111m n n n n m m n P p P p P p P p H ∑∑==-=n i m j ji i ji i P p P p 11log ∑∑∑∑====--=n i ji m j ji i n i m j i ji i P P p p P p 11 11log log ∑∑∑∑====--=n i ji m j ji i n i m j i i ji P P p p p P 1111 log log )( ]log [log 1 1 1 ∑∑∑===-+-=n i ji m j ji i n i i i P P p p p )()(11 1mi i m n i i n n P P H p p p H ∑=+= 若信源由两个独立消息1U 取值n 种, 2U 取值m 种所组成,这时ji P 与i 无关,且j ji q P =,则上式可减化为: )()()(11111111m m n n m n n n n m m n q q H p p H P p P p P p P p H += 定理2-2-2:熵函数H(U)具有极值性,即 =)(1n n p p H ≤-∑i i i p p log i i i q p log ∑- n n n H n log )1 ..........1(=≤ 证明:先证明一个常用不等式:log x ≤x-1 用图形表示为: -1 x 令f(x)=log x –(x-1) ,则 11 )('-= x x f , 可见当x=1时,f(x)=0,它是f(x)的极值。且 01 )(2' '<-=x x f ,故此极值 为极大值。 所以有: f(x)≤ f(1)=0 ,当且仅当x=1时取等号。 这时 f(x)=log x-(x-1) ≤0 => log x ≤(x-1) 现令i i p q x = ,则有 1)log( -≤i i i i p q p q , 两边取统计平均值 第一章信息论与基础 1.1信息与消息的概念有何区别? 信息存在于任何事物之中,有物质的地方就有信息,信息本身是看不见、摸不着的,它必须依附于一定的物质形式。一切物质都有可能成为信息的载体,信息充满着整个物质世界。信息是物质和能量在空间和时间中分布的不均匀程度。信息是表征事物的状态和运动形式。 在通信系统中其传输的形式是消息。但消息传递过程的一个最基本、最普遍却又十分引人注意的特点是:收信者在收到消息以前是不知道具体内容的;在收到消息之前,收信者无法判断发送者将发来描述何种事物运动状态的具体消息;再者,即使收到消息,由于信道干扰的存在,也不能断定得到的消息是否正确和可靠。 在通信系统中形式上传输的是消息,但实质上传输的是信息。消息只是表达信息的工具,载荷信息的载体。显然在通信中被利用的(亦即携带信息的)实际客体是不重要的,而重要的是信息。 信息载荷在消息之中,同一信息可以由不同形式的消息来载荷;同一个消息可能包含非常丰富的信息,也可能只包含很少的信息。可见,信息与消息既有区别又有联系的。 1.2 简述信息传输系统五个组成部分的作用。 信源:产生消息和消息序列的源。消息是随机发生的,也就是说在未收到这些消息之前不可能确切地知道它们的内容。信源研究主要内容是消息的统计特性和信源产生信息的速率。 信宿:信息传送过程中的接受者,亦即接受消息的人和物。 编码器:将信源发出的消息变换成适于信道传送的信号的设备。它包含下述三个部分:(1)信源编码器:在一定的准则下,信源编码器对信源输出的消息进行适当的变换和处理,其目的在于提高信息传输的效率。(2)纠错编码器:纠错编码器是对信源编码器的输出进行变换,用以提高对于信道干扰的抗击能力,也就是说提高信息传输的可靠性。(3)调制器:调制器是将纠错编码器的输出变换适合于信道传输要求的信号形式。纠错编码器和调制器的组合又称为信道编码器。 信道:把载荷消息的信号从发射端传到接受端的媒质或通道,包括收发设备在内的物理设施。信道除了传送信号外,还存储信号的作用。 译码器:编码的逆变换。它要从受干扰的信号中最大限度地提取出有关信源输出消息的信息,并尽可能地复现信源的输出。 1.3 同时掷一对骰子,要得知面朝上点数之和,描述这一信源的数学 模型。 解:设该信源符号集合为X 各章参考答案 2.1. (1)4.17比特 ;(2)5.17比特 ; (3)1.17比特 ;(4)3.17比特 2.2. 1.42比特 2.3. (1)225.6比特 ;(2)13.2比特 2.4. (1)24.07比特; (2)31.02比特 2.5. (1)根据熵的可加性,一个复合事件的平均不确定性可以通过多次实验逐步解除。如果我们使每次实验所获得的信息量最大。那么所需要的总实验次数就最少。用无砝码天平的一次称重实验结果所得到的信息量为log3,k 次称重所得的信息量为klog3。从12个硬币中鉴别其中的一个重量不同(不知是否轻或重)所需信息量为log24。因为3log3=log27>log24。所以在理论上用3次称重能够鉴别硬币并判断其轻或重。每次实验应使结果具有最大的熵。其中的一个方法如下:第一次称重:将天平左右两盘各放4枚硬币,观察其结果:①平衡 ②左倾 ③右倾。ⅰ)若结果为①,则假币在未放入的4枚币,第二次称重:将未放入的4枚中的3枚和已称过的3枚分别放到左右两盘,根据结果可判断出盘中没有假币;若有,还能判断出轻和重,第三次称重:将判断出含有假币的三枚硬币中的两枚放到左右两盘中,便可判断出假币。ⅱ)若结果为②或③即将左盘中的3枚取下,将右盘中的3枚放到左盘中,未称的3枚放到右盘中,观察称重砝码,若平衡,说明取下的3枚中含假币,只能判出轻重,若倾斜方向不变,说明在左、右盘中未动的两枚中其中有一枚为假币,若倾斜方向变反,说明从右盘取过的3枚中有假币,便可判出轻重。 (2)第三次称重 类似ⅰ)的情况,但当两个硬币知其中一个为假,不知为哪个时, 第三步用一个真币与其中一个称重比较即可。 对13个外形相同的硬币情况.第一次按4,4,5分别称重,如果假币在五个硬币的组里,则鉴 别所需信息量为log10>log9=2log3,所以剩下的2次称重不能获得所需的信息. 2.6. (1)215 log =15比特; (2) 1比特;(3)15个问题 2. 7. 证明: (略) 2.8. 证明: (略) 2.9. 31)(11= b a p ,121 )(21=b a p , 121 )(31= b a p , 61)()(1312= =b a b a p p , 241)()()()(33233222= ===b a b a b a b a p p p p 。 2.10. 证明: (略) 2.11. 证明: (略) 第一章引论 1-1信息与信息科学 1-1-1信息的概念 ▲信息的定义:很难给出,信息的定义是信息论研究的一个基本内容。象物质,能量一样越基本的概念越难以给出明确的定义。 ▲信息的概念:信息是可以传递的,具有不确定性的消息(情报,指令,数据,信号)中所包含的表示事物特性的内容。 ▲几个要点: △信息不是事物的本身,信息是抽象的。而消息,情报,指令,数据等本身不是信息。 △Shannon认为:信息是关于环境事实的可以通信的知识。 △Winner认为:信息是人们在适应外部世界并且使这种适应反作用于外部世界的过程中,同外部世界进行交换的内容。 △近代人认为:信息是具有新内容的消息;是对于决策有价值的情报;是一切所感知的信号,信息就是知识等。 △Shannon信息论认为:信息的多少等于无知度的大小。人们已知的消息不是信息,而好象,大概,可能之类的不确切的内容包含着信息。(不能说信息冗余、信息压缩)1-1-2信息科学 ▲信息科学是研究信息的概念,相关理论和应用的科学,信息科学是一门新兴科学,边缘学科。 ▲信息科学的特点:(1)多学科--它与许多基础科学和应用技术有关,互相渗透,如数学,逻辑学,心理学,语言文字学,生物学,控制论,计算机科学,通信技术,仿生学,人工智能技术。(2)产业化--它应用服务于国民经济和社会生活的各个方面,从而形成一个新兴产业----信息产业。 ▲信息科学的研究范围: ☆信息源:自然信息源(物理,化学,天体,地理,生物);社会信息源(管理,金融,商业);知识信息源(古今中外) ☆信息载体:第一载体(语言);第二载体(文字);第三载体(电磁波)。 ☆信息的采集与转换:传感器,雷达,视,听,触,力,声光热点磁。 ☆信息的传输:光,电磁波,神经,意念。 ☆信息的存储与处理:计算机,视听系统。 1-1-3信息的性质 ⑴信息的可扩充性:相对物质和能量而言,信息资源没有限度,永远不会耗尽,而且回越来越多,信息爆炸,知识爆炸,能源危机。 ⑵信息的可压缩性:通过人脑的归纳和综合,信息可精炼和压缩,产生专家系统,知识库。 ⑶信息的可替代性:信息可替代有形物质,信息出口,情报出口。 ⑷信息的可传递性:人与人之间,人与物之间,细胞,天体之间。 ⑸信息的可扩散性:总是以各种方式向外部扩散,绝对保密是无法实现的。 ⑹信息的可共享性:信息无法垄断,不能做转手交易。 第一章信息的定性描述 第一节对信息的初步认识 一. 信息社会 当今,世界上信息革命的热潮一浪高过一浪。近年来,移动电话、个人电脑和网络用户正以高于摩尔定律的速度迅猛增长。人们都在谈论着信息社会、信息革命和网络时代,信息似乎成了个很时髦的字眼儿。就连中国人平常打招呼的话“你吃饭了吗?”也被有些人改成“你上网了吗?”但这绝不是什么赶时髦,也绝不是什么偶然现象,而是社会发展的必然趋势。因为在信息社会里,人们最关心的是信息问题,而不是吃饭问题。“民以食为天”的信条将会逐渐被“民以信为天”所代替。社会学家和未来学家普遍认为,20世纪末和21世纪初,是信息革命爆发的时期。一些新技术的突破和新产业的出现,使社会生产力发生了新的飞跃,人们的生活也发生了新的变化,人类社会正在进入信息化社会。所谓信息化社会,就是以信息产业为中心,使社会生产、生活和经济都发展起来的社会。在这种社会中, ◆信息成了比物质或能源更为重要的资源, ◆对信息产业成了重要的产业。 ◆从事信息工作者成了主要的劳动者。 ◆信息和知识成了生产力发展的决定因素。 二. 信息的普遍性 其实,信息并不是什么新鲜东西, 信息无时不在,无处不有。 人们生活在信息的海洋里,天天都要通过自己的感觉器官感受各种外界信息。例如,衣食住行,读书看报,听广播,看电视等等。人们要进行社会活动就需要有信息交流。例如,除了书信、电话、电报之外,天天都要同许多人交谈、交往。人们还要进行信息处理和存储。例如,要把观察、接收到的大量事物、数据和资料进行分类、分析、整理和纪录。 不仅如此,信息也是人类自身进化的一个基本条件。恩格斯对于人类的进化过程,曾有过这样一段极其精彩的描述:“……这些猿类,大概是首先由于它们生活方式的影响……渐渐直立行走……手变得自由了……随着手的发展,随着劳动而开始的人对自然的统治,在每一个新的发展中扩大了人的眼界。……另一方面,劳动的发展必然促使社会成员更加紧密地互相结合起来,因为它使互相帮助和共同协作的场合增多了,并且使每个人都清楚地意识到这种共同协作的好处。一句话,这些正在形成中的人,已经到了彼此间有些什么非说不可的地步了。需要产生了自己的器官:猿类不发达的喉头,由于音调的抑扬顿挫的不断加多,缓慢地然而肯定地得到改造,而口部的器官也逐渐学会了发出一个个清晰的音节……首先是劳动,然后是语言和劳动一起,成了两个最主要的推动力,在它们的影响下,猿的脑髓就逐渐地变成人的脑髓……由于随着完全形成的人的出现而产生了新的因素——社会。”在这里,我们看到了一幅清晰的图景,它说明这些正在形成中的人,怎样在与外部的联系中产生了感知信息与利用信息的需要,因而逐渐形成和发展了自己的信息器官:眼、耳、口、脑等等。形成和发展这些器官,形成和发展语言,正是为了从自然界取得信息和利用信息来强化自己, 《信息论基础》答案 一、填空题(共15分,每空1分) 1、若一连续消息通过某放大器,该放大器输出的最大瞬时电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是 无穷大 ;其能在每个自由度熵的最大熵是 ()log b-a . 2、高斯白噪声信道是指 信道噪声服从正态分布,且功率谱为常数 。 3、若连续信源的平均功率为5 W ,则最大熵为12log10π ? e ,达到最大值的条件是 高斯信道 . 4、离散信源存在剩余度的原因是 信源有记忆(或输出符号之间存在相关性) 和 不等概 。 5、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 6、离散无记忆信源在进行无失真变长信源编码时,码字长度是变化的。根据信源符号的统计特性,对概率大的符号用 短 码,对概率小的符号用 长 码,这样平均码长就可以降低,从而提高编码效率。 7、八进制信源的最小熵为 0 ,最大熵为 3 bit 。 8、一个事件发生概率为0。125,则自信息量为 3 bit 。 9、在下面空格中选择填入数字符号“,,,=≥≤>”或“<" ()H XY = ()()+H Y H X Y ≤ ()()+H Y H X 二、判断题(正确打√,错误打×)(共5分,每小题1分) 1) 离散无记忆等概信源的剩余度为0。 ( √ ) 2) 离散无记忆信源N 次扩展源的熵是原信息熵的N 倍 ( √ ) 3) 互信息可正、可负、可为零。 ( √ ) 4) 信源的真正功率P 永远不会大于熵功率P ,即P P ≤ ( × ) 5) 信道容量与信源输出符号的概率分布有关。 ( × ) 三、(5分)已知信源的概率密度函数()p x 如下图所示,求信源的相对熵 0.5 第一章 1-1 信息.消息和信号的定义是什么?三者的关系是什么? 答:定义:信息是事物运动状态或存在方式的不确定性的描述。 用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来就成为消息。 把消息换成适合信道传输的物理量,这种物理量称为信号。 三者的关系:消息包含信息,是信息的载体,但不是物理性的。信号是信息的载体,是物理性的。 1-3 写出信息论的定义(狭义信息论和广义信息论). 答:狭义信息论:信息论是在信息可以度量的基础上有效地和可靠地传递信息的科学,它涉及信息的度量、信息的特性、信息传输速率、信道容量、干扰对信息传输的影响等方面的知识。 广义信息论:信息论包括通信的全部统计问题的研究、香农信息论、信号设计、噪声理论、信号检测与估值等,还包括如医学、生物学、心理学、遗传学、神经生理学、语言学甚至社会学和科学管理学中有关信息的问题。 1-5信息有哪些分类? 答:( 1 )按信息的性质分类:语法信息,语义信息和语用信息; (2)按观察过程分类:实在信息,先验信息和实得信息; (3)按信息的地位分类:客观信息(效果信息、环境信息)和主观信息(决策信息,指令、控制和目标信息); (4)按信息的作用分类:有用信息、无用信息和干扰信息; ( 5)按信息的逻辑意义分类:真实信息、虚假信息和不定信息; (6)按信息的传递方向分类:前馈信息和反馈信息; ( 7)按信息的生成领域分类:宇宙信息、自然信息、思维信息和社会信息;(8)按信息的信息源性质分类:语言信息、图像信息、数据信息、计算信息和文字信息; (9)按信息的信号形成分类:连续信息、离散信息和半连续信息。 09电子2 22 何清林 第一章 绪论 1、什么是信息?香农对于信息是如何定义的。 答:信息是事物运动状态或存在方式的不确定性的描述(Information is a measure of one's freedom of choice when one selects a message )。 2、简述通信系统模型的组成及各部分的含义。 答:(1)、信源:信源是产生消息的源。信源产生信息的速率---熵率。 (2)、编码器:编码器是将消息变成适合于信道传送的信号的设 备。包括信源编码器(提高传输效率)、信道编码器(提高传输可靠性)、调制器。 (3)、信道:信道是信息传输和存储的媒介。 (4)、译码器:译码是编码的逆变换,分为信道译码和信源译码。 (5)、信宿:信宿是消息的接收者(人或机器)。 3、简述香农信息论的核心及其特点。 答:(1)、香农信息论的核心:在通信系统中采用适当的编码后能够实现高效率和高可靠性的信息传输,并得出了信源编码定理和信道编码定理。 (2)、特点:①、以概率论、随机过程为基本研究工具。 ②、研究的是通信系统的整个过程,而不是单个环节,并以编、译码器为重点。 ③、关心的是最优系统的性能和怎样达到这个性能(并不具体设计系统)。 ④、要求信源为随机过程,不研究信宿。 第二章 信息的度量 2.1 自信息和互信息 1、自信息(量): (1)、定义:一个事件(消息)本身所包含的信息量,它是由事件的不确定性决定的。某个消息i x 出现的不确定性 的大小定义为自信息,用这个消息出现的概率的对数的负值来表示: ()()() i i i x p x p x I 1 log log =-= 第一章 信息论基础 课后习题 1.7同时掷一对均匀的骰子,要得知面朝上点数之和,描述这一信源的数学模型。 解:两个点数的排列如下: 11 12 13 14 15 16 21 22 23 24 25 26 31 32 33 34 35 36 41 42 43 44 45 46 51 52 53 54 55 56 61 62 63 64 65 66 参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下: ?? ????????=??????36112181111211091936586173656915121418133612)(X P X 故:该信源的数学模型如上。 1.8居住在某地区的女孩中有25%是大学生,在女大学生中75%身高 1.6m 以上,而女孩中身高1.6m 以上的占总数的一半,要从信源消息中得知身高及学历,描述这一信源。 解:设随机变量X 代表女孩子学历 X X1(是大学生) X2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y Y1 (身高>1.6m ) Y2(身高<1.6m ) P(Y) 0.5 0.5 1.9设有一个二阶二元马尔可夫信源,其4种状态的转移概率矩阵为 ????? ???????=7.03.000005.05.05.05.000002.08.0p ,画出状态图并求稳态下各状态出现的概率。 1.10有一个二元对称信道,信道误码率P=0.06,设该信道以1000个符号/秒的速率传输输入符号,现有一消息序列,共有9500个符号,并设消息中q(0)=q(1)=0.5,问从信号传输的角度来考虑,10秒能否将消息无失真地传送完? 解:06.0)1()1()0(=-?+?=p q p q P e ,此信道10秒内能无失真传输的最大信息量为950094001000)1(10<=?-?e P ,故不能。 1.12某有扰离散信道的输入是等概率出现的A 、B 、C 、D 四个字母,信道正确传输的概率是0.5,等概率错误传输成其他三个字母,描述这一信道的数学模型,并计算相应的后验概率。 解:P(A)=P(B)=P(C)=P(D)=1/4 P=1-P=0.5 P(A|A)=P(B|B)=P(C|C)=P(D|D)=1/2 P(B|A)=P(C|A)=P(D|A)=1/6 P(A|B)=P(C|B)=P(D|B)=1/6 信息理论基础 回 顾 回 顾 回 顾 回 顾 哈尔滨医科大学生物信息科学与技术学院 第一章绪论 1、什么是信息?香农对于信息是如何定义的。 答:信息是事物运动状态或存在方式的不确定性的描述(Information isameasureofone'sfreedomofchoice whenoneselectsamessage)。 2、简述通信系统模型的组成及各部分的含义。 答:(1)、信源:信源是产生消息 的源。信源产生信息的速率---熵率。 (2)、编码器:编码器是将消 息变成适合于信道传送的信号的设 备。包括信源编码器(提高传输效率)、信道编码器(提高传输可靠性)、调制器。 (3)、信道:信道是信息传输和存储的媒介。 (4)、译码器:译码是编码的逆变换,分为信道译码和信源译码。 (5)、信宿:信宿是消息的接收者(人或机器)。 3、简述香农信息论的核心及其特点。 答:(1)、香农信息论的核心:在通信系统中采用适当的编码后能够实现高效率和高可靠性的信息传输,并 得出了信源编码定理和信道编码定理。 (2)、特点:①、以概率论、随机过程为基本研究工具。 ②、研究的是通信系统的整个过程,而不是单个环节,并以编、译码器为重点。 ③、关心的是最优系统的性能和怎样达到这个性能(并不具体设计系统)。 ④、要求信源为随机过程,不研究信宿。 第二章信息的度量 2.1自信息和互信息 1、自信息(量): (1)、定义:一个事件(消息)本身所包含的信 息量,它 Ixi 1 logpxilog pxi 是由事件的不确定性决定的。某个消息xi出现的不确定性 的大小定义为自信息,用这个消息出现的概率的对数的负值来表示: 信息论基础第-1- 页共11页 《信息论基础》答案 一、填空题(共15分,每空1分) 1、若一连续消息通过某放大器,该放大器输出的最大瞬时电压为b,最小瞬时电压为a 。 若消息从放大器中输出,则该信源的绝对熵就是 无穷大 ;其能在每个自由度熵的最 大熵就是 ()log b-a 。 2、高斯白噪声信道就是指 信道噪声服从正态分布,且功率谱为常数 。 3、若连续信源的平均功率为 5 W,则最大熵为12log10π ? e ,达到最大值的条件就是 高斯信道 。 4、离散信源存在剩余度的原因就是 信源有记忆(或输出符号之间存在相关性) 与 不等概 。 5、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 6、离散无记忆信源在进行无失真变长信源编码时,码字长度就是变化的。根据信源符号 的统计特性,对概率大的符号用 短 码,对概率小的符号用 长 码,这样平均码长就 可以降低,从而提高编码效率。 7、八进制信源的最小熵为 0 ,最大熵为 3 bit 。 8、一个事件发生概率为0、125,则自信息量为 3 bit 。 9、在下面空格中选择填入数字符号“,,,=≥≤>”或“<” ()H XY = ()()+H Y H X Y ≤ ()()+H Y H X 二、判断题(正确打√,错误打×)(共5分,每小题1分) 1) 离散无记忆等概信源的剩余度为0。 ( √ ) 2) 离散无记忆信源N 次扩展源的熵就是原信息熵的N 倍 ( √ ) 3) 互信息可正、可负、可为零。 ( √ ) 4) 信源的真正功率P 永远不会大于熵功率P ,即P P ≤ ( × ) 5) 信道容量与信源输出符号的概率分布有关。 ( × ) 三、(5分)已知信源的概率密度函数()p x 如下图所示,求信源的相对熵 0.5信息论与编码第一章答案

信息论基础各章参考答案

信息论讲义11

信息论第1章

信息论基础 答案2

信息论第一章

信息论基础复习提纲

信息论作业第一章

信息论讲义-第五章(13讲)

第13讲 北京航空航天大学 201教研室 陈 杰

1. 编码器

—信源符号集 —码符号集 —代码组(Source Code ) —码 字(Codeword )

2. 分组码

S=(s1,s2, …sq) X=(x1,x2…xr) C=(W1, W2,…Wq) Wi=(xl1,xl2,…xli)

— 奇异性 (Non-singular ) — 唯一可译性 (Uniquely decodable ) — 即时码 (Instantaneous)

2

All codes Non-singular codes Uniquely decodable codes

Instantaneous codes

Figure 5.1. Classes of codes

3

3. 定长编码 3.1 唯一可译定长码

log q L log q +1 > l = ≥ log r N log r

编码速率 编码效率

L log r R= ≥ log q N

例: 英文字符数q=27, 且log2q=4.754 bit 信源熵 H(S)=4.03 bit, 取编码速率R=log2q 则编码效率 η=85%

H (S ) H (S ) η= ≤ R log q

4

3. 定长编码 3.2 定长码编码定理 (1) 正定理:

L log r ≥ H (S ) + ε R= N D[ I ( si )] pE ≤ Nε 2

pE → 0

(2) 逆定理:

L log r ≤ H ( S ) ? 2ε R= N

pE ≥ 1 ? 2 ? N ε

pE → 1

5信息论基础复习提纲

信息论基础 答案2