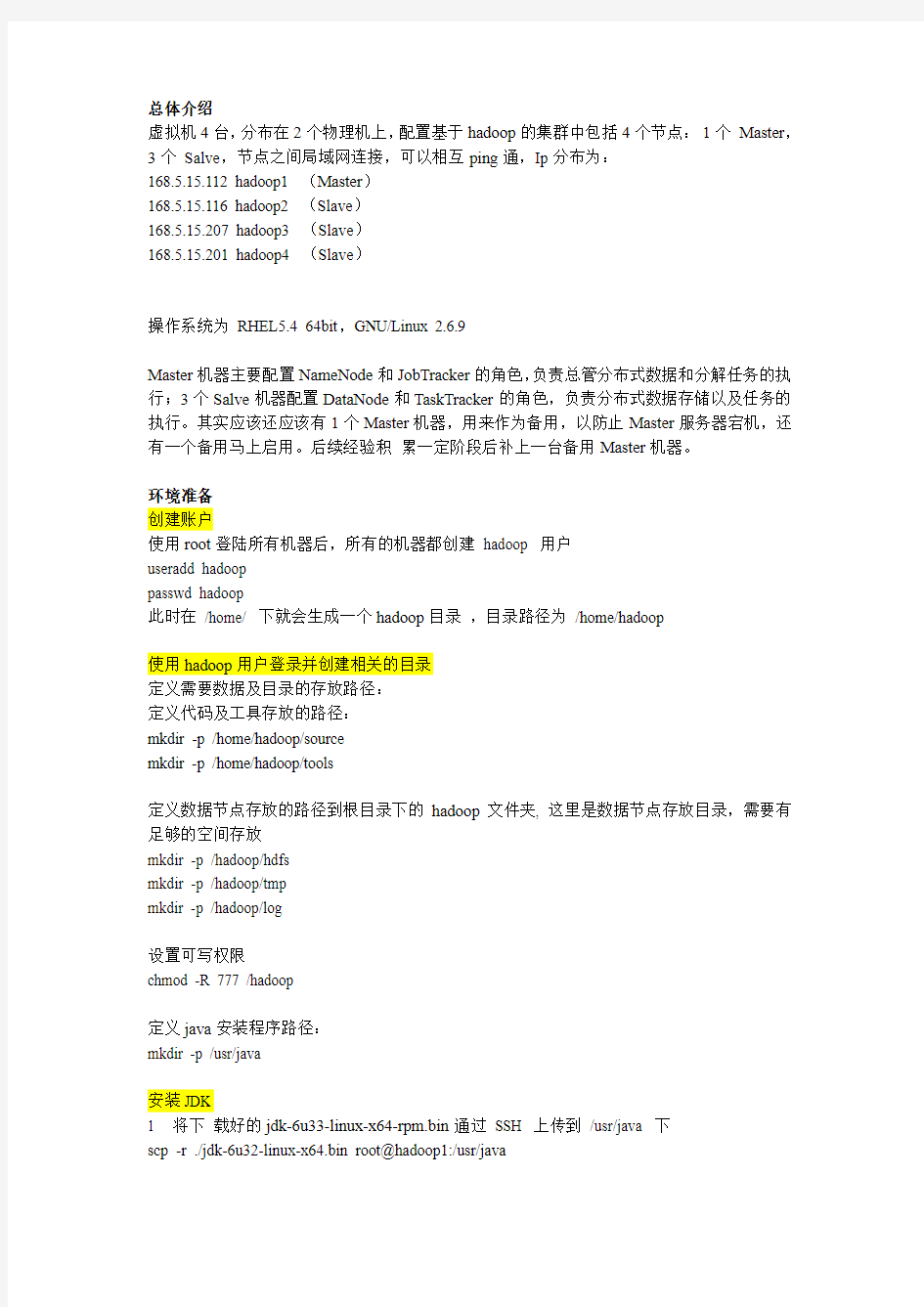

总体介绍

虚拟机4台,分布在2个物理机上,配置基于hadoop的集群中包括4个节点:1个Master,3个Salve,节点之间局域网连接,可以相互ping通,Ip分布为:

168.5.15.112 hadoop1 (Master)

168.5.15.116 hadoop2 (Slave)

168.5.15.207 hadoop3 (Slave)

168.5.15.201 hadoop4 (Slave)

操作系统为RHEL5.4 64bit,GNU/Linux 2.6.9

Master机器主要配置NameNode和JobTracker的角色,负责总管分布式数据和分解任务的执行;3个Salve机器配置DataNode和TaskTracker的角色,负责分布式数据存储以及任务的执行。其实应该还应该有1个Master机器,用来作为备用,以防止Master服务器宕机,还有一个备用马上启用。后续经验积累一定阶段后补上一台备用Master机器。

环境准备

创建账户

使用root登陆所有机器后,所有的机器都创建hadoop 用户

useradd hadoop

passwd hadoop

此时在/home/ 下就会生成一个hadoop目录,目录路径为/home/hadoop

使用hadoop用户登录并创建相关的目录

定义需要数据及目录的存放路径:

定义代码及工具存放的路径:

mkdir -p /home/hadoop/source

mkdir -p /home/hadoop/tools

定义数据节点存放的路径到根目录下的hadoop文件夹, 这里是数据节点存放目录,需要有足够的空间存放

mkdir -p /hadoop/hdfs

mkdir -p /hadoop/tmp

mkdir -p /hadoop/log

设置可写权限

chmod -R 777 /hadoop

定义java安装程序路径:

mkdir -p /usr/java

安装JDK

1 将下载好的jdk-6u33-linux-x64-rpm.bin通过SSH 上传到/usr/java 下

scp -r ./jdk-6u32-linux-x64.bin root@hadoop1:/usr/java

2 进入JDK 安装目录cd /usr/java 且执行chmod +x jdk-6u33-linux-x64-rpm.bin

3 执行./jdk-6u33-linux-x64-rpm.bin

4 配置环境变量,vi /etc/profile ,在行末尾添加

export JA VA_HOME=/usr/java/jdk1.6.0_33

export CLASSPATH=.:$JA V A_HOME/lib/tools.jar:/lib/dt.jar

export PA TH=$JA V A_HOME/bin:$PA TH

5 执行chmod +x profile 将其变成可执行文件

6 使配置立即生效

source /etc/profile

7 执行java -version 查看是否安装成功

这个步骤所有机器都必须安装

[root@hadoop1 bin]# java -version

java version "1.6.0_33"

Java(TM) SE Runtime Environment (build 1.6.0_33-b04)

Java HotSpot(TM) 64-Bit Server VM (build 20.8-b03, mixed mode)

修改主机名

修改主机名,所有节点均一样配置

1 连接到主节点168.5.15.11

2 ,修改network ,执行vi /etc/sysconfig/network ,修改HOSTNAME=hadoop1

2 修改hosts 文件,vi /etc/hosts ,在行末尾添加:

168.5.15.112 hadoop1

168.5.15.116 hadoop2

168.5.15.207 hadoop3

168.5.15.201 hadoop4

3 执行hostname hadoop1

4 执行exit 后重新连接可看到主机名以修改OK

其他节点也修改主机名后添加Host, 或者host 文件可以在后面执行scp 覆盖操作

配置SSH无密码登陆

SSH 无密码原理简介:

首先在hadoop1 上生成一个密钥对,包括一个公钥和一个私钥,并将公钥复制到所有的slave(hadoop2-hadoop4)机器上。

然后当master 通过SSH连接slave时,slave就会生成一个随机数并用master的公钥对随机数进行加密,并发送给master。

最后,master收到加密数之后再用私钥解密,并将解密数回传给slave,slave确认解密数无误之后就允许master不输入密码进行连接了

具体步骤(在root用户和hadoop用户登陆情况下分别执行,hadoop用户密码必须设置)1 执行命令ssh-keygen -t rsa 之后一路回车,查看刚生成的无密码钥对:cd .ssh 后执行ll (两个l字母)

2 把id_rsa.pub 追加到授权的key 里面去

执行命令cat ~/.ssh/id_rsa.pub >>~/.ssh/authorized_keys

3 修改权限:执行chmod 600 ~/.ssh/authorized_keys

4 确保cat /etc/ssh/sshd_config中存在如下内容(root下处理)RSAAuthentication yes

PubkeyAuthentication yes

AuthorizedKeysFile .ssh/authorized_keys

ssh localhost (务必执行)

如果没有需要密码即可

去掉前面的#注释字符,在修改后执行重启SSH 服务命令使其生效(root下处理)service sshd restart

5 将公钥复制到所有的slave机器上

scp ~/.ssh/id_rsa.pub 168.5.15.116:~/

然后输入yes

最后输入slave机器的密码

6 在slave 机器上创建 .ssh 文件夹(若文件夹已存在则不需要创建)mkdir ~/.ssh

然后执行

chmod 700 ~/.ssh

7 追加到授权文件authorized_keys 执行命令

cat ~/id_rsa.pub >> ~/.ssh/authorized_keys

然后执行

chmod 600 ~/.ssh/authorized_keys

8 在其他机器上重复第5 步

scp ~/.ssh/id_rsa.pub 168.5.15.207:~/

scp ~/.ssh/id_rsa.pub 168.5.15.201:~/

9 验证命令

在master机器上执行ssh 168.5.15.207发现主机名由hadoop1变成hadoop3即成功:

按照以上步骤分别配置hadoop1,hadoop2,hadoop3,hadoop4,要求每个都可以无密码登录其他机器,如下所示:

Hadoop安装

HADOOP 版本

最新版本hadoop-2.2.0安装包为hadoop-2.2.0.tar.gz

下载官网地址:https://www.doczj.com/doc/cd5814898.html,/dyn/closer.cgi/hadoop/common/

下载到/home/hadoop/source目录下

wget http://ftp.riken.jp/net/apache/hadoop/common/hadoop-2.2.0/hadoop-2.2.0.tar.gz 解压目录

tar zxvf hadoop-2.2.0.tar.gz

创建软连接

cd /home/hadoop

ln -s /home/hadoop/source/hadoop-2.2.0/ ./hadoop

源码配置修改

/etc/profile

配置环境变量

vi /etc/profile

添加

export HADOOP_HOME=/home/hadoop/hadoop

export PA TH=$PATH:$HADOOP_HOME/bin

export PA TH=$PATH:$HADOOP_HOME/sbin

export HADOOP_MAPARED_HOME=${HADOOP_HOME}

export HADOOP_COMMON_HOME=${HADOOP_HOME}

export HADOOP_HDFS_HOME=${HADOOP_HOME}

export Y ARN_HOME=${HADOOP_HOME}

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop export HDFS_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export Y ARN_CONF_DIR=${HADOOP_HOME}/etc/hadoop

生效配置:

source /etc/profile

进入/etc/hadoop目录中

cd /home/hadoop/hadoop/etc/hadoop

配置hadoop-env.sh

#vi /home/hadoop/hadoop/hadoop-2.0.5-alpha/etc/hadoop/hadoop-env.sh vi hadoop-env.sh

在末尾添加

export JA VA_HOME=/usr/java/jdk1.6.0_33

编辑core-site.xml的配置

vi core-site.xml

在configuration 节点里面添加属性

-- 添加httpfs 的选项

master配置

vi masters

168.5.15.112

slave配置

vi slaves

添加slave 的IP

168.5.15.116

168.5.15.201

168.5.15.207

配置hdfs-site.xml

vi hdfs-site.xml

添加节点

配置yarn-site.xml

vi yarn-site.xml

添加节点

同步代码到其他机器

同步配置代码

先在slaves的机器上也创建

mkdir -p /home/hadoop/source

部署hadoop代码,创建软连接,然后只要同步修改过的etc/hadoop下的配置文件即可

cd /home/hadoop/source

tar zxvf hadoop-2.2.0.tar.gz

cd /home/hadoop

ln -s /home/hadoop/source/hadoop-2.2.0/ ./hadoop

scp -r /home/hadoop/hadoop/etc/hadoop/core-site.xml root@hadoop2:/home/hadoop/hadoop/etc/hadoop/core-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/hdfs-site.xml root@hadoop2:/home/hadoop/hadoop/etc/hadoop/hdfs-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/yarn-site.xml root@hadoop2:/home/hadoop/hadoop/etc/hadoop/yarn-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/core-site.xml root@hadoop3:/home/hadoop/hadoop/etc/hadoop/core-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/hdfs-site.xml root@hadoop3:/home/hadoop/hadoop/etc/hadoop/hdfs-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/yarn-site.xml root@hadoop3:/home/hadoop/hadoop/etc/hadoop/yarn-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/core-site.xml root@hadoop4:/home/hadoop/hadoop/etc/hadoop/core-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/hdfs-site.xml root@hadoop4:/home/hadoop/hadoop/etc/hadoop/hdfs-site.xml

scp -r /home/hadoop/hadoop/etc/hadoop/yarn-site.xml root@hadoop4:/home/hadoop/hadoop/etc/hadoop/yarn-site.xml

同步/etc/profile和/etc/hosts

scp -r /etc/profile root@hadoop2:/etc/profile

scp -r /etc/hosts root@hadoop2:/etc/hosts

其他机器以此类推操作

scp -r /etc/profile root@hadoop3:/etc/profile

scp -r /etc/hosts root@hadoop3:/etc/hosts

scp -r /etc/profile root@hadoop4:/etc/profile

scp -r /etc/hosts root@hadoop4:/etc/hosts

同时修改各个slave机器上的/home/hadoop/hadoop/etc/hadoop/hadoop-env.sh中,加上export JA VA_HOME=/usr/java/jdk1.6.0_33

Hadoop启动

格式化集群

以下用hadoop用户执行

hadoop namenode -format -clusterid clustername

启动hdfs

执行

start-dfs.sh

开启hadoop dfs服务

启动Yarn

开启yarn 资源管理服务

start-yarn.sh

启动httpfs

开启httpfs 服务

httpfs.sh start

使得对外可以提高http的restful接口服务

Http安装结果验证

验证hdfs

在各台机器执行jps看进程是否都已经启动了

[root@hadoop1 hadoop]# jps

27113 ResourceManager

27546 Bootstrap

26793 DataNode

27232 NodeManager

26387 SecondaryNameNode

26075 NameNode

27633 Jps

[root@hadoop2 ~]# jps

8966 Jps

31822 DataNode

31935 NodeManager

进程启动正常

验证是否可以登陆

hadoop fs -ls hdfs://168.5.15.112:9000/

hadoop fs -mkdir hdfs://168.5.15.112:9000/testfolder

hadoop fs -copyFromLocal /testfolder hdfs://168.5.15.112:9000/testfolder (前提为本机已创建/testfolder目录)

hadoop fs -ls hdfs://168.5.15.112:9000/testfolder

看以上执行是否正常

验证map/reduce

在master1 上,创建输入目录:

hadoop fs -mkdir hdfs://168.5.15.112:9000/input

将一些txt文件复制到hdfs 分布式文件系统的目录里,执行以下命令

hadoop fs -put /test/*.txt hdfs://168.5.15.112:9000/input

在hadoop1 上,执行HADOOP 自带的例子,wordcount 包,命令如下

cd $HADOOP_HOME/share/hadoop/mapreduce

hadoop jar hadoop-mapreduce-examples-2.2.0.jar wordcount hdfs://168.5.15.112:9000/input hdfs://168.5.15.112:9000/output

在hadoop1上,查看结果命令如下:

[root@master1 hadoop]# hadoop fs -ls hdfs://168.5.15.112:9000/output

Found 2 items

-rw-r--r-- 2 root supergroup 0 2012-06-29 22:59 hdfs://168.5.15.112:9000/output/_SUCCESS

-rw-r--r-- 2 root supergroup 16605 2012-06-29 22:59 hdfs://168.5.15.112:9000/output/part-r-00000

[root@hadoop1 hadoop]# hadoop fs -cat hdfs://168.5.15.112:9000/output/part-r-00000 即可看到每个单词的数量

验证WEB管理功能

打开IE,输入http://168.5.15.112:23001,可以看到如下画面

附录

RHEL使用yum安装软件

1,加载光盘:

cd /media

mkdir iso

mount /dev/hdc iso

2,在/etc/yum.repos.d/路径下找到*.repo,输入以下文本内容:

[base]

name=Base RPM Repository for RHEL5

baseurl=file:///media/iso/Server/

enabled=1

gpgcheck=0

3,修改/usr/lib/python2.4/site-packages/yum/路径下的yumRepo.py文件(可以看到,RHEL5.0 的系统代码是用Python开发的!),将其中由remote = url + '/' + relative 修改为remote = "file:///mnt/iso/Server/" + '/' + relative 就可以了。

(vi通过:/remote = ulr即可找到)

通过yum install可以安装,如安装gcc,输入yum install gcc即可

一般尽量不要使用yum remove

另外,如果安装光盘的版本比系统版本低,一般无法正常安装,必须找到匹配版本进行安装

sshd_config的内容

# $OpenBSD: sshd_config,v 1.73 2005/12/06 22:38:28 reyk Exp $

# This is the sshd server system-wide configuration file. See

# sshd_config(5) for more information.

# This sshd was compiled with PATH=/usr/local/bin:/bin:/usr/bin

# The strategy used for options in the default sshd_config shipped with

# OpenSSH is to specify options with their default value where

# possible, but leave them commented. Uncommented options change a

# default value.

#Port 22

#Protocol 2,1

Protocol 2

#AddressFamily any

#ListenAddress 0.0.0.0

#ListenAddress ::

# HostKey for protocol version 1

#HostKey /etc/ssh/ssh_host_key

# HostKeys for protocol version 2

#HostKey /etc/ssh/ssh_host_rsa_key

#HostKey /etc/ssh/ssh_host_dsa_key

# Lifetime and size of ephemeral version 1 server key

#KeyRegenerationInterval 1h

#ServerKeyBits 768

# Logging

# obsoletes QuietMode and FascistLogging

#SyslogFacility AUTH

SyslogFacility AUTHPRIV

#LogLevel INFO

# Authentication:

#LoginGraceTime 2m

#PermitRootLogin yes

#StrictModes yes

#MaxAuthTries 6

#RSAAuthentication yes

#PubkeyAuthentication yes

#AuthorizedKeysFile .ssh/authorized_keys

# For this to work you will also need host keys in /etc/ssh/ssh_known_hosts #RhostsRSAAuthentication no

# similar for protocol version 2

#HostbasedAuthentication no

# Change to yes if you don't trust ~/.ssh/known_hosts for

# RhostsRSAAuthentication and HostbasedAuthentication

#IgnoreUserKnownHosts no

# Don't read the user's ~/.rhosts and ~/.shosts files

#IgnoreRhosts yes

# To disable tunneled clear text passwords, change to no here!

#PasswordAuthentication yes

#PermitEmptyPasswords no

PasswordAuthentication yes

# Change to no to disable s/key passwords

#ChallengeResponseAuthentication yes

ChallengeResponseAuthentication no

# Kerberos options

#KerberosAuthentication no

#KerberosOrLocalPasswd yes

#KerberosTicketCleanup yes

#KerberosGetAFSToken no

# GSSAPI options

#GSSAPIAuthentication no

GSSAPIAuthentication yes

#GSSAPICleanupCredentials yes

GSSAPICleanupCredentials yes

# Set this to 'yes' to enable PAM authentication, account processing,

# and session processing. If this is enabled, PAM authentication will

# be allowed through the ChallengeResponseAuthentication mechanism.

# Depending on your PAM configuration, this may bypass the setting of

# PasswordAuthentication, PermitEmptyPasswords, and

# "PermitRootLogin without-password". If you just want the PAM account and

# session checks to run without PAM authentication, then enable this but set

# ChallengeResponseAuthentication=no

#UsePAM no

UsePAM yes

# Accept locale-related environment variables

AcceptEnv LANG LC_CTYPE LC_NUMERIC LC_TIME LC_COLLATE LC_MONETARY LC_MESSAGES

AcceptEnv LC_PAPER LC_NAME LC_ADDRESS LC_TELEPHONE LC_MEASUREMENT AcceptEnv LC_IDENTIFICATION LC_ALL

#AllowTcpForwarding yes

#GatewayPorts no

#X11Forwarding no

X11Forwarding yes

#X11DisplayOffset 10

#X11UseLocalhost yes

#PrintMotd yes

#PrintLastLog yes

#TCPKeepAlive yes

#UseLogin no

#UsePrivilegeSeparation yes

#PermitUserEnvironment no

#Compression delayed

#ClientAliveInterval 0

#ClientAliveCountMax 3

#ShowPatchLevel no

#UseDNS yes

#PidFile /var/run/sshd.pid

#MaxStartups 10

#PermitTunnel no

#ChrootDirectory none

# no default banner path

#Banner /some/path

# override default of no subsystems

Subsystem sftp /usr/libexec/openssh/sftp-server

格式化集群的输出

[root@hadoop1 hadoop]# hadoop namenode -format -clusterid clustername DEPRECATED: Use of this script to execute hdfs command is deprecated.

Instead use the hdfs command for it.

13/08/16 16:31:01 INFO https://www.doczj.com/doc/cd5814898.html,Node: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = hadoop1/168.5.15.112

STARTUP_MSG: args = [-format, -clusterid, clustername]

STARTUP_MSG: version = 2.0.5-alpha

STARTUP_MSG: classpath = /home/hadoop/hadoop/etc/hadoop:/home/hadoop/hadoop/share/hadoop/common/lib/kfs-0.3.jar:/ho me/hadoop/hadoop/share/hadoop/common/lib/guava-11.0.2.jar:/home/hadoop/hadoop/share/hadoo p/common/lib/jackson-jaxrs-1.8.8.jar:/home/hadoop/hadoop/share/hadoop/common/lib/snappy-jav a-1.0.3.2.jar:/home/hadoop/hadoop/share/hadoop/common/lib/commons-digester-1.8.jar:/home/ha doop/hadoop/share/hadoop/common/lib/jets3t-0.6.1.jar:/home/hadoop/hadoop/share/hadoop/com mon/lib/servlet-api-2.5.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jetty-util-6.1.26.jar:/h ome/hadoop/hadoop/share/hadoop/common/lib/commons-net-3.1.jar:/home/hadoop/hadoop/share/ hadoop/common/lib/zookeeper-3.4.2.jar:/home/hadoop/hadoop/share/hadoop/common/lib/hadoop -annotations-2.0.5-alpha.jar:/home/hadoop/hadoop/share/hadoop/common/lib/protobuf-java-2.4.0a .jar:/home/hadoop/hadoop/share/hadoop/common/lib/jasper-compiler-5.5.23.jar:/home/hadoop/ha doop/share/hadoop/common/lib/commons-beanutils-1.7.0.jar:/home/hadoop/hadoop/share/hadoop /common/lib/commons-httpclient-3.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jetty-6.

1.26.jar:/home/hadoop/hadoop/share/hadoop/common/lib/stax-api-1.0.1.jar:/home/hadoop/hadoop /share/hadoop/common/lib/commons-io-

2.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/c ommons-codec-1.4.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jsp-api-2.1.jar:/home/had oop/hadoop/share/hadoop/common/lib/jsr305-1.

3.9.jar:/home/hadoop/hadoop/share/hadoop/comm on/lib/commons-math-2.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/commons-beanutil s-core-1.8.0.jar:/home/hadoop/hadoop/share/hadoop/common/lib/avro-1.5.3.jar:/home/hadoop/had oop/share/hadoop/common/lib/xmlenc-0.52.jar:/home/hadoop/hadoop/share/hadoop/common/lib/c ommons-lang-2.5.jar:/home/hadoop/hadoop/share/hadoop/common/lib/hadoop-auth-2.0.5-alpha.ja r:/home/hadoop/hadoop/share/hadoop/common/lib/jackson-core-asl-1.8.8.jar:/home/hadoop/hadoo p/share/hadoop/common/lib/slf4j-api-1.6.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/ja xb-impl-2.2.3-1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/commons-logging-1.1.1.jar:/ home/hadoop/hadoop/share/hadoop/common/lib/paranamer-2.3.jar:/home/hadoop/hadoop/share/h adoop/common/lib/commons-cli-1.2.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jersey-js on-1.8.jar:/home/hadoop/hadoop/share/hadoop/common/lib/slf4j-log4j12-1.6.1.jar:/home/hadoop/ hadoop/share/hadoop/common/lib/jersey-server-1.8.jar:/home/hadoop/hadoop/share/hadoop/com mon/lib/jsch-0.1.42.jar:/home/hadoop/hadoop/share/hadoop/common/lib/asm-3.2.jar:/home/hadoo p/hadoop/share/hadoop/common/lib/jackson-xc-1.8.8.jar:/home/hadoop/hadoop/share/hadoop/com mon/lib/commons-configuration-1.6.jar:/home/hadoop/hadoop/share/hadoop/common/lib/commo ns-el-1.0.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jersey-core-1.8.jar:/home/hadoop/h adoop/share/hadoop/common/lib/jettison-1.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/

log4j-1.2.17.jar:/home/hadoop/hadoop/share/hadoop/common/lib/jasper-runtime-5.5.23.jar:/home/ hadoop/hadoop/share/hadoop/common/lib/jackson-mapper-asl-1.8.8.jar:/home/hadoop/hadoop/sha re/hadoop/common/lib/jaxb-api-2.2.2.jar:/home/hadoop/hadoop/share/hadoop/common/lib/commo ns-collections-3.2.1.jar:/home/hadoop/hadoop/share/hadoop/common/lib/activation-1.1.jar:/home/ hadoop/hadoop/share/hadoop/common/hadoop-common-2.0.5-alpha-tests.jar:/home/hadoop/hado op/share/hadoop/common/hadoop-common-2.0.5-alpha.jar:/contrib/capacity-scheduler/*.jar:/contr ib/capacity-scheduler/*.jar:/home/hadoop/hadoop/share/hadoop/hdfs:/home/hadoop/hadoop/share/ hadoop/hdfs/lib/guava-11.0.2.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/servlet-api-2.5.jar:/ home/hadoop/hadoop/share/hadoop/hdfs/lib/jetty-util-6.1.26.jar:/home/hadoop/hadoop/share/hado op/hdfs/lib/protobuf-java-2.4.0a.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/jetty-6.1.26.jar:/h ome/hadoop/hadoop/share/hadoop/hdfs/lib/commons-io-2.1.jar:/home/hadoop/hadoop/share/hado op/hdfs/lib/commons-codec-1.4.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/jsp-api-2.1.jar:/h ome/hadoop/hadoop/share/hadoop/hdfs/lib/jsr305-1.3.9.jar:/home/hadoop/hadoop/share/hadoop/h dfs/lib/xmlenc-0.52.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/commons-lang-2.5.jar:/home/ hadoop/hadoop/share/hadoop/hdfs/lib/jackson-core-asl-1.8.8.jar:/home/hadoop/hadoop/share/hado op/hdfs/lib/commons-logging-1.1.1.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/commons-cli-1.2.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/jersey-server-1.8.jar:/home/hadoop/hadoop/sh are/hadoop/hdfs/lib/asm-3.2.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/commons-el-1.0.jar:/ home/hadoop/hadoop/share/hadoop/hdfs/lib/jersey-core-1.8.jar:/home/hadoop/hadoop/share/hadoo p/hdfs/lib/log4j-1.2.17.jar:/home/hadoop/hadoop/share/hadoop/hdfs/lib/jasper-runtime-5.5.23.jar:/ home/hadoop/hadoop/share/hadoop/hdfs/lib/jackson-mapper-asl-1.8.8.jar:/home/hadoop/hadoop/s hare/hadoop/hdfs/lib/commons-daemon-1.0.13.jar:/home/hadoop/hadoop/share/hadoop/hdfs/hado op-hdfs-2.0.5-alpha-tests.jar:/home/hadoop/hadoop/share/hadoop/hdfs/hadoop-hdfs-2.0.5-alpha.jar :/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/snappy-java-1.0.3.2.jar:/home/ha doop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/junit-4.8.2.jar:/home/hadoop/source/hadoo p-2.0.5-alpha/share/hadoop/yarn/lib/hadoop-annotations-2.0.5-alpha.jar:/home/hadoop/source/had oop-2.0.5-alpha/share/hadoop/yarn/lib/protobuf-java-2.4.0a.jar:/home/hadoop/source/hadoop-2.0. 5-alpha/share/hadoop/yarn/lib/javax.inject-1.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/h adoop/yarn/lib/commons-io-2.1.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/li b/guice-servlet-3.0.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/avro-1.5.3. jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/jackson-core-asl-1.8.8.jar:/ho me/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/paranamer-2.3.jar:/home/hadoop/sou rce/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/guice-3.0.jar:/home/hadoop/source/hadoop-2.0.5-al pha/share/hadoop/yarn/lib/netty-3.5.11.Final.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/h adoop/yarn/lib/aopalliance-1.0.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib /jersey-server-1.8.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/asm-3.2.jar: /home/hadoop/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/jersey-guice-1.8.jar:/home/hadoo p/source/hadoop-2.0.5-alpha/share/hadoop/yarn/lib/jersey-core-1.8.jar:/home/hadoop/source/hado op-2.0.5-alpha/share/hadoop/yarn/lib/log4j-1.2.17.jar:/home/hadoop/source/hadoop-2.0.5-alpha/sh are/hadoop/yarn/lib/jackson-mapper-asl-1.8.8.jar:/home/hadoop/source/hadoop-2.0.5-alpha/share/ hadoop/yarn/hadoop-yarn-server-web-proxy-2.0.5-alpha.jar:/home/hadoop/source/hadoop-2.0.5-al pha/share/hadoop/yarn/hadoop-yarn-server-common-2.0.5-alpha.jar:/home/hadoop/source/hadoop -2.0.5-alpha/share/hadoop/yarn/hadoop-yarn-server-tests-2.0.5-alpha.jar:/home/hadoop/source/had oop-2.0.5-alpha/share/hadoop/yarn/hadoop-yarn-server-nodemanager-2.0.5-alpha.jar:/home/hadoo

弹性计算服务 (ECS)-技术白皮书 目录 文档图索引 (3) 文档表索引 (4) 1.云服务器概述 (4) 2.产品功能与特点 (4) 2.1.产品价值 (4) 2.2.系统架构 (4) 2.2.1.虚拟化平台与分布式存储 (5) 2.2.2.控制系统 (5) 2.2.3.运维及监控系统 (6) 2.3.云服务器 (6) 2.4.磁盘快照 (7) 2.5.自定义镜像 (7) 3.产品特点介绍 (8) 3.1.灵活方便 (8)

3.1.1.数据安全可靠 (9) 3.1.2.网络安全可靠 (10) 3.1.3.高效的运维与客服 (10) 4.价值分析 (10) 5.使用案例 (12) 5.1.平台概念解析及原理介绍 (12) 5.1.1.镜像与云服务器实例 (12) 5.1.2.Region (13) 5.1.3.存储系统 (13) 5.2.网络与安全组 (13) 5.3.实施 (15) 5.3.1.镜像使用 (15) 5.3.2.创建并使用云服务器创建并使用云服务器并使用 (16) 5.3.3.使用安全组完成解决方案使用安全组完成解决方案 (17) 5.3.4.使用磁盘快照 (17) 5.3.5.调用API实例 (17) 6.附录 (18)

6.1.云服务器规格说明 (18) 6.2.云服务器使用说明 (19) 6.3.云服务器安全防护 (19) 文档图索引 图 1 系统架构 (4) 图 2 虚拟化平台与分布式存储 (5) 图 3 云服务器 (6) 图 4 磁盘快照 (7) 图 5 自定义镜像 (8) 图 6用户业务 (8) 图 7产品特点介绍 (8) 图 8网络安全设置 (10) 图 9防ARP/IP欺骗 (14) 图 10 流量清洗 (15) 图 11 自定义镜像 (16) 图 12 安全组实施方案 (17) 图 13 磁盘快照 (17)

我们以Windows Server 2003搭配邮件服务器软件Exchange 2003为例,介绍G 容量的邮箱是怎样架设的。 架设初步: 安装邮件服务器 Step1:将计算机的IP地址设定为192.168.10.100,设置DNS为本机IP地址。 Step2:点击“开始→运行”,键入dcpromo命令,将Windows Server 2003升级到Active Directory活动目录服务器。在“新的域名”处设置域名为https://www.doczj.com/doc/cd5814898.html,,“NetBIOS域名”设置为MSFT,其他的按照默认值设置即可。 小知识 Active Directory是活动目录服务器,相当于Windows NT中的“域”。 NNTP(Network News Transfer Protocol)是网络新闻传输协议,用于新闻组服务。 SMTP(Simple Mail Transfer Protocal)称为简单邮件传输协议,用于邮件服务器发送邮件。 Step3:Exchange 2003需要NNTP和SMTP协议的支持,在安装Exchange 2003之前,需要安装这两项服务。运行“添加/删除程序→添加Windows组件”,在“Windows组件向导”中,双击“应用程序服务器”,选中“https://www.doczj.com/doc/cd5814898.html,”和“Internet信息服务(IIS)”(图1)。双击“Internet信息服务(IIS)”,在弹出的窗口中选中“NNTP Service”和“SMTP Service”,然后单击“确定”。

图1 Step4:运行Windows Server 2003安装光盘中“Support\tools”文件夹中的suptools.msi,安装Windows Server 2003的支持工具。 Step5:安装Exchange 2003。将Exchange 2003安装光盘放在光驱中,运行安装程序。在Exchange 2003的安装界面中,依次单击“Exchange部署工具→部署第一台Exchange 2003服务器→安装全新的Exchange 2003”,将进入部署工具界面(图2)。

前言 本篇主要介绍在大数据应用中比较常用的一款软件Mysql,我相信这款软件不紧紧在大数据分析的时候会用到,现在作为开源系统中的比较优秀的一款关系型开源数据库已经被很多互联网公司所使用,而且现在正慢慢的壮大中。 在大数据分析的系统中作为离线分析计算中比较普遍的两种处理思路就是:1、写程序利用 mapper-Reducer的算法平台进行分析;2、利用Hive组件进行书写Hive SQL进行分析。 第二种方法用到的Hive组件存储元数据最常用的关系型数据库最常用的就是开源的MySQL了,这也是本篇最主要讲解的。 技术准备 VMware虚拟机、CentOS 6.8 64 bit、SecureCRT、VSFTP、Notepad++ 软件下载 我们需要从Mysql官网上选择相应版本的安装介质,官网地址如下: MySQL下载地址:https://www.doczj.com/doc/cd5814898.html,/downloads/

默认进入的页面是企业版,这个是要收费的,这里一般建议选择社区开源版本,土豪公司除外。

然后选择相应的版本,这里我们选择通用的Server版本,点击Download下载按钮,将安装包下载到本地。 下载完成,上传至我们要安装的系统目录。 这里,需要提示下,一般在Linux系统中大型公用的软件安装在/opt目录中,比如上图我已经安装了Sql Server On linux,默认就安装在这个目录中,这里我手动创建了mysql目录。 将我们下载的MySQL安装介质,上传至该目录下。

安装流程 1、首先解压当前压缩包,进入目录 cd /opt/mysql/ tar -xf mysql-5.7.16-1.el7.x86_64.rpm-bundle.tar 这样,我们就完成了这个安装包的解压。 2、创建MySql超级管理用户 这里我们需要单独创建一个mySQL的用户,作为MySQL的超级管理员用户,这里也方便我们以后的管理。 groupaddmysql 添加用户组 useradd -g mysqlmysql 添加用户 id mysql 查看用户信息。

一、新增账号 1、打开Outlook Express,如下图1所示,在“工具”菜单中,选择“帐号”单击。 图1 2、出现如下图2所示窗口,单击“邮件”。 图2 3、出现如下图3窗口,单击“添加--〉邮件”。

图3 4、出现如下图 4所示"Internet 连接向导”窗口,填写用户姓名,单击“下一步”。 图4 5、出现如下图5所示窗口,填写用户电子邮件地址,单击“下一步”。 sc02@https://www.doczj.com/doc/cd5814898.html,

sc02@https://www.doczj.com/doc/cd5814898.html, 图5 6、出现如下图6所示窗口,选择邮件接收服务器类型,填写接收邮件服务器和发送邮件服务器地址. 发件(pop3)服务器(192.168.1.116)、接收(smtp)服务器的地址(192.168.1.116). 然后单击“下一步”。 192.168.1.116 192.168.1.116 图 6 7、出现如下图7所示的窗口,填写“帐户名”和“密码”,选择“记住密码”,单击“下一步”。

sc0200@https://www.doczj.com/doc/cd5814898.html, ********** 图7 8、出现如下图8所示窗口,单击“完成”。 9、然后在“工具”菜单中,选择“帐号”单击。如下图9所示

图9 10 、出现如下图10所示窗口,单击“邮件”。 图10 11、出现如下图11所示窗口,选择您的账户,单击“属性”。 192.168.1.116……

192.168.1.116 图11 12、出现如下图12所示窗口,选择“服务器”。 192.168.1.116 192.168.1.116 生产部-贾红萍 Sc02@https://www.doczj.com/doc/cd5814898.html, 图12 13、出现如下图13所示的窗口,请把“我的服务器需要身份验证”选上,然后单击“确定”,完成所有设置操作。

阿里云主机Linux服务器配置步骤详解 编辑:restart 来源:转载 下面我们一起来看看关于阿里云主机Linux服务器配置步骤详解,如果你正在使用阿里云主机我们可进入参考一下配置步骤哦,有兴趣的同学可进入参考。 一提到云主机,大家肯定熟知国内最知名品牌——阿里云了,后来居上的它受到不少的站长所追捧,它的稳定与服务让它的性价比直线上升,现在阿里云的最低端配置云主机年费只需要550元了,在同类产品中可谓最有性价了。如果想做个小站,又想速度上去,阿里云也是一个不错的选择。用过阿里云的站长都知道,阿里云主机是需要自己动手配置的,一些站长就有夸大其词说“没有一定的技术,最好不要用阿里云”。其实,配置阿里云主机也不是很难,只要按照本文的方法一步一步去做就可以了。 第一步:远程连接阿里云主机。 下载xshell和xftp 并安装。这2个软件可以到网站下载。xshell 是一个强大的安全终端模拟软件,它支持SSH1, SSH2, 以及Microsoft Windows 平台的TELNET 协议,可以方便地远程登录阿里云主机。Xftp 是一个基于MS windows 平台的功能强大的S 文件传输软件,可以通过它来上传文件到主机。 这2个软件的安装这里就不说了。下面来看看怎么使用这两个软件。 一、打开xshell

二、设置云服务器登录信息,点击认证(新版本可能是“用户身份验证”)。填写阿里云主机用户名和密码。 三、设置服务器帐号密码。再点击“连接”,填写在“主机”处填写你购买的阿里云主机的IP地址。

四、设置字符集编码。点击”终端“,然后在“编码”选项选择“ UTF-8″。然后按确定保存配置。接着就开始连接主机了。 五、连接后的阿里云主机的庐山正面目。

实验5 电子邮件服务器的建立及设置 5.1 实验目的 了解电子邮件服务器的功能和作用。 熟练掌握一种电子邮件服务器的安装、配置及用户管理的方法。 进一步理解应用层协议。 5.2 实验环境 1.硬件环境 Pentium III 500MHz 以上的微型处理器,以及256MB 以上内存(推荐计算机1GHz CPU 和1GB 内存)。 2.软件配置 Microsoft Windows 9x/NT4/2000/XP以上操作系统+ Internet Explorer 5.0以上版本。SMTP/POP/IMAP 及相关服务需要Winsock TCP/IP 堆栈。 3.网络环境 ISP 提供的互联网访问或局域网环境(仅把MDaemon 当作一个内部邮件服务器,即不使用它发送和接收外部邮件)。 5.3 准备知识 电子邮件服务是目前Internet上使用最频繁的服务。电子邮件系统不但可以传输各种格式的文本信息,而且可以传输图像、声音、视频等多种信息。 邮件服务器系统的核心邮件服务器负责接收用户送来的邮件,并根据收件人地址发送到对方的邮件服务器中,同时负责接收由其他邮件服务器发来的邮件,并根据收件人地址分发到相应的电子邮箱中。当用户向ISP申请Internet账户时,ISP就会在它的邮件服务器上建立该用户的电子邮件账户,包括用户名(user name)和用户密码(password)。 在电子邮件程序向邮件服务器中发送邮件时,使用的是简单邮件传输协议SMTP;电子邮件程序从邮件服务器中读取邮件时,可以使用邮局协议POP3或交互式邮件存取协议IMAP,它取决于邮件服务器支持的协议类型。配置电子邮件服务器的准备知识如下: 1.相关协议 (1)SMTP(Simple Mail Transfer Protocol):简单邮件传输协议。SMTP是一种提供可靠且有效电子邮件传输的协议。SMTP是建立在FTP文件传输服务上的一种邮件服务,主要用于传输系统之间的邮件信息并提供与来信有关的通知。 SMTP独立于特定的传输子系统,且只需要可靠有序的数据流信道支持。SMTP的重要

Hadoop全分布式安装配置 一实验目的: 1、了解Hadoop的体系结构、组成; 2、熟练掌握Hadoop的配置、安装方法; 3、通过安装Hadoop了解Hadoop的原理; 二实验内容: 集群包含三个安装了Linux操作系统的节点。将其中的一个节点作为NameNode,另外两个节点作为DataNode,安装之前先利用ping命令,确认三个节点之间的网络互通,即可以互相ping通。假设三个节点IP地址如下,实际的集群节点IP地址可以不同。 NameNode:192.168.198.2 主机名:master DataNode1:192.168.198.3 主机名:slaver1 DataNode2:192.168.198.4 主机名:slaver2 三实验环境: 在申请的虚拟服务器上安装了VMWare Workstation虚拟3个Ubuntu14.04系统。 四安装配置过程: 1、安装Vmware WorkStation软件 下载安装Vmware WorkStation12.0软件。 2、在虚拟机上安装linux操作系统 在Vmware WorkStation12.0中创建一个Ubuntu14.04系统。拷贝镜像文件复制出三个系统。分别为master、slaver1、slaver2。 3、配置hosts、hostname文件

在三台机器上配置相同的hosts文件 (1)修改hosts sudo gedit /etc/hosts 192.168.198.200 master 192.168.198.199 slave1 192.168.198.198 slave2 (2)修改hostname sudo gedit /etc/hostname 4、配置ip地址 配置ip:sudo gedit /etc/network/interfaces slave2 auto eth0 iface eth0 inet static address 192.168.198.198 gateway 192.168.198.107 netmask 255.255.255.0 slave1 auto eth0 iface eth0 inet static address 192.168.198.199 gateway 192.168.198.107 netmask 255.255.255.0 master auto eth0 iface eth0 inet static address 192.168.198.200 gateway 192.168.198.107 netmask 255.255.255.0

IMAIL邮件服务器配置 一、实验目的 1、掌握利用Imail软件构建企业邮件服务器的方法。 2、理解电子邮件服务的体系结构与工作原理。 3、熟悉邮件用户代理程序的使用。 二、实验设备及环境 1、两台计算机。一台做服务器,系统平台为Window2000 server,另一台做客户机,系统平台为Window2000 Professional 或Windows XP。 2、Imail 8.22软件、Web中文模板。 三、实验步骤 1、检查实验环境。 确认服务器已安装DNS组件,且网络属性设置为:IP 192.168.1.2、子网掩码255.255.255.0、网关为空、DNS为192.168.1.1(在本机测试用)。 客户机网络属性设置为:IP 192.168.1.10、子网掩码255.255.255.0、网关为空、DNS为192.168.1.1。在客户机能ping 通192.168.1.2。 2、配置DNS服务。 创建https://www.doczj.com/doc/cd5814898.html,域,创建mail主机记录指向192.168.1.2。创建邮件交换记录。 在客户机ping https://www.doczj.com/doc/cd5814898.html,,看到DNS域名解释结果为192.168.1.2。 3、安装Imail。 1)设置邮箱域名 DNS设置了https://www.doczj.com/doc/cd5814898.html,指向192.168.1.2即可 2)选择服务 这里用到四个服务,一个POP3服务,一个是SMTP服务,一个是web service(用于网页访问),还有一个默认选上的IMAIL 队列管理服务。

4、配置IMail服务器。 按照上面的步骤一步一步来做,完成后,不需要做额外的配置就可以工作了,需要进一步设置,可以通过在如下面板设置。 5、创建用户user1和user2,并设置用户属性。 6、使用Outlook Express收发电子邮件。 添加两个账户user1@https://www.doczj.com/doc/cd5814898.html,和user2@https://www.doczj.com/doc/cd5814898.html,。用两个账户互发邮件,验证服务器和用户属性配置。 7、利用浏览器访问Mail服务器。 四、实验过程原始记录(数据、图表、计算等) 1、配置DNS服务

阿里云服务器配置SVN 服务器与生产站点同步 来源:本站转载作者:佚名时间:2014-03-08 TAG:我要投稿 作为linux的门外汉,一直觊觎svn的方便性,在有台aliyun的情况下,一起来搞搞。 1.环境 阿里云centos5.5 2.安装svn yum -y install subversion 3.配置 建立版本库目录 mkdir /alidata/www/svndata svnserve -d -r /alidata/www/svndata 4.建立版本库 创建一个新的Subversion项目 svnadmin create /alidata/www/svndata/myproject 配置允许用户rsync访问 cd /alidata/www/svndata/myproject/conf vi svnserve.conf anon-access=none

auth-access=write password-db=passwd 注:修改的文件前面不能有空格,否则启动svn server出错 vi passwd [users] #<用户1> = <密码1> #<用户2> = <密码2> myname=myaname 5.客户端连接 svn co svn://ip/alidata/www/svndata/myproject 用户名密码:myname 6.实现SVN与WEB同步,可以CO一个出来,也可以直接配在仓库中 1)设置WEB服务器根目录为/alidata/www/webroot 2)checkout一份SVN svn co svn://localhost/alidata/www/svndata/myproject /alidata/www/webroot 修改权限为WEB用户 chown -R www:www /alidata/www/webroot/myproject 3)建立同步脚本 cd /alidata/www/svndata/oplinux/hooks/ cp post-commit.tmpl post-commit 编辑post-commit,在文件最后添加以下内容 export LANG=en_US.UTF-8 SVN=/usr/bin/svn

2008-10-23 17:31 2008-06-23 10:53 在windows2003下架设邮件服务器的过程跟XP系统类似,可以用系统自带的POP3及SMTP服务建立,也可以借助第三方软件实现。适用环境不同自然采取的方式不同。以下笔者的搭建过程分别以这两种方式为例。一.利用windows2003自带POP3/SMTP服务实现第一步:安装POP3/SMTP服务。默认情况下windows2003是没有安装的,我们必须手工添加。 安装POP3服务:控制面板----“添加/删除windows组件—电子邮件服务”下,它共包括两项内容: POP3服务和POP3服务WEB管理. 而SMTP服务应:选择控制面板—添加删除WINDOWS组件—应用程序服务器—详细信息—internet信息服务 (IIS)—详细信息—SMTP service”进行安装,如果你需要对邮件服务器进行远程WEB管理,还要选中“万 维网服务”中的“远程管理(HTML)”。 第二步:配置POP3服务依次点击“开始-管理工具-POP3服务”,打开“POP3服务”主窗口;然后在窗口左面点击POP3服务下的主机名(本机),再在右面点选“新域”;在弹出的“添加域”对话框内输入欲建立的邮件服务器主 机名,也就是@后面的部分,确定即可。接着创建邮箱。在左面点击刚才建好的域名,选择“新建邮箱”,在弹出的对话框内输入邮箱名(即@前面部分),并设定邮箱使用密码,最终设定如图1。

图1 第三步:SMTP服务配置依次打开“开始-程序-管理工具-internet信息服务”,在窗口左面”SMTP虚拟服务器”上点右键选属性,在“常规”选项卡下的“IP地址”下拉列表框中选择此邮件服务器的IP地址,并可以设定允许的最大连接数,最后确定即可。(如图2所示) 图2 经过以上三步,一个功能简单的邮件服务器就建好了,大家即可用邮件客户端软件连接到此服务器进行邮件收发应用了。 二.使用第三方软件Winmail Server 搭建 是一款安全易用全功能的邮件服务器软件,它既可以作为局域网邮件服务器、互联网邮件服务器,也可以作为拨号ISDN、ADSL宽带、FTTB、有线通(Ca bleModem) 等接入方式的邮件服务器和邮件网关。 软件大小:12899KB 下载地:https://www.doczj.com/doc/cd5814898.html,/download/winmail.exe 一.初始化配置流程:

本文为笔者安装配置过程中详细记录的笔记 1.下载hadoop hadoop-2.7.1.tar.gz hadoop-2.7.1-src.tar.gz 64位linux需要重新编译本地库 2.准备环境 Centos6.4 64位,3台 hadoop0 192.168.1.151namenode hadoop1 192.168.1.152 datanode1 Hadoop2 192.168.1.153 datanode2 1)安装虚拟机: vmware WorkStation 10,创建三台虚拟机,创建时,直接建立用户ha,密码111111.同时为root密码。网卡使用桥接方式。 安装盘 、 2). 配置IP.创建完成后,设置IP,可以直接进入桌面,在如下菜单下配置IP,配置好后,PING 确认好用。 3)更改三台机器主机名 切换到root用户,更改主机名。 [ha@hadoop0 ~]$ su - root Password: [root@hadoop0 ~]# hostname hadoop0 [root@hadoop0 ~]# vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=hadoop0 以上两步后重启服务器。三台机器都需要修改。 4)创建hadoop用户 由于在创建虚拟机时,已自动创建,可以省略。否则用命令创建。

5)修改hosts文件 [root@hadoop0 ~]# vi /etc/hosts 127.0.0.1 localhostlocalhost.localdomain localhost4 localhost4.localdomain4 ::1localhostlocalhost.localdomain localhost6 localhost6.localdomain6 192.168.1.151 hadoop0 192.168.1.152 hadoop1 192.168.1.153 hadoop2 此步骤需要三台机器都修改。 3.建立三台机器间,无密码SSH登录。 1)三台机器生成密钥,使用hadoop用户操作 [root@hadoop0 ~]# su– ha [ha@hadoop0 ~]$ ssh -keygen -t rsa 所有选项直接回车,完成。 以上步骤三台机器上都做。 2)在namenode机器上,导入公钥到本机认证文件 [ha@hadoop0 ~]$ cat ~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys 3)将hadoop1和hadoop2打开/home/ha/.ssh/ id_rsa.pub文件中的内容都拷贝到hadoop0的/home/ha /.ssh/authorized_keys文件中。如下: 4)将namenode上的/home/ha /.ssh/authorized_keys文件拷贝到hadoop1和hadoop2的/home/ha/.ssh文件夹下。同时在三台机器上将authorized_keys授予600权限。 [ha@hadoop1 .ssh]$ chmod 600 authorized_keys 5)验证任意两台机器是否可以无密码登录,如下状态说明成功,第一次访问时需要输入密码。此后即不再需要。 [ha@hadoop0 ~]$ ssh hadoop1 Last login: Tue Aug 11 00:58:10 2015 from hadoop2 4.安装JDK1.7 1)下载JDK(32或64位),解压 [ha@hadoop0 tools]$ tar -zxvf jdk-7u67-linux-x64.tar.gz 2)设置环境变量(修改/etx/profile文件), export JAVA_HOME=/usr/jdk1.7.0_67 export CLASSPATH=:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib export PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin 3)使环境变量生效,然后验证JDK是否安装成功。

阿里云云服务器Windows 2008中的FTP配置图文教程 这篇文章主要介绍了阿里云云服务器Windows 2008中的FTP配置图文教程,本文包含创建FTP账号、添加FTP站 点、绑定和SSL设置等内容,需要的朋友可以参考下 云服务器默认使用Windws 2008 IIS 中自带的FTP服务器。 1、添加FTP帐号 A. 选择“服务管理器”->“配置”->“本地用户和组”->“用户”;在空白处右键选择“新用户”; B. 输入用户名,全名和描述可以不填写;输入两遍密码;可以设置“用户不能修改密码”和“密码永不过期”;选择“创建”; 2、打开Internet 服务(IIS)管理器 启动左下角任务栏中的“服务器管理器”,选择“角色”->”Web服务器IIS”->”Internet 服务(IIS)管理器”来打开IIS管理界面; 3、启动添加FTP站点向导 选择左侧连接中的“网站”,点击右侧操作窗口中的“添加FTP站点”;

4、启动“添加FTP站点”向导 输入FTP站点名称和FTP指向的路径;选择“下一步”; 5、绑定和SSL设置 选择你希望开放的IP地址(默认选择全部未分配,即所以IP都开放)和端口(默认选择21);SSL请根据您的具体情况选择,如无需使用SSL,请选择“无”;选择“下一步”;

6、身份验证和授权信息 身份验证请选择“基本”,不建议开启“匿名”;授权中允许访问的用户可以指定具体范围,如果FTP用户不需要很多的话,建议选择“指定用户”,权限选择“读取”和“写入”;选择“完成”。 7、测试FTP连接 您可以在“我的电脑”地址栏中输入ftp://IP来连接FTP服务器,根据提示输入账户密码。 如果您开启了windows默认的防火墙,默认是外网连接不了ftp的,需要设置防火墙策略,允许在windows防火墙的例外里面添加“C:\windows\system32\svchost.exe”程序,才能从外网成功访问ftp 步骤如下: 8)打开windows防火墙,选择允许程序或功能通过windows防火墙

Postfix邮件服务器安装 一.安装前准备 1.关闭防火墙 vi /etc/selinux/config 图1 如图1,将其中的SELINUX=enforcing修改为SELINUX=disabled 需要注意的是此修改需要重启后才能生效,可以在将所有搭建步骤结束后在进行重启。 2.关闭ip信息包过滤系统iptables iptables –flush 图2 3. 从自启动中关掉sendmail 先停掉sendmail服务:service sendmail stop

图3 然后从自启动项中移除sendmail:chkconfig sendmail off 二、安装软件包,本文档中安装的是linux redhat5.4自带的rpm安装包 1. 安装配置DNS服务器 DNS服务用来帮助解析域名的,如果不配置DNS服务,那么outlook,foxmail等软件无法解析我们的邮件域名,也就无法连接到提供收发邮件协议的服务器。 (1)查看系统是否已经安装了服务相关的所有安装包rpm –qa|grep bind 图4 可以看到系统只安装了服务所需的部分包,还需要安装如下图所示的其他包: 图5 (2)使用rpm –ivh 命令安装其他包: 图6

(3)配置DNS DNS有两个配置文件: ①主配置文件: /var/named/chroot/etc/named.conf 用来设置DNS全局命令的 编辑DNS主配置文件(默认是空的)如下: 命令:vi /var/named/chroot/etc/named.conf 这里以https://www.doczj.com/doc/cd5814898.html,域名为例进行配置,如图: 图7 编辑完成后先按Esc键退出编辑状态然后输入:wq 点击回车进行保存。 ②zone文件,注意此处的zone文件的名称要和住配置文件中的file后写的文件名一致。可以从模板拷贝一份zone文件进行编辑配置: cp/usr/share/doc/bind-9.3.6/sample/var/named/localdomain.zone /var/named/chroot/var/named/https://www.doczj.com/doc/cd5814898.html,.zone 图8 编辑https://www.doczj.com/doc/cd5814898.html,.zone文件:

hadoop3.0.0安装和配置1.安装环境 硬件:虚拟机 操作系统:Centos 7 64位 IP:192.168.0.101 主机名:dbp JDK:jdk-8u144-linux-x64.tar.gz Hadoop:hadoop-3.0.0-beta1.tar.gz 2.关闭防火墙并配置主机名 [root@dbp]#systemctl stop firewalld #临时关闭防火墙 [root@dbp]#systemctl disable firewalld #关闭防火墙开机自启动 [root@dbp]#hostnamectl set-hostname dbp 同时修改/etc/hosts和/etc/sysconfig/network配置信息 3.配置SSH无密码登陆 [root@dbp]# ssh-keygen -t rsa #直接回车 [root@dbp]# ll ~/.ssh [root@dbp .ssh]# cp id_rsa.pub authorized_keys [root@dbp .ssh]# ssh localhost #验证不需要输入密码即可登录

4.安装JDK 1、准备jdk到指定目录 2、解压 [root@dbp software]# tar–xzvf jdk-8u144-linux-x64.tar.gz [root@dbp software]# mv jdk1.8.0_144/usr/local/jdk #重命名4、设置环境变量 [root@dbp software]# vim ~/.bash_profile 5、使环境变量生效并验证 5.安装Hadoop3.0.0 1、准备hadoop到指定目录 2、解压

阿里云云主机搭建网站攻略 前言:虽然我也不知道前言有什么用,但是还是跟随潮流写了。我也不知道这应不应该叫攻略,因为我自己也是一个新手,只是想写些自己用了云主机的一些经验和心得。作为一个萌新其实也很慌的好吗!虽然不知道有几个人会看,其实网上也有很多关于云主机如何搭建的,我会写还是要感谢同样在玩云主机的三位朋友!作为一个新人第一次写这么正经的文章有点小小的羞耻,不知道会写多少,坚持多久,只是想试试,能够坚持多久!这篇攻略主要针对阿里云出售的云主机,windows的系统和Linux系统大致一样。 1.阿里云云主机 1.1用途 云主机大多用于搭建一些小型网站,由于操作简单,价格比云服务器要便宜,是新手的话推荐这个 1.2购买 如果是新手的话我推荐阿里云中售价分别为6元/每年和9.9元每年的共享虚拟主机惠普版(如果有朋友找不到的话,我附上一个链接: https://https://www.doczj.com/doc/cd5814898.html,/hosting/free?spm=5176.8060947.858673.gongxiangpuhu i.794a029dqn9MbW) (ps:别说我打广告啊!我虽然也挺想收广告费的,但是人家也看不上我啊)。

如果打开链接或者自己搜索成功的话应该是这样的页面,以上三个选哪个都不影响,具体作用等着我下次有生之年系列再说。操作系统方面小白建议选windows 系统,windows系统支持https://www.doczj.com/doc/cd5814898.html,平台,如果是php开发就选Liunx系统。点击立即购买之后之后付款按钮之类的自己去找找吧,应该在很显眼的位置,毕竟是消费嘛。 显示购买成功之后就看下一步吧! 1.3怎么找到云主机的操作平台 确定买好了云主机,现在可以看下云主机是怎么操作的了,看网页的右上角有个这样的导航栏 点击控制台,以后在阿里云买的其他东西也可以在控制台看。 点击控制台之后在左上角应该可以看到这样一个侧边栏,点击有三根横线的按钮之后,应该看见这样一个面板 接下来选择域名与网站,因为买的是云主机,与网站相关,这个应该很好理解。在域名与网站中选中云虚拟主机,显示正确的话应该是如下页面

Exchange Server2003安装全过程 介绍Exchange 2003安装要求(了解即可) Exchange 2003 的全系统要求 安装Exchange Server 2003 之前,请确保网络和服务器满足以下全系统要求: ?域控制器正在运行 Windows 2000 Server Service Pack 3 (SP3) 或 Windows Server 2003。 ?全局编录服务器正在运行 Windows 2000 SP3 或Windows Server 2003。建议每个计划安装 Exchange 2003 的域中都要有全局编录服务器。 ?在 Windows 站点中,已正确配置域名系统 (DNS) 和 Windows Internet 名称服务(WINS)。 ?服务器正在运行Windows 2000 SP3 或Windows Server 2003 Active Directory。 Exchange 2003 的服务器特定要求 安装Exchange Server 2003 之前,请确保服务器满足这一节中描述的要求。如果服务器不满足所有要求,Exchange 2003 安装程序将停止安装。 硬件要求 下面是 Exchange 2003 服务器的最低硬件要求及推荐的硬件要求: ?Intel Pentium 或兼容的 133 MHz 或更快的处理器 ?建议至少使用 256 MB RAM;最低支持 128 MB ?安装 Exchange 的驱动器上应具备 500 MB 的可用磁盘空间 ?系统驱动器上应具备 200 MB 的可用磁盘空间 ?CD-ROM 驱动器 ?SVGA 或分辨率更高的显示器 文件格式要求 要安装 Exchange 2003,磁盘分区格式必须采用 NTFS 文件系统而不能采用文件分配表(FAT)。该要求适用于下列分区: ?系统分区 ?存储 Exchange 二进制数据的分区 ?包含事务日志文件的分区 ?包含数据库文件的分区 ?包含其他 Exchange 文件的分区 操作系统要求 下列操作系统支持 Exchange Server 2003: ?Windows 2000 SP3 或更高版本 ?Windows Server 2003

Hadoop安装简要过程及配置文件 1、机器准备 ①、Linux版操作系统centos 6.x ②、修改主机名,方便配置过程中记忆。修改文件为: /etc/sysconfig/network 修改其中的HOSTNAME即可 ③、配置局域网内,主机名与对应ip,并且其中集群中所有的机器的文件相同,修改文件为 /etc/hosts 格式为: 10.1.20.241 namenode 10.1.20.242 datanode1 10.1.20.243 datanode2 2、环境准备 ①、配置ssh免密码登陆,将集群中master节点生成ssh密码文件。具体方法: 1)、ssh-keygen -t rsa 一直回车即可,将会生成一份 ~/.ssh/ 文件夹,其中id_rsa为私钥文件 id_rsa.pub公钥文件。 2)、将公钥文件追加到authorized_keys中然后再上传到其他slave节点上 追加文件: cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys 上传文件: scp ~/.ssh/authorized_keys root@dananode:~/.ssh/ 3)、测试是否可以免密码登陆:ssh 主机名或局域网ip ②、配置JDK ③、创建hadoop用户 groupadd hadoop useradd hadoop -g hadoop 4)、同步时间 ntpdate https://www.doczj.com/doc/cd5814898.html, 5)、关闭防火墙 service iptables stop 3、安装cdh5 进入目录/data/tools/ (个人习惯的软件存储目录,你可以自己随便选择); wget "https://www.doczj.com/doc/cd5814898.html,/cdh5/one-click-install/redhat/ 6/x86_64/cloudera-cdh-5-0.x86_64.rpm" yum --nogpgcheck localinstall cloudera-cdh-5-0.x86_64.rpm 添加cloudera仓库验证: rpm --importhttps://www.doczj.com/doc/cd5814898.html,/cdh5/redhat/6/x86_64/cdh/RPM-GPG-KEY-cloudera

细数阿里云服务器的十二种典型应用场景 本文章来自于阿里云云栖社区 摘要:文章转载:小白杨1990 如今,阿里云的产品可谓是多种多样,纷繁复杂。面对各种各样的技术和产品,ECS、RDS、OSS…等等一系列的东西,很容易让人找不到头绪,尤其是刚刚开始接触网站建设的朋友。阿里云湖北授权服务中心武汉捷讯结合阿里云官网的资料,针对建站相关的内容为大家整理一些阿里云典型的应用场景 免费开通大数据服务:https://https://www.doczj.com/doc/cd5814898.html,/product/odps 文章转载:小白杨1990 如今,阿里云的产品可谓是多种多样,纷繁复杂。面对各种各样的技术和产品,ECS、RDS、OSS…等等一系列的东西,很容易让人找不到头绪,尤其是刚刚开始接触网站建设的朋友。阿里云湖北授权服务中心武汉捷讯结合阿里云官网的资料,针对建站相关的内容为大家整理一些阿里云典型的应用场景,以及每一种应用场景主要涉及的技术,给大家提供一个参考。相信看完本文,大家都能清楚的知道自己要实现的应用大概会需要用到什么样的服务和产品。 典型应用一些典型应用中可能涉及到的产品和概念 (一)一站式建站

阿里云提供域名和云解析服务,云市场还提供全程建站服务。小型网站只需一台云服务器ECS即可。 1、域名注册:国内域名市场NO.1,19年专业域名服务,超30种域名供您选择; 2、云解析:提供安全、稳定、极速的域名解析服务,每天超百亿次解析响应; 3、免费备案:人脸识别,备多久云服务器免费送多久; 4、建站服务:服务全程监管,不满意全额退款; 5、云服务器:可弹性伸缩、安全稳定、简单易用。 (二)随时灵活扩展 建议使用过弹性伸缩结合云服务器,实现在业务增长/下降时自动增加/减少云服务器实例。 1、网站初始阶段访问量小,应用程序、数据库、文件等所有资源均在一台云服务器上,节省初创成本; 2、用户使用镜像可免安装快速部署,提供php、Java、asp、https://www.doczj.com/doc/cd5814898.html,等运行环境; 3、当您开始营销推广,网站流量可能会出现成倍的增幅,使用台云服务器可以在几分钟内完成扩容,轻松应对,搭配负载均衡,实现水平扩容; 4、如果你的业务存在明显的波峰/谷,或无法预估流量波动,建议使用过弹性伸缩,实现在业务增长/下降时自动增加/减少云服务器实例。

很多企业局域网内都架设了邮件服务器,用于进行公文发送和工作交流。但使用专业的企业邮件系统软件需要大量的资金投入,这对于很多企业来说是无法承受的。其实我们可以通过Windows Server 2003提供的POP3服务和SMTP服务架设小型邮件服务器来满足我们的需要。 一、安装POP3和SMTP服务组件 Windows Server 2003默认情况下是没有安装POP3和SMTP服务组件的,因此我们要手工添加。 1.安装POP3服务组件 以系统管理员身份登录Windows Server 2003 系统。依次进入“控制面板→添加或删除程序→添加/删除Windows组件”,在弹出的“Windows组件向导”对话框中选中“电子邮件服务”选项,点击“详细信息”按钮,可以看到该选项包括两部分内容:POP3服务和POP3服务Web管理。为方便用户远程Web方式管理邮件服务器,建议选中“POP3服务Web管理”。 2.安装SMTP服务组件 选中“应用程序服务器”选项,点击“详细信息”按钮,接着在“Internet信息服务(IIS)”选项中查看详细信息,选中“SMTP Service”选项,最后点击“确定”按钮。此外,如果用户需要对邮件服务器进行远程Web管理,一定要选中“万维网服务”中的“远程管理(HTML)”组件。完成以上设置后,点击“下一步”按钮,系统就开始安装配置POP3和SMTP服务了。 二、配置POP3服务器 1.创建邮件域 点击“开始→管理工具→POP3服务”,弹出POP3服务控制台窗口。选中左栏中的POP3服务后,点击右栏中的“新域”,弹出“添加域”对话框,接着在“域名”栏中输入邮件服务器的域名,也就是邮件地址“@”后面的部分,如“https://www.doczj.com/doc/cd5814898.html,”,最后点击“确定”按钮。其中“https://www.doczj.com/doc/cd5814898.html,”为在Internet上注册的域名,并且该域名在DNS 服务器中设置了MX邮件交换记录,解析到Windows Server 2003邮件服务器IP地址上。 2.创建用户邮箱 选中刚才新建的“https://www.doczj.com/doc/cd5814898.html,”域,在右栏中点击“添加邮箱”,弹出添加邮箱对话框,在“邮箱名”栏中输入邮件用户名,然后设置用户密码,最后点击“确定”按钮,完成邮箱的创建。 三、配置SMTP服务器 完成POP3服务器的配置后,就可开始配置SMTP服务器了。点击“开始→程序→管理工具→Internet 信息服务(IIS)管理器”,在“IIS管理器”窗口中右键点击“默认SMTP虚拟服务器”选项,在弹出的菜单中选中“属性”,进入“默认SMTP虚拟服务器”窗口,切换到“常规”标签页,在“IP地址”下拉列表框中选中邮件服务器的IP地址即可。点击“确定”按钮,这样一个简单的邮件服务器就架设完成了。 完成以上设置后,用户就可以使用邮件客户端软件连接邮件服务器进行邮件收发工作了。在设置邮件客户端软件的SMTP和POP3服务器地址时,输入邮件服务器的域名“https://www.doczj.com/doc/cd5814898.html,”即可。 四、远程Web管理 Windows Server 2003还支持对邮件服务器的远程Web管理。在远端客户机中,运行IE浏览器,在地址栏中输入“https://服务器IP地址:8098”,将会弹出连接对话框,输入管理员用户名和密码,点击“确定”按钮,即可登录Web管理界面 邮件服务器的配置同样是企业网络管理中经常要进行的任务之一。与Web网站、FTP站点服务器一样,邮件服务器的配置方案也非常之多,但对于中小型企业说,利用网络操作系统自带的方式进行配置是最经济的。本文中,要向大家介绍如何在Windows Server 2003系统中配置企业内部邮件服务器。 Outlook Express、Outlook 200X、Windows Live Mail,Windows Mail Koomail,DreamMail,Thunderbird,The Bat!, SecureBat!,Eudora,IncrediMail,Becky!...