大数据背景下基于主题模型的

学习资源聚合研究

吴

笛,李保强

(武汉大学教育科学研究院,湖北武汉

430072)

[摘

要]随着大数据时代的来临,新的数据分析方法为人们在学术和学习领域提供了深层次的信息,揭示了更多隐

藏的数据关联并辅以可视化的呈现方式。采用数据挖掘技术分析和提取学习资源中的语义信息,使学习资源的管理更加智能化,已经成为目前教育技术领域研究的热点。文章基于自然语言处理与深度学习等相关算法,将零乱的学习资源分解为基于主题模型的资源实体;并且通过词语向量之间的语义关联,以标签作为资源集合的代表,重新对教育资源进行结构化的描述和聚合。通过该框架重新组织的学习资源库,可以解决目前学习资源建设中存在的资源组织非结构化与资源关系孤立化等问题,提高数据资源使用效率。

[关键词]大数据;主题模型;学习资源;资源聚合[中图分类号]G434[文献标志码]A

[作者简介]吴笛(1984—),男,湖北潜江人。讲师,博士,主要从事远程教育、个性化学习、数据挖掘研究。E-mail :

wudi@https://www.doczj.com/doc/a95770894.html, 。

基金项目:中国博士后科学基金第58批面上资助“大数据环境下基于本体关联的学习资源个性化推荐研究”(项目编号:

2015M580661)

一、引言网络技术飞速发展,推动了教育资源在互联网上快速积累和传播,网络学习已经进入大数据时代,对数字时代学习资源的管理方式也正在与时俱进。当前的电子学习资源包括电子书、讲义、视频和音频等多种形态,具有信息量大、更新速度快、共享性高等优点,但是也存在分散无序、组织混乱、难以管理等问题。因此,面对海量学习资源,如何利用数据挖掘、语义分析等技术解决当前网络学习资源分散无序、共享性差、聚合性不足等问题,成为当前教育技术关注的热点问题。本研究将借助语义分析和数据挖掘等相关算法,对数字化学习资源进行关联分析和结构化处理,期望能对当前数字化学习领域的资源建设提供借鉴和参考。

二、相关研究

大数据技术逐渐成为海量数据中快速定位的有效工具,自动化的辅助学习软件与大数据技术相结合将成为未来电化教育发展的重点,然而如何提高大数据处理能力以应对快速增长的学习资源成为难点问题。数字化学习资源中半结构化数据和非结构化数据非常多,为了提高计算机对自动化学习资源数据整理和个性化学习服务的智能程度,首先必须提高计算机对学习资源的语义提取能力。

语义数据提取是指利用自然语言处理的相关算法,从待处理文本中自动、准确提取最有代表性的文本特征作为语义表达,形成各种可重复利用的结构化数据文件,并能够提取学习资源所传达知识的核心概念及概念间的关系[1]。计算机在具备准确的语义数据

提取能力的情况下,才能更好地在学习资源分类和结构化整理中进行文本属性的定义,以及知识本体的关联,并进一步对资源个体之间的联系进行梳理,最终将学习资源库构建为一个有机的结构化整体。

(一)语义数据的提取

语义数据的提取主要分为有监督、半监督和无监督自动提取等三种情况。有监督语义数据提取的基本思想是应用统计学的方法来发现两个词语之间的关联关系,对于目标实体上下文中的词语关系处理需要人工参与,且人力开销较大;半监督的语义数据自动抽取方法更注重自动化,只需要少量的已标注数据;无监督的语义数据提取则从未标注的数据中学习和提取语义信息,不需要人工参与并且难度最大。用于语义关系抽取的方法有很多,目前比较成熟的有Bootstrapping、Co-training和Adaboost算法等[2][3]。Bootstrapping算法是一种广泛用于知识获取的机器学习方法,该方法利用有限的样本数据作为种子,通过多次重复抽样以及模式匹配,将种子不断扩充并重新建立一个新样本,其标注模型是一个反复迭代的过程。Co-training将Bootstrapping算法的思路加以扩展,主要用于解决二元分类问题,其核心步骤是构造两个不同的分类器,利用小规模的标注语料来对大规模的未标注语料进行标注,主要应用到网页分类、图像标注和词语分析等场景中。但该方法需要构建两个充分冗余视图,并且要求两个特征视图满足一致性和独立性假设,不符合许多实际应用的要求。Adaboost算法也是一种迭代算法,但它根据不同的内容和场景将多个不同的子分类器组合起来,构建成一个强分类器来提高精度,其在迭代计算时需要根据样本分类情况调整子分类器的权重,以此排除一些不必要的训练数据特征。

(二)语义的关联

提高计算机对学习资源的语义理解能力是为了对学习资源进行关联分析做准备,这种关联形式可以简单地分为显性和隐性两种模式[4]。显性关联是指不经过复杂的语义分析,以原始数据现存的数据结构和层次目录为基础,包括资源目录、超级链接和RSS聚合等,对学习资源重新梳理和归类。隐性关联不能通过人为规划的资源链接和目录形式体现,需要通过数据挖掘技术分析出计算机能够处理的潜在联系。隐性的关联需要将学习资源个体进行语义分析和描述,再通过聚类和推理等方法对数据资源进行结构化的划分。隐性的关联要求资源个体在进行关联时是从知识领域上的解释和逻辑出发,体现学习资源所要表达核心内容的概念及概念间的关系[5]。

学习资源的显性关联一般用链接的方式关联数据对象,主要依靠人工的结构化数据梳理形成联系,主观性较强,无法体现数据的内在联系[6]。而通过语义分析和关联之后,一方面可以提高对学习资源进行语义搜索时的准确性,为进一步的知识检索和学习推荐提供服务;另一方面还可以将分散的学习资源分类聚集,根据内在逻辑动态规划为结构清晰的资源群体。

(三)资源的聚合

学习资源的多元化发展一直存在着资源整合、集成和融合的问题,有很多种方法可用来形成结构化和有序化的资源体[7]。有研究人员指出:资源的聚合不等同于整合,整合仅仅将分散的资源归集到一起,而聚合则是整合基础上的进一步分类和聚集[8][9]。学习资源知识组织技术主要有基于目录、元数据和语义等聚合方式。基于目录的聚合方法是应用最广泛的,例如基于OPAC资源系统的美国国会图书馆目录门户提供的馆藏目录资源检索和OCLC公司(联机计算机图书馆中心)的在线编目联合目录。基于元数据的聚合方法一般采用类似SCORM的CAM中定义的关系元数据进行加工、整理和扩展,试图在元数据之间建立关系,以元数据作为资源的语义和关系表达形式对知识库重新进行梳理[10]。基于语义的聚合方法主要用到信息与知识集成等相关技术,通过为数字资源添加能够被计算机所理解的语义,并在此基础上对不同层次、不同来源的本体进行再构建,再对其进行系统化处理,从而形成新的知识体系的技术。本体的构建工具一般需要人工辅助,例如斯坦福大学开发的开放源代码的本体构建工具Protégé以及Apache公司发布的基于Java的Jena工具包等。

三、基于主题模型的聚合结构设计与实现

学习资源的聚合结构有多种,例如聚类划分、层次划分、基于图论和基于模型的划分等模式[11]。聚类划分是以相似性为基础,对数据进行无监督的自动分类统计方法,代表算法为K-means。它的基本思想是选取学习资源中多个节点作为聚类初始节点,采用距离作为相似性的评价指标,即认为两个节点的距离越近,其相似度就越大,然后根据聚类准则函数收敛情况动态调整。层次划分方法对给定的学习资源数据集进行层次似的分解,将数据划分为不同的分组,通过不停地迭代进行临近分组的组合,直到满足预定条件停止迭代。迭代过程又可以分为“自底向上”和“自顶

向下”两种结构。基于图论的划分则是为学习资源所处的数据空间构建一个相适应的图,图的节点对应于学习资源中的最小单元,图的边可以理解为单元数据之间的相似性度量,以单元数据之间的连接特征作为聚合结构的局部特性。基于模型的方法则是预定义一个模型,例如基于文本特征的向量空间等,然后将数据集进行分类和调整以满足该模型。

在对学习资源进行聚合结构设计之前,我们必须对学习资源个体进行结构化的表示,以方便我们对非结构化的学习资源表现形式进行统一。如图1所示,这里我们采用了基于主题模型的设计思路。主题可以简单地认为是语义相似的词的集合,集合里面汇集的是出现概率较高并且和主题具有强烈相关性的词语。我们把学习资源的基本单元结构分为主题(Topic)、资源实体(Occurrences)和关联(Association)。一个学习资源实体可能有多个主题,在抽象的学习资源体系中,主题可能表示为代表性的名词术语、作者、关键词等,主题与主题之间形成关联,并以此演变为资源实体之间的关联。本文的研究目的为通过聚合具有内在联系的资源实体形成一个庞大的资源库,协助学习者进行开放式的学习,并且资源实体之间根据主题分析而非人工整理形成高度的语义关联,提高学习者资源查找和探索的效率。

图1学习资源聚合结构设计

(一)主题信息的提取

在判断文档相关性的时候需要考虑到文档的语义,资源聚合的基础是根据资源实体挖掘语义生成主题。在主题模型中,主题代表学习资源实体的概念与核心,由从资源中选取的具有代表性的词语组成。从条件概率的角度解释,主题就是一个词语集合,集合中的每一个词与这个主题有很强的相关性,即“一个文档的每个词都是通过以一定概率选择了某个主题,并从这个主题中以一定概率选择某个词语”[12]。通过概率公式可以将词语、主题和文档的关系表示为:P(词语|文档)=

主题

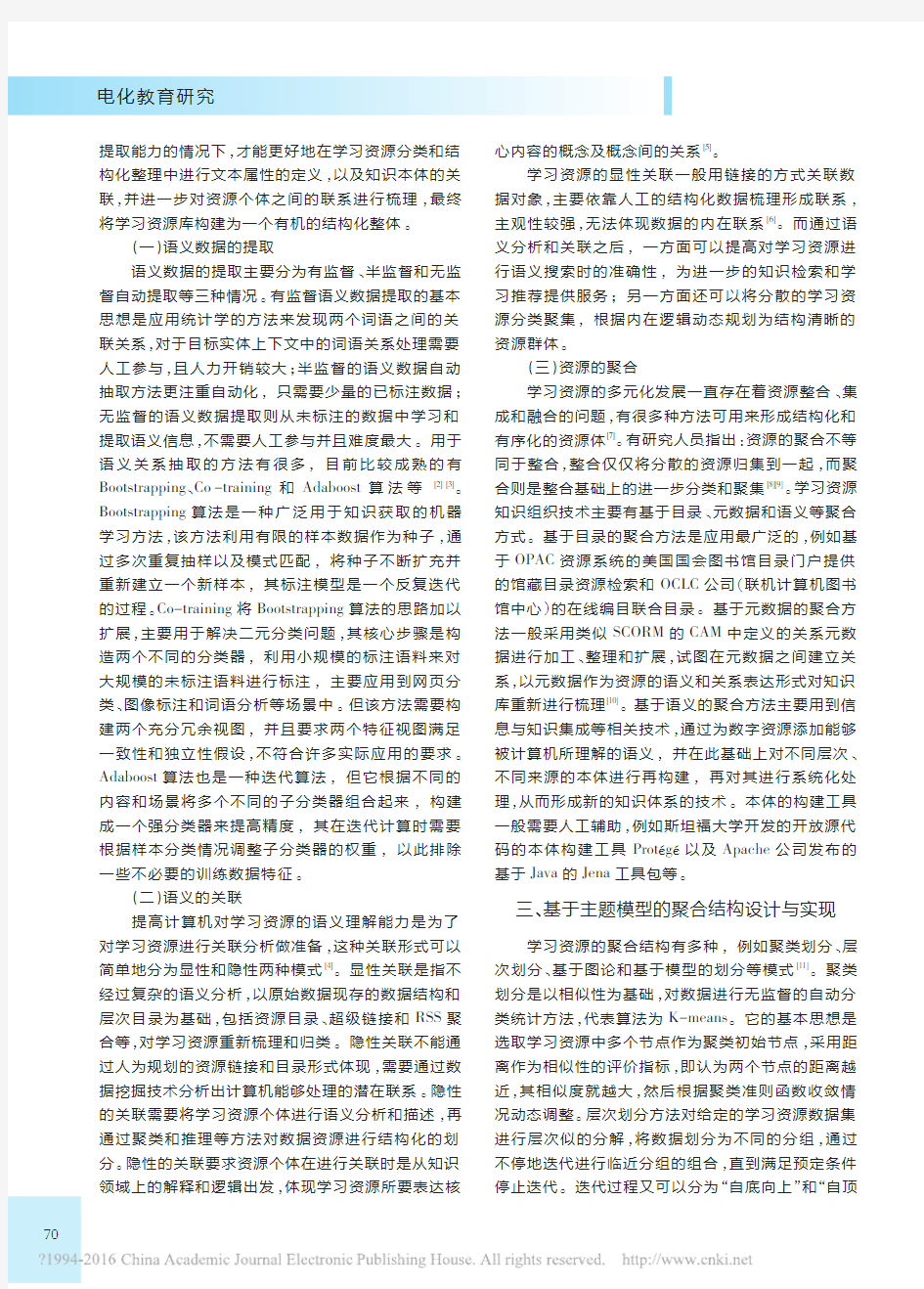

ΣP(词语|主题)×P(主题|文档)在该概率公式中,通过对文章进行分词统计可以得到每个词的词频概率P(词语|文档),这里需要选择恰当的迭代训练方法,找到合适的主题使得概率P (主题|文档)尽可能为最大值。本文采用常用的LDA 主题模型生成算法(隐含狄利克雷分配,Latent Dirichlet Allocation),LDA是一种非监督机器学习算法,能够识别大规模文档集和语料库中潜藏的主题信息。它通过一个生成性的三层贝叶斯网络,将词和文档通过潜在的主题相关联,在模型中不考虑词汇的顺序而只考虑它们的出现次数,简化了算法的复杂程度。LDA算法首先选定一个主题向量θ,每个主题被选择的概率则为P(θ|α),然后在每个主题中选定一个词语w,选择的概率为P(z n|θ),其选择的过程如图2所示。

图2LDA算法流程

从图2可知LDA的联合概率为:

P(θ,z,w|α,β)=P(θ|α)

N

n=1

仪P(z n|θ)p(w n|z n,β)图中M为学习资源库中文档的总数,N表示待处理文档的词语数量,w是文档的词向量表式,θ代表文档中各隐含主题的比重,z表示文档分配在每个词上的隐含主题比重,α反映了文档集中隐含主题间的相对强弱,β代表了所有隐含主题自身的概率分布矩阵P(w n|z n)。把w当作观察变量,θ和z当作隐藏变量,通过最大期望算法寻找参数α和β的最大似然估计,最终得到每个资源实体的主题。

(二)基于词向量的语义关联

在对资源实体生成主题信息之后,我们还需要将主题之间的关系计算出来,这里采用了自然语言处理中的词向量的计算方法,通过训练将文档中的每一个词映射成一个固定长度的短向量,这些向量共同组成了一个词向量空间,空间中的每一个点代表了一个词语,词语之间的距离就可以通过词向量空间中的“距离”进行表示[13][14]

。

以图3为例,假设将“余弦”、“正弦”、“动量”和“增势”等词语置入三维空间中(实际应为多维空间,维数由词向量的维数确定),不同词语向量以余弦距离或欧式距离作为向量差异,得到词语之间的距离,我们便能够通过词语向量进行关联分析,为进一步的知识关联作准备。“余弦”、和“正弦”两个词语的欧式距离最近,说明其语义较接近,而离“动量”和“增势”等词语较远。

图3词向量在三维空间中模拟的示意图

这种基于神经网络及深度学习的词语多维向量化模型最初由Bengio等人在NIPS(Neural Information Processing Systems)会议上发表,并且提出了相应的三层神经网络构建的训练方法[15]。随后Mikolov在2009年的ICASSP(International Conference on Acoustics, Speech and Signal Processing)会议中对该模型进行了完善并使其实用化,主要利用了单隐层网络训练词语表征,然后将该表征作为神经网络语言模型(Neural Network Language Model)的输入进行训练以提高算法计算速度[16]。斯坦福的Richard Socher在2014年的EMNLP会议上发表GloVe新算法[17],通过融合LSA 等算法的想法,利用全局向量将词向量精度提升了11%。这些模型均基于“相似的词语拥有相似的语境”假设,通过最大化条件概率,使得单词和语境之间的对应关系最大化,进而得到满足条件概率最大化的词语向量,最终结果也印证了假设的正确性。

本文采用了Mikolov开源的词向量训练工具Word2vec进行向量数据的生成,训练方式分为Skip-gram和CBOW,前者计算速度较慢,但对罕见字的训练精度较高;后者将输入层的所有词语共享映射层,导致精度降低但提高了速度。本次测试使用互动百科词条与分类页面数据为语料,共计4.65G及36万个页面,然后通过ANSJ进行分词,训练时设置采样阈值为1e-4,线程数20,使用默认窗口大小5,最终训练的词语向量为100维。

(三)资源聚合的设计与实现

本文在设计基于主题模型的资源聚合时,参考了复杂网络的相关算法。复杂网络即呈现高度复杂性的网络,根据钱学森的定义,即“具有自组织、自相似、吸引子、小世界、无标度中部分或全部性质的网络称为复杂网络”[18]。复杂网络是复杂系统的抽象,现实中许多复杂系统都可以用复杂网络的相关特性进行描述和定性,它具有结构复杂、小世界、网络进化、连接多样性等特点。小世界表示不管网络规模多大,但是任意两个节点间却有一条相当短的路径,同时网络中各个节点会形成小规模内聚的网络分布并且相互联系的状况,同时网络自身会根据节点的变化而发生形态的变动[19]。类似的,大数据背景下的学习资源中的聚合方式一般也是依据相似性查找的方法,在资源库中将具有相似关系的资源节点根据关联程度聚合成不同的主题资源集合,不同的资源节点之间也有不同程度的关联。

因此,在聚合过程中将学习资源库的构建过程作为一个复杂网络对待,在词向量组成的向量空间中,以主题词语为代表的资源个体可以作为复杂网络中的系统个体,个体之间的词向量距离表示个体之间的关系。同一集合内的节点与节点之间的连接很紧密,而集合与集合之间的连接比较稀疏。设图G=G(V,E),资源聚合的目的就是在图G中确定n(≥1)个社区使得各集合的顶点集合构成V的一个覆盖[20],形成过程如图4所示。

C=C1,C2,…,C n

≥≥

图4复杂网络中的资源聚合过程

将学习资源库通过复杂网络模型抽象之后,使用标签传播算法(LPA)这种基于图的半监督学习方法来对资源节点的相互关系和聚集形式进行计算。LPA 算法由Zhu,X.J.于2002年提出,该算法需要初始化一部分带有标签的资源节点,每个标签代表一个资源集合,每个节点的标签按相似度传播给相邻节点[21]。通过不断迭代的传播过程,已标注数据逐步将自身的标签复制给周围的未标注数据,同一个标签代表的资源集合形成一个相对稳定的整体,直到整个系统趋于稳定时完成标签传播过程。该过程利用少量的人工标注标签作为指导,通过资源个体的主题模型和代表词语自动关联周围的未标注数据,从而自动构建能够体现学习资源库内在关系的网络结构,完成资源群体的标记和划分

。

K-means LPA LPA (2)LPA (3)LPA (4)0.5624

0.5707

0.593

0.613

0.629

标签传播算法(LPA )的计算过程如下[22]:第一步:为已经标注的节点设定标签,假设(x 1,y 1)…(x l ,y l )为已经标记的数据,(y 1…y l )为类标签。标签的总数为C ,并且在已有标记中均使用过。

第二步:准备对未标记的节点(x l+1,y l+1)…(x l+u ,y l+u )进行标注。计算网络中某一个资源节点周围的所有节点的欧式距离,距离越小,权重越大,将出现权重最大的那个标签赋给当前节点,其中的权重大小可以通过参数σ进行控制。

第三步:逐轮刷新所有节点的标签,直到达到收敛要求为止[23]。

具体的标签选择过程如图5所示,计算主题“?”的节点周围的节点权重和顶点度,主题1的平均权重为1,主题2和3的平均权重都为3,而标签2的顶点度之和为2,标签3的顶点度之和为4。因此中间的顶点将选择3作为其标签。

图5

标签选择过程示意图

由于一个资源实体对应有多个标签,因此对每个节点所能归属的资源集合进行划分的时候,还需要考虑到多标签传播的问题。这里借鉴SLPA 重叠型社区发现算法的思路,记录每一个节点在刷新迭代过程中的历史标签序列,当迭代停止后,对每一个节点历史标签序列中的标签进行排序,选取最靠前的多个标签为该节点的标签[24]。

通过该算法,可以利用未标注数据之间的语义关系和邻近数据的标记,从已标记的数据预测和传播标签,由此形成以主题为核心、以标签为关联的知识网络,运算方式适合大量学习资源数据信息的结构化整理工作,并且为后续的检索与分类、语义分析、语料标注、信息推荐提供基础。

四、实验结果与分析

利用现有学习系统平台对已有的学习资源进行数据分析,该数据集包含5275个节点和15384条边,训练集以计算机课程方面的学习资源为主,以少量的人工标注数据对整个学习资源库进行深度的聚合处

理,其最终网络模型的部分数据如图6所示,该图形使用基于Cytoscape 的复杂网络可视化工具生成,资源节点附带由字母和数字编号对应的标签进行标注。

图6

基于Cytoscape 的复杂网络可视化数据结果

对这种复杂网络的划分结果一般采用模块度

(Modularity Measure)的指标进行评价,所谓模块度就是

网络中连接集合结构内部顶点的边所占的比例与另一个随机网络中连接社区结构内部顶点的边所占的比例的期望值的差值[25]。通过数学公式可以定义为:

在上式中,I c 是集合V 内部的节点相连的总边数,k c 是集合V 的度,E 是网络中边的数目。需要比较两个不同的网络划分时,取它们最好的集合结构C

(G 1)和C (G 2),如果Q (C G1)>Q (C G2),那么网络G 1的结构划分好于G 2。而对于本文中,由于一个集合可能会标注多个标签,集合与集合之间可能是重叠的,相应的模块度计算公式需要扩展,其中A vw 代表了网络对应的邻接矩阵的元素,较高的EQ 值代表了较强的重叠集合结构,通常现实网络的模块度函数的值一般在

0.3~0.7之间。

表1

K-means 聚类算法与不同标签数

上限的LPA 算法结果比较

本文将算法结果与常用的K-means 聚类算法进行了比较(见表1),当限定每个资源只能有一个标签时,即当所有的资源集合是非重叠时,模块度的区分不大,当增大每个节点的最大标签数量且允许资源集合重叠后,模块度有所增大。在测试中还发现,K-

means 算法因为需要预先确定初始聚类系数,系数的

选取和初始聚类中心的好坏对结果的影响非常大,特别是当集合之间大小差别较大并且网络结构比较复

[参考文献]

[1]张沪寅,李鑫,陆春涛,吴笛.LMOD :一种基于本体描述的电子学习资源库模型[J].计算机应用研究,2011,(4):1360~1364.[2]Zhang Minling ,Zhou Zhihua.A Review on Multi -Label Learning Algorithms [J].IEEE Transactions on Knowledge and Data

Engineering ,2014,26(8):1819~1837.

[3]Kim Tae-Hyun ,Park Dong-Chul ,Jeong Taikyeong ,Min Soo-Young.Multi-Class Classifier Based Adaboost Algorithm [C].Lecture

Notes in Computer Science ,2012:122~127.

[4]杨现民,余胜泉.学习元平台的语义技术架构及其应用[J].现代远程教育研究,2014,(1):89~99.[5]陈毅波.基于关联数据和用户本体的个性化知识服务关键技术研究[D].武汉:武汉大学,2012.[6]谢铭.关联数据和知识表示的自动语义标注技术[D].武汉:武汉大学,2012.

[7]杨现民,余胜泉,张芳.学习资源动态语义关联的设计与实现[J].中国电化教育,2013,(1):70~75.[8]杨现民.泛在学习环境下的学习资源有序进化研究[J].电化教育研究,2015,(1),62~68.[9]杨现民.泛在学习资源动态语义聚合研究[J].电化教育研究,2014,(2):68~73.

[10]赵雪芹.知识聚合与服务研究现状及未来研究建议[J].情报理论与实践,2015(2):132~136.

[11]杨瑞仙,李露琪.国内外数字文献资源深度聚合研究现状的比较分析[J].图书情报知识,2014,(6):68~75.[12]刘隽.多视角主题模型的研究和应用[D].上海:复旦大学,2013.

[13]Tomas Mikolov ,Ilya Sutskever ,Kai Chen ,Greg Corrado ,Jeffrey Dean.Distributed Representations of Words and Phrases and

Their Compositionality [J].Advances in Neural Information Processing Systems ,2013(26):3111~3119.[14]周练.Word2vec 的工作原理及应用探究[J].科技情报开发与经济,2015,(1),145~148.

[15]Lindh -Knuutila Tiina ,V 覿yrynen Jaakko J.,Honkela Timo.Semantic Analysis in Word Vector Spaces with ICA and Feature

Selection[C].Proceedings of the Conference on Natural Language Processing ,2012:98~107.

[16]Mikolov Tom á觢,Kombrink Stefan ,Burget Luk á觢,Cernocky Jan ,Khudanpur Sanjeev.Extensions of Recurrent Neural Network

Language Model[C].Proceedings of the Conference on Acoustics ,Speech ,and Signal Processing ,2011,125(3),5528~5531.[17]J.Pennington ,R.Socher ,C.D.Manning.Glove :Global Vectors for Word Representation [C].Proceedings of the Conference on

Empirical Methods on Natural Language Processing ,2014:1532~1543.

[18]杨博,刘大有,金弟,马海宾.复杂网络聚类方法[J].软件学报,2009,20(1):54~66.[19]张金松.基于引文上下文分析的文献检索技术研究[D].大连:大连海事大学,2013.

[20]罗秋滨,朱宏,李云晖,丛二勇.标签传播算法在社会网络中的应用研究[J].智能计算机与应用,2013,(3):37~42.

[21]Ismail ,M..Image Annotation and Retrieval Based on Multi-Modal Feature Clustering and Similarity Propagation [D].Louisville :

University of Louisville ,2011.

[22]Yang Yi-Hsuan ,Bogdanov Dmitry ,et al.Music Retagging Using Label Propagation and Robust Principal Component Analysis[C].

Proceedings of the 21st International Conference Companion on World Wide Web.New York ,USA ,2012:869~876.[23]张俊丽,常艳丽,师文.标签传播算法理论及其应用研究综述[J].计算机应用研究,2013,(1):21~26.[24]马宇峰,阮形.基于LDA 及标签传播的实体集合扩展研究[J].山东大学学报(理学版),2015,(3):20~28.[25]肖灵机,徐思良,汪明月.基于模块度的复杂网络社团结构聚类新算法[J].航空科学技术,2014,(11):74~78.

杂时,聚类结果不太准确。本文所使用的聚合方法能够更好地提取资源节点之间的聚合关系,虽然网络的复杂程度有所提高,但是更能体现资源集合之间的复杂语义关系。

五、总结与展望

本文基于主题模型结合语义分析和数据挖掘相关算法,对学习资源的聚合方式提出了新的思路。研

究的重点和创新点在于大数据背景下,如何利用复杂网络的分析算法对学习资源个体之间的关系进行重新梳理和结构化,将整个资源库构建为一个有机的整体。由于自然语言处理技术的局限性和知识关联的复杂性,要想对学习资源进行精确度更高的自动化知识标注和关联分析,还需要人工智能和机器学习技术在自然语言处理方向有所突破,后续工作将进一步关注国内外相关领域的最新进展。

Research on the Aggregation of Topic Model Based

Learning Resources in Big Data Environment

WU Di,LI Bao-qiang

[Abstract]With the coming of the big data era,new data analysis methods have provided deep information for research and learning,disclosed more hidden information of data association,and displayed the association with visualization.A popular research area in educational technology is to use data mining technology to analyze and extract semantic information from learning resources to make the management of learning resources more https://www.doczj.com/doc/a95770894.html,ing the algorithms of natural language processing and deep learning, we tried to break scattered learning resources into topic model based resource entities.Then,we described and aggregated the educational resources in a new way according to the semantic association of word vectors and the labels of topic model.By reorganizing the learning resources library using this framework, we were able to solve the issues that resources organization was unstructured and resources were isolated in the construction of learning resources,and thus were able to increase the efficiency of using learning resources.

[Keywords]Big Data;Topic Model;Learning Resources;Resource Aggregation

(上接第60页)

[15]连玉明.创新驱动力:中国数谷的崛起[M].北京:中信出版社,2015.

[16]吴志攀.“互联网+”的兴起与法律的滞后性[J].国家行政学院学报,2015,(3):39~43.

[17]杨开城,许易.论现代教育的基本特征与教育信息化的深层内涵[J].电化教育研究,2016,(1):12~17.

[18]刘晓琳,黄荣怀.从知识走向智慧:真实学习视域中的智慧教育[J].中国电化教育,2016,(3):14~20.

[19]颜正恕,徐济惠.线上线下一体化“互联网+”个性化教学模式研究[J].中国职业技术教育,2016,(5):74~78.

[20]陆俊杰.无差异的差异化:“互联网+”时代的高等教育变革[J].现代教育管理,2016,(1):1~6.

"Internet+"Education:The Debate and The Developmental Path

NAN Xu-guang,ZHANG Pei

[Abstract]"Internet+",originated from the real economy,is diffusing into and changing the field of education.It will reshape not only educational concepts and forms but also the entire education ecological system.However,the understanding of"Internet+"education is not unified.There are a lot of debates on the meaning of"Internet+"education,some of which are related to the essence of"Internet+"education.

Based on the analysis of the debates and the difficulties in its development,this paper discusses the implementation logics and development path of"Internet+"education from the perspectives of reshaping educational concepts,perfecting educational laws and regulations,improving educational infrastructure, changing operational mechanism,innovating schooling models,strengthening the analysis of learning,and others.The purposes of this paper are to inform the theoretical research and the practices in education, and to promote the healthy development of education in China in the era of"Internet+"education.

[Keywords]"Internet+"Education;The Debate;Logical Connotation;Development Path

一、描述统计描述性统计是指运用制表和分类,图形以及计筠概括性数据来描述数据的集中趋势、离散趋势、偏度、峰度。 1、缺失值填充:常用方法:剔除法、均值法、最小邻居法、比率回归法、决策 树法。 2、正态性检验:很多统计方法都要求数值服从或近似服从正态分布,所以之前需要进行正态性检验。常用方法:非参数检验的K-量检验、P-P图、Q-Q图、W 检验、动差法。 二、假设检验 1、参数检验 参数检验是在已知总体分布的条件下(一股要求总体服从正态分布)对一些主要的参数(如均值、百分数、方差、相关系数等)进行的检验。 1)U验使用条件:当样本含量n较大时,样本值符合正态分布 2)T检验使用条件:当样本含量n较小时,样本值符合正态分布 A 单样本t检验:推断该样本来自的总体均数卩与已知的某一总体均数卩0 (常为理论值或标准值)有无差别; B 配对样本t 检验:当总体均数未知时,且两个样本可以配对,同对中的两者在可能会影响处理效果的各种条件方面扱为相似; C 两独立样本t 检验:无法找到在各方面极为相似的两样本作配对比较时使用。 2、非参数检验 非参数检验则不考虑总体分布是否已知,常常也不是针对总体参数,而是针对总体的某些一股性假设(如总体分布的位罝是否相同,总体分布是否正态)进行检验。 适用情况:顺序类型的数据资料,这类数据的分布形态一般是未知的。 A 虽然是连续数据,但总体分布形态未知或者非正态; B 体分布虽然正态,数据也是连续类型,但样本容量极小,如10 以下; 主要方法包括:卡方检验、秩和检验、二项检验、游程检验、K-量检验等。 三、信度分析检査测量的可信度,例如调查问卷的真实性。 分类: 1、外在信度:不同时间测量时量表的一致性程度,常用方法重测信度 2、内在信度;每个量表是否测量到单一的概念,同时组成两表的内在体项一致性如何,常用方法分半信度。 四、列联表分析用于分析离散变量或定型变量之间是否存在相关。对于二维表,可进行卡 方检验,对于三维表,可作Mentel-Hanszel 分层分析列联表分析还包括配对计数资料的卡方检验、行列均为顺序变量的相关检验。 五、相关分析 研究现象之间是否存在某种依存关系,对具体有依存关系的现象探讨相关方向及相关程度。 1、单相关:两个因素之间的相关关系叫单相关,即研究时只涉及一个自变量和一个因变量; 2、复相关:三个或三个以上因素的相关关系叫复相关,即研究时涉及两个或两个以

关于大数据国内外的发展状态 来源:金窝窝 大数据的背景与意义 上世纪60年代到80年代早期,企业在大型机上部署财务、银行等关键应用系统,存储介质包括磁盘、磁带、光盘等。尽管当时人们称其为大数据,但以今日的数据量来看,这些数据无疑是非常有限的。随着PC的出现和应用增多,企业内部出现了很多以公文档为主要形式的数据,包括Word、Excel文档,以及后来出现的图片、图像、影像和音频等。此时企业内部生产数据的已不仅是企业的财务人员,还包括大量的办公人员,这极大地促进了数据量的增长。 关键词:大数据,发展,分析,技术 互联网的兴起则促成了数据量的第三次大规模增长,在互联网的时代,几乎全民都在制造数据。而与此同时,数据的形式也极其丰富,既有社交网络、多媒体等应用所主动产生的数据,也有搜索引擎、网页浏览等被动行为过程中被记录、搜集的数据。时至今日,随着移动互联网、物联网、云计算应用的进一步丰富,数据已呈指数级的增长,企业所处理的数据已经达到PB级,而全球每年所产生的数据量更是到了惊人的ZB级。在数据的这种爆炸式增长的背景下,“大数据”的概念逐渐在科技界、学术界、产业界引起热议。在大数据时代,我们分析的数据因为“大”,摆脱了传统对随机采样的依赖,而是面对全体数据;因为所有信息都是“数”,可以不再纠结具体数据的精确度,而是坦然面对信息的混杂;信息之“大”之“杂”,让我们分析的“据”也由传统的因果关系变为相关关系。 大数据热潮的掀起让中国期待“弯道超越”的机会,创造中国IT企业从在红海领域苦苦挣扎转向在蓝海领域奋起直追的战略机遇。传统IT行业对于底层设备、基础技术的要求非常高,企业在起点落后的情况下始终疲于追赶。每当企业在耗费大量人力、物力、财力取得技术突破时,IT革命早已将核心设备或元件推进至下一阶段。这种一步落后、处处受制于人的状态在大数据时代有望得到改变。大数据对于硬件基础设施的要求相对较低,不会受困于基础设备核心元件的相对落后。与在传统数据库操作层面的技术差距相比,大数据分析应用的中外技术差距要小得多。而且,美国等传统IT强国的大数据战略也都处于摸着石头过河的试错阶段。 中国市场的规模之大也为这一产业发展提供了大空间、大平台。大数据对于中国企业不仅仅是信息技术的更新,更是企业发展战略的变革。随着对大数据的获取、处理、管理等各个角度研究的开展,企业逐渐认识数据已经逐渐演变成“数据资产”。任何硬件、软件及服务都会随着技术发展和需求变化逐渐被淘汰,只有数据才具有长期可用性,值得积累。数据是企业的核心资产,可以是也应该是独立于软硬件系统及应用需求而存在的。大数据是信息技术演化的最新产物,确立了数据这一信息技术元素的独立地位。正因为数据不再是软硬件及应用的附属产物,才有了今天爆炸式的数据增长,从而奠定了大数据的基础。

剖析大数据分析方法论的几种理论模型 做大数据分析的三大作用,主要是:现状分析、原因分析和预测分析。什么时候开展什么样的数据分析,需要根据我们的需求和目的来确定。 作者:佚名来源:博易股份|2016-12-01 19:10 收藏 分享 做大数据分析的三大作用,主要是:现状分析、原因分析和预测分析。什么时候开展什么样的数据分析,需要根据我们的需求和目的来确定。 利用大数据分析的应用案例更加细化的说明做大数据分析方法中经常用到的几种理论模型。 以营销、管理等理论为指导,结合实际业务情况,搭建分析框架,这是进行大数据分析的首要因素。大数据分析方法论中经常用到的理论模型分为营销方面的理论模型和管理方面的理论模型。 管理方面的理论模型: ?PEST、5W2H、时间管理、生命周期、逻辑树、金字塔、SMART原则等?PEST:主要用于行业分析 ?PEST:政治(Political)、经济(Economic)、社会(Social)和技术(Technological) ?P:构成政治环境的关键指标有,政治体制、经济体制、财政政策、税收政策、产业政策、投资政策、国防开支水平政府补贴水平、民众对政治的参与度等。?E:构成经济环境的关键指标有,GDP及增长率、进出口总额及增长率、利率、汇率、通货膨胀率、消费价格指数、居民可支配收入、失业率、劳动生产率等。?S:构成社会文化环境的关键指标有:人口规模、性别比例、年龄结构、出生率、死亡率、种族结构、妇女生育率、生活方式、购买习惯、教育状况、城市特点、宗教信仰状况等因素。

?T:构成技术环境的关键指标有:新技术的发明和进展、折旧和报废速度、技术更新速度、技术传播速度、技术商品化速度、国家重点支持项目、国家投入的研发费用、专利个数、专利保护情况等因素。 大数据分析的应用案例:吉利收购沃尔沃 大数据分析应用案例 5W2H分析法 何因(Why)、何事(What)、何人(Who)、何时(When)、何地(Where)、如何做(How)、何价(How much) 网游用户的购买行为: 逻辑树:可用于业务问题专题分析

龙源期刊网 https://www.doczj.com/doc/a95770894.html, 大数据思维的真理问题研究及背景分析 作者:何伟华 来源:《教育界·上旬》2018年第12期 【摘要】大数据技术的革新与发展给传统认识论真理的探究提出了新的挑战与机遇,大数据革命过程中所蕴含的大数据思维为真理的产生提供了新的思维模式,从大数据思维的视角剖析其中的真理问题,不仅为真理问题研究的完善提供了借鉴意义,更为大数据技术提供了一个新的应用视角。 【关键词】大数据思维;真理问题研究;背景分析 一、大数据思维真理问题研究的背景 (一)大数据技术方面 大数据技术是在云计算和互联网的支持推动下形成的一种全新的数据分析技术,而大数据思维是建立在“数据化”世界观基础上的思维形式,是大数据技术应用的理论前提,它为人类社会带来了一场全新的思维方式革命。现今对大数据思维中的真理问题分析很少,需要对大数据思维中的真理问题进行全面分析和理解,一种在信息时代网络复杂条件下的认识理论拓展。 西方国家对于大数据分析方法在技术和科学层面上的研究要更早一些,以大数据技术在哲学层面上研究层次的深度为标准大致可以分为两个阶段。第一个阶段是从大数据产生到其发展成熟,大概是从1980年到2010年间,这一时期国外关于大数据分析方法的研究绝大多数仍然停留在计算机科学与互联网平台构建的层次上,或者更多的是与经济学领域中的决策优化以及社会科学领域中的预测性问题相关,而在哲学的层面上对于大数据分析方法的抽象思考鲜有人提。第二个阶段大致是从2010年至今,这一阶段随着大数据技术在社会各领域的广泛运用和巨大变革,越来越多的国外学者聚焦从哲学视角来探讨大数据技术,尤其是从科学哲学视角以及伦理学视角探讨大数据技术给社会各领域带来的影响。 戴维·柏林(D.Bollier)的《大数据的前途与危机》(The Promise and Peril of Big Data,2010)一书对于大数据分析方法基础上的科学理论构造以及大数据分析的因果性与相关性之间的关系进行了探讨,然而该书并非立足于一种系统的哲学观所进行的结构性讨论,其中所涉及的哲学思考流于表面,没有深入展开。西格尔(E.Siegel)的《预测性分析》(Predictive Analytics)一书对于大数据的决策观察、数据挖掘、预测分析与人工智能的困境等问题进行了研究,然而该书并没有深入挖掘大数据分析方法的思维本质。 总体来看,国外对大数据现象的研究主要是在非哲学层面来进行的,真理的探讨很多是涉及哲学的,但从哲学上来关注大数据思维以及其中的真理问题的有关研究几乎尚未展开,即使

1 【单选题】 以下关于大数据的特点,叙述错误的是()。答案:速度慢A、 速度慢 B、 多元、异构 C、 数据规模大

D、 基于高度分析的新价值 2 【单选题】在《法华经》中,“那由他”描写的“大”的数量级是()。答案:10^28 A、10^7 B、10^14 C、10^28 D、10^56 3 【多选题】以下选项中,大数据涉及的领域中包括()。答案:社交网络计算机艺术医疗数据 A、社交网络 B、医疗数据 C、计算机艺术 D、医疗数据

4 【多选题】大数据的应用包括()。答案:推荐科学研究预测商业情报分析 A、预测 B、推荐 C、商业情报分析 D、科学研究 5 【判断题】目前,关于大数据已有公认的确定定义。答案:× 6 【判断题】大数据种类繁多,在编码方式、数据格式、应用特征等方面都存在差异。()答案:√ 1 【单选题】 大数据求解计算问题过程的第三步一般是()。答案:算法设计与分析

A、 判断可计算否 B、 判断能行可计算否 C、 算法设计与分析 D、 用计算机语言实现算法 2 【多选题】在大数据求解计算问题中,判断是否为能行可计算的因素包括()。答案:资源约束数据量时间约束

A、数据量 B、资源约束 C、速度约束 D、时间约束 3 【判断题】大数据求解计算问题过程的第一步是确定该问题是否可计算。答案:√ 4 【判断题】大数据计算模型与一般小规模计算模型一样,都使用的是图灵机模型。答案:√ 1 【多选题】资源约束包括()。答案:网络带宽外存CPU内存 A、CPU B、网络带宽 C、内存 D、外存

2 【多选题】大数据算法可以不是()。答案:精确算法串行算法内存算法 A、云计算 B、精确算法 C、内存算法 D、串行算法 3 【判断题】大数据算法是在给定的时间约束下,以大数据为输入,在给定资源约束内可以生成满足给定约束结果的算法。答案:× 4 【判断题】MapReduce是一种比较好实现大数据算法的编程架构,在生产中得到广泛应用。答案:√ 5 【判断题】大数据算法是仅在电子计算机上运行的算法。答案:× 1

一、描述统计 描述性统计是指运用制表和分类,图形以及计筠概括性数据来描述数据的集中趋势、离散趋势、偏度、峰度。 1、缺失值填充:常用方法:剔除法、均值法、最小邻居法、比率回归法、决策树法。 2、正态性检验:很多统计方法都要求数值服从或近似服从正态分布,所以之前需要进行正态性检验。常用方法:非参数检验的K-量检验、P-P图、Q-Q图、W检验、动差法。 二、假设检验 1、参数检验 参数检验是在已知总体分布的条件下(一股要求总体服从正态分布)对一些主要的参数(如均值、百分数、方差、相关系数等)进行的检验。 1)U验使用条件:当样本含量n较大时,样本值符合正态分布 2)T检验使用条件:当样本含量n较小时,样本值符合正态分布 A 单样本t检验:推断该样本来自的总体均数μ与已知的某一总体均数μ0 (常为理论值或标准值)有无差别; B 配对样本t检验:当总体均数未知时,且两个样本可以配对,同对中的两者在可能会影响处理效果的各种条件方面扱为相似; C 两独立样本t检验:无法找到在各方面极为相似的两样本作配对比较时使用。 2、非参数检验 非参数检验则不考虑总体分布是否已知,常常也不是针对总体参数,而是针对总体的某些一股性假设(如总体分布的位罝是否相同,总体分布是否正态)进行检验。 适用情况:顺序类型的数据资料,这类数据的分布形态一般是未知的。

A 虽然是连续数据,但总体分布形态未知或者非正态; B 体分布虽然正态,数据也是连续类型,但样本容量极小,如10以下; 主要方法包括:卡方检验、秩和检验、二项检验、游程检验、K-量检验等。 三、信度分析 检査测量的可信度,例如调查问卷的真实性。 分类: 1、外在信度:不同时间测量时量表的一致性程度,常用方法重测信度 2、内在信度;每个量表是否测量到单一的概念,同时组成两表的内在体项一致性如 何,常用方法分半信度。 四、列联表分析 用于分析离散变量或定型变量之间是否存在相关。 对于二维表,可进行卡方检验,对于三维表,可作Mentel-Hanszel分层分析。列联表分析还包括配对计数资料的卡方检验、行列均为顺序变量的相关检验。 五、相关分析 研究现象之间是否存在某种依存关系,对具体有依存关系的现象探讨相关方向及相关程度。 1、单相关:两个因素之间的相关关系叫单相关,即研究时只涉及一个自变量和一个因变量; 2、复相关:三个或三个以上因素的相关关系叫复相关,即研究时涉及两个或两个以上的自变量和因变量相关; 3、偏相关:在某一现象与多种现象相关的场合,当假定其他变量不变时,其中两个变量之间的相关关系称为偏相关。 六、方差分析

一、云计算与大数据的定义、特征 1、云计算的定义:是一种商业计算模型。它将计算任务分布在大量计算机构成的资源池上,使各种应用系统能够根据需要获取计算力、存储空间和信息服务。(维基百科)一种基于互联网的计算方式,通过这种方式,共享软硬件资源和信息,可以按需提供给计算机和其他设备。云计算能够给用户提供可靠的、自定义的、最大化资源利用的服务,是一种崭新的分布式计算模式。 云计算的类型可以分为基础设施即服务(Iaas)、平台即服务(Pass)、软件即服务(Saas)。 2、云计算的特征:超大规模、虚拟化、高可靠性、高可伸缩性、按需服务、极其廉价。 (1)服务资源池化:通过虚拟化技术,对存储、计算、内存、网络等资源化,按用户需求动态地分配。 (2)可扩展性:用户随时随地可以根据实际需要,快速弹性地请求和购买服务资源,扩展处理能力。 (3)宽带网络调用:用户使用各种客户端软件,通过网络调用云计算资源。 (4)可度量性:服务资源的使用可以被监控、报告给用户和服务商,并可以根据具体使用类型收取费用。 (5)可靠性:自动检测失效节点,通过数据的冗余能够继续正常工作,提供高质量的服务,达到服务等级协议要求。 3、大数据的定义:(维基百科)指利用常用软件工具捕获、管理和处理数据所耗时间超过科容忍时间的数据集,即大数据泛指大规模、超大规模的数据集,因可从中挖掘出有价值的信息而备受关注。 4、大数据的特征(5V特征): (1)数据体量(Volume)巨大,指收集和分析的数据量非常大,从TB级别跃升至PB 级别; (2)处理速度(Velocity)快,需要对数据进行近实时的分析; (3)数据类别(Variety)大,大数据来自多种数据源,数据种类和格式日渐丰富,包括结构化、半结构化和非结构化等多种数据形式; (4)数据真实性(Veracity),大数据中的内容是与真实世界中的发生息息相关的,研究大数据就是从庞大的网络数据中提取能够解释和预测现实事件的过程。 (5)价值密度低,商业价值(Value)高,通过分析数据可以得出如何抓住机遇及收获价值。 二、云计算安全,可信云以及用户对云计算信任的预期? 由于云服务的“外包”特性,用户对云提供商是否能够对其数据安全提供保障,对其应用程序是否按照约定的方式安全执行产生了怀疑,亦即云服务的可信性问题。云服务的可信问题不仅指服务计算环境受其开放、共享等特点而导致服务结果可能受云服务提供商的主观意志等因素导致的不可信。 用户对云服务的安全怀疑主要集中在客观与主观两个方面:客观来说,云计算的集中服务模式使其更容易成为安全攻击的目标,而云计算技术的大规模分布式处理也大大增加了安全管理的难度,因此服务商是否具有足够的安全管理能力来保证用户信息安全值得怀疑;主观方面,由于云计算模式下,用户信息的存储、管理以及应用处理都在云服务方完成,用户丧失控制权,此时如何保证服务方忠实履行自己的服务协议,保证服务质量,并且不会通过自己的特权来违规使用用户资源获利成为必须要解决的问题。 如果云服务的行为和结果总是与用户预期的行为和结果一致,那么就可以说云服务是可信的。要讨论云服务的可信性,需要明确3个方面的问题: 1)用户的界定。不同用户拥有的信息安全敏感度不同,对于云安全性认定也不同。

大数据发展背景与研究现状 (一)大数据时代的背景 随着计算机存储能力的提升和复杂算法的发展,近年来的数据量成指数型增长,这些趋势使科学技术发展也日新月异,商业模式发生了颠覆式变化。《分析的时代:在大数据的世界竞争》是____年12月xx全球研究院(MGI)发表的一份报告。五年前MGI就指出大数据分析在基于定位的服务、xx零售业、制造业、欧盟公共部门及xx健康医疗领域有很大的增长潜力。数据正在被商业化,来自网络、智能手机、传感器、相机、支付系统以及其他途径的数据形成了一项资产,产生了巨大的商业价值。苹果、亚马逊、Facebook、xx、通用微软以及阿里巴巴集团利用大数据分析及自己的优势改变了竞争的基础,建立了全新的商业模式。稀缺数据的所有者利用数字化网络平台在一些市场近乎垄断,只需用独特方式将数据整合分析,提供有价值的数据分析,几乎可以“赢家通吃”。____年全球的数据储量就达到1.8ZB,与____年相比____年大数据增长了近4倍,未来十年,全球数据存储量还将增长十倍,大数据成为提升产业竞争力和创新商业模式的新途径。大数据在企业中得到了充分的应用并实现了巨大的商业价值。xx百货的SAS系统可以根据7300种货品的需求和库存实现实时定价。零售业寡头摩尔xx通过最新的搜索引擎Polaris,利用语义数据技术使得在线购物的完成率提升了10%到15%。我国信息数据资源80%以上掌握在各级政府部门手里,但很多数据却与世隔绝“xx闺中”,成为极大的浪费。____年,国务院印发《促进大数据发展行动纲要》,明确要求“____年底前建成国家政府数据统一开放平台”;今年5月,国务院办公厅又印发《政务信息系统整合共享实施方案》,进一步推动政府数据向社会开放。 大数据可以把人们从旧的价值观和发展观中解放出来,从全新的视角和角度理解世界的科技进步和复杂技术的涌现,变革人们关于工作、生活和思维的看法。大数据的应用十分广泛,通过对大规模数据的分析,利用数据整体性与涌现性、相关性与不确定性、多样性与非线性及并行性与实时性研究大数据在公共交通、公共安全、社会管理等领域的应用。大数据与xx计算、物联网一起使得很多事情成为可能,将会是新的经济增长点。大数据随着以数据科学为核心的计算机技术的迅猛发展,推动了社会科学与自然科学等跨科学研究的发展。因此对xx乃至全国的大数据研究具有深刻而广泛的意义。

常用数据分析方法 常用数据分析方法:聚类分析、因子分析、相关分析、对应分析、回归分析、方差分析;问卷调查常用数据分析方法:描述性统计分析、探索性因素分析、Cronbach’a信度系数分析、结构方程模型分析(structural equations modeling) 。 数据分析常用的图表方法:柏拉图(排列图)、直方图(Histogram)、散点图(scatter diagram)、鱼骨图(Ishikawa)、FMEA、点图、柱状图、雷达图、趋势图。 数据分析统计工具:SPSS、minitab、JMP。 常用数据分析方法: 1、聚类分析(Cluster Analysis) 聚类分析指将物理或抽象对象的集合分组成为由类似的对象组成的多个类的分析过程。聚类是将数据分类到不同的类或者簇这样的一个过程,所以同一个簇中的对象有很大的相似性,而不同簇间的对象有很大的相异性。聚类分析是一种探索性的分析,在分类的过程中,人们不必事先给出一个分类的标准,聚类分析能够从样本数据出发,自动进行分类。聚类分析所使用方法的不同,常常会得到不同的结论。不同研究者对于同一组数据进行聚类分析,所得到的聚类数未必一致。 2、因子分析(Factor Analysis) 因子分析是指研究从变量群中提取共性因子的统计技术。因子分析就是从大量的数据中寻找内在的联系,减少决策的困难。 因子分析的方法约有10多种,如重心法、影像分析法,最大似然解、最小平方法、阿尔发抽因法、拉奥典型抽因法等等。这些方法本质上大都属近似方法,是以相关系数矩阵为基础的,所不同的是相关系数矩阵对角线上的值,采用不同的共同性□2估值。在社会学研究中,因子分析常采用以主成分分析为基础的反覆法。 3、相关分析(Correlation Analysis) 相关分析(correlation analysis),相关分析是研究现象之间是否存在某种依存关系,并对具体有依存关系的现象探讨其相关方向以及相关程度。相关关系是一种非确定性的关系,例如,以X和Y分别记一个人的身高和体重,或分别记每公顷施肥量与每公顷小麦产量,则X 与Y显然有关系,而又没有确切到可由其中的一个去精确地决定另一个的程度,这就是相关关系。 4、对应分析(Correspondence Analysis) 对应分析(Correspondence analysis)也称关联分析、R-Q型因子分析,通过分析由定性变量构成的交互汇总表来揭示变量间的联系。可以揭示同一变量的各个类别之间的差异,以及不同变量各个类别之间的对应关系。对应分析的基本思想是将一个联列表的行和列中各元素的比例结构以点的形式在较低维的空间中表示出来。 5、回归分析 研究一个随机变量Y对另一个(X)或一组(X1,X2,…,Xk)变量的相依关系的统计分析方法。回归分析(regression analysis)是确定两种或两种以上变数间相互依赖的定量关系的一种统计分析方法。运用十分广泛,回归分析按照涉及的自变量的多少,可分为一元回归分析和多元回归分析;按照自变量和因变量之间的关系类型,可分为线性回归分析和非线性回归分析。 6、方差分析(ANOVA/Analysis of Variance) 又称“变异数分析”或“F检验”,是R.A.Fisher发明的,用于两个及两个以上样本均数差

大数据建模和算法特征 Coca-cola standardization office【ZZ5AB-ZZSYT-ZZ2C-ZZ682T-ZZT18】

零售银行为了给客户提供更加优质的服务,需要通过分析银行系统本身数据库所保留的客户资料信息,对客户进行分类管理。 近年来,大数据已成为科技界和企业界关注的热点,越来越多的企业和研究者正在关注大数据的应用。大数据的分析与挖掘技术在科学界正在如火如荼的展开,各种大数据的新算法被开发研究出来,例如近年来发展比较完善的一种数据分析挖掘算法支持向量机。 与此同时,大数据分析在商业中的运用受到人们的追捧,各种大数据在商业中成功运用的案例层出不穷,比如美国大型零售商target公司的广告精准推送。本文将对大数据分析技术以及大数据分析技术在零售银行行业的作用进行一番探讨。 什么是大数据 2011年,麦肯锡在题为《海量数据,创新、竞争和提高生成率的下一个新领域》的研究报告中首次提出大数据的概念。报告认为数据已经渗透到每一个行业和业务职能领域,数据中蕴含着巨大的价值,这些价值将导致数据成为重要的生产因素。2012年《纽约时报》的一篇专栏中写到,“大数据”时代已经降临,在商业、经济及其他领域中,最终决策将日益基于数据和分析而作出,而并非基于经验和直觉。2012年3月,美国奥巴马政府宣布投资2亿美元启动“大数据研究和发展计划”,这是继1993年美国宣布“信息高速公路”计划后的又一次重大科技发展部署。美国政府认为大数据是“未来的新石油”,将“大数据研究”上升为国家意志,对未来的科技与经济发展必将带来深远影响。 进入21世纪,互联网的兴起促成了数据量的大规模增长。互联网时代,几乎全民都在制造数据,与此同时,数据的形成也极其丰富。一方面,既有社交网络、多媒体、协同创造、虚拟服务等应用所主动产生的数据;另一方面,又有搜索引擎、网页浏览过程中被记录、被收集的数据。该阶段数据的特点是用户原创、主动、交互。 根据国际数据公司(IDC)的研究报告,2011年全球被创建和被复制的数据总量为(数据存储单位,泽字节,等于 1024艾字节或270个字节),且增长趋势遵循新摩尔定律,预计到2020年,全球数据量大约每两年翻一番,全球将拥有35ZB的数据量。正是由于信息技术的发展,大数据才能生成和发展。大数据技术正是从海量的、多样化的数据中,快速获得有价值信息的能力。 大数据指的是所涉及的数据量规模巨大到无法通过人工,在合理时间内达到截取、管理、处理、整理成为人类所能解读的信息。在维克托迈尔-舍恩伯格及肯尼斯库克耶编写

方法、数据处理流程实战案例时代,我们人人都逐渐开始用数据的眼光来看待每一个事情、事物。确实,数据的直观明了传达出来的信息让人一下子就能领略且毫无疑点,不过前提是数据本身的真实性和准确度要有保证。今天就来和大家分享一下关于方法、数据处理流程的实战案例,让大家对于这个岗位的工作内容有更多的理解和认识,让可以趁机了解了解咱们平时看似轻松便捷的数据可视化的背后都是有多专业的流程在支撑着。 一、大数据思维 在2011年、2012年大数据概念火了之后,可以说这几年许多传统企业也好,互联网企业也好,都把自己的业务给大数据靠一靠,并且提的比较多的大数据思维。 那么大数据思维是怎么回事?我们来看两个例子: 案例1:输入法 首先,我们来看一下输入法的例子。 我2001年上大学,那时用的输入法比较多的是智能ABC,还有微软拼音,还有五笔。那时候的输入法比现在来说要慢的很多,许多时候输一个词都要选好几次,去选词还是调整才能把这个字打出来,效率是非常低的。 到了2002年,2003年出了一种新的输出法——紫光拼音,感觉真的很快,键盘没有按下去字就已经跳出来了。但是,后来很快发现紫光拼音输入法也有它的问题,比如当时互联网发展已经比较快了,会经常出现一些新的词汇,这些词汇在它的词库里没有的话,就很难敲出来这个词。

在2006年左右,搜狗输入法出现了。搜狗输入法基于搜狗本身是一个搜索,它积累了一些用户输入的检索词这些数据,用户用输入法时候产生的这些词的信息,将它们进行统计分析,把一些新的词汇逐步添加到词库里去,通过云的方式进行管理。 比如,去年流行一个词叫“然并卵”,这样的一个词如果用传统的方式,因为它是一个重新构造的词,在输入法是没办法通过拼音“ran bing luan”直接把它找出来的。然而,在大数据思维下那就不一样了,换句话说,我们先不知道有这么一个词汇,但是我们发现有许多人在输入了这个词汇,于是,我们可以通过统计发现最近新出现的一个高频词汇,把它加到司库里面并更新给所有人,大家在使用的时候可以直接找到这个词了。 案例2:地图 再来看一个地图的案例,在这种电脑地图、手机地图出现之前,我们都是用纸质的地图。这种地图差不多就是一年要换一版,因为许多地址可能变了,并且在纸质地图上肯定是看不出来,从一个地方到另外一个地方怎么走是最好的?中间是不是堵车?这些都是有需要有经验的各种司机才能判断出来。 在有了百度地图这样的产品就要好很多,比如:它能告诉你这条路当前是不是堵的?或者说能告诉你半个小时之后它是不是堵的?它是不是可以预测路况情况? 此外,你去一个地方它可以给你规划另一条路线,这些就是因为它采集到许多数据。比如:大家在用百度地图的时候,有GPS地位信息,基于你这个位置的移动信息,就可以知道路的拥堵情况。另外,他可以收集到很多

大数据时代背景下分析计算机信息技术 摘要:计算机信息技术的飞速发展,逐步实现了数 据信息的大量、高效交换,打破了原本在时间上和空间上的限制,进一步拉近了人与人之间的距离。而伴随着大数据时代的到来,计算机信息技术也面临着机遇与挑战并存的新局面。本文结合大数据时代的相关内涵和特点,对计算机信息技术的现状及前景进行了分析。 关键词:大数据时代;计算机信息技术;现状;前景 大数据也称巨量数据,指数据量极其巨大,无法通过现有的主流数据处理软件,在合理时间内进行采集、管理、处理的资讯。大数据可以说是科技发展的产物,是继移动计算、物联网、云计算等信息技术之后的又一个新兴事物,是在信息技术快速发展的基础上产生和发展起来的。在这种情况下,如何对计算机信息技术进行创新,确保其能够进一步推动社会的发展,是需要人们重点研究的课题。 一、大数据的内涵和特点 简单来讲,大数据就是指大量的数据,其中所蕴含的信息无法利用现有的计算机硬件设备和软件系统进行处理,也就无法为客户提供全面准确的数据服务。通常来讲,当数据容量在10TB-1PB之间时,就可以称之为“大数据”。

与一般的数据信息相比,大数据具有几个非常显著的特点:一是信息容量极其庞大,在大数据时代背景下,计算机的信息容量能够达到1ZP(约为1.0×1012GB)的数量级, 相当于传统1TB(约为1.0×103GB)的数量级要远远超出;二是信息处理效率极高,大数据时代许多的信息流都是能够进行实时计算存储的,而且依托于网络可以实现高速传输,而在这种情况下,为了适应信息流实时高速传输的显示需求,需要开发更加专业的大数据处理工具;三是信息结构的多样化,大数据时代中数据信息的构成并非单一的文本信息,还包括了音频、视频、图像等多样化的内容,在为人们提供更加高效的数据服务的同时,也在一定程度上增大了信息处理的难度。 二、大数据时代计算机信息技术的发展现状 大数据时代的到来,推动了社会的变革,也为人们开创了一种全新的生活模式。而在大数据时代背景下,计算机信息技术面临着机遇与挑战并存的局面,需要相关技术人员的深入研究,以确保计算机信息技术的发展能够紧跟时代发展潮流,满足大数据时代的信息处理需求。 1.机遇 大数据时代的开幕预示着计算机网络的普及,从目前来看,计算机网络已经基本实现了全球互联,开放式的数据共享平台加快了信息的流通速度,也使得“大数据模式”在各

政府采购 招标文件 采购编号: NBZFCGG 项目名称:宁波智慧教育统一资源与数据中心运维项目 宁波市政府采购中心 二〇一八年七月

目录 第一部分投标邀请(招标公告) 第二部分项目需求说明及评标标准第三部分投标人须知前附表 第四部分投标人须知 第五部分合同格式 第六部分投标文件格式 第七部分其他文件格式

第一部分投标邀请(招标公告) 宁波市政府采购中心就“宁波智慧教育统一资源与数据中心运维项目”进行公开招标采购,现邀请合格供应商参加投标。 一、采购编号:NBZFCGG 二、采购需求: 宁波智慧教育统一资源与数据中心运维,详见需求说明。 三、采购预算(最高限价):.万元 四、供应商资格要求:、符合《政府采购法》第条的规定,且未列入“信用中国https://www.doczj.com/doc/a95770894.html,”网站失信被执行人、重大税收违法案件当事人名单、政府采购严重违法失信记录名单在禁止参加采购期限的供应商; 、本项目特定资格条件:不接受联合体投标。 五、标书发售日期:自公告发布之日起至年月日止(节假日及法定假日除外)。 六、标书售价、地点及方式:符合上述资格条件的供应商请到https://www.doczj.com/doc/a95770894.html,“采购公告”栏目下载电子招标文件。 七、投标截止时间:年月日:。 八、投标地点:宁波市鄞州区宁穿路号市行政服务中心四楼开标区(具体场所安排详见电子指示屏幕)。 九、开标时间:年月日:。 十、开标地点:宁波市鄞州区宁穿路号市行政服务中心四楼开标区(具体场所安排详见电子指示屏幕)。 十一、公告期限:自公告之日起个工作日。 十二、其他事项:符合资格条件的供应商请在宁波政府采购网(https://www.doczj.com/doc/a95770894.html,)上完成供应商注册工作,并于投标截止时间天前完成网上投标报名。 采购机构:宁波市政府采购中心 联系人:张先生TEL:- FAX: 地址:宁波市鄞州区宁穿路号市行政服务中心五楼邮编: 采购人:宁波市学校装备管理与电化教育中心/王老师/

第7 章空间数据分析模型 7.1 空间数据 按照空间数据的维数划分,空间数据有四种基本类型:点数据、线数据、面数据和体数据。 点是零维的。从理论上讲,点数据可以是以单独地物目标的抽象表达,也可以是地理单元的抽象表达。这类点数据种类很多,如水深点、高程点、道路交叉点、一座城市、一个区域。 线数据是一维的。某些地物可能具有一定宽度,例如道路或河流,但其路线和相对长度是主要特征,也可以把它抽象为线。其他的 线数据,有不可见的行政区划界,水陆分界的岸线,或物质运输或思想传播的路线等。 面数据是二维的,指的是某种类型的地理实体或现象的区域范围。国家、气候类型和植被特征等,均属于面数据之列。 真实的地物通常是三维的,体数据更能表现出地理实体的特征。一般而言,体数据被想象为从某一基准展开的向上下延伸的数,如 相对于海水面的陆地或水域。在理论上,体数据可以是相当抽象的,如地理上的密度系指单位面积上某种现象的许多单元分布。 在实际工作中常常根据研究的需要,将同一数据置于不同类别中。例如,北京市可以看作一个点(区别于天津),或者看作一个面 (特殊行政区,区别于相邻地区),或者看作包括了人口的“体”。 7.2 空间数据分析 空间数据分析涉及到空间数据的各个方面,与此有关的内容至少包括四个领域。 1)空间数据处理。空间数据处理的概念常出现在地理信息系统中,通常指的是空间分析。就涉及的内容而言,空间数据处理更多的偏重于空间位置及其关系的分析和管理。 2)空间数据分析。空间数据分析是描述性和探索性的,通过对大量的复杂数据的处理来实现。在各种空间分析中,空间数据分析是 重要的组成部分。空间数据分析更多的偏重于具有空间信息的属性数据的分析。 3)空间统计分析。使用统计方法解释空间数据,分析数据在统计上是否是“典型”的,或“期望”的。与统计学类似,空间统计分析与空间数据分析的内容往往是交叉的。 4)空间模型。空间模型涉及到模型构建和空间预测。在人文地理中,模型用来预测不同地方的人流和物流,以便进行区位的优化。在自然地理学中,模型可能是模拟自然过程的空间分异与随时间的变化过程。空间数据分析和空间统计分析是建立空间模型的基础。 7.3 空间数据分析的一些基本问题 空间数据不仅有其空间的定位特性,而且具有空间关系的连接属性。这些属性主要表现为空间自相关特点和与之相伴随的可变区域 单位问题、尺度和边界效应。传统的统计学方法在对数据进行处理时有一些基本的假设,大多都要求“样本是随机的”,但空间数据可能不一定能满足有关假设,因此,空间数据的分析就有其特殊性(David,2003 )。

1.1 1 【单选题】 以下关于大数据的特点,叙述错误的是()。答案:速度慢?A、 速度慢 ?B、 多元、异构 ?C、 数据规模大

?D、 基于高度分析的新价值 2 【单选题】在《法华经》中,“那由他”描写的“大”的数量级是()。答案:10^28 ?A、10^7 ?B、10^14 ?C、10^28 ?D、10^56 3 【多选题】以下选项中,大数据涉及的领域中包括()。答案:社交网络计算机艺术医疗数据 ?A、社交网络 ?B、医疗数据 ?C、计算机艺术

?D、医疗数据 4 【多选题】大数据的应用包括()。答案:推荐科学研究预测商业情报分析 ?A、预测 ?B、推荐 ?C、商业情报分析 ?D、科学研究 5 【判断题】目前,关于大数据已有公认的确定定义。答案:× 6 【判断题】大数据种类繁多,在编码方式、数据格式、应用特征等方面都存在差异。()答案:√ 1.2 1 【单选题】

大数据求解计算问题过程的第三步一般是()。答案:算法设计与分析?A、 判断可计算否 ?B、 判断能行可计算否 ?C、 算法设计与分析 ?D、 用计算机语言实现算法 2

【多选题】在大数据求解计算问题中,判断是否为能行可计算的因素包括()。答案:资源约束数据量时间约束 ?A、数据量 ?B、资源约束 ?C、速度约束 ?D、时间约束 3 【判断题】大数据求解计算问题过程的第一步是确定该问题是否可计算。答案:√ 4 【判断题】大数据计算模型与一般小规模计算模型一样,都使用的是图灵机模型。答案:√ 1.3 1 【多选题】资源约束包括()。答案:网络带宽外存CPU内存 ?A、CPU ?B、网络带宽

数据分析方法汇总 一、描述统计 描述性统计是指运用制表和分类,图形以及计筠概括性数据来描述数据的集中趋势、离散趋势、偏度、峰度。 1、缺失值填充:常用方法:剔除法、均值法、最小邻居法、比率\回归法、决策树法。 2、正态性检验:很多统计方法都要求数值服从或近似服从正态分布,所以之前需要进行正态性检验。常用方法:非参数检验的K-量检验、P-P 图、Q-Q图、W检验、动差法。 二、假设检验 1、参数检验 参数检验是在已知总体分布的条件下(一股要求总体服从正态分布)对一些主要的参数(如均值、百分数、方差、相关系数等)进行的检验。1)U验使用条件:当样本含量n较大时,样本值符合正态分布 2)T检验使用条件:当样本含量n较小时,样本值符合正态分布 A单样本t检验:推断该样本来自的总体均数μ与已知的某一总体均数μ0 (常为理论值或标准值)有无差别; B 配对样本t检验:当总体均数未知时,且两个样本可以配对,同对中的两者在可能会影响处理效果的各种条件方面扱为相似; C 两独立样本t检验:无法找到在各方面极为相似的两样本作配对比较时使用。 2、非参数检验

非参数检验则不考虑总体分布是否已知,常常也不是针对总体参数,而是针对总体的某些一股性假设(如总体分布的位罝是否相同,总体分布是否正态)进行检验。 适用情况:顺序类型的数据资料,这类数据的分布形态一般是未知的。 A 虽然是连续数据,但总体分布形态未知或者非正态; B 体分布虽然正态,数据也是连续类型,但样本容量极小,如10以下;主要方法包括:卡方检验、秩和检验、二项检验、游程检验、K-量检验等。 三、信度分析 检査测量的可信度,例如调查问卷的真实性。 分类: 1、外在信度:不同时间测量时量表的一致性程度,常用方法重测信度 2、内在信度;每个量表是否测量到单一的概念,同时组成两表的内在体项一致性如何,常用方法分半信度。 四、列联表分析 用于分析离散变量或定型变量之间是否存在相关。 对于二维表,可进行卡方检验,对于三维表,可作Mentel-Hanszel分层分析。 列联表分析还包括配对计数资料的卡方检验、行列均为顺序变量的相关检验。 五、相关分析

考试模拟样题—数据分析算法与模型 一.计算题 (共4题,100.0分) 1.下面是7个地区2000年的人均国内生产总值(GDP)和人均消费水平的统计数据: 一元线性回归.xlsx 一元线性回归预测.xlsx 要求:(1)绘制散点图,并计算相关系数,说明二者之间的关系; (2)人均GDP作自变量,人均消费水平作因变量,利用最小二乘法求出估计的回归方程,并解释回归系数的实际意义; (3)计算判定系数,并解释其意义; (4)检验回归方程线性关系的显著性(a=0.05); (5)如果某地区的人均GDP为5000元,预测其人均消费水平; (6)求人均GDP为5000元时,人均消费水平95%的置信区间和预测区间。(所有结果均保留三位小数) 正确答案: (1)以人均GDP为x,人均消费水平为y绘制散点图,如下:

用相关系数矩阵分析可求得相关系数为0.9981。从图和相关系数都可以看出人均消费水平和人均国内生产总值(GDP)有比较强的正相关关系。 (2)以人均GDP作自变量,人均消费水平作因变量,做线性回归分析,得到回归方程如下: y = 0.3087x + 734.6928 回归系数0.3087表示人均GDP每增加一个单位,人均消费水平大致增加0.3087个单位,人均GDP对人均消费水平的影响是正向的,人均GDP越高人均消费水平也越高。 (3)判定系数R方为0.9963,说明模型拟合效果很好。 (4)T检验和F检验的P值都小于0.05,线性关系显著。 (5)做预测分析可得,如果某地区的人均GDP为5000元,则其人均消费水平为2278.1066元。 (6)人均GDP为5000元时,由预测分析的结果可知,人均消费水平95%的置信区间为[1990.7491,2565.4640],预测区间为 [1580.4632,2975.7500]。 2.根据以下给出的数据进行分析,本次给出鸢尾花数据,其中包含萼片长、萼片宽、花瓣长、花瓣宽、以及花的类型数据,请根据以下问题进行回答。(本

大数据风控建模标准流程 一、风控建模标准过程 (一)数据采集汇总 1、以客户为维度组织搜集(人口属性、交易信息、交易渠道、风险评估、产品偏好、经营信息) 2、评估数据真实性和质量,数据质量好的变量进入后续步骤 (二)模型设计 1、时间窗和好坏客户定义 时间窗:根据获取数据的覆盖周期,将数据分为用来建模的观察期数据,和后面用来验证表现的表现期数据; 好坏客户定义:分析客户滚动和迁移率,来定义什么程度逾期的为“坏客户”,例如定义M3为坏客户就是定义逾期3个月的才是坏客户; 2、样本集切分和不平衡样本处理

样本集切分:切分为训练集和测试集,一般7/3或8/2比例; 不平衡样本:最理想样本为好坏各50%,实际拿到的样本一般坏客户占比过低,采取过采样或欠采样方法来调节坏样本浓度。 3、模型选择 评分卡模型以逻辑回归为主。 (三)数据预处理及变量特征分析 1、变量异常值、缺失值处理:使用均值、众数等来平滑异常值,来填补缺失,缺失率过高的变量直接丢弃; 2、变量描述性统计:看各个变量的集中或离散程度,看变量的分布是否对样本好坏有线性单调的相关性趋势; (四)变量筛选 1、变量分箱:变量取值归入有限个分组中,一般5个左右的分箱数量,来参加后面的算法模型计算。分箱的原则是使得各箱内部

尽量内聚,即合并为一箱的各组坏样本率接近;使得相邻分箱的坏样本率呈现单调趋势。从方法上一版采取先机器分箱,后人工微调。 2、定量计算变量对于识别坏样本的贡献度(WOE和IV) (1)WOE是统计一个变量的各分箱区间之间的好占总好比值坏占总坏之比,不同分箱之间差异明显且比例成单调趋势,说明分箱的区分度好; (2)IV是在WOE基础上进一步加权计算这个变量整体上对于区分好坏样本的识别度,也就是变量影响因子。数越大说明用这个变量进行区分的效果越好,但IV值过大容易引起模型过拟合,即模型过于依赖单一变量,造成使用过程中平衡性健壮性不好; 3、计算变量之间的相关性或多重共线性,相关性高于0.5甚至0.7的两个变量里,就要舍弃一个,留下iv值较高的那个。例如“近一个月查询次数”、“近三个月查询次数”、“近六个月查询次数”这三个变量显然明显互相相关度高,只保留其中一个变量进入模型即可。 (五)变量入模计算