实验报告

实验题目:MATLAB中神经网络工具箱的使用

课程名称:智能控制概论

任课教师:xx

姓名:xxx 学号:xxxxxxxxxx 班级:自动化11-3班

一、实验目的

能够使用MATLAB中神经网络工具箱工具箱进行控制系统仿真

二、相关知识

神经元网络是机器学习学科中的一个重要部分,用来分级或者回归。思维学普遍认为,人类大脑的思维分为抽象(逻辑)思维、形象(直观)思维和灵感(顿悟)思维三种基本方式。

逻辑性的思维是指根据逻辑规则进行推理的过程;它先将信息化成概念,并用符号表示,然后,根据符号运算按串行模式进行逻辑推理;这一过程可以写成串行的指令,让计算机执行。然而,直观性的思维是将分布式存储的信息综合起来,结果是忽然间产生想法或解决问题的办法。这种思维方式的根本之点在于以下两点:1.信息是通过神经元上的兴奋模式分布存储在网络上;2.信息处理是通过神经元之间同时相互作用的动态过程来完成的。

人工神经网络就是模拟人思维的第二种方式。这是一个非线性动力学系统,其特色在于信息的分布式存储和并行协同处理。虽然单个神经元的结构极其简单,功能有限,但大量神经元构成的网络系统所能实现的行为是极其丰富多彩的。

三、实验软件

MATLAB 7

四、实验步骤

1神经网络的创建与训练

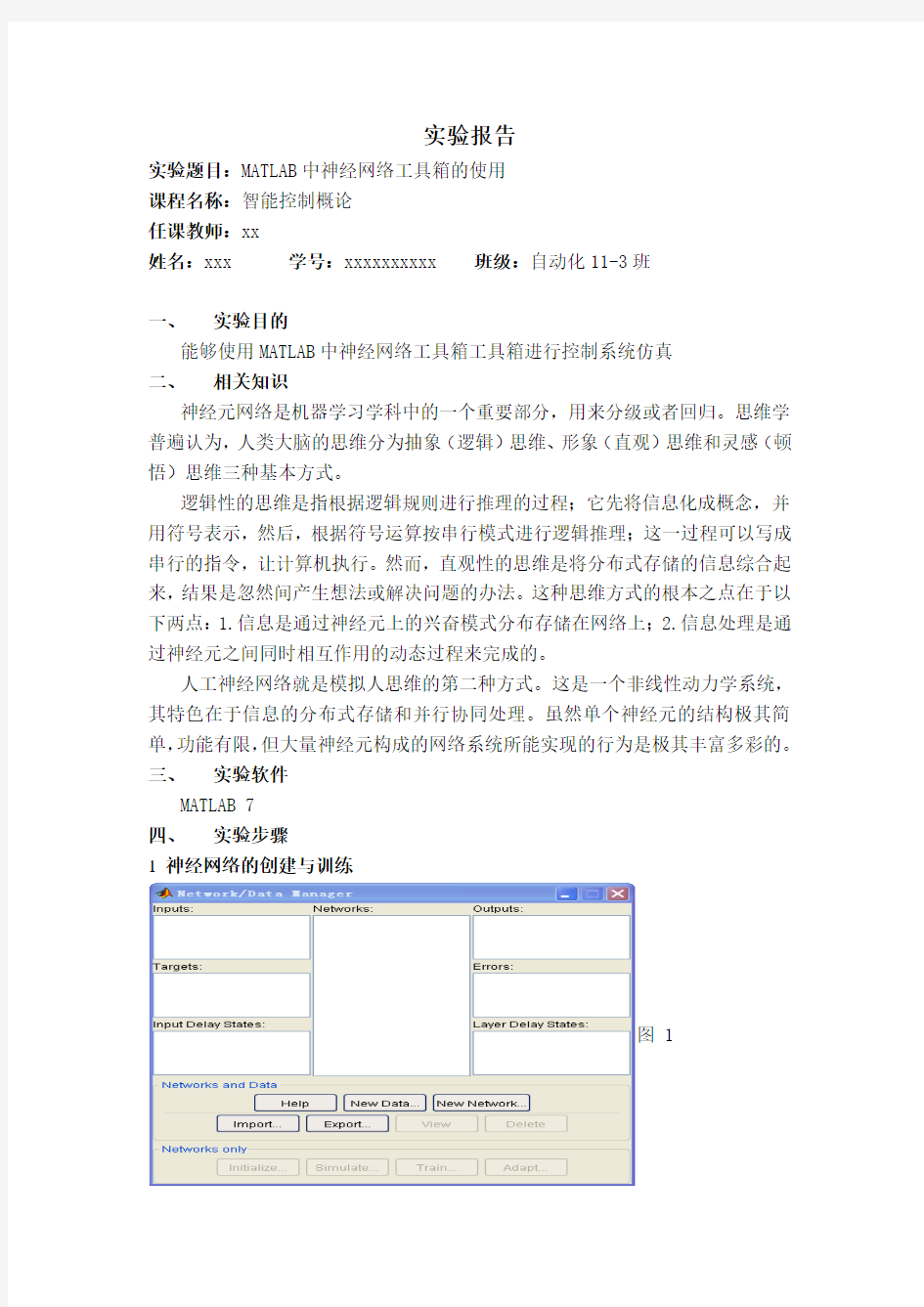

图 1

神经网络的创建主要分为以下四步:

1)在命令窗口键入nntool命令打开神经网络工具箱。如图1:

2)点击Import按钮两次,分别把输入向量和目标输出加入到对应的窗口([Inputs]和[Targets])中,有两种可供选择的加入对象(点击Import后可以看见),一种是把当前工作区中的某个矩阵加入,另一种是通过.mat文件读入。如图2和图3:

图 2

图 3

3)点击[New Network]按钮,填入各参数:(以最常用的带一个隐层的3层神经网络为例说明,下面没有列出的参数表示使用默认值就可以了,例如Network Type 为默认的BP神经网络);

i)Input Range——这个通过点击Get From Input下拉框选择你加入的输入向量便可自动完成,当然也可以自己手动添加。

ii) Training Function——最好使用TRAINSCG,即共轭梯度法,其好处是当训练不收敛时,它会自动停止训练,而且耗时较其他算法(TRAINLM,TRAINGD)

少,也就是收敛很快(如果收敛的话),而且Train Parameters输入不多,也不用太多的技巧调整,一般指定迭代次数、结果显示频率和目标误差就可以了(详见下文)。

iii) Layer 1 Number of Neurons——隐层的神经元个数,这是需要经验慢慢尝试并调整的,大致上由输入向量的维数、样本的数量和输出层(Layer2)的神经元个数决定。一般来说,神经元越多,输出的数值与目标值越接近,但所花费的训练时间也越长,反之,神经元越少,输出值与目标值相差越大,但训练时间会相应地减少,这是由于神经元越多其算法越复杂造成的,所以需要自己慢慢尝试,找到一个合适的中间点。比如输入是3行5000列的0-9的随机整数矩阵,在一开始选择1000个神经元,虽然精度比较高,但是花费的训练时间较长,而且这样神经网络的结构与算法都非常复杂,不容易在实际应用中实现,尝试改为100个,再调整为50个,如果发现在50个以下时精度较差,则可最后定为50个神经元,等等。

iv)Layer 1 Transfer Function——一般用TANSIG(当然也可以LOGSIG),即表示隐层输出是[-1,1]之间的实数,与LOGSIG相比范围更大。

v) Layer 2 Number of Neurons——输出层的神经元个数,需要与输出的矩阵行数对应,比如设置为3,等等。

vi) Layer 2 Transfer Function——如果是模式识别的两类(或者多类)问题,一般用LOGSIG,即表示输出层的输出是[0,1]之间的实数;如果输出超过[0,1]则可选择PURELIN。如图4和图5。

图 4

图 5

所有参数输入后,可以先用View按钮预览一下,如图6。没有问题的话就可以Create了。另外,网络创建完毕后,如果需要手动设置权重的初始值,按View 按钮后有个Initialize选项卡,在那里可以设定。当然了,也可以不自行设定,这时候Matlab执行默认的程序进行权重的初始化(没有具体研究过,可能是随机设定)。

图 6

4)点击Train按钮,到达Training Info选项卡,在输入向量[Inputs]和目标输入向量[Targets]下拉框中选择你要训练的向量(即第二步加入的对象),如图7。然后到达Train Parameters选项卡,填入适当的迭代次数[epochs](一般先设置一个较小的数如200,然后观察收敛结果,如果结果窗口的收敛曲线衰减较快,

则表示之前的参数比较有效,因此可填入2000或更大的数目使得网络收敛,否则修改之前的参数)、结果显示频率[show](例如要每隔50次迭代显示结果窗口,则填50)和目标误差[goal](这个与第2步中的“Performance Function”有关,如果使用默认的MSE,则一般满足“goal*样本数量<0.5”就可以了),就可以开始训练了(按钮[Train Network]),如果结果收敛(训练误差不大于目标误差,即蓝色线到达黑色线位置)就OK了(例如要求精度很高,尝试填0,等等),如图8。

图 7

图8

2 神经网络的仿真测试

神经网络的仿真测试非常简单,选定训练好的神经网络,点击View按钮,再点击Simulate按钮,在Simulate Data中的Inputs一栏中导入需要测试的数据(需要是工作区的矩阵,所以可以事先将数据写在但单独的程序中,需要时运行程序即可),然后点击Simulate Network,测试结束后可以在Outputs中看到结果,在Errors中可以看到误差。

五、参考文献

[1] 刘金琨.智能控制[M].北京: 电子工业出版社,2009.

[2] 李国勇.智能控制及其Matlab实现[M].北京: 电子工业出版社,2005.

[3] 侯媛彬,杜京义,汪梅等.神经网络[M].西安: 西安电子科技大学出版社, 2007.

MATLAB软件中包含MATLAB神经网络工具箱,工具箱以人工神经网络为基础,只要根据自己需要调用相关函数,就可以完成网络设计、权值初始化、网络训练等,MATLAB神经网络工具箱包括的网络有感知器、线性网络、BP神经网络、径向基网络、自组织网络和回归网络,BP神经网络工具箱主要包括newff,sim和train三个神经网络函数各函数的解释如下:1 newff::::BP神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数 函数功能:构建一个BP神经网络。 函数形式:net = newff(P,T,S,TF,BTF,BLF,PF,IPF,OPF,DDF) P:输入数据矩阵 T:输出数据矩阵 S:隐含层节点数 TF:节点传递函数,包括硬限幅传递函数hardlim,对称硬限幅传递函数hardlims,线性传递函数purelin,正切S型传递函数tansig,对数S型传递函数logsig BTF:训练函数,包括梯度下降BP算法训练函数traingd,动量反传的梯度下降BP算法训练函数traingdm,动态自适应学习率的梯度下降BP算法训练函数traingda,动量反传和动态自适应学习率的梯度下降BP算法训练函数traingdx,Levenberg_Marquardt 的BP算法训练函数trainlm BLF:网络学习函数,包括BP学习规则learngd,带动量项的BP学习规则learngdm PF:性能分析函数,包括均值绝对误差性能分析函数mae,均方差性能分析函数mse IPF:输入处理函数 OPF:输出处理函数 DDF:验证数据划分函数 一般在使用过程中设置前六个参数,后四个参数采用系统默认参数。 2 train::::BP神经网络训练函数神经网络训练函数神经网络训练函数神经网络训练函数函数功能:用训练数据训练BP神经网络。 函数形式:[net,tr] = train(NET,X,T,Pi,Ai) NET:待训练网络 X:输入数据矩阵 T:输出数据矩阵 Pi:初始化输入层条件 Ai:初始化输出层条件 net:训练好的网络 tr:训练过程记录 一般在使用过程中设置前三个参数,后两个参数采用系统默认参数。 3 sim::::BP神经网络预测函数神经网络预测函数神经网络预测函数神经网络预测函数 函数功能:用训练好的BP神经网络预测函数输出 函数形式:y=sim(net,x) net:训练好的网络 x:输入数据 y:网络预测数据 只要我们能够熟练掌握上述三个函数,就可以完整的编写一个BP神经网络预测或者分类的程序。

MATLAB 图形用户界面功能: ——作者:强哥1573:2017-09-01 nnstart - 神经网络启动GUI nctool - 神经网络分类工具 nftool - 神经网络的拟合工具 nntraintool - 神经网络的训练工具 nprtool - 神经网络模式识别工具 ntstool - NFTool神经网络时间序列的工具 nntool - 神经网络工具箱的图形用户界面。 查看- 查看一个神经网络。 网络的建立功能。 cascadeforwardnet - 串级,前馈神经网络。 competlayer - 竞争神经层。 distdelaynet - 分布时滞的神经网络。 elmannet - Elman神经网络。 feedforwardnet - 前馈神经网络。 fitnet - 函数拟合神经网络。 layrecnet - 分层递归神经网络。 linearlayer - 线性神经层。 lvqnet - 学习矢量量化(LVQ)神经网络。 narnet - 非线性自结合的时间序列网络。 narxnet - 非线性自结合的时间序列与外部输入网络。 newgrnn - 设计一个广义回归神经网络。 newhop - 建立经常性的Hopfield网络。 newlind - 设计一个线性层。 newpnn - 设计概率神经网络。 newrb - 径向基网络设计。 newrbe - 设计一个确切的径向基网络。 patternnet - 神经网络模式识别。 感知- 感知。 selforgmap - 自组织特征映射。 timedelaynet - 时滞神经网络。 利用网络。 网络- 创建一个自定义神经网络。 SIM卡- 模拟一个神经网络。 初始化- 初始化一个神经网络。 适应- 允许一个神经网络来适应。 火车- 火车的神经网络。 DISP键- 显示一个神经网络的属性。 显示- 显示的名称和神经网络属性 adddelay - 添加延迟神经网络的反应。 closeloop - 神经网络的开放反馈转换到关闭反馈回路。

神经网络工具箱的使用 本章主要介绍神经网络工具箱的使用,使用nntool可以使得原本用编程来创建神经网络变得容易,而且不容易出错。 1 神经网络的创建与训练 神经网络的创建主要分为以下四步: 1)在命令窗口键入nntool命令打开神经网络工具箱。如图1: 图 1 2)点击Import按钮两次,分别把输入向量和目标输出加入到对应的窗口([Inputs]和[Targets])中,有两种可供选择的加入对象(点击Import后可以看见),一种是把当前工作区中的某个矩阵加入,另一种是通过.mat文件读入。如图2和图3:

图 2 图 3 3)点击[New Network]按钮,填入各参数:(以最常用的带一个隐层的3层神经网络为例说明,下面没有列出的参数表示使用默认值就可以了,例如Network Type为默认的BP神经网络);

i)Input Range——这个通过点击Get From Input下拉框选择你加入的输入向量便可自动完成,当然也可以自己手动添加。 ii) Training Function——最好使用TRAINSCG,即共轭梯度法,其好处是当训练不收敛时,它会自动停止训练,而且耗时较其他算法(TRAINLM,TRAINGD)少,也就是收敛很快(如果收敛的话),而且Train Parameters输入不多,也不用太多的技巧调整,一般指定迭代次数、结果显示频率和目标误差就可以了(详见下文)。 iii) Layer 1 Number of Neurons——隐层的神经元个数,这是需要经验慢慢尝试并调整的,大致上由输入向量的维数、样本的数量和输出层(Layer2)的神经元个数决定。一般来说,神经元越多,输出的数值与目标值越接近,但所花费的训练时间也越长,反之,神经元越少,输出值与目标值相差越大,但训练时间会相应地减少,这是由于神经元越多其算法越复杂造成的,所以需要自己慢慢尝试,找到一个合适的中间点。比如输入是3行5000列的0-9的随机整数矩阵,在一开始选择1000个神经元,虽然精度比较高,但是花费的训练时间较长,而且这样神经网络的结构与算法都非常复杂,不容易在实际应用中实现,尝试改为100个,再调整为50个,如果发现在50个以下时精度较差,则可最后定为50个神经元,等等。 iv)Layer 1 Transfer Function——一般用TANSIG(当然也可以LOGSIG),即表示隐层输出是[-1,1]之间的实数,与LOGSIG相比范围更大。 v) Layer 2 Number of Neurons——输出层的神经元个数,需要与输出的矩阵行数对应,比如设置为3,等等。 vi) Layer 2 Transfer Function——如果是模式识别的两类(或者多类)问题,一般用LOGSIG,即表示输出层的输出是[0,1]之间的实数;如果输出超过[0,1]则可选择PURELIN。如图4和图5。

研究生必备的人工神经网络电子书汇总(31本) 这些都是我从淘宝和百度文库里面搜集到的电子书,需要的可以联系我 QQ:415295747,或者登录我的博客https://www.doczj.com/doc/ab5243237.html,/u/1723697742 1.神经网络在应用科学和工程中的应用——从基础原理到复杂的模式识别 5 译者序 6 前 9 致谢 10 作者简介 11 目录 19 第1章从数据到模型:理解生物学、生态学和自然系统的复杂性和挑战 27 第2章神经网络基础和线性数据分析模型 72 第3章用于非线性模式识别的神经网络 105 第4章神经网对非线性模式的学习 166 第5章从数据中抽取可靠模式的神经网络模型的实现 205 第6章数据探测、维数约简和特征提取 235 第7章使用贝叶斯统计的神经网络模型的不确定性评估 276 第8章应用自组织映射的方法发现数据中的未知聚类 359 第9章神经网络在时间序列预测中的应用 458 附录 2.MATLB 神经网络30个案例分析 第1章BP神经网络的数据分类——语音特征信号分类 23 第2章BP神经网络的非线性系统建模——非线性函数拟合 33 第3章遗传算法优化BP神经网络——非线性函数拟合 48 第4章神经网络遗传算法函数极值寻优——非线性函数极值寻优 57 第5章基于BP_Adsboost的强分类器设计——公司财务预警建模 66 第6章PID神经元网络解耦控制算法——多变量系统控制 77 第7章RBF网络的回归——非线性函数回归的实现 85 第8章GRNN的数据预测——基于广义回归神经网络的货运量预测 93 第9章离散Hopfield神经网络的联想记忆——数字识别 102 第10章离散Hopfield神经网络的分类——高校科研能力评价 112 第11章连续Hopfield神经网络的优化——旅行商问题优化计算 124 第12章SVM的数据分类预测——意大利葡萄酒种类识别 134 第13章SVM的参数优化——如何更好的提升分类器的性能

第一章Matlab神经网络工具箱介绍和数值试验 1.1Matlab神经网络工具箱中BP网络相关函数介绍 MATLAB神经网络工具箱中包含了许多用于BP网络分析和设计的函数。BP网络的常用函数如表4-1所示。[10,12] 表4-1 BP网络的常用函数 函数类型函数名称函数用途 前向网络创建函数newcf 创建一个多层前馈BP网络newff 创建一个前向BP网络 newfftd 创建一个前馈输入延迟BP网络 传递函数logsig S型的对数函数dlogsig Logig的导函数tansig S型的正切函数dtansig tansig的导函数purelin 纯线性函数 学习函数traingd 基于标准BP算法的学习函数trainrp 采用Rprop算法训练 trainlm 采用LM算法训练 traincgf 基于共轭梯度法的学习函数 仿真函数sim 仿真一个神经网络 1.2数值试验 1.2.1.“异或”问题 “异或”问题(XOR)是典型的非线性划分问题。这里以它为例,简单介绍BP网络的使用。 在Matlab7.0环境下,建立一个三层的BP神经网络,其中输入层和隐层分别各有两个神经元,输出层有一个神经元。现要求训练这一网络,使其具有解决“异或”问题的能力。 “异或”问题的训练输入和期望输出如表5-1。

表5-1 异或问题的训练输入和期望输出 1X 2X 1d 0 0 0 0 1 1 1 0 1 1 1 1) 基于标准BP 算法 结果如下及图5.1所示: 横轴表示迭代次数,纵轴表示误差。迭代到第240次时达到预设精度。迭代停止时,误差为9.97269e-005,此时的梯度为0.00924693。 050 100150200 10 -4 10 -3 10 -2 10 -1 10 10 1 240 Epochs T r a i n i n g -B l u e G o a l -B l a c k Performance is 9.97269e-005, Goal is 0.0001 图5.1 基于标准BP 算法的“异或”问题 2) 基于共轭梯度法 结果如下及图5.2所示: 横轴表示迭代次数,纵轴表示误差。迭代到第16次时达到预设精度。迭代停止时,

1. 打开MATLAB,在命令行输入nntool,将出现如下界面: 图1 神经网络工具箱主界面 其中最主要的分为6个部分:第1部分中显示的是系统的输入数据;第2部分是系统的期望输出;第3部分是网络的计算输出;第4部分是网络的误差,即2 和3之间的差异;第5部分呈现的是已经建立的神经网络实例;第6部分的两个按钮分别负责数据的导入和网络模型的建立。 2. 点击“Import”按钮,分别导入输入数据与目标输出数据(数据可从工作区导入,也可从文件导入): 图2 导入输入数据集

图3 导入期望输出数据集 导入数据后主界面的情况如下: 图4 导入数据后的情况 重要说明:神经网络的数据是以列为基本单位的,即输入与输出数据的列数必须相同,否则将报错!如果原先数据是以行为单位组织的话,可以先在MATLAB 中实现转置然后再导入,即B = A’。

3.现在需要的数据已经有了,下一步就是建立一个神经网络模型对数据集进行学习。以下步骤以BP网络为例,首先点击“New”按钮,出现如下界面: 几个重要部分已在上图中框出:1处用于定义该神经网络的名称;2处用于选择神经网络的类型;3处用于选择网络的输入数据;4处用于确定网络的期望输出数据;5、6、7处分别对神经网络的主要机制函数进行设置;8处设置网络层数;9处用于选择各网络层(需要说明的是:第1层指的是隐含层而不是输入层),从而在10和11处可以对该层的神经元个数和传递函数进行设置;12处按钮可以用于查看当前所设置的神经网络的结构图(下附图);点击13处按钮即可生成对应的神经网络模型。前面只是简单地介绍了各个部分的作用,具体参数应该如何设置就只有各位自行去学习相关的文献了,此处不再多言。

b p神经网络及m a t l a b实现

图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值 ( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为: 图中 yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数 ( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ]

则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function ) 以上3个激活函数都属于线性函数,下面介绍两个常用的非线性激活函数。 (4) S形函数 ( Sigmoid Function ) 该函数的导函数:

Matlab的神经网络工具箱实用指南 文章摘要:第一章是神经网络的基本介绍,第二章包括了由工具箱指定的有关网络结构和符号的基本材料以及建立神经网络的一些基本函数,例如new、init、adapt和train。第三章以反向传播网络为例讲解了反向传播网络的原理和应用的基本过程。 第一章介绍 1.神经网络 神经网络是单个并行处理元素的集合,我们从生物学神经系统得到启发。在自然界,网络功能主要由神经节决定,我们可以通过改变连接点的权重来训练神经网络完成特定的功能。 一般的神经网络都是可调节的,或者说可训练的,这样一个特定的输入便可得到要求的输出。如下图所示。这里,网络根据输出和目标的比较而调整,直到网络输出和目标匹配。作为典型,许多输入/目标对应的方法已被用在有监督模式中来训练神经网络。 神经网络已经在各个领域中应用,以实现各种复杂的功能。这些领域包括:模式识别、鉴定、分类、语音、翻译和控制系统。 如今神经网络能够用来解决常规计算机和人难以解决的问题。我们主要通过这个工具箱来建立示范的神经网络系统,并应用到工程、金融和其他实际项目中去。 一般普遍使用有监督训练方法,但是也能够通过无监督的训练方法或者直接设计得到其他的神经网络。无监督网络可以被应用在数据组的辨别上。一些线形网络和Hopfield网络是直接设计的。总的来说,有各种各样的设计和学习方法来增强用户的选择。 神经网络领域已经有50年的历史了,但是实际的应用却是在最近15年里,如今神经网络仍快速发展着。因此,它显然不同与控制系统和最优化系统领域,它们的术语、数学理论和设计过程都已牢固的建立和应用了好多年。我们没有把神经网络工具箱仅看作一个能正常运行的建好的处理轮廓。我们宁愿希望它能成为一个有用的工业、教育和研究工具,一个能够帮助用户找到什么能够做什么不能做的工具,一个能够帮助发展和拓宽神经网络领域的工具。因为这个领域和它的材料是如此新,这个工具箱将给我们解释处理过程,讲述怎样运用它们,并且举例说明它们的成功和失败。我们相信要成功和满意的使用这个工具箱,对范例

如何用MA TLAB的神经网络工具箱实现三层BP网络? % 读入训练数据和测试数据 Input = []; Output = []; str = {'Test','Check'}; Data = textread([str{1},'.txt']); % 读训练数据 Input = Data(:,1:end-1); % 取数据表的前五列(主从成分) Output = Data(:,end); % 取数据表的最后一列(输出值) Data = textread([str{2},'.txt']); % 读测试数据 CheckIn = Data(:,1:end-1); % 取数据表的前五列(主从成分) CheckOut = Data(:,end); % 取数据表的最后一列(输出值) Input = Input'; Output = Output'; CheckIn = CheckIn'; CheckOut = CheckOut'; % 矩阵赚置 [Input,minp,maxp,Output,mint,maxt] = premnmx(Input,Output); % 标准化数据 %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%% % 神经网络参数设置 %====可以修正处 Para.Goal = 0.0001; % 网络训练目标误差 Para.Epochs = 800; % 网络训练代数 Para.LearnRate = 0.1; % 网络学习速率 %==== Para.Show = 5; % 网络训练显示间隔 Para.InRange = repmat([-1 1],size(Input,1),1); % 网络的输入变量区间 Para.Neurons = [size(Input,1)*2+1 1]; % 网络后两层神经元配置

神经网络工具箱 版本6.0.4(R2010a版本)25-JAN-2010 图形用户界面的功能。 nctool - 神经网络分类的工具。 nftool - 神经网络拟合工具。 nprtool - 神经网络模式识别工具。 nntool - 神经网络工具箱的图形用户界面。 nntraintool - 神经网络训练工具。 视图- 查看一个神经网络。 分析功能。 混乱- 分类混淆矩阵。 errsurf - 单输入神经元的误差表面。 maxlinlr - 最大的学习率的线性层。 鹏- 受试者工作特征。 距离函数。 boxdist - 箱距离函数。 DIST - 欧氏距离权重函数。 mandist - 曼哈顿距离权重函数。 linkdist - 链路距离函数。 格式化数据。 combvec - 创建载体的所有组合。 con2seq - 转换并行向量连续载体。 同意- 创建并发偏载体。 dividevec - 创建载体的所有组合。 ind2vec - 转换指数为载体。 最小最大- 矩阵行范围。 nncopy - 复印基质或细胞阵列。 normc - 规格化矩阵的列。 normr - 规格化行的矩阵的。 pnormc - 矩阵的伪规格化列。 定量- 值离散化作为数量的倍数。 seq2con - 转换顺序向量并发载体。 vec2ind - 将矢量转换成指数。 初始化网络功能。 initlay - 层- 层网络初始化函数。 初始化层功能。

initnw - 阮层的Widrow初始化函数。 initwb - 从重量和- 偏置层初始化函数。 初始化的重量和偏见的功能。 initcon - 良心的偏见初始化函数。 initzero - 零重量/偏置初始化函数。 initsompc - 初始化SOM的权重与主要成分。 中点- 中点重初始化函数。 randnc - 归一列重初始化函数。 randnr - 归行重初始化函数。 兰特- 对称随机重量/偏置初始化函数。 学习功能。 learncon - 良心的偏见学习功能。 learngd - 梯度下降重量/偏置学习功能。 learngdm - 梯度下降W /气势重量/偏置学习功能。 learnh - 赫布重学习功能。 learnhd - 赫布衰变重学习功能。 learnis - 重量龄学习功能。 learnk - Kohonen的重量学习功能。 learnlv1 - LVQ1重学习功能。 learnlv2 - LVQ2重学习功能。 learnos - Outstar重学习功能。 learnsomb - 批自组织映射权重学习功能。 learnp - 感知重量/偏置学习功能。 learnpn - 归感知重量/偏置学习功能。 learnsom - 自组织映射权重学习功能。 learnwh - 的Widrow - 霍夫重量/偏置学习规则。 在线搜索功能。 srchbac - 回溯搜索。 srchbre - 布伦特的结合黄金分割/二次插值。 srchcha - Charalambous“三次插值。 srchgol - 黄金分割。 srchhyb - 混合二分/立方搜索。 净输入功能。 netprod - 产品净输入功能。 netsum - 求和净输入功能。 网络创造的功能。 网络- 创建一个自定义的神经网络。 NEWC - 创建一个有竞争力的层。 newcf - 创建级联转发传播网络。

小波神经网络及其应用 陆宇颖 摘要:小波神经网络是将小波理论和神经网络理论结合起来的一种神经网络,它避免了BP 神经网络结构设计的盲目性和局部最优等非线性优化问题,大大简化了训练,具有较强的函数学习能力和推广能力及广阔的应用前景。首先阐明了小波变换和多分辨分析理论,然后介绍小波神经网络数学模型和应用概况。 1. 研究背景与意义 人工神经网络是基于生物神经系统研究而建立的模型,它具有大规模并行处理和分布式存储各类图像信息的功能,有很强的容错性、联想和记忆能力,因而被广泛地应用于故障诊断、模式识别、联想记忆、复杂优化、图像处理以及计算机领域。但是,人工神经网络模型建立的物理解释,网络激活函数采用的全局性函数,网络收敛 即 ,焦李神经网络2. 2.1()x ,使式中为的Fourier 变换。对作伸缩、平移变换得到小波基函数系 对任意2()()f x L R ∈,其连续小波变换定义为: 反演公式为: 在实际应用中,特别是计算机实现中,往往要把上述的连续小波及其变换离散化,通常采用二进制离散,即 令2,2m m a b k ==,则 二进小波一定是一个允许小波,且是一个正交小波基。考虑一个连续的、平方可积的函数 2()()f x L R ∈在分辨率2m 下的逼近()m f x ,由多分辨分析理论可知:

()x Φ是尺度函数,对其作伸缩、平移变换得到()mk x Φ。 Mallat 同时证明了函数()f x 在2m 和12m -分辨率下的信息差别(即细节)()m D f x ,可以通过将函数() f x 在一小波正交基上分解而获得,从而定义了一种完全而且正交的多分辨率描述,即小波描述。 ()mk x ψ就是式(5)定义的二进小波,则()f x 在12m -分辨率下的逼近式为: Mallat 并指出,对于任意一个函数 2()()f x L R ∈可以在一组正交小波基上展开: 式(11)是一个平方可积函数的小波分解,提供了小波神经网络设计的理论框架。 .. 12(,)x x ο 则有2.2 (ψ(f x 式(Lk a 与式 (17i c i 则有: 即(21)=f Ac 式(20)的最小二乘解为: +A 被称为A 的伪逆矩阵。且 如果样本i x 均匀分布,(1,2,...,)θ=i i n 是正交基, 则T A A 是一个?n n 单位矩阵,且

MATLAB 神经网络工具箱函数 说明:本文档中所列出的函数适用于 MATLAB5.3以上版本, 为了简明起见, 只列出了函数名, 若需要进一步的说明,请参阅 MATLAB 的帮助文档。 1. 网络创建函数 newp 创建感知器网络 newlind 设计一线性层 newlin 创建一线性层 newff 创建一前馈 BP 网络 newcf 创建一多层前馈 BP 网络 newfftd 创建一前馈输入延迟 BP 网络 newrb 设计一径向基网络 newrbe 设计一严格的径向基网络 newgrnn 设计一广义回归神经网络 newpnn 设计一概率神经网络 newc 创建一竞争层 newsom 创建一自组织特征映射 newhop 创建一 Hopfield 递归网络 newelm 创建一 Elman 递归网络 2. 网络应用函数

sim 仿真一个神经网络 init 初始化一个神经网络 adapt 神经网络的自适应化 train 训练一个神经网络 3. 权函数 dotprod 权函数的点积 ddotprod 权函数点积的导数 dist Euclidean 距离权函数normprod 规范点积权函数negdist Negative 距离权函数mandist Manhattan 距离权函数linkdist Link 距离权函数 4. 网络输入函数 netsum 网络输入函数的求和dnetsum 网络输入函数求和的导数5. 传递函数 hardlim 硬限幅传递函数hardlims 对称硬限幅传递函数purelin 线性传递函数

tansig 正切 S 型传递函数 logsig 对数 S 型传递函数 dpurelin 线性传递函数的导数 dtansig 正切 S 型传递函数的导数dlogsig 对数 S 型传递函数的导数compet 竞争传递函数 radbas 径向基传递函数 satlins 对称饱和线性传递函数 6. 初始化函数 initlay 层与层之间的网络初始化函数initwb 阈值与权值的初始化函数initzero 零权/阈值的初始化函数 initnw Nguyen_Widrow层的初始化函数initcon Conscience 阈值的初始化函数midpoint 中点权值初始化函数 7. 性能分析函数 mae 均值绝对误差性能分析函数 mse 均方差性能分析函数 msereg 均方差 w/reg性能分析函数

神经网络算法详解 第0节、引例 本文以Fisher的Iris数据集作为神经网络程序的测试数据集。Iris数据集可以在https://www.doczj.com/doc/ab5243237.html,/wiki/Iris_flower_data_set 找到。这里简要介绍一下Iris数据集: 有一批Iris花,已知这批Iris花可分为3个品种,现需要对其进行分类。不同品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度会有差异。我们现有一批已知品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度的数据。 一种解决方法是用已有的数据训练一个神经网络用作分类器。 如果你只想用C#或Matlab快速实现神经网络来解决你手头上的问题,或者已经了解神经网络基本原理,请直接跳到第二节——神经网络实现。 第一节、神经网络基本原理 1. 人工神经元( Artificial Neuron )模型 人工神经元是神经网络的基本元素,其原理可以用下图表示: 图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j到神经元i的连接权值,θ表示一个阈值( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为:

图中yi表示神经元i的输出,函数f称为激活函数 ( Activation Function )或转移函数( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ] 则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net 为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数 ( Liner Function ) (2) 斜面函数 ( Ramp Function ) (3) 阈值函数 ( Threshold Function )

小波神经网络及其应用 1014202032 陆宇颖 摘要:小波神经网络是将小波理论和神经网络理论结合起来的一种神经网络,它避免了BP 神经网络结构设计的盲目性和局部最优等非线性优化问题,大大简化了训练,具有较强的函数学习能力和推广能力及广阔的应用前景。首先阐明了小波变换和多分辨分析理论,然后介绍小波神经网络数学模型和应用概况。 1.研究背景与意义 人工神经网络是基于生物神经系统研究而建立的模型,它具有大规模并行处理和分布式存储各类图像信息的功能,有很强的容错性、联想和记忆能力,因而被广泛地应用于故障诊断、模式识别、联想记忆、复杂优化、图像处理以及计算机领域。但是,人工神经网络模型建立的物理解释,网络激活函数采用的全局性函数,网络收敛性的保证,网络节点数的经验性确定等问题尚有待进一步探讨和改善。 小波理论自 Morlet 提出以来,由于小波函数具有良好的局部化性质,已经广泛渗透到各个领域。小波变换方法是一种窗口大小固定但其形状可以改变, 时间窗和频率窗都可以改变的时频局部化分析方法, 由于在低频部分具有较高的频率分辨率和较低的时间分辨率, 在高频部分具有较高的时间分辨率和较低的频率分辨率, 所以被誉为数学显微镜。正是这种特性, 使小波变换具有对信号的自适应性。基于多分辨分析的小波变换由于具有时频局部化特性而成为了信号处理的有效工具。实际应用时常采用Mallat快速算法,利用正交小波基将信号分解到不同尺度上。实现过程如同重复使用一组高通和低通滤波器把信号分解到不同的频带上,高通滤波器产生信号的高频细节分量,低通滤波器产生信号的低频近似分量。每分解一次信号的采样频率降低一倍,近似分量还可以通过高通滤波和低通滤波进一步地分解,得到下一层次上的两个分解分量。 而小波神经网络(Wavelet Neural Network, WNN)正是在近年来小波分析研究获得突破的基础上提出的一种人工神经网络。它是基于小波分析理论以及小波变换所构造的一种分层的、多分辨率的新型人工神经网络模型,即用非线性小波基取代了通常的非线性Sigmoid 函数,其信号表述是通过将所选取的小波基进行线性叠加来表现的。 小波神经网络这方面的早期工作大约开始于1992 年,主要研究者是Zhang Q、Harold H S 和焦李成等。其中,焦李成在其代表作《神经网络的应用与实现》中从理论上对小波神经网络进行了较为详细的论述。近年来,人们在小波神经网络的理论和应用方面都开展了不少研究工作。 小波神经网络具有以下特点。首先,小波基元及整个网络结构的确定有可靠的理论根据,可避免BP 神经网络等结构设计上的盲目性;其次,网络权系数线性分布和学习目标函数的凸性,使网络训练过程从根本上避免了局部最优等非线性优化问题;第三,有较强的函数学习能力和推广能力。 2.数学模型与小波工具 2.1 小波变换及多分辨分析 L R(或更广泛的Hilbert 空间)中,选择一个母小波函数(又称为基本在函数空间2() ,使其满足允许条件: 小波函数)()x

数学建模B P神经网 络论文

BP 神经网络 算法原理: 输入信号i x 通过中间节点(隐层点)作用于输出节点,经过非线形变换,产生输出信号k y ,网络训练的每个样本包括输入向量x 和期望输出量d ,网络输出值y 与期望输出值d 之间的偏差,通过调整输入节点与隐层节点的联接强度取值ij w 和隐层节点与输出节点之间的联接强度jk T 以及阈值,使误差沿梯度方向下降,经过反复学习训练,确定与最小误差相对应的网络参数(权值和阈值),训练即告停止。此时经过训练的神经网络即能对类似样本的输入信息,自行处理输出误差最小的经过非线形转换的信息。 变量定义: 设输入层有n 个神经元,隐含层有p 个神经元,输出层有q 个神经元 输入向量:()12,, ,n x x x x = 隐含层输入向量:()12,,,p hi hi hi hi = 隐含层输出向量:()12,,,p ho ho ho ho = 输出层输入向量:()12,,,q yi yi yi yi = 输出层输出向量:()12,,,q yo yo yo yo = 期望输出向量: ()12,, ,q do d d d = 输入层与中间层的连接权值: ih w 隐含层与输出层的连接权值: ho w 隐含层各神经元的阈值:h b 输出层各神经元的阈值: o b 样本数据个数: 1,2, k m =

激活函数: ()f ? 误差函数:21 1(()())2q o o o e d k yo k ==-∑ 算法步骤: Step1.网络初始化 。给各连接权值分别赋一个区间(-1,1)内的随机数,设定误差函数e ,给定计算精度值ε和最大学习次数M 。 Step2.随机选取第k 个输入样本()12()(),(), ,()n x k x k x k x k =及对应期望输出 ()12()(),(),,()q d k d k d k d k =o Step3.计算隐含层各神经元的输入()1 ()()1,2, ,n h ih i h i hi k w x k b h p ==-=∑和输出 ()()(())1,2, ,h h ho k f hi k h p ==及输出层各神经元的输入 ()1 ()()1,2, p o ho h o h yi k w ho k b o q ==-=∑和输出()()(())1,2, ,o o yo k f yi k o p == Step4.利用网络期望输出和实际输出,计算误差函数对输出层的各神经元的偏导数()o k δ。 o ho o ho yi e e w yi w ???=??? (()) () ()p ho h o o h h ho ho w ho k b yi k ho k w w ?-?==??∑ 2 1 1((()()))2(()())()(()())f (()) () q o o o o o o o o o o o o d k yo k e d k yo k yo k yi yi d k yo k yi k k δ=?-?'==--??'=---∑ Step5.利用隐含层到输出层的连接权值、输出层的()o k δ和隐含层的输出计算误差函数对隐含层各神经元的偏导数()h k δ。

BP神经网络matlab工具箱和matlab实现使用实例经过最近一段时间的神经网络学习,终于能初步使用matlab实现BP网络仿真试验。这里特别感谢研友sistor2004的帖子《自己编的BP算法(工具:matlab)》和研友wangleisxcc的帖子《用C++,Matlab,Fortran实现的BP算法》前者帮助我对BP算法有了更明确的认识,后者让我对matlab 下BP函数的使用有了初步了解。因为他们发的帖子都没有加注释,对我等新手阅读时有一定困难,所以我把sistor2004发的程序稍加修改后加注了详细解释,方便新手阅读。 %严格按照BP网络计算公式来设计的一个matlab程序,对BP网络进行了优化设计 %yyy,即在o(k)计算公式时,当网络进入平坦区时(<0.0001)学习率加大,出来后学习率又还原 %v(i,j)=v(i,j)+deltv(i,j)+a*dv(i,j);动量项 clear all clc inputNums=3;%输入层节点 outputNums=3;%输出层节点 hideNums=10;%隐层节点数 maxcount=20000;%最大迭代次数 samplenum=3;%一个计数器,无意义 precision=0.001;%预设精度 yyy=1.3;%yyy是帮助网络加速走出平坦区 alpha=0.01;%学习率设定值 a=0.5;%BP优化算法的一个设定值,对上组训练的调整值按比例修改字串9 error=zeros(1,maxcount+1);%error数组初始化;目的是预分配内存空间 errorp=zeros(1,samplenum);%同上 v=rand(inputNums,hideNums);%3*10;v初始化为一个3*10的随机归一矩阵;v表输入层到隐层的值deltv=zeros(inputNums,hideNums);%3*10;内存空间预分配 dv=zeros(inputNums,hideNums);%3*10; w=rand(hideNums,outputNums);%10*3;同V deltw=zeros(hideNums,outputNums);%10*3 dw=zeros(hideNums,outputNums);%10*3 samplelist=[0.1323,0.323,-0.132;0.321,0.2434,0.456;-0.6546,-0.3242,0.3255];%3*3;指定输入值 3*3(实为3个向量) expectlist=[0.5435,0.422,-0.642;0.1,0.562,0.5675;-0.6464,-0.756,0.11];%3*3;期望输出值3*3(实为3个向量),有导师的监督学习 count=1; while(count<=maxcount)%结束条件1迭代20000次 c=1; while(c<=samplenum)

PS:这篇介绍神经网络是很详细的,有一步一步的推导公式!神经网络是DL(深度学习)的基础。 如果对神经网络已经有所了解,可以直接跳到“三、BP算法的执行步骤“ 部分,算法框架清晰明了。 另外,如果对NN 很感兴趣,也可以参阅最后两篇参考博文,也很不错! 学习是神经网络一种最重要也最令人注目的特点。在神经网络的发展进程中,学习算法的研究有着十分重要的地位。目前,人们所提出的神经网络模型都是和学习算法相应的。所以,有时人们并不去祈求对模型和算法进行严格的定义或区分。有的模型可以有多种算法.而有的算法可能可用于多种模型。不过,有时人们也称算法为模型。 自从40年代Hebb提出的学习规则以来,人们相继提出了各种各样的学习算法。其中以在1986年Rumelhart等提出的误差反向传播法,即BP(error BackPropagation)法影响最为广泛。直到今天,BP算法仍然是自动控制上最重要、应用最多的有效算法。 1.2.1 神经网络的学习机理和机构 在神经网络中,对外部环境提供的模式样本进行学习训练,并能存储这种模式,则称为感知器;对外部环境有适应能力,能自动提取外部环境变化特征,则称为认知器。 神经网络在学习中,一般分为有教师和无教师学习两种。感知器采用有教师信号进行学习,而认知器则采用无教师信号学习的。在主要神经网络如BP网络,Hopfield网络,ART网络和Kohonen 网络中;BP网络和Hopfield网络是需要教师信号才能进行学习的;而ART网络和Kohonen网络则无需教师信号就可以学习。所谓教师信号,就是在神经网络学习中由外部提供的模式样本信号。 一、感知器的学习结构 感知器的学习是神经网络最典型的学习。 目前,在控制上应用的是多层前馈网络,这是一种感知器模型,学习算法是BP法,故是有教师学习算法。 一个有教师的学习系统可以用图1—7表示。这种学习系统分成三个部分:输入部,训练部和输出部。

径向基函数神经网络模型与学习算法 1985年,Powell提出了多变量插值的径向基丙数(Radical Basis Function, RBF)方法。1988 年,Moody 和Darken 提出了一种神经网络结构,即RBF 神经网络,属于前向神经网络类型,它能够以任意精度逼近任意连续函数,特别适合于解决分类问题。 RBF网络的结构与多层前向网络类似,它是一种三层前向网络。输入层由信号源结点组成;第二层为隐含层,隐单元数视所描述问题的需要而定,隐单元的变换函数RBFO是对中心点径向对称且衰减的非负非线性函数;第三层为输出层,它对输入模式的作用作出响应。从输入空间到隐含层空间的变换是非线性的,而从隐含层空间的输出层空间变换是线性的。 RBF网络的基本思想是:用RBF作为隐单元的“基”构成隐含层空间,这样就可以将输入矢量直接(即不需要通过权接)映射到隐空间。当RBF的屮心点确定以后,这种映射关系也就确定了。而隐含层空间到输出空间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此处的权即为网络可调参数。由此可见,从总体上看,网络市输入到输出的映射是非线性的,而网络输出对叮调参数而言却又是线性的。这样网络的权就可由线性方程直接解岀,从而大大加快学习速度并避免局部极小问题。 1.1RBF神经网络模型 径向基神经网络的神经元结构如图1所示。径向基神经网络的激活函数采用径向基函数,通常定义为空间任一点到某一中心之间欧氏距离的单调函数。由图1所示的径向基神经元结构可以看出,径向基神经网络的激活函数是以输入向量和权值向量之间的距离||dist||作为自变量的。径向基神经网络的

激活函数的一般表达式为 /?(||dist||)= e~yist^(1) 图1径向基神经元模型 随着权值和输入向量之间距离的减少,网络输出是递增的,当输入向量和权值向量一致时,神经元输出1。在图1中的b为阈值,用于调整神经元的灵敏度。利用径向基神经元和线性神经元可以建立广义回归神经网络,该种神经网络适用于函数逼近方面的应用;径向基神经元和竞争神经元可以组建概率神经网络,此种神经网络适用于解决分类问题。 由输入层、隐含层和输岀层构成的一般径向基神经网络结构如图2所示。在RBF网络中,输入层仅仅起到传输信号的作用,与前面所讲述的神经网络相比较,输入层和隐含层之间可以看做连接权值为1 的连接。输出层和隐含层所完成的任务是不同的,因而它们的学习策略也不相同。输岀层是对线性权进行调整,采用的是线性优化策略。因而学习速度较快。而隐含层是对激活函数(格林函数或高斯函数,一般取高斯)的参数进行调整,采用的是非线性优化策略,因而学习速度较慢。