第18卷第6期2006年12月

军械工程学院学报

Journal of O rdnance Engineering College

Vol118No16

Dec.,2006

文章编号:1008-2956(2006)06-0024-05

基于模糊支持向量机的发动机故障诊断方法

范红波,张英堂,任国全,罗鸿飞

(军械工程学院火炮工程系,河北石家庄 050003)

摘要:发动机的故障样本少,用神经网络进行故障类别的学习和分类往往会出现过学习、泛化能力不高以及局部极小点等问题。针对这一缺陷,将基于小样本理论的支持向量机学习方法应用到发动机的故障诊断中。同时讨论了3种多故障分类器的优缺点,并用引入模糊隶属函数的方法解决了“一对多”方法在构建多故障分类器时存在的分类盲区,提高了分类器的分类精度。用该方法对发动机常见的8种状态模式的样本进行训练和识别,训练样本和测试样本都有较好的识别率。

关键词:支持向量机;发动机;故障诊断

中图分类号:TP20613;TP181 文献标识码:A

Fault D i a gnosis of Eng i n e Ba sed on Fuzzy Support Vector M ach i n e

F AN Hong-bo,ZHAN

G Ying-tang,RE N Guo-quan,LUO Hong-fei

(Depart m ent of Guns Engineering,O rdnance Engineering College,Shijiazhuang 050003,China)

Abstract:A s lack of fault sa mp les of engine,it′s used t o lead t o over-learning,l ow generalizati on and l ocal m ini m um p r oble m when training and recognizing the category of faults with neural net w ork method.To s olve the p r oble m of lack of fault engine sa mp le,support vect or machines,which is a meth2 od based on s mall sa mp le theory is app lied.The advantages and shortcom ings of3kinds of multi-fault classifier are argued here.The classifying blind area of“one against all”method is s olved by using fuzzy me mbershi p grade functi on,and it enhances the p recisi on of classifier.W ith this method,the sa mp les fr om8common engine models are trained and recognized.The result shows it is a good method.

Key words:support vect or machines;engine;fault diagnosis

发动机的故障诊断,实质上是一个分类问题,它根据发动机在运行过程中产生的各种信息(如振动频谱、波形特征、相关运行参数等),判断其是否有故障,并判断故障产生的原因和部位。由于发动机自身机构和运行过程及环境的复杂性,其运行特征参数与状态之间,一般来说,并无一一对应的关系,诊断方法十分复杂。而且发动机故障往往是多种状态并存,属于多类状态识别。

现有的基于数据的机器学习方法,包括神经网络在内,其理论基础是统计学。按经典统计数学中的大数定律,统计规律只有当训练样本数目接近无限大时才能准确地被表达。而对发动机而言,其故收稿日期:2006-08-05;修回日期:2006-09-29

作者简介:范红波(1982—),男,硕士研究生.障样本不可能很多。因此,这些理论上很优秀的诊断方法在实际应用中很难有出色的表现,由此所构建的故障诊断模型,在有些情况下会出现过学习、泛化能力不高以及局部极小点等问题,影响了实际诊断效果。而统计学习理论S LV(Statistical Learning Theory)和支持向量机S VM(Support Vect or Ma2 chines)的诞生为解决这一问题开辟了新的途径。

统计学习理论是建立在结构风险最小化的原则基础上,针对小样本情况下机器学习问题建立的一套新的理论体系。与传统的统计学习理论不同,它不是要得到样本数趋于无穷大时的最优解,而是追求在有限样本的情况下得到最优解,是兼顾到经验风险和置信范围的一种折中的思想。支持向量机就是在统计学习理论基础上发展起来的新的机器学习

算法,它是S LT 理论的具体应用。1 支持向量机的分类算法

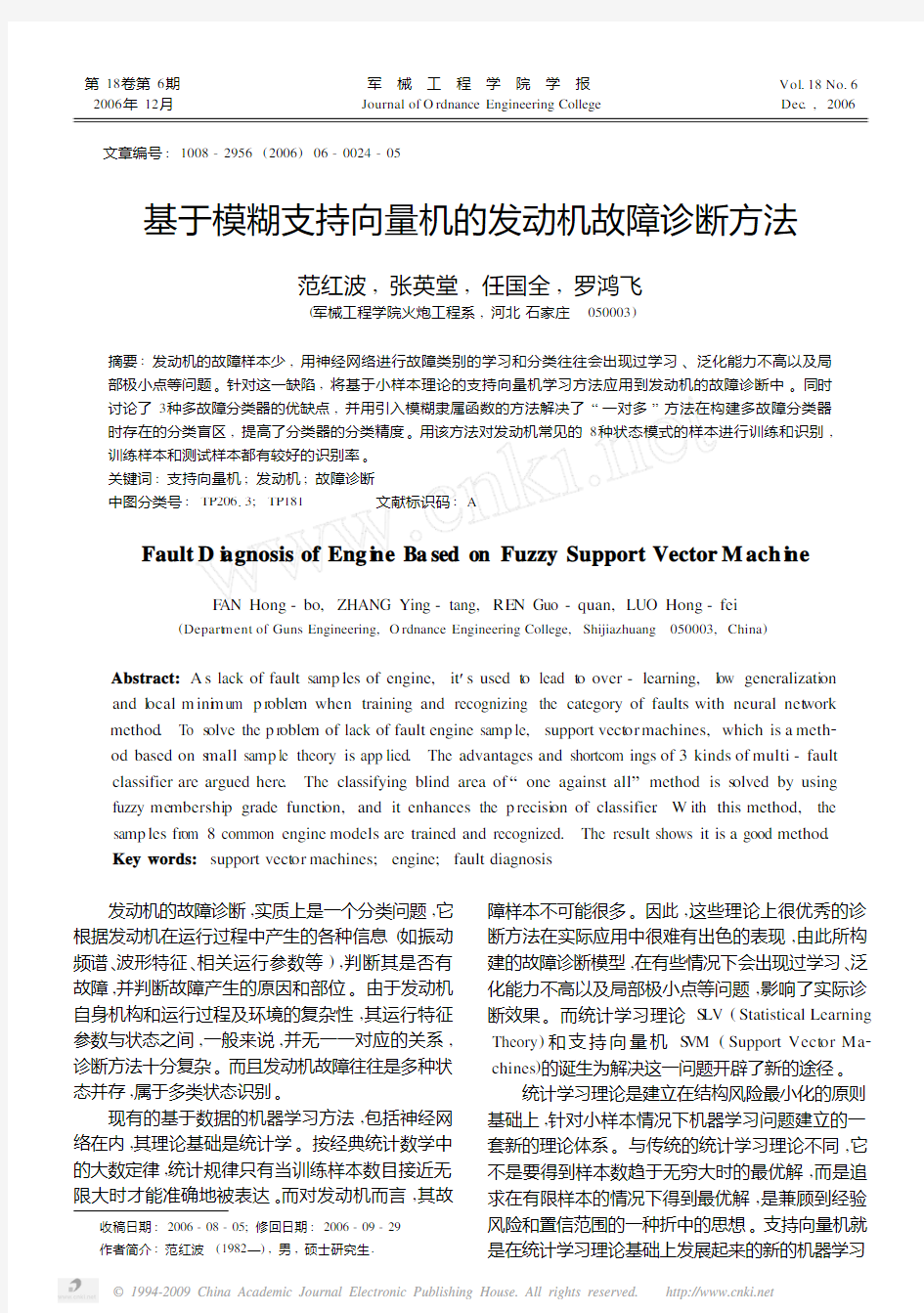

支持向量机是Vapnik 等根据统计学中的结构风险最小化原则提出来的,该方法是用少数的支持向量代表整个向量集。假定有2类训练样本数据集

(x i ,y i ),i =1,2,…,n,x i ∈R d

,y i ={1,-1},其中n

为训练样本的个数,d 为向量x i 所属空间的维数,y i

表示样本数据的类别符号。基本思想可用图1所示的二维的情况进行说明

。

在图1中,实心圆点和空心圆点分别代表2类

不同的样本,H 为分类线,H 1和H 2分别为过各类中离分类线最近的样本且平行于分类线的直线,它们之间的距离叫做分类间隔。显然能正确地将2类样本分开的分类线有无数条,支持向量机分类算法的目的就是要找出一条最优分类线。所谓最优分类线是指分类线不仅能正确地将样本分开,而且离2类样本的间隙最大。延伸到多维空间最优分类线则被定义为最优超平面,定义如下:

y i [(ω?x i )-b ]≥1-ξi ,i =1,2,…,n,(1)且使得φ(ω)=‖

ω‖2

最小。式中:ω为分类面的权重系数向量,b 为分类阈值,ξi 为非线性情况下的松弛项。而构造最优分类面的问题在式(1)下转化

为求函数1

2

‖ω‖+C (∑n

i =1ξi )(C 为惩罚参数)的最小值,即在确定最优分类面时考虑最小错分样本和最大分类间隔。这是凸二次优化问题,能够保证找到的极值解就是全局最优解。利用拉格朗日函数,并考虑K ühn -Tucher 条件问题转化为简单的对偶问题,即寻找最大泛函:

Q (a )=∑l i =1a i -1

2∑l

i,j =1a i a j y i y j K (x i ,x j ),(2)约束条件为:a i ≥0,i =1,…,n,∑n

i =1a i y i =0。

最终,支持向量的决策函数可以表示为:

f (x )=sgn [

∑支持向量

y i

a i

K (x,x i

)

-b ],(3)

由f (x )的正负即可判别x 的所属类别,式(3)中的系数由式(2)确定。

选择不同的核函数,可以实现输入空间中不同类型的非线性决策面的学习机器,常用的核函数有:线性核函数、多项式核函数、径向基核函数和Sig 2moid 核函数。

2 多故障分类器的建立

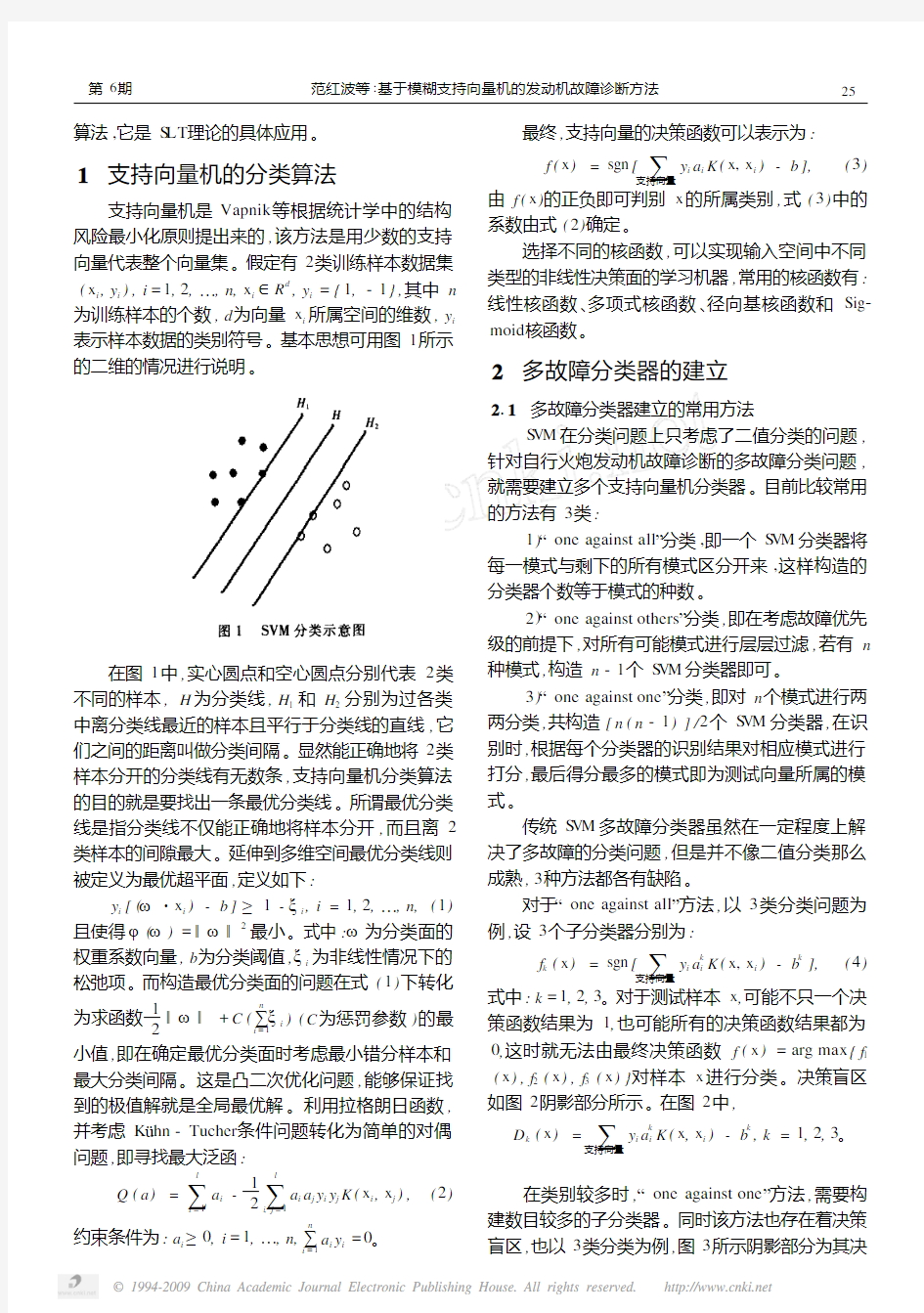

211 多故障分类器建立的常用方法

S VM 在分类问题上只考虑了二值分类的问题,

针对自行火炮发动机故障诊断的多故障分类问题,就需要建立多个支持向量机分类器。目前比较常用的方法有3类:

1)“one against all ”分类,即一个S VM 分类器将

每一模式与剩下的所有模式区分开来,这样构造的分类器个数等于模式的种数。

2)“one against others ”分类,即在考虑故障优先级的前提下,对所有可能模式进行层层过滤,若有n

种模式,构造n -1个S VM 分类器即可。

3)“one against one ”分类,即对n 个模式进行两

两分类,共构造[n (n -1)]/2个S VM 分类器,在识别时,根据每个分类器的识别结果对相应模式进行打分,最后得分最多的模式即为测试向量所属的模式。

传统S VM 多故障分类器虽然在一定程度上解决了多故障的分类问题,但是并不像二值分类那么成熟,3种方法都各有缺陷。

对于“one against all ”方法,以3类分类问题为例,设3个子分类器分别为:

f k (x )=sgn [

∑支持向量

y i a k

i

K (x,x i

)

-b k

],

(4)

式中:k =1,2,3。对于测试样本x ,可能不只一个决策函数结果为1,也可能所有的决策函数结果都为0,这时就无法由最终决策函数f (x )=arg max {f 1

(x ),f 2(x ),f 3(x )}对样本x 进行分类。决策盲区

如图2阴影部分所示。在图2中,

D k (x )=

∑支持向量

y i a k i

K (x ,x i

)

-b k

,k =1,2,3。

在类别较多时,“one against one ”方法,需要构建数目较多的子分类器。同时该方法也存在着决策盲区,也以3类分类为例,图3所示阴影部分为其决

5

2 第6期 范红波等:基于模糊支持向量机的发动机故障诊断方法

策盲区。在图3中,

D ij (x )=

∑支持向量

y p

a

ij p

K (x ,x p )-b ij

,

i,j =1,2,3,且i ≠j

。

而“one against others ”方法,虽然不存在分类盲区的现象,但是其在考虑故障概率优先级的前提下,将故障概率高的模式优先识别,因此存在自上而下的累计误差,如果某个子分类器发生分类错误,则会把这个错误传递给后续的子分类器,导致越靠近根部的子分类器,其分类性能越差。212 基于“one against all ”方法的模糊支持向量机多故障分类器的建立

比较“one against all ”和“one against one ”2种分类方法,一般来说,“one against one ”的[n (n -1)]/2分类器每次只涉及2类问题的数据计算,计算相对来说比较简单,“one against all ”的n 个分类器中的每一个都要用所有数据进行训练,计算复杂程度较大。但是在机械故障诊断中,故障样本不可能太多,样本数量是有限的,“one against all ”子分类器的训练计算复杂程度不会太大,同时“one against all ”需要构建的子分类器的数目也要比“one against one ”方法少得多,若对8类故障进行分类,“one a 2gainst one ”方法需要28个子分类器,而“one against

all ”方法只需要8个子分类器。因此,笔者采用

“one against all ”方法构建多故障分类器。

为解决“one against all ”方法存在的分类盲区,日本学者Takuya 和Shigeo 于2001年提出一种模糊支持向量机方法。笔者也将采用这种方法来克服S VM 多故障分类器中的分类盲区。

在该方法中,Takuya 和Shigeo 引入了模糊隶属函数。对于n 类分类问题,对于每个类i,在与最优分类超平面D j (x )=0的垂直方向上引入一维隶属度函数m ij (x )如下:

当i =j 时,

m ij (x )=

1,

D i (x ),

D i (x )>1,D i (x )≤1;(5)

当i ≠j 时,

m ij (x )=

1,

-D i (x ),

D i (x )>1,D i (x )≤1。

(6)

定义模式x 属于第i 类的隶属函数为:

m i (x )=m in j =1,2,…,n

m ij (x

)。

(7) 最终模式x 按照下面的原则进行分类:

g (x )=arg m ax i =1,2,…,n

m i (x ),

(8)

g (x )为最大隶属度所对应的类别。通过这种方法,

减少了不可分点的数目,减小了分类盲区,提高了支持向量机的分类效率。对比图2,3类分类示意图变为图4中实线所示。

3 模糊S VM 多故障分类器的应用

笔者针对某型自行火炮柴油发动机常见的8种

状态模式下的振动信号,即正常状态、气门间隙过大、气门间隙过小、喷油器堵死、喷油器卡死、开启压力过低、开启压力过高和喷油器弹簧折断进行故障诊断。每种模式对应的气缸盖振动信号消噪后,经过db6小波包3层分解,得到8个子频带,计算各子频带的能量,经归一化后形成该模式下特征向量。

6

2军械工程学院学报 2006

每种模式提取9个特征向量,8种模式共72个特征向量。

表1中列出了发动机8种模式下的2种特征向量,利用这些数据构建S VM多故障分类器。将每种模式的9个特征向量的前6个用于训练各个子分类器,后3个作为测试样本,以检验分类器的分类效果。

目前,支持向量机的核函数以及相应参数的选

表1 8种模式的2种特征向量

各种状态模式频带1频带2频带3频带4频带5频带6频带7频带8

正常状态013225010966010388010971010124011504010786012035 013202010969010389010973010124011513010789012041

气门间隙过大013817011349010413010699010187011376010794011365 013633011377010406010707010197011446010785011449

气门间隙过小012147010527010598011123010178011773011679011974 012159010527010598011123010178011772011669011973

喷油器堵死013923011196010623011191010084011033010567011383 013912011197010654011230010099011027010565011317

喷油器卡死015125010852010609010854010118010746010687011008 015192010879010604010834010114010726010669010982

开启压力过低014462011011010344010562010214012174010578010656 014552010989010344010570010206012137010595010608

开启压力过高014777010676010702011153010049010608010678011356 014702010690010692011176010048010616010690011387

喷油器弹簧折断014385011029010396010578010116011896010518011080 014310011057010403010564010113011912010537011104

择还没有统一、有效的规则。根据大量试验,笔者选

择径向基核函数k(x,y)=exp-‖x-y‖2

2σ2

,参

数σ取2,惩罚参数C取1000,分类器的训练结果如表2所示。

表3给出了子分类器3的详细信息。

表2 多故障分类器训练结果

子分类器支持向量/个子分类器支持向量/个11259

21168

32712

410816

表3 子分类器3训练详细结果

支持向量权重系数w分类阈值b 013202010969010389010973010124011513010789012041-3871563-7199 0122130104670105790111020101900118380116090120023871563-7199

多故障分类器训练完毕后,将48个训练样本带入分类器,其识别正确率100%,这说明支持向量机分类器具有良好的学习能力。将24个测试样本分别带入已经训练好的故障分类器,所有测试样本的分类结果均正确无误,部分结果如表4所示。这进一步说明支持向量机故障分类器,不仅具有良好的学习能力,还具有优越的泛化性能。

表4 部分测样本的分类结果

样本编号所属类别分类结果最大隶属度

3111

422014336

622012330

续表4

样本编号所属类别分类结果最大隶属度733019894

933019900

11441

1244019545

1355016975

1555017789

1666019958

17661

1977016822

21771

2488015835

72

第6期 范红波等:基于模糊支持向量机的发动机故障诊断方法

为了便于比较,针对相同的训练样本集和测试样本集,设计了基于BP神经网络的多故障分类器,采用8×17×8三层网络。其训练样本的识别正确率同样也为100%,说明其也有很好的学习能力,但是在对测试样本进行识别时其结果就不尽如人意,识别率仅为5813%,部分识别错误样本见表5。

表5 部分神经网络错误识别样本

样本编号理想输出实际输出

40 0 1010034,019693,018488

60 0 1010158,019986,018713

131 0 0019876,019790,010075

211 1 0019598,013656,010033

4 结论

基于模糊支持向量机的多故障分类器在发动机故障诊断中的应用,克服了发动机故障样本少的不足。即在小样本下,用该方法构建的多故障分类器不仅具有良好的学习能力,还具有优越的泛化性。为发动机的故障诊断提供了一条新的途径。

参考文献:

[1]黄席樾,张著洪,胡小兵,等.现代智能算法理论及

应用[M].北京:科学出版社,2005.387-416. [2]阳爱民.模糊分类模型的研究[D].上海:复旦大

学,2005.

[3]马笑潇,黄席樾,柴毅.基于S VM的二叉树多类分类

算法及其在故障诊断中的应用[J].控制与决策,

2003,18(3):272-273.

[4]Vapnik V.Statistical Learning Theory[M].N Y:

Sp ringer,1998.

[5]Shigeo Abe,Takuya I noue.Fuzzy Support Vect or Ma2

chines f or Pr oble m s[A].I n:Pr

oceedings of Eur opean

Sy mposiu m on Neural Net w orks[C].B ruges:ES ANN,

2002.113-118.

(责任编辑:韩红艳) (上接第13页)

4 结论

由沙土地等路面功率谱曲线可知,相同路面多

次采样数据的加速度功率谱曲线一致,说明采用

AR模型法进行频谱分析的可靠性。比较各路面的

路面谱曲线,可知沙土地和耕地路况要好于硬土地

路况,该结论与常识相符,说明AR模型法的合理

性。在对其它路面进行功率谱估计时,也可借鉴此

方法。同时通过频谱分析获得的各种路面的功率谱

等效随机样本[5],可作为悬挂系统减振性能实验

及计算机仿真模拟的路面数字样本。

参考文献:

[1]薛年喜.MAT LAB在数字信号处理中的应用[M].

北京:清华大学出版社,2003.

[2]G B7031-1987,车辆振动输入———路面平度表示方法

[S].

[3]余志生.汽车理论[M].北京:机械工业出版社,

2000.

[4]陈亚勇.MAT LAB信号处理详解[M].北京:人民邮

电出版社,2001.

[5]欧进萍.结构随机振动[M].北京:高等教育出版

社.

(责任编辑:韩红艳) 82军械工程学院学报 2006

支持向量机(SVM )原理及应用 一、SVM 的产生与发展 自1995年Vapnik (瓦普尼克)在统计学习理论的基础上提出SVM 作为模式识别的新方法之后,SVM 一直倍受关注。同年,Vapnik 和Cortes 提出软间隔(soft margin)SVM ,通过引进松弛变量i ξ度量数据i x 的误分类(分类出现错误时i ξ大于0),同时在目标函数中增加一个分量用来惩罚非零松弛变量(即代价函数),SVM 的寻优过程即是大的分隔间距和小的误差补偿之间的平衡过程;1996年,Vapnik 等人又提出支持向量回归 (Support Vector Regression ,SVR)的方法用于解决拟合问题。SVR 同SVM 的出发点都是寻找最优超平面(注:一维空间为点;二维空间为线;三维空间为面;高维空间为超平面。),但SVR 的目的不是找到两种数据的分割平面,而是找到能准确预测数据分布的平面,两者最终都转换为最优化问题的求解;1998年,Weston 等人根据SVM 原理提出了用于解决多类分类的SVM 方法(Multi-Class Support Vector Machines ,Multi-SVM),通过将多类分类转化成二类分类,将SVM 应用于多分类问题的判断:此外,在SVM 算法的基本框架下,研究者针对不同的方面提出了很多相关的改进算法。例如,Suykens 提出的最小二乘支持向量机 (Least Square Support Vector Machine ,LS —SVM)算法,Joachims 等人提出的SVM-1ight ,张学工提出的中心支持向量机 (Central Support Vector Machine ,CSVM),Scholkoph 和Smola 基于二次规划提出的v-SVM 等。此后,台湾大学林智仁(Lin Chih-Jen)教授等对SVM 的典型应用进行总结,并设计开发出较为完善的SVM 工具包,也就是LIBSVM(A Library for Support Vector Machines)。LIBSVM 是一个通用的SVM 软件包,可以解决分类、回归以及分布估计等问题。 二、支持向量机原理 SVM 方法是20世纪90年代初Vapnik 等人根据统计学习理论提出的一种新的机器学习方法,它以结构风险最小化原则为理论基础,通过适当地选择函数子集及该子集中的判别函数,使学习机器的实际风险达到最小,保证了通过有限训练样本得到的小误差分类器,对独立测试集的测试误差仍然较小。 支持向量机的基本思想:首先,在线性可分情况下,在原空间寻找两类样本的最优分类超平面。在线性不可分的情况下,加入了松弛变量进行分析,通过使用非线性映射将低维输

2011国家农业科技成果转化资金项目 1、基于质量追溯系统的大豆生产加工全程安全技术体系示范2011GB2B200007 张东杰 2011-2013 食品学院 2、模拟移动床色谱高效纯化猪小肠肝素的中试与转化2011GB2B200010 张丽萍 2011-2013 省农产品工程技术研究中心2011年国家自然科学基金项目立项情况

2011年省科技厅科研计划项目 1、农产品加工产业综合技术创新服务平台(省农产品加工工程技术研究中心) 2、黑龙江小麦增产保优高光效群体结构与栽培技术研究 GZ11B101 (指导)于立河 3、基于区域布局的玉米机械化高效高产栽培技术创新集成与示范 GZ11B107 (指导)杨克军 4、以沼肥提高谷子产量和品质技术研究 GZ11B108 (指导)王彦杰 5、水稻钵盘精量排种装置投种机理及试验研究 GZ11B109 (指导)陶桂香 6、玉米芽种振动式定向排序装置机理及试验研究 GZ11B110 (指导)毛欣 7、甜叶菊机械化栽植技术研究 GZ11B111 (指导)郭占斌 8、寒区棚室蔬菜专用杀虫水乳剂的制备及药效研 GZ11B112 (指导)冯世德 9、肝片吸虫病新型诊断方法的建立GZ11B208 (指导)闻晓波 10、阻断剂法生物合成番茄红素技术及分离纯化工艺研究 GZ11B401 (指导)汤华成 11、高产海藻糖合成酶选育及生产工艺的研究GZ11B402 (指导)曹冬梅 12、稻草纤维素基全生物降解地膜的研究GZ11B502 (指导)鹿保鑫 2011年重点实验室开放基金课题 1、纳滤技术在油田采出水深度脱盐处理中的应用(天津市水质科学与技术重点实验室) 食品学院 2011-2012 金丽梅 2、基于scFv分子的TGEV细胞受体靶向阻断剂的筛选(兽医生物技术国家重点实验室) 动物科技学院2011-2012 孙东波3、柽柳THCAP基因启动子的克隆及表达特性分析(林木遗传育种国家重点实验室开放基金) 农学院郭晓红2012-2014 4、黑龙江省农垦系统农产品物流信息化的发展现状及技术需求(北京农业信息技术研究中心) 信息技术学院任守华2011-2012

机器学习与SVM支持向量机 内容摘要: 机器学习是研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能,它是人工智能的核心,是使计算机具有智能的根本途径。基于数据的机器学习是现代智能技术中的重要方面,研究从观测数据出发寻找规律,利用这些规律对未来数据或无法观测的数据进行预测,包括模式识别、神经网络等在内,现有机器学习方法共同的重要理论基础之一是统计学。支持向量机是从统计学发展而来的一种新型的机器学习方法,在解决小样本、非线性和高维的机器学习问题中表现出了许多特有的优势,但是,支持向量机方法中也存在着一些亟待解决的问题,主要包括:如何用支持向量机更有效的解决多类分类问题,如何解决支持向量机二次规划过程中存在的瓶颈问题、如何确定核函数以及最优的核参数以保证算法的有效性等。本文详细介绍机器学习的基本结构、发展过程及各种分类,系统的阐述了统计学习理论、支持向量机理论以及支持向量机的主要研究热点,包括求解支持向量机问题、多类分类问题、参数优化问题、核函数的选择问题等,并在此基础上介绍支持向量机在人脸识别中的应用,并通过仿真实验证明了算法的有效性。 关键词:机器学习、支持向量机

机器学习的研究背景 机器学习概念的出现学习是人类具有的一种重要智能行为,但究竟什么是学习,长期以来却众说纷纭。社会学家、逻辑学家和心理学家都各有其不同的看法。按照人工智能大师西蒙的观点,学习就是系统在不断重复的工作中对本身能力的增强或者改进,使得系统在下一次执行同样任务或相同类似的任务时,会比现在做得更好或效率更高。西蒙对学习给出的定义本身,就说明了学习的重要作用。在人类社会中,不管一个人有多深的学问,多大的本领,如果他不善于学习,我们都不必过于看重他。因为他的能力总是停留在一个固定的水平上,不会创造出新奇的东西。但一个人若具有很强的学习能力,则不可等闲视之了。机器具备了学习能力,其情形完全与人类似。什么是机器学习?迄今尚没有统一的定义,由其名字可理解为机器学习是研究如何使用机器来模拟人类学习活动的一门学科。稍微严格的提法是机器学习是一门研究机器获取新知识和新技能,并识别现有知识的学问。这里所说的“机器”指的就是计算机,现在是电子计算机,以后还可能是种子计算机、光子计算机或神经计算机等等。机器能否像人类一样能具有学习能力呢?1959年美国的塞缪尔(Samuel)设计了一个下棋程序,这个程序具有学习能力,它可以在不断的对弈中改善自己棋艺。4年后,这个程序战胜了设计者本人。又过了3年,这个程序战胜了美国一个保持8年之久的常胜不败的冠军。这个程序向人们展示了机器学习的能力,提出了许多令人深思的社会问题与哲学问题。机器的能力是否能超过人的,很多持否定意见的人的一个主要论据是:机器是人造的,其性能和动作完全是由设计者规定的,因此无论如何其能力也不会超过设计者本人。这种意见对不具备学习能力的机器来说的确是对的,可是对具备学习能力的机器就值得考虑了,因为这种机器的能力在应用中不断地提高,过一段时间之后,设计者本人也不知它的能力到了何种水平。 支持向量机的研究背景 支持向量机(Support Vector Machine,SVM)方法是在统计学习理论(Statistical LearningTheory,SLT)基础上发展而来的一种机器学习方法,SVM在使用结构风险最小化原则替代经验风险最小化原则的基础上,又结合了统计学习、机器学习和神经网络等方面的技术,在解决小样本、非线性和高维的机器学习问题中表现出了许多特有的优势。它一方面可以克服神经网络等方法所固有的过学习和欠学习问题,另一方面又有很强的非线性分类能力,通过引入核函数,将输入空间的样本映射到高维特征空间,输入空间的线性不可分问题就转化为特征空间的线性可分问题。支持向量机被看作是对传统分类器的一个好的发展,并被证明可在保证最小化结构风险的同时,有效地提高算法的推广能力。随着计算机技术的蓬勃发展以及人们在各个领域对模式识别技术的需求与应用,计算机模式识别技术也有了很大的发展。模式识别就是设计一个能够对未知数据进行自动分类的方法,常用模式识别方法有统计识别方法、句法结构识别方法、模糊理论识别方法、神经网络识别方法、模板匹配识别方法和支持向量机的识别方法等。其中基于支持向量机的模式识别方法是目前最为有效的模式识别方法之一。V.Vapnik等人早在20世纪60年代就开始研究小样本情况下的机器学习问题,当时这方面的研究尚不十分完善,且数学上比较艰涩,大多数人难以理解和接受,直到90年代以前还没能够提出将其理论付诸实现的方法,加之当时正处在其他学习方法飞速发展的时期,因此这方面的研究一直没有得到足够的重视。直到90年代中期,小样本情况下的机器学习理论研究逐渐成熟起来,形成了较完善的理论体系——统计学习理论(Statistical Learning Theory,SLT)[2],而同时,神经网络等新兴

支持向量机算法 [摘要] 本文介绍统计学习理论中最年轻的分支——支持向量机的算法,主要有:以SVM-light为代表的块算法、分解算法和在线训练法,比较了各自的优缺点,并介绍了其它几种算法及多类分类算法。 [关键词] 块算法分解算法在线训练法 Colin Campbell对SVM的训练算法作了一个综述,主要介绍了以SVM为代表的分解算法、Platt的SMO和Kerrthi的近邻算法,但没有详细介绍各算法的特点,并且没有包括算法的最新进展。以下对各种算法的特点进行详细介绍,并介绍几种新的SVM算法,如张学工的CSVM,Scholkopf的v-SVM分类器,J. A. K. Suykens 提出的最小二乘法支持向量机LSSVM,Mint-H suan Yang提出的训练支持向量机的几何方法,SOR以及多类时的SVM算法。 块算法最早是由Boser等人提出来的,它的出发点是:删除矩阵中对应于Lagrange乘数为零的行和列不会对最终结果产生影响。对于给定的训练样本集,如果其中的支持向量是已知的,寻优算法就可以排除非支持向量,只需对支持向量计算权值(即Lagrange乘数)即可。但是,在训练过程结束以前支持向量是未知的,因此,块算法的目标就是通过某种迭代逐步排除非支持向时。具体的做法是,在算法的每一步中块算法解决一个包含下列样本的二次规划子问题:即上一步中剩下的具有非零Lagrange乘数的样本,以及M个不满足Kohn-Tucker条件的最差的样本;如果在某一步中,不满足Kohn-Tucker条件的样本数不足M 个,则这些样本全部加入到新的二次规划问题中。每个二次规划子问题都采用上一个二次规划子问题的结果作为初始值。在最后一步时,所有非零Lagrange乘数都被找到,因此,最后一步解决了初始的大型二次规划问题。块算法将矩阵的规模从训练样本数的平方减少到具有非零Lagrange乘数的样本数的平方,大减少了训练过程对存储的要求,对于一般的问题这种算法可以满足对训练速度的要求。对于训练样本数很大或支持向量数很大的问题,块算法仍然无法将矩阵放入内存中。 Osuna针对SVM训练速度慢及时间空间复杂度大的问题,提出了分解算法,并将之应用于人脸检测中,主要思想是将训练样本分为工作集B的非工作集N,B中的样本数为q个,q远小于总样本个数,每次只针对工作集B中的q个样本训练,而固定N中的训练样本,算法的要点有三:1)应用有约束条件下二次规划极值点存大的最优条件KTT条件,推出本问题的约束条件,这也是终止条件。2)工作集中训练样本的选择算法,应能保证分解算法能快速收敛,且计算费用最少。3)分解算法收敛的理论证明,Osuna等证明了一个定理:如果存在不满足Kohn-Tucker条件的样本,那么在把它加入到上一个子问题的集合中后,重新优化这个子问题,则可行点(Feasible Point)依然满足约束条件,且性能严格地改进。因此,如果每一步至少加入一个不满足Kohn-Tucker条件的样本,一系列铁二次子问题可保证最后单调收敛。Chang,C.-C.证明Osuna的证明不严密,并详尽地分析了分解算法的收敛过程及速度,该算法的关键在于选择一种最优的工

第38卷 第2期2011年2月计算机科学Computer Science Vo l .38No .2Feb 2011 到稿日期:2010-03-14 返修日期:2010-06-21 本文受江苏省自然科学基金项目(BK2009093),国家自然科学基金项目(60975039)资助。顾亚祥(1987-),男,硕士生,主要研究方向为数据挖掘、支持向量机,E -mail :gu yaxiang @yah oo .com .cn ;丁世飞(1963-),男,教授,博士生导师,主要研究方向为机器学习与数据挖掘、人工智能与模式识别等。 支持向量机研究进展 顾亚祥1 丁世飞1,2 (中国矿业大学计算机科学与技术学院 徐州221116) 1 (中国科学院计算技术研究所智能信息处理重点实验室 北京100080) 2 摘 要 基于统计学习理论的支持向量机(Suppo rt v ec to r machines ,SV M )以其优秀的学习能力受到广泛的关注。但 传统支持向量机在处理大规模二次规划问题时会出现训练时间长、效率低下等问题。对SV M 训练算法的最新研究成果进行了综述,对主要算法进行了比较深入的分析和比较,指出了各自的优点及其存在的问题,并且着重介绍了目前研究的新进展———模糊SV M 和粒度SV M 。接着论述了SV M 主要的两方面应用———分类和回归。最后给出了今后SV M 研究方向的预见。 关键词 支持向量机,训练算法,模糊支持向量机,粒度支持向量机中图法分类号 T P181 文献标识码 A Advances of Support Vector Machines (SVM ) G U Y a -xiang 1 DING Shi -fei 1,2 (Sch ool of Com pu ter Science and Tech nology ,C hina University of M ining and Techn ology ,Xuzh ou 221116,China ) 1 (Key Lab oratory of Intelligent In formation Processing ,Institute of Computing T ech nology ,Chinese Academy of S ciences ,Beijin g 100080,China ) 2 A bstract Suppo rt v ecto r machines (SV M )a re w idespread a ttended fo r its ex ce llent ability to learn ,tha t are based on statistical learning theo ry .But in dealing w ith lar ge -scale quadratic pr og ramming (Q P )problem ,traditio nal S VM will take to o long time of tr aining time ,and has lo w efficiency and so on .T his paper made a summa rize o f the new pro gr ess in the SV M training of alg o rithm ,and made analysis and compariso n o n main alg orithm ,pointed out the advantages and disadvantage s o f them ,focused on new pro g ress in the curre nt study ———F uzzy Suppo rt Vecto r M achine and G ranular Suppo r t Vecto r M achine .Then the two mainly applicatio ns ———cla ssifica tion and reg ression o f SV M wer e discussed .Fi -nally ,the article gav e the future r esear ch dir ec tions on S VM prediction . Keywords Suppo rt vecto r machine ,T r aining algo rithm ,Fuzzy SV M ,G r anula r SVM 支持向量机是Vapnik 等人于1995年首先提出的[1],它是基于VC 维理论和结构风险最小化原则的学习机器。它在解决小样本、非线性和高维模式识别问题中表现出许多特有的优势,并在一定程度上克服了“维数灾难”和“过学习”等传统困难,再加上它具有坚实的理论基础,简单明了的数学模型,使得支持向量机从提出以来受到广泛的关注,并取得了长足的发展。 支持向量机的训练算法归结为求解一个受约束的Q P 问题。对于小规模的Q P 问题,它体现出了十分优秀的学习能力,但当将其应用到大规模的QP 问题时,就会表现出训练速度慢、算法复杂、效率低下等问题。现在主要的训练算法都是将原有大规模的Q P 问题分解成一系列小的Q P 问题。但是如何进行分解以及选择合适的工作集是这些算法面临的主要问题,并且这也是各个算法优劣的表现所在。另外一些算法主要是增加函数项、变量或系数等方法使公式变形,使其具有某一方面的优势,或者有一定应用范围。 目前研究的大规模问题训练算法并不能够彻底解决所面 临的问题,因此在原有算法上进行合理的改进或者研究新的训练算法势在必行。本文对主要的训练算法以及SV M 扩展算法进行了综述,并在此基础上对未来研究的方向进行了展望。 1 SVM 基本理论 支持向量机最初是在模式识别中提出的。假定训练样本集合(x i ,y i ),i =1,…,l ,x i ∈R n ,y ∈{-1,+1},可以被超平面x ·w +b =0无错误地分开,并且离超平面最近的向量离超平面的距离是最大的,则这个超平面称为最优超平面[1]。而SVM 的主要思想是通过某种事先选择的非线性映射将输入向量x 映射到一个高维特征空间Z ,并在这个空间中构造最优超平面[2,3]。但是如何求解得到这个最优超平面以及如何处理高维空间中经常遇到的维数灾难问题?针对第一个问题,主要将训练SV M 算法归结成一个Q P 问题,并且该问题的解由下面的拉格朗日函数的鞍点给出: L (w ,b ,α)=1 2w 2-∑l i =1 αi {y i [(x i ·w )-b ]-1}

题目:支持向量机的算法学习 姓名: 学号: 专业: 指导教师:、 日期:2012年6月20日

支持向量机的算法学习 1.理论背景 基于数据的机器学习是现代智能技术中的重要方面,研究从观测数据(样本)出发寻找规律,利用这些规律对未来数据或无法观测的数据进行预测。迄今为止,关于机器学习还没有一种被共同接受的理论框架,关于其实现方法大致可以分为三种: 第一种是经典的(参数)统计估计方法。包括模式识别、神经网络等在内,现有机器学习方法共同的重要理论基础之一是统计学。参数方法正是基于传统统计学的,在这种方法中,参数的相关形式是已知的,训练样本用来估计参数的值。这种方法有很大的局限性,首先,它需要已知样本分布形式,这需要花费很大代价,还有,传统统计学研究的是样本数目趋于无穷大时的渐近理论,现有学习方法也多是基于此假设。但在实际问题中,样本数往往是有限的,因此一些理论上很优秀的学习方法实际中表现却可能不尽人意。 第二种方法是经验非线性方法,如人工神经网络(ANN)。这种方法利用已知样本建立非线性模型,克服了传统参数估计方法的困难。但是,这种方法缺乏一种统一的数学理论。 与传统统计学相比,统计学习理论(Statistical Learning Theory或SLT)是一种专门研究小样本情况下机器学习规律的理论。该理论针对小样本统计问题建立了一套新的理论体系,在这种体系下的统计推理规则不仅考虑了对渐近性能的要求,而且追求在现有有限信息的条件下得到最优结果。V. Vapnik 等人从六、七十年代开始致力于此方面研究[1],到九十年代中期,随着其理论的不断发展和成熟,也由于神经网络等学习方法在理论上缺乏实质性进展,统计学习理论开始受到越来越广泛的重视。 统计学习理论的一个核心概念就是 VC 维(VC Dimension)概念,它是描述函数集或学习机器的复杂性或者说是学习能力(Capacity of the machine)的一个重要指标,在此概念基础上发展出了一系列关于统计学习的一致性(Consistency)、收敛速度、推广性能(GeneralizationPerformance)等的重要结论。 支持向量机方法是建立在统计学习理论的 VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以

支持向量机算法推导及其分类的算法实现 摘要:本文从线性分类问题开始逐步的叙述支持向量机思想的形成,并提供相应的推导过程。简述核函数的概念,以及kernel在SVM算法中的核心地位。介绍松弛变量引入的SVM算法原因,提出软间隔线性分类法。概括SVM分别在一对一和一对多分类问题中应用。基于SVM在一对多问题中的不足,提出SVM 的改进版本DAG SVM。 Abstract:This article begins with a linear classification problem, Gradually discuss formation of SVM, and their derivation. Description the concept of kernel function, and the core position in SVM algorithm. Describes the reasons for the introduction of slack variables, and propose soft-margin linear classification. Summary the application of SVM in one-to-one and one-to-many linear classification. Based on SVM shortage in one-to-many problems, an improved version which called DAG SVM was put forward. 关键字:SVM、线性分类、核函数、松弛变量、DAG SVM 1. SVM的简介 支持向量机(Support Vector Machine)是Cortes和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力。 对于SVM的基本特点,小样本,并不是样本的绝对数量少,而是与问题的复杂度比起来,SVM算法要求的样本数是相对比较少的。非线性,是指SVM擅长处理样本数据线性不可分的情况,主要通过松弛变量和核函数实现,是SVM 的精髓。高维模式识别是指样本维数很高,通过SVM建立的分类器却很简洁,只包含落在边界上的支持向量。

收稿日期:2003-06-13 作者简介:姬水旺(1977)),男,陕西府谷人,硕士,研究方向为机器学习、模式识别、数据挖掘。 支持向量机训练算法综述 姬水旺,姬旺田 (陕西移动通信有限责任公司,陕西西安710082) 摘 要:训练SVM 的本质是解决二次规划问题,在实际应用中,如果用于训练的样本数很大,标准的二次型优化技术就很难应用。针对这个问题,研究人员提出了各种解决方案,这些方案的核心思想是先将整个优化问题分解为多个同样性质的子问题,通过循环解决子问题来求得初始问题的解。由于这些方法都需要不断地循环迭代来解决每个子问题,所以需要的训练时间很长,这也是阻碍SVM 广泛应用的一个重要原因。文章系统回顾了SVM 训练的三种主流算法:块算法、分解算法和顺序最小优化算法,并且指出了未来发展方向。关键词:统计学习理论;支持向量机;训练算法 中图分类号:T P30116 文献标识码:A 文章编号:1005-3751(2004)01-0018-03 A Tutorial Survey of Support Vector Machine Training Algorithms JI Shu-i wang,JI Wang -tian (Shaanx i M obile Communicatio n Co.,Ltd,Xi .an 710082,China) Abstract:Trai n i ng SVM can be formulated into a quadratic programm i ng problem.For large learning tasks w ith many training exam ples,off-the-shelf opti m i zation techniques quickly become i ntractable i n their m emory and time requirem ents.T hus,many efficient tech -niques have been developed.These techniques divide the origi nal problem into several s maller sub-problems.By solving these s ub-prob -lems iteratively,the ori ginal larger problem is solved.All proposed methods suffer from the bottlen eck of long training ti me.This severely limited the w idespread application of SVM.T his paper systematically surveyed three mains tream SVM training algorithms:chunking,de -composition ,and sequenti al minimal optimization algorithms.It concludes with an illustrati on of future directions.Key words:statistical learning theory;support vector machine;trai ning algorithms 0 引 言 支持向量机(Support Vector M achine)是贝尔实验室研究人员V.Vapnik [1~3]等人在对统计学习理论三十多年的研究基础之上发展起来的一种全新的机器学习算法,也使统计学习理论第一次对实际应用产生重大影响。SVM 是基于统计学习理论的结构风险最小化原则的,它将最大分界面分类器思想和基于核的方法结合在一起,表现出了很好的泛化能力。由于SVM 方法有统计学习理论作为其坚实的数学基础,并且可以很好地克服维数灾难和过拟合等传统算法所不可规避的问题,所以受到了越来越多的研究人员的关注。近年来,关于SVM 方法的研究,包括算法本身的改进和算法的实际应用,都陆续提了出来。尽管SVM 算法的性能在许多实际问题的应用中得到了验证,但是该算法在计算上存在着一些问题,包括训练算法速度慢、算法复杂而难以实现以及检测阶段运算量大等等。 训练SVM 的本质是解决一个二次规划问题[4]: 在约束条件 0F A i F C,i =1,, ,l (1)E l i =1 A i y i =0 (2) 下,求 W(A )= E l i =1A i -1 2 E i,J A i A j y i y j {7(x i )#7(x j )} = E l i =1A i -1 2E i,J A i A j y i y j K (x i ,x j )(3)的最大值,其中K (x i ,x j )=7(x i )#7(x j )是满足Merce r 定理[4]条件的核函数。 如果令+=(A 1,A 2,,,A l )T ,D ij =y i y j K (x i ,x j )以上问题就可以写为:在约束条件 +T y =0(4)0F +F C (5) 下,求 W(+)=+T l -12 +T D +(6) 的最大值。 由于矩阵D 是非负定的,这个二次规划问题是一个凸函数的优化问题,因此Kohn -Tucker 条件[5]是最优点 第14卷 第1期2004年1月 微 机 发 展M icr ocomputer Dev elopment V ol.14 N o.1Jan.2004

支持向量机算法介绍 众所周知,统计模式识别、线性或非线性回归以及人工神经网络等方法是数据挖掘的有效工具,已随着计算机硬件和软件技术的发展得到了广泛的应用。 但多年来我们也受制于一个难题:传统的模式识别或人工神经网络方法都要求有较多的训练样本,而许多实际课题中已知样本较少。对于小样本集,训练结果最好的模型不一定是预报能力最好的模型。因此,如何从小样本集出发,得到预报(推广)能力较好的模型,遂成为模式识别研究领域内的一个难点,即所谓“小样本难题”。支持向量机(support vector machine ,简称SVM )算法已得到国际数据挖掘学术界的重视,并在语音识别、文字识别、药物设计、组合化学、时间序列预测等研究领域得到成功应用。 1、线性可分情形 SVM 算法是从线性可分情况下的最优分类面(Optimal Hyperplane )提出的。所谓最优分类面就是要求分类面不但能将两类样本点无错误地分开,而且要使两类的分类空隙最大。 设线性可分样本集为),(i i y x ,d R x n i ∈=,,,1 ,}1,1{-+∈y ,d 维空间中线性判别函数的一般形式为 ()b x w x g T +=, 分类面方程是 0=+b x w T , 我们将判别函数进行归一化,使两类所有样本都满足()1≥x g ,此时离分类面最近的 样本的 ()1=x g ,而要求分类面对所有样本都能正确分类,就是要求它满足 n i b x w y i T i ,,2,1,01)( =≥-+。 (4)

式(4)中使等号成立的那些样本叫做支持向量(Support Vectors )。两类样本的分类空隙(Margin )的间隔大小: Margin =w /2(5) 因此,最优分类面问题可以表示成如下的约束优化问题,即在条件(4)的约束下,求函数 ())(2 1221w w w w T == φ(6) 的最小值。为此,可以定义如下的Lagrange 函数: ]1)([21),,(1 -+-=∑=b x w y a w w a b w L i T i n i i T (7) 其中,0≥i a 为Lagrange 系数,我们的问题是对w 和b 求Lagrange 函数的最小值。把式(7)分别对w 、b 、i a 求偏微分并令它们等于0,得: i i n i i x y a w w L ∑==?=??10 001 =?=??∑=i n i i y a b L 0]1)([0=-+?=??b x w y a a L i T i i i 以上三式加上原约束条件可以把原问题转化为如下凸二次规划的对偶问题: () ???? ? ???? ==≥∑∑∑∑====-0,,1,0.m a x 1111 21i n i i i j T i j i j n i n j i n i i y a n i a t s x x y y a a a (8) 这是一个不等式约束下二次函数机制问题,存在唯一最优解。若*i a 为最优解,则 ∑== n i i i i x y a w 1* * (9) *i a 不为零的样本即为支持向量,因此,最优分类面的权系数向量是支持向量的线性组合。

支持向量机SVM分类算法 SVM的简介 支持向量机(Support Vector Machine)是Cortes和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中[10]。 支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力[14](或称泛化能力)。 以上是经常被有关SVM 的学术文献引用的介绍,我来逐一分解并解释一下。 Vapnik是统计机器学习的大牛,这想必都不用说,他出版的《Statistical Learning Theory》是一本完整阐述统计机器学习思想的名著。在该书中详细的论证了统计机器学习之所以区别于传统机器学习的本质,就在于统计机器学习能够精确的给出学习效果,能够解答需要的样本数等等一系列问题。与统计机器学习的精密思维相比,传统的机器学习基本上属于摸着石头过河,用传统的机器学习方法构造分类系统完全成了一种技巧,一个人做的结果可能很好,另一个人差不多的方法做出来却很差,缺乏指导和原则。所谓VC维是对函数类的一种度量,可以简单的理解为问题的复杂程度,VC维越高,一个问题就越复杂。正是因为SVM关注的是VC维,后面我们可以看到,SVM解决问题的时候,和样本的维数是无关的(甚至样本是上万维的都可以,这使得SVM很适合用来解决文本分类的问题,当然,有这样的能力也因为引入了核函数)。 结构风险最小听上去文绉绉,其实说的也无非是下面这回事。 机器学习本质上就是一种对问题真实模型的逼近(我们选择一个我们认为比较好的近似模型,这个近似模型就叫做一个假设),但毫无疑问,真实模型一定是不知道的(如果知道了,我们干吗还要机器学习?直接用真实模型解决问题不就可以了?对吧,哈哈)既然真实模型不知道,那么我们选择的假设与问题真实解之间究竟有多大差距,我们就没法得知。比如说我们认为宇宙诞生于150亿年前的一场大爆炸,这个假设能够描述很多我们观察到的现象,但它与真实的宇宙模型之间还相差多少?谁也说不清,因为我们压根就不知道真实的宇宙模型到底是什么。 这个与问题真实解之间的误差,就叫做风险(更严格的说,误差的累积叫做风险)。我们选择了一个假设之后(更直观点说,我们得到了一个分类器以后),真实误差无从得知,但我们可以用某些可以掌握的量来逼近它。最直观的想法就是使用分类器在样本数据上的分类的结果与真实结果(因为样本是已经标注过的数据,是准确的数据)之间的差值来表示。这个差值叫做经验风险Remp(w)。以前的机器学习方法都把经验风险最小化作为努力的目标,但后来发现很多分类函数能够在样本集上轻易达到100%的正确率,在真实分类时却一塌糊涂(即所谓的推广能力差,或泛化能力差)。此时的情况便是选择了一个足够复杂的分类函数(它的VC维很高),能够精确的记住每一个样本,但对样本之外的数据一律分类错误。回头看看经验风险最小化原则我们就会发现,此原则适用的大前提是经验风险要确实能够逼近真实风险才行(行话叫一致),但实际上能逼近么?答案是不能,因为样本数相对于现实世界要分类的文本数来说简直九牛

ENVI4.3 支持向量机分类原理、操作及实例分析 一、支持向量机算法介绍 1.支持向量机算法的理论背景 支持向量机分类(Support Vector Machine或SVM)是一种建立在统计学习理论(Statistical Learning Theory或SLT)基础上的机器学习方法。 与传统统计学相比,统计学习理论(SLT)是一种专门研究小样本情况下及其学习规律的理论。该理论是建立在一套较坚实的理论基础之上的,为解决有限样本学习问题提供了一个统一的框架。它能将许多现有方法纳入其中,有望帮助解决许多原来难以解决的问题,如神经网络结构选择问题、局部极小点问题等;同时,在这一理论基础上发展了一种新的通用学习方法——支持向量机(SVM),已初步表现出很多优于已有方法的性能。一些学者认为,SLT和SVM正在成为继神经网络研究之后新的研究热点,并将推动机器学习理论和技术的重大发展。 支持向量机方法是建立在统计学习理论的VC维(VC Dimension)理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力。 支持向量机的几个主要优点有: (1)它是专门针对有限样本情况的,其目标是得到现有信息下的最优解而不仅仅是样本数趋于无穷大时的最优值; (2)算法最终将转化成为一个二次型寻优问题,从理论上说,得到的将是全局最优点,解决了在神经网络方法中无法避免的局部极值问题; (3)算法将实际问题通过非线性变换转换到高维的特征空间(Feature Space),在高维空间中构造线性判别函数来实现原空间中的非线性判别函数,特殊性质能保证机器有较 好的推广能力,同时它巧妙地解决了维数问题,其算法复杂度与样本维数无关; 2.支持向量机算法简介 通过学习算法,SVM可以自动寻找那些对分类有较大区分能力的支持向量,由此构造出分类器,可以将类与类之间的间隔最大化,因而有较好的推广性和较高的分类准确率。 最优分类面(超平面)和支持向量

计算机模式识别报告 支持向量机 一、SVM的介绍 支持向量机(Support Vector Machine,SVM)是Corinna Cortes和Vap nik[8]等于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。 支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小 原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力。 我们通常希望分类的过程是一个机器学习的过程。这些数据点是n维实空间中的点。我们希望能够把这些点通过一个n-1维的超平面分开。通常这个被称为线性分类器。有很多分类器都符合这个要求。但是我们还希望找到分类最佳的平面,即使得属于两个不同类的数据点间隔最大的那个面,该面亦称为最大间隔超平面。如果我们能够找到这个面,那么这个分类器就称为最大间隔分类器。 支持向量机将向量映射到一个更高维的空间里,在这个空间里建立有一个最大间隔超平面。在分开数据的超平面的两边建有两个互相平行的超平面。建立方向合适的分隔超平面使两个与之平行的超平面间的距离最大化。其假定为,平行超平面间的距离或差距越大,分类器的总误差越小。一个极好的指南是C.J.C Burges的《模式识别支持向量机指南》。 所谓支持向量是指那些在间隔区边缘的训练样本点。这里的“机(ma chine,机器)”实际上是一个算法。在机器学习领域,常把一些算法看做是一个机器。 支持向量机(Support vector machines,SVM)与神经网络类似,都是学习型的机制,但与神经网络不同的是SVM使用的是数学方法和优化技术。 支持向量机是由Vapnik领导的AT&TBell实验室研究小组在1963年提出的一种新的非常有潜力的分类技术,SVM是一种基于统计学习理论的模式识别方法,主要应用于模式识别领域。由于当时这些研究尚不十分完善,在解决模式识别问题中往往趋于保守,且数学上比较艰涩,这些研究一直没有得到充分的重视。直到90年代,统计学习理论 (Statistical Learni

1决策树(Decision Trees)的优缺点 决策树的优点: 一、决策树易于理解和解释.人们在通过解释后都有能力去理解决策树所表达的意义。 二、对于决策树,数据的准备往往是简单或者是不必要的.其他的技术往往要求先把数据一般化,比如去掉多余的或者空白的属性。 三、能够同时处理数据型和常规型属性。其他的技术往往要求数据属性的单一。 四、决策树是一个白盒模型。如果给定一个观察的模型,那么根据所产生的决策树很容易推出相应的逻辑表达式。 五、易于通过静态测试来对模型进行评测。表示有可能测量该模型的可信度。 六、在相对短的时间内能够对大型数据源做出可行且效果良好的结果。 七、可以对有许多属性的数据集构造决策树。 八、决策树可很好地扩展到大型数据库中,同时它的大小独立于数据库的大小。 决策树的缺点: 一、对于那些各类别样本数量不一致的数据,在决策树当中,信息增益的结果偏向于那些具有更多数值的特征。 二、决策树处理缺失数据时的困难。 三、过度拟合问题的出现。 四、忽略数据集中属性之间的相关性。 2 人工神经网络的优缺点 人工神经网络的优点:分类的准确度高,并行分布处理能力强,分布存储及学习能力强,对噪声神经有较强的鲁棒性和容错能力,能充分逼近复杂的非线性关系,具备联想记忆的功能等。人工神经网络的缺点:神经网络需要大量的参数,如网络拓扑结构、权值和阈值的初始值;不能观察之间的学习过程,输出结果难以解释,会影响到结果的可信度和可接受程度;学习时间过长,甚至可能达不到学习的目的。 3 遗传算法的优缺点 遗传算法的优点: 一、与问题领域无关切快速随机的搜索能力。 二、搜索从群体出发,具有潜在的并行性,可以进行多个个体的同时比较,鲁棒性好。 三、搜索使用评价函数启发,过程简单。 四、使用概率机制进行迭代,具有随机性。 五、具有可扩展性,容易与其他算法结合。 遗传算法的缺点: 一、遗传算法的编程实现比较复杂,首先需要对问题进行编码,找到最优解之后还需要对问题进行解码, 二、另外三个算子的实现也有许多参数,如交叉率和变异率,并且这些参数的选择严重影响解的品质,而目前这些参数的选择大部分是依靠经验.没有能够及时利用网络的反馈信息,故算法的搜索速度比较慢,要得要较精确的解需要较多的训练时间。 三、算法对初始种群的选择有一定的依赖性,能够结合一些启发算法进行改进。 4 KNN算法(K-Nearest Neighbour) 的优缺点