RHEL ENTERPRISE 6.4 多路径软件multi-path

配置操作手册

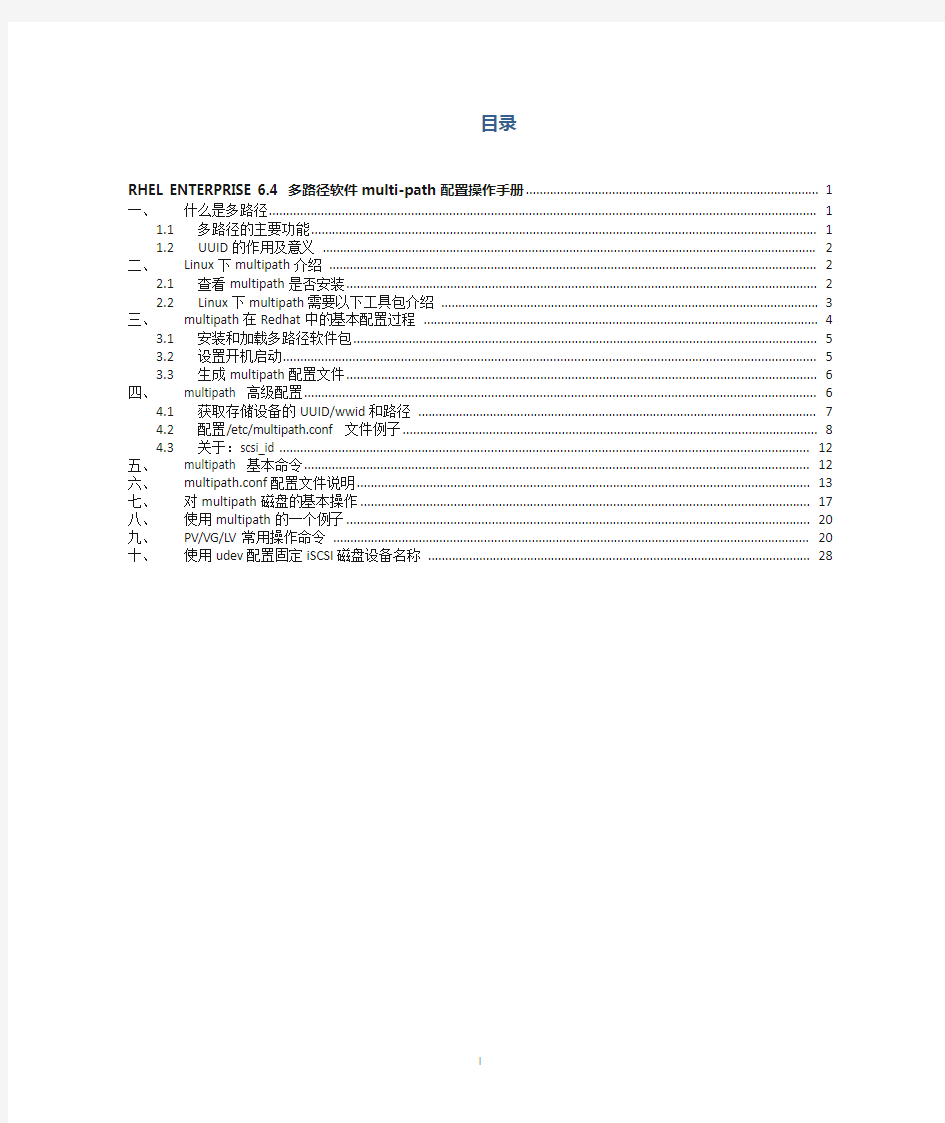

目录

一、什么是多路径 (1)

1.1 多路径的主要功能 (1)

1.2 UUID的作用及意义 (2)

二、Linux下multipath介绍 (2)

2.1 查看multipath是否安装 (2)

2.2 Linux下multipath需要以下工具包介绍 (2)

三、multipath在Redhat中的基本配置过程 (3)

3.1 安装和加载多路径软件包 (3)

3.2 设置开机启动 (4)

3.3 生成multipath配置文件 (4)

四、multipath 高级配置 (4)

4.1 获取存储设备的UUID/wwid和路径 (5)

4.2 配置/etc/multipath.conf 文件例子 (5)

4.3 关于:scsi_id (8)

五、multipath 基本命令 (8)

六、multipath.conf配置文件说明 (9)

七、对multipath磁盘的基本操作 (10)

八、使用multipath的一个例子 (12)

九、PV/VG/LV常用操作命令 (12)

十、使用udev配置固定iSCSI磁盘设备名称 (16)

一、什么是多路径

普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN 环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。

也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。

另外在linux中,同样的设备在重新插拔、系统重启等情况下,自动分配的设备名称并非总是一致的,它们依赖于启动时内核加载模块的顺序,就有可能导致设备名分配不一致。

1.1多路径的主要功能

多路径的主要功能就是和存储设备一起配合实现如下功能:

1.故障的切换和恢复

2.IO流量的负载均衡

3.磁盘的虚拟化

由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。

比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在,RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

1.2UUID的作用及意义

原因1:它是真正的唯一标志符

UUID为系统中的存储设备提供唯一的标识字符串,不管这个设备是什么类型的。如果你在系统中添加了新的存储设备如硬盘,很可能会造成一些麻烦,比如说启动的时候因为找不到设备而失败,而使用UUID则不会有这样的问题。

原因2:设备名并非总是不变的

自动分配的设备名称并非总是一致的,它们依赖于启动时内核加载模块的顺序。如果你在插入了USB盘时启动了系统,而下次启动时又把它拔掉了,就有可能导致设备名分配不一致。如何让它保持在任何系统中的标识,那就是UUID唯一性标识。

二、Linux下multipath介绍

2.1查看multipath是否安装

查看multipath是否安装如下:

[root@testvm1 disk]# rpm -qa |grep device-mapper

device-mapper-event-libs-1.02.74-10.el6.x86_64

device-mapper-multipath-libs-0.4.9-56.el6.x86_64

device-mapper-event-1.02.74-10.el6.x86_64

device-mapper-1.02.74-10.el6.x86_64

device-mapper-libs-1.02.74-10.el6.x86_64

device-mapper-multipath-0.4.9-56.el6.x86_64

2.2Linux下multipath需要以下工具包介绍

1、device-mapper-multipath:即multipath-tools。

主要提供multipathd和multipath等工具和multipath.conf等配置文件。这些工具通过device mapper 的ioctr的接口创建和配置multipath设备(调用device-mapper的用户空间库。创建的多路径设备会在/dev/mapper中)。

2、 device-mapper:

主要包括两大部分:内核部分和用户部分。

内核部分主要有device mapper核心(dm.ko)和一些target driver(md-multipath.ko)。

核心完成设备的映射,而target根据映射关系和自身特点具体处理从mappered device 下来的i/o。

同时,在核心部分,提供了一个接口,用户通过ioctr可和内核部分通信,以指导内核驱动的行为,比如如何创建mappered device,这些divece的属性等。

用户空间部分主要包括device-mapper这个包。其中包括dmsetup工具和一些帮助创建和配置mappered device的库。这些库主要抽象、封装了与ioctr通信的接口,以便方便创建和配置mappered device。

multipath-tool的程序中就需要调用这些库。

3、dm-multipath.ko和dm.ko:

dm.ko是device mapper驱动。它是实现multipath的基础。dm-multipath其实是dm的一个target驱动。

4、scsi_id:

包含在udev程序包中,可以在multipath.conf中配置该程序来获取scsi设备的序号。通过序号,便可以判断多个路径对应了同一设备。这个是多路径实现的关键。

scsi_id是通过sg驱动,向设备发送EVPD page80或page83 的inquery命令来查询scsi设备的标识。

但一些设备并不支持EVPD 的inquery命令,所以他们无法被用来生成multipath设备。但可以改写scsi_id,为不能提供scsi设备标识的设备虚拟一个标识符,并输出到标准输出。

multipath程序在创建multipath设备时,会调用scsi_id,从其标准输出中获得该设备的scsi id。在改写时,需要修改scsi_id程序的返回值为0。因为在multipath程序中,会检查该直来确定scsi id是否已经成功得到。

三、multipath在Redhat中的基本配置过程

3.1安装和加载多路径软件包

# rpm -ivh device-mapper-1.02.39-1.el5.rpm #安装映射包

# rpm -ivh device-mapper-multipath-0.4.7-34.el5.rpm #安装多路径包

或者使用yum进行安装

yum -y install device-mapper-multipath-libs.x86_64

yum -y isntall device-mapper-multipath.x86_64

3.2设置开机启动

#是否开机自启动

[root@testvm1 dev]# chkconfig --list|grep multipathd

multipathd 0:off 1:off 2:off 3:off 4:off 5:off 6:off

# chkconfig --level 2345 multipathd on #设置成开机自启动multipathd

# modprobe -l |grep multipath #来检查安装是否正常,内核中是否存在

kernel/drivers/md/dm-multipath.ko

至此进行了安装并设置了开机启动,但是multipath服务现在还没有启动,如果启动两种办法:

一、重启启动系统reboot ,开机自动载入内核并启动服务。

二、手工加载

# modprobe dm-multipath #加载到内核

#modprobe dm-round-robin

# service multipathd start #重启服务

3.3生成multipath配置文件

用/sbin/mpatchconf --enable生成multipath.conf

[root@testvm2 ~]# /sbin/mpatchconf --enable

[root@testvm2 ~]# ls /etc/multipath.conf

/etc/multipath.conf

(也可以按上面提示将/usr/share/doc/device-mapper-multipath-0.4.9/multipath.conf文件复制到/etc下)

四、multipath 高级配置

除了可以multipath命令来的默认配置multipath,比如映射设备的名称、multipath负载均衡。

也可以按照我们自己定义的方法来配置multipath。

首先,需要获取uuid

4.1获取存储设备的UUID/wwid和路径

通过/sbin/scsi_id -g -u -s /block/sdf 获取uuid/wwid

通过multipath -v3 命令查看,注意,会默认生成设备的路径。

multipath -v3

1、通过命令查看:

例如:/sbin/blkid

/sbin/blkid /dev/sdg1

但是只能看到已挂接文件系统的存储和分区的uuid,对于裸设备、未挂接的分区看不到uuid。

2、文件查看:ls -l /dev/disk/by-uuid

3、查看文件ls -l /dev/disk/by-id

其中红线部分既是uuid。

看路径ls -l /dev/disk/by-path/

4.2配置/etc/multipath.conf 文件例子

1、查看设备

# ls -l /dev/

2、获取设备的uuid

使用multipath 设备名生成设备路径,同时也获取了设备uuid

3、配置/etc/multipath.conf 文件

# vi /etc/multipath.conf

将这段中前面的#号删除,或复制后编辑成实际需要的路径配置。

配置了设备sdb 、sdc的多路径

运行multipath 命令生成路径文件(如果之前已经有该设备的路径文件,不会重新生成)

查看

multipath -ll

如果是通过光纤多条线路连接的会显示多条连接线路复合成一条链路,这个只是本地硬盘所以只有一条路径,类似下面的信息:

如果针对设备路径mpath0进行分区,

fdisk /dev/mapper/mpath0

fdisk对多路径软件生成的磁盘进行分区之后,所生成的磁盘分区并没有马上添加到/dev/目录下,

此时我们要重启IPSAN或者FCSAN的驱动.

如果是用iscsi-initiator来连接IPSAN的重启ISCSI服务就可以发现所生成的磁盘分区了

# service iscsi restart

如果是本地磁盘可以使用partprobe同步磁盘信息(分完区使用partprobe 同步磁盘信息(此命令让kernel会重新读取磁盘分区表,修改生效)或partprobe /dev/mapper/mpath0 单独同步)

partprobe /dev/mapper/mpath0

在/dev/mapper下已有了分区的路径文件

4.3关于:scsi_id

其包含在udev程序包中,可以在multipath.conf中配置该程序来获取scsi设备的序号。通过序号,便可以判断多个路径对应了同一设备。这个是多路径实现的关键。scsi_id是通过sg驱动,向设备发送EVPD page80或page83 的inquery命令来查询scsi设备的标识。但一些设备并不支持EVPD 的inquery命令,所以他们无法被用来生成multipath设备。但可以改写scsi_id,为不能提供scsi设备标识的设备虚拟一个标识符,并输出到标准输出。

multipath程序在创建multipath设备时,会调用scsi_id,从其标准输出中获得该设备的scsi id。

在改写时,需要修改scsi_id程序的返回值为0。因为在multipath程序中,会检查该直来确定scsi id是否已经成功得到。

五、multipath 基本命令

# multipath 自动生成设备路径,对于没有生成对于没有默认路径的磁盘设备或分区进行自动生成,

不会重复生成,包括磁盘的,以及磁盘上的分区的.

如果有磁盘sdb 、sdc,磁盘sdb分了四个区,运行multipath # multipath 设备名仅对该设备生成路径,不能针对设备的分区,针对的是设备

命令将自动生成设备路径,在/dev/mapper下会有mpatha、mpathap1 、mpathap2、

mpathap3、mpathap4、mpathb等路径。其中mpathap1 、mpathap2、mpathap3、mpathap4

是mpatha的分区。

实际生成中应先不进行分区,在磁盘的路径上再使用fdisk进行分区.

# multipath -v<1 234> #格式化路径,检测路径,合并,自动生成设备路径,对于没有生成对于没有默

认路径的磁盘设备或分区进行自动生成,不会重复生成,包括磁盘的,以及磁盘上的

分区的.

数字1 - 4,显示的信息不同。

# multipath -F #删除现有没有使用的路径,将没有挂载的文件系统、绑定为raw设备的路径删除# multipath -ll #查看多路径状态,不论是multipath.conf文件中配置的还是未配置而使用multipath命令

自动生成

#multipath ll #查看多路径状态,只显示multipath.conf文件中配置的.

六、multipath.conf配置文件说明

multipath.conf主要包括blacklist、multipaths、devices三部份的配置

blacklist配置

blacklist {

wwid 26353900f02796769

devnode "^(ram|raw|loop|fd|md|dm-|sr|scd|st)[0-9]*"

devnode "^hd[a-z]"

}

将所有设备加入黑名单

Multipaths部分配置multipaths

multipaths {

multipath {

wwid 3600508b4000156d700012000000b0000 #此值multipath -v3可以看到

alias yellow #映射后的别名,可以随便取

path_grouping_policy multibus #路径组策略

path_checker readsector0 #决定路径状态的方法

path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法

failback manual

rr_weight priorities

no_path_retry 5

}

}

Devices部分配置

devices {

device {

vendor "COMPAQ " #厂商名称

product "HSV110 (C)COMPAQ" #产品型号

path_grouping_policy multibus #默认的路径组策略

getuid_callout "/lib/udev/scsi_id --whitelisted --device=/dev/%n" #获得唯一设备号使用的默认程序

prio_callout "/sbin/acs_prio_alua %d" #获取有限级数值使用的默认程序

path_checker readsector0 #决定路径状态的方法

path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法

hardware_handler "0"

failback 15 #故障恢复的模式

rr_weight priorities

no_path_retry queue #在disable queue之前系统尝试使用失效路径的次数的数值

rr_min_io 100 #在当前的用户组中,在切换到另外一条路径之前的IO请求的数目}

device {

vendor "COMPAQ "

product "MSA1000 "

path_grouping_policy multibus

}

}

对一些设备名可以进行黑名单过滤,如:

blacklist {

devnode "^(ram|raw|loop|fd|md|dm-|sr|scd|st)[0-9]*"

devnode "^hd[a-z][[0-9]*]"

devnode "^cciss!c[0-9]d[0-9]*

devnode "^sda"

}

七、对multipath磁盘的基本操作

要对多路径软件生成的磁盘进行操作直接操作/dev/mapper/目录下的磁盘就行.

对多路径软件生成的磁盘进行分区,用fdisk对多路径软件生成的磁盘进行分区保存时会有一个报错,此报错不用理会。

# fdisk /dev/mapper/mpatha

在使用fdisk -l 查看

fdisk对多路径软件生成的磁盘进行分区之后,所生成的磁盘分区并没有马上添加到/dev/目录下,

此时我们要重启IPSAN或者FCSAN的驱动.

如果是用iscsi-initiator来连接IPSAN的重启ISCSI服务就可以发现所生成的磁盘分区了

# service iscsi restart

如果是本地磁盘可以使用partprobe同步磁盘信息

# ls -l /dev/mapper/

对通过网络方式连接的存储,如果需要在开机自动挂接到文件系统的/etc/fstab文件配置时,最好加上在Defaults前记得加上参数“_netdev”.

此参数的意思是说在网络服务启动完成后再执行mount操作,否则启动过程可能报错。如:

/dev/mapper/mpathap1 /data1 ext3 _netdev,defaults 0 0

对其中的一个分区进行格式化

将两个分区挂接到文件系统

将其他两个两个分区绑定到raw。

八、使用multipath的一个例子

九、PV/VG/LV常用操作命令

常用命令:

# pvcreate /dev/md0 #创建PV

pvcreate /dev/mapper/mpath{1,2,3,4,5} 注意括号中的用法

# pvscan 检索pv

#pvdisplay 显示pv信息,

后跟pv名称可显示该pv详细信息

pvremove /dev/sdb1 删除物理卷

# vgcreate LVM1 /dev/md0 #创建VG

创建vg,。一个vg中可以有一个pv也可以有多个pv,如:

# vgcreate vg1 /dev/mpath/mpath0 /dev/mpath/mpath1

# vgcreate vg2 /dev/mpath/mpath2

# vgcreate vg3 /dev/mpath/mpath3 /dev/mpath/mpath4 /dev/mpath/mpath5

# vgscan 检索vg

#vgdisplay 显示vg信息,

后跟vg名称可显示该vg详细信息

#vgextend vgxx pv名称将vg扩展pv

为VG添加新的PV使其增加容量# vgextend vg1 /dev/hda7

删除VG # vgremove vg1

# lvcreate -L 1.5TB -n data1 LVM1 #创建LV -L指扩展的意思创建一个lv ,使用的vg如:

# lvcreate -L 325GB -n data2 LVM1 #创建LV

# lvcreate -L 1G -n lv1 vg1

# lvcreate -L 15G -n lv2 vg2

# lvcreate -L 15G -n lv3 vg3

删除LV# lvremove /dev/vg1/lv1

# lvscan #查看LV信息

#lvdisplay 显示lv信息,

后跟lv名称可显示该lv详细信息。

#lvremove 删除LV(lvremove)后跟lv名称

# lvextend -L 1.5G /dev/vg1/lv1 例如将1G的/dev/vg1/lv1修改成1.5G:

说明:在这里-L 1.5G意思是扩大“到”1.5G,而不是扩大1.5G

当然,如果这个lv已经被格式化、被使用,这样还没有算完成,还要扩大文件系统,可以参考以下的办法:resize2fs /dev/vg1/lv1

lvextend.有两种方法,一个是指定在现有的空间上增加的大小,一个是指定将现有空间增加到多少。

在testlv现有空间的基础上再增加10G

lvextend -L +10G -f -r /dev/testvg/testlv

#此时testlv的大小是30G

将testlv的空间扩大到100G

lvextend -L 100G -f -r /dev/testvg/testlv

#此时testlv的大小是100G

减少lv大小:

不建议采取缩小LV的操作,如果非要缩小LV,建议采用以下步骤:

a. 备份原LV上的数据(fbackup或用其他软件,或tar到磁带机上或其他地方)

b. 删除原LV(lvremove)

c. 创建新LV(lvcreate)

d. 生成新的文件系统(newfs)

e. 恢复原LV上的数据(restore或用其他软件,或解tar回来)

而如果有OnlineJFS,可以采用以下办法:

首先检查文件系统是否有错e2fsck -f /dev/vg1/lv1

取消挂载umount /dev/vg1/lv1

调整文件系统大小:resize2fs /dev/vg1/lv1 1G

调整lv的大小: #lvreduce -L

lvreduce -L 1G /dev/vg1/lv1

调整文件系统大小:resize2fs /dev/vg1/lv1

挂载

mount -t ext3 /dev/vg1/lv1 /data1

要配置LVM,可以按以下步骤进行:

1. 创建和初始化物理卷(Physical Volume),通过pvcreate建立pv,即pv阶段;

2. 添加物理卷到卷组(Volume Group),使用vgcreate加入多个pv成为vg,即vg阶段;

3. 在卷组上创建逻辑卷(logical volume),使用lvcreate划分vg,成为一个或多个lv,即lv阶段;

针对创建的lv如果作为文件系统使用,还需要进行格式化,并挂接到文件系统上。

如,格式化:

mkfs.ext3 /dev/vg1/lv1

挂载到文件系统挂接点/data1

mount -t ext3 /dev/vg1/lv1 /data1

设置开机自动挂载:

编辑/etc/fstab

/dev/vg1/lv1 /data1 ext3 _netdev,defaults 0 0

如果需要修改LV的名字,则只要简单的做以下操作:

#umount /dev/vg01/lvol1

#mv /dev/vg01/lvol1 /dev/vg01/lvdata

#mv /dev/vg01/rlvol1 /dev/vg01/rlvdata

#mount /dev/vg01/lvdata

修改PV

有关PV的参数选项中,有一个是最常用的:-t,它是LVM对硬盘相应所等待的时间(timeout值),默认的值是30秒。可以用一下命令修改成120秒的timeout值:

#pvchange -t 120 /dev/dsk/cXtXdX

如果要去掉timeout,可以用以下命令:

#pvchange -t 0 /dev/dsk/cXtXdX

修改VG

vgchange命令可以用来激活/不激活VG。

其中max_pe这个参数只能在VG创建的时候指定,默认的PE数是1016。由于默认的pe_size的大小是4M,而如果采用默认的max_pe的话,我们只能使用到4G的空间。这在动辄上百G的硬盘时代,这些默认值肯定不符合需求了。

除了在创建PV的时候指定pe_size更大以外(但这有个缺点,就是容易造成空间的浪费),还能够在创建VG的时候指定max_pe,虽然默认值是1016,但是实际上,LVM会根据硬盘的实际大小和pe_size来决定max_pe——不过这又引起另外一个问题,例如:我们现在使用的硬盘是36G,而后来空间不够,我们又加了一个72G的硬盘,这个时候,由于在创建VG的时候,max_pe已经固定了,这可能就会导致空间的浪费。我们可以根据数据的增量,来考虑设定max_pe的值。而max_pe的值,可以在1——65535之间。

为了修改VG的名字,我们可以有两个办法来实现:

(即系统默认仅vg00是加了tag的,其他vg要激活必须手动在某一节点上加tag来激活卷)

修改名字要保证vg是激活

vgchange --addtag tagname emcvg02(加tag)

vgchange -a y emcvg02(激活卷)

改名过程:

改lv名

(此文件系统需umount状态)

lvchange -a n /dev/newvg2/newlv2(去激活才能改名)

lvrename /dev/vg2/lv2/dev/newvg2/newlv2

改vg名

vgrename emcvg02 newvgname

激活newlv2

lvchange -ay /dev/newvg2/newlv2

注意:

如果使用multipath进行设备多路径绑定,有部分multipath版本存在与lvm兼容的问题。当使用device-mapper 设备创建lvm完成,重启后,虽然lvm仍存在,但/dev/mapper下的设备丢失。可以参考:https://https://www.doczj.com/doc/7313466551.html,/ubuntu/+source/multipath-tools/+bug/230006

解决方法:

/etc/lvm/lvm.conf文件中加入:

types=["device-mapper", 1]

十、使用udev配置固定iSCSI磁盘设备名称

相同名称的设备文件在不同的系统中可能对应的是不同的磁盘。以下展示了一个实例,挂载到本地服务器的设备名称都是/dev/sdd,但对应的却不是同一个iSCSI磁盘。

节点1通过执行fdisk -l查看到的/dev/sdd设备文件大小情况如下:

1.Disk /dev/sdd: 5502 MB, 5502926848 bytes

2.170 heads, 62 sectors/track, 1019 cylinders

3.Units = cylinders of 10540 * 512 = 5396480 bytes

节点1/dev/sdd设备文件对应的LUN大小为5502MB。

节点2通过执行fdisk -l查看到的/dev/sdd设备文件大小情况如下:

1.Disk /dev/sdd: 1073 MB, 1073741824 bytes

2.34 heads, 61 sectors/track, 1011 cylinders

3.Units = cylinders of 2074 * 512 = 1061888 bytes

节点2/dev/sdd设备文件对应的LUN大小为1073MB。显然,两个节点/dev/sdd对应的并不是同一个设备。

如果在环境中使用/dev/sd*的设备文件来管理和使用存储,而相同名称的设备文件对应的iSCSI磁盘却是不同的,这样就会导致操作的失败。例如,在第一个节点将分区/dev/sdd1格式化成OCFS2挂载到某个节点,在第二个节点执行同样的挂载命令就会失败,因为第二个节点的/dev/sdd1分区和第一个节点并不是同一个分区,即使挂载成功也不是相同的共享存储。

Linux平台为了解决这个问题,使两个节点的设备文件都能相互对应,需要使用udev动态设备文件管理工具。它是一个默认安装并在系统启动时最先加载的工具,使用它能配置相应的设备加载规则,udev通过定义的规则来生成相应的设备文件。在指定规则下能够使用磁盘唯一标识的属性作为生成设备文件名称的一部分,就能在不同的节点保证相同名称的设备文件指向相同的iSCSI磁盘。

下面举例说明udev的配置方法。

udev的配置主目录是/etc/udev,包含以下文件和目录:

udev.conf文件。这是udev输出日志的配置文件,默认的配置是:udev_log=“err”,udev_log还可以被配置为info 或debug。一般默认即可,如果修改为info或debug将有大量的日志信息被输出。

rules.d目录。此目录是最重要的配置目录,里面包含的都是配置的udev加载规则,udev会根据配置的规则来生成相应的设备文件。所有的规则文件都必须以“.rules”作为扩展名。

scripts目录。此目录保存着加载规则需要执行的脚本。

在/etc/udev/rules.d目录下创建55-openiscsi.rules规则文件,将以下内容保存到文件中:

#/etc/udev/rules.d/55-openiscsi.rules

KERNEL=="sd*", BUS=="scsi", PROGRAM="/etc/udev/scripts/iscsidev.sh %b",SYMLINK+="iscsi/%c/part%n"

以上规则的含义是:为设备名以“sd”开头、设备的总线类型为scsi的设备创建链接文件。

PROGRAM参数包含的是一条命令,SYMLINK中的%c代表的是PROGRAM命令的输出结果,

SYMLINK参数表示链接文件存储的位置以及文件名,链接文件存放在/dev/iscsi/

下面是PROGRAM中指定的iscsidev.sh脚本。

#!/bin/sh

# FILE: /etc/udev/scripts/iscsidev.sh

BUS=${1}

HOST=${BUS%%:*}

[ -e /sys/class/iscsi_host ] || exit 1

file="/sys/class/iscsi_host/host${HOST}/device/session*/iscsi_session*/targetname"

target_name=$(cat ${file})

# This is not an open-scsi drive

if [ -z "${target_name}" ]; then

exit 1

fi

echo "${target_name##*.}"

以上脚本的含义是将表2-6中iSCSI Target IQN的最后一个小数点之后的名称提取出来,作为udev创建链接文件的目录。由于iSCSI Target的名称是唯一的,通过这种方式就能使所有节点通过udev新创建的链接文件指向相同的iSCSI磁盘。

将刚才创建的shell脚本修改为可执行文件:

# chmod 755 /etc/udev/scripts/iscsidev.sh

相应的配置工作结束之后,需要重启服务器链接文件才能生成。其实,配置udev和在生产环境中安装多路

径软件的效果是相同的,都是生成相应设备的链接文件,通过对链接文件的访问实现对设备的访问。重启服务器之后生成如下的文件结构。

[root@rhel1 iscsi]# pwd /dev/iscsi

[root@rhel1 iscsi]# tree

. |-- dbfile1 | `-- part -> ../../sda

|-- dbfile2 | `-- part -> ../../sdd

|-- fra1 | `-- part -> ../../sdb |-- ocrvdisk1 | `-- part -> ../../sdf |-- ocrvdisk2 | `-- part

-> ../../sdc `-- ocrvdisk3 `-- part -> ../../sde 6 directories, 6 files

节点2执行结果:

[root@rhel2 iscsi]# pwd /dev/iscsi

[root@rhel2 iscsi]# tree . |-- dbfile1

| `-- part -> ../../sdf |-- dbfile2 | `-- part -> ../../sdc |-- fra1 | `-- part -> ../../sda |-- ocrvdisk1 | `-- part -> ../../sde |-- ocrvdisk2 | `-- part -> ../../sdb `-- ocrvdisk3 `-- part -> ../../sdd

上面的执行结果dbfile1、dbfile2、fra1、ocrvdisk1、ocrvdisk2、ocrvdisk3表示的是目录,目录下面的part才是链接文件,链接文件对应的sd*就是链接对象。两个节点相同路径的链接文件对应的设备文件名不是完全相同的,但它们对应的共享磁盘确是完

全一致的,不同节点对相同链接文件的访问能够确保访问的是相同的共享存储。

链接文件是新生成的,并没有改动原有的以“sd”开头的设备文件,所以不同节点的/dev目录下以“sd”开头的设备文件依然不能正确地对应iSCSI磁盘。

多路径配置与管理

目录 1. 多路径概述 (1) 1.1 什么是多路径 (1) 1.2 业界的MPIO (1) 2. Windows Server 2008/2012 MPIO配置与管理 (1) 2.1 MPIO安装 (1) 3.2 MPIO配置 (5) 3.3 MPIO切换策略介绍 (13) 4. RedHat Linux MPIO配置与管理 (15) 4.1 多路径软件的安装 (15) 4.2 Multipath.conf配置文件解析 (16) 4.3 配置multipath.conf (19) 4.3.1 快速配置 (19) 4.3.2 高级配置 (19) 4.4 多路径管理 (24) 4.5 多路径磁盘的使用 (25) 5 各产品multipath.conf参数配置 (26) 5.1 INSPUR AS500G/E、AS520G/E (26) 5.1.1 Windows客户端 (26) 5.1.2 Linux客户端 (27) 6 Multipath Issues Troubleshooting (27) 6.1在群集中保持多路径设备名称一致 (27)

1. 多路径概述 1.1 什么是多路径 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。也就是说,主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。 多路径管理MPIO(Multi-Path),对支持MPIO的存储设备,MPIO自动发现、配置和管理多个存储路径,提供IO高可靠性和负载均衡。MPIO方案的实现有三个部分组成,分别为存储系统部分、存储软件部分和操作系统部分。 多路径的主要功能就是和存储设备一起配合实现如下功能: 1.故障的切换和恢复 2.IO流量的负载均衡 3.磁盘的虚拟化 在RedHat和Suse的2.6内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 1.2 业界的MPIO 由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。,业界比较常见的MPIO功能软件有EMC 的PowerPath,IBM的SDD,日立的Hitachi Dynamic Link Manager和广泛使用的linux开源软件device-mapper。 2. Windows Server 2008/2012 MPIO配置与管理 2.1 MPIO安装 Windows Server 2008系统包含MPIO软件,不需要使用其它的MPIO软件。具体安装步

RHEL ENTERPRISE 6.4 多路径软件multi-path 配置操作手册

目录 一、什么是多路径 (1) 1.1 多路径的主要功能 (1) 1.2 UUID的作用及意义 (2) 二、Linux下multipath介绍 (2) 2.1 查看multipath是否安装 (2) 2.2 Linux下multipath需要以下工具包介绍 (2) 三、multipath在Redhat中的基本配置过程 (3) 3.1 安装和加载多路径软件包 (3) 3.2 设置开机启动 (4) 3.3 生成multipath配置文件 (4) 四、multipath 高级配置 (4) 4.1 获取存储设备的UUID/wwid和路径 (5) 4.2 配置/etc/multipath.conf 文件例子 (5) 4.3 关于:scsi_id (8) 五、multipath 基本命令 (8) 六、multipath.conf配置文件说明 (9) 七、对multipath磁盘的基本操作 (10) 八、使用multipath的一个例子 (12) 九、PV/VG/LV常用操作命令 (12) 十、使用udev配置固定iSCSI磁盘设备名称 (16)

一、什么是多路径 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN 环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。 也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。 另外在linux中,同样的设备在重新插拔、系统重启等情况下,自动分配的设备名称并非总是一致的,它们依赖于启动时内核加载模块的顺序,就有可能导致设备名分配不一致。 1.1多路径的主要功能 多路径的主要功能就是和存储设备一起配合实现如下功能: 1.故障的切换和恢复 2.IO流量的负载均衡 3.磁盘的虚拟化 由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。 比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在,RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。

1.多路径的管理软件 Dynamic Link Manager是HDS配合各个主机厂家在主机高可用系统运行结构中提供的独特软件,安装在主机上,需要存储系统微码支持。它使用最优的调度算法使连接主机与磁盘阵列的各I/O通道间的I/O自动达到均衡,这样可提高系统的I/O吞吐量,提高整个系统的性能。Dynamic Link Manager另一个功能是I/O通道故障自动隔离。当主机与磁盘系统之间的I/O通道在链路环节上出现故障(如HBA卡、交换机、光缆、接口卡),Dynamic Link Manager能实现自动故障隔离,即切换至另一通路,应用I/O可以在正常的通道上继续进行,确保生产业务的连续性。当故障通道修复或替换完毕后,可在线激活,重新开始在原通路上工作。 HDLM可以在IBM AIX、 SUN Solaris、Microsoft Windows NT/2000、Linux及HP-UX等多种平台上提高系统的可靠性。并支持其他的高可靠性(HA)软件,如HACMP、SUN CLUSTER、VCS、MCS等。 在没有多路径功能支持下,主机只能通过某一个路径访问一个磁盘(LUN),系统存在单点故障的隐患。当该路径上的任何一个环节出现问题时,如主机HBA卡损坏、光纤或光纤交换机损坏等情况下,会造成主机无法访问磁盘的现象,而导致用户系统的中断。在多路径软件(如HDLM)的支持下,使用多条路径连接主机和存储系统,主机可以通过多个路径访问同一个磁盘,避免出现单点故障,提高整个系统的可靠性。 1.1.HDLM的主要功能 负载均衡(Load balancing) 当多条路径连接主机和存储系统时,HDLM把负载分配到各个路径,避免单个路径负载繁重而影响处理速度。

关于存储控制器的多路径机制 业界某些存储控制器支持ALUA多路径机制(或者说负载均衡技术),什么是ALUA多路径机制? ALUA即“Asymmetric Logical Unit Access(异步逻辑单元访问)”的缩写,它是前端控制器多路径机制之一。前端控制器多路径机制一定程度上决定存储的读写性能和可靠性,现有的前端控制器多路径机制可分为三大类:A/A:Symmetric Active/Acivie,对于特定的LUN来说,在它的路劲中,两个存储控制器的目标端口均处于主动/优化(active/optimized)状态。两个控制器之间实现高速互联的通讯,一个IO发到控制器端,两个控制器可同时参与处理;当一个控制器繁忙,系统不需要主机端的负载均衡软件参与就可以自动实现负载均衡。 ALUA:Asymmetric Active/Active,对于特定的LUN来说,在它的路径中,一个控制器的目标端口处于主动/优化(active/optimized)状态,另一个控制器的目标端口处于主动/非优化(active/unoptimized)状态。在某一个时刻,某个LUN只是属于某一个控制器,要想实现两边的负载均衡,就是将任务A扔给控制器A,将任务B扔给控制器B,对于同一个任务来说,任何时候只有一个控制器在控制。 A/P:Active/Passive,对于特定的LUN来说,在它的路径中,一个控制器的目标端口处于主动/优化(active/optimized)状态,另一个控制器的目标端口处于备用(standby)状态。其负载均衡及任务处理方式与ALUA类似。 Active/optimized、Active/unoptimized、Standby和Unavailable是目标端口的四种访问状态,在相应访问状态下,设备服务器(即阵列控制器)只能回应相应的命令标准(命令标准由ISO/IEC 14776-453文件Part 453:SPC-3制定),这就决定了在某一时刻是否可以通过某个目标端口访问逻辑单元。 目标端口的状态可以转换,目标端口从一个状态转换到另一个状态的过程称为过渡。 Active/optimized:目标端口有能力立即访问逻辑单元。 Active/unoptimized:只能回应相应的命令标准,可以过渡到Active/optimized。

Oracle RAC存储多路径的设置案例 以redhat6、centos6、oracle6及Asianux4为例 1.安装多路径的客户端 如果是FC SAN: yum install device-mapper device-mapper-multipath -y 如果是IP SAN: yum install iscsi-initiator-utils device-mapper device-mapper-multipath -y 2.设置一个多路径的配置文件: /usr/share/doc/device-mapper-multipath-0.4.9/multipath.conf的文件拷贝到/etc目录下面: 3.启动multipath服务 /etc/init.d/multipathd restart 4.将所有/etc/multipath/bindings 设置为一致,两边的内容一样 [root@rac81]# cat /etc/multipath/bindings # Multipath bindings, Version : 1.0 # NOTE: this file is automatically maintained by the multipath program. # You should not need to edit this file in normal circumstances. # # Format: # aliaswwid # mpatha 3600605b005c1b03019ae96a616049c04 mpathb 3600143801259f9320000500000360000 mpathc 3600143801259f9320000500000420000 mpathd 3600143801259f9320000500000460000 mpathe 3600143801259f93200005000004a0000 mpathf 3600143801259f93200005000003e0000 mpathg 3600143801259f93200005000003a0000 mpathh 3600143801259f93200005000004e0000 mpathi 3600143801259f9320000500000520000 mpathj 3600143801259f9320000500000560000 mpathk 3600143801259f93200005000005a0000 mpathl 3600143801259f93200005000005e0000 mpathm 3600143801259f93200005000007a0000 4.配置multipath.conf文件的磁盘项目 devices { device { vendor "HP" product "HSV2[01]0|HSV300|HSV4[05]0"

LINUX下多路径(multi-path)介绍及使用 2013-05-16 11:15:34| 分类:openfiler系统+fr|举报|字号订阅 一、什么是多路径 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。多路径的主要功能就是和存储设备一起配合实现如下功能: 1.故障的切换和恢复 2.IO流量的负载均衡 3.磁盘的虚拟化 由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 二、Linux下multipath介绍,需要以下工具包: 在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:

一:查看IBM存储盘的路径 1、查看MPIO的存储盘的路径 # lspath (适用于所有存储的MPIO路径查询) # mpio_get_config -Av (适用于DS3K/DS4K的MPIO路径查询) 2、查看RDAC存储盘的路径 # fget_config -Av (适用于DS3K/DS4K的RDAC路径查询) 3、查看SDDPCM存储盘的路径 # pcmpath query device (适用于DS6K/DS8K和v7000的SDDPCM路径查询) 4、查看当前操作系统自带的支持IBM存储的多路径软件 # manage_disk_drivers 5、将DS4700默认的多路径软件更改成RDAC # manage_disk_drivers -d DS4700 -o AIX_fcparray 二:MPIO路径的常用操作 1、查看单个盘的路径 # lspath -l hdisk3 # lspath -F "status name path_id parent connection" | grep -w hdisk3 2、MPIO路径控制 将fcs0卡下的hdisk2的路径禁用 # chpath -l hdisk2 -p fscsi0 -s disable 将fcs0卡下的hdisk2的路径启用 # chpath -l hdisk2 -p fscsi0 -s enable 3、其它参数 # chdev -l hdisk3 -a queue_depth=1 //如果ODM是1.0.1.0以上可以是任何数字 # chdev -l hdisk3 -a hcheck_interval=60 //链路失效检查时间间隔;如果等0,则不会自检 # chdev -l hdisk3 hcheck_mode=nonacive This parameter specifies which I/O paths should be monitored by the path health checking functionality. nonactive: This mode will check all failed I/O paths and all standby paths of used/opened devices. failed: This mode with check failed I/O paths only. enabled: This mode will check all enabled I/O paths which are opened. Note: Non-opened devices are not monitored. Also, this attribute is not being used at this time since path health checking is not enabled. This attribute can be ignored 4、修改链路优先级 lspath -AHE -l hdisk2 -p vscsi3 //查看链路优先级 # chpath -l hdisk3 -p fscsi0 -w 链路1 -a priority=1 # chpath -l hdisk3 -p fscsi0 -w 链路2 -a priority=2 5、处理故障 1)如果发现有很多路径是missing的,可以用cfgmgr重新扫描,如果还有missing的,可以用步骤2和2来激活路径; 2)如果要更换光纤线,可以该卡上的有的路径禁用,换完线后再启用,避免直接拨线产生的风险。

服务器多路径挂载FC存储 一、物理连接 1、打开服务器,将HBA卡插入插槽,并将光线连接到光线交换机。注意光线如果插反会无法 正常通信,也不会亮。 二、存储设置 2、进入存储管理界面,进行分配存储空间与映射 三、服务器设置 rpm常用命令参数说明: rpm -e xxxxx --nodeps ##### RPM强制卸载 rpm -ivh xxxxxx --replacepkgs ##### RPM将忽略软件包已被安装强行安装 rpm -ivh xxxxxx --replacefiles ##### RPM将忽略文件冲突强行安装 [root@DCXZM-SR43-NF5270M3 home]# rpm -e kpartx-0.4.9-87.el6.x86_64 –nodeps [root@DCXZM-SR43-NF5270M3 home]# rpm -ivh kpartx-0.4.9-93.el6.x86_64.rpm Preparing... ########################################### [100%] 1:kpartx ########################################### [100%] [root@DCXZM-SR43-NF5270M3 home]# rpm -ivh device-mapper-multipath-libs-0.4.9-93. el6.x86_64.rpm Preparing... ########################################### [100%] 1:device-mapper-multipath########################################### [100%] [root@DCXZM-SR43-NF5270M3 home]# rpm -ivh device-mapper-multipath-0.4.9-93.el6.x 86_64.rpm Preparing... ########################################### [100%] 1:device-mapper-multipath########################################### [100%] [root@DCXZM-SR43-NF5270M3 home]# service multipathd status multipathd is stopped [root@DCXZM-SR43-NF5270M3 home]# service multipathd start Starting multipathd daemon: [ OK ] [root@DCXZM-SR43-NF5270M3 home]# chkconfig multipathd on

常见的多路径管理软件 Multipath I/O (多路径) 在计算机存储技术里,多路径提供了容错和性能提高,在计算机系统里CPU有多条物理路径通道,块存储设备通过总线,控制器,交换设备以及桥接设备来连接。简单举例同一台计算机里1块SCSI磁盘连接2个SCSI控制器或者磁盘连接到两个FC端口。如果其中1个控制器,端口或交换设备故障,那操作系统就会自动切换I/O路径到冗余的控制器为应用程序使用,但这样可能会增加延迟. 一些多路径软件可以利用冗余的路径提高性能,例如: Dynamic load balancing 动态负载均衡 Traffic shaping 流量控制 Automatic path management 自动路径管理 Dynamic reconfiguration 动态设置 Multipath I/O software implementations 多路径软件工具 一些操作系统自带支持多路径功能,如下 SGI IRIX - using the LV, XLV and later XVM volume managers (1990s and onwards) AIX - MPIO Driver, AIX 5L 5.2 (October 2002) and later HP-UX 11.31 (2007) Linux - Device-Mapper Multipath . Linux kernel 2.6.13 (August 2005) OpenVMS V7.2 (1999) and later Solaris Multiplexed I/O (MPxIO), Solaris 8 (February 2000) and later Windows MPIO Driver, Windows Server 2003 and Windows Server 2008 (April 2003) FreeBSD - GEOM_FOX module Mac OS X Leopard and Mac OS X Leopard Server 10.5.2 Multipath software products: (软件产品) AntemetA. Multipathing Software solution for AIX for HP EVA Disk Arrays NEC PathManager EMC PowerPath FalconStor IPStor DynaPath Fujitsu Siemens MultiPath for Linux and Windows OS Fujitsu ETERNUS Multipath Driver (ETERNUSmpd) for Solaris, Windows, Linux and AIX. Hitachi HiCommand Dynamic Link Manager (HDLM) HP StorageWorks Secure Path NCR UNIX MP-RAS EMPATH for EMC Disk Arrays NCR UNIX MP-RAS RDAC for Engenio Disk Arrays ONStor SDM multipath IBM System Storage Multipath Subsystem Device Driver (SDD), formerly Data Path Optimizer Accusys PathGuard Infortrend EonPath Sun Multipath failover driver for Windows and AIX Sun StorEdge Traffic Manager Software, included in Sun Java StorEdge

LINUX下多路径(multi-path)介绍及使用2013-05-16 11:15:34| 分类:openfiler系统+fr|举报|字号订阅 一、什么是多路径 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。 多路径的主要功能就是和存储设备一起配合实现如下功能: 1.故障的切换和恢复 2.IO流量的负载均衡 3.磁盘的虚拟化 由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在,RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 二、Linux下multipath介绍,需要以下工具包: 在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下: 1、device-mapper-multipath:即multipath-tools。主要提供multipathd和multipath等工具和multipath.conf等配置文件。这些工具通过device mapper的

Windows Native MPIO存储多路径软件详解与应用 介绍 在Windows Server 2008和Windows Server 2008 R2中开始支持Native Multipathing(MPIO)软件作为操作系统的一个组件存在。EMC旗下的存储阵列都支持MPIO。本文将介绍MPIO和它饿安装与配置,以及如何使用Windows Server Native MPIO连接存储的方法和注意事项。 更多信息 安装与配置Windows Native MPIO: Native MPIO在Windows Server 2008和Windows Server 2008 R2内是一个可选安装项目,用户需要手动启动该功能才能开始使用Native MPIO软件。具体的方式是: 1. 打开Server Manager Management Console 2. 选择Features > Features Summary > Add Features , 打开Add Features Wizard 3. 点击Next选择“MultiPath I/O“、安装 4. 重启Windows 使用Native MPIO连接EMC VPLEX、Symmetrix、DMX、VNX和CLARiiON存储系统的时候需要进行适当配置,用户可以通过两个方法完成特定存储系统的连接配置。 方法1:手动输入Vender和Device ID(建议优先使用这种方法,如果所有的存储阵列没有被初始化连接,可以避免连续重启) ?使用MPIO Properties控制面板程序中的MPIO-ed Devices标签 ?选择Add然后输入vender和product ID(vender ID为8位字符,不满8位的用空格补全,product ID为16位,不满16位的用空格补全) ?比如在MPIO中claim VNX系列和CLARiiON的Raid 1的LUN,输入字符为

一、什么是multipath 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN环境,由于主机和存储通过了光纤交换机连接,这样的话,就构成了多对多的关系。也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。 既然,每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。多路径的主要功能就是和存储设备一起配合实现如下功能: 1. 故障的切换和恢复 2. IO流量的负载均衡 3. 磁盘的虚拟化 二、为什么使用multipath 由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。比如EMC公司基于linux下的多路径软件,就需要单独的购买license。 其中,EMC提供的就是PowerPath,HDS提供的就是HDLM,更多的存储厂商提供的软件,可参考这里。 当然,使用系统自带的免费多路径软件包,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 ※请与IBM的RDAC、Qlogic的failover驱动区分开,它们都仅提供了Failover的功能,不支持Load Balance负载均衡方式。但multipath根据选择的策略不同,可支持多种方式,如:Failover、Multipath等。 Failover的功能解释:通俗地说,即当A无法为客户服务时,系统能够自动地切换,使B能够及时地顶上继续为客户提供服务,且客户感觉不到这个为他提供服务的对象已经更换。这里的

操作系统linux6.4 存储:emc wmax 在emc划分好LUN后,通过配置(FC)将空间分配给linux服务器,在Linux系统中可以查看到emc的LUN,在linux中显示为一个物理分区emcpowera 因为存储有多路径冗余,所以在linux系统端需要安装配置多路径管理软件,linux系统自带了一个多路径管理软件multipath,EMC也有自己的多路径管理软件,这里介绍下emcpwerpath多路径的软件的安装和配置。由于emcpower与系统自带的多路径管理软件multipath冲突,所以需要将multipathd服务关闭。 将/etc/multipath.conf文件进行备份 #cp /etc/multipath.conf /etc/multipath.conf.bak 编辑/etc/multipath.conf文件 #vi /etc/multipath.conf 修改 blacklist { devnode "*" }

修改multipathd服务 # chkconfig multipathd off # chkconfig --list multipathd 生成新的开机启动加载的.img文件 #dracut /boot/initramfs-wo-DM-$(uname -r).img $(uname -r) 执行完后会生成.img文件/boot/目录下

修改开机启动的.img文件(修改前对其文件进行备份cp grub.conf grub.conf.bak) #vi grup.conf

将initrd修改为新生成的.img文件,保存后重启服务器,查看multipath的状态#multipath -ll multipath配置好后,开始安装emcpower 安装emcpower需要emc的key,可以通过已安装的服务器上产看 #powermt check registration 得到key之后,我们开始安装EMCpowerpath

EMC PowerPath多路径控制软件的部署和最佳实践 好消息,EMC中文论坛里新一期的“专家问答”活动已开启。EMC PowerPath一款常用于在各类主机和存储系统间进行多路径控制、管理和优化的软件,实现负载均衡和故障切换。从12月10日(周一)开始为期两周的时间里,我们将和大家一起讨论和分享有关EMC PowerPath 多路径控制软件的部署和最佳实践的话题和心得。以往所有已完成的“专家问答”活动可参考这个汇总贴。 沙发,哈 请问 powerpath 最多只可以做两条冗余的路径吗? 应该是每个逻辑单元(LUN)最多可以支持32个通道(Path),但是随着通道数量的增加,Powerpath需要消耗的系统资源也会随之增加。因此综合考虑冗余和计算性能的话,很少有用户会配置如此多数量的通道。 谢谢偶这边是配置两路的一般运作的时候是负载均衡的吗?还是只是用一路主的另外的备用呢? Powerpath会自动的做负载均衡。但需要注意的是,负载均衡不等于Round Robin算法,虽然这也是选择之一。Powerpath的负载均衡的考虑因素要复杂很多,不仅有I/O数量,还有I/O大小,队列深度,响应时间,等等,Powerpath会对每个I/O请求选择一条最优的通道,即使和上一个I/O请求是同一个。 powerpath在vmware上需不需要安装,谢谢,貌似vmware自带多路径软件!!! VMware对存储的管理是通过ESX来实现的。 ESX的VMKernel有自带的故障切换和多路径管理,但仍然可以安装PowerPath/VE以实现ESX 所连接存储的特有属性。

在VMWare (ESX以及ESXi)上的Powerpath软件为 Powerpath / VE,具体的安装方法是不一样的。并且管理工具(rpowermt)和许可证的管理方式也不同。 Powerpath/VE的管理由rpowermt命令控制,这个命令可以安装在一台windows或者Linux 操作系统上,通过TCP/IP网络对Vmware进行管理。 许可证也有几种,不像传统的Powerpath都是单机的。安装配置方式根据许可证的类型(Served, Unserved)也有不同,过程相对要复杂一点。 上述详细情况请参考一下Powerlink或者Supportzone上面的文档。 哦,那安装好powerpath之后,vmware自带的多路径功能是不是要屏蔽掉? VMWare有一个claimrule的功能,可以配置使用特定的软件来管理某一类阵列的设备。安装Powerpath/VE之后,EMC的阵列就会被Powerpath/VE管理了,没有被PP接管的设备才会被NMP接管。 哦,自动切换的,很方便!! 那么powerpath是要单独收费的嘛? vmware的pp很贵! 记得好像AX、CX的连个sp应该是active-standby?,针对同一个lun的访问,如果两台链路一个到spa,一个到spb,这种情况下powerpath应该提供的是链路冗余(主备,并不负载分担)的功能?是不是负载分担应该是在多个lun的时候分布于不同sp owner的时候宏观上看到的是负载分担?还是别的理解? 但是实际上,有VMWARE的基本上没什么人再买powerpath吧?

常用多路径软件汇总 前段时间研究了点多路径的东东,也看到了下面的资料,感觉不错,发给大家,有不完整的希望兄弟们补充,这里我先开个头了!~~~~~~~~~~~~~~~ ====================================================================== ======== Multipath I/O (多路径) 在计算机存储技术里,多路径提供了容错和性能提高,在计算机系统里CPU有多条物理路径通道,块存储设备通过总线,控制器,交换设备以及桥接设备来连接。 简单举例同一台计算机里1块SCSI磁盘连接2个SCSI控制器或者磁盘连接到两个FC端口。如果其中1个控制器,端口或交换设备故障,那操作系统就会自动切换I/O路径到冗余的控制器为应用程序使用,但这样可能会增加延迟. 一些多路径软件可以利用冗余的路径提高性能,例如: Dynamic load balancing 动态负载均衡 Traffic shaping 流量控制 Automatic path management 自动路径管理 Dynamic reconfiguration 动态设置 Multipath I/O software implementations 多路径软件工具 一些操作系统自带支持多路径功能,如下 SGI IRIX - using the LV, XLV and later XVM volume managers (1990s and onwards) AIX - MPIO Driver, AIX 5L 5.2 (October 2002) and later HP-UX 11.31 (2007) Linux - Device-Mapper Multipath . Linux kernel 2.6.13 (August 2005) OpenVMS V7.2 (1999) and later Solaris Multiplexed I/O (MPxIO), Solaris 8 (February 2000) and later Windows MPIO Driver, Windows Server 2003 and Windows Server 2008 (April 2003) FreeBSD - GEOM_FOX module Mac OS X Leopard and Mac OS X Leopard Server 10.5.2

Windows Server 2008多路径I/O 概述 面向高可用性的多路径支持 Windows Server? 2008 包括许多将运行Windows 服务器级操作系统的计算机与存储区域网络(SAN) 设备连接起来的增强功能。 集成的多路径I/O (MPIO) 支持是为基于Windows 的服务器与SAN 连接提供高可用性的众多增强功能之一。Microsoft MPIO 体系结构通过建立到存储阵列的多个会话或连接,支持iSCSI、光纤通道和串行连接的存储(SAS) SAN 连接。 多路径解决方案使用冗余的物理路径组件(适配器、电缆和交换机)在服务器与存储设备之间创建逻辑路径。如果这些组件中的一个或多个发生故障,导致路径无法使用,多路径逻辑就使用I/O 的备用路径以使应用程序仍然能够访问其数据。每个网络接口卡(在使用iSCSI 的情况下)或HBA都应通过使用冗余的交换机基础结构连接起来,以便在存储结构组件发生故障时能继续访问存储。 故障转移次数因存储供应商而异,并且可以通过使用Microsoft iSCSI 软件发起程序驱动程序中的计时器,或修改光纤通道主机总线适配器驱动程序参数设置进行配置。 Windows Server 2008 中的新MPIO 功能包含一个设备特定模块(DSM),该模块用于处理支持非对称逻辑单元访问(ALUA) 控制器模型(在SPC-3 中定义)的存储阵列,以及遵循Active/Active 控制器模型的存储阵列。 包含的DSM 的功能 Microsoft DSM 提供以下负载平衡策略。请注意,负载平衡策略通常取决于连接到基于Windows 的计算机的存储阵列的控制器模型(ALUA或实际Active/Active)。 故障转移不执行负载平衡。应用程序指定一个主路径和一组备用路径。主路径用于处理

CentOS 系统光纤连接存储的多路径配置及使用方法1、安装多路径软件包: device-mapper-1.02.67-2.el5 device-mapper-event-1.02.67.2.el5 device-mapper-multipath-0.4.7-48.el5 2、检查安装包的安装情况 #rpm –aq |grep multipath 3、安装上述多路径软件包 # rpm -ivh device-mapper-1.02.67-2.el5.x86_64.rpm # rpm -ivh device-mapper-event-1.02.67-2.el5.x86_64.rpm # rpm -ivh device-mapper-multipath-0.4.7-48.el5.x86_64.rpm 安装过程中可能会提示需要安装其他的关联软件包: 主要与多路径软件相关联的软件包如下: libaio-0.3.107-10.e16.i686.rpm libaio-0.3.107-10.e16.x86_64.rpm libaio-devel-0.3.107-10.e16.i686.rpm libaio-devel-0.3.107-10.e16.x86_64.rpm 如服务器可以连接公网的话,可直接用yum来安装,yum会自动将相关联的软件安装上. #yum install y device-mapper* 检查安装情况 #rpm –aq|grep multipath 安装完成后需重启机器. 4、配置多路径软件multipath 4.1 、将多路径软件添加至内核模块中 #modprobe dm-multipath #modprobe dm-round-robin 检查内核添加情况 #lsmod |grep multipath 4.2、将多路径软件multipath设置为开机自启动 #chkconfig --level 2345 multipathd on 检查 #chkconfig --list|grep multipathd 启动multipath服务 #service multipathd restart