人工神经网络控制 摘要: 神经网络控制,即基于神经网络控制或简称神经控制,是指在控制系统中采用神经网络这一工具对难以精确描述的复杂的非线性对象进行建模,或充当控制器,或优化计算,或进行推理,或故障诊断等,亦即同时兼有上述某些功能的适应组合,将这样的系统统称为神经网络的控制系统。本文从人工神经网络,以及控制理论如何与神经网络相结合,详细的论述了神经网络控制的应用以及发展。 关键词: 神经网络控制;控制系统;人工神经网络 人工神经网络的发展过程 神经网络控制是20世纪80年代末期发展起来的自动控制领域的前沿学科之一。它是智能控制的一个新的分支,为解决复杂的非线性、不确定、不确知系统的控制问题开辟了新途径。是(人工)神经网络理论与控制理论相结合的产物,是发展中的学科。它汇集了包括数学、生物学、神经生理学、脑科学、遗传学、人工智能、计算机科学、自动控制等学科的理论、技术、方法及研究成果。 在控制领域,将具有学习能力的控制系统称为学习控制系统,属于智能控制系统。神经控制是有学习能力的,属于学习控制,是智能控制的一个分支。神经控制发展至今,虽仅有十余年的历史,已有了多种控制结构。如神经预测控制、神经逆系统控制等。 生物神经元模型 神经元是大脑处理信息的基本单元,人脑大约含1012个神经元,分成约1000种类型,每个神经元大约与102~104个其他神经元相连接,形成极为错综复杂而又灵活多变的神经网络。每个神经元虽然都十分简单,但是如此大量的神经元之间、如此复杂的连接却可以演化出丰富多彩的行为方式,同时,如此大量的神经元与外部感受器之间的多种多样的连接方式也蕴含了变化莫测的反应方式。 图1 生物神经元传递信息的过程为多输入、单输出,神经元各组成部分的功能来看,信息的处理与传递主要发生在突触附近,当神经元细胞体通过轴突传到突触前膜的脉冲幅度达到一定强度,即超过其阈值电位后,突触前膜将向突触间隙释放神经传递的化学物质,突触有两

1 第8章 神经网络的参数优化设计 在神经网络的泛化方法中,研究最多的是前馈神经网络的结构优化设计方法(剪枝算法、构造算法及进化算法等,我们将在以后各章讨论)。除了结构设计,其余前馈神经网络的泛化方法还有主动学习、最优停止法、在数据中插入噪声、神经网络集成及提示学习方法等,由于这些方法中神经网络的结构是固定的,因此神经网络性能是通过参数优化改善的,我们称这些方法为神经网络的参数优化设计方法。本章介绍最主要的参数优化设计方法,并给出了每种方法的算法实现和仿真例子。 8.1 主动学习 8.1.1 原理 按照学习机器对训练样本的处理方式,可将学习方式分为两类:被动学习方式和主动学习方式。被动学习是常用的学习方式,常被称为“从样本中学习” (Learning from samples ),该方式被动地接受训练样本,并通过学习从这些样本中提取尽可能多的信息。与被动学习相反,主动学习属于更高层次的、具有潜意识的学习。主动学习对训练样本的选择是主动的,通常通过对输入区域加以限制,有目的地在冗余信息较少的输入区域进行采样,并选择最有利于提高学习机器性能的样本来训练分类器,从而提高了整个训练样本集的质量。由上一章的讨论,训练样本质量对神经网络的泛化能力有极大影响,甚至超过网络结构对泛化能力的影响。因此采用主动学习方法,是改进神经网络泛化能力的一个重要方法。 主动学习机制大部分用于分类或概念学习[Baum1991,HwCh1990,SeOp1992]。在单概念学习中,Mitchell[Mitch1982]关于版本空间(Version Space)的论述有着较大的影响。下面,我们先简要介绍一下这一理论。 如果X 为一线性空间,概念c 定义为X 中点的集合。对目标概念t ,训练样本可写为()()x x t ,,其中X ∈x 为样本输入,()x t 为对x 的分类。如果t ∈x ,则()1=x t ,称()()x x t ,为t 的正样本;如果t ?x ,则()0=x t ,此时称()()x x t ,为t 的负样本。显然,对线性空间内的任何两个可分概念1c 和2c ,如果()()x x 1,c 是1c 的正样本(负样本),则()()x x 11,c ?必然是2c 的负样本(正样本),即任意两个可分概念的正负样本之间可以互相转换。如果某概念c 对x 的分类与目标概念对其的分类()x t 相等,即()()x x t c =,

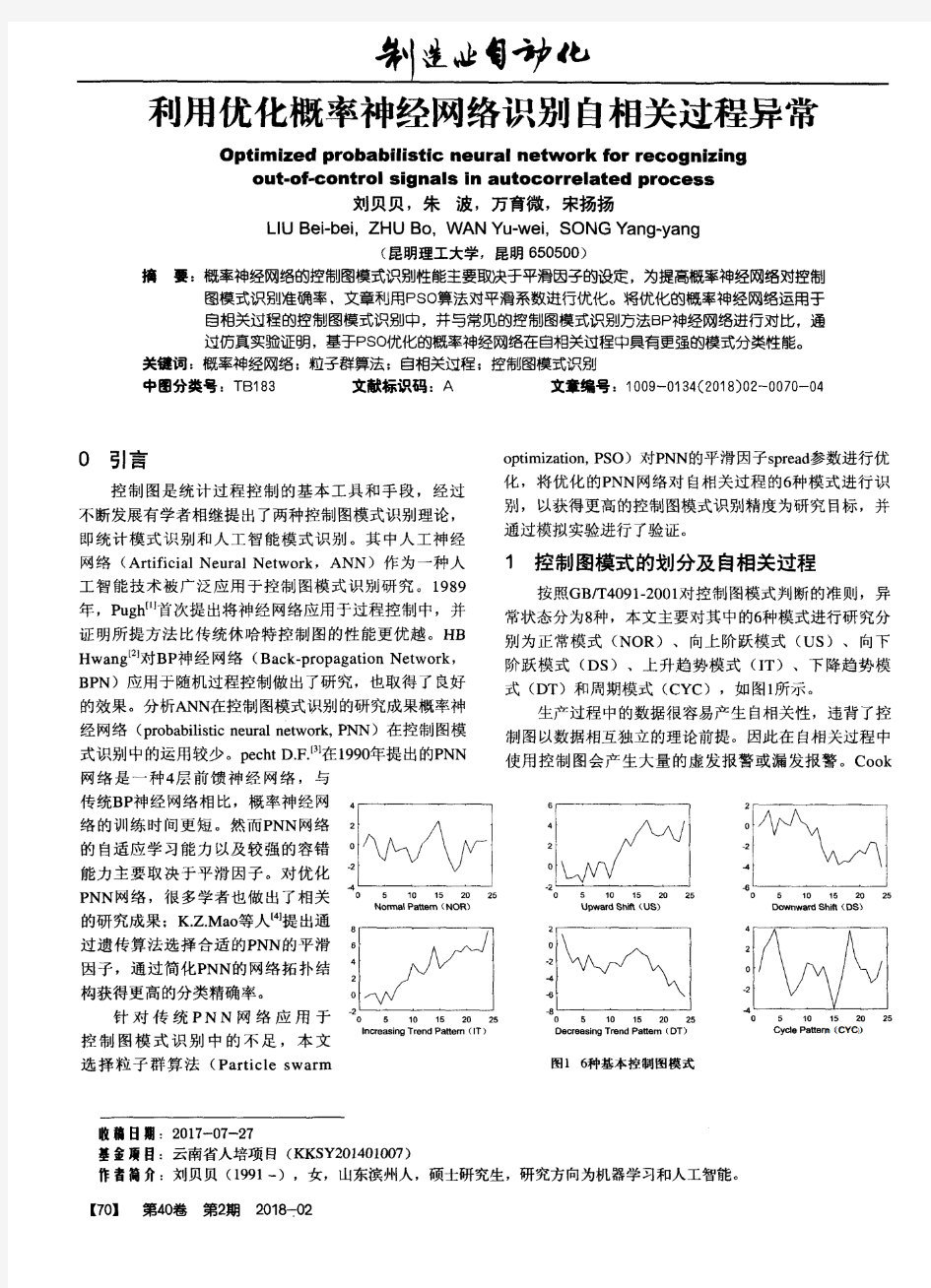

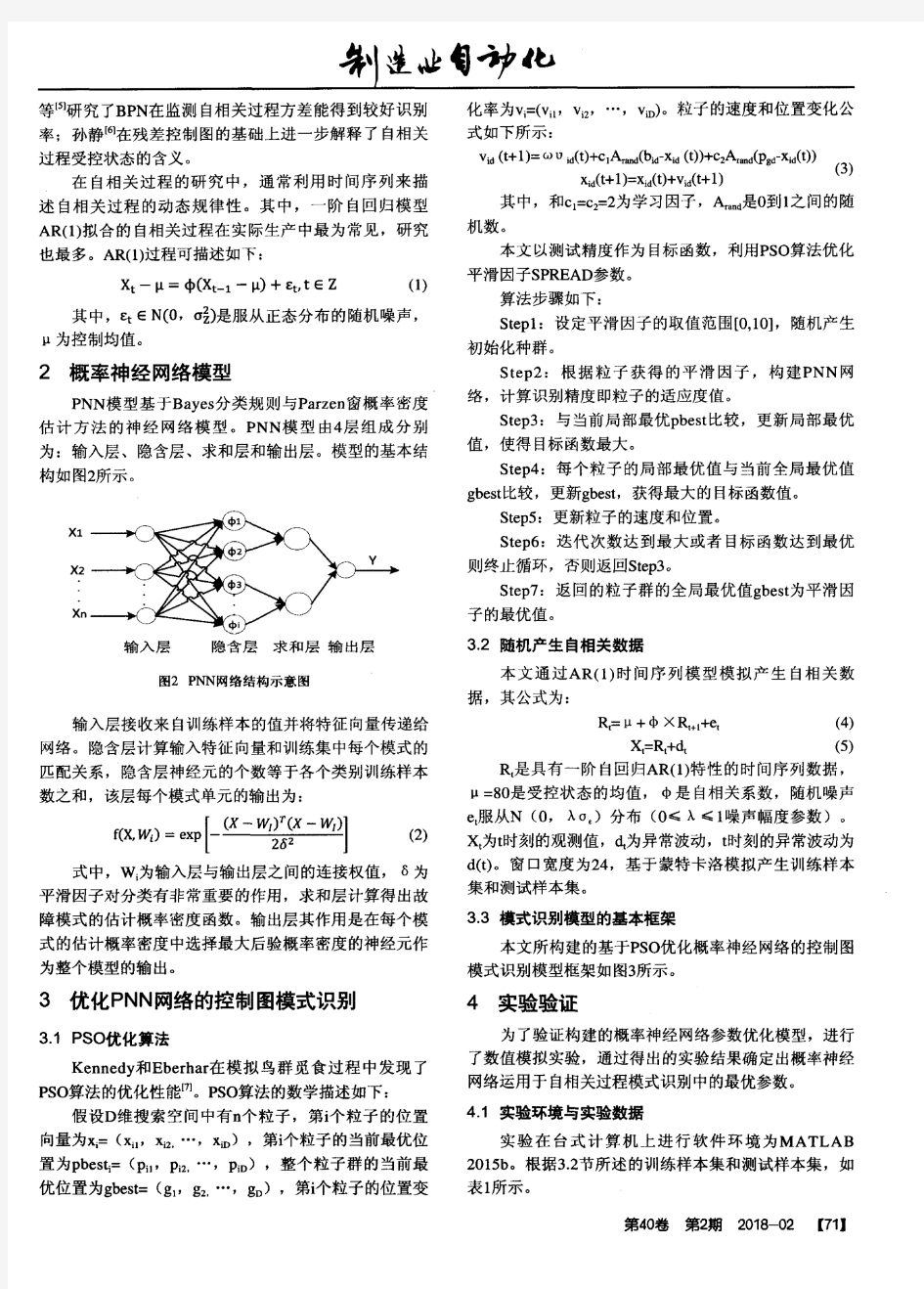

目录 摘要 (1) 1概率神经网络 (1) 1.1网络模型 (1) 1.2分类思想 (2) 1.3 PNN分类的优点 (3) 2 PNN网络的构建 (3) 2.1 构建步骤 (3) 2.2 Matlab中的主要代码 (4) 3 Matlab编程及结果分析 (4) 3.1 Matlab中的编程 (4) 3.2 仿真结果分析 (7) 3.3 结论 (10) 4 总结 (11) 参考文献 (12)

PNN神经网络聚类法 摘要 近几年来,对于神经网络的研究越来越普遍,神经网络在我们社会生活中的作用也越来越不可替代,尤其在模式识别的领域里,更是有着举足轻重的作用。 酒是由多种成分按不同的比例构成的,兑酒时需要三种原料(X,Y,Z),现在已测出不同酒中三种原料的含量,本文正是基于PNN神经网络针对酒中X、Y、Z三种含量的不同来对酒进行识别分类。本文首先介绍了PNN神经网络的网络模型以及它对不同的模式进行分类判别的思想,然后针对本文的酒类判别的要求来构建PNN网络,并在Matlab中进行编程仿真,最后对所仿真的结果进行了分析比较,最后找出最优的模式分类。 1概率神经网络 概率神经网络(Probabilistic Neural Networks,PNN)是由D. F. Specht在1990年提出的。主要思想是用贝叶斯决策规则,即错误分类的期望风险最小,在多维输入空间内分离决策空间。它是一种基于统计原理的人工神经网络,它是以Parzen 窗口函数为激活函数的一种前馈网络模型。PNN吸收了径向基神经网络与经典的概率密度估计原理的优点,与传统的前馈神经网络相比,在模式分类方面尤其具有较为显著的优势。 1.1网络模型 PNN的结构如图1所示,共由四层组成。 图1 概率神经网络结构

人工智能实验报告 实验六基于神经网络的优化计算实验 一、实验目的: 掌握连续Hopfield神经网络的结构和运行机制,理解连续Hopfield神经网络用于优化计算的基本原理,掌握连续Hopfield神经网络用于优化计算的一般步骤。 二、实验原理 连续Hopfield神经网络的能量函数的极小化过程表示了该神经网络从初始状态到稳定状态的一个演化过程。如果将约束优化问题的目标函数与连续Hopfield神经网络的能量函数对应起来,并把约束优化问题的解映射到连续Hopfield神经网络的一个稳定状态,那么当连续Hopfield神经网络的能量函数经演化达到最小值时,此时的连续Hopfield神经网络的稳定状态就对应于约束优化问题的最优解。 三、实验条件: VC++6.0。 四、实验内容: 1、参考求解TSP问题的连续Hopfield神经网络源代码,给出15个城市和20个城市的求解结果(包括最短路径和最佳路线),分析连续Hopfield神经网络求解不同规模TSP问题的算法性能。 2、对于同一个TSP问题(例如15个城市的TSP问题),设置不同的网络参数,分析不同参数对算法结果的影响。 3、上交源代码。

五、实验报告要求: 1、画出连续Hopfield神经网络求解TSP问题的流程图。 2、根据实验内容,给出相应结果及分析。 (1)15个城市(测试文件TSP15.TXT)

tsp15.txt 最短路程371 最佳路线 →→→→→→→→→→→→→→→1914861351534712210111 (2)20个城市(测试文件TSP20.TXT) tsp20.txt 最短路程349 最佳路线 →→→→→→→→→→→→→→→→→→→→→141618971315111735124289191610201 3、总结连续Hopfield神经网络和遗传算法用于TSP问题求解时的优缺点。 遗传算法易出现早熟收敛和收敛性差的缺点。 Hopfield算法对高速计算特别有效,但网络不稳定。 用Hopfield解TSP问题效果并不理想。相对前面的遗传算法解TSP 性能有相当大差距。

概率神经网络概述 概率神经网络(Probabilistic Neural Network ,PNN )是由D. F. Specht 在1990年提出的。主要思想是贝叶斯决策规则,即错误分类的期望风险最小,在多维输入空间内分离决策空间。它是一种基于统计原理的人工神经网络,它是以Parazen 窗口函数为激活函数的一种前馈网络模型。PNN 吸收了径向基神经网络与经典的概率密度估计原理的优点,与传统的前馈神经网络相比,在模式分类方面尤其具有较为显著的优势。 1.1 概率神经网络分类器的理论推导 由贝叶斯决策理论: w w w i j i x then i j x p x p if ∈≠?>→ → → , )|()|( (1-1) 其中 )|()()|(w w w i i i x p p x p → →=。 一般情况下,类的概率密度函数)|(→ x p w i 是未知的,用高斯核的Parzen 估 计如下: )2exp(1 1 )|(2 2 1 2 2σ σ π→ → -∑ - = =→ x x N w ik N i k l l i i x p (1-2) 其中,→ x ik 是属于第w i 类的第k 个训练样本,l 是样本向量的维数,σ是 平滑参数,N i 是第w i 类的训练样本总数。 去掉共有的元素,判别函数可简化为: ∑-=→ → → - = N ik i k i i i x x N w g p x 1 2 2 )2exp()()(σ (1-3)

1.2 概率神经元网络的结构模型 PNN 的结构以及各层的输入输出关系量如图1所示,共由四层组成,当进行并行处理时,能有效地进行上式的计算。 图1 概率神经网络结构 如图1所示,PNN 网络由四部分组成:输入层、样本层、求和层和竞争层。PNN 的工作过程:首先将输入向量→ x 输入到输入层,在输入层中,网络计算输入 向量与训练样本向量之间的差值 |-|→→ x ik x 的大小代表着两个向量之间的距离, 所得的向量由输入层输出,该向量反映了向量间的接近程度;接着,输入层的输出向量 →→x ik x -送入到样本层中,样本层节点的数目等于训练样本数目的总和,∑===M i i i N N 1 ,其中M 是类的总数。样本层的主要工作是:先判断哪些类别输入 向量有关,再将相关度高的类别集中起来,样本层的输出值就代表相识度;然后,将样本层的输出值送入到求和层,求和层的结点个数是M , 每个结点对应一个类,

神经网络模型预测控制器 摘要:本文将神经网络控制器应用于受限非线性系统的优化模型预测控制中,控制规则用一个神经网络函数逼近器来表示,该网络是通过最小化一个与控制相关的代价函数来训练的。本文提出的方法可以用于构造任意结构的控制器,如减速优化控制器和分散控制器。 关键字:模型预测控制、神经网络、非线性控制 1.介绍 由于非线性控制问题的复杂性,通常用逼近方法来获得近似解。在本文中,提出了一种广泛应用的方法即模型预测控制(MPC),这可用于解决在线优化问题,另一种方法是函数逼近器,如人工神经网络,这可用于离线的优化控制规则。 在模型预测控制中,控制信号取决于在每个采样时刻时的想要在线最小化的代价函数,它已经广泛地应用于受限的多变量系统和非线性过程等工业控制中[3,11,22]。MPC方法一个潜在的弱点是优化问题必须能严格地按要求推算,尤其是在非线性系统中。模型预测控制已经广泛地应用于线性MPC问题中[5],但为了减小在线计算时的计算量,该部分的计算为离线。一个非常强大的函数逼近器为神经网络,它能很好地用于表示非线性模型或控制器,如文献[4,13,14]。基于模型跟踪控制的方法已经普遍地应用在神经网络控制,这种方法的一个局限性是它不适合于不稳定地逆系统,基此本文研究了基于优化控制技术的方法。 许多基于神经网络的方法已经提出了应用在优化控制问题方面,该优化控制的目标是最小化一个与控制相关的代价函数。一个方法是用一个神经网络来逼近与优化控制问题相关联的动态程式方程的解[6]。一个更直接地方法是模仿MPC方法,用通过最小化预测代价函数来训练神经网络控制器。为了达到精确的MPC技术,用神经网络来逼近模型预测控制策略,且通过离线计算[1,7.9,19]。用一个交替且更直接的方法即直接最小化代价函数训练网络控制器代替通过训练一个神经网络来逼近一个优化模型预测控制策略。这种方法目前已有许多版本,Parisini[20]和Zoppoli[24]等人研究了随机优化控制问题,其中控制器作为神经网络逼近器的输入输出的一个函数。Seong和Widrow[23]研究了一个初始状态为随机分配的优化控制问题,控制器为反馈状态,用一个神经网络来表示。在以上的研究中,应用了一个随机逼近器算法来训练网络。Al-dajani[2]和Nayeri等人[15]提出了一种相似的方法,即用最速下降法来训练神经网络控制器。 在许多应用中,设计一个控制器都涉及到一个特殊的结构。对于复杂的系统如减速控制器或分散控制系统,都需要许多输入与输出。在模型预测控制中,模型是用于预测系统未来的运动轨迹,优化控制信号是系统模型的系统的函数。因此,模型预测控制不能用于定结构控制问题。不同的是,基于神经网络函数逼近器的控制器可以应用于优化定结构控制问题。 在本文中,主要研究的是应用于非线性优化控制问题的结构受限的MPC类型[20,2,24,23,15]。控制规则用神经网络逼近器表示,最小化一个与控制相关的代价函数来离线训练神经网络。通过将神经网络控制的输入适当特殊化来完成优化低阶控制器的设计,分散和其它定结构神经网络控制器是通过对网络结构加入合适的限制构成的。通过一个数据例子来评价神经网络控制器的性能并与优化模型预测控制器进行比较。 2.问题表述 考虑一个离散非线性控制系统: 其中为控制器的输出,为输入,为状态矢量。控制

实验八:基于神经网络的优化计算实验 一、实验目的 掌握连续Hopfield神经网络的结构和运行机制,理解连续Hopfield神经网络用于优化计算的基本原理,掌握连续Hopfield神经网络用于优化计算的一般步骤。 二、实验原理 连续Hopfield神经网络的能量函数的极小化过程表示了该神经网络从初始状态到稳定状态的一个演化过程。如果将约束优化问题的目标函数与连续Hopfield神经网络的能量函数对应起来,并把约束优化问题的解映射到连续Hopfield神经网络的一个稳定状态,那么当连续Hopfield神经网络的能量函数经演化达到最小值时,此时的连续Hopfield神经网络的稳定状态就对应于约束优化问题的最优解。 三、实验条件 VC++6.0。 四、实验内容

1、参考求解TSP问题的连续Hopfield神经网络源代码,给出15个城市和20个城市的求解结果(包括最短路径和最佳路线),分析连续Hopfield神经网络求解不同规模TSP问题的算法性能。 2、对于同一个TSP问题(例如15个城市的TSP问题),设置不同的网络参数,分析不同参数对算法结果的影响。 3、上交源代码。 五、实验报告 1、画出连续Hopfield神经网络求解TSP问题的流程图。

2、根据实验内容,给出相应结果及分析。 (1)15个城市(测试文件TSP15.TXT)

tsp15.txt 最短路程 371 最佳路线 1914861351534712210111 →→→→→→→→→→→→→→→ (2)20个城市(测试文件TSP20.TXT) tsp20.txt 最短路程349 最佳路线 →→→→→→→→→→→→→→→→→→→→→141618971315111735124289191610201 3、总结连续Hopfield神经网络和遗传算法用于TSP问题求解时的优缺点。

#include "stdio.h" #include "stdlib.h" #include "time.h" #include "math.h" /********************************************* inpoints 为输入神经元个数,可改变 outpoints为输出神经元个数 defaultpoints为隐层神经元个数 datagrough为样本数据个数 ********************************************** ******以下数据定义可以修改*****/ #define A 0 #define a 1 #define b 1 #define c 1 #define ALFA 0.85 #define BETA 0.2 //学习率0~1 #define Total 20000 #define inpoints 9 #define outpoints 5 #define defaultpoints 28 #define datagrough 44 #define forecastdata 4 /**********定义所需变量********/ double InpointData[datagrough][inpoints],OutpointData[datagrough][outpoints]; /* 输入输出数据*/ double InpointData_MAX[inpoints],InpointData_MIN[inpoints]; /* 每个因素最大数据*/ double OutpointData_MAX[outpoints],OutpointData_MIN[outpoints]; /* 每个因素最小数据*/ double w[defaultpoints][inpoints],limen[defaultpoints],v[outpoints][defaultpoints]; /* 连接权值、阈值*/ double dlta_w[defaultpoints][inpoints],dlta_limen[defaultpoints],dlta_v[outpoints][defaultpoints]; /* 连接权、阈值修正值*/ double defaultOutpoint[defaultpoints],Outpoint_dp[outpoints],Outpoint_ep[datagrough]; /**************************读数据文件******************************/ void ReadData() { FILE *fp1,*fp2; int i,j; if((fp1=fopen("D:\\data\\训练输入.txt","r"))==NULL) {

第22卷第3期湖 北 工 业 大 学 学 报2007年06月 V ol.22N o.3 Journal of H ubei U niversity of T echnology Jun.2007 [收稿日期]2007-03-20 [基金项目]湖北省自然科学基金项目(2004ABA065). [作者简介]刘幺和(1954-),男,湖北武汉人,湖北工业大学教授,美国ASM E 和IEEE 专业会员,研究方向:智能控制. [文章编号]1003-4684(2007)0320001203 一种B P 神经网络学习率的优化设计 刘幺和1,陈 睿1,彭 伟2,周 蕾1 (1湖北工业大学机械工程学院,湖北武汉430068;2湖北工业大学计算机学院,湖北武汉430068)[摘 要]考虑到结构优化设计的实用性和模糊性.在大量智能计算的基础上,提出了一种动态BP 神经网络 的学习率优化方法,该方法如同Rough 集理论的数据分类简约功能去掉了多余属性的样本数据一样,从而使神经网络拓扑结构优化.实验表明,这种方法简单、实用且快速收敛. [关键词]BP 网络;优化设计;学习率[中图分类号]TP183 [文献标识码]A 目前,智能计算在结构优化设计中已经得到广 泛应用.智能计算是根据人和动物的3大系统(神经系统、遗传系统、免疫系统)特性,提出恰当的数学模型来进行智能计算. Rumelhart 等提出的误差反向传播(Back Propagation )学习算法是训练神经网络的强有力的工具.但是BP 算法存在收敛速度慢、易陷入局部极小等缺点,所以对BP 算法的改进是一个重要的研究课题.其中对学习率的研究是很重要的一个部分.如果学习率太小,收敛性容易得到保证,但收敛速度太慢;学习率太大,学习速度快,但可能导致振荡或发散[1].因而一个固定学习率不可能很好地适用于网络的整个学习过程.为实现快速而有效的学习收敛过程,人们提出了许多自适应地调节学习率的方法(自适应调节学习率,即在网络的学习过程中,学习率随着环境状态的变化不断自动调整). 1 BP 神经网络 BP 网络可实现输入空间到输出空间的非线性 映射,它采用了优化算法中的梯度下降法,把一组样 本的I/O 问题变为非线性优化问题,B P 神经网络模型一般由输入层、中间层、输出层构成(图1),该方法的数学原理和推导方法见文献[2]. 算法的执行步骤如下[2]. 1)对权系数W ij 置初值.对各层的权系数W ij 置一个较小的非零随机数,但其中W i ,n+1=-θ. 2)输入一个样本X =(X 1,X 2,…,X n ),以及对 应的期望输出Y =(Y 1,Y 2,…,Y n ). 3)计算各层的输出.对于第k 层第i 个神经元的输出X k i ,有 图1 BP 神经网络模型 4)求各层的学习误差d k i .对于输出层k =m , 有 d m i =X m i (1-X m i )(X m i -Y i ). 对于其他各层,有 d k i =X k i (1-X k i )? ∑ t W li ?d k+l l . 5)修正权系数W ij 和阀值θ有 ΔW ij (t +l )=ΔW ij (t )-η?d k i ?X k-1 j .其中, ΔW ij (t )=-η?d k i ?X k-1 j +αΔW ij (t -l )=W ij (t )-W ij (t -l ). 6)当求出了各层各个权系数之后,可按给定品 质指标判别是否满足要求.如果满足要求,则算法结

基于概率神经网络(PNN)的故障诊断 概率神经网络PNN是一种结构简单、训练简洁、应用相当广泛的人工神经网络,在实际应用中,尤其是在解决分类问题的应用中,它的优势在于线性学习算法来完成以往非线性学习算法所做的工作,同时又能保持非线性算法的高精度等特性。基于概率神经网络的故障诊断方法实质上是利用概率神经网络模型的强大的非线性分类能力,将故障样本空间映射到故障模式空间中,从而形成一个具有较强容错能力和结构自适应能力的诊断网络系统。 1 概述 概率神经网络是一种可以用于模式分类的神经网络,其实只是基于贝叶斯最小风险准则发展而来的一种并行算法,目前已经在雷达、心电图仪等电子设备中获得了广泛的应用。PNN与BP网络相比较,其主要优点为: 快速训练,其训练时间仅仅大于读取数据的时间。 无论分类问题多么复杂,只要有足够多的训练数据,就可以保证获得贝叶斯准则下的最优解。 允许增加或减少训练数据而无需重新进行长时间的训练。 PNN层次模型是Specht根据贝叶斯分类规则与Parzen的概率密度函数提出的。在进行故障诊断的过程中,求和层对模式层中间同一模式的输出求和,并乘以代价因子;决策层则选择求和层中输出最大者对应的故障模式为诊断结果。当故障样本的数量增加时,模式层的神经元将随之增加。而当故障模式多余两种时,则求和层神经元将增加。所以,随着故障经验知识的积累,概率神经网络可以不断横向扩展,故障诊断的能力也将不断提高。 2基于PNN的故障诊断 1.问题描述 发动机运行过程中,油路和气路出现故障是最多的。由于发动机结构复杂,很难分清故障产生的原因,所以接下来尝试利用PNN来实现对发动机的故障诊断。 在发动机运行中常选用的6种特征参数:AI、MA、DI、MD、TR和PR。其中,AI为最大加速度指标;MA为平均加速度指标;DI为最大减速度指标;MD为平均减速度指标;TR为扭矩谐波分量比;PR为燃爆时的上升速度。 进行诊断时,首先要提取有关的特征参数,然后利用PNN进行诊断,诊断模型如图1所示。 2.PNN的创建和应用

神经网络学习算法的过拟合问题及解决方法 李俭川 秦国军 温熙森 胡茑庆 (国防科技大学机电工程与自动化学院 长沙,410073) 摘要 针对反向传播学习算法及其改进算法中出现的过拟合问题,探讨了三种解决方法:调整法、提前停止法和隐层节点自生成法,并用实例对三种方法进行了验证和比较。其中,调整法和提前停 止法针对一个较大的网络可以解决过拟合问题,而隐层节点自生成法的提出既能避免过拟合问 题,又能获得最少神经元网络结构。这三种方法有效地解决了在神经网络学习过程中的过拟合问 题,提高了网络的适应性。它们不仅适合于函数逼近,而且可以推广到其他网络结构等应用领域。关键词 神经网络 计算机 BP 算法 过拟合 均方误差 自生成 故障诊断 中图分类号 T H 165.3神经网络已经在模式分类、机器视觉、机器听觉、智能计算、自动控制、故障诊断、信息处理、地震勘探、通信、雷达和声纳等领域有着十分广泛的应用前景,并随着计算机技术和信号处理技术的发展而发展。应用神经网络必须解决两个问题:模型和算法。现有的神经网络模型已达上百种[1] ,应用最多的是Hopfield 神经网络、多层感知器、自组织神经网络、概率神经网络以及它们的改进型。自Rumellhart D E,H inton 和Williams 提出误差反向传播算法(即BP 算法),解决了神经网络在引入隐层节点后的学习(或训练)问题后,已经发展了许多的改进学习算法[1],如快速下降法、共轭梯度法、一维搜索法及Lev enberg -Mar quardt 法等,其收敛速度很快,能满足实时性要求,但也存在着一些问题。1 学习算法及其过拟合问题 BP 算法及其改进算法是目前应用最广泛的学习算法,尽管不能证明这类算法能象单层感知器一样收敛,但是对许多问题的解决是成功的[2]。实际上,BP 算法是把一组样本的输入输出问题,变为一个非线性优化问题,它使用了优化技术中最普通的一种梯度下降法,用迭代运算求解权值并相应于学习记忆问题,加入隐层节点可使优化问题的可调参数增加,这样可得到更精确的解。要应用学习算法对网络进行训练,首先需要确定网络的结构,即输入、输出层神经元数目和隐层数及其神经元数目。 如何适宜地选取隐含层神经元的数目还没有确定的规律可以指导,但是,隐含层神经元数目是否合适对整个网络是否能够正常工作具有重要的甚至是决定性的意义。隐含层神经元数第22卷第4期2002年12月 振动、测试与诊断Jo ur nal of Vibr ation,M easur em ent &Diag no sis V o l.22No.4 D ec.2002 国家自然科学基金资助项目(编号:59775025)。 收稿日期:2001-07-09;修改稿收到日期:2001-12-03。

神经网络控制 HEN system office room 【HEN16H-HENS2AHENS8Q8-HENH1688】

人工神经网络控制 摘要: 神经网络控制,即基于神经网络控制或简称神经控制,是指在控制系统中采用神经网络这一工具对难以精确描述的复杂的非线性对象进行建模,或充当控制器,或优化计算,或进行推理,或故障诊断等,亦即同时兼有上述某些功能的适应组合,将这样的系统统称为神经网络的控制系统。本文从人工神经网络,以及控制理论如何与神经网络相结合,详细的论述了神经网络控制的应用以及发展。 关键词: 神经网络控制;控制系统;人工神经网络 人工神经网络的发展过程 神经网络控制是20世纪80年代末期发展起来的自动控制领域的前沿学科之一。它是智能控制的一个新的分支,为解决复杂的非线性、不确定、不确知系统的控制问题开辟了新途径。是(人工)神经网络理论与控制理论相结合的产物,是发展中的学科。它汇集了包括数学、生物学、神经生理学、脑科学、遗传学、人工智能、计算机科学、自动控制等学科的理论、技术、方法及研究成果。 在控制领域,将具有学习能力的控制系统称为学习控制系统,属于智能控制系统。神经控制是有学习能力的,属于学习控制,是智能控制的一个分支。神经控制发展至今,虽仅有十余年的历史,已有了多种控制结构。如神经预测控制、神经逆系统控制等。 生物神经元模型 神经元是大脑处理信息的基本单元,人脑大约含1012个神经元,分成约1000种类型,每个神经元大约与 102~104个其他神经元相连接,形成极为错综复杂而又灵活多变的神经网络。每个神经元虽然都十分简单,但是如此大量的神经元之间、如此复杂的连接却可以演化出丰富多彩的行为方式,同时,如此大量的神经元与外部感受器之间的多种多样的连接方式也蕴含了变化莫测的反应方式。 图1 生物神经元传递信息的过程为多输入、单输出,神经元各组成部分的功能来看,信息的处理与传递主要发生在突触附近,当神经元细胞体通过轴突传到突触前膜的脉

概率神经网络概述 令狐采学 概率神经网络(Probabilistic Neural Network ,PNN )是由D. F. Specht 在1990年提出的。主要思想是贝叶斯决策规则,即错误分类的期望风险最小,在多维输入空间内分离决策空间。它是一种基于统计原理的人工神经网络,它是以Parazen 窗口函数为激活函数的一种前馈网络模型。PNN 吸收了径向基神经网络与经典的概率密度估计原理的优点,与传统的前馈神经网络相比,在模式分类方面尤其具有较为显著的优势。 1.1 概率神经网络分类器的理论推导 由贝叶斯决策理论: w w w i j i x then i j x p x p if ∈≠?>→ →→ , )|()|( (1-1) 其中)|()()|(w w w i i i x p p x p → → = 。 一般情况下,类的概率密度函数)|(→x p w i 是未知的,用高斯核的Parzen 估计如下:

) 2exp(1 1 )|(2 2 1 2 2σ σ π→ → -∑ - = =→ x x N w ik N i k l l i i x p (1-2) 其中,→ x ik 是属于第w i 类的第k 个训练样本,l 是样本向量的维数,σ是平滑参数,N i 是第w i 类的训练样本总数。 去掉共有的元素,判别函数可简化为: ∑-=→ → → - = N ik i k i i i x x N w g p x 1 2 2 ) 2exp()()(σ (1-3) 1.2 概率神经元网络的结构模型 PNN 的结构以及各层的输入输出关系量如图1所示,共由四层组成,当进行并行处理时,能有效地进行上式的计算。 图1 概率神经网络结构 如图1所示,PNN 网络由四部分组成:输入层、样本层、求和层和竞争层。PNN 的工作过程:首先将输入向量→ x 输入到输入层,在输入层中,网络计算输入向量与训练样本向量之间

实验六基于神经网络的优化计算实验 一、实验目的 掌握连续Hopfield神经网络的结构和运行机制,理解连续Hopfield神经网络用于优化计算的基本原理,掌握连续Hopfield神经网络用于优化计算的一般步骤。 二、实验原理 连续Hopfield神经网络的能量函数的极小化过程表示了该神经网络从初始状态到稳定状态的一个演化过程。如果将约束优化问题的目标函数与连续Hopfield神经网络的能量函数对应起来,并把约束优化问题的解映射到连续Hopfield神经网络的一个稳定状态,那么当连续Hopfield神经网络的能量函数经演化达到最小值时,此时的连续Hopfield神经网络的稳定状态就对应于约束优化问题的最优解。 实验报告 1、画出连续Hopfield神经网络求解TSP问题的流程图。

2、根据实验内容,给出相应结果及分析。 (1)、参考求解TSP问题的连续Hopfield神经网络源代码(设置参数A=15,B=15,D=0.015, u0=0.02,h=0.5,r= cityNumber*10),给出15个城市和20个城市的求解结果(包括最短路径和最佳路线),分析连续Hopfield神经网络求解不同规模TSP问题的算法性能。 1)int main(int argc,char *argv[]):修改路径计算的代码 2)最后要求输出:

TSP4 (2)、对于同一个TSP问题(例如15个城市的TSP问题),设置不同的网络参数(A=50,B=50,D=0.01,C=50,u0=0.02, h=0.5,r=cityNumber*100; A=0.5, B=0.5, D=0.5, C=0.2,u0=0.02,h=0.5,r=cityNumber*100; A=500,B=500,D=500,C=200,u0=0.02,h=0.5, r=cityNumber*100; A=5, B=5, D=0.01, C=5,u0=0.02,h=0.5, r=cityNumber*100),分析不同参数对算法结果的影响。 1)int main(int argc,char *argv[]):增加全局约束的参数C,网络动态方程也需增加全局约束项。 2)bool is_a_road():在是否是一条可行路径中,需要增加满足全局约束的判断 3)最后要求输出: 情况一 情况二

概率神经网络讲解 Document serial number【UU89WT-UU98YT-UU8CB-UUUT-UUT108】

Donald Probabilistic Neural Networks Neural Networks,,,1990 概率神经网络 摘要:以指数函数替代神经网络中常用的S形激活函数,进而构造出能够计算非线性判别边界的概率神经网络(PNN),该判定边界接近于贝 叶斯最佳判定面。还讨论了拥有类似性质的其他激活函数。所提出的这种4层神经网络能够把任何输入模式映射到多个类别。如果能取得新数据的话,可以使用新数据实时地修改判定边界,并可以使用完全并行运行的人工“神经元”付诸实现。还为估计类别的出现概率和可靠性,以及做判别作好准备。对于反向传播增加的适应时间占总计算时间的重大部分的问题,这种方法显示出非常快速的优点。PNN范式比反向传播快200,000倍。 关键词:神经网格,概率密度函数,并行处理机,“神经元”,模式识别,Parzen窗口,贝叶斯策略,相联存储器 1. 动机 神经网络常用来依据向实例学习进行模式分类。不同的神经网格范式(paradigm)使用不同的学习规则,但都以某种方式,根据一组训练样本确定模式的统计量,然后根据这些统计量进行新模式分类。

通用方法如反向传播,使用探试法获得基础的类别统计量。探试法通常包含对系统参数的许多小的改进,逐渐提高系统的性能。除了训练需要长的计算时间外,还表明,反向传播增加的适应近似法对错误的最小值很敏感。为了改进这种方法,找到了基于己确立的统计原理的分类方法。 可以表明,尽管最终得到的网络在结构上类似于反向传播,且其主要区别在于以统计方法推导的激活函数替代S形激活函数,但这个网络具有的特点是:在某些易满足的条件下,以PNN实现的判别边界渐进地逼近贝叶斯最佳判定面。 为了了解PNN范式的基础,通常从贝叶斯判定策略以及概率密度函数的非参数估计的讨论开始。之后可以表明,这种统计方法如何映射到前馈神经网络结构,网络结构是以许多简单处理器(神经元)代表的,所有处理器都是并行运行。 2. 模式分类的贝叶斯判定策略 用于模式分类的判定规则或策略的公认标准是:在某种意义上,使“预期风险”最小。这样的策略称之“贝叶斯策略”,并适用于包含许多类别的问题。

收稿日期:2002-11-13;修订日期:2003-02-12 作者简介:郭海丁(1958-) 男 山东潍坊人 南京航空航天大学能源与动力学院副教授 博士 主要从事工程结构强度~断裂~疲 劳损伤及结构优化设计方法等研究. 第18卷第2期2003年4月 航空动力学报 Journal of Aerospace Power Vol.18No.2 E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E E Apr.2003 文章编号:1000-8055(2003)02-0216-05 基于BP 神经网络和遗传算法 的结构优化设计 郭海丁1 路志峰2 (1.南京航空航天大学能源与动力学院 江苏南京210016; 2.北京运载火箭技术研究院 北京100076) 摘要:现代航空发动机不断追求提高推重比 优化其零部件的结构设计日益重要 传统结构优化方法耗时多且不易掌握 针对这一问题 本文提出了将BP 神经网络和遗传算法相结合用于结构优化设计的方法 并编制了相应的计算程序 实现了一个含9个设计变量的发动机盘模型的结构优化计算 计算证明 与传统结构优化方法相比 此方法计算速度快~精度良好 关 键 词:航空~航天推进系统;结构优化;神经网络;遗传算法;航空发动机 中图分类号:V 231 文献标识码:A Structure Design Optimization Based on BP -Neural Networks and Genetic Algorithms GUO -ai -ding 1 LU Zhi -feng 2 (1.Nanjing University of Aeronautics and Astronautics Nanjing 210016 China ; 2.Beijing institute of Astronautics Beijing 100076 China ) Abstract :Owing to the increasing demand for raising the thrust -weight ratio of modern aero -engine it is very important to optimize the structures of the components .Traditional optimization methods of structure design are time -consuming and hard to be put into practice .So in this paper a new method of structure design optimization is induced to which both BP neural networks and genetic algorithms (in short :BPN -GA )are applied .A program which contains 9variables is designed for the structure optimization of a disk model with the BPN -GA method which proves that it has better calculating rate and precision than those with traditional optimization methods . Key words :aerospace propulsion ;structure optimization ;neural network ; genetic algorithms ;aero -engine 1 引言 在航空~航天等领域 结构优化设计技术正在得到越来越广泛的应用 结构优化设计逐步进入工程实用阶段!1"3# 但从工程应用角度来看 结构优化设计方法的推广仍存不少障碍 主要表现为: (1)优化中靠经验调整的参数较多 掌握困难;(2)优化计算效率较低 应用现有的结构优化算法进

第29卷第6期 2008年 12月河南科技大学学报:自然科学版Journal of Henan University of Science and Technol ogy:Natural Science Vol .29No .6Dec .2008 基金项目:辽宁省教育厅科学研究计划项目(2002D031) 作者简介:王丹凤(1983-),女,辽宁辽阳人,硕士生;李书臣(1960-),男,辽宁桓仁人,教授,主要研究领域为预测控制、智能控制、 迭代学习控制算法及应用. 收稿日期:2008-05-15 文章编号:1672-6871(2008)06-0042-03 基于神经网络参数优化的迭代学习控制算法 王丹凤,李书臣,翟春艳,邢宜春 (辽宁石油化工大学信息与控制工程学院,辽宁抚顺113001) 摘要:针对迭代学习控制用于轨迹跟踪时存在收敛速度慢的问题,提出用RBF 网络优化迭代控制器参数的算法。在每一次迭代学习过程之后利用RBF 网络对当次输出的数据进行优化计算,拟合出最优的学习增益,使迭代学习算法具有较快的收敛速度,在单关节机器人中进行仿真验证了方法的有效性。 关键词:迭代学习控制;RBF 网络;单关节机器人 中图分类号:TP389.1文献标识码:A 0 前言 机器人是一类高度非线性、强耦合和时变性的动力学系统,设计其控制器存在的一个严重问题是我们并不知道准确的数学模型,如果忽略各种不确定因素,设计出的控制器可能会导致系统性能变坏甚至 引起不稳定[1]。迭代学习控制(I L C )[2-3]是一种新型控制算法,它能以非常简单的方式处理不确定度 相当高的动态系统,且仅需要较少的先验知识和计算量,适应性强,易于实现;更主要的是它不依赖于动态系统的精确数学模型。从“迭代”二字可以看出,这是要求动态过程是可以重复的一种行为,它的研究对诸如机器人等对运动控制有着高速、高精度要求的对象有着重要的意义。但现有的迭代学习控制只能用于某种特定的轨迹跟踪问题,且学习速度慢,迭代的次数多,本文将离线的神经网络与在线的迭代学习相结合的控制方案,在控制器中加入神经网络的优化作用,把在线的学习,在线的控制与控制系 统性能改善的功能有效的综合在一个算法里[3]。此方法原理简单,实现的P D 型迭代学习控制器结构 简单,保证了系统的实际输出在最少的迭代次数,以最快的收敛速度逼近期望输出。 1 迭代学习神经网络控制结构 基于神经网络的迭代学习控制系统结构图主要分为两大部分:迭代学习控制器和神经网络,结构图如图1所示 。 图1 基于神经网络的迭代学习控制结构图本文采用P D 型学习律[4]的迭代学习控制器直接对 被控对象进行控制,控制器中的可调参数k p ,k d 通过离线 的神经网络进行调整。P D 型学习律公式为 u k +1(t )=u k (t )+k p e k (t )+k d d e k (t )d t (1)e k =y d (t )-y k (t ) (2)其中 k 表示迭代的次数;u k (t )为第k 次控制输入;k p ,k d 分别为迭代学习控制器的学习增益。 随着神经网络的发展尤其是在出现多层前馈网络和 反馈性网络后获得了突破性进展[5]。多层神经网络逼近 任意非线性映射能力,以及固有的学习特点,已得到各个 领域的极端重视,将极具潜力的神经网络模型运用到学习控制系统的研究,已陆续得到某些结果。