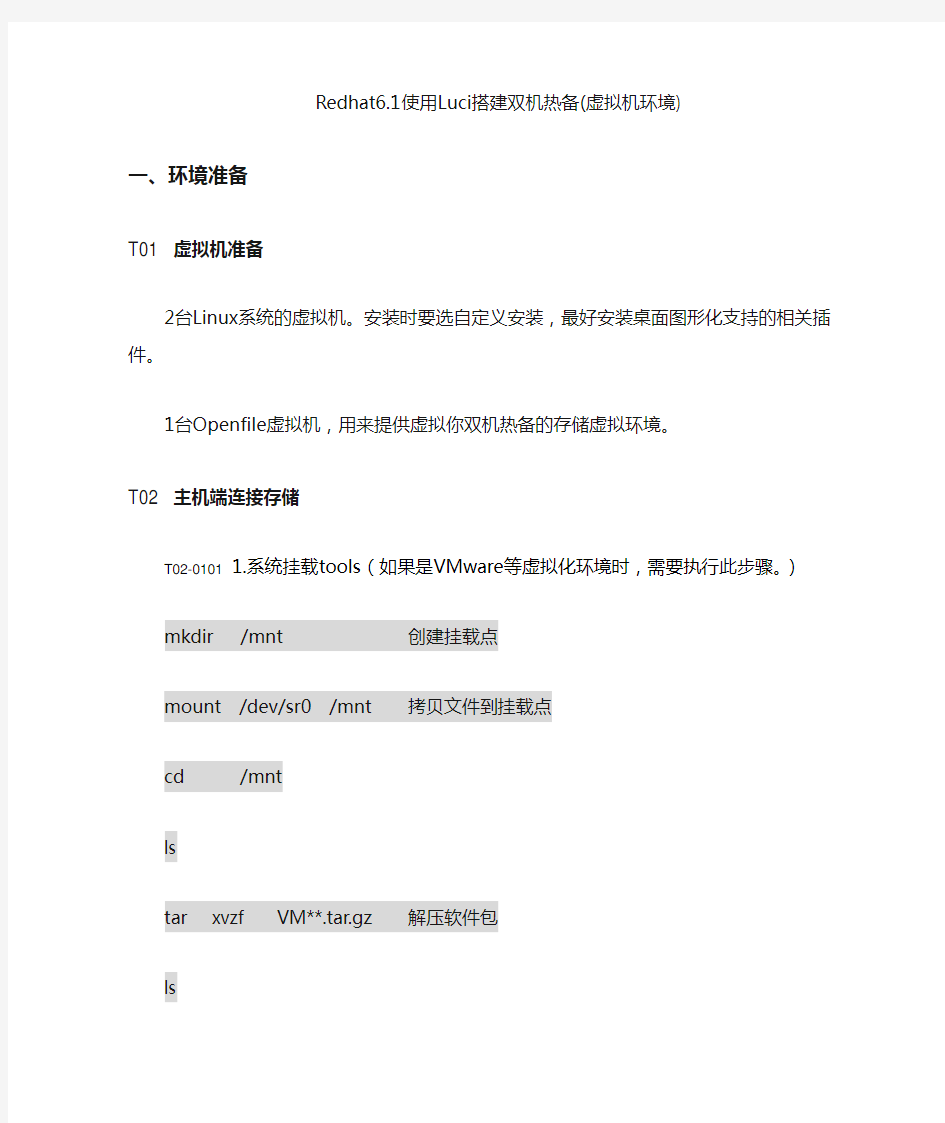

Redhat6.1使用Luci搭建双机热备(虚拟机环境)

一、环境准备

T01 虚拟机准备

2台Linux系统的虚拟机。安装时要选自定义安装,最好安装桌面图形化支持的相关插件。

1台Openfile虚拟机,用来提供虚拟你双机热备的存储虚拟环境。

T02 主机端连接存储

T02-0101 1.系统挂载tools(如果是VMware等虚拟化环境时,需要

执行此步骤。)

mkdir /mnt 创建挂载点

mount /dev/sr0 /mnt 拷贝文件到挂载点

cd /mnt

ls

tar xvzf VM**.tar.gz 解压软件包

ls

cd ./vmware-tools-dis**b

ls

./vm**install.pl

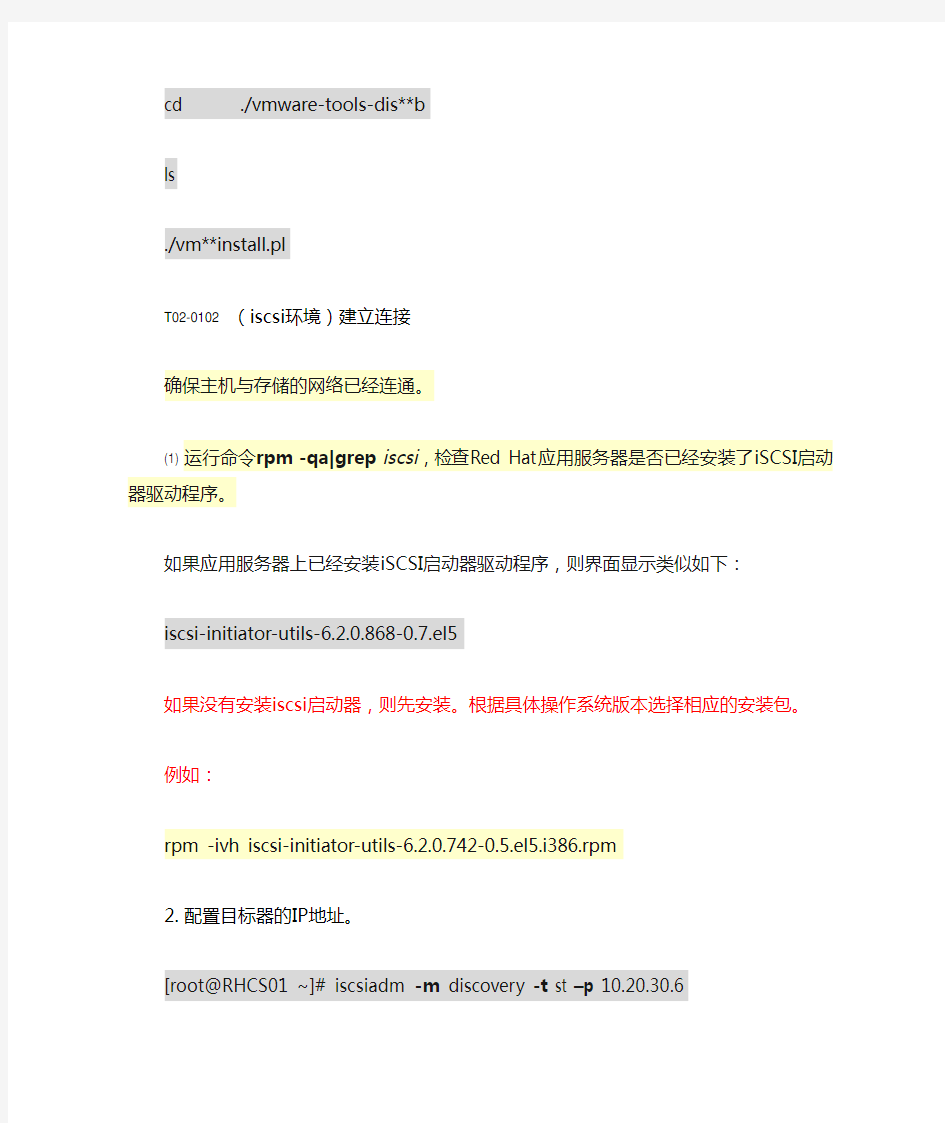

T02-0102 (iscsi环境)建立连接

确保主机与存储的网络已经连通。

(1) 运行命令rpm-qa|grep iscsi,检查Red Hat应用服务器是否已经安装了iSCSI启动器驱

动程序。

如果应用服务器上已经安装iSCSI启动器驱动程序,则界面显示类似如下:

iscsi-initiator-utils-6.2.0.868-0.7.el5

如果没有安装iscsi启动器,则先安装。根据具体操作系统版本选择相应的安装包。

例如:

rpm -ivh iscsi-initiator-utils-6.2.0.742-0.5.el5.i386.rpm

2. 配置目标器的IP地址。

[root@RHCS01 ~]# iscsiadm-m discovery-t st–p 10.20.30.6

3. 登录目标器。

[root@RHCS01 ~]# iscsiadm -m node -p 10.20.30.6 –l

4. 设置目标器为自动启动模式。

设置目标器为自动启动模式后,每次应用服务器重新启动后会自动登录与其连接的目标器。

a.运行命令vi/etc/iscsi/iscsid.conf,打开“iscsid.conf”文件。

b.按“i”键,进入编辑模式,编辑“iscsid.conf”文件。

在Startup settings区域中,将node.startup=字段设置为automatic。

设置完成后界面显示如下信息。

#***************** # Startup settings #*****************

# To request that the iscsi initd scripts startup a session set to

"automatic".

node.startup = automatic

# # To manually startup the session set to "manual". The default is automatic.

# node.startup = automatic

说明:

?“iscsid.conf”文件中“node.startup”前的“#”表示注释,在首次配置时请将该“#”删除。

?配置时只需使一条配置生效即可。

c.按“ESC”键退出编辑模式。

d.运行命令:wq,保存设置并退出“iscsid.conf”文件。

5. 运行/etc/init.d/iscsi restart命令,重新启动iSCSI业务并使配置生效。

T02-0103 (FC环境)建立连接

1. 运行hot_add命令扫描新映射的LUN

会显示如下信息:

starting new devices re-scan...

scan mptsas HBA host /sys/class/scsi_host/host1...

no new device found run /usr/sbin/upTools -s busscan...

found 2:0:0:0->/dev/sdb found 2:0:0:1->/dev/sdc /usr/sbin/hot_add is completed.

T02-0104 扫描磁盘并创建分区

1. 运行命令fdisk -l浏览应用服务器上的所有硬盘的信息。

如以下信息所示,应用服务器扫描到1073 MB的LUN,且新的逻辑硬盘名称为

/dev/sdb。

Disk /dev/sda: 8589 MB,8589934592 bytes 255 heads,63 sectors/track,1044 cylinders Units = cylinders of 16065 * 512 = 8225280 bytes

Device Boot Start End Blocks Id System /dev/sda1

* 1 13 104391 83 Linux /dev/sda2

14 1044 8281507+ 8e Linux LVM

Disk /dev/sdb: 1073 MB,1073741824 bytes 34 heads,61 sectors/track,

1011 cylinders Units = cylinders of 2074 * 512 = 1061888 bytes

Disk /dev/sdb doesn't contain a valid partition table

说明:

如果未扫描到新映射的磁盘,请进行相应的故障处理后重新进行扫描。

2. 运行fdisk命令对扫描到的新逻辑硬盘进行分区。

以为逻辑硬盘/dev/sdb创建一个主分区为例,运行的命令如下所示:

# fdisk /dev/sdb

Command (m for help): n

Command action e extended

p primary partition (1-4)

p Partition number (1-4): 1

First cylinder (1-1011,default 1): 1

Last cylinder (1-1011,default 1): 1011

Command (m for help): w

The partition table has been altered!

Calling ioctl()to re-read partition table. Syncing disks.

在逻辑硬盘上创建文件系统。

对精简LUN映射的逻辑磁盘进行格式化时,为避免格式化对该逻辑盘的每一个数据块进行写操作,占用精简LUN的所有物理空间,请使用不对全盘写零数据进行硬盘清零的格式化。

3. 运行命令在逻辑硬盘上创建文件系统。

以如下命令为例:

mkfs.ext3 /dev/sdb1在此例中,为创建了分区的逻辑硬盘/dev/sdb1创建的文件系统类型为ext3。

运行mkfs.ext3 /dev/sdb1命令后,界面显示如下:

mke2fs 1.38 (30-Jun-2005)/dev/sdb is entire device,not just one partition!

Proceed anyway? (y,n)y

Filesystem label= OS type:

Linux Block size=4096 (log=2)

Fragment size=4096 (log=2)

131072 inodes,262144 blocks 13107 blocks (5.00%)reserved for the super user First data block=0 8 block groups 32768 blocks per group,

32768 fragments per group 16384 inodes per group Superblock backups stored on blocks: 32768,98304,163840,229376

Writing inode tables: done Creating journal (8192 blocks): done Writing

superblocks and filesystem accounting information: done

This filesystem will be automatically checked every 39 mounts or 180 days,

whichever comes first.

Use tune2fs -c or -i to override.

4. mkdir创建文件目录。

以如下命令为例:

mkdir /directory在此例中,创建的文件目录名称为/directory。

注意:

请在挂载逻辑磁盘完成后修改“/etc/fstab”文件,设置自动加载配置项并绑定UUID

(Universally Unique Identifier),避免应用服务器重新启动时无法自动加载逻辑磁盘或者导致磁盘盘符漂移等问题,具体的修改方法请咨询您的操作系统供应商或系统管理员。

5. mount将创建了分区的逻辑硬盘挂载到创建的目录下。

运行命令挂载逻辑硬盘。以如下命令为例:

mount /dev/sdb1 /directory在此例中,将创建了分区的逻辑硬盘/dev/sdb1挂载到

/directory目录下。

操作结果

运行mount命令,查看应用服务器上扫描到的硬盘是否挂载成功,如果挂载成功,则应用服务器可将扫描到的硬盘作为普通硬盘对其进行读写操作。如果界面显示如下信息,则说明硬盘挂载成功。

# mount

/dev/sda2 on / type ext3 (rw)

proc on /proc type proc (rw)

sysfs on /sys type sysfs (rw)

devpts on /dev/pts type devpts (rw,gid=5,mode=620)

/dev/sda5 on /home type ext3 (rw)

/dev/sda1 on /boot type ext3 (rw)

tmpfs on /dev/shm type tmpfs (rw)

none on /proc/sys/fs/binfmt_misc type binfmt_misc (rw)

sunrpc on /var/lib/nfs/rpc_pipefs type rpc_pipefs (rw)

none on /proc/fs/vmblock/mountPoint type vmblock (rw)

/dev/hdc on /media/RHEL_5.3 i386 DVD type iso9660 (ro,noexec,nosuid,nodev,uid=0)

/dev/sdb1 on /directory type ext3 (rw)

6. df –h查看挂载点情况

7. 特殊注意点

对于大于2T的分区,分区类型要改为gpt。

?打印一个磁盘的当前的分区结构:

?$ parted /dev/sdb print

?将一个MBR的磁盘格式化为GPT磁盘:

?parted> mklabel gpt

?将一个GPT磁盘格式化为MBR磁盘:

?parted> mklabel msdos

/dev/sda代表磁盘空间sda1代表分区,格式化的对象是分区。

(parted) mkpart

分区名称?[]? primary

文件系统类型?[ext2]? ext4

起始点?1

结束点?-1 (-1代表最大空间的结束点)

(parted) p

Model: up updisk (scsi)

Disk /dev/sdf: 4674GB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Number Start End Size File system Name 标志

1 1049kB 4674GB 4674GB primary

mkfs.ext4 /dev/sdf1 建文件系统

mount /dev/sdf1 /qaddbs/挂在分区

T03 配置服务器端口绑定

1. 创建bond接口,在接口配置文件的路径下

/etc/sysconfig/network-scripts/

#vi /etc/sysconfig/network-scripts/ifcfg-bond0

DEVICE="bond0"

BOOTPROTO=none

IPADDR=192.168.1.10

NETMASK=255.255.255.0

GATEWAY=192.168.1.1

NM_CONTROLLED=no —这个参数是networdmanager相关的,可以把个关了

(在RH5885V3服务器上,必须有这一行,且必须在setup里关掉该服务。

否则,只有重启服务器,才存在bond信息,执行service network restart是不存在bond 信息的,而且可能造成网卡信息紊乱)

ONBOOT=yes

USERCTL=no

BONDING_OPTS=”mode=1 miimon=100”——mode=0为冗余模式。一个中断,另一个立即生效,且交换机不需做任何配置。

2. 修改要加入bond的两个物理口的接口配置文件如下(修改eth0):

# vi /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE="eth0"

BOOTPROTO=none

MASTER=bond0

SLAVE=yes

ONBOOT=yes

USERCTL=no

3. 修改要加入bond的两个物理口的接口配置文件如下(修改eth0):

# vi /etc/sysconfig/network-scripts/ifcfg-eth1

DEVICE="eth1"

BOOTPROTO=none

MASTER=bond0

SLAVE=yes

ONBOOT=yes

USERCTL=no

4. 关闭networkmanager服务

#setup

取消勾选保存退出

5. 重启服务器

用reboot命令重启

6. 重启后查看配置情况:

# cat /proc/net/bonding/bond0

7. Ping网关,拔网线进行测试,验证bond是否成功

T04 安装Redhat 6.1 HA软件

T04-01 配置yum环境(使用这个工具会比较便于安装各种rpm包)

1. 创建CDROM 加载目录

例:mkdir /media/rhel6

2. 加载CDROM

放入安装光盘,加载光驱。

例:mount /dev/cdrom /media/rhel6

3. 备份rhel-source.repo文件

例:cp /etc/yum.repos.d/rhel-source.repo /etc/yum.repos.d/bak 4. 编辑rhel-source.repo文件

例:vi /etc/yum.repos.d/rhel-source.repo

例如:

[Server]

name=Server

baseurl=file:///mnt/Server

enabled=1

gpgcheck=0

说明:

安装RHCS需要用到系统自带光盘中的一些软件包,具体如下:

HighAvailability LoadBalancer Packages ResilientStorage

ScalableFileSystem Server

先将这些包(文件夹)拷贝至/mnt目录下,也可以不拷贝,把YUM源设置好就可以了

5. 安装软件:

# yum install cluster-glue resource-agents pacemaker

选Y

# yum install luci ricci cman openais rgmanager lvm2-cluster

gfs2-utils

选Y

6. 启动HA服务:

# service luci start

# service ricci start

# service rgmanager start

# service cman start

7. 设置HA服务自启动

chkconfig ricci on

chkconfig luci on

chkconfig cman on

chkconfig rgmanager on

chkconfig modclusterd on

chkconfig clvmd on

8. 修改ricci用户的密码

Passwd ricci,改为root用户密码即可。

9. 创建QDISK盘(用于后续集群配置中,做仲裁盘)

用法:mkqdisk -L | -f

mkqdisk -c /dev/sdb -l qdisk

这里把一块1G的/dev/qdisk配置成了一块叫qdisk的仲裁盘T04-02 登录HA的配置

用 Firefox浏览器打开

例:https://128.1.1.202:8084/

1. 创建一个群集

2. 添加节点名称和成员

3. 配置fence设备

添加fence设备

点节点名称,关联节点和Fence设备

4. 创建失效域

添加故障切换域

5. 创建资源

此处可以添加开机自动挂载的路径,对外业务IP等。

6. 创建集群服务

7. 验证HA功能

关闭其中一台服务器,通过电脑ping双机的业务地址,会有短暂中断时间,其实是集群状态切换和恢复的时间。

df –h

查看配置的资源,盘符是否自动挂载过来。如果是,存储磁盘自动挂载配置成功。T04-03 集群常用命令

使用clustat显示HA服务

# clustat

查看HA的日志

# tail -f /var/log/cluster/rgmanager.log

系统结构: 两台服务器集群,通过网络同时与阵列相连。其中一台为当前活动服务器,另一台热备。 服务器间通过心跳线相连,确保集群讯息传递。 目的: 为防止单点故障,集群服务通过服务器即时切换,实现任意一台服务器故障后,用户依然能对阵列上所存储的资源进行操作而不受影响,为维修或更换设备赢得时间。 整体思路: 1.在阵列上创建仲裁分驱和共享分驱 2.启动集群服务器中的一台A,查看是否识别出阵列上划分的空间。是则格式化分驱, 并启动集群服务器B,检查其是否识别已分驱的磁盘。是则关闭服务器B,然后在 服务器A上创建集群 3.选择域,输入要创建的集群名称 4.输入节点A主机名,可点击BROWSE选择服务器名称 5.等待系统执行前至配置,如无异常执行下一步 6.输入集群ip地址,此地址为虚拟集群服务器地址,并无实际设备存在

7.在域服务器上创建一个集群用户,在集群向导中输入用户名密码 8.点击QUORUM选择在阵列上创建的仲裁磁盘,结束配置 9.启动集群服务器B,启动集群管理服务,选择加入集群。 10.选择要加入集群的节点服务器B 11.等待配置完成,若无异常进行下一步 12.输入集群服务器所在域的域用户密码 13.检察配置信息,无误则结束配置 14.右键单击RESOURCE新建资源 15.输入资源名称并选择资源类型及所在组 16.将与之关联的服务器加入相关组 17.设置共享名称及路径,单击完成结束配置 18.设置共享资源完全共享权限 19.在当前管理服务器上设置共享磁盘的权限 一.环境准备条件: 1.域服务器至少一台 2.在域中创建用户,为后边集群服务器登陆使用 3.两台准备做集群的节点服务器,需配置双网卡。 4.准备心跳线一根,将两台节点服务器相连。 二。配置集群 域用户:cluster 主机A信息: 主机A名称:NASA 域名:12.CALT.CASC 公网IP:10.21.0.171 心跳IP:192.168.0.1 主机B信息: 主机B名称:NASB 域名:12.CALT.CASC 公网IP:10.21.0.172 心跳IP:192.168.0.2

2003服务器集群实验 一、服务器集群简介 什么是服务器群集?有何作用? 服务器群集是一组协同工作并运行Microsoft群集服务(Microsoft Cl uster Service,MSCS)的独立服务器。它为资源和应用程序提供高可用性、故障恢复、可伸缩性和可管理性。它允许客户端在出现故障和计划中的暂停时,依然能够访问应用程序和资源。如果群集中的某一台服务器由于故障或维护需要而无法使用,资源和应用程序将转移到可用的群集节点上。 服务器群集不同于NLB群集,服务器群集是有独立计算机系统(节点)构成的组,不同节点协同工作,就像单个系统一样,从而确保关键的应用程序和资源始终可由客户端使用。用于访问量较少的企业内网的服务器的冗余和可靠性。 哪些版本的操作系统支持服务器群集? 只有两个版本的windows server 2003系统支持该技术:企业版和数据中心版。 服务器群集的应用范围? 服务器群集最多可以支持8个节点,可实现DHCP、文件共享、后台打印、MS SQL server、exchange server等服务的可靠性。 二、群集专业术语 节点: 构建群集的物理计算机 群集服务: 运行群集管理器或运行群集必须启动的服务 资源: IP地址、磁盘、服务器应用程序等都可以叫做资源 共享磁盘: 群集节点之间通过光纤SCSI 电缆等共同连接的磁盘柜或存储 仲裁资源: 构建群集时,有一块磁盘会用来仲裁信息,其中包括当前的服务状态各个节点的状态以及群集转移时的一些日志 资源状态: 主要指资源目前是处于联机状态还是脱机状态 资源依赖: 资源之间的依存关系 组: 故障转移的最小单位 虚拟服务器: 提供一组服务--如数据库文件和打印共享等 故障转移: 应用从宕机的节点切换到正常联机的节点

实验指导书_lly 实验三、计算机网络常用服务器的安装与配置 1.实验目的 ●在Windows 2003下进行DNS服务器的配置 ●在Windows 2003下进行DHCP服务器的配置 ●在Windows XP下进行FTP服务器的配置 ●在Windwos XP下进行代理服务器的配置 2.实验环境 ●PC个人计算机一台 ●Windows 2003和Windows XP两个操作系统 3.实验步骤及内容 内容一:DNS服务器的配置 【示例】某页面服务器(或称网站)的网址为“https://www.doczj.com/doc/536520928.html,”,其对应的IP地址为“192.168.0.100”。如何在Windows Server 2003操作系统中配置DNS服务器? 【解析】 DNS服务器的配置主要是两方面的配置:创建正向搜索区域,即根据域名“https://www.doczj.com/doc/536520928.html,”解析IP地址“192.168.0.100”;创建反向搜索区域,即根据IP地址解析域名,即根据IP地址“192.168.0.100”解析出“https://www.doczj.com/doc/536520928.html,”。本实验内容主要是创建正向搜索区域。 【步骤】 1)在Windows 2003下进行DNS服务器的安装 单击“开始”——〉“控制面板”——〉“添加或者删除程序”。单击“添加或者删除Windows 组件”,在“组件”列表中,单击“网络服务”,然后单击“详细信息”按钮。选中“域名系统”复选框(注:也可以全部选中)。如图3-1所示。

单击“网 络服务” 图3-1 安装DNS服务器 2)在Windows 2003下进行DNS服务器的配置 启动DNS服务管理器,创建域名服务器。单击“开始”——〉“程序”——〉“管理工具”——〉“DNS”选项。弹出一个对话框,如图3-2所示,在域名服务管理器的主窗口中,用鼠标右键单击用户的新服务器并选择“配置服务器”,出现“配置DNS服务器向导”对话框。 图3-2 启动DNS服务器 3)创建一个域“https://www.doczj.com/doc/536520928.html,” 如图3-3所示,为BBS服务器、邮件服务器和Web服务器创建一个新的域“https://www.doczj.com/doc/536520928.html,”。

RH5885V3服务器系统安装手册 一、信息收集 1.服务器配置信息 操作系统兼容表 2.

通过此表,大致可以判断出所要安装的系统是否需要加载驱动等内容。 例如:安装windows2008系统:通过对应此表可知需Note1与Note8,即使用ServiceCD2.0引导光盘以及要加载LSI2208阵列卡驱动;(在实际安装中,ServiceCD2.0基本都包含所有驱动,如果未通过引导盘安装,则不仅要安装阵列卡驱动,装好系统后还需安装各类硬件驱动) 二、Riad制作 1.信息收集 华为RH55885V3服务器的阵列卡有多种选择,首先要确定服务器所使用何种阵列卡,本例使用的为LSI SAS2208 RAID 控制扣卡

2.配置流程 3.进入远程管理界面 本例远程控制台为iMana 200,配置步骤如下: 在终端设备的浏览器地址栏中输入http://192.168.2.100(默认地址)。 出现安全认证对话框,点击“是”按钮,进入Web登录界面。 在语言下拉框中选择“中文(简体)”,再选择“English”。再选择“中文”。 输入用户名“root”,输入默认密码“Huawei12#$”。 右侧选择远程管理界面

4.进入WebBIOS管理界面 远程虚拟控制台(以iMana 200为例)登录到服务器的实时操作桌面,进行远程重启 服务器启动过程中,当出现如图2-5所示“Press

服务器集群系统中,服务器不再分布在各处,而是集中在一起统一进行管理和维护。它保持了分布式客户机/服务器模式的开发性、可扩展性的优点,同时又具备了终端/主机模式的资源共享和集中易于管理的优点。 服务器集群系统中,服务器不再分布在各处,而是集中在一起统一进行管理和维护。它保持了分布式客户机/服务器模式的开发性、可扩展性的优点,同时又具备了终端/主机模式的资源共享和集中易于管理的优点。相对集中的集群系统,降低了系统管理的成本,而且还提供了和大型服务器系统相媲美的处理能力。 在传统的终端/主机的网络模式时代,终端功能简单,无需维护工作,在主机一端进行专门的管理与维护,具有资源共享、便于管理的特点。但是,主机造价昂贵,终端没有处理能力,限制了网络的规模化发展。之后的客户机/服务器模式推进了计算产业的标准化和开发化的发展,为系统提供了相当大的灵活性,但是随着分布系统规模的规模扩大,系统的维护和管理带来了巨大的开销。 面向Internet的服务型应用,需要高性能的硬件平台作为支持,将并行技术应用在服务器领域中,是计算机发展的必然趋势。并行处理技术在高性能计算领域中,高可用和高性能是集群服务器系统发展的两个重要方向。 集群的概念 集群英文名称是CLUSTER,是一组相互独立的、通过高速网络互联的计算机,它们构 成了一个组,并以单一系统的模式加以管理。一个客户与集群相互作用时,集群像是一个独立的服务器。集群配置是用于提高可用性和可缩放性。 和传统的高性能计算机技术相比,集群技术可以利用各档次的服务器作为节点,系统造价低,可以实现很高的运算速度,完成大运算量的计算,具有较高的响应能力,能够满足当今日益增长的信息服务的需求。 #P# 集群技术应用的需求 Internet用户数量呈几何级数增长和科学计算的复杂性要求计算机有更高的处理能力,而CPU的发展无法跟上不断增长的需求,于是我们面临以下问题: ●大规模计算如基因数据的分析、气象预报、石油勘探需要极高的计算性能。

服务器集群设计 服务器集群技术随着服务器硬件系统与网络操作系统的发展而产生的,在可用性、高可靠性、系统冗余等方面越来越发挥重要中用,是核心系统必不可少的。数据库保存者抄表系统的数据,是整个信息系统的关键所在。 解决系统可靠性的措施通常是备份和群集。备份不能快速恢复,主要用于安全保存,数据库和系统的快速故障恢复通常采用HA(高可用)群集模式, HA 能提供不间断的系统服务,在线系统发生故障时,离线系统能立即发现故障并立即进行接管,继续对外提供服务。HA技术可以有效防止关键业务主机宕机而造成的系统停止运行,被广泛采用。HA技术有两种模式: 具有公共存储系统的HA 数据存储在公共的存储系统上,服务器1为活动服务器,服务器2为待机服务器(备份服务器),当服务器1发生故障时(软或硬件故障),服务器2通过私有网络(心跳路径)侦测到服务器1的故障并自动接管服务器1上所有的资源(如IP地址、存储系统、数据库服务、计算机名等),继续为客户机提供数据或其他应用服务。 独立存储系统的HA数据存储在各自服务器的独占存储设备上(内置磁盘或磁盘阵列) ,没有共享存储系统,数据保存在每个服务器独占的存储设备上。通过镜像技术使每台服务器的数据保持同步,切换时间更短,可靠性比共享存储系统的方案更高,并避免了单点崩溃的可能性,增加了数据的安全性及系统的可用性。两台服务器之间的距离不受外部存储设备连接线的限制,因而可以将两台服务器放置在不同位置。

根据上述分析、系统要求、应用软件采用三层结构的优势以及艾因泰克在发电企业几十家的建设经验,方案采用独立存储系统的HA模式。 由于两套数据库服务器只有一台在线工作,方案本着最大限度节约资源的原则,充分高性能服务器的性能,在备用服务器上运行系统的WEB应用。采用双机双应用,互为备用结构。即在线数据库服务器是 WEB应用服务器的备用服务器,在线WEB应用服务器是数据库服务器的备用服务器。这种结构不但充分发挥性能服务器的优势,又保证关键服务器具有自动备用服务器。不但节约了成本,而且避免了采用共用存储设备单点故障带来的数据丢失的灾难,是最佳的选择。 数据库和应用服务器集群结构如下图: 服务器采用2台PowerEdge R900,配置7块146G磁盘,2块磁盘组成RAID 1镜像,作为操作系统盘。5块组成磁盘组成RAID 5,作为数据盘。 集群镜像软件选用RoseMirrorHA。RoseMirrorHA是一个可靠的、稳定的、高性能的应用高可用保护解决方案,实现应用程序的保护,保证了业务的持续运

华为服务器操作系统安装指南 用户使用ServiceCD安装操作系统之前,需要做好以下三方面的准备。 ?准备安装工具和软件。 o USB光驱/内置光驱 o ServiceCD光盘 o Windows操作系统安装光盘 ?保需要安装操作系统的服务器已安装到位。 ?置设备启动顺序。 在BIOS的设备启动优先级设置中,将光驱设置为第一启动设备,硬盘设置为第二启动设备。 以Windows Server 2008操作系统为例,介绍Windows操作系统的安装过程。 1.将USB光驱插入服务器的USB接口或通过高密线缆将USB光驱连接到服务器节点, 将ServiceCD光盘放入USB光驱。 2.将服务器上电,系统启动,进入POST(Power-on Self-test)阶段。 3.ServiceCD自动引导系统进入安装启动界面(如图1),按上下方向键选择 “Microsoft Windows”选项,按“Enter”键确认。 说明: 安装启动界面只显示ServiceCD在当前服务器所支持的操作系统。因此,在不同 型号的服务器上安装时,安装启动界面中的操作系统会存在不同。

图1 选择Windows操作系统 4.此时,ServiceCD提供32位和64位的Windows Server 2003和Windows Server 2008 操作系统类型(如图2),按上下方向键选择V2服务器支持的Windows Server 2008操作系统的相应版本(下面以x86版本为例进行说明)进行安装。按“Enter”键确认,ServiceCD自动加载文件。 说明: 1.Windows Server 2008 for x86为32位操作系统。 2.Windows Server 2008 for x64为64位操作系统 图2 选择Windows Server 2008操作系统类型 文件加载完成后,进入图3界面,选择是否创建系统分区。

搭建一个服务器集群 包含负载均衡,HA高可用,MySQL主从复制,备份服务器,和监控服务器,服务用discuz 论坛演示 服务器配置如下 服务器名服务器ip服务器作用 backup192.168.199.180备份+zabbix监控+NFS Nginx1192.168.199.142主Director Nginx2192.168.199.145从Director Apache1192.168.199.200Apache1 Apache2192.168.199.210Apache2 Apache3192.168.199.233Apache3 Mysql1192.168.199.126主mysql Mysql2192.168.199.131从mysql Mysql3192.168.199.197从mysql VIP192.168.199.3Apache负载均衡VIP 在所有服务器上操作 #关闭selinux sed-i's/SELINUX=enforcing/SELINUX=disabled/'/etc/selinux/config&&setenforce0; #清空iptables iptables-F&&service iptables save; #安装nfs服务 yum install-y nfs-utils epel-release 配置backup服务器 mkdir-p/data/discuz#建立discuz应用目录 mkdir/opt/backup#建立backup目录 #设置目录的属主和属组 chown-R shared:shared/data/discuz chown-R shared:shared/opt/backup vi/etc/exports#设置共享目录 /data/discuz/192.168.199.0/24(rw,sync,all_squash,anonuid=500,anongid=500) /opt/backup/192.168.199.0/24(rw,sync,all_squash,anonuid=500,anongid=500) /etc/init.d/rpcbind start;/etc/init.d/nfs start#启动NFS服务 配置mysql服务器 #挂载NFS服务器backup目录 mount-t nfs-onolock192.168.199.180:/opt/backup/opt vi/etc/fstab 192.168.199.180:/opt/backup/opt nfs nolock00 安装MySQL #在3台mysql服务器上下载mysql5.7的二进制安装文件

本文由szg81贡献 doc1。 七台服务器的集群方案 在传统的终端/主机的网络模式时代,终端功能简单,无需维护工作,在主机一端进行专门的管理与维护,具有资源共享、便于 管理的特点。但是,主机造价昂贵,终端没有处理能力,限制了网络的规模化发展。之后的客户机/服务器模式推进了计算产业 的标准化和开发化的发展,为系统提供了相当大的灵活性,但是随着分布系统规模的规模扩大,系统的维护和管理带来了巨大 的开销。面向 Internet 的服务型应用,需要高性能的硬件平台作为支持,将并行技术应用在服务器领域中,是计算机发展的必然 趋势。并行处理技术在高性能计算领域中,高可用和高性能是集群服务器系统发展的两个重要方向。 集群的概念 集群英文名称是 CLUSTER,是一组相互独立的、通过高速网络互联的计算机,它们构成了一个组,并以单一系统的模式加以管 理。一个客户与集群相互作用时,集群像是一个独立的服务器。集群配置是用于提高可用性和可缩放性。和传统的高性能计算 机技术相比,集群技术可以利用各档次的服务器作为节点,系统造价低,可以实现很高的运算速度,完成大运算量的计算,具 有较高的响应能力,能够满足当今日益增长的信息服务的需求。 集群技术应用的需求 Internet 用户数量呈几何级数增长和科学计算的复杂性要求计算机有更高的处理能力,而 CPU 的发展无法跟上不断增长的需求, 于是我们面临以下问题: ●大规模计算如基因数据的分析、气象预报、石油勘探需要极高的计算性能。 ●应用规模的发展使单个服务器难以承担负载。 ●不断增长的需求需要硬件有灵活的可扩展性。 ●关键性的业务需要可靠的容错机制。 IA 集群系统(CLUSTER)的特点 ●由若干完整的计算机互联组成一个统一的计算机系统; ●可以采用现成的通用硬件设备或特殊应用的硬件设备,例如专用的通讯设备; ●需要特殊软件支持,例如支持集群技术的操作系统或数据库等等; ●可实现单一系统映像,即操作控制、IP 登录点、文件结构、存储空间、I/O 空间、作业管理系统等等的单一化; ●在集群系统中可以动态地加入新的服务器和删除需要淘汰的服务器, 从而能够最大限度地扩展系统以满足不断增长的应用的需 要; ●可用性是集群系统应用中最重要的因素,是评价和衡量系统的一个重要指标; ●能够为用户提供不间断的服务,由于系统中包括了多个结点,当一个结点出现故障的时候,整个系统仍然能够继续为用户提供 服务; ●具有极高的性能价格比,和传统的大型主机相比,具有很大的价格优势; ●资源可充分利用,集群系统的每个结点都是相对独立的机器,当这些机器不提供服务或者不需要使用的时候,仍然能够被充分 利用。而大型主机上更新下来的配件就难以被重新利用了。 实现服务器集群的硬件配置 ●网络服务器 七台 ●服务器操作系统硬盘 七块 ●ULTRA 160 LVD SCSI 磁盘阵列 一个 ●18G SCSI 硬盘 十块 ●网络服务网卡 十四块 服务器集群的实践步骤 ●在安装机群服务之前的准备: 1、 十四块 18G SCSI 硬盘组成磁盘阵列,做 RAID5。 2、 两台服务器要求都配置双网卡,分别安装 Microsoft Windows Server2008 操作系统,并配置网络。 3、 所有磁盘必须设置成基本盘,阵列磁盘分区必须大于 7 个。 4、 每台服务器都要加入域当中,成为域成员,并且在每台服务器上都要有管理员权限。 ●安装配置服务器网络要点 1、在这一部分,每个服务器需要两个网络适配器,一个连接公众网,一个连接内部网(它只包含了群集节点) 内部网适配器 。 建立点对点的通信、群集状态信号和群集管理。每个节点的公众网适配器连接该群集到公众网上,并在此驻留客户。 2、安装 Microsoft Windows 2000 Adwance Server 操作系统后,开始配置每台服务器的网络。在网络连接中我们给连接公众网的 命名为"外网",连接内部网的命名为"内网"并分别指定 IP 地址为:节点 1:内网:ip:10.10.10.11 外网 ip:192.168.0.192 子网 掩码:255.255.255.0 网关:192.168.0.191(主域控制器 ip) ;节点 2:内网:ip:10.10.10.12 外网 ip:192.168.0.193 子网掩码: 255.255.255.0 网关:192.168.0.191;节点 3:内网:ip:10.10.10.13 外网 ip:192.168.0.194 子网掩码:255.255.255.0 网关: 192.168.0.191;节点 4:内网:ip:10.10.10.14 外网 ip:192.168.0.195 子网掩码:255.255.255.0 网关:192.168.0.191;节点 5: 内

WindowsServer2012R2文件服务器安装与配置01 文件服务器配置的相关目录

02 基础说明与安装 一、文件服务器的基础说明 文件服务器是企业里面用的最多的服务器之一,它主要用于提供文件共享。 为了配合文件服务器的权限管理,从Windows Server 2008新增了文件服务器资源管理器,其实在Windows Server 2003里面也有文件服务器资源管理器的功能,只是放于DFS功能模块里面了。 文件服务器资源管理器是一组可让你对文件服务器上存储的数据进行管理和分类的功能。文件服务器资源管理器包括以下功能: 文件分类基础结构文件分类基础结构通过分类流程的自动化提供对数据的洞察力,从而让你更有效地管理数据。你可以基于此分类对文件进行分类并应用策略。示例策略包括限制访问文件的动态访问控制、文件加密和文件过期。可以使用文件分类规则自动分类文件,也可以修改所选文件或文件夹的属性手动分类文件。 文件管理任务文件管理任务可让你基于分类对文件应用有条件的策略或操作。文件管理任务的条件包括文件位置、分类属性、创建文件的数据、文件的上一次修改日期或上一次访问文件的时间。文件管理任务可以采取的操作包括使文件过期、加密文件的功能,或运行自定义命令的功能。 配额管理配额允许你限制卷或文件夹可拥有的空间,并且它们可自动应用于卷上创建的新文件夹。你还可以定义可应用于新卷或文件夹的配额模板。 文件屏蔽管理文件屏蔽可帮助控制用户可存储在文件服务器上的文件类型。你可以限制可存储在共享文件上的扩展名。例如,你可以创建文件屏蔽,不允许包含MP3 扩展名的文件存储在文件服务器上的个人共享文件夹上。 存储报告存储报告可用于帮助你确定磁盘使用的趋势以及数据分类的方式。你还可以监视尝试要保存未授权文件的一组所选用户。 通过使用文件服务器资源管理器Microsoft 管理控制台(MMC) 或使用Windows PowerShell,可以配置和管理文件服务器资源管理器包含的功能。 二、文件服务器的基础安装 1、在服务器管理界面点击“添加角色和功能”,进入到“选择服务器角色”,选择“文件服务器”与“文件服务器资源管理器”。

RH2285 EP Windows Server 2008 安装手册 拟制: Prepared by 陈远明 KF59885 日期: Date 2012-2-24 审核: Reviewed by 日期:Date 批准: Granted by 日期: Date 华为技术有限公司Huawei Technologies Co., Ltd. 版权所有侵权必究 All rights reserved

1安装前准备 1.1硬件环境准备 1、操作系统安装光盘: Windows2008 R1 sp2 32位系统需两张光盘:一张系统盘,一张升级成sp2光盘 Windows Server 2008 R2 sp1 64位系统需一张系统光盘 2、USB光驱一个 3、USB软驱一个 1.2软件环境准备 1.LSI硬盘控制器驱动 如果是LSI 2308 硬盘驱动器,则需加载2308驱动,驱动如下所示: (解压后并拷贝到软盘中) 注:也可以使用虚拟软驱挂载虚拟镜像文件: 如果是LSI 2208 硬盘驱动器,则需加载2208 驱动,驱动如下所示: (解压后并拷贝到软盘中) 注:也可以使用虚拟软驱挂载虚拟镜像文件: 2.驱动程序: 3. 82580网卡驱动 1.332为系统使用位系统使用环境配置 1、单板在启动阶段点击“DEL”键,设置BIOS时间为当前时间,如图1-1。 1-1 2、输入“F9”,将BIOS的设置进行“Load Optimal Default”操作,如图1-2,“YES” 确认。

1-2 3、输入“F10”,保存BIOS设置并退出,,如图1-3,“Yes”确认后系统将会自动重启。 1-3 4、在系统启动,LSI控制器初始化的时候,根据实际情况按相应的提示信息配置好磁盘 RAID关系。 如果是LSI SAS2308控制器,按下“Ctrl+C”,进入2308 SAS控制器的setup菜 单,配置好磁盘raid 如果是LSI SAS2208控制器,按下“Ctrl+H”,进入2208 SAS控制器的setup菜 单,配置好磁盘raid 5、如果LSI 2308控制器下挂了多个硬盘,必需将系统安装硬盘安装在bootdevice上, 因此需要在2308 SAS控制器的setup菜单中设置你即将作为系统盘那个硬盘为bootdevice,依次进入LSISAS2308->SAS Topology->Ditrect Attach Devices 如下界面所示,选择一个硬盘,例如“ATA ST9500420AS”,然后输入“Alt+B”,如下图1-4红框所示,出现“BOOT”即成功,然后保存退出: 1-4 2安装过程 1、将标识为DVD 1的光盘放入USB光驱,重新启动服务器单板,在POST阶段点击“F11” 键,在弹出的对话框中,选择从USB光驱启动(如图)然后“Enter”确认。在出现提 示Press any key to boot from CD …时,迅速按任意键,从光盘启动。 2、进入安装界面,在安装界面下方出现提示:“Enter your language and other preferences and click “Next” to continue.”通过下接拉框选择分别选择安 装语言,时间和当前格式,键盘等属性,按“Next”进入下一步。

l i n u x服务器集群的详细 配置 This model paper was revised by the Standardization Office on December 10, 2020

linux服务器集群的详细配置 一、计算机集群简介 计算机集群简称集群是一种计算机系统,它通过一组松散集成的计算机软件和/或硬件连接起来高度紧密地协作完成计算工作。在某种意义上,他们可以被看作是一台计算机。集群系统中的单个计算机通常称为节点,通常通过局域网连接,但也有其它的可能连接方式。集群计算机通常用来改进单个计算机的计算速度和/或可靠性。一般情况下集群计算机比单个计算机,比如工作站或超级计算机性能价格比要高得多。 二、集群的分类 群分为同构与异构两种,它们的区别在于:组成集群系统的计算机之间的体系结构是否相同。集群计算机按功能和结构可以分成以下几类: 高可用性集群 High-availability (HA) clusters 负载均衡集群 Load balancing clusters 高性能计算集群 High-performance (HPC) clusters 网格计算 Grid computing 高可用性集群 一般是指当集群中有某个节点失效的情况下,其上的任务会自动转移到其他正常的节点上。还指可以将集群中的某节点进行离线维护再上线,该过程并不影响整个集群的运行。 负载均衡集群

负载均衡集群运行时一般通过一个或者多个前端负载均衡器将工作负载分发到后端的一组服务器上,从而达到整个系统的高性能和高可用性。这样的计算机集群有时也被称为服务器群(Server Farm)。一般高可用性集群和负载均衡集群会使用类似的技术,或同时具有高可用性与负载均衡的特点。 Linux虚拟服务器(LVS)项目在Linux操作系统上提供了最常用的负载均衡软件。 高性能计算集群 高性能计算集群采用将计算任务分配到集群的不同计算节点而提高计算能力,因而主要应用在科学计算领域。比较流行的HPC采用Linux操作系统和其它一些免费软件来完成并行运算。这一集群配置通常被称为Beowulf集群。这类集群通常运行特定的程序以发挥HPC cluster的并行能力。这类程序一般应用特定的运行库, 比如专为科学计算设计的MPI库 集群特别适合于在计算中各计算节点之间发生大量数据通讯的计算作业,比如一个节点的中间结果或影响到其它节点计算结果的情况。 网格计算 网格计算或网格集群是一种与集群计算非常相关的技术。网格与传统集群的主要差别是网格是连接一组相关并不信任的计算机,它的运作更像一个计算公共设施而不是一个独立的计算机。还有,网格通常比集群支持更多不同类型的计算机集合。 网格计算是针对有许多独立作业的工作任务作优化,在计算过程中作业间无需共享数据。网格主要服务于管理在独立执行工作的计算机间的作业分配。资源如存储可以被所有结点共享,但作业的中间结果不会影响在其他网格结点上作业的进展。

(售后服务)集群服务器安 装

WIN2Kadvanceserver集群服务器安装 壹:安装要求 1.软件要求 于群集里的所有计算机上,均安装了MicrosoftWindows2000AdvancedServer或 Windows2000DataCenterServer。 2.硬件要求 群集服务节点的硬件,必须满足Windows2000AdvancedServer或Windows2000DataCenterServer的硬件要求。这些要求可于产品兼容性查找页面找到。 群集硬件必须是于群集服务硬件兼容性列表里的(HCL)。到Windows硬件兼容性列 表中,查询群集,就能够找到最新的群集服务HCL。 俩台满足HCL的计算机,分别具有如下配置: 有所安装的Windows2000AdvancedServer或 Windows2000DataCenterServer的启动盘。该启动盘不能位于下面 所描述的共享存储总线上。 共享的磁盘有独立的PCI存储适配器(SCSI或光纤)。启动盘适配器 除外。 群集里的每台计算机有俩块PCI网络适配器。 有HCL兼容的外部存储单元,它跟所有的计算机相连。它被作为群 集磁盘使用。建议使用独立磁盘冗余阵列(RAID)。 用存储线缆,将共享设备连接到所有的计算机。可参考制造商的指南, 配置存储设备。 3.网络要求 唯壹的NetBIOS群集名。 五个独立的、静态的IP地址:俩个用于内部网的网络适配器(192.0.0.1、192.0.0.2), 俩个用于外接公众网的网络适配器(10.10.100.1、10.10.100.2),壹个用于群集本身 (10.10.100.3)。

两台服务器集群巧搭建 服务器集群系统中,服务器不再分布在各处,而是集中在一起统一进行管理和维护。它保持了分布式客户机/服务器模式的开发性、可扩展性的优点,同时又具备了终端/主机模式的资源共享和集中易于管理的优点。 服务器集群系统中,服务器不再分布在各处,而是集中在一起统一进行管理和维护。它保持了分布式客户机/服务器模式的开发性、可扩展性的优点,同时又具备了终端/主机模式的资源共享和集中易于管理的优点。相对集中的集群系统,降低了系统管理的成本,而且还提供了和大型服务器系统相媲美的处理能力。 在传统的终端/主机的网络模式时代,终端功能简单,无需维护工作,在主机一端进行专门的管理与维护,具有资源共享、便于管理的特点。但是,主机造价昂贵,终端没有处理能力,限制了网络的规模化发展。之后的客户机/服务器模式推进了计算产业的标准化和开发化的发展,为系统提供了相当大的灵活性,但是随着分布系统规模的规模扩大,系统的维护和管理带来了巨大的开销。 面向Internet的服务型应用,需要高性能的硬件平台作为支持,将并行技术应用在服务器领域中,是计算机发展的必然趋势。并行处理技术在高性能计算领域中,高可用和高性能是集群服务器系统发展的两个重要方向。 集群的概念 集群英文名称是CLUSTER,是一组相互独立的、通过高速网络互联的计算机,它们构 成了一个组,并以单一系统的模式加以管理。一个客户与集群相互作用时,集群像是一个独立的服务器。集群配置是用于提高可用性和可缩放性。 和传统的高性能计算机技术相比,集群技术可以利用各档次的服务器作为节点,系统造价低,可以实现很高的运算速度,完成大运算量的计算,具有较高的响应能力,能够满足当今日益增长的信息服务的需求。 #P# 集群技术应用的需求 Internet用户数量呈几何级数增长和科学计算的复杂性要求计算机有更高的处理能力,而CPU的发展无法跟上不断增长的需求,于是我们面临以下问题: ●大规模计算如基因数据的分析、气象预报、石油勘探需要极高的计算性能。 ●应用规模的发展使单个服务器难以承担负载。 ●不断增长的需求需要硬件有灵活的可扩展性。 ●关键性的业务需要可靠的容错机制。 #P# IA集群系统(CLUSTER)的特点 ●由若干完整的计算机互联组成一个统一的计算机系统; ●可以采用现成的通用硬件设备或特殊应用的硬件设备,例如专用的通讯设备;

W A S集群部署方案及安装 配置手册 Prepared on 24 November 2020

1. 部署方案参考 如上图所示,中间件平台主要包括两大部分: ●负载分发层 ?包括两台服务器,通过Heartbeat实现HA,提供浮动IP给客户 端,保证了系统不存在单点故障问题 ?负载分发软件采用IBM HTTP Server实现 ?通过IBM HTTP Server配置虚拟主机,实现对不同应用的请求进行 分发到不同的后台WAS中间件集群。 ●WAS中间件集群 ?包括两台4CPU(每CPU 4Core)服务,每个服务器上通过水平扩展可 以启动多个WAS服务器。 ?基于应用部署要求,为每个应用建立一个集群,逻辑上实现应用之 间的隔离。 ?每个集群可以根据应用的负载,动态分配WAS服务器实例数。如 HR应用访问量较大则分配4个WAS实例。

?但最小要保证一个集群至少包括2个WAS实现,并且这两个实例 分别在不同的物理服务器上,这样才能保证不出现单点故障。 ?部署管理器,部署在WAS Server1上。 2. WebSphere 7安装及配置 此安装配置说明仅供参考,还需要根据现场实现情况进行调整。 2.1.WAS安装 一、四台服务器拓朴结构 四台机器IP地址,名称与安装内容 主机名IP 安装软件(组件)

其中DM控制台管理用户admin,口令 两个web服务器的管理用户也是admin,口令 二、安装后验收 可打开应用服务器主机的控制管理台,管理用户admin,口令****** 服务器->集群下建有应用集群 服务器->应用服务器下建有两个WEB服务 节点共有五个,分别是一个控制节点(一个dmgr节点),两个受控节点(两个app 节点),两个非受控节点(两个web节点) 集群下各受控节点已同步,并启动服务;两个WEB服务已生成插件、传播插件并启动。 在DMGR控制管理台可直接控制两个WEB的启动与停止。 三、安装前系统检查 ?群集安装时,确认所有机子的日期要一致 ?确认磁盘空间足够 两个应用服务器的安装文件放在/was_install 两个WEB服务器的安装文件放在/http_install 安装目录都是安装于默认的/opt目录下

华为服务器安装操作系统 1.把网线接到服务器管理口上,2288服务器管理口在服务器背后 中下部位置,有Mgmt的指示字样。 5885服务器管理口在服务器背后右中部位置,有Mgmt的指示字样。 2.另一端连接到电脑上,并配上ip地址,段地址。 3.在浏览器输入管理口默认ip地址:,可以先ping测该地址是否通。 4.点击访问后出现登录界面,输入默认用户名:root,密码:Huawei12#$ 5. 先检查服务器是否有告警,若有告警请参照提示查看处理。 6.下面开始安装操作系统,点击远程控制,若计算机没有安装java,请按提示引导正确安装java。 7.安装完后在安全中配置例外地址。 8.配置完成后点击远程虚拟控制台 9.弹出java安全提示,允许

10.出现虚拟KVM如下,上面一列是工具栏。 11.点击光驱,加载引导。 12.如果本地电脑有光驱,找到服务器自带的引导盘,放入光驱。 13.在虚拟KVM上选择光驱,并点连接。 14.如果没有光驱,本地有引导镜像也可以加载镜像,并点击连接。 15.连接上后,显示的是断开。 16.镜像加载后,点击强制重启。 17.重启界面。 18. 重启到这个界面时按F11进入选择启动项。

如果管理口ip被修改且忘记,可以接上一台显示器,重启服务器 到这个界面可以查看。 19.按到F11会有如下提示,如果没按到,需要强制重启重按。 20.提示要求输入密码:Huawei12#$ 21.进入后选择从虚拟光驱启动,2288如下,5885略有不同。 22.加载光盘完以后到操作界面,选择做RAID。 23.选择要做RAID组的磁盘。并选择合适的RAID。完成后点击创建。 24.在建好的虚拟磁盘组上右键,选择设为启动盘。 25.这几步做好后,点击右上角返回。

7 步10 分钟服务器集群已构建完毕 1、前言 每当服务器要报废,或者有新业务上线的时候,运维人总是会比较辛苦,要上线新的服 务器以支撑业务,这通常意味着一系列的工作,上架服务器、分配网络、安装对应的操作系 统、安装业务应用,这些仅仅是第一步而已,但这已经耗费了大量的时间。可能运维兄弟的 另一半永远不会担心为什么下班了还没有回家,那肯定是在加班!对于物理环境而言,上线 一台服务器跟上线一个服务器集群,也许都是重复工作,但却需要大量的时间。如果我告诉 你,上线一个服务器集群,只需要10 分钟,你信吗? 其实没什么信不信的,因为这就是事实!这不是什么高级的人工智能,而是得益于云计算技术的成熟发展,人均运维几千台服务器已经不是什么难事,大幅缩减简单重复的工作,几分钟构建一套应用集群,已经真实可用了,下面就介绍如何在10 分钟内构建一套完整的服务器集群。 2、第一分钟,构建网络 使用公有云服务的话,就省去了服务器上架等流程,直接从接通网络开始。在使用公有 云时,我们通常做的第一件事情是构建网络,相对于物理环境下的复杂网络配置,在公有云 上构建网络只需要简单两步,整个过程不到1 分钟: 第一步创建路由器 图1

在网络界面选择“路由器”,然后点击“创建”,选择你希望构建服务器集群的数据中心,如图1 中的“华北、华南、华东、香港”,这是公有云数据中心所在的位置。然后输入你希望创建的路由器的名称,比如创建一个名为“Testlab”的路由器。 第二步创建子网 图2 在网络界面选择“子网”,然后点击“创建”,在弹窗内输入子网名称和CIDR,并选择需要连接的路由器,如图2 所示,创建同名的子网和路由器,这是出于便于管理的目的,然后CIDR 中选择希望使用的网段,这个可根据实际需求进行选择。图2 中选择了“192.168.2.0/24” 网段,这主要是为了与之前的网络进行隔离。点击“确定”按钮之后,等待页面刷新,不到5 秒钟,网络就创建好了,然后就可以进入服务器创建过程了。

华为服务器安装redhat操作系统指导 书 业务IP段:10.182.80.1-10.182.80.43 管理IP段:10.183.43.121-10.183.43.163 主机名称:HQATMAPP(ip后两段) 例:HQATMAPP080001 ROOT密码:root 一、格式化Raid卡,并配置Raid。 1、通过web登入服务器IPMI管理页面进入虚拟控制台(或通过在服务器尾接入显示器)进行服务器界面。 2、确认当前服务器业务均已经停止,所有数据均已备份。 3、重启操作系统。根据服务器界面raid 配置提示,按键进入Raid卡配置界面。(根据不同型号的raid卡进行配置) (如下图所示:) 4、通过raid卡配置界面提示,清楚当前raid卡配置。并按照需求新建raid。 (如下图所示:)

按“↑”、“↓”将光标移至“SAS3108 (Bus 0x01, Dev 0x00)”。 按“F2”,在弹出的列表中选择“Create Virtual Drive”,按“Enter”。 参数项说明 Strip Size 每个硬盘上的数据条带的大小。默认配置为256KB。 Read Policy 虚拟磁盘的数据读策略,分以下两种: ?Normal:关闭预读取功能(Read Ahead)。 ?Ahead:使能预读取功能。控制器可以预读取顺序数据或

参数项说明 提升,但当系统意外掉电时,如果没有保护机制,数据会 丢失。 ?Disable:读写过程中数据不经过硬盘写Cache,当系统意外掉电时,数据不会丢失。 ?Unchanged:保持当前磁盘Cache策略。 Initialize 选中“Initialize”后,RAID创建完成后自动进行快速初始化操作。初始化会破坏RAID组成员盘上数据。 选中后,会在前方显示“[X]”。 Configure HotSpare 为RAID组配置热备盘。 选中后,会在前方显示“[X]”。创建RAID 0时,该参数无效。 大数据raid配置需求

系统部署及集群配置 手册 版本:1.1

变更记录

1引言 1.1 编写目的 新HD是集群部署,所以在HD上线的时候我才有机会我目睹了部署的整个过程,所以编写一份集群部署的文档来和大家分享,也希望大家多提意见。 2安装系统、存储设置 2.1 服务器配置 现有设备HP服务器两台,首先是给服务器安装windows2008系统。 注意事项:HP服务器的特点是要先安装驱动,然后系统会提示插入系统盘,会自动将系统盘上的数据存入复制到服务器上的硬盘,然后再安装系统。 2.2 存储设置 2.2.1存储布线 电源线:将电源线插头插入到各电源装置中的插座中。 LAN连接线:以太网LAN电缆连接到控制器#0或控制器#1上的LAN管 理端口中另一端连接到管理控制台上的LAN端口。 * 10.0.0.16/10.0.0.17是无法改变的。正常情况下请使用管理端口,连接时准备两条网线,将两个控制器同时联入内部局域网进行带外管理。 2.2.2存储设置 2.2.2.1安装管理软件 从随机光盘中找到对应版本的 Storage Navigator Modular2 安装程序,这里是“HSNM2-0600-W-GUI-P01.exe” ,双击该程序,安装默认安装即可。

2.2.2.2安装和配置JA V A 首先要删除管理PC上存留的所有java版本及所有的安装目录和文件,检查JAVA 目录下只有唯一的JAVA版本,并确保“添加/删除程序”中也只有唯一的JAVA 版本。设置临时文件不要保留在计算机上。将JAVA Runtime参数设置成:-Xmx192m 2.2.2.3登录管理软件 在管理PC上运行web浏览器,在地址栏输入: http://