压力测试报告目录

1 简介

1.1目的和范围

1.2术语和缩略语

1.3测试方案摘要

1.4测试方法

1.5测试工具

2 测试环境与配置

2.1 测试网络关系图

2.2 测试软硬件环境及配置

3 性能测试业务描述

3.1 测试需求

3.2 测试点1:点击分析按钮进行检索

4 测试结果

4.1 测试场景

4.1.1 场景设计1:

4.1.2 场景设计2:

4.2 测试结果

4.2.1 场景1结果:

4.2.2 场景2结果:

5 性能测试业务描述

5.1 场景1结果分析

5.2 场景2结果分析

6 结论

6.1 场景1结论

6.2 场景2结论

1 简介

1.1 目的和范围

完成对NLP管理系统的压力测试

主要是对硬件环境、系统设置等方面的调整来达到预期的性能目标。

1)测试产品在单台应用服务器上部署时可以承受的最大并发数;

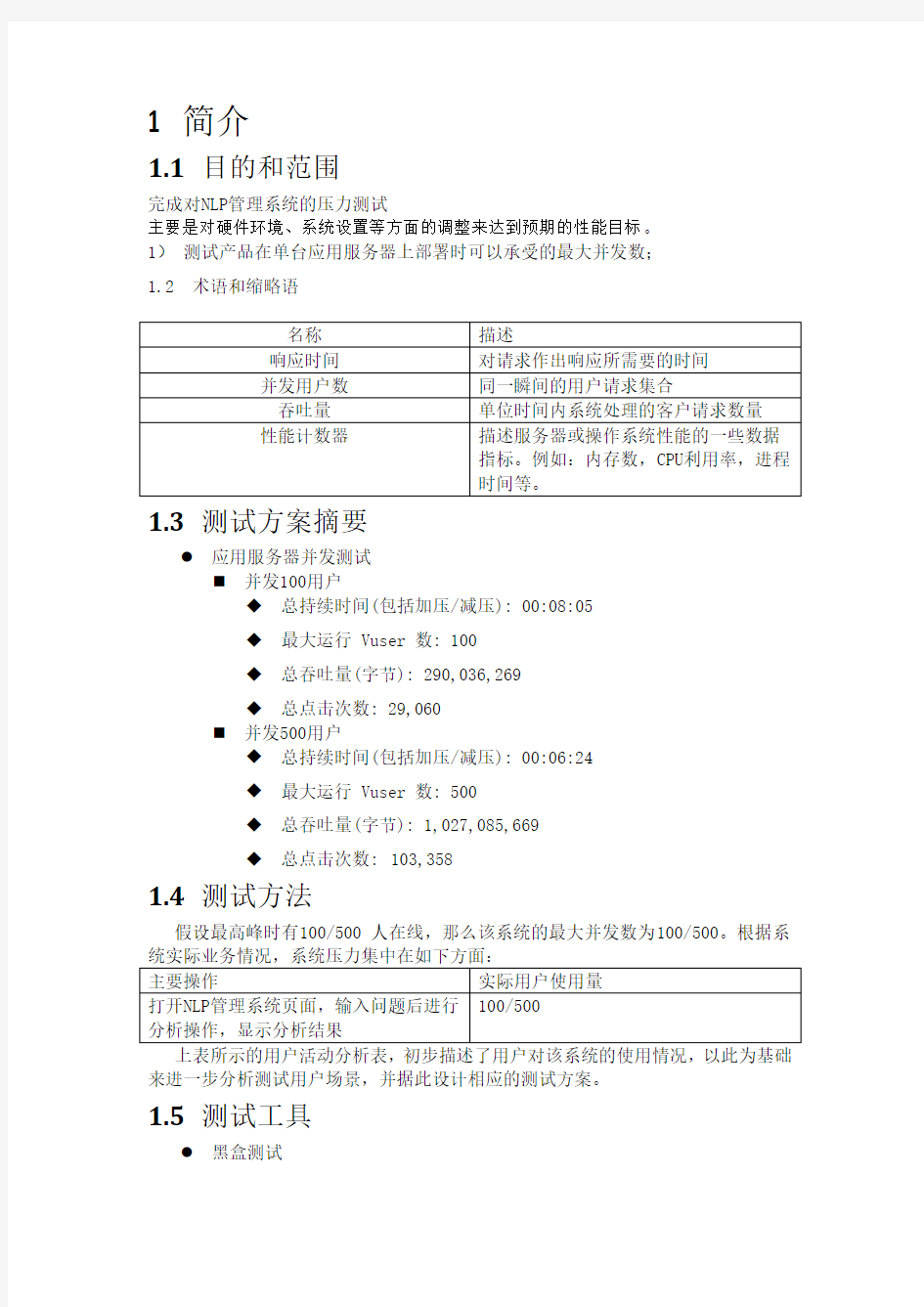

1.2 术语和缩略语

1.3 测试方案摘要

● 应用服务器并发测试

? 并发100用户

◆ 总持续时间(包括加压/减压): 00:08:05

◆ 最大运行 Vuser 数: 100

◆ 总吞吐量(字节): 290,036,269

◆ 总点击次数: 29,060

? 并发500用户

◆ 总持续时间(包括加压/减压): 00:06:24

◆ 最大运行 Vuser 数: 500

◆ 总吞吐量(字节): 1,027,085,669

◆ 总点击次数:103,358

1.4 测试方法

假设最高峰时有100/500 人在线,那么该系统的最大并发数为100/500。根据系

来进一步分析测试用户场景,并据此设计相应的测试方案。

1.5 测试工具

● 黑盒测试

● 测试工具:LoadRunner 11.0

2 测试环境与配置

2.1 测试网络关系图

2.2 测试软硬件环境及配置

3 性能测试业务描述

3.1 测试需求

整体测试标准:

● 应用服务器支持的最大并发数(要求不低于100)。

● 当数据库数据达到50万条时,单次分析的时间(要求不高于3s)。

● 上述两种情况下,对应的应用服务器、数据库服务器CPU使用率,内存使用率,要求:

? 应用服务器CPU平均占用率(%)< 70;

? 数据库服务器CPU平均占用率(%)< 70;

? 应用服务器内存最高占用率(%)< 90;

? 数据库服务器内存最高占用率(%)< 90。

3.2 测试点1:点击分析按钮进行问题分析

用户填入需要分析的提问,并点击分析按钮,显示分析结果。

【验证】页面上显示出分析后的结果。

4 测试结果

4.1 测试场景

4.1.1 场景设计1:

每10秒钟增加10个用户数,每个用户一直连续重复查询10个问题,当最大增加到并发用户为100用户时,持续运行5分钟后,以每10秒减少10个用户数减压,至用户数为0。

● 增加运行虚拟用户数方案如下图:

● 测试中的查询问题来着上次功能测试中的提问,进行测试的问题列表如下所示:Q1:我要找人民广场附近的必胜客

Q2:静安寺附近的酒吧

Q3:我周围有西餐厅吗

Q4:四川北路上的必胜客在哪里

Q5:八佰伴周围有西餐厅吗

Q6:我附近的餐馆有哪些

Q7:金桥小南国附件的酒店

Q8:中山西路上的肯德基在哪里

Q9:百货大楼周围的西餐厅

Q10:人民路附近的安基大厦在哪里

4.1.2 场景设计2:

每50秒钟增加5个用户数,每个用户一直连续重复查询10个问题,当最大增加到并发用户为500用户时,持续运行5分钟后,以每150秒减少5个用户数减压,至用户数为0。

● 增加运行虚拟用户数方案如下图:

● 测试中的查询问题同“4.1.1场景设计1”中的问题列表。

4.2 测试结果

4.2.1 场景1结果:

并发用户数:100

行的成功数是1298,故,压测的分析事务执行情况的总的成功数为:1298×10=12980。

● 分析事务响应详细时间表:

Transaction Name SLA Status Minimum Average Maximum Std. Deviation 90 Percent Pass Fail Stop

Q10.013 0.191 0.705 0.114 0.347 1,300 0 0

Q100.007 0.018 0.439 0.03 0.024 1,290 0 0

Q20.007 0.021 0.462 0.039 0.026 1,300 0 0

Q30.007 0.016 0.234 0.015 0.024 1,300 0 0

Q40.008 0.019 0.539 0.023 0.033 1,300 0 0

Q50.008 0.018 0.319 0.022 0.024 1,300 0 0

Q60.007 0.017 0.535 0.027 0.022 1,300 0 0

Q70.007 0.016 0.321 0.023 0.022 1,300 0 0

Q80.008 0.021 0.563 0.03 0.034 1,300 0 0

Q90.007 0.018 0.367 0.026 0.025 1,290 0 0

说明:这里的Q1~Q10是上次功能测试的问题中的实际提问,详细参见“4.1.1场景

设计1”中的问题列表。

● CPU监测图

略

4.2.2 场景2结果:

并发用户数:500

行的成功数是4521,故,压测的分析事务执行情况的总的成功数为:4521×10=45210。

● 分析事务响应详细时间表:

Transaction Name SLA Status Minimum Average Maximum Std. Deviation 90 Percent Pass Fail Stop

Q10.012 2.902 35.527 3.22 6.589 4,676 0 3

Q100.008 0.52 28.359 1.265 1.26 4,322 0 0

Q20.007 0.574 41.183 1.146 1.35 4,675 0 0

Q30.008 0.489 14.791 1.006 1.232 4,657 0 0

Q40.007 0.485 22.525 1.066 1.251 4,620 0 1

Q50.009 0.449 31.313 1.062 1.185 4,556 0 3

Q60.007 0.48 37.283 1.084 1.204 4,499 0 0

Q70.008 0.457 19.052 1.077 1.143 4,446 0 0

Q80.007 0.451 23.845 0.937 1.19 4,406 0 0

Q90.008 0.504 19.278 0.991 1.269 4,351 0 0

说明:这里的Q1~Q10是上次功能测试的问题中的实际提问,详细参见“4.1.1场景

设计1”中的问题列表。

● CPU监测图

略

5 测试结果分析

5.1 场景1结果分析:

每10秒钟增加10个用户数,每个用户一直连续重复查询10个问题,当最大增加到并发用户为100用户时,持续运行5分钟后,以每10秒减少10个用户数减压,至用户数为0。

整个过程中,所有分析事务都得到成功执行,10个具体问题的分析事务执行的平均响应时间为0.02秒左右, 90%分析响应时间为0.025秒左右,每秒分析次数平均为59.794次。

应用服务器的CPU最大占用率为21%,平均占用率为10%,小于70%。

应用服务器的内存最大占用率为22%,平均占用率为22%,小于90%。

5.2 场景2结果分析:

每50秒钟增加5个用户数,每个用户一直连续重复查询10个问题,当最大增加到并发用户为500用户时,持续运行5分钟后,以每5秒减少150个用户数减压,至用户数为0。

整个过程中,所有分析事务都得到成功执行,10个具体问题的分析事务执行的平均响应时间为0.51秒左右, 90%分析响应时间为1.23秒左右,每秒风析次数平均为268.462次。

应用服务器的CPU最大占用率为24%,平均值为15%,小于70%。

应用服务器的内存最大占用率为22%,平均占用率为22%,小于90%。

6 结论

6.1 场景1结论:

1.本次测试脚本主要设置分析事务来进行测试。按照递增用户数逐渐增加压力,最高并发100用户数的场景进行测试。

2.并发用户数达到100个时,响应时间很平均。所有分析事务都成功执行,每个问题的分析事务执行平均响应时间为0.02秒左右。

3.应用服务器的CPU最大占用率为21%,平均占用率为10%。

4. 应用服务器的内存最大占用率为22%,平均占用率为22%。

6.2 场景2结论:

1.本次测试脚本主要设置分析事务来进行测试。按照递增用户数逐渐增加压力,最高并发500用户数的场景进行测试。

2.并发用户数达到500个时,响应时间很平均。所有分析事务都成功执行,每个问题的分析事务执行平均响应时间为0.51秒左右。

3.应用服务器的CPU最大占用率为24%,平均占用率为15%。

4. 应用服务器的内存最大占用为22%,平均占用为22%。

XXXX软件项目系统测试报告

1.引言部分 1.1项目背景 本测试报告的具体编写目的,指出预期的读者范围。(3-4句) 本测试报告为(系统名称)系统测试报告;本报告目的在于总结测试阶段的测试及测试结果分析,描述系统是否达到需求的目的。 本报告预期参考人员包括测试人员、测试部门经理、项目管理人员、SQA人员和其他质量控制人员。 1.2参考资料 《XXXX需求说明书》 2.测试基本信息 2.1测试范围 2.2测试案例设计思路 根据上述测试范围测试点进行测试用例的设计。 3.测试结果及缺陷分析 3.1测试执行情况与记录 3.1.1测试组织 第 2 页共4 页

3.1.2测试时间 3.1.3冒烟情况 3.1.4测试用例统计 3.2缺陷的统计与分析 缺陷汇总: 列出本次实际发现缺陷数、解决的缺陷数、残留的缺陷数、未解决的缺陷数。 缺陷分析: 对测试中发现的缺陷按缺陷类型、严重程度进行分类统计: 对测试中发现的缺陷就其功能分布、测试阶段进行统计,分析软件缺陷倾向及其主要原因: 残留缺陷与未解决问题 对残留缺陷对系统功能的影响情况进行分析:对未解决问题对项目的影响(如有,列表说明) 4.测试结论与建议 4.1风险分析及建议 无 第 3 页共4 页

4.2测试结论 本项目根据业务需求及开发人员的反馈意见,覆盖了所有的测试需求及案例,均已在ST环境测试完成,有效案例一共xx个,执行率xx%,,成功率xx%,缺陷关闭率为xx%,目前缺陷均已修复并回归关闭; 综上所述,xx需求达到ST项目测试出口标准,本项目ST测试(通过/不通过),可以进行验收测试 5.交付文档 《xxx需求_系统测试计划》 《xx需求_测试案例》 《xx需求_ST测试报告》 第 4 页共4 页

南昌大学软件学院 实验报告 实验名称 LoadRunner的使用 实验地点 实验日期 指导教师 学生班级 学生姓名 学生学号 提交日期 LoadRunner简介: LoadRunner 是一种适用于各种体系架构的自动负载测试工具,它能预测系统行为并优化系统性能。LoadRunner 的测试对象是整个企业的系统,它通过模拟实际用户的操作行为和实行实时性能监测,来帮助您更快的查找和发现问题。此外,LoadRunner 能支持广范的协议和技术,为您的特殊环境提供特殊的解决方案。LoadRunner是目前应用最为广泛的性能测试工具之一。 一、实验目的

1. 熟练LoadRunner的工具组成和工具原理。 2. 熟练使用LoadRunner进行Web系统测试和压力负载测试。 3. 掌握LoadRunner测试流程。 二、实验设备 PC机:清华同方电脑 操作系统:windows 7 实用工具:WPS Office,LoadRunner8.0工具,IE9 三、实验内容 (1)、熟悉LoadRunner的工具组成和工具原理 1.LoadRunner工具组成 虚拟用户脚本生成器:捕获最终用户业务流程和创建自动性能测试脚本,即我们在以后说的产生测试脚本; 压力产生器:通过运行虚拟用户产生实际的负载; 用户代理:协调不同负载机上虚拟用户,产生步调一致的虚拟用户;压力调度:根据用户对场景的设置,设置不同脚本的虚拟用户数量;监视系统:监控主要的性能计数器; 压力结果分析工具:本身不能代替分析人员,但是可以辅助测试结果的分析。 2.LoadRunner工具原理 代理(Proxy)是客户端和服务器端之间的中介人,LoadRunner 就是通过代理方式截获客户端和服务器之间交互的数据流。 ①虚拟用户脚本生成器通过代理方式接收客户端发送的数据包,

XXXX空心板外观检测报告

目录 一、项目概况 (1) 二、检测标准 (1) 三、检测方法 (2) 四、检测结果 (2) 4.1 裂缝测试结果 (2) 4.2 保护层厚度测试结果 (7) 4.3 混凝土强度测试结果 (10) 五、主要结论和建议 (10) 5.1 检测结论......................................................... 错误!未定义书签。 5.2 建议............................................................... 错误!未定义书签。附图I 桥梁检测照片.. (12)

XXXX空心板 外观检测报告 一、项目概况 桥中心桩号xxxx,上部结构为4跨16m预应力混凝土空心板桥,下部结构为桩柱式桥墩和桥台,钻孔灌注桩基础。该桥老桥修建于2007年,本次改建工程中在其两侧各增加两块空心板进行加宽,其中老空心板桥设计等级为公路II 级,加宽空心板设计等级为公路I级。 该桥施工完成后发现加宽空心板底板出现裂缝,受委托,我单位对该桥的裂缝情况进行现场检测。 二、检测标准 ●《公路桥梁技术状况评定标准》(JTG/T H21-2011) ●《公路桥梁承载能力检测评定规程》(JTG/T J21-2011) ●《公路桥涵养护规范》(JTG H11-2004) ●《混凝土中钢筋检测技术规程》(JGJ/T 152-2008) ●《建筑结构检测技术标准》(GB/T 50344-2004) ●《建筑结构检测技术标准》(GB/T 50344-2004) ●《混凝土结构工程施工质量验收规》(GB50204-2002) ●《回弹法检测混凝土抗压强度技术规程》(JGJ/T 23-2011)

嘉应学院计算机学院 实验报告 实验地点锡科405 课程名称软件测试实验名称负载测试工具 LoadRunner 指导老师实验时间第11周提交时间第12周班级姓名座号 一、实验目的和要求 ?规划负载测试。定义性能测试要求,例如并发用户数量、典型业务流程和要求的 响应时间。 ?创建Vuser 脚本。在自动化脚本中录制最终用户活动。 ?定义场景。使用LoadRunner Controller 设置负载测试环境。 ?运行场景。使用LoadRunner Controller 驱动、管理并监控负载测试。 ?分析结果。使用LoadRunner Analysis 创建图和报告并评估性能。 二、实验环境、内容和方法 实验环境:Windows 7 负载测试工具LoadRunner 实验对象:教务管理系统 三、实验过程描述 1.创建脚本 要生成负载,首先要创建模拟实际用户行为的自动脚本。 1.1录制用户操作: 打开VUG

创建一个空白Web 脚本 录制业务流程来创建脚本

打开一个项目后出现 登录到教务管理系统。 在User Name (用户名)框中输入11111,在Password (密码)框中输入123。单击Login (登录)。欢迎页面打开。 在浮动工具栏上单击停止以停止录制 已成功录制 2利用创建的虚拟用户脚本创建负载测试 启动Controller 默认情况下,Controller 打开时会显示“新建场景”对话框。

生成重负载 选择load generators

您将使用本地计算机作为Load Generator (默认情况下包括在场景 中)。localhost Load Generator 的状态为关闭。这说明Controller 未连接到Load Generator。 3运行负载测试场景 单击strat 监控负载下的应用程序

LoadRunner性能测试实战讲解 内容介绍: 很多使用LoadRunner的测试人员经常面临两个难题:脚本开发与性能测试分析。本书就是基于帮助测试人员解决这两个问题而编写,致力于使读者学精LoadRunnner这一强大的性能测试工具。 全书共分为四部分:入门篇、基础篇、探索篇、实战篇。第一篇入门篇的内容包括第1章和第2章,着重于讲解性能测试与LoadRunner的基础理论知识。第二篇基础篇的内容包括第3章至第5章,是LoadRunner 的基本使用部分,着重讲解Virtual User Generator、Controller、Analysis的使用方法。第三篇探索篇的... 第1部分入门篇.. (1) 第1章性能测试基础知识.. 3 1.1 性能测试基本概念 (4) 1.1.1 什么是性能测试 (4) 1.1.2 性能测试应用领域 (6) 1.1.3 性能测试常见术语 (8) 1.2 全面性能测试模型 (11) 1.2.1 性能测试策略模型 (14) 1.2.2 性能测试用例模型 (17) 1.2.3 模型的使用方法 (20) 1.3 性能测试调整基础 (21) 1.4 如何做好性能测试 (24) 1.5 本章小结 (28) 第2章LoadRunner基础知识.. 29 2.1 LoadRunner简介 (29) 2.1.1 LoadRunner主要特点 (29) 2.1.2 LoadRunner常用术语 (31) 2.2 LoadRunner工作原理 (32) 2.3 LoadRunner测试流程 (33) 2.4 LoadRunner的部署与安装 (35) 2.5 本章小结 (41) 第2部分基础篇 (43) 第3章脚本的录制与开发.. 45 3.1 Virtual User Generator简介 (45)

软件项目系统测试报告 2019年10月

1.引言部分 1.1项目背景 本测试报告的具体编写目的,指出预期的读者范围。 本测试报告为(系统名称)系统测试报告;本报告目的在于总结测试阶段的测试及测试结果分析,描述系统是否达到需求的目的。 本报告预期参考人员包括测试人员、测试部门经理、项目管理人员、SQA人员和其他质量控制人员。 1.2参考资料 XXXX需求说明书 2.测试基本信息 2.1测试范围 2.2测试案例设计思路 根据上述测试范围测试点进行测试用例的设计。

3.测试结果及缺陷分析 3.1测试执行情况与记录 3.1.1测试组织 3.1.2测试时间 3.1.3冒烟情况 3.1.4测试用例统计 3.2缺陷的统计与分析 缺陷汇总: 列出本次实际发现缺陷数、解决的缺陷数、残留的缺陷数、未解决的缺陷数。 缺陷分析: 对测试中发现的缺陷按缺陷类型、严重程度进行分类统计: 对测试中发现的缺陷就其功能分布、测试阶段进行统计,分析软件缺陷倾向及其主要原因: 残留缺陷与未解决问题 对残留缺陷对系统功能的影响情况进行分析:对未解决问题对项目的影响(如有,列表说明)

4.测试结论与建议 4.1风险分析及建议 有/无按实际写 4.2测试结论 本项目根据业务需求及开发人员的反馈意见,覆盖了所有的测试需求及案例,均已在ST环境测试完成,有效案例一共xx个,执行率xx%,,成功率xx%,缺陷关闭率为xx%,目前缺陷均已修复并回归关闭; 综上所述,xx需求达到ST项目测试出口标准,本项目ST测试(通过/不通过),可以进行验收测试 5.交付文档 《xxx需求_系统测试计划》 《xx需求_测试案例》 《xx需求_ST测试报告》

1.系统概述

项目名称: 项目简称: 项目单位: 开 发 商:

2.测试场景

场景

Scenario1 Scenario1 Scenario1 Scenario1

执行脚本 11qq 11qq 11qq 11qq

并发用户数 10 100 300 1010

并发策略 时间

2014/10/22 10:14 - 2014/10/22 10:17 2014/10/22 11:43 - 2014/10/22 10:55 2014/10/22 11:10 - 2014/10/22 11:25 2014/10/22 11:38 - 2014/10/22 12:04

同步点

3 分钟, 17 秒 12 分钟, 09 秒 15 分钟, 39 秒 26 分钟, 28 秒.

分析 概要

场景名: 会话中的结果数: 持续时间: Scenario1 C:\Users\Administrator\AppData\Local\Temp\res\res. lrr 26 分钟, 28 秒.

时间段: 2014/10/22 11:38 - 2014/10/22 12:04

统计信息概要表

运行 Vuser 的最大数目: 总吞吐量(字节): 平均吞吐量(字节/秒): 总点击次数: 平均每秒点击次数: 错误总数:

1,006 187,564,053 118,039 28,569 17.979 12 查看 HTTP 响应概要

您可以使用以下对象定义 SLA 数据 SLA 配置向导 您可以使用以下对象分析事务行为 分析事务机制

事务摘要

事务:

通过总数: 22,387

失败总数: 12

停止总数: 607

平均响应时间

事务名称 Action_Transaction vuser_end_Transaction vuser_init_Transaction

SLA Status

最小值 2.098 0 0

平均值 2.437 0 0

最大值 3.058 0.019 0.041

标准偏差 0.299 0 0.001

90 Percent 2.948 0 0

通过 18,834 2,020 2,020

失败 12 0 0

停止 607 0 0

服务水平协议图例:

Pass

Fail

No Data

HTTP 响应概要

HTTP 响应 HTTP_200 HTTP_302

合计 28,557 12

每秒 17.972 0.008

查看每秒重试次数图。

xxxxxxxxxxxxxx 测试报告

目录 1.引言 (1) 1.1 编写目的 (1) 1.2 项目背景 (1) 1.3 系统简介 (1) 1.4 参考资料 (1) 2.测试概要 (2) 2.1 测试方法(和工具) (2) 2.2 测试范围 (2) 2.3测试环境与配置 (2) 3.测试结果与缺陷分析 (3) 3.1测试执行情况与记录 (3) 3.1.1测试组织 (3) 3.1.2测试时间 (3) 3.1.3测试版本 (4) 3.2覆盖分析 (4) 3.2.1需求覆盖 (4) 3.2.2测试覆盖 (4) 3.3缺陷的统计与分析 (5) 3.3.1缺陷汇总 (5) 3.3.2缺陷分析 (5) 3.3.3残留缺陷与未解决问题 (6) 4.测试结论与建议 (6) 4.1 测试结论 (6) 4.2 建议 (6)

1.引言 1.1 编写目的 实例:本测试报告为XXX项目的测试报告,目的在于总结测试阶段的测试以及分析测试结果,描述系统是否符合需求(或达到XXX功能目标)。预期参考人员包括用户、测试人员、、开发人员、项目管理者、其他质量管理人员和需要阅读本报告的高层经理。 1.2 项目背景 对项目目标和目的进行简要说明。必要时包括简史,这部分不需要脑力劳动,直接从需求或者招标文件中拷贝即可。 1.3 系统简介 如果设计说明书有此部分,照抄。注意必要的框架图和网络拓扑图能吸引眼球。 1.4 参考资料 1. 需求、设计、测试用例、手册以及其他项目文档都是范围内可参考的东西。 2. 测试使用的国家标准、行业指标、公司规范和质量手册等等。

2.测试概要 测试的概要介绍,包括测试的一些声明、测试范围、测试目的等等,主要是测试情况简介。(其他测试经理和质量人员关注部分) 2.1 测试方法(和工具) 简要介绍测试中采用的方法(和工具)。 提示:主要是黑盒测试,测试方法可以写上测试的重点和采用的测试模式,这样可以一目了然的知道是否遗漏了重要的测试点和关键块。工具为可选项,当使用到测试工具和相关工具时,要说明。注意要注明是自产还是厂商,版本号多少,在测试报告发布后要避免大多工具的版权问题。 2.2 测试范围 简要介绍测试用例的设计方法。例如:等价类划分、边界值、因果图,以及用这类方法(3-4句)。 提示:如果能够具体对设计进行说明,在其他开发人员、测试经理阅读的时候就容易对你的用例设计有个整体的概念,顺便说一句,在这里写上一些非常规的设计方法也是有利的,至少在没有看到测试结论之前就可以了解到测试经理的设计技术,重点测试部分一定要保证有两种以上不同的用例设计方法。 2.3测试环境与配置 简要介绍测试环境及其配置。 提示:清单如下,如果系统/项目比较大,则用表格方式列出 数据库服务器配置 CPU: 内存: 硬盘:可用空间大小 操作系统: 应用软件: 机器网络名: 局域网地址: 应用服务器配置

LoadRunner测试结果分析LoadRunner测试结果分析之我见一 LoadRunner生成测试结果并不代表着这次测试结果的结束,相反,这次测试结果的重头戏才刚刚开始。如何对测试结果进行分析,关系着这次测试的成功与否。网上关于LoadRunner测试结果如何分析的介绍相当匮乏,在总结他人的观点和自己的实验体会基础上来介绍如何进行LoadRunner测试结果分析。 1. LoadRunner测试结果分析的第一步应该是查看分析综述(Analysis Summary),其包括统计综述(Statistics Summary)、事务综述(Transaction Summary)、HTTP响应综述(HTTP Responses Summary)三部分。在统计综述中查看Total Errors的数量,HTTP响应综述中查看HTTP 404数量,若数值相对较大(HTTP 404则相对于HTTP 200),则说明系统测试中出错较多,系统系能有问题;另外查看事务的平均响应时间和其90%的事务平均响应时间,若时间过长,超过测试计划中的要求值,则说明系统的性能不满足我们的要求。 2.第二步对LoadRunner测试结果图进行分析,首先对事务综述(Transaction Summary)进行分析,该图可以直观地看出在测试时间内事务的成功与失败情况,所以比第一步更容易判断出被测系统运行是否正常。 3.接着分析事务平均响应时间(Average Transaciton Response Time),若事务平均响应时间曲线趋高,则说明被测系统处理事务的速度开始逐渐变慢,即被测系统随着运行时间的变化,整体性能不断下降。当系统性能存在问题时,该曲线的走向一般表现为开始缓慢上升,然后趋于平稳,最后缓慢下降。原因是:被测系统处理事务能力下降,事务平均响应时间变长,在曲线上表现为缓慢上升;而并发事务达到一定数量时,被测系统无法处理多余的事务,此时曲线变现为趋于平稳;当一段时间后,事务不断被处理,其数量减少,在曲线上表现为下降。如果被测系统没有等待机制,那么事务响应时间会越来越长,最后系统崩溃。

实验报告书 实验一白盒测试 学生姓名:李庆忠 专业:计算机科学与技术学号:1341901317

白盒测试实验报告 一实验内容 1、系统地学习和理解白盒测试的基本概念、原理,掌握白盒测试的基本技术和方法; 2、举例进行白盒测试,使用语句覆盖、判定覆盖、条件覆盖、判定/条件覆盖、组合 覆盖、路径覆盖进行测试。 3、通过试验和应用,要逐步提高和运用白盒测试技术解决实际测试问题的能力; 4、熟悉C++编程环境下编写、调试单元代码的基本操作技术和方法; 5、完成实验并认真书写实验报告(要求给出完整的测试信息,如测试程序、测试用例, 测试报告等) 二实验原理 白盒测试原理:已知产品的内部工作过程,可以通过测试证明每种内部操作是否符合设计规格要求,所有内部成分是否已经过检查。它是把测试对象看作装在一个透明的白盒子里,也就是完全了解程序的结构和处理过程。这种方法按照程序内部的逻辑测试程序,检验程序中的每条通路是否都能按预定要求正确工作。其又称为结构测试。 流程图如下图所示 实验代码 #include"stdio.h"

int main() { int x,y,z; scanf("%d%d",&x,&y); if((x>0)&&(y>0)) { z=x+y+10; } else { z=x+y-10; } if(z<0) { z=0; printf("%d\n",z); } else { printf("%d\n",z); } return 0; } 语句覆盖是指选择足够的测试,使得程序中每个语句至少执行一次。如选择测试x=1,y=1和x=1,y=-1可覆盖所有语句。 判定覆盖是指选择足够的测试,使得程序中每一个判定至少获得一次“真”值和“假”值,从而使得程序的每个分支都通过一次(不是所有的逻辑路径)。选择测试x=1,y=1和x=1,y=-1可覆盖所有判定。 条件覆盖是指选择语句多数的测试,使得程序判定中的每个条件能获得各种不同的结果。选择测试x=1,y=1和x=-1,y=-1可覆盖所有条件。 判定/条件覆盖是指选择足够多的测试,使得程序判定中每个条件取得条件可能的值,并使每个判定取到各种可能的结果(每个分支都通过一次)。即满足条件覆盖,又满足判定覆盖。选择测试x=1,y=1和x=-1,y=-1可覆盖所有判定/条件。 条件组合覆盖是指选择足够的测试,使得每个判定中的条件的各种可能组合都至少出现一次(以判定为单位找条件组合)。 注:a,条件组合只针对同一个判断语句存在多个条件的情况,让这些条件的取值进行笛卡尔乘积组合。 b,不同的判断语句内的条件取值之间无需组合。 c,对于但条件的判断语句,只需要满足自己的所有取值即可。 选择测试用例x=1,y=1;x=1,y=-1,x=-1,y=1和x=-1,y=-1可覆盖所有条件组合。 路径覆盖是分析软件过程流的通用工具,有助分离逻辑路径,进行逻辑覆盖的测试,所用的流程图就是讨论软件结构复杂度时所用的流程图。

测试目的: 考虑到各地区的用户数量和单据量的增加会给服务器造成的压力不可估计,为确保TMS系统顺利在各地区推广上线,决定对TMS系统进行性能测试,重点为监控服务器在并发操作是的资源使用情况和请求响应时间。 测试内容 测试工具 主要测试工具为:LoadRunner11 辅助软件:截图工具、Word

测试结果及分析 5个用户同时生成派车单的测试结果如下: Transaction Summary(事务摘要) 从上面的结果我们可以看到该脚本运行47秒,当5个用户同时点击生成派车单时,系统的响应时间为41.45秒,因为没有设置持续运行时间,所以这里我们取的响应时间为90percent –time,且运行的事物已经全部通过

事务概论图,该图表示本次场景共5个事务(每个用户点击一次生成派车单为1个事务),且5个事务均已pass,绿色表色pass,如出现红色则表示产生error

从上图可以看到服务器的CPU平均值为14.419% ,离最大参考值90%相差甚远;且趋势基本成一直线状,表示服务器响应较为稳定,5个用户操作5个900托运单的单据对服务器并没有产生过大的压力。

“Hits per Second(每秒点击数)”反映了客户端每秒钟向服务器端提交的请求数量,这里服务器每秒响应9,771次请求;如果客户端发出的请求数量越多,与之相对的“Average Throughput (吞吐量)”也应该越大。图中可以看出,两种图形的曲线都正常并且几乎重合,说明服务器能及时的接受客户端的请求,并能够返回结果。 按照上述策略,我们得出的最终测试结果为: 生成派车单: 1个用户,300个托运单点击生成派车单,响应时间7.34秒 5个用户,900个托运单点击生成派车单,响应时间41.45秒 单据匹配: 单用户1000箱,20000个商品,上传匹配时间8秒 五个用户2500箱,40000个商品,同时上传匹配耗时2分25秒 自由派车: 单条线路917个托运单下载,响应时间1分40秒 上述结果是在公司内网,测试环境上进行的测试,可能与实际会有偏差

性能测试与LoadRunner基础笔试题 笔试:45分钟满分100分 选择:(共6分,3分一题) 1. To control the time between iterations in a Vuser, you will need to configure which run-time(2分) feature? A. Run Logic B. Pacing C. Think Time D. Network Speed 2. You are about to run a Debug scenario with a small number of Vusers. What type of log setting will you select to help identify and check errors in the Vuser scripts?(2分) A. Only when errors occur B. Standard log C. Extended log 判断:(共20分,2分一题) 1.集合点可以贯穿整个事务,加了集合点,整个事务都是同步运行的 2.集合点可以加在vuser_int中 3.LR可以录制单机程序 4.一个脚本中可以有多个action 5.10M的网络环境中,不能模拟20M的带宽 6.HTTPS安全协议,可以使用‘HTML-based script’模式录制 7.vuser_end中内容是不可以迭代运行的 8.file类型参数化,最多只能参数化100个 9.手动关联,查找需要关联的数据,要在Sending request中查找 10.调试lr脚本可以run step by step

文档级别:X级模板编号:TNET-QR-RD004 模板版本:V1.0 XXXX公司 系统名称V1.0 测试报告(功能+性能)

版本记录 状态:C-创建文档,A-增加内容,M-修改内容,D-删除内容

目录 引言 (4) 1.1编制目的 (4) 1.2词汇表 (4) 1.3背景 (4) 2 测试管理 (4) 2.1测试范围与主要内容 (4) 2.2测试方法 (4) 2.3测试环境与测试辅助工具 (5) 2.4测试准则 (5) 2.5测试接受准则 (5) 2.6 BUG的定义标准 (5) 2.7人员与任务表 (6) 2.8缺陷管理与改错计划 (7) 3 测试概要 (7) 3.1测试执行 (7) 3.2测试用例 (8) 3.2.1 功能性 (8) 3.2.2 易用性 (8) 4 测试结果 (8) 4.1B UG量表格统计 (8) 4.2柱形图统计 (9) 4.3B UG趋势图 (9) 4.4B UG引入阶段 (10) 4.5B UG状态分布 (10) 5 测试结论 (11) 5.1功能性 (11) 5.2易用性 (11) 5.3兼容性 (11) 6 附录. 本计划审批意见 (11)

引言 1.1编制目的 略 1.2词汇表 1.3背景 随着互联网的发展,人们对于网络依赖,XX系统的实现提供手机端的访问,及各功能在便捷设备上的使用,提供客户更快更优质的服务。 2测试管理 2.1测试范围与主要内容 略 2.2测试方法 黑盒测试: 1.系统测试 2.兼容性测试 3.性能测试 4.压力测试 5.容错性测试 6.升级测试 7.用户体验测试 8.UI测试 9.易用性测试 10.集成测试

一、实验目的 熟悉LoadRunner 的使用并对网站进行并发测试得到性能指标。 二、实验内容 1、题目内容描述 题目一:LoadRunner 的使用 熟悉LoadRunner 的界面,掌握LoadRunner 进行性能测试的测试流程。题目二:对某个网站进行并发测试 录制用户登录系统过程,并进行参数化。然后分别模拟10个、20个、50 个和100个用户登录系统,分别获得响应时间、吞吐量等性能指标。 2、测试计划 测试流程: 第一步:制定测试计划 第二步:创建虚拟用户脚本 第三步:创建场景 第四步:运行测试 第五步:监视场景 第六步:分析测试结果 1. 系统分析 本网站的用户有三类,一类是教师,可以对学生该科目的成绩等进行操作;一类是学生,进入该网站并登录教务系统,另一类是管理员。 2. 系统压力强度估算 3. 系统性能测试项 本次测试的主要内容是用户并发测试。主要指对系统的核心部分进行测试,以真实的业务数据作为输入,选择有代表性和关键的业务操作来设计测试用例。根据测试计划,对下列业务进行并发测试: (1)点击进入计科学院 (2)主页搜索 (3)登陆教务系统 (4)组合业务

注:由于条件的限制,在进行性能测试中不可能对所有的功能点都进行性能测试,在此只选择了几个典型的功能点。 3、实验过程 使用LoadRunner对西南科技大学的网站进行测试。 1对登陆的用户名和密码进行参数化 设置迭代次数为1,设置虚拟用户分别为5和10,localhost 进行连接,点击运行。 2. 设置本地连接、等待时间等。 3. 运行。 4、测试结果

、实验思考 通过这次实验学习了使用LoadRunner 对网站进行性能测试,压力测试,获得响应时间、吞吐量、点击率等性能指标。使用这个工具对我们测试网站的性能有很大的帮助,经过参数化后模拟登陆用户进行大量并发测试,获得性能指标,避免网站承受能力差的情况,提高质量。这样使用工具来测试网站比手动测试方便多了,而且不会出错。

LoadRunner性能测试软件的基本使用步骤 一. 1、测试脚本录制 1.1录制前准备工作 在录制脚本前需检查压测环境的整体功能是否正确,待测部分的功能是否正确,只有确定功能正确后才可进行压测。 1.2录制及调试脚本 在准备工作OK后,进行脚本的录制,具体过程如下: 打开“开始>程序>MercuryLoadRunner>MercuryLoadRunner”测试脚本录制; 2、点击“Create/EdirScripts”,也可在“File”下选择New 新建。 3、选择Web(HTTP/HTML)协议,我们测试的是B/S模式,采用的是Web协议,选择后点【OK】按钮。 4、点击界面中的录制按钮,这个表示开始录制脚本点。 录制前,如果已经打开待测页面的话,建议关闭该页面。点【OK】后,同时会出现这表示现在已经开始录制。 5、所有操作完成后,点击中停止按钮,停止录制,页面将自动关闭,返回到loadrunner录制界面,将在界面中显示录制脚本代码,保存录制的脚本。 6、调试代码并进行参数化 录制后的代码需要进行调试才可用于压测,调试的办法就是进行

回放操作,如果回放过程无错误,运行结果也正确的话,则可用于压测。 二.设计测试场景 在脚本录制完成,调试通过后,可以进行测试场景的设计。 1.打开“开始>程序>MercuryLoadRunner >MercuryLoadRunner” 2.点击的RunLoadTests;在新建场景的窗口,选择一种场景类型。 3.选择要进行场景设计的脚本,若没有出现需要对应的脚本,可点击Browse查找后添加进来,选择好脚本后,点add则可加入到右边的窗口中然后点【OK】。 4.显示的是脚本的路径与并发数个数,根据测试方案中的并发 数可更改此处的并发数。 Eg:假如我们设计的场景是每15秒增加2个,所有并发数增加完后持续运行5分钟,5分钟运行结束后,每30秒减少5个并发。 5.再点击页面右下角的“Run-timeSettings” 。 6.一切设置OK后,点击运行测试场景。 三.测试结果分析 1.场景执行结束后可以,使用loadrunner自带的分析工具进行结果分析。 2.在菜单栏中选择打开,找到要分析的场景执行结果,点【打开】即可,还可以直接在场景运行结束后,点击Controller菜单栏

软件测试报告模板适用于XX公司 编写者: XX 文档编号: 编写日期: 2020-1-25

分发列表 文档修订历史 [模板修订历史 (文档首次使用前请删除)]

目录 1.测试概述 (4) 1.1.测试项目简述 (4) 1.2.名词定义 (4) 1.3.参考文档 (4) 2.测试环境与配置 (4) 3.测试情况 (4) 3.1.测试版本情况 (4) 3.2.测试用例统计执行情况 (4) 3.3.测试组织 (4) 4.测试结果及分析 (5) 4.1.测试情况统计分析 (5) 4.2.覆盖分析 (5) 4.2.1.需求覆盖 (5) 4.2.2.测试覆盖 (5) 4.3.缺陷的统计与分析 (5) 4.3.1.缺陷汇总 (5) 4.3.2.缺陷分析 (5) 4.4.测试质量对比统计 (5) 5.遗留缺陷与未解决问题 (5) 6.测试总结及风险分析 (6) 7.测试报告批准 (6)

1. 测试概述 1.1. 测试项目简述 <大、小、临时版本确定,测试范围 1. 测试需求 那些新增的需求验证 那些变更需求的需求验证 本次版本中可验证的需求列表 2. 修改问题的测试 3. 其他的功能测试内容> 1.2. 名词定义 本轮验证测试过程中涉及到需求、更新的产品术语、新产品术语等。 1.3. 参考文档 <参考的需求分档、设计文档等> 2. 测试环境与配置 简要介绍测试环境及其配置。 3. 测试情况 3.1. 测试版本情况 测试版本版本号,是否接受该版本以及原因表述。 什么时候接收的版本,什么时间版本部署完成 测试过程中有无更新版本 更新版本对测试的影响 测试中冒烟测试是否通过 3.2. 测试用例统计执行情况 3.3. 测试组织

软件测试报告范例1 XX软件测试报告 共x 页 拟制年月日审核年月日会签年月日批准年月日 1 范围 本文档适用于XX软件的单元/集成测试。 1.2 系统概述 1.3 文档概述 本文档用于对XX软件的测试工作阶段成果的描述。包括对软件测试的整体描述,软件测试的分类和级别,软件测试的过程描述,软件测试的结果等内容。 2 引用文档 《XX软件需求规格说明》 《XX软件设计说明》 《XX系统接口协议》 3 测试概述 3.1被测软件的基本概况 使用的编程语言:XXX 汇编语言

程序行数:1590 子程序个数:11 单行注释行数:669 注释率:约为42% 3.1.1. 测试小结 本次测试对XX软件进行了静态分析和动态测试。测试工作分为两个阶段。第一阶段进行了软件静态分析,软件测试人员和开发人员分别对软件V1.00版本的代码进行走读。在此基础上软件开发人员对代码走查中发现的问题进行了修改,做了97处代码变更并提交了V1.01版本进行动态测试。 在测试过程中针对发现的软件缺陷进行了初步分析,并提交程序设计人员对原软件中可能存在的问题进行考查。在软件测试中首先根据软件测试的规范进行考核,将书写规范,注释等基础问题首先解决,其次 考核软件测试中的问题是否存在设计上的逻辑缺陷,如果存在设计缺陷则应分析该缺陷的严重程度以及可能引发的故障。软件开发人员在以上基础上对软件的不足做出相应的修改,同时通过软件回归测试验证软件修改后能够得到的改善结果。 软件代码1.00与1.01版变更明细表: 从上表可以看出,注释变更一共有15处,主要排除了对原程序的理解错误问题;根据程序的书写规范要求,一行多条语句

网站性能测试报告

目录 1项目背景 (3) 2编写目的 (3) 3参考文档 (3) 4参与测试人员 (3) 5测试说明 (3) 5.1 测试对象 (3) 5.2 测试环境结构图 (4) 5.2.1测试环境 (4) 6测试流程 (5) 7测试方法 (5) 8测试结果统计 (6) 8.1 用户并发测试:独立业务 (6) 8.2 用户并发测试:组合业务 (16) 8.3 大数据量测试 (22) 9分析与建议 (22) 9.1 独立业务 (22) 9.2 组合业务 (22) 9.3 大数据 (22) 9.4 其它....................................................................................................错误!未定义书签。

1项目背景 为了了解网易网的行你呢,我特此对网易网站进行压力测试。2 2编写目的 描述网易网站,在大数据量的数据环境下,系统的执行效率和稳定性。3参考文档 4参与测试人员 软件测试0801雷晓华 5测试说明 5.1测试对象 网易网站

5.2测试环境结构图 5.2.1测试环境5.2.1.1服务器端 5.2.1.1.1硬件环境 5.2.1.1.2软件环境

5.2.1.2客户端 5.2.1.2.1硬件环境 5.2.1.2.2软件环境 6测试流程 1、搭建模拟用户真实运行环境。 2、安装压力测试工具Loadrunner7.8。 3、使用LoadRunner中VuGen录制测试脚本。 4、使用Load Runner Controller组织发起模拟负载,并收集测试数据以及测试目标机器和网络的资源数据。 5、使用LoadRunner 的Analysis组件,分析测试结果。 6、整理并分析测试结果,写测试总结报告。 7测试方法 使用Mercury公司的性能测试软件LoadRunner8.1,对本系统业务进行脚本录制,测试回放,逐步加压和跟踪记录。测试过程中,由LoadRunner的管理平台调用各前台测试,发起各种组合的业务请求,并跟踪记录服务器端的运行情况和返回给客户端的运行结果。 1、录制日常访问量比较大的业务模块的代码,对测试机器进行压力测试。 2、模拟用户在单个业务操作和两个业务混合操作时,20、50、100、300、500用户同时并发,进行多次连续测试,完成测试目标。

苏宁信息体系 中台项目群订单中心项目 SIT测试阶段 测试报告 (示例文档) 错误!未找到引用源。错误!未找到引用源。

文档记录 修订记录 批准者 此文档需要以下人员批准 分发 此文档分发给以下部门或单位相关人员:

目录 1.文档简介 (4) 1.1文档说明 (4) 1.2参考文档 (4) 2.测试概述 (5) 2.1测试范围 (5) 2.2测试过程概述 (5) 2.3测试软硬件环境 (6) 2.4测试数据 (6) 2.5测试工具 (6) 2.6测试方法 (7) 3.测试执行总结 (8) 3.1测试案例覆盖总结 (8) 3.2测试案例执行总结 (8) 3.3测试缺陷总结 (8) 3.3.1 缺陷的分布--按照严重程度划分 (8) 3.3.2 缺陷的分布--按照功能模块划分 (9) 3.3.3 缺陷的趋势—阻塞(Block)级别缺陷 (10) 3.3.4 缺陷的趋势—致命(Critical)级别缺陷 (11) 4.分析与总结 (12) 4.1结论和建议 (12) 4.2遗留的显著问题 (12) 4.3风险分析 (13)

1. 文档简介 1.1 文档说明 本文档是关于中台项目群订单中心项目SIT测试阶段的测试报告,目的是有效总结订单中心项目SIT测试阶段测试工作的实施情况,评估测试状态与结果, 使得需求负责人、开发负责人、版本负责人等相关人员能够对版本质量有一个全面的认识。 1.2 参考文档 本文档在编写过程中参考了如下文档:

2. 测试概述 2.1 测试范围 <包括被测试项目的业务范围,项目所涉及的外部系统等, 可以列举测试范围内的需求列表、模块列表,也可以列举测试特性列表, 并说明本阶段测试涉及的前提条件,包括受到哪些条件限制和相关情况说明等,> <注:一般情况下,本部分的内容与对应的测试计划当中相应部分的内容应该一致。可以从测试方案中获得. 如果不一致,应该在后续测试执行概述章节将不一致的地方进行描述,并说明造成不一致的原因> 本次SIT测试包含以下的业务流程: 实体及实时延保订单交易及执行流程 礼品卡订单交易及执行流程 事后延保订单交易及执行流程 合约机订单交易及执行流程 货到付款流程 订单支付后退货流程 订单支付后取消流程 2.2 测试过程概述

LoadRunner压力测试

一、环境准备 优化操作系统(centOS) 1、执行命令 sudo modprobe -r xt_NOTRACK nf_conntrack_netbios_ns nf_conntrack_ipv4 xt_state sudo modprobe -r nf_conntrack 2、使用文本编辑器打开 /etc/sysctl.conf 修改net.ipv4.tcp_max_tw_buckets的值 net.ipv4.tcp_max_tw_buckets= 16000 修改nginx配置 (只在压力测试使用,测试完毕后恢复) 1、找到以下条目,修改值 proxy_connect_timeout 600; proxy_send_timeout 600; proxy_read_timeout 600; 2、修改 upstream 中的值 server 192.168.0.254:8003 max_fails=15 fail_timeout=160s weight=1 srun_id=03; jvm_route $cookie_JSESSIONID reverse; 修改 LEAP.xml (只在压力测试使用,测试完毕后恢复) 在RPCServices 节点中添加disablesid="true" 例:

二、Loadrunner安装之前 安装要求 1、Loadrunner(主控机和压力机)必须安装在windows2003 server 版本下 2、必须安装IE浏览器,建议为IE6版本,其他版本在脚本录制过程中会出现打不开IE的情况 安装虚拟光驱

性能测试指标参考 目录 1术语 (2) 1.1响应时间 (2) 1.2并发用户数 (2) 1.3在线用户数 (2) 1.4吞吐量 (3) 2 Vuser图 (3) 2.1 “运行Vuser ”图(Running Vusers) (3) 2.2 “集合”图(Rendezvous) (3) 3 错误图 (3) 3.1 “每秒错误数(按描述)”图(Error Statistics) (3) 4 事务图 (4) 4.1 “平均事务响应时间”图(Average Transaction Response Time) (4) 4.2“负载下的事务响应时间”图(Running Vuser –Average Transaction Response Time) (4) 4.3“页面细分”图(Web Page Diagnostics图) (5) 4.4“每秒事务数”(Transactions per second 简称:TPS) (6) 5 Web资源图 (6) 5.1“每秒点击次数”图(Hits per Second) (6) 5.2“吞吐量”图(Throughput) (6) 6 系统资源图 (6) 6.1 LoadRunner下监控的UNIX资源指标 (6) 6.1.1平均负载(Average load) (6) 6.1.2 CPU利用率(CPU utilization) (7) 6.1.3 每秒传入的包数(Paging rate) (7) 6.2使用NMON工具监控Linux资源 (7) 6.2.1 系统资源汇总(SYS_SUMM) (7) 6.2.2 磁盘资源汇总(DISK_SUMM) (8) 6.2.3 内存资源(MEM) (8) 7 网络监控器图 (9) 7.1 “网络延迟时间”图(Network Delay Time) (9) 8 数据库服务器资源图 (10) 8.1 Oracle服务器监控度量 (10) 8.1.1 添加Oracle自定义计数器 (11) 8.1.2 性能分析工具Statspack所提供的性能分析指标 (15) 8.2 SQL Server服务器监控度量 (18)