GPFS 在 Linux 集群中的灾难恢复

GPFS 在Linux 集群中的灾难恢复

灾难恢复是当前存储技术领域的热点之一。GPFS (General Parallel File System) 作为一个支持多节点的并行文件系统,在其长期运行过程中可能遇到各种问题(软件问题和硬件问题)而造成其中的某些节点不能正常工作。GPFS 提供了强大的功能来进行灾难恢复,以确保数据安全。本文根据GPFS 的容灾特性提出了两种灾难恢复( disaster recovery) 的解决方案。一是将问题节点从GPFS 集群中移除,使GPFS 集群在剩下的健康节点上继续工作;二是重新安装配置问题节点,再对原有GPFS 集群进行恢复,使其健康运行。采用这两种解决方案都可以快捷地恢复GPFS 系统,从而保证整个GPFS 集群正常的工作。最后,以实例的形式给出了详细的实现步骤以及实例分析。

GPFS 文件系统相关介绍

IBM General Parallel File System(GPFS) 是高性能、可扩展、并行文件系统。通过它,可以构建一个高可用、高性能的大型Linux 计算机集群。GPFS 提供了强大的灾难恢复功能。从而,通过GPFS 可以构建高可用的Linux 集群。

GPFS 文件系统

GPFS 是一个并行的共享磁盘文件系统,它保证在资源组内的所有节点可以并行访问整个文件系统。GPFS 允许客户共享文件,而这些文件可能分布在不同节点的不同硬盘上。它提供了标准的UNIX 文件系统接口。GPFS 能够很好的支持UNIX 文件系统的工具,用户可以在Linux 集群中像使用普通文件系统一样使用GPFS 文件系统。它可以很好的应用在Linux 集群中。

GPFS 节点可能发生的问题

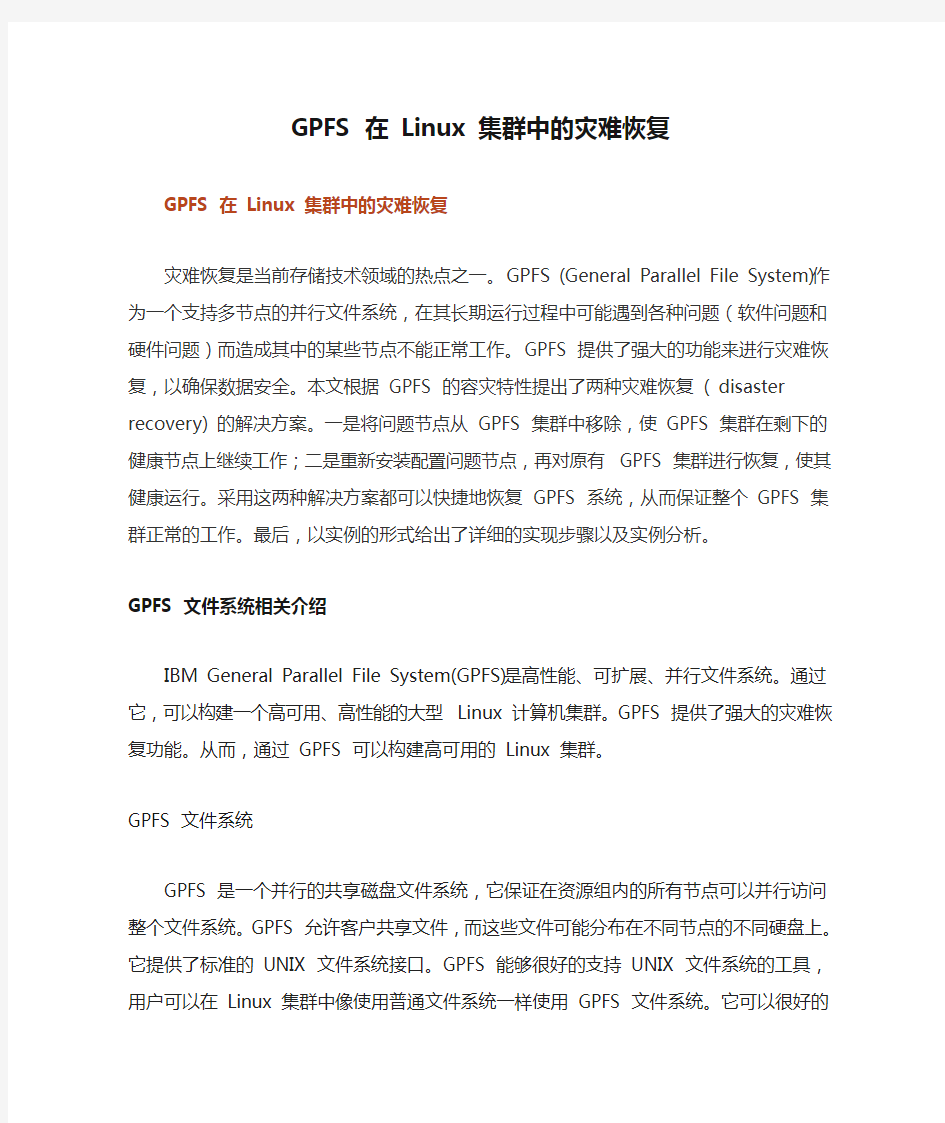

GPFS 是由多个节点组成的集群系统,我们在GPFS 长期运行过程中,可能有软件问题,比如集群中某个节点GPFS 文件系统崩溃;也可能有硬件问题,比如系统磁盘坏掉,这样就会导致集群中某个节点不能工作。这些问题在GPFS 集群长期运行过程中都是很可能遇到的问题,在遇到这种问题后,我们执行“mmgetstate –a”就会发现问题节点的状态不正常。状态“active”表示正常,其他状态都是异常。

node1:~ # mmgetstate -a

Node number Node name GPFS state

------------------------------------------

1 node1 active

2 node2 active

3 node3 unknown

用户针对这种情况都想尽快能够恢复整个集群的正常工作,把坏掉的节点尽快恢复工作。

GPFS 文件系统的灾难恢复(容灾特性)

GPFS 文件系统提供了很多特性可以来支持GPFS 文件系统在发生问题时能够很好的进行灾难恢复使整个集群继续工作。首先GPFS 是一个支持多节点的并行式文件系统,整个集群采用网络共享磁盘的方式,当其中任何一个节点发生问题时,其它节点能够及时接管问题节点的任务,从而保证整个集群能够继续工作。这样保证在集群中的其它节点健康的情况下可以及时接管问题节点的任务,我们可以尽快对问题节点进行恢复。

Linux 集群中GPFS 灾难恢复方法及相关命令简介

我们通常在采用GPFS 的Linux 集群中某个节点发生硬件或者文件系统崩溃而不能正常工作时,那么整个集群中就会出现问题的节点。为了使原来的集群的所有节点都能健康的工作,我们可以有两种方法:一是把坏掉的节点从原有的集群中移除掉;二是把坏掉的节点的硬件问题解决之后重装该节点,并重新添加进GPFS 集群中。下面我们来分别介绍两种方案。

方案一:通过移除GPFS 问题节点来恢复

方案描述:

如果集群中有节点的硬件或者软件发生严重问题时,我们可以先把该节点从整个集群中移除掉,这样集群中就没有这个坏掉的节点,我们可以通过“mmgetstate –a”得到所有的节点都是“active”的状态。

方案流程:

我们要从集群中移除掉坏掉的节点,就要改变记录整个GPFS 集群配置信息的文件,把坏掉节点的信息删除,使GPFS 集群中都没有坏掉节点的信息,这样这个坏掉节点就能够删除掉了。如下图所示,我们可以看到图中,本来三个节点的GPFS 集群中,第三个节点坏了,我们把该问题节点移除后就成为一个只包含两个健康节点的集群。

图 1. 移除GPFS 问题节点流程图

方案二:通过重装问题节点来恢复

方案描述:

当然还有另外一种方法就是,无论问题节点是发生硬件或者文件系统崩溃,我们在把硬件问题首先解决后,重装这个节点并把它加入我们的GPFS 集群中来。下面我们对这种方案的实现进行介绍。

方案流程:

首先对原GPFS 集群中配置信息文件mmsdrfs 进行备份,对问题节点重装,把原有的GPFS 配置信息文件还原到原来节点上面,使这个记录GPFS 节点信息的配置文件能够生效我们需要对GPFS 集群进行刷新。如图 2 所示,从图中我们可以看到第三个节点重装后,恢复mmsdrfs 文件在坏掉之前的状态后重新加进集群后,形成三个节点的集群。

图 2. 恢复问题节点流程图

通过这两种方法后原有的GPFS 集群中就会没有问题节点,集群以健康状态工作。而且最重要的一点是我们在移除节点或者重装节点之后,都能立即接管本来GPFS 集群中的任务,顺利进行下去。

mmsdrfs 配置文件

我们无论是采取上述两种方案中的哪一种,都需要对mmsdrfs 这个文件进行更新。下面对mmsdrfs 这个文件进行简单的介绍。mmsdrfs 是一个很重要的文件,是整个GPFS 文件系统的配置文件。它位于每个节点的/var/mmfs/gen/ 目录下,这个文件保存了整个GPFS 集群里所有节点的配置信息。mmsdrfs 里面第一个记录是一个随机生成的数字。当GPFS 集群中的节点或者文件系统发生改变,在mmsdrfs 文件里面这个数字都会有相应的改变。在mmsdrfs 里面还记录了GPFS 集群配置首要节点和GPFS 集群配置次要节点。如果我们要改变GPFS 中的节点那么首先要改变这个配置文件中关于节点的信息。所以我们在节点发生严重问题联系不到,不能直接执行“mmdelnode –a”的情况下,我们可以通过改变mmsdrfs 文件,删除文件中包含问题节点的部分。

灾难恢复相关命令简介

对于mmsdrfs 文件的操作,我们往往要用到mmsdrrestore 和mmsdrbackup 这两个命令。mmsdrrestore 是在GPFS 集群灾难恢复中一个很重要的命令,可以用来恢复GPFS 集群中指定节点的配置文件。我们在灾难恢复时主要是恢复mmsdrfs 这个GPFS 的重要配置文件。下面我给大家举例mmsdrrestore 命令使用。如果我想恢复GPFS 集群中node1 上面的GPFS 配置文件

/var/mmfs/gen/mmsdrfs。我们可以执行下面的命令。

mmsdrrestore – p node1 – F /var/mmfs/gen/mmsdrfs

还有一个命令mmrefresh 同样也是在GPFS 集群灾难恢复中比较常用的命令。它一般在集群中一些配置信息进行了更新之后,我们需要对整个GPFS 集群进行刷新使新的配置文件生效。如果我们想要在整个GPFS 集群中的所有节点上面执行,可以执行下面的命令:

mmrefresh – f

回页首实例

下面我们以一个安装GPFS 文件系统的Linux 集群为例,如果集群中有一个节点的硬件发生问题,或者该节点的GPFS 文件系统彻底坏掉,我们该怎么样来修复。下面我们分别应用上面提到的两种方案。

实验环境

安装GPFS 的Linux 集群,在本文中以三个节点为例,分别为node1,node2 和node3。

灾难模拟

通过把 GPFS 集群中某一节点的网线拔掉,使得集群中其它节点不能访问该节点的方式来模拟灾难的发生。我们假设环境中问题节点是 node3,需要被修复。可以利用 mmlscluster 和 mmgetstate 命令分别查看当前集群环境的节

点数目和节点状态,如下:

node1:~ # mmlscluster

GPFS cluster information

========================

GPFS cluster name: node1

GPFS cluster id: 12402633003865615606

GPFS UID domain: node1

Remote shell command: /usr/bin/ssh

Remote file copy command: /usr/bin/scp

GPFS cluster configuration servers:

-----------------------------------

Primary server: node1

Secondary server: node2

Node Daemon node name IP address Admin node name Designation

---------------------------------------------------------

------------

1 node1 172.31.1.1 node1

quorum-manager

2 node2 172.31.1.2 node2

quorum-manager

3 node3 172.31.1.3 node3

quorum-manager

node2:/var/mmfs/gen # mmgetstate -a

Node number Node name GPFS state

------------------------------------------

1 node1 active

2 node2 active

3 node3 unknown

方案一:通过移除 GPFS 问题节点来恢复

方法一:首先我们尝试利用 mmdelnode 命令移除问题节点:

这个命令是集群内所有节点的 GPFS 都正常,能够联系到所有节点的情况下才

会成功。但是当集群中有节点的 GPFS 或者硬件发生问题时,这个命令将无法

成功,我们可以看到这个命令会失败。如下:

node1:~ # mmdelnode -N node3

Verifying GPFS is stopped on all affected nodes ...

mmdelnode: GPFS cluster configuration server node

node3cannot

be removed.

mmdelnode: Command failed. Examine previous error messages to

determine cause.

这时需要我们利用 mmsdrfs 配置文件进行问题节点的移除。

方法二:在方法一失败的情况下我们利用 mmsdrfs 配置文件移除问题节点:第一步是备份健康节点上的mmsdrfs 配置文件:

首先到健康节点node1 或node2 中,把原来的mmsdrfs 备份。如下:

node1:/var/mmfs/gen # cp mmsdrfs mmsdrfs.old

第二步是修改mmsdrfs 配置文件:

把原来的mmsdrfs 配置文件中包含问题节点内容的部分去掉,该配置文件中主要有两部分和节点相关的信息,首先第一个部分是其中关于成员节点部分,第二部分是GPFS 和其他存储管理软件TSM 相结合的部分,关于TSM 的具体内容本文不详细讨论。这两部分内容我在下面的实例中以粗体标出,大家如果要删减可以照此操作。当删除节点是首要集群配置服务器或者次要集群配置服务器时,在文件第一句还会包括相关信息。当然删除之前不要忘记备份原文件。具体的mmsdrfs 配置文件修改内容如下:

%%9999%%:00_VERSION_LINE::6:3:90::lc:node1:node2:1:/usr/bin/ssh:/usr/bin/scp: 12402633008479124940:lc2:1575927244::node2:0:0:0:0::::::

…

…

%%home%%:20_MEMBER_NODE::3:3:node3:172.31.1.3:node3:manager::::::node3:node3:10

21:3.2.1.16:Linux:Q:0:N:9.11.96.125:E::::

%%home%%:70_MMFSCFG::1:# :::::::::::::::::::::::

%%home%%:70_MMFSCFG::2:# WARNING: This is a machine generated file. Do not edit! ::::::::::::::::::::::

%%home%%:70_MMFSCFG::3:# Use the mmchconfig command to change configuration parameters. :::::::::::::::::::::::

…

…

~%DSM%%:910_HSMDATA:%%home%%:28::::::::::::::::::::::::

~%DSM%%:910_HSMDATA:%%home%%:29:

~%DSM%%:910_HSMDATA:%%home%%:30: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:31: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:32: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:33: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:34: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:35: type="uint">23157

~%DSM%%:910_HSMDATA:%%home%%:36: type="uint">0

~%DSM%%:910_HSMDATA:%%home%%:37: type="hex">0x1fac0301::::::::::::::::::::::: ~%DSM%%:910_HSMDATA:%%home%%:38: type="string">node3 ~%DSM%%:910_HSMDATA:%%home%%:39: type="uint">0 ~%DSM%%:910_HSMDATA:%%home%%:40: type="int">3::::::::::::::::::::::: ~%DSM%%:910_HSMDATA:%%home%%:41:::::::::::::::::::::::: ~%DSM%%:910_HSMDATA:%%home%%:42:::::::::::::::::::::::: 把mmsdrfs 文件中这些部分去掉之后,下面就需要对集群当中的信息进行及时的刷新,以使新的配置信息生效。 第三步是刷新集群信息: 执行如下命令使新的配置信息生效: node1:/var/mmfs/gen # mmrefresh – f 最后一步我们要验证问题节点是否被移除成功: 利用mmlscluster 和mmgetstate 命令分别查看移除问题节点后的集群环境的节点数目和节点状态,如下: node1:/var/mmfs/gen # mmlscluster GPFS cluster information ======================== GPFS cluster name: node1 GPFS cluster id: 12402633003868883952 GPFS UID domain: node1 Remote shell command: /usr/bin/ssh Remote file copy command: /usr/bin/scp GPFS cluster configuration servers: ----------------------------------- Primary server: node1 Secondary server: node2 Node Daemon node name IP address Admin node name Designation --------------------------------------------------------------------- 1 node1 172.31.1.1 node1 quorum-manager 2 node2 172.31.1.2 node2 quorum-manager node2:/var/mmfs/gen # mmgetstate -a Node number Node name GPFS state ------------------------------------------ 1 node1 active 2 node2 active 我们可以看到当前集群环境中只要两个节点,并且状态都为健康。问题节点node3 已经被成功的从集群环境中移除掉。删除节点后不会影响我们正在进行的NFS 传输文件等其他操作。 方案二:通过重装问题节点来恢复 当GPFS 节点出现硬件问题或者系统崩溃后,修复后我们只能对问题节点进行重装。重新安装好GPFS 之后,把健康节点上面的原来保存好的配置文件mmsdrfs 复制到新安装好的节点上面,下面我们可以用mmsdrrestore 来恢复新安装节点的GPFS 配置文件。在执行这条命令前我们需要首先把所有节点上面的GPFS 停掉,然后执行如下命令: node3:~ # mmsdrrestore -F /var/mmfs/gen/mmsdrfs -N node1 Tue Dec 19 00:51:03 UTC 2009: mmsdrrestore: Processing node node3 Tue Dec 19 00:51:04 UTC 2009: mmsdrrestore: Processing node node1 mmsdrrestore: Command successfully completed node3:~ # mmrefresh – f 然后同样的对GPFS 集群进行刷新,使最新的GPFS配置文件生效。 执行方案二前,我们执行mmlscluster看到的集群情况如下: node2:/var/mmfs/gen # mmlscluster GPFS cluster information ======================== GPFS cluster name: node1 GPFS cluster id: 12402633003868883952 GPFS UID domain: node1 Remote shell command: /usr/bin/ssh Remote file copy command: /usr/bin/scp GPFS cluster configuration servers: ----------------------------------- Primary server: node1 Secondary server: node2 Node Daemon node name IP address Admin node name Designation --------------------------------------------------------------------- 1 node1 172.31.1.1 node1 quorum-manager 2 node2 172.31.1.2 node2 quorum-manager node2:/var/mmfs/gen # mmgetstate -a Node number Node name GPFS state ------------------------------------------ 1 node1 active 2 node2 active 执行方案二后,我们看到的集群情况如下: node3:~ # mmlscluster GPFS cluster information ======================== GPFS cluster name: node1 GPFS cluster id: 12402633003868883952 GPFS UID domain: node1 Remote shell command: /usr/bin/ssh Remote file copy command: /usr/bin/scp GPFS cluster configuration servers: ----------------------------------- Primary server: node1 Secondary server: node2 Node Daemon node name IP address Admin node name Designation --------------------------------------------------------------------- 1 node1 172.31.1.1 node1 quorum-manager 2 node2 172.31.1.2 node2 quorum-manager 3 node3 172.31.1.3 node3 quorum-manager 我们可以看到第三个节点的信息已经被添加进去。节点重新添加进去后可以及时接管GPFS 现在正在进行的各项工作。 总结 基于GPFS 的灾难恢复特性,在GPFS(Linux 集群)某些节点发生硬件或软件问题时,我们能够很快的以文章介绍的两种方案进行灾难恢复,保证整个GPFS 的所有节点在Linux 集群中以健康的状态工作。 SUSE Linux搭建企业服务器的双机配置过程 当集群中的某个节点由于软件或硬件原因发生故障时,集群系统可以把资源切换到其他健康的节点上,使整个系 统能连续不间断的对外提供服务,从而为机构24x365的关键业务提供了可靠的保障,达到了系统99.999%的高可用性和可靠性。SuSE Enterprise Linux 10.0是内置Linux 2.6.16内核的企业级服务器,较之SuSE Enterprise Linux 9.0,它在性能、可扩展性、易管理性和安全等方面都予以加强,并有众多硬件和应用软件支持。 最近,笔者使用SuSE Enterprise Linux 10.0作为系统平台(使用其它Linux平台在安装部署时可能有小差异),在其上采用HeartBeat、Mon和Rsync等开源软件打造了一个高可用系统,挖掘了SuSE Linux的高可用性。下面我为大家 详细介绍如何在Suse Linux搭建双机的配置过程。 一、HeartBeat、Mon、Rsync简介 二、安装环境 首先,需要准备两台PC服务器,每台服务器有两块网卡,其物理网络图如图 1 安装环境 图1 网络拓扑图 虽然在YaST2控制中心里有"高可用性"图形化的配置向导,我们这里不介绍一个过程,中在讲述原理和方法,主 要是基于命令行的配置方式。首先在PC服务器上安装SuSE Enterprise Linux 10.0系统,并将eth0配置为192.168.8.*网段,eth1配置为10.1.1.*网段,eth0链接对外的交换机,eth1用于两台机器的对连。 修改/etc /hosts文件,修改内容如下: 服务器集群系统(二) 集群的体系结构 本文主要介绍了集群的体系结构。先给出集群的通用体系结构,并讨论了其的设计原则和相应的特点;最后将集群应用于建立可伸缩的、、和等网络服务。 .引言 在过去的十几年中,从几个研究机构相连为信息共享的网络发展成为拥有大量应用和服务的全球性网络,它正成为人们生活中不可缺少的一部分。虽然发展速度很快,但建设和维护大型网络服务依然是一项挑战性的任务,因为系统必须是高性能的、高可靠的,尤其当访问负载不断增长时,系统必须能被扩展来满足不断增长的性能需求。由于缺少建立可伸缩网络服务的框架和设计方法,这意味着只有拥有非常出色工程和管理人才的机构才能建立和维护大型的网络服务。 针对这种情形,本文先给出集群的通用体系结构,并讨论了其的设计原则和相应的特点;最后将集群应用于建立可伸缩的、、和等网络服务。 集群的通用体系结构 集群采用负载均衡技术和基于内容请求分发技术。调度器具有很好的吞吐率,将请求均衡地转移到不同的服务器上执行,且调度器自动屏蔽掉服务器的故障,从而将一组服务器构成一个高性能的、高可用的虚拟服务器。整个服务器集群的结构对客户是透明的,而且无需修改客户端和服务器端的程序。 图:集群的体系结构 为此,在设计时需要考虑系统的透明性、可伸缩性、高可用性和易管理性。一般来说,集群采用三层结构,其体系结构如图所示,三层主要组成部分为: ?负载调度器(),它是整个集群对外面的前端机,负责将客户的请求发送到一组服务器上执行,而客户认为服务是来自一个地址(我们可称之为虚拟地址)上的。 ?服务器池(),是一组真正执行客户请求的服务器,执行的服务有、、和等。 ?共享存储(),它为服务器池提供一个共享的存储区,这样很容易使得服务器池拥有相同的内容,提供相同的服务。 调度器是服务器集群系统的唯一入口点(),它可以采用负载均衡技术、基于内容请求分发技术或者两者相结合。在负载均衡技术中,需要服务器池拥有相同的内容提供相同的服务。当客户请求到达时,调度器只根据服务器负载情况和设定的调度算法从服务器池中选出一个服务器,将该请求转发到选出的服务器,并记录这个调度;当这个请求的其他报文到达,也会被转发到前面选出的服务器。在基于内容请求分发技术中,服务器可以提供不同的服务,当客户请求到达时,调度器可根据请求的内容选择服务器执行请求。因为所有的操作都是在操作系统核心空间中将完成的,它的调度开销很小,所以它具有很高的吞吐率。 服务器池的结点数目是可变的。当整个系统收到的负载超过目前所有结点的处理能力时,可以在服务器池中增加服务器来满足不断增长的请求负载。对大多数网络服务来说,请求间不存在很强的相关性,请求可以在不同的结点上并行执行,所以整个系统的性能基本上可以随着服务器池的结点数目增加而线性增长。 建立Java Web服务器 技术:Apache+Tomcat+JDK+Mysql 由于Apache整合了Tomcat,所以这个直接拿来用 首先上传上去 1.安装JDK jdk-6u18-linux-i586.bin:此文件为Linux可执行文件,所以直接运行但是这里不能运行,所以chmod 755必须赋予权限 安装完之后Java还不能运行,但是这不影响后面的,要让Java运行,先进入/bin/目录建立快捷方式:(注意此Java目录,我给移动到/目录下了) ln -sf /java/jdk1.6.0_18/bin/java ln -sf /java/jdk1.6.0_18/bin/javac ln -sf /java/jdk1.6.0_18/bin/javadoc ln -sf /java/jdk1.6.0_18/bin/javaws 2.安装Tomcat,直接解压缩就可以了 apache-tomcat-5.5.28.tar.gz 这种文件是先经过tar压缩,再由gzip压缩 gzip -d apache-tomcat-5.5.28.tar.gz tar -xvf apache-tomcat-5.5.28.tar 改名和移动文件都使用mv 启动Tomcat 配置一些环境变量 JAVA_HOME=/usr/java/jdk1.6.0_18 export JAVA_HOME 后启动Tomcat ./startup.sh 先安装Mysql Server,后安装Mysql Client 一些注意: ps -ef | grep tomcat(列出进程) kill ID号(结束进程) service iptables off ----彻底关闭防火墙 命令行下上网:wget http://IP .rpm:redHat package managerment rpm -qa:列出所有安装的包 rpm -qa | grep jdk是否安装jdk rpm -e 包名:卸载此包 rpm -ivh 文件名:安装文件 文件名》package名 文件名:MySQL-server-community-5.0.89-0.rhel4.i386.rpm 包名:MySQL 设置JAVA_HOME JAVA_HOME不能每次手动设 前言 目前天安保险的WAS环境中有5台服务器,每台服务器配成一个node,每个node上配置了2个application server,组成了一个ND的环境。前台有一台F5做负载均衡,后面连接了1套oracle RAC的数据库。但5个node之间没有做成集群。为了保证Websphere系统高可用性,提高系统性能和负载均衡,考虑配置成集群,下面说明创建、配置集群的整个过程与注意事项。 1. 集群系统架构 操作系统:Linux version 2.6.18-8.el5 Websphere版本:WAS6.1ND 根据天安的环境,可使用如下拓扑: 其中cisapp1~cisapp5表示5台WebSphere,cisCluster表示5台做成一个cluster,dmgr一般是5台中的一台。 2. 创建集群(含session复制) (截图为我本机测试截图,只是示意图,与天安保险的节点名和集群名不符) 在DMGR控制台中,选择集群,然后新建。 注意:先创建一个空的集群,然后我们再向该集群中添加成员即可。 这里还要注意勾选“配置HTTP会话内存到内存复制”,这样就能使session 在集群内共享,比如用户登录,加入被集群分配给node1来处理,用户的登录信息就会被保存在session中,如果此时node1宕机了,用户就会被分配到其他节点来处理而不会要求重新登录。 如果在创建集群时没有勾选此选项,也可按如下方式操作: 配置会话复制 服务器 --> 应用程序服务器 --> 选择集群成员 --> 容器设置:会话管理--> 其他属性:分布式环境设置 --> 确认分布式会话选择的是内存到内存复制,其他属性:定制调整参数 --> 调整级别: 低(故障转移优化) 写频率 servlet服务结束 Linux下搭建web服务器 Apache源于NCSAhttpd服务器,经过多次修改,成为世界上最流行的 Web服务器软件之一。Apache取自“a patchy server”的读音,意 思是充满补丁的服务器,因为它是自由软件,所以不断有人来为它开发新的功能、新的特性、修改原来的缺陷。Apache的特点是简单、 速度快、性能稳定,并可做代理服务器来使用。 本来它只用于小型或试验 Internet网络,后来逐步扩充到各种Unix 系统中,尤其对Linux的支持相当完美。Apache有多种产品,可以支持SSL技术,支持多个虚拟主机。Apache是以进程为基础的结构,进程要比线程消耗更多的系统开支,不太适合于多处理器环境,因此,在一个Apache Web站点扩容时,通常是增加服务器或扩充群集节点 而不是增加处理器。到目前为止Apache仍然是世界上用的最多的Web 服务器,市场占有率达60%左右。世界上很多著名的网站如Amazon.c om、Yahoo!、W3 Consortium、Financial Times等都是Apache的产物,它的成功之处主要在于它的源代码开放、有一支开放的开发队伍、支持跨平台的应用(可以运行在几乎所有的Unix、Windows、Linux 系统平台上)以及它的可移植性等方面。 Apache的诞生极富有戏剧性。当NCSA WWW服务器项目停顿后,那些 使用NCSA WWW服务器的人们开始交换他们用于该服务器的补丁程序,他们也很快认识到成立管理这些补丁程序的论坛是必要的。就这样,诞生了Apache Group,后来这个团体在NCSA的基础上创建了Apache。 Apache的主要特征是: 可以运行上所有计算机平台; 支持最新的H TT P1.1协议; 简单而强有力的基于文件的配置; 支持通用网关接口CGI; 支持虚拟主机; 支持H TT P认证; 集成P erl脚本编程语言; 概述 linux集群部署,记录关键的几个步骤如下: 1.做两个InstallationManager安装工具,一个控制平台(79),一个HIS(78),两个node 2.服务器获取文件,sftp root@10.224.130.18p@ssw0rd 3.get /opt/software/IBM/agent.zip /opt/software/IBM/ exit 安装InstallationManager # 78、79上安装InstallationManager cd /opt/software mkdir agent unzip -q agent.zip -d agent cdagent /tools ./imcl install com.ibm.cic.agent -repositories ../repository.config -acceptLicense 安装WAS AS 8.5.5 #两个服务器都安装WAS mkdir WAS_ND_V8.5.5_3 unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_1_OF_3.zip unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_2_OF_3.zip unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_3_OF_3.zip cd /opt/IBM/InstallationManager/eclipse/tools/ ./imcllistAvailablePackages -repositories /opt/software/IBM/WAS_ND_V8.5.5_3 ./imcl install com.ibm.websphere.ND.v85_8.5.5000.20130514_1044 -repositories /opt/software/IBM/WAS_ND_V8.5.5_3 -acceptLicense 安装HIS #78 安装HIS mkdirWAS_V8.5.5_SUPPL unzip -q -d WAS_V8.5.5_SUPPLWAS_V8.5.5_SUPPL_1_OF_3.zip unzip -q -d WAS_V8.5.5_SUPPLWAS_V8.5.5_SUPPL_2_OF_3.zip Linux下高可用集群方案很多,本文介绍的是性价比比较高的一种: 使用Heartbeat 2.0配置Linux高可用性集群。 一、准备工作 你首先需要两台电脑,这两台电脑并不需要有相同的硬件(或者内存大小等),但如果相同的话,当某个部件出现故障时会容易处理得多。接下来您需要决定如何部署。你的集群是通过Heartbeat 软件产生在两台电脑之间心跳信号来建立的。为了传输心跳信号,需要在节点之间存在一条或多条介质通路(串口线通过modem电线,以太网通过交叉线,等等)。现在可以开始配置硬件了。既然想要获得高可用性(HA),那么您很可能希望避免单点失效。在本例中,可能是您的null modem线/串口,或者网卡(NIC)/ 交叉线。因此便需要决定是否希望为每个节点添加第二条串口null modem连线或者第二条NIC/交叉线连接。我使用一个串口和一块额外的网卡来作为heartbeat的通路,这是因为我只有一条null modem线和一块多余的网卡,并且认为有两种介质类型传输heartbeat信号比较好。硬件配置完成之后,便需要安装操作系统以及配置网络(我在本文中使用的是RedHat)。假设您有两块网卡,那么有一块应该配置用于常规网络用途,另一块作为集群节点之间的专用网络连接(通过交叉线)。例如,假设集群节点有如表-1下的IP地址: 表-1集群节点的IP地址 输入如下命令检查您的配置: ifconfig 这将显示您的网卡及其配置。也可以使用命令“netstat –nr”来获得网络路由信息。如果一切正常,接下来要确定可以来两个节点之间通过所有接口ping通对方。如果使用了串口,便需要检测其连接情况。把一个节点作为接收者,输入命令: cat LVS集群有DR、TUN、NAT三种配置模式,可以对www服务、FTP服务、MAIL服务等做负载均衡,下面通过搭建www服务的负载均衡实例,讲述基于DR模式的LVS集群配置。 一、 Director Server的配置 在Director Server上配置LVS负载均衡集群,有两种方法: a. 通过ipvsadm命令行进行配置 b. 通过Redhat提供的工具piranha来配置LVS 通过ipvsadm命令行方式配置LVS 安装IPVS后,就可以配置LVS集群了,首先在Director Server上绑定一个虚拟IP(也叫VIP),此IP用于对外提供服务,执行如下命令: 复制代码 代码如下: [root@localhost ~]#ifconfig eth0:0 192.168.60.200 broadcast 192.168.60.200 netmask 255.255.255.255 up 此处在eth0设备上绑定了一个虚拟设备eth0:0,同时设置了一个虚拟IP是192.168.60.200,也就是上面我们规划的IP地址,然后指定广播地址也为192.168.60.200,需要特别注意的是,这里的子网掩码为255.255.255.255。 然后给设备eth0:0指定一条路由,执行如下指令: 代码如下: [root@localhost ~]#route add -host 192.168.60.200 dev eth0:0 接着启用系统的包转发功能,从而使系统充当路由器,执行如下指令: 代码如下: [root@localhost ~]#echo 1 ;/proc/sys/net/ipv4/ip_forward 指令中,参数值为1时启用ip转发,为0时禁止ip转发。其实在DR模式中,开启系统的包转发功能不是必须的,而在NAT模式下此操作是必须的。 然后开始配置ipvs,执行如下操作: DM7集群部署方案之数据守护集群 Linux(主备) 武汉达梦数据库有限公司 2019年9月 版本历史 目录 1 安装前准备 (1) 1.1集群规划 (1) 1.2网络架构 (1) 1.3硬件环境建议 (2) 1.4硬件环境环境验证 (2) 1.5A机器:实例、启服务 (2) 2 配置A机器 (2) 2.1注册服务 (2) 2.2配置DM.INI (3) 2.3配置DMARCH.INI (3) 2.4配置DMMAL.INI (4) 2.5配置DMWATCHER.INI (4) 2.6配置DMWATCHER.CTL (4) 2.7拷贝实例 (5) 3 配置B机器 (5) 3.1注册服务 (5) 3.2配置DM.INI (6) 3.3配置DMARCH.INI (6) 3.4相同配置项 (6) 4 配置监视器 (6) 4.1注册服务 (6) 4.2配置DMMONITOR.INI (7) 4.3监视器使用 (7) 5 启动服务及查看信息 (8) 5.1启动数据库服务并修改参数 (8) 5.2查询主备库信息是否一致 (8) 5.3启动守护进程 (8) 5.4启动监视器 (8) 5.5启停集群 (9) 6 配置DM_SVC.CONF文件 (9) 6.1 DM_SVC.CONF配置内容 (9) 6.2应用连接 (9) 7 附加操作 (10) 7.1操作系统/数据库调优 (10) 7.2数据库备份 (10) 7.3项目管理维护 (10) 1安装前准备 1.1集群规划 说明:具体规划及部署方式以现场环境为准。 1.2网络架构 主机备机 1.3硬件环境建议 心跳网络方面:①集群间的心跳网络要走数据,最好走两个交换机,来实现冗余和负载均衡。②需要把服务器多个心跳网卡绑定为一个逻辑网卡来使用(比如bond方式)。③交换机速度建议至少为千兆。 存储方面:①需要在每台机器上挂在独立存储,其中主机所在机器挂载的存储建议大一些。②需要格式化好,且所有机器挂载路径保持一致。③在空间不够用时,要求支持在挂载目录上直接进行扩充。④文件系统建议使用ext4。 1.4硬件环境环境验证 心跳网络方面:①关闭其中一台交换机或者模拟其中一条线路故障,是否能做到网络方面的冗余。②测试心跳网络的稳定性,会不会出现断连或者丢包等情况。 存储方面:反复重启集群机器,检查存储是否会出现只读、脱挂、挂载路径是否会发生改变等情况。 1.5A机器:实例、启服务 2配置A机器 2.1注册服务 ①复制数据库和守护进程服务文件到/etc/rc.d/init.d目录 ②vi /etc/rc.d/init.d/DmServiceRT1_01文件 ③vi /etc/rc.d/init.d/DmServiceWatcher文件 ④修改启动服务的等级连接 1.MYSQL的配置过程: [root@mailweb]#tar zxvf mysql-5.0.18.tar.gz [root@mailweb]#cdmysql-5.0.18 [root@mailmysql-5.0.18]#groupaddmysql [root@mailmysql-5.0.18]#useradd-gmysqlmysql [root@mailmysql-5.0.18]#./configure——prefix=/usr/local/mysql#把MYSQL安装到指定目录 [root@mailmysql-5.0.18]#make [root@mailmysql-5.0.18]#makeinstall [root@mailmysql-5.0.18]#scripts/mysql_install_db [root@mailmysql-5.0.18]#chown-Rroot/usr/local/mysql [root@mailmysql-5.0.18]#chown-Rmysql/usr/local/mysql/var [root@mailmysql-5.0.18]#chgrp-Rmysql/usr/local/mysql [root@mailmysql-5.0.18]#cpsupport-files/https://www.doczj.com/doc/4b8258308.html,f/etc/https://www.doczj.com/doc/4b8258308.html,f 用如下命令启动MySQL数据库(如果操作系统默认安装的有MySQL数据库请确认其没有启动): [root@mailmysql-5.0.18]#/usr/local/mysql/bin/safe_mysqld——user=mysql& 将上面的启动命令追加到文件"/etc/rc.d/rc.local"的尾部,使操作系统启动时就自动MySQL数据库服务器。以下对MYSQL进行初始化设置: [root@mailmysql-5.0.18]#/usr/local/mysql/bin/mysql进入MYSQL客户端工具,进行相关设置 mysql>dropdatabasetest;mysql>usemysql;mysql>deletefrommysql whereuser="";mysql>deletefrommysqlwherehost="%";mysql>delet efromdb; 现在mysql数据库将只允许本机的mysql管理员root用户(和操作系统的root 用户不同)连接,用如下命令为root用户指定密码: 课程描述: 网络的飞速发展,给网络带宽和服务器性能带来了巨大的挑战,基于互联网的应用系统越来越多的瓶颈出现在服务器端,这就对服务器提出了更高的要求,同时,在互联网运营和管理上,也要求更加的智能和灵活,如何能够实时的了解每个服务器的运行状态,并在应用出现故障的第一时间内来处理问题,成为互联网运维中的一个重中之重。 本课程就重点介绍这方面的应用和案例,首先介绍开源的网络存储应用ISCSI,iSCSI技术以其低廉的构建成本和优秀的存储性能,博得了很多CIO和存储管理员的喜爱,目前已经陆续进入企业应用领域,这种技术推动了企业向集中式存储环境转变。 接着介绍nagios监控系统,Nagios是系统管理人员和运维监控人员必须的工具之一,使用nagios可以监控本地或远程主机资源,例如磁盘空间、系统负载等信息,也可以监控各种应用服务,例如httpd服务、ftp服务等,当主机或者服务出现故障时,nagios还可以通过邮件、手机短信等方式在第一时间内通知系统维护人员。利用nagios可以以低廉的成本达到商业监控系统所完成的功能。 最后,讲解了集群系统在企业级方面的应用,主要讲述了红帽集群套件RHCS开源HA heartbeat、负载均衡器LVS、Oracle集群数据库RAC、Mysql+DRBD集群等方面的应用案例,通过使用Linux搭建集群,可以用较低的价格来实现高可伸缩、高可用的网络服务,弥补单一服务器无法达到的性能。 购买地址:https://www.doczj.com/doc/4b8258308.html,/3501607 在线观看: 讲师介绍: 高俊峰,网名南非蚂蚁,经常活跃于国内著名技术社区IXPUB (https://www.doczj.com/doc/4b8258308.html,)、ITPUB (https://www.doczj.com/doc/4b8258308.html,)、ChinaUnix(https://www.doczj.com/doc/4b8258308.html,),在IXPUB任“Linux与开源世界”及“存储设备与容灾技术”版主,多年专注于Linux+Oracle技术方面的研究与实践,擅长Linux系统管理与应用,实战经验丰富。 课程目录一览 第1讲 iscsi的概念、组成和工作原理 课程目标:了解iscsi的组成和工作原理。 课程内容: iscsi的概念。 iscsi的组成。 iscsi的工作原理。 第2-3讲基于iscsi的ip san存储系统 课程目标: DM7集群部署方案之数据共享集群 Linux(2节点) 武汉达梦数据库有限公司 2019年9月 版本历史 目录 1 前期准备工作 (1) 1.1硬件准备 (1) 1.2网络架构 (1) 1.3硬件环境建议 (1) 1.4硬件环境环境验证 (2) 1.5集群规划 (2) 1.6修改主机名 (2) 1.7关闭防火墙 (3) 1.8网卡自启 (3) 1.9修改系统参数 (3) 2 创建目录并安装数据库 (3) 2.1A机器 (3) 2.2B机器 (4) 3 存储准备 (4) 3.1划存储 (4) 3.2挂存储方法1:直接挂 (4) 3.3挂存储方法2:多路径绑定 (5) 4 搭建DSC (6) 4.1配置DMDCR_CFG.INI (6) 4.2初始化磁盘组 (7) 4.3配置DMASVRMAL.INI (7) 4.4配置DMDCR.INI (7) 4.5启动CSS、ASM服务 (8) 4.6创建DMASM磁盘组 (9) 4.7配置DMINIT.INI (9) 4.8初始化数据库 (9) 4.9配置DMARCH.INI (10) 4.10启动DMSERVER服务 (10) 4.11设置后台启动脚本 (11) 4.12启停集群 (12) 5 配置监视器 (13) 5.1配置DMCSSM.INI (13) 5.2启动监视器 (13) 6配置DM_SVC.CONF文件 (13) 6.1 DM_SVC.CONF配置内容 (13) 6.2应用连接 (14) 7附加操作 (14) 7.1操作系统/数据库调优 (14) 7.2数据库备份 (14) 7.3项目管理维护 (14) 实训项目5 Linux文件与Web服务 一、实训目的 ●掌握Linux系统之间资源共享和互访方法。 ●掌握Linux文件服务器的配置方法(企业NFS服务器和客户端的安装与配置)。 ●掌握Linux系统中Apache服务器的安装与配置。 ●掌握个人主页、虚拟目录、基于用户和主机的访问控制及虚拟主机的实现方法(可选)。 二、实训内容 ●练习Linux系统NFS服务器与NFS客户端的配置方法。 ●练习Linux系统Apache服务器的安装与配置方法。 三、实训步骤 子项目1.NFS服务器与NFS客户端的配置(必做) 某企业的销售部有一个局域网,域名为https://www.doczj.com/doc/4b8258308.html,。网络拓扑图如下图所示。网内有一台Linux的共享资源服务器www,域名为https://www.doczj.com/doc/4b8258308.html,。现要在www上配置NFS 服务器,使销售部内的所有主机都可以访问www服务器中的/share共享目录中的内容,但不允许客户机更改共享资源的内容。同时,让主机china在每次系统启动时自动挂载www 的/share目录中的内容到china3的/share1目录下。 (一)、软件安装及准备工作 检测系统是否安装了NFS服务器对应的软件包,如果没有安装的话,进行安装。 # rpm -qa | grep nfs //确认NFS已经安装,NFS是默认安装选项 nfs-utils-lib-1.1.5-1.el6.i686 # service nfs status rpc.svcgssd is stopped //如果NFS已经安装,则查看其服务是否启动 rpc.mountd is stopped nfsd is stopped rpc.rquotad is stopped # ll /share //查看/share目录是否已经建立 ls: cannot access /share: No such file or directory # mkdir /share # cat > /share/hello.txt hello! ^C //注意:此处的^C不是输入的字符内容,而是一个Ctrl+C的键盘输入 (二)、配置主配置文件/etc/exports # vim /etc/exports /share *(ro,async) //所有网段访问,只读,同步 /tmp 192.168.0.0/255.255.255.0(rw,async) //只允许192.168.5网段访问,可读写 (三)、启动服务 # service nfs start Starting NFS services: [ OK ] Starting NFS quotas: [ OK ] Starting NFS daemon: [ OK ] Starting NFS mountd: [ OK ] # service named start //启动域名服务 Starting named: [ OK ] (四)、配置防火墙 第03章 集群利器Keepalived 本章主要了解开源高可用负载均衡集群利器Keepalived,掌握Keepalived的安装,运用Keepalived配置高可用集群,并能够实现Keepalived与负均衡集群LVS的完美组合。 一、Keepalived概述 1、什么是Keepalived? keepalived是一个类似于layer3, 4 & 5交换机制的软件,也就是我们平时说的第3层、第4层和第5层交换。Keepalived的作用是检测web服务器的状态,如果有一台web服务器死机,或工作出现故障,Keepalived将检测到,并将有故障的web服务器从系统中剔除,当web服务器工作正常后Keepalived自动将web服务器加入到服务器群中,这些工作全部自动完成,不需要人工干涉,需要人工做的只是修复故障的web服务器 2、keepalived理论工作原理 Layer3,4&5工作在IP/TCP协议栈的IP层,TCP层,及应用层,原理分别如下: Layer3:Keepalived使用Layer3的方式工作式时,Keepalived会定期向服务器群中的服务器发 送一个ICMP的数据包(既我们平时用的Ping程序),如果发现某台服务的IP地址没有激活,Keepalived便报告这台服务器失效,并将它从服务器群中剔除,这种情况的典型例子是某台服务器被非法关机。Layer3的方式是以服务器的IP地址是否有效作为服务器工作正常与否的标准。 Layer4:主要以TCP端口的状态来决定服务器工作正常与否。如web server的服务端口一般是80,如果Keepalived检测到80端口没有启动,则Keepalived将把这台服务器从服务器群中删除。 Layer5:Layer5就是工作在具体的应用层了,比Layer3,Layer4要复杂一点,在网络上占用的带宽也要大一些。Keepalived将根据用户的设定检查服务器程序的运行是否正常,如果与用户的设定不相符,则Keepalived将把服务器从服务器群中剔除。 服务器的基本状况: 一个2T硬盘的前端存储节点,名称为tccl_front;9台8核的计算节点,名称分别为tccl01-tccl09。操作系统为CentOS 5.3 x86_64版本的Linux系统。 NIS服务已经配置好,存储节点的磁盘用NFS挂载在每个计算节点上作为共享磁盘。所有的应用软件都安装在此共享磁盘上。 1.ssh免密码登录.对每个用户都要设置。 2.下载Torque,解压缩,编译。 目前,torque 2.3是稳定版本,2.4是beta版本。为了稳定,我下载的是2.3.9版本。下载地址: https://www.doczj.com/doc/4b8258308.html,/downloads/torque 在PBS服务器节点上: tar xvfz torque-2.3.9.tar.gz configure需要加参数 ./configure --enable-docs --with-scp --enable-syslog make make packages make install 将torque-package-mom-linux-i686.sh,torque-package-clients-linux-i686.sh安装到计算节点上。 将这两个文件拷贝到计算节点上(或者是共享磁盘上),登录进计算节点,运行: ./torque-package-mom-linux-i686.sh --install ./torque-package-clients-linux-i686.sh --install 可以使用dsh之类的工具来辅助。或者手工写一个脚本来完成这些工作。 3.配置pbs_mom为服务 在torque源码包contrib目录中有一个文件 cp contrib/init.d/pbs_mom /etc/init.d/pbs_mom chkconfig --add pbs_mom 在所有的机器(pbs服务器和计算节点)上都需要如此设置。 写脚本来完成吧!比如 for i in `seq 1 9` do echo tccl0$i ssh tccl0$i "some command" done 4.配置torque 1) ldconfig 2) Specify Compute Nodes 编辑文件 /var/spool/torque/server_priv/nodes 内容如下(注意,这里使用的都是机器的简称,与使用免密码登录时的机器名称相同): ServerRoot :设置httpd服务器的根目录,该目录运行了web站点必须的文件,默认根目录为/usr/local/httpd. 与httpd的安装目录相同,在httpd.conf配置文件中,如果没有指定目录或文件位置,则默认位置都是在服务器根目录下。 Listen:监听的网络端口号,默认80 User:设置运行httpd进程使用的用户身份,默认daemon。 Group:设置运行httpd进程使用的组身份,默认daemon。 ServerName:设置web站点的完整主机名。 DocumentRoot:设置网站根目录,网页文档在系统中实际存放路径,此配置和serverroot混淆。Direttoryindex:设置网站默认索引页,可以设置多个首页文件。默认是index.html Errorlog:设置错误页的日志文件存放路径,默认路径为logs/error-log. Loglevel:设置记录日志级别,默认级别为warn(警告)。 Customlog:访问日志存放路径,日志类型,默认路径logs/access_log,类型commot通用格式 Pidfile:设置保存httpd进程号pid的文件,默认为logs/httpd.pid,logs位于apache服务器的根目录。 Charsetdefault:设置站点默认使用的字符集编码,如果utf-8,gb2312等 Include:包含另一个配置文件,为实现特殊功能,不影响主配置文件。 Httpd服务安装 搭建web服务 1.首先挂载光盘,然后修改yum配置文件。 2. 3. 4.安装完之后开始配置,vim/etc/httpd/conf/httpd.conf 或者使用rpm安装httpd包,配置文件默认在etc/httpd下 在或者使用源码编译安装。需要注意系统之间兼容性。 实现拒绝某个ip 访问网站 Linux平台Apache双机高可用集群 + Tomcat负载均衡集群配置手册 在这个配置手册中,使用的操作系统和软件清单如下: 操作系统: RedHat Enterprise Linux AS4 U4 64bit(安装时最好选择完全安装) 软件: jdk-1_5_0_15-linux-amd64.bin Tomcat5.5.26 httpd-2.0.63.tar.gz jakarta-tomcat-connectors-jk2-src-current.tar.gz ipvsadm-1.24.tar.gz libnet.tar.gz heartbeat-2.1.3-3.el4.centos.x86_64.rpm heartbeat-pils-2.1.3-3.el4.centos.x86_64.rpm heartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm 因为是linux操作系统,所以在安装软件时请使用对应自己操作系统内核的软件,这是整个集群成功的第一步。本配置手册中的软件都是对应RedHat Enterprise Linux AS4 U4 64bit 这个版本的软件。 jdk-1_5_0_15-linux-amd64.bin JAVA环境包使用的是64位1.5版 Tomcat版本为公司指定的5.5版本 Apache为2.0.63版 jakarta-tomcat-connectors-jk2-src-current.tar.gz 是连接Apache和Tomcat的连接插件,具体可以去Tomcat网站上查找下载 ipvsadm-1.24.tar.gz libnet.tar.gz 这两个是用于2台Apache服务器虚拟一个IP地址使用 heartbeat-2.1.3-3.el4.centos.x86_64.rpm heartbeat-pils-2.1.3-3.el4.centos.x86_64.rpm heartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm 这3个软件是用于2台Apache服务器之间的心跳检测 石河子大学信息科学与技术学院 计算机网络课程设计报告 基于Linux平台(RedHat)安装配置实现Web 课题名称: 服务器 学生姓名: 学号: 学院: 专业年级: 指导教师: 完成日期:2013-12-30 目录: 1.课题任务名称 (2) 1.1课题任务: (2) 1.2课题要求: (2) 2. 相关理论背景/基础知识概述 (2) 3实践环境/条件及资源说明 (3) 4.实践任务内容 (5) 4.2.1全局环境配置: (6) 4.2.2主服务配置: (8) 4.2.3虚拟主机配置 (10) 5.过程步骤说明 (11) 5.1 启动 Linux RedHat系统 (11) 5.2实现Web服务器安装配置 (12) 6、结论 (20) 7总结与体会 (21) 1.课题任务名称 1.1课题任务: 基于Linux平台(RedHat)安装配置实现Web服务器 1.2课题要求: 给出Apache服务器配置文件的存储位置和全部内容,包括其中全部选项的含义及作用、配置建议。 2.相关理论背景/基础知识概述 Apache HTTP Server(简称Apache)是Apache软件基金会的一个开放源码的网页服务器,可以在大多数计算机操作系统中运行,由于其多平台和安全性被广泛使用,是最流行的Web服务器端软件之一。它快速、可靠并且可通过简单的API扩展,将Perl/Python等解释器编译到服务器中。 Apache源于NCSA httpd服务器,经过多次修改,成为世界上最流行的Web服务器软件之一,它可以运行在几乎所有广泛使用的计算机平台上。 Apache取自“a patchy server”的读音,意思是充满补丁的服 linux服务器集群的详细配置 一、计算机集群简介 计算机集群简称集群是一种计算机系统,它通过一组松散集成的计算机软件和/或硬件连接起来高度紧密地协作完成计算工作。在某种意义上,他们可以被看作是一台计算机。集群系统中的单个计算机通常称为节点,通常通过局域网连接,但也有其它的可能连接方式。集群计算机通常用来改进单个计算机的计算速度和/或可靠性。一般情况下集群计算机比单个计算机,比如工作站或超级计算机性能价格比要高得多。 二、集群的分类 群分为同构与异构两种,它们的区别在于:组成集群系统的计算机之间的体系结构是否相同。集群计算机按功能和结构可以分成以下几类: 高可用性集群High-availability (HA) clusters 负载均衡集群Load balancing clusters 高性能计算集群High-performance (HPC) clusters 网格计算Grid computing 高可用性集群 一般是指当集群中有某个节点失效的情况下,其上的任务会自动转移到其他正常的节点上。还指可以将集群中的某节点进行离线维护再上线,该过程并不影响整个集群的运行。 负载均衡集群 负载均衡集群运行时一般通过一个或者多个前端负载均衡器将工作负载分发到后端的一组服务 器上,从而达到整个系统的高性能和高可用性。这样的计算机集群有时也被称为服务器群(Server Farm)。一般高可用性集群和负载均衡集群会使用类似的技术,或同时具有高可用性与负载均衡的特点。 Linux虚拟服务器(LVS)项目在Linux操作系统上提供了最常用的负载均衡软件。 高性能计算集群 高性能计算集群采用将计算任务分配到集群的不同计算节点而提高计算能力,因而主要应用在科学计算领域。比较流行的HPC采用Linux操作系统和其它一些免费软件来完成并行运算。这一集群配置通常被称为Beowulf集群。这类集群通常运行特定的程序以发挥HPC cluster的并行能力。这类程序一般应用特定的运行库, 比如专为科学计算设计的MPI库 集群特别适合于在计算中各计算节点之间发生大量数据通讯的计算作业,比如一个节点的中间结果或影响到其它节点计算结果的情况。 网格计算 网格计算或网格集群是一种与集群计算非常相关的技术。网格与传统集群的主要差别是网格是连接一组相关并不信任的计算机,它的运作更像一个计算公共设施而不是一个独立的计算机。还有,网格通常比集群支持更多不同类型的计算机集合。 网格计算是针对有许多独立作业的工作任务作优化,在计算过程中作业间无需共享数据。网格主要服务于管理在独立执行工作的计算机间的作业分配。资源如存储可以被所有结点共享,但作业的中间结果不会影响在其他网格结点上作业的进展。 安装CAS集群(v1.0) 目录 1部署操作 (2) 1.1硬件及部署要求 (2) 1.1.1部署图 (2) 1.2操作系统安装—SERVER1,2 .................................................................................................. 错误!未定义书签。 1.3安装M EMCACHED (2) 1.3.1安装环境 (2) 1.3.2安装步骤 (3) 1.4安装LVS (7) 1.5配置CAS集群模式 (11) 1 部署操作 1.1 硬件及部署要求 以下几种集群部署策略请根据实际情况选择确定。 (1)使用认证平台人数在3万人以下,并发5000以下,不推荐集群化部署,单台即可; 节点服务器要求(2路4核,8G 内存以上)物理机优先。 1.1.1 部署图 说明:此架构为CAS 的集群模式,考虑高并发的模式及双击热备的模式,Memcached 需要配置1-2G 内存,可以考虑单独部署服务器,可以与其中一台CAS 服务器进行一起部署。 如果Memcached 挂了或者不能访问了,CAS 服务器就不能访问。 ● CPU 类型:Intel/AMD (64位,主频2.6GHz 以上,2核及以上) ● 内存容量:4GB 及以上 ● 硬盘容量:160GB 以上,Raid 1/5 ● 网络控制器:千兆以太网卡(两块以上) ● IP (对外提供服务):3个,其中一个为虚拟ip ● 集群策略:MirrorMode ● 拓扑图: PC Smart Phone IP :Memcached 1.2 安装Memcached 1.2.1 安装环境 redhat server 6.3(64bit)/ Centos 6.3(64bit)SUSELinux搭建企业服务器的双机配置过程

详解Linux服务器集群

Linux上搭建Java Web服务器

Websphere for Linux集群安装和配置

linux下用apache搭建web服务器

was8.5.5 linux集群部署

Linux下高可用集群方案

LINUX中使用IPVSADM配置LVS集群的基本方法

DM7集群部署方案之数据守护集群Linux(主备)

Linux系统下Web服务器配置详细介绍

linux集群应用实战

DM7集群部署方案之数据共享集群Linux(2节点)

Linux文件服务器与Web服务配置

Linux开源集群架构之keepalived应用详解

Torque在Linux集群上的安装配置

linux下搭建http服务

Linux平台Apache高可用双机集群Tomcat负载均衡集群配置手册

基于Linux平台(RedHat)安装配置实现Web服务器..

linux服务器集群的详细配置

CAS集群部署(Linux)